基于CycleGAN的仿真PET/CT圖像生成方法

李柏橋,彭 顯

(昆明理工大學 信息工程與自動化學院,云南 昆明 650050)

0 引 言

直到今天,癌癥依然是威脅人類健康的主要疾病之一。據統計,2018年全球有1 807萬余例新增癌癥病例,發病率為每10萬人236.9例。盡可能早的癌癥診斷對患者的康復至關重要,醫療影像學方法尤其是正電子發射型計算機斷層顯像/計算機斷層掃描顯像(Positron Emission Computed Tomography/Computed Tomography,PET/CT)是癌癥診斷(特別是早期診斷)的一種重要手段,但其現階段主要依據常規代謝顯像,在癌癥早期診斷上的診斷力不高[1-3]。患病部位的血流灌注參數是臨床檢測和診斷癌癥的重要參考指標[4]。因此,目前常用的肝癌診斷方式是依據機器學習計算出灌注參數,并通過灌注參數在腫瘤組織與正常組織之間的差異來進行診斷[5]。血流灌注參數是通過基于機器學習技術建立的血流動力學模型計算得到的。現階段用于癌癥診斷的血流動力學模型主要有兩類:一類是Mullani等[6]提出的最大斜率法模型,主要關注示蹤劑首次通過組織時的血流情況,通過模型計算出的動脈灌注量(Hepatic Artery Perfusion,HAP)、靜脈灌注量(Hepatic Portal Vein Perfusion,HVP)、總灌注量(Total Liver Perfusion,TLP)、動脈灌注指數(Hepatic Artery Perfusion Index,HPI)和靜脈灌注 指 數(Hepatic Portal Vein Perfusion Index,PPI)5個參數來區分腫瘤組織與正常組織[7];另一類是房室模型,使用電信號模擬病變器官的生理過程,主要關注腔室之間的血流轉換和血液中葡萄糖的代謝情況[8]。房室模型主要分為單房室模型[1]、雙房室模型[9]以及三房室模型[10-12]。以上的方法存在一個共同缺點,即先需要人工提取出存在于PET/CT圖像中的特征,再將特征輸入模型進行癌癥的早期診斷,將消耗大量的人工成本。

隨著計算機技術的不斷發展,出現了以卷積神經網絡為代表的深度學習技術,并被廣泛應用于醫療、軍事、航天以及氣象等領域,并取得了良好效果。卷積神經網絡由卷積層、池化層和全連接層組成。由于卷積層可以自動從數據中提取預測所需的特征,因此十分適于替代上述依賴人工提取特征的早期診斷模型。然而,基于卷積神經網絡的癌癥早期預報模型依賴于大規模數據集的訓練,由于PET/CT成像存在費用過于高昂和造成患者較大生理不適的問題,目前PET/CT設備并未得到大范圍普及,造成可以用于訓練卷積神經網絡模型的PET/CT數據量嚴重不足。

生成對抗網絡(Generative Adversarial Network,GAN)是深度學習領域的一個重要分支,可以根據已有的圖像數據生成與之相似的仿真圖像數據,非常適合于擴充PET/CT圖像的數量。因此,本文提出了一種基于GAN(CycleGAN)的PET/CT仿真圖像生成的方法,以此獲得更多的仿真PET/CT圖像,用于后續基于卷積神經網絡的癌癥早期診斷模型的訓練。

1 數 據

1.1 數據來源

本文使用的原始數據來自斯坦福大學2018年發布的NSCLC Radiogenomics數據集(https://wiki.cancerimagingarchive.net/display/Public/NSCLC+Radiogenomics),其中包含了211位受試者的肺部 PET/CT 圖像[13]。

1.2 數據預處理

NSCLC Radiogenomics數據集中包含了211位受試者的全身(軀干部分)PET/CT圖像,而每位受試者的癌變部位均為肺部,需要手動從原始數據中提取肺部PET/CT圖像。同時,為了獲得更大規模的數據集,在圖像符合要求的前提下,從每位受試者圖像樣本中提取盡量多的PET/CT圖片。提取工作由一名有3年從業經驗的放射科醫師進行,最終提取到來自211位受試者的917張肺部PET/CT圖像。提取出的部分圖像如圖1所示。

圖1 部分真實的肺部PET/CT圖像

2 方 法

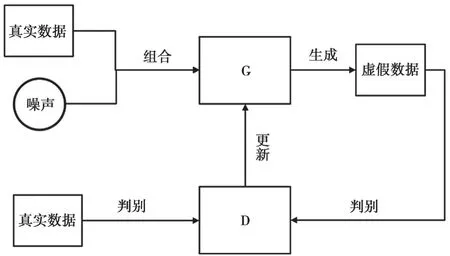

生成對抗網絡是深度學習的一個重要分支,是一種典型的無監督學習算法。如圖2所示,生成對抗網絡包括生成模塊(Generator,G)和判別模塊(Discriminator,D)兩個模塊。生成模塊的作用是根據輸入的圖像數據生成仿真圖像數據,判別模塊的作用是判斷生成模塊所生成的仿真數據是否符合要求。訓練過程中,生成模型會隨機選擇輸入的真實圖像數據中的各項特征并進行重新組合,同時加入隨機噪聲。判別模塊會同時接收到真實的圖像數據和生成模塊生成的仿真圖像數據,進而判斷每一個輸入是真實圖像數據還是仿真圖像數據,并給出一個評分。訓練過程中,對兩個模塊的參數進行同時調優,如果判別模塊可以識別出仿真圖像數據,需要更新生成模塊的參數使其生成的仿真圖像數據更加逼真,最終使判別模塊難以判別出生成模塊所生成的仿真圖像數據,至此整個網絡訓練完成。

圖2 生成對抗網絡的總體結構

2.1 CycleGAN概述

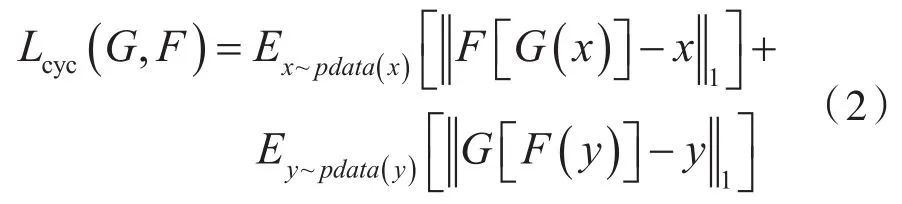

Zhu等人在2017年提出了一種名為CycleGAN的生成對抗網絡[14]。CycleGAN在結構方面做了大幅度改進,如圖3所示。它包含2個生成對抗網絡,與傳統的生成對抗網絡不同。CycleGAN中的兩個生成對抗網絡只輸入真實數據而不輸入噪聲,將兩類真實的圖像進行圖像風格的融合。此時,模型的優化目標為:

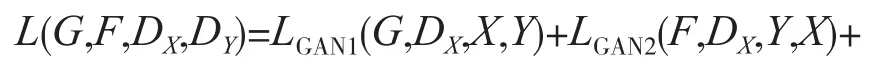

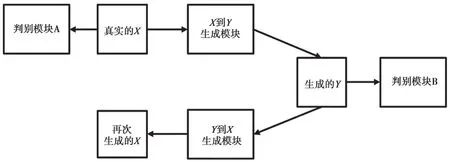

式中,X、Y分別表示待融合的兩張圖像;模型GAN1負責將圖像X轉換成圖像Y相近的圖像;模型GAN2負責將圖像Y轉換成圖像X相近的圖像;Lcyc(G,F)代表循環一致性損失,是實現CycleGAN的關鍵,計算方法如下:

式(2)右側第1項表示圖像X輸入到GAN1的生成模塊中,并將GAN1的輸出結果輸入到GAN2的生成模塊中,然后計算GAN2的輸出結果與輸入圖像X的真實值之間的距離。式(2)右側第2項用于保證輸入的圖片經過兩次變換后發生的變化盡可能小,即使生成模塊能更好地擬合圖像X到圖像Y之間和圖像Y到圖像X之間的映射關系,從而避免模型的生成圖片過于單調。

圖3 CycleGAN模型的總體結構

2.2 生成模塊與鑒別模塊

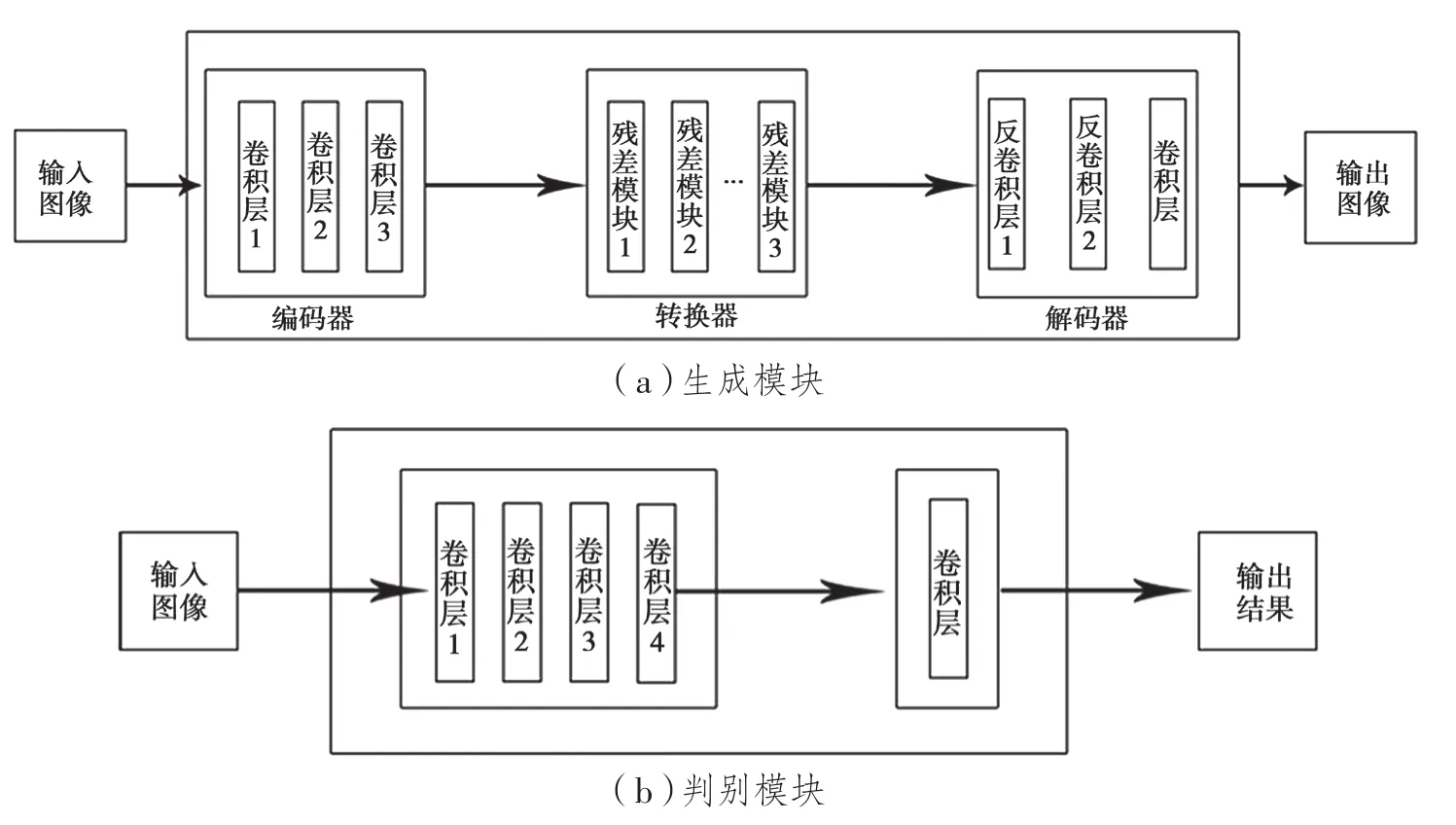

如圖4(a)所示,CycleGAN的生成模塊主要由編碼器、轉換器和解碼器3個部分組成。其中,編碼器的作用是初步利用卷積神經網絡提取輸入圖像中的特征,得到256個尺寸為64×64的特征圖;轉換器的作用是組合圖像的不相近特征,將圖像在一個域中的特征向量轉換為另一個域中的特征向量,常使用兩個卷積層組成的網絡,保證轉換的同時保留原始圖像的特征;解碼器的作用是利用反卷積從特征向量中還原出低級的特征,得到生成圖像。

鑒別模塊的結構如圖4(b)所示。鑒別模塊的本質是一個卷積神經網絡,從輸入的圖像中提取出特征,再通過添加的一層一維輸出卷積層判別網絡所提取到的特征是否屬于特定的類別。

2.3 模型訓練與仿真圖像的生成

本文搭建的CycleGAN模型的超參數根據經驗和實驗結果設置如下:生成模塊與判別模塊均使用Adam 優化器[15],其中β1參數被設置為 0.4,β2參數被設置為0.8,學習率被設置為0.001。同時,在模型的預訓練結束后,判別模塊參數每更新5次生成模塊參數就被更新1次。batch-size被設置為64。

模型訓練完成后,嘗試使用訓練后的模型生成若干仿真肺部PET/CT模型。部分生成的仿真PET/CT圖像如圖5所示,可以看出,生成圖像與真實圖像有所不同,但總體上擁有相似的特征。

3 結 果

3.1 類圖靈測試

1950年,計算機之父艾倫·麥席森·圖靈首次提出“圖靈測試”的概念[16]。“圖靈測試”是指測試者在不知道被測試者是人還是機器的情況下,通過某些特定的手段向被測試者進行提問,由測試者判斷被測試者是人還是機器。如果進行多次提問后機器的回答讓平均每個測試者作出超出一定比例的誤判,那么這臺機器就通過了測試,并被一定程度上認為具有智慧。

圖4 CycleGAN模型的生成模塊與判別模塊

圖5 模型生成的仿真肺部PET/CT圖像

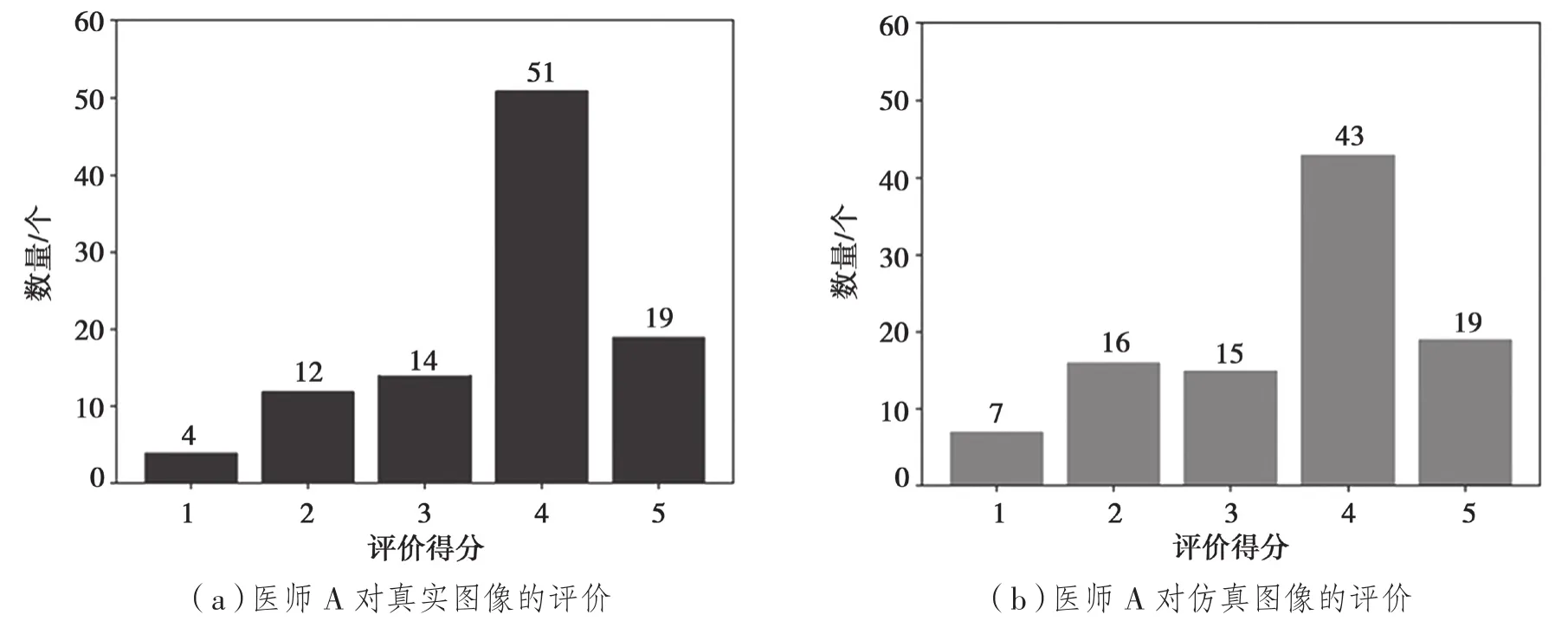

為了對模型輸出的仿真PET/CT圖像的真實程度進行評估,設計了一個“類圖靈測試”方法,即取100張原始數據中的真實PET/CT圖像和100張模型生成的仿真PET/CT圖像進行混合,再由兩位有經驗的放射科醫師(其中,醫師A有3年從業經驗,醫師B有2年從業經驗)對圖像進行評價。評價標準是對圖像進1~5分的打分,其中1分表示圖像質量非常差,5分表示圖像質量非常好。

3.2 測試結果

經過統計,最終的測試結果如圖6所示。其中:圖6(a)和圖6(b)分別表示醫師A對真實圖像和仿真圖像的評價,真實圖像的平均得分為3.69分(計算算方法為所有柱形圖橫縱坐標乘積的和除以圖像總數100,下同),仿真圖像的平均得分為3.51分;圖6(c)和圖6(d)分別表示醫師B對真實圖像和仿真圖像的評價,真實圖像的平均得分為3.63分,仿真圖像的平均得分為3.58分。通過測試結果可以看出:對于提出的基于CycleGAN的模型生成的仿真圖像,醫師A和醫師B都給出了略低于真實圖像的評分,但總體上兩種圖像的得分差異不大。因此,可以認為即使是專業的醫師也很難將提出模型所生成的模擬PET/CT圖像與真實PET/CT圖像完全區分開來,證明了提出的基于CycleGAN的仿真PET/CT圖像生成方法的有效性。

圖6 兩位醫師對真實圖像和生成的仿真圖像的評分

4 結 語

本文提出了一種基于CycleGAN的仿真PET/CT圖像生成方法,詳細介紹了該方法的原理、模型結構以及訓練過程。該方法可以基于真實的PET/CT圖像對其特征進行重新組合,生成與輸入圖像有所不同但擁有相同特征的仿真圖像,可以有效對已有的真實PET/CT圖像數據集進行數據擴充,從而實現將PET/CT圖像用于基于卷積神經網絡的癌癥早期診斷模型的訓練工作。實驗過程中,將來自NSCLC Radiogenomics數據集的肺部PET/CT圖像用于提出的模型訓練,生成了若干仿真PET/CT圖像,并經過兩名有經驗的放射科醫師對實驗結果的評價,初步證明:提出的基于CycleGAN的仿真PET/CT圖像生成模型可以有效產生可用于訓練癌癥早期診斷的卷積神經網絡模型的仿真PET/CT圖像。未來將要嘗試除肺部PET/CT圖像以外的其他人體器官或部位的仿真PET/CT圖像的生成,并設計基于卷積神經網絡的癌癥早期診斷模型,嘗試聯合使用真實的PET/CT圖像和所提模型生成的仿真PET/CT圖像對人體各個部位的早期癌癥進行診斷。