雙向特征融合的快速精確任意形狀文本檢測

邊 亮 屈亞東 周 宇

①(北京航空航天大學(xué)電子信息工程學(xué)院 北京 100191)

②(中國科學(xué)技術(shù)大學(xué)信息科學(xué)技術(shù)學(xué)院 合肥 230026)

1 引言

自然場景文本檢測任務(wù)旨在定位自然場景中文本區(qū)域的位置,其在智能交通系統(tǒng)、可穿戴翻譯裝備、視覺輔助系統(tǒng)等智能系統(tǒng)中有著廣泛的應(yīng)用,近年來成為研究者關(guān)注的熱門話題之一。然而由于自然場景環(huán)境的復(fù)雜性,文本圖像的檢測可能受到形狀模糊、光照不均等影響,使得自然場景文本檢測技術(shù)的發(fā)展相較于傳統(tǒng)文檔檢測技術(shù)更加困難。

傳統(tǒng)文本檢測技術(shù)[1-3]依賴于人工設(shè)計(jì)的文本特征以及一些文本的先驗(yàn)信息,如紋理、筆畫寬度等。這些方法主要分為基于滑動窗口及基于聯(lián)通組件的方法,它們的精度低、速度慢。近年來,基于深度學(xué)習(xí)的方法在文本檢測中占據(jù)了主要地位。在深度學(xué)習(xí)發(fā)展的早期,文獻(xiàn)[4]首先采用MSER方法獲取候選文本組件,文獻(xiàn)[5]通過訓(xùn)練字符分類器生成文本顯著性圖。這些算法仍一定程度依賴于人工設(shè)計(jì)的特征。隨著目標(biāo)檢測和語義分割方法的發(fā)展,目前的文本檢測方法得到了很大的改進(jìn),主要分為基于分割的方法和基于回歸的方法。

基于分割的方法針對輸入圖像生成像素級標(biāo)簽。文獻(xiàn)[6]通過分辨屬于不同文本實(shí)例的鏈接來定位文本區(qū)域位置。文獻(xiàn)[2]提出了一種新的文本表征方式適用于曲形文本。文獻(xiàn)[7]從最小分割圖開始擴(kuò)充像素直至最大的分割圖結(jié)束,獲取文本連通區(qū)域,但非常耗時。文獻(xiàn)[8]將文本檢測視為實(shí)例分割問題,并基于Mask R-CNN提出了文本上下文模塊以及重評分機(jī)制來抑制假陽性文本案例。文獻(xiàn)[3]提出了一種新思路,通過多維向量之間的距離約束文本像素之間的關(guān)系,采用聚類操作分離相近文本實(shí)例。文獻(xiàn)[9]提出了一種可微二值化模塊,提升了文本檢測的性能。

基于回歸的方法的主要思想是根據(jù)從預(yù)置錨框或像素點(diǎn)所預(yù)測的回歸框偏置來生成文本檢測框。借鑒目標(biāo)檢測領(lǐng)域相關(guān)算法,Textboxes++[10]直接預(yù)測回歸預(yù)置框的四邊形或多方向矩形框來檢測任意方向的文本區(qū)域;文獻(xiàn)[11]首先預(yù)測一系列小文本框,然后將屬于同一大文本框的小文本框進(jìn)行合并得到最終檢測結(jié)果。與上述基于框偏置不同,文獻(xiàn)[12]采用了另一種回歸方式,直接預(yù)測文本實(shí)例內(nèi)部像素各點(diǎn)到文本框4個頂點(diǎn)的偏置或到4個邊界的距離。文獻(xiàn)[13]通過直接回歸模塊生成文本的四邊形預(yù)測框并進(jìn)行迭代優(yōu)化,從而逐漸感知到整個長文本。

上述方法的主要不同在于:傳統(tǒng)的文本檢測方法工作量大,后處理復(fù)雜,速度慢,效果差;早期的基于深度學(xué)習(xí)方法一定程度需要人為設(shè)計(jì)特征,相對簡單,后處理仍比較復(fù)雜,速度中等;基于分割和回歸的場景文本檢測方法不需要手工設(shè)計(jì)特征,后處理簡單,速度快,效果好。其中,基于分割的方法一般先將文本從圖像中分割出來,然后進(jìn)行閾值處理來得到文本區(qū)域的邊界框。而基于回歸的方法一般直接回歸出文本區(qū)域的邊界框,速度通常比基于分割的方法快,但是其對長文本及曲形文本的檢測效果仍難以令人滿意。

本文提出一種新的文本檢測方案來解決上述兩個問題以實(shí)現(xiàn)精確的任意場景文本檢測。首先通過特征金字塔網(wǎng)絡(luò)(Feature Pyramid Network,FPN)生成多尺度特征圖,隨后構(gòu)建整體文本區(qū)域預(yù)測和縮小文本區(qū)域預(yù)測兩個平行分支本,提出了雙向特征融合模塊對兩個分支的特征進(jìn)行融合處理,最終經(jīng)過簡單的后處理步驟對縮小文本區(qū)域分割圖進(jìn)行放大即可得到文本實(shí)例的檢測結(jié)果。

本文的主要貢獻(xiàn)有3個方面:(1)提出一種新穎的文本實(shí)例重建方式,可將中心分割圖快速準(zhǔn)確地重建出完整的文本區(qū)域,與目前的方法相比可以在后處理階段節(jié)省很多計(jì)算消耗;(2)提出的雙向特征融合模塊可更好地融合文本語義特征,從而生成非常有效的文本特征;(3)提出的方法在SCUTCTW1500, Total-Text以及MSRA-TD500上分別可以獲得83.5%, 85.7%, 85.9%的F綜合指標(biāo),檢測速度可以分別達(dá)到15.2, 16, 17.1FPS,很好地實(shí)現(xiàn)了精度和速度的權(quán)衡。

2 模型構(gòu)建

2.1 網(wǎng)絡(luò)工作流程

如圖1所示,文本圖像經(jīng)過ResNet進(jìn)行特征提取,經(jīng)過FPN特征融合及通道級聯(lián)之后,生成特征圖f;特征圖f通過兩個分支處理之后經(jīng)過雙向特征融合模塊生成具有很強(qiáng)的特征表示能力的特征圖p5和p6,分別用于預(yù)測完整和縮小的文本區(qū)域圖。其中f1到f5是ResNet的5個階段, h1到h4是FPN的4個特征圖。縮小的文本區(qū)域圖經(jīng)過重建算法進(jìn)行后處理,得到最終檢測結(jié)果。

2.2 特征提取階段

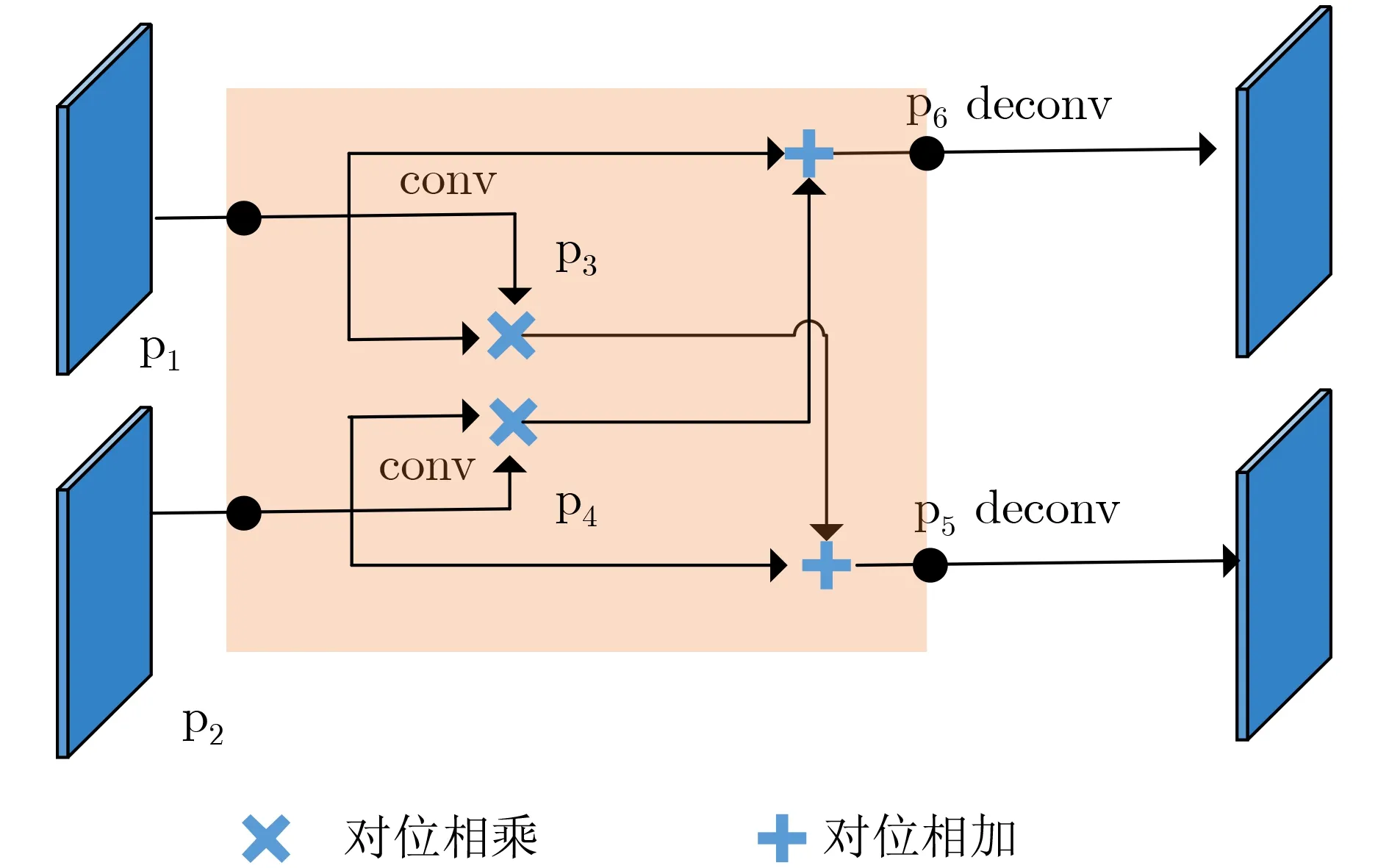

圖1 雙向特征融合模塊內(nèi)部網(wǎng)絡(luò)示意圖

圖2 網(wǎng)絡(luò)結(jié)構(gòu)圖

本文使用ResNet和FPN進(jìn)行特征提取和融合,并且ResNet使用了可變形卷積[14]。如圖2所示,首先進(jìn)行下采樣,從而分別得到特征圖f1, f2,f3, f4, f5。從f1到f5的分辨率依次降低為前者的1/2,包含的語義信息越來越豐富。小尺度的特征圖如f5有利于大文本的檢測,大尺度的特征圖如f2對于小文本檢測至關(guān)重要。然后,f5, f4, f3依次經(jīng)過上采樣兩倍之后分別與f4, f3, f2進(jìn)行特征融合,分別得到特征圖h3, h2, h1。最后特征圖h4, h3, h2分別上采樣到h1的大小,與h1級聯(lián),得到特征圖f。f融合了具有不同感受野和語義信息的特征圖,從而對于不同尺度的文本具有更強(qiáng)的檢測能力。

2.3 雙向特征融合模塊

本文提出雙向特征融合模塊有效地檢測相鄰文本。特征融合[15]能顯著提升網(wǎng)絡(luò)性能,廣泛應(yīng)用于深度學(xué)習(xí)的任務(wù)中。盡管特征提取階段的FPN已經(jīng)使用了特征融合,但是這對于檢測背景復(fù)雜的文本還是不夠的,因此本文提出了雙向特征融合模塊。如圖1所示,p1經(jīng)過3×3的特征圖處理之后得到p3,p1與p3相乘之后與p2相加得到p5。類似地,p2經(jīng)過3×3的卷積處理之后得到p4, p4和p2相乘之后與p1相加得到p6。雙向特征融合模塊能使兩個分支的信息互相監(jiān)督,彼此受益,從而促進(jìn)網(wǎng)絡(luò)優(yōu)化。此外,還能融合上下文的尺寸信息,實(shí)現(xiàn)特征信息的互補(bǔ),得到更準(zhǔn)確的檢測結(jié)果。

2.4 預(yù)測階段

本文提出了一種新的預(yù)測分支模塊,如圖1所示,p6和p5經(jīng)過步長為2的反卷積進(jìn)行上采樣到原圖大小之后,分別用于預(yù)測完整和縮小的文本區(qū)域圖。縮小的文本區(qū)域中不同的實(shí)例的間距變大,因此能有效地將相鄰文本區(qū)分開。但縮小的文本區(qū)域并不是完整的文本實(shí)例,想要得到完整的文本邊界框需要額外的后處理。因?yàn)橥暾奈谋緟^(qū)域包括了很多邊界信息,而網(wǎng)絡(luò)對于邊界信息是非常敏感的,因此本文預(yù)測了完整的文本區(qū)域圖,進(jìn)一步優(yōu)化網(wǎng)絡(luò),降低了檢測過程的漏檢率。本文的實(shí)現(xiàn)中分別使用1個1×1的卷積來預(yù)測完整和縮小文本區(qū)域圖。完整文本區(qū)域圖和縮小文本區(qū)域圖中每個像素點(diǎn)的預(yù)測值都在0~1范圍內(nèi),表示該像素點(diǎn)屬于文本的概率。

2.5 實(shí)例重建算法

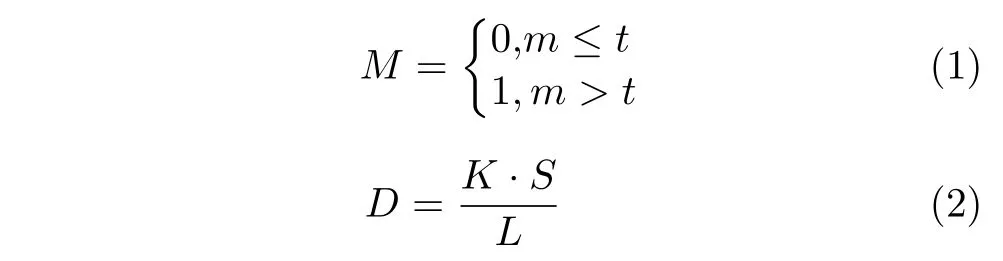

一般基于分割的文本檢測算法的后處理都非常復(fù)雜且耗時,本文提出了一個非常簡單有效的文本重建算法,主要包括如下操作:(1)閾值處理。對預(yù)測的縮小的文本區(qū)域圖使用固定的閾值 t進(jìn)行如式(1)的二值化操作,得到文本區(qū)域二值圖;(2)去噪。得到每個文本實(shí)例的最小外接矩形,計(jì)算每個實(shí)例的面積與外接矩形框的比例作為文本實(shí)例的置信度,濾除置信度低的區(qū)域;(3)輪廓生成。得到二值圖中每個文本實(shí)例的輪廓圖;(4)擴(kuò)張。使用放大比例系數(shù) K,計(jì)算出每個文本需要擴(kuò)張的像素個數(shù) D,使用Vatti’s clipping algorith對縮小的文本區(qū)域進(jìn)行擴(kuò)張。 D的計(jì)算公式如式(2)所示

其中,S和L分別表示縮小的文本區(qū)域的面積和周長。

2.6 標(biāo)簽生成

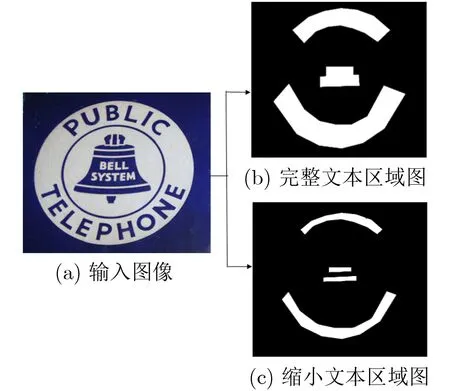

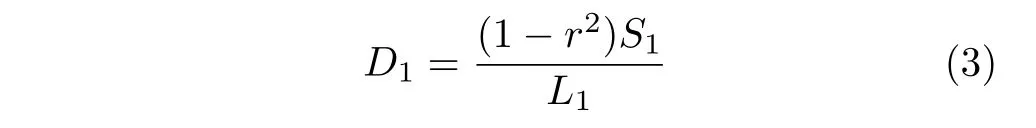

預(yù)測完整和縮小的文本區(qū)域圖,需要對應(yīng)的兩種標(biāo)簽進(jìn)行網(wǎng)絡(luò)模型的訓(xùn)練。標(biāo)簽的生成過程如圖3所示。對于完整的文本實(shí)例標(biāo)簽,本文直接將多邊形標(biāo)注的區(qū)域設(shè)置為1,將其他區(qū)域設(shè)置為0。對于縮小的文本區(qū)域的標(biāo)簽生成,與DB[9]一樣,訓(xùn)練數(shù)據(jù)中的多邊形標(biāo)注框是由一系列2維坐標(biāo)點(diǎn)表示的,因此可以采用 Vatti’s clipping algorithm將多邊形區(qū)域向內(nèi)縮小D1個像素。其中,D1是由該多邊形框的周長L1和面積S1共同決定的,用公式表示則為

圖3 標(biāo)簽生成示意圖

2.7 損失函數(shù)

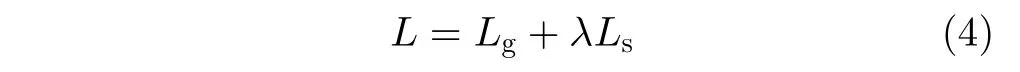

整體的損失函數(shù)是預(yù)測階段各個分支的加權(quán)和,用公式可以表達(dá)為

其中,Lg為完整文本區(qū)域分割圖的損失函數(shù),Ls為縮小文本區(qū)域分割圖的損失函數(shù),λ為平衡系數(shù),本文設(shè)置為1。

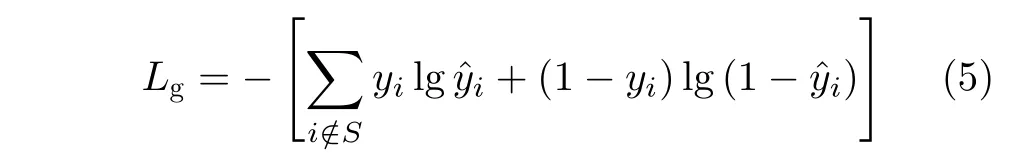

本文使用二值交叉熵?fù)p失來計(jì)算Lg。此外,為避免正負(fù)樣本嚴(yán)重不平衡,使得網(wǎng)絡(luò)偏向于預(yù)測背景區(qū)域,我們在損失函數(shù)中加入了難樣本挖掘處理,完整文本區(qū)域分割圖的損失函數(shù)用公式表示為

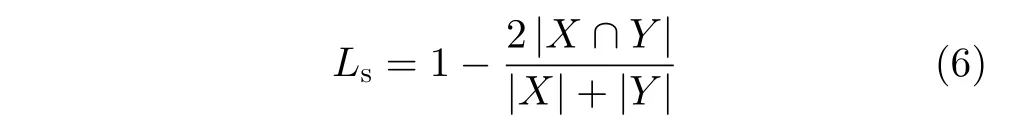

其中, y?i表示預(yù)測結(jié)果,yi是標(biāo)簽,S是對圖像進(jìn)行正負(fù)樣本比例為1:3的采樣樣本。Ls采用的是Dice損失函數(shù)。Dice損失函數(shù)是用于度量集合相似度的一種函數(shù),其公式為

其中,X和Y分別表示預(yù)測結(jié)果和標(biāo)簽,| X ∩Y|表示X和Y的交集,| X|+|Y|表示X和Y的并集。

3 實(shí)驗(yàn)結(jié)果及分析

3.1 數(shù)據(jù)集

本文在實(shí)驗(yàn)過程中共涉及了SynthText[16]、曲形文本數(shù)據(jù)集SCUT-CTW1500[17], Total-Text[18]以及四邊形文本數(shù)據(jù)集MSRA-TD500[19]。

3.2 實(shí)驗(yàn)結(jié)果評價(jià)指標(biāo)

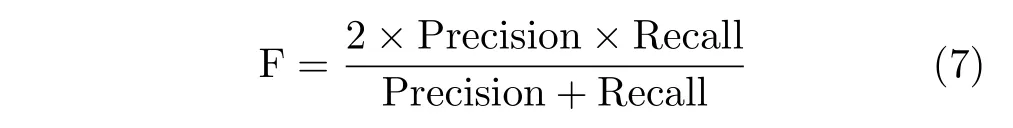

本文選取場景文本檢測常用的3個評價(jià)指標(biāo):準(zhǔn)確率(Precision)、召回率(Recall)和F綜合指標(biāo)(F-measure)來評價(jià)模型性能。準(zhǔn)確率為檢測結(jié)果中正確檢測的文本占實(shí)際被檢測文本的總數(shù)的比例,召回率表示正確檢測的文本數(shù)占正樣本數(shù)的比例,F(xiàn)綜合指標(biāo)則為準(zhǔn)確率與召回率的調(diào)和平均值,其計(jì)算方式為

3.3 實(shí)驗(yàn)平臺及模型參數(shù)

實(shí)驗(yàn)所用到的軟硬件環(huán)境為:1塊NVIDIA 1080Ti顯卡。操作系統(tǒng)為Ubuntu16.04,使用Pytorch框架實(shí)現(xiàn)。

本文使用在SynthText[16]上預(yù)訓(xùn)練1輪的Res-Net50模型作為基礎(chǔ)網(wǎng)絡(luò),隨后使用各目標(biāo)數(shù)據(jù)集的官方訓(xùn)練數(shù)據(jù)進(jìn)行相應(yīng)的訓(xùn)練。數(shù)據(jù)增廣方式包括訓(xùn)練圖像的隨機(jī)水平翻轉(zhuǎn)、旋轉(zhuǎn)、縮放以及裁剪。訓(xùn)練批量大小設(shè)定為16,參數(shù)優(yōu)化采用隨機(jī)梯度下降法,且權(quán)重衰減設(shè)為0.0001,梯度沖量設(shè)為0.9,初始學(xué)習(xí)率為0.007。

3.4 模型消融實(shí)驗(yàn)

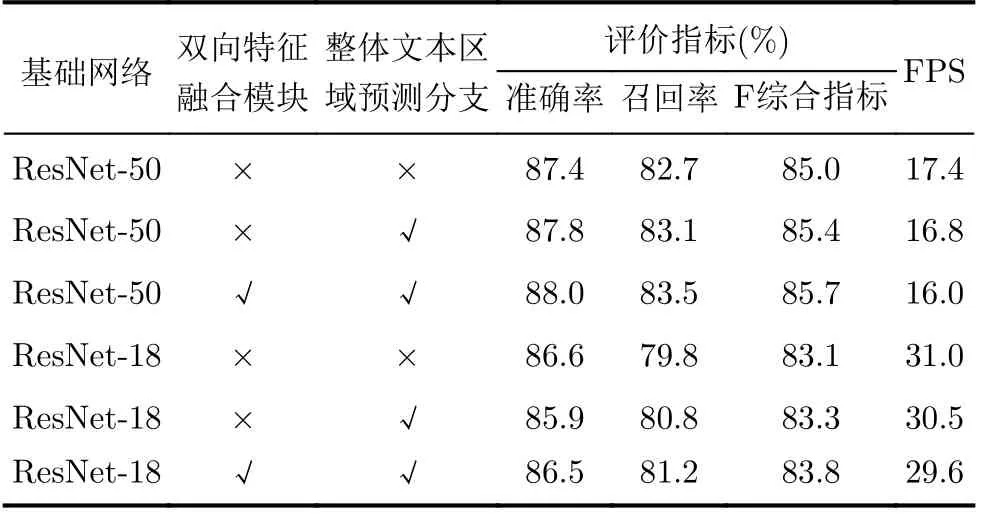

為了驗(yàn)證本文所提出方法的有效性,本文進(jìn)行了相關(guān)模塊的消融實(shí)驗(yàn),同時將更換ResNet50基礎(chǔ)網(wǎng)絡(luò)為ResNet18進(jìn)行相關(guān)實(shí)驗(yàn)。

雙向特征融合模塊:本文首先驗(yàn)證雙向特征融合模塊對于模型整體性能的影響,該對比實(shí)驗(yàn)固定模型其余部分網(wǎng)絡(luò)結(jié)構(gòu)以及學(xué)習(xí)率等影響因素,僅針對雙向特征融合模塊進(jìn)行消融。

表1對比第2, 3行及5, 6行為雙向特征融合模塊的消融實(shí)驗(yàn)結(jié)果,可以看出,雙向特征融合模塊分別在準(zhǔn)確率、召回率及F綜合指標(biāo)方面獲得了0.2%,0.4%及0.3%的提升,在檢測速度方面只有0.8FPS的差距,ResNet18基礎(chǔ)網(wǎng)絡(luò)也在添加了雙向特征融合模塊之后,F(xiàn)綜合指標(biāo)有0.5%的提升。并且檢測速度方面僅低0.9FPS。

整體文本區(qū)域圖:網(wǎng)絡(luò)通過縮小文本區(qū)域預(yù)測分支來分辨相鄰的文本實(shí)例,增加整體文本區(qū)域預(yù)測分支來學(xué)習(xí)整個文本實(shí)例分割圖,讓網(wǎng)絡(luò)對整體文本區(qū)域敏感。表1對比第1, 2行及4, 5行可以看到,基于ResNet50基礎(chǔ)網(wǎng)絡(luò)整體文本區(qū)域預(yù)測分支可以將網(wǎng)絡(luò)F綜合指標(biāo)提升0.4%,且網(wǎng)絡(luò)檢測速度相當(dāng)。而基于ResNet18基礎(chǔ)網(wǎng)絡(luò),整體文本區(qū)域預(yù)測分支的加入也提升了0.2%的F綜合指標(biāo),且檢測速度僅有0.5FPS的下降。

基礎(chǔ)網(wǎng)絡(luò):對比表1中1, 4行或2, 5行可以看出基于基礎(chǔ)網(wǎng)絡(luò)ResNet50的模型的表現(xiàn)相較于ResNet18分別在F綜合指標(biāo)方面有1.9%, 2.1%的提升,而基于ResNet18基礎(chǔ)網(wǎng)絡(luò)的模型也因?yàn)榫W(wǎng)絡(luò)層數(shù)較淺,在檢測速度方面表現(xiàn)更好。

表1 雙向特征融合模塊及整體文本框分支在不同基礎(chǔ)網(wǎng)絡(luò)下的性能增益及檢測效率

3.5 本文方法與先進(jìn)方法的比較

3.5.1 Total-Text數(shù)據(jù)集測評

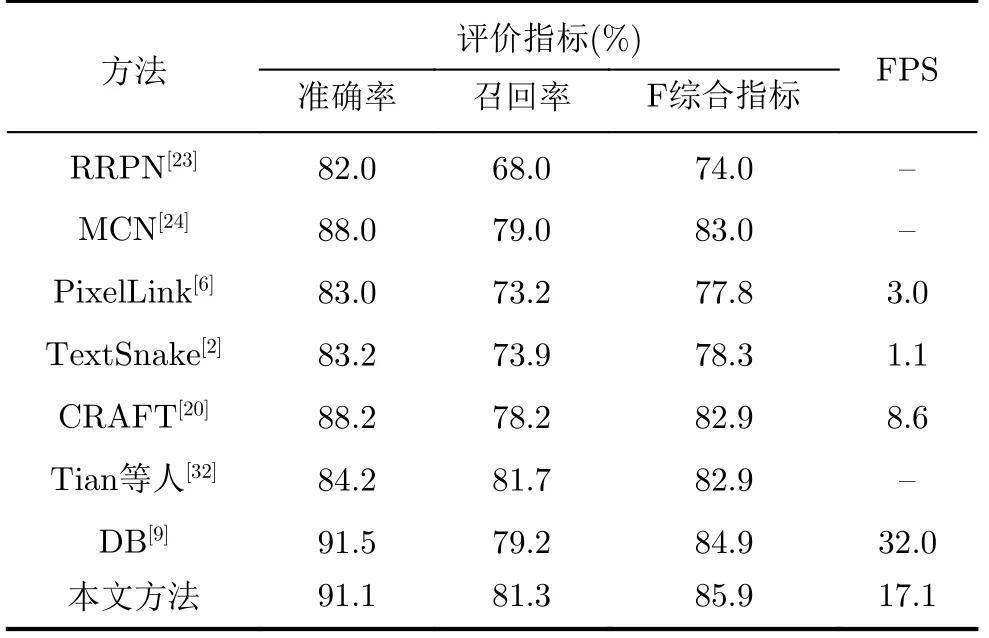

如表2所示,本文方法在Total-Text[18]數(shù)據(jù)集上取得了準(zhǔn)確率88.0%,召回率83.5%及F綜合指標(biāo)85.7%的結(jié)果,相較于表中的方法在F綜合指標(biāo)上取得了最好的結(jié)果,且超出最好方法1%(85.7% vs.84.7%)。相較于針對曲形文本提出的場景文本檢測方法TextSnake[2], PSENet[7]等,本文方法相比于其中最高性能方法在F綜合指標(biāo)上提升了3.8%,并可以達(dá)到檢測速度16FPS,與PSENet[7]的檢測速度相比是4倍。盡管CRAFT[20]使用了字符級的圖像標(biāo)注信息來指導(dǎo)網(wǎng)絡(luò)的學(xué)習(xí),本文方法在準(zhǔn)確率、召回率及F綜合指標(biāo)分別提升0.4%, 3.6%, 2.1%。與DB[9]相比雖速度方面有些差距,但在精度方面本文分別在準(zhǔn)確率、召回率及F綜合指標(biāo)上超出其0.9%,1%, 1%。

3.5.2 MSRA-TD500數(shù)據(jù)集測評

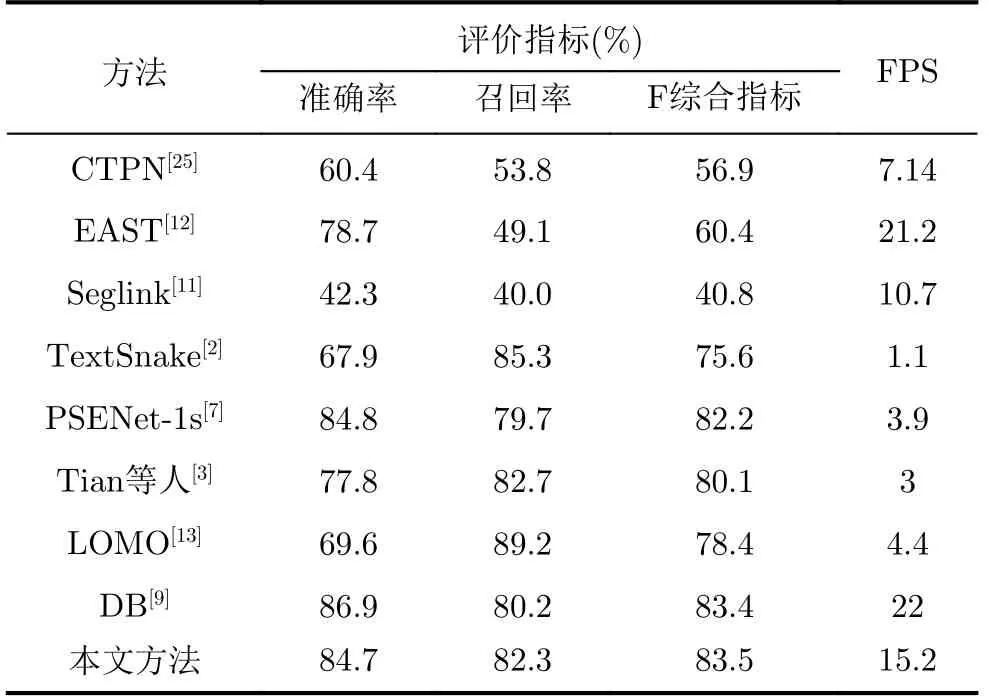

不同方法在MSRA-TD500[19]數(shù)據(jù)集上的定量檢測結(jié)果如表3所示。從表3可以看出,本文方法相比于目前最好方法DB在召回率及F綜合指標(biāo)上分別超出了2.1%, 1%,且在檢測速度方面也達(dá)到了較為可觀的數(shù)值。

3.5.3 SCUT-CTW1500數(shù)據(jù)集測評

如表4所示,本方法取得了準(zhǔn)確率84.7%,召回率82.3%,F(xiàn)綜合指標(biāo)83.5%的結(jié)果,不僅F綜合指標(biāo)相較于其他方法有提升,檢測速度也達(dá)到了15.2FPS,優(yōu)于PSENet[7]。盡管LOMO[13]中的迭代矯正模塊對長文本的檢測效果有不錯的提升,本文方法仍在F綜合指標(biāo)上比其高出了5.1%(83.5% vs.78.4%)。

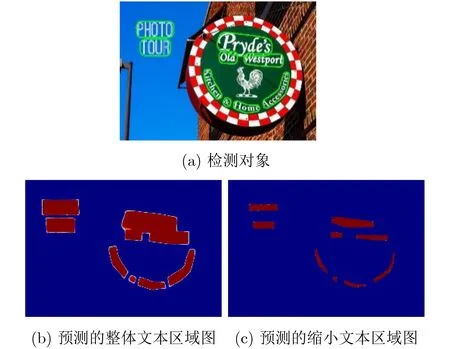

圖4(b)、圖4(c)分別為對圖4(a)的整體和縮小文本區(qū)域分割圖的預(yù)測結(jié)果。從圖4(c)可以看出,縮小文本區(qū)域分割圖可以將整體分割圖中因距離較近互相粘連的文本區(qū)域分開,最終對文本實(shí)例精確定位。圖4(b)、圖4(c)也驗(yàn)證了本文的網(wǎng)絡(luò)結(jié)構(gòu)可以適應(yīng)于任意形狀文本實(shí)例。

表2 TotalText數(shù)據(jù)集模型性能對比

表3 MSRA-TD500數(shù)據(jù)集模型性能對比

表4 CTW1500數(shù)據(jù)集模型性能對比

圖5是不同方法在3個數(shù)據(jù)集上的速度和精度比較,F(xiàn)PS表示每秒運(yùn)行幾幀。圖6是3個測試數(shù)據(jù)集上的檢測結(jié)果,從圖中可以看出,本文的方法可以精確定位文本,并對于距離較近的文本實(shí)例也能正確分割。

3.6 缺點(diǎn)與不足

盡管本文的方法能在多個公開數(shù)據(jù)集上取得最好的效果,但是由于場景文本背景的復(fù)雜性,字體大小、形狀、顏色等的多樣性,本文的方法對于一些極端的文本仍然存在檢測困難的問題。

圖4 檢測的最終結(jié)果

圖5 不同方法在3個數(shù)據(jù)集上的速度-精度對比

如圖7所示,圖7(a)顯示的是本文方法對于特別長的文本存在檢測不完整的問題,這是網(wǎng)絡(luò)的感受野不夠大導(dǎo)致的,可以通過使用空洞卷積來解決這個問題,但是這將會降低網(wǎng)絡(luò)的速度。圖7(b)顯示的是對于一些字符與字符之間距離很大的文本,模型會將它檢測為多個文本實(shí)例,這是缺乏足夠的上下文信息和語言模型導(dǎo)致的,即使是人也很難分辨出來。圖7(c)顯示的是,在背景非常復(fù)雜的情況下,一些外形類似于文本的目標(biāo)很容易被檢測為文本,主要是因?yàn)檫@些目標(biāo)的外形與文本的筆畫很相似。圖7(d)揭示的是對于一些在水平方向和垂直方向都存在靠得很近的相鄰文本的時候,在只基于圖像的視覺信息而沒有加入語意信息進(jìn)行檢測的時候,模型很難辨別出文本應(yīng)該是從水平方向讀取還是從垂直方向讀取。圖7(e)和圖7(f)顯示的是模型對于一些非常小的文本可能存在漏檢的問題,這是因?yàn)榻?jīng)過多次下采樣之后,這些小的文本區(qū)域已經(jīng)變得非常小了,會被模型當(dāng)成是噪聲過濾掉。上述的問題是文本檢測存在的普遍問題,它們共同的最主要的原因是訓(xùn)練集中缺乏相應(yīng)的文本,使得模型無法學(xué)習(xí)到相關(guān)知識。

4 結(jié)束語

圖6 不同數(shù)據(jù)集模型的測試結(jié)果可視化圖

圖7 模型檢測錯誤的一些例子

首先,為了有效地區(qū)分相鄰文本實(shí)例,本文設(shè)計(jì)了縮小和整體兩個并行的文本區(qū)域預(yù)測分支。其中前者可以準(zhǔn)確地分離粘連的文本實(shí)例,而后者能夠通過預(yù)測圖像中文本實(shí)例的整體文本區(qū)域分割圖來輔助整體網(wǎng)絡(luò)優(yōu)化以及縮小文本區(qū)域預(yù)測分支的學(xué)習(xí)。其次,本文提出了雙向特征融合模塊用于充分融合兩個分支所獲取的文本語義信息以及提升文本檢測的精度。最后,為了解決現(xiàn)有方法存在的檢測速度過慢的問題,本文設(shè)計(jì)了一個簡單高效的文本重建算法。在3個公開數(shù)據(jù)集上的實(shí)驗(yàn)證明,本文的方法在F綜合指標(biāo)上超越了現(xiàn)有方法,并且達(dá)到了與現(xiàn)有最快的方法相當(dāng)?shù)乃俣龋浞肿C明了本文方法的有效性和高效性。后續(xù)工作計(jì)劃將網(wǎng)絡(luò)進(jìn)行進(jìn)一步擴(kuò)展,構(gòu)成端到端文本檢測識別系統(tǒng)。