融合深度信息的雙向人流量統(tǒng)計(jì)方法的研究與實(shí)現(xiàn)

張文利, 王 寧, 郭 向, 楊 堃, 馬 超, 朱清宇

(1.北京工業(yè)大學(xué) 信息學(xué)部,北京 100124; 2.中建科技集團(tuán)有限公司,北京 100070)

智慧建筑利用物聯(lián)網(wǎng)、云計(jì)算、智能感知等現(xiàn)代信息技術(shù),實(shí)現(xiàn)自然環(huán)境與人的溝通與交互。智慧建筑始終應(yīng)以人為服務(wù)中心,相關(guān)研究[1]表明人們每天80%~90%的時(shí)間都處于室內(nèi)建筑環(huán)境中,為給室內(nèi)人員提供更好的體驗(yàn),因此感知室內(nèi)人員及人員流動(dòng)狀況成為智慧建筑的基礎(chǔ)前提。在室內(nèi)辦公區(qū),人流量統(tǒng)計(jì)數(shù)據(jù)能夠?yàn)樽詣?dòng)化控制建筑內(nèi)部的溫濕度、光線(xiàn)強(qiáng)度、電梯規(guī)劃、工位規(guī)劃等提供可靠數(shù)據(jù)支撐,營(yíng)造舒適、人性化的辦公環(huán)境。對(duì)于商場(chǎng)店鋪而言,參考客流量信息分析客戶(hù)的購(gòu)物習(xí)慣和偏好,統(tǒng)籌商場(chǎng)布局、布置商品貨柜,避免商品資源浪費(fèi)。而走廊等狹窄環(huán)境光照條件較昏暗,存在擁擠、踩踏等安全隱患,通過(guò)掌握該場(chǎng)景中的人流數(shù)量及流動(dòng)方向,能夠?qū)崟r(shí)評(píng)估場(chǎng)所的擁擠程度,從而做到提前預(yù)警和指導(dǎo)疏散引流措施的部署。

綜上所述,人流量統(tǒng)計(jì)技術(shù)不僅為智慧建筑的自動(dòng)化、智慧化控制提供了可靠的判斷依據(jù),同時(shí)在資源合理調(diào)配以及公共安全防控等方面發(fā)揮著重要作用,具有廣泛的應(yīng)用前景和社會(huì)價(jià)值。

目前,為滿(mǎn)足多個(gè)應(yīng)用場(chǎng)景的需求,人流量統(tǒng)計(jì)方法分為縱向、橫向人流量統(tǒng)計(jì)方法,其中橫向人流量統(tǒng)計(jì)即對(duì)從左向右和從右向左運(yùn)動(dòng)的人員進(jìn)行計(jì)數(shù);縱向人流量統(tǒng)計(jì)即對(duì)遠(yuǎn)離攝像頭和接近攝像頭的人員分別進(jìn)行計(jì)數(shù)。

① 縱向人流量統(tǒng)計(jì)方法[2-10]。韓曉微等[2]通過(guò)判斷RGB視頻幀中目標(biāo)的的初始位置和結(jié)束位置與門(mén)的相對(duì)位置關(guān)系,對(duì)縱向行走的人進(jìn)行計(jì)數(shù)。張開(kāi)生[3]首先定義RGB視頻幀中進(jìn)入場(chǎng)景的正方向向量,然后計(jì)算目標(biāo)進(jìn)入場(chǎng)景和離開(kāi)場(chǎng)景的位置的向量與定義的正方向之間的夾角,若夾角大于90°則count加1,對(duì)縱向行走的人進(jìn)行計(jì)數(shù)。劉軍[7]通過(guò)基于加權(quán)的K近鄰多目標(biāo)跟蹤算法跟蹤每一個(gè)確認(rèn)的人頭目標(biāo),檢測(cè)目標(biāo)是否穿過(guò)虛擬線(xiàn)對(duì)人流量進(jìn)行計(jì)數(shù)。周珂等[10]通過(guò)幀差法對(duì)運(yùn)動(dòng)目標(biāo)進(jìn)行檢測(cè),當(dāng)目標(biāo)未進(jìn)入檢測(cè)區(qū)域時(shí),只對(duì)目標(biāo)檢測(cè),不進(jìn)行跟蹤、畫(huà)框;目標(biāo)進(jìn)入檢測(cè)區(qū)域后,對(duì)目標(biāo)畫(huà)框,并進(jìn)行跟蹤;目標(biāo)離開(kāi)檢測(cè)區(qū)域后,對(duì)目標(biāo)進(jìn)行計(jì)數(shù)。

② 橫向人流量統(tǒng)計(jì)方法[11-13]。張小紅[11]應(yīng)用卡爾曼濾波的最近鄰匹配跟蹤算法對(duì)行人進(jìn)行實(shí)時(shí)跟蹤;根據(jù)人員在檢測(cè)線(xiàn)左邊(右邊)狀態(tài),對(duì)人員進(jìn)行左右方向的計(jì)數(shù)。楊亦樂(lè)等[12]通過(guò)DeepSORT對(duì)檢測(cè)到的行人進(jìn)行跟蹤,判斷連續(xù)兩幀目標(biāo)位置的連線(xiàn)與計(jì)數(shù)線(xiàn)是否相交決定是否對(duì)此行人進(jìn)行計(jì)數(shù)。

但是現(xiàn)有人流量統(tǒng)計(jì)方法仍存在以下問(wèn)題:

① 密集人群場(chǎng)景下,只能對(duì)左右或者上下方向人流量進(jìn)行統(tǒng)計(jì),不能提供全方位人流量信息。

② 現(xiàn)有多目標(biāo)跟蹤方法多采用IoU距離度量檢測(cè)邊框之間的位置相似度并進(jìn)行關(guān)聯(lián),但在目標(biāo)框頻繁重疊的密集人群中,僅基于IoU距離的關(guān)聯(lián)策略在密集人群中的可靠性較差。

③ 大多數(shù)RGB-D(RGB圖像+Depth圖像)多目標(biāo)跟蹤工作跟蹤過(guò)程仍沿用已有基于RGB圖像的跟蹤方法,難以判斷并處理跟蹤過(guò)程中的目標(biāo)遮擋。

④ 現(xiàn)有雙向人員計(jì)數(shù)方法多依據(jù)兩幀間目標(biāo)軌跡的二維坐標(biāo)變化,判斷人員過(guò)線(xiàn)時(shí)的運(yùn)動(dòng)方向,而對(duì)于不規(guī)則運(yùn)動(dòng)的目標(biāo)或相機(jī)視角變化情況易導(dǎo)致目標(biāo)過(guò)線(xiàn)方向判斷錯(cuò)誤。

針對(duì)現(xiàn)有人流量統(tǒng)計(jì)方法存在的問(wèn)題,為適應(yīng)全方位計(jì)數(shù)場(chǎng)景,本文提出了融合深度信息的雙向人流量統(tǒng)計(jì)方法,即對(duì)橫、縱雙向經(jīng)過(guò)計(jì)數(shù)區(qū)域的人員同時(shí)計(jì)數(shù),對(duì)人流量進(jìn)行全方位監(jiān)測(cè),創(chuàng)新點(diǎn)如下:

① 提出一種基于邊框IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略,結(jié)合目標(biāo)的位置相似度和深度相似度來(lái)提高目標(biāo)關(guān)聯(lián)的可靠性,降低匹配過(guò)程中的錯(cuò)誤和遺漏。

② 提出一種基于軌跡上下文深度差的目標(biāo)遮擋判斷策略,判斷目標(biāo)當(dāng)前的遮擋狀態(tài),并依據(jù)遮擋狀態(tài)優(yōu)化軌跡處理策略,以處理關(guān)聯(lián)過(guò)程中出現(xiàn)的人員遮擋問(wèn)題,恢復(fù)長(zhǎng)時(shí)間遮擋的軌跡。

③ 提出一種基于三維質(zhì)心坐標(biāo)的人員運(yùn)動(dòng)方向判斷方法,該方法依據(jù)軌跡在當(dāng)前幀的遮擋狀態(tài)、三維質(zhì)心坐標(biāo)以及軌跡在前N幀的三維質(zhì)心坐標(biāo),判斷當(dāng)前幀人員的運(yùn)動(dòng)方向,減少由于人員不規(guī)則運(yùn)動(dòng)或相機(jī)視角變化導(dǎo)致的過(guò)線(xiàn)方向判斷錯(cuò)誤。

1 總體框架

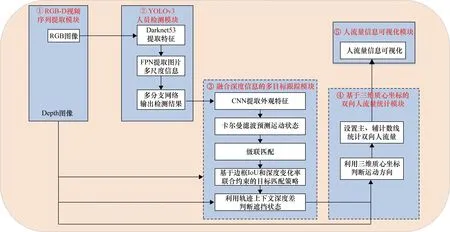

本文提出融合深度信息的雙向人流量統(tǒng)計(jì)方法的總體架構(gòu),如圖1所示。算法架構(gòu)步驟如下。

圖1 融合深度信息的雙向人流量統(tǒng)計(jì)方法框架

① RGB-D視頻序列提取模塊。利用Kinect相機(jī)同時(shí)拍攝特定場(chǎng)所的RGB圖像和深度圖像,并將RGB圖像與同一場(chǎng)景下的深度圖像進(jìn)行配對(duì),組成一組RGB-D圖像,輸出RGB-D視頻序列。

② YOLOv3[14]人員檢測(cè)模塊。將從上述步驟①中獲取的RGB視頻序列作為輸入,采用YOLOv3目標(biāo)檢測(cè)算法檢測(cè)行人頭部,獲取RGB視頻序列的當(dāng)前幀中所有人員的頭部區(qū)域邊框坐標(biāo)并輸出。

③ 融合深度信息的多目標(biāo)跟蹤模塊。將從步驟②中獲取到的行人頭部邊框坐標(biāo)作為輸入并將其標(biāo)記為行人軌跡的起始位置,對(duì)行人進(jìn)行跟蹤,其中利用深度變化率和邊框IoU優(yōu)化目標(biāo)匹配過(guò)程,聯(lián)合上下文深度差判斷遮擋狀態(tài),自適應(yīng)調(diào)整軌跡的更新和注銷(xiāo),優(yōu)化軌跡處理過(guò)程,輸出匹配成功的行人軌跡和遮擋狀態(tài)信息。

④ 基于三維質(zhì)心坐標(biāo)的雙向人流量統(tǒng)計(jì)模塊。將從步驟③中獲取到的行人運(yùn)動(dòng)軌跡和遮擋狀態(tài)作為輸入,依據(jù)軌跡遮擋狀態(tài)、三維質(zhì)心坐標(biāo)判斷當(dāng)前幀人員的運(yùn)動(dòng)方向,并根據(jù)人員運(yùn)動(dòng)方向和運(yùn)動(dòng)軌跡,對(duì)橫、縱雙向經(jīng)過(guò)主計(jì)數(shù)線(xiàn)的人員進(jìn)行計(jì)數(shù),并將計(jì)數(shù)結(jié)果、人員遮擋狀態(tài)、人員運(yùn)動(dòng)軌跡和橫、縱運(yùn)動(dòng)方向等信息輸出到步驟⑤。

⑤ 人流量信息可視化。統(tǒng)計(jì)并可視化人員數(shù)量,實(shí)時(shí)日志,人員運(yùn)動(dòng)軌跡,人員遮擋狀態(tài)和橫、縱運(yùn)動(dòng)方向。

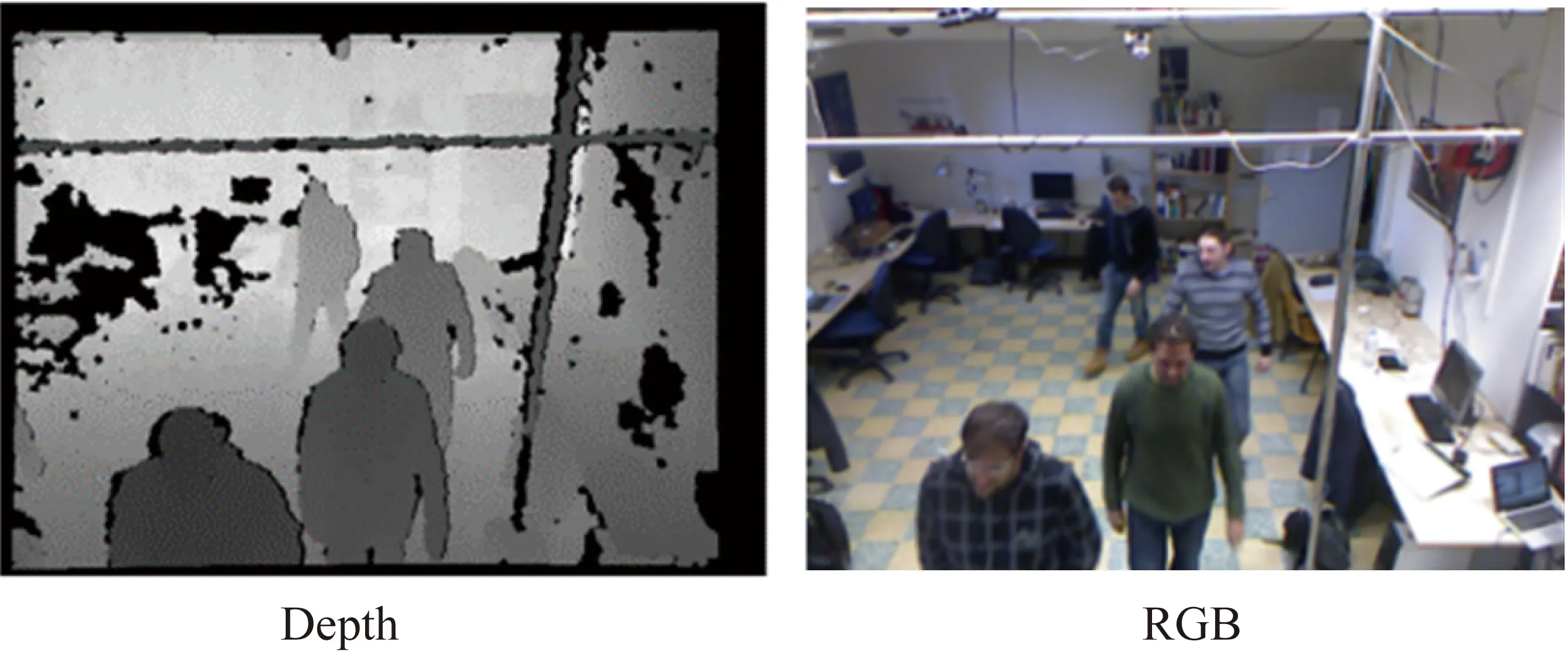

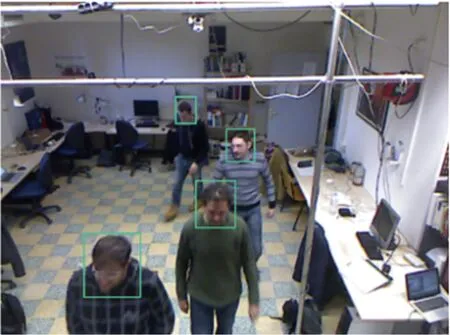

RGB-D視頻序列提取模塊得到成對(duì)圖像,如圖2所示。本文應(yīng)用YOLOv3目標(biāo)檢測(cè)算法檢測(cè)行人頭部,檢測(cè)結(jié)果如圖3所示。以下將對(duì)圖1中③、④模塊進(jìn)行詳細(xì)說(shuō)明。

圖2 視頻序列中RGB和深度圖像分組

圖3 檢測(cè)結(jié)果

1.1 融合深度信息的多目標(biāo)跟蹤模塊

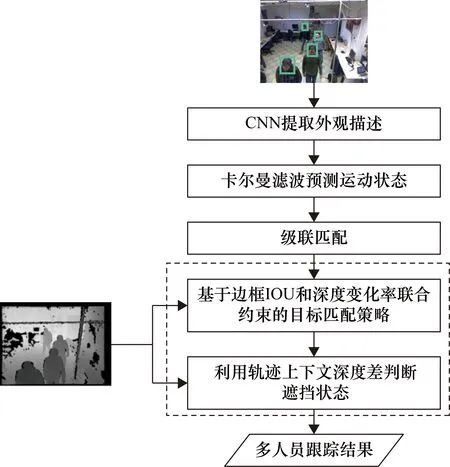

本文在DeepSORT算法[15]的基礎(chǔ)上引入場(chǎng)景深度信息,增加了“基于IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略”和“利用軌跡上下文深度差判斷遮擋狀態(tài)”兩個(gè)步驟,提高跟蹤匹配的精準(zhǔn)性和可靠性,總體流程如圖4所示。本模塊利用深度變化率對(duì)目標(biāo)軌跡進(jìn)行約束,提高目標(biāo)匹配的可靠性,同時(shí)聯(lián)合軌跡上下文深度差判斷目標(biāo)的遮擋狀態(tài),對(duì)目標(biāo)軌跡進(jìn)行優(yōu)化。

圖4 融合深度信息改進(jìn)的DeepSORT多目標(biāo)跟蹤算法

1.1.1 基于邊框IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略

如圖1中的模塊③所示,本步驟在利用DeepSORT算法中預(yù)訓(xùn)練的CNN網(wǎng)絡(luò)提取目標(biāo)的外觀描述后,通過(guò)卡爾曼濾波器預(yù)測(cè)獲得目標(biāo)的兩個(gè)運(yùn)動(dòng)信息:位置信息及位置的不確定性信息,為基于邊框IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略提供輸入數(shù)據(jù)。

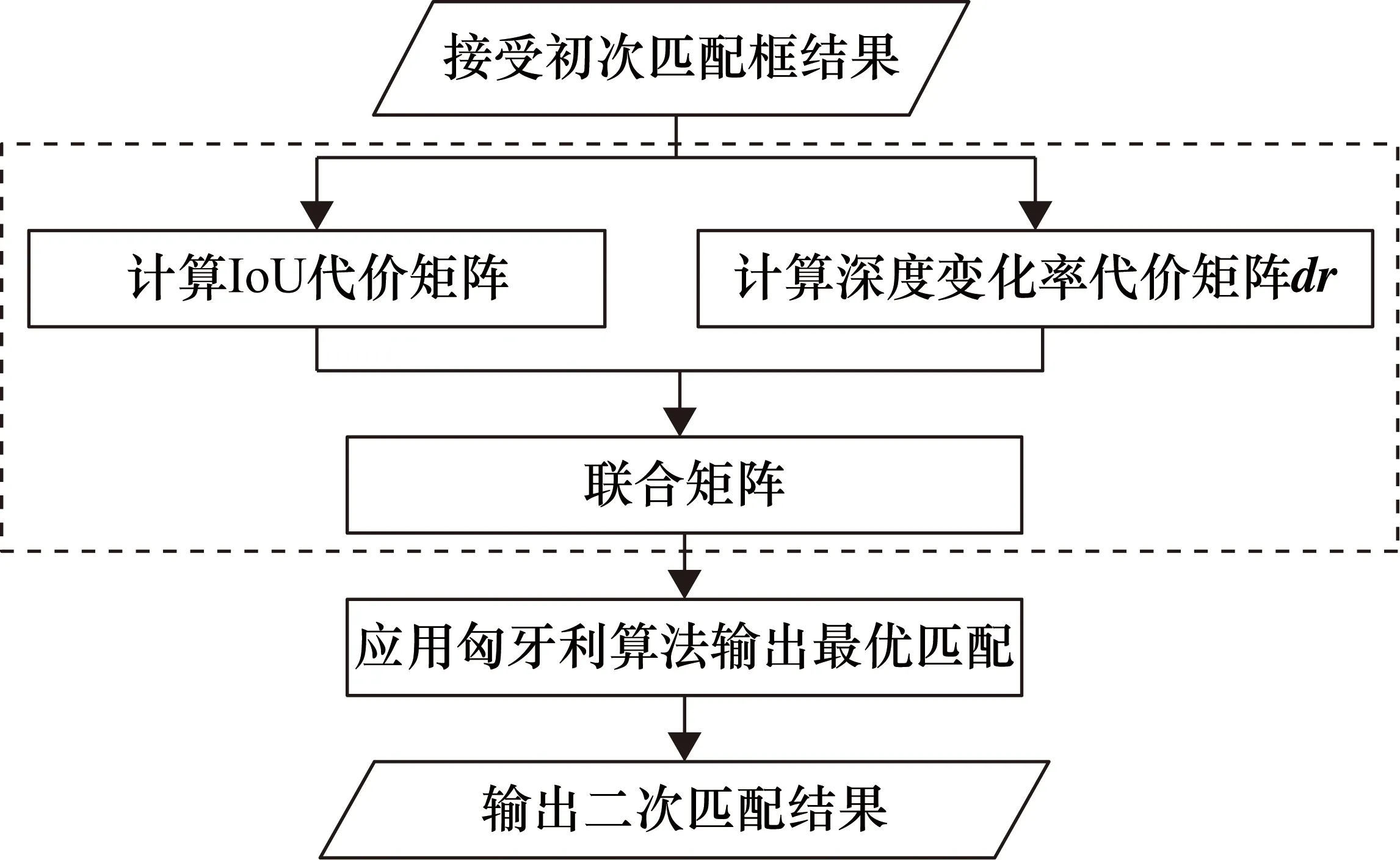

傳統(tǒng)方法使用硬間隔對(duì)IoU進(jìn)行分類(lèi),硬間隔即應(yīng)用超平面將所有值進(jìn)行正確分類(lèi)。但I(xiàn)oU硬間隔可靠性差,易導(dǎo)致匹配錯(cuò)誤。本文提出一種聯(lián)合約束目標(biāo)匹配方法,采用軟間隔的方式平滑決策邊界,即引入邊框IoU和深度變化率作為松弛量,允許有一定的分類(lèi)誤差,流程圖如圖5所示。深度變化率dr定義為:軌跡存儲(chǔ)的第i-1幀的平均深度值減去目標(biāo)在當(dāng)前第i幀的平均深度,最后除以100取百分?jǐn)?shù),計(jì)算公式如式(1)所示。

圖5 基于IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略

(1)

具體步驟如下。

① 計(jì)算IoU代價(jià)矩陣。計(jì)算初次匹配結(jié)果中所有未匹配軌跡的集合trk與未匹配檢測(cè)的集合det之間的IoU代價(jià)矩陣C,IoU代價(jià)可以通過(guò)式(2)和式(3)計(jì)算獲得。

(2)

(3)

② 計(jì)算深度變化率代價(jià)矩陣dr。獲取所有未匹配軌跡的深度均值Dtrk以及所有未匹配檢測(cè)結(jié)果的深度均值Ddet,并計(jì)算兩兩之間的深度變化率矩陣dr,其計(jì)算公式如下:

(4)

③ 聯(lián)合約束。采用軟間隔的方式平滑決策邊界: 若0.6≤Cij≤0.8,利用Cij和drij聯(lián)合約束代價(jià)矩陣;若Cij>0.8,表明二者位置相似度很低,drij≥0.8,表明二者深度相似度十分微小,上述兩種情況拒絕trki與detj關(guān)聯(lián);若0≤Cij≤0.6,表明二者的位置相似度具有較高的可靠性。聯(lián)合約束公式如下:

(5)

(6)

Cij=Cij,0≤Cij<0.7或Cij>0.8

(7)

Cij=1,drij≥0.8

(8)

④ 應(yīng)用匈牙利算法[16]輸出最優(yōu)匹配。本文將聯(lián)合約束后的代價(jià)矩陣C輸入到匈牙利算法中,獲得trk與det之間的最優(yōu)匹配結(jié)果。

1.1.2 利用軌跡上下文深度差判斷遮擋狀態(tài)

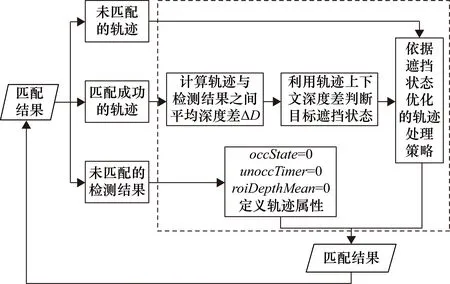

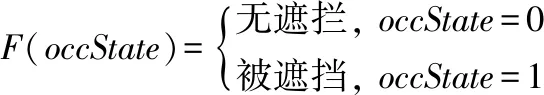

經(jīng)過(guò)1.1.1節(jié)的目標(biāo)匹配操作之后,需要對(duì)不同狀態(tài)的軌跡進(jìn)行后續(xù)處理和更新,在密集人群場(chǎng)景下,容易發(fā)生目標(biāo)長(zhǎng)時(shí)間被遮擋的情況,導(dǎo)致目標(biāo)跟丟。本文提出一種遮擋狀態(tài)判斷方法,基于軌跡上下文深度差的目標(biāo)遮擋判斷策略,如圖6所示。判斷人員在當(dāng)前幀的遮擋狀態(tài)下,利用遮擋狀態(tài)自適應(yīng)調(diào)整目標(biāo)最大存活時(shí)間max_ages,有效降低因目標(biāo)長(zhǎng)時(shí)間被遮擋導(dǎo)致跟丟的概率。

圖6 基于軌跡上下文深度差判斷遮擋狀態(tài)

軌跡上下文深度差是指包括當(dāng)前時(shí)刻在內(nèi),軌跡連續(xù)N幀的幀間深度差,幀間深度差ΔD定義為:當(dāng)前時(shí)刻檢測(cè)結(jié)果的深度均值Ddet與對(duì)應(yīng)的軌跡在上一時(shí)刻存儲(chǔ)的深度均值Dtrk之差的絕對(duì)值,計(jì)算方法如下:

ΔD=|Ddet-Dtrk|

(9)

具體算法如下。

① 定義軌跡屬性。對(duì)于每個(gè)初始化的軌跡賦予3個(gè)屬性參數(shù):occState,用于記錄當(dāng)前軌跡的遮擋狀態(tài);unoccTimer,用于記錄當(dāng)前軌跡保持無(wú)遮擋狀態(tài)的時(shí)間;roiDepthMean,當(dāng)前檢測(cè)結(jié)果或軌跡的平均深度值。

② 計(jì)算軌跡與檢測(cè)結(jié)果之間的深度差ΔD。首先需要計(jì)算二者的平均深度值,平均深度值roiDepthMean的計(jì)算方法如圖7所示,先將目標(biāo)邊框坐標(biāo)映射到深度圖像上,提取人員的頭部區(qū)域;本文中通過(guò)計(jì)算感興趣區(qū)域中所有非零元素的最小值,來(lái)填充深度缺失值,減少背景像素深度的干擾。進(jìn)一步以感興趣區(qū)域的中心點(diǎn)為中心,向外拓展6×6大小的矩形窗口,計(jì)算該矩形窗口下的深度均值作為感興趣區(qū)域的深度均值。最后獲得當(dāng)前時(shí)刻檢測(cè)結(jié)果的深度均值Ddet以及對(duì)應(yīng)的軌跡在上一時(shí)刻存儲(chǔ)的深度均值Dtrk,通過(guò)式(9)計(jì)算幀間深度差以用于后續(xù)遮擋判斷。

圖7 平均深度值的計(jì)算步驟

③ 利用軌跡上下文深度差判斷目標(biāo)的遮擋狀態(tài)。依據(jù)遮擋變化與深度變化之間的關(guān)聯(lián)性,本文利用軌跡上下文深度差判斷目標(biāo)的遮擋狀態(tài),當(dāng)前幀與上一幀目標(biāo)深度差過(guò)大時(shí)判定為目標(biāo)被遮擋,當(dāng)目標(biāo)連續(xù)N次無(wú)遮擋時(shí)判定為無(wú)遮擋狀態(tài)。

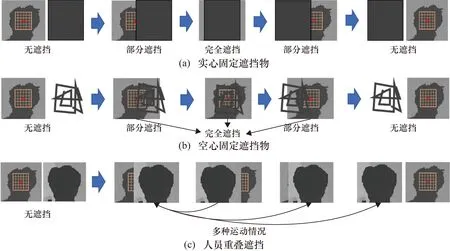

分析遮擋變化與深度變化的關(guān)聯(lián)性。如圖8所示,由于跟蹤過(guò)程中人員的運(yùn)動(dòng)連續(xù)性,當(dāng)人員頭部處于無(wú)遮擋狀態(tài)時(shí),幀間深度差ΔD將保持小數(shù)值范圍內(nèi)的變化。如圖8(a)所示,當(dāng)頭部被實(shí)心固定物遮擋時(shí),相對(duì)應(yīng)的ΔD變化為:數(shù)值波動(dòng)—小數(shù)值—數(shù)值波動(dòng)。如圖8(b)所示,人頭被空心固定物遮擋時(shí),對(duì)應(yīng)的ΔD將在一定時(shí)間內(nèi)介于小數(shù)值與大數(shù)值之間進(jìn)行數(shù)值波動(dòng)。如圖8(c)所示,人頭被多人重疊遮擋時(shí),此情況下由于人員的運(yùn)動(dòng)方向、速度等屬性通常具有隨機(jī)性,人員遮擋情況較為復(fù)雜,難以定量捕捉ΔD的顯著變化規(guī)律,ΔD仍將在一定時(shí)間進(jìn)行小數(shù)值與大數(shù)值之間的上下波動(dòng)。

圖8 運(yùn)動(dòng)遮擋變化分析

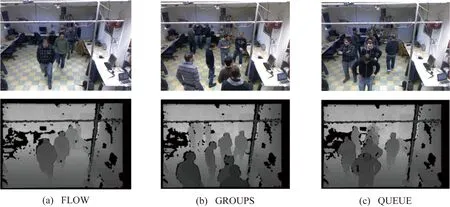

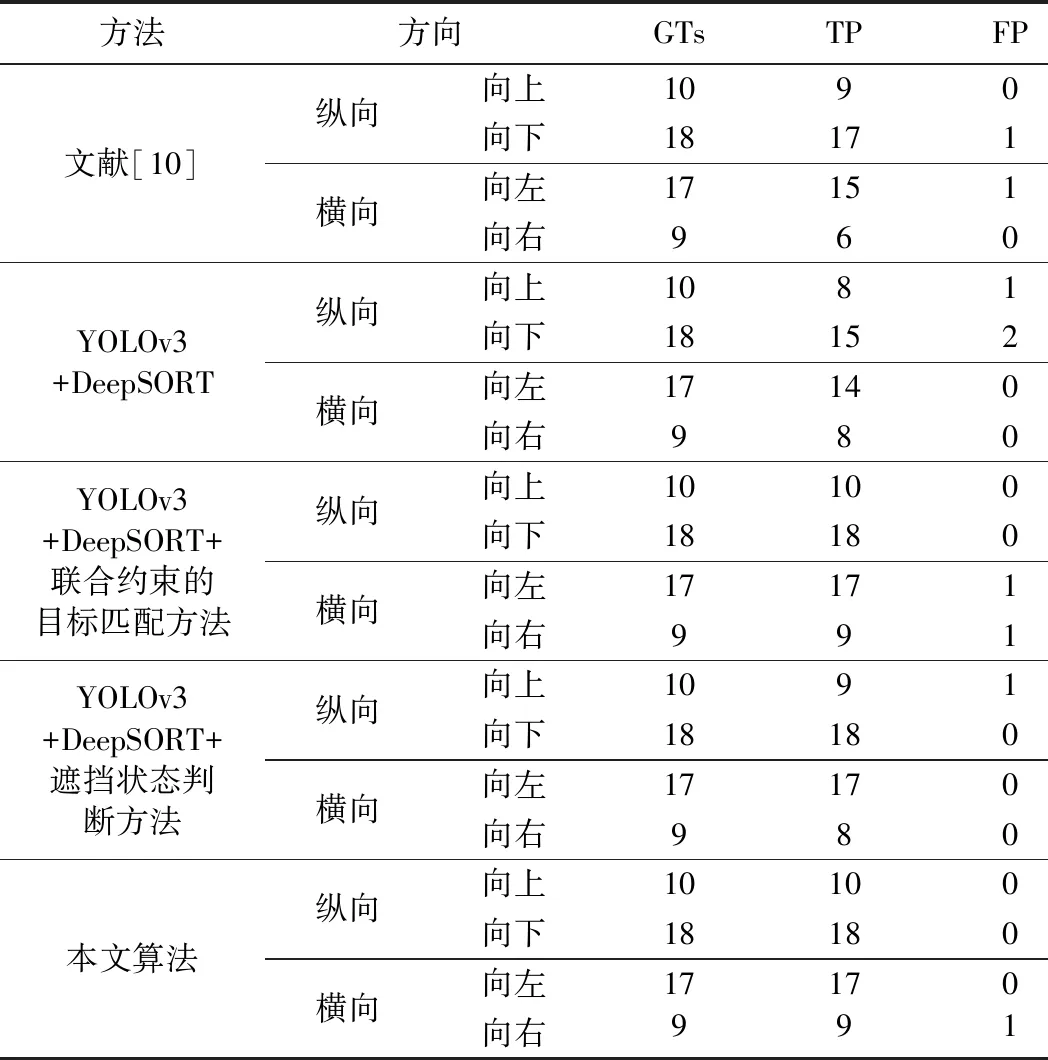

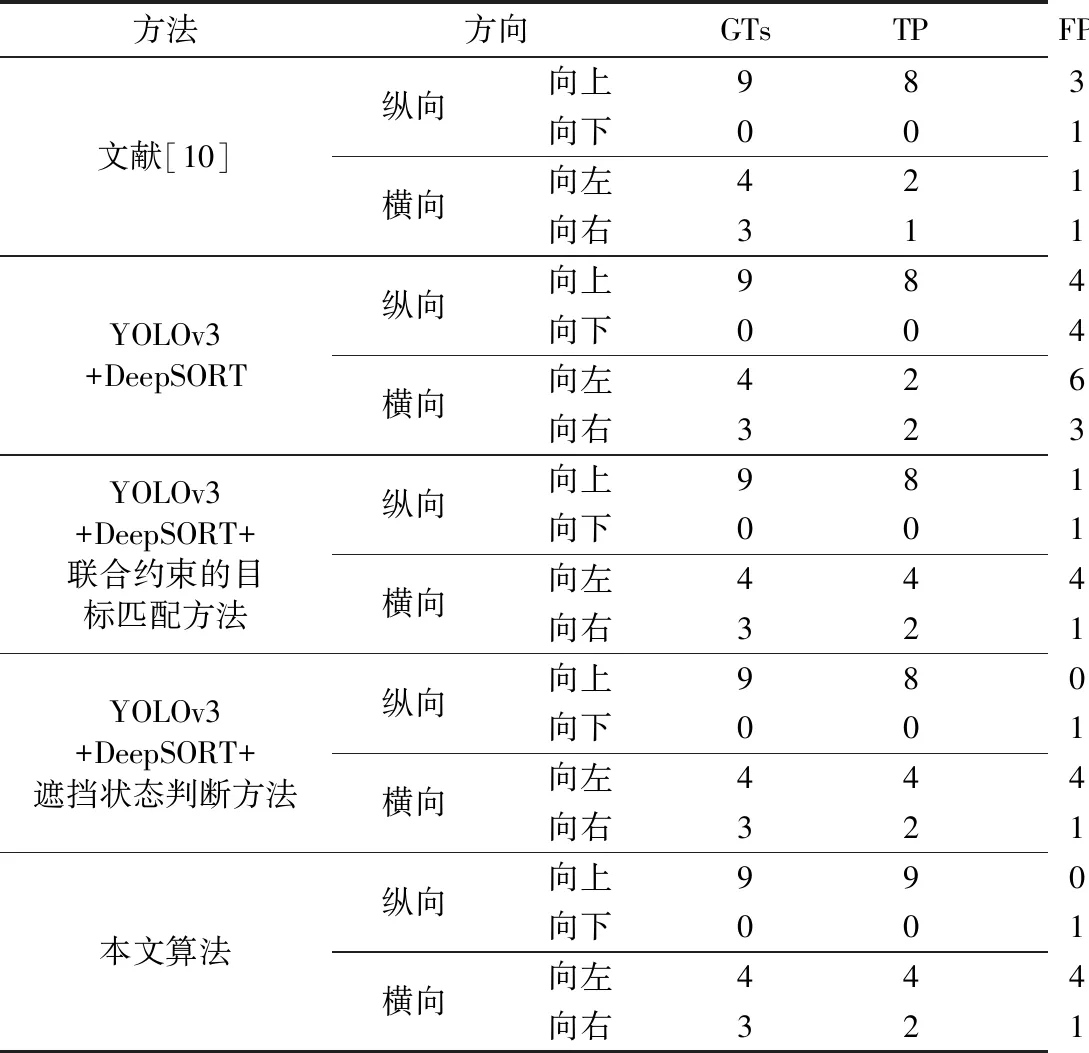

利用軌跡上下文深度差判斷遮擋狀態(tài)。當(dāng)幀間深度差ΔD大于等于最大深度差閾值T時(shí),更新當(dāng)前目標(biāo)的遮擋狀態(tài)為“被遮擋”;若軌跡在連續(xù)N幀內(nèi)的幀間深度差均滿(mǎn)足ΔD (10) ④ 依據(jù)遮擋狀態(tài)優(yōu)化的軌跡處理策略。對(duì)于未匹配的軌跡,本文利用目標(biāo)的遮擋狀態(tài),自適應(yīng)調(diào)整軌跡的最大存活時(shí)間max_ages。首先為max_ages設(shè)置固定初始值S(本文設(shè)置為15),若當(dāng)前軌跡的消失幀數(shù)time_since_update≤S,則保留該軌跡進(jìn)行后續(xù)匹配;反之則檢查該軌跡的遮擋狀態(tài);若當(dāng)前軌跡處于“無(wú)遮擋”狀態(tài),則有足夠證據(jù)表明該軌跡對(duì)應(yīng)的目標(biāo)已從視頻幀中消失,因此刪除該軌跡;若為“被遮擋狀態(tài)”,令max_ages+1,適當(dāng)延長(zhǎng)該軌跡的最大存活時(shí)間,從而有助于恢復(fù)被長(zhǎng)時(shí)間遮擋的目標(biāo)的軌跡;與此同時(shí)設(shè)置最大截?cái)嘀礶nd,當(dāng)處于“被遮擋”的軌跡滿(mǎn)足max_ages≥end時(shí),刪除該軌跡,以避免跟蹤過(guò)程中存儲(chǔ)過(guò)多無(wú)效軌跡。 基于三維質(zhì)心坐標(biāo)的雙向人流量統(tǒng)計(jì)模塊主要分為兩個(gè)部分:首先針對(duì)二維質(zhì)心坐標(biāo)對(duì)人員運(yùn)動(dòng)方向容易判斷錯(cuò)誤,本文引入深度信息,利用目標(biāo)的三維質(zhì)心坐標(biāo)對(duì)運(yùn)動(dòng)方向進(jìn)行判斷,提升目標(biāo)運(yùn)動(dòng)方向判斷的準(zhǔn)確性;其次雙向人員計(jì)數(shù)方法部分引入兩條虛擬計(jì)數(shù)線(xiàn),對(duì)過(guò)線(xiàn)目標(biāo)進(jìn)行計(jì)數(shù)。具體方法如下。 1.2.1 基于三維質(zhì)心坐標(biāo)的人員運(yùn)動(dòng)方向判斷方法 傳統(tǒng)方法僅依據(jù)兩幀間目標(biāo)軌跡的二維坐標(biāo)變化判斷人員運(yùn)動(dòng)方向,判斷不規(guī)則運(yùn)動(dòng)人員過(guò)線(xiàn)時(shí)的運(yùn)動(dòng)方向時(shí)易導(dǎo)致方向判斷錯(cuò)誤,此外過(guò)度依賴(lài)于二維平面坐標(biāo)系,忽略了目標(biāo)在場(chǎng)景中的三維距離變化,對(duì)相機(jī)的拍攝視角敏感。為解決上述問(wèn)題,本文提出一種基于三維質(zhì)心坐標(biāo)的方向判斷方法,引入目標(biāo)的深度信息,同時(shí)聯(lián)合多幀質(zhì)心,判斷人員橫向和縱向的運(yùn)動(dòng)方向,算法流程如圖9所示,算法具體步驟如下。 圖9 基于三維質(zhì)心坐標(biāo)的人員運(yùn)動(dòng)方向判斷方法 ① 獲取檢測(cè)結(jié)果的三維質(zhì)心坐標(biāo)Centroiddet。對(duì)于匹配成功的軌跡,獲取當(dāng)前幀檢測(cè)結(jié)果的三維質(zhì)心坐標(biāo)Centroiddet,三維質(zhì)心可以表示為(x,y,d),其中x,y,d分別為質(zhì)心橫坐標(biāo)、縱坐標(biāo)和質(zhì)深度。 ② 獲取對(duì)應(yīng)軌跡的質(zhì)心隊(duì)列preCentroids。每個(gè)軌跡都具有一個(gè)最大長(zhǎng)度為N的質(zhì)心隊(duì)列preCentroids,用于記錄該人員在前N幀的三維質(zhì)心坐標(biāo)。本文中N取10,即軌跡最大能夠記錄從當(dāng)前時(shí)刻向前10次成功匹配的三維質(zhì)心。 ③ 判斷人員的運(yùn)動(dòng)方向。本文所提方法能夠同時(shí)實(shí)現(xiàn)對(duì)縱向(上、下) 和橫向(左、右)的方向判斷。 對(duì)于縱向方向判斷,分為以下兩種情況。若當(dāng)前時(shí)刻人員處于無(wú)遮擋狀態(tài),計(jì)算前N幀質(zhì)心深度均值與當(dāng)前質(zhì)心深度差值,得到目標(biāo)運(yùn)動(dòng)方向,如式(11)所示: (11) 式中,preCentroidsd=[d1,d2,…,dN]代表從preCentroids提取的質(zhì)心深度隊(duì)列。 若當(dāng)前時(shí)刻人員處于被遮擋狀態(tài),此時(shí)質(zhì)心深度可能發(fā)生波動(dòng)而不適用于定量計(jì)算,因此計(jì)算前N幀質(zhì)心縱坐標(biāo)均值與當(dāng)前質(zhì)心縱坐標(biāo)做差,得到目標(biāo)運(yùn)動(dòng)方向,如式(12)所示。 (12) 式中,preCentroidsy=[y1,y2,…,yN]代表從preCentroids提取的質(zhì)心縱坐標(biāo)隊(duì)列。 最后依據(jù)目標(biāo)遮擋狀態(tài)和diff的符號(hào),利用式(13)和式(14)判斷當(dāng)前時(shí)刻人員的縱向運(yùn)動(dòng)方向directy。 (13) (14) 對(duì)于橫向方向判斷,由于相機(jī)鏡頭的法線(xiàn)方向與人員運(yùn)動(dòng)平面垂直,使得人員橫向運(yùn)動(dòng)時(shí)深度變化較小,因此本文采用通過(guò)質(zhì)心橫坐標(biāo)的變化判斷人員的橫向運(yùn)動(dòng)方向,計(jì)算方法見(jiàn)式(15)和式(16)。 (15) (16) 在縱向運(yùn)動(dòng)方向directy的取值中,up代表人員的運(yùn)動(dòng)方向?yàn)橛上孪蛏希琩own則代表由上向下;在橫向運(yùn)動(dòng)方向directx的取值中,left代表人員的運(yùn)動(dòng)方向?yàn)閺挠蚁蜃螅瑀ight則代表從左向右;0則代表靜止?fàn)顟B(tài),也用于表示軌跡在首幀的初始方向。 ④ 更新軌跡參數(shù)。在完成人員在當(dāng)前幀的方向判斷后,利用當(dāng)前幀的計(jì)算結(jié)果,更新軌跡的三維質(zhì)心坐標(biāo)、橫/縱運(yùn)動(dòng)方向、平均深度值等參數(shù),并將當(dāng)前幀的三維質(zhì)心坐標(biāo)壓入到preCentroids隊(duì)列中,用于后續(xù)幀的判斷和處理。 1.2.2 雙向人員計(jì)數(shù)方法 在1.1節(jié)獲取人員運(yùn)動(dòng)軌跡以及1.2.1節(jié)獲取人員運(yùn)動(dòng)方向后,本文對(duì)橫、縱雙向經(jīng)過(guò)主計(jì)數(shù)線(xiàn)的人員進(jìn)行計(jì)數(shù),從而記錄雙向人流量,同時(shí)結(jié)合人員起始位置和兩條輔助計(jì)數(shù)線(xiàn),處理人員折返等異常運(yùn)動(dòng)狀態(tài),減少重復(fù)計(jì)數(shù)和錯(cuò)誤計(jì)數(shù)的發(fā)生,提高計(jì)數(shù)的準(zhǔn)確率。雙向人流量統(tǒng)計(jì)方法如圖10所示。 圖10 雙向人流量統(tǒng)計(jì)可視化結(jié)果 下文以縱向計(jì)數(shù)為例,描述所提雙向人員計(jì)數(shù)方法的具體步驟。 ① 獲取當(dāng)前軌跡的三維質(zhì)心坐標(biāo)、質(zhì)心隊(duì)列和運(yùn)動(dòng)方向。由1.1節(jié)多目標(biāo)跟蹤結(jié)果獲取當(dāng)前軌跡的三維質(zhì)心坐標(biāo)centroid、質(zhì)心隊(duì)列preCentroids,由1.2.1節(jié)人員運(yùn)動(dòng)方向判斷結(jié)果獲取當(dāng)前軌跡的運(yùn)動(dòng)方向direct。 ② 設(shè)置主計(jì)數(shù)線(xiàn)。對(duì)于縱向計(jì)數(shù),本文在視頻幀的中央設(shè)置一條水平主計(jì)數(shù)線(xiàn),用于對(duì)向上和向下經(jīng)過(guò)計(jì)數(shù)線(xiàn)的人員進(jìn)行分別計(jì)數(shù)。本文中所采用的視頻序列,分辨率為640像素×480像素,因此主計(jì)數(shù)線(xiàn)的縱坐標(biāo)記為L(zhǎng)y=240。 ③ 判斷軌跡的起始位置。判斷起始位置的目的是避免目標(biāo)在首次出現(xiàn)但還未過(guò)線(xiàn)時(shí)被錯(cuò)誤計(jì)數(shù)。對(duì)于縱向計(jì)數(shù),通過(guò)質(zhì)心隊(duì)列中縱坐標(biāo)大于(小于)Ly的個(gè)數(shù)與閾值S作比較,對(duì)目標(biāo)起始位置進(jìn)行判斷,軌跡的起始位置位于計(jì)數(shù)線(xiàn)上半部分,記Flagup=1,反之為0,本文將閾值S設(shè)置為3,F(xiàn)lagup和Flagdown的計(jì)算公式如下: (17) (18) ④ 統(tǒng)計(jì)首次穿越計(jì)數(shù)線(xiàn)的人員數(shù)量。布爾參數(shù)counted初始化為0,用于記錄該人員ID是否已經(jīng)被計(jì)數(shù)。若當(dāng)前軌跡尚未計(jì)數(shù),則依據(jù)運(yùn)動(dòng)方向可分為以下3種情況:若direction=0,表明目標(biāo)靜止或當(dāng)前為軌跡的首幀,因此不納入計(jì)數(shù);若direction<0,并且當(dāng)前質(zhì)心縱坐標(biāo)在主計(jì)數(shù)線(xiàn)上半部分,即centroidy ⑤ 設(shè)置輔助計(jì)數(shù)線(xiàn),處理折返目標(biāo)的重復(fù)計(jì)數(shù)。針對(duì)已計(jì)數(shù)的軌跡,本文依據(jù)其到達(dá)的最遠(yuǎn)位置來(lái)判斷是否重復(fù)計(jì)數(shù)。 對(duì)于縱向計(jì)數(shù),首先以主計(jì)數(shù)線(xiàn)為中心,分別在距其上、下方dis的位置設(shè)置第1、第2輔助計(jì)數(shù)線(xiàn)。若direction<0且滿(mǎn)足centroidy 推廣到橫向計(jì)數(shù)中,實(shí)現(xiàn)對(duì)左、右方向人流量的統(tǒng)計(jì),從而完成對(duì)橫、縱雙向人員流量的精準(zhǔn)統(tǒng)計(jì)。 在實(shí)際場(chǎng)景下,以沿相機(jī)鏡頭法線(xiàn)運(yùn)動(dòng)的縱向計(jì)數(shù)應(yīng)用最為廣泛,橫向計(jì)數(shù)與其原理基本一致。為了驗(yàn)證本文融合場(chǎng)景深度信息的雙向人流量統(tǒng)計(jì)方法的有效性,筆者選取MICC數(shù)據(jù)集進(jìn)行實(shí)驗(yàn)驗(yàn)證。MICC數(shù)據(jù)集由Bondi等[17]提供,該數(shù)據(jù)集以俯角45°對(duì)人員密集場(chǎng)景進(jìn)行拍攝,其中由FLOW、QUEUE、GROUPS 3個(gè)集合構(gòu)成,其場(chǎng)景示意圖如圖11所示,其包含了多種行人運(yùn)動(dòng)模式,具有一定的挑戰(zhàn)性,下面對(duì)3個(gè)數(shù)據(jù)集進(jìn)行詳細(xì)介紹。 圖11 MICC在3個(gè)場(chǎng)景下的樣本示例 ① FLOW。如圖11(a)所示,F(xiàn)LOW數(shù)據(jù)集共1148幀,其中包括9名人員。其模擬了地下通道以及建筑出入口等人員縱向快速流動(dòng)的場(chǎng)景,同時(shí)包含了部分橫向移動(dòng)。本文利用該序列評(píng)估所提算法在快速運(yùn)動(dòng)和方向變化情況下的人流量統(tǒng)計(jì)精度。 ② GROUPS。如圖11(b)所示,GROUPS數(shù)據(jù)集共917幀,其中包括9名人員。人員首先運(yùn)動(dòng)至畫(huà)面中,并分為兩組進(jìn)行相互交談,其模擬了會(huì)議室等人員從運(yùn)動(dòng)到聚集停留的場(chǎng)景。本文利用該序列評(píng)估所提算法在人員聚集情況下的人流量統(tǒng)計(jì)精度。 ③ QUEUE。如圖11(c)所示,QUEUE數(shù)據(jù)集共1128幀,其中包括10名人員。人員以有序隊(duì)列的形式依次向前緩慢移動(dòng),其模擬了店鋪、售票廳的排隊(duì)場(chǎng)景。本文利用該序列驗(yàn)證所提算法在人員小幅度運(yùn)動(dòng)情況下的人流量統(tǒng)計(jì)精度。 本文通過(guò)精準(zhǔn)率(Precision)、召回率(Recall)和F1分?jǐn)?shù)來(lái)評(píng)估雙向人流量統(tǒng)計(jì)的精度。 本實(shí)驗(yàn)使用Pytorch1.0深度學(xué)習(xí)框架,在裝有NVIDIA GTX1080Ti和CUDA10.2 的Ubuntu18.04系統(tǒng)上訓(xùn)練模型。 本文分別在FLOW、GROUPS和QUEUE 3個(gè)數(shù)據(jù)集上測(cè)試所提雙向人流量統(tǒng)計(jì)方法的精度,與文獻(xiàn)以及僅基于RGB圖像的YOLOv3-DeepSORT方法進(jìn)行對(duì)比,并進(jìn)行消融實(shí)驗(yàn),在YOLOv3-DeepSORT基礎(chǔ)上驗(yàn)證聯(lián)合約束的目標(biāo)匹配方法和遮擋狀態(tài)判斷方法的有效性,對(duì)比實(shí)驗(yàn)結(jié)果見(jiàn)表1~表3。其中GTs代表視頻序列中真實(shí)縱向、橫向運(yùn)動(dòng)的人數(shù),文獻(xiàn)[10]采用YOLOv3與SORT跟蹤算法的組合實(shí)現(xiàn)人流量統(tǒng)計(jì)。 由表1~表3的結(jié)果可以看出,在YOLOv3-DeepSORT算法分別加入聯(lián)合約束的目標(biāo)匹配方法和遮擋狀態(tài)判斷方法后精準(zhǔn)率和召回率有了明顯提升,漏檢誤檢情況極大降低,說(shuō)明了兩種方法的有效性。本文所提算法同時(shí)加入兩種方法后在3個(gè)不同場(chǎng)景的數(shù)據(jù)集上進(jìn)行測(cè)試,雖然速度有一些下降,但仍能達(dá)到實(shí)時(shí)效果,且性能有了大幅度提升。在3個(gè)數(shù)據(jù)集中,當(dāng)某運(yùn)動(dòng)方向沒(méi)有行人走動(dòng)時(shí),算法精準(zhǔn)率為0;當(dāng)某方向被統(tǒng)計(jì)的行人全部被正確統(tǒng)計(jì)時(shí),其F1值和Recall值為100%。 表1 FLOW數(shù)據(jù)集上的對(duì)比實(shí)驗(yàn)結(jié)果 在FLOW數(shù)據(jù)集上,文獻(xiàn)[10]的方法以及僅基于RGB圖像的YOLOv3-DeepSORT方法均出現(xiàn)了不同程度的人員漏檢和錯(cuò)檢,導(dǎo)致F1分?jǐn)?shù)的降低,本文算法通過(guò)組合RGB信息和深度信息,在人員快速流動(dòng)的橫、縱方向計(jì)數(shù)中,F(xiàn)1分?jǐn)?shù)超過(guò)95%,甚至高達(dá)100%,明顯優(yōu)于上述兩種算法。 在GROUPS數(shù)據(jù)集上,由于人員聚集而產(chǎn)生的交叉遮擋使得僅基于RGB圖像的方法出現(xiàn)較多目標(biāo)誤檢,本文方法通過(guò)融合場(chǎng)景的三維數(shù)據(jù)強(qiáng)化了對(duì)目標(biāo)的特征描述,從而增強(qiáng)了算法處理遮擋的能力,使得F1分?jǐn)?shù)顯著優(yōu)于對(duì)比算法。 表2 GROUPS數(shù)據(jù)集上的對(duì)比實(shí)驗(yàn)結(jié)果 在QUEUE數(shù)據(jù)集上,基于RGB圖像的方法產(chǎn)生了大量人員漏檢,經(jīng)分析主要是由于人員小幅度移動(dòng)導(dǎo)致了長(zhǎng)時(shí)間遮擋,與此同時(shí)人員在計(jì)數(shù)線(xiàn)附近徘徊也使得誤檢的風(fēng)險(xiǎn)增大。而本文所提方法能夠有效地應(yīng)對(duì)上述情況,使橫、縱雙向的人流量統(tǒng)計(jì)保持較高的精度。 表3 QUEUE數(shù)據(jù)集上的對(duì)比實(shí)驗(yàn)結(jié)果 ① 為解決基于IoU距離的關(guān)聯(lián)策略在密集人群中的可靠性較差的問(wèn)題,本文提出基于IoU和深度變化率聯(lián)合約束的目標(biāo)匹配策略,利用位置相似度和深度相似度聯(lián)合約束目標(biāo)和運(yùn)動(dòng)軌跡,提升匹配可靠性; ② 提出基于軌跡上下文深度差的目標(biāo)遮擋判斷策略,有效判斷目標(biāo)遮擋狀態(tài),并及時(shí)調(diào)整其軌跡更新策略; ③ 由于人員不規(guī)則運(yùn)動(dòng)和沿成像平面法線(xiàn)運(yùn)動(dòng)在二維坐標(biāo)上具有很小的差異,因此本文提出利用三維質(zhì)心坐標(biāo)判斷運(yùn)動(dòng)方向,引入深度信息,得到目標(biāo)間的位置差異,使以上問(wèn)題得到解決。 現(xiàn)階段人流量統(tǒng)計(jì)方法僅實(shí)現(xiàn)了二維平面上人員的定位與跟蹤,后續(xù)將考慮拓展到三維空間中定位人員位置并分析人員分布;而且目前本方法可承載最大人流量約為10~15人,后續(xù)考慮對(duì)該方法進(jìn)行優(yōu)化,提升可承載人流量容量。

1.2 基于三維質(zhì)心坐標(biāo)的雙向人流量統(tǒng)計(jì)模塊

2 實(shí)驗(yàn)分析與對(duì)比

2.1 數(shù)據(jù)集選擇

2.2 評(píng)價(jià)指標(biāo)

2.3 實(shí)驗(yàn)對(duì)比

3 結(jié)論