基于多殘差網絡的遙感圖像語義分割方法

楊甜甜,郭大波,孫 佳

(山西大學 物理電子工程學院,山西 太原 030006)

0 引 言

科學技術的發展使得我們能夠獲取到超高分辨率的光學遙感圖像[1],尤其是城區遙感圖像,分類更為復雜. 如何在復雜的遙感圖像中獲取到對人們有用的信息已經成為了國土規劃、 地理監測、 智慧城市等領域的熱點問題. 圖像語義分割是計算機視覺中最具挑戰性的任務之一,其為圖像中的每一個像素標注語義標簽. 高分辨率遙感圖像包含豐富的語義信息,相對于一般圖像的語義分割而言,有待分割對象的距離變化較小和分割目標相對較少等有利因素,因而更便于在現有技術條件下進行針對性研究.

基于傳統的計算機視覺圖像語義分割方法有: 基于邊緣的分割(邊緣松弛法、 邊界跟蹤法等)、 基于閾值的分割(閾值檢測法、 最優閾值化等)、 基于區域的分割(分裂與歸并、 分水嶺分割等)[2]. 王宏勝等[3]利用一種改進的種子區域生長算法對農村地區房屋進行提取,結果表明,基于小區域種子提高了算法的抗噪能力,但需要人為進行多次閾值干預; 翟慶羽等[4]采用最優閾值分割法,在抑制其他地物信息的基礎上精確分割出了水體細節部分,在遙感圖像中的水體類分割方面具有很大的優勢,但其泛化能力不夠強. 這些傳統的分割法只能提取到圖像的紋理信息、 顏色、 形狀等低層特征,且需人工提前設計特征,在消耗了大量的人力物力后得到的分割效果仍不理想.

自深度學習技術出現以來,語義分割進入了新的快速發展時期. 研究者利用深度神經網絡接收原始圖像數據,通過端到端的自動學習,提取到圖像的低層、 中層和高層特征,實現像素級分類,極大地提高了語義分割的精度和效率[5]. 目前,深度學習中主要的語義分割算法有全卷積網絡(Fully Convolitional Networks, FCN)[6],U-Net[7],SegNet[8]等. 2016年,Maggiori等[9]首次將FCN應用于遙感圖像分割領域中,該方法與帶有全連接的卷積神經網絡(convolutional neural networks, CNN)相比更加高效,但其對圖像的細節信息保留不夠完整; Zhang等[10]基于FCN提出影像自適應分割并開發了多級分類器,使其在建筑物單一項上提高了提取精度; 張浩然等[11]提出一種基于U-Net網絡與全連接CRFs網絡相結合的方法,通過調試全連接CRFs模型的推算流程參數,實現了對建筑物的精準提取,但存在建筑物分割邊界模糊的問題; 楊建宇等[12]采用傳統的SegNet網絡對遙感影像中的農村建筑物進行提取,但傳統的SegNet方法分割精度較低,且訓練耗時較長; 張哲晗等[13]基于SegNet網絡,融合了端到端的編碼器-解碼器(Encoder-Decoder)網絡結構思想,設計了SegProNet網絡結構,在保留圖像像素的空間語義信息的同時進行地物識別分割,其方法主要提高了分割速度,在分割精度上還有待提升; He等[14]提出殘差學習(Residual Learning)的框架,用于對更深層次的網絡進行訓練,這些殘差網絡(ResNet)不僅更容易優化,并且可以從增加的深度中獲得準確性. 如: Lin等[15]采用一種遠程殘差連接的網絡結構(RefineNet),將下采樣中缺失的信息融合進來,從而產生高分辨率的預測圖像; 徐勝軍等[16]將殘差網絡與空洞卷積融合,提高了遙感圖像中建筑物的分割精度,但是對植被、 道路等分割效果不佳; 王宇等[17]提出一種用殘差網絡作為編碼器(Encoder),用反卷積網絡作為解碼器(Decoder)的Encoder-Decoder深度學習框架,實現對建筑物的分割,提高了對建筑物單一項的分割精度,且對建筑物的邊緣細節分割不夠精細.

針對上述算法中存在的分割精度不理想、 邊界細節分割效果不佳等問題,本文結合U-Net網絡融合多尺度特征的優點和殘差網絡提高圖像特征重復利用率的優點,提出了一種基于U-Net網絡和殘差網絡的遙感圖像語義分割模型. 仿真分析有效地表明了該模型可以提高對遙感圖像中建筑物、 植被、 道路、 水體等的整體分割精度,并在“CCF衛星影像的AI分類與識別競賽”[18]的數據集上進行了實驗.

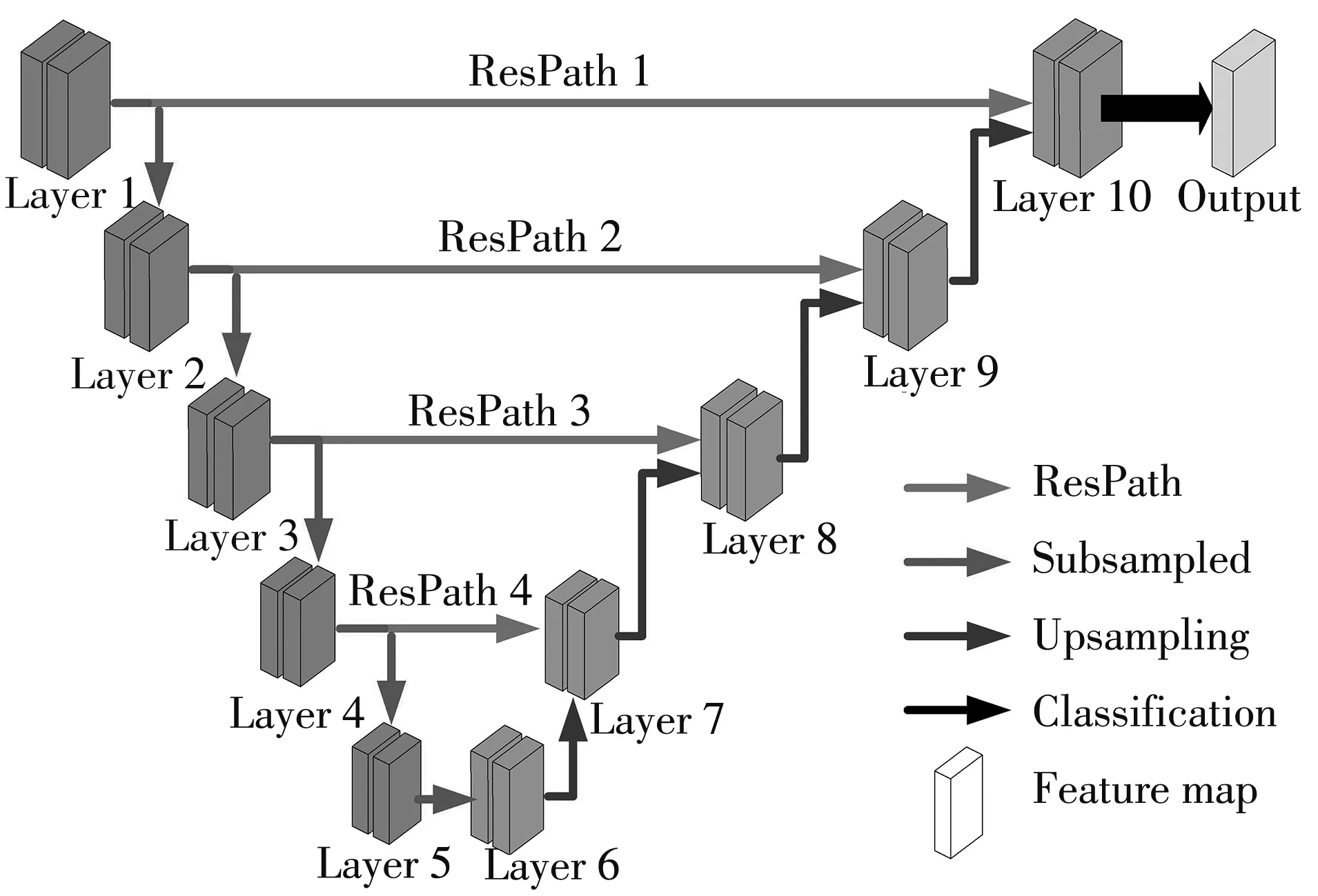

1 模型框架

本文提出的模型整體結構主要分為3部分: 編碼器、 解碼器和殘差連接. 其中編碼器主體由殘差網絡組成,提高了圖像特征的重復利用率,提取到更深層次的高級語義信息; 解碼器主要由上采樣層和卷積層組成,通過上采樣恢復圖像分辨率,最后輸出分割圖像; 殘差連接能夠減少下采樣過程中空間信息的損失程度,使得上采樣恢復的特征圖中包含更多低層次的語義信息,提高分割精度. 算法整體網絡框架如圖1 所示.

圖1 本文算法整體框架Fig.1 The over all frame work of the proposed method

1.1 編碼器

編碼器由圖1 中的Layer1~Layer5組成. 原始的U-Net 網絡編碼器中所采用的池化層對圖像細節信息捕捉不夠精細,容易造成分割邊緣處出現分割斷裂的現象,而且網絡適應能力較差,因此,本文提出編碼器采用ResNet殘差網絡代替U-Net 網絡. ResNet殘差網絡能夠將圖像的低層特征傳輸到高層,實現信息融合,盡可能地保證信息的完整性,還解決了梯度消失的問題. 殘差網絡是從輸入直接引入一個短連接線到非線性層的輸出上,該映射公式為

y=H(x,wh)+x,

(1)

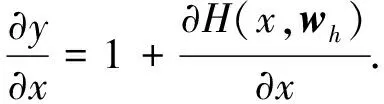

式中:y表示輸出;x表示輸入;H(x,wh)為殘差映射,是殘差模塊中短路連接的起點和終點之間的網絡所要擬合的函數;wh是第h層的系數矩陣. 通過對式(1)求偏導數可得

(2)

由(2)式可得,其偏導數始終大于1,因此隨著網絡層數的加深梯度也不會消失,解決了梯度消失的問題. 需要注意的是,式(1)中輸入x與輸出y的維度一般是不同的,故引入參數ws完成維度匹配

y=H(x,wh)+wsx,

(3)

式中:ws是系數矩陣.

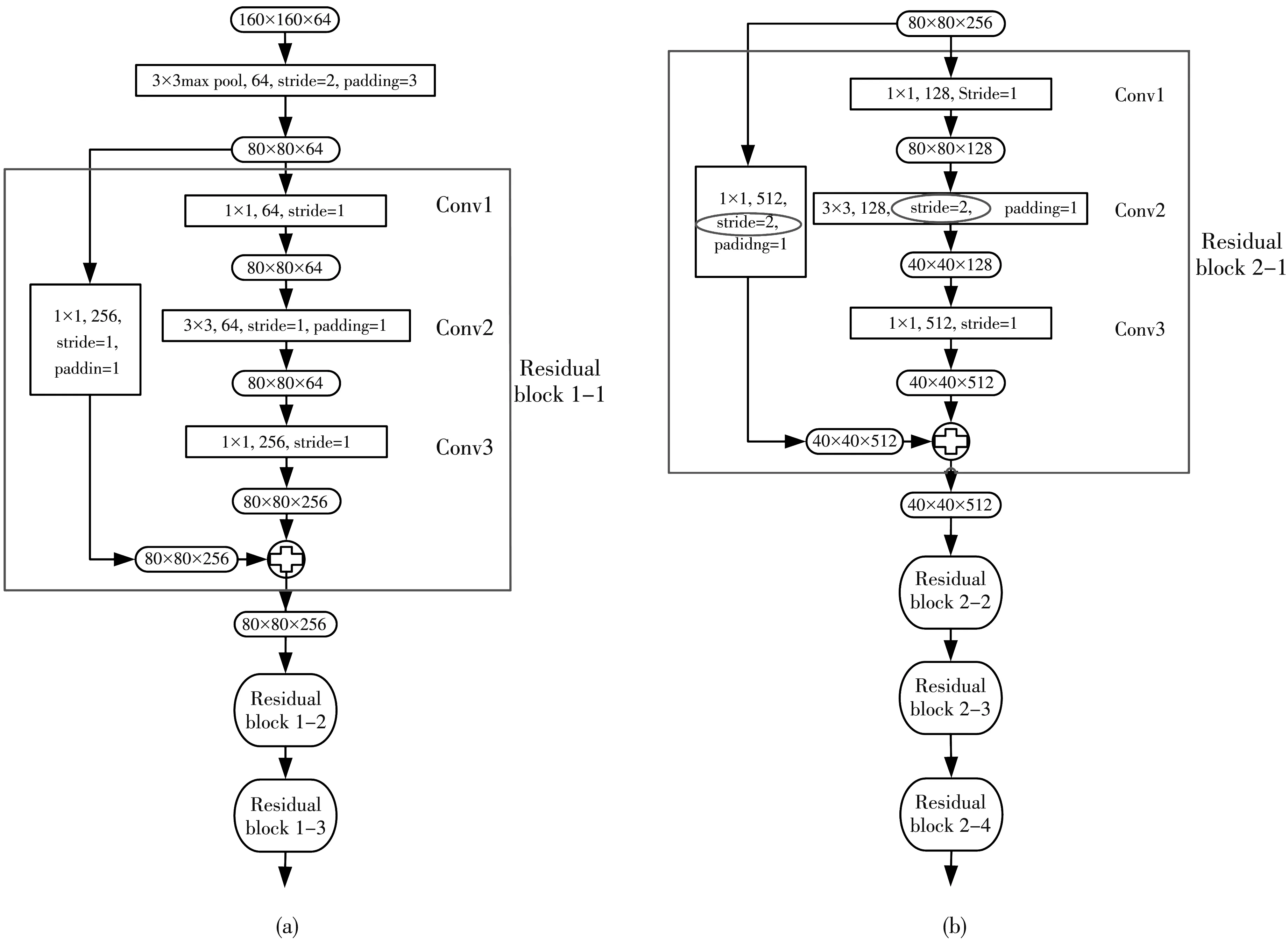

向Layer1輸入大小為320×320×3的圖像,經過7×7,64,stride=2,padding=3的卷積,輸出160×160×64的圖像,再進入Layer2. Layer2與Layer3所用殘差塊網絡結構如圖2 所示.

圖2 編碼器中第2層和第3層殘差塊結構圖

圖2(a)為Layer2的結構圖,先經過3×3max pool,64,stride=2,padding=3,輸出80×80×64的圖像,再輸入殘差塊(Residual block). Residual block 1-1輸入圖像為80×80×64; Conv1的1×1卷積為降維; Conv3的1×1卷積為升維,完成特征維度匹配; Add 操作完成特征融合. Layer2的Residual block1-2、 Residual block1-3與Residual block 1-1完全相同,重復以上操作3次即可.

圖2(b)為Layer3中Residual block的結構圖,輸入圖像為80×80×256; Conv1的1×1卷積為降維; Conv2中stride=2的3×3 卷積將80×80的圖像縮小到40×40; Conv3的1×1卷積為升維; 最后到輸出處進行Add特征融合時因為圖像尺寸不同,需要將輸入圖像進行下采樣,通過stride=2的1×1卷積層實現. Layer3中Residual block 2-2、 Residual block 2-3、 Residual block 2-4輸入圖像為40×40×512,就不需要進行下采樣了,所以stride=1,這3個殘差塊結構均相同,重復3次即可. Layer4、 Layer5結構和Layer3相同,不同的是通道數變多,輸出尺寸變小.

這種網絡結構的優點是在卷積的同時就完成了維度上的適應,輸入可以直接加到輸出上,這樣使得計算量減少一半以上. 該模塊還避免了因梯度消失而造成模型性能下降的問題,降低了深層網絡的訓練難度,更容易優化. 同時該模塊縮短了前后層之間的距離,有效地提高了特征的學習能力,有助于提取出更多細節信息,在反向傳播過程中梯度信息也更容易傳播,一定程度上提高了模型的結果精確度.

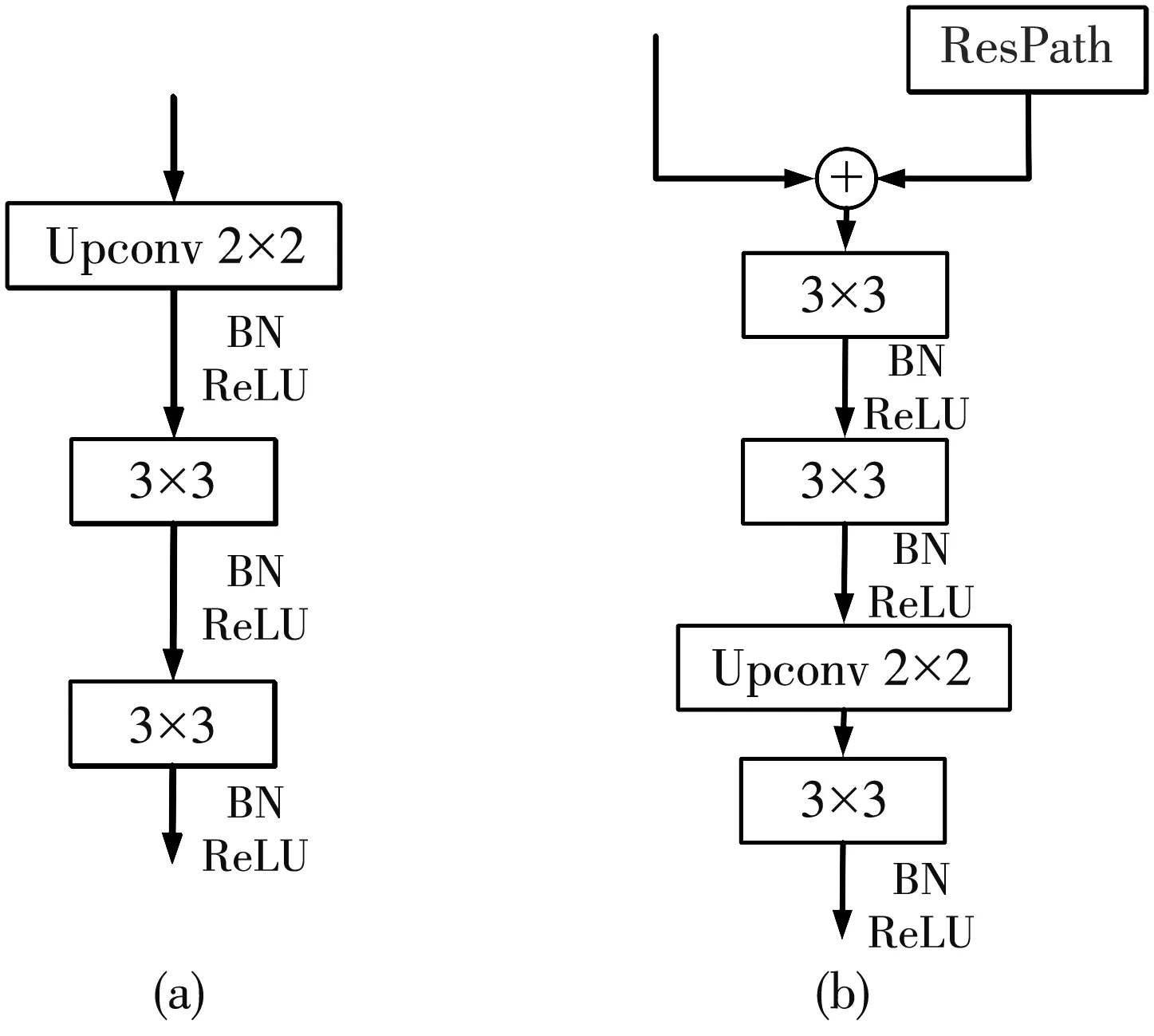

1.2 解碼器

解碼器由圖1 中的Layer6~Layer10組成. Layer6如圖3(a)所示,直接對輸入進行反卷積操作,將特征圖大小擴大一倍,通道數縮小為原來的一半. Layer7~Layer10如圖3(b)所示,它的輸入由兩部分組成: 上一級解碼器的輸入和殘差連接層的輸入. 先將上一級解碼器的輸出與殘差連接層提取的多尺度特征進行合并,此時通道數變為原來的二倍,再進行降維; 之后再通過反卷積操作,將特征圖尺寸擴大一倍,再降維將通道數縮小為原來的一半(Layer9降維將通道數縮小為原來的1/4). 起到了補充信息的作用,改善上采樣時信息不足的問題. 通過Layer6~Layer10后,特征圖像恢復到320×320×64,經過特征提取器后,最后輸出與原始圖像對應的320×320×5的目標區域分割圖. 該設計網絡可以利用較少的訓練集進行訓練,得到較好的分割結果.

圖3 解碼器結構圖Fig.3 The structure diagram of decoders

1.3 殘差連接

本文采用殘差連接代替傳統的跳層連接. 使用殘差路徑(ResPath),通過帶有殘差連接的卷積層鏈將編碼器中的低層次特征與解碼器中高層次的特征相連接. ResPath降低了二者在語義上的差距,使二者在拼接前具有一致的深度. 本文在ResPath1,2,3,4中分別使用了4,3,2,1個卷積層.

圖4 殘差連接Fig.4 ResPath

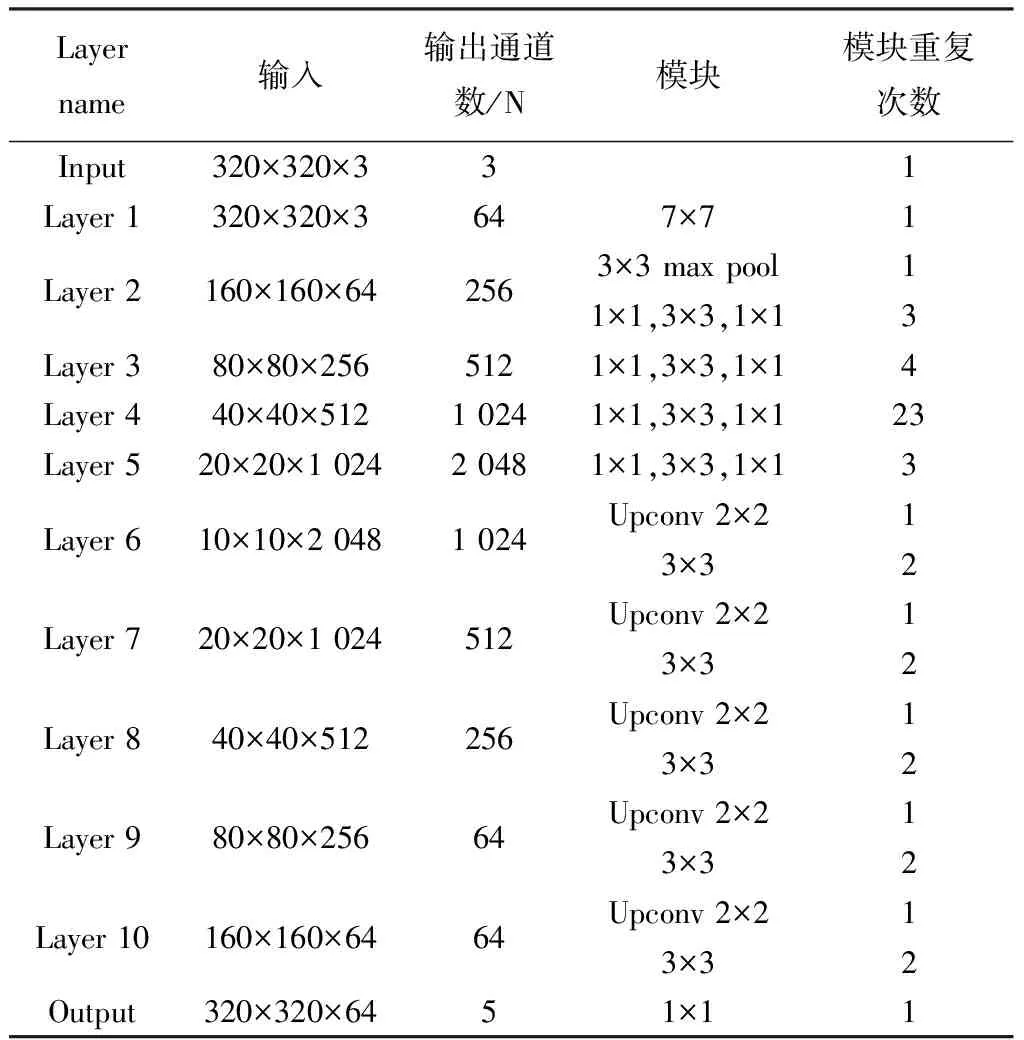

本文模型網絡參數如表 1 所示.

表 1 模型網絡參數表Tab.1 Table of parameters of proposed module networks

2 實驗及結果分析

2.1 數據集及其處理

本文所使用的數據集來自“CCF衛星影像的AI分類與識別競賽”. 將該數據集中的訓練樣本分為5類: 植被、 水體、 道路、 建筑、 其他. 采用數據集中的6幅圖像,3幅大小為7 939×7 969,3幅大小為5 190×5 204,其中4幅作為訓練圖像,2幅作為測試圖像,圖片格式為png格式.

該數據集圖像尺寸過大,樣本數量過少,在網絡訓練過程中容易產生過擬合的現象,因此,本文對圖像進行了數據增強,豐富圖像訓練集,提升網絡的泛化能力. 首先采用滑動窗口將圖像切割成大小為320×320的小尺寸圖像,然后采用了隨機旋轉、 縮放、 平移、 翻轉、 添加噪聲、 對比度色彩調整共6種方式對數據集進行擴充. 經擴充后的訓練集共包含75 540幅320×320的圖像.

2.2 實驗環境

本實驗所采用的CPU是Corei7-8 700k,顯卡是Nvidia GeForce GTX 1 080 ti,顯存容量為11 G,本文運行的所有代碼都是在Keras+Tensorflow深度學習框架下運行的,使用ResNet101網絡作為預訓練模型,反向傳播采用隨機梯度下降算法[19]. 在訓練階段,采用adam優化器多元學習率策略來動態調整學習率,避免訓練過程中梯度消失的問題; 模型的初始學習率設置為2×10-4; 訓練的batch_size=6; 每輪迭代steps_per_epoch=圖像總數/batch_size; 計劃訓練epochs為280; 采用早停法控制訓練過程,若損失loss在10個epoch內沒有下降則停止訓練,最終在epochs為118時訓練停止.

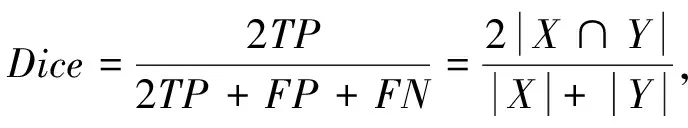

2.3 訓練損失函數設計

為了得到效果最好的模型,本文使用Dice損失函數[20]評估訓練結果,能夠解決樣本不均衡問題. 定義Dice損失函數為

(4)

式中:TP,FP,FN分別為遙感圖像像素正確分類數目、 背景像素錯誤分類數目、 遙感圖像像素錯誤分類數目,X,Y分別為真實值和預測值.Dice值表示真實值與預測值的相似度,Dice值越大說明圖像分割準確性越高.

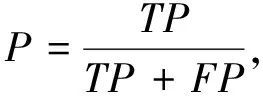

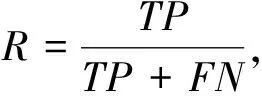

2.4 評價指標

圖像分割一般使用精確率(precision, P)和召回率(recall, R)對遙感圖像分割結果進行定量分析.P和R的定義式分別為

(5)

(6)

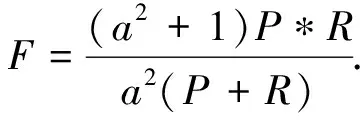

因為P和R本身的限制,無法對分割結果進行全面評價,所以本文采用F值作為綜合評價指標,其定義為

(7)

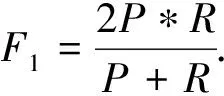

當參數a=1時,則

(8)

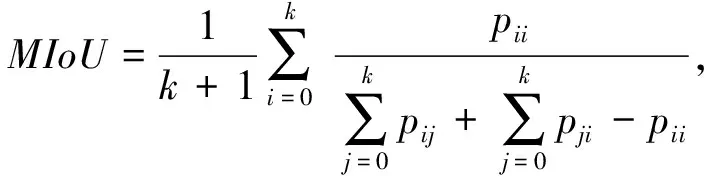

同時還使用了語義分割當中標準的準確率度量方法MIoU[21]進行評價,其定義為

(9)

式中:k為類別總數;pij為i類別的像素被預判為j類別像素的總數量;pji為j類別的像素被預判為i類別像素的總數量;pii為i類別的像素被預判為i類別像素的總數量;pij和pji屬于被分錯的像素數量;pii屬于被分對的像素數量.

2.5 結果分析

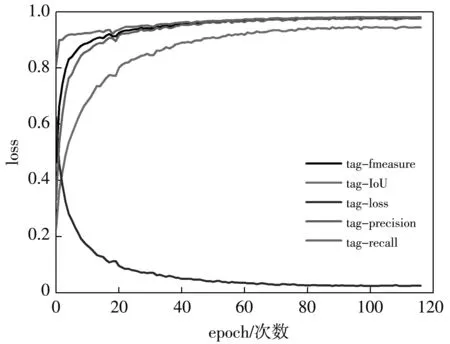

本文網絡模型所訓練的P,R,F和IoU如圖5 所示.

圖5 訓練過程中各性能指標的變化趨勢Fig.5 The chart of the tendency of several performance withepochs in the training process

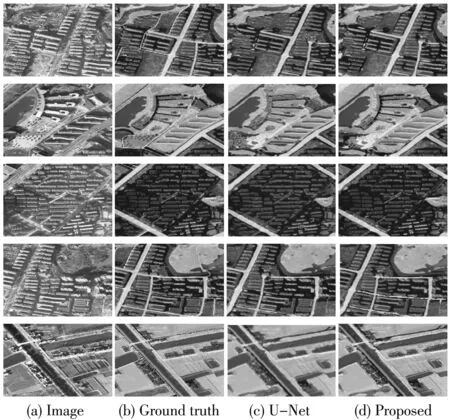

圖6 所示為該實驗中的部分可視化結果,第1列圖像為原始彩色遙感圖像; 第2列圖像為人工標記真實類別; 第3列圖像為使用U-Net網絡所產生的分割圖; 第4列圖像為使用本文模型所產生的分割圖; 第1行為建筑物密集的分割對比圖; 第2行為其它類密集的分割對比圖; 第3行為植被密集的分割對比圖; 第4行為道路密集的分割對比圖; 第5行為水體密集的分割對比圖.

圖6 遙感圖像語義分割結果Fig.6 Semantic segmentation results for remote sensing images

從圖6中第1行分割對比圖中可以看出,本文模型對于建筑物密集的圖像也能做到較為準確的分割,在建筑物邊緣分割上也比較精確,而U-Net網絡在建筑分割上出現了比較明顯的分割錯誤; 從圖6 中第2行、 第3行與第5行分割對比圖中可以看到,本文模型在河流、 建筑、 植被等比較復雜的圖像中,河流、 植被也能得到比較好的分割效果; 從圖6 中第4行分割對比圖中可以看出,本文模型在道路細節特征方面分割效果不佳,出現了分割錯誤的現象,導致原圖中的細小道路沒有被分割出來,但與U-Net網絡分割效果相比結果較好.

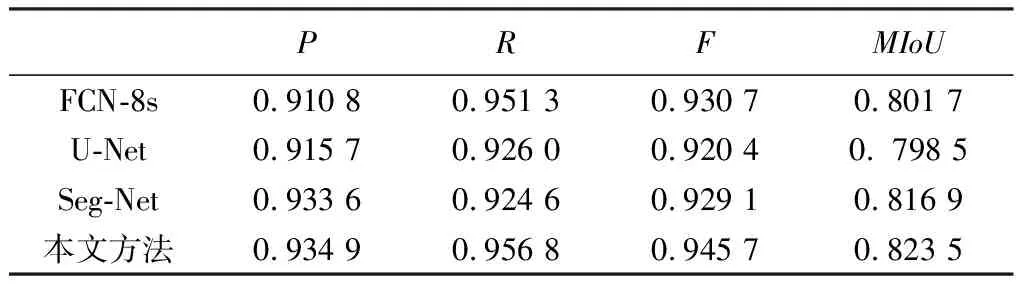

為了驗證本文模型的訓練效果,將本文模型的分割結果與FCN-8s,U-Net和Seg-Net 3種經典語義分割模型進行對比,結果如表 2 所示.

表 2 不同模型在相同數據集下的測試結果Tab.2 Test results of different models under the same data set

表 2 中加粗數字表示最優結果. 由數據可得,本文所使用模型的P,R,F和MIoU指標均優于其它3種經典語義分割算法.

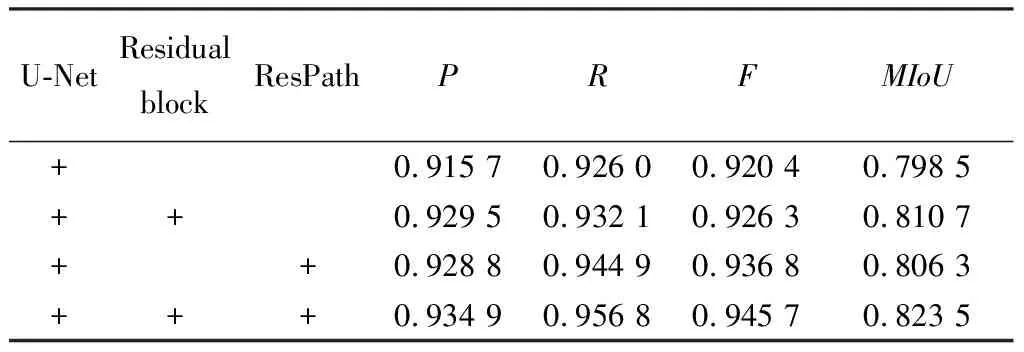

2.6 各模塊對整體模型的影響

實驗中為了驗證各模塊對整體模型的影響,將原始U-Net 模型、 添加Residual block后的模型、 添加ResPath后的模型與本文模型進行了對比實驗,對比結果如表 3 所示.

表 3 各模塊對整體模型性能的影響Tab.3 The influence of each module to the performanceof the overall model

本文模型是以U-Net 網絡作為基礎網絡進行的,U-Net網絡P為0.915 7,R為 0.926 0,F為0.920 4,MIoU為0.798 5; 添加Residual block與 ResPath后的本文模型在這3項指標上均有提升,其中P與U-Net網絡相比提高了2.09%,表明該文方法能夠提取到更多的細節信息,圖中對比度較低的一些區域也能被有效分割出來,MIoU與U-Net網絡相比提高了3.13%,F與U-Net網絡相比提高了2.74%,R與U-Net網絡相比提高了3.32%,充分證明了本文算法的有效性.

3 結束語

本文針對遙感圖像語義分割提出一種基于U-Net網絡和多殘差網絡結合的遙感圖像語義分割模型,該模型在U-Net網絡模型基礎上引入殘差塊,加強特征傳播,減少了信息的損失程度; 采用殘差連接,減少了下采樣過程中空間信息的損失程度,使得上采樣恢復的特征圖中包含更多低層次的語義信息,提高了分割精度. 實驗結果表明,與其它經典分割模型相比,本文算法對遙感圖像具有較高的分割精度,在植被、 建筑、 道路等目標復雜的圖像中也能得到比較準確的分割結果,具有很好的魯棒性. 在后續研究中,擬考慮加入空洞卷積與注意力機制進一步優化結構,實現更加精確的遙感圖像語義分割.