基于共享聯結三元組卷積神經網絡的槍彈膛線 痕跡快速匹配方法

潘楠 潘地林 潘世博 劉海石 蔣雪梅 劉益

摘 要:針對傳統通過激光檢測提取膛線線形痕跡信號時槍彈痕跡檢測精度不高且操作復雜的問題,提出了新型提取和處理方法。采用多尺度配準、彈性形狀度量與卷積神經網絡技術,基于多模式彈性驅動自適應控制方法,建立了試件末端位置和姿態參數分布模型,采用孤立森林算法檢測信號進行異常處理,利用變尺度形態濾波算法去除非細小特征,引入平方速度函數優化彈性形狀度量算法,完成曲線輪廓嵌入層映射;在膛線線形匹配部分,建立了適用于痕跡特征的優化參數共享聯結三元組卷積神經網絡模型,通過嵌入層相似度計算和最小化三重損失函數訓練該網絡至收斂;最后進行了不同方法的相似度匹配對比實驗。結果表明,與傳統的檢測方法相比,新方法解決了傳統槍彈痕跡檢測中面臨的精度與操作性問題,保證檢測結果的穩定性,且成本大大降低。在膛線線形痕跡提取中采用多模式彈性驅動自適應控制方法和三元組卷積神經網絡模型,可為槍彈痕跡檢測提供一種新的可行方法和思路。

關鍵詞:測試計量儀器;槍彈痕跡;多尺度配準;彈性形狀度量;三重損失函數;卷積神經網絡

中圖分類號:TP183 文獻標識碼:A

doi:10.7535/hbkd.2021yx03002

Fast matching method of bullet rifling traces based on shared connection triplet convolutional neural network

PAN Nan1, PAN Dilin2, PAN Shibo1, LIU Haishi1, JIANG Xuemei3, LIU Yi4

(1.Faculty of Civil Aviation and Aeronautics,Kunming University of Science and Technology,Kunming,Yunnan 650500,China;

2.Kunming Zhiyuan Measurement and Control Technology Company Limited,Kunming,Yunnan 650500,China;

3.Institute of Forensic Science of China,Beijing 100038,China;4.Kunming SNLab Technology Company Limited,Kunming,Yunnan 650228,China)

Abstract:Aiming at the problems of low precision and complicated operation of traditional bullet trace detection which generally uses laser to detect rifling traces to extract the signal of the rifling traces,new extraction and handling method was provided.By adopting multi-scale registration,elastic shape measurement and convolutional neural network technology,and using multi-mode elastic drive based adaptive control method,the end position and attitude parameter distribution model of the specimen were established.At the same time,the isolated forest algorithm was used to detect the signal for anomaly processing,and the variable-scale morphological filtering algorithm was used to remove non-small features.The square velocity function was introduced to optimize the elastic shape measurement algorithm to complete the curve contour embedding layer mapping.Aiming at the matching part of the rifle line shape,a convolutional neural network model of optimized parameter sharing connection triples suitable for trace features was established,and the network was trained to convergence by calculating the similarity of the embedding layer and minimizing the triple loss function.The comparison of similarity matching experiment results by using different methods was conducted.The results show that the new method solves the accuracy and operability problems faced in the traditional bullet trace detection,the stability of the detection result can be guaranteed,and the cost is greatly reduced compared with the traditional detection method.Adopting multi-mode elastic drive adaptive control method and three-tuple convolutional neural network model in the extraction of rifling traces provides a new feasible method and idea for bullet trace detection.

Keywords:

test and measurement instrument;bullet trace;multi-scale registration;elastic shape metric;triplet loss function;convolution neural network

槍彈膛線痕跡是指彈頭在擠進過程中,受到線膛內表面的擠壓和剪切、刮擦作用在披甲表面形成的凹陷條狀痕跡(線形痕跡)。由于槍管內陰、陽膛線對彈頭披甲擠壓力大小不同及陽膛線2棱邊側面對披甲的剪切、刮擦作用,致使彈頭披甲與陽膛線表面直接接觸的部位產生壓縮變形,而呈凹陷狀,從而明顯地區別于陰膛線表面作用的部位[1]。在涉槍案件偵破過程中,彈頭膛線線形痕跡最為常見,其對于辦案人員認定案件性質,確定作案槍支,進而證實犯罪嫌疑人有著十分重要的意義[2]。

相較于傳統通過顯微鏡觀察、人為比對形態特征的方式,近年來興起的圖像識別及三維掃描技術,為膛線線形痕跡的無損定量測試提供了一些新的解決方案。

國外諸多研究者就此問題提出了許多解決方法。美國愛荷華州立大學提出了一種基于線形痕跡輪廓數據對犯罪槍支進行推斷[4];利用顯微鏡進行線形痕跡提取,芬蘭、美國和德國的研究者分別著重于利用三維顯微鏡的掃描白光干涉[5],利用白光共聚焦顯微鏡[6]和基于三維激光掃描共聚焦的方式進行提取[7],此類通過三維光學儀器提取線形痕跡輪廓的方式具有很高的精度,但是在實施過程中十分復雜,需要足夠的技術力。而關于擦劃線形痕跡,德國、荷蘭和美國愛荷華州立大學的研究者通過相關分析計算2個溝槽的關聯程度[8],構建了一種針對線形痕跡的多尺度配準框架[9]和使用MANTIS處理軟件對提取痕跡輪廓圖像進行比對的方法進行研究[10]。

在國內,楊敏等[11]通過構造槍彈膛線痕跡紋理局部小波能量特征矢量并衡量特征標準差實現痕跡相似度檢驗,同時提出使用擴展分形模型描述彈頭膛線區域痕跡,給出了相關算法[12]。李軼昳等[13]嘗試建立一種射擊彈頭、彈殼三維形貌以及痕跡特征的復制方法——槍彈物證模塑成型技術,但是成本不易控制。哈爾濱工業大學利用歸一化互相關函數與全元匹配結合的算法實現了線形痕跡的高效匹配[14]。李趙春等[15]嘗試利用特征識別加速魯棒特征(SURF)算法進行匹配研究,利用該算法提取彈痕表面特征建立三維模型,并使用隨機抽樣一致性(RANSAC)算法實現匹配優化。中國人民公安大學在Evofinder槍彈痕跡比對系統的基礎上,探究似然比在槍彈痕跡評估中的計算與評價方法,并嘗試建立以似然比方法為基礎的槍彈痕跡比對系統證據評估體系[16]。張馨[17]利用高分辨率的3D點云數據和二維圖像復合的方法重現彈頭膛線痕跡的三維特征。

以上方法雖然都在一定程度上實現了線形痕跡的自動匹配,但仍存在以下問題:

1)基于圖片的比對方法,對拍照設備的要求較高,反光、拍攝角度及對焦不一致,將直接導致原始數據失真,分析結果穩健性下降;

2)三維掃描穩健雖能更真實地反映線形痕跡細節特征,但其檢測硬件成本高昂,且形成的文件體積過大,易造成計算量級呈幾何倍數增長;

3)現有匹配方法在區分槍支本身個體特征的同時需要區分類特征和子類特征,對于因槍支擊發次數較多而造成形態復雜且隨機性較大的線形痕跡,其準確性較為有限。

單點激光測試具有受環境光影響小、精度高、數據文件體積小、頻響特性好等特點,對于微觀特征的非接觸式測量非常有效[18]。近年來深度學習領域興起的卷積神經網絡,其權值共享網絡結構可規避傳統識別算法中復雜的特征提取和數據重建過程,同時足夠穩健,對于平移、比例縮放、傾斜或者共他形式的變形具有高度不變性,已被廣泛應用于圖像和語音識別之中[19-22]。因此,將單點激光測試與卷積神經網絡相結合,應用于線形痕跡相似性匹配,不啻為一種可行的嘗試。然而,在解決實際問題時仍然需要面對保證檢測信號穩定性、痕跡特征快速提取、穩健訓練數據集選取、部分重合相似性識別等問題。

針對上述問題,本文利用基于多模式彈性驅動自適應控制方法保證彈頭的旋轉軸線與電動旋轉臺的旋轉軸線始終重合,使得測試信號具備長期穩定性;針對線形彈痕則采用有限元分析、三維掃描和單點激光檢測實驗相結合的方式,完成線形痕跡特征的采集,形成機理分析、確定高區分性形貌特征分布并建立激光檢測信號與實際形貌特征的近似等價關聯關系;對于異常數據的檢測與處理,采用了基于孤立森林和指數加權移動平均算法;在濾波方面采用基于變尺度形態濾波算法去除非細小特征;通過多尺度配準策略完成曲線輪廓的快速提取;采用優化彈性形狀度量算法完成輪廓嵌入層映射;最終的匹配部分采用痕跡特征參數共享的聯結三元組卷積神經網絡完成樣本特征提取、訓練及相似性識別,利用平均精度均值和接收者操作特征曲線完成相似性匹配排序標準的構建,實現彈頭膛線痕跡快速檢驗。

1 痕跡微觀形態與激光檢測信號等價關系的建立

1.1 保持檢測彈頭與電動旋轉臺同軸

假設激光傳感器到彈頭表面的垂直距離為L,到電動旋轉臺軸心的距離為H,彈頭軸心至電動旋轉臺軸心距離為δ,彈頭半徑為r,電動旋轉臺軸心與彈頭表面的垂直距離為S,如圖1所示。

在電動旋轉臺進行360°旋轉時有:

L=H-δsin α±δ2sin2α-δ2-r2。(1)

基于多模式彈性驅動自適應控制方法構建試件座末端(與彈頭底部重合)位姿參數分布模型,分析試件座位姿調節的約束參量,將試件座位姿調節的穩態控制問題轉化為試件座位姿參量自適應調節問題,實現試件座姿態變換的特征分解和誤差補償修正,從而保證彈頭旋轉軸線與電動旋轉臺的旋轉軸線始終重合,使得測試信號具備長期穩定性。

1.2 典型制式公務用槍和對應彈頭膛線有限元模型的建立

通過有限元仿真定量分析其彈頭披甲初始擠進槍管時在膛線和坡膛的碰撞與擠壓作用下產生彈性變形,擠進過程中產生的應力變化趨勢,以及最后擠進全深膛線時發生的塑性變形。據此建立彈塑性有限元模型,通過分析等效應力圖、膛線X方向主應力圖和膛線應力偏張量圖等計算確定出應力集中點、變化過程以及強度薄弱區域,分析膛線痕跡的產生、演變機制和相應模態特征。某彈頭膛線痕跡有限元模型見圖2。

將有限元計算結果和三維激光掃描共聚焦顯微鏡測取線形痕跡表面凹凸痕跡的微觀數據相結合,根據槍彈類型、痕跡起止部位,確定膛線加工明顯留痕區域和特征表現。利用單點激光檢測對留痕區域進行多次環繞檢測,最終結合三維掃描模型建立其與線形痕跡微觀形態的近似等價關聯關系。圖2中Z軸為激光頭到彈頭表面凹凸的距離,單位為μm;X軸為環繞彈頭掃描一周的長度,單位為mm;Y軸為掃描的信號個數,5 000個組成一個面。

2 痕跡曲線輪廓提取及嵌入層映射

2.1 檢測異常數據處理

檢測異常數據處理,異常數據多由過分反光或振動造成,同周邊的數據有明顯差異,以單點激光檢測信號作為測試數據輸入,基于孤立森林算法,在訓練集上使用子采樣建立多棵iTree,創建iForest,評估樣本(實例),計算所有樣本的異常指數,對所有的一維數據異常指數進行K均值聚類,估算當前差異閾值,低于此閾值的樣本即為異常,予以剔除,基于臨近正常數據通過指數加權移動平均進行修正。

2.2 多檢測數據相位同步及非特征信息去除

利用改進動態時間規整算法和皮爾森相關系統,將10條檢測信號進行相似度比對,取相似度最大點為相位起始點,進行數據疊加,隨后構建變尺度形態濾波器,保留細小區分特征信息,去除非特征信息。

2.3 曲線輪廓快速提取

多尺度配準策略用于配準經同型號不同槍支形成痕跡信號的輪廓(已知不匹配配準)及相同槍支不同夾持力、擊發力而形成痕跡信號的輪廓(已知匹配配準),分多步配準,每步均增加細節信息,從粗略結構開始,對于每個尺度只考慮大于給定波長λ的結構,在每個步驟中,確定最佳平移和縮放參數并將其作為下一步的初始化,最后一步形成的參數用于轉換包括所有結構的整個輪廓,以產生最終的配準結果,如圖3所示。

2.4 曲線輪廓映射到嵌入層

設參數化曲線輪廓為β(β:D→瘙綆n),其中D是參數化的確定域,瘙綆n為實數集,定義‖·‖為瘙綆n中的歐幾里得2范數,定義連續映射F:瘙綆n→瘙綆n,利用平方根速度函數定義β的形狀q:D→瘙綆n,其中:

q(t)=Fβ·(t)=β·(t)‖β·(t)‖。(2)

對于每一個q∈L2D,瘙綆n,均存在能夠通過q的平方根速度函數定義的β,此曲線通過β(t)=∫t0qs‖qs‖ds獲得,隨后通過∫D‖q(t)‖2dt=∫D‖β·‖2dt=1將曲線縮放至單位長度以實現尺度不變性,表示為該預形狀空間L2D,瘙綆n中的單位超球點;最后,通過由預形狀空間中點與點之間最小化測地線的長度定義2條曲線之間的距離,測地線通過解析表達式和路徑矯正算法進行計算,分別基于奇異值分解和動態規劃實現該預形狀空間旋轉和重新參數化不變性。

3 痕跡相似性匹配卷積神經網絡模型的建立

3.1 三重損失和相似度計算

相似度計算步驟如下:從訓練數據集(空間)中隨機選一個樣本xp1,再隨機選取一個和xp1屬于同一類的樣本xp2和不同類的樣本xn,由此構成一個T=xp1,xp2,xn三元組,f(xi)為歸一化的高度嵌入特征,嵌入層的維度通過網絡分支最后一層的大小進行控制,最后可構成一個基本的卷積神經網絡結構,如圖4所示。本文的卷積神經網絡利用相似性匹配方法,構建了一個10層的卷積神經網絡模型來完成彈痕匹配。

將所有樣本之間的距離均加以利用,使用Softmax層和均方根標準實現Δ+同時滿足小于Δ1+且小于Δ*=minΔ1-,Δ2-的條件,以簡化訓練樣本選擇過程,將損失定義為

(T)=eΔ+eΔ++eΔ*2+1-eΔ*eΔ++eΔ*2 。(3)

將L2范數用于評估痕跡在嵌入層中表征之間的距離,利用損失函數使匹配痕跡之間局部差異值最小,完成相似度計算。

3.2 三元組選擇和數據增強

本文卷積神經網絡的三元組選擇分別為評估全輪廓、輪廓重排列、輪廓分段和補丁4類策略,通過實際測試選擇最為合適的策略,以隱式地定義相關特征以及應被卷積神經網絡所抑制的特征,避免因卷積神經網絡內權值共享而導致全部樣本被抑制或僅因局部特征區分樣本的情況出現。

3.3 卷積神經網絡結構優化和排序標準建立

由于輸入樣本是一個輪廓,因此卷積和池化層是一維信號輸入。在各卷積層之后進行批量歸一化,以減少對網絡的輸入規范化和初始化的依賴性,通過經驗性實驗評估卷積大小、映射數量以及池化層大小以防止過擬合,同時引入平均池和ReLU激活函數加快訓練速度并降低梯度消失帶來的影響。利用隨機梯度下降進行優化,最終利用訓練好的痕跡特征卷積神經網絡模型進行相似性識別。采用平均精度均值和接收者操作特征曲線構建相似性匹配排序標準,綜合評估分類和識別結果。具體層數的作用如表1所述。

4 實驗測試

1)擊發彈頭積累 選取自動步槍、沖鋒槍、手槍3大類總計5種型號槍支50支,安裝在仿生危險槍支射擊架上,進行多角度射擊實驗,通過干式無損集彈器回收。板機擊發力按1.0,2.0,5.0,7.0和10.0 kg等5級進行調節,前后夾持力按5,10,20,50和70 kg進行調節。每支槍支射擊25次,形成待測彈頭1 250個,每次射擊均記錄子彈出膛速度。

2)訓練集積累 為了能夠更好地進行訓練,要求痕跡檢測樣本的數量盡量大,利用單點激光檢測,對各彈頭披甲表面留痕區域進行10次環繞檢測,積累單點激光檢測信號樣本庫,樣本庫樣本數量(測試集)達到12 500。

3)彈頭軸線中心自適應校正 利用基于多模式彈性驅動自適應控制方法保證彈頭的旋轉軸線與電動旋轉臺的旋轉軸線始終重合,使得測試信號具備長期穩定性,避免因傾斜產生數據偏差。

4)彈性形狀度量 利用彈性形狀度量算法對檢測信號進行曲線輪廓映射,通過由預形狀空間中點與點之間最小化測地線的長度定義2條曲線之間的距離。

5)實施細節 通過計算嵌入層痕跡映射之間的L2距離計算相似度。對于輪廓段,使用滑動窗口從上到下計算多個表征。然后,將相應表征的成對距離之和用作2條痕跡之間的距離度量,將步長設置為段或補丁高度的1/8。

優化參數通過多次實驗后得以確定:使用隨機梯度下降法進行優化,學習速率為0.000 1,權重衰減為10-4,動量設定為0.88。

6)編寫程序 相關算法利用Matlab 2019a驗證后,采用Python進行編寫,在CPU為Intel Core i7 3.2 GHz、雙1080Ti GPU的深度學習計算主機上運行。

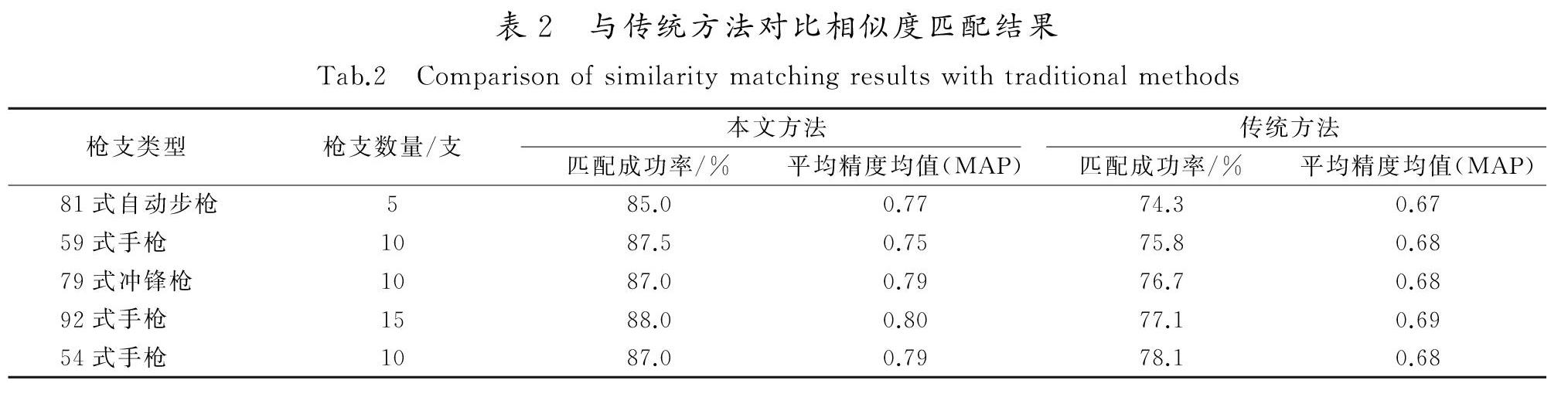

將該方法與傳統方法作比較,約定同一類型槍所擊發的比對排序全部位于前10%,也就是前9位的,則匹配為優秀,有6組數據比對排序在前10%,則該比對結果記為良好(成功),結果見表2。

單個彈頭全測試集匹配時間為0.1 s,經實驗,81式自動步槍彈痕匹配成功率為85.0%(MAP 0.77),59式手槍彈痕匹配成功率為87.5%(MAP 0.75),79式沖鋒槍彈痕匹配成功率為87.0%(MAP 0.79),92式手槍彈痕匹配成功率為88.0%(MAP 0.8),54式手槍彈痕匹配成功率為87.0%(MAP 0.79),整體匹配準確率和穩健度與傳統方法相比較都要優越。

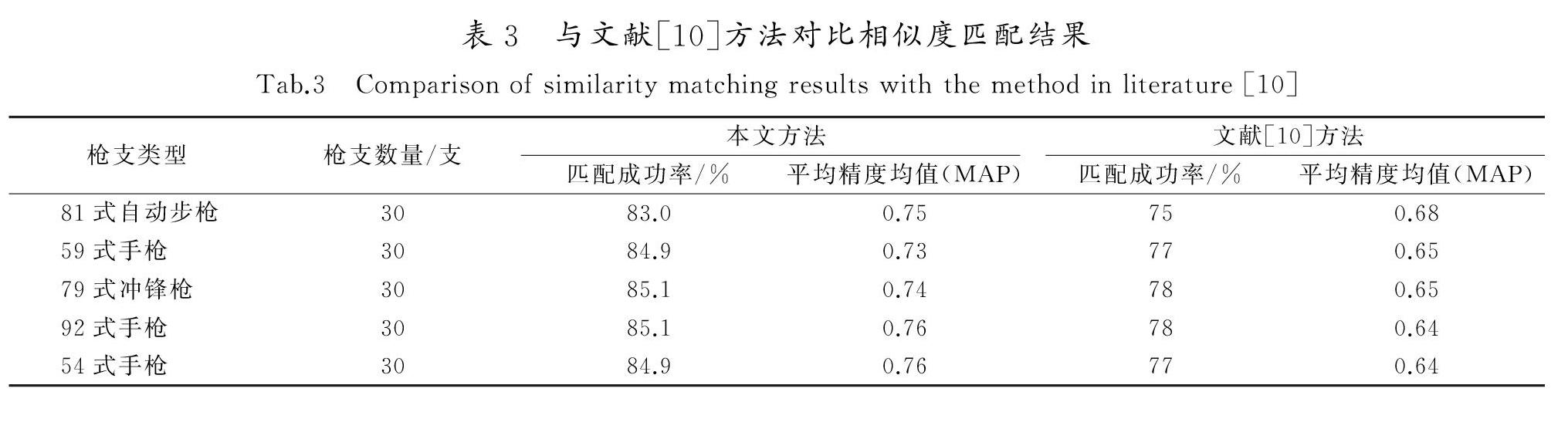

為與本文方法進行對比,采用文獻[10]提出方法對測試集進行匹配測試。與傳統方法的對比試驗相比較,本次增加了每個種類的槍支數量,單個彈頭全測試集匹配時間為1.5 s。由表3可知,本文所提出的方法在匹配速度、精確度和穩健度方面均優于文獻[10]方法。

5 結 語

提出了一種基于卷積神經網絡的槍彈膛線痕跡相似度匹配算法。該算法基于多模式彈性驅動自適應控制方法,保證彈頭的旋轉軸線與電動旋轉臺的旋轉軸線始終重合,采用有限元分析、三維掃描和單點激光檢測實驗相結合的方式,建立激光檢測信號與實際形貌特征的近似等價關聯關系;采用基于孤立森林和指數加權移動平均算法完成檢測異常數據處理,基于變尺度形態濾波算法去除非細小特征;采用多尺度配準策略,完成曲線輪廓的快速提取;采用優化彈性形狀度量算法,完成輪廓嵌入層映射;采用痕跡特征參數共享的聯結三元組卷積神經網絡,完成樣本特征提取、訓練及相似性識別,利用平均精度均值和接收者操作特征曲線完成相似性匹配排序標準的構建,最終實現了彈頭膛線痕跡的快速檢驗,實際數據測試也驗證了算法的有效性。為了進一步貼近實際辦案環境,如何擴大樣本庫和算法運算速度,將是下一步的研究方向。

參考文獻/References:

[1] SPOTTS R,CHUMBLEY L S,EKSTRAND L,et al.Optimization of a statistical algorithm for objective comparison of toolmarks[J].Journal of Forensic Sciences,2015,60(2):303-314.

[2] 李岳松,羅亞平.運用Evofinder槍彈自動識別系統對建檔手槍彈頭數字化建檔的研究[J].刑事技術,2018,43(5):363-368.

LI Yuesong,LUO Yaping.Digital filing into the registered-bullet imaging database by ballistic identification system evofinder[J].Forensic Science and Technology,2018,43(5):363-368.

[3] 張樹江,顏景龍,邢慧.一種基于圖像檢索的槍彈識別系統[J].兵工學報,2008,29(4):459-463.

ZHANG Shujiang,YAN Jinglong,XING Hui.A cartridge identification system based on image retrieval[J].Acta Armamentarii,2008,29(4):459-463.

[4] LOCK A B,MORRIS M D.Significance of angle in the statistical comparison of forensic tool marks[J].Technometrics,2013,55(4):548-561.

[5] KASSAMAKOV I,BARBEAU C,LEHTO S,et al.CSI Helsinki:Comparing three-dimensional imaging of diagonal cutter toolmarks using confocal microscopy and SWLI[C]//SPIE Defense,Security,and Sensing.Orlando:[s.n.],2010:76900Y.

[6] GAMBINO C,MCLAUGHLIN P,KUO L,et al.Forensic surface metrology:Tool mark evidence[J].Scanning,2011,33(5):272-278.

[7] CLAUSING E,VIELHAUER C.Digitized locksmith forensics:Automated detection and segmentation of toolmarks on highly structured surfaces[C]//Media Watermarking,Security,and Forensics.[S.l.]:[s.n.],2014:90280W.

[8] HEIZMANN M.Techniques for the segmentation of striation patterns[J].IEEE Transactions on Image Processing,2006,15(3):624-631.

[9] BAIKER M,KEEREWEER I,PIETERMAN R,et al.Quantitative comparison of striated toolmarks[J].Forensic Science International,2014,242:186-199.

[10]CHUMBLEY S,ZHANG S,MORRIS M,et al.Development of a mobile toolmark characterization/comparison system[J].Journal of Forensic Sciences,2017,62(1):83-91.

[11]楊敏,彭穎.基于專家知識的工具痕跡系統構建研究[J].中國人民公安大學學報(自然科學版),2013,19(2):1-5.

[12]楊敏,牟麗.彈頭痕跡多尺度擴展分形檢驗分析[J].兵工學報,2009,30(6):677-681.

YANG Min,MOU Li.Multiscale extended fractal analysis for identifying bullet engraving[J].Acta Armamentarii,2009,30(6):677-681.

[13]李軼昳,周志飛,張剛,等.利用高分子材料復制槍彈物證三維形貌及痕跡特征[J].刑事技術,2019,44(6):497-501.

LI Yiyi,ZHOU Zhifei,ZHANG Gang,et al.Ballistic evidence reproduced of its own 3D shape and marks patterns by polymer materials[J].Forensic Science and Technology,2019,44(6):497-501.

[14]ZHANG H,SONG J,TONG M S,et al.Correlation of firing pin impressions based on congruent matching cross-sections (CMX) method[J].Forensic Science International,2016,263:186-193.

[15]李趙春,周駿,張浩,等.基于SURF特征的槍彈痕跡匹配方法[J].傳感器與微系統,2019,38(11):35-38.

LI Zhaochun,ZHOU Jun,ZHANG Hao,et al.Bullet scrapping matching method based on SURF feature[J].Transducer and Microsystem Technologies,2019,38(11):35-38.

[16]董鋒.Evofinder槍彈痕跡比對系統似然比評估方法研究[D].北京:中國人民公安大學,2020.

DONG Feng.Research on the Likelihood Ratio Evaluation Method of Evofinder Bullet Trace Comparison System[D].Beijing:People′s Public Security University of China,2020.

[17]張馨.基于遷移學習的彈痕比對方法研究[D].合肥:安徽大學,2020.

ZHANG Xin.Research on Bullet Marks Recognition Based on Transfer Learning[D].Hefei:Anhui University,2020.

[18]潘楠,伍星,劉益,等.線性痕跡激光檢測信號自適應匹配算法研究[J].儀器儀表學報,2015,36(6):1372-1380.

PAN Nan,WU Xing,LIU Yi,et al.Research on the adaptive matching algorithm for laser linear mark detection signals[J].Chinese Journal of Scientific Instrument,2015,36(6):1372-1380.

[19]PARKHI O M,VEDALDI A,ZISSERMAN A.Deep face recognition[C]//Procedings of the British Machine Vision Conference 2015.Swansea:British Machine Vision Association,2015:1-12.

[20]ZAGORUYKO S,KOMODAKIS N.Learning to compare image patches via convolutional neural networks[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Boston:IEEE,2015:4353-4361.

[21]IOFFE S,SZEGEDY C.Batch Normalization:Accelerating Deep Network Training by Reducing Internal Covariate Shift[EB/OL].[2020-12-21].https://www.ixueshu.com/document/f8e66fe8224877ea318947a18e7f9386.html.

[22]CHEN W H,CHEN X T,ZHANG J G,et al.Beyond triplet loss:A deep quadruplet network for person Re-identification[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:1320-1329.