強化學習算法在超視距空戰輔助決策上的應用研究

吳宜珈 賴俊 陳希亮 曹雷 徐鵬

摘要:針對近端策略優化算法在空戰智能決策過程中面臨的動作空間過大、難收斂等問題,提出基于option的近端策略分層優化算法,構建了基于強化學習的空戰智能決策模型框架,并在超視距空戰仿真模型中進行了對抗性實驗并可視化。實驗結果表明,近端策略分層優化算法能夠驅動智能體在對抗過程中產生迂回攻擊等戰術行為,達到提升傳統算法性能和提高空戰博弈決策效率的目的。

關鍵詞: 超視距空戰;智能決策;人工智能;強化學習;近端策略優化算法;分層強化學習

中圖分類號:TJ760; V271.4? 文獻標識碼: A 文章編號: 1673-5048(2021)02-0055-07

0 引? 言

超視距空戰環境中,戰場態勢不斷變化,戰爭節奏不斷加快。傳統空戰中常用的影響圖法[1-3]、動態規劃法[4]、矩陣博弈法[5]、風險決策法[6]、模糊推理法[7-11]等已不能滿足指揮員決策需要,空戰領域智能化發展需求與日俱增[12]。隨著人工智能技術的飛速發展,利用智能化方法輔助飛行員決策、奪取制空權在打贏信息化局部戰爭中的需求日趨迫切,空戰智能決策成為研究熱點[13-14]。

強化學習作為人工智能技術的重要組成部分,在指揮控制系統中的應用優勢愈發突顯。2007年,DARPA開發DEEP GREEN系統,平行仿真戰場態勢,預測戰局走向[15]。2016年,美國空軍實驗室將遺傳模糊樹(Genetic Fuzzy Trees,GFTs)方法應用于ALPHA AI系統,使系統具備充當僚機、搜集情報、控制無人機群[16]等能力。同年,應用強化學習算法對計算機生成兵力(Computer Generated Forces,CGFs)行為建模,開發新的獎勵函數,使之可將擊敗曾經對手時學到的知識應用于擊敗下一個對手,從而學習到新戰術[17]。2017年,美國空軍Maven系統成功利用強化學習算法在智能采集單元中自動識別目標運動,通過自主智能體實驗改進軍事仿真軟件行為建模方式,為決策應用提供輔助[18]。2018年,智能化交互式問題解答系統MEADE應用于美國空軍飛行員日常訓練,為訓練提供針對性輔助決策。同年10月,美國空軍在軍事演習中應用SLATE訓練系統實現航空兵在本場和異地開展分布式訓練。2019年,美軍啟動 “智能僚機”、“空戰演進”和“機器飛行員”項目,旨在為飛行員提供智能僚機群作戰輔助和行動方案推薦,通過非侵入式手段對現有作戰系統進行無人化改裝。同年,模擬人類知識的更新和存儲機制改造智能空戰學習系統,設計了具有層次結構的異步學習原理[19],將神經網絡和人工勢場結合應用于空戰協同博弈問題[20]。2020年,DARPA 發布“座艙內機組自動化系統(ALIAS)”研究計劃,擬通過無人駕駛技術控制美國陸軍直升機,利用蒙特卡洛搜索樹算法進行推演式決策計算,通過智能虛擬陪練幫助飛行員完成復雜的戰術訓練[21]。

指揮控制系統的智能化水平決定未來戰爭的主動權[22],戰術決策是該系統的核心[23]。實踐證明,強化學習算法有效提升指揮控制系統智能性,為戰術決策系統在戰場信息搜集、處理、分析、決策等方面提供強大動力。目前,近端策略優化算法是強化學習中性能最好的算法[24],但面對具體的超視距空戰決策問題仍面臨動作空間過大、不易收斂等問題。 現提出基于Option的近端策略分層優化算法,通過在動作選擇過程中加入專家知識,智能提高決策博弈效率,輔助智能體學習空戰規則,豐富空戰過程戰術指向性。

1 相關工作

1.1 強化學習

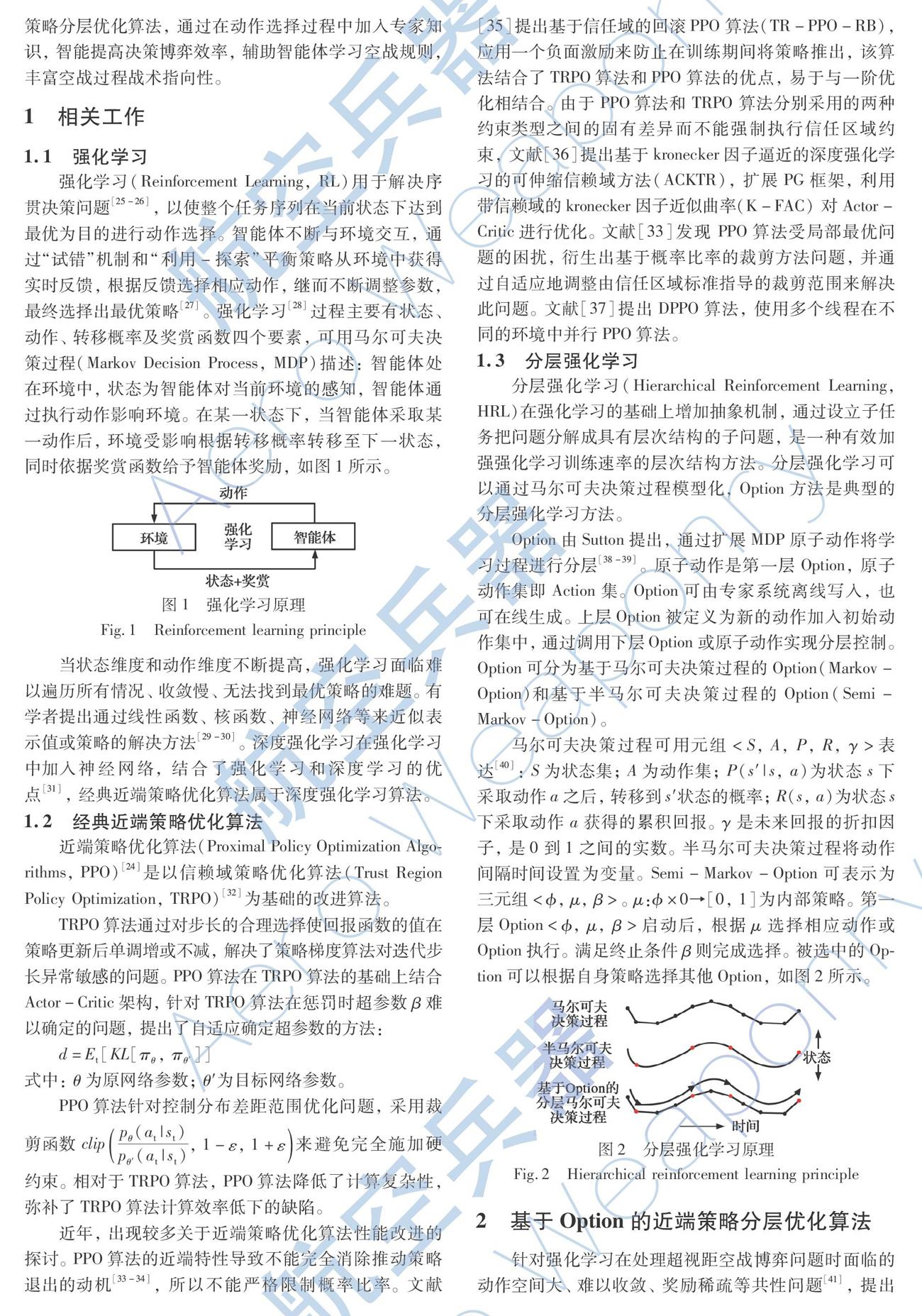

強化學習(Reinforcement Learning,RL)用于解決序貫決策問題[25-26],以使整個任務序列在當前狀態下達到最優為目的進行動作選擇。智能體不斷與環境交互,通過“試錯”機制和“利用-探索”平衡策略從環境中獲得實時反饋,根據反饋選擇相應動作,繼而不斷調整參數,最終選擇出最優策略[27]。強化學習[28]過程主要有狀態、動作、轉移概率及獎賞函數四個要素,可用馬爾可夫決策過程(Markov Decision Process,MDP)描述:智能體處在環境中,狀態為智能體對當前環境的感知,智能體通過執行動作影響環境。在某一狀態下,當智能體采取某一動作后,環境受影響根據轉移概率轉移至下一狀態,同時依據獎賞函數給予智能體獎勵,如圖1所示。

當狀態維度和動作維度不斷提高,強化學習面臨難以遍歷所有情況、收斂慢、無法找到最優策略的難題。有學者提出通過線性函數、核函數、神經網絡等來近似表示值或策略的解決方法[29-30]。深度強化學習在強化學習中加入神經網絡,結合了強化學習和深度學習的優點[31],經典近端策略優化算法屬于深度強化學習算法。

1.2 經典近端策略優化算法

近端策略優化算法(Proximal Policy Optimization Algorithms,PPO)[24] 是以信賴域策略優化算法(Trust Region Policy Optimization,TRPO)[32] 為基礎的改進算法。

TRPO算法通過對步長的合理選擇使回報函數的值在策略更新后單調增或不減,解決了策略梯度算法對迭代步長異常敏感的問題。PPO算法在TRPO算法的基礎上結合Actor-Critic架構,針對TRPO算法在懲罰時超參數β難以確定的問題,提出了自適應確定超參數的方法:

d=Et[KL[πθ,πθ′]]

式中:θ為原網絡參數;θ′為目標網絡參數。

PPO算法針對控制分布差距范圍優化問題,采用裁剪函數

clippθ(at|st)pθ′(at|st),1-ε,1+ε

來避免完全施加硬約束。相對于TRPO算法,PPO算法降低了計算復雜性,彌補了TRPO算法計算效率低下的缺陷。

近年,出現較多關于近端策略優化算法性能改進的探討。PPO算法的近端特性導致不能完全消除推動策略退出的動機[33-34],所以不能嚴格限制概率比率。文獻[35]提出基于信任域的回滾PPO 算法(TR-PPO-RB),應用一個負面激勵來防止在訓練期間將策略推出,該算法結合了TRPO算法和PPO算法的優點,易于與一階優化相結合。由于 PPO算法和 TRPO 算法分別采用的兩種約束類型之間的固有差異而不能強制執行信任區域約束,文獻[36]提出基于kronecker因子逼近的深度強化學習的可伸縮信賴域方法(ACKTR),擴展PG框架,利用帶信賴域的kronecker因子近似曲率(K-FAC) 對Actor-Critic進行優化。文獻[33]發現 PPO算法受局部最優問題的困擾,衍生出基于概率比率的裁剪方法問題,并通過自適應地調整由信任區域標準指導的裁剪范圍來解決此問題。文獻[37]提出DPPO算法,使用多個線程在不同的環境中并行PPO算法。

1.3 分層強化學習

分層強化學習(Hierarchical Reinforcement Learning,HRL)在強化學習的基礎上增加抽象機制,通過設立子任務把問題分解成具有層次結構的子問題,是一種有效加強強化學習訓練速率的層次結構方法。分層強化學習可以通過馬爾可夫決策過程模型化,Option方法是典型的分層強化學習方法。

Option由Sutton提出,通過擴展MDP原子動作將學習過程進行分層[38-39]。原子動作是第一層Option,原子動作集即Action集。Option可由專家系統離線寫入,也可在線生成。上層Option被定義為新的動作加入初始動作集中,通過調用下層Option或原子動作實現分層控制。Option可分為基于馬爾可夫決策過程的Option(Markov-Option)和基于半馬爾可夫決策過程的Option(Semi- Markov-Option)。

馬爾可夫決策過程可用元組

2 基于Option的近端策略分層優化算法

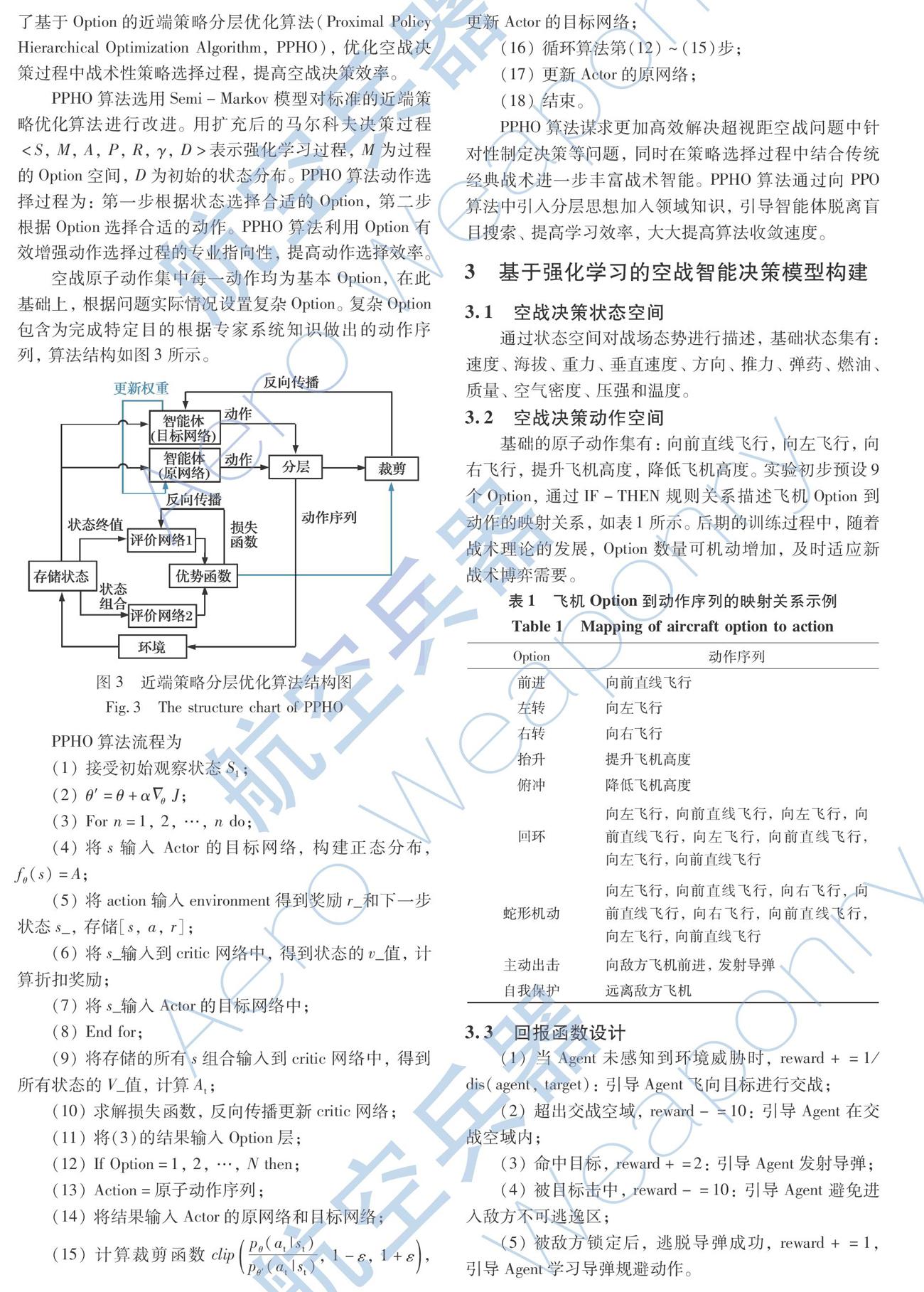

針對強化學習在處理超視距空戰博弈問題時面臨的動作空間大、難以收斂、獎勵稀疏等共性問題[41],提出了基于Option的近端策略分層優化算法(Proximal Policy Hierarchical Optimization Algorithm,PPHO),優化空戰決策過程中戰術性策略選擇過程,提高空戰決策效率。

PPHO算法選用Semi-Markov模型對標準的近端策略優化算法進行改進。用擴充后的馬爾科夫決策過程

空戰原子動作集中每一動作均為基本Option,在此基礎上,根據問題實際情況設置復雜Option。復雜Option包含為完成特定目的根據專家系統知識做出的動作序列,算法結構如圖3所示。

PPHO算法流程為

(1) 接受初始觀察狀態S1;

(2) θ′=θ+αΔθJ;

(3) For n=1,2,…,n do;

(4) 將s輸入 Actor的目標網絡,構建正態分布,fθ(s)=A;

(5) 將action輸入environment得到獎勵r_和下一步狀態s_,存儲[s,a,r];

(6) 將s_輸入到critic網絡中,得到狀態的v_值,計算折扣獎勵;

(7) 將s_輸入Actor的目標網絡中;

(8) End for;

(9) 將存儲的所有s組合輸入到critic網絡中,得到所有狀態的V_值,計算At;

(10) 求解損失函數,反向傳播更新critic網絡;

(11) 將(3)的結果輸入Option層;

(12) If Option=1,2,…,N then;

(13) Action=原子動作序列;

(14) 將結果輸入Actor的原網絡和目標網絡;

(15) 計算裁剪函數clippθ(at|st)pθ′(at|st),1-ε,1+ε,更新Actor的目標網絡;

(16) 循環算法第(12)~(15)步;

(17) 更新Actor的原網絡;

(18) 結束。

PPHO算法謀求更加高效解決超視距空戰問題中針對性制定決策等問題,同時在策略選擇過程中結合傳統經典戰術進一步豐富戰術智能。PPHO算法通過向PPO算法中引入分層思想加入領域知識,引導智能體脫離盲目搜索、提高學習效率,大大提高算法收斂速度。

3 基于強化學習的空戰智能決策模型構建

3.1 空戰決策狀態空間

通過狀態空間對戰場態勢進行描述,基礎狀態集有:速度、海拔、重力、垂直速度、方向、推力、彈藥、燃油、質量、空氣密度、壓強和溫度。

3.2 空戰決策動作空間

基礎的原子動作集有:向前直線飛行,向左飛行,向右飛行,提升飛機高度,降低飛機高度。實驗初步預設9個Option,通過IF-THEN規則關系描述飛機Option到動作的映射關系,如表1所示。后期的訓練過程中,隨著戰術理論的發展,Option數量可機動增加,及時適應新戰術博弈需要。

3.3 回報函數設計

(1) 當Agent未感知到環境威脅時,reward+=1/dis(agent,target):引導Agent飛向目標進行交戰;

(2) 超出交戰空域,reward-=10:引導Agent在交戰空域內;

(3) 命中目標,reward+=2:引導Agent發射導彈;

(4) 被目標擊中,reward-=10:引導Agent避免進入敵方不可逃逸區;

(5) 被敵方鎖定后,逃脫導彈成功,reward+=1,引導Agent學習導彈規避動作。

3.4 決策模型構建

構建基于強化學習的空戰仿真指揮控制模型,如圖4所示。

智能決策系統代表強化學習過程中智能體的角色,利用傳感器、探測器等設備感知當前戰場態勢信息。決策系統利用自身目前已掌握的經驗和知識,對當前戰場態勢進行判斷,同時結合強化學習所學得的策略,在動作空間中對飛行控制、航電系統、火力控制等方面進行相應的選擇。戰場環境狀態收到動作的影響后,轉移到新的狀態,同時給予智能決策系統一個即時效果反饋,決策系統根據效果反饋和當前戰場態勢,調整自身強化學習策略并進行下一次動作選擇。結合近端策略分層優化算法的空戰智能決策模型訓練過程如圖5所示。

4 面向超視距空戰模型的近端策略分層優化算法仿真實驗

4.1 實驗場景設置

現有的空戰仿真實驗因實際問題的復雜性和仿真效能的限制大多將問題抽象成簡單模型,簡化空戰決策過程,降低了系統對飛行員決策的參考意義。本實驗選用在Unity平臺安裝ML-Agents插件為背景進行超視距智能化空戰模擬仿真實驗,構建空戰仿真環境,對超視距空戰博弈問題進行3D仿真。

ML-Agents是Unity支持的處理連續問題的開源插件,用于Agent在模擬環境中的訓練。ML-Agents提供基于TensorFlow的算法實現方式,包含2D,3D 和 VR/AR的實驗環境。

ML-Agents包含三個高級組件:

(1)Learning Environment:包含 Unity 場景和所有角色,可分為三個組件:Agent,可以被附加到場景中的任何角色上,負責生成觀測結果、執行接收動作,并適時分配正/負獎勵。Brain,封裝 Agent 的決策邏輯。Academy,指揮 Agent 的觀測和決策過程。

(2)Python API:包含訓練的所有機器學習算法。

(3)External Communicator:將Learning Environment與 Python API 連接起來。

實驗運用PPHO 算法指導紅方飛機進行機動。PPHO算法包含于Python API 組件中,通過External Communicator與 Learning Environment中的紅方智能體相連,使紅方智能體在學習型Brain的指導下學習算法策略。Learning Environment中的Academy組件負責指揮智能體的觀測和決策過程。ML-Agents環境中PPHO算法應用框架如圖6所示。

基于Unity平臺,實驗場景設置為100 km×100 km,設置紅藍雙方飛機探測性能50 km,射程10 km,同時對飛機速度、海拔、重力、垂直速度、方向、功效、推力、彈藥、燃油、重量、空氣密度、壓強、溫度等參數進行實時監控調整。在仿真環境中既可以通過規則制定紅藍雙方的作戰行動序列,也可以通過快速博弈對抗產生大量數據訓練決策模型的方式進行,實驗場景如圖7所示。

4.2 定義任務想定

紅藍雙方使用同等戰機型號。雙方在指定對抗空域內,自由空戰。藍方為規則驅動,當未感知到威脅時,在預設交戰空域內巡邏,一旦感知到威脅,殲滅紅方威脅,目標丟失后,繼續巡邏搜索。紅方任務為取得預設空域制空權,擊落敵機。

4.3 決策模型更新方法

智能體學習主要包括離線訓練和在線使用兩部分。通過離線訓練得到強化學習的決策網絡,然后進行“自主對抗”,優化決策網絡。使用“自主對抗”產生的數據訓練態勢評估網絡,訓練好的態勢評估網絡能夠對戰場態勢進行評估,對決策方案的作戰效能進行預測。

在離線訓練階段,智能決策模型為紅方智能體提供動作選擇,藍方智能體基于規則驅動,紅藍雙方進行對抗。將戰場態勢信息等交戰數據轉換成狀態向量存儲于記憶單元中,從記憶單元中采樣數據對新舊策略價值網絡進行訓練,經過Option層輸出相應行為序列,對紅方飛機速度、航向、航電系統、火力控制等參數設置進行更新,進一步提高對抗水平,產生更高質量的交戰數據用于策略價值網絡的訓練。學得的策略價值網絡即作為當前作戰仿真環境下的博弈對抗行為模型,進行在線部署。

對戰回合數以200為限,基礎點數均為100。每回合開始,飛機位置隨機分配,交戰過程根據動作選擇損失相應點數,點數歸零,回合結束。下一回合開始,系統初始化。實驗主要根據點數比分判斷回合勝負,通過比較算法收斂速度和變化率進行算法優劣對比。

4.4 仿真實驗結果分析

針對實驗效果和收斂速度兩方面對當前訓練階段算法效能進行評價。通過累計回報和損失函數的對比進行具體論述。累計回報是智能體在采取相應動作之后,環境反饋的累計獎勵,實驗效果如圖8所示。

實驗數據統計時,取最近10次訓練模型的測試累計回報值,偏差小于1.5%,認為該算法已經達到穩定收斂。PPHO算法在1.1×105步長的訓練后趨于穩定,PPO算法在1.6×105步長的訓練后趨于穩定。PPHO算法累計回報值達到與PPO算法同樣高度,證明PPHO算法在效果上同樣達到了PPO算法的高水平。對訓練數據進行統計分析:PPHO算法訓練數據均值為1.50,方差為0.39。 PPO算法訓練數據均值為1.12,方差為1.10。PPHO算法與PPO算法均值相近,方差相差較大,說明算法的改進起到了穩定提升訓練速度的作用。

損失函數計算訓練樣本的誤差,評估算法對數據的建模程度。若實際結果與預測值相差較大 ,損失函數也會相應變大。算法優化后,損失函數不斷減小預測值的誤差。實驗效果如圖9所示,PPHO算法初始狀態損耗值小于經典PPO算法損耗值的一半。訓練過程中,PPHO算法正向損耗值均小于PPO算法,實驗效果優于PPO算法。收斂速度上,PPHO算法先于PPO算法達到穩定狀態,最終結果趨近于0。

實驗結果顯示:在訓練期間,PPHO算法較PPO算法展現出了更加優越的性能。

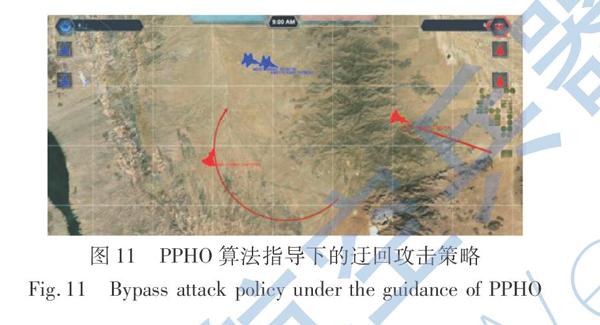

利用訓練好的模型驅動飛機2v2自由空戰,同時取1.1×105步長訓練后的模型作為測試對象。可視化表明,PPO算法在1.1×105步長訓練后飛機仍采用直接攻擊的策略,如圖10所示。通過探索-利用與仿真環境交互產生動作,由于動作本身沒有明確的戰術意義,學習的代價是大量不符合戰術規則的動作導致任務失敗。但PPHO算法訓練得到的模型驅動的飛機在面對敵方正面攻擊的情況時,能夠以顯式的戰術機動優化模型,表現出迂回攻擊的戰術行為,如圖11所示。

5 結? 論

本文提出的PPHO算法通過專家指導增加戰術儲備,為超視距空戰仿真過程注入經驗支持的戰術智能,達到加速學習過程的效果。實驗過程貼近實戰,對增強戰斗機端到端的操作訓練經驗具有積極意義。實驗結果表明PPHO算法可有效提升輔助決策效率。

下一步工作重點為:提升算法自學習能力,解決Option的內容需要離線更新的問題。可以采取的方法包括:(1)結合規則驅動;借助少量規則提升強化學習的探索與利用效率,加速收斂。(2)結合元深度強化學習; 對不同任務下歷史數據和訓練參數優化模式的充分利用,從一系列不同任務下歷史數據中尋找共性規律,提煉出一般性的知識,提升決策模型的泛化能力。(3)結合深度逆向強化學習; 借助少量高質量對抗樣本數據重構回報函數,加速強化學習。

參考文獻:

[1] Ji H M,Yu M J,Yang J Y. Research on the Air Combat Countermeasure Generation of Fighter Mid-Range Turn[C]∥ 2018 2nd International Conference on Artificial Intelligence Applications and Technologies (AIAAT2018),2018.

[2] 孫永芹,孫濤,范洪達,等. 現代空戰機動決策研究[J]. 海軍航空工程學院學報,2009,24(5):573-577.

Sun Yongqin,Sun Tao,Fan Hongda,et al. Research on Maneuvering Decision for Modern Air Combat[J]. Journal of Naval Aeronautical and Astronautical University,2009,24(5):573-577. (in Chinese)

[3] Pan Q,Zhou D Y,Huang J C,et al. Maneuver Decision for Cooperative Close-Range Air Combat Based on State Predicted Influence Diagram[C]∥? IEEE International Conference on Information and Automation(ICIA),2017:726-731.

[4] 馬耀飛,馬小樂. 一種空戰智能決策方法研究[C]∥中國制導、導航與控制學術會議論文集,2014: 2249-2454.

Ma Yaofei,Ma Xiaole.The Methods of Air Combat Intelligent Decision[C]∥Proceedings of IEEE Chinese Guidance,Navigation and Control Conference,2014: 2249-2454. (in Chinese)

[5] 惠一楠,朱華勇,沈林成. 無人機攻防對抗不完全信息動態博弈方法研究[J]. 兵工自動化,2009,28(1):7-10.

Hui Yinan,Zhu Huayong,Shen Lincheng. Study on Dynamic Game Method with Incomplete Information in UAV Attack-Defends Campaign[J].Ordnance Industry Automation,2009,28(1):7-10. (in Chinese)

[6] 周思羽,吳文海,張楠.自主空戰機動決策方法綜述[J]. 航空計算技術,2012,24(1):27-31.

Zhou Siyu,Wu Wenhai,Zhang Nan. Overview of Autonomous Air Combat Maneuver Decision[J]. Aeronautical Computing Technique,2012,24(1):27-31.(in Chinese)

[7] 張立鵬,魏瑞軒,李霞. 無人作戰飛機空戰自主戰術決策方法研究[J]. 電光與控制,2012,19(2):92-96.

Zhang Lipeng,Wei Ruixuan,Li Xia. Autonomous Tactical Decision-Making of UCAVs in Air Combat[J]. Electronics Optics & Control,2012,19(2):92-96.(in Chinese)

[8] 張磊. 無人作戰飛機自主決策技術研究[J]. 航空科學技術,2014,25(5):49-53.

Zhang Lei. Research on Autonomous Decision Making Technology of UCAV[J]. Aeronautical Science & Technology,2014,25(5):49-53.(in Chinese)

[9] 唐傳林,黃長強,丁達理,等. 一種UCAV自主空戰智能戰術決策方法[J].指揮控制與仿真,2015,37(5):5-11.

Tang Chuanlin,Huang Changqiang,Ding Dali,et al. A Method of Intelligent Tactical Decision Making for UCAV Autonomous Air Combat[J]. Command Control & Simulation,2015,37(5):5-11.(in Chinese)

[10] Ma S D,Zhang H Z,Yang G Q. Target Threat Level Assessment Based on Cloud Model under Fuzzy and Uncertain Conditions in Air Combat Simulation[J]. Aerospace Science and Technology,2017,67:49-53.

[11] Ernest N,Cohen K,Kivelevitch E,et al. Genetic Fuzzy Trees and Their Application towards Autonomous Training and Control of a Squadron of Unmanned Combat Aerial Vehicles[J]. Unmanned Systems,2015,3(3):185-204.

[12] 鮮勇,李揚. 人工智能技術對未來空戰武器的變革與展望[J]. 航空兵器,2019,26(5): 26-31.

Xian Yong,Li Yang. Revolution and Assumptions of Artificial Intelligence Technology for Air Combat Weapons in the Future[J]. Aero Weaponry,2019,26(5): 26-31.(in Chinese)

[13] Ernest N,Garroll D,Schumacher C,et al. Genetic Fuzzy Based Artificial Intelligence for Unmanned Combat Aerial Vehicle Control in Simulated Air Combat Missions[J]. Journal of Defense Management,2016,6(1):1-7.

[14] Yin Y F,Gong G H,Han L. An Approach to Pilot Air-Combat Behavior Assessment[J].Procedia Engineering,2011,15:4036-4040.

[15] 胡曉峰,榮明. 作戰決策輔助向何處去——“深綠”計劃的啟示與思考[J]. 指揮與控制學報,2016,2(1):22-25.

Hu Xiaofeng,Rong Ming. Where Do Operation Decision Support Systems Go: Inspiration and Thought on Deep Green Plan[J]. Journal of Command and Control,2016,2(1):22-25.(in Chinese)

[16] 周光霞,周方.美軍人工智能空戰系統阿爾法初探[C]∥第六屆中國指揮控制大會論文集,2018.

Zhou Guangxia,Zhou Fang. Analysis of Alpha AI for Air-to-Air Combat of US[C]∥Proceedings of 6th Command and Control Conference,2018.(in Chinese)

[17] Toubman A,Roessingh J J,van Oijen J,et al. Modeling Behavior of Computer Generated Forces with Machine Learning Techniques,the NATO Task Group Approach[C]∥ IEEE International Conference on? Systems,Man,and Cybernetics(SMC), 2016.

[18] Roessingh J J,Toubman A,van Oijen J,et al. Machine Learning Techniques for Autonomous Agents in Military Simulations-Multum in Parvo[C]∥IEEE International Conference on Systems,Man,and Cybernetics (SMC), 2017.

[19] Zhou K,Wei R X,Xu Z F,et al. An Air Combat Decision Learning System Based on a Brain-Like Cognitive Mechanism[J]. Cognitive Computation,2019,12(4):128-139.

[20] 張菁,何友,彭應寧,等. 基于神經網絡和人工勢場的協同博弈路徑規劃[J]. 航空學報,2019,40(3): 322493.

Zhang Jing,He You,Peng Yingning,et al. Neural Network and Artificial Potential Field Based Cooperative and Adversarial Path Planning[J]. Acta Aeronautica et Astronautica Sinica,2019,40(3): 322493.(in Chinese)

[21] 陳斌,王江,王陽. 戰斗機嵌入式訓練系統中的智能虛擬陪練[J]. 航空學報,2020,41(6): 523467.

Chen Bin,Wang Jiang,Wang Yang. Intelligent Virtual Training Partner in Embedded Training System of Fighter[J]. Acta Aeronautica et Astronautica Sinica,2020,41(6): 523467. (in Chinese)

[22] 程運江,張程,趙日,等. 人工智能的發展及其在未來戰爭中的影響與應用思考[J]. 航空兵器,2019,26(1): 58-62.

Cheng Yunjiang,Zhang Cheng,Zhao Ri,et al. Development of Artificial Intelligence and Thoughts on Its Influence and Application in the Future War[J]. Aero Weaponry,2019,26(1): 58-62.(in Chinese)

[23] 黃長強. 未來空戰過程智能化關鍵技術研究[J]. 航空兵器,2019,26(1): 11-19.

Huang Changqiang. Research on Key Technology of Future Air Combat Process Intelligentization[J]. Aero Weaponry,2019,26(1): 11-19. (in Chinese)

[24] Schulman J,Wolski F,Dhariwal P,et al. Proximal Policy Optimization Algorithms[EB/OL].(2017-08-28)[2020-05-10].https://arxiv.org/pdf/1707.06347.pdf

[25] 杜正軍,陳超,姜鑫. 基于影響網絡與序貫博弈的作戰行動序列模型與求解[J]. 系統工程理論與實踐,2013,33(1):215-222.

Du Zhengjun,Chen Chao,Jiang Xin. Modeling and Solution of Course of Action Based on Influence Net and Sequential Game[J]. System Engineering Theory and Practice,2013,33(1): 215-222. (in Chinese)

[26] 張迎新,陳超,劉忠,等. 資源不確定軍事任務計劃預測調度模型與算法[J]. 國防科技大學學報,2013,35(3): 30-35.

Zhang Yingxin,Chen Chao,Liu Zhong,et al. Method for Modeling and Solving Military Mission Planning with Uncertain Resource Availability[J]. Journal of National University of Defense Technology,2013,35(3): 30-35. (in Chinese)

[27] 陳希亮,張永亮. 基于深度強化學習的陸軍分隊戰術決策問題研究[J]. 軍事運籌與系統工程,2017,31(3):21-27.

Chen Xiliang,Zhang Yongliang. Research on the Tactical Decision-Making Problem of Army Units Based on Deep Reinforcement Learning[J].Military Operations Research and Systems Engineering,2017,31(3):21-27.(in Chinese)

[28] Richard S S,Andrew G B. Reinforcement Learning: An Introduction[M].London: MIT Press,1998.

[29] Whiteson S,Stone P. Evolutionary Function Approximation for Reinforcement Learning[J]. Journal of Machine Learning Research,2006(7):877-917.

[30] Preux P,Girgin S,Loth M. Feature Discovery in Approximate Dynamic Programing[C]∥ Proceedings of IEEE Symposium on Adaptive Dynamic Programming and Reinforcement Learning,2009:109-116.

[31] 周志華.機器學習[M].北京:清華大學出版社,2015: 390-392.

Zhou Zhihua. Machine Learning[M]. Beijing: Tsinghua University Press,2015:390-392. (in Chinese)

[32] Schulman J,Levine S,Moritz P,et al. Trust Region Policy Optimization[EB/OL].(2015-02-19)[2020-05-10].https://arxiv.org/abs/1502.05477v2.

[33] Wang Y H,He H,Tan X Y,et al.Trust Region-Guided Proximal Policy Optimization[EB/OL].(2019-11-08)[2020-05-10].https://arxiv.org/pdf/1901.10314.pdf.

[34] Ilyas A,Engstrom L,Santurkar S,et al. Are Deep Policy Gradient Algorithms Truly Policy Gradient Algorithms? [EB/OL].(2018-11-06)[2020-05-10].https://arxiv.org/abs/1811.02553v3.

[35] Wang Y H,He H,Wen C,et al. A Closer Look at Deep Policy Gradients[EB/OL].(2018-11-06)[2020-05-10].https://arxiv.org/abs/1811.02553v4.

[36] Wu Y H,Mansimov E,Liao S,et al. Scalable Trust Region Method for Deep Reinforcement Learning Using Kronecker-Factored Approximation[EB/OL].(2017-08-17)[2020-05-10].https://arxiv.org/abs/1708.05144v2.

[37] Heess N,TB D,Sriram S,et al.Emergence of Locomotion Behaviors in Rich Environments[EB/OL].(2017-07-10)[2020-05-10].https://arxiv.org/pdf/1707.02286.pdf.

[38] Sutton R S,Precup D,Singh S. Between MDPs and Semi-MDPs: A Framework for Temporal Abstraction in Reinforcement Learning[J]. Artificial Intelligence,1999,112(1/2):181-211.

[39] Mannor S,Menache I,Hoze A,et al. Dynamic Abstraction in Reinforcement Learning via Clustering[C]∥ Proceedings of the 21st International Conference on Machine Learning,2004: 560-567.

[40] Preux P,Girgin S,Loth M. Feature Discovery in Approximate Dynamic Programming[C]∥Proceedings of IEEE Symposium on Adaptive Dynamic Programming and Reinforcement Learning,2009:109-116.

[41] Barto A G,Mahadevan S. Recent Advances in Hierarchical Reinforcement Learning[J].Discrete Event Dynamic Systems,2003,13 (4): 341-379.

Research on the Application of Reinforcement Learning Algorithm in

Decision Support of Beyond-Visual-Range Air Combat

Wu Yijia1,2,Lai Jun1*,Chen Xiliang1,Cao Lei1,Xu Peng1,3

(1. Army Engineering University of PLA,Nanjing 210000,China;2. Unit 32526 of PLA,Wuxi 214000,China;

3.Unit 31102 of PLA,Nanjing 210000,China)

Abstract:

In order to solve? problems of the action selection space and the difficulty of convergence of traditional proximal policy optimization algorithm in air combat simulation,proximal policy hierarchical optimization algorithm is proposed. The framework of intelligent decision model of air combat based on reinforcement learning is constructed,and the antagonistic experiment is carried out and visualized. The experimental result shows that proximal policy hierarchical optimization algorithm could drive the agent to produce indirect attack and other tactical behaviors in the process of confrontation. The purpose of improving the performance of the traditional algorithm and decision-making efficiency of air combat is achieved.

Key words: beyond-visual-range air combat; intelligent decision; artificial intelligence; reinforcement learning; proximal policy optimization algorithm; hierarchical reinforcement learning

收稿日期:2020-05-11

基金項目:國家自然科學基金項目(61806221);裝備發展部預研基金項目(61421010318);十三五全軍共用信息系統裝備預研項目(31505550302)

作者簡介:吳宜珈(1993-),女,江蘇連云港人,助理工程師,研究方向為智能化指揮控制。

通訊作者:賴俊(1979-),男,江蘇南京人,副教授,研究方向為指揮信息系統、虛擬現實、模擬仿真和人工智能。