3D遷移網絡的阿爾茨海默癥分類研究

陸小玲,吳海鋒,曾 玉,孔伶旭,羅金玲

云南民族大學 電氣信息工程學院,昆明650504

作為最常見的老年癡呆癥,阿爾茲海默癥(Alzheimer’s Disease,AD)是一種神經系統功能退化性疾病,病因尚未完全查明。以現在的醫療手段,AD還無法被治愈[1],但若能對其正確診斷,則可采用正確的治療方式延緩病人病情。目前,AD的主流診斷方式是依靠醫師以臨床資料綜合分析和判斷,包括簡易精神狀態檢查表(Minimum Mental State Examination,MMSE)的神經心理學測驗[2],腦電圖(Electroencephalogram,EEG)的電生理檢查[3],核磁共振成像(Magnetic Resonance Imaging,MRI)、正電子發射斷層掃描(Positron Emission Tomography,PET)的神經影像學檢查[4]以及腦脊液檢查[5]等。雖然這些方式均取得不錯的診斷效果,但畢竟耗時耗力,且存在一定主觀性,仍可能發生誤診。

近年來,隨著機器學習技術的快速發展,尤其是在AD定量評估中所展現的優勢,人們發現其可作為一種快速的輔助診斷方式,例如多模態分類[6]和支持向量機(Support Vector Machines,SVM)[7]等機器學習算法。MRI作為一種高清晰的成像技術,其成像分辨率高,對比度好,信息量大,可清楚地顯示腦結構,反映細微變化,且不會產生對人體有害的電離輻射,目前被廣泛地應用于機器學習對AD的輔助診斷上。傳統的MRI機器學習分類方法主要可分為結構特征分類和降維特征分類,其中結構特征分類又主要基于海馬體和腦灰質特征[8-9],而降維特征分類主要從感興趣區(Region of Interest,ROI)提取特征[10]。另外,還有MRI紋理特征提取技術[11],其運行速度和分類性能也較好。然而,這些傳統的MRI機器學習分類準確率依賴提取特征的準確率,且大多還需手動提取,有時特征提取還較困難。如果提取的特征本身不太正確,那么分類的準確率也不會很高。除此之外,傳統機器學習分類更擅長于已知特征數據挖掘,而對于如AD其特征尚未完全明確的圖像分類,往往存在一些不確定性。

相比傳統的機器學習算法,深度學習針對未明確特征的對象往往具有自學習提取特征特性,其通過非線性模型將原始數據轉變成低級特征,再經多個全連接層形成抽象高級特征,使得分類對象具有更具體和有效的特征表達。由于MRI是一個具有腦區空間信息的三維(3D)圖像,目前AD分類較好的深度學習是建立在3D卷積神經網絡(Convolutional Neural Network,CNN)上[12],該方法能夠自動從MRI數據提取特征進行分類,而無需對腦組織和區域進行分割。然而,為了提高分類準確率,深度學習網絡往往需要大量的訓練數據,而目前公開可使用的AD MRI數據仍然有限。另外,深度學習通常是深度網絡,權重數量巨大,再加上巨大的訓練數據,導致深度網絡的訓練時間較為漫長。作為一種針對小型數據訓練的分類深度網絡,遷移學習已在相關的訓練數據集中進行了預訓練,因此可縮減在目標數據集的訓練時間。較早將遷移學習用在MRI AD診斷上的是采用3D的CNN方法[13-14],其利用SAE提取特征,然后將其作用于網絡的較低層中,而較高層則通過全連接層實現。該3D CNN可在(Computer-Aided Diagnosis of Dementia,CADDementia)[15]數據集上進行訓練和驗證,也可遷移至阿爾茨海默病神經影像學倡議(Alzheimer’s Disease Neuroimaging Initiative,ADNI)[16]數據集。雖然該方法能夠得到較高的分類準確率,但畢竟采用3D卷積,權重數量龐大,盡管網絡文件可公開下載,預訓練權重卻未提供下載,這些都致使其訓練時間過長,成為其進一步擴大應用的制約因素。因此,二維(2D)遷移網絡被提出用在MRI的AD診斷上,AlexNet[17]和VGG16[18]作為可遷移網絡,已在AD診斷上展示了良好性能。這兩個遷移網絡分別采用AlexNet和VGG16作為預訓練網絡,然后將MRI圖像進行切片,按位置和圖像熵選擇若干張切片圖像作為2D卷積神經網絡的輸入,再將2D神經網絡的輸出送至一個頂層網絡中實現最后的分類。由于該方法將MRI圖像進行切片,該切片可以作為2D卷積神經網絡的輸入,避免了3D圖像與2D網絡維度不匹配問題。然而,切割不可避免帶來信息丟失,致使分類的準確率受到影響。

針對以上問題,本文提出了一種3D遷移學習網絡,該遷移學習可實現MRI的AD與正常控制(Normal Control,NC)分類。首先,將一個被試者的MRI圖像進行切片,得到若干二維圖像,再將這些二維圖像輸入到預訓練的遷移網絡中完成瓶頸特征提取,然后對瓶頸特征進行有監督的頂層特征提取,最后將來自每個切片提取的頂層特征合并輸入到分類層網絡實現分類。相比以往的遷移學習,該3D網絡可從MRI圖像中提取更多的特征值,因此具有更高的分類正確率。同時,引入了遷移學習,其瓶頸層網絡已經過預訓練,且頂層網絡采用有監督訓練,因此減少了訓練時間。實驗中,本文采用公開的華盛頓大學阿爾茨海默病研究中心的開放成像數據(Open Access Series of Imaging Studies,OASIS)[19]和預訓練權重可下載的MobileNet網絡,相比傳統的2D遷移網絡,分類準確率提高了約8個百分點,而分類時間約為傳統堆疊自動編碼器(Stacked Auto-Encoder,SAE)方法的1/60。

1 維度匹配問題

由于公開的AD MRI數據有限,本文將采用面向小數據集分類的遷移卷積神經網絡來實現AD分類。同時,為了減少分類信息的損失,考慮一種3D網絡的分類方法。與傳統方法相比,本文的分類網絡需要保證輸入到分類網絡的數據應包含豐富的分類信息,同時也要使得分類網絡不能太復雜,以免造成較長的訓練時間,因此數據如何進入分類網絡是將MRI數據應用于遷移學習的AD分類的首要問題。作為一種高清晰的成像技術,MRI信號是一個包含腦區結構像的3D圖像,因此是一個NX×NY×NZ的3D數據,其中NX、NY和NZ分別表示腦區的三個空間維度。

一種常用的MRI數據應用于2D遷移學習的方法是將MRI數據進行切割[17-18],得到N1張N2×N3的二維圖像,其中Ni,i=1,2,3可以是NX、NY和NZ的任一維,從而可得到冠狀、矢狀或軸狀切面。然后將這N1張二維切面輸入到2D遷移網絡,最后構建一個頂層網絡實現最終的分類。此時,原來的MRI數據經切割后從三維降至二維,因此解決了2D CNN網絡的輸入維度問題。然而,該方法的性能將取決于N1的值。理論上,N1的取值越大越好,這相當于原3D圖像經切割后信息丟失得越少。然而由于深度學習通常是深度網絡,輸入的圖像越多則權重將變得異常龐大。以一個CNN網絡為例,假設其共有NC個卷積層,每個卷積層分別由L1,L2,…,LN個特征圖組成,特征圖的大小分別為F1×F1,F2×F2,…,FN×FN,所使用的卷積核尺寸分別為M1×M1,M2×M2,…,MN×MN,若步長(stride)為1時,那么該網絡總共的權重數量為:

其中偏置數為1。由式(1)可見,網絡的權重數與MRI圖像切片數N1密切相關,N1越大WCNN也越大。

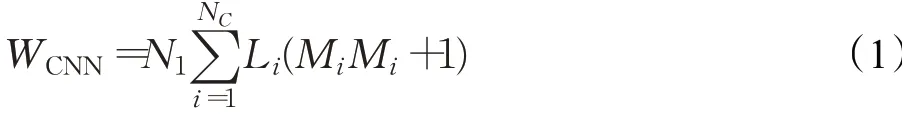

為減小切片數,也可按照一定規律進行切割。一種方法是按位置排序,越靠腦中部位置的切片將保留,反之則舍棄[17];另外一種方法是按圖像熵排序,熵越大的切片將保留下來[18]。然而,不管是以上哪種方法切割,若減少切片數將不可避免帶來MRI圖像經切割后的信息損失,但增加切片數又將使網絡變得復雜,訓練時間延長,如圖1所示。因此,在MRI信息損失和遷移網絡復雜度上尋找平衡,以保證分類網絡的分類準確率和減少訓練時間將是本文研究的一個重要問題。

圖1 MRI遷移學習的AD分類問題Fig.1 AD classification for MRI transfer learning

2 算法

2.1 分類基本過程

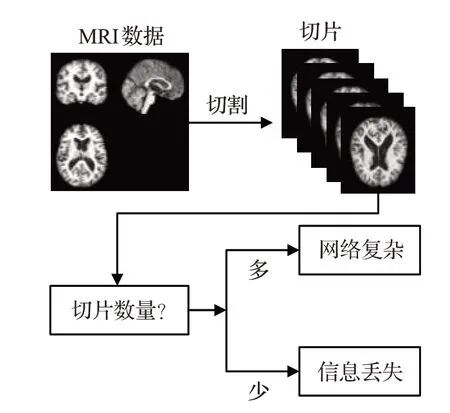

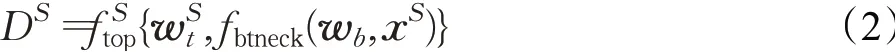

本文使用MRI數據以及采用遷移學習的CNN網絡來對AD進行診斷,方法的基本過程如圖2所示。把一個被試者的MRI數據經I個切片后輸入到已預訓練完的遷移瓶頸(Bottleneck)網絡中,以此獲得每個切片的瓶頸特征,再將每個切片的瓶頸特征經一頂層以獲得頂層特征,然后該被試者所有切片的頂層特征輸入到分類層中得到最后分類結果,完成疾病診斷。在該訓練網絡中,無論是瓶頸層還是頂層的權重對于每一個切片均為共享,不需要對每個切片都采用不同的權重,因此,即使增加切片數量,權重數量也沒有得到增加。在本文方法中,遷移的瓶頸網絡是用一個2D網絡來對2D切片的特征進行提取,因此只要對3D圖像產生足夠的切片數就可實現對3D圖像的分類。同時,雖然對每個切片都提取了瓶頸層特征,然而分類網絡中又添加了頂層來進一步降維來提取特征,因此特征值維度將變小,分類網絡的復雜度也將降低。

圖2 分類方法基本框架Fig.2 Basic framework for classification

2.2 遷移學習的3D特征提取

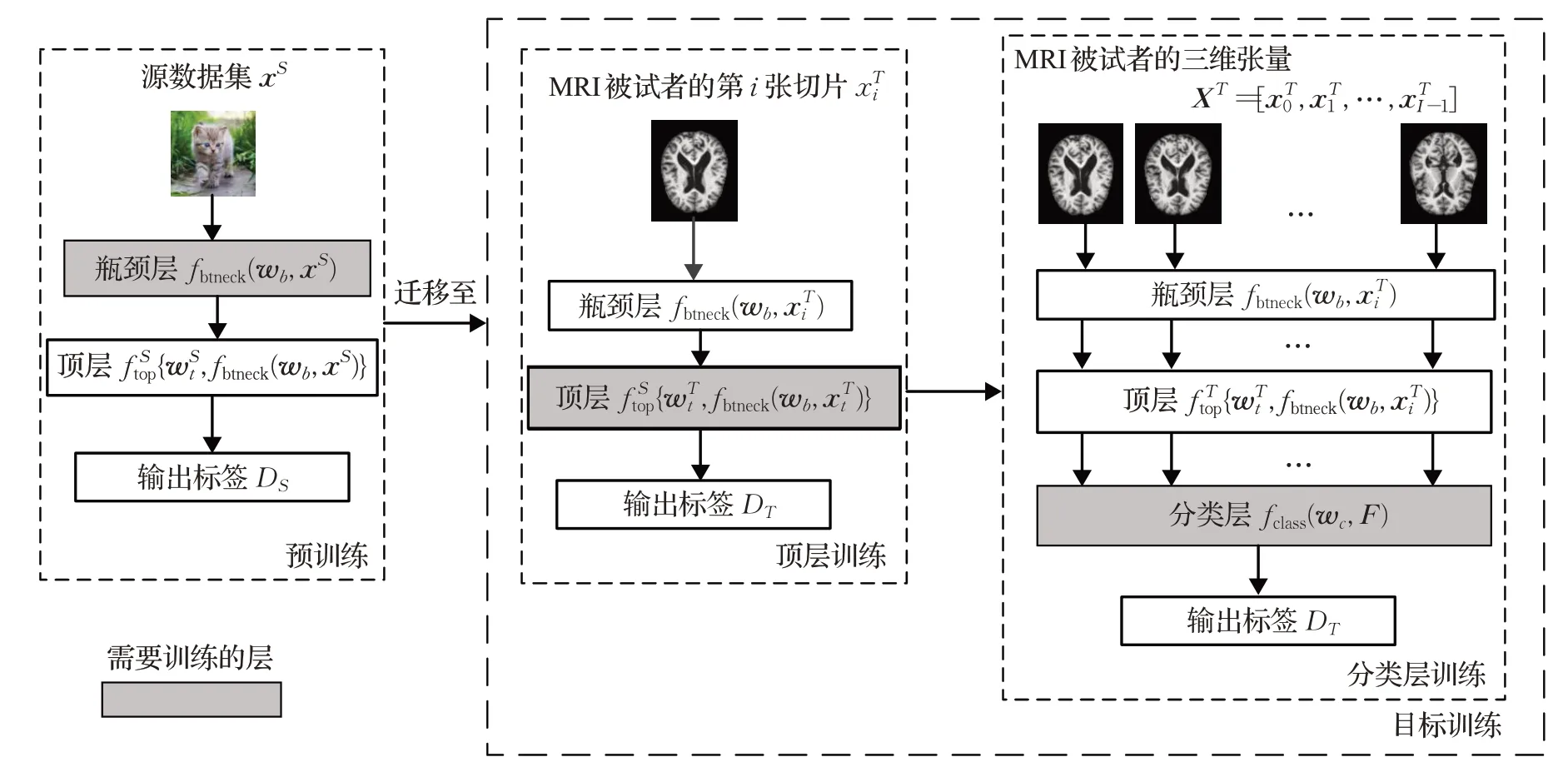

一個MRI信號往往是一個具有腦區空間的三維數據,不能直接作為一個2D圖像分類器的輸入。由上所述,為實現3D圖像的特征提取,利用一個2D的遷移網絡來提取圖像切片的特征。設xS和DS分別是一源數據集中任意一張2D圖像矢量和其對應標簽,將一CNN網絡在該源數據集中進行預訓練,使其滿足

預訓練完成后,將在目標MRI訓練數據集中訓練網絡以完成遷移學習的特征提取。首先,完成頂層網絡訓練。把訓練集中任意一個被試者的MRI中第i個切片圖像作為遷移網絡fbtneck(?)的輸入,使得該被試者及其所對應標簽DT滿足

其次,完成分類層網絡訓練。把訓練集中任意一個被試者的MRI 3D圖像張量作為遷移網絡fbtneck(?)的輸入,使得該被試者XT及其所對應標簽DT均滿足

則目標網絡分類層fclass(?)訓練完成,其中wc是分類層權重矢量,F為圖像張量XT經I個切片后由式(3)得到的頂層特征矢量,表示為

圖3 給出了遷移學習AD特征提取的訓練過程,整個過程包含預訓練和目標訓練兩部分。其中預訓練部分通常無需在本地端完成,即使瓶頸層的權重wb非常龐大,但可由第三方預先完成而獲得,因此可大幅減少提取特征的訓練時間。更重要的是,為保證提取瓶頸特征的有效性,訓練和獲取瓶頸層權重wb往往在一個非常巨大的源數據集中完成,如ImageNet數據集,因此相比單純無遷移的CNN,遷移網絡可以解決目標數據集不足的情形,而目前獲取大規模ADMRI數據仍存在一定困難。圖3中的AD目標訓練中又包含頂層訓練和分類層訓練兩部分,其中頂層訓練的輸入是由被試者的每張切片所提取的瓶頸層特征,瓶頸層的權重則來自于預訓練后得到的結果。頂層網絡的輸出為從每張切片中提取的特征值,而每張切片的標簽將對應所屬被試者的標簽。訓練完畢的頂層權重將可用于分類層訓練,分類層訓練的輸入是以被試者為單位的3D切片張量圖像,而該切片張量經過頂層得到該被試者的MRI圖像特征,然后進入分類層以完成最終分類層的訓練。值得注意的是,圖3分類層訓練中分類層的權重wc對每一個切片都為共享,因此即使每個被試者的切片數量I非常龐大,相比非共享的方式,權重數也僅為其1/I。另外,提取特征值的頂層訓練和分類層訓練均為有監督訓練,由于無監督SAE訓練不僅需要編碼層還有解碼層[15],本目標訓練的層數可減少1/2。

圖3 遷移學習特征提取訓練圖Fig.3 Train and feature extraction in transfer learning method

其實,圖3的遷移學習特征提取只需對一頂層網絡和分類網絡進行訓練,而兩者均是一個淺層的神經網絡,其權重和wc的數量并不大,因此可保證訓練能在短時間內完成。另外,由于頂層特征來源于一個被試者的若干切片圖像,只要切片數量足夠多,則可以保證MRI圖像的信息損失足夠小,而由于頂層的權重對所有切片均為共享,并不會使切片數量增大而使權重數量增大,這也可保證較少的網絡訓練時間。當然,頂層特征來自對瓶頸特征的提取,而瓶頸層fbtneck(?)的權重wb雖可由預訓練得到,但瓶頸層的特征也需由fbtneck(?)得到,因此太復雜的可遷移CNN網絡fbtneck(?)會增大特征提取的計算量,本文將選用一種輕型的CNN網絡來實現遷移學習。

2.3 MobileNet的遷移學習

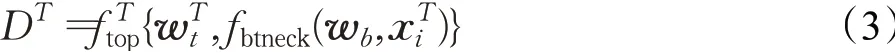

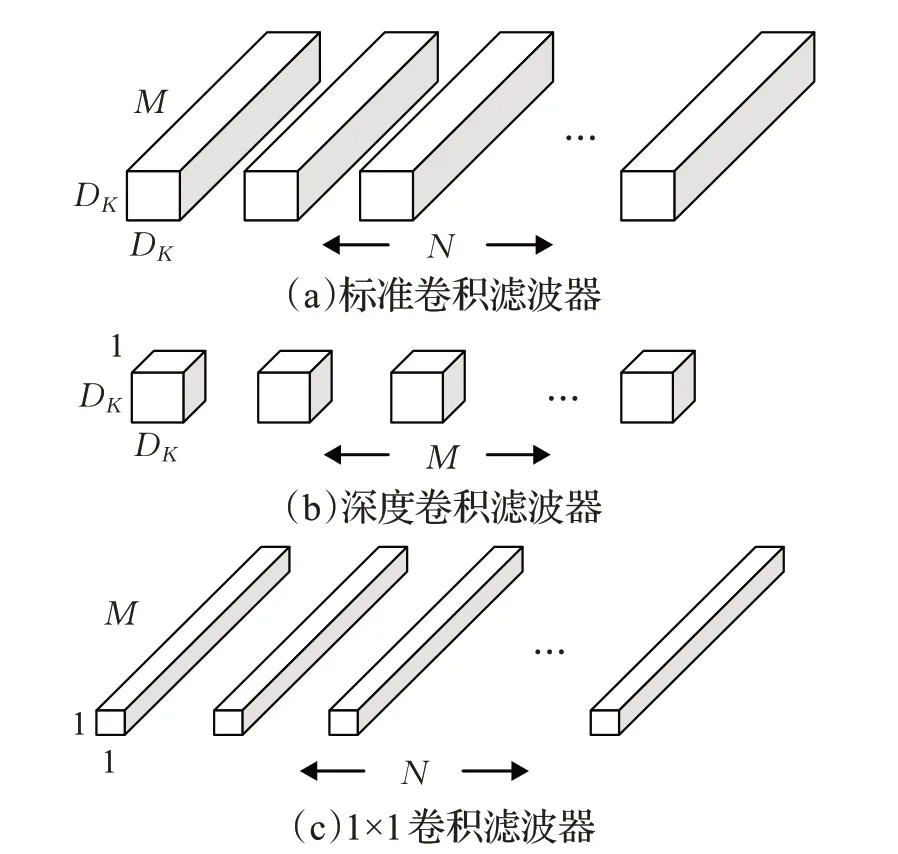

在遷移學習的目標訓練中,將選用MobileNet來作為瓶頸層網絡,該網絡能夠在保持模型性能的前提下降低模型大小,同時提升模型速度。這樣可大幅減少計算量和模型參數量,并且它的預訓練權重可下載,它采用一種深度可分離卷積代替傳統卷積運算,將一個標準的卷積分解成一個深度卷積和一個點卷積,如圖4所示,具體計算過程如下。

圖4 MobileNet的深度可分離卷積網絡Fig.4 Illustration for separable convolution in deep MobileNet

對于一個N1×N2的MRI數據的切片來說,設其輸入通道為M,經過一個標準卷積層,則將產生一個No×NT×NA的特征圖,No是輸出通道數。若經過一個卷積核大小為DK×DK×M×No的標準卷積層,其中DK是卷積核維度,那么該標準卷積的計算成本為

在深度可分離卷積中,先使用深度卷積為每個輸入通道應用單個濾波器,深度卷積的計算成本為DK×

然后使用1×1的卷積濾波器來創建深度層的輸出的線性組合,其計算成本為M×No×N1×N2。

從而深度可分離卷積的計算成本為DK×DK×M×

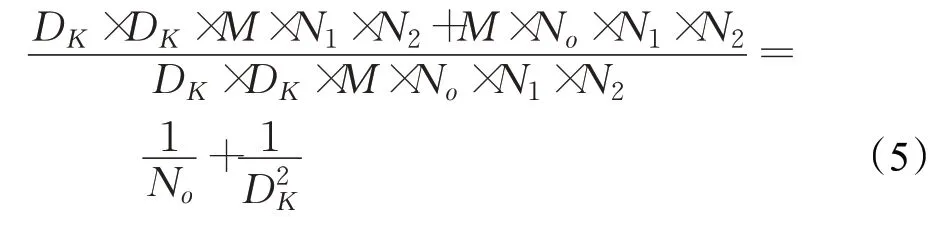

因此,深度可分離卷積的計算成本與標準卷積之比為:

由式(5)可知,MobileNet的瓶頸層所需計算量與相同規模的傳統遷移網絡比,大大減少。因此從計算量角度,選擇MboileNet作為遷移網絡是較好的選擇。

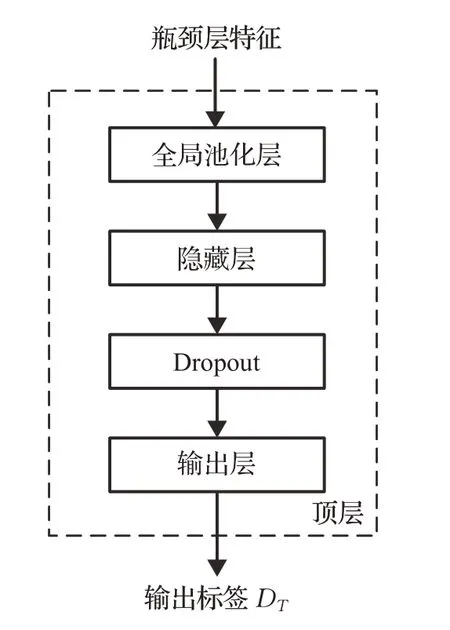

2.4 頂層與分類層設計

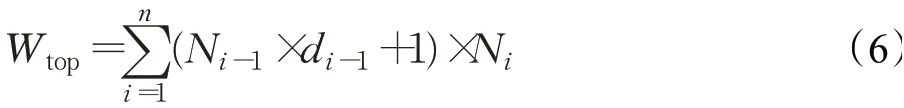

在目標訓練中,瓶頸層網絡采用遷移的MobileNet網絡,無需自行設計,但頂層網絡和分類層網絡需要設計以保證提取有效的特征。頂層網絡的目的是對瓶頸層特征降維,以進一步提取特征,頂層網絡設計如圖5所示,主要包括全局池化層、全連接層和激活函數輸出層。因此,該頂層的權重數量為:

圖5 頂層訓練設計Fig.5 Top layer in transfer learning

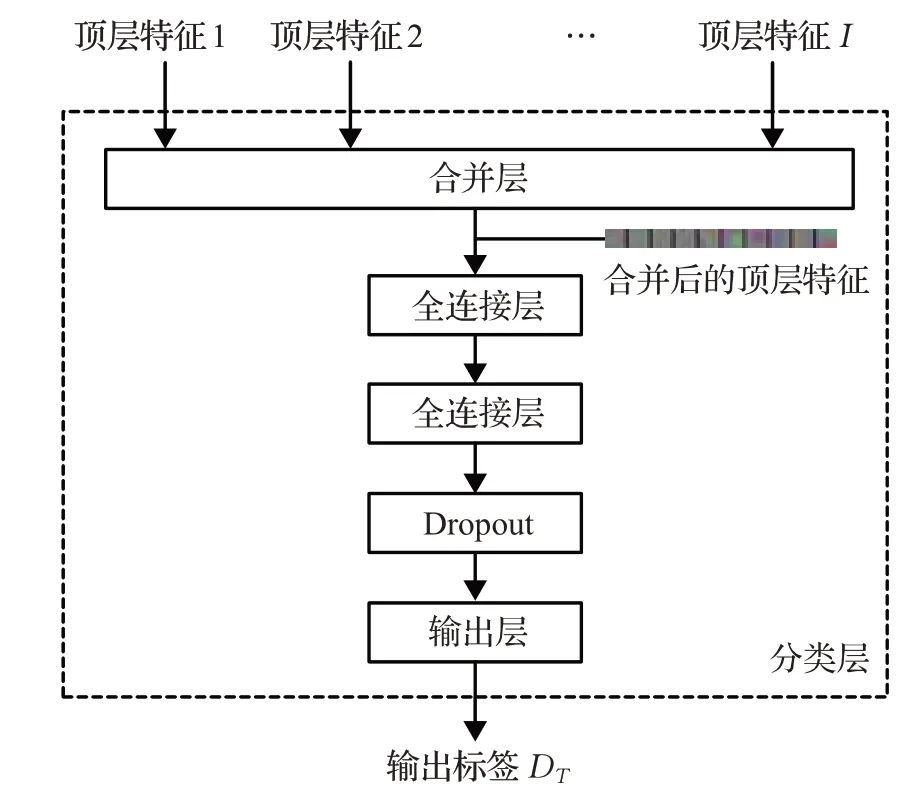

其中,n為全連接層的層數,Ni-1和Ni分別為第i-1層和第i層的神經元個數,di-1為神經元Dropout率,1代表偏置數。在頂層中,經提取和融合后的瓶頸層特征維度已經降至很低,即N0較小,且層數值n較小,因此式(6)的權重數不會很大。分類層網絡的目的是對每個被試者的若干張切片的瓶頸特征進行合并,以形成該被試者的特征表示,最后實現分類。分類層網絡設計如圖6所示,主要包括全局池化層、兩個全連接層和輸出層,其權重數量類似式(6),若m為分類層的全連接層數,則代入式(6)可得分類層權重數量。

圖6 分類層訓練設計Fig.6 Classification layer in transfer learning

需要注意的是,頂層和分類層中的一些參數設定會影響最后的分類結果,如全連接層層數、全連接層的神經元數、Dropout的權重丟棄率等,如何選擇合適的參數值可以通過實驗來測試,這部分的討論將在實驗部分做詳細介紹。

2.5 分類算法步驟

本文遷移學習AD分類算法的訓練步驟如下所示。

輸入:

輸出:

已知條件:

瓶頸層網絡fbtneck(?)及其權重wb;

分類層網絡fclass(?)。

初始條件:

步驟:

1.預處理:對原始圖像進行預處理得到XT,然后分成訓練集和測試集,再進行切片

4.分類層訓練:由式(4)得到分類層權重wc;

5.驗證:由驗證集,通過式(4)得到分類結果,并計算分類準確率;

6.重復執行步驟3~5直至獲得較高分類準確率。

3 實驗

3.1 實驗設置

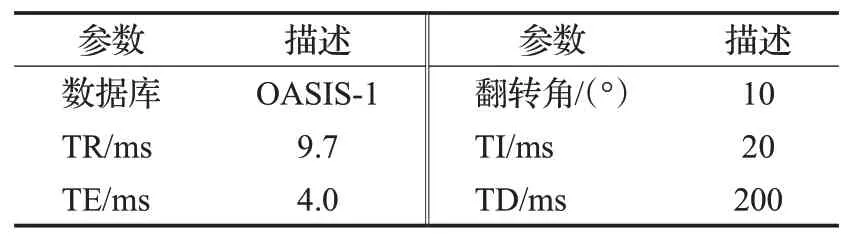

在本實驗中,所采用的MRI數據均來源于華盛頓大學阿爾茨海默病研究中心的OASIS數據庫,其網址為http://www.oasis-brains.org/,所下載的數據為OASIS-1數據組。該數據包含了416名年齡在18歲至96歲的男性和女性被試者,所有被試者均是右撇子,其中AD被試者100人,NC被試者316人,其數據采集參數詳見表1。除此之外,所下載的每個被試者數據均包含源數據和預處理后數據,本文選擇預處理后數據作為研究對象,該數據已經過去面部特征、平滑、校正、標準化和配準等預處理[19]。最終,本實驗選取了100個AD和100個NC數據,其中AD組包含了70個非常輕度、28個輕度和2個中度AD的被試者數據,NC組數據則從數據庫中隨機選取。

表1 OASIS中MRI數據相關參數Table 1 Parameters of MRI data in OASIS

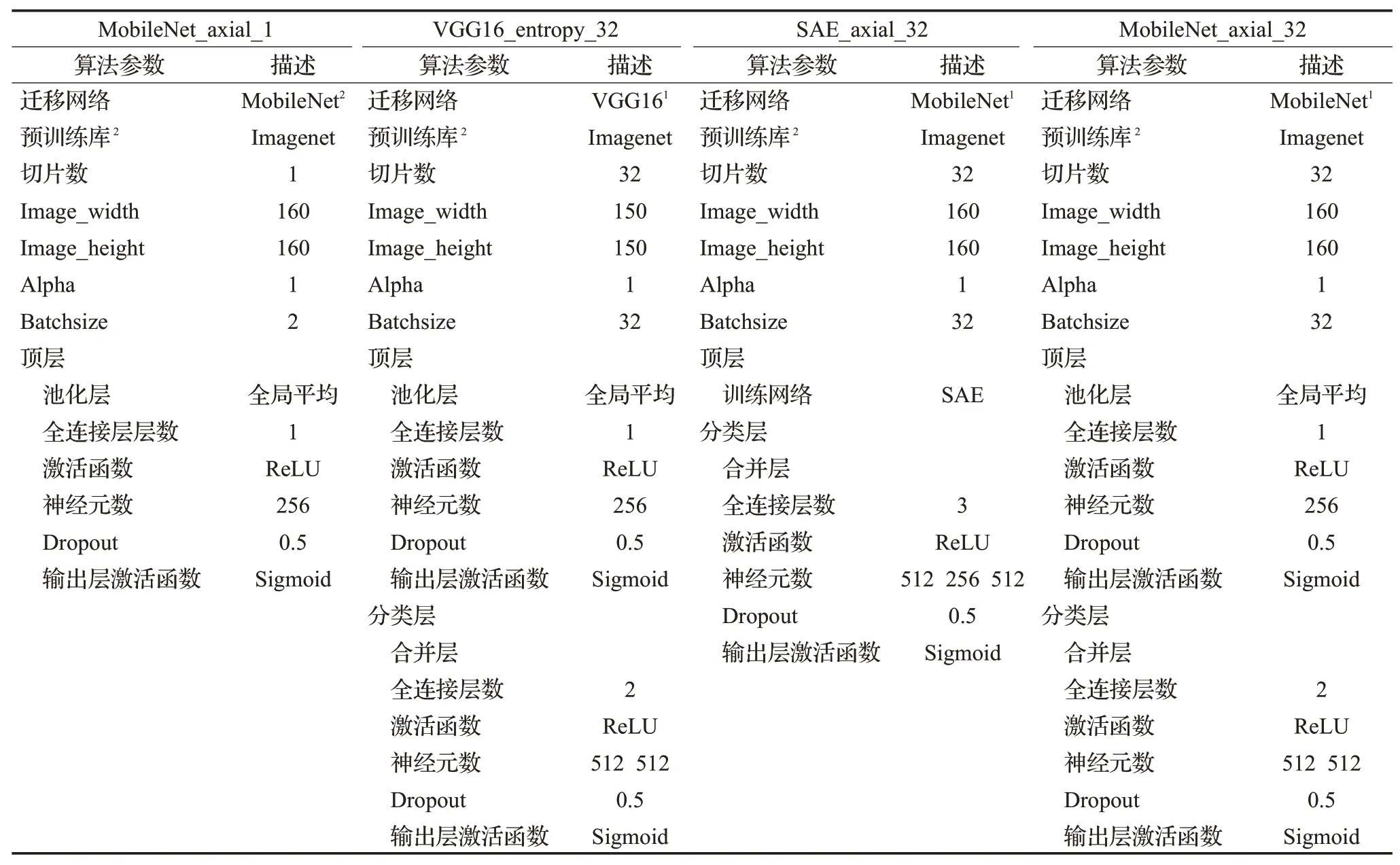

本實驗分別用以下幾種遷移學習的方法提取特征和分類,具體參數由表2列出,步驟簡述如下:

表2 相關分類方法參數Table 2 Parameters in evaluated classification algorithms

(l)MobileNet_axial_1:選取每個被試者最靠近中心的1張軸狀切片,用MobileNet提取瓶頸特征后,經頂層網絡得到分類。

(2)VGG16_entropy_32:由文獻[18]的方法,選取每個被試者信息熵最高的32張MRI切片,其余步驟如第2.5節。需要注意的是,文獻[18]中同一被試者的若干張切片被隨機地分配到訓練集和驗證集,而本文方法的訓練集和驗證集的切片以被試者劃分,即同一被試者的切片只能劃分至訓練集或驗證集,以避免驗證集中被試者的某些切片已被訓練的情況。

(3)SAE_axial_32:由文獻[17]按位置切片的方法,選取每個被試者最靠近中心的32張軸狀切片,經MoblieNet提取瓶頸特征,提取的瓶頸特征再經SAE提取頂層特征,最后合并被試者的各切片頂層特征送至分類層分類。

(4)MobileNet_axial_32:切片方法與SAE_axial_32相同,其余步驟如第2.5節。

本實驗所測試的所有分類方法均采用5折交叉驗證,將總數據樣本隨機分成5份樣本,選擇其中一份樣本作為驗證集,其余的樣本作為訓練集,每個子樣本用作測試集1次,交叉驗證重復5次。需要注意的是,5折交叉驗證是對被試者進行劃分,即同一被試者的所有切片是在同一個數據集中,避免被試者的一部分切片在訓練集經過訓練,其余切片在驗證集的情況。根據以上的測試方法,各分類方法的分類準確率為5次分類結果的平均值。

本實驗還給出了各遷移方法運行時間的結果,包括了完成一次5折交叉驗證時提取瓶頸特征時間、提取頂層特征時間、分類層時間以及總時間。所有方法均在Ubuntu 16.04下Anoconda Python2.7上進行,遷移學習平臺為以TensorFlow為后端的Keras,運行硬件為帶有Intel?CoreTMi5-5200U(4核)CPU的PC機,未采用任何GPU。

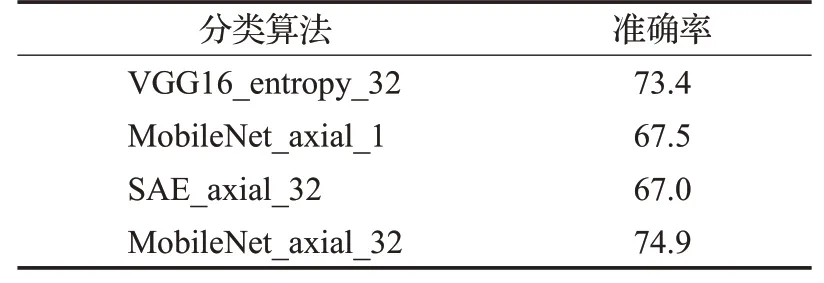

3.2 分類準確率結果

首先,給出各方法的分類準確率,如表3所示。在表3中,MobileNet_axial_1的分類準確率為67.5%,由于該方法僅選取了一張最靠近中心位置的切片,包含的信息不完整,分類準確率較低。表中其余方法的分類結果均對一個被試者的若干切片進行綜合得到,其中SAE_axial_32的分類準確率較低,僅有67%,剩余兩種方法的準確率均超過了70%,該結果表明利用SAE提取頂層特征的方法分類準確率并不高。分類準確率最高的是MobileNet_axial_32,其分類準確率約75%,與其余的VGG16_entropy_32、MobileNet_axial_1、SAE_axial_32三種方法的分類準確率相比,分別提升了1.5個百分點、7.4個百分點、7.9個百分點。這也表明,利用有監督訓練提取頂層特征并在分類層合并的方法的分類準確率要高于僅利用瓶頸特征進行分類的方法。

表3 不同分類方法的分類準確率Table 3 Classification accuracy for evaluated classification algorithms %

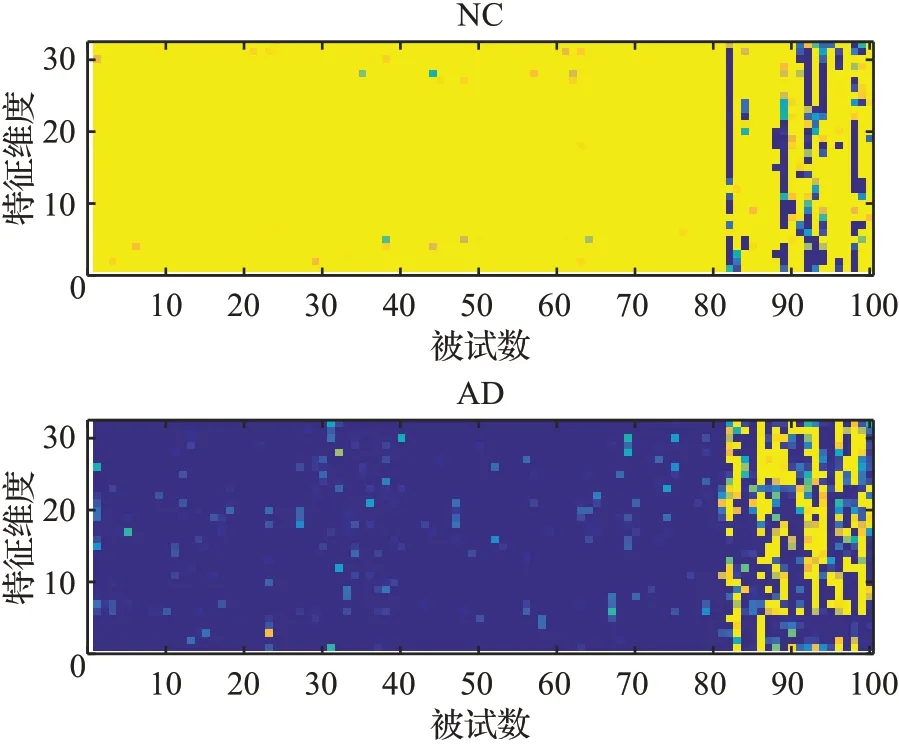

圖7 給出了預訓練網絡MobileNet所提取的特征值結果圖,其中NC是預訓練網絡MobileNet提取NC組的頂層特征,AD是預訓練網絡MobileNet提取AD組的頂層特征。被試者數1~80為訓練集,81~100為驗證集。從圖中可以看出,NC組測試集的頂層特征值大部分集中在0.8~1.0之間,而AD組測試集的頂層特征的一部分值在0.2左右,存在一定的差異性,可確保AD與NC的分類。

圖7 頂層提取的特征值Fig.7 Features extracted from top layer

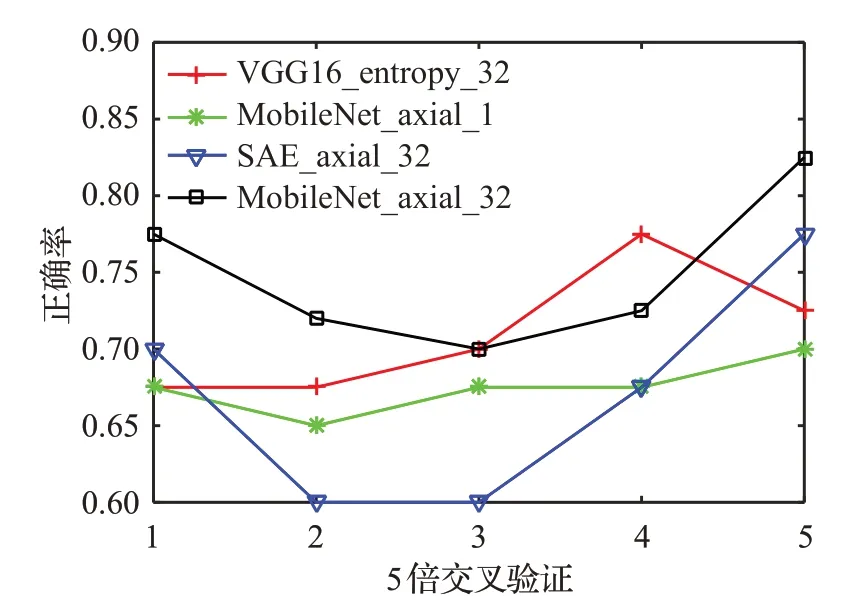

圖8 給出了四種分類方法在5次交叉驗證中的分類準確率曲線,雖然SAE_axial_32在第1和第5次實驗有較高準確率,但是其余實驗的分類準確率較低,且曲線波動較大。另外一方面,雖然MobileNet_axial_32和VGG16_entropy_32這兩種分類方法并不是每次實驗都有較高的分類準確率,但是波動較小,因此平均值相對其他兩種方法較高。這也表明,利用遷移學習網絡提取特征的方法較SAE的方法更好。

圖8 不同分類方法的分類準確率曲線Fig.8 Classification accuracy curves for evaluated classification algorithms

3.3 分類時間

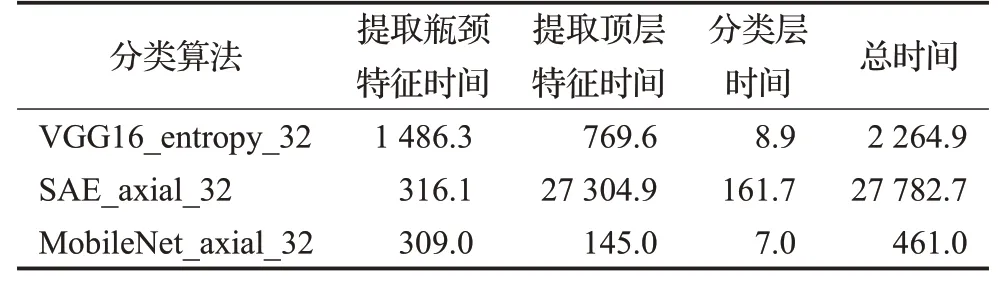

表4 給出了各遷移方法提取瓶頸特征時間、提取頂層特征時間、分類層時間和總時間。從表4中可以看出,當切片數相同時,使用MobileNet提取瓶頸特征的時間少于用VGG16提取瓶頸特征,減少了近80%。這表明MobileNet使用深度可分離卷積,大大減少了計算量。從表中還可以看出,與SAE_axial_32相比,MobileNet_axial_32提取頂層特征的時間減少了近96%,且分類時間也減少了近96%,總時間減少了近97%。這都表明了在相同的環境下,設計一個有監督訓練的頂層所提取特征的時間遠少于用SAE提取特征的時間。

表4 分類算法運行時間Table 4 Running time for evaluated classification algorithms s

3.4 其他因素對算法的影響

本節給出了其他因素對本文3D遷移學習網絡的分類影響。

首先,給出各切片方法對結果的影響,如圖9和表5所示,采用的切片方法參照文獻[17-18]得到,簡述如下:

(l)MobileNet_acs_32:分別沿軸狀、矢狀和冠狀對每個被試者的MRI圖像進行切片,選取靠近中心的32張MRI切片,其中包含了11張軸狀、11張矢狀和10張冠狀切片。

(2)MobileNet_entropy_32:對每個被試者的MRI圖像切片,選取信息熵最大的32張軸狀切片。

(3)MobileNet_axial_32:對每個被試者的MRI圖像切片,選取最靠近中心位置的32張軸狀切片。

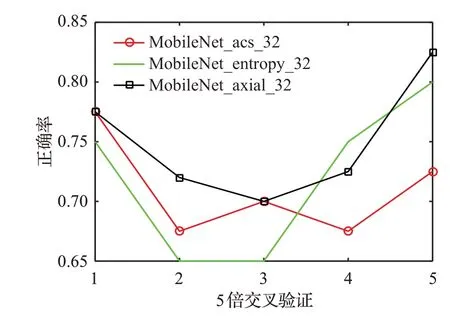

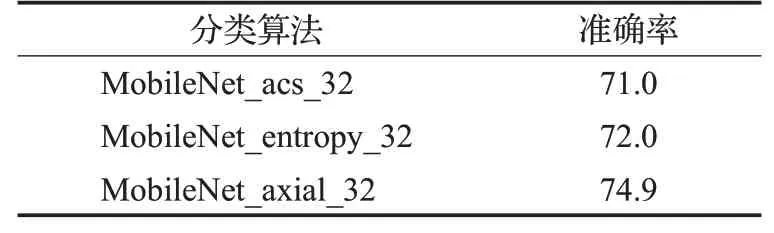

以上方法切片后所采用的步驟均如第2.5節所述。其余參數同MobileNet_axial_32。從圖9可以看到,除第4次外,MobileNet_axial_32的分類準確率均較高,與表5的結果一致。該結果表明,按中心位置選取切片的方法優于按信息熵選取切片的方法,且切片選取應在同一狀位。

圖9 不同切片方法的分類準確率曲線Fig.9 Classification accuracy curves for different slice segment methods

表5 不同切片方法的分類準確率Table 5 Classification accuracy for different slice segment methods %

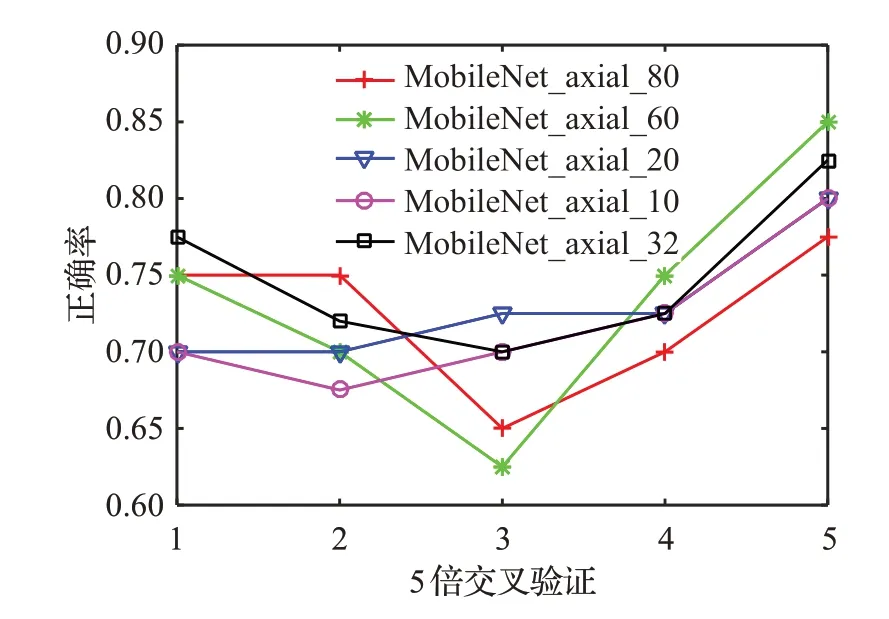

再次,給出切片的數量對分類算法的影響,分別選取了最靠中心位置的80張、60張、32張、20張和10張軸狀切片,分類算法的其余參數同表5和圖9中的算法所采用參數,分類結果如圖10和表6所示。總體看,各切片數量的分類準確率較為接近,32張切片的結果略高于其余切片數量,然而切片數量太多會導致網絡復雜度上升,而切片數量太少,分類準確率會略有下降,因此選用32張切片是一種可行的折衷方案。

圖10 不同切片數的分類準確率曲線Fig.10 Classification accuracy curves for different counts of slices

表6 不同切片數的分類準確率Table 6 Classification accuracy for different counts of slices %

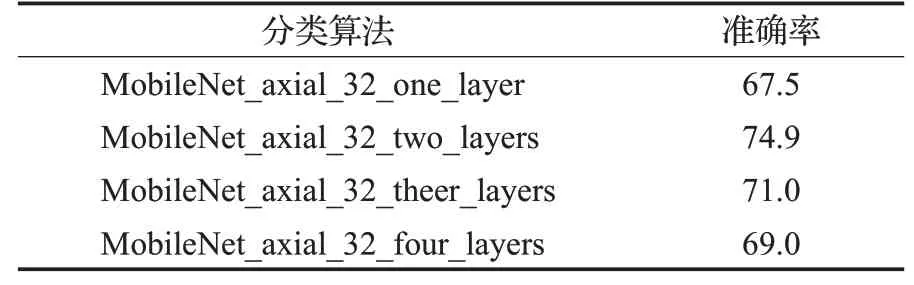

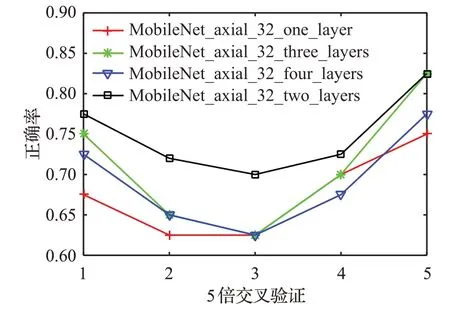

最后,給出分類層參數對本文3D遷移網絡的分類影響,主要考慮分類層中全連接層的層數。表7給出了全連接層數分別為1、2、3和4時MobileNet_axial_32的平均分類準確率,圖11給出了每次交叉驗證的分類準確率曲線。從圖中可以看到,具有兩個全連接層的分類層網絡的分類準確率曲線最高,且表中的平均準確率最高的也是兩個全連接層的網絡,因此,設計具有兩個全連接層的分類層網絡是一個較好的選擇。

表7 分類層中不同全連接層數的分類準確率Table 7 Classification accuracy for different full-connect layers in classification layer %

圖11 分類層中不同全連接層數的分類準確率曲線Fig.11 Classification accuracy curves for different full-connect layers in a classification layer

4 討論

針對MRI數據的AD分類問題,本文采用遷移學習MoblieNet網絡對切片數據進行特征提取,再進入到頂層提取頂層特征,最后由分類層網絡分類。實驗結果表明,本文方法較其他方法的分類準確率有所提升,且運行時間也有較大程度的減少,但還有以下幾點需要進一步進行討論。

首先,本文所采用的遷移網絡與傳統的3DCNN網絡[13-14]相比,AD的分類準確率未表現出顯著提升。然而,3DCNN將3D的MRI圖像數據直接作為深度網絡的輸入,權重將不可避免地大幅增加,使得訓練時間也大幅增加,而本文方法采用2D遷移網絡的預訓練權重來提取特征,可大幅減少訓練時間,且與傳統診斷AD的2D遷移網絡相比,分類準確率確實得到了提高。因此,作為一種用于AD輔助診斷的機器學習算法,本文的遷移網絡在減少計算成本和節約訓練時間上具備一定優勢。另外,本文僅使用MRI數據進行AD分類,而文獻[20-26]的高分類準確率是建立在多模態分類方法上,除使用MRI,還使用了PET和腦脊髓液等數據,因此也可以考慮使用更多種類數據來進一步提高本文的遷移網絡分類準確率。

本實驗主要從OASIS-1數據庫中選取數據,因此實驗所得到的分類準確率結果僅局限于該數據庫上,嚴格意義上,要得到更完整的分類準確率結果還應嘗試更多的數據庫數據。本文所對比的傳統遷移網絡[18]使用該數據庫,因此選用該數據庫能得到較為直觀的對比結果。在未來的工作中,也可以使用ADNI和CADDementia等數據庫。

在選取切片數上,僅給出被試者10、20、32、60、80張切片的實驗結果,并未嘗試其他切片數量來作為網絡的輸入。由于離中心位置較遠,靠近頭顱兩邊的切片包含的結構信息較少,且切片數越多,冗余信息越多,過多切片反而降低分類準確率,增加網絡運行時間,因此沒有考慮更多的切片數量。

在分類層參數設置的實驗中,僅給出了全連接層數的實驗結果,而未對其他參數做進一步討論,這主要是因為相對于其他參數,全連接層數對分類結果的影響比較大。對于激活函數,也嘗試了一些常用的softmax、tanh、sigmoid等函數,但發現這些函數的分類結果并沒有較大差別,因此選擇了最常見的ReLU。當然,還有一些參數對頂層性能也非常重要,例如全連接層節點數。然而,節點數量可由經驗確定,若節點數太小,網絡無法適應大尺寸圖像,若節點數太大,會增加訓練時間且可能產生過擬合,本文的分類層網絡的兩個全連接層的節點數均設置為512。

5 結論

利用機器學習方法來輔助診斷AD可減少人工診斷的時間和人力,本文提出了一種利用MRI信號來分類AD和NC的遷移網絡機器學習方法。在實驗中,采用了OASIS-1的MRI數據,將本文方法與其他傳統方法進行了對比,結果顯示本文方法的分類準確率比僅用VGG16提取瓶頸特征來分類的方法提高了1.5個百分點,總時間減少了約80%;比用SAE提取特征來分類的方法,準確率提高了約8個百分點,總時間減少了約98%。該結果說明,對于MRI數據,從瓶頸特征提取出頂層特征再到分類層合并的方法要優于直接從瓶頸特征進行分類的方法,其分類準確率得到提高,并且使用有監督的頂層特征訓練時間要少于無監督的SAE方法。