基于遺傳算法的多模態病變圖像關聯挖掘仿真

岳根霞

(山西醫科大學汾陽學院,山西 汾陽 032200)

1 引言

通過單一成像設備對病變信息進行獲取往往無法為醫生提供充足的病理信息,此時需要用多種成像設備對病人的同一病變部位進行多次成像,并對通過多種成像設備得到的圖像進行融合以及比較分析,才能獲取更加全面的病變部位相關信息,從而幫助醫生對疾病進行更加準確的判斷并提出更具針對性的治療方案。而圖像采集技術在醫學界的應用與普及,使醫學治療領域與臨床診斷領域出現了多種醫學成像設備,為醫生對疾病的診斷提供了不同特性的多種醫學圖像,這些圖像通常來源于各種成像設備,因此具備多模態的特征,能夠為醫生對疾病的診斷提供決定性的關鍵信息,這些圖像被統一稱為多模態病變圖像[1]。

當前多模態病變圖像的獲取方式有基于剛體模型的多模態病變圖像、基于圖像灰度的多模態病變圖像、基于圖像特征點的多模態病變圖像[2]。其中基于剛體模型的多模態病變圖像主要是結合最近鄰點迭代法、斜面匹配法與頭帽法對病變圖像進行獲取,并利用初步獲取的病變圖像建立頭表面模型,利用搜索算法對頭表面模型的空間變換參數進行獲取,從而得到病變圖像的多模態特征;基于圖像灰度的多模態病變圖像主要是結合多項式函數、基函數等變換函數對圖像進行空間變換,并通過空間變換對其它圖像中的同一部位或器官進行擬合,從而實現病變圖像多模態特征的獲取;基于圖像特征點的多模態病變圖像主要是通過圖像的外部特征點與內部特征點對多幅圖像的重要拐角、曲面、曲線等對應特征進行匹配,并通過對應特征的匹配度對圖像的幾何變換方式進行決定,從而獲取病變圖像的多模態特征[3]。這幾種傳統多模態病變圖像的獲取方法都有一個共同的問題,即圖像挖掘誤差較大,因此提出一種基于遺傳算法的多模態病變圖像,通過實驗驗證了該多模態病變圖像的圖像挖掘誤差小于傳統多模態病變圖像的獲取方法。

2 基于遺傳算法的多模態病變圖像合成

2.1 病變圖像互信息歸一化

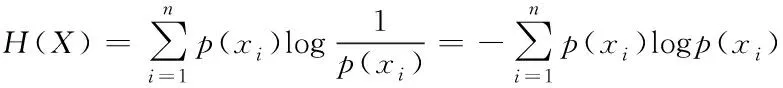

首先獲取病變圖像Shannon 信息熵中條件熵與聯合熵的關系,接著根據病變圖像Shannon 信息熵關系對病變圖像的互信息進行歸一化處理[4]。根據Shannon 信息熵的定義,對病變圖像中隨機特征變量的熵進行定義,如式(1)所示,其中隨機特征變量中包含的事件集合為{x1,x2,…,xn}。

(1)

其中,H(X)代表隨機特征變量的熵;X代表隨機特征變量;p(xi)代表事件xi發生的概率[5]。假設病變圖像中兩個隨機特征變量分別為Y與Z,并且Y與Z的取值范圍分別是{y1,y2,…,yn}與{z1,z2,…,zn},則Y與Z的概率條件分布密度分別為{p(yi|zj)|i=1,2,…,n,j=1,2,…,n}與{p(zj|yi)|j=1,2,…,n,i=1,2,…,n},這兩個隨機特征變量的序偶隨機量可以用(Y,Z)來表示,取值范圍是{(yi|zj)|i=1,2,…,n,j=1,2,…,n},這兩個隨機特征變量序偶隨機量的概率聯合分布密度是{p(yi,zj)|i=1,2,…,n,j=1,2,…,n},則這兩個隨機特征變量的聯合熵可以用式(2)來表示

(2)

其中,H(Y,Z)指的是兩個隨機特征變量的聯合熵,代表的是序偶隨機量(Y,Z)的不確定性或隨機性。

接著對兩個隨機特征變量Y與Z的條件熵進行定義,如式(3)和式(4)

(3)

(4)

其中,H(Y|Z)與H(Z|Y)分別代表兩個隨機特征變量Y與Z的條件熵,通過條件熵可以在確定一個已知隨機特征變量時,對另一個隨機特征變量的不確定性進行度量。經過計算得到兩個隨機特征變量條件熵與聯合熵的關系

H(Y,Z)=H(Y)+H(Z|Y)=H(Z)+H(Y|Z)

(5)

當兩個隨機特征變量Y與Z處于獨立狀態時,則它們的條件熵與聯合熵的關系如下

H(Y,Z)=H(Y)+H(Y)

(6)

H(Z|Y)=H(Z)

(7)

H(Y|Z)=H(Y)

(8)

根據隨機特征變量中條件熵與聯合熵的關系對病變圖像的互信息進行歸一化處理,利用H(Y)與H(Z)表示兩個隨機特征變量Y與Z的熵,則其互信息的定義如下

(9)

利用熵的形式對互信息進行描述

I(Y,Z)=H(Y)+H(Z)-H(Y,Z)

(10)

進一步用條件熵與聯合熵對互信息進行描述

I(Y,Z)=I(Y,Z)-H(Y|Z)=H(Z)-H(Z|Y)

(11)

由于隨機特征變量具備以上性質,因此必須對其進行歸一化處理,處理方式如下

(12)

2.2 最優模態搜索

在完成病變圖像互信息的歸一化處理后,基于遺傳算法對病變圖像互信息的最優解即病變圖像的最優模態進行搜索[6]。首先確定病變圖像互信息的編碼方式:對圖像x軸方向的平移距離tx、y軸方向的平移距離ty、旋轉角α這3個參數進行實數編碼,對剩余參數采取二進制編碼方式,編碼中的各個數字都代表病變圖像的一個模態[7]。

接著對適應度函數進行確定,首先獲取每個病變圖像模態的適應值:對實際待優化模態的目標函數進行轉換以獲取模態適應值。利用病變圖像互信息對適應度函數進行描述:在T這一變換下,最優模態搜索函數為:

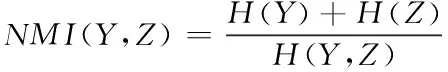

(13)

并通過模態適應值對遺傳算法的參數進行確定:包括算法最大執行代數N、種群數目P,準確選擇算法參數可以提高最優模態搜索效率,并減少程序運行時間,通常最大執行代數N與算法收斂速度直接相關,而種群數目P在10到160之間取值[8]。利用實驗法對最大執行代數N、種群數目P的取值進行確定:測試不同的取值組合,所獲得的參數列表如表1所示。

表1 不同取值組合下的參數列表

根據表2的實驗結果并考慮遺傳算法自身的穩定性,P與N的取值分別為41,40。最后需要對遺傳算法的運行停止條件進行確定,即當遺傳算法到達最大執行代數后停止搜索,則算法達到最大執行代數后,病變圖像的最優模態就是種群中的最優個體[9]。完成遺傳算法的準備工作后,對算法進行執行,其具體執行步驟如圖1所示。

圖1 算法具體執行步驟

2.3 實現多模態病變圖像的合成

完成最優模態搜索后,建立最優模態獲取模型以獲取多種成像設備病變圖像的最優模態,從而進行多模態病變圖像的合成,實現多模態病變圖像的獲取。最優模態獲取模型主要以SegNet和DeconvNet 為基礎,通過病變圖像模態數據,以特定多路網絡分割復合訓練的方式,在最優模態搜索訓練中引入反卷積網絡模型,通過最優模態搜索訓練實現對多種成像設備所獲取病變圖像的最優模態獲取。最優模態獲取模型的結構如圖2所示。

圖2 最優模態獲取模型結構

如圖2所示,最優模態搜索訓練中包括兩個訓練部分:卷積訓練部分與反卷積訓練部分,其中卷積訓練部分是對模態進行編碼,反卷積訓練部分是對最優模態進行解碼,編碼與解碼均通過反卷積網絡模型來進行。在最優模態搜索訓練中,可以將卷積網絡視為一種特征提取器,其主要作用是在成像設備病變圖像中對模態的特征描述進行提取,而反卷積網絡可以視為一種形狀生成器,其主要作用是通過模態的特征描述對最優模態進行提取,最后利用 softmax 網絡進行最優模態提取結果的生成。卷積網絡中包含的卷積層數量共13個,通過池化層與激活層能夠連接這些卷積層,除此之外,卷積網絡還包括兩個全連接層,這兩個全連接層能夠對特定類映射起到加強作用,卷積網絡主要通過池化操作實現模態特征描述的提取。而反卷積網絡是一種卷積網絡的鏡像結構,通過反池化操作來實現最優模態的提取。

獲取多種成像設備病變圖像的最優模態后,對多模態病變圖像進行合成:對多種成像設備病變圖像中的多個最優模態進行整合,引入深度神經網絡對模態整合結果進行訓練,從而獲得最優模態整合結果,實現多模態病變圖像的合成。綜上所述,通過病變圖像互信息歸一化、最優模態搜索建立最優模態獲取模型從而實現了基于遺傳算法的多模態病變圖像合成。

3 仿真研究

為了檢測本文提出的基于遺傳算法的多模態病變圖像,基于Matlab Web平臺進行仿真。

3.1 實驗過程

以Matlab Web為實驗平臺編寫vc模型仿真程序對最優模態獲取模型進行仿真,通過MIDMES 系統,系統主界面由萊單、工具欄、狀態欄和多窗口容器組成。由系統的萊單欄進入系統的各個功能模塊:圖像瀏覽與格式轉換、聚類分析、關聯規則挖掘等。當進行圖像檢索時狀態欄顯示數據庫中圖像數,以及檢索到的相似圖像數。完成最優模態獲取模型的仿真后,通過最優模態獲取模型獲取多模態病變圖像。

圖3 實驗數據來源界面

為了保證實驗的有效性,使用基于剛體模型的多模態病變圖像、基于圖像灰度的多模態病變圖像、基于圖像特征點的多模態病變圖像與本文提出的基于遺傳算法的多模態病變圖像進行對比,觀察仿真的結果,比較多模態病變圖像挖掘誤差的大小。其中多模態病變圖像挖掘誤差的定義如下

(14)

為了減少多模態病變圖像的圖像挖掘誤差,實驗中的病變圖像都進行了同樣程度的灰度調整。每種多模態病變圖像各自進行三次實驗。本次實驗以病變細胞為病變圖像部位。

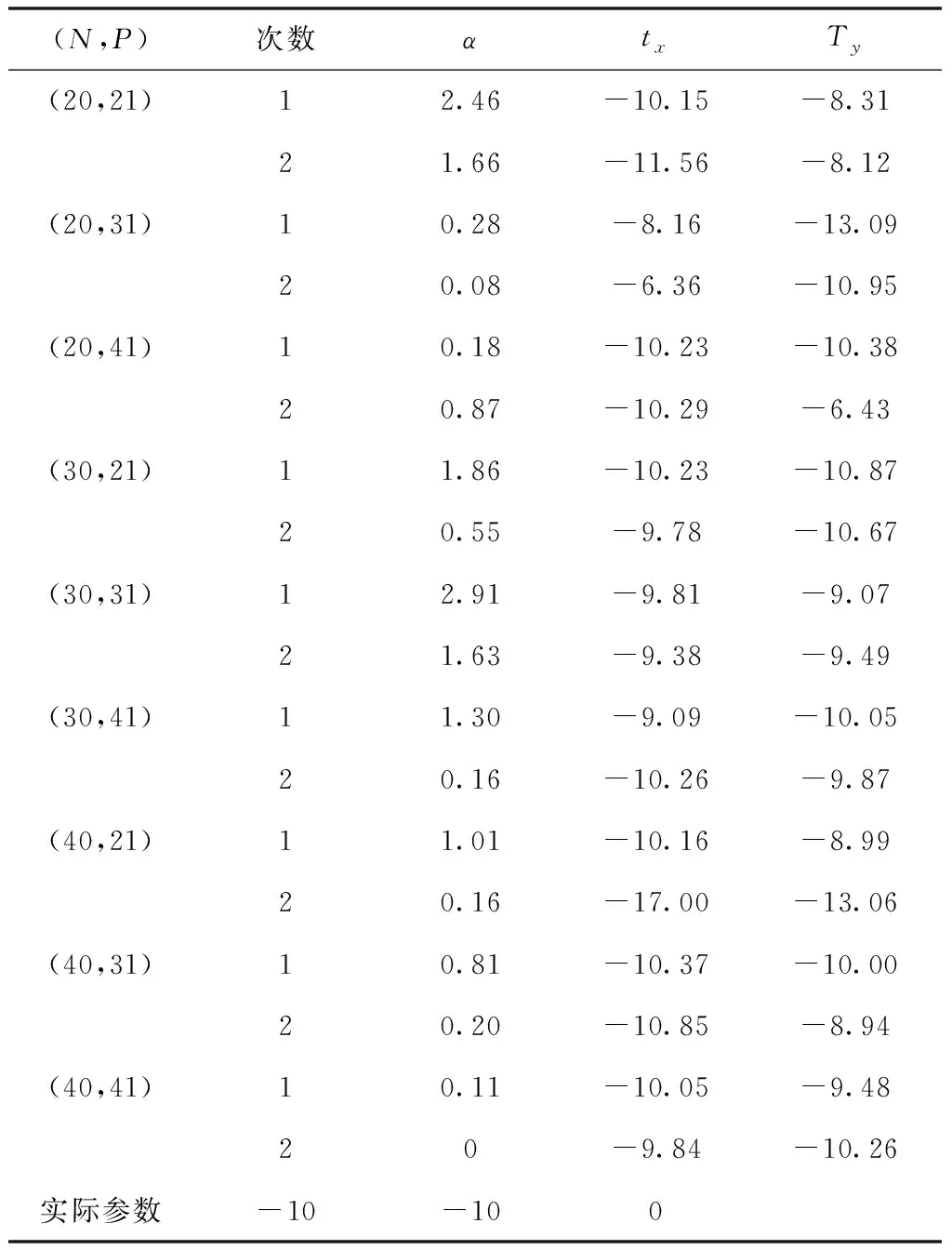

通過細胞病變圖像獲取互信息可以得到其性質,如表2所示。

表2 病變圖像互信息性質

3.2 實驗結果

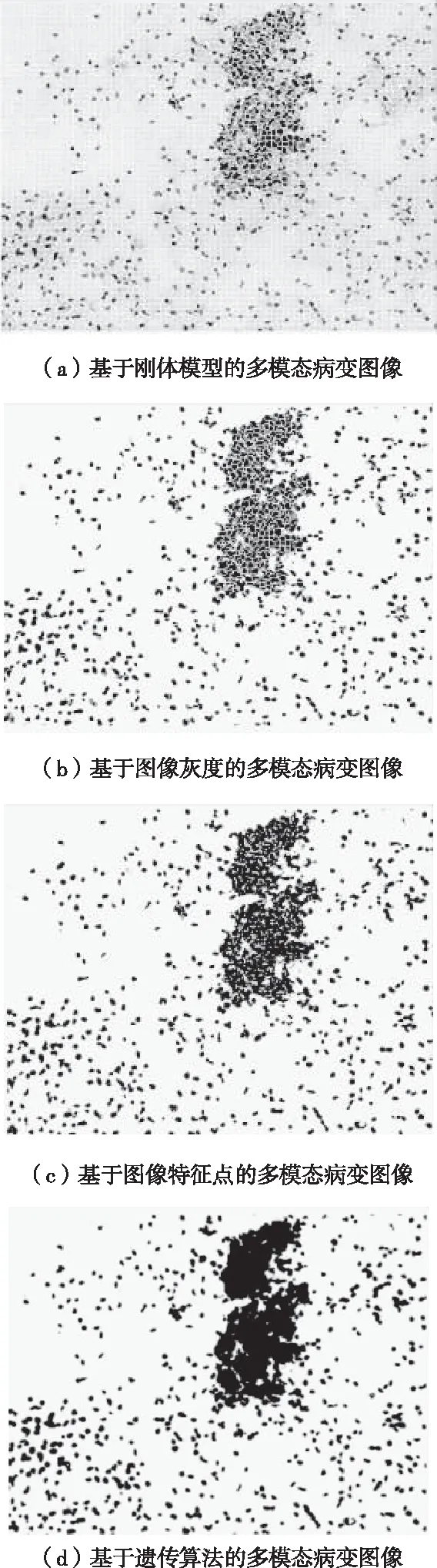

基于剛體模型的多模態病變圖像、基于圖像灰度的多模態病變圖像、基于圖像特征點的多模態病變圖像、基于遺傳算法的多模態病變圖像的獲取結果如圖4所示。

圖4 不同方法的多模態病變圖像對比圖

如圖4所示,基于遺傳算法的多模態病變圖像更清晰,效果更為理想。在此基礎上,對實驗具體數據進行對比,實驗獲取的具體數據如表3所示。

表3 實驗獲取具體數據

通過表3可知,基于剛體模型的多模態病變圖像的平均圖像挖掘誤差為0.41;基于圖像灰度的多模態病變圖像的平均圖像挖掘誤差為0.2;基于圖像特征點的多模態病變圖像的平均圖像挖掘誤差為0.19;基于遺傳算法的多模態病變圖像的平均圖像挖掘誤差為0.063,通過比較可知,基于遺傳算法的多模態病變圖像的圖像挖掘誤差最小,證明本文提出的多模態病變圖像更加精準,將其應用在醫學領域能夠提升醫生診斷疾病的效率。

4 結束語

基于遺傳算法的多模態病變圖像通過病變圖像互信息歸一化、最優模態搜索建立最優模態獲取模型,并通過該模型獲取多種成像設備病變圖像的最優模態,進行多模態病變圖像的合成,實現多模態病變圖像的獲取。該多模態病變圖像的圖像挖掘誤差較小,相較于傳統多模態病變圖像來說更加精準,對醫療界的意義重大,有助于醫生對病變部位的疾病診斷,是醫學影像技術的一種發展,能夠獲取全面、有效、互補的病變部位醫療信息,在提升治療效果與追蹤病理變化方面有著卓越的效果。