基于多尺度注意力CNN的SAR遙感目標(biāo)識(shí)別 *

陳 禾, 張心怡, 李 燦, 莊 胤

(1. 北京理工大學(xué)信息與電子學(xué)院雷達(dá)技術(shù)研究所, 北京 100081; 2. 嵌入式實(shí)時(shí)信息處理技術(shù)北京市重點(diǎn)實(shí)驗(yàn)室, 北京 100081)

0 引言

合成孔徑雷達(dá)(Synthetic Aperture Radar,SAR)是一種基于多平臺(tái)的主動(dòng)式對(duì)地觀測(cè)系統(tǒng),不受光照和氣候條件的制約,具有全天時(shí)、全天候、高分辨、大幅寬等多種特點(diǎn)[1-2]。經(jīng)歷60多年的發(fā)展,合成孔徑雷達(dá)成像技術(shù)已經(jīng)逐漸成熟,高分辨SAR圖像的數(shù)據(jù)獲取能力得到了顯著的提高,為SAR圖像的智能化應(yīng)用奠定了基礎(chǔ)。上世紀(jì)80年代,林肯實(shí)驗(yàn)室提出了SAR自動(dòng)目標(biāo)識(shí)別(SAR ATR)系統(tǒng)的一般流程,將其分為了檢測(cè)、鑒別和識(shí)別三個(gè)階段。識(shí)別是SAR ATR的最后一個(gè)階段,SAR圖像經(jīng)過檢測(cè)與鑒別后,大部分的雜波虛警已被濾除,剩下的主要工作就是對(duì)目標(biāo)切片進(jìn)行分類識(shí)別。本文主要圍繞SAR圖像目標(biāo)識(shí)別這一環(huán)節(jié)展開研究,實(shí)現(xiàn)對(duì)SAR遙感圖像的高精度智能化判讀。

目標(biāo)識(shí)別往往是在特征空間中進(jìn)行分類,因此能否提取到圖像的有效特征是決定識(shí)別結(jié)果好壞的關(guān)鍵因素。近年來國內(nèi)外的學(xué)者開展了大量研究,根據(jù)其提取特征的方法可分為兩大類:1)基于人工特征描述的方法;2)基于深度學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)的方法。

基于人工特征描述的方法需要人工設(shè)計(jì)并選取具有判別性的特征。丁柏圓[3]等人提取了SAR圖像和模板的屬性散射中心,綜合考慮不同散射中心對(duì)于匹配度的貢獻(xiàn)及其虛警和漏警對(duì)最終匹配度的影響,設(shè)計(jì)了一種度量散射中心匹配度方法。康妙[4]等人提取了SAR圖像的25種基線特征和局部紋理特征,將其串聯(lián)輸入棧式自編碼器網(wǎng)絡(luò)進(jìn)行融合,最后利用softmax進(jìn)行分類。張楚笛[5]等人采用二維變分模態(tài)分解技術(shù)將SAR圖像分解為多個(gè)子模態(tài)分量,分別用于表示全局信息和邊緣信息,進(jìn)一步提取二維雙向主成分分析特征,最后聯(lián)合原始圖像和各子模態(tài)的特征完成分類。李璐[6]等人提取了多級(jí)幅度特征和多級(jí)密集尺度不變特征變換(Dense-SIFT)特征。并借鑒深度森林的思想對(duì)二者進(jìn)行聯(lián)合利用,將得到的深層融合特征對(duì)目標(biāo)進(jìn)行識(shí)別任務(wù)。然而,人工特征描述十分依賴專業(yè)的經(jīng)驗(yàn)與知識(shí),且對(duì)復(fù)雜目標(biāo)的特征表達(dá)能力有限,難以達(dá)到更好的識(shí)別性能。2006年,Hinton等人提出了深度學(xué)習(xí)[7],這是一種基于人工神經(jīng)網(wǎng)絡(luò)的機(jī)器學(xué)習(xí)算法,通過深層神經(jīng)網(wǎng)絡(luò)從低到高逐層提取數(shù)據(jù)的特征,獲取更豐富的特征表示。近年來,基于卷積神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)模型在自然圖像分類范疇取得了出色的成果,很多研究者開始嘗試?yán)镁矸e神經(jīng)網(wǎng)絡(luò)來處理SAR圖像目標(biāo)識(shí)別問題。Wang[8]等人設(shè)計(jì)了稀疏數(shù)據(jù)特征提取模塊(SDFE),并在此基礎(chǔ)上提出了一種新的卷積神經(jīng)網(wǎng)絡(luò)SSF-Net,網(wǎng)絡(luò)具有較好的魯棒性。倉明杰[9]等人提出一種基于改進(jìn)的卷積神經(jīng)網(wǎng)絡(luò)(ICNN)和改進(jìn)的生成對(duì)抗網(wǎng)絡(luò)(IGAN)的SAR目標(biāo)識(shí)別方法,用無監(jiān)督預(yù)訓(xùn)練好的IGAN鑒別器參數(shù)初始化ICNN,再用訓(xùn)練樣本對(duì)ICNN微調(diào),使網(wǎng)絡(luò)具有更高的準(zhǔn)確率和更強(qiáng)的抗噪聲能力。陳禾[10]等人提出了一種結(jié)合高階特征表示的多尺度特征提取殘差結(jié)構(gòu),有效提升了深度卷積網(wǎng)絡(luò)對(duì)于SAR圖像細(xì)粒度型號(hào)識(shí)別任務(wù)的特征提取及泛化能力。REN[11]等人提出了一種擴(kuò)展卷積膠囊網(wǎng)絡(luò)的SAR ATR方法,其在編碼器網(wǎng)絡(luò)中利用不同膨脹率的多次卷積運(yùn)算提取多尺度特征,然后嵌入了特征細(xì)化模塊,以增強(qiáng)顯著特征,抑制無用特征。高飛[12]等人提出基于度量學(xué)習(xí)的SAR圖像識(shí)別方法,使用LSTM網(wǎng)絡(luò)保留樣本間相似特征,并通過距離度量函數(shù)將各類別樣本進(jìn)行關(guān)聯(lián),最后引入注意力機(jī)制提取出與測(cè)試圖像特征更相似的訓(xùn)練圖像。Pei[13]等人提出了一種基于深度特征提取與融合網(wǎng)絡(luò)(FEF-Net)的多視點(diǎn)SAR ATR方法。FEF-Net具有多輸入拓?fù)浣Y(jié)構(gòu),包括可變形卷積和SE等特定模塊,具有學(xué)習(xí)多視點(diǎn)SAR圖像有用分類信息的能力。綜上所述,卷積神經(jīng)網(wǎng)絡(luò)可以自動(dòng)從數(shù)據(jù)中學(xué)習(xí)特征,完成端到端的高精度目標(biāo)識(shí)別,是SAR遙感圖像目標(biāo)識(shí)別的研究熱點(diǎn)。

然而SAR圖像與光學(xué)圖像不同,SAR圖像上的信息主要是地物目標(biāo)對(duì)雷達(dá)波束的后向散射形成的。雷達(dá)的工作參數(shù)如入射角、工作波長、極化方式等,以及地表的粗糙度等目標(biāo)特性都會(huì)對(duì)成像產(chǎn)生影響。目標(biāo)的散射特征往往存在于多個(gè)尺度當(dāng)中,此外,SAR圖像中存在固有的噪聲斑,提取到的特征可能含有冗余信息,對(duì)SAR圖像的目標(biāo)識(shí)別也會(huì)產(chǎn)生負(fù)面影響。因此,本文提出一種結(jié)合多尺度特征提取和注意力機(jī)制的卷積神經(jīng)網(wǎng)絡(luò) —— 多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)。針對(duì)提取不同尺度的目標(biāo)散射特征的問題,設(shè)計(jì)了多尺度殘差特征提取模塊,針對(duì)區(qū)分關(guān)鍵信息和冗余信息的問題,設(shè)計(jì)了注意力模塊。最后將它們進(jìn)行組合和有層次的堆疊構(gòu)成了多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)。將所設(shè)計(jì)網(wǎng)絡(luò)在MSTAR(Moving and Stationary Target Acquisition and Recognition)數(shù)據(jù)集上,針對(duì)10種軍事目標(biāo)型號(hào)開展了圖像分類實(shí)驗(yàn),并取得了99.84%的總體精度,驗(yàn)證了本文提出方法的性能。進(jìn)一步,在測(cè)試集中加入4種型號(hào)的變體進(jìn)行擴(kuò)展驗(yàn)證實(shí)驗(yàn),取得了99.28%的總體精度,驗(yàn)證了本文方法在復(fù)雜情況下的有效性。

1 多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)

1.1 算法總體介紹

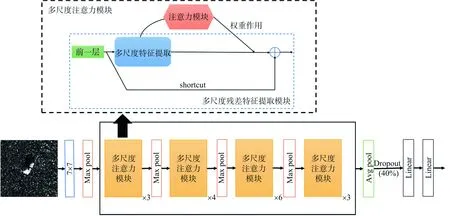

本文所提出的多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)模型如圖1所示,整體架構(gòu)基于ResNet34[14]網(wǎng)絡(luò),將原始BasicBlock替換為所設(shè)計(jì)的多尺度注意力模塊,進(jìn)行有層次的堆疊所構(gòu)成。其中多尺度注意力模塊由多尺度殘差特征提取模塊(包括多尺度特征提取與殘差連接shortcut)和注意力模塊組成,實(shí)現(xiàn)了多尺度特征提取和注意力機(jī)制的功能。以下將詳細(xì)介紹多尺度殘差特征提取模塊、注意力模塊以及網(wǎng)絡(luò)的詳細(xì)結(jié)構(gòu)。

圖1 本文網(wǎng)絡(luò)總體架構(gòu)圖

1.2 多尺度殘差特征提取模塊

由于SAR遙感成像對(duì)于同一目標(biāo)的散射信息會(huì)隨成像條件的變化而改變,這對(duì)SAR圖像目標(biāo)識(shí)別帶來了很大的挑戰(zhàn),故需要對(duì)目標(biāo)提取不變性散射特征。然而,這些不變性散射特征往往隱藏在多個(gè)尺度的散射點(diǎn)分布中:大尺度中存在全局散射特征,小尺度中存在局部散射特征,僅使用單一尺度的特征提取架構(gòu)難以得到有效特征描述。因此,多尺度特征提取及融合是SAR遙感圖像目標(biāo)識(shí)別的關(guān)鍵所在。

對(duì)于多尺度特征提取,本模塊在ResNet的BasicBlock基礎(chǔ)上采用了GoogLeNet[15]中Inception模塊的多尺度特征提取思想,多分支的網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)可以進(jìn)行多尺度的特征提取和融合,增加了網(wǎng)絡(luò)的寬度和對(duì)多尺度信息的處理能力。進(jìn)一步,借鑒VGGNet[16]用連續(xù)的小卷積核代替大卷積核的方法,在保持相同感受野的情況下進(jìn)一步加深網(wǎng)絡(luò)。

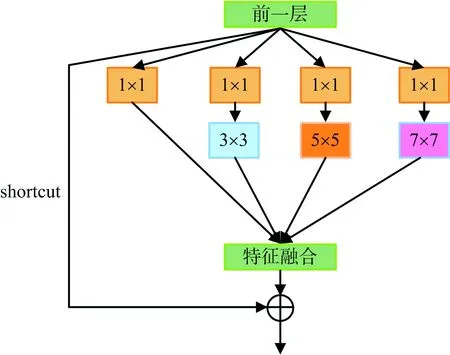

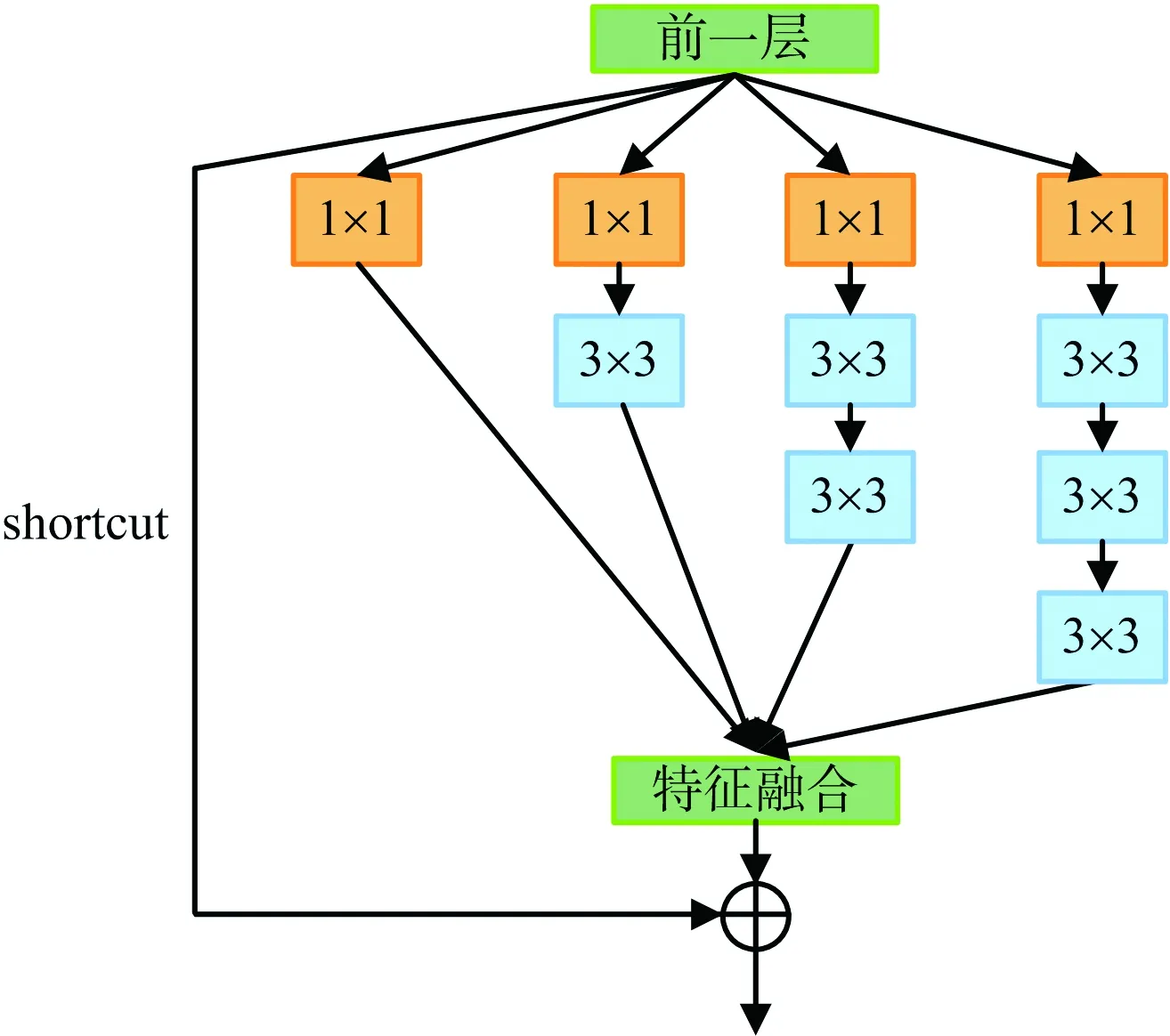

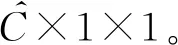

本文提出的多尺度殘差特征提取模塊有兩種:Block-A和Block-B。Block-A如圖2(a)所示,采用4個(gè)并行分支,分別是卷積核大小為1×1、3×3、5×5、7×7的卷積層,進(jìn)行不同尺度的特征提取,然后將特征融合。同時(shí)加入殘差模塊的快捷連接(shortcut),將輸入層加到輸出層。其中除了第一個(gè)分支中的1×1卷積用來進(jìn)行特征提取,其他的1×1卷積用來降維,以減少參數(shù)量;Block-B如圖2(b)所示,在上述基礎(chǔ)上將5×5卷積核分解為2個(gè)串聯(lián)的3×3卷積核、7×7卷積核分解為3個(gè)串聯(lián)的3×3卷積核,以進(jìn)一步加深網(wǎng)絡(luò)。對(duì)于多尺度特征融合,考慮采用兩種特征融合方式:拼接(concatenate)和對(duì)應(yīng)元素相加(element-wise summation),具體使用方式與選用的注意力模塊有關(guān),將在下一節(jié)補(bǔ)充說明。

(a) Block-A

(b) Block-B圖2 多尺度殘差特征提取模塊

1.3 注意力模塊

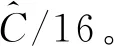

雖然上述多尺度殘差特征提取模塊可以用多個(gè)尺寸的卷積核來提取不同尺度的SAR目標(biāo)散射特征,然而,得到的多尺度散射特征若被無差別使用,則會(huì)造成信息冗余,毫無側(cè)重。因此,本文進(jìn)一步引入注意力機(jī)制來指導(dǎo)網(wǎng)絡(luò)分配權(quán)重,使網(wǎng)絡(luò)能夠關(guān)注各個(gè)尺度散射特征中更具判別性的信息,達(dá)到更精確的SAR圖像目標(biāo)識(shí)別性能。具體地,在多尺度殘差特征提取模塊后加入注意力模塊,分別考慮使用SENet[17]中的Squeeze and Excitation block(SE模塊)和SKNet[18]中的Selective Kernel block(SK模塊)。下面將詳細(xì)介紹這兩種注意力模塊在本章提出的模型上的應(yīng)用。

1) SE模塊:其結(jié)構(gòu)如圖3(a)所示。SE模塊關(guān)注的是所有通道間的權(quán)重分配,所以將四路卷積輸出的特征圖按特征通道維度拼接在一起,將多尺度特征以特征拼接(concatenate)方式融合。之后的具體操作可分為以下三個(gè)步驟:

(1)

(c) 權(quán)重作用(Scale):使用Excitation 得到的結(jié)果作為權(quán)重,分別乘到特征圖對(duì)應(yīng)的通道上(element-wise product),進(jìn)行特征重標(biāo)定,得到輸出特征圖。

將SE模塊與上節(jié)提出的多尺度殘差特征提取模塊結(jié)合,可使網(wǎng)絡(luò)從通道的角度進(jìn)行側(cè)重,關(guān)注更具判別信息的特征通道。

2) SK模塊:其結(jié)構(gòu)如圖3(b)所示。SK模塊關(guān)注的是不同尺度卷積支路之間的權(quán)重分配,從而達(dá)到調(diào)整神經(jīng)元感受野大小的目的。故參考SKNet[17]中的特征融合方式,將上一步的多尺度特征以特征圖對(duì)應(yīng)元素相加(element-wise summation)的方式融合,這要求每個(gè)尺度的卷積核輸出的特征圖維度是完全相同的。之后操作可以分為以下兩個(gè)步驟:

(a) 壓縮和激活(Squeeze and Excitation):相當(dāng)于SE模塊中Squeeze和Excitation,區(qū)別在于此處要對(duì)Squeeze結(jié)果分別作4個(gè)分支的非線性變換,以對(duì)應(yīng)四路卷積。

(b) 權(quán)重作用(Select):把Squeeze and Excita-tion的輸出通過softmax函數(shù)轉(zhuǎn)化為縱向通道之間的權(quán)重,然后把權(quán)重信息乘(element-wise pro-duct)到對(duì)應(yīng)的U1、U2、U3和U4上。最后再把權(quán)重作用后的四路的特征圖進(jìn)行對(duì)應(yīng)相加(element-wise summation)得到輸出特征圖M。

SK模塊中的Select操作使用softmax加權(quán)與SE模塊中最后把權(quán)重分別乘到輸入特征圖上的操作很相似,區(qū)別在于SE模塊考慮的是通道之間的權(quán)重,而SK模塊不僅考慮了通道之間的權(quán)重,還考慮了多路卷積的權(quán)重。也就是說,SE模塊是對(duì)通道執(zhí)行注意力機(jī)制,而SK模塊則是對(duì)卷積核執(zhí)行注意力機(jī)制,即讓網(wǎng)絡(luò)自己選擇合適的卷積核。

(a) SE模塊

(b) SK模塊圖3 注意力模塊

1.4 網(wǎng)絡(luò)詳細(xì)結(jié)構(gòu)

將上述的兩種多尺度殘差特征提取模塊和兩種注意力模塊兩兩組合在一起,構(gòu)成4種多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)。Block-A與SE模塊組合構(gòu)成的網(wǎng)絡(luò)命名為:多尺度-se34,Block-A與SK模塊組合構(gòu)成的網(wǎng)絡(luò)命名為:多尺度-sk34,“34”表示它們將構(gòu)成34層的卷積神經(jīng)網(wǎng)絡(luò);Block-B與SE模塊組合構(gòu)成的網(wǎng)絡(luò)命名為:多尺度-se66,Block-B和SK模塊組合構(gòu)成的網(wǎng)絡(luò)命名為:多尺度-sk66,“66”表示它們將構(gòu)成66層的卷積神經(jīng)網(wǎng)絡(luò)。

2 數(shù)據(jù)集與評(píng)價(jià)指標(biāo)

2.1 數(shù)據(jù)集簡(jiǎn)介

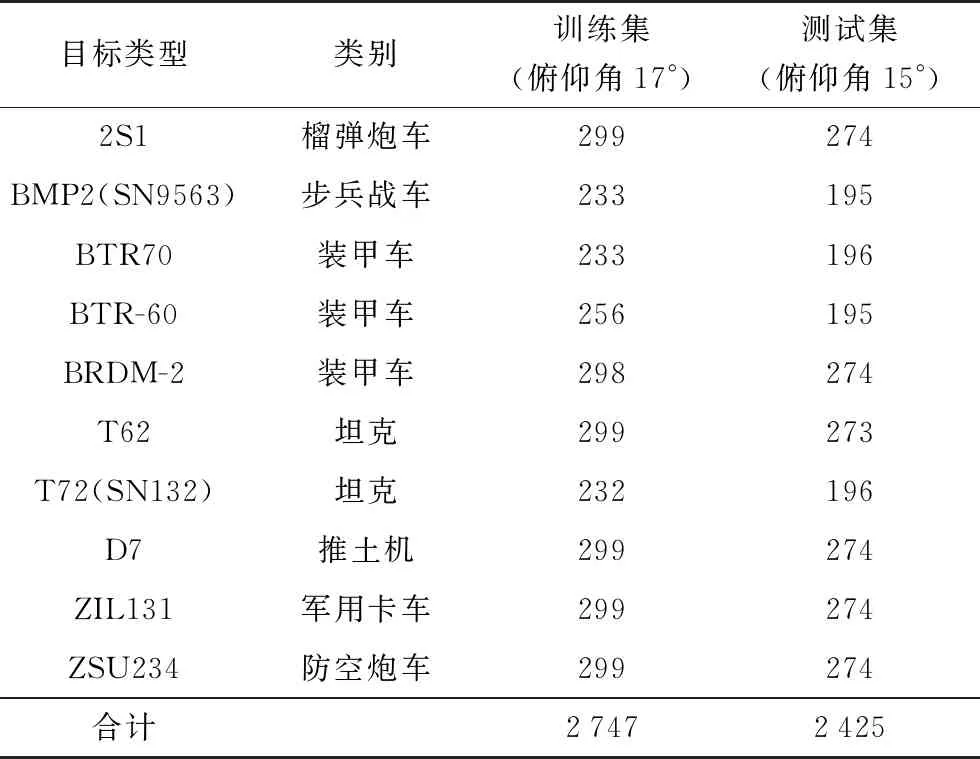

本文采用MSTAR數(shù)據(jù)集進(jìn)行SAR圖像目標(biāo)分類實(shí)驗(yàn)。該數(shù)據(jù)集采用美國國防高等研究計(jì)劃署(DARPA)支持的MSTAR計(jì)劃所公布的實(shí)測(cè)SAR地面靜止目標(biāo)數(shù)據(jù),是通過工作在X波段、HH極化方式的高分辨率的聚束式合成孔徑雷達(dá)采集得到,雷達(dá)空間分辨率為0.3 m×0.3 m。采集的數(shù)據(jù)共有10種前蘇聯(lián)軍事目標(biāo)車輛,包括坦克、裝甲車等。其中SOC工作條件下10類MSTAR數(shù)據(jù)集中圖像的俯仰角分別是 17°和 15°,圖4分別展示了10類目標(biāo)車輛的光學(xué)圖像和對(duì)應(yīng)的 SAR 圖像。本文選用在俯仰角為17°和 15°的圖像分別作為訓(xùn)練集和測(cè)試集。具體類別和圖像數(shù)量見表2。

2.2 實(shí)驗(yàn)設(shè)置與評(píng)價(jià)指標(biāo)

本文所有實(shí)驗(yàn)基于Ubuntu16.04.6 LTS操作系統(tǒng),所用開發(fā)環(huán)境是python 3.7及其第三方庫,以及深度框架Pytorch1.2.0。GPU的處理環(huán)境為CUDA9和cuDNN7。輸入圖像尺寸需統(tǒng)一裁剪為224×224以適應(yīng)網(wǎng)絡(luò),batchsize設(shè)置為32,使用SGD優(yōu)化器進(jìn)行訓(xùn)練,初始學(xué)習(xí)率為0.001,每經(jīng)過50個(gè)Epoch學(xué)習(xí)率減半。實(shí)驗(yàn)采用總體精度OA(Overall Accuracy)和混淆矩陣CM(Confusion Matrix)作為模型分類性能的評(píng)價(jià)指標(biāo)。

圖4 數(shù)據(jù)集中10類目標(biāo)的光學(xué)圖像和SAR圖像對(duì)照

表2 MATAR數(shù)據(jù)集SOC工作條件下10類目標(biāo)訓(xùn)練與測(cè)試樣本數(shù)

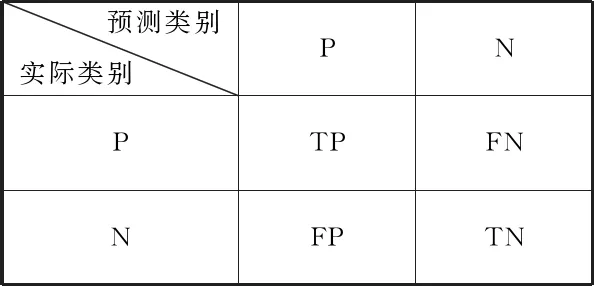

混淆矩陣:如圖5所示,為一個(gè)二分類混淆矩陣的示例。TP(True Positive)表示實(shí)際標(biāo)簽是P,被正確預(yù)測(cè)為P的數(shù)量;FN(False Negative)表示實(shí)際標(biāo)簽是P,但被錯(cuò)誤預(yù)測(cè)為N的數(shù)量; TN(True Negative)表示實(shí)際標(biāo)簽是N,被正確預(yù)測(cè)為N的數(shù)量;FP(False Positive)表示實(shí)際標(biāo)簽是N,但被錯(cuò)誤預(yù)測(cè)為P的數(shù)量。可以將其拓展到多分類的情況下。若數(shù)據(jù)集有M個(gè)類別,那么混淆矩陣可以用一個(gè)M行M列的矩陣形式來表示。正如混淆矩陣的名字,它的作用是體現(xiàn)出多個(gè)類別之間是否有混淆,可以直觀地體現(xiàn)每一類的分類準(zhǔn)確率和錯(cuò)分的類別。

圖5 混淆矩陣示意圖

總體準(zhǔn)確率OA:其計(jì)算方法為所有分類正確的圖像數(shù)除以圖像總數(shù),在混淆矩陣表示下如式(2)。該指標(biāo)能夠?qū)?shù)據(jù)集整體的預(yù)測(cè)情況進(jìn)行評(píng)價(jià)。

(2)

3 實(shí)驗(yàn)結(jié)果與分析

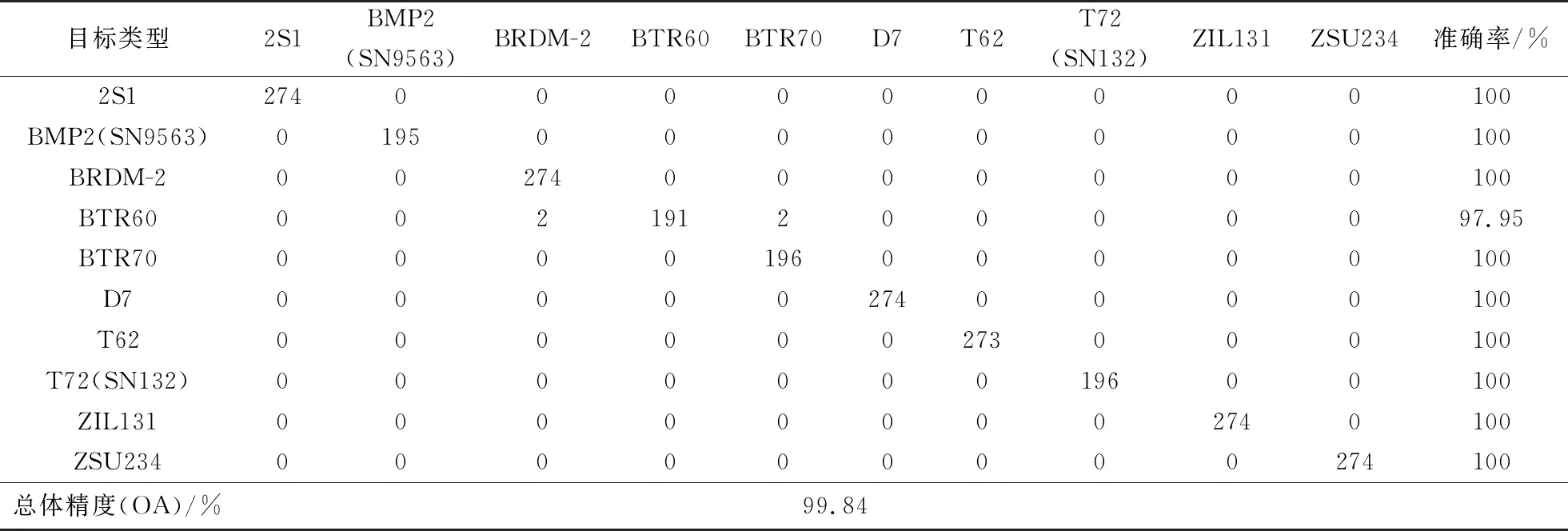

3.1 實(shí)驗(yàn)結(jié)果

為進(jìn)一步驗(yàn)證本文提出網(wǎng)絡(luò)的性能,將本文模型的實(shí)驗(yàn)結(jié)果與其他算法以及一些經(jīng)典的神經(jīng)網(wǎng)絡(luò)模型進(jìn)行了比較,如表3所示。文獻(xiàn)[4]和文獻(xiàn)[5]是基于傳統(tǒng)人工特征描述的方法,文獻(xiàn)[11]和文獻(xiàn)[12]是基于卷積神經(jīng)網(wǎng)絡(luò)特征提取的方法。可以看出傳統(tǒng)算法的分類精度普遍不高,而基于卷積神經(jīng)網(wǎng)絡(luò)的分類方法有著明顯的優(yōu)越性。本文提出的多尺度-sk66網(wǎng)絡(luò)OA達(dá)到99.84%的最高準(zhǔn)確率,體現(xiàn)了本文提出的多尺度注意力網(wǎng)絡(luò)的優(yōu)越性能。

表3 本文方法與其他方法結(jié)果比較

3.2 優(yōu)化討論

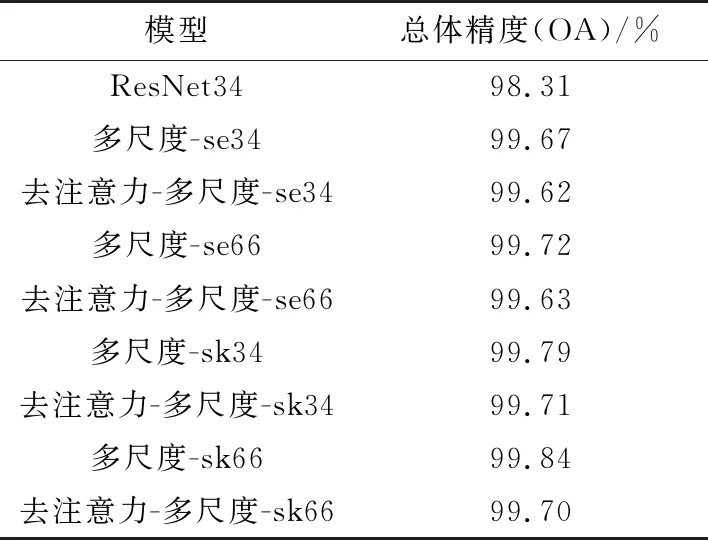

為了分析本文設(shè)計(jì)模型中兩種多尺度殘差特征提取模塊和兩種注意力模塊對(duì)性能的影響,開展了一系列的對(duì)比試驗(yàn)。實(shí)驗(yàn)結(jié)果如表4所示。

表4 各模型分類精度

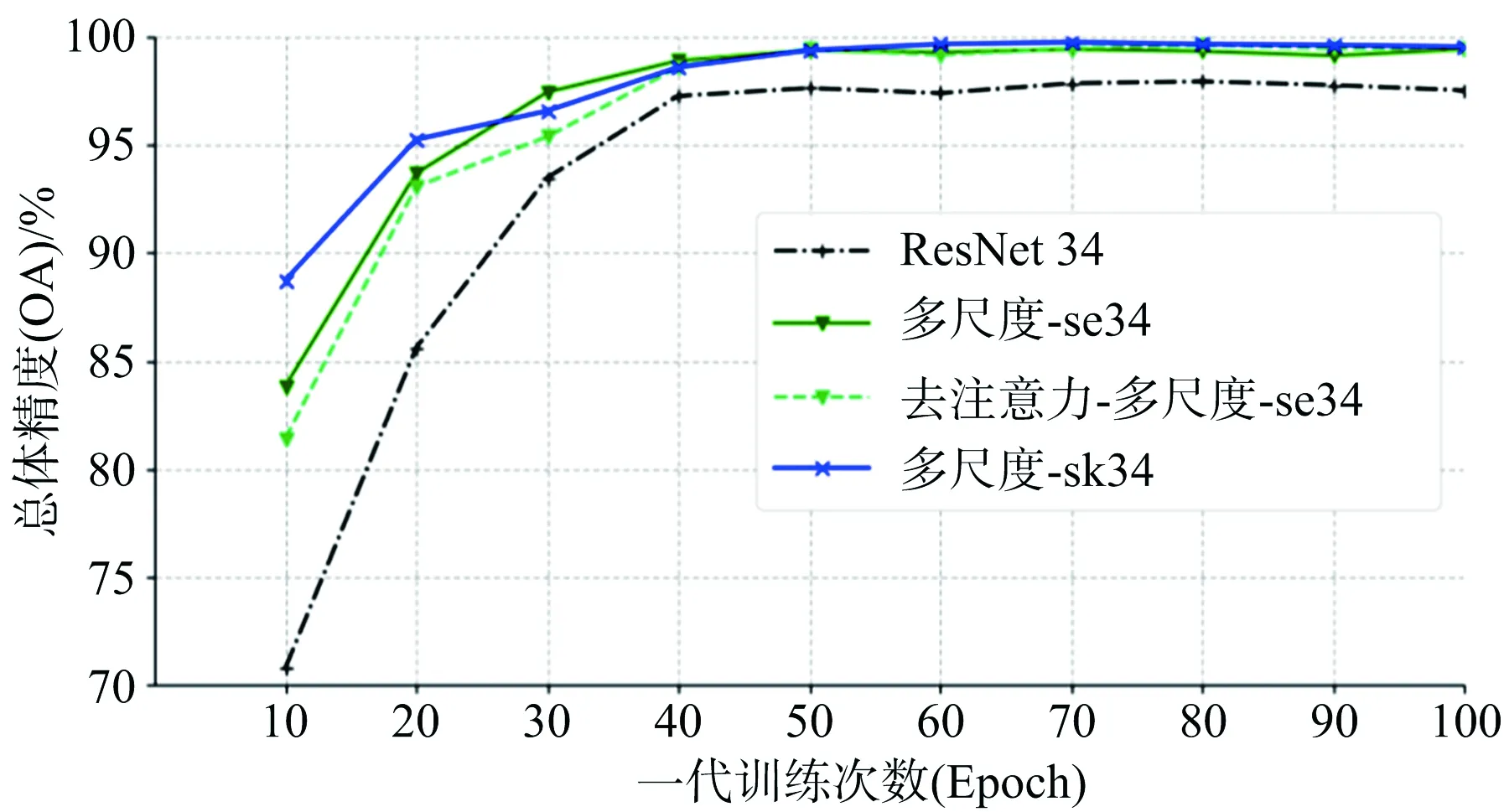

1) 多尺度殘差特征提取模塊:對(duì)比ResNet34與去注意力-多尺度-se34的精度,如圖6(a)所示,可以證明本文設(shè)計(jì)的多尺度殘差特征提取模塊的有效性。ResNet34網(wǎng)絡(luò)單一尺度的特征提取導(dǎo)致獲得的特征不夠有效,而多尺度殘差特征提取模塊可以很好地提取并融合多尺度的特征,擁有更強(qiáng)大的特征提取能力,有效提升模型的收斂速度和分類精度。

2) 注意力模塊:對(duì)比有無注意力的多尺度網(wǎng)絡(luò)分類精度可以證明本文設(shè)計(jì)的注意力模塊的有效性。如圖6(a)所示,可以看出加入注意力模塊之后,網(wǎng)絡(luò)收斂速度有所提升。觀察表4的2至5行與6至9行可以看出,相較于層數(shù)較淺的34層多尺度網(wǎng)絡(luò),注意力模塊對(duì)于66層的深層多尺度網(wǎng)絡(luò)的最終精度提升效果更加明顯。深層網(wǎng)絡(luò)的參數(shù)量更大,提取到的特征數(shù)量更多更復(fù)雜,存在冗余信息的可能性也就越大。這說明SE模塊和SK模塊都可以在大量信息中區(qū)分關(guān)鍵信息和冗余信息,有側(cè)重地利用信息,從而有效提升網(wǎng)絡(luò)性能。同時(shí),觀察表4以及圖6(a)中多尺度-se34和多尺度-sk34的曲線可以看出,SK模塊相較于SE模塊對(duì)多尺度網(wǎng)絡(luò)有著更好的提升效果。這可能是因?yàn)镾K模塊不僅考慮了通道之間的權(quán)重,還考慮了多路卷積的權(quán)重,更加適合多尺度網(wǎng)絡(luò)的特點(diǎn)。

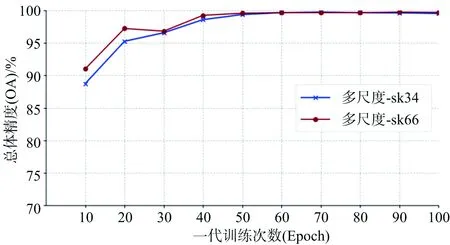

(a)

(b)圖6 部分模型在測(cè)試集上的精度變化曲線

3) 網(wǎng)絡(luò)深度:本文在第一節(jié)中設(shè)計(jì)了兩種多尺度殘差特征提取模塊,分別對(duì)應(yīng)了34層和使用連續(xù)小卷積核替換大尺寸卷積核得到的66層的網(wǎng)絡(luò)結(jié)構(gòu)。對(duì)比不同層數(shù)的多尺度注意力網(wǎng)絡(luò)性能,如圖6(b)所示,繪制了多尺度-sk34和多尺度-sk66的精度變化曲線圖。可以看出,增加網(wǎng)絡(luò)深度可以有效提升網(wǎng)絡(luò)精度,但在前期的訓(xùn)練過程中可能會(huì)存在一定的波動(dòng)。

表5是本文實(shí)驗(yàn)中最優(yōu)模型多尺度-sk66的混淆矩陣。

表5 多尺度sk-66混淆矩陣

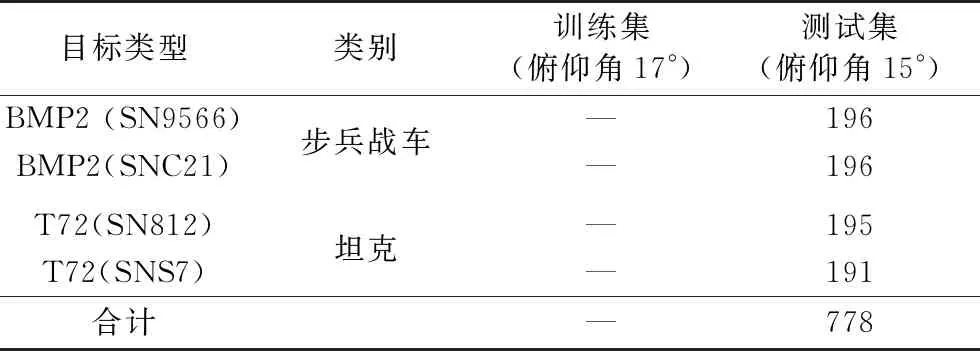

3.3 擴(kuò)展驗(yàn)證

同一大類軍事目標(biāo)中還會(huì)存在不同型號(hào)的變體,它們的軍事配置不同,例如同類坦克上有無機(jī)關(guān)槍、油箱,以及天線是否展開等[19]。這些外觀上的變化也會(huì)影響SAR目標(biāo)識(shí)別。因此,為驗(yàn)證本文方法在復(fù)雜情況下的有效性,不改變訓(xùn)練集,向測(cè)試集中補(bǔ)充了BMP2的兩種變體:SN9566、SNC21,以及T72的兩種變體:SN812、SNS7。表6為所加入變體數(shù)據(jù)的具體類別型號(hào)和圖像數(shù)量。

表6 加入變體的類別型號(hào)和圖像數(shù)量

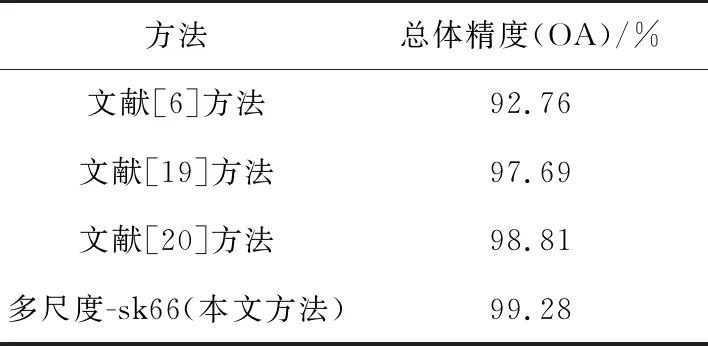

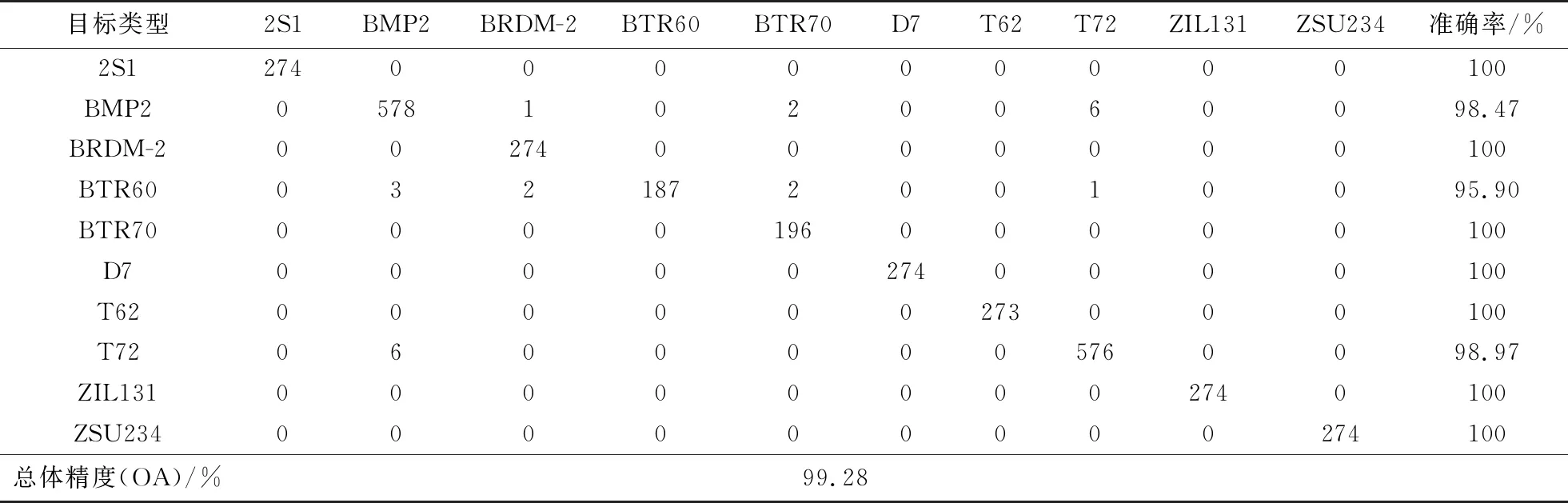

選擇在3.1節(jié)實(shí)驗(yàn)中性能最好的多尺度-sk66模型對(duì)補(bǔ)充變體后的MSTAR數(shù)據(jù)集10類目標(biāo)進(jìn)行識(shí)別,并與其他方法[6,19-20]進(jìn)行對(duì)比。實(shí)驗(yàn)結(jié)果如表7所示,多尺度-sk66的混淆矩陣如表8所示。可見,在測(cè)試集中加入變體之后,算法的整體性能稍有下降,但也優(yōu)于其他算法。這說明本文提出模型有較強(qiáng)的泛化能力,在復(fù)雜情況下仍能保持較高精度,進(jìn)一步驗(yàn)證了該方法的有效性。

表7 本文方法與其他方法在補(bǔ)充變體數(shù)據(jù)集上的結(jié)果比較

表8 多尺度sk-66在補(bǔ)充變體數(shù)據(jù)集上的混淆矩陣

4 結(jié)束語

本文以SAR遙感圖像目標(biāo)識(shí)別為背景,提出了多尺度注意力卷積神經(jīng)網(wǎng)絡(luò)。針對(duì)SAR圖像的多尺度散射特征,設(shè)計(jì)了多尺度殘差特征提取模塊,能夠提取并融合多尺度特征。同時(shí)引入了注意力機(jī)制來區(qū)分關(guān)鍵信息和冗余信息。通過在MSTAR數(shù)據(jù)集上進(jìn)行10類目標(biāo)識(shí)別的實(shí)驗(yàn),驗(yàn)證了本文算法的有效性,總體準(zhǔn)確率達(dá)到了99.84%,明顯優(yōu)于其他算法。另外,向測(cè)試集中補(bǔ)充4種型號(hào)的變體,進(jìn)行擴(kuò)展驗(yàn)證,總體準(zhǔn)確率達(dá)到了99.28%,驗(yàn)證了本文算法在復(fù)雜情況下的有效性。

然而,本文實(shí)驗(yàn)選用的MSTAR數(shù)據(jù)集類別較少,圖片樣本有限,對(duì)模型的泛化能力有待進(jìn)一步驗(yàn)證。此外,所設(shè)計(jì)的多尺度注意力網(wǎng)絡(luò)模型參數(shù)量較大。因此,如何構(gòu)建更好的多尺度特征融合方法和注意力機(jī)制從而進(jìn)一步提升網(wǎng)絡(luò)性能,是今后有待繼續(xù)研究的內(nèi)容。