基于深度學習的盲道障礙物檢測算法研究

段中興,王 劍,丁青輝,溫 倩

(西安建筑科技大學 信息與控制工程學院,西安 710055)

0 引言

我國目前視力障礙人群總數高達1 731萬,其中年輕人占比23.5%,視障人群作為弱勢群體,他們的日常出行是不可忽視的問題。但目前城市對于道路規劃不全面,又因機動車輛急劇增多等原因,致使一車“難停”。同時共享單車的興起,使得公眾私自占用盲道現象十分普遍,導致視障人群出行存在安全隱患,故解決盲道障礙問題不但有利于視障人群日常出行,同時有利于社會發展。

近些年,視覺處理技術得到突破,出現以卷積神經網絡為代表的障礙物檢測方法,Girshick等[1]提出R-CNN檢測方法,通過利用深度卷積神經網絡提取目標特征信息,獲得良好的檢測精度。R-CNN提出后,許多學者通過對其網絡結構研究與優化,提出不同的目標檢測算法以提高。主要包括SPP-Net[2],Fast R-CNN[3],Faster R-CNN[4]等檢測算法,此類算法在應用到障礙物檢測時需要將檢測過程分為兩段:先進行候選區域生成,然后進行目標分類,在障礙檢測中尤其在無人駕駛、盲道障礙檢測等實時性要求較高的方向上性能表現并不優越[5]。Redmon等[6]基于回歸預測的思想提出了YOLO算法,直接在卷積神經網絡中提取目標的相關特征來預測其位置信息,相比兩階段目標檢測算法檢測速度更快,但一階段算法[7]由于追求速度而放棄對圖像中小型目標的特征提取,導致精度不高。Liu等[8]提出SSD方法,網絡引入先驗框進行障礙物檢測,提高了網絡對于障礙目標的精度。Redmon[9]隨后借鑒SSD算法提出YOLO V2算法,在檢測精度上有明顯提升,但是對于目標特征提取能力沒有得到有效解決。為改善網絡對于目標特征提取能力,YOLO V3[10]以及YOLO V4[11]等算法相繼提出,網絡通過殘差結構提高對小型物體的特征提取能力,從而實現精度的提升。隨著目標檢測算法被應用到道路障礙檢測中,更多學者針對目標的特性進行不同方面的改進,李鵬飛[12]等對YOLO9000模型提出改進,通過對模型算法參數進行調整來適合多目標檢測。王建林[13]等針對目標檢測精度低的問題對YOLO V2中卷積層采用密集連接方式來獲取更好的目標信息,同時采用空間金字塔池化增強局部特征來提高網絡的檢測精度。郭進祥[14]等將YOLO V3骨干特征提取網絡變為空洞卷積,保持較大感受野同時對非極大抑制算法進行優化,提高對遮掩目標的檢測。孫佳等[15]提出K-means-threshold方法,彌補普通K-means算法對聚類中心初始位置敏感問題。鞠默然[16]等針對圖像中小型障礙的像素相對較少,通過將YOLO V3網絡輸出層進行上采樣,將高層特征與低層特征進行特征融合獲得對障礙目標的位置信息。鞏笑天[17]等對Tiny YOLOV3目標檢測改進,增加2步長的卷積層代替最大池化,同時使用深度可分離卷積替換傳統卷積增加網絡模型精度。王偉鋒[18]等通過增強網絡對障礙目標的感受野來擴大卷積核對特征的提取范圍及能力提高,同時將低層與高層的特征信息融合起來增加對小型障礙物的檢測精度。而盲道障礙物以其背景復雜,障礙種類繁多,物體遮掩占比大等特點使得常見的目標檢測算法在實際檢測中存在對小型障礙物體、遠距離物體、條形障礙物體的漏檢、誤檢等問題。針對以上問題,本文基于深度學習的方法對盲道障礙物檢測展開研究。對此本文網絡提出改進:1)通過對盲道障礙物特性進行分析,針對遠距離物體以及條形物體特征信息較少問題,增加非對稱卷積模塊(ACB)[19],在垂直方向與水平方向強化特征提取,將提取后的特征增加到方形卷積特征中,實現對條形物體以及遠距離物體的特征加強;2)引入條形池化模塊[20],減少方形池化過程中空白信息與污染信息的干擾,為兼顧長條形與非長條形障礙物的效果,將金字塔池化改進為混合池化模塊(MPM);3)改變特征融合方式[21],將高級特征語義信息融入到低級特征的方式來解決復雜場景下盲道障礙物識別問題。

1 盲道障礙檢測算法優化

1.1 特征提取結構

網絡特征提取結構如圖1所示,由CSPDarknet53,MPM池化模塊,PANet[22]組成。CSPDarknet53作為骨干特征提取網絡,由Darknet53和CSP局部交叉階段組成。Darknet53主要由5個殘差塊構成,CSP局部交叉階段能夠增強CNN的特征提取能力,在輕量化的同時保持準確性,降低計算成本。MPM為混合池化模塊,由Pyramid pooling與Strip Pooling 組成,主要作用為增大網絡感受野,增強條形特征池化效果。PANet通過自下而上的路徑增強較低層中定位信息流的準確性,建立底層特征和高層特征之間的信息路徑,增強整個特征層次架構。

改進后的網絡中將非對稱卷積加入到骨干特征提取網絡中,條形池化與金字塔池化構成MPM混合池化模塊,在特征融合方式上改變傳統concat融合操作,將高級特征的語義信息加入到低級特征中增強對小目標識別精度。

1.2 非對稱卷積模塊(ACB)

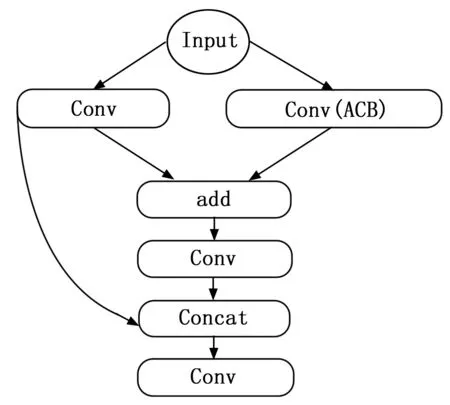

為使網絡在實際場景下對盲道中條形障礙物與盲道中小目標障礙物有更好的檢測效果,在網絡方形卷積核的基礎上增加非對稱卷積模塊,增強在圖像水平與垂直方向上的特征提取。對于盲道障礙物檢測中對于小目標障礙物與條形障礙物來說,十字區域信息尤為重要,因此將非對稱卷積核中十字骨架部分特征信息提取后與原方形卷積核提取特征信息權重相疊加,提升網絡對條形障礙物的檢測精度,降低較遠處障礙物的漏檢率。

如圖2所示,將非對稱卷積(ACB)添加到網絡殘差塊中,針對盲道中條形障礙物特征信息進行提取,并與方形卷積核提取的特征信息進行融合。

圖2 卷積結構

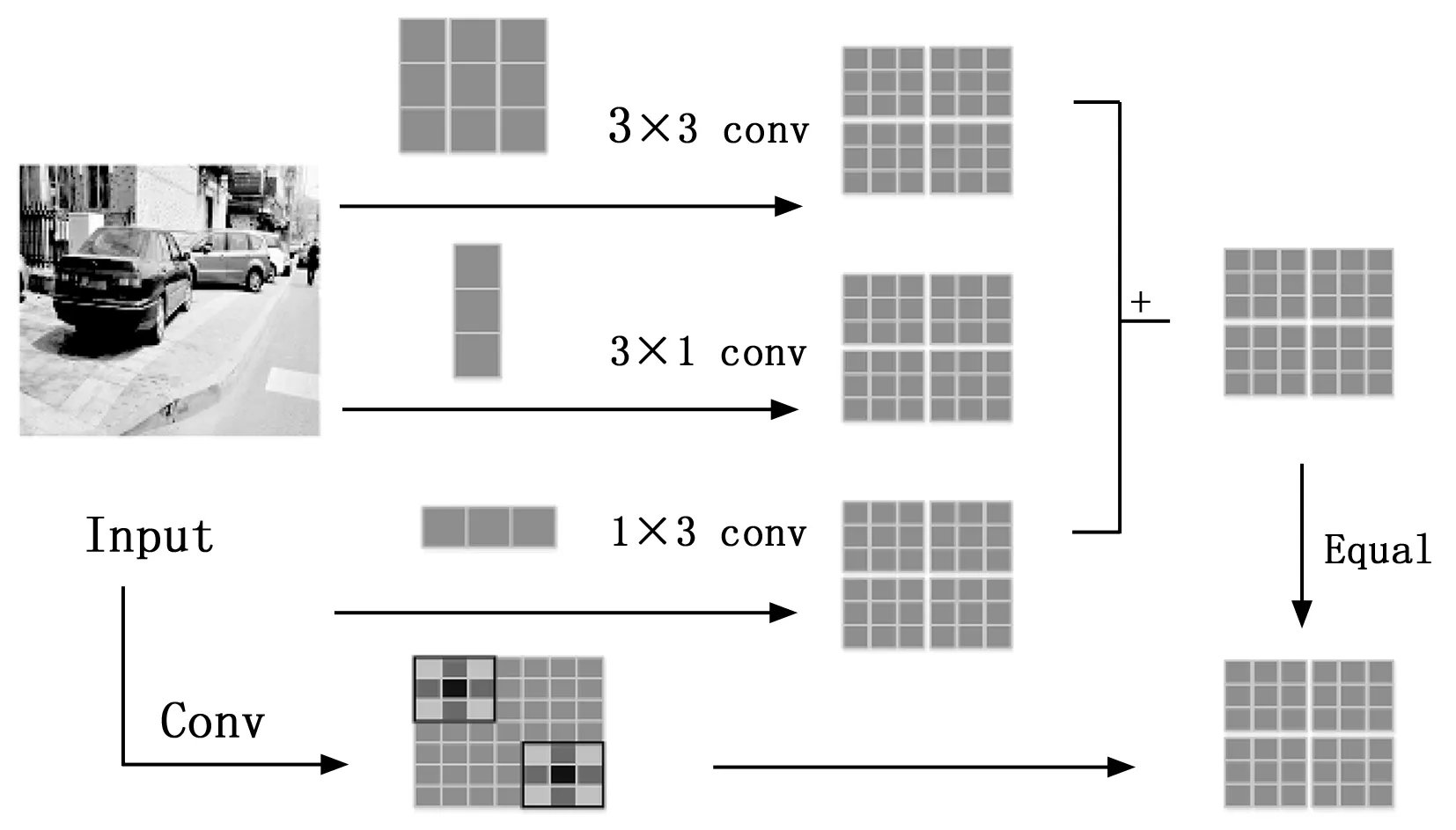

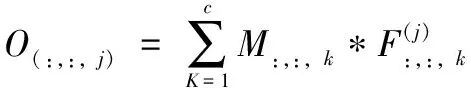

圖3公式如下,對于一個尺寸為H×W,通道數為D的卷積核,通道數為C的特征圖作為輸入,用F∈RH×W×C表示卷積核,M∈RU×V×C表示輸入,O∈RR×T×D代表輸出特征圖,對于這個層的第j個卷積核,對應的輸出特征映射通道為:

圖3 卷積原理圖

(1)

I*K(1)+I*K(2)=I*(K(1)⊕K(2))

(2)

其中:I是一個矩陣,k(1)和k(2)是具有兼容尺寸的兩個2D核,⊕是在對應位置求和。圖像經過非對稱卷積模塊(ACB)處理后,保留了目標水平與垂直方向上的特征,再通過與方形卷積后的特征對應位置像素疊加,實現對條形目標特征信息的增強,提高網絡對條形障礙物目標的檢測精度。

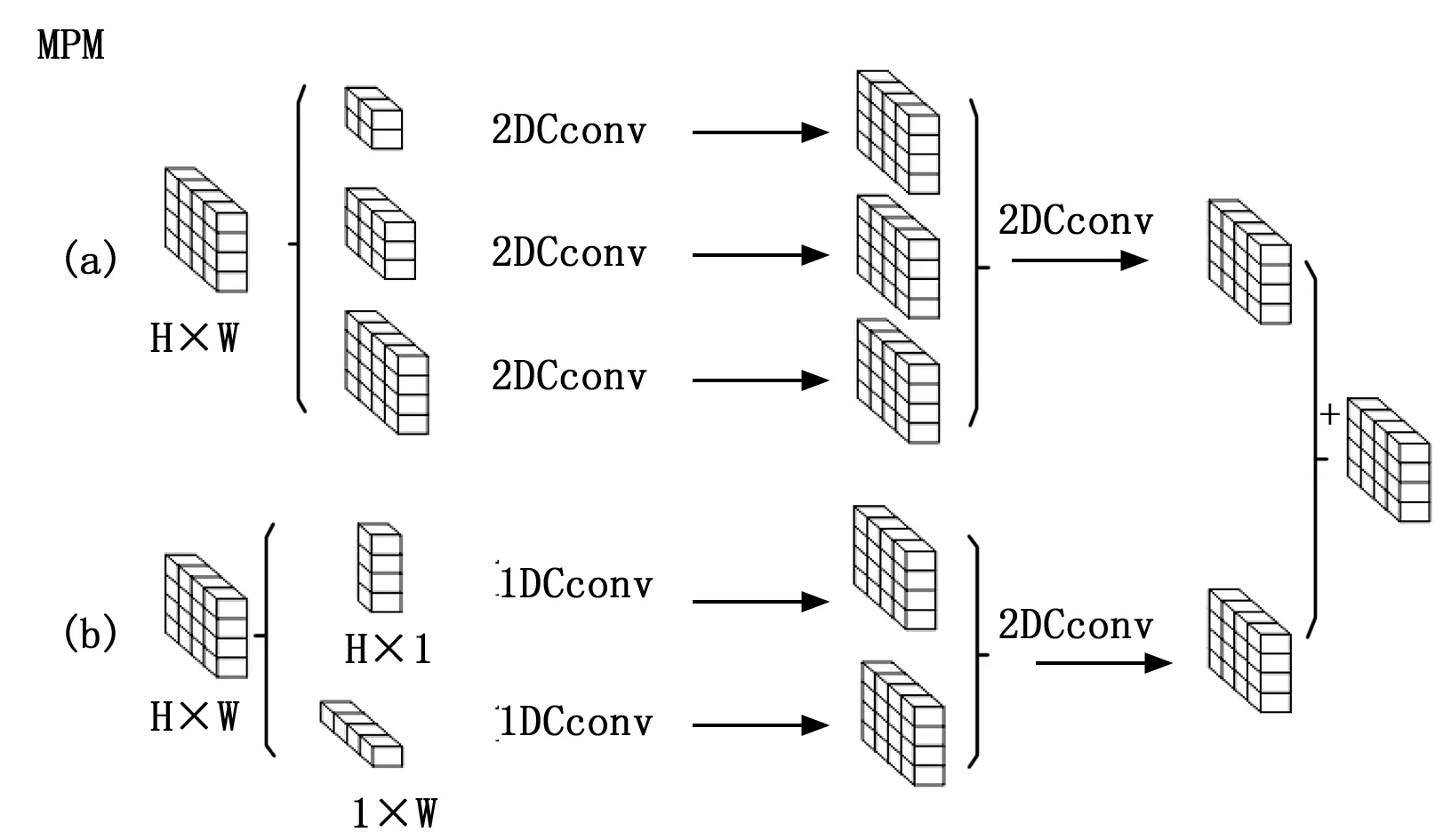

1.3 混合池化(MPM)

金字塔池化是為了獲得更大的感受野,現階段增大感受野的方法,可利用自注意力機制(self-attention)來建立長距離關系,也可以使用空洞卷積(dilated convolution)[19]或金字塔池化,但這幾種方法在特征為方形條件下效果較好,本文經實驗發現,在實際盲道場景中,金字塔池化對于長條形目標檢測效果并不理想。針對于此問題,本文提出引入長條形池化模塊,既可以豐富長條障礙物特征語義信息,同時避免了使用方形池化時引入的污染信息和空白無效信息。但全部使用條形池化又會導致方形障礙物目標的效果變差,因此設計了一種混合池化模塊(mix pooling moudle),其結構如圖4所示。

圖4 特征融合

圖5所示為混合池化模塊,由金字塔池化與條形池化模塊組成,其中條形池化公式如下,對于一個輸入為H×W的特征圖,其水平池化公式為:

圖5 混合池化

(3)

同理垂直池化公式為:

(4)

其中:(h×u)代表池化范圍,將池化后的特征圖進行擴容,擴容后的特征圖進行對應位置相加,再將條形池化后的特征權重增加到金字塔池化特征圖上,實現對檢測目標十字區域信息增強,提高對條形物體以及遠距離物體的檢測精度。

1.4 特征融合方式

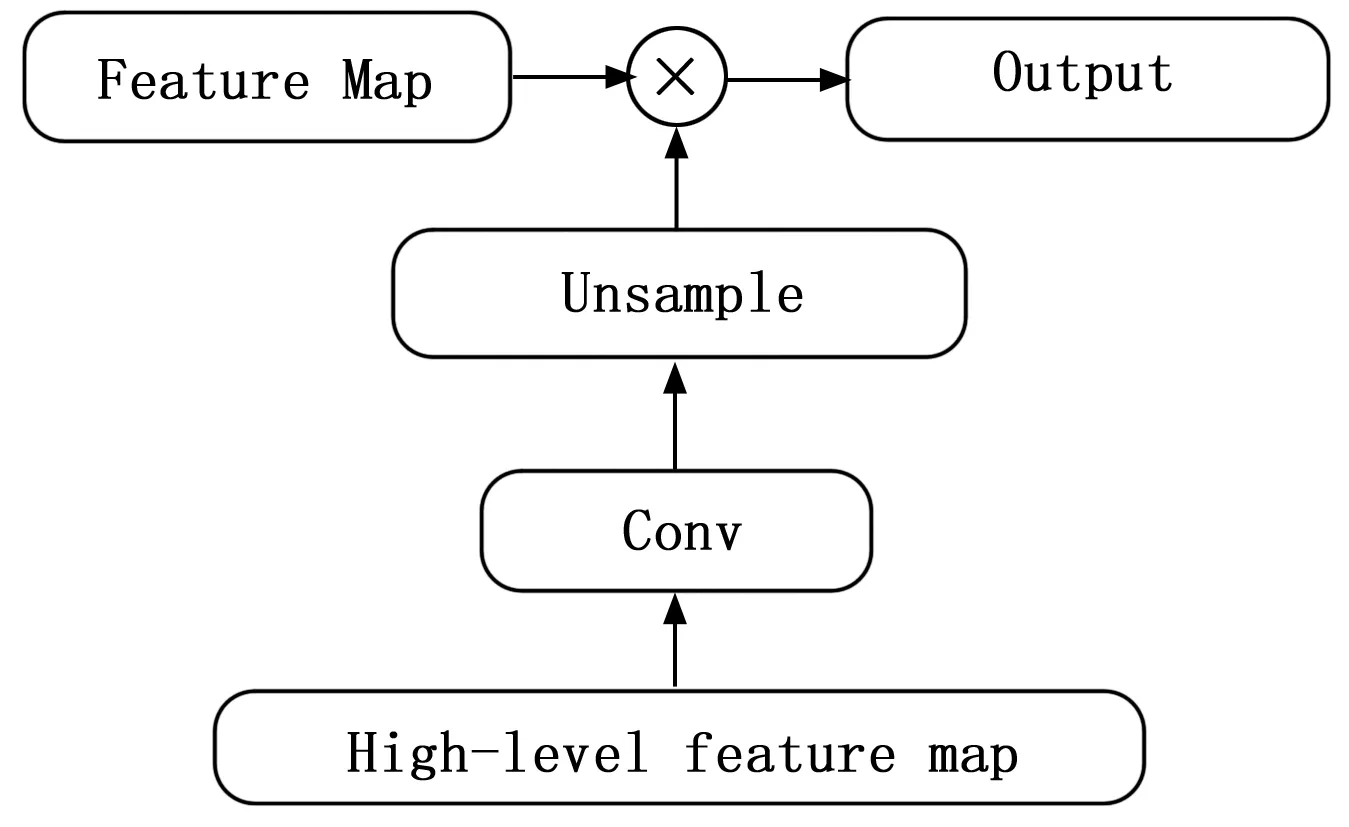

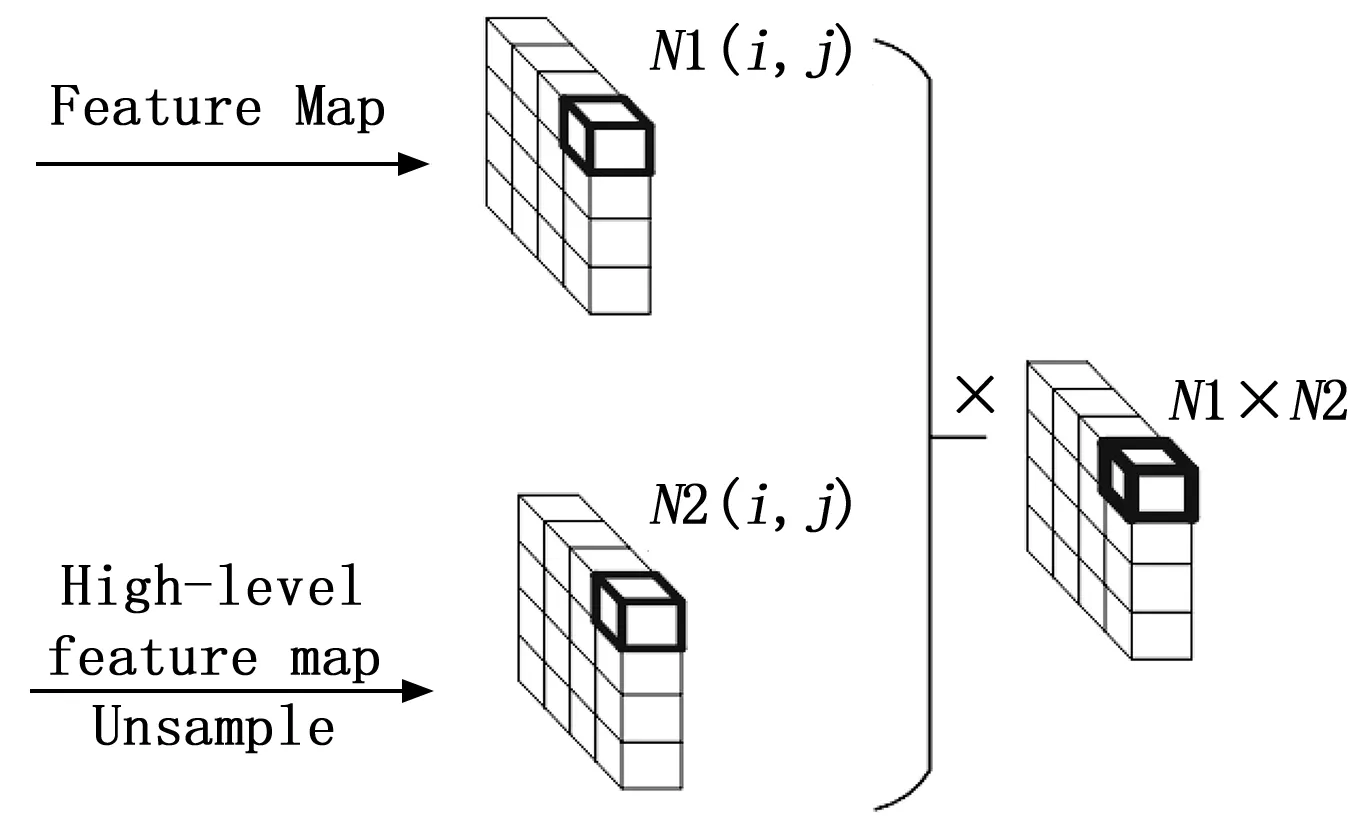

常用的特征融合方法一般為concat,concat是進行通道擴容,物體特征增加但是每一維的特征信息沒有改變,但是concat操作會導致計算量增大。而低級特征包含豐富的空間信息,高級特征擁有豐富的語義信息,因此本文引入一種特征融合方法[23],如圖6所示。本文特征融合方法是將低級特征與上采樣后的高級特征進行逐元素相乘。為防止網絡訓練過程中出現過擬合現象,提前進行歸一化處理,從而使低級特征含有更多的語義信息,加強網絡對于盲道中小目標物體特征信息的提取能力,提升網絡對于盲道中小目標物體的檢測精度。

圖6 特征融合

圖6為特征融合方式,其公式為:

yl=f(xl,xl+1)

(5)

yl表示特征融合輸出,f表示矩陣運算,xl表示低級特征,xl+1表示高級特征,N1表示低級特征每一通道對應信息,N2表示高級特征每一通道對應信息,為使公式成立,xl與xl+1需滿足大小相同,通道數相等,故利用卷積操作進行通道變換。改變傳統的空間融合,利用高級與低級特征對應位置相乘的形式,加強每一位置的特征信息。

2 實驗與結果分析

實驗平臺搭載Inter i7 9700K處理器, 1個NVIDIA 2080Ti顯卡;深度學習框架采用pytorch-1.6.0,以及Nvidia公司CUDA10.1的GPU運算平臺以及CUDNN深度學習GPU加速庫。

2.1 盲道障礙物數據集

目前,由于盲道障礙物體種類復雜,用于深度學習的盲道障礙物數據集較為匱乏,已知的公共數據集都只包含部分盲道障礙物體類別。對此本文對于實際盲道場景進行調查,分析盲道主要出現的障礙物。城市主干道區域盲道障礙物主要以行人、共享單車為主;生活區域所在盲道上出現障礙物較多,主要以汽車、貨車、共享單車、摩托車、行人、桌子、椅子等中大型物體出現,其中汽車、自行車、摩托車以及行人在盲道上出現頻率較多且數量大。對于上述情況,本文采用視頻拍攝方式,共采集不同場景下的37個視頻段,通過將視頻按幀率裁剪得到不同場景下的障礙物圖像。圖像主要分為兩部分,一部分以生活區域為主的障礙物圖像,該部分圖像具有場景復雜、障礙物種類以及數量多、物體遮掩比大等特點;另一部分以主干道區域為主的障礙物圖像,具有物體較為單一,輪廓完整等特點。本文通過裁剪獲得圖像共計3 380張,為豐富障礙物數據集,對圖像進行數據增強方法擴充數據集,共計7 460張。

圖7 盲道障礙數據集

2.2 定量與定性分析

本文為驗證改進YOLO V4網絡的有效性,將YOLO V4作為對比實驗,初始化權值來自于VOC數據集預訓練的結果,對盲道障礙物數據集進行訓練,訓練批次為64,衰減為0.000 5,最大迭代次數200。初次訓練學習率為10-3,100 epochs后調整為10-4,150 epochs后調整為10-5。

為了對模型進行量化分析,對比兩種方法對障礙物的檢測效果,采用評價指標交并比GIOU、Objectness、Classification、Recall、mAP、F1作為定量評價指標,如圖8所示。

圖8 訓練指標

圖8分別表示YOLO V4模型與改進后的網絡模型各個指標訓練過程,同時加入第三章模型訓練指標進行對比。圖(a)表示GIoU訓練過程,(b)表示Objectness訓練過程,(c)表示Recall訓練過程,(d) 表示F1訓練過程, (e) 表示Classification訓練過程, (f)表示mAP訓練過程。

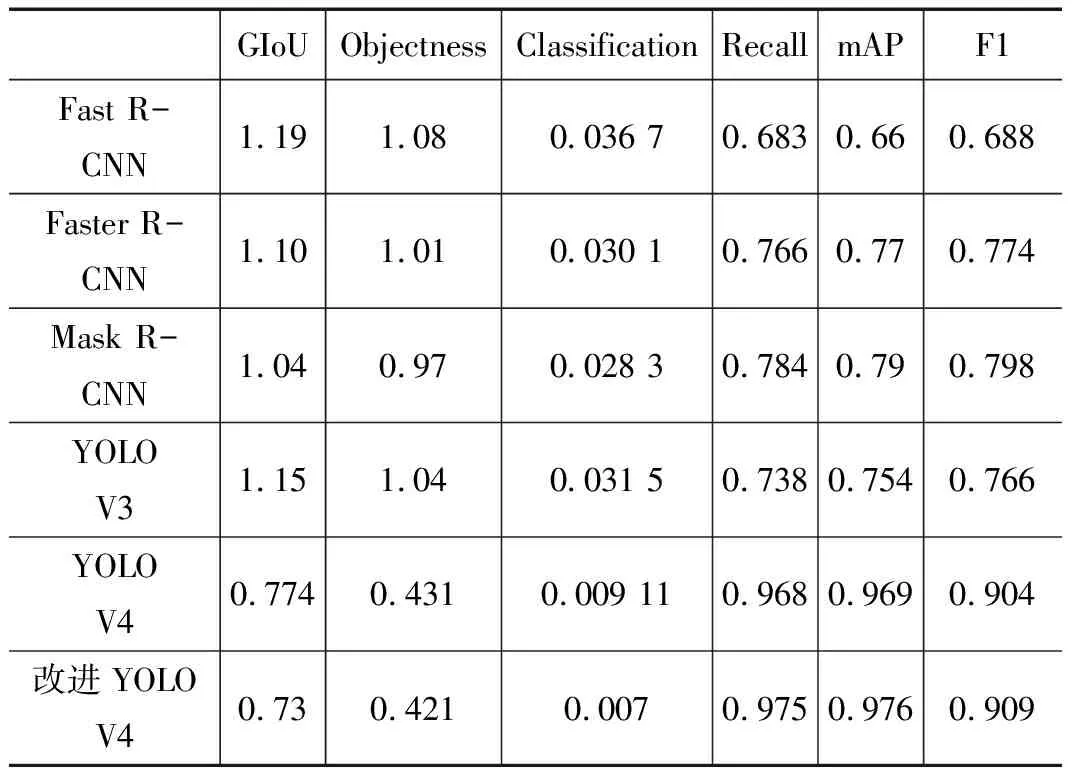

為更好地展現本文改進YOLO V4網絡的性能,本文將FAST-RCNN、Faster-RCNN、MASK-RCNN、YOLO V3、YOLO V4網絡進行綜合對比,通過交叉展現對比結果,驗證改進YOLOV4網絡的性能。如表1所示。

表1 各模型在盲道障礙數據集的訓練指標

通過對比YOLO V4與改進網絡兩個模型的各指標訓練過程可以看出,改進模型在盲道障礙數據集GIOU為0.73,Objectness為0.421,Classification為0.007,Recall為0.975,MAP為0.976,F1為0.909,與YOLO V4模型在盲道障礙數據集上對應的指標分別提升了0.036,0.01,0.000 183,0.007,0.003,0.005。

通過對比改進YOLOV4網絡與FAST-RCNN、Faster-RCNN、MASK-RCNN、YOLO V3、YOLO V4網絡的GIOU指標分析發現,改進YOLO V4網絡對于真實值包圍框的下降曲線最快,可快速有效地定位圖像中的真值區域,驗證了數據集中障礙物集中分布于圖像中十字區域,通過混合池化模塊及先驗定位策略,幫助網絡快速定位圖像中的IOU區域;對比Objectness指標發現,改進YOLOV4網絡對于目標IOU區域的包裹緊密性較FAST-RCNN、Faster-RCNN、MASK-RCNN、YOLO V3、YOLO V4網絡的損失值較小,證明改進YOLOV4網絡中可以緊密的包圍目標區域,去除背景噪聲對于有效特征的干擾,得益于本文中混合池化模塊及ACB模塊組合效果對于圖像IOU區域特征提取的精細程度,提取圖像中細致特征信息;對比Classification指標可知,改進YOLO V4網絡對于分類結果的快速有效性強于FAST-RCNN、Faster-RCNN、MASK-RCNN、YOLO V3、YOLO V4網絡,可以準確有效的將障礙物類型進行區分,得益于非對稱卷積模塊對卷積核提取能力的加強,以及特征融合方式低層特征對高層特征補充的有效性;通過對Recall、mAP、F1共3個指標的分析可知,改進YOLOV4網絡對于整體類別的正樣本的召回率較FAST-RCNN、Faster-RCNN、MASK-RCNN、YOLO V3、YOLO V4網絡提升較大,且對于單獨類別的調和對比值F1有一定的提升,驗證了網絡在準確預估類別及檢測過程中有較好的準確率和魯棒性,對于mAP綜合全局的驗證指標分析可知,本文方法的混合池化模塊、多尺度的特征融合方式及非對稱卷積對于網絡整體有較好的提升效果,三者組合交叉嵌入互相影響,綜合提升網絡對于障礙物目標的檢測及識別能力,從而提升網絡整體的檢測精度及準確率,驗證了改進網絡的有效性。

表2分別表示YOLO V4與本文特征提取方法對盲道障礙物的效果。通過將非對稱卷積加入骨干特征提取網絡中,以及采樣后的高級特征的信息與低級特征相融合。利用相乘的方式進一步增強障礙物的特征信息,可以看出本文特征融合方法相對于concat融合來說將障礙物目標信息表現更為明顯。YOLO V4網絡對圖像中人以及電動車等目標信息提取較為模糊,而本文網絡相較于YOLO V4網絡提取效果更佳。

表2 特征提取對比

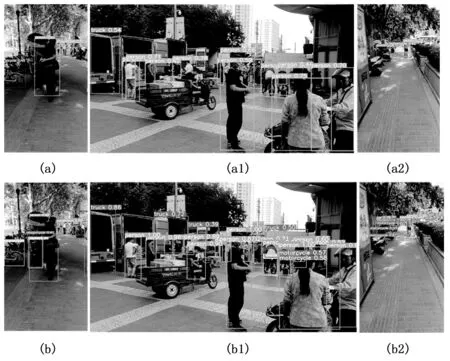

圖9為YOLO V4與改進YOLO V4的識別效果,(a)、(a1)、(a2)表示YOLO V4模型檢測效果,(b) 、(b1)、(b2)表示改進YOLO V4模型檢測效果。

圖9 場景測試對比

由圖9可看出,通過引入非對稱卷積模塊,加強了對障礙物十字區域的特征提取能力,使得網絡對較遠處障礙物包括條形障礙物可以檢測出來,同時有較好的檢測精度,混合池化模塊減少污染信息以及冗余特征信息對障礙目標信息的干擾,利用相乘的融合方式進一步增強條形以及小型障礙物的特征信息。改進YOLO V4模型相較于原YOLO V4模型能夠將較遠處條形以及小障礙物檢測出來,提升了網絡模型對障礙物的檢測精度,對于含有部分特征信息以及特征信息不明顯的障礙物目標,也能較為準確地檢測出來。改進YOLO V4模型在盲道障礙物檢測中提高了對條形障礙物的檢測能力。同時非對稱卷積以及混合池化模塊也增強了非條形障礙物的特征信息,對近距離障礙目標的檢測效果也有提升。

3 結束語

本文針對于目標檢測算法在檢測遠距離盲道障礙物以及條形障礙物檢測存在漏檢誤檢問題,在YOLO V4模型基礎上,加強骨干網絡在水平與垂直方向上的提取能力,構建混合池化模塊與特征融合部分使得網絡對條形障礙物、小型障礙物檢測精度提升并在盲道數據集上進行實驗。實驗表明條形目標以及遠距離障礙目標能夠以良好的精度識別出來,降低網絡漏檢率。結果表明改進后的網絡模型對障礙物檢測有更好效果。