融合句法信息的無觸發詞事件檢測方法

汪 翠,張亞飛*,郭軍軍,高盛祥,余正濤

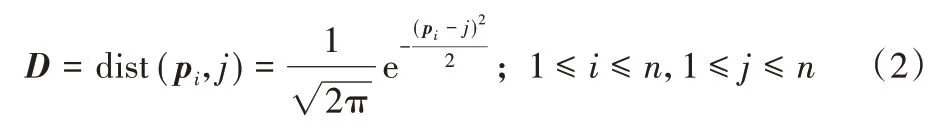

(1.昆明理工大學信息工程與自動化學院,昆明 650504;2.云南省人工智能重點實驗室(昆明理工大學),昆明 650504)

(?通信作者電子郵箱zyfeimail@163.com)

0 引言

事件檢測是信息抽取中一項重要而具有挑戰性的任務,事件檢測任務旨在識別句子中的事件觸發詞并將其分類為特定類型。觸發詞是指在句子中能夠清楚地表示事件發生的核心單詞,通常是動詞或名詞短語。

大多數現有的事件檢測方法需要帶標注的事件觸發詞和事件類型進行訓練。這些方法根據輸入的不同,可以分為基于語義表示[1-3]的方法和基于句法依存表示[4-6]的方法。其中,基于語義表示的方法只使用給定的句子作為模型的輸入,在長距離依賴方面存在著低效率的問題。基于句法依存表示的方法通過在模型中融入句法信息能夠準確定位與觸發詞最相關的信息,以及在單個句子中存在多個事件時,增強事件之間的信息流動性。現有的基于句法依存表示的方法通常采用鄰接矩陣來表示原始的句法依賴關系[4-6],但鄰接矩陣表示范圍有限,只能捕獲當前節點與相鄰節點的關系。同時,鄰接矩陣需要圖卷積網絡(Graph Convolutional Network,GCN)對其進行編碼以獲取句法信息。但是,利用GCN 編碼會引入額外的訓練參數,增加了模型的復雜度。此外,這些方法對觸發詞的標注會耗費大量的人力工程。

為解決以上問題,受Okazaki 等[7]提出的采用父詞信息來表示句法依賴關系思想的啟發,本文提出了融合句法信息的無觸發詞事件檢測方法。將依存句法解析中的依賴父詞(下文簡稱為父詞)及其上下文轉換為位置標記向量后融入依賴子詞中,不需要借助GCN 的編碼便能獲取句法信息,并提高事件檢測的準確性。具體地,在Transformer 的局部自注意力機制中以一種無參的方式將父詞信息融入依賴子詞的單詞嵌入,使模型在編碼源句子時關注到每個單詞的父級依賴項及其上下文;同時,針對觸發詞的標注費時費力,提出了基于多頭注意力機制的類型感知器對句子中隱藏的觸發詞進行建模,以實現無觸發詞的事件檢測。

通過在ACE2005 數據集上的實驗表明,本文采用的方法在事件檢測任務上取得的性能超過了以往的方法;另外,通過在低資源越南語數據集上的實驗表明本文方法也適用于少樣本的低資源情況。

1 相關工作

在早期的工作中,事件檢測的方法包括基于特征的方法,該方法在不同的統計模型[8]中采用手工設計的特征。在過去的幾年里,神經網絡模型成功地用于事件檢測。其中,典型模型采用了卷積神經網絡(Convolutional Neural Network,CNN)[1]、循環神經網絡(Recurrent Neural Network,RNN)[2]、雙向長短時記憶(Bi-directional Long Short-Term Memory,Bi-LSTM)循環神經網絡[3],雖然這些方法能有效地捕獲局部的語義關系,但對于非局部以及非結構化的句法信息卻能力有限。然而,在許多應用中,這種非局部的句法信息可以顯著地加強句子的語義表征并提高整體性能。為了將句法信息融入神經網絡模型以提高事件檢測性能,Yan等[4]將鄰接矩陣輸入到具有聚合注意的圖卷積網絡中,來對句子中的句法表示進行顯式建模和聚合;陳佳麗等[5]將GCN 編碼后的句法信息與文本的語義信息通過門控機制進行融合;Li 等[6]通過GCN 生成多個潛在的上下文感知圖結構來選擇有用的句法信息;Dutta等[9]將句法解析樹中單詞之間的依賴關系以及依賴標簽整合到圖變換網絡(Graph Transformer Network,GTN)[10]中以實現事件檢測。

以上基于句法依存表示的方法采用鄰接矩陣來表示原始的句法依賴關系,需要經過GCN 編碼為高階的句法表征后,再融合到文本的語義信息中,由此增加了模型的復雜度。因此,本文將父詞信息連接到依賴子詞來表征句法依存樹中的依賴關系,并在Transformer 的編碼器中將非結構化的句法信息與結構化的語義信息進行融合,不破壞Transformer 原本的結構性、減少了GCN 單獨編碼的額外參數,并且更加簡便有效。

2 融合句法信息的無觸發詞事件檢測模型

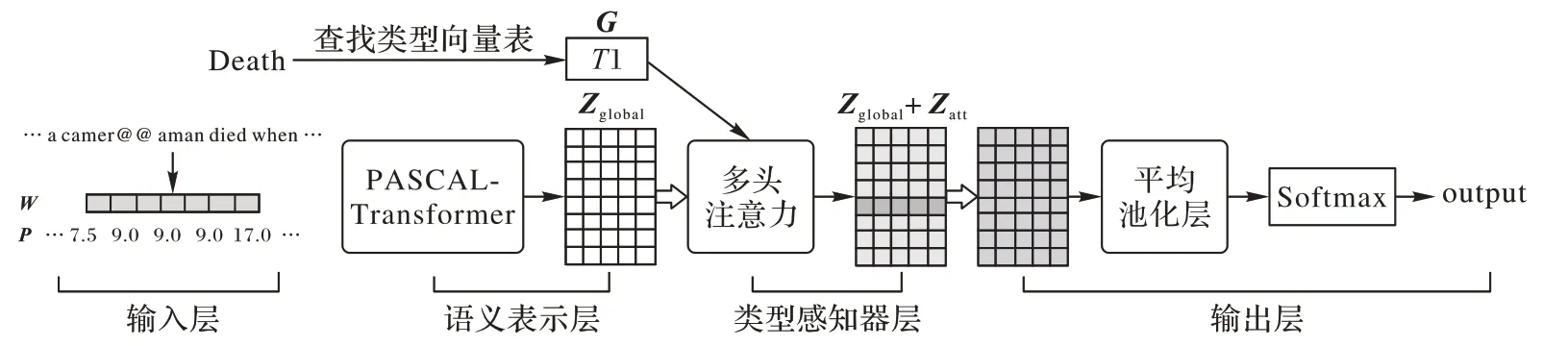

首先,文本采用Transformer 編碼器獲取句子的上下文語義表征,然后使用多頭注意力機制來建模句子中潛在的觸發詞,最后將獲取的觸發詞信息連接到句子的語義表征來獲取全局的事件信息。模型的基本架構如圖1所示,由4個部分組成:輸入層、語義表示層、類型感知器層以及輸出層。

圖1 融合句法信息的無觸發詞事件檢測模型的基本架構Fig.1 Basic structure of no trigger word event detection model incorporating syntactic information

2.1 輸入層

本文以目標句子以及由外部解析器提供的句法依存關系作為模型的輸入,此外還使用BPE(Byte Pair Encoding)子詞單元來緩解未登錄詞與罕見詞問題。將輸入的文本序列進行BPE 編碼后以補全或截斷的方式固定句子長度,將其表示為X={x1,x2,…,xi,…,xn},n為句子長度。對X進行隨機初始化后獲得詞向量W={w1,w2,…,wi,…,wn},其中,wi為xi的向量表示。

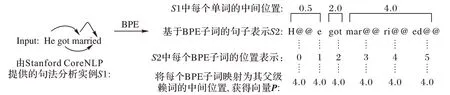

還根據單詞經過BPE編碼后的子詞數量來計算出每個單詞的中間位置,以及將每個單詞映射為其父詞的中間位置表示。如圖2所示,S1中的married經過BPE編碼后獲得S2中的3 個子詞單元“mar@@”“ri@@”“ed@@”,位置分別為3、4、5,則married 的中間位置為4.0;然后將S2 的每個子詞單元映射為其父詞(句中所有單詞的父詞為married)的中間位置;從而為目標句子S2產生一個由父詞的中間位置組成的向量表示P;最后以詞向量W和父詞的位置向量P作為語義表示層的輸入。

圖2 句法信息處理實例Fig.2 Examples of syntactic information processing

2.2 語義表示層

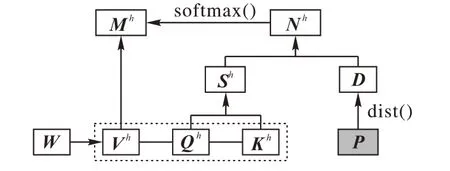

圖1 中的語義表示層由12 層的Transformer 編碼端組成。本文在第li層Transformer 的局部自注意力層中融入了句法信息,而其他層的Transformer 則采用普通的自注意力層。融入句法信息的局部自注意力稱為依賴縮放自注意力(PArent-SCALed self-attention,PASCAL),結構如圖3所示。

圖3 依賴縮放自注意力(PASCAL)結構Fig.3 Structure of Parent-Scaled Self-Attention(PASCAL)

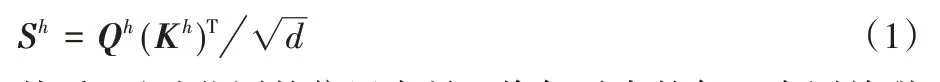

在圖3 的PASCAL 結構圖中,詞向量W經過線性變換后,獲得查詢Qh、鍵Kh和值Vh。先計算Qh和所有Kh之間的點積,給出句子中每個單詞對輸入的其他部分放置多少焦點的分數。然后,這個分數除以,以緩解如果點積很大時出現的梯度消失問題,d的大小為W的大小dmodel除以多頭注意力機制的頭數h。最后獲得相似度權重Sh∈Rn×n,如式(1)所示。

然后,通過父詞的位置向量P將句子中的每一個詞關聯到其父級依賴項。以xi作為當前詞,通過計算出所有xj到xi的父詞的距離來衡量xi位于位置i的得分。如式(2)所示,pi表示xi的父詞的中間位置,j表示句子所有詞的絕對位置,輸出的句法關聯矩陣D∈Rn×n,D的每一行表示任意j到xi的父詞的中間位置pi的距離。

之后,將相似度矩陣Sh、值vh與句法關聯矩陣D通過向量運算的方式進行融合。如式(3)、(4)所示,序列相似度矩陣Sh與關聯矩陣D對應元素相乘后得到中間向量Nh,對Nh應用Softmax 后再與值vh相乘,獲得PASCAL 每個頭的輸出Mh。這樣便實現了以局部無參的方式將句法依賴信息融入缺乏任何上下文的詞嵌入中。

將Mh拼接后獲得PASCAL 的最終輸出M,M經過Transformer 后續的殘差連接、歸一化以及全連接層后獲得M′。然后M′經過剩下的11 層Transformer 編碼器后獲得句子的全局特征表示Zglobal,如式(5)~(7)所示。

2.3 類型感知器層

由于本文任務沒有標注觸發詞,為了對隱藏的觸發詞進行建模,通過在多頭注意力機制中引入候選事件類型來發現句子中隱藏的觸發詞。

如式(8)、(9)所示,對全局特征Zglobal和候選事件類型的詞嵌入G進行頭數為8 的多頭注意力機制,為Zglobal中潛在的觸發詞分配更高的權重。

其中:Zglobal為語義表示層的輸出;G為候選事件類型的詞嵌入;是在輸入向量上執行線性投影的參數;At表示多頭注意力機制中每個頭的最終輸出;Zatt為At的拼接,表示包含觸發詞信息的局部特征。

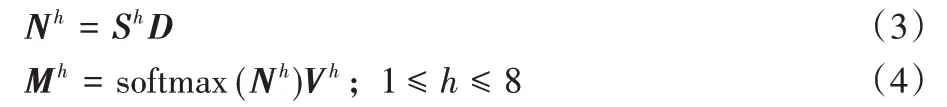

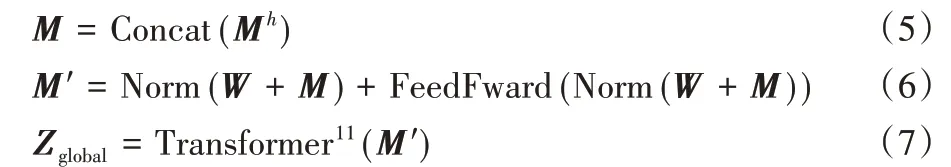

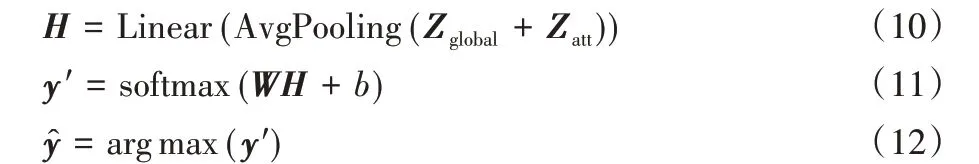

2.4 輸出層

為了獲取全局的事件信息,將全局特征Zglobal和局部特征Zatt進行加權求和后再執行平均池化操作,然后經過一個線性層后獲得向量H;最后,對H執行Softmax 獲取對應類別的分布概率,并根據概率分布的值來判斷輸入句子的事件類型,如式(10)~(12)所示。

其中:H表示全局事件信息;W和b為權重和偏置;y′表示輸入句子是否為預標注類型的概率;y表示最終的預測值。

2.5 模型訓練

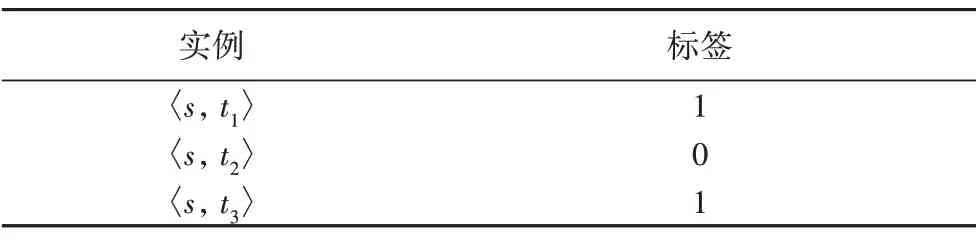

為了解決機器學習中的多標簽問題——一個句子可能包含零個或多個事件[11],本文在模型中將多標簽分類轉化為多個二分類。如表1所示,假設句子s共有三個預定義的事件類型t1、t2和t3,而句子s包含事件類型t1和t3,則事件句s可以轉化為以表1所示的三個實例。

表1 事件句s的二分類舉例Tab.1 Example of binary classifications of sentence s

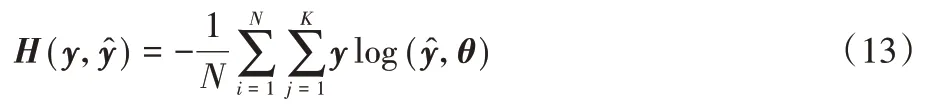

這樣的話,如果一個句子中包含多個事件,則可以產生多個正對,從而很好地解決了多標簽問題。此外,模型訓練的目標函數采用交叉熵損失,如式(13)所示:

其中:θ表示模型中需要更新的參數;N表示一個batch 的樣本數;K表示類別數,本文將其設置為2,即每個句子屬于預標注類型或無類型(NA);y代表真實標簽,值為0 或1;?表示候選事件的預測概率。本文使用Adam優化函數來更新參數θ。

3 實驗與分析

3.1 數據集及評價指標

3.1.1 數據集

本文在ACE2005 數據集上進行了大量的實驗,并對ACE數據集進行了預處理:刪除數據集中觸發詞的標注,使用Stanford CoreNLP 工具獲取句法依存信息,并為每一個句子分配一組標簽,不包含任何事件時標注為NA。為了方便比較,劃分數據集的方式與文獻[4-6]一致,將40 篇文章作為測試集,30篇文章作為開發集,剩余的529篇文章作為訓練集。

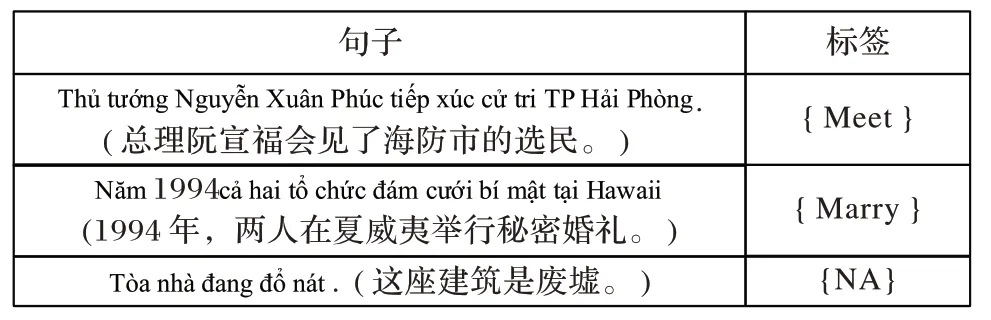

此外,本文還構建了一個小型的越南語數據集,用于驗證本文方法在少樣本的低資源語言上的泛化能力。構建的數據集總共有5 317 條樣本數據,正樣本2 913 條,負樣本2 404 條。純文本數據來自多個公開的越南語新聞網站。經過人工排查去除大部分非事件句后,以ACE 定義的33 種事件類型為基準,采用人工的方式為每一條句子標注候選標簽,以及采用VnCoreNLP 工具獲取句子的句法依存信息。其中,不包含任何事件的句子被標注為NA,標注后的句子案例見圖4。越南語數據集的劃分比例和實驗設置等同于ACE2005。

圖4 越南語數據集標注案例(無觸發詞)Fig.4 Examples of labeling of Vietnamese dataset(no trigger words)

備注:以下實驗,除低樣本的對比實驗在越南語數據集上進行,其他實驗均設置在ACE2005數據集上。

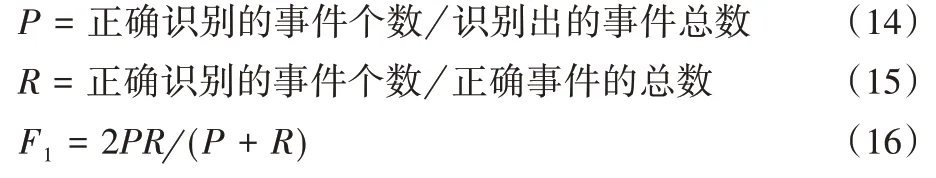

3.1.2 評價指標

評估方法和Liu 等[11-14]的工作一致,使用準確率P(Precision)、召回率R(Recall),F1 值F1作為評價指標。P、R、F1定義如式(14)~(16)所示。

3.2 參數設置

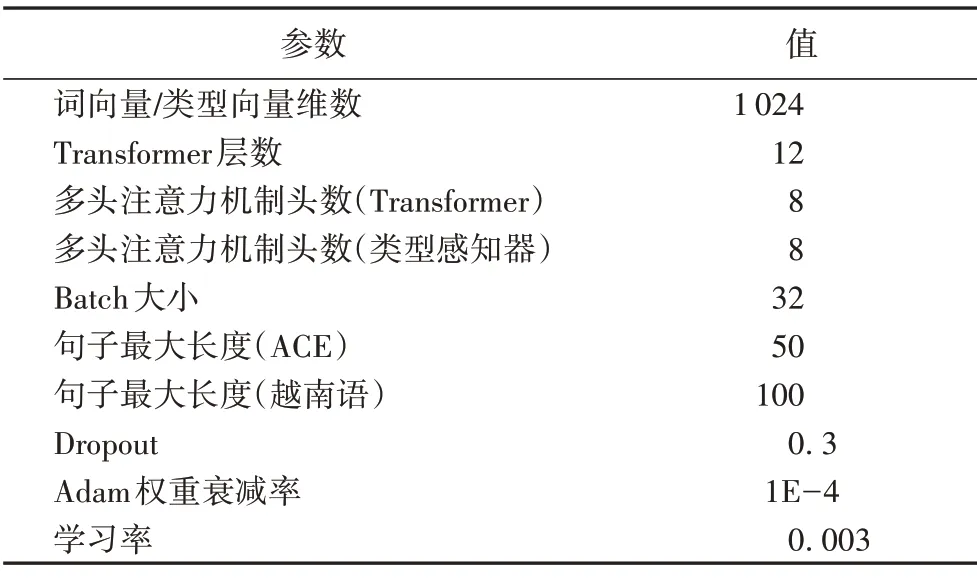

本文選擇Pytorch 框架進行開發,采用12層的Transformer編碼端作為編碼器,本文模型中用到的多頭注意力機制的頭數均設置為8,具體的超參數設置如表2所示。

表2 模型超參數Tab.2 Model hyperparameters

3.3 與基線模型的對比實驗

3.3.1 基線模型

本文選用以下8個事件檢測模型作為基線模型,其中前4種是基于語義表示的事件檢測模型,后4 種是基于句法依存表示的事件檢測模型,它們都是當前事件檢測方面經典或最新的模型,分別如下:

1)基于語義表示的事件檢測模型。

動態多池卷積神經網絡(Dynamic Multi-Pooling Convolutional Neural Network,DMCNN)[1],使用動態多池層從純文本中自動提取詞匯級和句子級特征。

雙向遞歸神經網絡(Joint event extraction via Recurrent Neural Network,JRNN)[2],采用雙向遞歸神經網絡的聯合框架來進行事件抽取。

混合型神經網絡(Hybrid Neural Network,HNN)[3],將雙向長短時記憶網絡(Bi-LSTM)和卷積神經網絡(CNN)相結合,獲取來自特定上下文的序列和結構語義信息。

類型感知偏差注意機制神經網絡(Type-aware Bias Neural Network with Attention Mechanism,TBNNAM)[11],它根據目標事件類型對句子的表示進行編碼。

2)基于句法依存表示的事件檢測模型。

多階圖卷積和聚合注意力的事件檢測方法(Multi-Order Graph Attention Network based method for Event Detection,MOGANED),由Yan 等[4]提出,使用GCN 對句法信息編碼,并使用Attention機制聚合句中多階的句法信息。

利用門控機制融合依存與語義信息的事件檢測方法[5],采用Bi-LSTM 與GCN 分別學習語義表示與句法表示,再利用門控將語義信息與句法信息動態融合。

多個潛在上下文感知圖結構上的圖卷積網絡事件檢測方法MH-GCN(Graph Convolution Over Multiple Latent Context-Aware Graph Structures for Event Detection)[6],通過在BERT 表示和鄰接矩陣上應用注意力機制,再使用GCN 生成多個潛在的上下文感知圖結構,動態保留與事件檢測有關的信息而忽略無關信息。

圖變換網絡事件檢測(Event Detection Using Graph Transformer Network,GTN-ED)方法[9],通過在GTN 中融入句法解析樹中的依賴標簽來完成事件檢測任務。

3.3.2 實驗結果分析

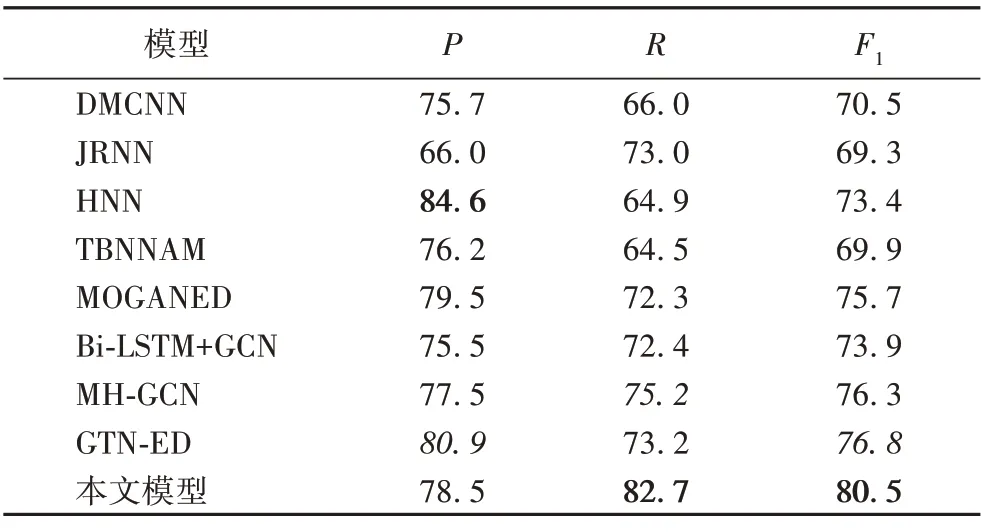

為了驗證本文提出的方法在事件檢測任務上具有優勢,將本文模型與以上8個基線模型進行了對比,實驗結果如表3所示(前人工作的實驗性能數據均引入相應參考文獻中的公開數據)。

分析表3 可知,本文模型的整體性能優于其他的基線模型,其中與基于語義表示的HNN 模型相比F1值提升了7.1個百分點,與基于句法依存表示的GTN-ED模型相比,F1值提升了3.7個百分點。

表3 事件檢測實驗結果 單位:%Tab.3 Experimental results of event detection unit:%

原因分析:

1)基于語義表示的方法將文本嵌入作為模型的輸入,然而,LSTM等神經網絡模型固有的特性并不能很好地解決句子的長距離依賴問題。本文通過引入句法信息加強了事件信息之間的語義關聯性以及增強了整個句子的上下文語義表征,因此實驗效果得到明顯提升。

2)TBNNAM 模型專注于無觸發詞的事件檢測,采用基于類型感知的Attention 去發現句子中潛在的觸發詞。與TBNNAM 不同的是,本文將LSTM 編碼器替換為PASCALTransformer,通過在Transformer 中融入句法信息有效捕獲了直接與觸發詞關聯的事件信息以及在單句子包含多個事件時加強了事件之間的信息流動性;此外,還將TBNNAM 中普通的注意力機制替換為多頭注意力機制,并在注意力機制之后將句子的全局特征和觸發詞的局部特征進行加權求和后進一步執行平均池化操作,以獲取全局的事件信息。由此實現了超越性的效果,F1值較TBNNAM提高了10.6個百分點。

3)相比之前基于句法依存表示的方法通過采用GCN 來編碼鄰接矩陣以獲取句法信息,本文方法證明通過將父詞信息連接到依賴子詞也能有效地進行句法信息的表征。此外,相較于之前的模型采用GCN 對句法信息編碼后再與文本的語義信息進行融合,本文采用向量運算的方式將句法依賴的位置信息融入句子的單詞嵌入,減少了使用GCN 編碼的額外參數,一定程度上提升了模型的性能。

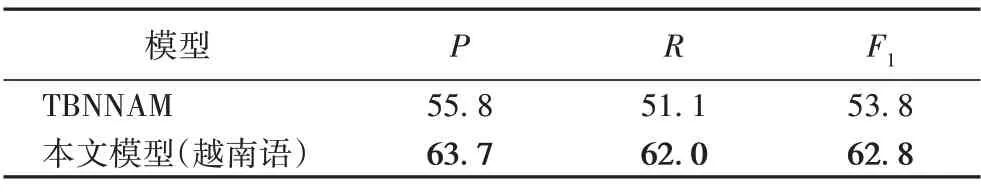

3.4 在低資源數據集上的對比實驗

為了驗證本文模型在低資源數據集上的泛化能力,選取了同為二分類的TBNNAM 模型進行對比分析。此模塊僅選取TBNNAM 模型進行對比分析的原因在于:越南語以音節為單位進行分詞,即單個觸發詞由不同的音節組成,分散在句子的不同片段中,導致無法確切地對事件的觸發詞信息進行標注,而以上基線模型中除TBNNAM 以外的模型都需要確切標注候選事件句中的觸發詞信息,因此,在面向低資源的越南語數據集時,文本僅在二分類基線模型TBNNAM 上設置實驗進行對比分析,實驗結果如表4 所示。與基線模型TBNNAM 相比,本文的P、R、F1分別提高了7.9、10.9、9 個百分點,表明在低樣本的越南語數據集中融入句法信息能夠捕獲越南語句子中多音節單詞之間的句法關聯性。因此,與基于語義表示的TBNNAM 相比,本文的模型在低資源的越南語數據集上具有更好的泛化能力。

表4 越南語數據集上的實驗結果 單位:%Tab.4 Experimental results on Vietnamese dataset unit:%

3.5 模塊有效性分析實驗

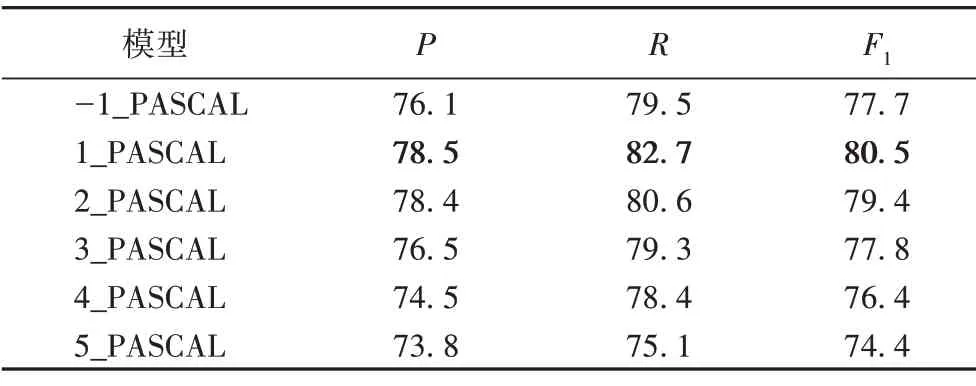

3.5.1 在Transformer的某一層融入句法信息

為了驗證句法信息中父級依賴詞的語境可以豐富句子中孤立的單詞嵌入表示,在語義表示層中設置了如下兩組實驗:不設置PASCAL以及在不同的Transformer層中設置PASCAL。其中,-1_PASCAL 表示不融入句法信息,n_PASCAL 表示在12層Transformer的第n層中融入句法信息。

如表5所示,在第一層設置PASCAL的實驗性能比只采用句子進行編碼的性能更優越,這說明融入句法解析中的句法依賴關系可以使句中單詞關注到語義上與之關聯的其他單詞。另外,當在不同的Transformer 層中設置PASCAL 時,在底層的效果明顯優于高層,這和文獻[15]中的結論一致:在底層時,更多的注意力集中于句法關系的編碼,而在高層中則偏向于語義任務。因此,可以推斷,在第一層執行PASCAL 時能充分利用句法依賴的位置信息來豐富孤立的單詞嵌入表示;而在高層時由于已經初步編碼到文本的語義表征,將導致模型偏向于文本的語義編碼而忽略來自底層的句法位置信息。

表5 不設置PASCAL以及在不同Transformer層中設置PASCAL的實驗結果 單位:%Tab.5 Experimental results of not setting PASCAL and setting PASCAL in different Transformer layers unit:%

3.5.2 在12層Transformer的多層中融入句法信息

為了驗證僅在12 層Transformer 的單層中設置句法信息的有效性,設置了在第m(1 ≤m≤12)層的Transformer 中同時融入句法信息的分析實驗,結果如圖5 所示。可以看出,當m<5 時,隨著m的增加F1 值趨于穩定;當5 ≤m≤12 時,隨著融入層數的增加,F1 值逐漸下降。由此表明,在少量的Transformer 層中融入句法位置信息能有效捕獲句子的句法信息,而在大量的Transformer 層中融入句法位置信息時不可避免地對句子的語義編碼造成了噪聲,以及大量句法信息的融入一定程度上增加了模型的復雜度,影響了模型的性能。同時,考慮到在少量層中融入句法信息可以降低模型的復雜度,以及結合3.4.1 節的推論即在Transformer 的底層融入句法信息取得的試驗效果最佳,因此,本文最終選擇了在Transformer的第一層進行句法信息的融入。

圖5 在12層Transformer的第m層中融入句法信息的F1值Fig.5 F1 score incorporating syntactic information into m-layer of the 12-layer Transformer

4 結語

本文通過在Transformer的編碼器中融入句法信息有效捕獲到了候選觸發詞與相關實體之間的句法關聯性,增強了多事件句中不同觸發詞之間的信息流動性;同時,通過采用類型感知器發現了句子中潛在的觸發詞,實現了無觸發詞的事件檢測。實驗表明,本文模型在ACE2005 數據集上取得了競爭性的效果,在低資源越南語數據集上也取得了較好的性能。另外,針對越南語數據集的實驗性能低于公開數據集的情況,在未來的工作中,我們希望引入預訓練模型,并利用海量的高資源語言來輔助低資源的越南語來完成事件檢測任務。