基于傳感器非視覺信息的無人機目標朝向識別

王 賓,韓群勇

(漳州職業技術學院 電子工程學院, 福建 漳州 363000)

人機交互在生活的各個方面起到重要作用,如醫療、軍事、交通等,近些年專家們對無人機操作方面的應用進行了廣泛研究.無人機進行作業時,有賴于對目標人體姿勢的有效識別.而實現該主動視覺交互功能的基礎是準確操作無人機面向人體,即對人體朝向進行準確估計[1-2].僅僅依靠無人機中的移動相機并不能很好地實現該目標,因為人體可能會進行出乎意料的移動,并且場景范圍廣,環境變化大,如光照、視覺角度等.因此,如何準確估計人體朝向是無人機研究的熱點.

為了克服環境的影響,目前常用的方法為先提取相關低級特征描述符,如尺度不變特征轉換[3]、梯度方向直方圖[4]等表示人體朝向特征,然后利用支持向量機[5]、神經網絡[6]等方法對提取特征進行分類,得到人體朝向標簽.同時一些研究者考慮頭部與身體的關系,將兩者進行有機結合,利用身體形狀的先驗信息提高人體朝向評估性能[7].由于航拍圖像的局限性,容易受外界環境影響,所以僅僅利用低級的視覺外觀特征不足以實現理想的評估結果.

為了獲得魯棒性更好的視覺外觀模型特征,很多研究者對提取的低級特征進行再訓練,然后進行反饋,使得在目標跟蹤過程中可以持續對外觀模型進行更新[8].由于無人機需要針對每個場景中的所有可能人體朝向進行評價,導致數據量很大.

1 算法整體模型

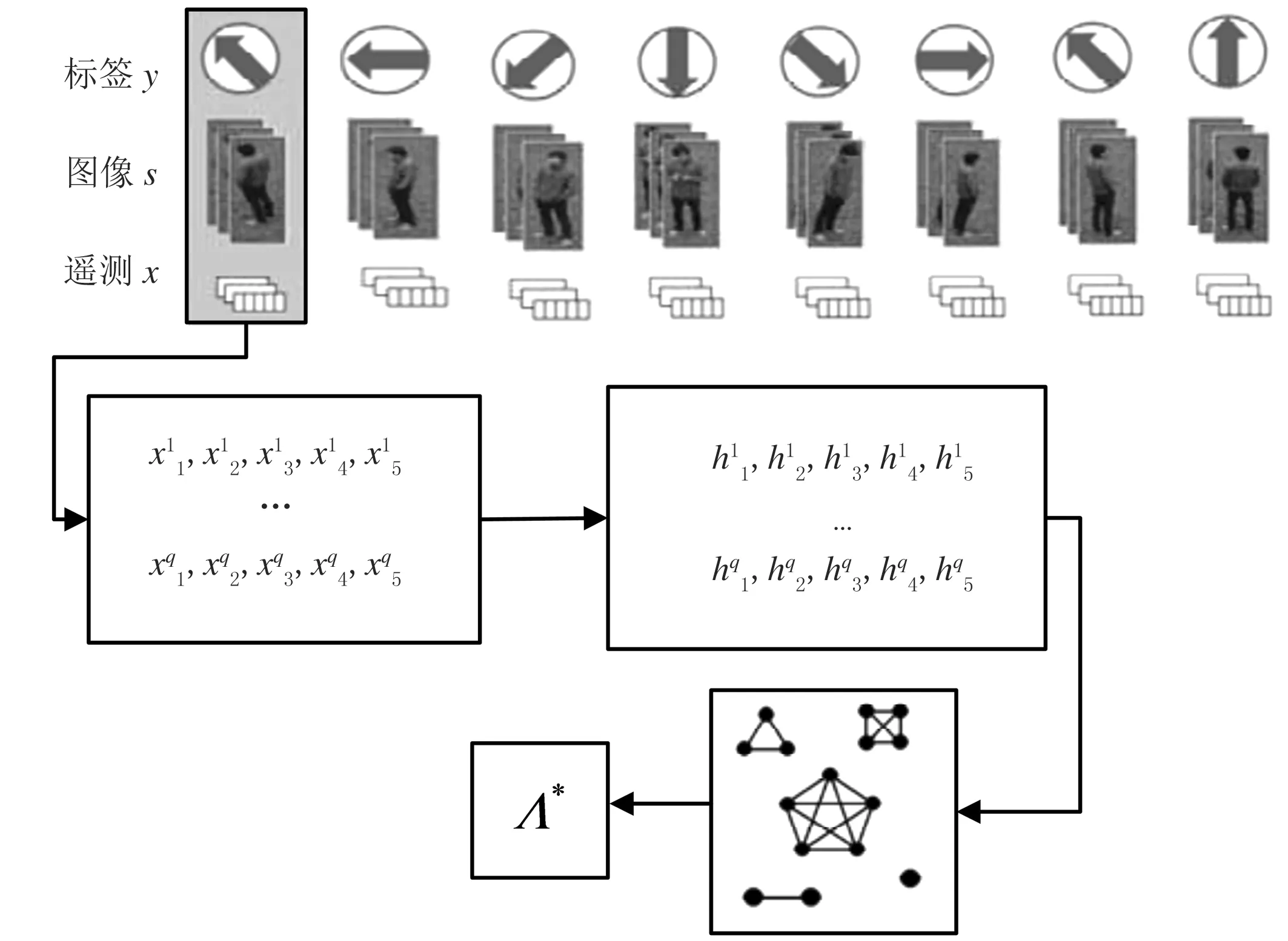

本文將目標人體朝向體位分為8種:后左、左、前左、前、前右、右、后右、后,標簽y和對應的圖像s,其訓練過程如圖1所示.輸入為圖像分塊的集合s,對應已知的表示身體朝向的標簽y∈{y1,...,y8},用遙測數據集x對每個圖像分塊進行標注.訓練具體步驟為:首先為每個標簽采集一組遙測數據集,得到每個傳感器度數的隱性狀態特征,然后使用隱條件隨機域方法選擇重要程度最高的特征,最后輸出參數集Λ*={λ1,...,λ5},其中λn為第n階交互的最優參數.

本文算法的目標是計算測試數據與訓練存儲的外觀視覺模型相關性最大化,如式(1)所示.

(1)

式中μst為已知標簽y的外觀模型;函數N(·)用于對已知模型和圖像分塊的窗口尺寸進行歸一化.在實際應用中,每隔幾幀便會生成視覺外觀模型,這將導致龐大的選擇模型集,計算困難.由于每個模型均對應與其相關聯的遙測數據,所以,模型的選擇可以投影到遙測數據上.對于指定場景觀測到的遙測數據,在訓練集中找到與該場景特征相似度最高的實例.在模型選擇過程中,所有遙測數據特征元素的貢獻并不相同,且對于一個標簽,這些特征元素也不是相互獨立.針對該問題,本文基于隱動態條件隨機域,對遙測數據中的隱相關性進行建模,從而快速實現視覺外觀模型子集的選擇.

圖1 訓練過程示意圖

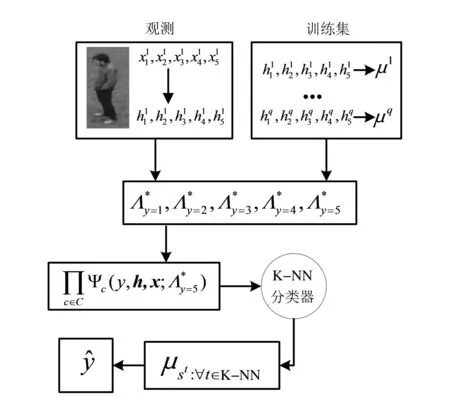

圖2 測試過程流程圖

2 模型選擇

條件隨機域[10](Condition Random Fields,CRF)是對非定向圖形模型中相關性進行編碼的較為簡便的模型.CRF模型的能力依賴于特征函數的數量和質量.本文通過向每個局部觀測xi中添加隱變量hi來提高CRF模型的性能,使可能狀態的范圍顯著縮減.同時,對判別特征函數進行動態選擇,并使用Akaike信息準則[11]對視覺外觀模型進行關聯.

2.1 視覺外觀模型學習

2.2 遙感信息特征提取

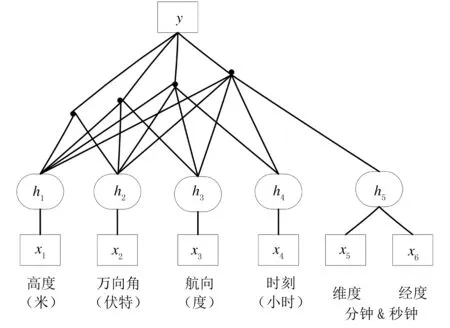

考慮一個圖形模型G= (V,E),其中V是M個節點的集合,每個節點對應于一個特定的遙測測量信息xi;同時定義遙感測量值xi的任意組合為信息組,E是不同信息組之間邊緣的集合.本文研究包括5個傳感器遙感測量信息:高度x1、萬向角x2、時刻x3、磁航向x4和GPS定位x5.5個傳感器信息上的隱性條件隨機域的結構如圖3所示.

圖3 在5個傳感器信息上的隱性條件隨機域結構

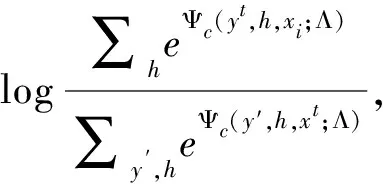

本文目標是對于已知標簽,利用{xi}的交互信息表示任何人體朝向模型,如公式(2)所示.

在現行的多版本教材中,都將“用字母表示數”作為“方程”這一課時的前提知識來編排。從知識結構來講,有其合理性。因為方程中必然涉及未知數的表達和運算,因此,提前學習“用字母表示數”會有助于學生更快掌握方程內容。

(2)

(3)

每個參數θk的值受數據x的稀疏性影響,提高稀疏性可優化條件隨機域結構的表達能力,對于隱馬爾科夫模型[14](Hidden Markov Models,HMM)和動態貝葉斯網絡(Dynamic Bayesian Networks,DBN)[15]的研究說明,增加隱變量的集合可以提高數據稀疏性.

2.3 稀疏性提高

條件隨機域模型的主要優勢在于特征函數的靈活性,隱性狀態的任何可能形態均可用于測量.如果觀測到的信息分布密集,那么特征函數的區分價值就會變小.對于遙感測量數據,每個局部觀測范圍較大,如GPS節點獲得的經緯度信息x5的分辨率小于1米,對如此密集的分布構建關聯模型效率很低.因此,對每個節點xi引入相應隱變量hi,使得hi=Ω(xi),其中映射函數Ω(·)為增加稀疏性的任意映射函數,如聚類等.本文使用一個預定義數量的集群對每個局部測量值進行聚類.定義隱變量集合h={h1,...,hM},其中每個隱變量hi均是對測量值xi的稀疏映射獲得.通過引入隱變量,對公式(2)的標準條件隨機域進行轉變,如公式(4)所示.

(4)

(5)

(6)

(7)

式中,kcn是n個節點交互參數的特征指標集合.相關性分析的主要缺點是條件隨機域模型不易擴展.如果決策邊界過于復雜,區別標簽的有效方法是將問題投影到更高維,該維度考慮到更遠范圍的相關性.下面將對訓練過程中所有可能的特征進行選擇和評價,以獲得高辨識度特征.

2.4 特征選擇

通過使用隱條件隨機域增加測量數據的稀疏性,提高特征描述能力,但并不是所有的特征均同樣重要,所以需要對重要特征進行選擇.本文使用改進的Akaike信息準則,選擇提高數據條件對數似然性的特征,抑制過擬合的特征,Akaike信息準則的定義如公式(8)所示.

(8)

式中,k表示每個相關性范圍所含的參數數量;L表示相應特征函數的似然最大值.Akaike信息準則認為:如果已知隱性條件隨機域模型的真實分布,則能夠利用度量方法準確計算信息丟失情況,如Kullback-Leibler距離.本文在特征選擇之前和之后,利用Akaike信息準則的得分A對相關信息進行度量.

2.5 參數估計

為了最大化條件似然項,在已知第t個訓練樣本的似然項時,本文利用使用BFGS梯度上升方法,如公式(9)所示.

(9)

其中,取Lt(Λ)相對于一元參數的導數,如公式(10)所示.

(10)

3 實驗結果與分析

本實驗的數據來自100次的無人機飛行采集.在每次飛行過程中,無人機在目標人體周圍以八邊形軌跡,采用不同的離地高度、萬向角、磁航向、定位和時刻來飛行.在數據采集時,目標人類定位于一個預定義的八邊形中心,無人機從八邊形各個角落得到目標人體的8個視覺外觀模型.本實驗對遙測數據的特征組合進行評價,并與傳統的條件隨機域和支持向量機方法進行比較.

3.1 特征選擇性能

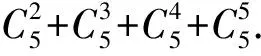

表1 8種朝向標簽的混淆矩陣

3.2 標簽識別性能

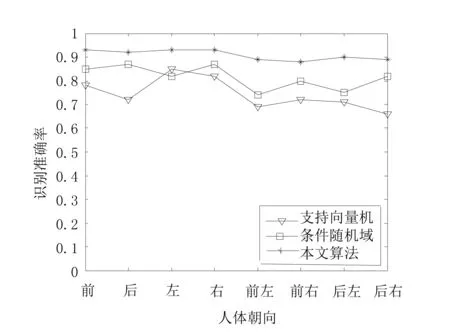

本文的主要目標是使用從場景獲得的非視覺信息對視覺外觀特征進行表征,實質是觀察到的遙測數據和可用的遙測模型之間的匹配,需要利用有效的距離度量方法.為了描述階數更高交互的重要性,將本文隱動態條件隨機域方法與僅使用遙測數據和視覺外觀模型之間的支持向量機方法和條件隨機域方法的識別結果進行比較,具體數據如圖4所示.可以看出,本文方法的性能最好,其剔除了冗余無效甚至會產生負作用的特征,充分利用具有高度辨識性的特征,能夠快速高效選擇正確模型.條件隨機域性能差一些,因為其冗余特征的數量過大,特征分布過于密集,使決策標簽邊界過于復雜.支持向量機表現最差,主要原因是未充分利用決策標簽邊界的高辨識特征.

4 結論

本文提出一種新的無人機識別人體朝向的方法,將非視覺場景特征與8種人體朝向的模型相結合.本文方法能夠對目標人體朝向進行準確估計,然后通過自動操控面向人體正面.該方法利用遙測數據特征間的交互信息,使用隱性動態條件隨機域解決視覺外觀模型分類問題.根據所有特征范圍的相關性,使用Akaike信息準則對交互信息進行評價,并選擇高識別性能特征,提高人體朝向的精度和速度.實驗結果表明,本文方法的人體朝向識別準確率可以到達90%左右.

圖4 不同方法的朝向標簽識別結果