機器人示教縫紉動作的學習方法

王皞燚,王曉華,王文杰

(西安工程大學 電子信息學院,陜西 西安 710048)

0 引 言

隨著機器人技術的發展,人們期望機器人具有更高級的技能[1]。協作機器人可以與工人良好合作,或者機器人真正替代人類完成工作任務[2-3]。

在學習人類技能的過程中,機器人需要依賴傳感器獲取作業環境以及作業工序中的操作信息[4-6]。在機器人技術發展的最初階段,機器人通常僅依靠安裝于末端的力傳感器感受操作信息[7],并采用一定的學習機制自適應地完成作業任務[8]。YIN等應用機械手上力傳感器測量實際力的大小,并根據與模糊邏輯定義的織物期望張力之間的誤差調整控制器參數,使得機械手能夠完成類似場景的縫紉作業[9]。KOUSTOUMPARDIS等設計了基于神經網絡的力控制器,機器人在縫紉過程中對織物施加期望的張力并完成運動動作。該縫紉機器人能夠實現對不同織物的縫制[10]。YOUSEFIZADEH等運用力傳感器將工人縫紉操作時手部產生的力傳遞到機器人末端執行器,并設計力阻抗控制器,實現人與機器人的協同縫紉控制[11]。隨著傳感器技術的發展,YOSHIMI等使用激光傳感器檢測縫紉部件邊緣線,生成期望的縫紉軌跡,機械臂通過軌跡跟蹤實現縫紉[12]。機器視覺技術的發展,給機器人縫紉技能學習帶來了便利[13]:ZACHARIA等基于視覺伺服技術,將視覺反饋和神經網絡與模糊邏輯相結合,使用自適應神經模糊推理系統進行調優,獲得更好的估計[14]。綜合神經網絡的學習能力和遺傳算法的優化能力,可應對縫紉過程中的不確定性、主觀性、模糊性[15-16]。HUANG等采用立體視覺系統,對比理想針位置和實時針的三維點模型,使針驅動器自適應針姿態的變化,機器人自適應地跟蹤針的姿態并實時調整學習的縫紉動作[17]。以上機器人技能學習方法,依靠神經網絡系統控制參數并存儲縫紉先驗知識,使機器人獲得作業技能。但是,這類方法存在著在線修正權值計算量大、權值過度修正,導致系統出現劇烈振蕩以及抗環境擾動滯后等問題[18]。因此,人工智能與深度學習方法逐漸被應用于機器人技能學習領域[19]。徐文霞等運用深度相機采集用戶的姿態信息,通過Kalman濾波方法預測用戶狀態,通過更新Kalman增益參數,機器人獲得預測用戶姿態的學習能力[20]。穆欣偉等采用雙目視覺技術及深度學習目標檢測算法對操作者手部進行識別與定位,建立操作者手部與機器人末端之間距離以及電機速度控制間的映射關系,使得機器人可根據距離自主執行減速、急停等操作的學習能力[21]。

機器人應用視覺傳感器觀察人類縫紉動作,生成示教運動軌跡的精度以及動作或技能特征參數的準確度,是機器人技能學習的首要條件[22]。機器人在動力性和可重復性等方面比人類有很大的優勢[23],機器人學習并跟隨工人的縫紉動作,在提升縫紉機器人自動化程度和節約人力資源方面具有較大的應用價值。本文使用GMM對深度神經網絡獲得的動作軌跡以及時間因素進行編碼,獲得運動基元,運用GMR計算每段運動基元的均值函數和方差函數,將得到的高斯回歸函數混合加權,預測軌跡回歸。通過仿真實驗驗證了本文方法的平穩性和有效性。

1 縫紉動作識別方法

人工縫紉動作中的運動信息由關節運動軌跡體現。如何準確定位工人縫紉動作視頻序列中的肩、肘、腕關節,并獲取關節的運動軌跡,是機器人學習縫紉動作的關鍵。在布料翻轉等動作中,由于工人動作習慣問題,常出現部分上肢或者手部被布料遮擋的情況,關節定位失敗。本文改進了OPENPOSE姿態估計模型,運用標簽融合方法更正關節點標簽,獲得縫紉動作中工人的完整關節信息。

1.1 基于OPENPOSE的關節定位

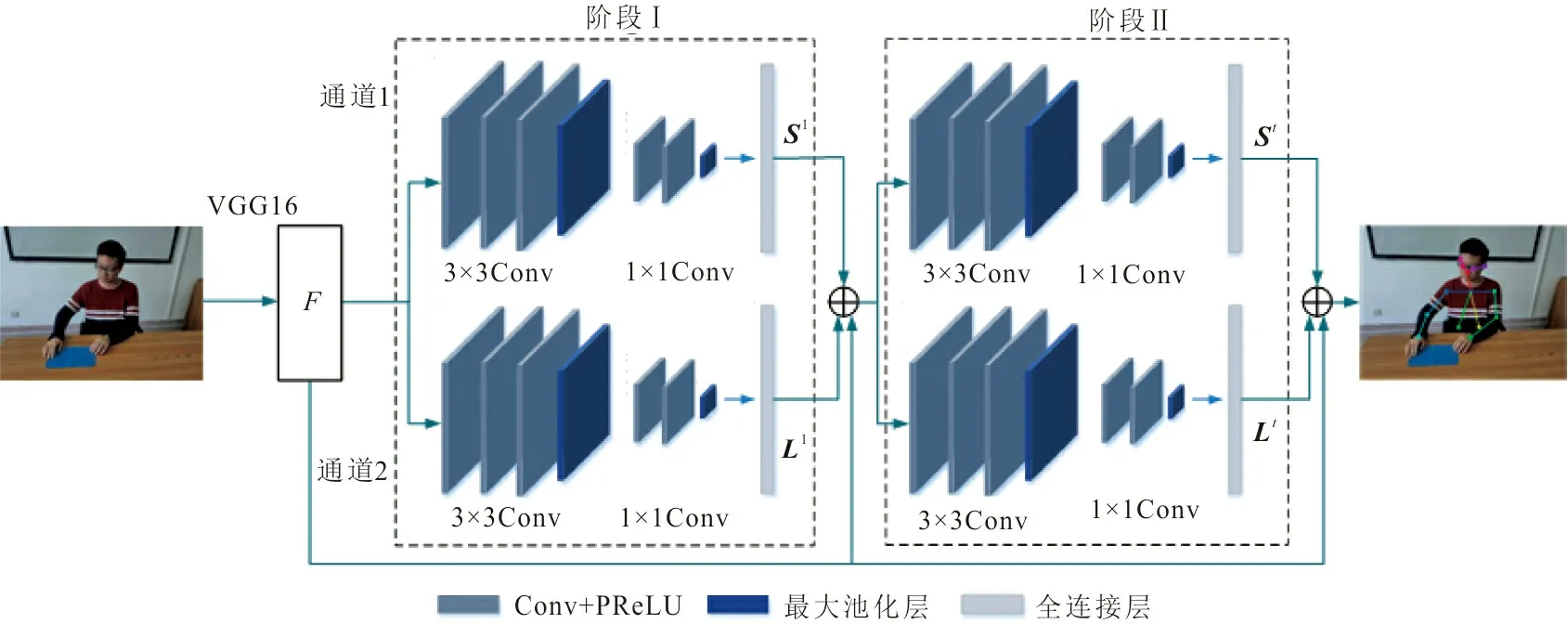

OPENPOSE模型采用了VGG-16深度學習網絡以及雙通道CNN殘差網絡結構,如圖1所示。VGG-16的前10層網絡獲得了動作圖像的原始特征圖F(feature maps),其后連接了多個稱為階段(stage)的子網絡,每個階段的Convolution部分是3個3×3卷積核所組成的殘差網絡結構。在提取深層特征信息和空間紋理信息的同時,也會保留部分淺層信息;其中Max Pooling使用1×1卷積核,使得網絡變得更深以提取更高層特征。實驗證明,6個階段能在避免過擬合的前提下使模型達到最快收斂。每個階段的輸出和特征圖F一起送到下一個階段進行運算,經6個階段之后輸出關節定位結果。

圖 1 姿態特征提取過程Fig.1 Pose feature extraction process

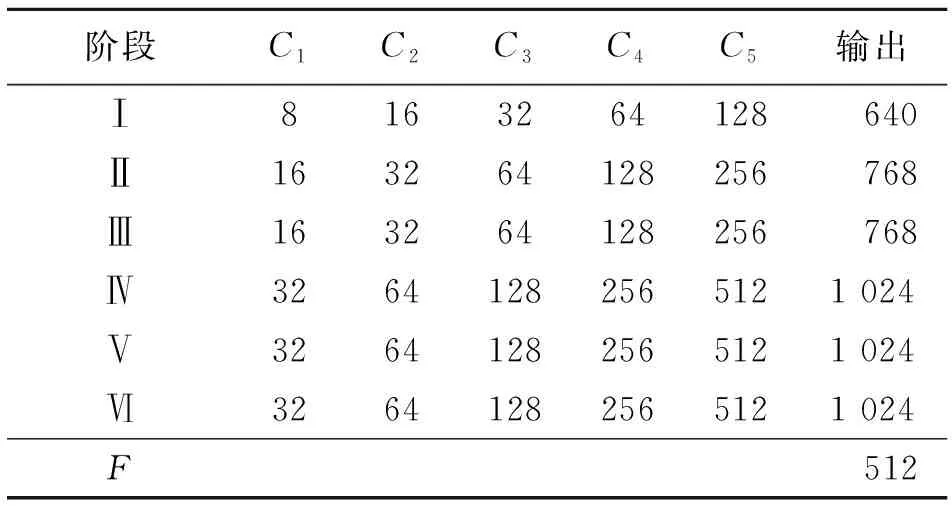

OPENPOSE模型結構卷積核數目如表1所示。表1中,C1~C5代表單個通道CNN中各卷積層的卷積核數目,F代表直接輸出的特征圖部分,Ⅰ~Ⅵ代表雙通道CNN結構的6個階段。

表 1 OPENPOSE模型結構卷積核數目

OPENPOSE模型的2支CNN通道分別預測關節和肢體的位置。通道1預測關節點的位置,該位置用置信度的大小表示。置信度值為像素距離關節點的高斯響應,距離關節點越近的像素,響應值越大。運用非極大值抑制(non-maximum suppression,NMS)算法得到所有高斯響應中的峰值作為該階段網絡輸出,記為S1;通道2預測關節點的親和域。親和域表示肢體位置和肢體上像素的方向,記為L1。若像素點在肢體外,則L1=0; 若像素點在肢體上,xj1、xj2等2點之間的L1=(xj2-xj1)/‖xj2-xj1‖2。

(1)

(2)

1.2 OPENPOSE的改進

(3)

標簽更正后的損失函數為

(4)

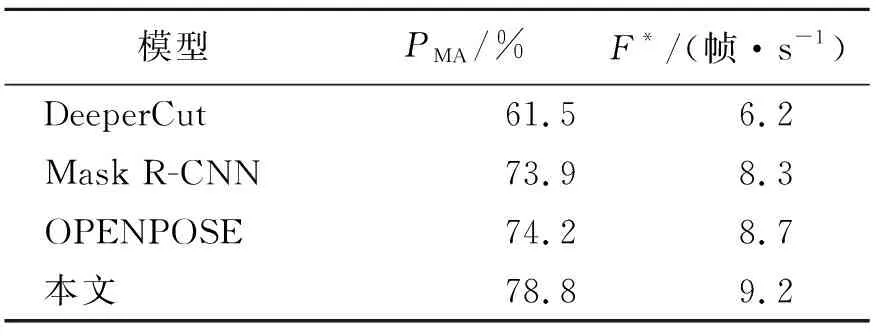

為驗證改進模型的有效性,進行人體動作識別對比實驗。采用COCO人體骨骼框架數據集進行模型訓練,使用平均精度均值PMA作為精度評價指標,表示所有關節點的平均定位精度;使用每秒測試的圖片幀數F*作為時間評價指標。幾種模型對比結果見表2。

表 2 不同模型在COCO人體數據集上的結果對比

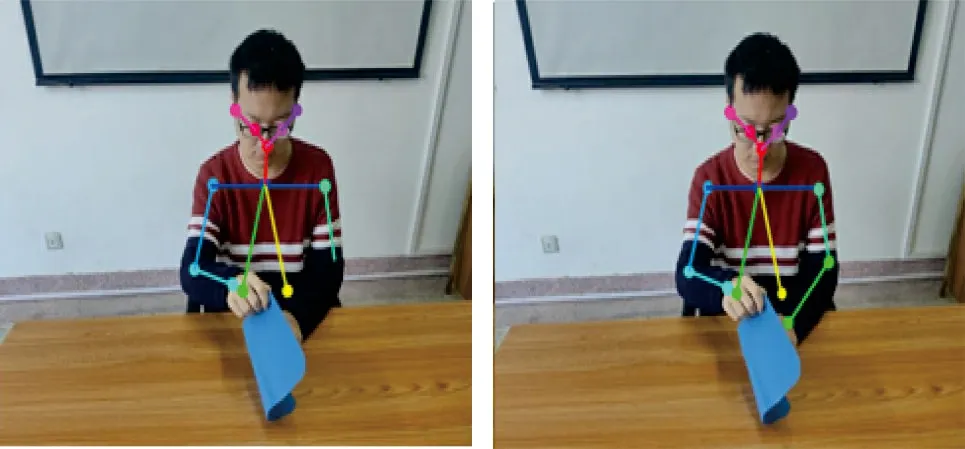

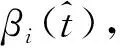

由表2可見:本文方法相對于DeeperCut,在精度上提高了17.3%,F*值提高了3 幀·s-1;與Mask R-CNN相比,在精度上提高了4.9%,F*值提高了0.9 幀·s-1;相較于OPENPOSE,在精度上提高了4.6%,F*值提高了0.5 幀·s-1。圖2為改進前后的人體上肢關節識別結果。

(a) 改進前 (b) 改進后圖 2 改進前后的模型識別效果對比Fig.2 Comparison of the recognition effect of before andimproved models

圖2可以看出:改進后的模型能夠更正關節點標簽,重新定位右手腕關節,并建立與右手肘關節的肢體連接,成功識別人體右側手臂。

2 機器人縫紉動作學習方法

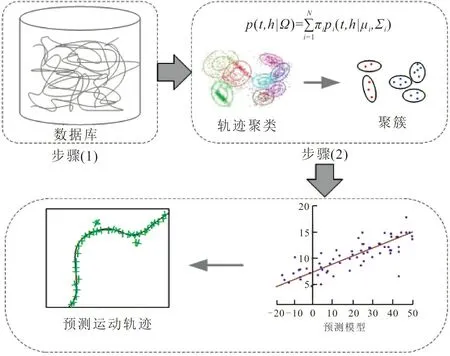

基于GMM-GMR的機器人縫紉動作學習過程如圖3所示。經OPENPOSE模型識別后,以獲得的工人縫紉動作中上肢關節的坐標值作為訓練樣本,對訓練樣本進行節點聚類。采用GMM對時間因子和聚類節點進行混合編碼,運用期望最大化算法求得聚類模型參數,使其基于歷史數據模型概率達到最大化,得到代表高斯分量的聚簇,每一個聚簇代表一個關節。運用GMR對關節訓練得到動作預測,根據預測誤差不斷更新模型的條件期望值和方差,期望值和方差即成為動作學習的參數。

圖 3 縫紉動作學習過程Fig.3 Sewing action learning process

2.1 GMM縫紉動作軌跡混合編碼

為使機器人同時學習到關節運動信息和對應的時間信息,采用GMM對獲取的縫紉動作軌跡進行混合編碼。工人上肢縫紉動作包含肩、肘、腕等3個關節的運動軌跡信息。使用相同時間段t(t=1 000 ms)將每個關節的運動軌跡分割成數段運動基元,每段運動基元均表示一個關節縫紉運動的子過程。建立GMM模型Ω對每一段運動基元進行混合編碼,每個基元以7個維度表示:一維的時間戳t和六維的機器人的關節姿態h={x,y,z,α,β,θ}。根據不同軌跡概率的比較確定預測軌跡,運用GMM建立n個高斯分量的聯合分布概率密度函數,每個高斯分量均代表一段編碼的運動基元,即

(5)

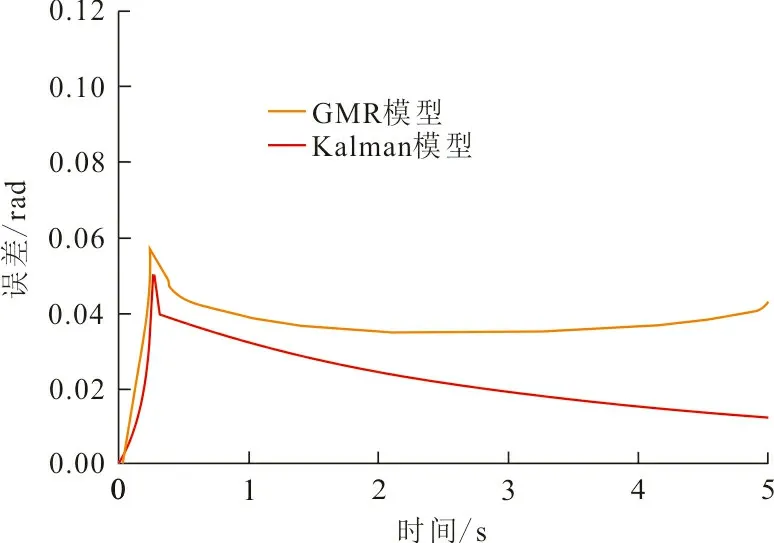

式中:t、h分別為模型Ω中運動基元的時間戳和關節姿態;πi、pi、μi和Σi分別為第i個高斯分量的先驗值、條件概率密度、均值和協方差。

首先運用概率密度函數對縫紉動作軌跡數據進行建模,通過GMM對訓練軌跡數據進行聚類分析。為提升算法收斂速度,使用K-means算法進行GMM初始化。采用期望最大化算法迭代計算至收斂,估計概率密度函數中的各參數;根據符合正態分布數據的條件分布,得到n個高斯分量的回歸函數,用于GMR軌跡預測學習。

2.2 GMR縫紉動作軌跡預測學習

運用GMR計算每段運動基元的均值函數和方差函數,將得到的n個高斯回歸函數混合加權,進行軌跡回歸預測。通過更新學習軌跡參數中的條件期望值和方差,學習縫紉動作的軌跡信息,生成機器人的跟隨動作的運動軌跡。

(6)

式中:

(7)

(8)

(9)

(10)

3 實驗結果及分析

為了驗證本文方法中機器人對縫紉動作的學習效果,由實驗者做出示教縫紉動作,運用工業相機進行樣本采集,提取上肢運動的樣本信息進行軌跡學習的仿真實驗,說明本文方法的可行性和學習效果。通過軌跡跟蹤仿真實驗,驗證本文方法的平穩性和推廣應用價值,并與Kalman軌跡預測方法的跟蹤誤差對比,驗證本文方法的有效性。

3.1 縫紉動作識別實驗

縫紉過程中常有 “移動布料”、“對齊布料”、“翻轉布料” 等動作,實驗者據此進行了3組示教縫紉動作演示。布料尺寸為260 mm×160 mm,六自由度機器人的工作半徑為850 mm,符合機器人的工作空間范圍。運用改進的OPENPOSE模型對示教縫紉動作進行姿態識別,圖4(a)、(b)、(c)分別為3組示教縫紉動作的識別結果。識別成功后,記錄每一個動作中人體右臂的肩、肘、腕關節的坐標變化,分別得到每個關節對應的縫紉軌跡,作為機器人學習的軌跡樣本。

(a) 移動布料

3.2 縫紉動作學習仿真實驗

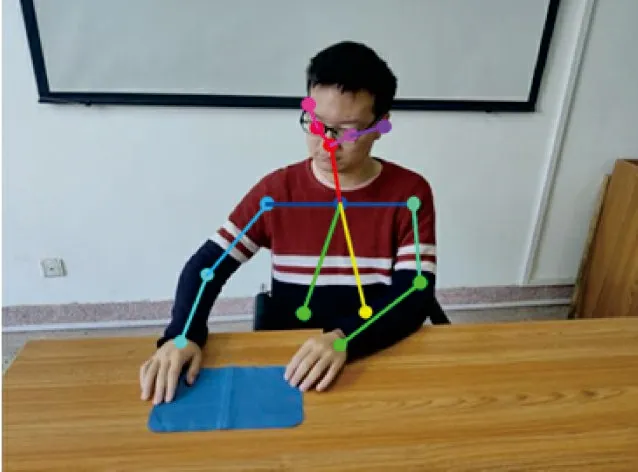

OPENPOSE模型識別完成后,記錄縫紉動作中右臂關節對應的坐標變化,分別得到人體右臂的腕關節、肘關節、肩關節的運動軌跡。縫紉動作軌跡如圖5所示。

(a) 移動布料

圖5中,綠色、紅色、藍色曲線分別代表腕關節、肘關節、肩關節的運動軌跡,A、B、C和A′、B′、C′點分別為腕關節、肘關節、肩關節的起始位置和終止位置。從圖5可見:移動布料時,右臂的3個關節運動幅度均比較小;對齊布料時,腕關節在垂直方向的運動幅度明顯增大;翻轉布料過程中,3個關節在垂直方向的運動幅度均較大。符合現實中人體運動學特征。

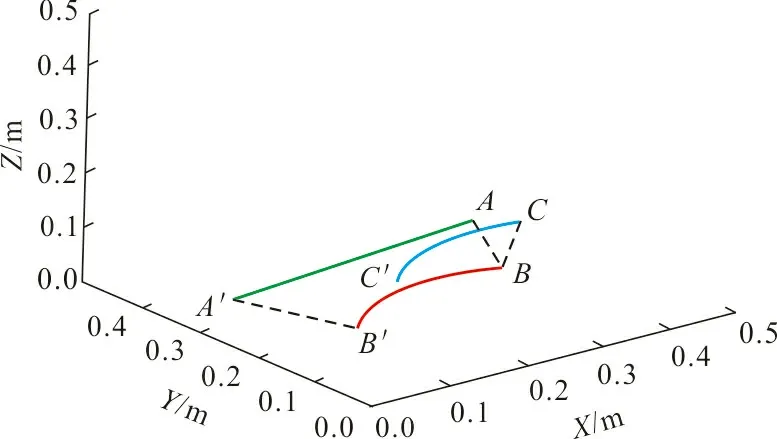

運用GMM編碼-GMR動作軌跡學習方法對每一條完整軌跡進行編碼學習,得到的軌跡二維投影,如圖6所示。圖6中每一條二維曲線均代表圖5中一個關節運動軌跡的學習結果:圖6(a)對應“移動布料”中的肩關節運動軌跡,即圖5(a)中的藍色軌跡;圖6(b)對應“對齊布料”中的腕關節運動軌跡,即圖5(b)中的綠色軌跡;圖6(c)對應“翻轉布料”中的肘關節運動軌跡,即圖5(c)中的紅色軌跡。

(a) 移動布料

3.3 軌跡跟蹤仿真實驗

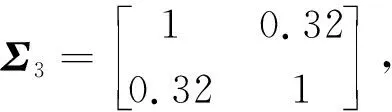

以“移動布料”中右臂的3個關節的運動軌跡為示例,在Simulink中搭建六自由度機器人的仿真模型,并進行機器人軌跡跟蹤的仿真實驗。經改進OPENPOSE模型識別獲取關節點的二維像素坐標,通過視覺標定建立三維坐標映射模型,得到像素坐標系到機器人基座坐標系的轉換關系,運用轉換矩陣計算實現關節像素坐標到機器人三維坐標的映射,即得到機器人工作空間中的位置數據。將該位置數據組成的縫紉軌跡作為學習樣本,通過GMM-GMR方法預測學習,得到樣本縫紉軌跡的學習結果。將學習得到的位置數據轉換成關節空間角度信息,分別將右臂的肩關節、肘關節、腕關節的空間角度信息輸入到Simulink中機器人仿真模型的關節2、3、4中,機器人根據輸入角度運動至期望位置,實現機器人對示教縫紉軌跡的跟蹤。圖7為軌跡跟蹤過程中機器人對應的關節力矩變化曲線,該曲線由Simulink仿真環境中的編碼器采集。

由圖7可見,機器人的2、3、4關節力矩曲線在軌跡跟蹤開始時均有較大幅度的波動。原因是機器人由靜止進入運動狀態的瞬間,慣性作用使機器人關節產生輕微的抖動。在0.5 s之內,各關節的力矩曲線均趨于平穩,說明機器人關節根據期望角度可以平穩地運動,證明了本文方法的平穩性。從關節力矩變化曲線可以得出,應用本文方法能實現機器人連續平穩地進行縫紉跟隨運動,在節約人力資源方面具有一定的推廣應用價值。

圖 7 關節力矩變化Fig.7 Curve of joint torque change

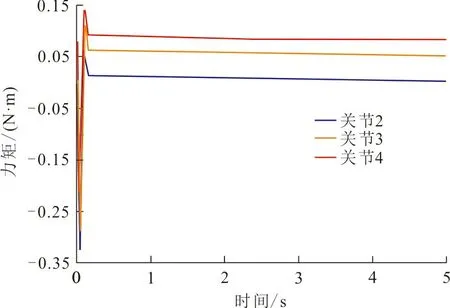

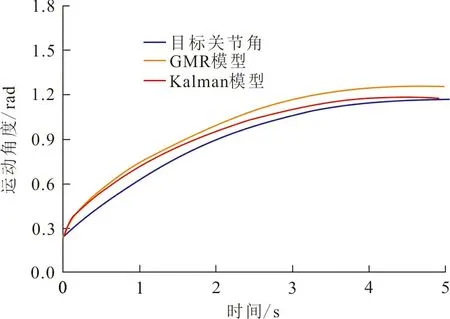

為進一步驗證本文方法的有效性,將本文方法與Kalman預測方法進行軌跡跟蹤仿真實驗對比。運用Kalman方法預測軌跡插值過程中的關節角度數據,根據當前的關節角預測下一步的關節角,并根據每一步關節角的預測值和測量值求出最優值,從而生成目標關節角的變化曲線。圖8為機器人運動跟蹤過程中,關節2、3、4的軌跡跟蹤曲線,圖9為對應的誤差曲線。從圖8、9可以看出,與Kalman模型相比,GMR模型軌跡跟蹤誤差更小。

(a) 關節2

(a) 關節2

由關節2、3、4的軌跡跟蹤曲線及誤差跟蹤曲線可見,機器人在運動的初始階段關節會產生約0.052~0.087 rad的誤差。原因是機器人從靜止狀態進入運動狀態的瞬間,運動的關節會產生較大幅度的抖動從而對軌跡跟蹤造成干擾。對比各關節中Kalman模型和GMR模型的誤差跟蹤曲線,2 s后Kalman模型的跟蹤誤差明顯增大。原因是Kalman模型對短時間內的預測有比較穩定的判斷,無法有效處理長時間的有噪聲軌跡數據。GMR模型的跟蹤誤差隨時間的增長呈下降趨勢,且其準確性高于Kalman模型。在關節2、3、4的跟蹤誤差曲線中,對比GMR模型與Kalman模型在0~1 s內的誤差變化,可以看出GMR模型可以在更短時間內降低跟蹤誤差,這是因為GMR模型加入了時間變量,考慮了機器人隨時間運動的連續性。對比誤差跟蹤曲線可以看出GMR模型的準確性和可靠性均優于Kalman模型,證明了本文所提出的方法具有更好的實時性與學習能力。

4 結 語

本文提出了一種基于GMM-GMR的機器人縫紉動作學習方法。通過搭建并改進OPENPOSE模型,對上肢縫紉動作進行了有效識別。將上肢動作的各關節軌跡信息,映射到機器人各關節,采用GMM對縫紉運動軌跡進行混合編碼,通過GMR方法進行參數學習,進而生成機器人關節的跟隨運動軌跡。經機器人縫紉動作識別學習實驗、縫紉動作學習仿真實驗和Kalman方法軌跡跟蹤對比仿真實驗,結果驗證了本文提出的方法能夠有效地實現對人體上肢縫紉動作的跟蹤,證明了本文方法的平穩性,且其運動精度可靠性、準確性均優于卡爾曼法,具有一定的推廣應用價值。