PS-DenseNet下的代數模型遙感圖像場景分類研究

陳 垚,張明波

(1.廣安職業(yè)技術學院,四川 廣安 638000;2.江西財經大學統(tǒng)計學院,江西 南充 330000)

1 引 言

伴隨遙感科技的飛速發(fā)展,遙感圖像[1]逐步成為軍事目標監(jiān)測、土地規(guī)劃和環(huán)境分析等諸多領域的重要依據。海量的遙感圖像所包含的數據亟待被識別和解析,而遙感圖像場景分類可直觀地表達圖像,其準確度直接影響后續(xù)場景解譯質量以及相關目標物的獲取。遙感圖像場景不止涵蓋了形態(tài)、顏色與紋理等數據,還囊括了眾多語義層數據,使得自動分類的難度大大增加。

現(xiàn)有的很多遙感圖像場景分類方法往往基于圖像的底層特征[2],如:紋理、邊緣、顏色等,根據工程應用場景的不同,針對性地采用人工特征獲取的方式,因此,所獲得的場景分類方法適應性與魯棒性不佳。

伴隨神經網絡和機器學習方法的深度發(fā)展,神經網絡逐步成為機器視覺領域強有力的技術之一,不少科研者嘗試將其運用在遙感圖像場景分類的領域中,獲得了良好的效果。Rajendran[3]采用Alexnet完成遙感圖像場景分類,該方法巧妙地訓練了淺層神經網絡,能夠迅速完成分類,但準確度有待提升;Liu[4]提出將VGG-19網絡設計在場景分類的線性變換部分,該方法的分類準確度得到提升,但不能滿足遙感圖像場景中的復雜空間與局部架構數據間的關聯(lián);Yan[5]選用集合子網絡的Googlenet,該方法在完成場景分類任務時能分別處理低復雜度與高復雜度遙感圖像,但主網絡與輔助分支網絡的結合度不佳,需要大量的訓練圖像集;Zhu[6]結合Resnet的思想并結合深淺層CNN實現(xiàn)多復雜度的遙感圖像分類,但該方法的網絡結構復雜,層數較深帶來分類效率低的問題;吳晨[7]結合卷積特征與稀疏編碼的方式,獲得初始特征圖,并在自動編碼裝置中完成分類,該方法能實現(xiàn)簡單遙感場景的分類,復雜場景效果差。

實現(xiàn)遙感圖像的場景分類在于獲取充分的遙感圖像特征,本文采用Lie group代數模型和PS-DenseNet分別提取遙感圖像的底層特征和高層特征,并在交叉熵損失模型的基礎上完成改進,可針對易和難分類的樣本分別削弱和增強權值,從而加強難分類樣本的重視度。

2 Lie group代數模型與Densenet網絡分析

2.1 Lie group代數模型分析

大多數工程問題均可轉換為數學模型的分析,因此可用代數方法輔助解決。為提升遙感圖像的分類準確性,可引入Lie group代數模型[8]可獲取底層特征并降低特征維度。Lie group代數模型可表述無窮小變換的代數架構,存在特殊的線性結構,可構建在Lie group胞元處的切集。將Lie代數元a轉換為相應的Lie group胞元陣A可實現(xiàn)很多非線性[9]到線性[10]間的變化,并可表示為指數模型exp:k→K與對數模型:LOG。

(1)

將Lie group胞元A轉換到相應的胞元空間M的映射為LOG:

(2)

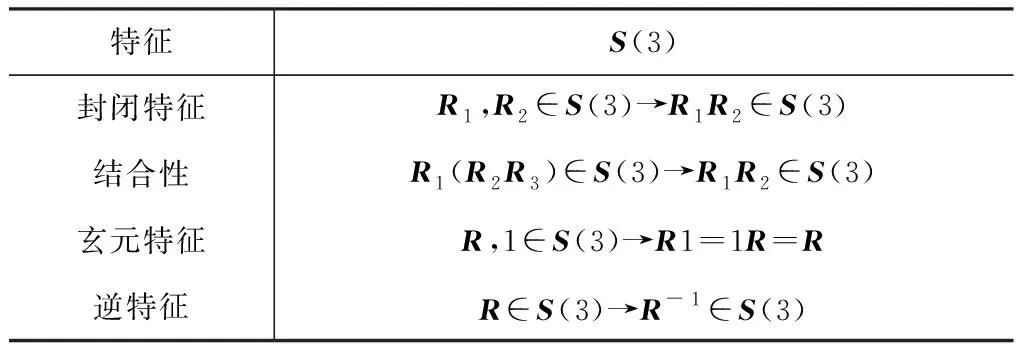

由于矩陣[11]是圖像的數據或特征表述的集合,而在機器視覺中常見的矩陣群(協(xié)方差矩陣、旋轉陣和仿射陣等)均具有Lie group代數模型的相關性質。針對Lie group矩陣S(3),該矩陣包含單個集合與二元計算,此模型應具備四個特征:封閉特征、結合性、玄元特征與逆特征。令正交約束RRT=1,detR=1,R1,R2,R3∈S(3),表1給出Lie group矩陣的相關性質。

表1 Lie group矩陣的相關性質

2.2 Densenet網絡分析

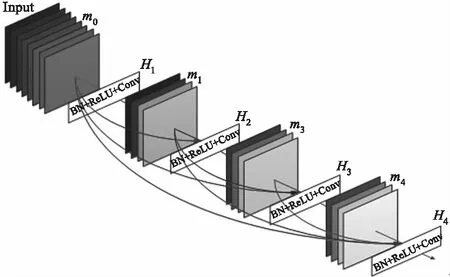

Densenet[12](密集連接深度網絡)是基于Resnet[13](殘差網絡)的優(yōu)化。Densenet應用跨層銜接模式獲取參數訓練過程中不同層的特征圖,并將Alexnet、VGGnet、Resnet等傳統(tǒng)網絡中未充分應用的特征加載入新層中,從而實現(xiàn)了中底層優(yōu)化信息的效應,實現(xiàn)獲取樣本特征的功能。此外,采用密集連接模式能增強層間的數據流動性,提升網絡功能,削減網絡參量。密集連接架構如圖1所示。Densenet可將全部網絡層所輸出的特征用作當前網絡層的輸入,即m0,m1,…,mi-1,根據復合解析式Hi可獲得輸入mi,如公式(3)所示:

mi=Hi([m0,m1,…,mi-1])

(3)

復合解析式Hi可視為通過BN(批處理),ReLU激活函數與卷積處理連續(xù)操作的Dense Block架構。

圖1 密集連接架構

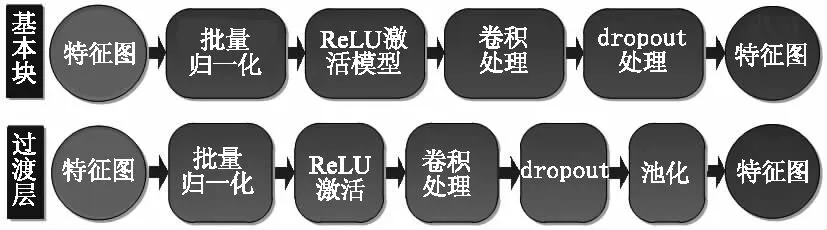

Densenet是由dense block架構和transition層組成,從圖1中可知,在Densenet中任意層與后繼層間的銜接均為密集連接,dense block作為基本塊能夠削弱梯度彌散作用的同時加強特征傳送,而過度層則位于dense block間,可削弱密集塊所輸出的通道數,從而提升效率,如圖2所示為dense block和transition層的結構。

圖2 Dense block和transition層的結構

3 DenseNet下的代數模型遙感圖像場景分類

3.1 遙感圖像場景特征提取和融合

由于遙感圖像中所包含的地物數據多樣、空間布置復雜性高,因此,實現(xiàn)遙感圖像的場景分類不僅在于獲取充分的遙感圖像特征,而且應完成遙感圖像特征的準確表述。

3.1.1 Lie group代數模型提取底層特征

遙感圖像底層特征涉及到紋理、形狀、亮度、顏色和對比度等特征,而上述特征均可用代數模型表述相應的特征概念。將上述底層特征的Lie group代數模型相結合可構成矩陣模式,從而將遙感圖像的各像素點結合為數據量豐富的向量模式,采用Lie group代數模型提取底層特征不僅維度較小而且能在圖像分類中激發(fā)出較好的效能。Lie group作為微分流形,能實現(xiàn)遙感圖像幾何特征的有效表述,而矩陣模式與傳統(tǒng)矢量空間存在差別,具有更多的特征數據。基于此,本文選用正定對稱矩陣模式表述遙感圖像。

將遙感圖像Y表達為u×v,采用(p,q)代表像素點,式中的p=0,1,…,u-1,q=0,1,…,v-1,則各像素能采用Y(p,q)表達,可將遙感圖像特征K表述為公式(4):

K(p,q)=λ(Y,p,q)

(4)

(5)

(6)

(7)

(8)

(9)

(10)

式中,Y(p,q)是像素點(p,q)的像素值;?Y(p,q)/?p是像素點(p,q)的p方向一階梯度;?2Y(p,q)/?2p是像素點(p,q)的p方向二階梯度;

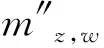

3.1.2 PS-DenseNet下提取高層特征

通過深度網絡模型可訓練海量遙感圖像樣本特征,使模型具備較強的自學習功能,從而自動獲取豐富的圖像特征。Densenet網絡模型具備優(yōu)秀的學習效力,結合卷積層、池化層與全連接層可提取遙感圖像的抽象特征,從而表達高層深度特征,不僅能直接將其完成分類,也可將其用于后續(xù)處理。Densenet模型由四個dense層構成,各個Dense層均有多個Dense block構成。為優(yōu)化Densenet各卷積層的輸入僅為前端卷積層的簡單組合,并考量特征通道間的聯(lián)系程度,本文在Densenet40的基礎上添加PS“Press and Stimulate”模塊,如圖3給出。各卷積層的結果特征圖通過“加壓”處理(LPS(·)),由空間維度完成相應的特征壓縮,可把各通道的二維特征圖轉換成實數,則第z層的第w個特征圖Mz,w加壓進程如公式(11)所示:

(11)

式(11)中的K與G分別代表特征圖的寬度與高度;“激發(fā)”處理(LST(·))則包含兩組全連接層,對各通道特征賦予權值,其激發(fā)進程如公式(12)所示:

=λ(β2η(β1))

(12)

(13)

圖3 PS-DenseNet下的高層特征提取

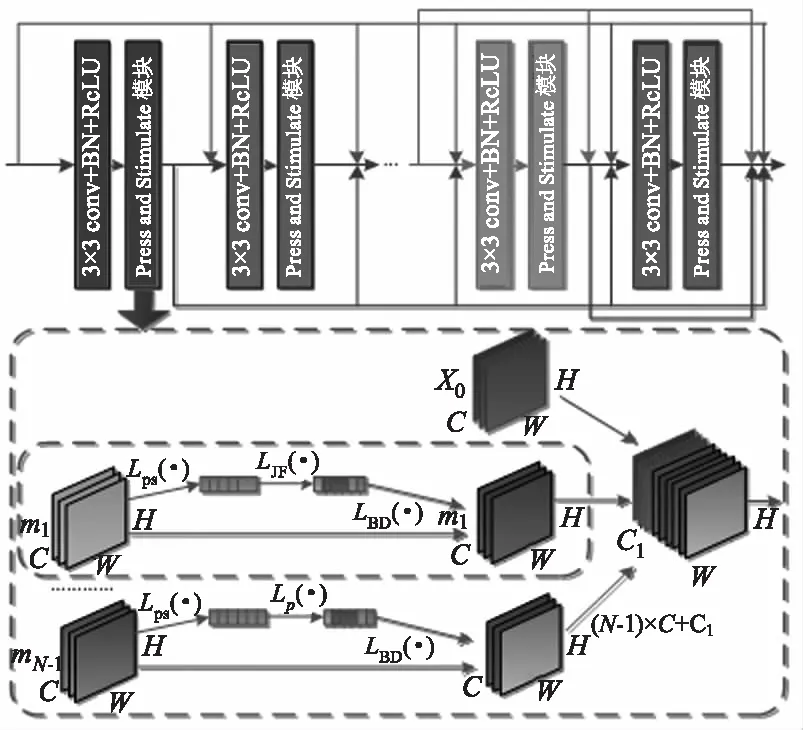

3.1.3 特征融合模塊

如圖4所示,特征融合[15]部分利用標準卷積完成底層特征的處理,得到輸出特征圖Ma;串行標準卷積和深度卷積處理高層特征,獲得輸出特征圖Mb,進而將Ma與Mb相融合,獲得融合特征圖Mc。

圖4 特征融合模塊

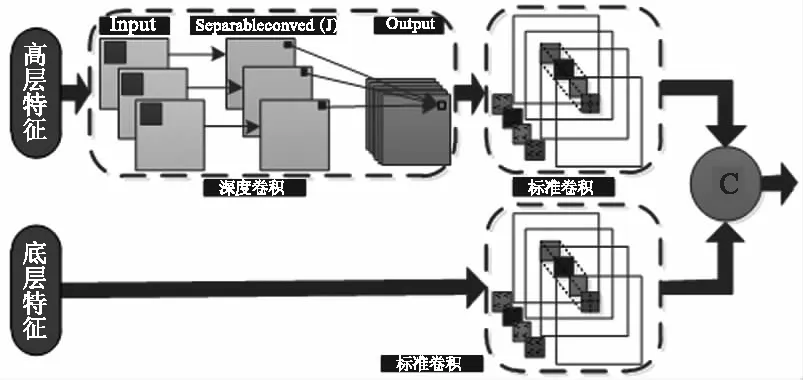

3.2 分類模塊

分類模塊采用softmax模型,如圖5所示,將上層的節(jié)點與全連接層的神經元銜接,整合底層與高層特征圖,從而將二維特征圖變換成一維的特征參量,該特征參量能夠表現(xiàn)成圖像的全局數據,從而完成圖像分類,其數學模型如公式(14)所示:

ml=f(ulml-1+bl)

(14)

其中,ul是全連接層的權值;bl是全連接層偏置參量;ml-1是前層的輸出特征圖。采用Sigmoid為全連接層的激活解析式,最后連接softmax解析式,從而預測各類的概率,其模型為公式(15):

(15)

其中,θ=(θ0,θ1,…,θN-1)為待優(yōu)化參量;y(i)為第i個特征樣本標簽;m(i)為第i個樣本;N為N個不同的標簽類;d(m(i))為第i個樣本的輸出結果,采用歸一化方法完成處理,可得概率和值為1。

圖5 Softmax分類模型

3.3 參數訓練

在深度學習的過程中,科學的代價函數選擇能夠在不斷調整參數的過程中優(yōu)化網絡模型,從而使所設計的深度學習網絡能夠完成較為精準的遙感圖像場景分類。本文采用焦點損失函數完成參數學習,該模型是在交叉熵損失模型(如公式(16))基礎上的改進,如公式(17)所示:

LJC=-alna′-(1-a)ln(1-a′)

(16)

其中,a∈[0,1]為真實值;a′為預測值。

LJD(ητ)=α(1-ητ)puln(ητ)

(17)

式中,α(1-ητ)pu代表交叉熵損失模型相應的權值;ητ是特征值相應的τ類預判機率;pu是相應的懲罰項;α值介于0與1間,代表權重參量,可平衡易與難分類的重要度,根據經驗可知;pu為2,α值為0.6。

本文所選用的焦點代價函數可對易和難分類的樣本分別削弱和增強權值,從而完成加強難分類樣本的重視度。

4 對比實驗分析

4.1 實驗數據集和設置

為校驗本文方法的有效性,采用兩類數據集完成驗證,所選取的數據集包含UC Merced Land Use與SIRI WHU完成校驗。

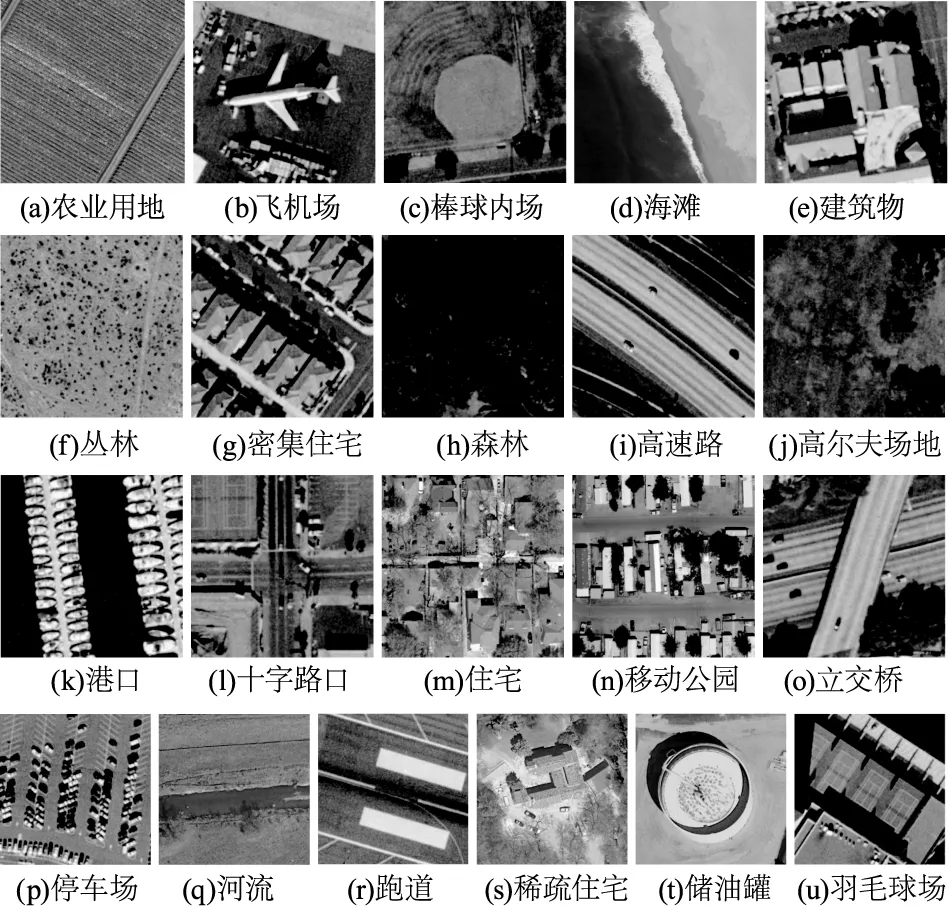

UC Merced Land Use(UCMLU)集生成于USGS的城市地圖,共包含21類所獲取的遙感正射圖像場景,各類場景由100張256×256的圖像構成,其空間分辨率均為0.3 m。此數據集包含若干個相似度和重疊度較高的場景、空間模式豐富,使得數據集更具完善性與挑戰(zhàn)性。圖6為每類場景的圖像示例,本文隨機選取各類圖像中的70張用作訓練樣本,30張用作測試樣本。

圖6 UCMLU遙感圖像集

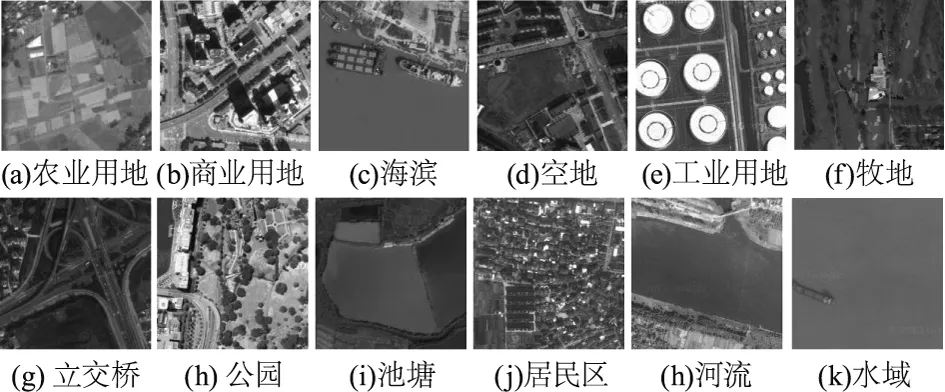

SIRI WHU集生成于谷歌地球,共包含12類遙感圖像場景,各類場景由200張200×200的圖像構成,其空間分辨率均為2 m。此數據集存在更豐富的視角狀態(tài)、光照情況與空間布局等因素,帶來場景內圖像差別大和場景間圖像差別小的狀況,對所提遙感圖像場景分類方法帶來了挑戰(zhàn)。圖7為每類場景的圖像示例,本文隨機選取各類圖像中的150張用作訓練樣本,50張用作測試樣本。

圖7 SIRI WHU遙感圖像集

本文的實驗環(huán)境為Intel I7-10700KF 主頻為3.7GHz的8核16線程CPU處理器,MX350顯卡,采用Iris Plus核顯,8GB運行內存,在windows 10系統(tǒng)中,加載Matlab 2020a完成本文方法的實驗仿真和與現(xiàn)有的優(yōu)秀分類方法[5-6]的準確度對比。

4.2 遙感圖像分類指標

4.2.1 指標解析

為校驗本文方法的遙感圖像場景的分類準確度,給出本文方法的混淆陣列及三種方法在UCMLU與SIRI WHU數據集下的整體與平均分類的精準度(Overall Classification Accuracy,OCA)和Kappa參數,從數據出發(fā),以客觀指標的角度完成本文方法分類準確度的綜合評判。

整體分類精準度代表某數據集中全部實現(xiàn)正確分類的遙感圖像數目與所驗證的全部圖像數的比例,如公式(18)給出。公式中的RC和OP分別為某數據集某一類中被正確分類的樣本數目和某一類中總體的樣本數目,J為某數據集的樣本類別數。

(18)

(19)

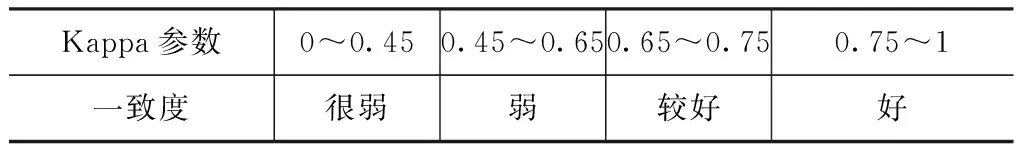

表2所示為Kappa參數與分類一致度的關聯(lián)。

表2 Kappa參數與分類一致度的關聯(lián)

4.2.2 實驗結果

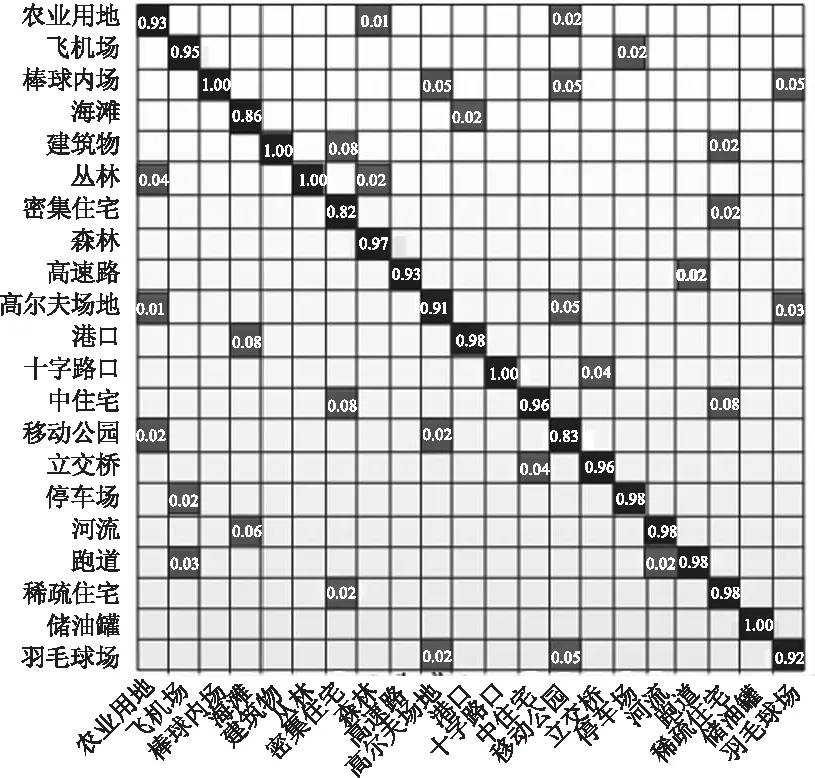

圖8給出本文方法在UCMLU數據集下的混淆矩陣,在該陣列中,每行的信息代表相同場景的樣本被預判成每個類別的比例,圖中的空白部分標示成0,斜對角的信息則代表各類場景能夠被正確預判的比率。從圖中可知,采用本文方法能夠得到較高的分類精準度,各類的分類精準度均高于0.8,并且棒球內場、建筑物、叢林、十字路口和儲油罐的分類精準度均達到1,而且稀疏型、中等和密集型住宅區(qū)等場景存在相似度高、密集度低的特點,本文方法均取得了較好的分類效果。

圖8 本文方法在UCMLU數據集下的混淆矩陣

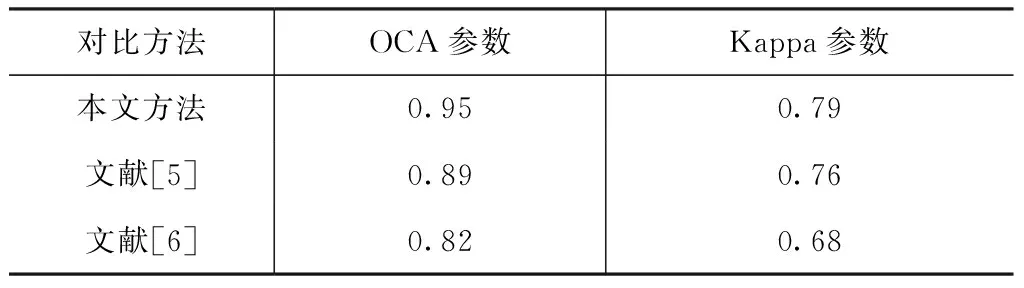

表3給出本文方法與方法[5]、[6]方法的指標對比,在UCMLU數據集中完成驗證。實驗結果表明,本文方法的OCA參數和Kappa參數均優(yōu)于其他兩種方法,這是由于文獻[5]方法的主網絡與輔助分支網絡的結合度不佳,帶來算法分類精準度欠佳的問題;文獻[6]方法結合Resnet的思想并結合深淺層CNN實現(xiàn)多復雜度的遙感圖像分類,但該方法的網絡結構復雜,層數較深易帶來分類效率低的問題。

表3 UCMLU數據集中的本文方法與文獻[5]、[6]方法的指標對比

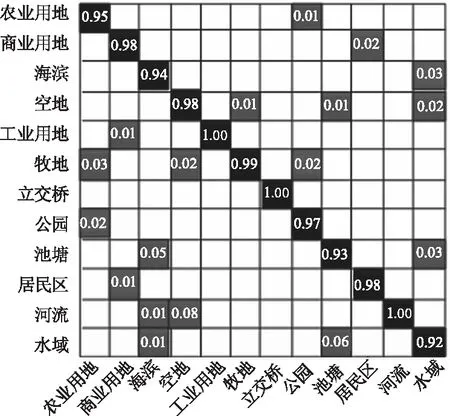

圖9給出本文方法在SIRI WHU數據集下的混淆矩陣,在該陣列中,每行的信息代表相同場景的樣本被預判成每個類別的比例,圖中的空白部分標示成0,斜對角的信息則代表各類場景能夠被正確預判的比率。從圖中可知,采用本文方法能夠得到較高的分類精準度,各類的分類精準度均高于0.9,并且工業(yè)用地、立交橋和河流的分類精準度均達到1,相對于UCMLU數據集由于場景類別數目偏少,使得整體精度得到提升。但一些遙感場景間存在相似性很難區(qū)分,例如水域邊由于植物、石頭等物體的覆蓋易被識別為池塘。

圖9 本文方法在SIRI WHU數據集下的混淆矩陣

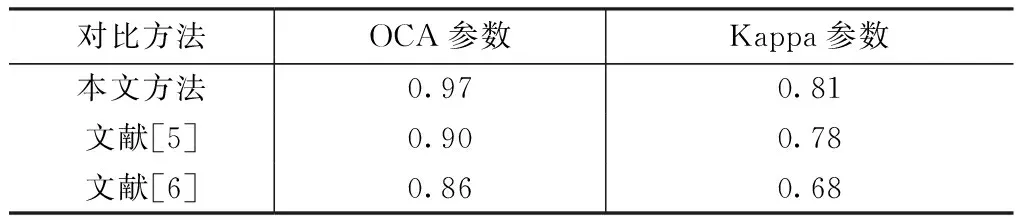

表4給出本文方法與文獻[5]、[6]方法的指標對比,在SIRI WHU數據集中完成驗證。實驗結果表明,本文方法的OCA參數和Kappa參數均優(yōu)于其他兩種方法,這是由于文獻[5]方法難以實驗遙感圖像場景被遮掩后不易辨別的狀況,該方法預測的適應性有限;文獻[6]方法由于自身泛化能力有待增強,適應變化場景的能力有待提升。

表4 UCMLU數據集中的本文方法與文獻[5]、[6]方法的指標對比

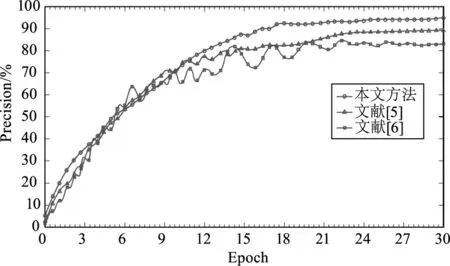

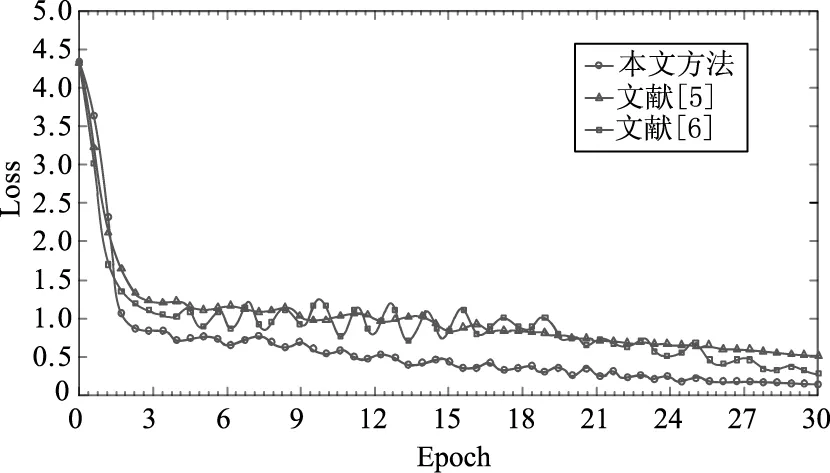

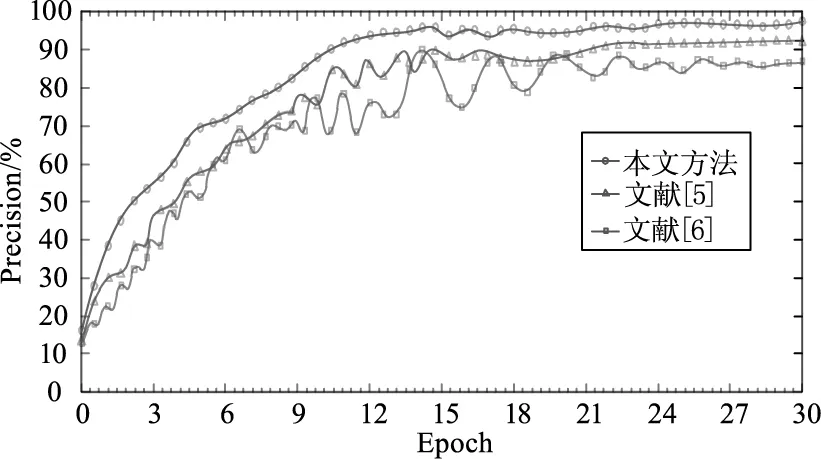

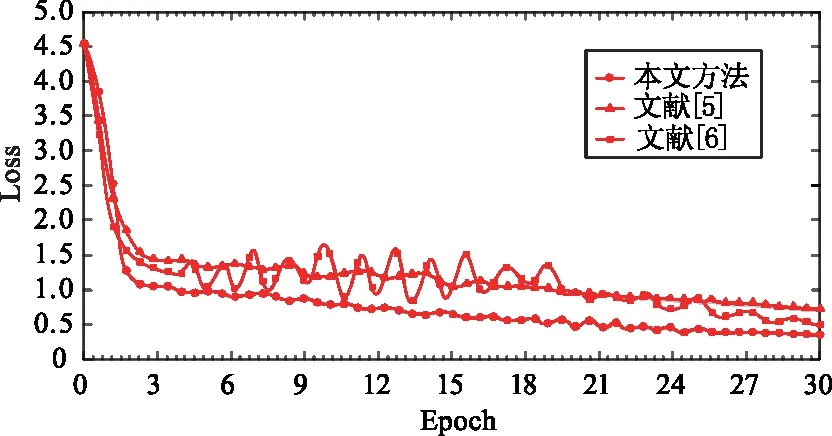

4.3 算法性能對比實驗

在UCMLU數據集中校驗本文方法和文獻[5]、[6]方法在三種網絡模型上的效能對比,以Batch作為單位把數據集傳送到模型張,Batch和epoch分別設成16和30,實現(xiàn)單個epoch應完成100次iteration,網絡的初始學習率設定為0.001。圖10和圖11為訓練進程中的準確度(Precision)和損失值(Loss)隨epoch增加的變化狀態(tài)。從圖10中可以看出本文方法相對于其他兩種方法能在較少的epoch中達到穩(wěn)定狀態(tài),并且精準度較高,這是由于本文方法能夠充分提取遙感圖像中所包含的地物和空間數據。

圖10 訓練進程中的準確度隨epoch增加的變化狀態(tài)

從圖11中可知隨著epoch的增加,本文方法的損失值逐步減少。這是由于本文方法所選擇的代價函數選擇能夠在不斷調整參數的過程中優(yōu)化網絡模型。

圖11 訓練進程中的損失值隨epoch增加的變化狀態(tài)

在SIRI WHU數據集中校驗本文方法和文獻[5]、[6]方法在三種網絡模型上的效能對比,圖12和圖13為訓練進程中的準確度(Precision)和損失值(Loss)隨epoch增加的變化狀態(tài)。從實驗結果可以看出在不同的數據集中,本文方法和其他兩種方法相比魯棒性和穩(wěn)定性好。

圖12 訓練進程中的準確度隨epoch增加的變化狀態(tài)

圖13 訓練進程中的損失值隨epoch增加的變化狀態(tài)

5 結 論

實現(xiàn)復雜遙感圖像的場景分類對發(fā)掘有價值的遙感數據具有重要的價值。由于大多數工程問題均可轉換為數學模型的分析,因此,本文引入代數方法輔助解決。為提升遙感圖像的分類準確性,引入了Lie group代數模型可獲取底層特征并降低特征維度,并在Densenet網絡的基礎上,設計PS-DenseNet網絡提取高層特征。通過深度網絡模型可訓練海量遙感圖像樣本特征,使模型具備較強的自學習功能,從而自動獲取豐富的圖像特征。將上層的節(jié)點與全連接層的神經元銜接,整合底層與高層特征圖,可將二維特征圖變換成一維的特征參量,從而完成圖像分類。

為校驗本文方法的有效性,采用兩類數據集,包含UC Merced Land Use與SIRI WHU完成校驗。并給出本文方法的混淆陣列及三種方法在UCMLU與SIRI WHU數據集下的整體與平均分類的精準度(Overall Classification Accuracy,OCA)和Kappa參數,從數據出發(fā),以客觀指標的角度完成本文方法分類準確度的綜合評判。實驗結果表明,本文方法能夠得到較高的分類精準度,較優(yōu)的OCA參數和Kappa參數,并且隨著epoch的增加,本文方法的損失值逐步減少。