面向空間機(jī)械臂的視觸融合目標(biāo)識別系統(tǒng)

沈書馨, 宋愛國, 陽雨妍, 倪江生

(東南大學(xué)儀器科學(xué)與工程學(xué)院, 南京 210096)

1 引言

空間機(jī)器人是應(yīng)用于太空環(huán)境,輔助或替代機(jī)器人完成危險作業(yè)的機(jī)器人。 自20 世紀(jì)起,各國大力發(fā)展空間機(jī)器人,尤其是空間機(jī)械臂相關(guān)技術(shù),研制了一系列空間機(jī)械臂作業(yè)系統(tǒng),進(jìn)行了大量遙操作實驗。 1981 年哥倫比亞號航天飛機(jī)搭載了加拿大機(jī)械臂操作系統(tǒng)(Shuttle Remote Manipulator System,SRMS),采用無力反饋的在軌遙操作模式進(jìn)行作業(yè)。 其后NASA 研制的FTS系統(tǒng)和DFT-1 系統(tǒng)、德國航宇中心研制的空間站小型機(jī)械臂系統(tǒng)ROTEX 和艙外ROKVISS 系統(tǒng)均搭載多種傳感器,實現(xiàn)了基于臨場感的在軌或遠(yuǎn)程遙操作模式。 NASA 于1999 年提出了機(jī)器人航天員(Robonaut),其操作主要分為遙操作模式和自主操作模式,開始探索空間機(jī)器人自主、半自主操控技術(shù)。

目標(biāo)識別技術(shù)是空間機(jī)械臂自主操控的核心技術(shù),是空間機(jī)械臂智能抓取和操作的前提。 視覺信息和觸覺信息是機(jī)器人感知系統(tǒng)的重要傳感模態(tài)。

由于視覺傳感器發(fā)展較為成熟,基于視覺信息的目標(biāo)識別是當(dāng)前機(jī)器人進(jìn)行目標(biāo)識別的主要方式。 視覺傳感器本身具有一定的局限性,在太空環(huán)境中視角單一,面對遮擋、光線條件復(fù)雜、物體視覺信息相近等情況時,僅憑借視覺信息難以完成識別任務(wù)。 隨著觸覺傳感器不斷發(fā)展,精度等方面逐步完善,觸覺信息輔助視覺信息,提取出物體軟硬度等特征,很好地解決空間目標(biāo)識別困難這一問題。

在觸覺感知領(lǐng)域,Aggarwal 等使用自研的高分辨率觸覺傳感器,采集深海物體觸覺圖像,通過局部特征匹配和全局特征匹配算法,完成了對45 種物體的識別;Chu 等使用安裝有BioTac 傳感器的PR2 機(jī)器人二指爪,對60 個物體采集抓取過程的觸覺數(shù)據(jù),利用機(jī)器學(xué)習(xí)算法提取特征信息,實現(xiàn)了物體表面材質(zhì)的分類。

在視 覺 觸 覺 融 合 方 面,Watkins?Valls 等構(gòu)建了用于觸覺信息與視覺深度信息數(shù)據(jù)融合的三維卷積神經(jīng)網(wǎng)絡(luò),以預(yù)測物體的幾何結(jié)構(gòu);劉華平等提出一種用于視覺觸覺信息融合的聯(lián)合核稀疏編碼(Joint Group Kernel Sparse Coding, JGKSC)方法,實現(xiàn)了對18 種常見物品的分類,準(zhǔn)確性相比單一觸覺或視覺識別有所提高。

本文提出一種基于卷積神經(jīng)網(wǎng)絡(luò)和門控循環(huán)單元CNN?GRU(Convolutional Neural Networks -Gate Recurrent Unit)的面向空間機(jī)械臂的視觸融合模型目標(biāo)識別系統(tǒng)。 系統(tǒng)通過點云定位、路徑規(guī)劃實現(xiàn)空間機(jī)械臂對目標(biāo)物視覺及觸覺信息的自主采集,利用深度學(xué)習(xí)在特征提取和數(shù)據(jù)融合方面的優(yōu)勢,通過CNN?GRU 網(wǎng)絡(luò)對視覺信息和觸覺時序信息進(jìn)行特征提取融合,最終實現(xiàn)對目標(biāo)物的識別。 基于視觸覺融合的目標(biāo)識別實驗構(gòu)建了目標(biāo)物體視覺觸覺數(shù)據(jù)庫,并初步驗證了系統(tǒng)的有效性。

2 系統(tǒng)構(gòu)成

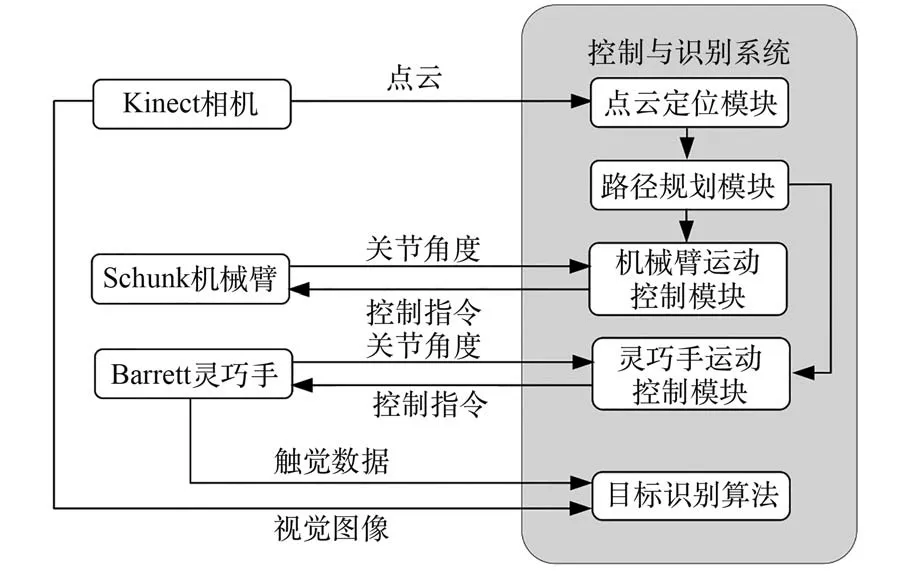

空間機(jī)械臂目標(biāo)識別系統(tǒng)的基本模塊主要包括:Schunk LWA 4D 型七自由度機(jī)械臂、Barrett BH8-282 型三指靈巧手、Kinect 深度相機(jī)以及基于ROS(Robot Operating System)機(jī)器人操作系統(tǒng)的控制與識別系統(tǒng),如圖1 所示。

圖1 空間機(jī)械臂視觸融合目標(biāo)識別實驗系統(tǒng)Fig.1 Visual?tactile fusion target recognition experi?mental system for space manipulator

控制與識別系統(tǒng)基于ROS 進(jìn)行開發(fā),分為點云定位模塊、路徑規(guī)劃模塊、機(jī)械臂運動控制模塊、靈巧手運動控制模塊和目標(biāo)識別模塊,如圖2所示。 空間機(jī)械臂目標(biāo)識別系統(tǒng)工作時,Kinect相機(jī)置于工作空間前方固定位置,采集目標(biāo)物三維點云信息和視覺圖像,將點云信息送入點云定位模塊進(jìn)行目標(biāo)物定位;路徑規(guī)劃模塊根據(jù)定位信息進(jìn)行運動軌跡規(guī)劃,交由控制模塊控制機(jī)械臂和靈巧手完成目標(biāo)接觸及抓取操作;靈巧手上的觸覺傳感器采集抓握過程的觸覺數(shù)據(jù);最后由目標(biāo)識別模塊根據(jù)觸覺數(shù)據(jù)和視覺圖像完成識別任務(wù)。

圖2 系統(tǒng)工作框圖Fig.2 Block diagram of system working

3 目標(biāo)定位與視觸覺數(shù)據(jù)采集

3.1 基于點云的目標(biāo)定位與路徑規(guī)劃

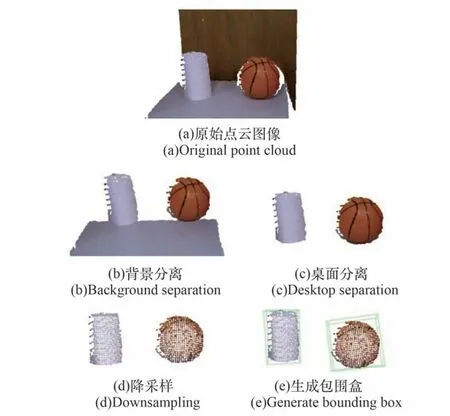

對目標(biāo)物的定位是實現(xiàn)自動抓取,完成觸覺數(shù)據(jù)采集的前提。 Kinect 相機(jī)采集的原始點云圖像如圖3 所示,對其進(jìn)行如下操作:①采用直通濾波分離背景;②采用隨機(jī)采樣一致算法(Random Sample Consensus,RANSAC)擬合平面,實現(xiàn)桌面分割;③采用Voxelized 網(wǎng)格法降采樣;④采用有向包圍盒(Oriented Bounding Box,OBB)獲取相機(jī)坐標(biāo)系下的目標(biāo)物位姿信息(,y,) 。

圖3 點云定位處理Fig.3 Point cloud positioning processing

選擇ROS 系統(tǒng)中運動規(guī)劃庫OMPL(the Open Motion Planning Library)內(nèi)置的快速擴(kuò)展隨機(jī)樹(Rapidly Exploring Random Tree,RRT)算法作為本系統(tǒng)中的路徑規(guī)劃模塊。

RRT 是一種基于采樣的多維空間規(guī)劃算法。將軌跡的初始點作為根節(jié)點,在節(jié)點周圍三維空間中進(jìn)行隨機(jī)采樣作為葉子節(jié)點,經(jīng)過層層采樣,進(jìn)而生成隨機(jī)擴(kuò)展樹。 若生成的隨機(jī)樹中的葉子節(jié)點包含了目標(biāo)點,則可以在隨機(jī)樹中找到一條由從初始點到目標(biāo)點的路徑。 該算法能高效地在高維空間進(jìn)行路徑規(guī)劃,并對采樣點進(jìn)行碰撞檢測。

3.2 觸覺數(shù)據(jù)采集與預(yù)處理

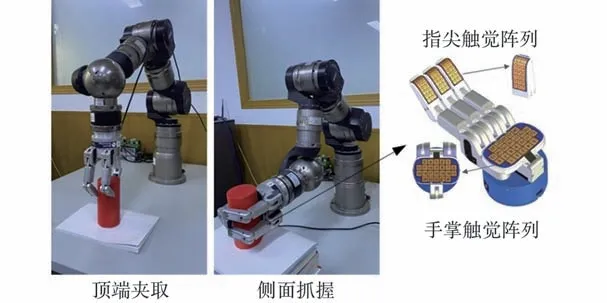

觸覺數(shù)據(jù)采用Barrett 靈巧手指尖搭載的陣列式觸覺傳感器采集,如圖4 所示。 靈巧手每個指尖部位安裝有獨立的觸覺傳感陣列,每個陣列包含24 個采集通道。 由控制系統(tǒng)根據(jù)目標(biāo)物位姿信息自主規(guī)劃,引導(dǎo)機(jī)械臂和靈巧手完成抓取動作,采集抓握過程觸覺信號,采樣頻率為20 Hz。

圖4 觸覺數(shù)據(jù)采集Fig.4 Tactile data collection

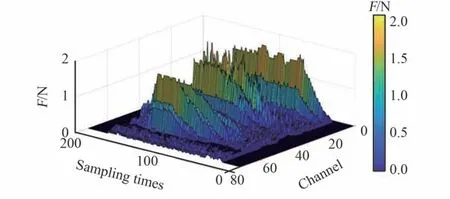

選取3 個指尖觸覺陣列的共72 個通道數(shù)據(jù)組建觸覺數(shù)據(jù)集。 觸覺數(shù)據(jù)的處理過程主要包括平滑濾波、降維、拼接、滑動窗口采樣以及歸一化。

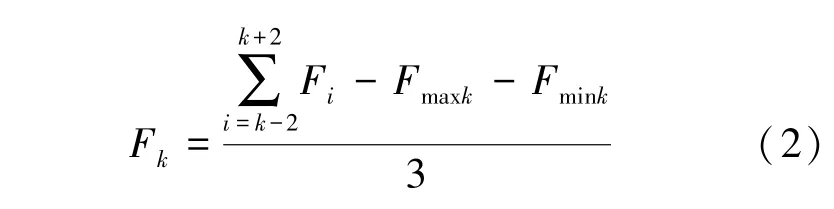

1)平滑濾波。 對每個通道數(shù)據(jù)進(jìn)行平滑濾波,去除噪聲。 采用大小為5、步長為1 的滑動窗口,去除最大值和最小值后,進(jìn)行均值濾波,計算過程如公式(2)所示:

式中,F表示時刻該通道采集到的觸覺數(shù)據(jù),滑動窗口為[-2,+2],表示該滑動窗口內(nèi)觸覺數(shù)據(jù)最大值,表示該滑動窗口內(nèi)觸覺數(shù)據(jù)最小值。

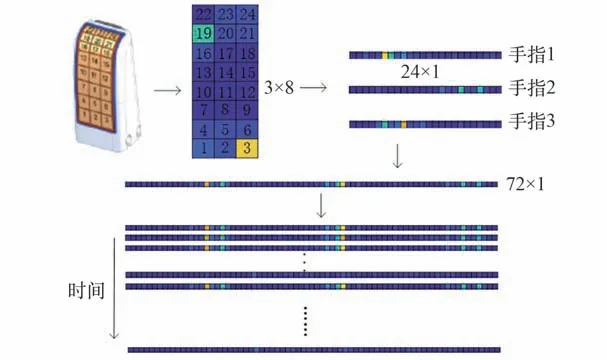

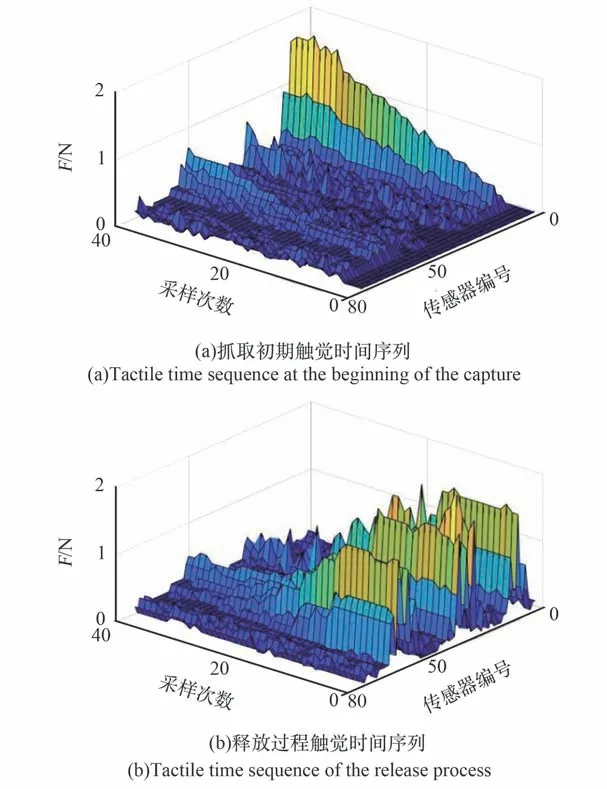

2)降維與拼接。 如圖5 所示,某時刻單個手指采集到二維觸覺陣列,將其按編號1 ~24 的順序展開為一行24 列的一維序列,再將3 個手指的數(shù)據(jù)頭尾相連拼接為一行72 列的一維序列。 將一次完整抓取過程中的觸覺采樣序列,在行方向按時間順序拼接,形成觸覺時間序列,如圖6所示。

圖5 觸覺數(shù)據(jù)處理Fig.5 Tactile data processing

圖6 抓取全程觸覺時間序列Fig.6 Tactile time sequence of crawling

3)滑動窗口采樣。 使用滑動窗口的方式,沿時間方向,窗口長度為40,滑動步長為5,形成大小為40× 72 的觸覺樣本,如圖7 所示。

圖7 觸覺時間序列樣本Fig.7 Samples of tactile time sequence

4)歸一化。 對觸覺樣本進(jìn)行歸一化處理,將每個觸覺數(shù)據(jù)除以該抓取模式下的抓取力最大值。

4 視觸融合神經(jīng)網(wǎng)絡(luò)模型

深度學(xué)習(xí)是一種區(qū)別于傳統(tǒng)機(jī)器學(xué)習(xí)的特殊機(jī)器學(xué)習(xí)方式,由網(wǎng)狀層級結(jié)構(gòu)構(gòu)成,其中含多隱層的多層感知器就是一種深度學(xué)習(xí)結(jié)構(gòu)。 深度學(xué)習(xí)模型主要有卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks, CNN)、循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Networks, RNN)、生成式對抗網(wǎng)絡(luò)(Gener?ative Adversarial Networks, GAN)等,適用于不同的應(yīng)用場景。

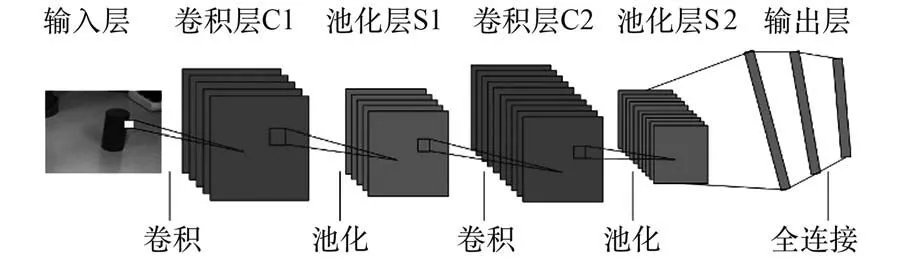

4.1 卷積神經(jīng)網(wǎng)絡(luò)CNN

CNN 的結(jié)構(gòu)如圖8 所示,主要有輸入層、卷積層、池化層和輸出層組成。

圖8 卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)Fig.8 Structure of CNN

輸入信息經(jīng)過多層卷積池化操作形成特征圖。 將特征圖按照行展開連接成向量,傳入全連接層。 全連接層為一個BP(Back Propagation)反向傳播神經(jīng)網(wǎng)絡(luò),通過梯度下降和反向傳播算法進(jìn)行訓(xùn)練。

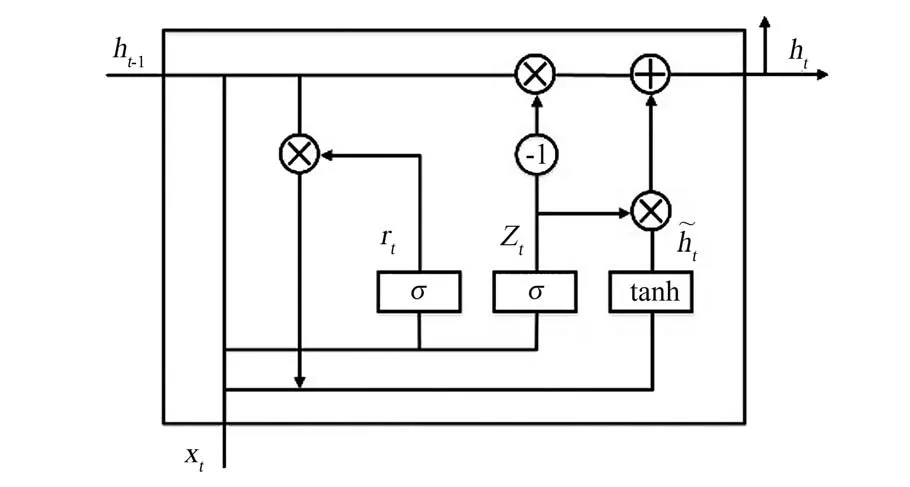

4.2 門控循環(huán)單元GRU

門控循環(huán)單元GRU(Gate Recurrent Unit)是以序列數(shù)據(jù)為輸入的遞歸網(wǎng)絡(luò)。 GRU 能挖掘數(shù)據(jù)中的時序信息以及語義信息,在解決語音識別、行為檢測、機(jī)器翻譯等涉及時序的問題上發(fā)揮了重要作用。

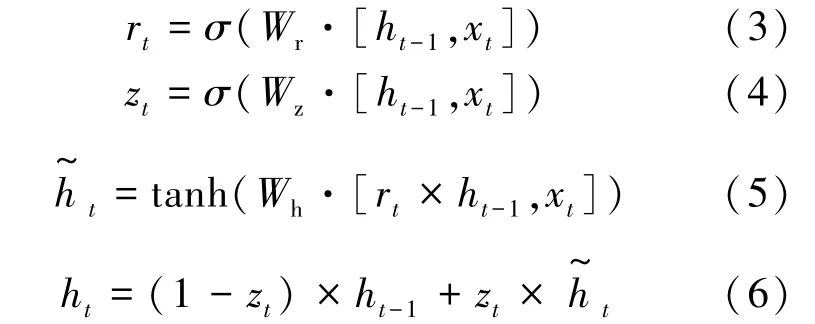

如圖9 所示,GRU 由重置門和更新門組成,重置門決定新輸入信息與記憶信息結(jié)合的方式,更新門決定了當(dāng)前時間步對記憶信息的保存量,其更新方式如式(3)~(6)所示:

圖9 門控循環(huán)單元結(jié)構(gòu)Fig.9 Structure of GRU

4.3 視觸覺信息融合CNN?GRU 模型結(jié)構(gòu)

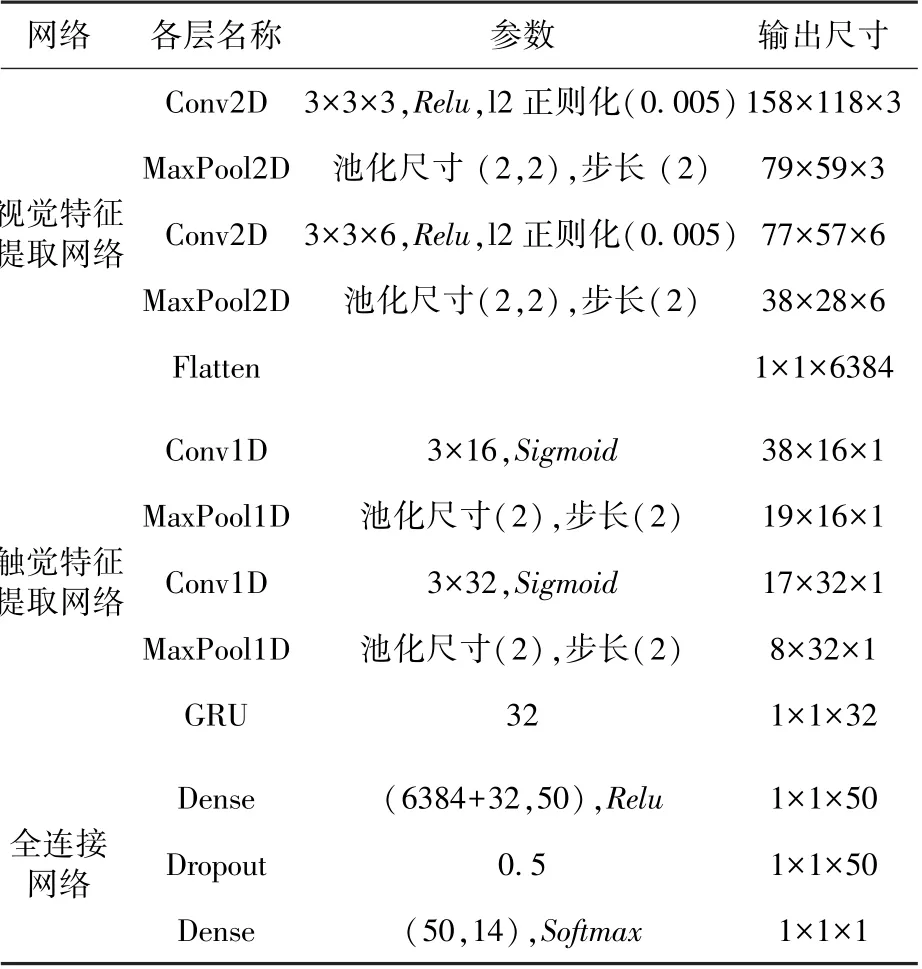

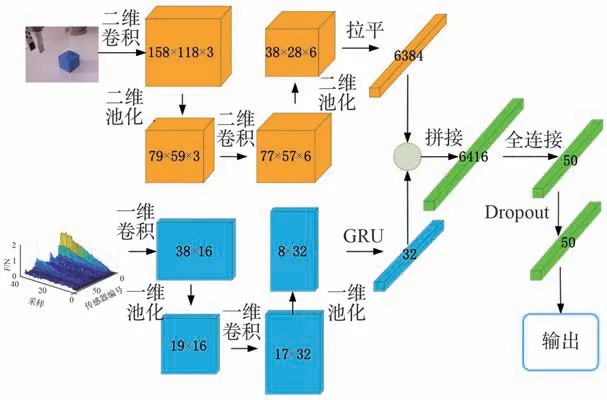

針對視覺觸覺信息融合問題,本文設(shè)計了如圖10 所示雙輸入神經(jīng)網(wǎng)絡(luò)。 由于視觸信息不同的特性,將視覺信息和觸覺信息分別送入神經(jīng)網(wǎng)絡(luò)進(jìn)行特征提取,提取得到的特征向量進(jìn)行拼接后再送入全連接層進(jìn)行訓(xùn)練。 在參考經(jīng)典神經(jīng)網(wǎng)絡(luò)的基礎(chǔ)上對比分析得到網(wǎng)絡(luò)參數(shù),如表1 所示。

表1 CNN?GRU 各層網(wǎng)絡(luò)參數(shù)Table 1 Parameters of layers of CNN?GRU

圖10 視觸覺融合網(wǎng)絡(luò)模型Fig.10 Network model of visual and tactile fusion

1)視覺特征提取。 視覺數(shù)據(jù)為160× 120 像素3 通道RGB 圖像,使用多核多通道卷積操作進(jìn)行特征提取。

第一層網(wǎng)絡(luò)采用3 個3× 3 卷積核對3 通道進(jìn)行卷積,卷積結(jié)果輸入激活函數(shù),得到158×118×3 的特征值矩陣。 采用步長為2,大小為2× 2 的最大池化,對特征進(jìn)行下采樣為79×59× 3 的特征值矩陣。

第二層網(wǎng)絡(luò)采用6 個3× 3 卷積核對第一層網(wǎng)絡(luò)輸出的特征值矩陣進(jìn)行卷積,卷積結(jié)果輸入激活函數(shù),得到77× 57× 6 的特征值矩陣。采用步長為2,大小為2× 2 的最大池化,對特征進(jìn)行下采樣為38× 28× 6 的特征值矩陣。

將卷積形成的38×28×6 特征矩陣?yán)綖橐涣?384 的特征向量。

2)觸覺特征提取。 觸覺數(shù)據(jù)由72 個觸覺陣列傳感器,以20 Hz 頻率采樣,按時間序列排列得到,數(shù)據(jù)大小為40× 72,采用一維卷積與門控循環(huán)單元相結(jié)合的方式進(jìn)行特征提取。 CNN 網(wǎng)絡(luò)能夠提取數(shù)據(jù)中的空間信息,GRU 具有長期記憶功能,能夠有效分析數(shù)據(jù)的時間變化關(guān)系,兩者結(jié)合能有效提取觸覺信息的特征。

第一層網(wǎng)絡(luò)采用16 個大小為3 的卷積核對觸覺數(shù)據(jù)沿時間方向進(jìn)行一維卷積,卷積結(jié)果輸入激活函數(shù),得到38× 16 的特征值矩陣。采用步長為2、大小為2 的最大池化,按時間方向?qū)μ卣鬟M(jìn)行下采樣為19× 16 的特征值矩陣。

第二層網(wǎng)絡(luò)采用32 個大小為3 的卷積核對第一層網(wǎng)絡(luò)輸出的特征值矩陣進(jìn)行一維卷積,卷積結(jié)果輸入激活函數(shù),得到17× 32 的特征值矩陣。 采用步長為2、大小為2 的最大池化,按時間方向?qū)μ卣鬟M(jìn)行下采樣為8× 32 的特征值矩陣。

第三層網(wǎng)絡(luò)采用神經(jīng)元數(shù)為32 的GRU 門控循環(huán)單元對第二層網(wǎng)絡(luò)輸出的特征值矩陣進(jìn)行時序特征提取,形成大小為32 的特征向量。

3)特征融合分類。 視觸覺信息融合為特征層面的融合,對提取完的視覺特征和觸覺特征進(jìn)行拼接,分類網(wǎng)絡(luò)采用全連接網(wǎng)絡(luò)實現(xiàn)。

在全連接層之前進(jìn)行,將提取完的視覺特征和觸覺特征按列方向進(jìn)行拼接[] ,形成一維視觸特征向量。

第一層全連接層神經(jīng)元個數(shù)為50,激活函數(shù)為。 引 入Dropout 層 防 止 過 擬 合, 參 數(shù)為0.5。

輸出層神經(jīng)元個數(shù)為物品類別數(shù)14,激活函數(shù)為,實現(xiàn)物品類別的輸出。

5 算法驗證

5.1 實驗物品選擇

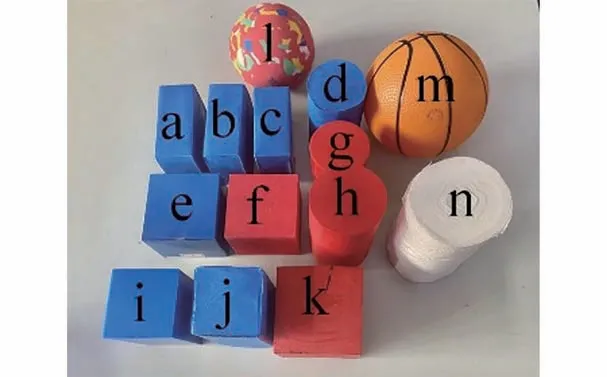

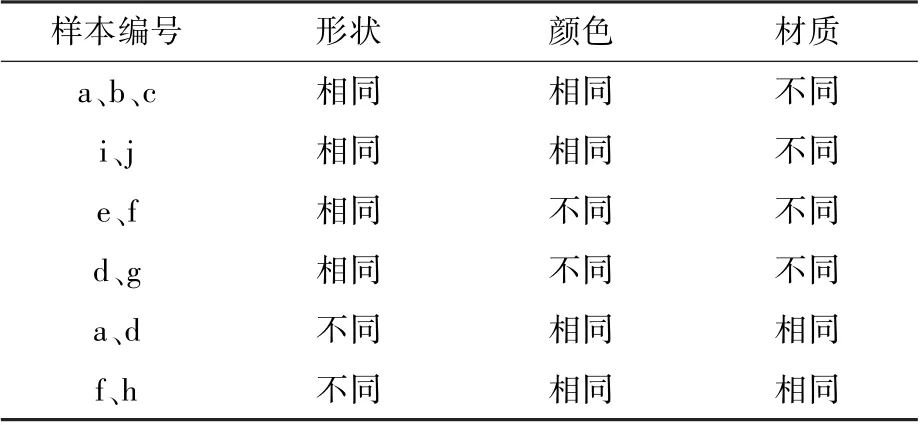

根據(jù)實驗?zāi)康模瑢Ρ确治鰡我灰曈X、觸覺、視觸融合網(wǎng)絡(luò)對復(fù)雜光線、單一視角下相似目標(biāo)識別情況。 選取具有對照價值的14 種物體,分別為:(a)軟泡沫藍(lán)色扁方塊;(b)硬泡沫藍(lán)色扁方塊;(c)鐵制藍(lán)色扁方塊;(d)軟泡沫藍(lán)色圓柱;(e)藍(lán)色硬紙盒;(f)硬海綿紅色方塊;(g)塑料紅色圓柱;(h)硬海綿紅色圓柱;(i)塑料藍(lán)色高方塊;(j)軟泡沫藍(lán)色高方塊;(k)木制紅色方塊;(l)硬海綿球;(m)充氣球;(n)卷紙。 如圖11 所示,材質(zhì)為軟泡沫、硬海綿、塑料等軟硬不同材質(zhì);顏色為紅色、藍(lán)色;形狀為圓柱、扁方塊、高方塊、球體。 其中存在多組對照,如表2 所示。

圖11 14 種物體Fig.11 14 kinds of objects

表2 樣本對照組Table 2 Sample control groups

5.2 視觸覺數(shù)據(jù)集組建

視覺采樣對復(fù)雜光線條件下、不同角度、不同遮擋情況下的實驗物品進(jìn)行拍攝,如圖12 所示。每個物品采集圖像200 張,分辨率為160× 120,刪除其中物品占比過小或失真嚴(yán)重的圖像。 使用鏡像和翻轉(zhuǎn)等重采樣操作對樣本量進(jìn)行擴(kuò)充,最終形成樣本量為7960 的視覺數(shù)據(jù)集。

圖12 視覺數(shù)據(jù)采集Fig.12 Visual data collection

觸覺采樣一次完整抓取過程分為恒速抓緊、保持、恒速釋放3 個階段。 每種物品進(jìn)行20 次抓取,經(jīng)過處理及滑動窗口采樣,最終形成樣本量為3025 個的觸覺數(shù)據(jù)集。

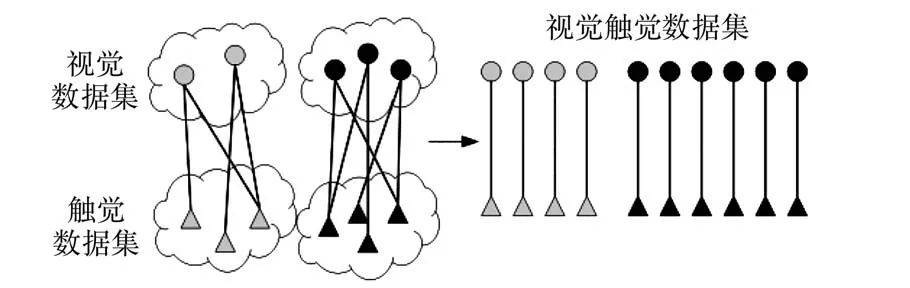

對于觸覺數(shù)據(jù)和視覺數(shù)據(jù),由于其觸覺數(shù)據(jù)與視覺數(shù)據(jù)之間無一一對應(yīng)的強(qiáng)匹配關(guān)系,所以采取在同一類物品內(nèi)部弱匹配方式。 如圖13 所示,對于某一物品的每個視覺樣本,隨機(jī)抽取該物品觸覺數(shù)據(jù)集的2 個觸覺樣本,組成2 組視覺觸覺樣本對,最終形成15 920 組視覺觸覺對,組成視覺觸覺數(shù)據(jù)集。

圖13 視覺觸覺融合Fig.13 Visual tactile fusion

5.3 算法比對

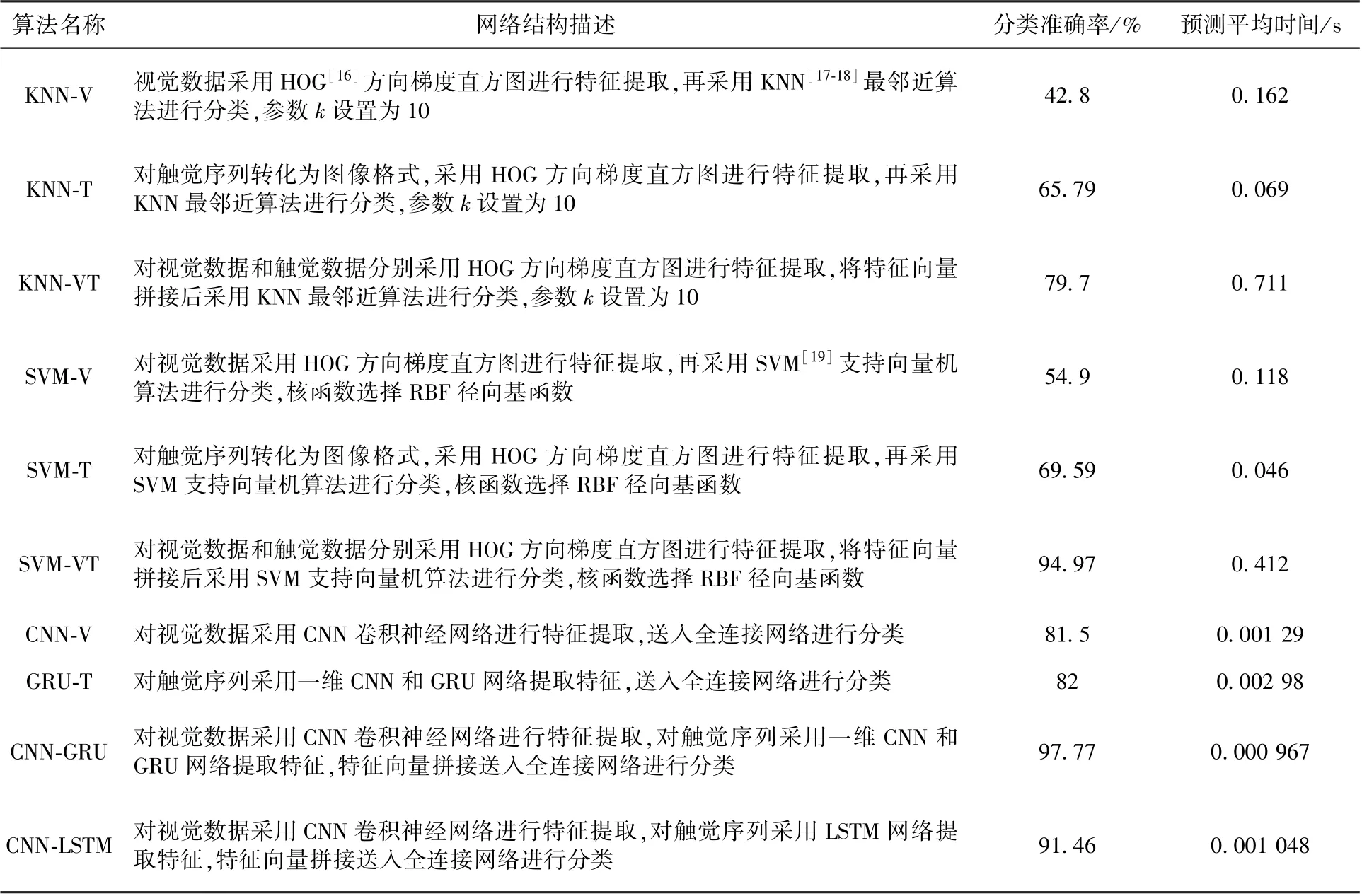

為了驗證本文設(shè)計的視觸覺融合神經(jīng)網(wǎng)絡(luò)在物體識別方面的優(yōu)勢,設(shè)置一定的傳統(tǒng)分類網(wǎng)絡(luò)、單獨視覺觸覺神經(jīng)網(wǎng)絡(luò)進(jìn)行對照。

實驗基于Python 下的tensorflow、keras 庫搭建神經(jīng)網(wǎng)絡(luò)算法,基于sklearn 庫搭建K 鄰近算法(K?Nearest Neighbor, KNN) 和 支 持 向 量 機(jī)(Support Vector Machines, SVM)算法。 將視覺、觸覺、視觸覺數(shù)據(jù)集分別按照1 ∶1 ∶4的比例劃分測試集、驗證集和訓(xùn)練集,并打亂樣本順序。KNN?V、SVM?V 和CNN?V 網(wǎng)絡(luò)使用視覺數(shù)據(jù)集進(jìn)行訓(xùn)練;KNN?T、SVM?T 和GRU?T 網(wǎng)絡(luò)使用觸覺數(shù)據(jù)集進(jìn)行訓(xùn)練;KNN?VT、SVM?VT、CNN?GRU和CNN?LSTM 網(wǎng)絡(luò)采用視覺觸覺數(shù)據(jù)集進(jìn)行訓(xùn)練。

訓(xùn)練環(huán)境:CPU 為Intel Core I7 6900K 8 核,運行內(nèi)存RAM 為64 G,GPU 為2 個NVIDIA TI?TAN Xp CPLLECTORS EDITION,顯卡內(nèi)存12 G。

使用訓(xùn)練集和驗證集對模型參數(shù)進(jìn)行訓(xùn)練,使用測試集計算模型分類準(zhǔn)確率,記錄100次連續(xù)分類所需總時間,計算預(yù)測平均時間。訓(xùn)練過程觀察模型的準(zhǔn)確率與誤差曲線,對模型的初始權(quán)值、學(xué)習(xí)率參數(shù)進(jìn)行調(diào)整,獲取最優(yōu)識別模型。

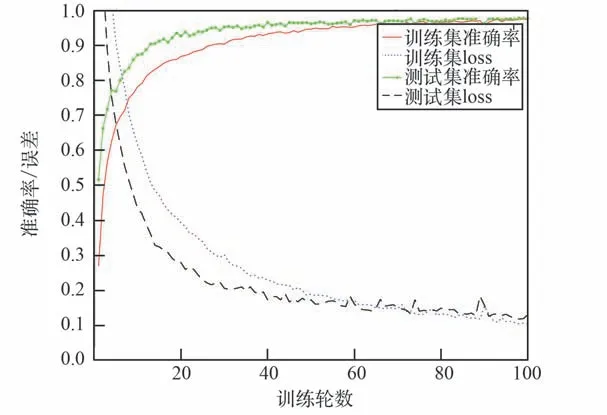

圖14 為視觸融合CNN?GRU 網(wǎng)絡(luò)訓(xùn)練過程的準(zhǔn)確率和誤差曲線。 訓(xùn)練過程學(xué)習(xí)率初始值為0.001,訓(xùn)練輪數(shù)為100。 最終訓(xùn)練樣本準(zhǔn)確率為97.5%、 誤 差 為 0.104, 測 試 樣 本 準(zhǔn) 確 率 為97.8%、誤差為0.131。 該結(jié)果表明CNN?GRU 網(wǎng)絡(luò)能夠有效利用視觸覺特征,對單一視角下相似物體做出準(zhǔn)確識別,符合空間機(jī)械臂目標(biāo)識別系統(tǒng)的應(yīng)用要求。

圖14 CNN?GRU 網(wǎng)絡(luò)模型訓(xùn)練曲線Fig.14 The training curve of CNN?GRU network model

對比表3 中各算法的準(zhǔn)確率和預(yù)測時間,在同一傳感器數(shù)據(jù)下,采用CNN 和GRU 網(wǎng)絡(luò)的分類方式比傳統(tǒng)KNN 和SVM 算法取得了更高的準(zhǔn)確率,且預(yù)測平均時間大幅度下降。 同時CNN?GRU 網(wǎng)絡(luò)比CNN?LSTM 準(zhǔn)確率高6.3%,表明CNN 和GRU 網(wǎng)絡(luò)能更有效地提取不同目標(biāo)物視覺數(shù)據(jù)與觸覺數(shù)據(jù)的特征。 針對同一類分類算法,使用視覺觸覺融合方式的分類網(wǎng)絡(luò),比單一視覺或觸覺的分類網(wǎng)絡(luò),準(zhǔn)確率均有明顯的提升。表明目標(biāo)物視覺數(shù)據(jù)與觸覺數(shù)據(jù)能夠有效互補(bǔ),彌補(bǔ)單一傳感器下難以分辨的特征信息。

表3 各個算法的分類準(zhǔn)確度和預(yù)測平均時間Table 3 Classification accuracy and average prediction time of each algorithm

本 文 提 出 的CNN?GRU 網(wǎng) 絡(luò), 準(zhǔn) 確 率 為97.8%, 比 單 一 視 覺 CNN?V 網(wǎng) 絡(luò) 識 別 提 升16.3%,比單一觸覺GRU?T 網(wǎng)絡(luò)提升15.8%,比視觸覺融合CNN?LSTM 網(wǎng)絡(luò)提升6.3%,同時預(yù)測時間更短,在該分類問題下?lián)碛辛己玫男阅堋?/p>

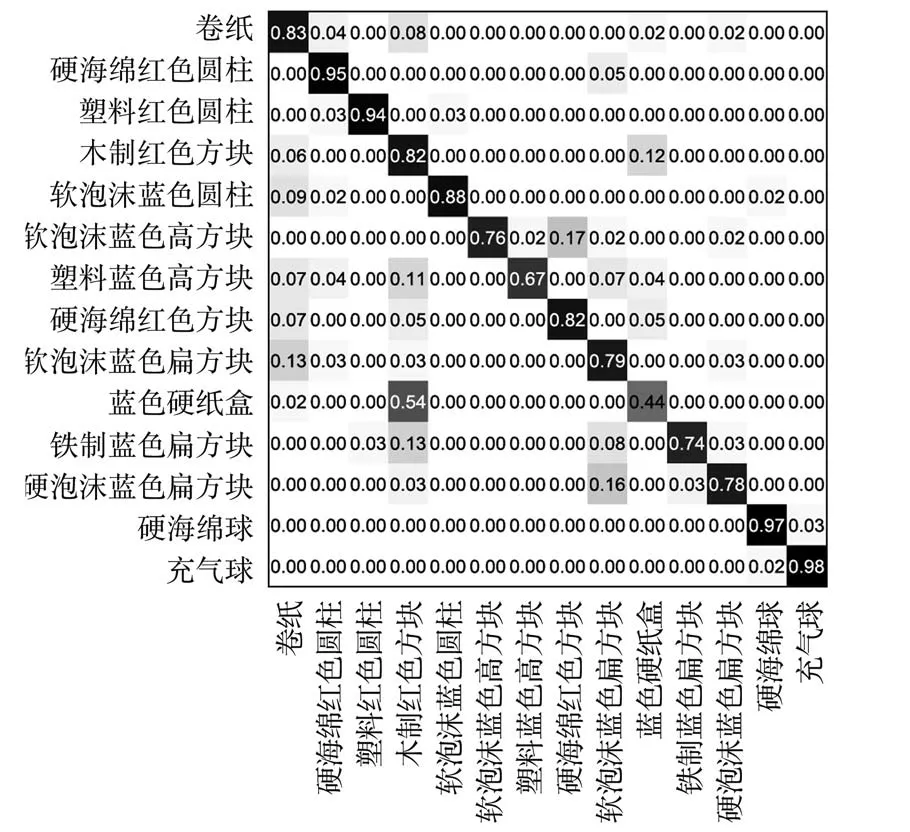

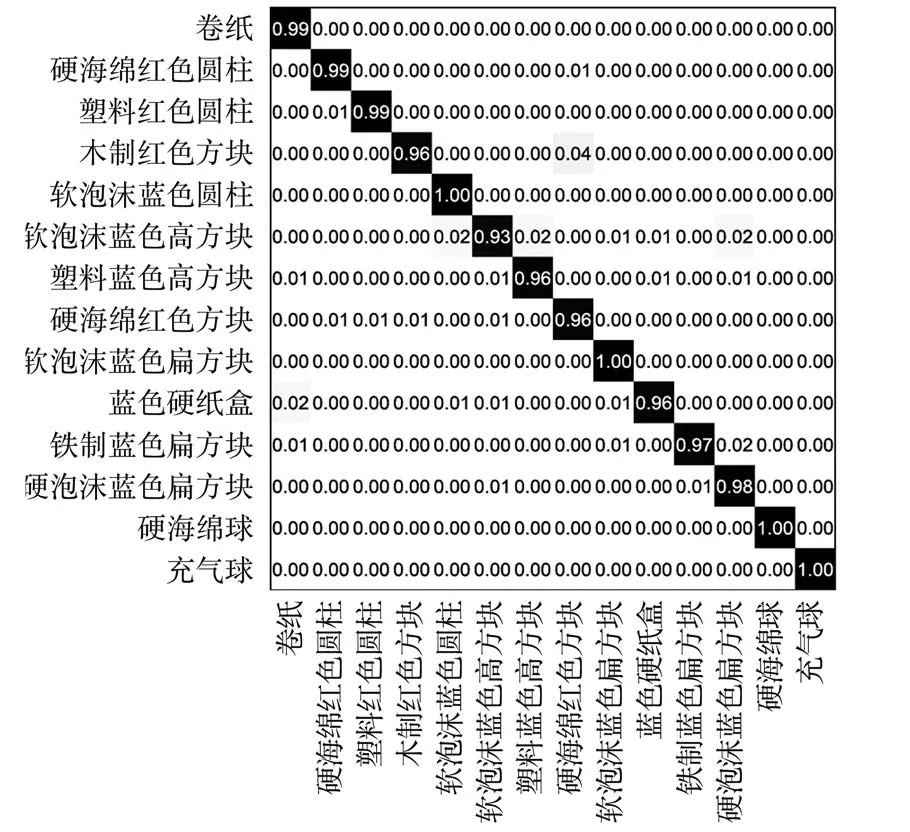

對比CNN?V 視覺神經(jīng)網(wǎng)絡(luò)、GRU?T 觸覺神經(jīng)網(wǎng)絡(luò)和CNN?GRU 視觸融合神經(jīng)網(wǎng)絡(luò)的混淆矩陣如圖15~17 所示,分析視觸覺網(wǎng)絡(luò)對物體的特征提取與識別狀況。 在CNN?V 視覺神經(jīng)網(wǎng)絡(luò)下,網(wǎng)絡(luò)有14%的幾率將木制紅色方塊識別為塑料紅色圓柱,將軟泡藍(lán)色高方塊識別為塑料藍(lán)色高方塊,有16%的幾率將硬泡沫藍(lán)色扁方塊識別為鐵制藍(lán)色扁方塊。 而在GRU?T 觸覺神經(jīng)網(wǎng)絡(luò)下,這3 種情況的誤識別率均為0,能夠做出有效區(qū)分。可知視覺網(wǎng)絡(luò)的誤識別主要發(fā)生在同色且外觀相似物體之間,與物體的材質(zhì)、軟硬等屬性幾乎無關(guān),觸覺信息能對此缺陷做出有效彌補(bǔ)。

圖15 CNN?V 網(wǎng)絡(luò)識別結(jié)果的混淆矩陣Fig.15 Confusion matrix of recognition results of CNN?V

GRU?T 觸覺神經(jīng)網(wǎng)絡(luò)在木制紅色方塊與藍(lán)色硬紙盒之間發(fā)生了嚴(yán)重的誤識別,錯誤率超過50%,同時也存在17%的幾率將軟泡沫藍(lán)色高方塊識別為硬海綿紅色方塊,11%的幾率將塑料藍(lán)色高方塊識別為木制紅色方塊。 在視覺神經(jīng)網(wǎng)絡(luò)下,這3 種情況的誤識別率也均為0%,能夠做出有效區(qū)分。 CNN?V 觸覺網(wǎng)絡(luò)的誤識別主要發(fā)生在形狀、硬度相似的物體之間,與物體的顏色無關(guān),視覺信息能有效彌補(bǔ)觸覺網(wǎng)絡(luò)對該特征的不足。

圖16 GRU?T 網(wǎng)絡(luò)識別結(jié)果的混淆矩陣Fig.16 Confusion matrix of recognition results of GRU?T

圖17 CNN?GRU 網(wǎng)絡(luò)識別結(jié)果的混淆矩陣Fig.17 Confusion matrix of recognition results of CNN?GRU

CNN?GRU 視觸覺融合神經(jīng)網(wǎng)絡(luò)對所有物體均有較高的識別準(zhǔn)確率,對于一半的物體準(zhǔn)確率超過99%,誤差主要產(chǎn)生于木制紅色方塊、硬海綿紅色方塊這類顏色、形狀、軟硬度都較接近的物體之間。

總體而言,面向空間機(jī)械臂的視觸覺融合目標(biāo)識別系統(tǒng)能夠自主采集有效視覺觸覺數(shù)據(jù)。 同時基于CNN?GRU 網(wǎng)絡(luò)能有效地對視覺和觸覺特征進(jìn)行提取和融合,解決空間作業(yè)過程中視覺傳感器視角單一、光線條件復(fù)雜導(dǎo)致的相似目標(biāo)識別較差的問題,明顯提高識別準(zhǔn)確率和速度。

6 結(jié)論

1)基于ROS 系統(tǒng)設(shè)計點云定位、路徑規(guī)劃、機(jī)械臂控制和靈巧手控制模塊,實現(xiàn)了對目標(biāo)物視覺觸覺信息的自主采集。

2)提出了基于CNN?GRU 網(wǎng)絡(luò)的視觸覺融合模型。 該模型通過卷積神經(jīng)網(wǎng)絡(luò)提取視覺特征,通過門控循環(huán)單元提取觸覺特征,將特征向量拼接后送入全連接網(wǎng)絡(luò)進(jìn)行目標(biāo)識別。

3)組建14 種分類樣本數(shù)據(jù)集,進(jìn)行算法驗證。 實驗表明,該系統(tǒng)能夠有效利用視觸覺信息的時空分布特性,解決空間作業(yè)過程中單一視覺傳感器識別較差的問題,準(zhǔn)確率為97.8%,比單一視覺CNN?V 網(wǎng)絡(luò)和觸覺GRU?T 網(wǎng)絡(luò)識別分別提升16.3%和15.8%。 同時,相較于傳統(tǒng)KNN 和SVM 網(wǎng)絡(luò),CNN?GRU 網(wǎng)絡(luò)在預(yù)測速度和準(zhǔn)確性方面都有極大的提升。 后續(xù)可繼續(xù)補(bǔ)充真實空間機(jī)械臂作業(yè)場景樣本及實驗,并且優(yōu)化模型參數(shù),以達(dá)到未來更好地應(yīng)用于實際空間機(jī)械臂作業(yè)的目的。