一種改進可形變FCN的農(nóng)作物害蟲檢測方法

徐聰 王旭啟 劉裕

摘要:田間農(nóng)作物害蟲種類繁多,不同的生長階段形態(tài)和顏色各異,在自然環(huán)境下采集的圖像背景復雜,角度和尺度變化多樣,從而使傳統(tǒng)的害蟲檢測方法準確率較低。提出一種改進可形變?nèi)矸e神經(jīng)網(wǎng)絡(deformable fully convolution network,DFCN)的農(nóng)作物害蟲檢測方法,該方法由編碼模塊和解碼模塊組成。編碼模塊在VGG16中采用了可形變卷積,能適應不同形狀、位置和尺寸等幾何形變的害蟲圖像。為了更好地保留害蟲圖像的紋理特征和背景特征,在編碼模塊中應用了混合池化,加快了網(wǎng)絡的訓練速度,提高了害蟲檢測的準確率;解碼模塊對編碼的下采樣層進行反卷積操作,最后應用像素級分類器獲得有效的檢測圖像。在擴展的害蟲圖像數(shù)據(jù)集上與DFCN方法的分割精確度和平均交并比分別為90.43、78.16,較語義分割方法SegNet分別提高了3.27、3.72,單幅圖像的識別時間為0.36 s,比SegNet 加快了0.16 s。結(jié)果表明DFCN方法在害蟲圖像檢測方面具有較高的準確率,分割速度快,可為復雜背景下農(nóng)作物害蟲檢測提供一定的理論參考。

關(guān)鍵詞:農(nóng)作物害蟲檢測;全卷積神經(jīng)網(wǎng)絡;可形變卷積;可形變?nèi)矸e神經(jīng)網(wǎng)絡

中圖分類號: TP391.4? 文獻標志碼: A

文章編號:1002-1302(2022)09-0211-08

農(nóng)作物害蟲檢測是現(xiàn)階段農(nóng)業(yè)生產(chǎn)活動中的關(guān)鍵問題之一。自然環(huán)境下采集的農(nóng)作物害蟲圖像經(jīng)常受光照、害蟲形態(tài)、圖像尺寸和拍攝角度等因素影響,使害蟲的分割和識別等具有很大難度[1]。隨著人工智能技術(shù)的快速發(fā)展,深度學習的理論方法被廣泛應用在農(nóng)作物病蟲害檢測上,降低了傳統(tǒng)人工檢測方法的主觀性和檢測成本,提高了檢測的準確率[2-5]。

趙志焱等基于Tiny-Alex卷積神經(jīng)網(wǎng)絡(TACNN)對金龜子、梨木虱和梨癭蚊3種玉露香梨葉常見害蟲進行識別[6],相比AlexNet有較高的識別率[7]。Zhou等提出了一種基于深度卷積條件生成對抗網(wǎng)絡的害蟲分類方法,該方法在卷積層之后嵌入空間金字塔層,將最小二乘損失函數(shù)作為網(wǎng)絡的損失函數(shù)來迭代優(yōu)化,使網(wǎng)絡收斂快、穩(wěn)定性好[8-9]。Schmidhuber等提出了一種基于深度卷積神經(jīng)網(wǎng)絡(convolutional neural network,CNN)的常見害蟲識別方法,使用數(shù)字圖像處理技術(shù)和對抗生成網(wǎng)絡對小麥、水稻、玉米等9種常見害蟲擴展構(gòu)建數(shù)據(jù)集,將VGG16、VGG19、Inception-v3和Inception-v4在數(shù)據(jù)集中所學的知識遷移在新的網(wǎng)絡中進行害蟲分類識別[10-11]。李靜等提出了一種基于改進GoogLeNet模型的玉米螟蟲害圖像識別方法,該方法先通過遷移學習將GoogLeNet的Inception-v4網(wǎng)絡結(jié)構(gòu)知識轉(zhuǎn)移到玉米螟蟲識別的任務上,再用Inception模塊的多尺度卷積核提取多尺度玉米螟蟲害分布的特征并優(yōu)化模型參數(shù),使模型具有更強的魯棒性和適用性,平均識別率達到了96.44%[12]。趙立新等將PlantVillage數(shù)據(jù)集學習到的知識遷移到目標棉花病蟲數(shù)據(jù)集上,用遷移學習算法改進AlexNet模型,實現(xiàn)棉花葉部蟲害圖像的準確分類,最終準確度能達到97.16%[13]。李衡霞等提出了一種基于深度卷積神經(jīng)網(wǎng)絡的油菜蟲害檢測方法,能對5種油菜害蟲快速檢測[14]。在空間金字塔池化的深度CNN和改進的YOLOv3的基礎上,張博等提出了一種農(nóng)作物害蟲的種類識別方法,改善因作物害蟲姿態(tài)和尺度多樣性導致的識別精度低的問題,識別率可達88.07%[15-17]。劉文定等提出了一種基于全卷積神經(jīng)網(wǎng)絡(fully convolution network,F(xiàn)CN)的蟲害區(qū)域識別方法,該方法用卷積層替換VGG16模型[18-19]的全連接層,通過上采樣實現(xiàn)端到端的學習,用跳躍結(jié)構(gòu)融合多種特征信息,有效提升識別精度,在一定程度上解決了蟲害區(qū)域不規(guī)則和傳統(tǒng)識別方法泛化能力差的問題[20]。張苗輝等利用深度學習理論訓練學習了10種常見害蟲的信息,構(gòu)建害蟲的超完備字典,引入稀疏表示算法對害蟲樣本分類識別,平均準確率達85.3%[21]。Fuentes等基于局部和全局類注釋信息,在不同分辨率的番茄病蟲害圖像上提出一種魯棒的深度學習檢測方法,能有效識別9種不同類型的病蟲[22]。梁萬杰等基于CNN提出了水稻二化螟蟲害識別方法,設計了一個10層卷積網(wǎng)絡模型,可有效學習圖像特征,對水稻二化螟識別有較好的魯棒性,識別精度達到89.14%[23]。Ding等基于深度學習模型提出了一種滑動窗對性誘劑黏板上害蟲圖像的自動檢測識別和計數(shù)方法,在蘋果蠹蛾數(shù)據(jù)集上驗證了該方法的有效性[24]。

以上都是基于深度神經(jīng)網(wǎng)絡及改進的算法模型,在農(nóng)作物病蟲害檢測和識別上取得了較好的試驗結(jié)果,但對于形變病蟲害圖像的檢測沒有涉及,因為模型對幾何形變的建模能力主要來自數(shù)據(jù)集的擴增、網(wǎng)絡層數(shù)的加深和模型的人為設計,沒有從根本上解決田間害蟲的形變問題[25]。為了解決以上問題,本研究提出了一種改進的可形變?nèi)矸e神經(jīng)網(wǎng)絡的農(nóng)作物害蟲檢測方法,該方法在改進的FCN網(wǎng)絡中嵌入可形變卷積[26]和混合池化,進一步提高了害蟲檢測的準確率并加快網(wǎng)絡的訓練速度。試驗表明該模型在田間對一定幾何形變的害蟲具有較好的檢測能力和魯棒性。

1 材料與方法

1.1 數(shù)據(jù)收集與擴充

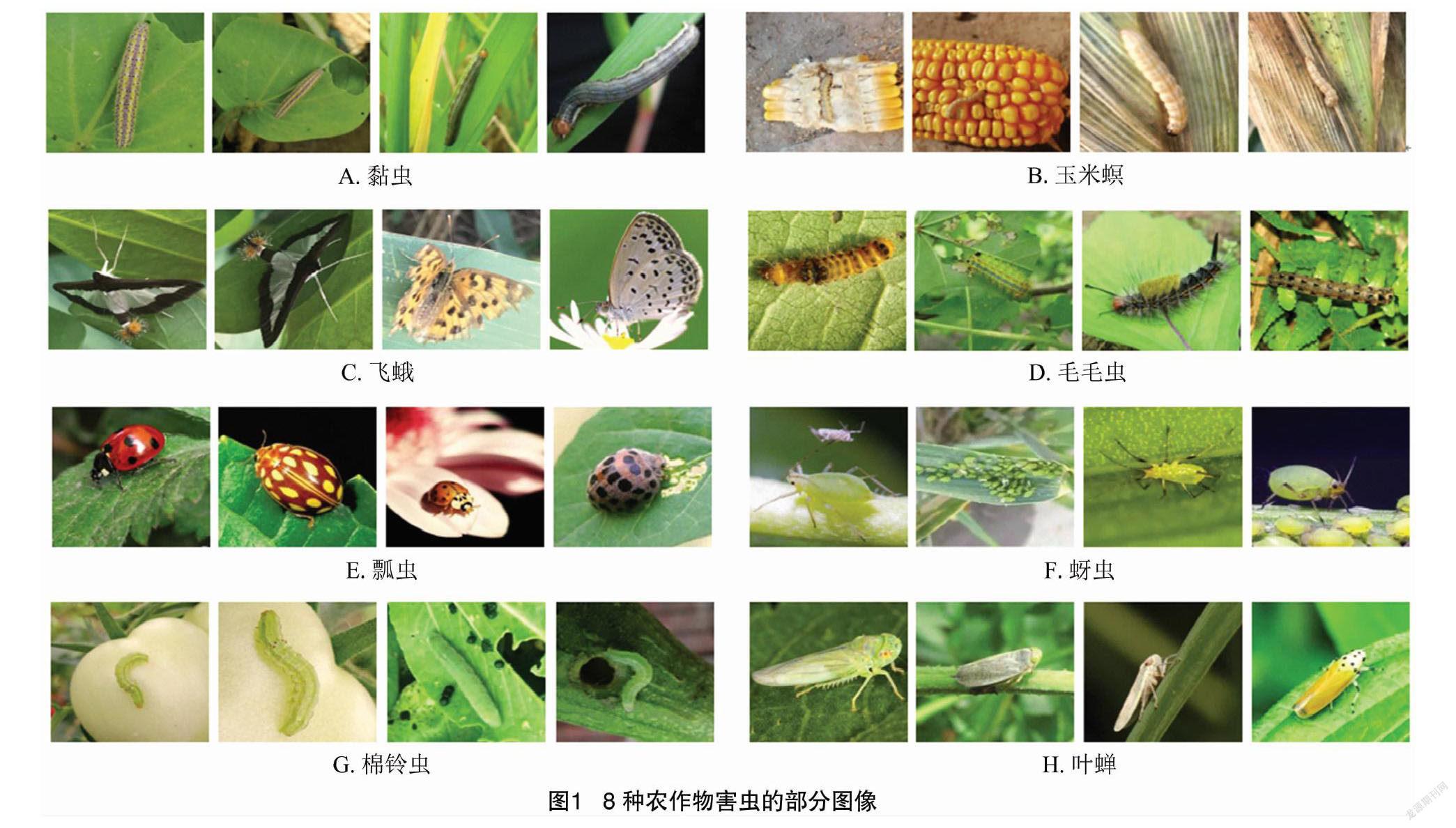

以常見的黏蟲、玉米螟、飛蛾、毛毛蟲、瓢蟲、蚜蟲、棉鈴蟲和葉蟬8種農(nóng)作物害蟲為研究對象。圖像來自陜西省寶雞市農(nóng)業(yè)科學研究所的大田試驗基地,在田間自然環(huán)境下的不同時間段里,用智能手機、攝像機和物聯(lián)網(wǎng)圖像采集設備采集了1 600幅害蟲圖像,每種害蟲圖像200幅。為保證數(shù)據(jù)集的完整性,每種害蟲再用50幅網(wǎng)絡圖像對數(shù)據(jù)集進行擴充。用PhotoShop將圖像統(tǒng)一裁剪為每幅 256×256像素大小的JPG彩色圖像以提高后續(xù)網(wǎng)絡模型的訓練效率。圖1為選用的部分害蟲圖像。

模型訓練之前先對采集的圖像數(shù)據(jù)進行隨機翻轉(zhuǎn)、平移、添加噪聲、隨機縮放和角度變換等處理進行擴充,如圖2為葉蟬害蟲的擴充圖像,以改善在訓練過程中模型出現(xiàn)的過擬合現(xiàn)象。經(jīng)過數(shù)據(jù)集擴充后,8種農(nóng)作物害蟲圖像各擴充為1 000幅,數(shù)據(jù)集共8 000幅,隨機選擇6 500幅作為訓練集用于訓練網(wǎng)絡,其余1 500幅作為測試集用于測試網(wǎng)絡性能。

1.2 可形變卷積

傳統(tǒng)的卷積神經(jīng)網(wǎng)絡采用固定形狀的卷積核,即只對輸入特征圖的固定位置進行采樣,在同一層特征圖中,所有特征點的感受野是一樣的,可不同特征點位置所對應物體的形變或尺度是不同的,所以常規(guī)卷積無法適應對象空間的幾何變換。為增強卷積神經(jīng)網(wǎng)絡對多形變圖像的處理能力,可采用可形變卷積。

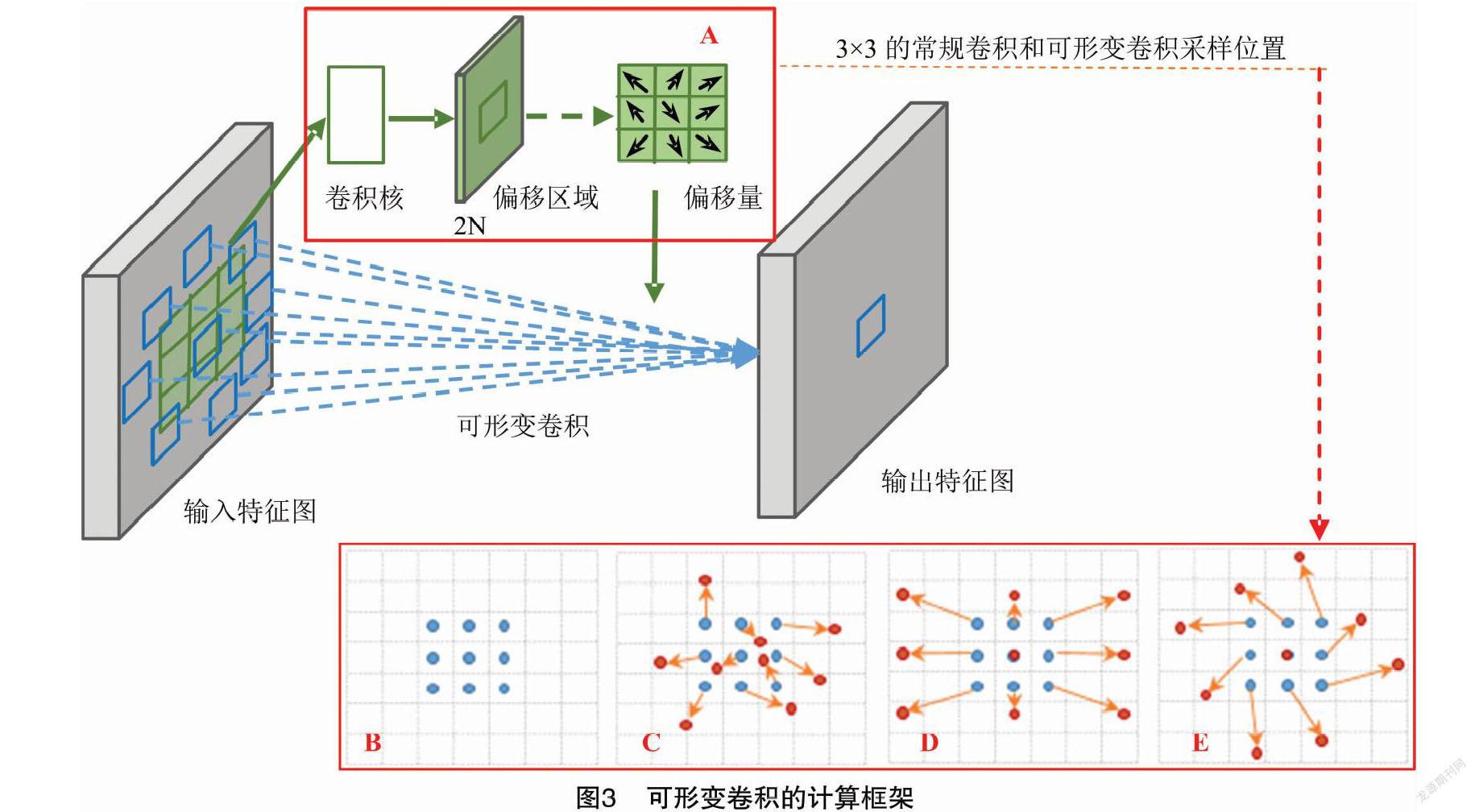

圖3為可形變卷積的計算框架。輸入特征圖經(jīng)過可形變卷積,如圖中紅色框(A)操作后獲取輸出特征圖。紅色框(A)內(nèi)表示卷積核中每一個采樣點加入一個偏移量,使得卷積核在輸入特征圖上的采樣點發(fā)生偏移,實現(xiàn)當前位置附近的隨意采樣而不局限于常規(guī)卷積的規(guī)則采樣點。偏移量不是隨機產(chǎn)生而是卷積核對特征圖中的每一個位置學習來的偏移量,即通過另一個平行的標準卷積單元計算得到,也可以通過梯度方向傳播進行端對端的學習。其中2N為預測的x、y方向的偏移量,因為不同采樣點征的貢獻不同,因此還需要預測采樣點的權(quán)重。以3×3大小的卷積為例,圖3-B、圖3-E是常規(guī)卷積與可形變卷積采樣位置對比情況,其中圖3-B是常規(guī)卷積核的采樣點位置,圖3-C是添加1個偏移量后可形變卷積的采樣點位置,圖3-D和圖3-E是圖3-C的特殊情況。表明可形變卷積包括了各種尺度的變換,縱橫比和旋轉(zhuǎn)。

常規(guī)卷積一般先對輸入特征映射圖使用規(guī)則R進行采樣,再用卷積核對采樣點進行加權(quán)求和。其中R表示當前卷積區(qū)域感受野的尺寸和位置。如定義一個大小為3×3且感受野在中心的卷積核R={(-1,1),(-1,0),…,(0,1),(1,1)},輸出特征圖y(P 0)的計算式為:

y(P 0)=∑P n∈Rw(P n)·x(P 0+P n)。(1)

式中:w(·)為權(quán)重;x(·)為輸入;P 0為輸出特征圖的每個位置;P n為對R中所列位置的枚舉。

為了獲取更好的空間信息表示能力,在常規(guī)卷積中加入偏移量,可形變卷積定義為:

y(P 0)=∑P n∈Rw(P n)·x(P 0+P n+ΔP n)。(2)

式中:{ΔP n|n=1,2,…,N}為P n的偏移量。

可形變卷積的采樣是在不規(guī)則區(qū)域上進行的,導致卷積后得到的特征圖像素偏移量通常為小數(shù),而卷積是基于整數(shù)位置的,所以需要通過線性插值算法獲取實際像素偏移位置。可以將2個一維線性插值分別用于特征圖的水平和垂直方向,實現(xiàn)雙線性插值,具體實現(xiàn)為:

x(p)=∑qG(q,p)·x(q);(3)

G(p,q)=g(q x,p x)·g(q y,p y)。(4)

式中:p為可形變卷積中的任意小數(shù)位置P 0+P n+ΔP n;g(a,b)=max(0,1-|a-b|)。

可形變卷積核的大小和位置可以根據(jù)當前圖像的內(nèi)容進行動態(tài)調(diào)整,直觀效果就是不同位置的卷積核采樣點位置會根據(jù)圖像內(nèi)容發(fā)生自適應變化,從而適應各種不同形狀、大小等幾何形變,更好地獲取檢測害蟲圖像所需的特征信息,從而提高檢測農(nóng)作物害蟲的精度。

1.3 混合池化

池化是對信息進行抽象的過程,而CNN幾乎都會使用池化操作來縮小特征圖的尺寸,這對于局部空間不變性和增大后續(xù)卷積的感受野是非常重要的。目前常見的池化操作有最大值池化(max pooling)和均值池化(mean pooling)。最大值池化是選取區(qū)域的最大值,能更好地保留紋理特征;均值池化是選取區(qū)域的平均值,能較好地保留整體數(shù)據(jù)的特征,突出背景信息。混合池化(mixed pooling,MXP)能結(jié)合最大值池化和均值池化的優(yōu)點,在保留紋理特征的同時也能突出背景特征,引入的計算和內(nèi)存開銷很小。在混合池化的基礎上,對害蟲檢測的模型進一步改進。

混合池化的計算公式如下:

f mix(x)=a·f max(x)+(1-a)f avg(x),a∈[0,1]。(5)

當a=0時,f mix(x)是均值池化f avg(x);當a=1時,f mix(x)為最大池化f max(x)。f mix(x)對參數(shù)a求導,學習參數(shù),對樣本x i求導,學習得到權(quán)重。進行梯度更新時,損失函數(shù)E的求導表示為:

E a= E f mix(x)· f mix(x) a=δ·maxix i-1N∑Ni=1x i;(6)

E x i= E f mix(x)· f min(x) x i=δ·a+(1-a)1N,當x i=maxix i

δ·(1-a)1N,當x i≠maxix。(7)

式中:δ= E f mix(x)為上一層傳遞回來的誤差。

1.4 改進的可形變?nèi)矸e神經(jīng)網(wǎng)絡

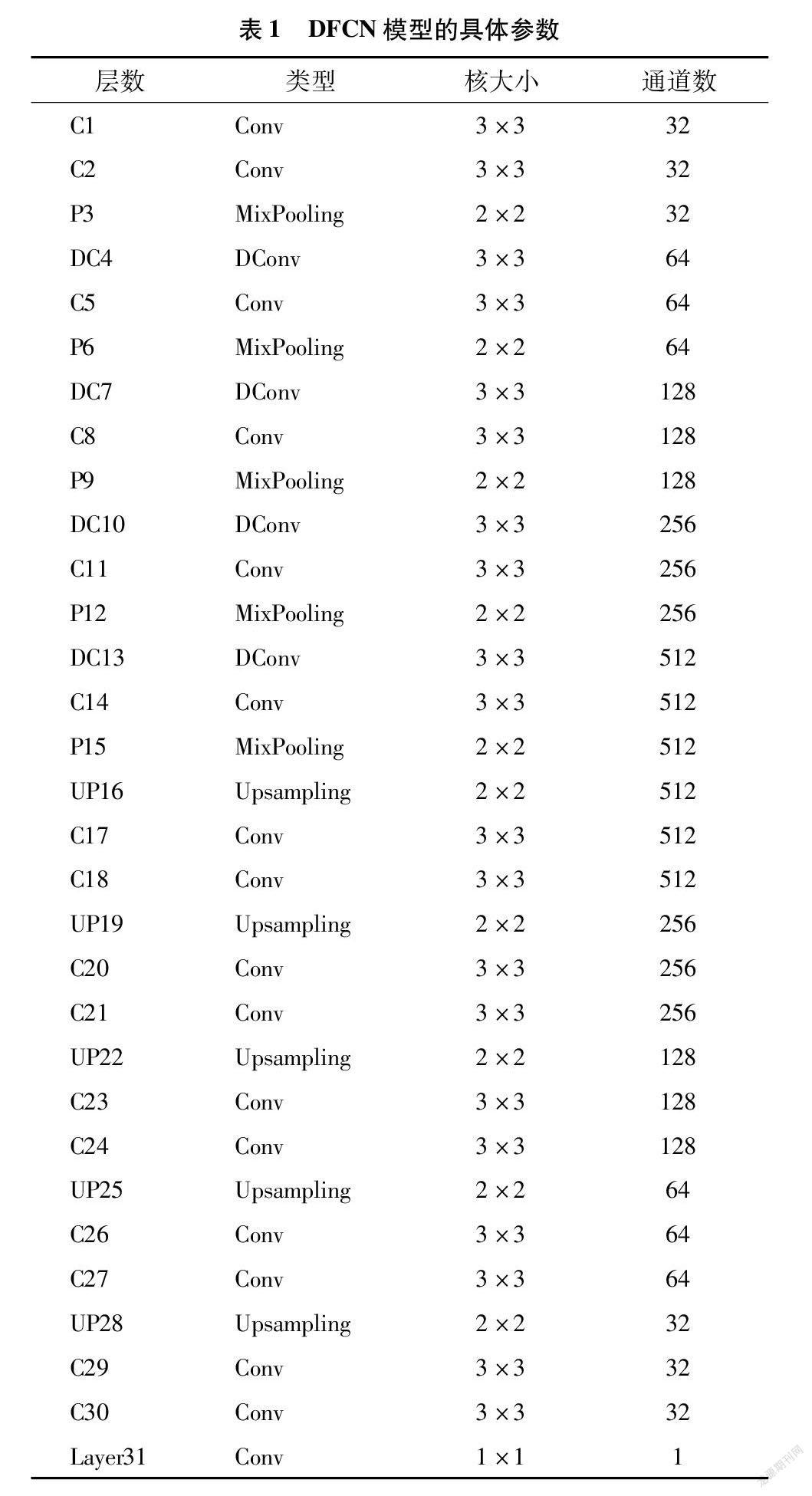

本研究提出的一種改進可形變?nèi)矸e神經(jīng)網(wǎng)絡(deformable fully convolution network,DFCN)的農(nóng)作物害蟲檢測方法主要由編碼和解碼2個部分組成。編碼模塊是在傳統(tǒng)的VGG16基礎上擴展改進,由常規(guī)卷積層、可形變卷積層、批歸一化層和激活層構(gòu)成,并在這些結(jié)構(gòu)后添加混合池化層。池化層相當于下采樣操作,所以此時輸出的特征圖分辨率小于原始圖。解碼與編碼相互對稱,主要進行上采樣操作得到稀疏特征圖,然后將稀疏特征圖反卷積操作得到密集的特征圖,圖像逐步恢復至原圖像大小。害蟲檢測問題實際就是害蟲的2個分類問題(害蟲區(qū)域和背景區(qū)域),所以解碼模塊最后加入 1×1 卷積層,完成害蟲區(qū)域的分割。DFCN模型結(jié)構(gòu)如圖4所示。

編碼模塊中只采用10層卷積,減少了原始VGG16的卷積層數(shù),使模型訓練速度加快。在編碼模塊中應用了4個可形變卷積層(DConv),能夠有效地適應田間害蟲圖像的多樣性。同時將下采樣的最大池化全部更改為混合池化,在保留紋理特征的基礎上也能保留背景特征,最大可能地減少特征學習過程中信息的丟失。常規(guī)卷積層(Conv)大小設置為3×3,步長為1,其后加入批歸一化層(Batch Normalisation)和激活層(RELU)。池化層大小設置為2×2,步長為2。可形變卷積大小也設置為3×3。解碼與編碼對稱,包括常規(guī)卷積層、上采樣層(up sampling)和Softmax分類器,上采樣的采樣尺度統(tǒng)一設置為2。表1為DFCN的具體參數(shù)情況。

2 試驗與結(jié)果

2.1 試驗環(huán)境搭建及參數(shù)設置

為了驗證提出算法對田間農(nóng)作物害蟲檢測的有效性,試驗基于實際采集的害蟲圖像及擴充的數(shù)據(jù)庫集,與分割模型FCN和SegNet進行試驗比較。所有試驗都使用TensorFlow作為深度學習框架,用Python3.7編程開發(fā)語言,系統(tǒng)的操作環(huán)境是Windows10 64 Bit,硬件開發(fā)環(huán)境為Intel Xeon E5-2643v3 @3.40 GHz CPU,64 GB內(nèi)存,顯卡NVidia Quadro M4000 GPU。

在對網(wǎng)絡模型進行訓練過程中,數(shù)據(jù)集中的每幅害蟲圖像都參與50次測試,最終害蟲檢測的準確率是統(tǒng)計了圖像50次試驗檢測率的平均值、訓練平均時間和測試平均時間。模型采用帶動量因子的小批量隨機梯度下降算法(stochastic gradient descent,SGD)對網(wǎng)絡模型進行訓練,采用(RELU)作為激活函數(shù)以保證模型的非線性能力,將初始學習率設置為0.01,動量因子設置為0.9,Batch size設置為12,將模型進行1 200次迭代后設置學習率為0.001。

在分割效果指標的量化過程中,使用平均精度均值 (mean average precision,MAP)和平均交并比(mean region intersection over union,Mean IOU)進行評價。具體的計算公式如下:

MAP=∑Ki=1AP(i)K×100%;(8)

MeanIOU=1c cl∑pn ppt p+∑ qn pq-n pp。(9)

式中:AP(i)表示第i類農(nóng)作物害蟲的平均精度;K為農(nóng)作物害蟲總類別數(shù);n cl為分割圖像像素所屬類別;p表示圖像中像素正確對應的像素類別;q表示圖像中像素錯誤分類后所屬像素類別;t p為分割結(jié)果中p類別的像素總數(shù);n pp為分割結(jié)果中正確分割為類別p的像素總數(shù);n pq為分割結(jié)果中本屬于類別p但被誤分為q的像素數(shù)量。

在農(nóng)作物害蟲分割的實際應用中,實時性也是一個較為重要的指標,所以本研究也將單幅圖像分割時間作為評估標準。

2.2 試驗驗證

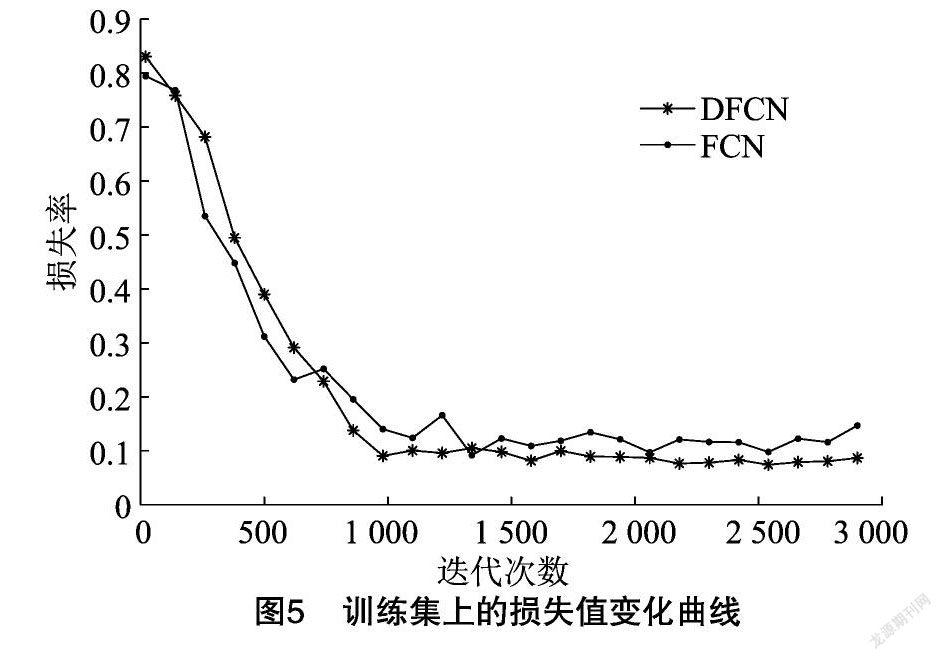

在試驗過程中采用批量訓練方式。將構(gòu)建后的訓練集和測試集圖像以批次(Batch)的形式送入網(wǎng)絡模型中,訓練集中共包含6 500幅圖像,將每50幅圖像分為一個批次,完成模型的訓練共需要130個批次。為保障模型的訓練效率以及分割精度,使用訓練集圖像對模型進行100次遍歷(Epoch),模型的迭代次數(shù)設置為3 000次。使用梯度下降和反向傳播算法對模型的權(quán)重參數(shù)進行更新,將學習率設置為1×10-5。由于使用帶動量的梯度下降算法,為防止模型出現(xiàn)過擬合現(xiàn)象,設置動量因子為0.9。利用驗證集對模型權(quán)重參數(shù)進行局部修正。為了表明DFCN的優(yōu)勢,將DFCN與經(jīng)典FCN進行比較。圖5為FCN和DFCN在訓練集上的損失值變化曲線。由圖5可以看出,與FCN相比,DFCN的收斂比較快,當?shù)螖?shù)大于1 500時,DFCN基本收斂,曲線比較平穩(wěn)。本研究選擇迭代次數(shù)為2 200時的DFCN模型進行害蟲檢測試驗。

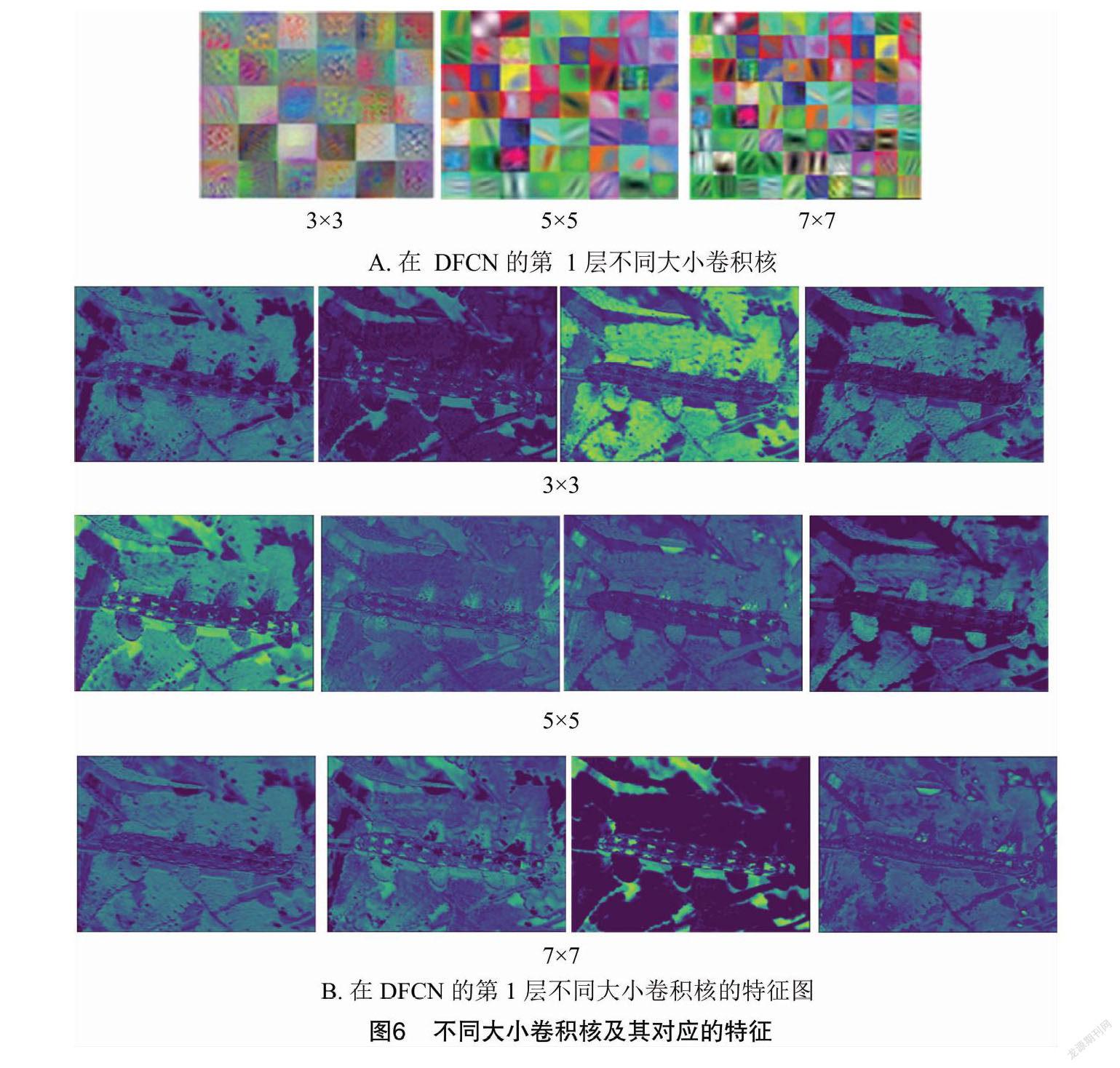

為了更好地理解分析網(wǎng)絡,先對卷積核進行可視化。全卷積神經(jīng)網(wǎng)絡分別采用大小為3×3、5×5和7×7的不同卷積核訓練模型得到圖6所示的卷積核及其對應的特征圖。

由圖6可以看出,較小的卷積核局部感受野小,包含了更多的特征細節(jié)信息,而卷積核大的局部感受野雖大,但不能充分表現(xiàn)害蟲圖像的細節(jié)。由于害蟲在圖像中所占的區(qū)域較小,所以在DFCN中使用3×3的卷積核提取害蟲的感興趣特征,更好地反映害蟲的特征信息。

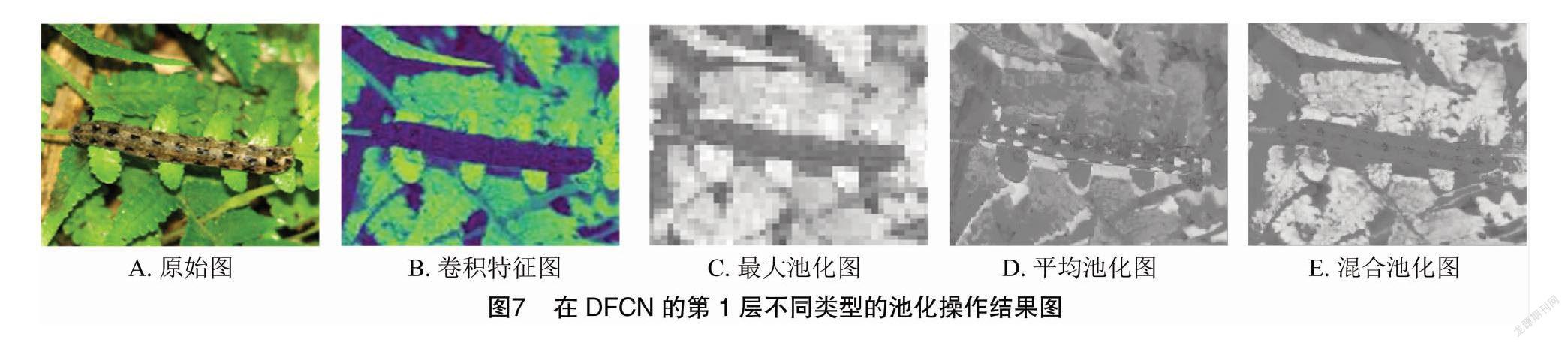

表2為不同卷積核大小和不同池化得到的檢測結(jié)果,圖7為各種不同池化在害蟲圖像上的操作結(jié)果。由表2和圖7可以看出,在相同的池化類型條件下,無論卷積核大小,混合池化的效果都要優(yōu)于最大池化和平均池化。不同尺寸的卷積核對分割結(jié)果有很大影響。

為了更好地觀察模型的訓練效果,及時調(diào)整卷積層的設置參數(shù),將多個卷積層和池化層逐步提取的特征圖結(jié)果進行輸出,可以看到模型在每一層中利用卷積所得到的特征提取效果。圖8是卷積核為3×3的可形變卷積和常規(guī)CNN的卷積核為3×3卷積的第一個卷積層上的5幅特征圖。可以看出可形變卷積的特征圖相較于常規(guī)CNN的卷積特征圖更能反映害蟲的基本特征。

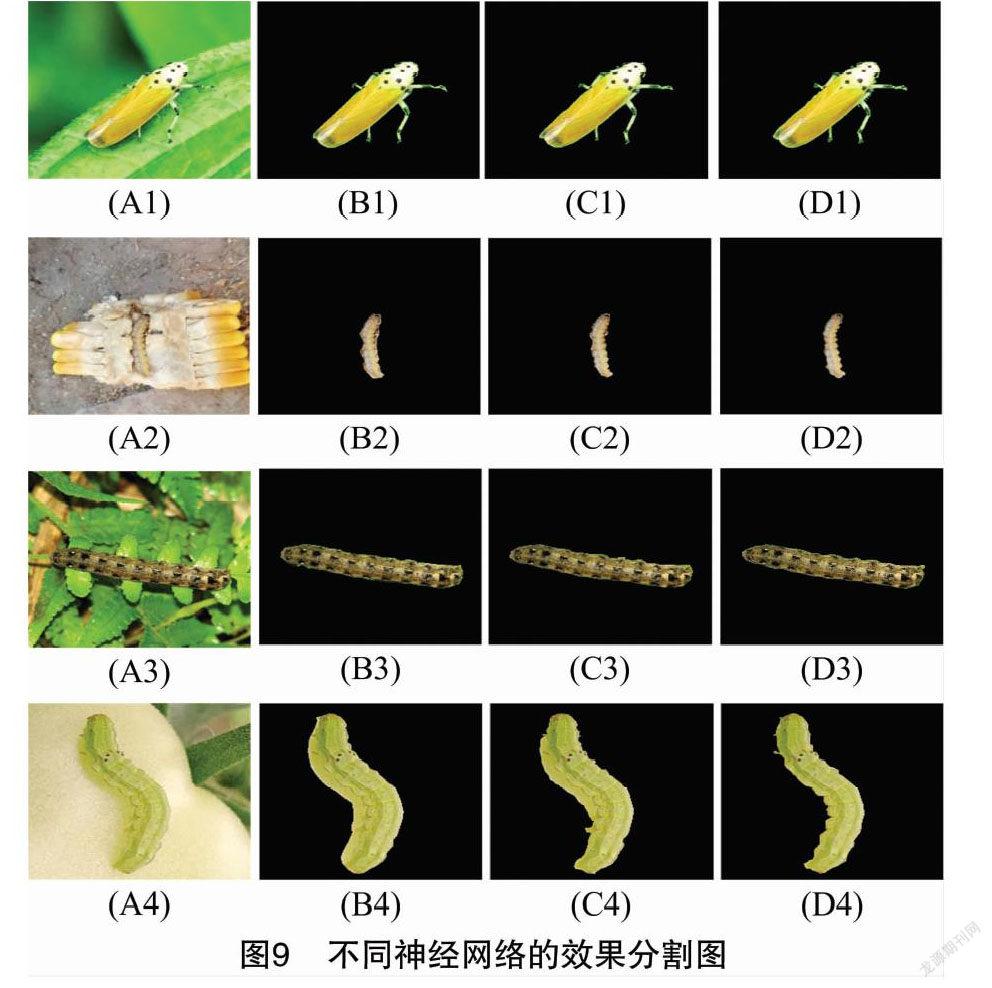

為了驗證改進的可形變?nèi)矸e神經(jīng)網(wǎng)絡在害蟲檢測上的有效性,在實際采集到的田間害蟲圖像數(shù)據(jù)庫及其擴展數(shù)據(jù)庫上分別進行試驗,與常見語義分割模型FCN和SegNet進行了試驗比較。圖9是害蟲分割的效果圖,其中(A)是原圖,(B)是FCN效果分割圖,(C)是SegNet效果分割圖,(D)是DFCN效果分割圖。

從圖9中直觀可以看出,DFCN模型分割的害蟲輪廓邊緣較清楚。特別從圖9中A4~D4可以看出FCN等一些方法,將害蟲的陰影部分錯分為害蟲本身,而DFCN對于這些地方并沒有誤分,同時細節(jié)信息保留得較好。這是因為DFCN中引入了可形變卷積,能適應害蟲復雜的幾何形變,同時混合池化最大限度地保留了輪廓信息和細節(jié)信息,使學習到的特征更易于害蟲的分割。

圖10為基于FCN、SegNet和DFCN模型在擴展的害蟲圖像集上的訓練分割精度隨迭代次數(shù)的變化情況。在前1 000次迭代時3個模型的分割精度都有較大幅度的增加,而在1 000次后,DFCN的上升幅度比FCN和SegNet快得多,且2 000次后DFCN整體上升趨勢較為穩(wěn)定,說明趨于收斂。由圖5至圖10的結(jié)果可知,DFCN提取的特征圖和收斂性能優(yōu)于FCN和SegNet,這是因為DFCN使用了可變形卷積和混合池化。由于分割時間是評價模型實用性的關(guān)鍵技術(shù)指標,使用單幅圖像分割時間作為衡量分割速度的時間指標。為了進一步表明DFCN的分割性能,將DFCN與FCN和SegNet進行比較。選擇迭代次數(shù)為3 000時的DFCN、FCN和SegNet為訓練好的3個模型,分別進行害蟲分割試驗。表3給出了基于3種方法的平均精度均值(MAP)、平均交并比(IOU)和單幅圖像分割時間。

在分割結(jié)果和單幅圖像分割時間上,表3表明DFCN比其他2種方法更有效。主要原因是DFCN采用了可分離卷積架構(gòu)。由于SegNet使用空洞卷積方式對網(wǎng)絡模型進行構(gòu)造,所以網(wǎng)絡模型需要耗費大量的訓練時間,導致模型分割效率下降,對單幅圖像的分割時間較長,為0.52 s。

3 結(jié)論

針對田間農(nóng)作物害蟲由于圖像形變導致檢測準確率較低的問題,提出一種改進可形變?nèi)矸e神經(jīng)網(wǎng)絡的方法,該方法主要由編碼模塊和解碼模塊組成。編碼模塊在VGG16上引入4個可形變卷積層,兼顧了害蟲尺寸大小和形態(tài)等多樣性,提高了模型對幾何形變害蟲圖像的特征提取能力。模型中采用了混合池化,最大化地保留了圖像的紋理特征和背景特征,有效地提高了害蟲檢測的準確率,分割精確度和平均交分別為90.43、78.16,比SegNet 分別提高了3.27、3.72,識別時間為0.36 s,比SegNet 加快了0.16 s。提出的方法不需要額外的監(jiān)督信息就能獲得較多有效的田間害蟲特征信息。研究通過試驗驗證了提出方法在形變蟲害圖像檢測的有效性,為復雜環(huán)境下的農(nóng)作物害蟲檢測提供了理論參考。

參考文獻:

[1]宋麗娟. 基于圖像的農(nóng)作物病害識別關(guān)鍵算法研究[D]. 西安:西北大學,2018.

[2]鄭方梅. 基于卷積神經(jīng)網(wǎng)絡的農(nóng)作物病害圖像識別研究[D]. 重慶:重慶師范大學,2019.

[3]衛(wèi)智熠. 基于卷積神經(jīng)網(wǎng)絡的可見光圖像農(nóng)作物病蟲害的檢測[D]. 哈爾濱:哈爾濱工業(yè)大學,2017.

[4]黃文江,張競成,師 越,等. 作物病蟲害遙感監(jiān)測與預測研究進展[J]. 南京信息工程大學學報(自然科學版),2018,10(1):30-43.

[5]劉思佳. 基于視覺的農(nóng)作物病蟲害自主識別系統(tǒng)研究[D]. 唐山:華北理工大學,2020.

[6]趙志焱,楊 華,胡志偉,等. 基于TACNN的玉露香梨葉蟲害識別[J]. 計算機工程與應用,2021,57(9):176-181.

[7]Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM,2017,60(6):84-90.

[8]Zhou X Y,Pan Z S,Hu G Y,et al. Stock market prediction on high-frequency data using generative adversarial nets[J]. Mathematical Problems in Engineering,2018,2018:1-11.

[9]王 鐸,溫長吉,王希龍,等. 基于深度卷積條件生成對抗網(wǎng)絡的蟲害分類算法研究[J]. 中國農(nóng)機化學報,2020,41(6):179-187.

[10]Schmidhuber J. Deep learning in neural networks:an overview[J]. Neural Networks,2015,61:85-117.

[11]Cao X,Wei Z Y,Gao Y J,et al. Recognition of common insect in field based on deep learning[J]. Journal of Physics:Conference Series,2020,1634(1):012034.

[12]李 靜,陳桂芬,安 宇. 基于優(yōu)化卷積神經(jīng)網(wǎng)絡的玉米螟蟲害圖像識別[J]. 華南農(nóng)業(yè)大學學報,2020,41(3):110-116.

[13]趙立新,侯發(fā)東,呂正超,等. 基于遷移學習的棉花葉部病蟲害圖像識別[J]. 農(nóng)業(yè)工程學報,2020,36(7):184-191.

[14]李衡霞,龍陳鋒,曾 蒙,等. 一種基于深度卷積神經(jīng)網(wǎng)絡的油菜蟲害檢測方法[J]. 湖南農(nóng)業(yè)大學學報(自然科學版),2019,45(5):560-564.

[15]He K M,Zhang X Y,Ren S Q,et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,37(9):1904-1916.

[16]Redmon J,F(xiàn)arhadi A. YOLOv3:an incremental improvement[EB/OL]. (2018-04-08)[2021-08-05]. https://arxiv.org/abs/1804.02767.

[17]張 博,張苗輝,陳運忠. 基于空間金字塔池化和深度卷積神經(jīng)網(wǎng)絡的作物害蟲識別[J]. 農(nóng)業(yè)工程學報,2019,35(19):209-215.

[18]Shelhamer E,Long J,Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[19]Mahapatra D,Roy P K,Sedai S M,et al. Retinal image quality classification using saliency maps and CNNs[C]//Machine Learning in Medical Imaging,2016:172-179.

[20]劉文定,田洪寶,謝將劍,等. 基于全卷積神經(jīng)網(wǎng)絡的林區(qū)航拍圖像蟲害區(qū)域識別方法[J]. 農(nóng)業(yè)機械學報,2019,50(3):179-185.

[21]張苗輝,李俊輝,李佩琛. 基于深度學習和稀疏表示的害蟲識別算法[J]. 河南大學學報(自然科學版),2018,48(2):207-213.

[22]Fuentes A,Yoon S,Kim S C,et al. A robust deep-learning-based detector for real-time tomato plant diseases and pests recognition[J]. Sensors,2017,17(9):2022.

[23]梁萬杰,曹宏鑫. 基于卷積神經(jīng)網(wǎng)絡的水稻蟲害識別[J]. 江蘇農(nóng)業(yè)科學,2017,45(20):241-243,253.

[24]Ding W G,Taylor G.Automatic moth detection from trap images for pest management[J]. Computers and Electronics in Agriculture,2016,123:17-28.

[25]Wang Q C,Zheng Y J,Yang G P,et al. Multiscale rotation-invariant convolutional neural networks for lung texture classification[J]. IEEE Journal of Biomedical and Health Informatics,2018,22(1):184-195.

[26]Dai J F,Qi H Z,Xiong Y W,et al. Deformable convolutional networks[C]//2017 IEEE International Conference on Computer Vision,2017:764-773.