結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼方法

曾志賢, 曹建軍, 翁年鳳, 蔣國權, 范強

(1.國防科技大學 計算機學院, 湖南 長沙 410003; 2.國防科技大學 第六十三研究所, 江蘇 南京 210007)

0 引言

近年來,隨著視頻分享軟件的崛起,如快手、抖音、微視等,現實生活中產生了越來越多的視頻- 文本數據。在這種情況下,如何對大量的視頻- 文本信息進行實體分辨以滿足人們對不同模態信息的需求,面臨巨大挑戰。跨模態實體分辨針對不同模態數據間的模態鴻溝和語義鴻溝問題,采用共同嵌入空間、語義對齊、語義關聯等方法,旨在從不同模態數據中識別出對同一客觀實體的描述。視頻- 文本作為多模態數據的重要組成部分,應該得到足夠的關注和廣泛的研究。

現有的視頻- 文本跨模態實體分辨方法主要包含傳統方法和深度學習相關的方法。傳統方法主要是基于關鍵字搜索的方法,該方法對每個視頻通過人工標記的方法預先標記與視頻內容密切相關的關鍵詞,然后利用與文本單模態檢索相同的方法進行跨模態實體分辨。然而,傳統方法不僅始終無法脫離人工標注的過程,而且由于人工標注的關鍵字通常是獨立的和非結構化的,導致關鍵字中幾乎沒有關于視頻的細粒度特征,例如紅色的轎車、穿著藍色球衣的男運動員等,對視頻- 文本跨模態實體分辨性能提高有限。在深度學習相關的方法中,一般應用人工神經網絡構建跨模態間的語義關聯,進行跨模態實體分辨。

由于深度學習強大的非線性學習能力,深度學習相關的跨模態實體分辨方法已經成為主流方法。該方法一般將不同模態的數據映射至共同嵌入空間,進行跨模態相似度的度量。根據采用的相似度度量的粒度不同,可以分為兩類。第1類將視頻和文本在共同空間中用一個全局向量表示,進行跨模態語義相似度度量。文獻[9]應用詞向量和句向量、二維卷積、三維卷積分別對文本、圖像和視頻進行全局編碼,然后在共同空間學習跨模態數據統一表征。文獻[10,12]提出一種雙重編碼方法,該方法首次采用一種多級編碼方法,通過挖掘視頻和文本中全局、局部和時序特征信息,形成各模態數據的編碼表示,進而學習不同模態數據的統一表征。然而,雖然該類方法與傳統方法相比,在性能上有了很大提升,但是該類方法忽略了視頻和文本中的細粒度信息,不能進行跨模態間的細粒度語義對齊,導致性能提升有限。為解決這個問題,第2類主要采用與圖像- 文本中細粒度處理相似的方法,對視頻中的每一幀和文本描述中的每個詞進行細粒度的語義對齊。文獻[16]首次將圖注意力機制應用于構建視頻和文本模態內的語義關聯,并在共同空間中進行多級語義對齊。盡管視頻- 文本跨模態實體分辨中的第1類雙重多級編碼方法和第2類細粒度語義對齊屬于不同類型,但其本質都是利用模態中不同層級的信息進行跨模態語義對齊。

然而,現有的視頻- 文本跨模態實體分辨方法在對視頻處理中均采用均勻取幀的方法,這種方法抽取的幀集合通常缺少視頻中的某些關鍵信息,不足以表征視頻的全部內容,同時由于均勻取幀的方法抽取的幀數較多,也增加了模型的復雜度。

為解決以上問題,本文提出一種結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼方法(DEIKFE)。首先,設計關鍵幀提取算法,在充分保留視頻信息的同時降低取幀數量;然后,通過雙重編碼方法提取視頻和文本的多級特征編碼表示,采用共同空間學習的方法學習視頻和文本跨模態數據的統一表征。本文的主要貢獻如下:

1)提出了一種結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼模型。設計關鍵幀提取算法提取關鍵幀,利用雙重編碼方法對視頻和文本數據進行多級編碼,提高實體分辨性能。

2)首次將關鍵幀提取方法與現有的視頻- 文本跨模態實體分辨相結合,設計關鍵幀集合相似度最小化的關鍵幀提取方法,在充分保留視頻信息的同時降低所需幀的數量,提高現有方法的性能,證明了關鍵幀提取的有效性。

3)與現有的方法進行對比,結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼模型取得了最好的性能,證明了該方法的優越性。

1 問題描述

視頻集={,,…,,…,},其中表示集合中第個視頻,為視頻集中視頻的個數,的關鍵幀集合特征表示為={,,…,,…,},為第個視頻中提取的關鍵幀數量,關鍵幀按在視頻中的時序排列,為視頻中第個關鍵幀的特征表示。文本集={,,…,, …,},其中表示文本集中第個文本描述,為文本集合中文本描述的數量,={,, …,, …,},為該文本描述中所包含的詞數量,為文本中第個單詞的特征表示。

視頻- 文本跨模態實體分辨的目的是構建視頻集與文本集的對應關系,即(,)={〈,〉|∈,∈,?},其中?表示兩個模態數據與,是對同一客觀實體的描述。

2 方法描述

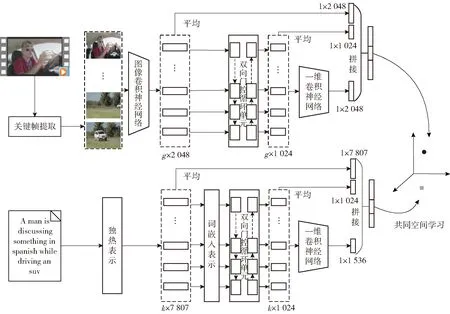

如圖1所示,結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼模型主要包含視頻關鍵幀提取、視頻多級編碼、文本多級編碼和共同空間學習4部分。其中,關鍵幀提取方法為本文設計的方法,采用相似度最小化方法提取視頻關鍵幀集合表示,該集合為原視頻幀集合的子集;視頻和文本編碼方法采用與文獻[11]相同的雙重編碼模型,提取視頻和文本由粗糙到精細不同層級的特征表示;共同空間學習采用強負樣本三元組損失進行網絡參數優化,實現視頻- 文本的跨模態語義關聯。下面對4部分進行詳細介紹。

圖1 結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼模型Fig.1 DEIKFE for video-text cross-modal entity resolution

2.1 視頻關鍵幀提取

視頻關鍵幀提取的目的是在盡可能減少視頻幀的情況下保留視頻原有的語義信息,即提取視頻中相似度差異最大的幀,同時保留對視頻信息的表征。因此,本文設計了基于相似度最小化的關鍵幀提取方法。表1所示為視頻幀提取算法結果示例。

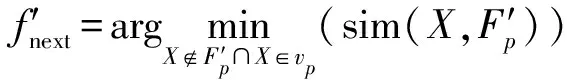

設視頻中的所有幀可以表示為={,,…,,…,},其中為視頻中幀的數量,為視頻中的第幀表示,初始關鍵幀集合為空集′={},選擇的下一關鍵幀可以表示為′。假定關鍵幀集合中的第1幀從視頻中隨機選取,則下一關鍵幀的選擇過程可以通過(1)式計算求得:

(1)

式中:sim(,′)的計算可以通過(2)式求得,

(2)

表1 視頻幀提取算法結果示例

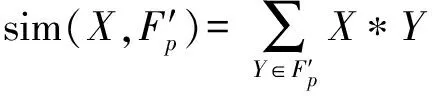

表示當前選中的視頻幀,表示關鍵幀集合中的一幀, *表示皮爾遜相關系數計算,計算結果為幀間相似性大小,幀間相似性的值越大,表示越相似,如(3)式所示:

(3)

′=′∪{′}

(4)

求視頻關鍵幀集合的過程如算法1所示。

相似度最小化的關鍵幀提取方法。

輸入:視頻中的所有幀={,, …,, …,},關鍵幀集合′,關鍵幀數量。

輸出:視頻關鍵幀集合′={′,′, …,′, …,′}

Begin

初始化:′={};

for=1:

{if==1

{從視頻中隨機抽取第1幀為關鍵幀′,更新′={′},并在視頻中移除該幀=-{′};

}

else

{根據(2)式計算中每一幀與關鍵幀集合的相似度;根據(1)式挑選下一幀關鍵幀′;更新′=′+{′},并在視頻中移除該幀=-{′};

}

}

對′中的關鍵幀,按在視頻中的時序進行排序,得出視頻關鍵幀集合′={′,′,…,′,…,′}

End

為更直觀地比較本文設計的關鍵幀提取算法與現有常用取幀方法之間的差異,直觀感受關鍵幀提取算法的優越性,表1列舉一個視頻例子,分別給出應用關鍵幀提取算法提取5幀和10幀,以及均勻取幀和幀間差分法——改進的幀間差分和高斯模型(IDM)提取20幀的效果。IDM中,設幀間差的閾值為065。從表1中可以看出:均勻取幀容易缺失視頻中某些場景的幀,導致在表征視頻原有內容時出現信息缺失的問題;IDM在提取幀時由于無平移不變性,容易導致視頻中具有位移的場景重復幀較多,而且在具有較復雜場景的視頻中容易出現缺幀和漏幀的情況;與之相比,本文設計的關鍵幀提取算法能夠有效提取表征視頻信息的關鍵幀,而且在關鍵幀數量比較大但又不過大時,如取10幀,存在可以記錄視頻中連續的動作等序列化信息的幀。

2.2 視頻多級編碼

如圖1所示,視頻多級編碼方法提取了視頻3個層級的特征信息,分別為全局、局部和時序相關的特征。給定視頻關鍵幀集合′,對于視頻幀的特征提取,一般采用在ImageNet數據集中預訓練的卷積神經網絡(CNN)ResNet或在視頻數據集中預訓練的三維CNN對視頻進行特征提取,形成視頻的特征表示,如(5)式所示:

={,,…,,…,}=(′)

(5)

221 視頻全局特征編碼

在全局特征編碼上,現有的一般方法均采用均勻池化或加權求和的方法,保持與文獻[11]的一致性,采用均勻池化的方法求視頻的全局特征表示,如(6) 式所示:

(6)

2.2.2 視頻序列化特征編碼

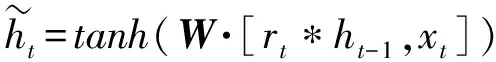

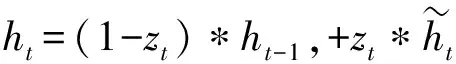

現有的大量工作已經證實,雙向長短時記憶(Bi-LSTM)網絡、雙向門控循環單元(Bi-GRU)網絡能夠有效地處理時序問題。因此,本文采用Bi-GRU網絡學習視頻序列化語義信息,該方法比Bi-LSTM網絡參數少,需要的訓練數據也更少,且效果更好。該網絡包含一個前向GRU網絡和一個反向GRU網絡,每個GRU皆由GRU單元構成,對于每個GRU單元,其遞歸更新的過程可以表示為(7)式~(10)式:

=(·[-1,])

(7)

=(·[-1,])

(8)

(9)

(10)

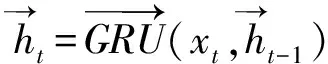

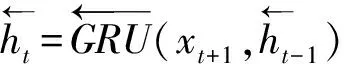

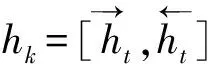

Bi-GRU網絡的輸出可以表示為={,,…,,…,},其中表示為第幀對應輸出的特征表示,可以表示為GRU前向門與后向門的輸出的組合,如(11)式~(13)式:

(11)

(12)

(13)

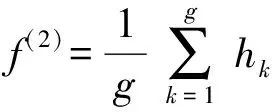

通過雙向門控循環單元,可以生成每一幀之間的序列化表示,然后利用平均池化的方法獲得視頻的序列化特征表示,如(14)式所示:

(14)

223 視頻局部特征編碼

由于視頻的序列化特征表示只是視頻關鍵幀序列化特征的平均,關注點在于視頻的時序特征。因此,有必要提取視頻中的局部特征,在提取方法上采用與文本分類處理相似的一維CNN。

在細節處理上,為了從不同大小的視角提取視頻關鍵幀的細粒度特征,分別設計不同大小的一維CNN。設卷積核的大小為×1,其中為卷積核第1維大小,即視覺感知大小,分別設置=2,3,4,5的4個卷積核,以利于在不同視角關注特征,其中每個卷積核的步長為2,輸入維度為×1 024,輸出大小為×512,對輸出采用非線性激活函數進行非線性映射,然后采用最大池化的方法將特征壓縮為512。對于每個卷積核的輸出進行拼接,形成視頻局部特征表示,如(15)式和(16)式所示:

=max-pooling((1-dCNN()))

(15)

=[,,,]

(16)

式中:[,,,]表示拼接,即前后元素相連接,如=[01, 02],=[03, 04],=[05, 06],=[07, 08];=[01, 02, 03, 04, 05, 06, 07, 08]。

224 視頻多級編碼表示

由于視頻全局、序列化、局部特征編碼為視頻不同層級特征的編碼,對視頻具有不同的表征作用。因此,采用將三者拼接的方式獲得視頻多級特征編碼表示,如(17)式所示:

l=[,,]

(17)

2.3 文本多級編碼

文本多級編碼方法與視頻多級編碼方法是對稱的,但也有些許不同,下面對不同之處進行描述。

文本的全局特征為詞的獨熱表示的平均,采用傳統的詞袋模型,詞的多少決定了全局特征維度的大小,如在圖1中,表示有7 807個已知且統計的詞;文本的序列化特征通過Bi-GRU提取,在詞嵌入的處理上,采用文獻[25]在30 M的Flick圖像- 文本標簽數據集中預訓練的詞向量模型;文本局部特征采用3個(分別取值2,3,4)的一維 CNN。最后,通過將不同層級的特征進行拼接形成文本的多級特征編碼表示,如(18)式所示:

l=[,,]

(18)

2.4 共同空間學習

由于視頻和文本的多級編碼表示不在同一維度空間,不能直接進行相似度的度量和比較。因此,首先分別采用全連接網絡將兩個模態的數據映射至一個同維度的共同嵌入空間。如(19)式、(20)式所示:

()=(l)

(19)

()=(l)

(20)

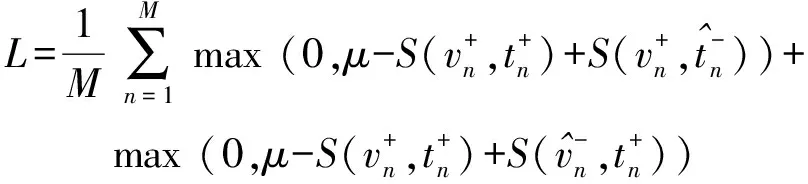

對于映射到同一空間中的視頻和文本數據,網絡模型優化目標是使得配對的視頻- 文本跨模態相似度盡可能大,而不配對的視頻- 文本相似度盡可能小,最大限度地學習模態間的語義關聯。因此,在跨模態語義關聯學習上,采用與VSE++相同的損失函數對模型參數進行優化,該損失只關注在每個批處理中最強的負樣本,而不關注其他負樣本,即強負樣本三元組損失函數,如(21)式所示:

(21)

3 實驗

3.1 實驗環境及參數設置

實驗環境如下:操作系統CentOS 7 64,GPU Nvidia Tesla P40,顯存24 GB,開發環境Python 3.6.5、Torch 1.6.0。

實驗中,批處理大小為128,閾值=0.2,Bi-GRU隱藏單元向量維度為512,嵌入共同空間的維度為2 048,詞袋模型中只統計詞頻不小于5的單詞。與文獻[25]相同,學習率為0.000 1,采用隨機梯度下降的Adam優化器,并且設置在驗證誤差連續3個epochs不下降的情況下,學習率減半,即除以2,在連續10個epochs驗證精度不提升的情況下,提前終止訓練,最多訓練50個epochs。

為驗證關鍵幀提取的幀數對跨模態實體分辨性能的影響,分別取值為5、10、15、20。

3.2 數據準備

為驗證DEIKFE的有效性,選擇在視頻- 文本跨模態實體分辨中廣泛使用的MSR-VTT(Microsoft Research-Videoto Text)數據集和VATEX數據集進行實驗驗證。

3.2.1 MSR-VTT數據集

MSR-VTT數據集包含10 000個網絡視頻,其中每個視頻都標注了20條英文文本描述,總計200 000條文本描述。實驗中,與文獻[10,33]相同,選取6 537個視頻及其文本描述作為訓練集,497個視頻及其文本描述作為驗證集,余下的2 990個視頻及其文本描述作為測試集。采用ResNet152進行特征提取,并選取pool5層輸出的2 048維向量作為視頻幀的特征表示。

3.2.2 VATEX數據集

原始的VATEX數據集中,訓練集包含25 991個視頻,驗證集包含3 000個視頻,測試集包含6 000個視頻,其中每個視頻都包含10個中文文本描述和10個英文文本描述。由于原始的6 000個測試集視頻并未公布其對應的文本描述,實驗中與文獻[10,33]相同,原始數據集的訓練集不變,將3 000個測試視頻隨機等分,即1 500個視頻及其文本描述作為驗證集,1 500個視頻及其文本描述作為測試集。由于只能獲取該數據集I3D的特征表示,統計特征維度為×1 024,其中≤32,而且絕大多數都落在32,因此采用重復補全的方法,將所有維度都擴充為32×1 024,同樣采用關鍵幀提取方法對其進行處理。此時,視頻全局特征表示和Bi-GRU輸入特征維度均為1 024。

3.3 評價指標

實驗采用兩種檢索任務用于驗證DEIKFE的有效性:1)視頻匹配文本,在測試集中隨機選取一個視頻,檢索測試集中與之匹配的文本;2)文本匹配視頻,在測試集隨機選取一個文本,檢索測試集中與之匹配的視頻。

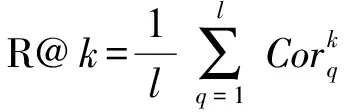

為了便于進行實驗對比,采用與文獻[10,30,33]相同的評價指標,包含R@、R@sum和MedR。下面對這些指標進行詳細介紹。

R@:為局部性能指標,表示根據查詢返回的結果中,相似度排名前(top-)中是否存在正確結果,可以用(22)式表示:

(22)

式中:表示查詢的數量;表示查詢結果,如果在排名前中存在正確結果則為1,否則為0。實驗中的取值為1、5、10。

R@sum:為總體性能指標,表示所有取值的R@之和。可以用(23)式表示。

(23)

式中:v2t表示視頻查詢文本;t2v表示文本查詢視頻。

MedR:表示測試集中所有查詢所得的正確結果相似度排名中位數的平均,體現了半數結果的排名情況。

3.4 實驗結果與分析

實驗與現有采用雙重編碼的5種方法進行對比,這些方法皆采用均勻取幀的方法,下面加以詳細介紹。

VSE:采用CNN和長短時記憶(LSTM)對視頻幀和文本進行特征提取,對提取的特征求平均,利用全連接層將其映射至共同空間,采用三元組損失進行語義關聯度量。

VSE++:特征提取和處理方式與VSE相同,不同在于改進了損失函數,采用強負樣本三元組損失進行語義關聯度量。

RNF:通過融合文本特征、視覺特征、動作特征和語音特征等多模態信息,并將正樣本的排名數融入強負樣本三元組損失進行語義相似度度量。

W2VV:采用詞向量工具和GRU網絡對文本進行編碼,采用CNN和視頻標簽對視頻進行編碼,而后在共同空間進行語義關聯學習。

Dual Encoding:采用雙重編碼方法對視頻和文本進行全局、局部和序列化特征的編碼,在共同空間中進行語義關聯學習。

為了對比分析方便,根據視頻和文本編碼粒度對方法進行分類:1)采用全局特征編碼的方法:VSE、VSE++;2)采用全局和序列化編碼的方法:RNF、W2VV;3)采用多級編碼的方法:Dual Encoding、DEIKFE;4)結合關鍵幀提取和多級編碼的方法:DEIKFE。

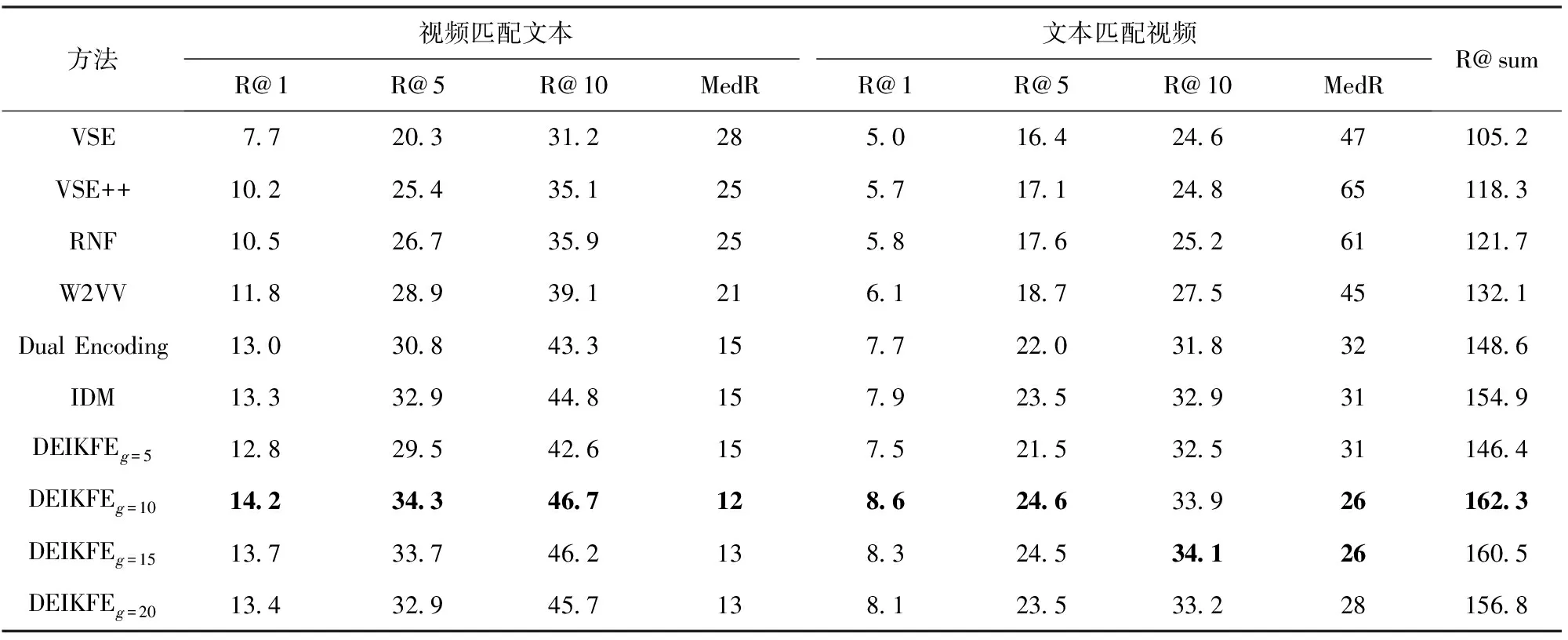

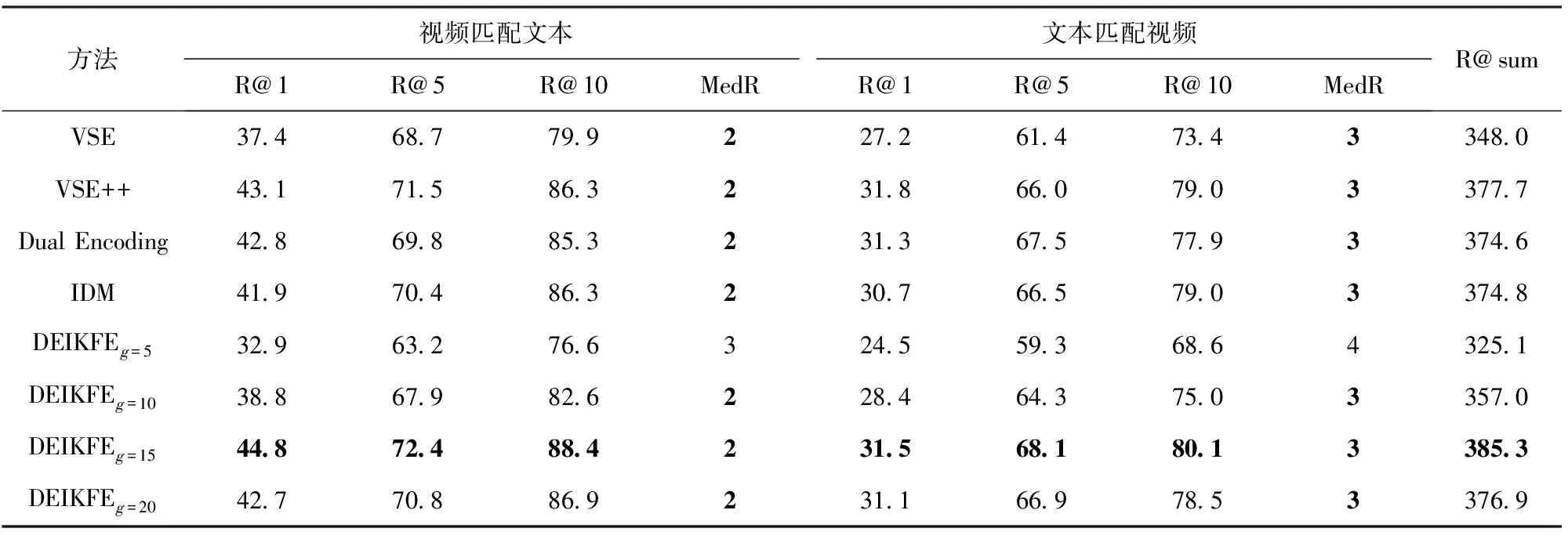

DEIKFE以及所有對比方法的結果如表2和表3所示。IDM為采用IDM進行關鍵幀提取的結果。

對比分析表2和表3可知:

結合關鍵幀提取與多級編碼的DEIKFE在所有性能指標上都達到了最優,優于其他對比方法:與同樣采用均勻取幀的多級編碼Dual Encoding對比,結合關鍵幀提取后,DEIKFE在MSR-VTT和VATEX兩個數據集中總體性能分別提升9.22%、2.86%;與采用IDM對比,在MSR-VTT和VATEX兩個數據集中總體性能分別提升了4.56%、2.80%。分析其中原因可知,雖然采用均勻取幀的多級編碼Dual Encoding能夠同時構建視頻和文本全局、局部和序列化特征,但是在視頻幀提取上,均勻取幀導致視頻信息缺失,實體分辨性能下降,而IDMIDM雖然優于均勻取幀,但是由于該方法對差分閾值的設定非常敏感,導致該方法不能盡可能多地提取視頻信息出現缺幀和漏幀的情況,性能提升有限。以上結果分析充分表明,結合關鍵幀提取的多級編碼方法能夠有效地提高實體分辨的性能。采用多級編碼的方法要優于只采用全局、局部和序列化中的一種或者兩種組合的特征編碼方法。采用多級編碼的Dual Encoding、DEIKFE優于VSE、VSE++、RNF、W2VV。分析可知,通過將視頻和文本不同層級的特征進行拼接,可以充分地表征模態數據信息,而采用其中的一種或者兩種都不足以表征完整的信息,導致性能下降。

表2 MSR-VTT數據集上跨模態實體分辨結果對比Tab.2 Comparison of cross-modal entity resolution results on MSR-VTT

表3 VATEX數據集上跨模態實體分辨結果對比Tab.3 Comparison of cross-modal entity resolution results on VATEX dataset

當取值為10和15時,DEIKFE分別在MSR-VTT和VATEX數據集中的性能達到最優。分析在不同關鍵幀數量下的結果可知,當關鍵幀數量較小時,即使能夠提取出視頻中不同場景的信息,但是卻不能記錄下視頻中的時序特征,對于動作理解的缺失,如跑步的先后動作,導致實體分辨性能降低;而當關鍵幀數量過多時,雖然能夠記錄下視頻中的時序特征,但是由于存在大量的冗余信息,導致模型訓練復雜度增大,而且在求平均過程中冗余信息大的特征所占權重大,而某些關鍵的特征可能因為無冗余而被忽略;只有當關鍵幀數量適中時,才能完整地記錄下視頻中的全局、局部和序列化特征,提高模型的性能。

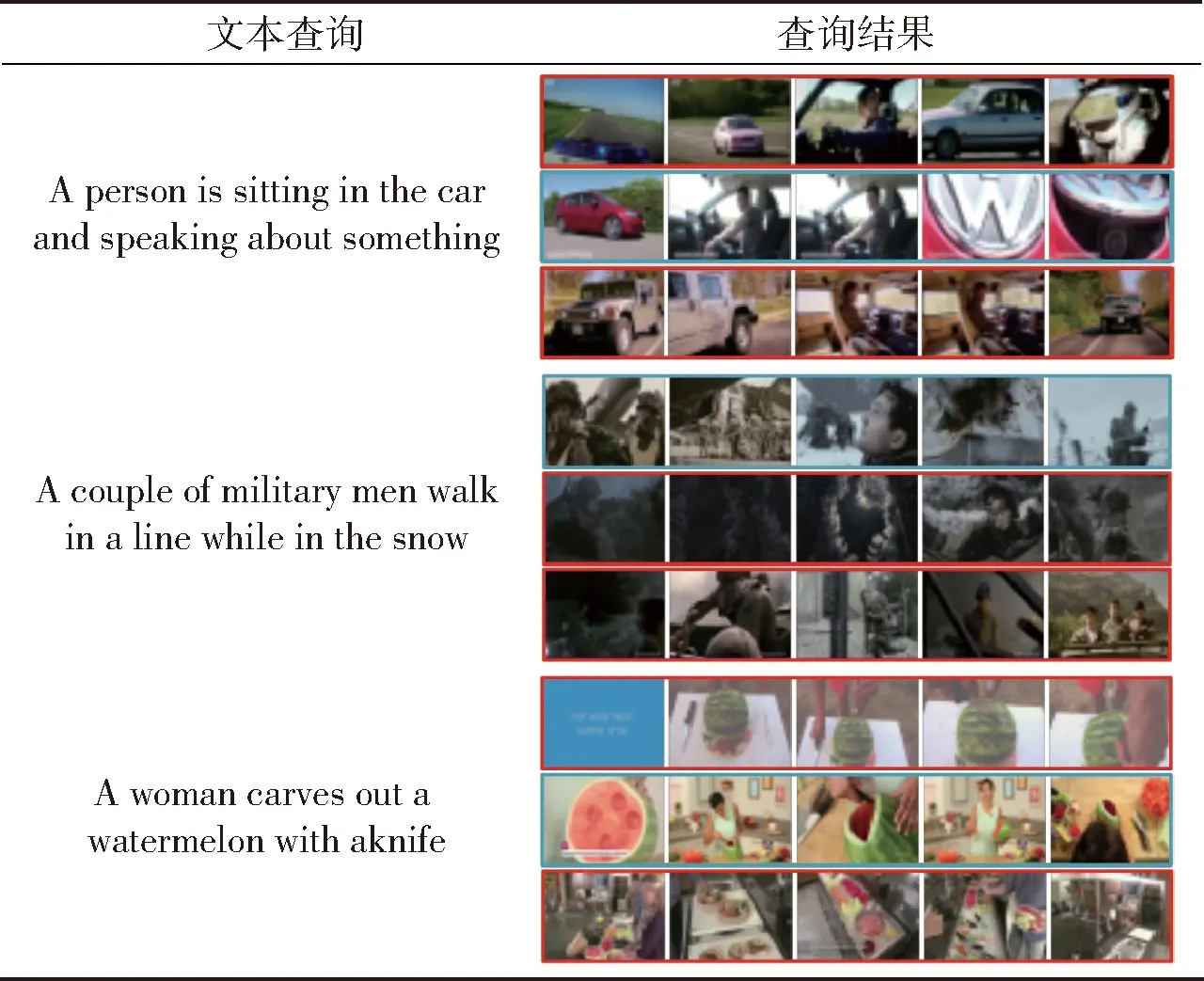

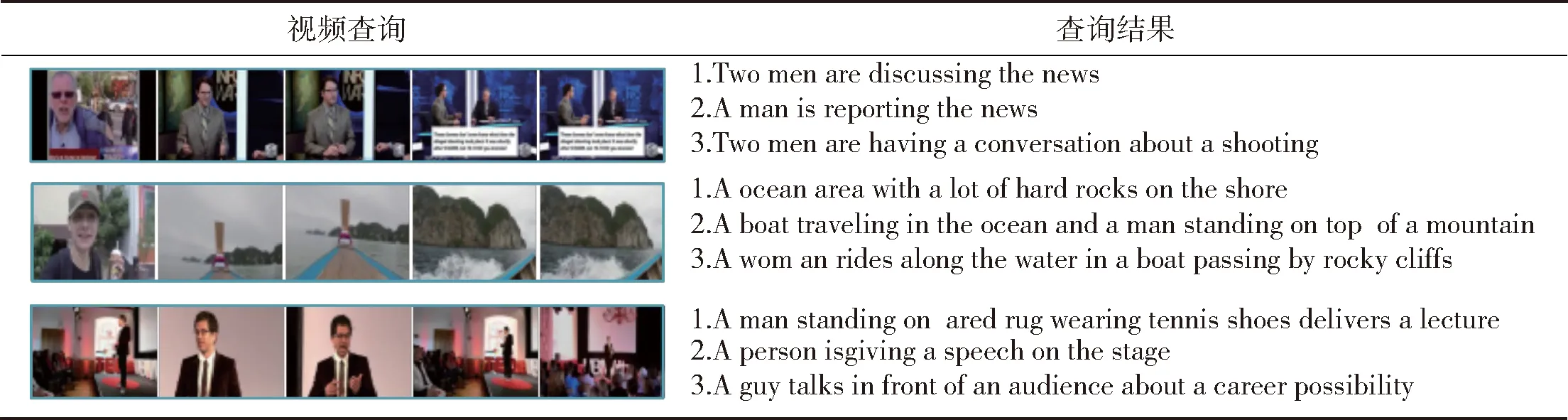

為更直觀地分析DEIKFE跨模態實體分辨的效果,表4和表5給出了DEIKFE在MSR-VTT數據集上文本匹配視頻與視頻匹配文本的例子,表中列出了與查詢視頻或文本相似度排名前3的文本描述或視頻對應的關鍵幀。對于每個查詢文本,有且僅有1個與之匹配的視頻,表中藍色方框為與文本描述相匹配的視頻,紅色方框為與文本描述不匹配的視頻;對于每個查詢視頻,表中藍色字體為正確的句子,紅色字體為錯誤匹配的結果。從表4中可以看出,在相似度排名前3的結果中,不論是文本匹配視頻還是視頻匹配文本,跨模態數據語義上都具有極高的相似性,表明DEIKFE模型能夠有效地構建視頻與文本之間的語義關聯關系,達到跨模態實體分辨的目的。

表4 MSR-VTT數據集文本查詢結果示例

4 結論

本文針對現有的視頻文本跨模態實體分辨存在的問題,提出一種結合關鍵幀提取的視頻- 文本雙重編碼方法。通過實驗驗證其有效性,得出如下主要結論:

1)采用多級特征的編碼方法整合了全局、局部和序列化特征,要優于僅采用其中一種或者兩種特征的組合。

2)結合關鍵幀提取的視頻- 文本跨模態實體分辨雙重編碼方法要優于未采用關鍵幀提取的方法。

3)提取足夠的關鍵幀,使其既能夠充分表示視頻中不同場景的信息,也能保留視頻原有的時序相關的特征信息,又不存在冗余,提高了視頻- 文本跨模態實體分辨的性能。

表5 MSR-VTT數據集視頻查詢結果示例

本文研究結論對未來的相關研究工作具有實際應用價值,在以后的視頻- 文本跨模態實體分辨研究中,應在考慮整合視頻和文本多級特征編碼的同時,結合本文提出的關鍵幀提取方法,或者設計性能更好的關鍵幀提取方法,以達到更佳的性能。