基于圖結構的圖像注意力網絡

曾金芳 封琳瑯 李婕妤 閆李丹

摘要:雖然現已有許多關于圖像注意力機制的研究,但是現有的方法往往忽視了特征圖的全局空間結構和空間注意力與通道注意力的聯系。所以本文提出了一種基于整個空間拓撲結構的注意機制,將特征圖映射成結點與特征的形式,再借助圖卷積網絡的特性,得以從整個空間學習特征權重圖。其次空間注意力與通道注意力一體化結構能夠更有效地學習特征權重。通過多個實驗測試表明,在圖像分類和人臉識別任務中,展現了優異的性能和普遍適用性。

關鍵詞:深度學習;注意力機制;圖像分類;人臉識別

隨著計算機性能的提升,卷積神經網絡(convolutional neural network,CNN)廣泛地運用于圖像領域。經過多年的研究,基于卷積神經網絡的網絡架構取得了重大的成功。HE等提出了殘差網絡,可以跳層連接的殘差單元有效地解決梯度消失與梯度爆炸問題,使得網絡的深度成倍增長,進而圖像注意力機制逐漸受到關注。WANG等使用編碼器-解碼器的結構對殘差網絡進行了注意力機制的改造得到殘差注意力網絡(residual attention network,RAN)。HU等使用通道注意和通道特征融合來抑制不重要通道的方式構建了縮聚激發網絡(squeeze-and-excitation networks,SENet)。PARK 等構建了瓶頸注意模塊(bottleneck attention module,BAM),該模塊依次使用通道注意力網絡和空間注意力網絡推理注意力圖。FUKUI等構建了復雜的注意力分支結構網絡(attention branch network,ABN),引入具有注意力機制的分支結構來擴展基于響應的視覺解釋模型。MISRA 等考慮了通道-空間相互作用,基于三個維度兩兩相關性構建注意力網絡TAM (triplet attention module)。

雖然現已提出的許多注意都從通道注意力和空間注意力兩方面來設計模型,但是其空間結構的尺度取決于卷積核的大小,而且沒有從圖像整體出發分析空間特性并忽視了通道與空間的關聯性。在研究中發現,圖卷積網絡(graph convolution network,GCN)能夠充分地使用這些特性學習特征圖。因此本文基于圖卷積網絡提出了圖結構注意力網絡(graph structure attention network,GSAN),該模型既考慮了通道與空間的關聯性也考慮了圖像整個拓撲結構。

1圖結構注意力網絡

在已有的研究表明,圖卷積網絡本身充分考慮了通道的影響并且在解決非歐幾里得數據展現了強大的性能。我們利用這些特性設計了一個通道注意力與空間注意力一體化的注意力網絡模型,而不用像其他注意力網絡模型一樣分別設計通道注意力分支和空間注意力分支。在模型中我們設計了一套由圖像到圖的數據映射關系,使得輸入特征與圖卷積網絡的輸入相匹配,并以圖卷積網絡為基礎構建了圖結構注意力網絡。在研究中表明,本文所設計注意力模型分類性能與卷積層數有關,所以本文設計的卷積層數可調的注意力網絡,以下內容均以兩層卷積層的網絡為例說明。

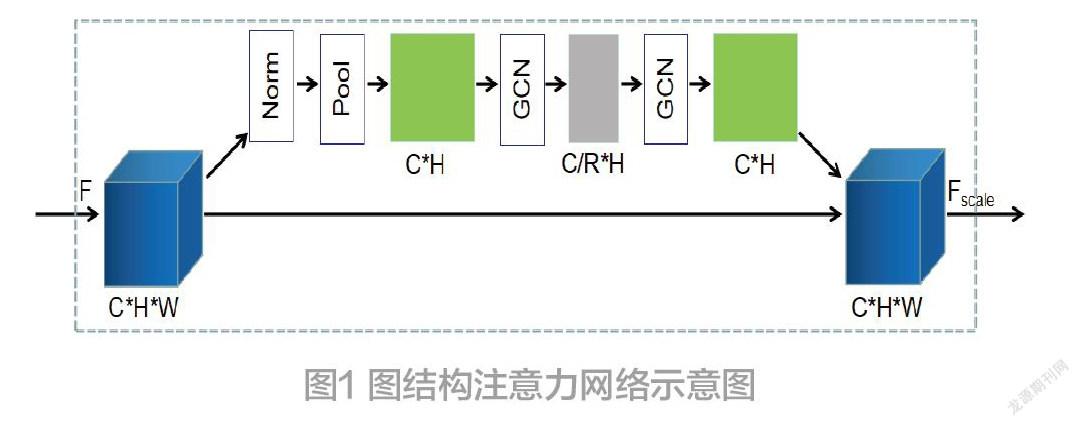

特征圖在模型中的維度與尺度變化過程如圖1所示。Norm表示正則化,Pool表示池化,GCN表示圖卷積網絡。特征圖F的尺度由F∈R經過正則化與池化得到F∈R,然后經過圖卷積通道壓縮得到中間態F∈R并再經過一層圖卷積恢復F∈R,最終利用廣播機制恢復到F∈R。

2圖與圖卷積網絡

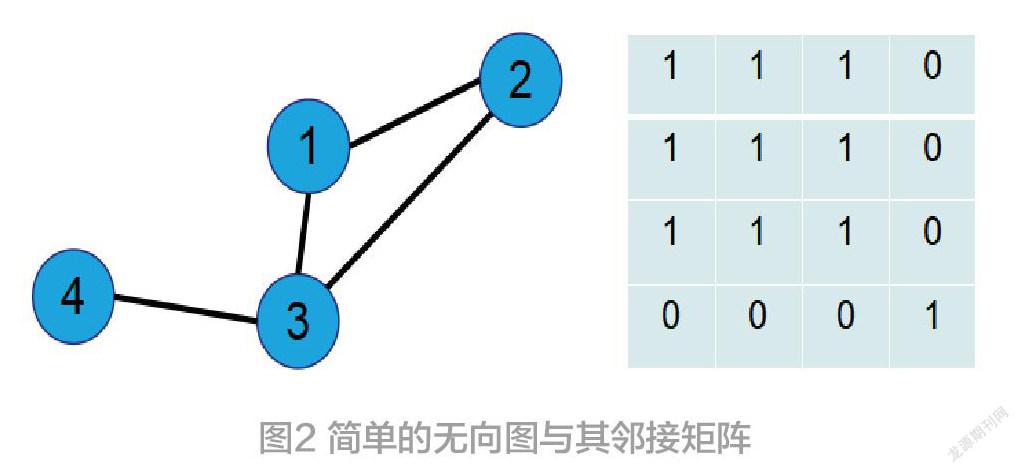

圖是一系列的結點和描述兩個結點關系的邊組成。圖是數據元素的集合,這些數據元素相互連接形成網絡,因此經常被用來描述具有拓撲結構的數據。如圖2所示,表示一個由四個結點與四條邊組成的圖,其對應的鄰接矩陣則是描述邊的連接關系的矩陣。當邊L(i,j∈1,2,3,4)存在時,對應的鄰接矩陣元素A為1,否則為0。

卷積網絡的卷積,本質上利用濾波器對矩陣空間的某個區域內的像素點進行加權求和,進而求得新的特征表示的過程。許多沒有明確規律的非歐幾里得數據并不適用于卷積網絡,而圖卷積的誕生者很好的解決這一問題。在已往的研究中,圖卷積網絡在具有拓撲結構的數據上表現出了強大的分類性能,其依賴不變的鄰接矩陣對輸入的結點特征學習,如圖3所示。

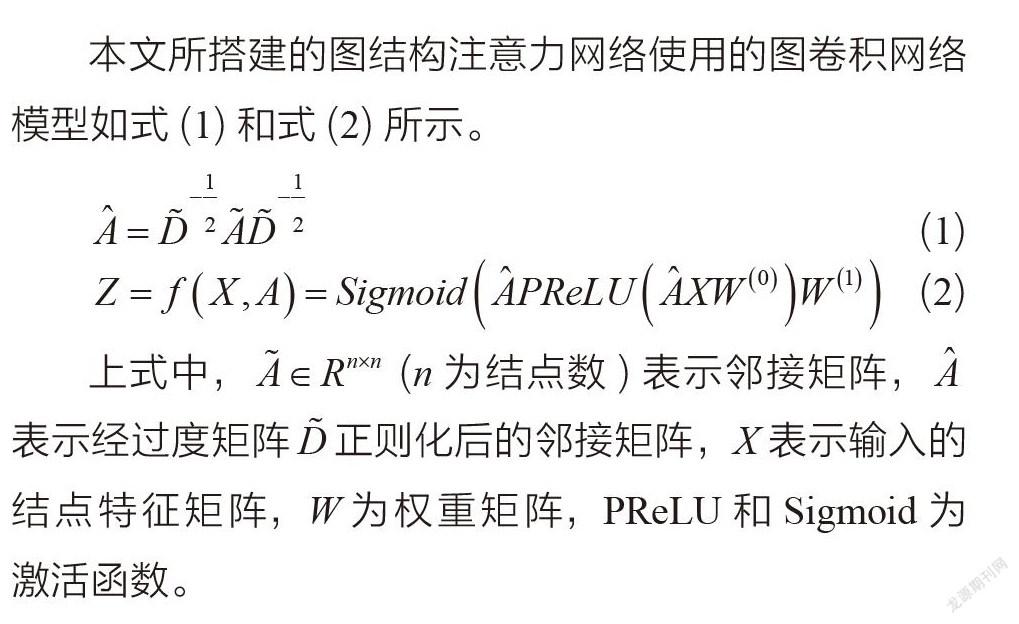

本文所搭建的圖結構注意力網絡使用的圖卷積網絡模型如式(1)和式(2)所示。

3圖結構注意力網絡算法

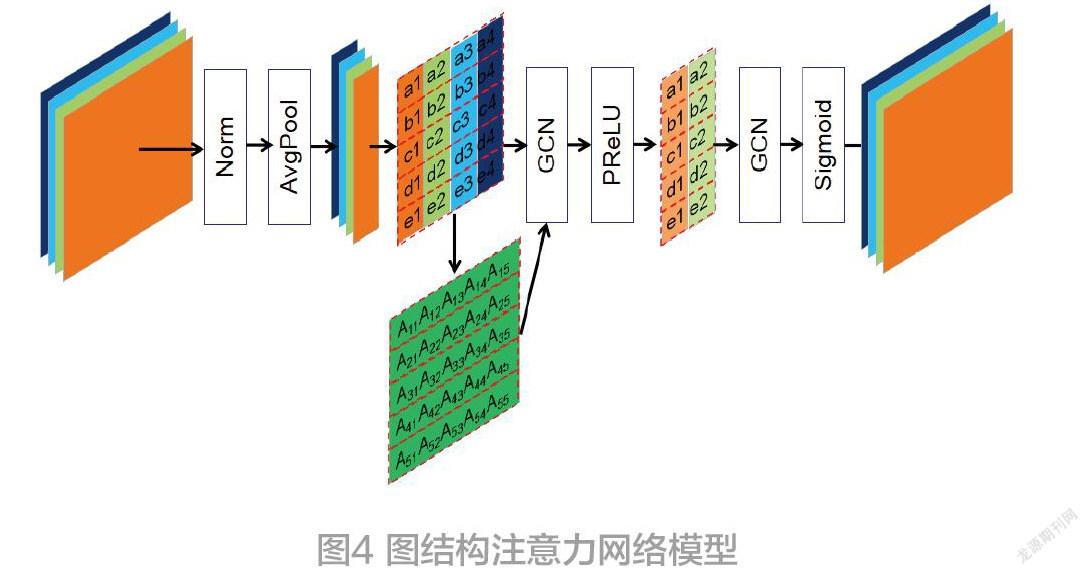

圖結構注意力網絡如圖4所示,該注意力網絡流程主要分成以下幾個。

步驟1:對上一層網絡得到的輸出特征圖進行正則化(Norm)處理,并利用平均池化(AvgPool)操作將三個維度(C×H×W)的特征圖壓縮成兩個維度(C×H)。

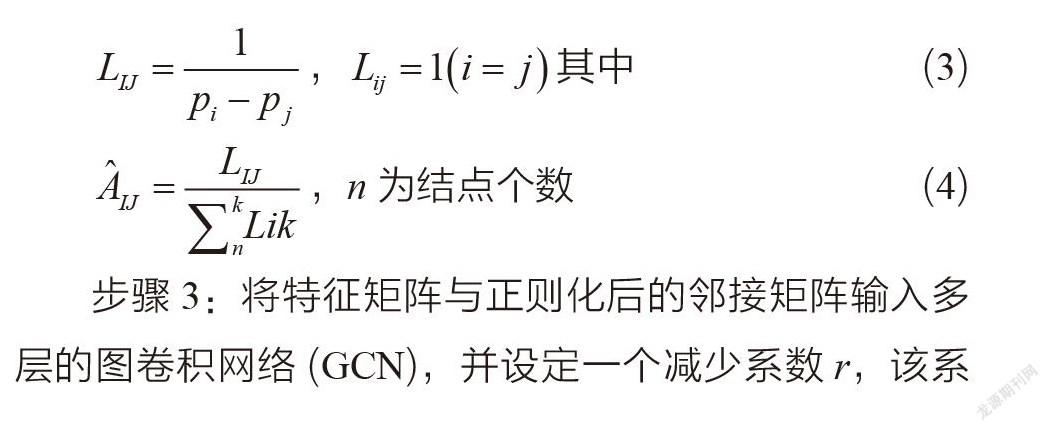

步驟2:對步驟1得到的向量組重新排列,得到特征矩陣。此外,對平均池化后得到的向量建立一維的歐式空間,計算兩點之間的歐氏距離,將其倒數作為結點之間連接的緊密程度,我們將其稱為弱連接,如等式3 和等式4所示。經過弱連接的映射后,將歐氏空間數據結構映射成了滿足圖卷積輸入的拓撲結構數據。最后經過正則化后,得到概率描述的邊,進而得到鄰接矩陣。

步驟3:將特征矩陣與正則化后的鄰接矩陣輸入多層的圖卷積網絡(GCN),并設定一個減少系數r,該系數為在中間層中減少通道數的系數。最后經過激活函數并恢復維度對原特征圖進行加權求解得到重新分配權重后的特征圖。

4實驗結果與分析

4.1實驗平臺

實驗環境為Ubuntu18.04操作系統,AMD3600X處理器,RTX2070SUPER顯卡,Pytorch框架。本文所有實驗均使用上述平臺。

4.1.1圖像分類實驗

在該實驗中我們在CIFARr100數據集對模型進行Rank-1準確度評估。我們在不同網絡模型上測試了SENet、BAM、TAM性能。分別設置了一項基準測試實驗和一項消融實驗。

CIFAR100數據集:該數據集有100個類。每個類有600張大小為32×32的彩色圖像,在模型訓練過程中將其中500張作為訓練集,100張作為測試集。對于每一張圖像,它有兩個標簽分別代表圖像的細粒度和粗粒度標簽。

參數設置:使用SGD優化器(lr=0.1,momentum=0.9,weight_decay=5e-4)和Cross Entropy Loss損失函數。學習率調整策略為迭代200次并在60、120,160次迭代調整學習率為原來的0.1倍。

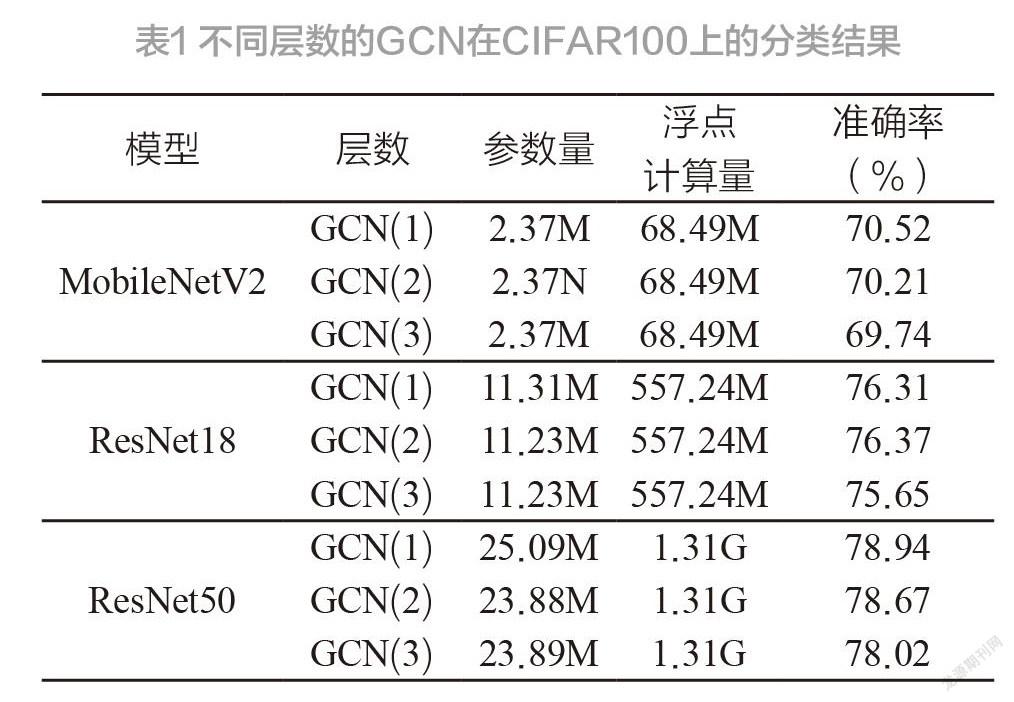

為了確定圖卷積的層數對GSAN的影響,我們設計了一組不同層數的對比實驗。如表1所示,較低復雜度的GSAN更有利于避免過擬合。

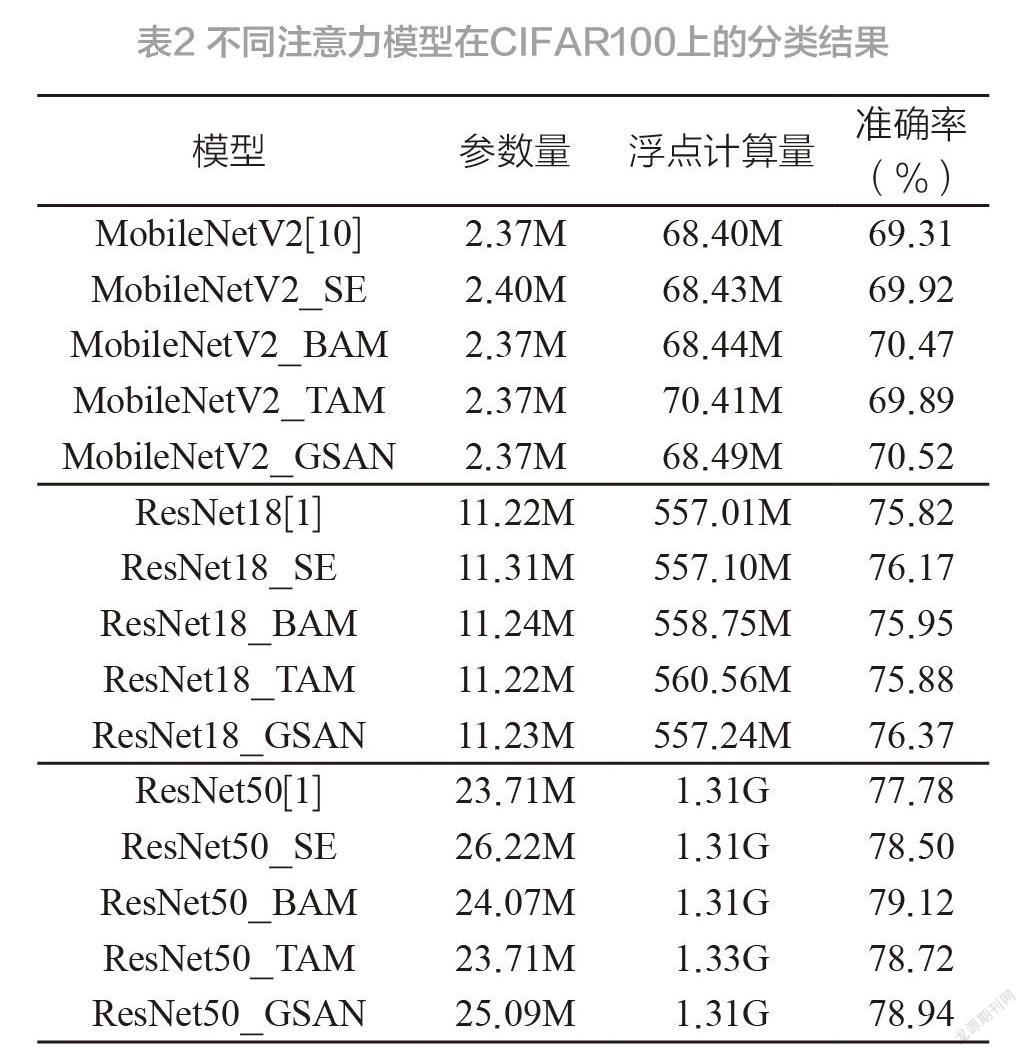

為了測試本文的注意力網絡性能與普遍適用性,我們在MobileNetV2、ResNet18 和ResNet50 上均做了不同注意力模型的對比試驗。如表2所示,在MobileNetV2和ResNet18上相較于其它方法達到了最好的效果,在ResNet50上稍差于BAM。

4.1.2人臉分類實驗

在該實驗中我們使用余弦相似度計算準確率的策略。在CASIA-WebFace數據集上訓練模型,并在LFW 數據集和CFP-FP數據集上進行人臉識別測試。

CASIA-WebFace數據集:CASIA-WebFace數據集是經過數據清洗的數據集,所以含有噪聲的圖像較少,常作為訓練集使用。數據集有10 575個人的494 414張人臉圖像。

LFW數據集:圖像源于生活中的自然場景,所以圖像受到表情、光照、多姿態、遮擋、年齡等因素影響而差異極大。數據集有5 749個人的13 233張人臉圖像。

CFP-FP數據集:數據集對于每個人有10張正面圖像和4張側面圖像。CFP-FP數據集有500個人的7 000張人臉圖像。

參數設置:使用SGD優化器(lr=0.1,momentum=0.9,weight_decay=5e-4)和ArcFace[16]損失函數。學習率調整策略為迭代18次并在6、11、16次迭代調整學習率為原來的0.1倍。

由于ArcFace損失函數的不同縮放系數s會極大的影響實驗結果的準確率,因此我們先通過ResNet50-IR 模型來確定準確率最高s,如表3所示。

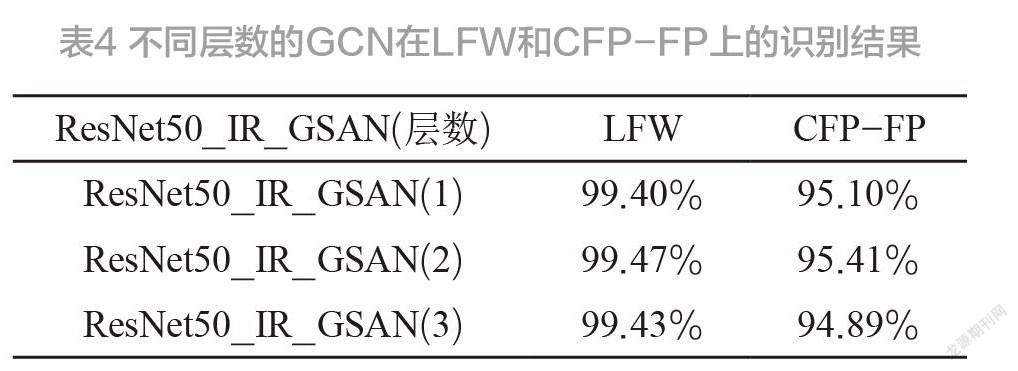

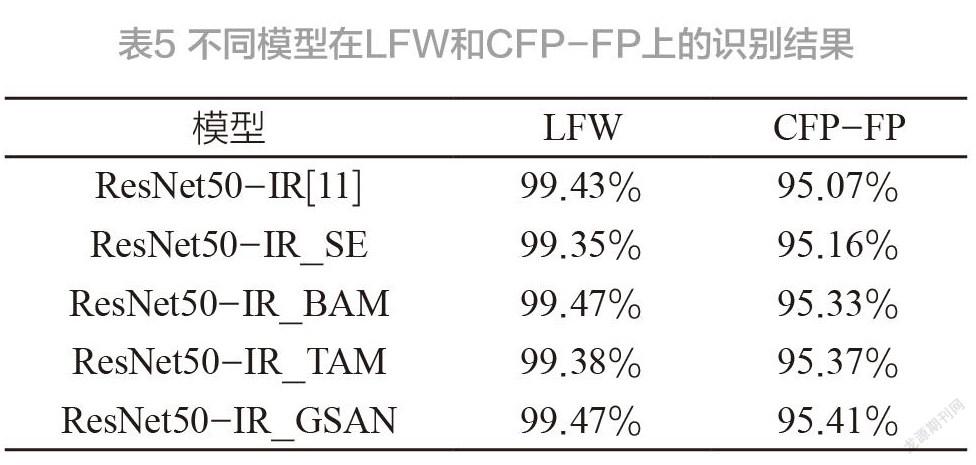

經過縮放系數的對比實驗可以看出ResNet50-IR模型在s為33的時候準確率達到最大值,因此在其他實驗中將縮放系數s固定為33進行訓練和測試。實驗結果如表4和表5所示,在ResNet50-IR上,當圖卷積層為2時達到最好的效果,并且性能優于其他注意力模塊。

5結語

本文提出一種圖結構注意力網絡,該方法壓縮寬度維度并有效地結合空間拓撲結構和通道注意力。通過映射成拓撲結構的方式學習空間注意力,有效地解決現有注意力感受野受限于卷積核大小的問題和卷積核過大導致性能下降的問題,并且更好地學習全局信息。實驗結果表明,本文注意力網絡在圖像分類和人臉識別任務中均展現了優異的性能與普遍適用性。

參考文獻:

[1]HE K,ZHANG X Y,REN S Q,et al. Deep residual learning for image recognition[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2016:770-778.

[2]LONG J,SHELHAMER E,DARRELL T. Fully convolutional networks for semantic segmentation[C]. In Proceedings of the IEEE Conference on Computer vision and Pattern Recognition. 2015:3431 -3440.

[3]KRIZHEVSKY A,SUTSKEVER I,HINTON G E. Imagenet classification with deep convolutional neural networks[C]. In Advances in Neural Information Processing Systems. 2012:1097- 1105.

[4]SIMONYAN K,ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]. arXiv preprint arXiv.2014:1409,1556.

[5]WANG F,JIANG M Q,QIAN C,et al. Residual attention network for image classification[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017:3156-3164.

[6]HU J,SHEN L,SUN G. Squeeze-and-excitation networks[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2018:7132-7141.

[7]PARK J,WOO S,LEE J Y,et al. Bam:Bottleneck attention module[C]. arXiv preprint 2018.

[8] FUKUI H,HIRAKAWA T,YAMASHITA T,et al. Attention branch network:Learning of attention mechanism for visual explanation [C]. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition,2019:10705-10714.

[9] MISRA D,NALAMADA T,ARASANIPALAI A U,et al. Rotate to attend:Convolutional triplet attention module[C]. In Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision.2021:3139-3148.

[10] SANDLER M,HOWARD A,ZHU M L,et al. Mobilenetv2:Inverted residuals and linear bottlenecks[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018:4510-4520.

[11]HAN,DONGYOON,KIM J,et al. Deep pyramidal residual networks[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2017:6307-6315.

[12]KRIZHEVSKY A. Learning multiple layers of features from tiny images[C]. 2009.

[13]YI,DONG,LEI Z,et al. Learning face representation from scratch[C]. arXiv preprint 2014.

[14] HUANG G,MATTAR M,BERG T,et al. Labeled faces in the wild:A database for studying face recognition in unconstrained environments[C]. 2008.

[15] SENGUPTA S,CHEN J C,CASTILLO C,et al. Frontal to profile face verification in the wild[C]. In Proceedings of the IEEE Conference on Winter Conference on Applications of Computer Vision.2016:1-9.

[16] DENG,KANG J,GUO J et al. ArcFace:Additive angular margin loss for deep face recognition[C]. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2019:4685-4694.

[17] N T,KIPF,MAX,et al. Semi-supervised classification with graph convolutional networks[C]. In Proceedings of the 5th International Conference on Learning Representations.2017.

[18] NIU Z Y,ZHONG G Q,and YU H. A review on the attention mechanism of deep learning[J]. Neuro computing.2017(452):48-62.