基于嵌入式移動端的目標檢測算法

劉信潮,房桐,杜保帥,趙景波

(青島理工大學,山東 青島 266520)

0 引 言

近年來,國內外研究人員針對目標檢測算法進行了大量研究。上海交通大學的朱壬泰等人針對當前基于深度學習的多目標檢測算法計算資源占用量大的問題,提出一種基于卷積神經網絡的計算過程化方法,在最終檢測精確度不變的前提下,算法幀率達到了56 fps。新疆大學的崔博超等人將無人機技術和機器視覺技術相結合,識別方法采用了YOLOv3 網絡和YOLOv3-tiny 網絡,可快速、精準、自動地獲得鼠洞在視頻范圍內的分布情況。南京郵電大學的徐融針對小目標檢測的漏檢率較高的問題,提出了基于YOLOv3網絡模型的小目標檢測算法,降低了在小目標上的漏檢率。沈陽農業大學的紀秋岑將基于YOLOv3 的學習模型和基于圖像特征識別的模板匹配法相結合,用于快速準確的識別絕緣子是否存在缺陷。Emin M 等人利用無人機遙感和機器視覺技術,實現云杉的自動、準確、高效計數,提高森林科學管理的效率。Micheal A A 等人采用基于區域的卷積神經網絡(R-CNN)和基于卡爾曼濾波的快速R-CNN 對無人機拍攝的圖像數據進行檢測和跟蹤。

綜合前人經驗提出了YOLOv3-tiny 夜間目標檢測的優化改進算法,提出了更優的檢測速度與檢測精度的模型。

1 總體設計方案

目標檢測平臺由紅外攝像頭和樹莓派3B 組成,如圖1所示。樹莓派3B 的CPU 使用的是ARM 的四核心Cortex-A53,頻率為1.2 GHz,RAM 大小1 GB,擁有4個USB2.0 插口且支持USB hub 擴展,GPU 為Broadcom VideoCore 6 集成顯卡,支持OpenGL ES 2.0,同時支持h.264/MPEG-4 AVC 高清解碼器,音頻輸出支持3.5 mm 插孔和HDMI 1.4,分辨率最高可達1920*1200,攝像頭使用CSI,供電方面有GPIO 和Micro USB 兩種可供選擇。

圖1 樹莓派3B 平臺

2 算法的分析與改進

YOLO 系列是Joseph Redmon 等人共同提出的系列目標檢測算法,算法家族眾多,開源且一直在更新。YOLOv3 是一種全卷積神經網絡的目標檢測算法,通過卷積運算,對候選框的尺寸大小及各類目標的分類類型進行回歸計算以達到不同的檢測要求。為了保證了目標檢測的實時性和準確性的共同進步,YOLOv3 目標檢測算法改進了以往相似的算法模型在多個目標和小尺寸目標檢測上的劣勢,引入特征金字塔的方法并采用了Darknet-53 特征提取網絡結構以及預測分支模塊。

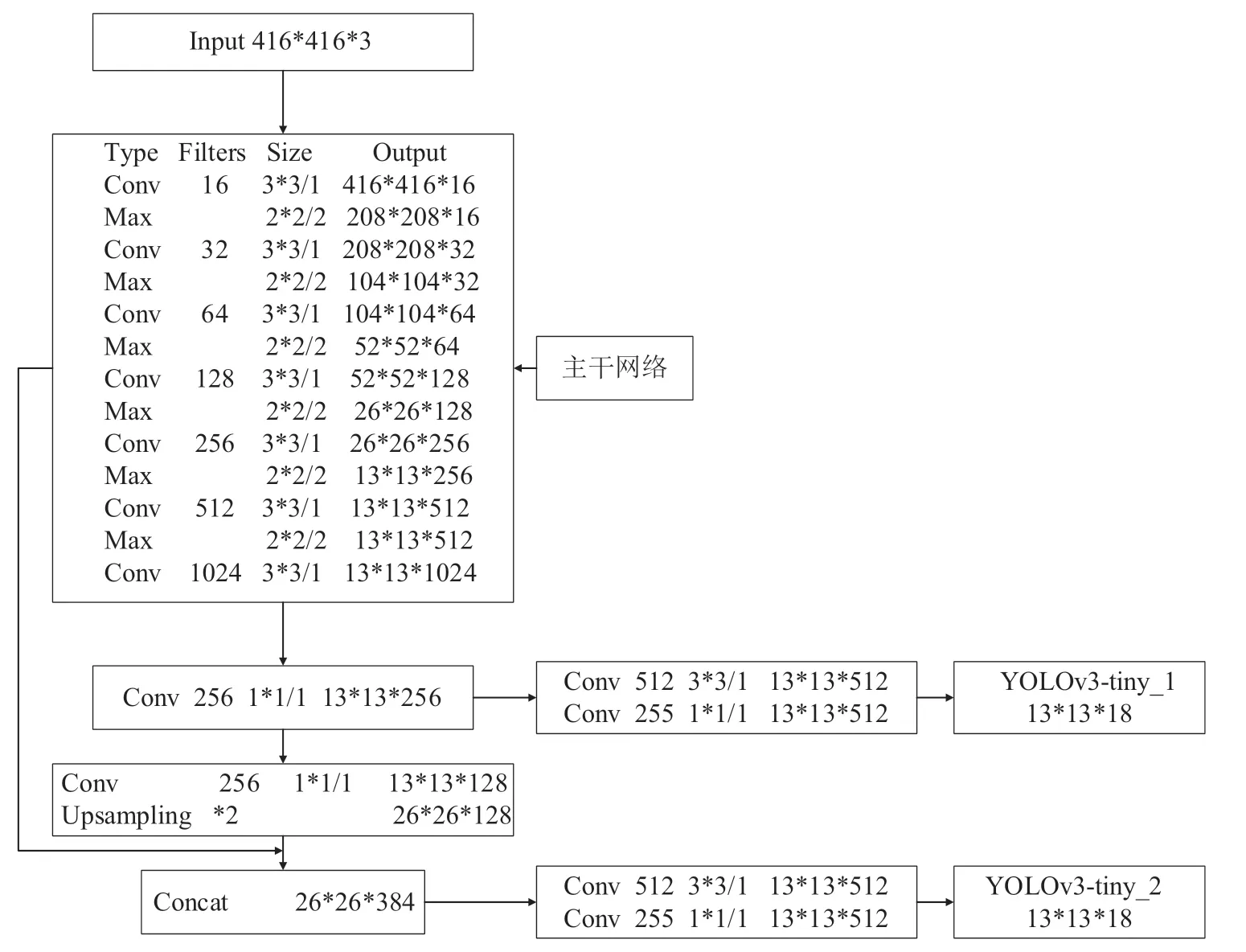

YOLOv3-tiny 是YOLOv3 算法經過改良的輕量化目標檢測算法,通過將YOLOv3 的特征提取網絡減少至7 層,從而得到更小的卷積神經網絡,同時刪除全連接層,運用聚類算法生成先驗框和多尺度預測相關技術提高目標檢測的精度,最終得到的YOLOv3-tiny 算法結構簡單,計算量較少,檢測速度相比YOLOv3 算法更快。通過分析目標檢測要求,對于速度要求比較高的項目,YOLOv3-tiny 更適合在樹莓派或使用條件比較受限的移動端下進行部署使用。YOLOv3-tiny 的流程圖如圖2所示。

圖2 YOLOv3-tiny 算法網絡結構圖

圖片的特征通過YOLOv3-tiny 的7 層卷積神經網絡來提取,首先輸入416*416*3 的圖片,通過第一層將其變為416*416*16,然后進行提取特征。前六個卷積層的最后都跟隨有最大池化層,它的作用是進行步長等于2 的下采樣,目標是將生成的特征圖尺寸模糊到原來的二分之一。圖片通過卷積后,特征圖尺寸為13*13*1024,然后進行1*1、3*3 和1*1 的卷積后,進入YOLOv3-tiny_1 結束。第7 層特征圖經過對應的卷積步驟和上采樣,然后和第五層的特征圖相結合,然后進行1*1、3*3 和1*1 的卷積后,進入YOLOv3-tiny_2結束。

2.1 CBAM 模塊的套用

CBAM 由Sanghyun Woo 等人提出并在ECCV2018 發表,屬于軟注意力機制,包含兩個模塊:通道注意力模塊和空間注意力模塊。

2.1.1 通道注意力模塊

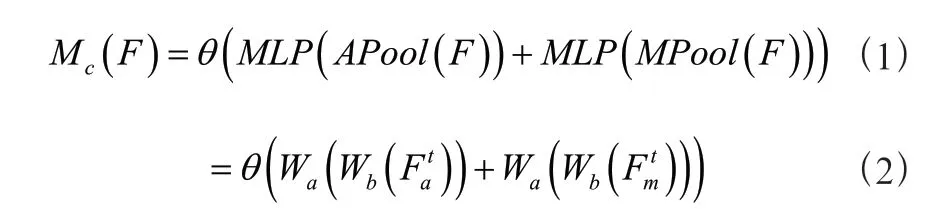

通道注意力模塊基本結構:MPool 是基于高度和寬度的最大池化,APool 是平均池化,輸入Input feature F 使其經過APool 和MPool 分別得到APool(F)和MPool(F),這兩條路徑用同一個MLP(多層感知機結構)處理過后,再次經過激活函數,最后得出M(),表達式為:

公式2 中,F表示平均池化的操作過程,F表示最大池化的操作過程,W表示第一層的權重,W表示第二層的權重。

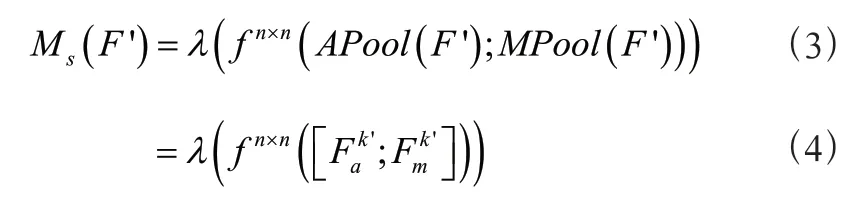

2.1.2 空間注意力模塊

空間注意力模塊基本結構:將計算得出并輸入到APool 和MPool 中,經過f 卷積后,最后通過sigmoid 激活函數后,得到M(F')。公式為:

公式(4)中,F '表示平均池化的操作過程,F '表示最大池化的操作過程,f 表示模塊的卷積過程。

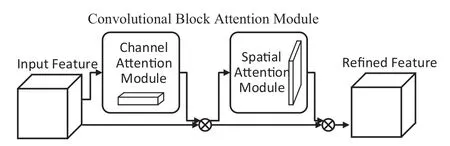

通道注意力模塊總結構:將Input feature F 輸入通道注意力模塊后,得到M(),再將M()與輸入圖像像素相乘后得到';將'輸入到進空間注意力模塊后,得到M('),再將M(')與'像素相乘后得到并輸出。CBAM 的網絡結構圖如3 所示。

圖3 CBAM 網絡結構圖

算法使用通道域+空間域注意力機制,解決YOLOv3-tiny 使用中易出現的小目標特征分配權重低,背景分配的權重高的現象。

2.2 改進K-Means 聚類算法

YOLOv3-tiny 引入了Anchor Box 機制,使用K-Means聚類算法可計算獲得Anchor Box。聚類算法的思想是將很多沒有標簽但又相似特征的數據自動歸類的辦法,根據數據間的親疏性,將差別小的數據聚到一起,最后形成多個簇,簇內特點為相似度高,簇間特點為差異性高。

K-Means 聚類算法流程:

首先確定一個值,值代表的是集合個數的期望值,在集合中選出個點作為聚類質心,計算集合中的每個個體與聚類之心的歐拉距離,根據歐拉距離最近,將個體分為個集合,然后再次計算個集合的各自的質心,直到新出現的聚類質心與之前的質心之間的距離小于閾值時,停止計算,否則重復上述步驟。

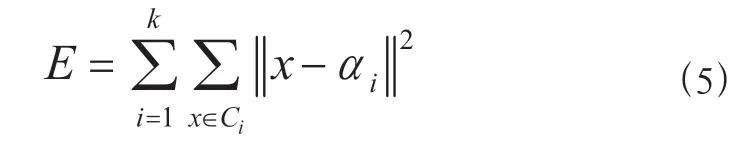

如果用數學表達式表示K-Means 聚類算法,設劃分為個簇為(,,,…,),方差為:

其中α是簇C的均值向量,稱為聚類質心,公式為:

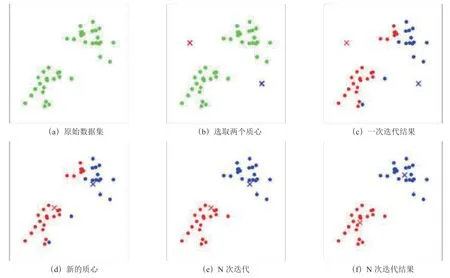

K-Means 聚類算法原理如圖4所示。

圖4 K-Means 聚類過程

在獲取聚類中心的過程中引入Small Batch-K-Means法,能盡量保持聚類準確性下但能大幅度降低計算時間,通過提取全體樣本的一部分代替整體,定義Small Batch 聚類準則函數。仿真效果對比如圖5所示。

圖5 K-Means 與SmallBatchK-Means 效果對比

YOLOv3-tiny 根據COCO 數據集計算,并不適用于本算法環境下的KAIST 數據集,需要對其重新聚類,生成新的Anchor Box。

將Small Batch K-Means 聚類算法中的歐氏距離計算法替換成IOU 重疊度來衡量距離變量,原理公式為:

式中,表示歐拉距離,IOU 表示Anchor Box 和Bounding Box 矩形框重合面積與兩者的并集的比值。

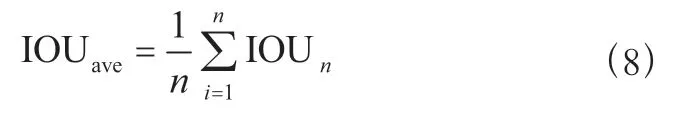

在計算時要將IOU 取平均,目的是為了使用更少的步驟就可以取得準確的值,平均重疊度的公式如下:

式中,為部分IOU 的總個數。

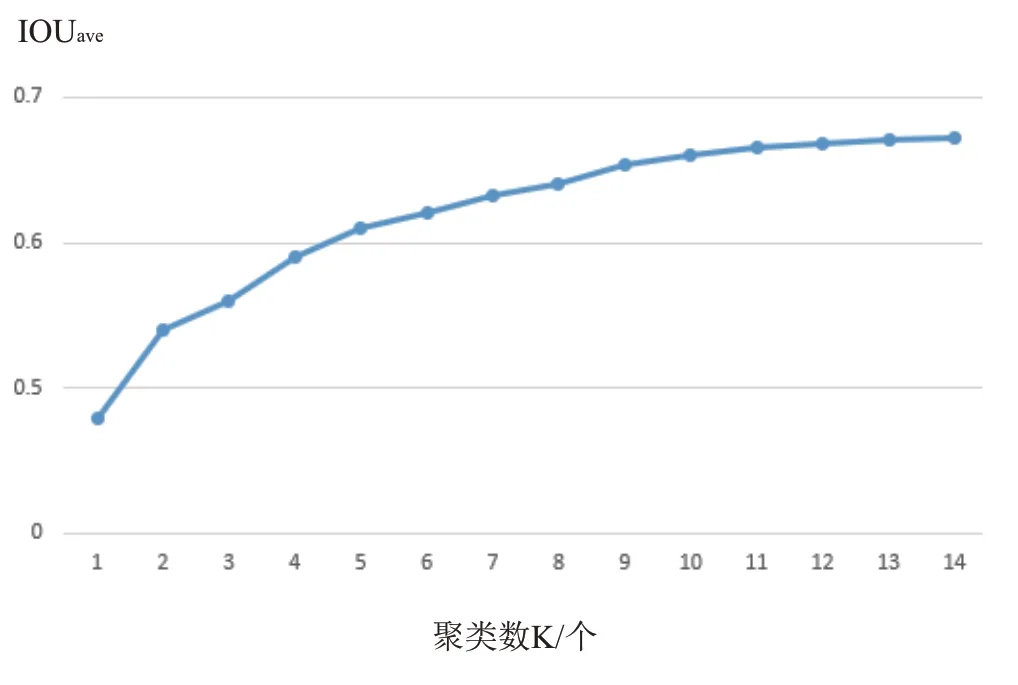

取=1 ~14,經計算獲得,IOU與值的關系如圖6所示。

由圖6可知,隨著的增加,IOUave 的增長逐漸平緩,當>9 時,斜率幾乎不變。為了算法的簡易性和運行的速度,應舍棄檢測效果提升不大的值,故聚類數選9。

圖6 IOUave 與K 聚類數的關系

在確定聚類質心后,再次對bounding box 進行聚類,將誤差最小的Bounding Box 歸為相應的Anchor Box,形成以Anchor Box 為中心的Bounding Box 集合共九個。

重復步驟,直到聚類質心不在變化時,算法停止。得到最終計算后的先驗框尺寸分別是(9,15),(25,41),(23,39),(30,51),(12,28),(18,34),(39,63),(14,28),(15,33)。

3 實驗測試

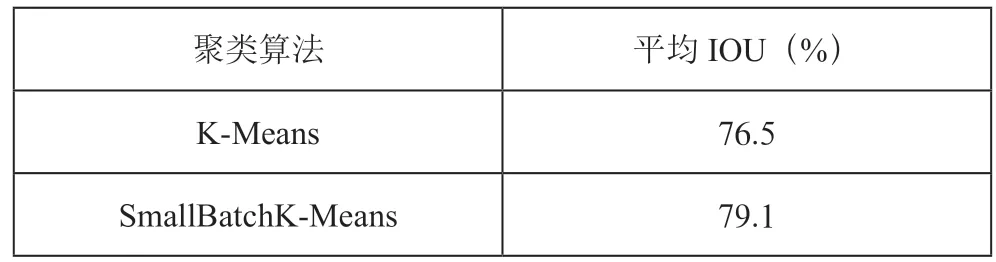

將Small Batch K-Means 算法應用于YOLOv3-tiny 中的在KAIST 行人數據集得到了較好的聚類結果,平均IOU 為79.1%。而原始 YOLOv3-tiny 的候選框初始化尺寸與KAIST行人數據集的真實框尺寸匹配的平均IOU 為76.5%。如表1所示。

表1 平均IOU 對比

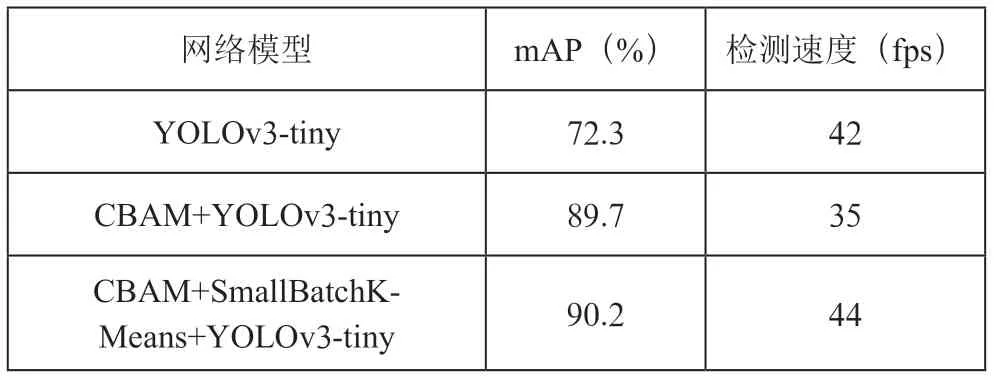

在KAIST 行人數據集上的YOLOv3-tiny 輸出的mAP值為72.3%,檢測速度為42 fps:使用CBAM+YOLOv3-tiny后,在數據集KAIST 上的mAP 值能夠提高到89.7%,檢測速度為35 fps;使用CBAM+SmallBatchK-Means+YOLOv3-tiny 后,在數據集KAIST 上的mAP 值為90.2%,檢測速度為44 fps。如表2所示。

表2 mAP 和FPS 對比

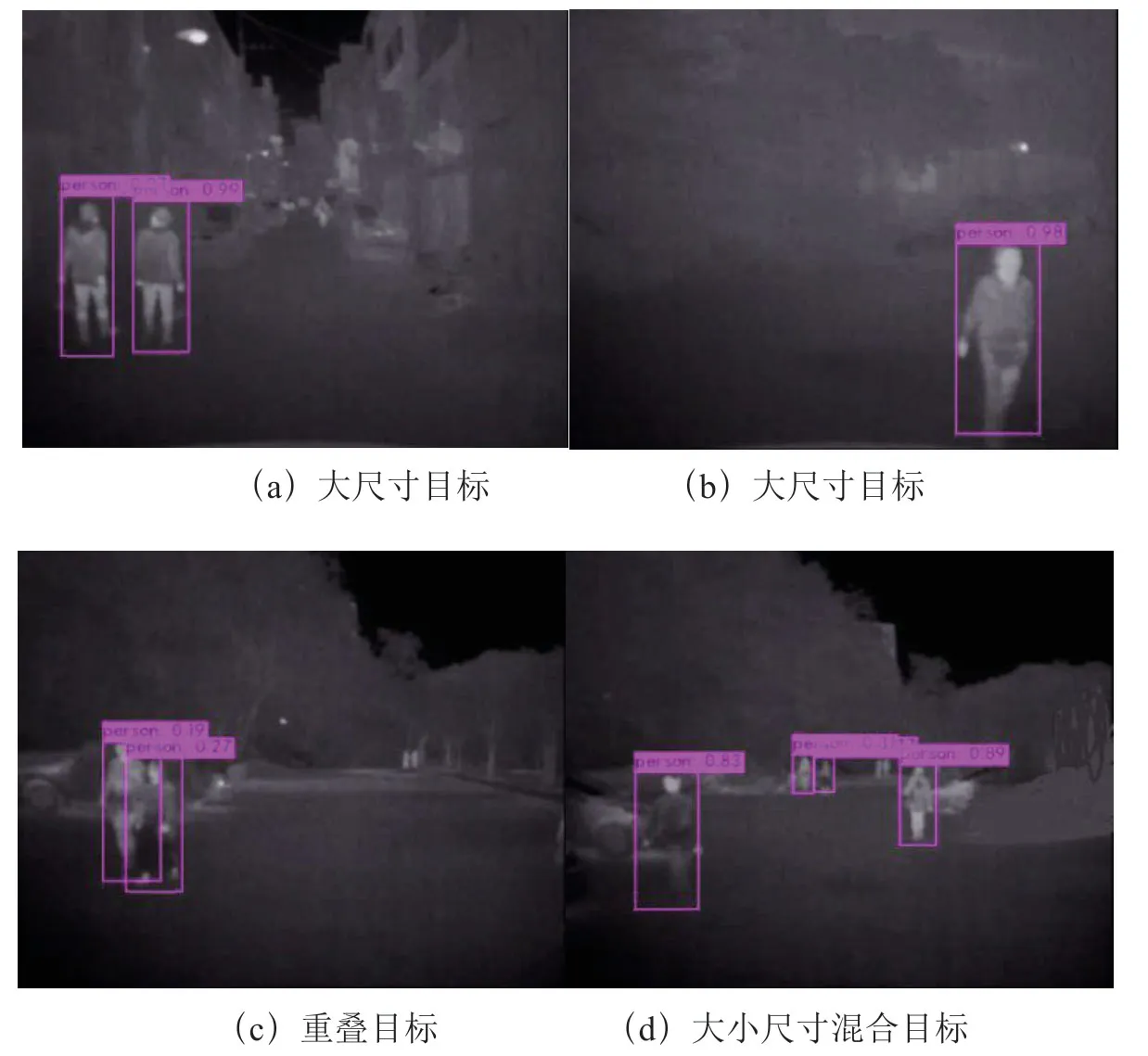

設計實驗場景為夜晚可見光較弱的環境下,樹莓派3B距地面2 米高度后進行拍攝處理。如圖7所示。

由圖7分析可得,圖7(a)、圖7(b)和圖7(d)中,大尺寸的目標識別置信度高,分別為99%、97%、98%、83%和89%,識別準確;圖7(c)中,由于目標有重疊,識別成功但置信度較低,分別為19%和27%;圖7(d)中,遠方小尺寸行人識別置信度較低,分別為31%和17%。

圖7 實驗效果

4 結 論

本系統通過樹莓派3B 對夜晚可見光較弱的環境下進行目標識別,可以看出改進后的K-Means 聚類算法得出的平均IOU 比K-Means 算法提高了2.6%。該算法在行人檢測上的mAP 值比YOLOv3-tiny 算法提高了17.9%,檢測速度提高了7 fps。使用Mini Batch K-Means 聚類算法后能在保證原有檢測速度的同時提高mAP 值,實驗證明了算法在可見光較弱的環境下仍有良好的識別準確度。