基于文本信息的圖書館讀者流失分析模型

徐根祺,曹寧,謝國坤,董三鋒,張正勃

(西安交通工程學院,1.機械與電氣工程學院,2.土木工程學院, 陜西,西安 710300)

0 引言

圖書館傳播知識的對象是讀者,而讀者又是圖書館資源中最根本的資源,圖書館價值的體現(如經濟效益和社會效益)很大程度上是建立在讀者資源這個平臺上的,讀者數量的穩定以及開發的深、廣度在根本上影響著圖書館的生存與發展。因此,如何能夠留住讀者,防止讀者流失逐漸引起決策者和管理者的重視,這也是檢驗圖書館是否成熟的一個重要標志[1]。

然而,當云計算風起云涌之際,大數據又風靡云蒸,在物聯網、移動互聯、云計算等技術的推動下,全球化大數據時代已如日方升[2]。隨著人們獲取知識的方式多樣化,傳統圖書館受到了極大的沖擊,讀者流失嚴重。探究讀者流失的原因、提升圖書館的服務質量、增加現有讀者的滿意度、吸引潛在讀者到圖書館借閱圖書、減少讀者流失的可能性,對比充分發揮圖書館知識服務的作用更顯得尤為重要[3]。目前,國內外研究大多集中于對圖書館讀者流失原因的剖析,而對于讀者流失預測的研究則鳳毛麟角,且預測效果也并不理想,面對讀者們各種需求的紛至沓來,為了最大程度減少讀者流失,可以采用數據挖掘算法根據讀者和圖書館的歷史數據建立以讀者信息和圖書館信息為輸入,讀者流失概率為輸出的模型,探求這些數據之間的內在聯系,據此來預測讀者流失的可能性。若讀者流失概率過高,則通過改善服務、為讀者推薦圖書等方式來提高讀者的忠誠度以預防讀者流失[4],這就改變了過去圖書館在讀者注冊后無法預估讀者流失和無法有效實現對讀者關懷的情況[5]。

本研究根據讀者的屬性信息、讀者的借閱行為信息和圖書館的屬性信息等文本信息[6]結合卷積神經網絡(convolutional neural network, CNN)[7],建立了圖書館讀者流失概率預測模型TEXT-CNN,利用這個模型對讀者的流失概率做出分析。

1 準備工作

造成圖書館讀者流失的原因有多種,眾多研究表明,常見的包括讀者和圖書館兩方面原因[8-10]。

1.1 讀者屬性

1.1.1 讀者固有屬性

年齡、性別、職業、學歷、是否結婚等均屬于讀者固有屬性信息,這些因素均從不同程度上對讀者進入圖書館閱讀的行為產生影響[11]。隨著讀者年齡的增長、學歷的提升、職業的轉變以及婚姻狀況的改變等,造成其遠離或轉移圖書館的行為。

1.1.2 讀者行為屬性

讀者在圖書館進行的借閱行為也屬于讀者屬性,借閱行為數據主要包括在借數據、歷史數據和統計數據。

(1) 在借數據收集的是讀者正在借閱的書籍信息。

(2) 歷史數據收集的是讀者過去半年內的借閱信息。

(3) 統計數據又分為借閱頻率和閱讀程度。借閱頻率表示讀者某時間段內借閱圖書的平均次數;閱讀程度表示讀者對所借閱書籍認真閱讀的程度,用續借次數和借閱天數之積表征。

1.2 圖書館屬性

圖書館屬性包括自身的“硬”屬性和“軟”屬性。館藏圖書數量與種類、開放時間和館內圖書更新速度等均屬于圖書館能否留住讀者的“硬”屬性,多倫多大學的Heather V. Cunningham和Susanne Tabur根據Maslow需求層次理論提出圖書館四大空間學習屬性,可將其歸納為地理位置便捷性、易于讀者活動性、便于建立社交性和學習空間舒適性,這些也可列入“硬”屬性范疇[12];而圖書館舉辦的講座與活動、工作人員的服務態度與服務質量等則屬于圖書館能否留住讀者的“軟”屬性。讀者流失正是由于圖書館的各種屬性無法滿足讀者相應的需求所導致的。

2 相關理論

2.1 卷積神經網絡(CNN)

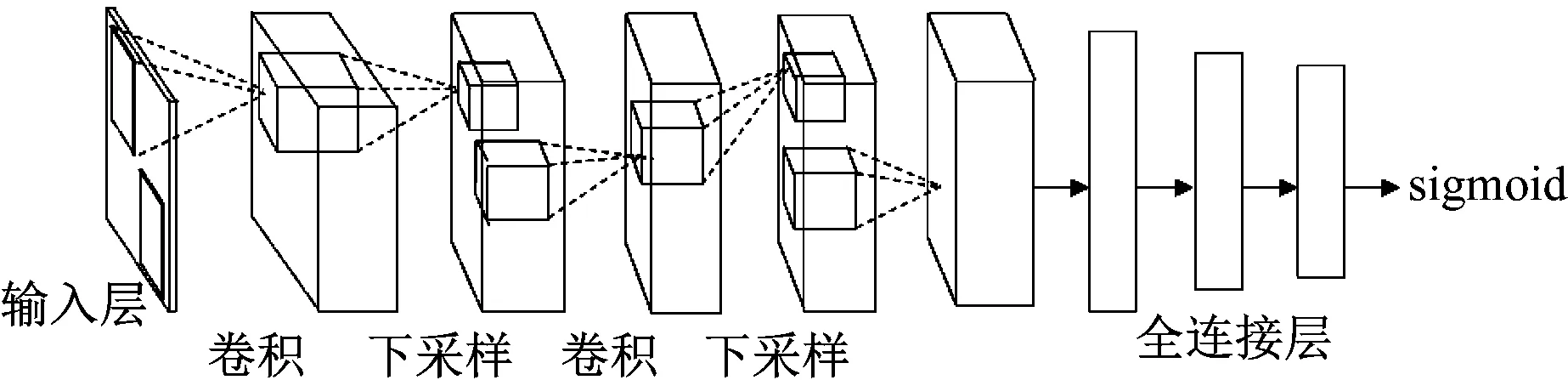

CNN本質上就是從輸入到輸出的某種映射關系,且輸入與輸出之間并不需要精確的數學表達式就可以從學習海量輸入與輸出數據得到映射關系[7]。為了建立卷積神經網絡的輸入、輸出之間的映射關系,需要用已設定好的模式對網絡進行訓練。Fukushima在神經認知機中提出了第一個卷積神經網絡計算模型。Lecun等提出的卷積神經網絡是第一個真正的多層結構學習算法。圖1給出了CNN的一般網絡結構,從左至右依次為輸入層、卷積層、池化層(子采樣層)、全連接層和輸出層。

圖1 卷積神經網絡結構圖

(1) 輸入層

CNN的輸入層可直接以原始數據作為輸入,也可以先通過矩陣變換得到特征向量,再將其輸入到網絡中。由于CNN通常都有全連接層,而全連接層的輸入要求是大小相同,因此卷積神經網絡的輸入一般大小都一樣。

(2) 卷積層

卷積層屬于特征抽取層。對輸入進行卷積,便可得到特征圖。為了減少網絡結構中連接權的數量,CNN要求同一卷積層中不同神經元與前一層中不同位置相連的權值相等(一個卷積核提取前一層輸出中不同位置的特征),即一個卷積核對前一層網絡的輸出進行卷積從而得到一種特征。對于不同的卷積核,每個卷積核都能分別進行卷積,這樣就能夠提取出不同的特征。

(3) 池化層

池化層(也稱下采樣層)是特征映射層。在池化層中,使用非線性降采樣法將輸入劃分為多個局部感受域,用這些局部感受域中的平均值(或最大值)來表示降維后的特征值。每一個與前一層的輸出局部感受域相連接的權值都被設定為固定值,在整個網絡訓練的過程中不再改變。這一層通過對前一層網絡的輸出進行下采樣,進一步降低了網絡參數規模。

(4) 全連接層

全連接層是采用全連接方式的人工神經網絡,對卷積層所提取特征的總結變換,將所有的特征映射至一維列向量。

(5) 輸出層

全連接層的下游為CNN的輸出層,與傳統前饋神經網絡的輸出層相比,其原理和結構完全相同。此處選用sigmoid函數作為輸出層激活函數。

2.2 文本數據的處理

首先,文本信息必須轉換為某種數字輸入,因此先要進行預處理,然后準備文檔,使每個術語都進行一次熱編碼。文本數據需要轉換為代表維空間中文本信息的維數字向量,連續的維向量表示可以隨機地使用預訓練的向量來初始化,這些詞嵌入可以像其他模型參數一樣在訓練期間進行更新,也可以保持不變。其次,可以從CNN卷積層的嵌入向量中計算出新的特征。本文使用復雜層術語,其中將卷積層定義為3個階段,即卷積階段、檢測器階段和合并階段。

卷積可以提高網絡的計算效率。首先,將卷積階段的單元組織在特征圖中,并通過一組連接權值連接到上一層特征圖中的局部補丁。其次,特征圖中的所有單位共享相同的連接權值或濾波器組,這一過程稱為參數共享。卷積是線性運算,因此將局部加權和的結果通過激活函數傳遞給檢測器階段的非線性模型,該激活功能將有關神經元輸出是否被激活的信息傳遞給外部連接。

分類需要將在卷積層中創建的特征組合到一個分類器中,通常使用一個或多個全連接(或密集)層。全連接層需要一維輸入,因此將最后一層中的列連接為單個向量x,變換Z定義為Z=xTW,它是權值矩陣W和某些非線性激活函數的內積。輸出層中使用softmax函數作為激活函數。

CNN的訓練需要使用損失函數,該函數間接優化了真實目標,其定義為Loss=-Σ{yilogpi+(1-yi)log(1-pi)},其中yi表示真實的類別標簽,pi表示讀者i的預測結果。當對讀者的預測越來越接近實際值時,損失也越來越少,因此可以通過減少損失來提高目標。

3 圖書館讀者流失預測模型搭建

3.1 CNN讀者流失預測模型

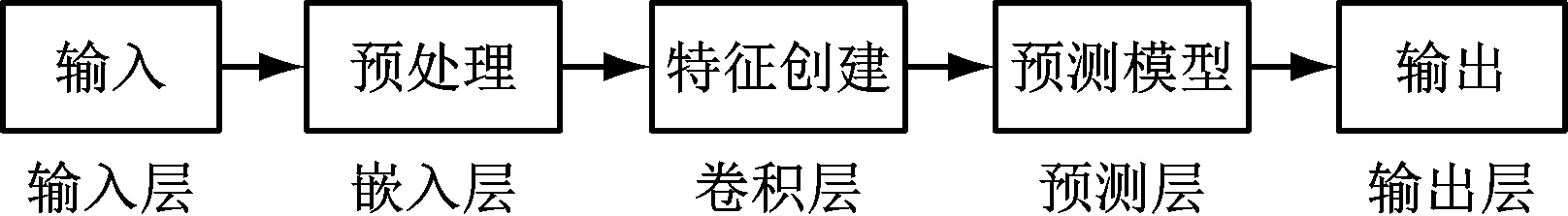

讀者預測模型流程如下:

(1) 將結構化處理后的讀者和圖書館的數據作為預測模型的輸入;

(2) 對數據進行數據抽取、數據清理和數據轉換等預處理過程;

(3) 將準備好的數據集輸入CNN網絡,預測出讀者流失的數量。

預測模型結構圖如圖2所示。

圖2 CNN讀者流失預測模型

3.2 將文本信息納入CNN

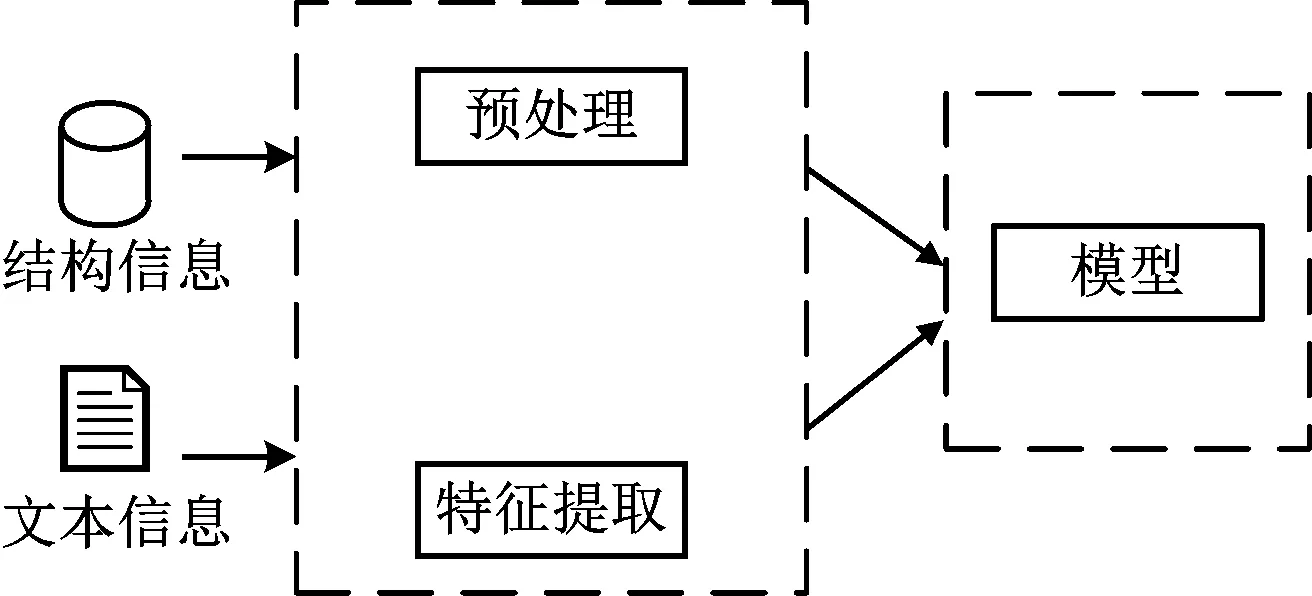

由于非結構化文本數據和結構化數據的數據類型之間存在巨大差異,因此第一階段將它們分開處理,該階段僅將文本數據納入基于結構化數據的預測模型中。第二階段將預處理的結構化信息和文本信息進行組合來構建預測模型,如圖3所示,將文本數據與卷積神經網絡進行合并。

圖3 基于文本信息的CNN讀者流失預測模型

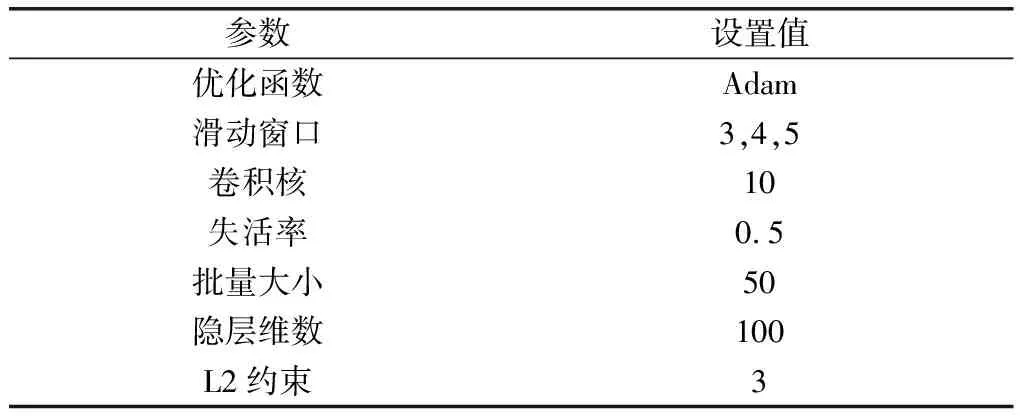

本節構造了一個非靜態的CNN來處理文本數據,嵌入層之后是一維卷積層和最大池化層,將這些層的輸出合并在一起作為全連接層的輸入。最后一層使用sigmoid激活函數,該函數對每個讀者可生成其流失概率。基于先前的研究經驗,本文CNN的參數設置如表1所示。

表1 CNN模型參數

4 實驗與仿真

4.1 數據來源

模型搭建過程中需要建立模型的目標變量,這些變量包括讀者屬性信息、讀者借閱行為信息和圖書館屬性信息。本文選取西安市某圖書館2018年1月~2018年12月共3 300組數據,將其分為兩部分對模型進行訓練和驗證,其中2018年1月~2018年11月的3 000組數據用于訓練模型,2018年12月的300組數據用于對模型進行驗證。

4.2 仿真驗證

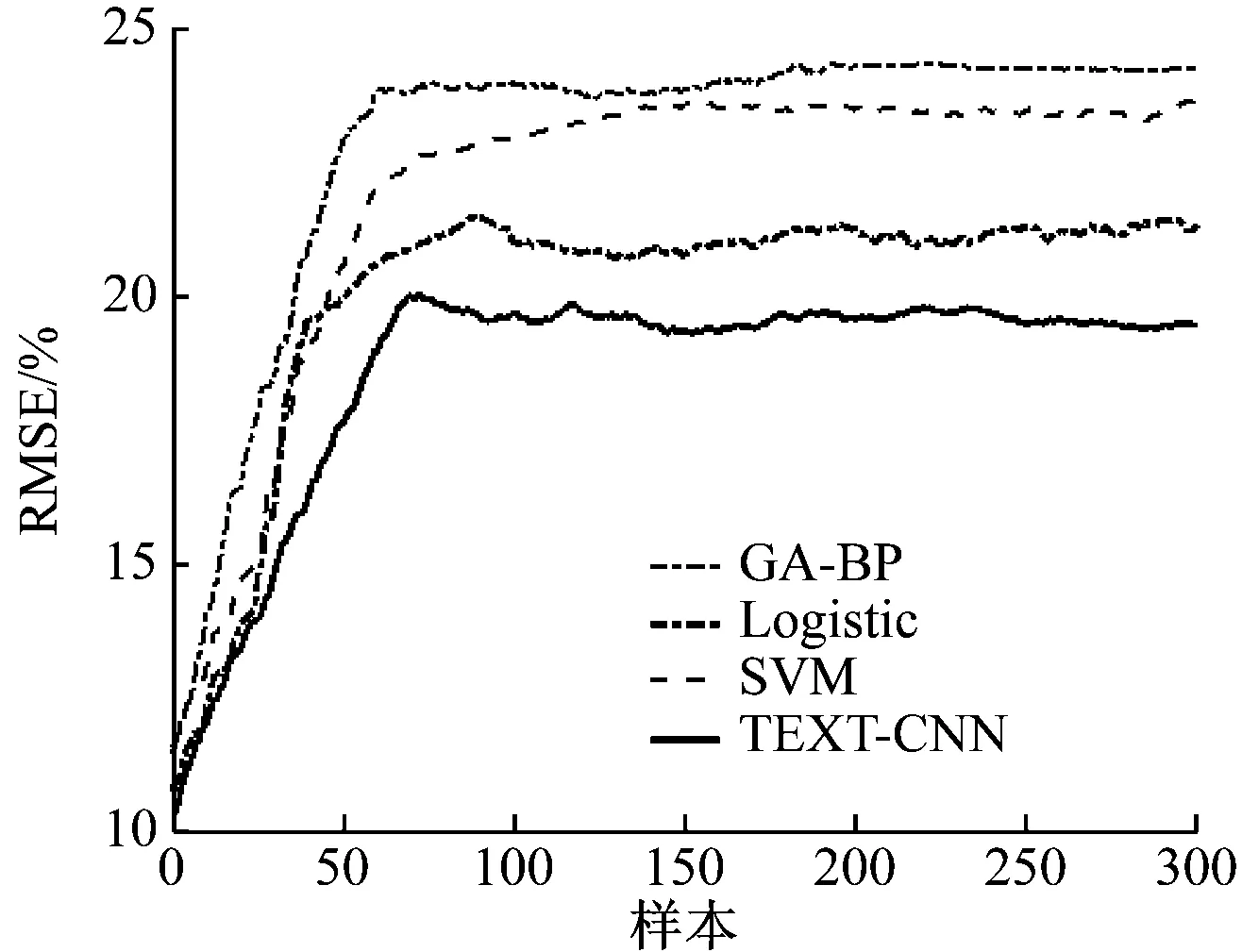

根據所選取的數據進行讀者流失的預測,輸入為某圖書館 2018年1月至2018年11月的讀者數據,目標變量為2018年12月的讀者流失數據,并將本研究中所用模型TEXT-CNN與遺傳算法優化的BP神經網絡(GA-BP)模型、支持向量機(SVM)模型以及邏輯回歸(Logistic)模型的預測結果進行比較,各模型的預測誤差如圖4所示。

圖4 4種模型預測誤差對比

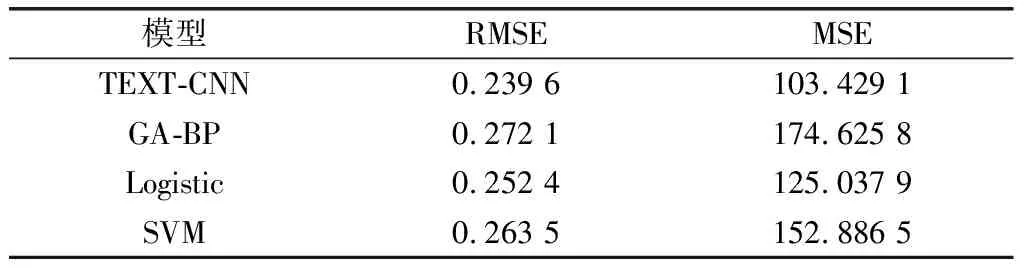

由圖4可知,TEXT-CNN的預測誤差明顯低于其他模型的預測誤差,采用將文本信息納入卷積神經網絡的結果要比實際讀者流失的變動曲線擬合效果更好。利用均方根誤差(root mean square error,RMSE)和均方誤差(mean square error,MSE)2個指標進行衡量并對比分析(結果如表2所示),由表2可以看出,TEXT-CNN模型的預測結果相對應的RMSE和MSE均為最小,同時相對其他3種模型可靠性也最高。

表2 4種模型的RMSE和MSE數值表

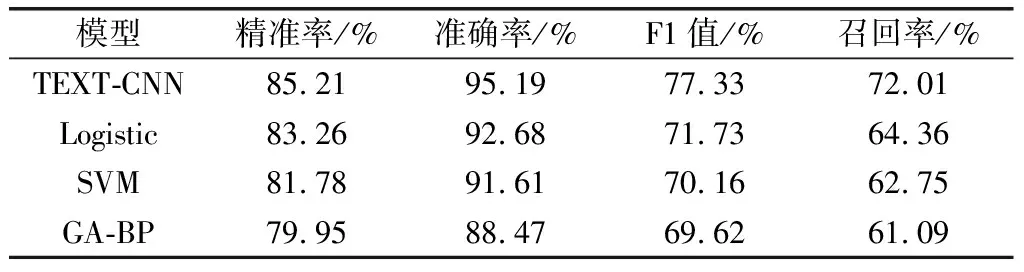

為了進一步分析各模型的性能,本節對各模型的精準率、準確率、F1值和召回率進行比較,結果如表3所示。

表3 4種模型預測結果

由表3可知,本文所用的TEXT-CNN神經網絡的精準率為85.21%,F1值為77.33%,均比其他3種模型略高;準確率為95.19%,比Logistic、SVM和GA-BP模型分別高2.51%、3.58%和6.72%;召回率為72.01%,分別高出Logistic模型7.65%、SVM模型9.26%和GA-BP模型10.92%。該結果表明TEXT-CNN模型相比于其他3種模型能夠更有效地對讀者流失情況進行預測。

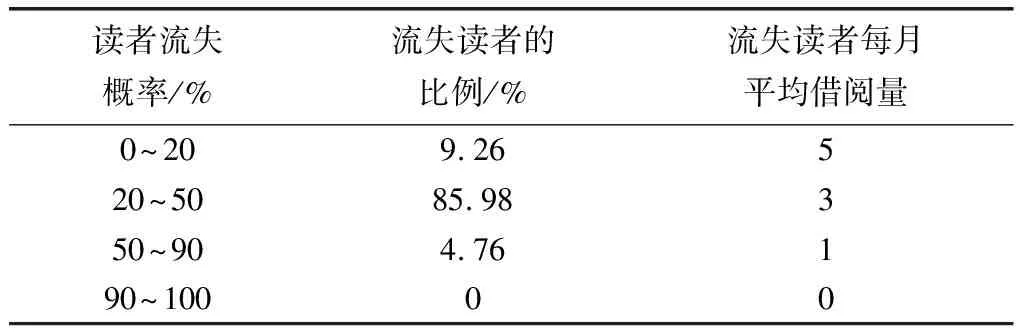

根據模型輸入的目標變量數據,生成讀者流失概率的信息列表,如表4所示。

由表4可知,模型的預測結果與圖書館的日常借閱情況相符,可用于圖書館讀者流失的預測,具有較強的實用性。根據預測結果,圖書館管理人員針對可能流失的原因進行分

析,對不同的讀者群體采取相應的措施。

表4 讀者信息列表

5 總結

通過對圖書館用戶流失原因的深入剖析,基于圖書館屬性和讀者屬性的文本信息結合卷積神經網絡構建了TEXT-CNN預測模型,并通過西安市某圖書館的實際樣本數據,分別將TEXT-CNN模型和Logistic模型、SVM模型及GA-BP模型的預測結果進行了比較,結果顯示,本文提出的模型在精準率、準確率、F1值和召回率方面均高于其他3種模型,預測結果與流失的讀者信息也基本一致。該模型能夠幫助圖書館準確分析讀者流失的實際情況,為全面有效地開展圖書館管理工作提供更好的決策支持。