基于元強化學習的無人機自主避障與目標追蹤

江未來 吳俊 王耀南

摘要:針對傳統深度強化學習在求解無人機自主避障與目標追蹤任務時所存在的訓練效率低、環境適應性差的問題,在深度確定性策略梯度(Deep Deterministic Policy Gradient,DDPG)算法中融入與模型無關的元學習(Model-Agnostic Meta-Learning,MAML),設計一種內外部元參數更新規則,提出了元深度確定性策略梯度(Meta-Deep Deterministic Policy Gradient,Meta-DDPG)算法,以提升模型的收斂速度和泛化能力.此外,在模型預訓練部分構造基本元任務集以提升實際工程中的預訓練效率.最后,在多種測試環境下對所提算法進行了仿真驗證,結果表明基本元任務集的引入可使模型預訓練效果更優,Meta-DDPG算法相比DDPG算法在收斂特性和環境適應性方面更有優勢,并且元學習方法和基本元任務集對確定性策略強化學習具有通用性.

關鍵詞:元強化學習;無人機;自主避障;目標追蹤;路徑規劃

中圖分類號:V249.1文獻標志碼:A

Autonomous Obstacle Avoidance and Target Tracking of UAV Based on Meta-Reinforcement Learning

JIANG Weilai1,2,WU Jun1,2,WANG Yaonan1,2

(1. College of Electrical and Information Engineering,Hunan Unviersity,Changsha 410082,China;2. National Engineering Research Center of Robot Visual Perception & Control Technology,Hunan University,Changsha 410082,China)

Abstract:There are some problems with traditional deep reinforcement learning in solving autonomous obstacle avoidance and target tracking tasks for unmanned aerial vehicles(UAV),such as low training efficiency and weak adaptability to variable environments. To overcome these problems,this paper designs an internal and external metaparameter update rule by incorporating Model-Agnostic Meta-Learning (MAML)into Deep Deterministic Policy Gradient (DDPG)algorithm and proposes a Meta-Deep Deterministic Policy Gradient (Meta-DDPG)algorithm inovder to improve the convergence speed and generalization ability of the model. Furthermore,the basic meta-task sets are constructed in the model,s pre-training stage to improve the efficiency of pre-training in practical engineering. Finally,the proposed algorithm is simulated and verified in Various testing environments. The results show thatthe introduction of the basic meta-task sets can make the model’s pre-training more efficient,Meta-DDPG algorithm has better convergence characteristics and environmental adaptability when compared with the DDPG algorithm. Furthermore,the meta-learning and the basic meta-task sets are universal to deterministic policy reinforcement learning.

Key words:meta-reinforcement learning;Unmanned Aerial Vehicle(UAV);autonomous obstacle avoidance;target tracking;path planning

隨著衛星導航、信號傳輸、電氣儲能等相關技術的進步,無人機的應用領域在不斷擴大,如森林防火、電力巡檢、物流運輸等.這些任務的基本前提均為無人機目標追蹤,只有追上目標或到達指定地點才可以繼續執行任務.無人機執行目標追蹤任務時不可避免地會遇到障礙物,例如房屋、樹木、電線等. 如何讓無人機安全自主地避開障礙物并實現目標追蹤是無人機領域一大研究熱點.

傳統避障算法有蟻群算法[1]、最短路徑制導向量場[2]和貝葉斯推理等.這些算法都是將避障問題轉換為優化問題,通過求解優化模型而得到最終的無人機飛行軌跡.但是這些方法由于存在迭代時間長、泛化能力弱、智能化水平低等缺點,無法適用于環境多變或環境未知下的避障問題.隨著人工智能技術發展,深度強化學習逐漸被運用于求解無人機自主避障與目標追蹤問題.文獻[3-5]基于深度Q網絡(Deep Q Net,DQN)[6]算法完成無人機離散動作空間下路徑規劃.文獻[7-8]采用深度確定性策略梯度(Deep Deterministic Policy Gradient,DDPG)[9]算法實現無人機連續動作空間下目標追蹤的自主決策.

雖然上述算法均取得了一定的成果,但是傳統深度強化學習算法訓練速度慢,且只能應對單一環境下的任務,而當障礙物環境或目標運動軌跡改變時,智能體往往需要重新進行大量探索和訓練.因此如何提升深度強化學習算法面對復雜動態任務時的收斂速度和適應性成為強化學習領域的一大熱點和難點.

近年來,有學者將元學習與深度強化學習相結合,提出了元強化學習概念.元學習主張讓機器學習如何學習,人類之所以比機器更智能是因為當遇到一個新任務時,人類知道怎么在短時間內得出執行任務的要領.Finn等[10]提出與模型無關的元學習(Model-Agnostic Meta-Learning,MAML),可適用于任何采用梯度下降更新方法的機器學習算法.Wang等[11]首次將長短期記憶網絡與強化學習結合,使得神經網絡具有能夠獨立訓練任務的能力.Xu等[12]提出在深度強化學習神經網絡中添加嵌入層對上下文潛在變量進行元訓練以提高分布式數據挖掘的效率.然而,發揮元強化學習可根據新任務自主適應的優勢,用以解決復雜動態環境下的無人機自主避障與目標追蹤問題鮮有報道.

綜上,為解決傳統深度強化學習在求解無人機自主避障與目標追蹤任務時收斂特性差、環境適應性弱的問題,本文提出了一種元深度確定性策略梯度(Meta-Deep Deterministic Policy Gradient,Meta- DDPG)算法.將元學習算法MAML與深度強化學習算法DDPG相結合,在預訓練過程中設計內外部元參數更新規則,獲取可以適應多種任務的元初始參數.此外,構造基本元任務集運用于Meta-DDPG算法預訓練階段.最后仿真結果表明,采用基本元任務集使得工程應用更加高效,Meta-DDPG算法與DDPG算法相比具有更優的收斂特性與環境適應性,并且元學習方法和基本元任務集對確定性策略強化學習算法具有較高的通用性.

1問題描述

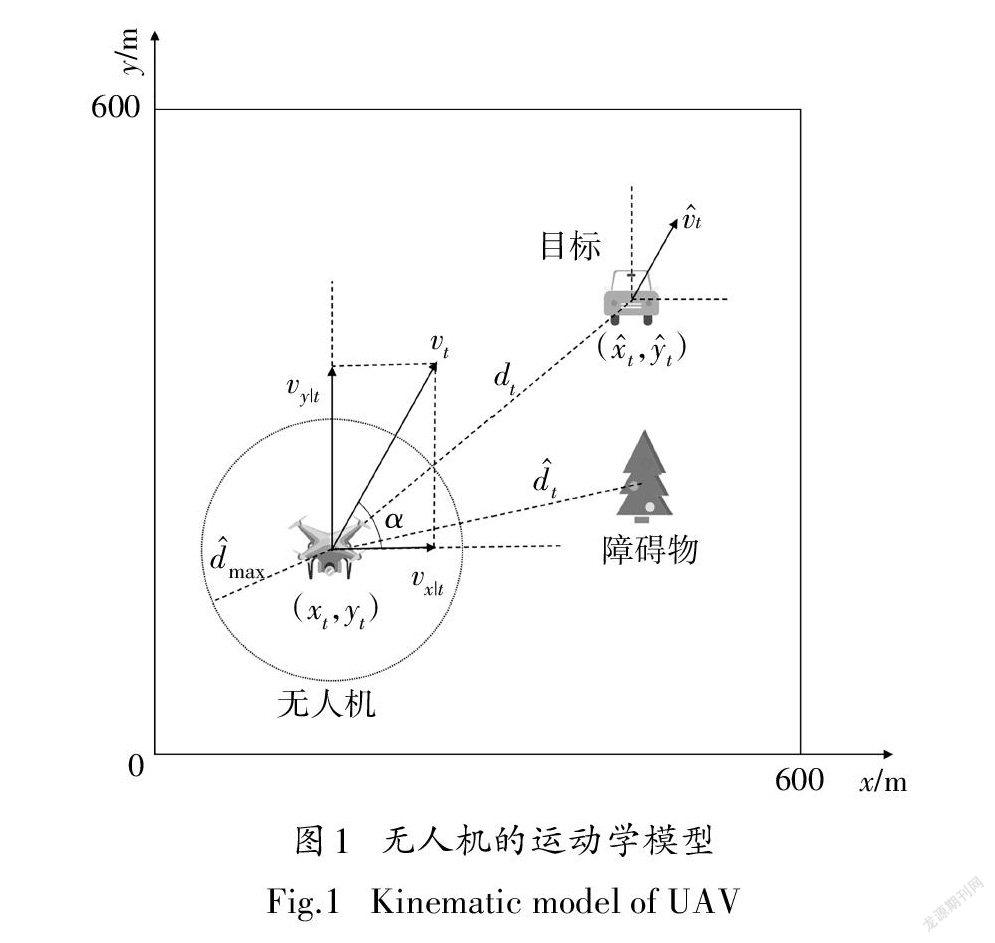

1.1無人機運動模型

考慮到實際情況中無人機速度不能瞬間變化,故無人機運動方程可表示為

式中:n為無人機t時刻的加速度大小;α為加速度方向與水平線的夾角.

1.2無人機自主避障與目標追蹤任務建模

為了更好地描述無人機自主避障與目標追蹤任務,將其定義為馬爾可夫決策過程(Markov decision process,MDP). MDP由狀態空間S、動作空間A、狀態轉移概率P、獎勵函數R和折扣因子γ組成,并以元組表示為(S,A,P,R,γ).在該任務中狀態空間S為無人機的本體狀態與傳感器采集的環境信息;動作空間A為無人機采取的追蹤動作;狀態轉移概率P[s丨s,a]為狀態s下執行動作a轉移到s的概率;獎勵函數R為在狀態s下采取動作a,無人機可以獲得的即時獎勵,即R(s,a);折扣因子γ為未來獎勵對當前狀態的影響因素.在此定義動作值函數的貝爾曼方程為

式中:π表示智能體所采取的動作序列,稱為策略;

Q(s,a)表示在狀態s處,采取動作a后,所得到的折扣累計獎勵的期望.根據Q(s,a)值大小可評估策略π的優劣.

1.2.1狀態空間S

狀態空間S為智能體自身狀態和環境信息的集

最終狀態空間S記作

1.2.2動作空間A

動作空間A為智能體可執行的動作.由于無人機速度不能瞬間變化,所以動作空間由加速度大小n和加速度方向與水平線的夾角α組成,同樣進行歸一化為

式中,n為無人機最大加速度.

所以動作空間A記作

A=[n′,α′](7)

深度強化學習算法最終目標是獲得最優策略π,即在任意狀態s下所執行的動作a.

1.2.3獎勵函數R

獎勵函數的設定對深度強化學習的訓練結果至關重要,不同的獎勵函數對模型收斂特性影響都不同.此任務中,若采用稀疏獎勵,也即只在無人機追蹤成功或失敗后才反饋獎勵,會造成收斂速度緩慢的問題.因此本文設置連續獎勵函數為

2DDPG算法

DDPG是一種處理連續狀態空間和動作空間問題的確定性策略強化學習算法.傳統演員-評論家(Actor-Critic,AC)算法中演員網絡與評論家網絡在訓練時往往不穩定.DDPG算法針對此問題,分別構建了一對結構完全相同的評估(Eval)神經網絡和目標(Target)神經網絡.其中Eval神經網絡用于訓練更新網絡參數,Target神經網絡采用軟更新的方式來跟隨Eval神經網絡參數,保證訓練過程的穩定性.

對于演員Eval網絡,可訓練參數為θ,輸入為狀態s,輸出為動作a.演員Eval神經網絡損失函數為

Target神經網絡采用式(14)周期性地進行軟更新,其中τ是常數.

3MAML

元學習使智能體具有學會學習的能力[14].元學習的重點在于如何在模型中引入先驗知識,并在訓練過程中優化外部記憶,從而在訓練新任務時更快更準確地學習.MAML與其他深度學習算法不同之處在于其不是尋找完成某個任務的最優參數,而是通過訓練一系列與任務相關的元任務來尋找使模型在面對新任務時快速達到最優的初始參數η.η具有對新任務學習域分布的敏感特性,在面臨新任務時可使訓練模型內部的某些特征更容易地在多種任務之間相互轉換,經過幾步更新后即可獲得最優的模型網絡參數.MAML梯度下降過程如圖2所示.圖中,η表示經過MAML預訓練后得到的初始化參數;L,L,L分別表示新任務的損失函數;▽表示梯度算子;η,η,η表示在新任務下的最優更新方向.

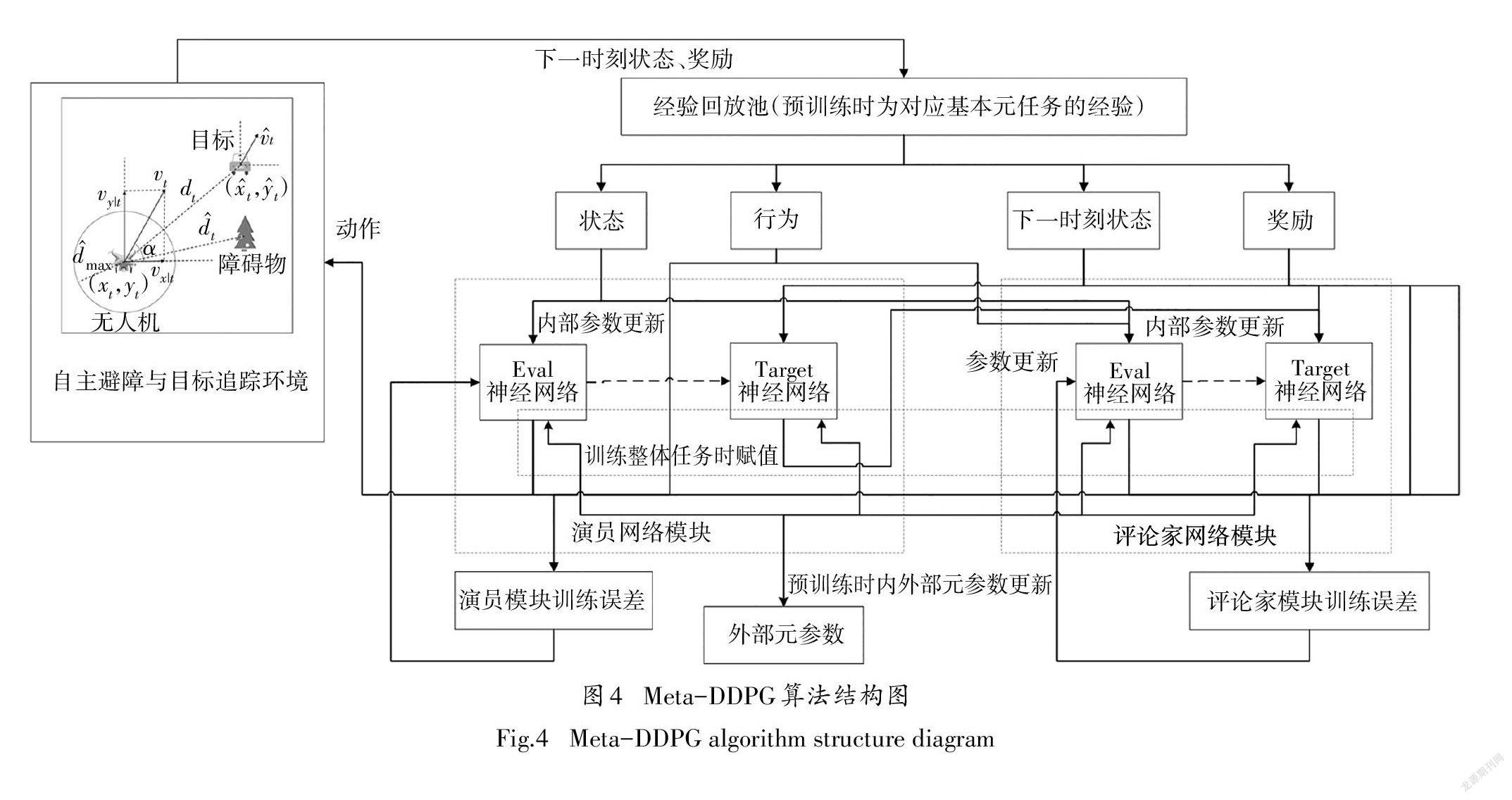

4元強化學習

在深度強化學習的訓練過程中,神經網絡的不確定性往往會導致算法收斂特性較差,且訓練的結果是一個僅適應當前任務和環境的策略.針對深度強化學習實施過程中存在的上述問題,本文在DDPG算法中引入MAML,提出一種元強化學習算法——Meta-DDPG算法.其基本思想是設計一種內外部元參數更新規則以獲得一組元初始參數,提高模型面對不同任務的收斂速度和環境適應性.

4.1基本元任務集

環境適應性是指模型面對一個新任務環境時經過少量訓練便可獲取正確策略的能力.元強化學習需要利用元任務集獲得先驗知識而提升模型的環境適應性,大部分元強化學習中的元任務集與實際任務場景相似[15-16].若把多種不同的復雜測試環境作為求解無人機自主避障與目標追蹤問題的元任務集,使用Meta-DDPG算法進行預訓練將花費大量時間,降低工程效率.為此,根據MAML中元任務的定義,將一個復雜多變的整體任務分解為多個只完成單一子任務目標的基本元任務,并將它們構成基本元任務集T={T,T,…,T},其中T為第j個基本元

在無人機自主避障與目標追蹤任務中,基本元任務集中包含無人機追蹤與無人機避障兩個基本元任務,如圖3所示.在Meta-DDPG算法預訓練中,首先學習無人機在無障礙物環境下靜態目標追蹤策略,然后學習無人機在簡單障礙物環境下的自主避障策略,最終獲得一個可以適應自主避障和目標追蹤新任務的元初始參數.由于基本元任務都較為簡單,只需要較少幕數便可獲取其中的先驗知識,提高了預訓練的效率.

4.2Meta-DDPG算法

Meta-DDPG算法分為預訓練和整體任務訓練兩部分.在預訓練中,設計一種內外部元參數更新規則,內部網絡訓練和外部元參數更新以一定的頻率交替進行.內部網絡依次學習各個基本元任務獲得不同的內部參數,外部元參數更新通過優化不同的參數獲得一個環境適應性較強的元初始參數.在整體任務訓練中,對于不同測試環境下無人機自主避障與目標追蹤,Meta-DDPG算法僅通過少量訓練幕數就能快速收斂,獲取正確動作策略.

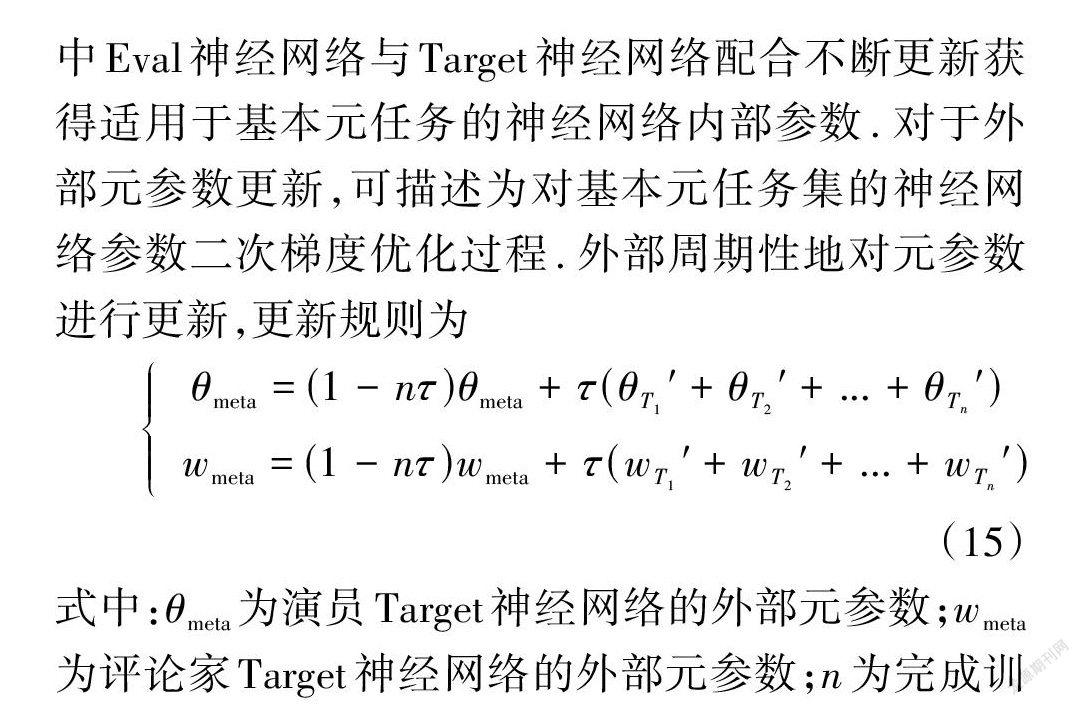

Meta-DDPG預訓練中內部參數更新可描述為依次對每個基本元任務的訓練過程,利用Meta-DDPG中Eval神經網絡與Target神經網絡配合不斷更新獲得適用于基本元任務的神經網絡內部參數.對于外部元參數更新,可描述為對基本元任務集的神經網絡參數二次梯度優化過程.外部周期性地對元參數進行更新,更新規則為

以基本元任務T為例,當Meta-DDPG網絡內部更新一定步數后外部元參數也進行更新.在每個基本元任務交替過程中,將外部元參數賦值給內部參數作為下一個基本元任務T的初始參數,直至遍歷完基本元任務集后獲得整體任務的元初始參數. 預訓練流程如算法1所示.

通過以上算法可獲得無人機自主避障與目標追蹤任務的元初始參數θ0、w.訓練整體任務時利用此參數初始化,模型可充分利用先驗知識,僅需少量迭代便可收斂并獲得完成任務的策略,后續對整體任務的訓練過程與DDPG算法相同,在此不再贅述. 另需指出的是,本文所提出的Meta-DDPG算法面對新任務時不必重復預訓練,只需使用元初始參數進行網絡初始化.

5仿真結果與分析

使用Meta-DDPG算法求解無人機自主避障與目標追蹤任務.設定追蹤場景為600 m×600 m的二維正方形領域,場景中存在多個障礙物,并且當目標感知無人機靠近時會產生逃逸動作.無人機可利用GPS等設備獲取目標位置且通過傳感器獲取與障礙物的距離.當無人機自主避開障礙物并追蹤到目標視為任務成功;當無人機撞上障礙物、無人機或目標離開正方形領域兩種情況視為任務失敗.

5.1實驗參數

5.2深度神經網絡結構

根據式(5)知狀態空間S包含7個參數,故演員深度神經網絡為7維輸入;由式(7)動作空間A包含2個參數,故為2維輸出.評論家深度神經網絡輸入為當前狀態與演員深度神經網絡輸出的動作,故為9維輸入;輸出為行為值Q(s,a),故為1維輸出.由上可設演員和評論家深度神經網絡結構分別為7×256×256×256×2和9×256×256×256×1.

演員深度神經網絡中,輸出動作均歸一化至[- 1,1],輸出層使用Tanh激活函數,其余層均使用Relu激活函數.評論家深度神經網絡中,輸出層為線性激活函數以確保行為值Q(s,a)正常輸出,其余層也均使用Relu激活函數.

5.3實驗結果

5.3.1基本元任務集預訓練效果驗證

構造基本元任務集,將無人機自主避障與目標追蹤任務分解為無人機追蹤與無人機避障兩個基本元任務并分別構建經驗回放池,如圖3所示.作為對比,將圖5中兩個復雜測試環境下動態目標追蹤任務作為復雜元任務集.使用Meta-DDPG算法,對兩種元任務集各進行共200幕預訓練.整體任務為圖6(2)中測試環境(1)下的無人機自主避障與目標追蹤.

利用平均獎勵值的收斂特性來衡量網絡的預訓練效果.如圖6(b)所示,可知在每個元任務訓練100 幕的情況下,當采用基本元任務集時可以更充分地利用先驗知識獲得適應整體任務的元初始參數.平均獎勵值的上升速度與收斂特性都優于復雜元任務集.Meta-DDPG算法整體任務測試結果如圖6(a)所示.

5.3.2Meta-DDPG收斂特性驗證

使用5.3.1節中預訓練獲得的元初始參數,在圖7(a)測試環境(2)中進行500幕訓練后測試.為了更好地體現Meta-DDPG在收斂速度上的優勢,使用不經預訓練的DDPG算法與之比較.利用平均獎勵值的收斂特性和Tensorboard中演員Eval神經網絡的Loss值來衡量算法的性能,仿真曲線分別如圖7(b)、圖7(c)所示.

由圖7(b)可知,使用Meta-DDPG算法時,平均獎勵值在訓練伊始就迅速上升,且經過150幕訓練后逐漸達到收斂.由圖7(c)知元初始參數可使演員Eval網絡Loss值迅速下降,并在訓練120幕后在一個較低的范圍內波動.使用Meta-DDPG訓練500幕所得模型進行測試,測試結果如圖7(a)所示,由圖知無人機可自主繞過障礙物并準確地追上逃逸的目標. 而DDPG算法由于先驗知識缺失、探索效率低、經驗樣本質量差等原因,在較短的訓練幕數與較少的經驗池容量下陷入錯誤的局部最優,無法得到完成此任務的策略.圖7(b)可知平均獎勵曲線無法正確地收斂,平均獎勵始終小于0.圖7(c)可知DDPG無法通過訓練使演員Eval網絡Loss函數梯度下降,loss值始終大于0.

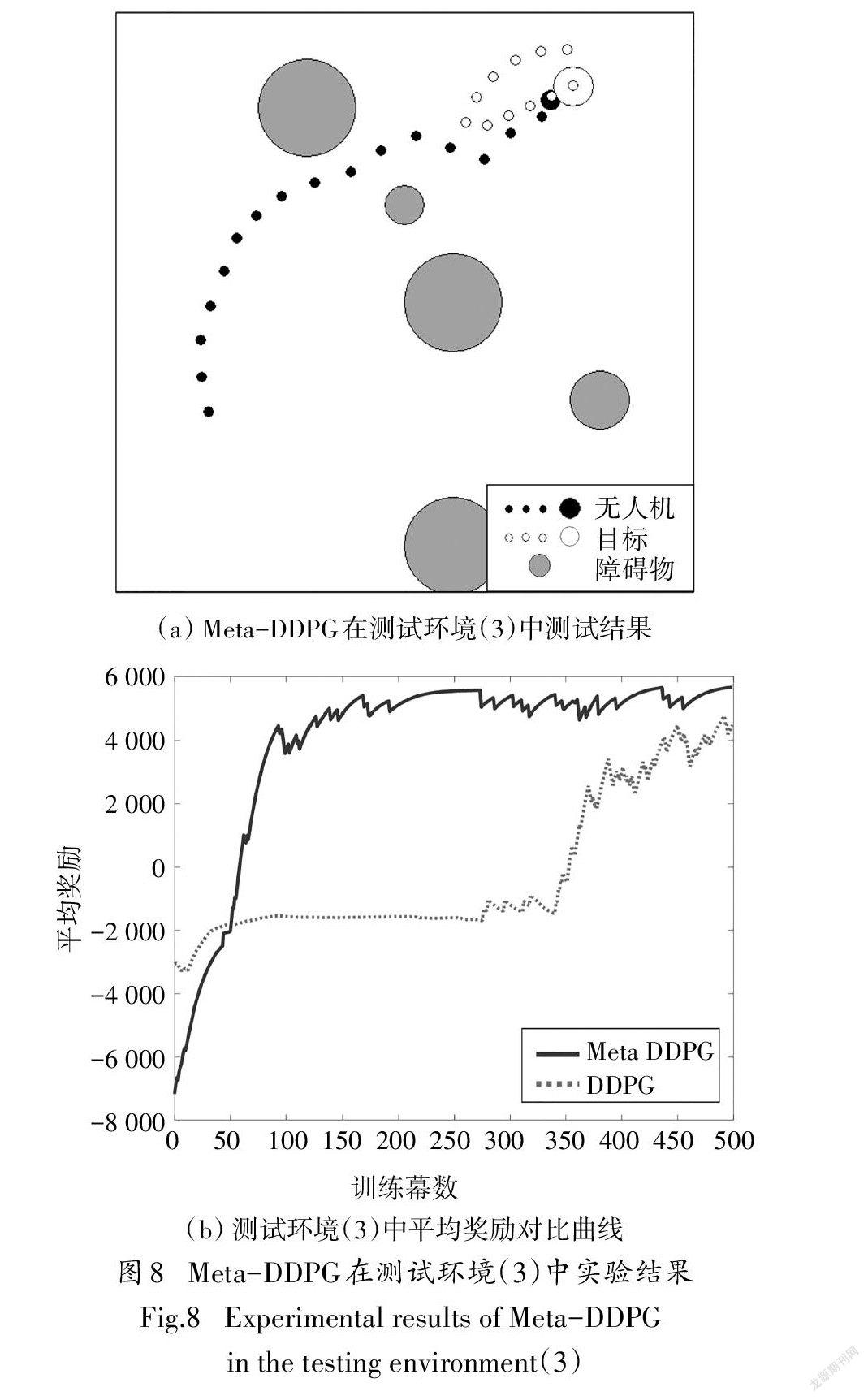

5.3.3Meta-DDPG環境適應性驗證

為了突出Meta-DDPG算法的環境適應性,在如圖8(a)所示障礙物大小不同、目標運動軌跡不同的測試環境(3)中,使用與5.3.2節相同的元初始參數進行訓練與測試.作為對比,使用能夠在測試環境(1)中完成任務的DDPG算法模型進行訓練.由圖8(b)可知,Meta-DDPG算法的平均獎勵在訓練伊始就快速上升,150幕后相對穩定,環境適應性較強.而DDPG算法的平均獎勵值在350幕才開始上升,且在500幕內尚未收斂.Meta-DDPG算法整體任務測試結果如圖8(a)所示.

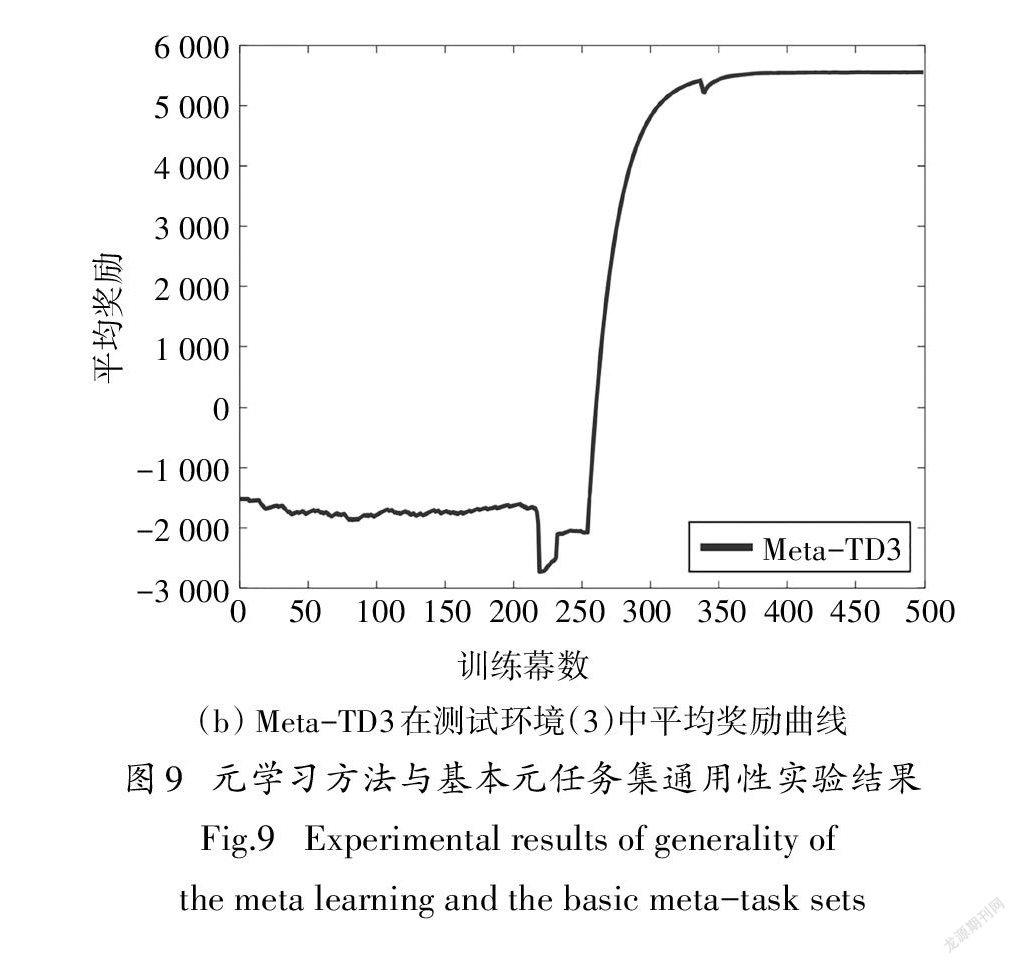

5.3.4元學習方法與基本元任務集通用性驗證

為了體現元學習方法和基本元任務集對確定性策略強化學習算法的通用性,將其運用于與DDPG 算法同為確定性策略的雙延遲深度確定性策略梯度(Twin Delayed Deep Deterministic Policy Gradient,TD3)[17]算法,構造Meta-TD3算法.使用圖3的基本元任務集預訓練,并在測試環境(2)-(3)中對其收斂特性和環境適應性進行仿真驗證,仿真結果見圖9.

由圖9(a)可知,Meta-TD3算法與Meta-DDPG算法結果類似,均可在較短訓練幕數與較小經驗池容量下充分利用元初始參數內的先驗知識,平均獎勵曲線在250幕后逐漸收斂.而TD3算法在此情況下同樣陷入錯誤的局部最優,無法正確收斂且平均獎勵始終小于0.由圖9(b)可知Meta-TD3算法面對新測試環境時可在300幕后逐漸達到收斂,具有較高的環境適應性.以上表明元學習方法和基本元任務集對確定性策略強化學習算法具有較好的通用性,且元強化學習方法能夠有效地解決傳統深度強化學習算法中存在的收斂特性差、面對新任務泛化能力弱的問題.

6結論

本文對無人機自主避障與目標追蹤任務進行建模,將深度強化學習算法DDPG與元學習算法MAML結合,并設計一種內外部元參數更新規則,提出元強化學習算法Meta-DDPG.該算法能夠有效地解決傳統深度強化學習存在的收斂特性差、面對新任務泛化能力弱的問題.此外,構建基本元任務集以提升工程應用時預訓練的效率.仿真結果表明,在求解無人機自主避障與目標追蹤任務時,不論是對于該無人機任務訓練的收斂特性,還是面對不同任務的環境適應性,Meta-DDPG算法與DDPG算法對比都有著顯著的提高.同時,使用基本元任務集進行預訓練時,比傳統元任務集更為高效.且元學習方法和基本元任務集對于確定性策略強化學習算法具有較好的通用性.

參考文獻

[1]馬小銘,靳伍銀.基于改進蟻群算法的多目標路徑規劃研究[J].計算技術與自動化,2020,39(4):100-105.

MA X M,JIN W Y. Mulit-objcctive path planning based on improved and colony algorithm [J]. Computing Technology and Automation,2020,39(4):100-105. (In Chinese).

[2]XU H T,HINOSTROZA M A,GUEDES SOARES C G. Modified vector field path-following control system for an underactuated autonomous surface ship modelin the presence of static obstacles [J]. Journal of Marine Science and Engineering,2021,9(6):652.

[3]ZHANG TK,LEI J Y,LIU Y W,et al. Trajectory optimization for UAV emergency communication with limited user equipment energy:a safe-DQN approach [J]. IEEE Transactions on Green Communications and Networking,2021,5(3):1236-1247.

[4]HUANG H J,YANG Y C,WANG H,et al. Deep reinforcement learning for UAV navigation through massive MIMO technique [J]. IEEE Transactions on Vehicular Technology,2020,69(1):1117-1121

[5] WU X,CHEN H L,CHEN C G,et al. The autonomous navigation and obstacle avoidance for USVs with ANOA deep reinforcement learning method[J]. Knowledge-Based Systems,2020,196:105201.

[6]MNIH V,KAVUKCUOGLU K,SILVER D,et al. Human-level control through deep reinforcement learning[J]. Nature,2015,518(7540):529-533.

[7]YOU S X,DIAO M,GAO L P,et al. Target tracking strategy using deep deterministic policy gradient[J] Applied Soft Comput- ing,2020,95:106490.

[8] HU Z J,WAN K F,GAO X G,et al. Deep reinforcement learning approach with multiple experience pools for UAV’s autonomous motion planning in complex unknown environments [J]. Sensors (Basel,Switzerland),2020,20(7):1890.

[9]LILLICRAP T P,HUNT J J,PRITZEL A,et al Continuous control with deep reinforcement learning [EB/OL]. 2015:arXiv:1509.02971 [cs. LG]. https://arxiv.org/abs/1509.02971.

[10] FINN C,ABBEEL P,LEVINE S Model-agnostic meta-learning for fast adaptation of deep networks[EB/OL]. 2017:arXiv:1703.03400[cs. LG]. https://arxiv.org/abs/1703.03400.

[11] WANG J X,KURTH-NELSON Z,TIRUMALA D,et al. Learning to reinforcement learn[EB/OL] 2016:arXiv:1611.05763[cs LG] https://arxiv.org/abs/1611.05763.

[12] XU J Y,YAO L,LI L,et al Argumentation based reinforcement learning for meta-knowledge extraction[J]. Information Sciences,2020,506:258-272

[13]張耀中,許佳林,姚康佳,等.基于DDPG算法的無人機集群追擊任務[J].航空學報,2020,41(10):324000.

ZHANG Y Z,XU J L,YAO K J,et al Pursuit missions for UAV swarms based on DDPG algorithm[J] Acta Aeronautica et Astro- nautica Sinica,2020,41(10):324000. (In Chinese).

[14]陸嘉猷,凌興宏,劉全,等.基于自適應調節策略熵的元強化學習算法[J].計算機科學,2021,48(6):168-174.

LU J Y,LING X H,LIU Q,et al Meta-reinforcement learning algorithm based on automating policy entropy[J] Computer Sci- ence,2021,48(6):168-174 (In Chinese).

[15] HU Y,CHEN M Z,SAAD W,et al Distributed multi-agent meta learning for trajectory design in wireless drone networks[J] IEEE Journal on Selected Areas in Communications,2021,39 (10):3177-3192.

[16] BELKHALE S,LI R,KAHN G,et al Model-based metareinforcement learning for flight with suspended payloads [J] IEEE Robotics and Automation Letters,2021,6(2):1471-1478

[17] FUJIMOTO S,VAN HOOF H,MEGER D Addressing function approximation error in actor-critic methods[EB/OL]. 2018:arXiv:1802.09477[cs. AI]. https://arxiv.org/abs/1802.09477.