基于線性注意力機制的單樣本生成對抗網絡研究*

陳 曦,趙紅東,2,楊東旭,徐柯南,任星霖,封慧杰

(1.河北工業大學電子信息工程學院,天津 300401;2.光電信息控制和安全技術重點實驗室,天津 300308)

1 引言

圖像分析作為機器學習一個特別重要的應用領域,如何利用已有的信息合成出新的圖像是該領域的重點研究內容。2014年,Goodfellow等人[1]創造性地利用零和博弈的思想提出了一種新的網絡模型——生成對抗網絡GANs(Generative Adversarial Networks)。經過不斷的發展,GANs衍生出了許多優秀的模型。其中,將卷積神經網絡引入GANs模型取得了巨大的成功[2]。傳統的GANs訓練需要海量的訓練樣本[3 - 5]。過去一段時間,研究人員將GANs生成樣本的質量與訓練集的容量進行綁定,認為只有海量的訓練樣本才可以訓練出穩定的模型。但是,大多數情況下研究人員無法獲得足夠多的樣本。因此,少樣本甚至單樣本訓練逐漸成為關注的重點。在傳統的少樣本GANs訓練中,通常會出現具有混合特征的生成圖像,例如生成的小狗圖像具有房子的特征信息[6]。出現這種現象的原因是生成器G(Generator)和判別器D(Discriminator)更多的是通過局部信息而非全局信息進行參數迭代。為了克服大量訓練樣本難以獲取的困難,文獻[7]在少樣本研究的基礎上提出了一種單樣本學習自然風景的網絡模型SinGAN(Learning a Generative Model From a Single Natural Image),該模型可以通過單樣本學習到圖像的基本特征并且進行生成。但是,SinGAN模型的訓練時間過長不利于實際應用。研究人員想到如果模型可以盡早獲取訓練樣本的全局信息,這樣更有利于訓練收斂,從而達到縮短訓練時間的目的。Vaswani等人[8]在2016年提出了一種可以抓取更遠距離特征的提取結構——自注意力SA(Self-Attention)機制。在2019年,Zhang等人[9]將此結構應用至GANs模型實現了自注意力和生成對抗網絡的融合SAGAN(Self-Attention for GANs),在ImageNet數據集[10]上取得了巨大成功。但是,應用自注意力機制意味著加深網絡層數,需要更多的計算資源。

為了解決上述問題,研究人員將自注意力機制中的2個全卷積層用線性層代替,這種結構能大幅降低計算次數[11]。于是,本文使用一種更加輕量的注意力方法,并將其命名為線性注意力LA(Linear Attention)機制,簡稱LA方法。

對于單樣本生成對抗網絡模型而言,模型的穩定性更加重要。研究人員在SAGAN中已經證實了光譜歸一化SN(Spectral Normalization)[12]對GANs模型的穩定性發揮了巨大作用。此外,本文還使用控制變量法對模型的各項性能進行了大量測試,評測結果詳見本文第4節。

2 相關工作

近年來,計算機視覺領域內針對少樣本訓練GANs開展了諸如文本生成圖像、圖像超分辨和圖像編輯等多項研究[13 - 15]。Shaham等人[7]提出的SinGAN模型是第1個將自然圖像引入基于GANs內部結構的網絡模型,并且對圖像特征進行了詳細的描述。最近的研究表明,在單樣本上訓練模型可以學到圖像的基本特點,并且生成具有訓練圖像基本特征的高質量圖像。但是,鑒于單樣本生成對抗網絡的模型依舊很少,現有較為成熟的大多數都只適用于紋理圖像,對于特征信息復雜的樣本圖像生成結果依舊不理想。針對SinGAN模型存在的問題,文獻[16]提出了新的解決方案,縮短了模型的訓練速度。目前,用于單樣本訓練生成對抗網絡的模型中,比較成熟的有SinGAN和InGAN(Internal GAN)[13],它們都是基于對圖像整體結構的把控以及生成圖像和真實圖像之間雙向相似性度量進行圖像生成的。

最近,注意力模型活躍在計算機視覺的各個領域中,并發揮了其顯著優勢。其中,作為注意力模型中的代表,自注意力模型可以有效地學習全局的依賴結構,尤其在單樣本任務中學習到有效的全局依賴結構顯得十分重要。Parmar等人[17]提出了一種添加了自注意力機制的圖像到圖像的轉化模型來實現圖像生成。文獻[18]建立了一種添加了自注意力機制的最先進的圖像翻譯模型。Wang等人[19]設計了一種包含自注意力機制的空間到時間獨立且無局部信息的音頻模型。文獻[20]提出來的Attn-GAN對輸入的順序信息進行編碼處理,但是自注意力機制并不需要此步驟。SAGAN模型是一種基于自注意力機制的GAN模型,該模型并不是基于某一特定任務,但是該模型的成功以消耗大量訓練資源為代價。SAGAN針對模型訓練不穩定的問題提出了諸多解決方法,在穩定訓練模型方面為本文提供了新的思路。此外,文獻[21]提出將光譜歸一化方法應用至判別器模型中,以此來防止Lipschitz出現崩潰,該模型在ImageNet數據集的有條件圖像生成方面取得了巨大成功。文獻[22]對自注意力方法進行了改進,并將其應用至GAN中,其相較于SAGAN并沒有太大的性能提升,但所需要的計算資源卻遠遠小于SAGAN。受到上述思想的啟發,本文設計了一種新的線性注意力模型,并將其應用至單樣本生成對抗網絡中,實驗結果表明,該模型可以有效學習全局結構和圖像內部更大范圍的特征結構。

3 模型構建

生成對抗網絡包含2個主要的結構模型:生成器和判別器。生成器是利用已有信息生成具有樣本特征的新圖像。判別器更像一個簡單的二值分類器,其目的是將輸入樣本中的假樣本找出來,并且利用反饋機制更新生成器的參數,使生成器可以輸出更加真實的圖像。傳統的生成對抗網絡模型的目標函數如式(1)所示:

Ez~PZ(z)[log(1-D(G(z)))]

(1)

其中,z表示隨機噪聲,x表示訓練樣本,x~Pdata(x)表示訓練樣本x來源于數據集Pdata(x),z~PZ(z)表示噪聲z來源于噪聲序列PZ(z)。

3.1 自注意力模型

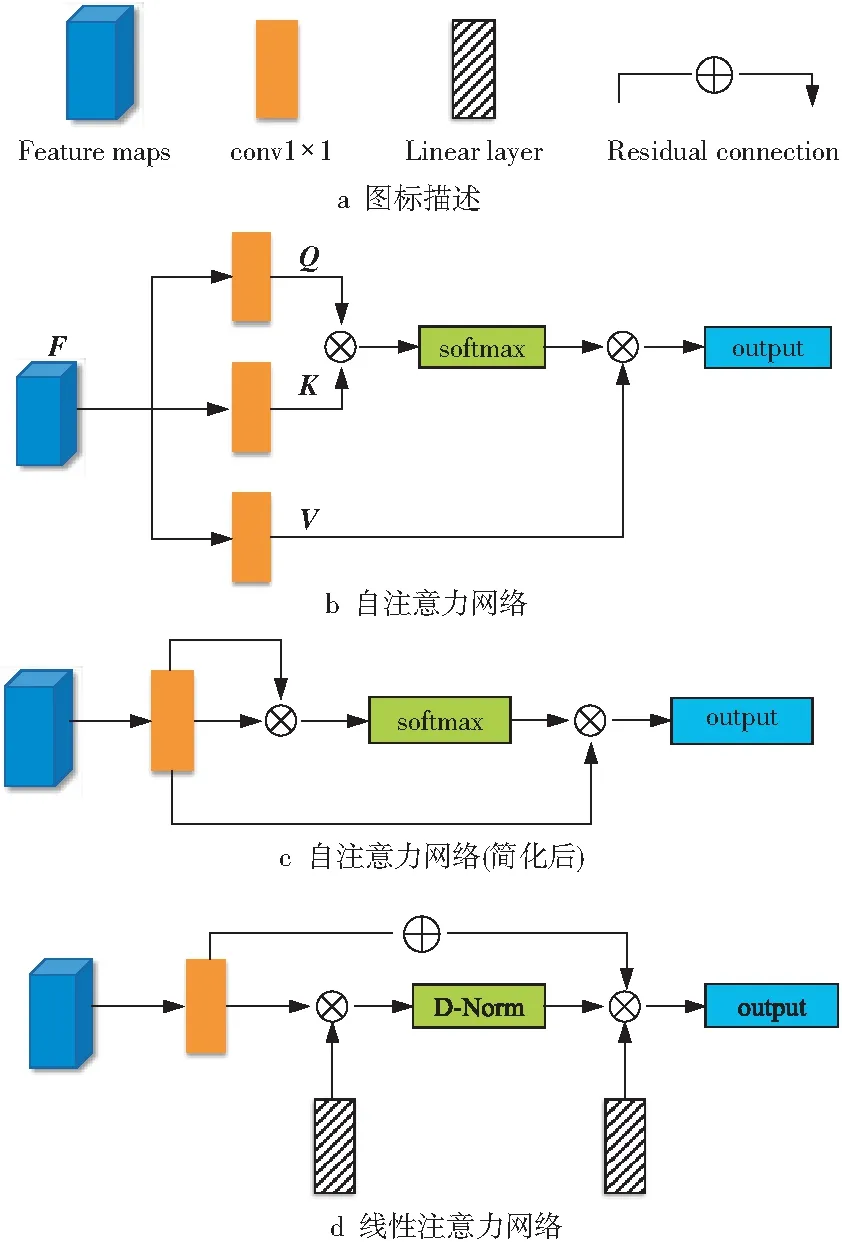

本節將簡化后的自注意力網絡和線性注意力網絡進行詳細對比(如圖1所示),并分析網絡的優缺點及其所帶來的影響。接下來通過數學推導闡述各個網絡模型的原理和優缺點。

Figure 1 Structure of the attention network圖1 注意力網絡結構

如圖1b所示的自注意力網絡[8]中,輸入特征F∈RN×d,其中,N表示輸入像素的數量,d是輸入特征的維度。自注意力網絡將輸入特征采樣為3個特征矩陣,分別是Q,K和V。自注意力機制可以表示為式(2)和式(3):

A=softmax(QKT)

(2)

Fout=AV

(3)

其中,A∈RN×N,這是由于Q,K和V都是維度為N×d的特征矩陣;softmax(·)為激活函數;Fout為自注意力機制的輸出結果,即計算得到的特征圖譜。自注意力網絡的計算復雜度為Ο(dN2),二次方運算意味著模型需要大量的計算資源。

目前更受研究人員關注的是如圖1c所示的簡化后的自注意力網絡[23]。其中,自注意力中的Q,K和V仍使用與之前相同的特征矩陣。將輸入的特征矩陣定義為F,則簡化后的表達式如式(4)和式(5)所示:

A=softmax(FFT)

(4)

Fout=AF

(5)

注意力圖譜是通過計算輸入特征相似空間上的像素得到的,其輸出信息中包含訓練樣本的特征信息。與傳統的自注意力網絡相比,簡化后的自注意力網絡省略了2個特征提取過程,結構更加簡潔。

但是,即使是簡化后的網絡,其計算復雜度依舊是Ο(dN2),輸入像素的二次方復雜性仍會導致其不能直接應用在圖像上。因此,以前的工作是使用信息補丁而不是利用像素降低計算復雜度。

觀察自注意力工作過程可以發現,從N到N的注意力矩陣是多余的,且大多數的計算僅與少部分像素相關。因此,本文提出了一種線性注意力代替方案,通過計算輸入特征和獨立線性層獲得特征圖譜信息。

3.2 線性注意力機制

仔細觀察自注意力網絡結構可發現,無論是傳統的結構還是簡化后的結構,它們都是通過反復計算輸入特征得到特征圖譜[22]。這樣的設計雖然對于獲得遠距離特征結構有一定的益處,但是重復計算會導致大量特征信息冗余,信息利用率不高。研究人員將Q,K和V中的2個使用額外的獨立線性層L1和L2代替(如圖1d所示),用于解決計算過程中出現的信息冗余問題。因此,表達如式(6)和式(7)所示:

(6)

Fout=AL2

(7)

其中,L1,L2∈RH×d,其參數值會根據A進行更新。

與自注意力不同的是,線性注意力模型計算復雜度為Ο(dHN),不會出現二次方復雜計算。這樣的設計大大縮減需要的計算資源,縮短了訓練時間。本文提出來的方法是在像素級別進行線性運算,彌補了之前在信息補丁層面計算存在的缺陷。此外,線性注意力模型采用了殘差項,這對于抑制模型崩塌十分有用。綜上可知,線性注意力模型比自注意力模型更加有效,適合規模化使用。

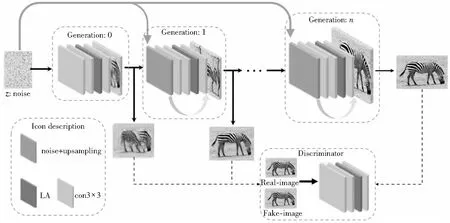

Figure 2 Structure of single sample generative adversarial network based on attention using linear layers圖2 基于線性注意力機制的單樣本生成對抗網絡結構

自注意力模型采用softmax函數對注意力圖譜進行歸一化處理。但是,注意力圖譜是通過特征矩陣的乘法得到的,對輸入特征十分敏感。為了避免這個問題,文獻[24]提出了一種新的雙重歸一化方法,分別對行和列的像素點進行了歸一化。其函數表達式如式(8)~式(10)所示:

(8)

(9)

(10)

本文將線性注意力模型應用至單樣本生成對抗網絡的生成器和判別器中,還將WGAN-GP的損失函數[25]和光譜歸一化應用到生成器網絡中,用來穩定模型,防止出現模型崩塌等問題。光譜歸一化的Lipschitz函數的梯度上界被限制,使得梯度函數更加光滑,在神經網絡優化過程中參數變化會更加穩定,不容易出現梯度爆炸。

3.3 LA模型

本文的目標是建立一個可以捕獲到訓練樣本內部統計數據的生成器模型。與傳統的GANs任務不同,此處的訓練集不是數據庫中的全部數據,而是單幅樣本圖像,且要求模型關注樣本更大范圍內的特征信息,以使輸出圖像結構合理化。

此外,大量實驗表明,金字塔結構和多尺度的訓練對提升圖像的質量和訓練速度具有顯著作用[26]。其中,最為有效的便是搭建拉普拉斯金字塔結構的生成器模型,生成的樣本圖像從低分辨率逐漸向高分辨率過渡。生成器每一層中添加隨機噪聲,以保證輸出圖像的多樣性。此外,相比于SinGAN模型,文獻[27]提出不需要凍結生成器之前的參數權重。實驗結果表明,這種設計有利于改善生成圖像的質量。

本文搭建了如圖2所示的模型,并將線性注意力機制應用至模型中。剛開始訓練時,生成器從低分辨率圖像開始輸出,直至圖像達到設定的分辨率。模型的訓練機制使用了多尺度訓練方法。如圖2所示,將生成器模型以3個為1組進行綁定訓練。例如,當模型訓練生成器n時,已經訓練好的生成器n-1和生成器n-2也會參與生成器n的訓練。具體而言,就是生成器n-1和生成器n-2的權重參數還會隨著生成器n的訓練再更新,并不對模型的權重進行鎖定。其中,權重的變化主要體現在學習率的變化。本文分別設定了2種學習率縮放因子進行比較,分別是0.1和0.5。將線性注意力機制應用至模型中有3種不同的設計方案,即分別將其放置在3個不同卷積層后,依次將其記為第1、2、3種方案。本文對上述3種方案進行了實驗比較,結果顯示:第1種方案的模型依舊難以快速抓取全局信息,生成的圖像質量差且結構布局不合理;其余2種方案的輸出結果并無太大差異,但是第3種方案獲取的信息更多,需要更多的訓練資源與訓練時間,且獲取太多的特征信息降低了生成圖像的多樣性,使得輸出圖像的布局與原始圖像的過于相似。因此,本文選擇第2種方案為最終的方案。此外,本文將殘差網絡的設計理念應用至模型中(如圖2所示),在每一個生成器的最后一個卷積層加上對上一層的輸出上采樣結果與隨機噪聲的和。

最近的工作發現光譜歸一化對穩定GANs模型的訓練尤其重要。但是,如果僅在生成器中應用光譜歸一化方法,會破壞生成器中的參數更新和梯度更新。實驗發現,將光譜歸一化放置在生成器和判別器中,可以減少判別器更新生成器參數的次數,因此會有效降低訓練過程中的資源消耗,訓練模型的表現也更加穩定。其中,單樣本生成對抗網絡的目標函數如式(11)和式(12)所示:

LD=-E(x~Pdata(x))[min(0,-1+D(x))]-

E((z~PZ(z)),(x~Pdata(x)))[min(0,-1-D(G(z),x))]

(11)

LG=-E((z~PZ(z)),(x~Pdata(x)))D(G(z),x)

(12)

4 實驗

本節將模型在不同風格的圖像上進行測試。并且利用控制變量法對其進行對比,分別對比不同訓練階段的生成結果以及不同學習率縮放因子對模型輸出結果的影響。關于評價方法,選擇文獻[6]提出來的SIFID(Single Image Fréchet Inception Distance)。相較于IS(Inception Scores)和FID(Fréchet Inception distance)等其它生成對抗網絡評價指標,SIFID的測評機制更加合理。

FID的提出者通過預先訓練的空間來提取全連接層之前的向量作為圖像的特征[28]。IS則是通過計算生成圖像與ImageNet中訓練圖像相似性進行判定。由于實驗并未采用ImageNet數據集,因此這樣的評價設置并不適用于本文模型。眾所周知,預先訓練好的神經網絡頂層可以提取圖像的高級信息,能一定程度上反映圖像本質。SIFID通過計算真實圖像和生成圖像在特征層面的距離來衡量生成圖像的質量,以及判斷紋理結構是否合理,其數學表達式如式(13)所示:

SIFID=‖μr-μg‖2+

(13)

其中,μr表示真實圖像的特征均值,μg表示生成圖像的特征均值,Σr表示真實圖像特征的協方差矩陣,Σg表示生成圖像特征的協方差矩陣。SIFID本質上計算的是真實圖像、生成圖像提取的特征向量之間差值的均值和協方差矩陣的均值。當生成圖像和真實圖像特征相近時,均值之差的平方越小,協方差也越小,SIFID的值越小。這意味著生成圖像的分布更接近真實分布。

4.1 結構設計及實驗細節

實驗中將生成圖像的尺寸設置為250×250。光譜歸一化被默認應用至生成器和判別器中。對于生成器和判別器,實驗中使用β1=β2=0.999的Adam優化器[29]進行訓練。默認生成器和判別器的學習率均為0.000 5。模型對學習率進行了縮放設計,即隨著訓練的進行,學習率也會進行更新,默認學習率縮放因子為0.1。訓練網絡每完成2 000次迭代記為一個階段,默認訓練階段為3。實驗是在顯卡為NVIDIA GTX 1060的硬件環境下進行的。

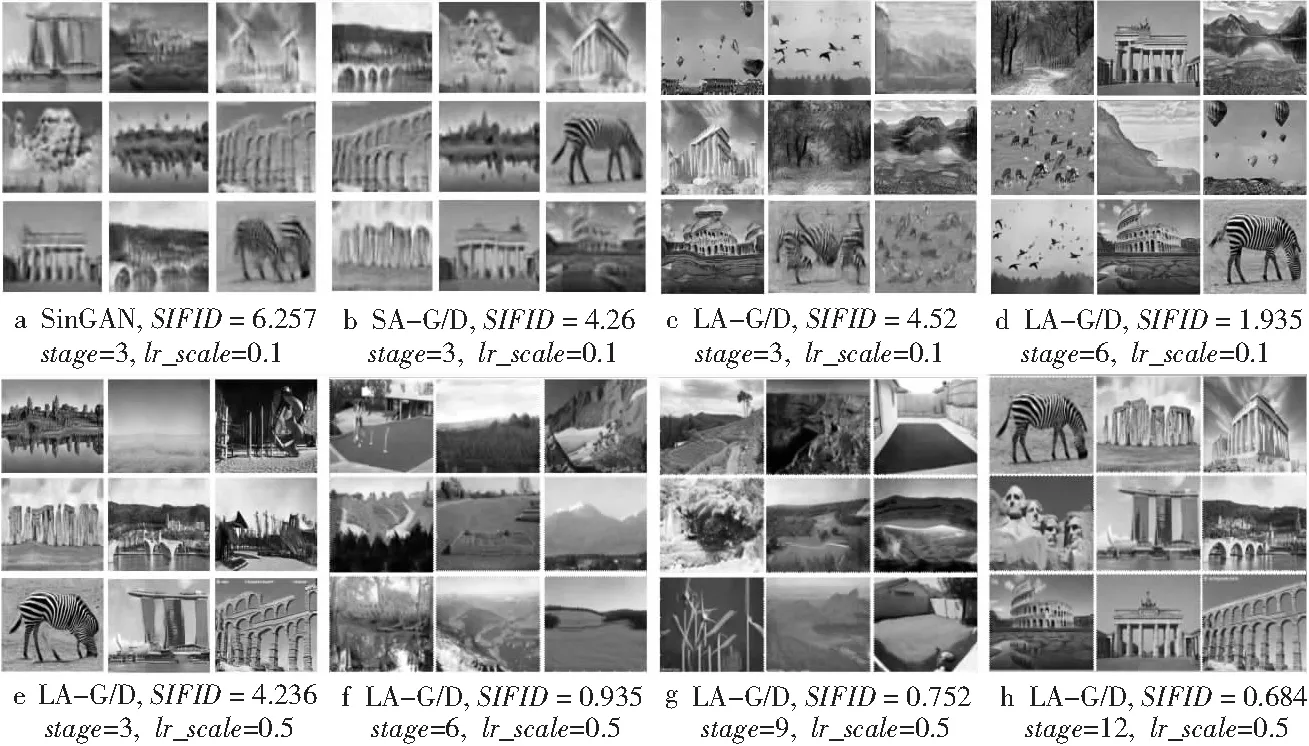

4.2 評價模型

本節從各個方面對本文提出來的模型進行評測,主要包括模型的穩定性評價、生成結果結構是否合理及模型的訓練時間等。對比測試了單樣本生成對抗網絡SinGAN模型、添加自注意力機制后的單樣本生成對抗網絡SA-G/D模型及使用LA模型的單樣本生成對抗網絡LA-G/D模型在不同數據集上的表現。

實驗在公開數據集Generation[6]、Places和CIFAR-100數據集上進行,上述數據集中包含各種類型和風格的圖像,可以很全面地檢驗模型的穩定性和魯棒性,部分實驗結果如圖3所示。研究發現,無論是自注意力還是線性注意力模型都能在較低階段快速獲取訓練樣本的全局結構,如圖3a~圖3c所示。此外,通過對比使用不同學習率縮放因子的模型生成的結果發現,較高的學習率縮放因子對模型的復原樣本結構有顯著幫助。

Figure 3 Comparison of the results among different models圖3 不同模型的生成結果對比

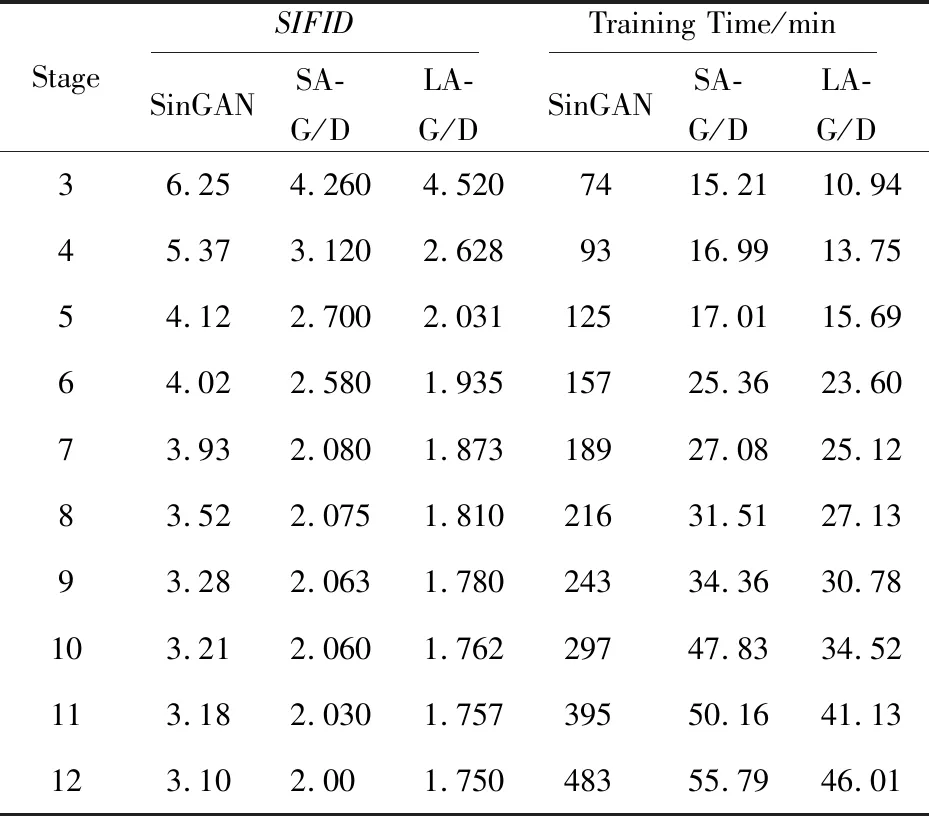

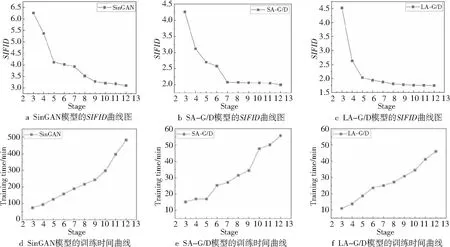

在評價結果選擇時并未區分不同的數據集,而是按照不同的模型、階段和學習率縮放因子進行。其中,實驗分別隨機選取每個模型的50個生成樣本測評其SIFID值并取平均值(如表1所示),得到不同模型各個階段的SIFID值曲線圖,如圖4a~圖4c所示,SIFID值越小則代表模型表現越好。對比之下,LA-G/D(將LA應用至生成器和判別器)模型要略優于SA-G/D(將自注意力模型應用至生成器和判別器)模型。并且,與SinGAN模型相比較,本文設計的LA-G/D模型的SIFID值、訓練時間和生成圖像視覺效果均有大幅改善,遠超過SinGAN的評測結果,并與圖3所示的生成結果相符合。

Table 1 SIFID and training time of different models (average value)

Figure 4 Comparison of SIFID and training time among different models圖4 不同模型的SIFID值和訓練時間對比曲線

LA-G/D模型由于其在注意力模型中采用了獨特的線性結構,相較于SA-G/D模型節省了更多訓練時間。實驗分別對比了SinGAN、SA-G/D和LA-G/D模型不同階段的訓練時間,如圖4d~圖4f所示。以最高訓練階段為例,SA-G/D模型的訓練時間只需SinGAN模型的1/9,而LA-G/D模型的訓練時間只有SinGAN的1/10。實驗結果表明,LA-G/D模型在訓練時間方面具有絕對優勢。

綜上所述,本文提出的基于線性注意力機制的單樣本生成對抗網絡模型較之已有模型具有顯著優勢,在評價指標SIFID和訓練時間上均改善明顯。

5 結束語

本文提出了一種基于線性注意力機制的單樣本生成對抗網絡模型。首先,該網絡僅需要單樣本就可以完成模型訓練,避免了需要獲得海量數據集所帶來的困難。然后,模型中應用了一種全新的線性注意力機制,相較于傳統的卷積注意力模型,避免了大量卷積計算帶來的信息冗余,提高了信息的利用率。其次,該模型相較于已有的網絡模型,更加容易在低階段獲得訓練圖像的全局結構,這對輸出圖像紋理結構是否合理十分有用,且更加有利于節省訓練時間。最后,本文在模型中借鑒了殘差網絡的設計思路,將帶有殘差項的線性注意力機制和光譜歸一化方法應用至模型中,以抑制模型發生崩塌的風險。本文的工作依舊有改進的空間,之后將著重研究如何構建基于線性注意力模型的單樣本多任務的生成對抗網絡結構。