移動邊緣計算中收益最大化的緩存協(xié)作策略

王亞麗,陳家超,張俊娜

移動邊緣計算中收益最大化的緩存協(xié)作策略

王亞麗1,2*,陳家超1,張俊娜1,2

(1.河南師范大學(xué) 計算機(jī)與信息工程學(xué)院,河南 新鄉(xiāng) 453007; 2.智慧商務(wù)與物聯(lián)網(wǎng)技術(shù)河南省工程實驗室(河南師范大學(xué)),河南 新鄉(xiāng) 453007)(?通信作者電子郵箱661687811@qq.com)

移動邊緣計算(MEC)通過將資源部署在用戶的近鄰區(qū)域,可以減少移動設(shè)備的能耗,降低用戶獲取服務(wù)的時延;然而,大多數(shù)有關(guān)緩存方面的研究忽略了用戶所請求服務(wù)的地域差異特性。通過研究區(qū)域所請求內(nèi)容的特點和內(nèi)容的動態(tài)性特性,提出一種收益最大化的緩存協(xié)作策略。首先,考慮用戶偏好的區(qū)域性特征,將基站分為若干協(xié)作域,使每一個區(qū)域內(nèi)的基站服務(wù)偏好相同的用戶;然后,根據(jù)自回歸移動平均(ARIMA)模型和內(nèi)容的相似度預(yù)測每個區(qū)域的內(nèi)容的流行度;最后,將緩存協(xié)作問題轉(zhuǎn)化為收益最大化問題,根據(jù)存放內(nèi)容所獲得的收益,使用貪心算法解決移動邊緣環(huán)境中緩存的內(nèi)容的放置和替換問題。仿真實驗表明,與基于MEC分組的協(xié)作緩存算法(GHCC)相比,所提算法在緩存命中率方面提高了28%,且平均傳輸時延低于GHCC。可見,所提算法可以有效提高緩存命中率,減少平均傳輸時延。

移動邊緣計算;緩存協(xié)作;用戶偏好;內(nèi)容流行度;緩存命中率

0 引言

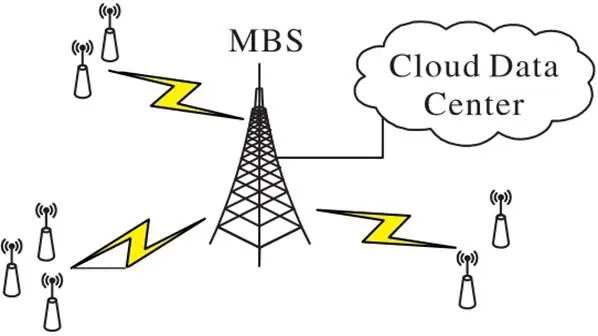

近年來,互聯(lián)網(wǎng)技術(shù)快速發(fā)展,便攜式設(shè)備大規(guī)模普及使用,無線網(wǎng)絡(luò)中數(shù)據(jù)呈指數(shù)級增長。傳統(tǒng)的集中式計算模式將所有請求遷移到云中心,移動設(shè)備和云數(shù)據(jù)中心之間由于長距離傳輸會造成巨大傳輸時延,這會大幅降低移動設(shè)備的服務(wù)質(zhì)量,損害用戶的服務(wù)體驗,甚至無法滿足實時性要求較高的應(yīng)用需求。移動邊緣計算(Mobile Edge Computing, MEC)通過將計算能力“下沉”到分布式基站[1-2],為近鄰用戶提供計算服務(wù)。在MEC中,用戶所請求的數(shù)據(jù)被緩存在邊緣基站,用戶可以直接從附近的邊緣基站獲取內(nèi)容,而無需請求云中心,從而減少數(shù)據(jù)傳輸時延,減輕骨干網(wǎng)絡(luò)的壓力。

然而,邊緣服務(wù)器的存儲容量有限,只能緩存部分內(nèi)容,而移動設(shè)備數(shù)量巨大,用戶請求多樣且隨時間變化。在這種情況下,緩存內(nèi)容的放置與替換以及邊緣服務(wù)器之間緩存協(xié)作對于減少傳輸時延、提高緩存性能至關(guān)重要。

大多數(shù)研究是在緩存大小有限的情況下優(yōu)化緩存內(nèi)容放置。在這類研究中,邊緣節(jié)點通常緩存最流行的內(nèi)容,這樣可以獲得較好的命中率。傳統(tǒng)的緩存策略如最近最少使用(Least Recently Used, LRU)、最不頻繁使用方法(Least Frequently Used , LFU)已經(jīng)得到廣泛研究[3-4];文獻(xiàn)[5]中提出了一種基于Zipf的移動邊緣主動緩存算法。然而,這些研究大多將流行度設(shè)置為靜態(tài)參數(shù)。實際上,內(nèi)容的流行度會隨時間不斷變化。邊緣服務(wù)器也可使用機(jī)器學(xué)習(xí)方法以更好地預(yù)測內(nèi)容的流行度。文獻(xiàn)[6]中應(yīng)用Q?learning算法進(jìn)行用戶偏好預(yù)測和內(nèi)容普及預(yù)測,進(jìn)而提出了一種分布式內(nèi)容緩存方案;文獻(xiàn)[7]中提出了一種基于進(jìn)化學(xué)習(xí)的內(nèi)容緩存策略,可以自適應(yīng)地學(xué)習(xí)隨時間變化的內(nèi)容流行度。然而這些研究方法均忽略了用戶偏好的地域差異特性。在實際應(yīng)用場景中,局部流行度與全局流行度差異很大。而且在緩存過程中也會出現(xiàn)一些新的內(nèi)容被用戶請求,但上述這些緩存策略因內(nèi)容設(shè)置不變,導(dǎo)致一些流行的新內(nèi)容沒有被緩存,使得緩存命中率下降。

本文綜合考慮用戶偏好的區(qū)域性以及內(nèi)容的動態(tài)性,提出了一種分區(qū)協(xié)作的緩存放置和替換策略。主要工作如下:

1)通過基站間所服務(wù)用戶的類型以及所請求內(nèi)容的類型,分析其相似度;根據(jù)相似度,采用譜聚類構(gòu)建協(xié)作域,使一個協(xié)作域中的基站服務(wù)一類或幾類用戶。

2)通過差分自回歸移動平均(Auto?Regressive Integrated Moving Average, ARIMA)模型分別預(yù)測不同區(qū)域中的內(nèi)容流行度;對于新的內(nèi)容根據(jù)內(nèi)容特征求解與現(xiàn)有流行內(nèi)容的相似度,進(jìn)而預(yù)估其流行度。

3)將緩存放置問題轉(zhuǎn)化為收益最大化問題,并通過貪心算法求解。仿真結(jié)果表明,本文提出的分區(qū)協(xié)作緩存算法可以顯著降低平均傳輸時延以及提高緩存命中率。

1 相關(guān)工作

內(nèi)容緩存旨在研究利用緩存技術(shù)達(dá)到節(jié)省帶寬、減少網(wǎng)絡(luò)時延和降低訪問花費等目的。MEC已經(jīng)有許多關(guān)于內(nèi)容緩存方面的工作。Gu等[8]提出了一種基于學(xué)習(xí)的算法以解決MEC節(jié)點的緩存替換問題。該算法通過將問題形式化為馬爾可夫決策過程,以分布式的方式解決該問題。Güven等[9]提出了一種基于線性整數(shù)問題的設(shè)備到設(shè)備(Device?to? Device, D2D)的網(wǎng)絡(luò)內(nèi)容分發(fā)和資源分配方案。以上緩存方式都是通過非合作方式完成的,但其實邊緣基站的協(xié)作可以提高緩存策略的性能。Wang等[10]考慮了基站緩存內(nèi)容的多樣性和冗余性之間的權(quán)衡,提出了一個邊緣緩存節(jié)點之間的協(xié)作緩存方案,利用粒子群優(yōu)化算法獲得了最優(yōu)的冗余度,極大地降低了總傳輸成本。Jiang等[11]提出了一種用于異構(gòu)蜂窩網(wǎng)絡(luò)的協(xié)作緩存策略,將最優(yōu)內(nèi)容緩存策略設(shè)計轉(zhuǎn)化為整數(shù)線性規(guī)劃問題,并通過次梯度方法求解。

上述緩存策略都是在內(nèi)容流行度已知的情況下實現(xiàn)的,但在實際應(yīng)用中,每個內(nèi)容未來受歡迎的程度是未知的。因此,任務(wù)流行度的預(yù)測也是一個重要的問題。Zhong等[12]采用強(qiáng)化學(xué)習(xí)的多智能體框架預(yù)測內(nèi)容流行度,將最流行的內(nèi)容預(yù)緩存在邊緣基站上,并通過協(xié)作實現(xiàn)最小的總傳輸時延。Yang等[13]提出了一種緩存輔助的NOMA MEC框架,該框架研究了任務(wù)卸載決策、計算資源分配和緩存決策的聯(lián)合優(yōu)化問題。首先,采用長短期記憶(Long Short?Term Memory, LSTM)網(wǎng)絡(luò)來預(yù)測任務(wù)流行度;接著根據(jù)所預(yù)測的任務(wù)流行度,使用一個單智能體Q?learning算法來解決該聯(lián)合優(yōu)化問題,最小化長期總能耗。Tan等[14]提出了一種利用矩陣補(bǔ)全(Matrix Completion, MC)技術(shù)進(jìn)行內(nèi)容流行度預(yù)測的方法來解決MEC的任務(wù)卸載和緩存問題,通過分析每個任務(wù)的流行度誤差,對預(yù)測誤差較低的任務(wù)進(jìn)行提前估計;然后利用MC技術(shù)對剩余流行度進(jìn)行估計;最后通過緩存與卸載帶來的收益決定所緩存的內(nèi)容。Jeon等[15]提出了一種混合式機(jī)器學(xué)習(xí)方法來預(yù)測視頻內(nèi)容的流行度,根據(jù)內(nèi)容特征將整個數(shù)據(jù)集分為兩類,并使用XGBoost算法或帶有類別嵌入的神經(jīng)網(wǎng)絡(luò)進(jìn)行流行度預(yù)測。此外,用戶請求存在地域差異,但大多數(shù)內(nèi)容放置策略都只考慮了內(nèi)容的全球流行度[16]。針對此問題,Zhong等[17]提出了一種基于協(xié)作簇劃分的緩存放置策略,通過集群內(nèi)小型基站的下載歷史日志判斷流行度,以提高基站的內(nèi)容命中率。Ren等[18]根據(jù)用戶分布特點和MEC的位置,提出了一種基于分組的分層協(xié)作緩存策略,但沒有考慮內(nèi)容的區(qū)域流行度和全局流行度的差異。本文綜合考慮了用戶的地域差異以及內(nèi)容的動態(tài)性,提出了一種基于收益最大化的協(xié)作內(nèi)容緩存策略。

2 系統(tǒng)場景與問題形式化

圖1 MEC協(xié)作場景

2.1 SBS相似度分析

用戶具有移動性的特點,但大部分用戶每天就在有限的基站間活動;不同基站服務(wù)的用戶所偏好的內(nèi)容也有差異,這導(dǎo)致不同的區(qū)域用戶群請求的內(nèi)容類別也會有差別。例如,用戶在住宅區(qū)會傾向于請求一些娛樂類信息,在公司會請求與工作相關(guān)的信息,這導(dǎo)致區(qū)域流行度與全局流行度之間存在差異。本文假定區(qū)域內(nèi)用戶位置相對穩(wěn)定,移動范圍較小,不考慮用戶跨區(qū)域移動的情況。

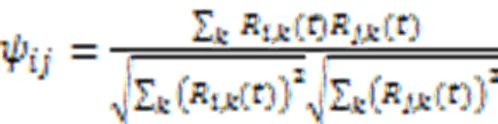

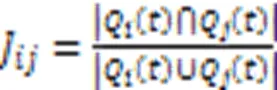

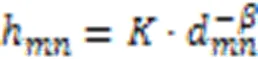

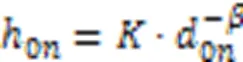

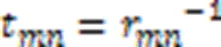

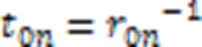

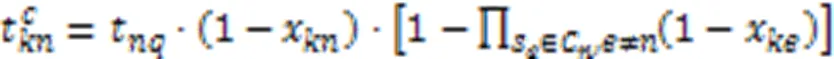

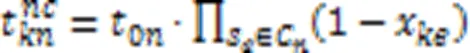

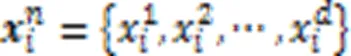

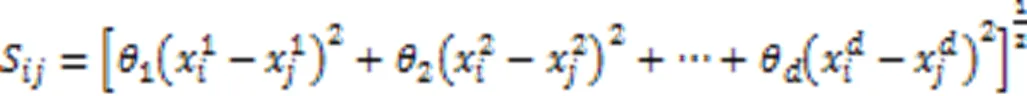

定義1 基站的內(nèi)容相似度。基站和基站的相似度定義為兩個基站所請求內(nèi)容的相似度,表示如下:

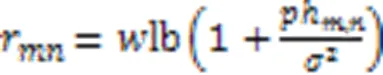

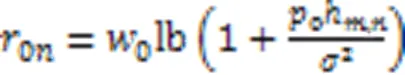

2.2 傳輸時延分析

由于本地服務(wù)器到用戶的傳輸時延總是存在的且通常很小,所以本文暫不進(jìn)行討論。

2.3 內(nèi)容的流行度預(yù)測

根據(jù)內(nèi)容流行度確定SBS中存儲的內(nèi)容至關(guān)重要。SBS中存儲的高流行度文件越多,用戶的請求命中率越高,獲取內(nèi)容的相應(yīng)時延也越少。內(nèi)容流行度與內(nèi)容的放置副本數(shù)、放置位置等都有關(guān)系。

用戶所請求內(nèi)容的流行度存在地域差異特性,造成區(qū)域流行度和全局流行度有很大不同[18]。本文根據(jù)歷史訪問記錄計算每個協(xié)作域中請求最頻繁的內(nèi)容,而不是全局請求最頻繁的內(nèi)容,以提高緩存命中率。由于新內(nèi)容無法根據(jù)歷史訪問記錄計算流行度,所以本文根據(jù)新內(nèi)容與現(xiàn)有內(nèi)容的相似度計算其流行度。

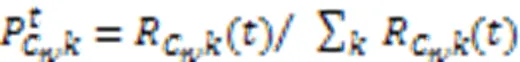

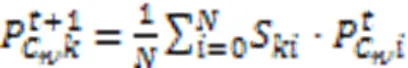

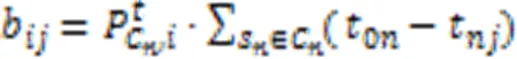

1)已有內(nèi)容流行度計算:通過時隙中歷史請求可以得到流行度為:

其中:為協(xié)作域中熱點內(nèi)容的數(shù)量。

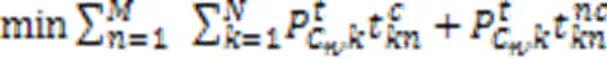

2.4 問題形式化

在所緩存內(nèi)容總量不超過緩存容量的情況下,可將緩存放置優(yōu)化問題轉(zhuǎn)化為所有請求內(nèi)容的傳輸時延最小化問題,表示為:

3 緩存協(xié)作策略及實現(xiàn)

緩存協(xié)作研究利用內(nèi)容主動緩存技術(shù)達(dá)到節(jié)省帶寬、減少網(wǎng)絡(luò)時延和降低訪問花費等方面的目的,研究內(nèi)容包括緩存資源分配、緩存內(nèi)容替換、緩存協(xié)作等。緩存協(xié)作研究在協(xié)同環(huán)境下一組相互合作的邊緣計算節(jié)點如何協(xié)同工作以便高效地存儲內(nèi)容和響應(yīng)用戶請求的問題;緩存資源分配研究在哪個邊緣計算服務(wù)器放置什么內(nèi)容的問題;緩存替換研究什么時機(jī)采用何種策略替換何種內(nèi)容的問題。

3.1 協(xié)作域的構(gòu)建

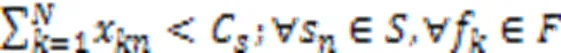

由于用戶所請求內(nèi)容存在地域差異,通過構(gòu)建協(xié)作域?qū)⒕哂胁煌d趣偏好的用戶所屬的服務(wù)基站進(jìn)行劃分,使同一個協(xié)作域中的基站可以服務(wù)具有相同或相似興趣偏好的用戶。協(xié)作域的劃分需要確保協(xié)作域中的每個SBS彼此位置相對鄰近,并且所緩存的內(nèi)容類別高度相似。因此聯(lián)合考慮基站間的內(nèi)容相似度和用戶相似度來描述不同基站間的綜合相似度。

兩個SBS的相似度越大,說明這兩個SBS所接收到的相同的內(nèi)容請求越多,或者這兩個基站相似的用戶越多,這兩個SBS就可以互相成為協(xié)作基站。當(dāng)用戶在本地基站無法獲取文件時,就從和本地基站相似度最大的基站開始依次尋找協(xié)作基站以獲取內(nèi)容。

算法1 協(xié)作域構(gòu)建算法。

7) END FOR

8) END FOR

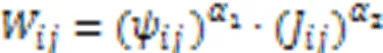

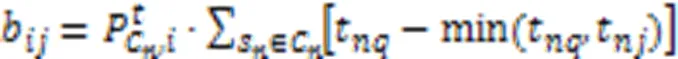

3.2 緩存放置策略

本文的目標(biāo)是設(shè)計一個緩存協(xié)作方案來最小化用戶獲取內(nèi)容的時延,其優(yōu)化目標(biāo)已由式(14)給出。本文將此問題轉(zhuǎn)化為收益最大化問題,使用效益值來描述緩存某指定內(nèi)容使平均傳輸時延減少的量,通過貪心算法尋找效益值最大的內(nèi)容進(jìn)行存放,解決內(nèi)容放置問題。

算法2 基于效益值的緩存放置方法。

8) END FOR

9) END FOR

14) END FOR

15) END FOR

3.3 緩存替換策略

算法3 基于效益值的緩存替換方法。

9) END IF

10) END IF

4 仿真實驗與結(jié)果分析

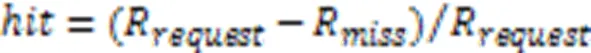

對本文算法與隨機(jī)置換(Random Permutation, RR)、最近最少使用(LRU)以及基于MEC分組的協(xié)作緩存(Grouping?based and Hierarchical Collaborative Caching, GHCC)[19]等三種緩存算法進(jìn)行評估比較。RR通過隨機(jī)選擇內(nèi)容進(jìn)行替換;LRU算法記錄最后兩次使用之間的間隔,如果請求的內(nèi)容未緩存,則替換間隔較長的內(nèi)容;GHCC算法是一種基于用戶位置和MEC分布的協(xié)作緩存策略。

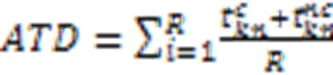

圖2顯示了前20個時隙中不同算法的緩存命中率。從圖2可以看出:RR算法的緩存命中率最低;與GHCC相比,本文算法在命中率方面提高了28%,且在所有時隙上都優(yōu)于其他三種方案。

圖2 前20個時隙中不同算法的緩存命中率

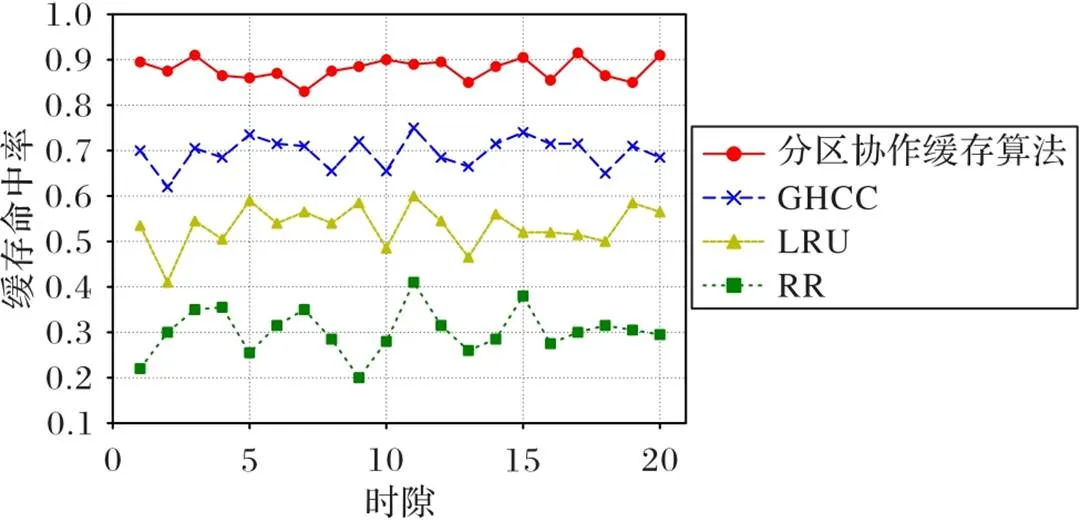

圖3 不同內(nèi)容相似度權(quán)重下的緩存命中率

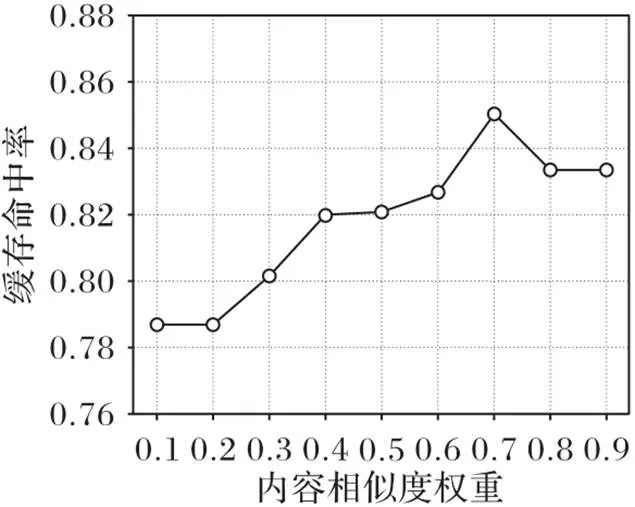

圖4描述了不同文件總量對四種不同緩存算法的緩存命中率和平均傳輸時延的性能影響。該實驗中,單個基站的容量控制為10,總文件數(shù)量在50~500。在圖4(a)中,當(dāng)用戶可以請求比緩存容量更多的內(nèi)容時,命中率將降低;此外,隨著文件數(shù)量的增加,緩存命中率下降的速度減慢。在圖4(b)中,平均傳輸時延隨著文件總量的增多而增加,這是因為文件數(shù)量變多,用戶請求被分散開,用戶通過宏基站獲取內(nèi)容的概率升高,總體傳輸時延增多。

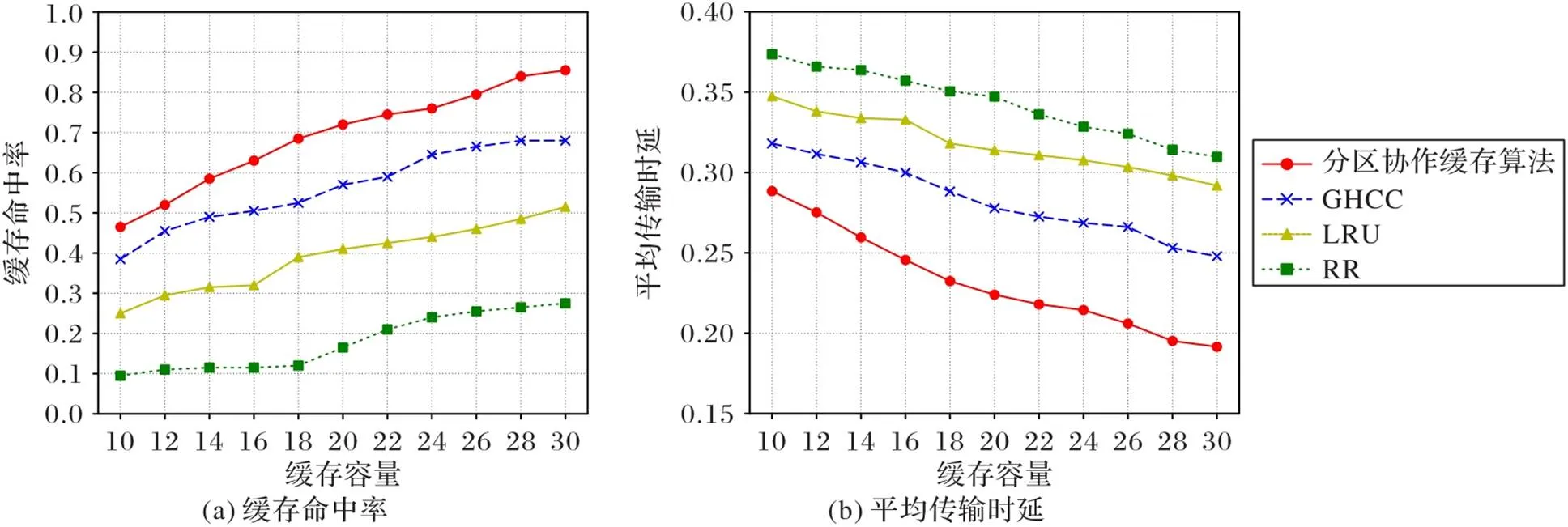

圖5描述了不同緩存容量下的性能比較。通過控制文件數(shù)量為500,將每個SBS的容量調(diào)整為10~30。在圖5(a)中,緩存命中率隨著邊緣基站緩存容量的增加而增加,而在圖5(b)中平均傳輸時延呈下降趨勢。這是因為隨著緩存容量的增加,更多的請求內(nèi)容可以緩存在SBS內(nèi)存中,總命中率會增加,通過宏基站傳輸?shù)母怕蕰p少。可以看出,本文算法優(yōu)于其他三種算法,在容量限制或文件基數(shù)大的情況下,本文提出的緩存方案優(yōu)于其他緩存方案,可以降低平均傳輸時延。

圖4 文件總量與緩存命中率和平均傳輸時延的關(guān)系

圖5 緩存容量與緩存命中率和平均傳輸時延的關(guān)系

5 結(jié)語

針對內(nèi)容請求的區(qū)域性和動態(tài)性,本文提出了一種內(nèi)容動態(tài)情況下的協(xié)作緩存策略,用來最小化平均傳輸時延,根據(jù)用戶訪問記錄中內(nèi)容和用戶的異同將基站間的協(xié)作區(qū)域進(jìn)行劃分,并按照內(nèi)容的新舊用不同的方式對內(nèi)容的流行度進(jìn)行預(yù)測,最后將優(yōu)化函數(shù)轉(zhuǎn)化為收益最大化問題并求解得出最優(yōu)的緩存放置和替換策略。實驗表明,該方案具有較高的緩存命中率和較低的平均傳輸時延。

本文提出的緩存協(xié)作策略雖然取得了較好的效果,但尚有需要完善的地方。比如:1)緩存內(nèi)容放置算法的更新頻率需要根據(jù)具體情況確定,過快會消耗更多功率,過慢則會降低整體命中率;2)還可以考慮所緩存的內(nèi)容大小不同,對于不同大小的內(nèi)容,可以對文件大小進(jìn)行歸一化處理,此時內(nèi)容流行度需要取一個相對于內(nèi)容大小的比值,這樣如果有相同流行度但大小不同的內(nèi)容時,小內(nèi)容的緩存收益會大于大內(nèi)容;3)本文構(gòu)建協(xié)作域時假定用戶的移動相對固定,下一步還可考慮用戶在協(xié)作域間動態(tài)移動場景下的協(xié)作緩存策略。

[1] 張開元,桂小林,任德旺,等. 移動邊緣網(wǎng)絡(luò)中計算遷移與內(nèi)容緩存研究綜述[J]. 軟件學(xué)報, 2019, 30(8): 2491-2516.(ZHANG K Y, GUI X L, REN D W, et al. Survey on computation offloading and content caching in mobile edge networks[J]. Journal of Software, 2019, 30(8): 2491-2516.)

[2] SAFAVAT S, SAPAVATH N N, RAWAT D B. Recent advances in mobile edge computing and content caching[J]. Digital Communications and Networks, 2020, 6(2): 189-194.

[3] MARKAKIS E K, KARRAS K, SIDERIS A, et al. Computing, caching, and communication at the edge: the cornerstone for building a versatile 5G ecosystem[J]. IEEE Communications Magazine, 2017, 55(11): 152-157 .

[4] IOANNOU A, WEBER S. A survey of caching policies and forwarding mechanisms in information?centric networking[J]. IEEE Communications Surveys and Tutorials, 2016, 18(4): 2847-2886.

[5] YAN M, CHAN C A, LI W W, et al. Assessing the energy consumption of proactive mobile edge caching in wireless networks[J]. IEEE Access, 2019, 7: 104394-104404.

[6] JIANG F, YUAN Z, SUN C Y, et al. Learning?based content caching with update strategy for fog radio access networks[C]// Proceedings of the 2019 IEEE/CIC International Conference on Communications in China. Piscataway: IEEE, 2019: 484-489.

[7] FAN Q L, LI X H, LI J, et al. PA?Cache: evolving learning?based popularity?aware content caching in edge networks[J]. IEEE Transactions on Network and Service Management, 2021, 18(2): 1746-1757.

[8] GU J X, WANG W, HUANG A P, et al. Distributed cache replacement for caching?enable base stations in cellular networks[C]// Proceedings of the 2014 IEEE International Conference on Communications. Piscataway: IEEE, 2014: 2648-2653.

[9] GüVEN C, BAYHAN S, GüR G, et al. Optimal resource allocation for content delivery in D2D communications[C]// Proceedings of the IEEE 28th Annual International Symposium on Personal, Indoor, and Mobile Radio Communications. Piscataway: IEEE, 2017: 1-5.

[10] WANG S, ZHANG X, YANG K, et al. Distributed edge caching scheme considering the tradeoff between the diversity and redundancy of cached content[C]// Proceedings of the 2015 IEEE/CIC International Conference on Communications in China. Piscataway: IEEE, 2015: 1-5.

[11] JIANG W, FENG G, QIN S. Optimal cooperative content caching and delivery policy for heterogeneous cellular networks[J]. IEEE Transactions on Mobile Computing, 2017, 16(5): 1382-1393.

[12] ZHONG C, GURSOY M C, VELIPASALAR S. Deep multi?agent reinforcement learning based cooperative edge caching in wireless networks[C]// Proceedings of the 2019 IEEE International Conference on Communications. Piscataway: IEEE, 2019: 1-6.

[13] YANG Z, LIU Y W, CHEN Y, et al. Cache?aided NOMA mobile edge computing: a reinforcement learning approach[J]. IEEE Transactions on Wireless Communications, 2020, 19(10): 6899-6915.

[14] TAN J W, LIU W, WANG T, et al. A high?accurate content popularity prediction computational modeling for mobile edge computing using matrix completion technology[J]. Transactions on Emerging Telecommunications Technologies, 2021, 32(6): No.e3871.

[15] JEON H, SEO W, PARK E, et al. Hybrid machine learning approach for popularity prediction of newly released contents of online video streaming services[J]. Technological Forecasting and Social Change, 2020, 161: No.120303.

[16] ZHU X D, QI W N, WANG J L, et al. A popularity?based collaborative caching algorithm for content?centric networking[J]. Journal of Communications, 2016, 11(10): 886-895.

[17] ZHONG N, ZHANG H M, ZHANG X L. Collaborative partition caching with local popularity[C]// Proceedings of the IEEE 20th International Conference on Communication Technology. Piscataway: IEEE, 2020: 514-518.

[18] REN J Z, TIAN H, NIE G F. Proactive caching scheme with local content popularity prediction[J]. Journal of Beijing University of Posts and Telecommunications, 2020, 43(1): 80-91.

[19] REN D W, GUI X L, LU W, et al. GHCC: grouping?based and hierarchical collaborative caching for mobile edge computing[C]// Proceedings of the 16th International Symposium on Modeling and Optimization in Mobile, Ad Hoc, and Wireless Networks. Piscataway: IEEE, 2018: 1-6.

Cache cooperation strategy for maximizing revenue in mobile edge computing

WANG Yali1,2*, CHEN Jiachao1, ZHANG Junna1,2

(1,,453007,;2(),453007,)

Mobile Edge Computing (MEC) can reduce the energy consumption of mobile devices and the delay of users’ acquisition to services by deploying resources in users’ neighborhood; however, most relevant caching studies ignore the regional differences of the services requested by users. A cache cooperation strategy for maximizing revenue was proposed by considering the features of requested content in different regions and the dynamic characteristic of content. Firstly, considering the regional features of user preferences, the base stations were partitioned into several collaborative domains, and the base stations in each collaboration domain was able to serve users with the same preferences. Then, the content popularity in each region was predicted by the Auto?Regressive Integrated Moving Average (ARIMA) model and the similarity of the content. Finally, the cache cooperation problem was transformed into a revenue maximization problem, and the greedy algorithm was used to solve the content placement and replacement problems according to the revenue obtained by content storage. Simulation results showed that compared with the Grouping?based and Hierarchical Collaborative Caching (GHCC) algorithm based on MEC, the proposed algorithm improved the cache hit rate by 28% with lower average transmission delay. It can be seen that the proposed algorithm can effectively improve the cache hit rate and reduce the average transmission delay at the same time.

mobile edge computing; cache cooperation; user preference; content popularity; cache hit rate

This work is partially supported by National Natural Science Foundation of China (61902112).

WANG Yali, born in 1979, Ph. D., associate professor. Her research interests include edge computing, software defined networking.

CHEN Jiachao, born in 1998, M. S. candidate. His research interests include edge computing.

ZHANG Junna, born in 1979, Ph. D., associate professor. Her research interests include edge computing, service computing.

1001-9081(2022)11-3479-07

10.11772/j.issn.1001-9081.2022020194

2022?02?22;

2022?04?10;

2022?04?15。

國家自然科學(xué)基金資助項目(61902112)。

TP393.0

A

王亞麗(1979—),女,河南三門峽人,副教授,博士,CCF會員,主要研究方向:邊緣計算、軟件定義網(wǎng)絡(luò);陳家超(1998—),男,河南洛陽人,碩士研究生,主要研究方向:邊緣計算;張俊娜(1979—),女,河南扶溝人,副教授,博士,主要研究方向:邊緣計算、服務(wù)計算。