基于多粒度雙向注意力機制的詞義消歧深度學習方法

初鈺鳳 張 俊 趙麗華

(大連海事大學信息科學與技術學院 遼寧 大連 116026)

0 引 言

詞義消歧(Word Sense Disambiguation,WSD)是自然語言處理中的基本任務,也是長期存在的挑戰,有著廣泛的應用。目前的詞義消歧方法主要可以分為基于知識的方法和基于監督的方法。基于知識的方法主要依賴于知識庫的結構和內容,例如,詞義定義和語義網絡,它們提供了兩種詞義之間的關系和相似性。

基于監督的方法通常根據其使用的特征可分為兩類,使用周圍單詞嵌入、PoS標簽嵌入等常規特征的基于特征的監督方法和使用Bi-LSTM等神經網絡編碼器來提取特征的基于神經網絡的監督方法[1]。雖然已有的基于監督的詞義消歧方法在大規模訓練語料的情況下實現了較好的詞義消歧性能,但還是存在一些問題。

首先,基于監督的方法通常對于每個單詞訓練專門的分類器,這使得很難將其擴展到需要消除文本中所有多義詞的全詞詞義消歧任務,即當文本中存在N個多義詞時,需要訓練N個分類器[2]。最近的基于神經網絡的方法通過為所有多義詞構建統一模型來解決此問題[3]。其次,神經網絡的方法總是僅考慮歧義詞的局部上下文的作用,忽視了WordNet中包含的詞義定義等詞匯資源。對于詞義定義資源,在Lesk算法及其變體中因起到擴充詞義含義的作用而得到廣泛應用[4]。

此前,基于神經網絡的詞義消歧方法總是對于上下文語境使用一位有效編碼(One-hot encoding)獲取詞級向量表示或者使用循環神經網絡(RNN)獲取句子級向量表示,并沒有考慮獲取字符級的向量作用。在引入詞義定義的詞匯資源后,總是單獨構建上下文語境和詞義定義的向量表示,沒有很好地構建兩者之間的交互作用。在此基礎上,本文提出分別整合歧義詞上下文語境和詞義定義的字符級和詞級向量表示,構建句子級上下文向量表示,然后在雙向注意力模型中鏈接和融合上下文語境和詞義定義的句子級上下文向量信息。

本文提出采用不同粒度對歧義詞上下文語境和詞義定義的表示建模;提出運用雙向注意力機制整合詞義定義的神經網絡詞義消歧方法,以便更好地構建歧義詞語境和詞義定義之間的相互表示作用。實驗驗證模型在SemEval-13:task #12和SemEval-15:task #13的全詞詞義消歧的數據集上達到很好的消歧效果。

1 相關工作

詞義消歧的定義可描述為:假設歧義詞w在詞典中有N個義項,則將包含w所有詞義定義的集合記為S(w)={s1,s2,…,si,…,sN}。設該歧義詞w所處的特定上下文語境為C(w)={c1,c2,…,cj,…,cn},其中:n為上下文特征的個數;cj表示某個上下文特征。在詞義集合S(w)中有且僅有一個詞義si是w在確定的上下文C(w)中表達的真實詞義。詞義消歧就是從歧義詞w的詞義集合S(w)中找到真實詞義si的工作。詞義消歧任務可表達為將上下文語境中的歧義詞與預定義的詞庫中的最合適的條目相關聯[5]。根據其特性,詞義消歧方法主要可分為兩類:基于知識的方法和基于監督的方法。

基于知識的詞義消歧方法主要是利用兩種多義詞的知識。第一種是利用在文獻[4]及其變體中的詞義定義知識——注釋,通過計算歧義詞的上下文語境和詞庫中的詞義定義之間的重疊或分布相似性關系。另一種是在文獻[6]中廣泛運用的基于圖的算法,其中:節點是同義詞集;邊是語義關系——語義網絡結構。首先創建輸入文本的圖表示,然后在給定表示上利用不同的基于圖的算法執行詞義消歧。基于知識方法的優點是不需要大規模的訓練語料,但存在難以適應語言動態變化和缺乏完備性等缺點[5]。

基于監督的詞義消歧方法通常將每個歧義詞作為單獨的分類問題,基于人工標注的特征訓練分類器。盡管基于監督的方法能夠在準確度上實現較好的性能,但是對于全詞的詞義消歧而言,在靈活性上比較差。為了解決這個問題,最近的基于神經網絡的方法構建統一的分類器,該分類器在所有的多義詞之間共享參數[3]。文獻[7]利用雙向長短時記憶網絡,在所有的多義詞之間共享參數,通過端到端的訓練來充分利用單詞順序。文獻[8]將詞義消歧問題轉化為神經序列標簽任務,提出一系列端到端的神經網絡,從雙向長短時記憶模型到編碼解碼模型。

對于監督的方法和基于神經網絡的方法,很少考慮WordNet等詞匯資源。有許多任務顯示出整合知識和標簽數據到統一的系統中能實現比單獨從大量標簽數據中學習的方法獲得更好的性能,如漢語分詞、語言建模和LSTMs任務。文獻[2]通過記憶網絡將目標詞的語境和詞義定義整合到一個統一的框架中,分別對目標詞的語境和詞義定義進行編碼,然后在記憶模型中對語境向量和詞義定義向量之間的語義關系進行建模。除此之外,還提出利用語義關系擴展詞義定義以便更好推導上下文。文獻[8]研究表明,WordNet中的粗粒度語義標簽可以在多任務學習框架中幫助詞義消歧。文獻[9]通過使用WordNet中的約束和語義關系將單詞嵌入擴展到語義嵌入,當使用語義嵌入作為SVM分類器的詞義消歧功能時,它們可將性能提高1%以上。以上列出的所有研究表明,將詞匯資源整合到WSD的監督系統中可以顯著提高性能。而且,已經有一些研究探索了使用諸如詞義定義等知識資源來增強監督詞義消歧的方法,并取得了很好的效果。因此,本文遵循這個方向,尋求一種更好地整合詞義定義知識資源的詞義消歧方法。

此外,之前的基于神經網絡的方法通常分別利用One-hot或RNN構建歧義詞上下文語境詞級和句子級向量表示,并沒有考慮利用CNN構建字符級向量表示的作用。文獻[10-11]研究表明,在構建文本向量表示時,字符級的局部向量表示對于提高閱讀理解能力和問題回答準確性起到重要作用。

本文關注如何構建不同粒度的上下文語境和詞義定義的文本表示,通過高速網絡(Highway Network[12])將不同粒度的表示級聯,并運用雙向長短時記憶網絡模型(LSTM[13])構建上下文的向量表示。采用在問答等自然語言處理領域取得巨大進展的雙向注意力機制,構建上下文語境和詞義定義之間的交互作用[14-16]。在雙向注意力模型上做了適當的調整,以便更好地獲取上下文語境和詞義定義之間的內部關系。

2 多粒度雙向注意力詞義消歧模型

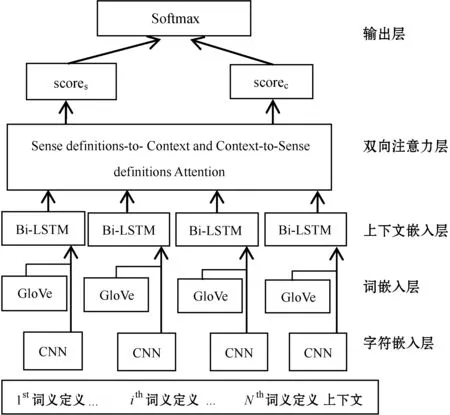

首先定義所提的多粒度雙向注意力詞義消歧模型的整體概述,模型主要包括5層(如圖1所示),然后分別對每一層進行描述。

圖1 多粒度雙向注意力詞義消歧模型

2.1 模型綜述

模型由字符嵌入層、詞嵌入層、上下文嵌入層、雙向注意力層和輸出層構成。字符嵌入層主要是通過卷積神經網絡(CNN),把每個詞映射到向量空間;詞嵌入層通過預訓練的詞嵌入模型(GloVe),將每個詞映射到向量空間;上下文嵌入層運用雙向長短時記憶網絡模型(Bi-LSTM)構建上下文向量表示。對于歧義詞的上下文語境和詞義定義的句子分別運用字符嵌入層、詞嵌入層和上下文嵌入層獲取向量表示。雙向注意力機制層主要是結合歧義詞的語境和詞義定義,生成對于歧義詞語境中每個單詞的一組詞義定義的向量表示和對于歧義詞詞義定義中每個單詞的一組語境的向量表示,構建兩者之間的交互關系。輸出層計算歧義詞所有詞義的分數,并最終輸出歧義詞的所有詞義的概率分布。

2.2 多粒度嵌入

令{c1,c2,…,cn}和{x1,x2,…,xm}分別表示歧義詞上下文語境和詞義定義中的單詞序列,其中,n和m分別表示上下文語境和詞義定義序列的最大長度。

(1) 詞嵌入層:負責將每個單詞映射到高維的向量空間。使用預訓練的單詞向量模型GloVe來獲取每個單詞的固定向量,表示成d1維度。對于不在預訓練中的單詞(Out-Of-Vocabulary,OOV),被映射為

(2) 字符嵌入層:負責將每個單詞映射到高維的向量空間。GloVe通過分配一些隨機向量值來處理OOV詞,而隨機分配最終會影響整個模型的效果。所以對于GLoVe中不存在的詞,使用一維卷積神經網絡(1D-CNN)獲得每個單詞的字符級嵌入,每個字符都表示成d2維度的可訓練向量,維度表示輸入通道的大小(卷積濾波器的數量)。按字符滑動掃描單詞,經過卷積和最大池化操作,選擇每一行的最大值,以獲得每個單詞的固定大小為d2維的向量表示。

(3) 對于字符嵌入向量和詞嵌入向量進行級聯,得到維度為d=d1+d2的級聯向量表示,然后矩陣被傳遞到兩層的高速網絡中,得到兩個維度相同的矩陣表示:對于歧義詞的上下文語境有C′∈Rd×n,歧義詞的詞義定義有S′∈Rd×m。上下文嵌入層:單詞級的向量表示并沒有考慮上下文的含義,所以在前兩層提供的級聯嵌入向量表示之上,通過雙向長短時記憶網絡模型級聯前向和后向的雙向文本狀態信息。從而得到歧義詞上下文語境表示C∈R2d×n,歧義詞的詞義定義表示S∈R2d×m。

模型的前三層是從歧義詞的上下文語境和詞義定義中計算不同粒度級別的向量表示,類似于計算機視覺領域的卷積神經網絡的多階段特征計算。

2.3 雙向注意力機制

不同于之前的注意力機制(Attention)表示,采用在自然語言處理問題中,證明能很好地構建不同文本之間的交互表示的雙向注意力機制。對于在自然語言處理和計算領域廣泛應用的Attention,只是將不同的文本單獨構建分布式向量表示,然后計算文本之間的相似性或者相關性,不能充分利用不同文本之間的交互作用。

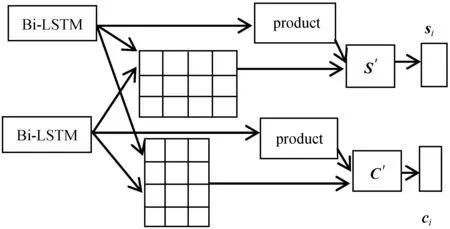

雙向注意力機制層如圖2所示。

圖2 雙向注意力機制

輸入為上下文嵌入層獲得的歧義詞上下文語境表示C和詞義定義表示S,輸出為N對(詞義定義的數量)雙向注意力表示的歧義詞上下文語境和詞義定義向量表示。雙向注意力機制表示從兩個方向上計算注意力,上下文語境到詞義定義(Context-to-Sense definition)的注意力向量表示和詞義定義到上下文語境(Sense definition-to-Context)的注意力向量表示。

首先,需要計算一個相似性矩陣A∈Rn×m,Aij表示的是上下文語境的第i個詞和詞義定義的第j個詞之間的相似性,相似性的計算公式表示為:

Aij=α(C:i,S:j)∈R

(1)

式中:α表示的是可訓練的標量函數,用于編碼兩個輸入向量之間的相似性;C:i表示C的第i列;S:j表示S的第j列。α函數的表達式為:

α(c,s)=(W(A))T[c;s;c°s]

(2)

式中:W(A)∈R6d,是一個可訓練的權重向量;°表示逐元素相乘(矩陣相乘);[;]表示跨行級聯運算。基于相似性矩陣A來獲取兩個方向上的注意力矩陣,分別為上下文語境到詞義定義的注意力矩陣As∈Rm×n和詞義定義到上下文語境的注意力矩陣Ac∈Rn×m。

Sense definition-to-Context(S2C)注意力,表示對于歧義詞的每個詞義定義詞而言哪個語境詞最相關。由于相似性矩陣A的第j列表示每個語境詞和第j個詞義定義詞之間的相似性,所以可利用跨A列的Softmax函數來獲得每個語境詞的注意力權重,其計算式為:

C′:C′=CAc∈R2d×m

(4)

式中:C′的第j列表示根據詞義定義的第j列獲得的語境表示。最終,通過計算C′列之和求得語境向量,其計算式為:

Context-to-Sense definition(C2S)注意力,表示對于歧義詞的每個語境詞而言哪個詞義定義詞最相關。由于相似性矩陣A的第i行表示第i個語境詞和每個詞義定義詞之間的相似性,所以可利用跨A行的Softmax函數來獲得每個詞義定義詞的注意力權重。由于矩陣存在轉置特性,A的行等于AT的列,所以其計算式可以表示為:

S′:S′=SAs∈R2d×n

(7)

式中:S′的第j列表示根據語境的第j列獲得詞義定義的表示。最終,通過計算S′列之和求得詞義定義向量,其計算式為:

最后,采用余弦相似度來計算歧義詞上下文語境和每個詞義定義之間交互關系的相似度,其計算式為:

式中:i表示第i個詞義定義;ci表示由第i個詞義定義獲得的詞義定義到上下文語境的向量c;si表示由第i個詞義定義獲得的上下文語境到詞義定義的向量。對于歧義詞上下文語境的向量表示,采用N個詞義定義到上下文語境向量的平均值,其計算式為:

2.4 輸出層

輸出層主要是計算歧義詞w的N個詞義定義的分數,并輸出N個詞義定義的詞義概率分布。每個詞義的分數是由兩個值的權重和求得:scores和scorec。scores表示歧義詞的上下文語境和詞義定義之間的相似度分數,主要體現在詞義消歧中引入詞典中詞義定義的作用,其計算式為:

scores=[β1,β2,…,βN]

(11)

而scorec表示歧義詞的上下文語境向量分數,是通過一個線性映射層計算的,主要體現廣泛應用的歧義詞上下文語境標簽數據的作用,其計算式為:

式中:Ww為權重參數;bw為偏置項。

最終歧義詞的所有詞義概率分布計算式為:

y′=softmax(λwscores+(1-λw)scorec)

(13)

式中:λw∈[0,1]是歧義詞w的參數。

在訓練的過程中,所有的模型參數通過最小化y′和真實標簽y之間的交叉熵損失聯合學習獲得。損失函數表示為:

3 實驗與結果分析

3.1 數據集

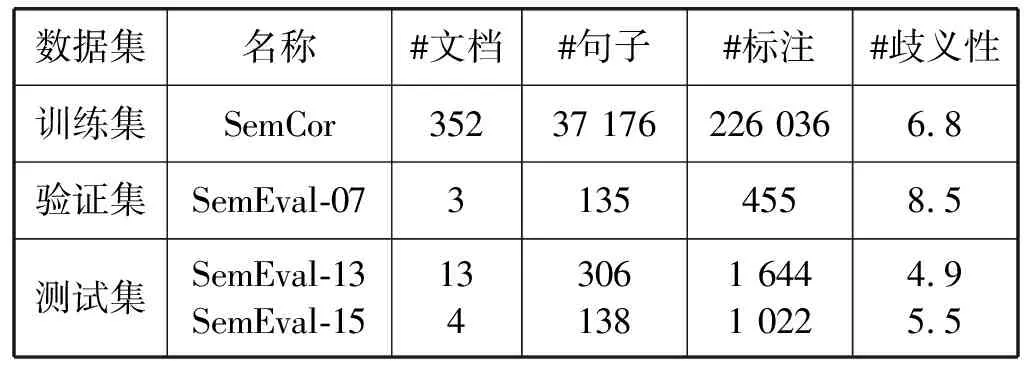

選擇SemCor 3.0作為訓練集,是通過WordNet詞典手工標注的最大的詞義消歧語料庫。它由352篇文檔的226 036個詞義標注組成,包含名詞、動詞、形容詞和副詞。采用公開評測的英語全詞詞義消歧數據集(English all-words WSD),把SemEval-07:task #17(SE7)作為驗證集,SemEval-13:task #12(SE13)和SemEval-15:task #13(SE15)作為測試集。其中:SemEval-07:task #17僅包含名詞和動詞,由455個詞義標注構成;SemEval-13:task #12僅包含名詞,由來自各個領域的13篇文檔的1 644個詞義標注構成;SemEval-15:task #13包括名詞、動詞、形容詞和副詞,由來自三個異構領域的1 022個詞義標注構成。表1顯示了訓練、驗證和測試數據集的統計數據。

表1 WSD數據集統計

3.2 實驗設置

運用驗證集SE7來設置模型的最佳參數:詞嵌入大小d1、字符嵌入大小d2、LSTM的隱藏層大小n、優化參數和初始化函數等。由于SE7僅存在名詞和動詞而沒有形容詞和副詞,所以選擇從訓練數據集中隨機抽取一些副詞和形容詞到SE7中進行驗證。使用的卷積輸入通道的大小為200,截斷或者填充的大小為16,預訓練詞嵌入的維度為300,并保證這些參數在訓練過程中固定大小。隱藏狀態大小n是256,最小批量大小設置為32。在訓練的過程中,選擇Adam優化器,初始學習率為0.001。為了避免過度擬合,在LSTM的輸出上使用丟棄正則化(Dropout Regularization),并將丟棄率設置為0.5。正交初始化用于在LSTM中初始化權重,而對于其他操作使用[-0.1,0.1]的隨機均勻初始化。如果驗證損失在最后5個周期(epochs)內沒有改善,則提前停止,訓練運行最多進行50個周期。

3.3 結果分析

這一部分首先給出詞義消歧的實例結果分析,然后給出不同的詞義消歧模型在英語全詞任務中的實驗結果。

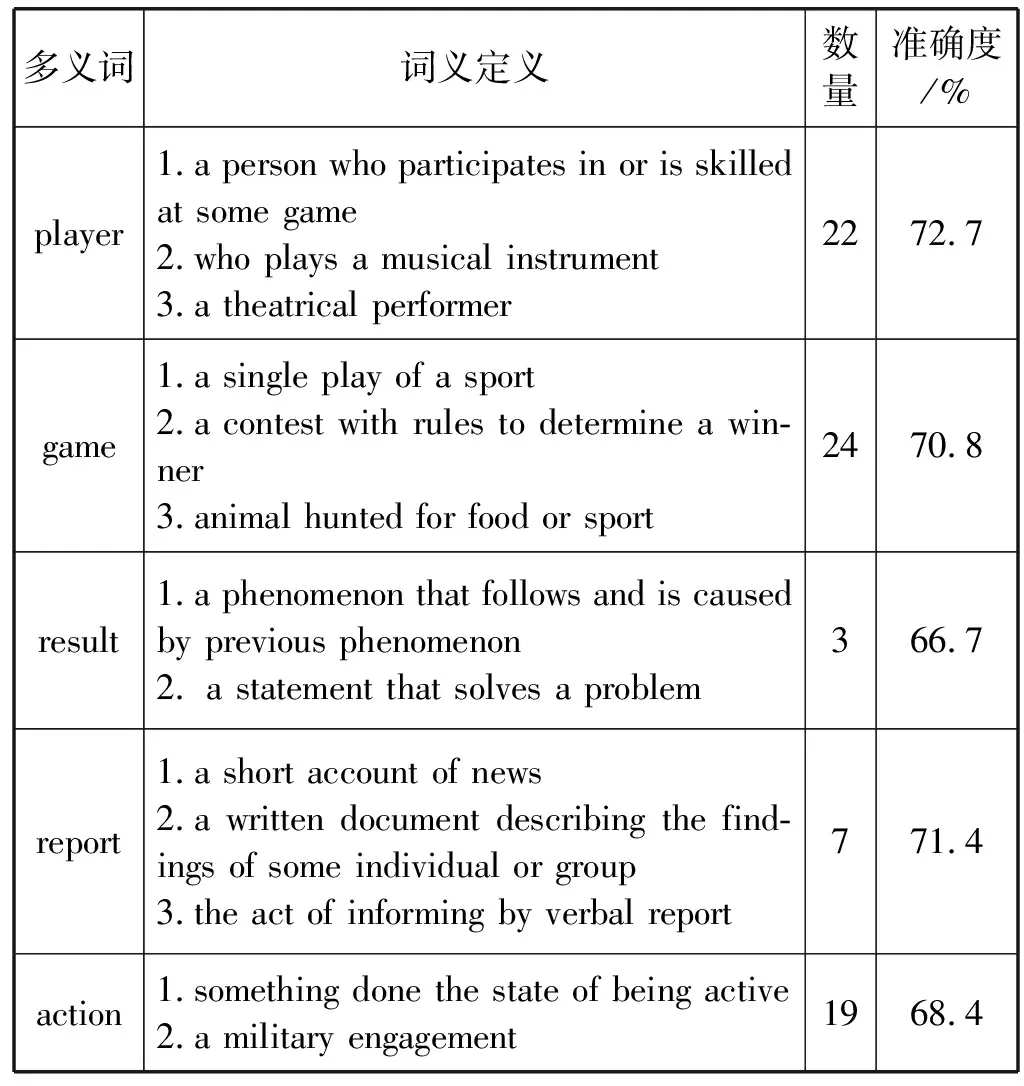

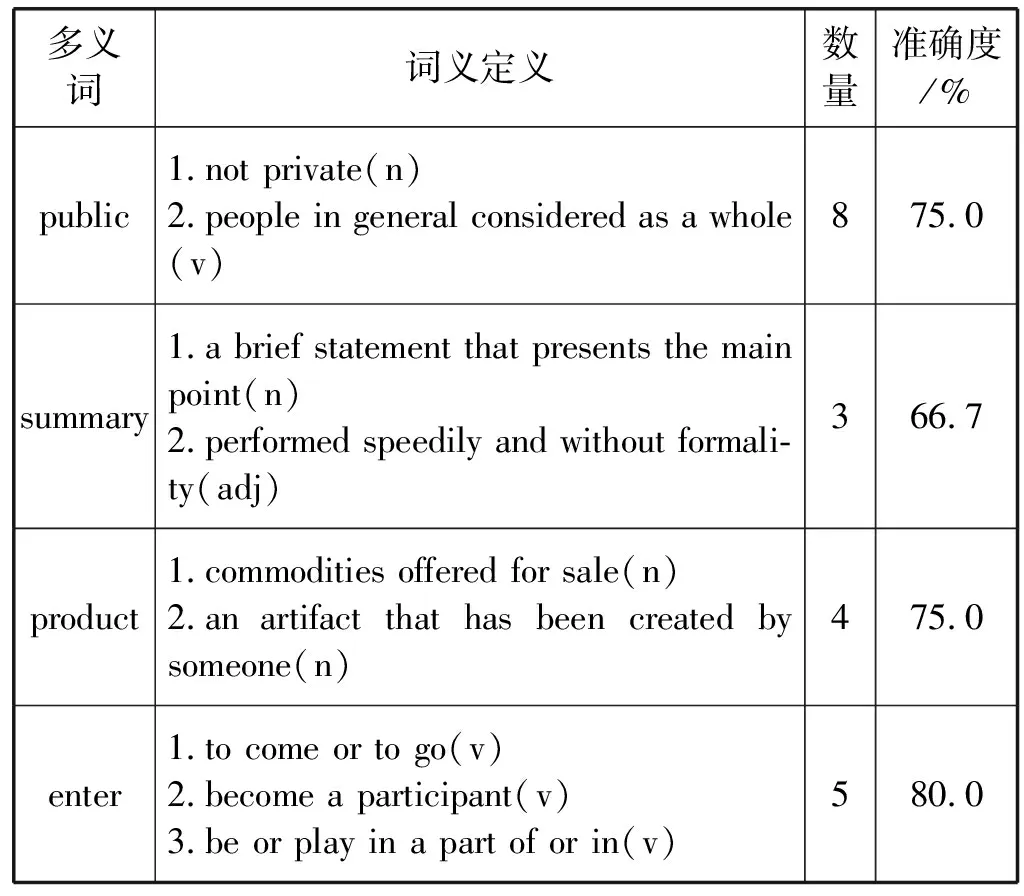

對于本文的詞義消歧模型,在SemEval-13:task #12(SE13)和SemEval-15:task #13(SE15)數據集中分別隨機選取部分多義詞進行準確度判斷,統計的結果如表2、表3所示。在表3中的詞義定義列中顯示的符號表示為名詞(n)、動詞(v)、形容詞(adj)和副詞(adv)。

表2 SE13名詞詞義消歧結果

表3 SE15全詞詞義消歧結果

可以看出,本文所提出的詞義消歧模型對于多義詞的詞義判斷有較高的準確度。

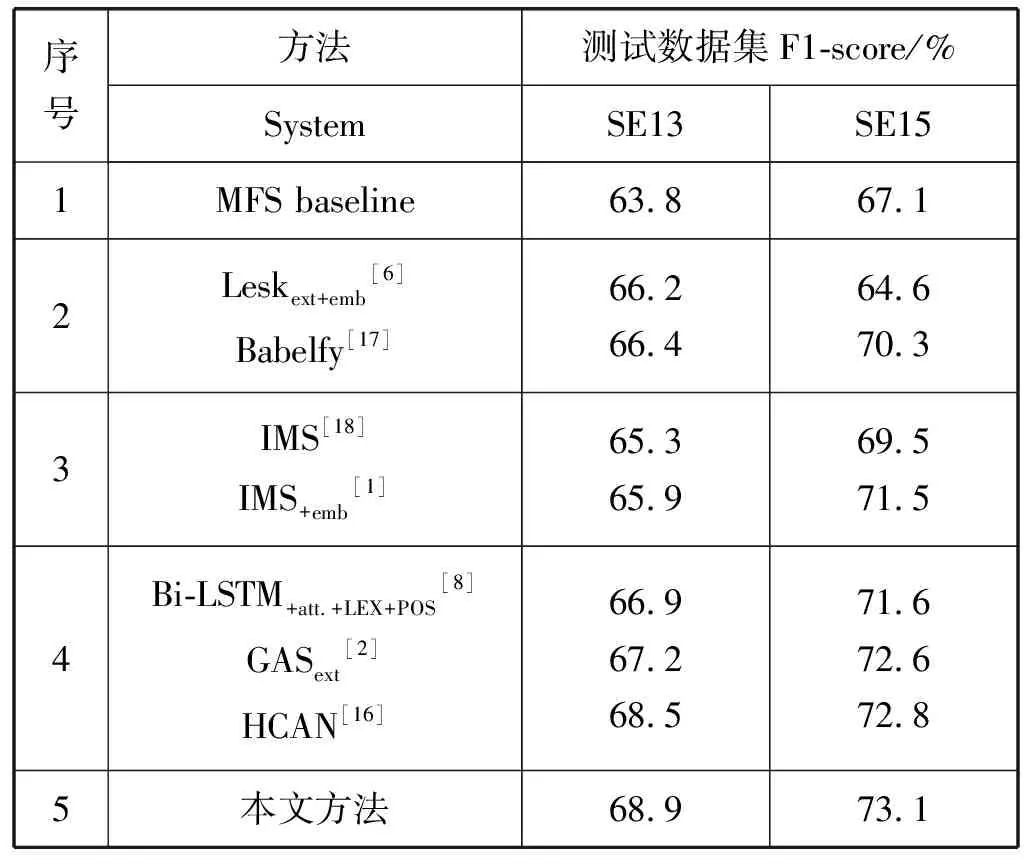

對于英語全詞詞義消歧的方法,主要包括:基準方法、基于知識的方法、基于監督的方法和基于神經網絡的方法及整合詞義定義等詞匯資源的神經網絡方法,如表4所示。

表4 英語全詞詞義消歧測試結果

表4中,所有的實驗都是在SemCor 3.0上訓練的。序號1行顯示了基準MFS(Most Frequent Sense)的測試集性能,MFS是一種選擇訓練數據集中的最頻繁詞義作為歧義詞詞義的方法。序號2行顯示的是兩種基于知識的詞義消歧方法:Leskext+emb是著名Lesk算法的一種變體,通過計算歧義詞的上下文和詞義定義之間的覆蓋度來計算詞義得分;Babelfy是一種基于圖的詞義消歧方法,利用同義詞集中的隨機游走來確定相互之間的聯系,通過整合WordNet構建的BabelNet語義網絡來消除歧義。序號3行展示了兩個傳統的監督系統,這些系統僅基于手工設計的特征從標記的數據中學習。IMS可以為K個多義詞訓練K個SVM分類器,默認設置中包含語境、詞性、局部詞組搭配。其變體IMS+emb將單詞嵌入功能添加到IMS中。IMS和IMS+emb是通過為每個目標詞構建單獨的分類器,即每個目標詞都有其自己的參數。因此,對于僅使用標記數據的許多神經網絡來說,IMS+emb都是在詞義消歧上很難被擊敗的系統。序號4行主要顯示了三個最新的神經網絡方法,除了Bi-LSTM之外,其余的方法除了運用標簽數據之外,還運用了詞典的詞匯知識資源。Bi-LSTM+att.+LEX+POS是一種對于詞義消歧、詞性標注、具有上下文自注意力機制的LEX的多任務學習框架。GAS是注釋增強的運用記憶網絡模型進行詞義消歧的神經方法。HCAN是一種整合注釋知識的層級注意力機制詞義消歧模型,實驗結果表明句子級的信息比詞級信息更重要,提升了詞義消歧的準確率。

在序號5框中,是本文提出的多粒度雙向注意力詞義消歧模型的性能,本文模型在SemEval-13和SemEval-15兩個公開評測的數據集上將結果分別提高了0.4百分點和0.3百分點。盡管沒有采用HCAN模型中的層級架構,但是在多粒度級別上進行整合操作,運用字符級嵌入彌補詞嵌入中OOV詞向量隨機初始化的缺點,以及采用不同的雙向注意機制模型建模方法,在數據集中獲得更好的性能。

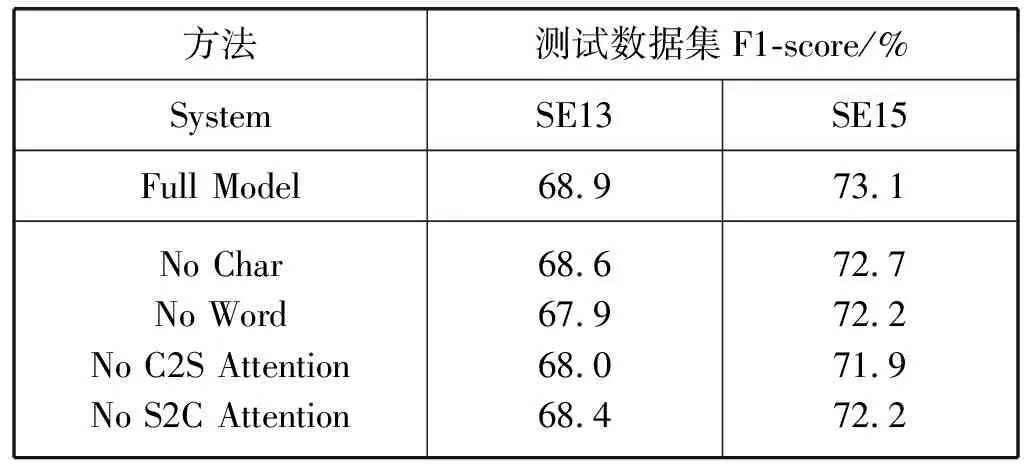

3.4 消融實驗

這一部分進一步研究模型中的各個組成部分的重要作用。通過消融某部分組成來訓練模型:消融字符級嵌入(No Char)、消融詞級嵌入(No Word)、消融語境到詞義定義的注意力(No C2S Attention)和消融詞義定義到語境的注意力(No S2C Attention)。

對于消融字符級嵌入是只把詞級向量輸入到雙向長短時記憶網絡中,通過雙向注意力機制模型進行訓練;對于消融詞級嵌入是只把字符向量輸入到雙向長短時記憶網絡中,通過雙向注意力機制模型進行訓練;對于消融語境到詞義定義的注意力是移除由語境向量生成的注意力,即As的所有元素設置為1;對于消融詞義定義到語境的注意力是移除由詞義定義向量生成的注意力,即Ac的所有元素設置為1。

消融實驗中,沒有字符級嵌入和詞級嵌入對于SE13分別下降了0.3百分點和1.0百分點,對于SE15分別下降了0.4百分點和0.9百分點,顯示出了多粒度級別中,詞級嵌入比字符嵌入更重要。沒有上下文語境到詞義定義的注意力和詞義定義到上下文語境的注意力對于SE13分別下降了0.9百分點和0.5百分點,對于SE15分別下降了1.2百分點和0.9百分點,顯示了上下文語境到詞義定義注意力比詞義定義到上下文語境注意力更重要,表明語境已知的詞義定義向量更能直接地確定歧義詞的正確詞義。消融實驗的結果如表5所示。

表5 模型的消融實驗結果

4 結 語

本文提出一種引入詞義定義的基于雙向注意力機制的詞義消歧方法。該方法不僅利用歧義詞上下文語境標簽數據的作用,而且充分發揮了詞義定義詞匯資源的作用。在歧義詞上下文語境和詞義定義上分別進行字符級、詞級、句子級的多粒度向量表示,運用雙向注意力機制構建上下文語境到詞義定義和詞義定義到上下文語境的注意力。實驗結果顯示,本文方法在兩個全詞詞義消歧數據集上取得了很好的效果。下一步的工作將考慮使用詞典中詞義的上位詞和下位詞等詞匯資源,以提供更準確的詞義表示。