基于云邊協同算力調度的高效邊緣卸載研究

王姍姍,羅志勇

(中山大學 電子與通信工程學院,廣東 深圳 518107)

0 引言

車載邊緣計算(Vehicular Edge Computirg, VEC)網絡因其廣泛的應用而備受關注[1]。然而,有限的車載設備資源無法支持越來越多對低延遲和高性能服務需求的新應用,如信息服務、路徑導航、娛樂應用等。為了應對這一挑戰,基于云邊端一體化與智能協同等算力網絡技術的車載邊緣計算作為一種新型計算范式。VEC網絡將分布式的計算節點連接起來,動態實時感知計算與通信資源,進而實時統籌分配和調度計算任務,形成了一張計算資源可感知、可分配、可調度的網絡,滿足了用戶車輛任務對算力的要求,也是邊緣計算向泛在算力網絡融合演進的新階段[2-3]。對于用戶車輛與邊緣服務器之間進行通信時,計算任務可被卸載到邊緣服務器上,在這個過程中VEC網絡會產生時延與能耗等方面的開銷。為了滿足VEC網絡中大量用戶的多樣化業務需求,基于云邊協同、多點算力均衡等算力網絡技術,設計高效的計算卸載策略來實現對計算和網絡資源狀態的感知,進而實現資源的按需調配與調度,從而在算力網絡中實現更快通信、更高感知、更準計算。

1 背景介紹

近年來,一些專家對VEC網絡的計算卸載策略開展了研究。Yang等人[4]研究了面向智能物聯網的多層算力網絡,通過考慮海量計算之間的交互與算力資源協同,實現了算力的智能分發。Luo等人[5]為提高VEC網絡的任務卸載率,提出了一種基于貪心匹配的動態任務卸載算法。澳大利亞悉尼大學計算機學院[6]提出了基于聯邦學習的無線網絡聯合優化模型,通過建立節點間分布式算力分配,為解決通感算一體化系統中節點算力不足與不均衡的問題提供了解決思路。然而,這些研究僅從移動終端架構的角度分別優化了卸載決策或資源配置,并沒有充分利用云中心和MEC服務器的異構計算能力,導致算力網絡中仍然存在算力分配不充分和不均衡的問題。

與此同時,鑒于VEC網絡的動態性和隨機性,現有的計算卸載策略大多需要引入更加智能的算法來應對傳統數學方法的不足, 并實現網絡的通信、計算和存儲資源的智能管理[7-9]。美國康奈爾大學的學者[10]采用在線優化方法實時學習并更新系統參數來優化網絡吞吐量。Leng等人[11]提出了一種基于云計算的智能車聯網管理系統,增強了車輛的實時感知功能。但這些研究僅適用于靜態網絡環境,即在執行卸載決策后不再同步更新資源的分配。

由以上的分析可知,目前VEC網絡中基于云邊協同的任務卸載與資源分配策略存在以下不足:① 大多沒有考慮同時利用云中心、邊緣服務器的異構計算能力,且集中在單一邊緣節點的通感、通算、感算等雙邊能力的一體化方面;② 雖然計算資源呈現出泛在部署的趨勢,但是邊緣節點與云計算節點之間缺失有效的算力協同機制;③ 聯合任務卸載決策與資源分配的研究大多是針對靜態的,執行卸載決策后未同步更新資源分配。

基于此,為了更加高效利用網絡邊緣側的海量分布式算力資源,本文針對6G通感算融合網絡中邊緣節點缺失智能化處理的問題,將算力與網絡深度融合,基于協同分布式計算資源提出了一種云邊協同智能驅動車載邊緣算力網絡架構,其中車輛可以將計算密集型和時延敏感型任務分別卸載到MEC服務器、聚合服務器和云中心三個層次上,實現業務在各級節點的算力最優。 通過結合實時計算負載與網絡狀態條件,動態地將計算任務卸載到最佳的邊緣節點上權衡用戶任務卸載策略,實現多點算力的最優均衡。考慮以最小化系統長期總成本為目標,聯合任務分配和資源分配策略建模為優化問題,并將該優化問題轉化為馬爾可夫決策過程(Markov Decision Process, MDP)。最后,利用云邊協同的深度Q網絡(Cloud-Edge Collaborative Deep Q-Network,CEC-DQN)算法解決MDP問題,實現了任務的靈活分配和資源的智能管理。仿真結果表明,所提出的計算卸載策略優于基準策略,能夠有效降低系統的總長期開銷,最終實現單點算力的有效利用與多點算力的最優均衡調度。

2 系統模型

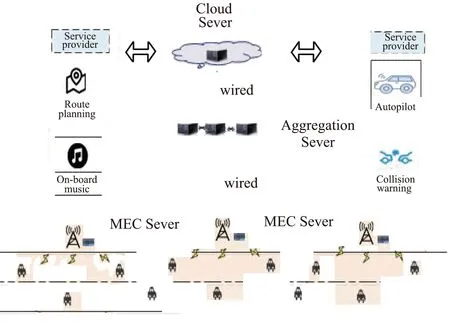

2.1 VEC 網絡架構

本文針對VEC網絡中邊緣節點缺失智能化處理的問題,基于云邊端協同與分布式算力調度等技術提出了一種分層協同智能驅動VEC網絡架構,如圖1所示。任務模型為整體任務卸載模型,IoV用戶可以將任務整體卸載到 MEC服務器、聚合服務器和云中心三個層次上權衡卸載策略。IoV用戶層包括行駛在道路上的I類車輛,車上配備了多種傳感器,可以用于感知物體的距離、角度等環境狀態信息,便于車輛做出可靠的研判。在VEC系統中,考慮的場景是一條雙向的車道,在車道一側部署了配有邊緣服務的路邊單元(Roadside Unit,RSU)構成邊緣層。每個RSU優先與通信范圍內的用戶通信,每個用戶在t時隙只能與一個RSU關聯。為了簡化模型,重點考慮單個RSU的模型,該解決方案可以拓展到多個RSU的情況。聚合服務器層比MEC服務器具有更好的計算資源,可以通過有線連接與多個RSU通信。此外,計算任務還可通過MEC服務器使用有線方式轉發到云服務層進行卸載。聚合服務器與云服務器作為MEC服務器的補充方案,可以滿足大量用戶的計算卸載需求,但是會消耗更多的時延與能耗。

圖1 云邊協同智能驅動VEC算力網絡架構

2.2 任務模型

在云邊協同VEC網絡中,用戶采用正交頻分多址接入技術(Orthogonal Frequency Division Multiple Access,OFDMA)與邊緣節點進行通信。不同的用戶車輛占用不同的信道進行雙向傳輸,每一個子信道的帶寬為b。假設在某一道路段內,各個用戶車輛與邊緣節點之間的通信干擾可以忽略不計,則根據香農定理,計算任務n與邊緣服務器之間的最大數據傳輸速率為:

(1)

(2)

若任務n需要通過有線連接卸載到聚合服務器上,則傳輸時延定義為:

(3)

式中,Ras為聚合服務器上的數據傳輸速率。若任務n需要通過有線連接方式將計算任務卸載到云服務器上,則將Ras替換為云服務器上的數據傳輸速率Rcs。

(4)

當計算任務n執行計算卸載時,一般經歷以下三個階段:任務上傳、任務執行與結果反饋。因為結果反饋階段的數據一般要比上傳的數據小很多,所以本文忽略結果反饋的時延。

因此,計算密集型任務n的處理總時延Tn可以根據通信與計算模型得到:

(5)

計算密集型任務n總能耗可以表示為:

(6)

為了考慮用戶針對不同的計算卸載場景對時延與能耗的偏好,考慮增加權重因子θ∈[0,1],來權衡時延與能耗的重要性。構建系統成本函數如下:

Gn(t)=θTn(t)+(1-θ)En(t)。

(7)

3 問題形成

本研究旨在動態、隨機的VEC系統中,針對有限的網絡資源與大量車載用戶需求之間的矛盾,通過基于云邊端一體化與分布式算力調度技術聯合優化設計任務卸載與資源分配策略,來最小化VEC系統在長期一段時間內的總成本函數,并解決通感算網絡中邊緣節點算力不足與分布不均衡的問題。因此目標函數如下:

(8)

C6:Tn≤τ, ?n∈N。

(9)

4 基于CEC-DQN的計算卸載策略

4.1 MDP 定義問題

由于P1屬于混合整數非線性規劃(MINP)問題,為了保證問題的長期隨機優化特性,本文將P1轉換為MDP[12-13]。MDP一般是由三個關鍵要素組成,即M= {State,Action,Reward}。其中,State為一個有限的狀態集合,Action為一個有限的動作集合,Reward為即時獎勵函數。通過結合具體的優化P1,給出了三個關鍵要素具體化的定義。

(1)State

在t時隙時,系統狀態包括所有車輛任務卸載的卸載請求、MEC服務器、聚合服務器和云服務器的計算資源、系統帶寬。因此系統狀態空間可以定義為s(t) = (at,bt,fk=1(t),fk=2(t),fk=3(t),B(t)),其中,at為待卸載任務數據量大小,bt為待卸載任務所需要的計算量,fk=1(t),fk=2(t),fk=3(t)分別為MEC、聚合服務器和云服務器的計算資源,B(t)為在時隙t時的帶寬資源。

(2)Action

(3)Reward

由于優化問題P1的目標是最小化系統長期總成本,所以將t時隙的即時回報獎勵函數設計如下:

(10)

式中,G(MEC)表示所有任務在MEC服務器上執行卸載時系統的總成本,G(s,a)表示基于當前狀態和動作執行后的系統總成本。

4.2 CEC-DQN 方法

隨著狀態空間和動作空間的增加,傳統Q-learning算法會產生巨大的時間開銷[14]。為避免這一問題,本文采用了一種基于CEC-DQN的高效計算卸載策略[15-16]。CEC-DQN算法的核心思想是將Q網絡作為VEC網絡中的策略評價準則[17],利用神經網絡對不同狀態的動作組合下的Q值進行近似估計,將Q表的更新轉化為函數擬合問題[18],即

Q(s,a;θ)≈Q(s,a)。

(11)

為了打破數據的相關性和保證訓練的穩定性,DQN算法引入經驗重放與雙網絡(預測網絡、目標網絡)機制,大大提高訓練的效率。神經網絡的更新是通過最小化損失函數獲得的。損失函數采用均方誤差函數,表示如下:

Loss(θ)=E[(y-Q(s,a;θ)2],

(12)

式中,y通過目標網絡生成,其計算公式為:

y=r+maxQ(s′,a′;θ′)。

(13)

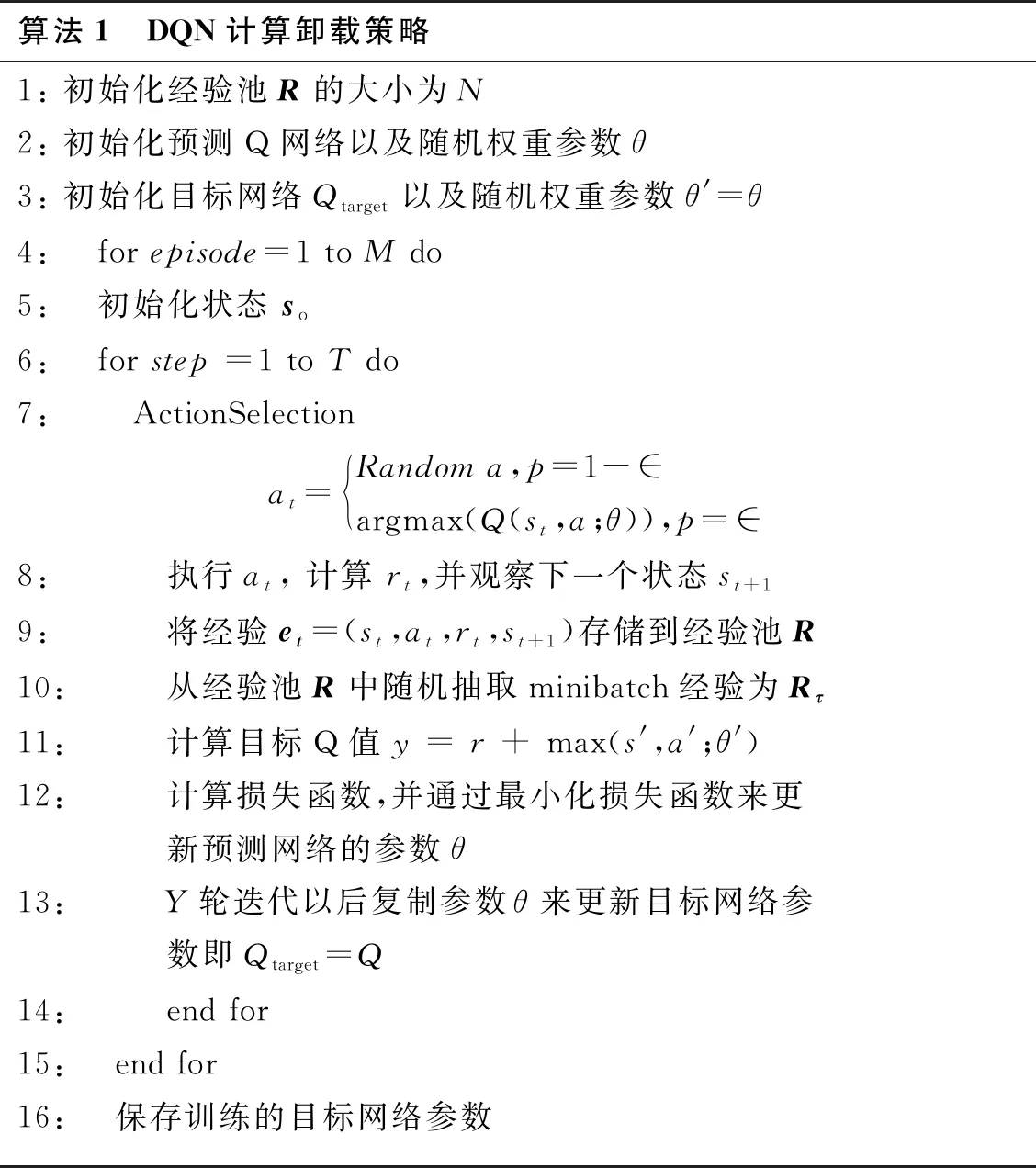

VEC網絡中基于CEC-DQN的計算卸載策略如圖2所示。CEC-DQN的訓練偽碼由算法1給出。

圖2 基于DQN的任務卸載和資源分配算法

算法1 DQN計算卸載策略1: 初始化經驗池R的大小為N2: 初始化預測Q網絡以及隨機權重參數θ3: 初始化目標網絡Qtarget以及隨機權重參數θ'=θ4: for episode=1 to M do5: 初始化狀態 so6: for step =1 to T do7: ActionSelectionat=Random a,p=1-∈argmax(Q(st,a;θ)),p=∈ 8: 執行at, 計算 rt,并觀察下一個狀態st+19: 將經驗et=(st,at,rt,st+1)存儲到經驗池R10: 從經驗池R中隨機抽取minibatch經驗為Rτ11: 計算目標Q值y = r + max(s',a';θ')12: 計算損失函數,并通過最小化損失函數來更新預測網絡的參數θ13: Y輪迭代以后復制參數θ來更新目標網絡參數即Qtarget=Q14: end for15: end for16: 保存訓練的目標網絡參數

5 性能評估

在VEC網絡中,考慮了一個RSU和多個IoV用戶的場景,其中RSU通信距離為500 m。MEC服務器、聚合服務器和云服務器的計算能力分別設置為F1=1×109Hz,F2=2×1010Hz,F3=1×1011Hz。發射功率為p1= 2 W,有線數據傳輸速率為Ras=2Rcs=10 Mbit/s,高斯噪聲功率譜密度為N0=-174 dBm/Hz,信道增益為hi=127+30lgd。系統總帶寬為20 MHz,每個子通道的帶寬為1 MHz。

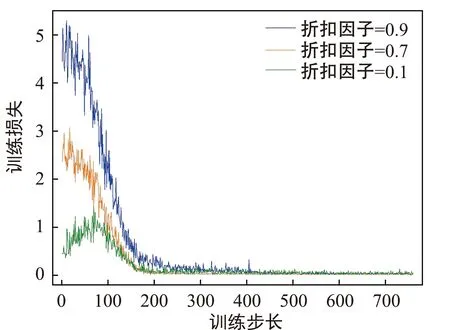

首先分析了不同折扣因子對收斂性的影響,如圖3所示。將折扣因子分別設置為0.9、0.7和0.1。由圖3可知,隨著折扣因子的增大,訓練損失收斂的速度越快。這是因為如果折扣因子設置過小,系統只能在短期內降低系統的總長期成本。若增大折扣因子,系統對未來獎勵的重視越高,在長期獎勵上就越有保證。

圖3 折扣因子對收斂性的影響

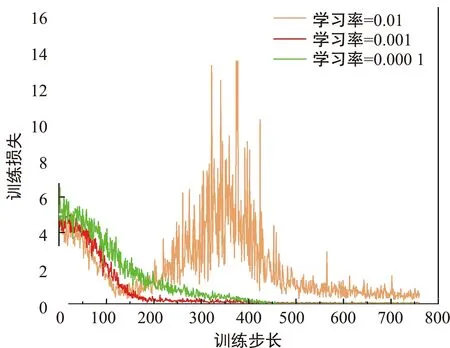

圖4分析了學習率對訓練損失的影響,從圖4可以看出,隨著訓練步數的增加,DQN算法可以有效地收斂。將學習率分別設置為0.01、0.001、0.000 1,可以得到,當學習率為0.001時,訓練損失收斂速度最快。這是因為學習率決定了權重在梯度方向變化的步長。學習率越大,權重變化越大容易導致跳過全局最優值而陷入局部最優值;若學習率設置較小,則每一步的損失函數最小值的方向都比較小,會浪費更多的時間來優化。

圖4 學習率對收斂性的影響

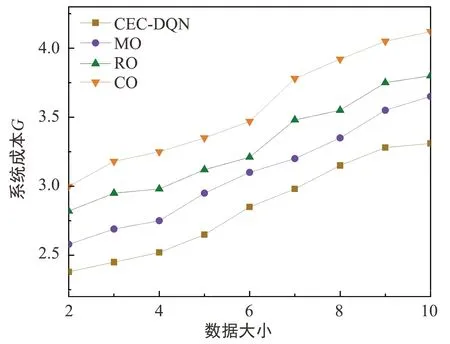

為了驗證CEC-DQN算法的性能,本文選擇了MEC Offloading (MO)、Cloud Offloading (CO)和Random Offloading (RO)三種計算方法與CEC-DQN算法進行比較。圖5顯示了不同算法下任務數據大小對系統總成本的影響,其中每個任務的數據大小設置為2~10 MB不等。從圖5可以看出,隨著任務數據大小的增加,系統總成本也會增加。與CO、RO和MO算法相比,CEC-DQN算法的系統總成本平均分別降低了7%、13%和22%。這表明,CEC-DQN算法可以整合系統當前和未來的狀態,可以更一致地優化系統總成本。

圖5 任務數據量對成本G的影響

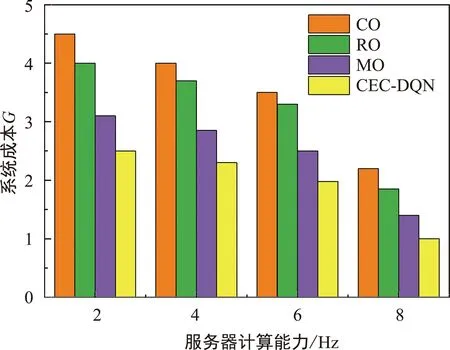

圖6分析了不同算法下MEC服務器計算能力對系統總成本的影響,其中服務器的計算能力設置為2~8 GHz不等。在圖6中,隨著MEC服務器計算能力的增加,系統總成本呈下降趨勢。與CO、RO和MO算法相比,CEC-DQN算法的系統總成本平均分別降低了5%、15%和23%。這表明,任務的計算量與邊緣服務器的計算能力呈正相關,且CEC-DQN方法在VEC網絡中的能耗、時延控制和可靠性方面優于基準策略。

圖6 MEC服務器計算能力對成本G的影響

6 結束語

面對車載邊緣計算網絡中高性能需求,為解決通感算融合網絡中邊緣節點缺失智能化處理現狀,本文基于分布式計算與云邊端一體化技術,提出一種高效的車載邊緣計算卸載策略來最小化系統的長期總成本,實現VEC網絡通感算資源調度優化。首先將算力與網絡深度融合,協同分布式計算資源提出了一種適用于多用戶的協同分層智能驅動VEC算力網絡體系架構,利用云中心、聚合服務器和MEC服務器的異構計算能力,有效應對邊緣節點在多層算力網絡中實現算力均衡。在此基礎上,聯合優化卸載決策與資源配置機制,將其轉化為MDP問題。最后,提出了一種基于CEC-DQN的算法來解決MDP問題,為提高通感算融合系統的網絡容量、計算效率提供了支持。仿真結果表明,與CO、RO和MO算法相比,CEC-DQN算法在優化系統長期總成本方面的平均性能優勢分別約為6%、14%和22.5%。在未來的研究中,將面向車載邊緣計算中通感算融合系統中實時邊緣智能難題進行更深入的探討,為后續課題奠定研究基礎。