基于EMobileNet的肝硬化圖像分類網(wǎng)絡(luò)研究

王珊珊 朱威 周萍萍 李開(kāi)艷

摘?要:為了解決肝硬化病理圖像分類準(zhǔn)確率低的問(wèn)題,基于復(fù)合卷積神經(jīng)網(wǎng)絡(luò)提出了一種更準(zhǔn)確的對(duì)肝硬化病理圖像分類的深度學(xué)習(xí)模型EMobileNet.EMobileNet是在EfficientNetV2網(wǎng)絡(luò)的基礎(chǔ)上,插入可分離自注意力模塊MobileViTv2,并引入四階龍格-庫(kù)塔殘差塊調(diào)整MBViTconv模塊間的連接方式.肝硬化病理圖像數(shù)據(jù)集由華中科技大學(xué)同濟(jì)醫(yī)學(xué)院附屬同濟(jì)醫(yī)院提供,實(shí)驗(yàn)采用十折交叉驗(yàn)證法對(duì)線陣和凸陣圖像分別進(jìn)行訓(xùn)練并分類.對(duì)所提出模型進(jìn)行消融實(shí)驗(yàn)并與多種經(jīng)典網(wǎng)絡(luò)效果進(jìn)行對(duì)比,結(jié)果顯示EMobileNet模型在三分類任務(wù)上達(dá)到了97.89%的總體準(zhǔn)確率,顯著提高了檢測(cè)性能,可以取得較高精度的肝硬化病理圖像分類效果.

關(guān)鍵詞:肝硬化;EMobileNet;可分離自注意力;MobileViTv2;四階龍格-庫(kù)塔殘差塊

中圖分類號(hào):TP391.4

文獻(xiàn)標(biāo)志碼: A

文章編號(hào):2096-398X(2023)04-0173-07

Abstract:To solve the problem of low classification accuracy of cirrhotic pathological images,this paper proposes a more accurate deep learning model EMobileNet for the classification of cirrhotic pathological images based on a composite convolutional neural network.EMobileNet refers to EfficientNetV2 network with the insertion of the separable self-attention module MobileViTv2,and the introduction of fourth-order Runge-Kutta residual block to adjust the connectivity between MBViTConv modules.The liver cirrhosis pathology image dataset was provided by Tongji Medical College,Huazhong University of Science and Technology,and the experiments were conducted using the ten-fold cross-validation method to train and classify the convex and line array images respectively.The proposed model was subjected to ablation experiments and compared with the effects of various classical networks,and the results showed that EMobileNet achieved an overall accuracy of 97.89% on the triple classification task,significantly improving the detection performance and enabling a higher accuracy in the classification of cirrhotic pathology images.

Key words:cirrhosis; EMobileNet; separable self-attention; MobileViTv2; fourth-order Runge-Kutta residual block

0?引言

肝臟是以代謝功能為主的重要器官之一,擔(dān)負(fù)著極其重要的功能,如有機(jī)營(yíng)養(yǎng)物質(zhì)的代謝合成,代謝毒素的無(wú)毒轉(zhuǎn)化,間接參與造血等等.全世界每年約有200萬(wàn)人死于肝病,100萬(wàn)人死于肝硬化并發(fā)癥,100萬(wàn)人死于病毒性肝炎和肝細(xì)胞癌[1].近年來(lái),全球肝硬化患者數(shù)量不斷增加,僅中國(guó)就有超過(guò)700萬(wàn)肝硬化患者.肝硬化一旦惡化,就應(yīng)盡早重視,否則會(huì)導(dǎo)致身體多方面的并發(fā)癥[2].

對(duì)肝硬化病理圖像的準(zhǔn)確分類,對(duì)輔助醫(yī)師診斷有重大意義.利用機(jī)器學(xué)習(xí)相關(guān)算法對(duì)醫(yī)學(xué)病理圖像的識(shí)別,主要有淺層次結(jié)構(gòu)模型[3]和深度學(xué)習(xí)模型[4]兩類研究方法.

在淺層次結(jié)構(gòu)模型方面,Xiong等[5]使用Lloyd算法、LBP算子和灰度共生矩陣紋理特征來(lái)處理肝硬化圖像,并通過(guò)支持向量機(jī)對(duì)肝硬化磁共振圖像進(jìn)行分類.在肝硬化ROI區(qū)域達(dá)到了97.83%的分類準(zhǔn)確率,對(duì)肝硬化圖像的分類準(zhǔn)確率高達(dá)99.5%.Akash等[6]使用改進(jìn)的區(qū)域生長(zhǎng)分割技術(shù)、邏輯回歸和支持向量機(jī)對(duì)肝硬化圖像和肝細(xì)胞癌圖像進(jìn)行分類,對(duì)肝硬化和肝細(xì)胞癌的預(yù)測(cè)準(zhǔn)確率分別達(dá)到86.9%和80%.Raghesh等[7]采用多級(jí)分形特征和多域小波紋理特征對(duì)肝臟超聲圖像進(jìn)行特征提取,利用粒子群優(yōu)化提取最佳特征、選擇最合適的分類器及參數(shù)實(shí)現(xiàn)分類,多級(jí)分形特征集減少了50%,總體準(zhǔn)確率為91%.

在肝臟病理圖像研究領(lǐng)域,基于深度學(xué)習(xí)的識(shí)別方法也得到了一定的應(yīng)用.Huang等[8]介紹了一種基于PCANet和DenseNet的輕量級(jí)混合神經(jīng)網(wǎng)絡(luò),用于肝硬化圖像分類,最終效果達(dá)到89.7%.Chowdhury等[9]采用EfficientNet網(wǎng)絡(luò)檢測(cè)COVID-19,結(jié)合硬集成和軟集成策略提高分類性能,總體準(zhǔn)確率達(dá)到96.07%.但是由于醫(yī)學(xué)病理圖像的特殊性,部分卷積神經(jīng)網(wǎng)絡(luò)讀取圖像特征信息的能力受限,且隨神經(jīng)網(wǎng)絡(luò)深度的增加,分類精度提升并不明顯.

為了進(jìn)一步提升肝硬化病理圖像分類精度,本文提出了一種基于復(fù)合卷積神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)模型EMobileNet.它利用EfficientNetV2系列網(wǎng)絡(luò)模型,在引入MobileViTv2模塊的基礎(chǔ)上,通過(guò)四階龍格-庫(kù)塔殘差塊調(diào)整連接方式,提升網(wǎng)絡(luò)提取肝硬化病理圖像特征信息的能力,進(jìn)一步提高網(wǎng)絡(luò)分類精度.實(shí)驗(yàn)采用線陣和凸陣數(shù)據(jù)集進(jìn)行訓(xùn)練.實(shí)驗(yàn)結(jié)果表明,本文所提出的EMobileNet模型能有效提高檢測(cè)精度,達(dá)到了較好的分類效果.

1?相關(guān)工作

1.1?EfficientNetV2

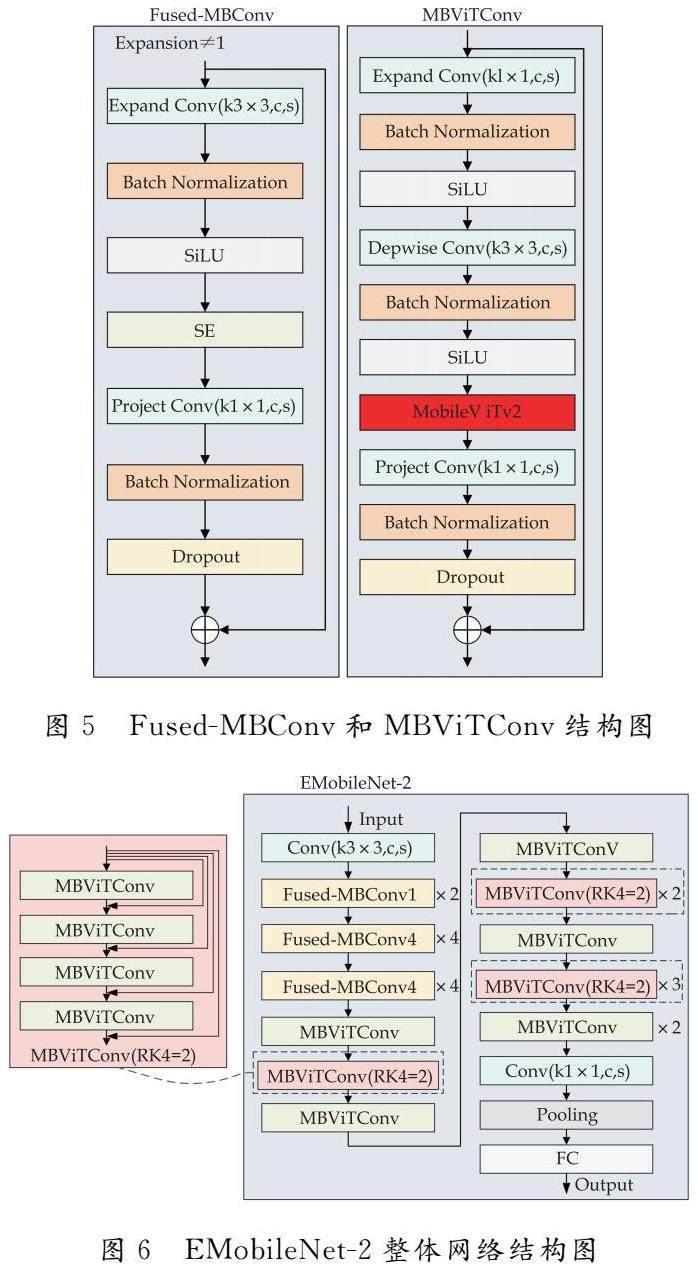

EfficientNetV2由移動(dòng)翻轉(zhuǎn)瓶頸卷積結(jié)構(gòu)(MBConv)和融合移動(dòng)翻轉(zhuǎn)瓶頸卷積結(jié)構(gòu)(Fused-MBConv)模塊組成.MBConv由兩個(gè)1×1標(biāo)準(zhǔn)卷積塊、SE注意力機(jī)制模塊、深度可分離卷積塊組成.其中,深度可分離卷積塊大大減小了模型的參數(shù)量.Fused-MBConv采用3×3的標(biāo)準(zhǔn)卷積塊替換了MBConv中的3×3深度可分離卷積塊和1×1標(biāo)準(zhǔn)卷積塊.相較于MBConv,F(xiàn)used-MBConv雖然參數(shù)量更多,但是具有更強(qiáng)的特征提取能力和圖形推理速度.通過(guò)神經(jīng)架構(gòu)搜索方法(NAS)得到了Fused-MBConv和MBConv的最佳組合,從而充分發(fā)揮兩種模塊的優(yōu)勢(shì),實(shí)現(xiàn)精度、模型參數(shù)量以及推理速度的平衡.Fused-MBConv和MBConv組合下的EfficientNetV2結(jié)構(gòu)參數(shù)如表1所示.Conv表示卷積層;Fused-MBConv和MBConv的尾部數(shù)字1、4和6均為倍率因子,即輸入特征層通道數(shù)擴(kuò)充的倍數(shù);k為卷積核大小;SE為通道注意力機(jī)制模塊;Pooling為池化層;FC為全連接層.

影響深度學(xué)習(xí)分類算法精度的主要因素有網(wǎng)絡(luò)的寬度、深度和圖像分辨率等[10].只調(diào)整主要因素中的某個(gè)參數(shù),增益很快會(huì)達(dá)到瓶頸,導(dǎo)致網(wǎng)絡(luò)性能很難有明顯提升.為了解決這個(gè)問(wèn)題,EfficientNetV2網(wǎng)絡(luò)使用了一種簡(jiǎn)單高效的復(fù)合縮放方法[11],該方法通過(guò)復(fù)合系數(shù)統(tǒng)一調(diào)整網(wǎng)絡(luò)的寬度、深度和圖像分辨率,調(diào)整原則如下:

式(1)~(5)中:d為網(wǎng)絡(luò)深度;w為網(wǎng)絡(luò)寬度;r為圖像分辨率;α、β、γ為網(wǎng)格搜索得到常數(shù);為人為指定的復(fù)合系數(shù),用來(lái)分配可用于模型復(fù)合縮放的資源.通常取復(fù)合系數(shù)為1,α=1.2,β=1.1,γ=1.15.

相較于現(xiàn)有的許多分類網(wǎng)絡(luò),EfficientNetV2網(wǎng)絡(luò)不僅具有更小的模型參數(shù)量,并且在多項(xiàng)分類任務(wù)中表現(xiàn)出更加優(yōu)異的準(zhǔn)確率和效率,因此本文以EfficientNetV2作為主體網(wǎng)絡(luò).

1.2?MobileViTv2

MobileViT是采用CNN(Convolutional Neural Network)和Transformer的混合架構(gòu)模型,在一定程度上緩解了Transformer模型參數(shù)過(guò)大的問(wèn)題.MobileViTv2結(jié)合了可分離自注意力(Separable Self-attention)和MobileViT的優(yōu)勢(shì),能以更高效的網(wǎng)絡(luò)結(jié)構(gòu)充分提取圖像的全局信息[12].通過(guò)引入可分離自注意力機(jī)制,運(yùn)用獨(dú)立的線性計(jì)算和逐元素乘積運(yùn)算編碼全局信息,緩解占用資源多的問(wèn)題.它的參數(shù)與許多輕量化神經(jīng)網(wǎng)絡(luò)相比也較少,性能更穩(wěn)定.

可分離自注意力機(jī)制的主要思想是計(jì)算與潛在標(biāo)記有關(guān)的全局特征分?jǐn)?shù).特征分?jǐn)?shù)被用來(lái)對(duì)另外輸入的標(biāo)記進(jìn)行重新加權(quán)計(jì)算,并產(chǎn)生一個(gè)新的全局向量,該向量對(duì)全局信息進(jìn)行編碼.由于可分離自注意力機(jī)制相對(duì)于潛在標(biāo)記進(jìn)行的是線性運(yùn)算,因此可以有效降低復(fù)雜度.

在可分離自注意力模塊內(nèi),對(duì)于輸入的特征 (m*n),使用三個(gè)分支進(jìn)行處理,處理過(guò)程如圖1所示.

在圖1中,分支1使用權(quán)重為W1的線性層將輸入特征 (m*n)中的每個(gè)n維向量上的特征一一映射,再經(jīng)過(guò)Sigmoid函數(shù)激活后生成m維的全局特征分?jǐn)?shù)CS;分支2使用權(quán)重為W2的線性層將輸入特征X(m*n)線性映射到n維空間,然后與分支1生成的m維向量進(jìn)行逐元素乘積運(yùn)算,加權(quán)計(jì)算后得到全局向量CV;分支3使用權(quán)重為W3的線性層將輸入特征X(m*n)線性映射到n維空間,然后使用ReLU函數(shù)進(jìn)行激活,跟CV再進(jìn)行逐元素乘積運(yùn)算,得到的特征向量再經(jīng)過(guò)一個(gè)線性層,最終生成新的(m′*n′)輸出特征,即為可分離自注意力特征圖.

圖2為圖1中分支1和分支2的交互計(jì)算示意圖.由圖1可知,全局特征分?jǐn)?shù)CS用于計(jì)算全局向量CV.由圖2可知,分支1通過(guò)內(nèi)積計(jì)算潛在特征信息L和輸入特征X之間的距離,得到一個(gè)m維向量,這個(gè)m維向量進(jìn)行softmax操作后得出全局特征分?jǐn)?shù)CS.分支2上經(jīng)過(guò)權(quán)重為W2∈Rn*n的線性層,再通過(guò)與CS逐元素乘積運(yùn)算并求和得到全局變量CV.CV的計(jì)算公式如下:

式(6)中:CS(i)表示分支1上經(jīng)過(guò)了Softmax層的全局特征分?jǐn)?shù),CS∈Rm.X2(i)表示分支2上經(jīng)過(guò)了權(quán)重為W2∈Rn*n線性層的特征向量,X2∈Rm*n.全局向量CV∈Rn.

全局向量CV對(duì)輸入特征中所有信息進(jìn)行編碼.CV編碼的全局信息可以與輸入特征中的信息共享.在CV的基礎(chǔ)上,再將分支3中輸入特征X線性映射在n維空間的特征信息,經(jīng)過(guò)ReLU激活函數(shù)得到X3∈Rm*n.通過(guò)CV中的全局信息與X3逐元素乘積運(yùn)算得到Xo.然后,將所得輸出傳遞至權(quán)重為Wo的線性層,產(chǎn)生最終輸出Y∈Rm′*n′.可分離自注意力整體公式可定義為:

式(7)中:σ表示Sigmoid函數(shù),X表示輸入特征,W1、W2和W3表示三個(gè)線性層對(duì)應(yīng)的權(quán)重,*表示逐元素乘積運(yùn)算,ReLU表示修正線性單元激活函數(shù),Wo表示最終輸出前線性層對(duì)應(yīng)的權(quán)重.

圖3為加入了可分離自注意力的MobileViTv2模塊示意圖,MobileViTv2模塊主要由深度卷積層(DWConv),逐點(diǎn)卷積層(PWConv)和可分離自注意力模塊等組成.本文所提到的MobileViTv2模塊,B值均取1.

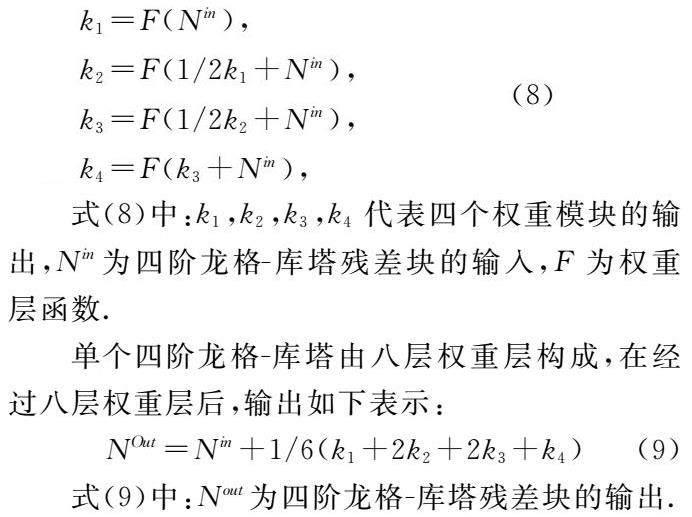

1.3?四階龍格-庫(kù)塔方案

與神經(jīng)網(wǎng)絡(luò)子模塊的設(shè)計(jì)一樣,子模塊間的堆疊策略對(duì)提升神經(jīng)網(wǎng)絡(luò)整體性能同樣重要[13].在資源成本和網(wǎng)絡(luò)參數(shù)相同的情況下,采用不同的堆疊策略,卷積神經(jīng)網(wǎng)絡(luò)可以有更好的表現(xiàn)[14].基于此,本文為EfficientNetV2提出了一種四階龍格-庫(kù)塔殘差連接方案.低階殘差連接方案如圖4(a)所示,低階殘差塊僅僅將每個(gè)權(quán)重塊與權(quán)重塊分隔開(kāi),輸入在經(jīng)過(guò)多個(gè)權(quán)重層后,淺層信息占比不足,提取圖像淺層特征信息效率低.如圖4(b)所示,四階龍格-庫(kù)塔殘差塊將圖像特征的映射分為兩部分,一部分映射來(lái)自前一個(gè)權(quán)重塊內(nèi)部的特征信息傳遞,另一部分是原始輸入特征x直接映射到對(duì)應(yīng)權(quán)重塊得到的特征信息.用高階殘差塊將輸入特征直接映射到其他權(quán)重塊,有效保證了圖像原始特征的傳遞,使淺層網(wǎng)絡(luò)上特征信息得到更好地提取,緩解網(wǎng)絡(luò)層數(shù)太深導(dǎo)致的過(guò)擬合現(xiàn)象.

四階龍格-庫(kù)塔殘差塊由四個(gè)權(quán)重模塊組成,每個(gè)權(quán)重模塊及整體的輸出表示如下:

(8)式(8)中:k1,k2,k3,k4代表四個(gè)權(quán)重模塊的輸出,Nin為四階龍格-庫(kù)塔殘差塊的輸入,F(xiàn)為權(quán)重層函數(shù).

單個(gè)四階龍格-庫(kù)塔由八層權(quán)重層構(gòu)成,在經(jīng)過(guò)八層權(quán)重層后,輸出如下表示:

式(9)中:Nout為四階龍格-庫(kù)塔殘差塊的輸出.

2?改進(jìn)后的EMobileNet

用可分離自注意力MobileViTv2模塊替換MBConv中的SE注意力機(jī)制模塊,命名為MBViTConv模塊.Fused-MBConv模塊和改進(jìn)后的MBViTConv如圖5所示.同時(shí)將各個(gè)MBViTConv層中的每第一個(gè)、第二個(gè)和第三個(gè)MBViTConv模塊用四階龍格-庫(kù)塔殘差塊連接,每四個(gè)MBViTConv模塊連接成一個(gè)四階MBViTConv模塊,分別為RK4=1、RK4=2和RK4=3.將EfficienNetV2中引入四階龍格-庫(kù)塔殘差塊的模型命名為EMobileNet,其中EMobileNet-2為引入了RK4=2的模型.改進(jìn)后EMobileNet-2整體網(wǎng)絡(luò)結(jié)構(gòu)圖如圖6所示.

EMobileNet-2整體網(wǎng)絡(luò)由Fused-MBConv模塊、MBViTConv模塊、卷積層、池化層和全連接層構(gòu)成.圖6虛線框內(nèi)的MBViTConv(RK4=2)可用左側(cè)模塊連接結(jié)構(gòu)代替.與EfficientNetV2相比,EMobileNet-2整體網(wǎng)絡(luò)將引入了可分離自注意力機(jī)制的MobileViTv2模塊替換掉了SE模塊,SE模塊更多關(guān)注圖像通道上的特征信息,而醫(yī)學(xué)圖像作為灰度圖像中常見(jiàn)的單通道圖像,在通道上的特征信息只是一部分.由于可分離自注意力機(jī)制能更有效把握?qǐng)D像的全局信息,降低了過(guò)多關(guān)注圖像通道上的特征信息可能導(dǎo)致分類準(zhǔn)確率低的風(fēng)險(xiǎn),使得醫(yī)學(xué)圖像的全局特征信息能得到更全面的提取.通過(guò)四階龍格-庫(kù)塔殘差塊改變MBViTConv層中的堆疊方式,使得網(wǎng)絡(luò)可以充分利用圖像的淺層特征與深層特征,從而緩解層數(shù)深的神經(jīng)網(wǎng)絡(luò)在訓(xùn)練過(guò)程中精度很快飽和的問(wèn)題,提升EMobileNet網(wǎng)絡(luò)的擬合能力.

3?實(shí)驗(yàn)結(jié)果與分析

3.1?數(shù)據(jù)集以及數(shù)據(jù)處理

肝硬化圖像分為早期、中期和晚期肝硬化(0型、1型和2型).在采集肝硬化超聲圖像時(shí),對(duì)同一批患者用線陣探頭和凸陣探頭采集兩組肝硬化圖像數(shù)據(jù).超聲機(jī)的型號(hào)是GE LOGIQ E9,兩組肝硬化圖像數(shù)據(jù)集如圖7所示.實(shí)驗(yàn)采集的肝硬化數(shù)據(jù)集包含61名患者的B超圖像,線陣數(shù)據(jù)集中有0型147張,1型108張,2型68張;凸陣數(shù)據(jù)集中有0型124張,1型110張,2型80張.圖像中的ROI區(qū)域(圖中綠色框內(nèi)的部分)由華中科技大學(xué)同濟(jì)醫(yī)學(xué)院經(jīng)驗(yàn)豐富的醫(yī)生圈出,并給出了病理檢查結(jié)果的分類.將線陣和凸陣圖像的ROI區(qū)域再隨機(jī)裁剪成64*64的小圖,使用模型訓(xùn)練時(shí),總共有圖片7 110張,其中0型2 390張,1型2 430張,2型2 290張.

3.2?評(píng)價(jià)指標(biāo)

本文實(shí)驗(yàn)使用準(zhǔn)確率(Acc),精確率(Pre),召回率(Rec)和F1-Score作為模型性能指標(biāo)量化神經(jīng)網(wǎng)絡(luò)分類性能.各指標(biāo)可用公式表示如下:

式(10)中:TP表示預(yù)測(cè)正確的正類樣本數(shù)量,TN表示預(yù)測(cè)正確的負(fù)類樣本數(shù)量,F(xiàn)P表示預(yù)測(cè)錯(cuò)誤的正類樣本數(shù)量,F(xiàn)N表示預(yù)測(cè)錯(cuò)誤的負(fù)類樣本數(shù)量.

式(11)、(12)中:i和j的取值為0,1,2.Prei表示第i類的準(zhǔn)確率,Reci表示第i類的召回率,TPi表示預(yù)測(cè)正確的第i類樣本數(shù)量,Eij和Eji表示真實(shí)標(biāo)簽為第i類但被錯(cuò)誤預(yù)測(cè)為第j類的樣本數(shù)量.

3.3?實(shí)驗(yàn)結(jié)果

本文所有實(shí)驗(yàn)均采用PyTorch開(kāi)源庫(kù)作為深度學(xué)習(xí)框架,CPU為Intel(R) Core(TM) i7-11800H,GPU使用的是NVIDIA GeForce GTX 3060 6GB.

將肝硬化線陣和凸陣超聲圖像數(shù)據(jù)集按照8∶1∶1的比例隨機(jī)劃分成訓(xùn)練集、驗(yàn)證集和測(cè)試集.實(shí)驗(yàn)重復(fù)300次,批大小設(shè)置為8,初始學(xué)習(xí)率設(shè)置為0.01,每經(jīng)過(guò)十個(gè)epoch,學(xué)習(xí)率乘以0.9.為避免圖像尺寸對(duì)模型效率的影響,實(shí)驗(yàn)采用漸進(jìn)學(xué)習(xí)策略,在早期訓(xùn)練過(guò)程中使用較小的圖像尺寸,使得網(wǎng)絡(luò)快速學(xué)習(xí)圖像淺層特征信息,在后續(xù)的訓(xùn)練過(guò)程中逐漸增大圖像尺寸,保證網(wǎng)絡(luò)學(xué)習(xí)圖像較為復(fù)雜的特征信息.在訓(xùn)練過(guò)程中對(duì)數(shù)據(jù)集進(jìn)行十折交叉驗(yàn)證,各網(wǎng)絡(luò)分類對(duì)比實(shí)驗(yàn)結(jié)果如表2所示.在表2中,AlexNet[15]、VGG11[16]、GoogLeNet[17]、ResNet50[18]和EfficientNet[19]、EfficientNetV2經(jīng)典網(wǎng)絡(luò)作為對(duì)比實(shí)驗(yàn)的參照.VGG-ResNet是VGG11和ResNet50融合后的深度學(xué)習(xí)模型.

EMobileNet表示插入可分離自注意力機(jī)制MobileViTv2同時(shí)引入四階龍格-庫(kù)塔殘差塊的模型.其中,EMobileNet-1、EMobileNet-2和EMobileNet-3分別表示引入了RK4=1、RK4=2和RK4=3的深度學(xué)習(xí)模型.EMobileNet-1、EMobileNet-2和EMobileNet-3這三種模型作為消融實(shí)驗(yàn)的參照如表3所示.

從表2可以看出,本文提出的EMobileNet模型,對(duì)于肝硬化病理圖像三分類,達(dá)到最高96.78%的分類準(zhǔn)確率,與其他幾種經(jīng)典的深度卷積神經(jīng)網(wǎng)絡(luò)如AlexNet、VGG11、GoogLeNet和ResNet50相比達(dá)到較高水平,說(shuō)明EMobileNet模型整體分類性能較好.從表3可以看出,引入了四階龍格-庫(kù)塔殘差塊的效果較初始EMobileNet仍有一定提高,其中EMobileNet-2分類準(zhǔn)確率最高達(dá)到97.75%,精確率達(dá)到97.78%,召回率達(dá)到97.75%,F(xiàn)1-Score達(dá)到了0.977 5.EMobileNet-2在肝硬化病理圖像測(cè)試集進(jìn)行分類,實(shí)驗(yàn)結(jié)果如表4所示,三分類混淆矩陣如圖8所示.

從測(cè)試集結(jié)果和三分類混淆矩陣可以看出,組合了MobileViTv2后的EMobileNet具有更好的穩(wěn)定性和泛化能力.同時(shí),四階龍格-庫(kù)塔殘差塊與低階殘差塊相比也具有一定的優(yōu)勢(shì),它可以彌補(bǔ)低階網(wǎng)絡(luò)模型的過(guò)擬合問(wèn)題,能有效提升分類精度.

本文提出的EMobileNet-2在線陣和凸陣肝硬化病理圖像數(shù)據(jù)集上測(cè)試時(shí),取得了較好的分類效果.其中,0型、1型和2型肝硬化病理圖像分類的F1-Score值都達(dá)到了0.97以上,檢測(cè)2型肝硬化時(shí)精確度最高,為99.56%,檢測(cè)1型肝硬化時(shí)召回率最高,達(dá)到了98.73%.各項(xiàng)指標(biāo)均達(dá)到較高水平,表明所提出模型在肝硬化病理圖像上有較大應(yīng)用潛力.

4?結(jié)論

本文提出了一種基于復(fù)合卷積神經(jīng)網(wǎng)絡(luò)的EMobileNet模型,它可以有效地檢測(cè)肝硬化病理圖像病變程度.在EfficientNetV2網(wǎng)絡(luò)的基礎(chǔ)上,首先引入可分離自注意力MobileViTv2模塊,保證了網(wǎng)絡(luò)的圖像特征提取能力;其次利用四階龍格-庫(kù)塔調(diào)整殘差連接方式,提高了模型的特征信息獲取能力;最后對(duì)肝硬化線陣和凸陣數(shù)據(jù)集分別應(yīng)用本文模型訓(xùn)練,結(jié)合二者結(jié)果后得到最終的分類結(jié)果.實(shí)驗(yàn)結(jié)果表明,所提出的EMobileNet模型達(dá)到了很好的分類效果,為肝硬化智能診斷分類提供了新思路,在相關(guān)醫(yī)學(xué)圖像的影像學(xué)分析領(lǐng)域內(nèi)有較高的參考價(jià)值.

參考文獻(xiàn)

[1] Cao W,Chen H D,Yu Y W,et al.Changing profiles of cancer burden worldwide and in China:A secondary analysis of the global cancer statistics 2020[J].Chinese Medical Journal,2021,134(7):783-791

[2] Cao G Y,Jing W Z,Liu J,et al.Countdown on hepatitis B elimination by 2030:The global burden of liver disease related to hepatitis B and association with socioeconomic status.[J].Hepatology International,2022,16(6):1 282-1 296.

[3] Obermeyer Z,Emanuel E J.Predicting the future-big data,machine learning,and clinical medicine[J].The New England Journal of Medicine,2016,375(13):1 216-1 219.

[4] Robert S,Bettina K B,Ambrus T,et al.Diagnosis of focal liver lesions with deep learning-based multi-channel analysis of hepatocyte-specific contrast-enhanced magnetic resonance imaging[J].World Journal of Gastroenterology,2021,27(35):5 978-5 988.

[5] Xiong C M,Han M,Zhao Y,et al.Diagnostic method of liver cirrhosis based on MR image texture feature extraction and classification algorithm[J].Journal of Medical Systems,2020,44:1-8.

[6] Akash N,Esha B K,Manish A,et al.Computer-aided diagnosis of cirrhosis and hepatocellular carcinoma using multi-phase abdomen CT[J].International Journal of Computer Assisted Radiology and Surgery,2019,14(8):1 341-1 352.

[7] Raghesh K K,Sudhakar R,Mohaideen A K K.Particle swarm optimization-based liver disorder ultrasound image classification using multi-level and multi-domain features[J].International Journal of Imaging Systems and Technology,2021,31(3):1 366-1 385.

[8] Huang Z W,Zhu X X,Ding M Y,et al.Medical image classification using a light-weighted hybrid neural network based on PCANet and DenseNet[J].IEEE Access,2020,8:24 697-24 712.

[9] Chowdhury N K,Kabir M A,Rahman M M,et al.ECOVNet:A highly effective ensemble based deep learning model for detecting COVID-19[J].PeerJ Computer Science,2021,7:e511.

[10] 劉金香,班?偉,陳?宇,等.融合多維度CNN的高光譜遙感圖像分類算法[J].中國(guó)激光,2021,48(16):159-169.

[11] Tan M X,Le Q V.Efficientnetv2:Smaller models and faster training[C]//Proceedings of the International Conference on Machine Learning.Online:ACM,2021:10 096-10 106.

[12] Quan Y,Li Z X,Zhang C L,et al.Object detection model based on scene-level region proposal self-attention[C]//International Conference on Pattern Recognition.Online:IEEE Computer Society,2021:954-961.

[13] 汪?豪,吉邦寧,何?剛,等.一種提高直腸癌診斷精度的基于U型網(wǎng)絡(luò)和殘差塊的電子計(jì)算機(jī)斷層掃描圖像分割算法[J].生物醫(yī)學(xué)工程學(xué)雜志,2022,39(1):166-174,184.

[14] Luo Z B,Sun Z T,Zhou W L,et al.Rethinking ResNets:Improved stacking strategies with high-order schemes for image classification[J].Complex & Intelligent Systems,2022,8(4): 3 395-3 407.

[15] Krizhevsky A,Sutskever I,Hinton G E.Imagenet classification with deep convolutional neural networks[J].Communications of the ACM,2017,60(6):84-90.

[16] Zhang X,Zou J,He K,et al.Accelerating very deep convolutional networks for classification and detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2015,38(10):1 943-1 955.

[17] Szegedy C,Liu W,Jia Y,et al.Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition.Boston:IEEE Computer Society,2015:1-9.

[18] He K M,Zhang X,Ren S,et al.Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas:IEEE Computer Society,2016:770-778.

[19] Tan M,Le Q V.Efficientnet:Rethinking model scaling for convolutional neural networks[C]//Proceedings of the International Conference on Machine Learning.Long Beach:ACM,2019:6 105-6 114.

【責(zé)任編輯:陳?佳】

基金項(xiàng)目:國(guó)家重點(diǎn)研發(fā)計(jì)劃項(xiàng)目(2018YFC0116100);湖北省重點(diǎn)研發(fā)計(jì)劃項(xiàng)目(2020BAB114);湖北省教育廳科學(xué)研究計(jì)劃重點(diǎn)項(xiàng)目(D20211402)

作者簡(jiǎn)介:王珊珊(1982—),女,湖北鐘祥人,副教授,研究方向:圖像處理、深度學(xué)習(xí)