稀疏統(tǒng)計學習及其最新研究進展綜述①

張紅英, 董珂臻

西安交通大學 數(shù)學與統(tǒng)計學院,西安 710049

稀疏性是高維空間中信號或者數(shù)據(jù)的普遍內(nèi)蘊屬性,意謂可以僅用少數(shù)位于低維子空間的參數(shù)(特征變量)近似表示高維空間的復雜物理過程.例如,在壓縮感知領域,圖像可用小波基線性表示并得到表示系數(shù),保留較大系數(shù),對較小系數(shù)賦值為0,可得到圖像的近似表示.通過此近似表示對圖像進行復原,基本可以恢復原圖[1].因此,圖像可通過少數(shù)系數(shù)(特征變量)近似線性表示,稱為圖像的稀疏表示.稀疏性廣泛存在于高維數(shù)據(jù)特征選擇、稀疏信號恢復以及眾多其他問題[2-4]之中.這些問題具有共同特點: 在數(shù)據(jù)生成過程中,特征變量的數(shù)量大于采樣數(shù)量.具有這樣特點的問題被稱為高維統(tǒng)計分析問題.稀疏統(tǒng)計學習正是處理這類問題的有效方法.

近10年來,深度學習在人臉識別、語音處理和文本分析等領域獲得空前成功,在眾多任務上均達到接近甚至超越人類的性能表現(xiàn).然而,大量的網(wǎng)絡參數(shù)會帶來訓練代價巨大、容易過擬合等問題,網(wǎng)絡的黑箱特性也導致模型可解釋性較弱.稀疏統(tǒng)計學習固有的約簡特性和強可解釋性,提供了解決上述問題的一種可能.將稀疏統(tǒng)計學習與深度學習結(jié)合,成為受到廣泛關(guān)注的熱點領域.相關(guān)研究大致可以分為基于稀疏建模的深度學習方法和數(shù)據(jù)驅(qū)動的稀疏統(tǒng)計分析方法.前者通過稀疏建模的思想與方法,進行深度神經(jīng)網(wǎng)絡架構(gòu)和算法的設計.后者則利用深度神經(jīng)網(wǎng)絡的強大表示能力,通過深度神經(jīng)網(wǎng)絡學習特征表示,并應用于稀疏統(tǒng)計學習模型.越來越多的研究集中于該領域,并獲得了令人欣喜的成果.

本文從經(jīng)典的稀疏統(tǒng)計學習方法出發(fā),回顧經(jīng)典的稀疏回歸分析方法,并對深度神經(jīng)網(wǎng)絡與稀疏統(tǒng)計學習相結(jié)合的研究進行簡要綜述.

1 稀疏回歸分析

回歸分析方法作為統(tǒng)計數(shù)據(jù)分析強有力的工具之一,一直是統(tǒng)計學的研究熱點,同時也被廣泛應用于自然科學及社會科學的各個領域.回歸分析旨在描述輸出變量與特征變量的關(guān)系,并進行統(tǒng)計建模和推斷.近年來,隨著計算與數(shù)據(jù)采集能力的持續(xù)提高,高維數(shù)據(jù)逐漸成為回歸分析的重要對象.為得到正定解,在高維數(shù)據(jù)回歸分析中,一般使用基于稀疏性假設的正則化框架.本節(jié)將在正則化框架下,綜述稀疏回歸分析的各類模型.

1.1 正則化框架

(1)

模型(1)稱為統(tǒng)計學習的正則化框架,其中L(·)是損失函數(shù),P(·)是正則項,λ是正則化參數(shù).特定的正則化框架會使模型的解具有正定性、光滑性和稀疏性等性質(zhì),從而提高了模型的精度和可解釋性.不同的方法常根據(jù)不同的先驗信息選擇不同的損失函數(shù)和正則項.

1.2 稀疏回歸分析中的變量選擇

稀疏性假設是針對高維數(shù)據(jù)進行統(tǒng)計建模和分析的重要手段.稀疏性假設意指在統(tǒng)計模型中,僅少數(shù)特征變量對輸出產(chǎn)生重要影響.基于稀疏性假設,稀疏回歸分析旨在基于回歸分析框架對高維數(shù)據(jù)進行統(tǒng)計建模、分析和推斷.

因僅少數(shù)特征變量產(chǎn)生重要影響,變量選擇便成為稀疏回歸分析中的關(guān)鍵問題.最優(yōu)子集選擇[5]則是最直接的變量選擇方法.

對于多元線性回歸模型

y=Xβ+ε

(2)

其中X=(x1,x2,…,xp),β=(β1,β2,…,βp)T,ε是隨機噪聲.最優(yōu)子集選擇在所有包含m(0≤m≤p)個變量的模型中,選擇擬合效果最好(殘差最小)的一個.

最優(yōu)子集的選擇可以被納入統(tǒng)計學習的正則化框架,可以被看作是基于L0-正則項的最小二乘模型.假設‖β‖0是向量β的L0-范數(shù),其中L0-范數(shù)表示向量β中的非零元素個數(shù),則基于L0-懲罰的最小二乘估計準則為

(3)

當‖β‖0=m時,模型(3)的解等價于最優(yōu)子集選擇的結(jié)果.求解模型(3)是NP-難問題[6],已知算法均無法在多項式時間內(nèi)有效解決.因此,求解過程通常需要進行近似.值得指出的是,一些準則例如AIC準則[7]、BIC準則[8]、HQIC準則[9]等也是L0-正則化模型.

1.3 基于凸正則項的稀疏回歸分析

求解模型(3)的NP-難問題,一個重要方法就是利用正則化框架進行松弛處理.

Tikhonov正則化方法通過利用控制函數(shù)光滑性的懲罰項解決積分方程不可解或者有無窮多解的問題,是一種標準的求解非適定積分方程的方法.以求解逆問題的觀點來看,嶺回歸模型可以認為是Tikhonov正則化方法的特例[10],其形式為

(4)

模型(4)用L2-正則項代替模型(3)中的L0-正則項,具有解析解,并具有收縮性質(zhì),即迫使參數(shù)β的所有元素趨向于0,卻不恰等于0.因此,模型(4)不具有變量選擇性質(zhì),且在參數(shù)較大時會帶來偏差.

文獻[11]提出了基于線性回歸模型的非負絞刑模型.該模型可看作3個步驟:

(ii) 求解模型

(5)

非負絞刑模型具有變量選擇性質(zhì),并且可以得到比最優(yōu)子集選擇和逐步選擇方法更加穩(wěn)定的解.

受到非負絞刑模型的啟發(fā),文獻[12]提出了Lasso模型.該模型使用L1-正則項替代最優(yōu)子集選擇中的L0-正則項.幾乎在同一時期,L1-正則項同樣被用于信號處理領域的基追蹤方法[13].基于L1-正則項的Lasso模型具有形式

(6)

Lasso懲罰具有變量選擇性質(zhì),且是L0-范數(shù)的最緊凸松弛,在特定條件下,兩者的解完全等價.大量的研究顯示,基于L1-正則項的Lasso模型具有強可解釋性、統(tǒng)計有效性[14]和計算高效性等良好性質(zhì),因此得到了廣泛關(guān)注和應用.

Lasso模型在變量選擇過程中,通過對全部特征變量的系數(shù)施加相同程度的懲罰進行系數(shù)收縮,以達到將與響應變量無關(guān)的冗余變量壓縮為0的目的.然而,這會使得與響應變量相關(guān)的目標變量的系數(shù)也受到相同程度的壓縮,導致回歸系數(shù)的估計是有偏的.

為得到無偏或者近似無偏的估計,文獻[15]提出了自適應Lasso模型.自適應Lasso模型具有形式

(7)

其中,w∈Rp是已知的權(quán)重向量.自適應Lasso模型采用重新加權(quán)的L1-范數(shù),能夠修正Lasso模型的過度估計,并且具有Oracle性質(zhì).

Lasso模型的另一個缺陷是無法妥善處理特征變量間具有高相關(guān)性的數(shù)據(jù).當一組特征變量兩兩之間相關(guān)性很高時,Lasso模型傾向于只選擇其中任意一個; 當n

(8)

當特征變量高相關(guān)時,彈性網(wǎng)模型會使這些變量的系數(shù)趨向于相同,因此,彈性網(wǎng)模型可以選到全部相關(guān)的特征變量.

另一種研究特征變量間相關(guān)性的方法是利用其組結(jié)構(gòu),將特征變量分組,研究不同組的特征變量與輸出之間的關(guān)系.組Lasso模型[17]就用來解決此類問題,其形式為

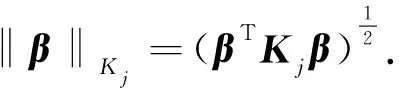

(9)

當某個組在組Lasso模型擬合中被選中時,該組中的所有系數(shù)均不為0,因此無法處理組內(nèi)個別目標變量的回歸系數(shù)不為0的情況.為了實現(xiàn)組內(nèi)稀疏性,稀疏組Lasso模型[18-19]對組Lasso模型進行了改進,其形式為

(10)

其中λ1,λ2≥0.模型(10)可以同時實現(xiàn)組間與組內(nèi)稀疏性.當λ1=0時,模型(10)退化為組Lasso模型; 當λ2=0時,模型(10)退化為Lasso模型.

Lasso模型無法處理連續(xù)變量數(shù)據(jù).為克服這個缺陷,融合Lasso模型[20]對Lasso模型進行了擴展,其具體形式為

(11)

其中λ1,λ2≥0,Bβ=[β1-β2,β2-β3,…,βp-1-βp]T.模型(11)通過促使相鄰系數(shù)趨于相同以保證獲得稀疏解以及數(shù)據(jù)的局部連續(xù)性.

除了上述參數(shù)回歸模型之外,一些基于稀疏正則化框架的非參數(shù)模型也得到了廣泛研究.非參數(shù)回歸往往受到“維數(shù)災難”的困擾,因此近似方法對于該類模型至關(guān)重要.加法模型正是此類近似方法,該模型為

(12)

通過在加法模型上應用Lasso懲罰,文獻[21]提出了稀疏加法模型

(13)

任何非參數(shù)方法均可以用于擬合模型(13).Backfitting算法[22]同樣適用于計算模型(13).

1.4 基于非凸正則項的稀疏回歸分析

L0-正則化模型中L0-范數(shù)是向量中非零元素的個數(shù),為非凸非連續(xù)函數(shù).因此,L0-正則化模型是基于非凸正則項的稀疏回歸模型.

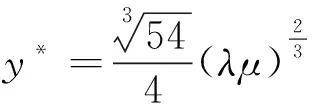

文獻[23-25]發(fā)現(xiàn)Lasso估計需要在特定條件下才具有較好的變量估計和選擇特性,且即使在這些條件下,Lasso估計仍存在偏差.為克服上述缺陷,可采用非凸的0 (14) 文獻[26]提出了bridge回歸模型 (15) 其中0<γ.模型(15)搭起了最優(yōu)子集選擇與嶺回歸之間的橋梁.當0<γ<1時,正則項是非凸的,其等價于0 (16) (17) (18) 其中 且 (19) (20) 使得D=DZ+E.模型(20)利用增廣拉格朗日乘子方法(ALM)[40]和Half閾值算子進行求解. (21) 并提出了求解的迭代算法,同時證明了其收斂性. (22) EKh和Ekv分別表示水平方向和豎直方向的運算. (23) 使得R=S+T,T=Z+C.其中 ⊙是張量核范數(shù)[46],表示張量秩的最緊凸松弛.模型(23)通過基于交替方向最小化(ADM)[47]的增廣拉格朗日乘子法(ALM)進行優(yōu)化求解[40]. 鑒于非凸正則項的顯著優(yōu)勢,除0 (24) 其中,pλ(βi)的形式為 (25) 其中λ≥0,a>2.SCAD正則項可以產(chǎn)生具有Oracle性質(zhì)的估計. 文獻[49]提出了極小極大凹正則項(MCP),其形式為 (26) 其中a>1.模型(26)理論上近似無偏,且具有Oracle性質(zhì). SCAD和MCP均為Folded Concave懲罰函數(shù),分別是軟閾值方法和硬閾值方法的拓展.SCAD是連續(xù)的,但MCP不連續(xù). 過去10年,深度神經(jīng)網(wǎng)絡的研究取得了空前的成功,尤其在圖像、語音、文本等任務上表現(xiàn)出色.深度神經(jīng)網(wǎng)絡研究的成功極大地拓寬了處理高維數(shù)據(jù)方法的邊界,提高了處理能力.然而,現(xiàn)代深度神經(jīng)網(wǎng)絡在訓練和應用中通常被當作“黑箱”,其內(nèi)部原理依然不清晰,可解釋性較差,因而無法嚴格保證模型性能.另外,現(xiàn)代深度神經(jīng)網(wǎng)絡參數(shù)量巨大,訓練過程需要大量訓練數(shù)據(jù).這使得深度神經(jīng)網(wǎng)絡訓練過程中的計算消耗巨大,常需要龐大的計算資源支持,效率較低. 作為處理高維數(shù)據(jù)的經(jīng)典方法,稀疏統(tǒng)計分析方法依據(jù)統(tǒng)計理論和不同先驗信息建模,通常有較強的可解釋性.同時,稀疏統(tǒng)計分析方法并不依靠大量訓練數(shù)據(jù),求解過程也僅需要少量迭代便能達到較好性能,因而計算消耗較小,效率較高.如何將稀疏統(tǒng)計分析方法與深度神經(jīng)網(wǎng)絡結(jié)合起來,使模型兼具兩種方法優(yōu)點,逐漸成為廣受關(guān)注的熱點問題. 已有研究大致可以分為兩個方向: 基于稀疏建模的深度學習方法和基于數(shù)據(jù)驅(qū)動的稀疏統(tǒng)計分析方法.本節(jié)將針對這兩方面的相關(guān)方法進行綜述. 基于稀疏建模的深度學習方法通過稀疏統(tǒng)計分析方法進行數(shù)據(jù)建模,并據(jù)此進行深度神經(jīng)網(wǎng)絡架構(gòu)和算法的設計.此類方法通常包含深度神經(jīng)網(wǎng)絡展開、神經(jīng)網(wǎng)絡剪枝、神經(jīng)網(wǎng)絡架構(gòu)搜索等主題.本文以深度神經(jīng)網(wǎng)絡展開為例進行介紹. 深度神經(jīng)網(wǎng)絡展開是基于稀疏建模的深度學習方法的典型代表.深度神經(jīng)網(wǎng)絡的架構(gòu)通常需要交替地進行線性和非線性的變換,其中非線性變換借由ReLU等激活函數(shù)完成.此類結(jié)構(gòu)與稀疏統(tǒng)計學習模型中的閾值迭代算法十分類似,其中閾值算子可以看作激活函數(shù).鑒于這種聯(lián)系,將稀疏編碼算法展開成為神經(jīng)網(wǎng)絡的深度神經(jīng)網(wǎng)絡展開方法逐漸受到關(guān)注. 早期的深度網(wǎng)絡展開方法可以追溯到文獻[50]的工作,為了提高稀疏編碼算法的計算效率,提出了一種端到端的學習方法(LISTA).該算法將求解稀疏編碼問題的ISTA迭代算法[51]的每一步迭代看作循環(huán)神經(jīng)網(wǎng)絡的一層,由此得到一個多層循環(huán)神經(jīng)網(wǎng)絡,通過學習參數(shù),自動地學得字典和稀疏編碼. 稀疏編碼問題的目標是求解模型(27)的稀疏編碼: (27) 其中λ>0,W∈Rn×m是過完備字典.ISTA迭代算法是求解稀疏編碼模型(27)的常用方法之一.其迭代過程為 (28) 其中Sλ是逐元素的軟閾值算子,其在每個元素上定義為 Sλ(x)=sign(x)·max{‖x‖-λ,0} (29) xl+1=Sλ{Wtxl+Wey}l=0,1,… (30) 仔細觀察公式(30)可以發(fā)現(xiàn),ISTA迭代算法的每一步迭代中,輸入xl經(jīng)過線性變換和軟閾值算子,得到新的xl+1.這可以看作深度神經(jīng)網(wǎng)絡中的一層,其中軟閾值算子對應于神經(jīng)網(wǎng)絡中的激活函數(shù).執(zhí)行L步迭代相當于連接了L層的深度神經(jīng)網(wǎng)絡.基于此,LISTA將ISTA展開為深度神經(jīng)網(wǎng)絡,其訓練損失函數(shù)為 (31) LISTA通過將稀疏編碼算法展開為深度神經(jīng)網(wǎng)絡,以一種可學習的方式獲得了稀疏編碼問題的解.該模型基于稀疏編碼算法,有著強可解釋性.同時,該模型在計算效率上有著顯著的優(yōu)勢.實驗表明,在達到同一精度的條件下,該模型比某些經(jīng)典ISTA方法快將近20倍. 此外,其他針對稀疏編碼問題的算法同樣可以被展開為深度神經(jīng)網(wǎng)絡.例如,文獻[52-54]將ADMM算法展開為神經(jīng)網(wǎng)絡,文獻[55-57]將近端梯度下降算法展開為深度神經(jīng)網(wǎng)絡,均獲得了不錯的表現(xiàn). 除了深度神經(jīng)網(wǎng)絡展開外,稀疏統(tǒng)計學習方法在深度學習的其他方面也有著廣泛的應用.例如,神經(jīng)網(wǎng)絡正則化方法Dropout[58]因其可誘導核范數(shù)[59-61]而可被看作探索網(wǎng)絡稀疏結(jié)構(gòu)的方式之一; 深度神經(jīng)網(wǎng)絡的初始化權(quán)重方法[62]、特征標準化方法[63]等訓練方法看作稀疏信號恢復或低秩矩陣恢復算法中的等距約束性質(zhì)[64],從而保證模型的性能表現(xiàn). 實際應用中,稀疏統(tǒng)計分析方法常依賴于手工得到的低階特征,表示能力有限.特征表示的好壞往往對模型性能有著重要影響.基于數(shù)據(jù)驅(qū)動的稀疏統(tǒng)計分析方法通常建立在傳統(tǒng)稀疏統(tǒng)計分析模型基礎之上,利用深度神經(jīng)網(wǎng)絡強大的特征表示能力,學習數(shù)據(jù)的高階特征,并應用于稀疏統(tǒng)計分析方法之中,以提升模型性能. 深度哈希學習便是數(shù)據(jù)驅(qū)動的稀疏回歸分析模型的應用之一.文獻[65]提出了深度語義排序模型(DSRH),將深度卷積神經(jīng)網(wǎng)絡整合到哈希函數(shù)中,共同學習特征表示及哈希函數(shù),并保持特征表示與哈希編碼之間的相似性,擺脫了手工特征語義表示能力的限制.同時,該方法利用編碼多層次相似度信息的排序表來指導深度哈希函數(shù)的學習.文獻[66]提出了深度監(jiān)督哈希模型(DSH),該模型基于卷積神經(jīng)網(wǎng)絡框架設計,將成對的圖像(相似或者不相似)作為訓練輸入以學習近似離散的二元哈希編碼表示. 相比于含有兩階段過程的深度哈希學習方法,端到端的深度哈希學習方法以其能大幅提高所學哈希編碼的表示能力而受到廣泛關(guān)注.文獻[67]將卷積神經(jīng)網(wǎng)絡引入哈希學習方法,提出了一種深度監(jiān)督哈希學習方法(DPSH).模型首先通過網(wǎng)絡學習圖像的特征表示,然后將此特征表示通過哈希函數(shù)映射為哈希編碼.模型以端到端的方式,通過衡量成對標簽相似性的損失函數(shù)同時學習特征表示和哈希編碼.為了進一步探索標簽信息,文獻[68]在DPSH基礎上增加了一個判別項用以更新二值編碼.文獻[69]利用錨點圖設計出深度監(jiān)督哈希學習方法(DAGH),可以更加高效地獲得哈希編碼.模型通過構(gòu)建樣本錨點子集,并建立錨點與哈希編碼之間聯(lián)系的方式達到提高計算效率的目的. 深度典型相關(guān)分析也是數(shù)據(jù)驅(qū)動的稀疏多元分析方法的代表之一.文獻[70]提出了早期的深度典型相關(guān)分析方法(Deep CCA).該方法先用深度神經(jīng)網(wǎng)絡分別求出兩個視圖的投影向量,然后通過最大化兩個投影向量的相關(guān)性進行求解.Deep CCA在訓練過程中需要將全部訓練數(shù)據(jù)作為一個批次,因此不能應對大規(guī)模的數(shù)據(jù).為解決該問題,文獻[71]提出了隨機Deep CCA(SDCCA).該模型將神經(jīng)網(wǎng)絡參數(shù)訓練嵌入交替最小二乘方法,以適應小批次隨機優(yōu)化.文獻[72]針對多模態(tài)數(shù)據(jù),提出了基于深度典型相關(guān)分析的處理方法DCCA.該模型利用深度全連接網(wǎng)絡學習文本數(shù)據(jù)的特征,并利用卷積神經(jīng)網(wǎng)絡(CNN)學習圖像數(shù)據(jù)的特征.隨后兩個模態(tài)的數(shù)據(jù)被當作兩個視圖的數(shù)據(jù)矩陣輸入典型相關(guān)分析框架.深度自編碼器同樣被用于典型相關(guān)分析.文獻[73]基于CCA框架提出了深度典型相關(guān)自編碼器(DCCAE),將典型相關(guān)分析與深度自編碼器進行結(jié)合,達到了更好的性能.文獻[74]提出了相關(guān)神經(jīng)網(wǎng)絡(CorrNet)以進一步描述重構(gòu)誤差.該模型可以利用已存在的一個視圖準確恢復另一個視圖. 大數(shù)據(jù)時代,作為傳統(tǒng)統(tǒng)計學習經(jīng)典方法的稀疏統(tǒng)計學習,在高維數(shù)據(jù)處理領域發(fā)揮著舉足輕重的作用,基于稀疏假設的正則化框架帶來了大量高效的高維數(shù)據(jù)處理方法.同時,隨著深度學習的革命性進展,結(jié)合稀疏統(tǒng)計學習與深度神經(jīng)網(wǎng)絡以兼取兩種方法優(yōu)點的研究也日趨受到重視.本文綜述了稀疏統(tǒng)計學習中的經(jīng)典模型,簡要介紹了傳統(tǒng)稀疏統(tǒng)計學習與現(xiàn)代深度學習相結(jié)合的研究進展.然而,目前針對此類結(jié)合的研究還有巨大的探索空間,接下來,對未來研究方向提出一些展望: 1) 由于傳統(tǒng)優(yōu)化理論與算法的局限性,目前稀疏統(tǒng)計學習的研究多集中于求解凸目標函數(shù).但實際應用中頻繁遇到損失函數(shù)和正則項非凸的情形.同時,非凸正則項通常具有更好的統(tǒng)計性質(zhì).因此,對于含有非凸損失和非凸正則項的模型,包括算法的設計與收斂性的證明,都是值得進一步研究的方向. 2) 由于傳統(tǒng)的稀疏統(tǒng)計學習方法通常基于最小二乘損失,其數(shù)據(jù)服從高斯分布.然而,現(xiàn)實應用中數(shù)據(jù)常常并不服從高斯分布.同時,高斯分布對異常點敏感的特性也限制了它的應用.因此,探索基于更加魯棒的損失函數(shù)的稀疏統(tǒng)計學習方法,例如基于分位數(shù)回歸的稀疏統(tǒng)計學習方法等也值得進一步的研究. 3) 深度網(wǎng)絡展開方法的研究目前也集中于具有凸性的稀疏編碼方法.對帶有非凸正則項的稀疏編碼算法進行展開,包括算法效率和性能的研究,還需要更進一步的探索.另外,深度網(wǎng)絡展開方法的理論研究還很初步,其性能表現(xiàn)也有進一步提升的空間,這些均為需要進一步研究的問題. 4) 傳統(tǒng)稀疏統(tǒng)計學習的建模往往嵌入了數(shù)據(jù)本身的先驗信息,大量的經(jīng)典方法在理論和性能上都有著不錯的表現(xiàn).同時,針對不同數(shù)據(jù)、不同問題的新型深度神經(jīng)網(wǎng)絡也不斷涌現(xiàn)出來.探索更適合特定問題的深度神經(jīng)網(wǎng)絡特征表示與傳統(tǒng)稀疏統(tǒng)計算法的結(jié)合,最大限度地發(fā)揮兩種方法的優(yōu)點,也是值得進一步研究的方向.

2 深度稀疏統(tǒng)計分析

2.1 基于稀疏建模的深度學習方法

2.2 基于數(shù)據(jù)驅(qū)動的稀疏統(tǒng)計分析方法

3 總結(jié)