基于中間層頻域特征蒸餾的元學習算法

張 靈, 郭林威

(廣東工業大學 計算機學院, 廣州 510000)

為解決大模型在有限資源設備上部署的難題,諸多學者開展相關研究,在保持DNNs表現不變或表現下降在可接受范圍的情況下,通常采用縮小其規模的方式以實現在嵌入式系統中應用的目的.現階段這方面的研究大致可分為4個方向:1)網絡剪枝;2)網絡量化;3)構建更有效的小型網絡;4)知識蒸餾(DT).其中,知識蒸餾是將大型神經網絡模型的信息遷移至小型神經網絡模型的深度網絡壓縮方法[1],進而用更小模型獲得更優的任務表現.根據當前知識蒸餾的發展,從知識類型上可將其劃分為3種類型:1)基于模型輸出的知識類型[2-4];2)基于模型中間層特征的知識類型[5-10];3)基于關系的知識類型[11-13].

目前,基于中間特征層知識的模型蒸餾方法較多是從特征圖單個激活值層面上的知識遷移,并未考慮到特征圖的全局特征.在學生模型訓練的過程中,教師模型僅能傳遞固定的監督信號,因此無法根據學生模型當前的訓練情況,對傳遞的知識做出適當調整.卷積神經網絡(CNN)模型通常對圖像的低頻特征更為敏感性,且低頻特征對視覺推理任務而言更具有信息性[14-15],因此,在CNN模型的知識蒸餾過程中,從教師模型提取更為敏感且信息性更高的低頻特征作為知識傳遞給學生模型進行輔助訓練會更為有效,故提出一種基于頻域特征遷移的知識蒸餾方法,并結合元代理標簽(MPL)進行模型訓練,使教師模型能夠在遷移中間層頻域知識的同時,根據學生模型在驗證集上的表現更新教師模型自身的參數,實現動態調整頻域特征知識(DTM)的目的.

此外,基于頻域特征的知識遷移僅局限在每個獨立類別上的知識遷移,而忽視了類別之間的差異性信息.對此,本文使用Logistic模型對各個類別提取到的頻域特征做線性二分類,再將分類邊界正交向量上的各個元素作為學生模型對應頻域特征值,使學生模型可根據輸入圖像的類別,有針對性地擬合該類別更具代表性的特征值,而在一定程度上忽略不重要的特征.

1 元學習算法

1.1 DCT頻域特征提取

Yosinski等[16]指出:不同模型在淺層提取的特征差異較小,而模型深隱層提取的特征則具有更多的獨特性.因此,對于處理同樣任務的兩個模型,更深層次的教師模型特征會為學生模型提供更多有用的信息.本文方法知識遷移的發起點是在模型最后一層的卷積輸出層.在特征圖提取頻域特征的過程中,將兩個模型最后卷積層輸出的特征圖看成特殊的二維信號矩陣,并用離散余弦變換(DCT)的變換核與信號矩陣相乘,得到代表特征圖頻域特征的DCT相關系數矩陣.最終通過縮小教師與學生模型特征圖頻率特征差異的方式完成知識遷移.該做法僅要求學生模型生成與教師模型數值分布相似的特征圖即可,而不要求每個對應的激活值均完全相似.此外,由于離散余弦變換具有能量聚集的性質,故相對于其他特征圖全局特征的遷移方法,DCT頻域特征遷移能用更少的參數來表示更多的特征圖知識,其計算表達式為

F=AfAT

(1)

(2)

(3)

式中:A為一維DCT變換的變換系數矩陣;f為模型的中間特征圖;P為特征圖維度大小;i、j分別為特征圖維度的橫、縱坐標編號,取值范圍為0到P-1;c(i)為DCT變換核的補償系數;F為離散余弦變換后得到的DCT相關系數矩陣,該矩陣中每個系數值表示頻率分布與特征圖數值分布的相似程度,相似程度越高,則對應的相關系數越大.

1.2 教師模型參數更新

在算法執行過程中,學生模型參數的更新表達式為

(4)

學生模型用于判別驗證集的表達式為

(5)

式中,xval與yval分別為驗證集輸入與驗證集標簽.

由式(5)可知,學生模型在驗證集上的判別損失對于教師模型參數可導,因此,可通過最小化學生模型在驗證集上的損失值來更新教師模型參數,使教師模型能夠通過學生模型在驗證集上的表現修改自身參數,進而調整傳遞給學生模型中間隱層的頻域特征知識.教師模型參數更新表達式為

(6)

式中,ηT為教師模型學習率.

1.3 線性分類器獲取類間差異性信息

在提取預訓練教師模型最后殘差塊的特征圖輸出頻域特征后,將特征向量與對應標簽用Logistic模型進行二分類,得到分類邊界的正交向量WLogistic.而正交向量上的每個元素在一定程度上表示了特征向量中每個對應特征值的重要程度,可以指導學生模型的頻域特征向量的擬合.

以CIFAR-10數據集分類為例,將10個類別中1個類別的頻域特征向量作為正類,而其他9個類別的頻域特征向量作為負類.用二元線性分類器Logistic Regression對定義好的正負類進行分類,可得到分類邊界的正交向量WLogistic.將正交向量中的每個數值按比例縮放至[0,2]范圍內,然后以權值的形式加權到教師模型與學生模型頻域特征的誤差損失中.當權值小于1時,說明該權值在對應位置上的DCT頻域特征重要程度較低,此時該位置上兩模型匹配的損失值應乘以一個小于1的數以縮小擬合程度;而當權值大于1時,說明該權值在對應位置上的DCT頻域特征需重視,則該位置上兩模型匹配的損失值要乘以一個大于1的數以提高擬合程度.這樣使學生模型在向教師模型學習過程中仍能對每個輸入圖像的類別有針對地擬合.

學生模型最后的訓練損失函數為

(7)

式中:LTotal為總的損失函數;LOutput為學生模型的分類損失;α為分類損失與頻域特征損失的平衡系數,取值范圍為0~1;LDCT_Loss為模型頻域特征損失.

2 實驗與分析

實驗采用數據集CIFAR-10、CIFAR-100及ImageNet 2012對基于頻域特征遷移蒸餾方法的有效性進行驗證.數據集CIFAR-10由10個類的60 000個32×32彩色圖像組成,每類有6 000個圖像,主要包含交通工具與動物兩個大類的圖像,如飛機、汽車、船、貓、鹿及青蛙等;數據集CIFAR-100有100個類別,每個類別包含600個圖像,包含20個大類的圖像,如哺乳動物類、水生動物類、花卉類及戶外場景類等;數據集ImageNet 2012包含了1 000個類別,且不同圖片的像素大小各不相同.由于設備條件限制,該實驗無法進行全數據集運行,故從中抽取了200個類別作為實驗數據集,在CIFAR-10與CIFAR-100數據集中存在較多的動物類別,因此在ImageNet 2012所抽取的類別集中選取交通工具、家具與球類等幾個大類.實驗中教師模型為ResNet-56,學生模型為ResNet-34.實驗設備為單個GPU(GeForce GTX 1080 Ti),實驗環境為python3.6和pytorch1.7.1.

此外,本文還進行了將類間差異性引入知識蒸餾的驗證實驗.通過使用各個類別分類的正交向量WLogistic相互計算距離,用來比較每個分類決策邊界之間的相似度.在DCT變換能量聚集性質的實驗中,進行了特征圖匹配維度的研究.在實驗中兩個模型每個通道的DCT相關系數矩陣大小為8×8,本文除了進行8×8尺寸的相關系數矩陣遷移外,還進行了4×4、2×2以及1×1尺寸的相關系數矩陣知識遷移實驗.

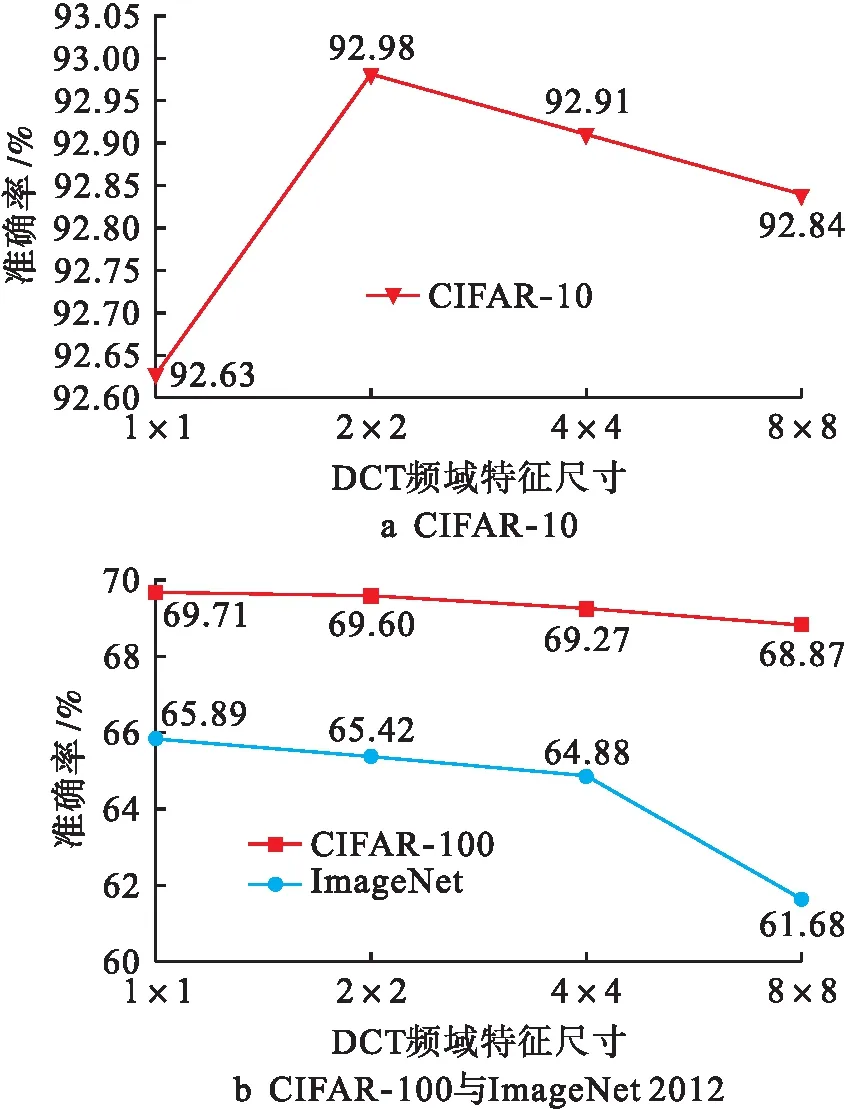

2.1 DCT相關系數矩陣尺寸的選擇

由于DCT變換對圖像特征有能量聚集的功能,因此進行了相關實驗以進一步探究DCT特征圖遷移尺寸的問題,以便能用更少的數值代表更多的特征知識.DCT相關系數矩陣遷移維度分別為8×8、4×4、2×2及1×1時學生模型的準確率如圖1所示.

圖1 不同尺寸系數矩陣的準確率

由圖1a可看出,在CIFAR-10數據集中,當DCT相關系數矩陣取2×2時,學生模型的準確率達到最優.由圖1b則可以看出,在圖像分類類別較多的CIFAR-100與ImageNet 2012數據集上,當DCT相關系數矩陣取1×1時,學生模型的準確率可達最優.這一結果說明DCT對特征圖的頻域特征提取操作在一定程度上還具備噪聲過濾的作用,其可將表示圖像主要信息的低頻特征及表示噪聲的高頻特征獨立地表征出來.而當僅取低頻的特征作為知識進行遷移時,對模型表現的改進則更為明顯.

根據上述實驗規律可發現,隨著數據集分類的增加,DCT對特征圖的特征提取與壓縮效果更加顯著,且對學生模型準確率的提升效果更優.由此將上述實驗得到的結論用于下文關于類間差異性信息及DT與DTM方法的實驗中,將CIFAR-10數據集上原本8×8的DCT相關系數矩陣截取為左上角2×2的矩陣作為教師模型遷移的知識;而在CIFAR-100與ImageNet 2012數據集中則截取左上角1×1的矩陣作為教師模型遷移的知識.

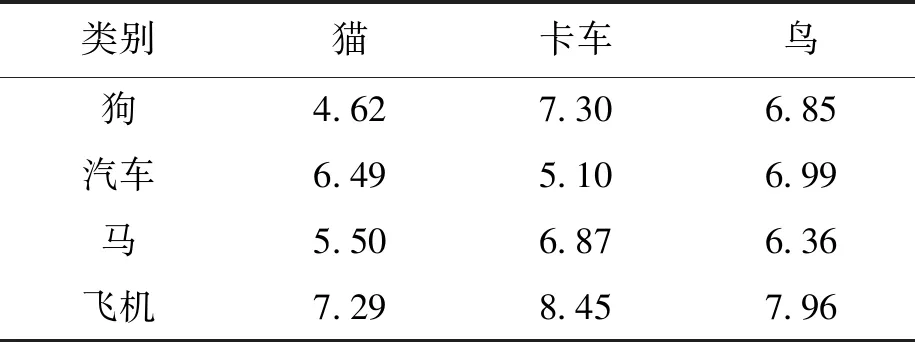

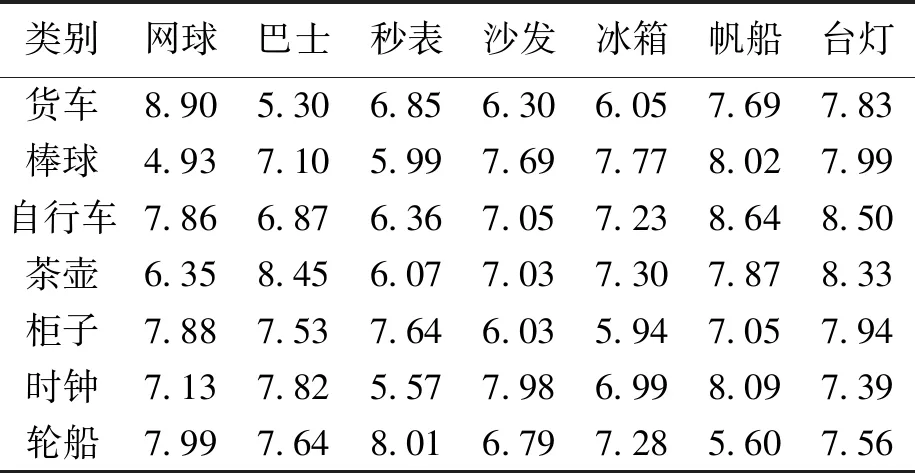

2.2 類間差異性信息

在該項實驗中,將從教師模型中獲得的DCT頻域特征作為Logistic分類器的輸入,得到每個類別正交向量WLogistic相互計算歐氏距離,并比較每兩個類別間對應的WLogistic.在CIFAR-10、CIFAR-100及ImageNet 2012數據集的實驗中分別取部分具有代表性的分類樣本,利用上述方法計算得到的相似性結果如表1~3所示.

表1 CIFAR-10正交向量的相似性比較

表2 CIFAR-100正交向量的相似性比較

表3 ImageNet 2012正交向量的相似性比較

由表1可看出,貓這個類別的正交向量與同為四肢動物的狗、馬等類別的歐氏距離會比汽車、飛機的類別更接近.同樣卡車這一類別的正交向量與汽車類別的歐氏距離會比馬、狗等四肢動物更接近.而鳥這一類別與狗、汽車、馬以及飛機這4類的相似度均較低,所以鳥這一類別的正交向量與其他4類正交向量的歐氏距離均較遠.由此可得,每個類別的正交向量在一定程度上確實包含了與不同類別間差異性的信息.在下文實驗中,DT及DTM方法得到的實驗準確率均為加入類間差異性這一信息后所得到的實驗結果.

2.3 對比實驗

對比方法包括了基于最終輸出的知識蒸餾方法KD,基于特征層的知識提取但缺少全局統計特征的方法AT、FT、EKD及結合了元學習的知識蒸餾算法MPL.在所有實驗中,除了AT與EKD為多個殘差塊做知識遷移操作之外,其余均為基于中間特征圖的知識遷移方法.對于所有的對比實驗,除模型結構更換為教師模型ResNet-56與學生模型ResNet-34之外,其他實驗步驟及相關參數基本沿用原文中的實驗步驟和相關參數.方法KD用于平滑教師輸出標簽的蒸餾溫度參數T設為4,向教師模型軟標簽學習的學習率設為0.9;AT中采用對所有通道對應激活值2次方求和的方法以獲取注意力圖;FT方法使用了原文中表現效果最優的通道壓縮比例k=0.5,用于提取特征的自編碼器為6層卷積層;EKD方法中在模型4個殘差塊的輸出都接入了引導模塊,引導模塊為3層卷積層,后面再接上單層的全連接層和一層softmax層;MPL中教師模型根據學生模型反饋更新參數的學習率為0.05,用于平滑教師輸出標簽的蒸餾溫度參數T與KD一樣設為4.

DT與DTM中頻域特征損失項的權重參數α設置為500.DT與其余未加入元學習訓練方法的知識蒸餾算法共訓練了150個epoch;每個batch大小為128;學習率初始化為0.1,后續在80~120 epoch下降為0.01,120~150 epoch處下降為0.001.MPL與DTM兩個方法訓練了150 000 epoch,學生模型每訓練1 000 epoch,教師模型則根據學生模型在驗證集的準確率更新一次參數;每個batch大小為128;學生模型學習率為0.05.

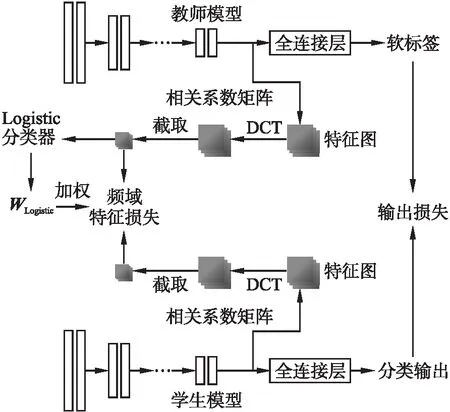

學生模型訓練具體過程如圖2所示,將模型最后一層卷積層的特征圖輸出經過DCT操作獲得對應的DCT相關系數矩陣,截取左上部分低頻特征后,將兩個模型的DCT頻域特征匹配做差進而完成知識遷移.其中,教師模型的頻域特征會再經過Logistic模型分類器,來獲取每個類別分類邊界的正交向量,以加權的形式調整學生模型每個頻域特征值需要向教師模型擬合的程度,使學生模型可根據圖像類別有針對性地擬合對該類別更有代表性的特征值,忽略不重要的特征,融入類別之間的差異性信息.而并非與現有大多數知識蒸餾方法類似,將所有提取到的特征值逐一完整地進行匹配.

圖2 學生模型訓練過程

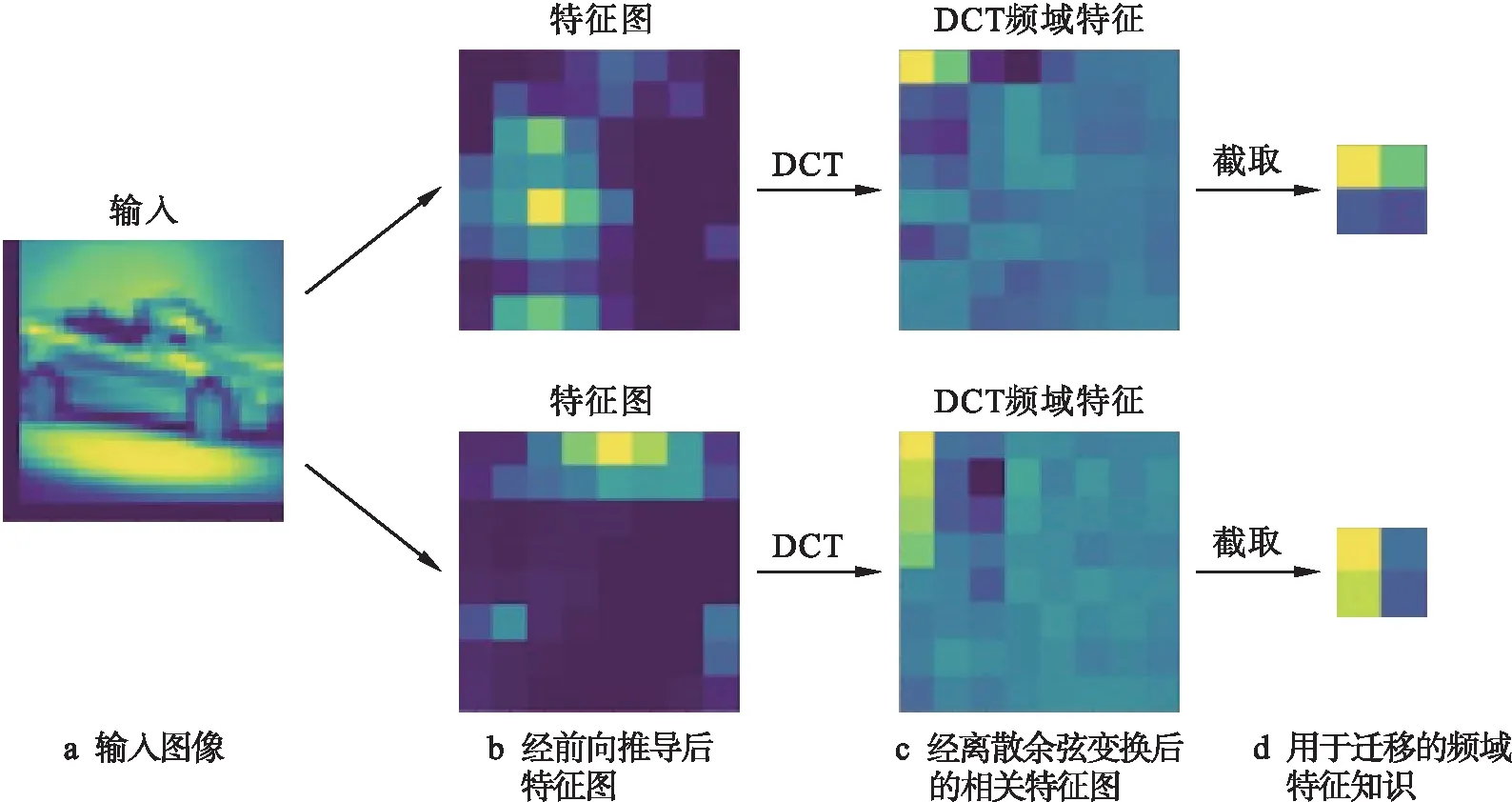

圖3展示了實驗中從模型輸入到最后用于遷移的知識提取過程.圖3中每個方格表示一個對應的數值,顏色越亮表示該方格對應的數值越大,且說明特征圖的數值分布與該位置所表示的頻率分布越相似.矩陣截取值根據上述關于DCT相關系數矩陣尺寸選擇的實驗結論中得出.

圖3 頻域特征提取過程

由圖3b與3c對比可看出,相對于圖像能量分散的特征圖3b而言,圖3c明顯使圖像能量更加集中于左上角的低頻區域.該區域所表示的低頻特征對視覺推理任務而言更具有信息性[14].相對于直接用圖3b進行匹配的FitNets或其他基于空間域特征的方法而言,不僅縮小了知識表達所需的參數,并且包含了整個特征圖的全局統計特征,而非僅局限于特征圖單個激活值層面上的知識表達,不同方法在3個數據集的準確率如表4所示.

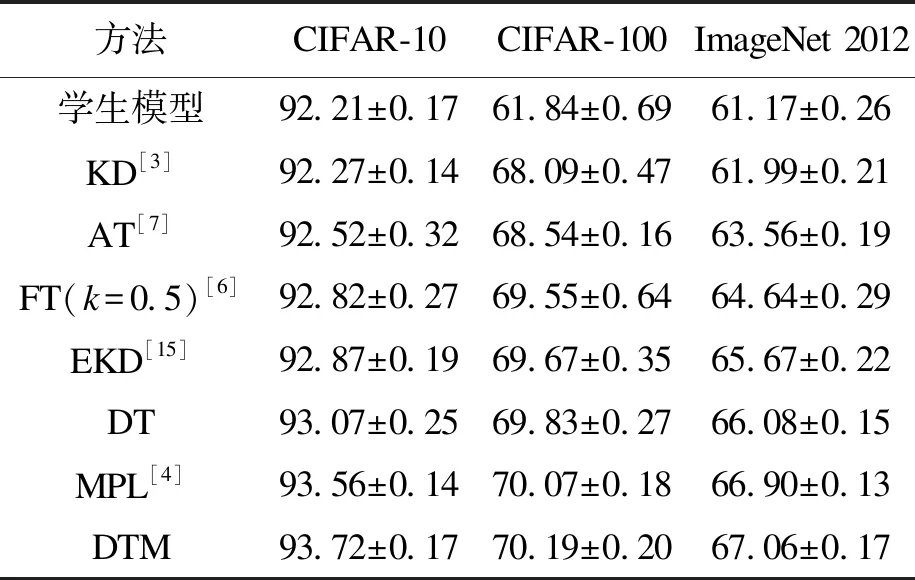

表4 不同數據集的平均準確率

由表4結果可看出,3個數據集上所有的知識蒸餾方法比原始的學生模型在準確率上均具有提升;相較原始知識蒸餾算法KD,AT、FT、EKD對學生模型精確度有一定的提升.而在未加入元學習訓練方法的知識蒸餾算法中,基于頻域知識遷移的DT準確率會高于前者對比方法,而低于MPL.將文中方法結合元學習訓練方法后,DTM準確率在CIFAR-100數據集上比缺少了全局統計特征知識的MPL平均提高了約0.12%,在CIFAR-10以及ImageNet 2012數據集上平均提高了0.16%.

3 結 論

本文從教師模型中提取了頻率域信息作為一種新的知識傳遞給學生模型,并用線性分類器Logistic模型對一個類別與其他全部類別進行分類,使其在知識遷移過程中兼顧了類別之間的差異性信息.最終結合MPL模型訓練方法,使教師模型在對學生模型進行知識遷移時,可根據學生模型在驗證集上的表現來修改教師模型自身的參數,以達到動態調整學生模型特征層知識的目的.CIFAR-10、CIFAR-100與ImageNet 2012圖像分類數據集的實驗結果也驗證了該方法的有效性.