基于卷積神經網絡的移動網絡目標跟蹤與控制

魏冬梅

(1. 西華大學 計算機與軟件工程學院, 成都 610039; 2. 西南財經大學 管理科學與工程學院, 成都 610074)

近年來,移動網絡目標跟蹤已成為視覺跟蹤的重要組成部分之一.移動網絡目標跟蹤被應用到多個領域,并成為眾多學者和專家研究的熱門話題[1-2].雖然目前已有許多優良的跟蹤算法,但是由于移動目標在運動過程中存在太多不確定性,導致移動目標跟蹤仍存在著較多待解決的難題[3-4].目前跟蹤算法基本上由判別類和生成類組成,判別類是指將跟蹤問題進行二值分類轉換,該方法易計算,效率高;生成類是指根據目標模板對圖像進行相似區域的搜索,以此確定跟蹤的目標位置,該方法計算難度大,結構復雜[5-6].鄭志材等[7]以拓撲坐標為基礎研究了移動目標跟蹤方法,通過分析優化后的拓撲算法生成新的坐標向量,降低圖像邊緣壓縮,利用虛擬坐標獲取移動目標的跟蹤位置.李靜等[8]利用局部搜索樹研究移動目標追蹤方法,通過傳感器獲取的時間信息對移動目標的位置進行預測,利用局部遞歸方式進行移動目標的跟蹤路徑搜索.雖然上述方法都能有效實現移動網絡目標的跟蹤,但是對于移動過程中產生的遮擋、形變和模糊等問題仍無法解決.卷積神經網絡(CNN)能夠有效對網絡模型進行優化,降低模型復雜程度,具備局部感知的能力,實現各層特征之間參數的共享[9].基于此,本文提出基于卷積神經網絡的移動網絡目標跟蹤與控制方法.在目標跟蹤分析過程中,利用傳感器采集移動網絡目標圖像,通過構建CNN模型,提取采集圖像的多尺度特征,結合濾波算法獲取響應圖,根據響應最大值實現移動目標的自適應跟蹤與控制.

1 移動網絡目標跟蹤與控制

1.1 相關濾波算法

移動網絡目標跟蹤通過濾波算法轉換為在線回歸,根據回歸誤差的最小化進行最佳濾波模板的求解,跟蹤求解公式為

(1)

式中:X為全部樣本,X∈Rn×n,主要包括目標模板和其通過循環偏移所產生的樣本集;y為跟蹤響應的目標期望值;λ和v分別為正則化參數和濾波參數.

將式(1)引入對偶域內進行閉環求解,計算公式為

(2)

式中:a′、y′和x′均為傅里葉轉換后的數值;x為目標模板;x′*為共軛復數.

通過濾波算法進行移動網絡目標響應圖的求解,計算公式為

h′(Z,a)=k′xZa′

(3)

式中,k′xZ=XZT,Z為循環數據矩陣.移動網絡目標的位置即為響應圖的響應最大值.

1.2 基于卷積神經網絡的卷積特征提取

由于相關濾波算法在面對復雜情況的目標跟蹤時無法提供精準的移動網絡目標模型,且其期望響應值難以跟隨復雜跟蹤情況自適應變化,導致跟蹤難度較大,以相關濾波算法為基礎,提出基于卷積神經網絡的移動網絡目標跟蹤與控制方法,通過卷積神經網絡(CNN)的簡單框架進行圖像層次特征的學習[10-11].

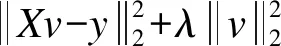

在移動網絡目標跟蹤與控制研究中,將尺度空間中的若干個尺度內引入CNN權值,對圖像所有像素目標進行識別并分類預測[12].采用拉普拉斯濾波對輸入圖像I進行快速局部操作,確保圖像中的細節得以增強.構建圖像I的多尺度As(高斯金字塔),其中,s∈{1,2,…,n},A1與I為相同尺度,具體變化如圖1所示.

圖1 目標圖像多尺度高斯金字塔示意圖

圖1中,I為輸入圖像,A1為第一尺度高斯金字塔,A2為第二尺度高斯金字塔,A3為第三尺度高斯金字塔,上下層圖像之間的關系為:上層面積為下層面積的4倍,上層分辨率為下層分辨率的2倍.假設卷積神經網絡模型為fs,模型內部參數為θs,則該網絡中全部模型參數可以跨越尺度進行共享,即

θs=θ0(s∈{1,2,…,n})

(4)

式中,θ0為CNN模型參數的初始值.設CNN網絡存在的階段數為L,則有

fs(Xs;θs)=WLHL-1

(5)

式中:W為權值矩陣;Xs為輸出通道數;H為輸出,且H0=Xs.在L階段之前的所有隱藏階段l輸出為

Hl=pool(tanh(WlHl-1+bl))

(6)

式中:l∈{1,2,…,L-1};pool()為池化操作;tanh()為激活函數;bl為偏置向量.模型訓練參數θs由Wl和bl構成.

利用上采樣方式對尺寸進行統一,將不同尺寸圖像特征進行組合,以此生成立體特征矩陣,即

F=[f1,u(f2),…,u(fn)]

(7)

式中,u()為采樣函數.

設n=16,特征提取流程如圖2所示.通過尺度空間進行的權值共享可促使網絡學習具備不變尺寸的特性,降低網絡發生過擬合幾率.訓練模型中參與的尺度越多,提取的特征效果越好[13-14].

1.3 自適應跟蹤與控制

濾波算法的響應目標分別與移動網絡目標的外觀模型和運行信息相關,在式(1)中引入跟蹤目標的運動信息[15],則有

(8)

(9)

(10)

式中:G′=[X′-I′],I′T=[I,I,…,I];T=[I,0];Q=[0,I].由式(10)可知,問題由濾波聯合轉換為二次凸優化[16],將式(10)引入對偶域內進行閉環求解,即

(11)

(12)

(13)

通過式(11)對各層卷積響應進行濾波參數的計算,以此獲得最優參數,通過獲取的最優參數展開響應圖計算[17-18],則有

(14)

式中:e為濾波參數;D為當前層特征維數;P-1為逆轉換傅里葉.

為了提升移動網絡目標跟蹤與控制的魯棒性,利用特征響應圖和加權融合方法獲取目標最終響應圖,即

(15)

式中:S為卷積特征池,即卷積特征利用的總層數;w為響應權重.最終響應圖ht中的響應最大值位置即為移動網絡目標位置,通過尋找該位置實現目標的自適應跟蹤與控制.最終響應圖如圖3所示.

圖3 最終響應圖

2 仿真實驗

2.1 實驗環境

仿真實驗開發工具為MATLAB,利用內存為8 GB的計算機實現跟蹤算法.以OTB數據庫中的8組傳感器網絡獲取的移動網絡目標視頻序列為實驗對象,高斯核為0.15,正則化因子為λ1=1×10-2,λ2=1×10-4,學習速率為1×10-3,提取的第8層卷積特征F8為1,第9層卷積特征F9為0.2,第10層卷積特征F10為0.2,第13層卷積特征F13為2×10-2,第14層卷積特征F14為3×10-2,第15層卷積特征F15為1×10-2,樣本模板數量為7.

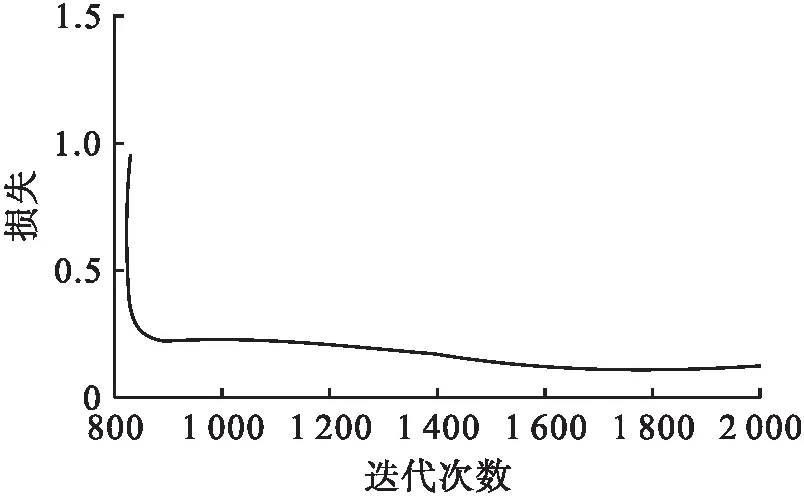

2.2 模型訓練

本文使用隨機梯度下降法對移動網絡目標進行訓練,為提高訓練效率,使用遷移學習方法.網絡訓練時,首先對網絡參數進行初始化處理,初始學習率設定為0.002,權重衰減率設定為0.000 6,動量因子為0.7,驗證周期為2 000,當模型準確率達到收斂時停止訓練,耗時40 h,結果僅保留概率值大于0.6的區域.訓練損失曲線如圖4所示.

圖4 訓練損失曲線

結果表明,隨著迭代次數的增加,訓練集產生的損失逐漸降低,當迭代次數達到1 000次后,損失降至0.25,說明模型訓練效果良好.訓練損失基本收斂到穩定值,表明其達到預期訓練效果.

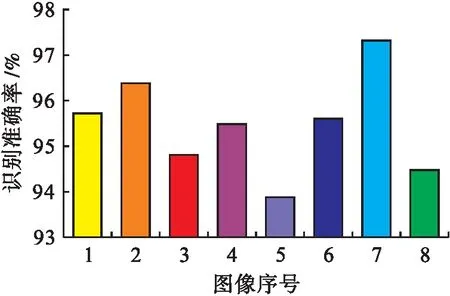

2.3 結果與分析

利用本文方法對移動網絡目標的8組圖像進行像素目標識別實驗,其中,8組圖像可有效驗證本文方法的準確率.通過多次實驗后,統計實驗結果如圖5所示.由圖5可知,本文方法利用多尺度特征進行各圖像像素目標識別能夠獲得良好的識別效果,其中識別準確率最高為97.48%,最低為93.85%,8組圖像平均識別準確率為95.41%.由于多尺度特征為高層次、涵蓋全方位圖像信息的抽象特征,能夠將圖像中所有目標自然屬性進行更好地表達,另外,不一樣尺度的圖像具備相同的CNN結構,促使圖像在提取局部特征過程中的范圍隨著圖像尺度的減小而增大,因此能夠保證從原始圖像中以從小到大的順序進行分層特征提取,從而實現精準識別像素目標的目的.

圖5 像素目標識別結果

采用本文方法分別與文獻[7]以拓撲坐標為基礎研究的移動目標跟蹤方法和文獻[8]以UAV與UGS協同為基礎研究的移動目標追蹤方法進行跟蹤性能比較,分別進行跟蹤精確度(DP)、跟蹤成功率(SR)和跟蹤中心位置誤差(CLE)的對比實驗,三種指標計算公式為

(16)

(17)

(18)

式中:K(p)和Ktotal分別為跟蹤目標距離小于實際中心位置的幀數和總幀數;Rtrack和Rgt分別為跟蹤目標區域和實際目標區域;xtrack和ytrack為目標跟蹤的位置中心坐標;xgt和ygt為目標中心的坐標.當SR大于0.5時,即跟蹤成功.

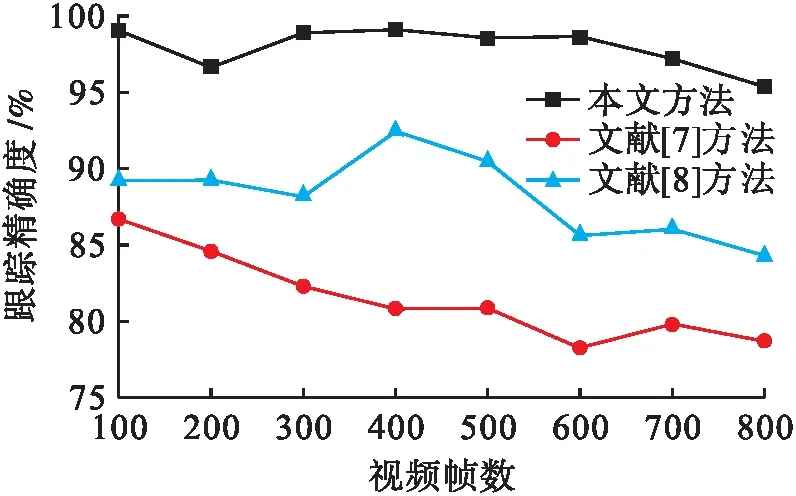

三種方法的跟蹤精確度實驗結果如圖6所示.由圖6可知,三種跟蹤方法在跟蹤精度上存在著較大差距,本文方法平均跟蹤精確度為97.18%,文獻[7]方法和文獻[8]方法的平均跟蹤精確度為81.28%、88.3%,本文方法比文獻[7]方法和文獻[8]方法分別高15.9%和8.88%.三種方法的跟蹤精度均隨著視頻幀數的增加呈不規律降低,但是本文方法波動較小,表明該方法具備移動網絡目標跟蹤的穩定性.

圖6 跟蹤精確度實驗結果

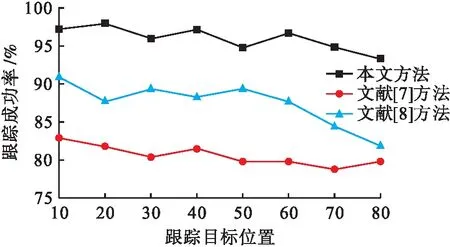

三種方法的跟蹤成功率實驗結果如圖7所示.由圖7可知,本文方法具有更高的移動網絡目標跟蹤成功率,本文方法平均跟蹤成功率為95.93%,文獻[7]方法的平均成功率為84.94%,本文方法比文獻[7]方法的平均成功率高10.99%,文獻[8]方法的平均成功率為87.51%,本文方法比文獻[8]方法的平均成功率高8.42%.

圖7 跟蹤成功率實驗結果

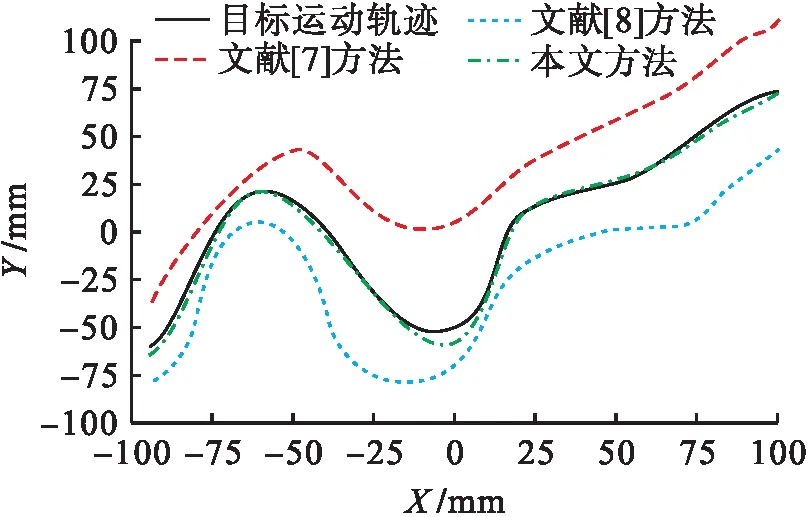

目標跟蹤實驗結果如圖8所示.由圖8可以看出,本文方法的跟蹤結果更接近移動網絡目標的實際運動軌跡,通過計算可知本文方法的中心位置平均誤差為4.38 mm,文獻[7]方法平均誤差為16.85 mm,文獻[8]方法平均誤差為12.08 mm.

圖8 目標跟蹤對比結果

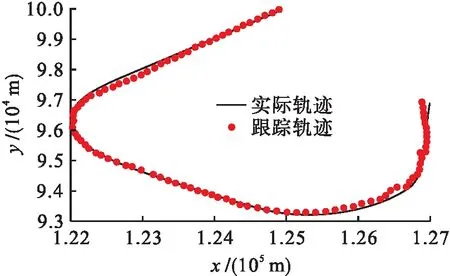

采用誤差評價指標均方根誤差(RMSE)評估跟蹤算法所得值與實際位置值之間的差距,均方根誤差計算公式為

(19)

式中,errj為跟蹤算法所得值與實際位置值之間的差值.目標跟蹤軌跡如圖9所示.

圖9 目標跟蹤軌跡

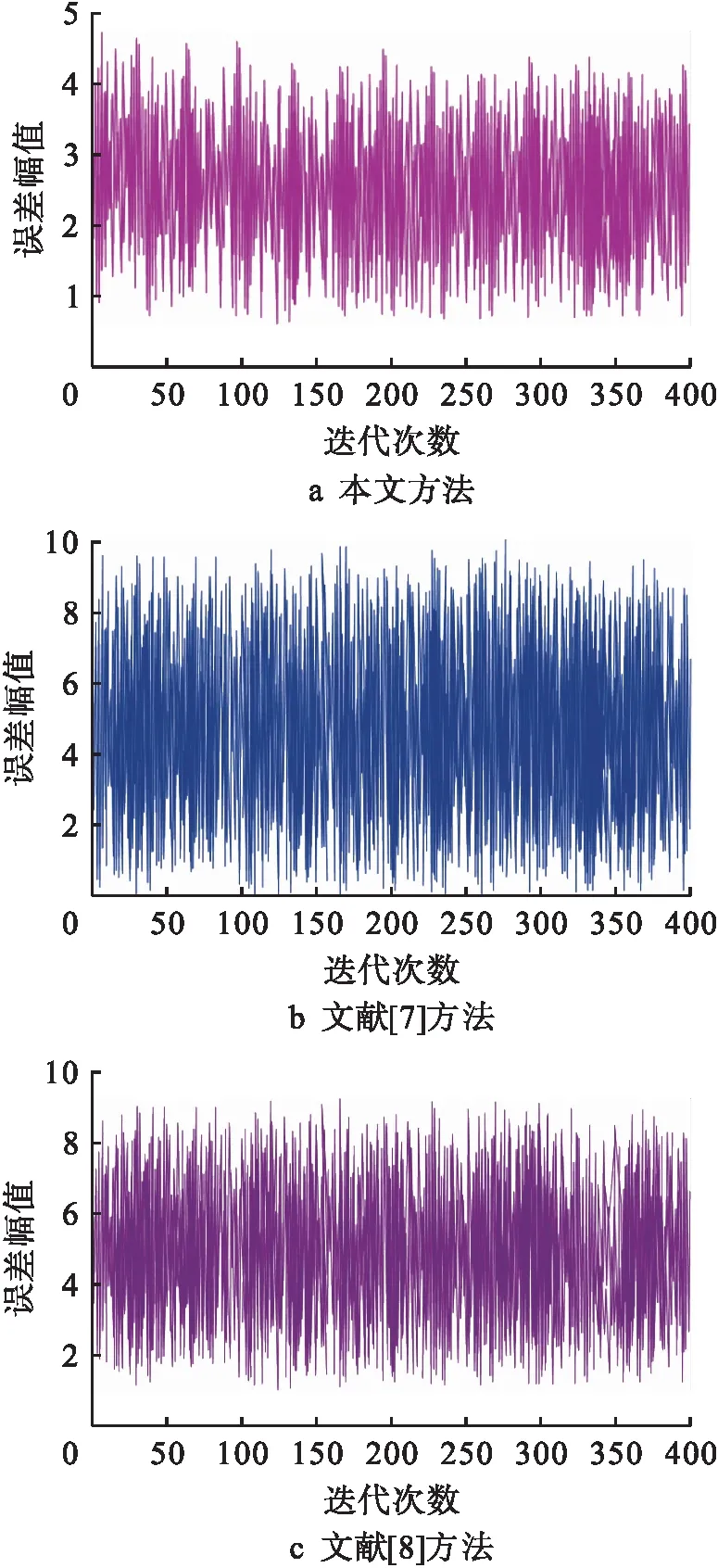

三種方法目標跟蹤位置的誤差實驗結果如圖10所示.由圖10可知,文獻[7]方法的誤差幅值最大,文獻[8]方法的誤差幅值次之,本文方法的誤差幅值最小,表明本文方法在移動網絡目標跟蹤與控制過程中具有更好的跟蹤效果.

圖10 誤差幅值曲線

3 結 論

針對移動網絡目標的跟蹤與控制,本文基于卷積神經網絡的跟蹤與控制方法,通過濾波算法對濾波響應進行計算,確定移動網絡目標的位置,結合CNN的簡單框架進行圖像層次特征的學習,提取卷積多尺度特征,通過濾波算法獲取最優濾波響應,促使移動網絡目標響應能夠隨著目標實際運動而產生自適應改變,以此獲取最優的跟蹤效果.