基于細(xì)節(jié)還原卷積神經(jīng)網(wǎng)絡(luò)的壓縮視頻質(zhì)量增強(qiáng)技術(shù)研究

李子晗 邵笑 張佩云

摘要 視頻編碼技術(shù)有效地解決了原始視頻數(shù)據(jù)量過大的問題,但壓縮效率的提升會使視頻質(zhì)量下降.為了提高壓縮視頻的視覺質(zhì)量,本文提出了一種基于細(xì)節(jié)還原卷積神經(jīng)網(wǎng)絡(luò)(Detail Recovery Convolutional Neural Network,DRCNN)的視頻質(zhì)量增強(qiáng)方法,該方法由一個主去噪分支和一個細(xì)節(jié)補(bǔ)償分支組成.為了有效地提取和消除壓縮失真,在主去噪分支中提出了一個多尺度失真特征提取塊(Multi-scale Distortion Feature Extraction Block,MDFEB),使其更加關(guān)注壓縮視頻中的失真區(qū)域,并提高DRCNN的失真特征學(xué)習(xí)能力.此外,為了豐富壓縮視頻中的細(xì)節(jié),本文提出了細(xì)節(jié)補(bǔ)償分支:首先采用預(yù)訓(xùn)練的50層殘差網(wǎng)絡(luò)組成的內(nèi)容特征提取器,提供豐富的內(nèi)容特征,如突出的物體、形狀、細(xì)節(jié)等;然后通過設(shè)計的細(xì)節(jié)響應(yīng)塊(Detail Response Block,DRB)從內(nèi)容特征中有效地提取細(xì)節(jié)特征.大量的實(shí)驗(yàn)結(jié)果表明,與4種有代表性的方法相比,本文所提出的DRCNN實(shí)現(xiàn)了最佳的壓縮視頻質(zhì)量增強(qiáng)性能.關(guān)鍵詞 視頻質(zhì)量增強(qiáng);深度學(xué)習(xí);視頻后處理;多尺度特征提取

中圖分類號TP391.4

文獻(xiàn)標(biāo)志碼A

0 引言

視頻編碼技術(shù)[1]有效地壓縮了視頻數(shù)據(jù).然而,當(dāng)視頻以低比特率編碼時,壓縮后的視頻會出現(xiàn)許多失真,如基于塊結(jié)構(gòu)編碼引起的塊偽影和變換編碼引起的振鈴偽影.這些壓縮失真可能會嚴(yán)重影響壓縮視頻的體驗(yàn)質(zhì)量(Quality of Experience,QoE).因此,為了有效地提高壓縮視頻的質(zhì)量,特別是在低比特率下編碼的視頻,研究一種先進(jìn)的視頻質(zhì)量增強(qiáng)方法是非常重要的.在過去的幾十年里,許多傳統(tǒng)的質(zhì)量增強(qiáng)方法[2-8]被提出來消除壓縮視頻的失真,這些方法可以分為環(huán)路濾波和后處理.環(huán)路濾波類方法[2-5]用于編碼中增強(qiáng)重建幀的質(zhì)量,但是受限于編解碼端的復(fù)雜度,環(huán)路濾波的增強(qiáng)性能并不令人滿意.因此,后處理質(zhì)量增強(qiáng)方法[6-8]被用在編碼后,來進(jìn)一步增強(qiáng)壓縮視頻的質(zhì)量.然而,這些傳統(tǒng)方法識別和消除失真的能力是不夠的,許多壓縮偽影仍然保留在壓縮視頻中.最近,深度學(xué)習(xí)方法[9-19]在壓縮視頻增強(qiáng)領(lǐng)域取得了巨大成功.Dai等[9]考慮到視頻編碼中的可變編碼塊大小不一,在已有深度學(xué)習(xí)方法的基礎(chǔ)上,使用兩種不同大小的濾波器組合并提出了一種基于可變?yōu)V波器的殘差學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)(Variable-filter-size Residue-learning Convolutional Neural Network,VRCNN)的環(huán)路濾波方法.Yang等[10]提出一種用于壓縮視頻增強(qiáng)的多幀質(zhì)量增強(qiáng)方法,通過將高質(zhì)量幀和目標(biāo)幀融合后送入網(wǎng)絡(luò)中,低質(zhì)量幀可以被鄰近的高質(zhì)量幀增強(qiáng).接著Guan等[11]更新了多幀方法中的高質(zhì)量幀搜尋器,并增加網(wǎng)絡(luò)的深度,實(shí)現(xiàn)了更好的增強(qiáng)性能增益.Zhang等[12]提出一種用于高效視頻編碼的環(huán)路濾波的殘差公路卷積神經(jīng)網(wǎng)絡(luò)(Residual Highway Convolutional Neural Network,RHCNN),文中提出的公路單元可以使原始信息傳送到網(wǎng)絡(luò)深層中,大大改善了RHCNN的性能.Yang等[13]提出一種質(zhì)量增強(qiáng)卷積神經(jīng)網(wǎng)絡(luò)(Quality Enhancement Convolutional Neural Network,QECNN),它使用兩個獨(dú)立的網(wǎng)絡(luò)分別學(xué)習(xí)幀內(nèi)和幀間的失真特征.Zhang等[14]基于殘差學(xué)習(xí)提出一個全新的網(wǎng)絡(luò)結(jié)構(gòu)作為新一代視頻編碼的后處理方法.Zheng等[15]采用一種新的收斂機(jī)制,自適應(yīng)地融合不同網(wǎng)絡(luò)的增強(qiáng)結(jié)果,同時保留了平坦 區(qū)域和豐富的紋理.Ding等[16]設(shè)計了一種基于塊的時間空間質(zhì)量增強(qiáng)方法,并采用時空注意融合模塊來融合不同特征,取得了很好的多幀質(zhì)量增強(qiáng)效果.Meng等[17]提出一種多幀引導(dǎo)注意力網(wǎng)絡(luò),通過融合運(yùn)動信息、時間信息和塊劃分圖,在高比特率下和運(yùn)動場景下取得了很好的效果.考慮到屏幕內(nèi)容視頻中存在大量的顏色相似區(qū)域,Huang等[18]提出基于跨幀信息融合的多幀信息交叉融合屏幕內(nèi)容質(zhì)量增強(qiáng)網(wǎng)絡(luò).Luo等[19]提出一種漸進(jìn)式的多幀質(zhì)量增強(qiáng)方法,由粗到細(xì)融合了視頻的時間空間信息.現(xiàn)有方法可以很好地去除壓縮損失,但是當(dāng)壓縮視頻以高碼率編碼時,視頻中的壓縮偽影將會減少,細(xì)節(jié)增多,均不能很好地區(qū)分損失和細(xì)節(jié),往往會忽略壓縮視頻的細(xì)節(jié),將細(xì)節(jié)特征當(dāng)成失真特征一同去除.為了解決這個問題并在去除視頻損失的同時豐富視頻的細(xì)節(jié)信息,受到視頻增強(qiáng)[9-19]及其他領(lǐng)域[20-25]提出的新穎的深度學(xué)習(xí)模型啟發(fā),本文提出一種細(xì)節(jié)還原卷積神經(jīng)網(wǎng)絡(luò)(Detail Recovery Convolutional Neural Network,DRCNN),此網(wǎng)絡(luò)主要由兩個分支組成:主去噪分支和細(xì)節(jié)補(bǔ)償分支.本文主要工作如下:

1)當(dāng)壓縮視頻處于低碼率時,視頻中呈現(xiàn)的損失主要為全局損失,而大的感受野通常可以很好地捕捉全局損失.因此本文提出一個基于多尺度的大感受野的分支:主去噪分支.在此分支中,由于壓縮視頻中損失特征的尺寸通常不統(tǒng)一,因此本文還采用新穎的多尺度失真特征提取塊(Multi-scale Distortion Feature Extraction Block,MDFEB)提高了整體網(wǎng)絡(luò)對于不同種類失真特征的提取能力.2)因?yàn)橹魅ピ敕种Ц雨P(guān)注全局損失,在去除局部損失的同時會去除掉同屬于高頻特征的細(xì)節(jié)信息,所以本文提出了基于預(yù)訓(xùn)練的50層殘差網(wǎng)絡(luò)(Residual Network-50,ResNet-50)[26]的細(xì)節(jié)補(bǔ)償分支,將壓縮視頻中的細(xì)節(jié)特征提取出來補(bǔ)償回增強(qiáng)視頻中,還原出丟失的細(xì)節(jié)信息.在此分支中,由于ResNet-50中的特征豐富且繁雜,本文提出了一個基于壓縮激活機(jī)制的細(xì)節(jié)響應(yīng)塊(Detail Response Block,DRB)將豐富的特征中的細(xì)節(jié)特征標(biāo)注并提取出來,增強(qiáng)分支的細(xì)節(jié)提取能力.

1 基于細(xì)節(jié)還原卷積神經(jīng)網(wǎng)絡(luò)的壓縮視頻增強(qiáng)方法 為了有效地消除壓縮失真,提高壓縮視頻的細(xì)節(jié)視覺質(zhì)量,本文提出了一種基于DRCNN的壓縮視頻質(zhì)量增強(qiáng)方法,DRCNN的結(jié)構(gòu)如圖1所示,由兩個分支組成:主去噪分支和細(xì)節(jié)補(bǔ)償分支.由于大量的損失出現(xiàn)在全局尺度,因此本文提出一個感受野逐漸擴(kuò)大的主去噪分支.在此分支中提出一個多尺度失真特征提取塊以提取出壓縮視頻的多尺度失真特征,然后將壓縮視頻和獲得的失真特征融合提取,最終重建一個高質(zhì)量的去噪視頻.接著,為了恢復(fù)主去噪分支中丟失的細(xì)節(jié)特征,本文還提出一個細(xì)節(jié)補(bǔ)償分支,以進(jìn)一步改善壓縮視頻的細(xì)節(jié).在此分支中,通過使用預(yù)訓(xùn)練的ResNet-50設(shè)計了一個內(nèi)容特征提取器,并采用多個細(xì)節(jié)響應(yīng)塊來關(guān)注壓縮視頻的細(xì)節(jié),從預(yù)訓(xùn)練的ResNet-50的內(nèi)容特征中提取細(xì)節(jié)特征.

DRCNN的輸入是低質(zhì)量的壓縮視頻,而輸出是增強(qiáng)的高質(zhì)量壓縮視頻.為了有效提高壓縮視頻的質(zhì)量,壓縮視頻被送入主去噪分支和細(xì)節(jié)補(bǔ)償分支,分別獲得去噪視頻和細(xì)節(jié)圖.在細(xì)節(jié)圖的幫助下,去噪的視頻被進(jìn)一步增強(qiáng).這個過程可以表示為

1.1 主去噪分支現(xiàn)有基于卷積神經(jīng)網(wǎng)絡(luò)的方法都采用尋找壓縮視頻特征到增強(qiáng)視頻特征的最佳映射來增強(qiáng)視頻,這些方法在增強(qiáng)過程中忽略了視頻中的失真特征,使得網(wǎng)絡(luò)的訓(xùn)練更加困難.為了更好地學(xué)習(xí)失真特征,本文提出了主去噪分支,它采用了殘差學(xué)習(xí)機(jī)制來加速訓(xùn)練過程,將現(xiàn)有方法的學(xué)習(xí)圖像干凈像素特征轉(zhuǎn)化為學(xué)習(xí)更加簡單更容易提取的損失特征,把特征提取過程和重構(gòu)過程當(dāng)作兩個單獨(dú)的進(jìn)程,以更準(zhǔn)確地重建噪聲圖.在特征提取過程中,由于損失的尺度不統(tǒng)一,為了增強(qiáng)多尺度特征提取能力,主去噪分支采用MDFEB來提高對失真區(qū)域內(nèi)不同尺度的失真的提取能力.在重建過程中,主去噪分支利用從前幾層學(xué)到的損失特征來預(yù)測噪聲圖.為了進(jìn)一步提高網(wǎng)絡(luò)的失真學(xué)習(xí)能力,本文使用長連接引入壓縮視頻來指導(dǎo)重建過程.圖2展示了所提出的主去噪分支的整體結(jié)構(gòu).在特征提取階段中,主去噪分支首先采用3×3卷積層將壓縮幀轉(zhuǎn)換為特征,然后將這些特征輸入13個MDFEB進(jìn)行失真特征提取.最后,一個帶有逐元素相加操作的跳連接被用來讓網(wǎng)絡(luò)學(xué)習(xí)和處理殘差信息.

1.2 細(xì)節(jié)補(bǔ)償分支主去噪分支可以有效地去除壓縮視頻的失真,然而,由于失真和細(xì)節(jié)均為高頻信息,壓縮視頻的細(xì)節(jié)信息也很容易被主去噪分支去除.為了恢復(fù)丟失的細(xì)節(jié)信息,本文提出一個細(xì)節(jié)補(bǔ)償分支,以進(jìn)一步提高壓縮視頻的質(zhì)量.所提出的細(xì)節(jié)補(bǔ)償分支利用U型網(wǎng)絡(luò)[29]作為骨干網(wǎng)絡(luò),這種編碼-解碼結(jié)構(gòu)能夠更好地恢復(fù)壓縮視頻中退化的細(xì)節(jié)信息.圖4展示了提出的細(xì)節(jié)補(bǔ)償分支的結(jié)構(gòu),它包括一個使用預(yù)訓(xùn)練ResNet-50的內(nèi)容特征提取器、三個提出的細(xì)節(jié)響應(yīng)塊、三個2倍pixel-shuffle層、一個4倍pixel-shuffle層以及兩個卷積層.首先預(yù)訓(xùn)練的ResNet-50作為內(nèi)容特征提取器提供了從大規(guī)模數(shù)據(jù)集中學(xué)習(xí)到的豐富特征,接著本文采用三個細(xì)節(jié)響應(yīng)塊來進(jìn)一步提取不同感受野的細(xì)節(jié)特征.細(xì)節(jié)補(bǔ)償分支使用pixel-shuffle層對小尺寸的特征圖進(jìn)行上采樣并且不引入冗余信息.最后3×3卷積層被用來來重建細(xì)節(jié)圖.所提出的細(xì)節(jié)補(bǔ)償分支可以被總結(jié)為

2 實(shí)驗(yàn)結(jié)果與分析

2.1 實(shí)驗(yàn)設(shè)置1)數(shù)據(jù)集:本文采用表1所示的37個不同分辨率的視頻序列制作數(shù)據(jù)集,其中21個視頻序列用來建立訓(xùn)練集,其余16個視頻序列用來建立測試集.訓(xùn)練集由4 200張圖像組成,測試集由16個序列的所有幀組成.每個視頻序列由高效視頻編碼測試軟件16.0(High Efficiency Video Coding Test Model 16.0,HM16.0)在四個不同的量化參數(shù)(Quantification Parameters,QP)下進(jìn)行編碼.2)訓(xùn)練設(shè)置:圖像像素塊大小設(shè)置為64×64,跨度為32,批尺寸設(shè)置為16.采用亞當(dāng)(Adam)優(yōu)化器[31]來優(yōu)化模型,學(xué)習(xí)率設(shè)置為0.001,訓(xùn)練過程將在200次迭代后停止.3)評價指標(biāo):為了評價不同方法的客觀性能,峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)被用來衡量每種方法的客觀質(zhì)量,其單位為分貝(dB).Bjntegaard失真率(Bjntegaard-Delta-rate,BD-rate)[32]被用來評價每種方法的失真率性能.

2.2 客觀增強(qiáng)性能的對比表2列出了全幀內(nèi)(ALL Intra,AI)、低延遲(Low Delay,LD)和隨機(jī)訪問(Random Access,RA)編碼結(jié)構(gòu)的ΔPSNR結(jié)果.可以看到,當(dāng)使用AI編碼結(jié)構(gòu)時,VRCNN[9]的PSNR增長范圍為-0.657 dB到0.282 dB,平均為-0.079 dB.RHCNN[12]的PSNR增長范圍為-0.075 dB到0.292 dB,平均0.143 dB.QECNN[13]的PSNR增長范圍為-0.237 dB到0.300 dB,平均0.036 dB.Zhang等[14]的PSNR增長范圍為-0.126 dB到0.326 dB,平均0.113 dB.本文提出的方法的ΔPSNR為0.147 dB到0.514 dB,平均0.266 dB.當(dāng)使用LD編碼結(jié)構(gòu)時,VRCNN[9]的結(jié)果仍是負(fù)增益.RHCNN[12]的的PSNR增長范圍為0.077 dB到0.335 dB,平均0.172 dB.對于QECNN[13]的PSNR增長范圍為-0.097 dB到0.225 dB,平均0.092 dB.對于Zhang等[14]的方法,PSNR增長范圍為0.092 dB到0.301 dB,平均0.173 dB.本文提出的方法的PSNR增長范圍為0.163 dB到0.409 dB,平均0.275 dB,比表現(xiàn)最好的方法高出了0.102 dB.

當(dāng)使用RA編碼結(jié)構(gòu)時,VRCNN[9]的PSNR增長范圍為-0.690 dB到0.062 dB,平均為-0.086 dB.RHCNN[12]的PSNR增長范圍為0.077 dB到0.376 dB,平均為0.184 dB.QECNN[13]的PSNR增長范圍為-0.098 dB到0.306 dB,平均為0.010 dB.Zhang等[14]的方法PSNR增長范圍為0.112 dB到0.400 dB,平均為0.195 dB.本文提出的方法的ΔPSNR從0.193 dB到0.534 dB,平均為0.290 dB.從這些結(jié)果中分析可知,當(dāng)視頻在不同編碼結(jié)構(gòu)下進(jìn)行編碼時,由于QP低時碼率高,視頻中的細(xì)節(jié)信息比較豐富,對比方法由于缺乏細(xì)節(jié)信息和損失信息的辨別能力,在增強(qiáng)過程中易將細(xì)節(jié)和損失共同去除,因此表現(xiàn)不佳.本文方法由于ResNet-50組成的內(nèi)容特征提取器的存在,大量的包含細(xì)節(jié)信息的內(nèi)容特征被提取出來,這些信息提高了本方法增強(qiáng)后視頻的客觀質(zhì)量.

2.3 失真率性能的對比為了比較所提出的方法和有代表性方法之間的失真率性能,表3中列出了每種方法的BD-rate.可以看出,VRCNN[9]的BD-rate節(jié)省范圍為8.313%到-4.630%,平均1.046%.RHCNN[12]的BD-rate節(jié)省范圍為1.836%到-7.932%,平均-2.957%.QECNN[13]的BD-rate節(jié)省范圍為0.820%至-6.250%,平均為-2.249%.Zhang等[14]的的BD-rate節(jié)省范圍為0.922%至-7.340%,平均為-2.985%.與這些壓縮視頻質(zhì)量增強(qiáng)方法相比,本文的方法的BD-rate節(jié)省范圍為-1.869%到-9.529%,平均-4.964%.由表3可以發(fā)現(xiàn),幾種對比方法均有BD-rate負(fù)增益的情況,因此對比方法在不同視頻序列上的增強(qiáng)效果是有波動的,在細(xì)節(jié)豐富的視頻中,這些方法增強(qiáng)性能大大受限.受益于細(xì)節(jié)補(bǔ)償分支提取細(xì)節(jié)信息的能力,本文提出的DRCNN在每個序列上都獲得了穩(wěn)定的增強(qiáng)效果.

2.4 視覺質(zhì)量對比為了比較所提出的DRCNN和最先進(jìn)的視頻質(zhì)量增強(qiáng)方法之間的視覺質(zhì)量增強(qiáng)性能,如圖7所示,本文從五個視頻序列中取出最具代表性的幀做視覺質(zhì)量對比,包括“PeopleOnStreet”、“Cactus”、“BQMall”、“FourPeople”和“BQTerrace”五個視頻序列.對于“PeopleOnStreet”和“Cactus”視頻序列,可以看到由于嚴(yán)重的壓縮失真,磚塊和數(shù)字的邊緣變得十分不清晰,現(xiàn)有的方法如VRCNN[9]、RHCNN[12]、QECNN[13]和Zhang等[14]都難以改善質(zhì)量下降的幀的視覺質(zhì)量.相比之下,本文提出的DRCNN在使用所提出的細(xì)節(jié)補(bǔ)償分支后可以更好地改善細(xì)節(jié)區(qū)域的質(zhì)量.對于 “BQMall”和“FourPeople”序列,許多偽影和模糊出現(xiàn)在視覺質(zhì)量下降的幀中.與其他增強(qiáng)方法相比,本文提出的DRCNN具有更強(qiáng)的偽影去除能力,并取得了更滿意的結(jié)果.此外,壓縮過程會將色調(diào)偏離引入壓縮后視頻幀中,如“BQTerrace”中的放大區(qū)域,由于其學(xué)習(xí)能力有限,傳統(tǒng)的基于卷積神經(jīng)網(wǎng)絡(luò)的方法很難將其去除.與這些方法相比, DRCNN能有效地去除色調(diào)偏離,并顯著改善質(zhì)量下降的幀的視覺質(zhì)量.

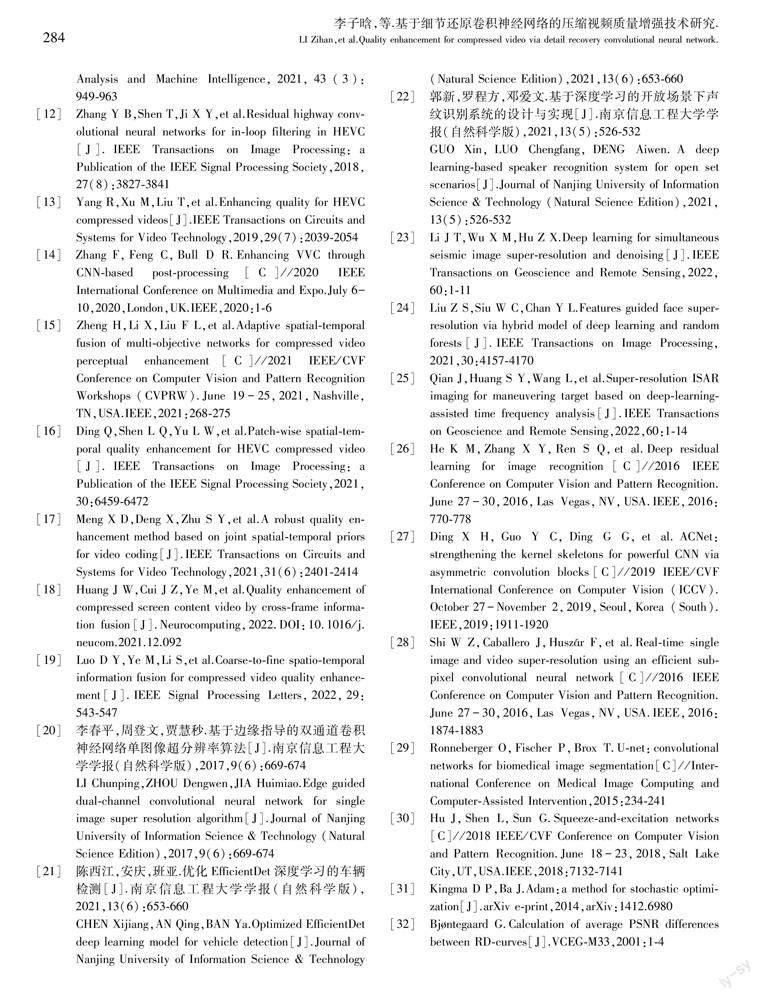

2.5 計算復(fù)雜度的對比為了比較各方法的計算復(fù)雜性,表4列出了一幀的顯卡測試時間,表5給出了顯卡內(nèi)存消耗的結(jié)果.從表4可以看出,VRCNN[9]、RHCNN[12]、QECNN[13]、Zhang等[14]和DRCNN的平均顯卡測試時間分別為0.19、0.27、0.15、1.10和1.18 s.由于VRCNN[9]、RHCNN[12]和QECNN[13]的網(wǎng)絡(luò)層數(shù)較淺,這三種方法的顯卡測試時間少于其他兩種方法,但是,它們?nèi)〉玫馁|(zhì)量提升性能比Zhang等[14]和DRCNN差很多.為了有效提取失真特征并提高降噪能力,Zhang等[14]和DRCNN被設(shè)計為深度神經(jīng)網(wǎng)絡(luò).與Zhang等[14]相比,本文方法實(shí)現(xiàn)了更好的增強(qiáng)性能,并保持了相當(dāng)?shù)娘@卡測試時間.從表5可以發(fā)現(xiàn),VRCNN[9]、RHCNN[12]、QECNN[13]、Zhang等[14]和DRCNN方法的顯卡內(nèi)存消耗分別為2.1、2.5、1.3、3.2和4.1 GB.總的來說,相比于對比方法,本文方法的復(fù)雜度高出一點(diǎn),處理一幀的平均測試時間比對比方法中最高的Zhang等[14]多了0.08 s,顯卡內(nèi)存大小也多了0.9 GB.但是考慮到本文在PSNR和BD-rate上比Zhang等[14]提升了0.117 dB和1.979%,復(fù)雜度微微上升是可以接受的.

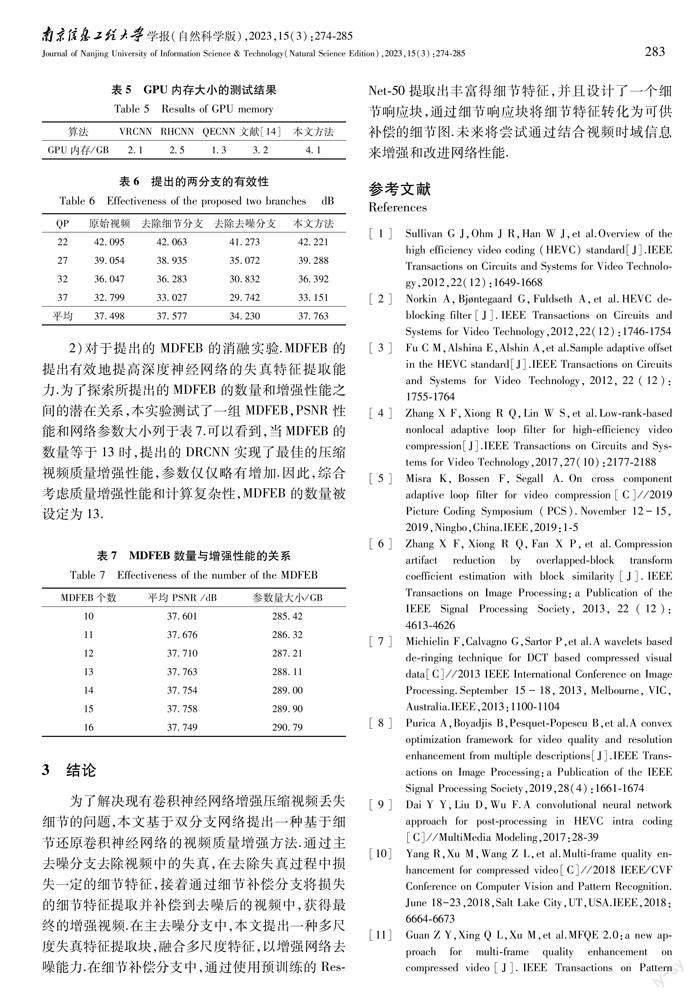

2.6 消融實(shí)驗(yàn)1)對于提出的兩分支的消融實(shí)驗(yàn).DRCNN采用一個主去噪分支和一個細(xì)節(jié)補(bǔ)償分支來有效地消除失真,提高壓縮視頻的質(zhì)量.為了驗(yàn)證這兩個分支的有效性,本文將它們從 DRCNN中分別刪除,在測試集上進(jìn)行消融研究.實(shí)驗(yàn)結(jié)果列于表6,其中“去除去噪分支”表示從DRCNN中刪除了主去噪分支,而“去除細(xì)節(jié)分支”表示從提出網(wǎng)絡(luò)中刪除了細(xì)節(jié)補(bǔ)償分支.可以看出,當(dāng)主去噪分支被移除時,所提出的DRCNN的質(zhì)量增強(qiáng)能力大大降低,平均PSNR下降了3.533 dB.這一結(jié)果證明,主去噪分支可以有效地消除壓縮視頻中的失真,提高DRCNN的增強(qiáng)性能.此外,可以看出,當(dāng)去除細(xì)節(jié)補(bǔ)償分支時,PSNR平均下降了0.186 dB.從這些結(jié)果中可以發(fā)現(xiàn),所提出的主去噪分支和細(xì)節(jié)補(bǔ)償分支大大提高了DRCNN的壓縮視頻增強(qiáng)能力.

2)對于提出的MDFEB的消融實(shí)驗(yàn).MDFEB的提出有效地提高深度神經(jīng)網(wǎng)絡(luò)的失真特征提取能力.為了探索所提出的MDFEB的數(shù)量和增強(qiáng)性能之間的潛在關(guān)系,本實(shí)驗(yàn)測試了一組MDFEB,PSNR性能和網(wǎng)絡(luò)參數(shù)大小列于表7.可以看到,當(dāng)MDFEB的數(shù)量等于13時,提出的DRCNN實(shí)現(xiàn)了最佳的壓縮視頻質(zhì)量增強(qiáng)性能,參數(shù)僅僅略有增加.因此,綜合考慮質(zhì)量增強(qiáng)性能和計算復(fù)雜性,MDFEB的數(shù)量被設(shè)定為13.

3 結(jié)論為了解決現(xiàn)有卷積神經(jīng)網(wǎng)絡(luò)增強(qiáng)壓縮視頻丟失細(xì)節(jié)的問題,本文基于雙分支網(wǎng)絡(luò)提出一種基于細(xì)節(jié)還原卷積神經(jīng)網(wǎng)絡(luò)的視頻質(zhì)量增強(qiáng)方法.通過主去噪分支去除視頻中的失真,在去除失真過程中損失一定的細(xì)節(jié)特征,接著通過細(xì)節(jié)補(bǔ)償分支將損失的細(xì)節(jié)特征提取并補(bǔ)償?shù)饺ピ牒蟮囊曨l中,獲得最終的增強(qiáng)視頻.在主去噪分支中,本文提出一種多尺度失真特征提取塊,融合多尺度特征,以增強(qiáng)網(wǎng)絡(luò)去噪能力.在細(xì)節(jié)補(bǔ)償分支中,通過使用預(yù)訓(xùn)練的ResNet-50提取出豐富得細(xì)節(jié)特征,并且設(shè)計了一個細(xì)節(jié)響應(yīng)塊,通過細(xì)節(jié)響應(yīng)塊將細(xì)節(jié)特征轉(zhuǎn)化為可供補(bǔ)償?shù)募?xì)節(jié)圖.未來將嘗試通過結(jié)合視頻時域信息來增強(qiáng)和改進(jìn)網(wǎng)絡(luò)性能.

參考文獻(xiàn) References

[1]Sullivan G J,Ohm J R,Han W J,et al.Overview of the high efficiency video coding (HEVC) standard[J].IEEE Transactions on Circuits and Systems for Video Technology,2012,22(12):1649-1668

[2] Norkin A,Bjntegaard G,F(xiàn)uldseth A,et al.HEVC deblocking filter[J].IEEE Transactions on Circuits and Systems for Video Technology,2012,22(12):1746-1754

[3] Fu C M,Alshina E,Alshin A,et al.Sample adaptive offset in the HEVC standard[J].IEEE Transactions on Circuits and Systems for Video Technology,2012,22(12):1755-1764

[4] Zhang X F,Xiong R Q,Lin W S,et al.Low-rank-based nonlocal adaptive loop filter for high-efficiency video compression[J].IEEE Transactions on Circuits and Systems for Video Technology,2017,27(10):2177-2188

[5] Misra K,Bossen F,Segall A.On cross component adaptive loop filter for video compression[C]//2019 Picture Coding Symposium (PCS).November 12-15,2019,Ningbo,China.IEEE,2019:1-5

[6] Zhang X F,Xiong R Q,F(xiàn)an X P,et al.Compression artifact reduction by overlapped-block transform coefficient estimation with block similarity[J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2013,22(12):4613-4626

[7] Michielin F,Calvagno G,Sartor P,et al.A wavelets based de-ringing technique for DCT based compressed visual data[C]//2013 IEEE International Conference on Image Processing.September 15-18,2013,Melbourne,VIC,Australia.IEEE,2013:1100-1104

[8] Purica A,Boyadjis B,Pesquet-Popescu B,et al.A convex optimization framework for video quality and resolution enhancement from multiple descriptions[J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2019,28(4):1661-1674

[9] Dai Y Y,Liu D,Wu F.A convolutional neural network approach for post-processing in HEVC intra coding[C]//MultiMedia Modeling,2017:28-39

[10] Yang R,Xu M,Wang Z L,et al.Multi-frame quality enhancement for compressed video[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018:6664-6673

[11] Guan Z Y,Xing Q L,Xu M,et al.MFQE 2.0:a new approach for multi-frame quality enhancement on compressed video[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2021,43(3):949-963

[12] Zhang Y B,Shen T,Ji X Y,et al.Residual highway convolutional neural networks for in-loop filtering in HEVC[J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2018,27(8):3827-3841

[13] Yang R,Xu M,Liu T,et al.Enhancing quality for HEVC compressed videos[J].IEEE Transactions on Circuits and Systems for Video Technology,2019,29(7):2039-2054

[14] Zhang F,F(xiàn)eng C,Bull D R.Enhancing VVC through CNN-based post-processing[C]//2020 IEEE International Conference on Multimedia and Expo.July 6-10,2020,London,UK.IEEE,2020:1-6

[15] Zheng H,Li X,Liu F L,et al.Adaptive spatial-temporal fusion of multi-objective networks for compressed video perceptual enhancement[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW).June 19-25,2021,Nashville,TN,USA.IEEE,2021:268-275

[16] Ding Q,Shen L Q,Yu L W,et al.Patch-wise spatial-temporal quality enhancement for HEVC compressed video[J].IEEE Transactions on Image Processing:a Publication of the IEEE Signal Processing Society,2021,30:6459-6472

[17] Meng X D,Deng X,Zhu S Y,et al.A robust quality enhancement method based on joint spatial-temporal priors for video coding[J].IEEE Transactions on Circuits and Systems for Video Technology,2021,31(6):2401-2414

[18] Huang J W,Cui J Z,Ye M,et al.Quality enhancement of compressed screen content video by cross-frame information fusion[J].Neurocomputing,2022.DOI:10.1016/j.neucom.2021.12.092

[19] Luo D Y,Ye M,Li S,et al.Coarse-to-fine spatio-temporal information fusion for compressed video quality enhancement[J].IEEE Signal Processing Letters,2022,29:543-547

[20] 李春平,周登文,賈慧秒.基于邊緣指導(dǎo)的雙通道卷積神經(jīng)網(wǎng)絡(luò)單圖像超分辨率算法[J].南京信息工程大學(xué)學(xué)報(自然科學(xué)版),2017,9(6):669-674

LI Chunping,ZHOU Dengwen,JIA Huimiao.Edge guided dual-channel convolutional neural network for single image super resolution algorithm[J].Journal of Nanjing University of Information Science & Technology (Natural Science Edition),2017,9(6):669-674

[21] 陳西江,安慶,班亞.優(yōu)化EfficientDet深度學(xué)習(xí)的車輛檢測[J].南京信息工程大學(xué)學(xué)報(自然科學(xué)版),2021,13(6):653-660

CHEN Xijiang,AN Qing,BAN Ya.Optimized EfficientDet deep learning model for vehicle detection[J].Journal of Nanjing University of Information Science & Technology (Natural Science Edition),2021,13(6):653-660

[22] 郭新,羅程方,鄧愛文.基于深度學(xué)習(xí)的開放場景下聲紋識別系統(tǒng)的設(shè)計與實(shí)現(xiàn)[J].南京信息工程大學(xué)學(xué)報(自然科學(xué)版),2021,13(5):526-532

GUO Xin,LUO Chengfang,DENG Aiwen.A deep learning-based speaker recognition system for open set scenarios[J].Journal of Nanjing University of Information Science & Technology (Natural Science Edition),2021,13(5):526-532

[23] Li J T,Wu X M,Hu Z X.Deep learning for simultaneous seismic image super-resolution and denoising[J].IEEE Transactions on Geoscience and Remote Sensing,2022,60:1-11

[24] Liu Z S,Siu W C,Chan Y L.Features guided face super-resolution via hybrid model of deep learning and random forests[J].IEEE Transactions on Image Processing,2021,30:4157-4170

[25] Qian J,Huang S Y,Wang L,et al.Super-resolution ISAR imaging for maneuvering target based on deep-learning-assisted time frequency analysis[J].IEEE Transactions on Geoscience and Remote Sensing,2022,60:1-14

[26] He K M,Zhang X Y,Ren S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.June 27-30,2016,Las Vegas,NV,USA.IEEE,2016:770-778

[27] Ding X H,Guo Y C,Ding G G,et al.ACNet:strengthening the kernel skeletons for powerful CNN via asymmetric convolution blocks[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).October 27-November 2,2019,Seoul,Korea (South).IEEE,2019:1911-1920

[28] Shi W Z,Caballero J,Huszár F,et al.Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.June 27-30,2016,Las Vegas,NV,USA.IEEE,2016:1874-1883

[29] Ronneberger O,F(xiàn)ischer P,Brox T.U-net:convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention,2015:234-241

[30] Hu J,Shen L,Sun G.Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018:7132-7141

[31] Kingma D P,Ba J.Adam:a method for stochastic optimization[J].arXiv e-print,2014,arXiv:1412.6980

[32] Bjntegaard G.Calculation of average PSNR differences between RD-curves[J].VCEG-M33,2001:1-4

Quality enhancement for compressed video via detail recovery convolutional neural network

LI Zihan SHAO Xiao ZHANG Peiyun

1School of Computer Science,Nanjing University of Information Science & Technology,Nanjing 210044

Abstract Video coding has effectively addressed the too large data volume of raw videos,however,the achieved compression efficiency comes at the cost of video quality degradation.To improve the visual quality of compressed video,a Detail Recovery Convolutional Neural Network (DRCNN)-based video quality enhancement method is proposed,which consists of a main denoising branch and a detail compensation branch.To effectively extract and eliminate the compression distortions,a Multi-scale Distortion Feature Extraction Block (MDFEB) is added to the main denoising branch,which can pay attention to the distorted areas in the compressed video,and improve the distortion feature learning ability of the proposed DRCNN.Furthermore,to enrich the details in the compressed video,the detail compensation branch adopts a content feature extractor composed of a pre-trained ResNet-50 to provide abundant content features,such as salient objects,shapes,and details,and then involves a Detail Response Block (DRB) to efficiently extract the detailed features from the content features.Extensive experimental results show that the proposed DRCNN achieves the best performance in enhancing the compressed video quality as compared with four representative methods.

Key words video quality enhancement;deep learning;video post-processing;multi-scale feature extraction