基于元學習的雙目深度估計在線適應算法

張振宇 楊 健

深度估計是視覺場景理解中的基礎性問題,并且越來越多地受到計算機視覺和機器人研究領域的關注.近年來,一些基于深度學習的RGB 自動深度估計方法陸續提出,取得了令人印象深刻的效果[1-7].在這些研究工作中,深度神經網絡模型的訓練需要依賴深度真值作為監督信息,可供訓練的深度真值越多則效果越好.然而,在現實場景中進行數據收集需要對應的硬件平臺和設備(例如汽車和雷達),且使其在不同環境中工作相當長的時間.因此,數據收集通常需要昂貴的財力和時間開銷,這制約了以上監督學習方法的實際應用.為了避免開銷較大的數據收集和人工標注過程,一些自監督(也稱為無監督)深度估計方法相繼提出[8-11].值得一提的是,盡管沒有精確的深度真值,這些方法仍能通過圖像重構誤差訓練模型,獲得與監督學習方法接近的結果.

盡管上文提到的自監督方法獲得了相當好的結果,其在現實場景中的使用仍然受到制約.原因在于這些方法均在封閉世界假設下進行設計和評估,這意味著訓練和測試數據處于同一個數據集,或者二者的環境表觀差異很小.當模型在全新的場景中工作時,由于數據域轉移的影響,方法的結果將大打折扣.因此,為了增強方法的實際應用效果,用于深度估計的深度神經網絡模型需要考量開放世界的設定,即可用的視覺數據是在連續變化的環境中被采集的數據流.以自動駕駛場景為例,模型需要連續適應于變化的環境(如城市、鄉村和高速公路場景等)以及光線場景(如黑夜、黃昏和白晝等).也就是說,深度神經網絡模型需要具有在線適應的能力.

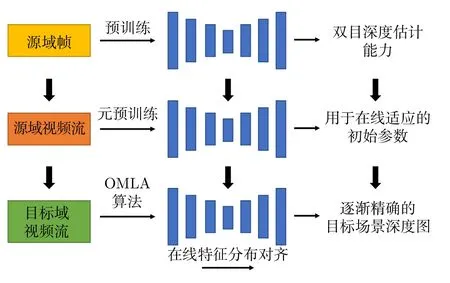

根據以上的分析和動機,本文提出了一種基于元學習的雙目深度估計方法,用于需要快速在線適應的開放世界場景.方法的框架在圖1 中展示.首先,一種新的在線元學習適應算法(Online metalearning with adaptation,OMLA)得以提出,用于模型的快速在線學習.具體地,為了處理源域數據(即訓練數據)和目標視頻數據之間的域轉移問題,模型通過調整源域和目標域的批歸一化(Batch normalization,BN)層統計量,使域間特征分布對齊.該方法受啟發于文獻[12-13],本文對其進行改進,使該方法適用于在線學習場景.然后,特征對齊過程與元學習算法相結合,利用先前時刻的模型反饋選擇能夠快速適應未來場景的網絡超參數.此外,本文提出了一種新的基于元學習的預訓練方法(元預訓練).具體地,在使用OMLA 算法進行一段視頻的在線適應過程后,模型評估其在未來幀上的表現,并以此為反饋更新初始參數.由此,模型獲得了適用于OMLA 算法進行快速在線學習的初始參數.

圖1 本文提出的基于元學習的深度估計在線適應算法框架Fig.1 The proposed meta-learning framework for online stereo adaptation

本文的主要貢獻總結如下: 1) 提出了一種新的基于元學習的在線適應算法,用于在線視頻流的雙目深度估計.該方法與特征對齊過程相輔相成: 元學習算法有助于更新特征對齊動量以提升模型的適應能力;特征對齊則更好地支持元學習算法進行優化過程的快速收斂.2) 提出了一種基于元學習的預訓練方法,利用OMLA 算法使模型獲得適用于快速在線學習和收斂的參數以及特征對齊動量.3) 在KITTI 數據集[14]上的實驗表明,本文提出的OMLA 算法與預訓練方法均有助于在線深度估計效果的提升,其效果超越了當前最佳的在線深度估計適應算法[15].

1 相關工作

1.1 深度估計

隨著深度卷積神經網絡的發展,近年來涌現了許多基于監督學習的深度估計方法[1-4,16-17],這些方法需要依賴深度真值訓練網絡模型.一些大規模數據集,例如NYU[18]、KITTI[14,19]等為深度估計任務提供了支持,一些合成數據庫的提出(例如Synthia[20])使得深度估計的遷移學習成為可能.

為了避免耗費較高的數據收集和標注過程,自監督的深度估計方法[8-10]得以陸續提出.例如,Godard 等[9]利用雙目一致性損失函數使自監督訓練成為可能.其他相關工作主要包括結合相機位姿估計的方法[21]、利用對抗學習的方法[10,22]、基于視覺里程計的方法[17]以及結合圖像超分辨的技術[11].最新的研究主要關注高效深度估計網絡的設計[6]和雷達點云的補全[7].然而,以上方法僅適用于封閉世界設定下的深度估計,缺少對開放世界問題的研究.

1.2 域適應問題

域適應是經典的機器學習問題,近年來逐漸為計算機視覺和機器人領域所關注[23].近期基于深度學習的方法主要通過以下策略減輕域轉移造成的影響: 分布對齊損失函數[24-25]、對抗生成網絡[26-28]和域對齊層[13,29-31].在機器人領域,域適應方法主要用于機器人抓握[12,27]、可行駛區域分割[31]以及基于目標定位的機器人控制問題[32-33].

與絕大多數先前工作采用離線設定(即源域與目標域數據在訓練過程中是可以全部獲取的)不同的是,近期一些域適應算法開始研究在線學習設定下的問題,即目標域數據以序列化形式獲得且其分布不斷改變,相關工作如文獻[12,30-31].一些工作研究了針對深度估計問題的域適應方法[32-35].Tonioni 等[15]首先利用在線數據流進行了相關嘗試.文獻[35]利用元學習方法增強了深度估計模型的在線收斂速度.然而,以上兩種在線深度估計方法并未清晰地對域轉移進行建模,也未使用任何策略以減弱源域和目標域數據差別帶來的影響.與其不同的是,本文方法具體地討論了在線深度估計中的域轉移問題,并給出了合理且新穎的解決方案.

1.3 元學習算法

元學習的目標是使模型利用先前學習的經驗,學會如何在未來的問題中進行高質量學習.在文獻[36-39] 中,元學習被用于獲得在新數據域和類別上的快速泛化能力.在遷移學習應用中,文獻[38]利用元學習方法,使主網絡模型引導學生網絡合理地微調參數.Park 等在文獻[39] 中提出了一種離線元學習方法,使網絡獲得較好的在線跟蹤能力.本文方法受啟發于文獻[39],與其不同的是,本文方法提出了適用于在線場景的元學習方法,在引導模型獲得合理初值的同時,使模型在線學習超參數以加速收斂.

2 基于元學習的深度估計在線適應方法

本節詳細介紹了本文提出的基于元學習的在線深度估計與適應方法.為方便形式化討論,假定源域是由N個雙目視頻序列組成的數據集,這些數據集使用同一個經標定后的雙目相機采集.首先,使用該源域數據集訓練參數為θ的神經網絡模型 Φ,使模型獲得雙目深度估計能力.然后,模型需要在目標域視頻VT上進行預測,該視頻由不同的雙目相機在新的環境中采集,且視頻幀為數據流形式.本文方法的目標是在線調整網絡參數θ(即在線適應),使其在目標域連續變化的視頻中逐漸獲得更精確的場景深度圖.

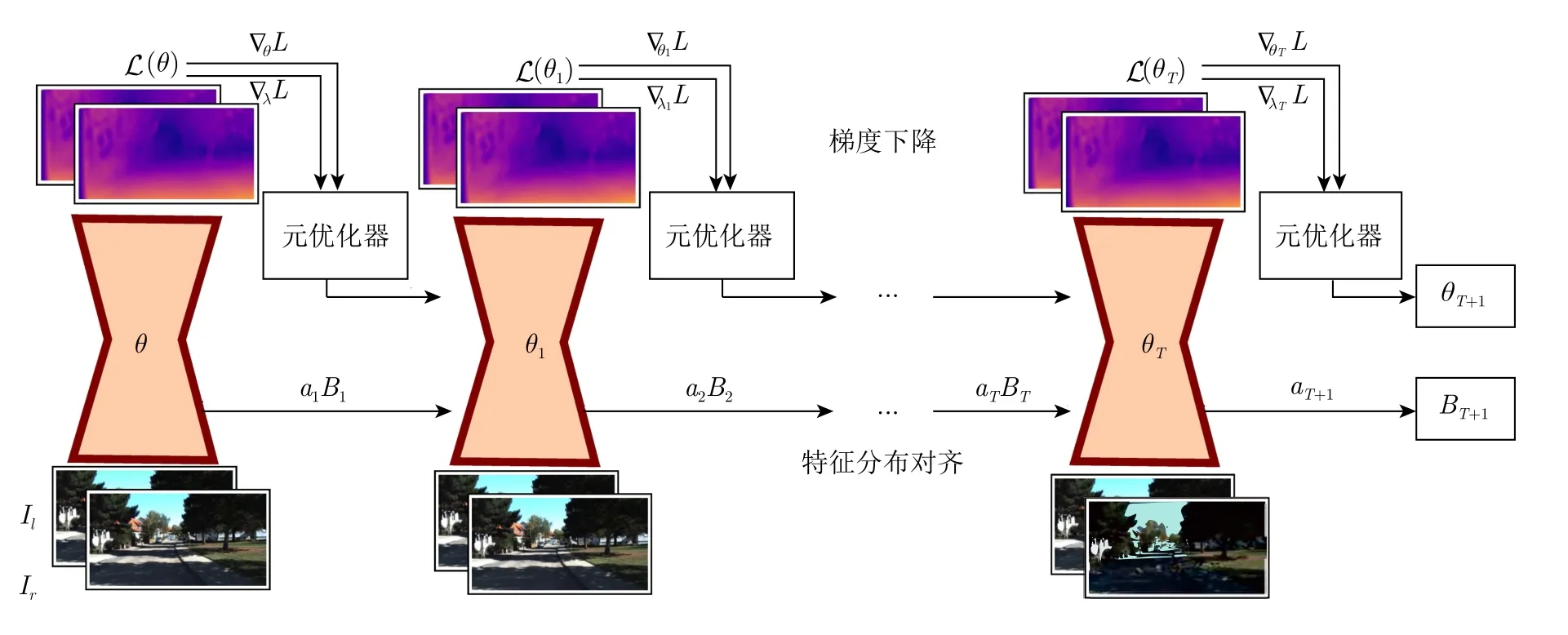

一種基本的用于在線適應的方法為: 在當前時刻計算當前幀的自監督損失,并通過梯度下降更新整個網絡參數.盡管這種方法非常簡潔,但其存在明顯的缺點,如其對于域轉移是非常敏感的,且僅關注于當前幀的做法可能會對模型更新過程帶來不良影響,例如場景突變導致的模型漂移會減緩收斂速度.為了避免這些問題,本節提出了兩種互補策略: 特征分布對齊和在線元學習適應算法(見圖2).具體地,使用批歸一化層的統計量對域轉移進行建模,并以此為基礎進行源域和目標域的特征分布對齊(見第2.1 節).該過程在前饋中的網絡淺層進行,僅需要非常有限的計算開銷.此外,使用基于元學習的優化器更新模型,使模型獲得對未來幀的快速收斂能力(見第2.2 節).由此,在在線適應過程中,特征對齊能夠應對不同域數據的表觀特征差異,元學習優化器則可處理高階表征的轉移問題.此外,基于元學習的預訓練策略被用于獲得模型初始參數θ0,使模型獲得針對數據流的快速適應能力(見第2.3 節).訓練和更新模型使用的自監督深度估計損失函數在第2.4 節中介紹.

圖2 本文提出的在線元學習適應方法Fig.2 The proposed online meta-learning with adaptation (OMLA) method

2.1 在線特征分布對齊的域適應算法

考慮一個包含批歸一化層的神經網絡模型 Φ,根據文獻[12-13,30]的研究,域適應可以通過更新BN 層統計量實現.在本文問題設定下,模型無法獲得全部目標域數據以計算真實的目標域統計量,但是由于數據流的存在,可以隨時間漸進地更新統計量使其逼近真實值.受此啟發,本文提出一種針對BN 統計量的在線更新策略,通過目標域數據流逐漸更新BN 統計量,使目標域模型特征分布逐漸對齊.與文獻[13,30] 的封閉世界方法不同的是,本文方法無需目標域的全部數據,適用于數據流可用的開放世界問題.為簡潔起見,此處僅討論單個BN 層的情況,但相關操作可部署至網絡任意BN 層.首先,模型在源域S進行訓練后,可以獲得對應的BN 層統計量Bs(μs,).然后,模型按照以下過程在目標域視頻流中更新統計量.在t0時刻,將統計量初始化BoBs.在t時刻,將先前時刻的BN 統計量Bt-1(μt-1,)對齊至Bt.假設特征向量由m個樣本{x1,···,xm}得到,則首先計算當前時刻BN 統計量的觀測值

給定動量參數atR,以及t-1 時刻更新后的統計量Bt-1(μt-1,),則t時刻更新后的統計量為

該更新后的統計量更接近當前場景統計量的真實值.對該BN 層給定輸入x,則此時輸出特征為

其中,γ和β為BN 層仿射變換參數,?R 為極小常量以保持數值穩定.事實上,動量at對特征分布對齊至關重要,其決定了該BN 層適應于當前幀的程度.因此,與文獻[12]中手動設定方法不同的是,本文采用元學習方法自動地獲得合適的動量at值,使其更好地引導BN 統計量更新和特征分布對齊.為簡潔起見,在下文中,at表示所有BN 層動量的組合.

2.2 在線元學習適應算法

本節介紹所提出的在線元學習適應算法.假設目標域雙目視頻序列為V其長度為T,其中,It為t時刻圖像對.當模型在視頻V上進行在線適應時,使用算法1 進行參數更新.

算法1.在線元學習適應算法

算法1 的動機在于: 對每個時刻t,網絡自適應學習并獲得用以更新參數的學習率.對于算法初始化,首先定義網絡參數θ0,BN 統計量B0,網絡參數的初始學習率λ0,以及元學習率λ*.對每個網絡參數均設定對應的學習率,因此,λ0和λ*與網絡參數θ維度相同.第3 行表示在t時刻,給定當前網絡參數θt,輸入圖像對It,則預測的深度圖為Dt(dr,dl)Φ((θt,at,Bt),It).此處dl和dr分別定義左圖像與右圖像對應的深度圖.在前饋過程中,算法使用第2.1 節中描述的特征分布對齊算法,動量為at.統計量Bt+1儲存至下一時刻使用.第4 行表示預測的深度圖由損失函數L(Dt,It) 進行評估.注意到學習率λt-1為t時刻損失Lt的參數,因此,在t時刻前饋完成后,通過損失Lt求解針對λt-1的梯度,并以元學習率λ*進行梯度下降即可獲得針對t時刻用于更新參數的學習率λt.以上過程在第6 行表示.由此,算法基于上一時刻的網絡參數學習率λt-1和當前時刻損失Lt,得到了更適合于當前時刻場景的λt用于參數更新.最后,在第7 行和第8 行,算法基于λt對網絡參數θt和動量at進行梯度下降更新.通過該算法,每一時刻當新的場景輸入模型后,優化器以先前時刻學習率為經驗,以當前時刻的自監督損失為引導獲得適用于當前時刻的參數學習率,使網絡中每個參數均得到合理更新,幫助模型快速適應于當前場景.在OMLA 過程結束后,模型獲得θT+1,aT+1,BT+1和λT.

2.3 基于元學習的模型預訓練方法

算法2.基于元學習的模型預訓練方法

2.4 深度估計損失函數

本節介紹在算法1和算法2 中使用的自監督深度估計損失函數.與文獻[9] 相同的是,模型以雙目圖像Il,Ir為輸入并獲得對應的視差圖dl,dr.使用扭轉操作fw,通過視差圖dl從右圖像重構左圖像:

對稱地,可用相同的方法從左圖像獲得右圖像的重構結果.計算兩個重構圖像與原圖像的誤差可以反映深度預測的效果.最終的損失函數由L1重構誤差和基于結構相似性(Structural similarity index,SSIM)的自重構誤差LSSIM(參見文獻[9])組成:

使用上述損失函數進行訓練,模型能夠無監督地獲得深度估計能力,進行在線適應過程時也無需深度真值.

3 相關實驗

3.1 評估方法和標準

1) 在線適應效果的評估方法.在線學習或適應過程中,視頻幀被序列化地輸入模型.對每個視頻幀,模型均進行深度估計和參數更新.需要強調的是,在實驗中為了合理地評估模型效果,在模型獲得預測結果后立即進行評估,然后進行參數更新.在整個視頻輸入完畢后,計算針對該視頻的平均效果以評估模型在該視頻上的整體表現,同時計算最后20% 視頻幀的平均效果以評估模型在最后階段是否已經較好地收斂.

2) 評估準則.本文采用與文獻[1,9,40]相同的評估準則.設P為測試視頻中具有深度真值的像素點總數,di分別為在像素i處的預測結果和深度真值,則評估準則如下:

3.2 數據庫與部署細節

本文實驗以包含視頻序列的自動駕駛合成數據庫為源域數據庫,在該數據庫上進行預訓練.以現實駕駛場景為目標域數據庫,在該數據庫上進行在線適應和評估.所使用的數據庫如下:

1) Synthia[20]為一個城市駕駛場景的合成數據庫.其包含5 個不同場景和季節的雙目視頻流.本文使用春季場景中模擬汽車以前置攝像頭記錄的視頻流,共包含4 000 對雙目圖像,并在該數據上進行預訓練過程.

2) Scene Flow Driving[41]為一個駕駛場景的合成視頻數據庫.其包含不同的相機設定、車速和行駛方向.本文選擇汽車前進場景中所有的視頻數據,共2 000 對雙目圖像.

3) KITTI[14]為現實行車場景數據庫.本文選擇文獻[1] 提供的子集(簡稱Eigen 子集)為目標域數據.該子集包含32 個不同的訓練場景以及28 個不同的測試場景.實驗中以28 個測試視頻進行在線適應和評估.

本文以Pytorch[42]平臺部署方法,以一塊Nividia P40 GPU 進行訓練和測試.在實驗中,每個網絡模型均在卷積層后包含BN 層[43],以進行特征分布對齊.在合成數據集上的預訓練過程中,首先以10-4為學習率進行100 個周期的訓練,然后利用算法2 進行10 個周期的元預訓練過程.此處設定λ10-4,λmeta10-5,K8,視頻長度T8,t′5.在目標視頻的在線適應過程中,使用OMLA 算法(即算法1),元學習率設置為λ*10-7,特征分布對齊方法僅在編碼網絡的BN 層中進行.所有的訓練和測試過程使用Adam 優化器[44].

3.3 實驗結果與分析

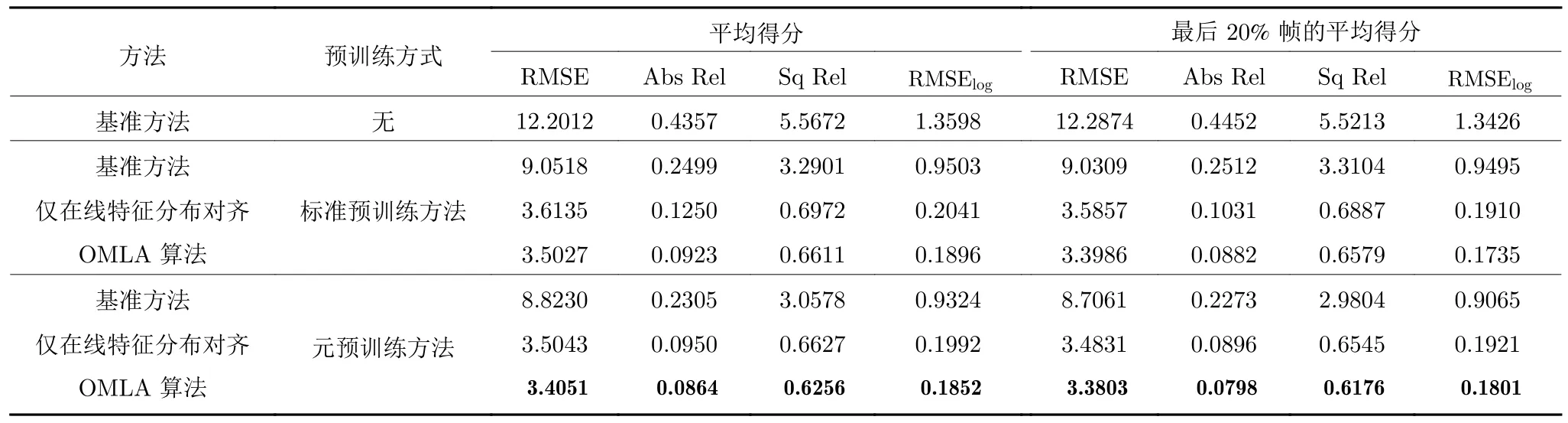

3.3.1 算法消融實驗

為了驗證本文算法的有效性,本節選擇在常用的雙目深度估計框架(在文獻[9]中提出)上進行算法消融實驗.值得一提的是,盡管該框架最初是作為單目深度估計方法而提出的,但隨后在文獻[9-10]中成功用于雙目深度估計.除特別說明,所有模型均在Synthia 數據集上進行預訓練,并且在Eigen子集的測試集視頻上進行在線適應和評估.每個視頻序列被單獨評估效果,即均從Synthia 數據集預訓練得到的初始網絡參數開始在線適應過程.最終的效果得分為所有視頻幀的平均得分.

相關的實驗結果在表1 中展示.其中,基準方法表示僅使用一般梯度下降法的在線適應模型,在線特征分布對齊表示僅使用第2.1 節中方法,且采用基準方法進行在線適應的模型.標準預訓練方法表示不使用第2.3 節中元預訓練方法,僅采用一般訓練方法的模型.首先可以觀察到,不使用預訓練過程的模型難以直接在目標域視頻流上取得令人滿意的效果,而使用基準方法對效果的提升也相當有限.這證明了僅在源域訓練時,或者數據間存在域轉移時會導致算法效果的顯著下降.當模型使用在線特征分布對齊方法后,其效果有明顯提升,這表明其能夠較好地處理在線適應過程中的域轉移問題.使用OMLA 算法使結果進一步提升.同時,使用元預訓練方法的模型,其在線適應效果均好于使用標準預訓練方法的模型.這些結果證明了本文元學習算法的有效性.

表1 KITTI Eigen 測試集的算法消融實驗 (僅評估 50 m 之內的深度估計效果)Table 1 Ablation study on KITTI Eigen test set (the results are evaluated within 50 m)

3.3.2 不同網絡模型和數據庫的實驗

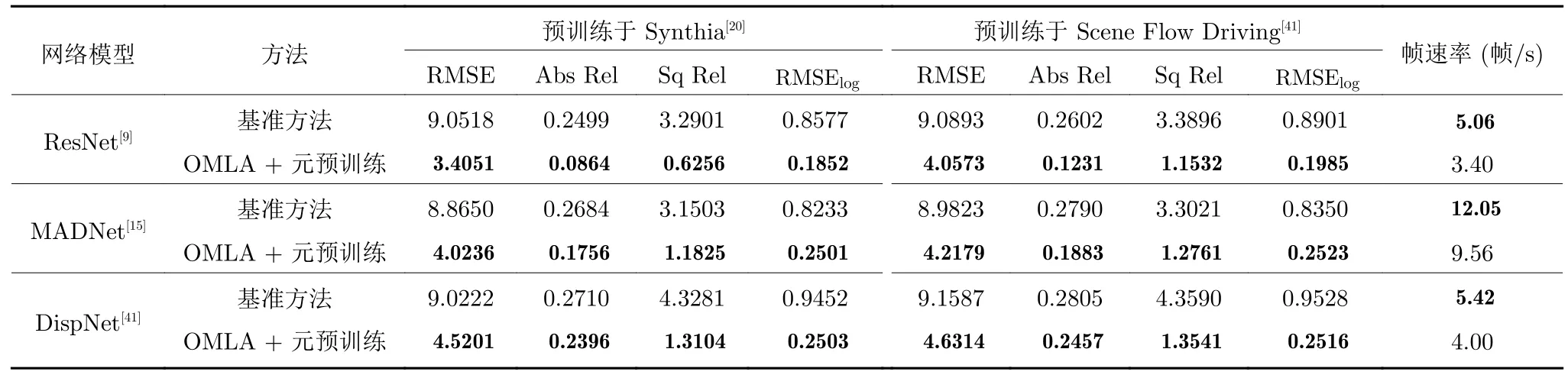

為了進一步驗證本文方法的有效性,本節首先在3 種網絡框架下進行對比實驗,分別為: DispNet[41],MADNet[15]和ResNet[9].實驗主要比較了基準方法和OMLA+元預訓練算法的效果,其中基準方法在源域上進行標準預訓練過程.同時,為了驗證本文方法在不同數據庫上的普適性,本節分別在Synthia和Scene Flow Driving 數據庫上進行預訓練以比較效果.相關實驗結果在表2 中展示.可以看到,在每個網絡模型中,OMLA 算法均取得了明顯的提升.這證明了本文方法在小型網絡(如DispNet和MADNet)中仍能取得良好效果.在兩個數據庫上,OMLA 算法均帶來了提升,證明了其在數據庫間的普適性.表2 中同時比較了算法的運行時間,以幀速率 (幀/s)為指標.可以看到,OMLA 算法由于需要額外的梯度回傳過程,因此相比于基準方法,其幀速率降低了大約20%.然而,考慮到取得的效果提升,該運行時間是可以接受的.

表2 不同網絡模型和數據庫上的結果對比Table 2 Comparison on different network architectures and datasets

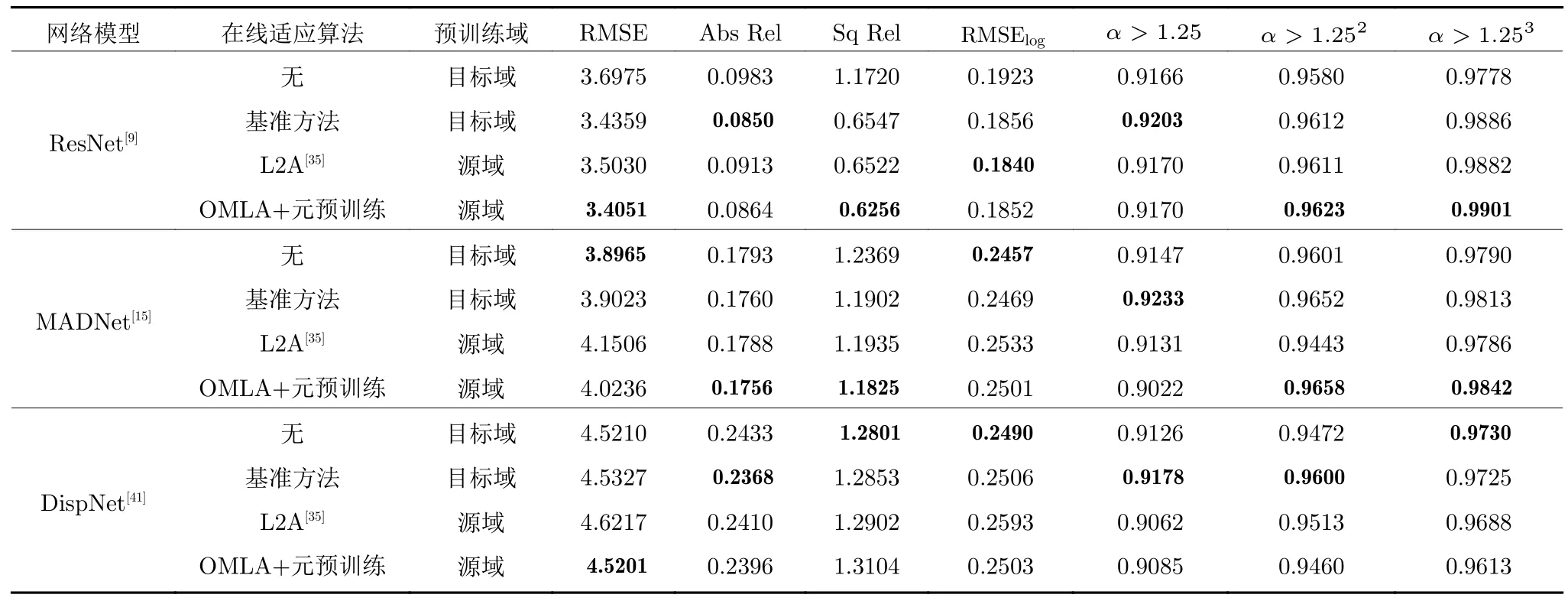

3.3.3與理想模型和當前最佳方法的比較

本部分通過實驗比較本文提出的算法與理想模型(即利用目標域數據訓練的模型)的在線適應效果.實驗中的網絡模型均為以ResNet 構建的模型[9].為訓練理想模型,首先將模型在KITTI Eigen訓練子集上進行預訓練.這樣一來,當模型用于目標域數據,即KITTI Eigen 測試子集時,不會受到域轉移問題的影響.對于理想模型的分析,采用了兩種做法: 1)在目標域上不進行在線適應和模型更新;2)在目標域以基準方法進行在線適應和模型更新.同時,實驗比較了L2A 算法[35],該算法為當前雙目深度估計領域最佳的在線適應方法.相關結果在表3中展示,除OMLA+元預訓練方法外,其余模型均采用標準預訓練方法.可以看到,當模型在目標域進行預訓練后,基準方法無法增強在線適應的效果.進一步地,相比于在目標域預訓練的理想模型,盡管存在域轉移問題,OMLA 算法獲得了有競爭力的在線適應效果.相比于L2A 算法,盡管其使用基準方法進行在線適應,幀速率略高于OMLA算法,但OMLA 算法的準確度較之獲得了明顯提升,這證明了處理在線適應過程中域轉移問題的重要性,也進一步驗證了本文方法的效果.以上結果表明,盡管模型在訓練過程中從未接觸真實世界數據,其仍然可以利用本文的在線適應方法獲得針對目標場景的快速收斂能力,并逐漸預測精準的場景深度圖.

表3與理想模型和當前最優方法的比較 (僅比較實際深度值小于50 m 的像素點)Table 3 Comparison with ideal models and state-of-the-art method (Results are only evaluated within 50 m)

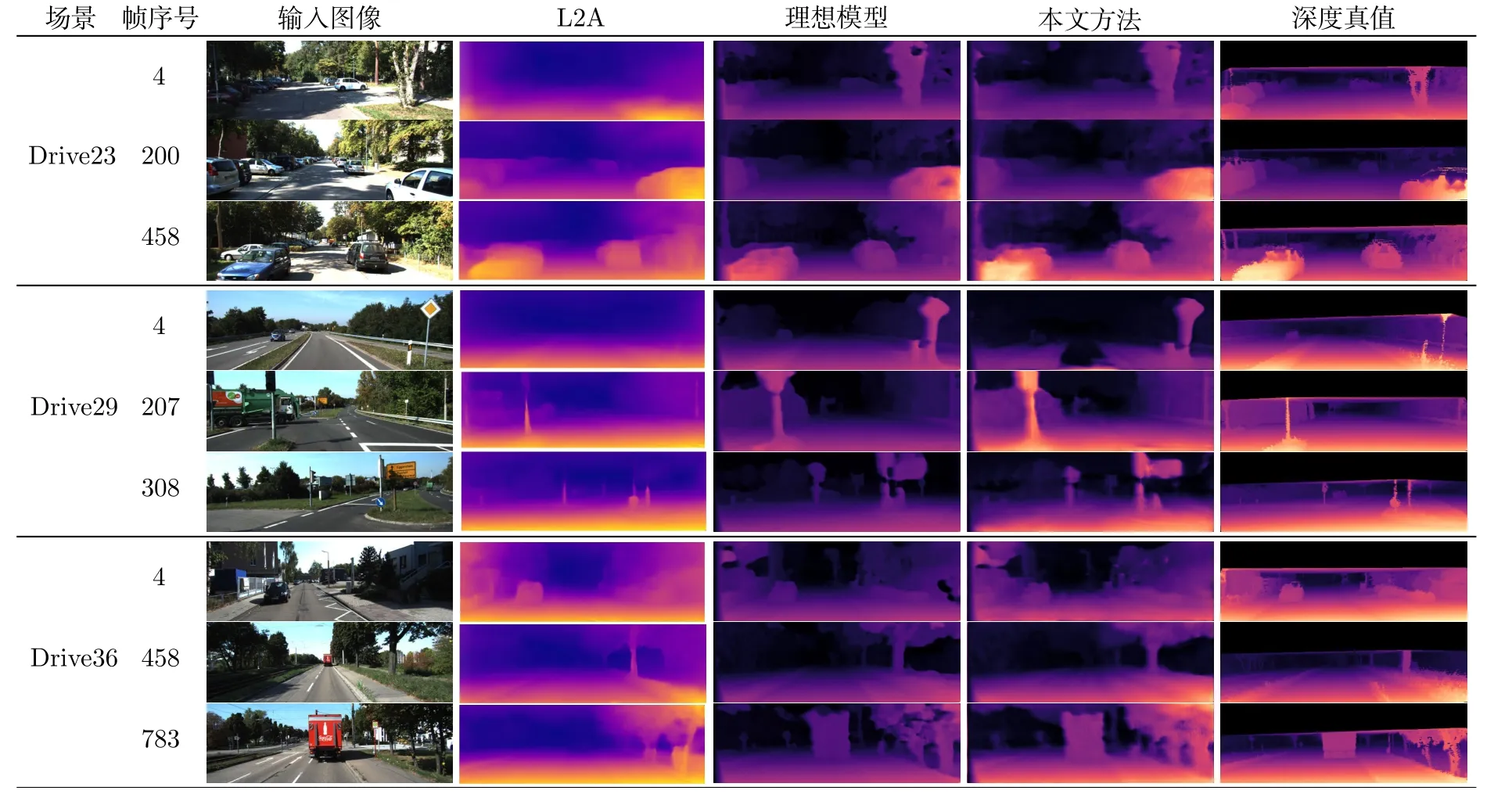

為了進一步分析本文方法,圖3 展示了不同模型的深度估計視覺效果.為了評估不同模型的在線適應效果隨時間的變化,此處展示了視頻初始、中段和末段時刻的深度估計效果.可以看到,理想模型在3 個時期的效果均是良好的,這是由于理想模型在目標域進行訓練,因此不存在域轉移問題,模型的在線適應效果可以得到保證.L2A 算法也取得了不錯的效果,但其問題也較為明顯,例如在初始階段無法預測出道路樹木、交通標志桿的深度,在中段和后段依然存在大目標(如大型標志牌、大貨車)的深度不準確、丟失等問題.相比之下,本文方法在視頻初期預測效果有限,但在中段和末段幀上的表現較好,接近理想模型和深度真值.這是由于在視頻開始階段,模型仍然受到場景差異的影響而難以獲得準確的預測結果.當進行一段時間的在線適應后,本文方法使模型較好地收斂至當前視頻場景,因而預測效果獲得了明顯提升.以上的視覺效果展示較好地說明了本文方法對模型在線適應效果的提升.

圖3 在KITTI Eigen 測試集中3 個不同視頻序列上的效果 (為了展示模型的在線適應效果隨時間的變化,此處展示了視頻初始,中段和末段時刻的深度估計效果)Fig.3 Performance on three different videos of KITTI Eigen test (We illustrated predictions of initial,medium,and last frames)

4 結束語

本文研究了深度估計模型的在線適應問題,并提出了一種新的在線元學習適應算法OMLA.該算法適用于需要深度估計網絡模型快速收斂和適應于目標視頻流的在線序列化學習場景.在公開數據集上的大量實驗表明,相對于一般的梯度下降算法,本文方法較好地處理了域轉移問題,并通過元學習方法充分利用每一時刻的學習反饋,有助于提升深度估計模型的在線適應效果.與當前最好的方法相比,本文方法取得了明顯提升;與理想模型相比,本文方法獲得了接近的并有競爭力的效果.