基于改進(jìn)GhostNet的輕量級(jí)手勢(shì)圖像識(shí)別方法

田秋紅 孫文軒 章立早 施之翔 潘豪 吳佳璐

摘 要: 卷積神經(jīng)網(wǎng)絡(luò)應(yīng)用于復(fù)雜背景的手勢(shì)圖像識(shí)別時(shí),存在深層模型參數(shù)量大、計(jì)算成本高、輕量級(jí)模型準(zhǔn)確率低等問(wèn)題,針對(duì)這些問(wèn)題提出了一種基于改進(jìn)GhostNet的輕量級(jí)手勢(shì)圖像識(shí)別方法。首先,在Ghost模塊中添加通道混洗操作,建立CS-Ghost模塊以提取手勢(shì)圖像中的手勢(shì)特征;然后,選用SMU(Smoothing maximum unit)激活函數(shù)優(yōu)化模型在反向傳播中的學(xué)習(xí)能力;最后,使用注意力機(jī)制中的輕量級(jí)通道注意力模塊ECA去除特征中的噪聲信息。該方法在ASL和NUS-Ⅱ數(shù)據(jù)集上的實(shí)驗(yàn)平均準(zhǔn)確率分別為98.82%和99.36%;在OUHANDS數(shù)據(jù)集上的實(shí)驗(yàn)平均準(zhǔn)確率為97.98%,參數(shù)量為1.2 Mi,F(xiàn)LOPs為0.29 Gi。實(shí)驗(yàn)結(jié)果表明該方法參數(shù)量小,計(jì)算成本低,可有效提高手勢(shì)圖像識(shí)別的準(zhǔn)確率。

關(guān)鍵詞:手勢(shì)圖像識(shí)別;卷積神經(jīng)網(wǎng)絡(luò);輕量級(jí)模型;注意力機(jī)制;激活函數(shù)

中圖分類號(hào):TP181

文獻(xiàn)標(biāo)志碼:A

文章編號(hào):1673-3851 (2023) 05-0300-10

引文格式:田秋紅,孫文軒,章立早,等. 基于改進(jìn)GhostNet的輕量級(jí)手勢(shì)圖像識(shí)別方法[J]. 浙江理工大學(xué)學(xué)報(bào)(自然科學(xué)),2023,49(3):300-309.

Reference Format: TIAN? Qiuhong,SUN? Wenxuan,ZHANG? Lizao,et al. Lightweight gesture image recognition method based on improved GhostNet[J]. Journal of Zhejiang Sci-Tech University,2023,49(3):300-309.

Lightweight gesture image recognition method based on improved GhostNet

TIAN Qiuhong, SUN Wenxuan, ZHANG Lizao, SHI Zhixiang, PAN Hao, WU Jialu

(School of Computer Science and Technology, Zhejiang Sci-Tech University, Hangzhou 310018, China)

Abstract: When convolutional neural network is applied to the recognition of gesture images with complex backgrounds, the deep model has a large number of parameters and high computational cost, and the accuracy of the lightweight model is low. To solve these problems, a lightweight gesture image recognition method based on improved GhostNet was proposed in this paper. Firstly, channel shuffling operation was added to the Ghost module, and the CS-Ghost module was designed to extract gesture features from gesture images. Then, SMU (smoothing maximum unit) was selected to activate the function to optimize the learning ability of the model in the back propagation. Finally, the lightweight channel attention module ECA in the attention mechanism was used to remove the noise information in the feature. The experimental average accuracy of the proposed method on ASL and NUS-Ⅱ datasets are 98.82% and 99.36%, respectively. The experimental average accuracy on the OUHANDS dataset is 97.98%, the parameter quantity is 1.2 Mi, and the FLOPs is 0.29 Gi. The experimental results show that the proposed method has small parameters, low computational cost, and effectively improves the accuracy of gesture image recognition.

Key words:gesture image recognition; convolution neural network; lightweight model; attention mechanism; activation function

0 引 言

手勢(shì)是一種自然形態(tài)的交互方式,表達(dá)意義豐富;手勢(shì)圖像識(shí)別在人機(jī)自然交互中可以為用戶提供更加真實(shí)的交互體驗(yàn)[1]。近年來(lái),手勢(shì)圖像識(shí)別在機(jī)器控制、虛擬現(xiàn)實(shí)和輔助駕駛等領(lǐng)域中發(fā)揮著重要的作用。現(xiàn)有手勢(shì)圖像識(shí)別任務(wù)的解決方法主要分為基于機(jī)器學(xué)習(xí)技術(shù)的傳統(tǒng)方法和基于卷積神經(jīng)網(wǎng)絡(luò)為主的深度學(xué)習(xí)方法[2]。

傳統(tǒng)手勢(shì)圖像識(shí)別方法針對(duì)特定數(shù)據(jù)集,人工設(shè)計(jì)手勢(shì)特征進(jìn)行手勢(shì)建模[3]。Tian等[4]使用YCbCr特征提取出有效的手臂區(qū)域,并使用SVM分類器進(jìn)行手勢(shì)分類;該方法對(duì)簡(jiǎn)單背景的手勢(shì)圖像識(shí)別準(zhǔn)確率較高,在復(fù)雜背景的手勢(shì)圖像中識(shí)別效果較差。Sadeddine等[5]提出了一種基于梯度局部自相關(guān)描述符、Gabor小波變換和快速離散曲線變換的靜態(tài)手勢(shì)識(shí)別方法,識(shí)別率達(dá)94%。以上方法采用的特征易于提取,但提取特征較為單一,復(fù)雜手勢(shì)圖像的識(shí)別準(zhǔn)確率不高。為了提高手勢(shì)識(shí)別的準(zhǔn)確率,一些學(xué)者采用更豐富的手勢(shì)特征,并通過(guò)特定機(jī)器學(xué)習(xí)方法進(jìn)行手勢(shì)圖像識(shí)別。楊述斌等[6]提取手勢(shì)圖像中的HOG特征并進(jìn)行PCA降維,再將特征歸一化處理,識(shí)別準(zhǔn)確率高于一般機(jī)器學(xué)習(xí)方法。以上傳統(tǒng)手勢(shì)圖像識(shí)別的方法需要對(duì)特征進(jìn)行針對(duì)性調(diào)整,且容易受到背景與光照等因素的影響,要求數(shù)據(jù)集中手勢(shì)動(dòng)作簡(jiǎn)單,背景噪聲較小,難以推廣使用。

近年來(lái),深度學(xué)習(xí)在圖像識(shí)別領(lǐng)域有著廣泛的應(yīng)用,其中卷積神經(jīng)網(wǎng)絡(luò)(Convolutional neural network, CNN)由于其無(wú)需人工設(shè)計(jì)特征受到了廣泛關(guān)注。Pardasani等[7]將CNN應(yīng)用到機(jī)器人上,識(shí)別人類的簡(jiǎn)單手勢(shì),在美國(guó)手語(yǔ)數(shù)據(jù)集上達(dá)到85%的準(zhǔn)確率。Khotimah等[8]使用CNN對(duì)動(dòng)態(tài)和靜態(tài)兩個(gè)場(chǎng)景的手勢(shì)進(jìn)行分類,平均準(zhǔn)確率為89%。以上兩種方法通過(guò)簡(jiǎn)單的CNN實(shí)現(xiàn)了手勢(shì)圖像識(shí)別,但準(zhǔn)確率不高,因此一些學(xué)者使用更復(fù)雜的模型進(jìn)行識(shí)別。Kwolek等[9]提出了一種基于生成性對(duì)抗網(wǎng)絡(luò)和ResNet模型的方法對(duì)日本手語(yǔ)圖像進(jìn)行分類。Xie等[10]使用Inception V3模型對(duì)表達(dá)24個(gè)英文字母的手勢(shì)數(shù)據(jù)集進(jìn)行分類,采用兩階段訓(xùn)練策略對(duì)模型進(jìn)行微調(diào),準(zhǔn)確率達(dá)到91.35%。Tao等[11]提出了一種利用CNN進(jìn)行多視角增強(qiáng)的手語(yǔ)識(shí)別方法,該方法具有較高的識(shí)別精度,但模型的計(jì)算成本較高。Singh等[12]構(gòu)建了基于VGG16的手勢(shì)圖像識(shí)別系統(tǒng),該系統(tǒng)對(duì)手勢(shì)圖像的識(shí)別率為96.7%。以上使用復(fù)雜CNN的方法能夠提升手勢(shì)圖像識(shí)別的準(zhǔn)確率,但隨著網(wǎng)絡(luò)加深,模型的計(jì)算成本越來(lái)越高,為了加快模型識(shí)別速度,一些學(xué)者采用輕量級(jí)模型進(jìn)行手勢(shì)圖像識(shí)別。辛文斌等[13]提出了一種ShuffleNetv2作為主干網(wǎng)絡(luò)的YOLOv3模型,同時(shí)采用CBAM模塊優(yōu)化特征提取,能夠得到較快的識(shí)別速度。Wang等[14]提出了一種改進(jìn)的輕量級(jí)模型E-MobileNetv2進(jìn)行手勢(shì)圖像識(shí)別,準(zhǔn)確率達(dá)到了96.82%,并且減少了30%的參數(shù)量。Ansari等[15]提出了一種使用MobileNetV2與SSD相結(jié)合的方法進(jìn)行手勢(shì)圖像識(shí)別,大幅減少了模型計(jì)算成本,但識(shí)別的準(zhǔn)確率只有44.7%。上述基于輕量級(jí)模型的方法能夠有效降低計(jì)算成本,但提取到的特征不夠豐富且存在較多的噪聲信息,手勢(shì)圖像識(shí)別的準(zhǔn)確率較低。

為了提高輕量級(jí)模型在手勢(shì)圖像識(shí)別任務(wù)中的準(zhǔn)確率,本文提出了一種基于改進(jìn)GhostNet的輕量級(jí)手勢(shì)圖像識(shí)別方法。該方法在Ghost模塊的基礎(chǔ)上加入通道混洗操作,設(shè)計(jì)了能夠?qū)Σ煌ǖ赖奶卣鬟M(jìn)行重新分配的CS-Ghost (Channel shuffle ghost)模塊。該模塊可以增強(qiáng)通道間的信息交流從而提取豐富的特征信息;同時(shí),采用SMU激活函數(shù)避免ReLU函數(shù)中的神經(jīng)元死亡問(wèn)題,加強(qiáng)模型在訓(xùn)練過(guò)程中的特征學(xué)習(xí)能力;最后,使用輕量級(jí)通道注意力模塊ECA去除特征中的噪聲信息,以增強(qiáng)有效特征的表達(dá)能力。本文提出方法對(duì)GhostNet結(jié)構(gòu)進(jìn)行優(yōu)化,在減少計(jì)算成本的同時(shí),進(jìn)一步提高手勢(shì)圖像識(shí)別的準(zhǔn)確率。

1 方法設(shè)計(jì)

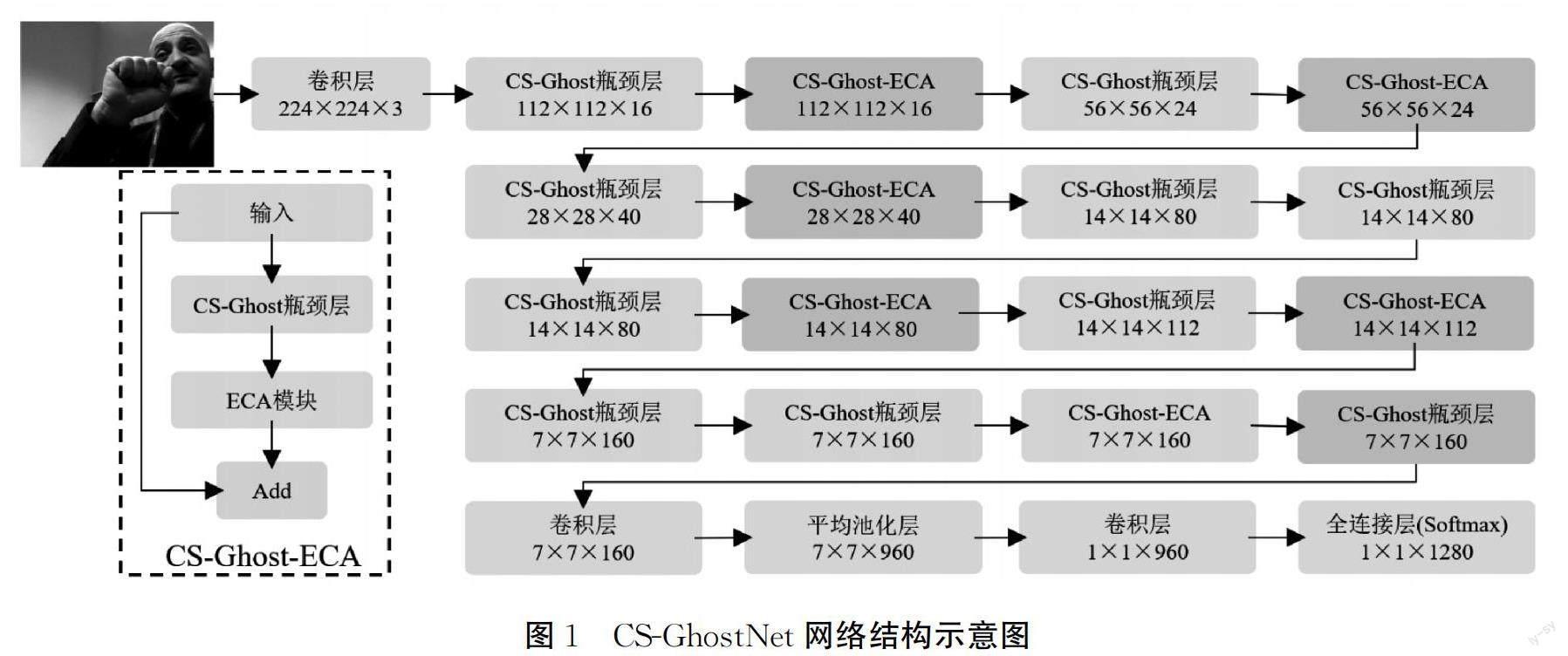

對(duì)于包含特定手勢(shì)的圖像,手勢(shì)圖像識(shí)別任務(wù)需要理解圖像內(nèi)容,排除背景干擾,強(qiáng)化手勢(shì)特征并準(zhǔn)確識(shí)別出手勢(shì)類型。本文建立了輕量級(jí)模型CS-GhostNet,對(duì)復(fù)雜手勢(shì)圖像中的手勢(shì)進(jìn)行分類。首先,在Ghost模塊中加入通道混洗操作,設(shè)計(jì)了CS-Ghost模塊,該模塊能夠提取更豐富的手勢(shì)特征;其次,使用CS-Ghost模塊和SMU激活函數(shù)搭建CS-Ghost瓶頸層,增強(qiáng)模型的學(xué)習(xí)能力;然后,利用ECA模塊減少特征中的噪聲信息;最后,構(gòu)建出CS-GhostNet模型,實(shí)現(xiàn)手勢(shì)圖像識(shí)別。

1.1 網(wǎng)絡(luò)結(jié)構(gòu)

CS-GhostNet網(wǎng)絡(luò)結(jié)構(gòu)示意圖如圖1所示,該模型建立在GhostNet的基礎(chǔ)上,網(wǎng)絡(luò)結(jié)構(gòu)為:首先使用一層卷積層提取尺寸為224×224×3的手勢(shì)圖像特征;再將特征輸入10層CS-Ghost瓶頸層和6個(gè)CS-Ghost-ECA模塊中,輸出尺寸為7×7×160的特征到卷積層中;接著經(jīng)過(guò)一層平均池化層、一層卷積層和一層全連接層,最終得到形狀為1×1×1280的特征進(jìn)行手勢(shì)分類。CS-Ghost-ECA模塊由CS-Ghost瓶頸層和ECA模塊組合得到,具體結(jié)構(gòu)如圖1所示。為了減少ECA模塊對(duì)模型增加的計(jì)算成本,本文只使用6個(gè)CS-Ghost-ECA模塊。其中5個(gè)模塊在傳遞過(guò)程中改變特征尺寸,該操作可以有效利用ECA模塊的注意力機(jī)制增強(qiáng)手勢(shì)特征表達(dá)能力,第6個(gè)CS-Ghost-ECA模塊用于在分類前強(qiáng)化手勢(shì)特征,增強(qiáng)模型的分類能力。

1.2 CS-Ghost模塊

手勢(shì)圖像中會(huì)存在一些非手勢(shì)的干擾物品,卷積操作會(huì)從圖像中提取出手勢(shì)特征和非手勢(shì)特征。為了強(qiáng)化其中的手勢(shì)特征,需要將同一手勢(shì)的多幅圖像輸入網(wǎng)絡(luò)進(jìn)行訓(xùn)練,這種操作會(huì)產(chǎn)生大量的特征圖。Han等[16]發(fā)現(xiàn),在特征圖中存在部分相似的特征,這些相似特征可增強(qiáng)模型對(duì)輸入數(shù)據(jù)的理解程度,有助于提升模型的準(zhǔn)確率;但這些相似特征在卷積過(guò)程中產(chǎn)生的冗余映射會(huì)消耗大量計(jì)算資源。為了減少冗余映射帶來(lái)的計(jì)算量,目前普遍采用輕量級(jí)模型GhostNet通過(guò)簡(jiǎn)單的線性操作生成特征圖。GhostNet由多個(gè)Ghost模塊組成,Ghost模塊的具體結(jié)構(gòu)如圖2(b)所示,每個(gè)Ghost模塊通過(guò)三步操作獲得與普通卷積一樣數(shù)量的特征圖。第一步操作是少量卷積,相對(duì)圖2(a)中的普通卷積操作,少量卷積只使用相當(dāng)于普通卷積一半數(shù)量的卷積核,減少了一半的計(jì)算量;第二步,對(duì)特征圖進(jìn)行廉價(jià)操作,其中1,2,…,m表示對(duì)m個(gè)通道中的特征圖逐個(gè)進(jìn)行線性變換,線性變換會(huì)選擇計(jì)算成本低的深度可分離卷積操作;第三步,對(duì)恒等映射后的特征圖和線性變換后的特征圖進(jìn)行拼接,得到最終的輸出特征。

在Ghost模塊中會(huì)生成兩組特征圖,其中第二組特征圖由第一組特征圖通過(guò)線性變換得到。由于兩組特征圖中存在較多的相似特征且通道結(jié)構(gòu)一致,模型在訓(xùn)練的過(guò)程中只能學(xué)習(xí)到其中一組特征圖的主要信息,而另一組信息被忽略。因此,本文設(shè)計(jì)了CS-Ghost模塊,使用ShuffleNetV2[17]中的通道混洗操作來(lái)增強(qiáng)兩組特征圖不同通道之間的信息交流,具體結(jié)構(gòu)如圖2(c)所示。其中通道混洗操作是在通道的層面上打亂特征的順序,首先假設(shè)一組特征圖中有N個(gè)特征通道,將其看作一個(gè)(1,N)的一維數(shù)組并重塑成(g,N/g)的多維數(shù)組,其中g(shù)為分組的數(shù)量,值為2;然后對(duì)多維數(shù)組進(jìn)行轉(zhuǎn)置,構(gòu)成(N/g,g)的數(shù)組;最后對(duì)其進(jìn)行重塑,將特征數(shù)組變回(1,N),完成通道混洗操作。通過(guò)打亂特征通道的位置順序,CS-Ghost模塊能夠同時(shí)學(xué)習(xí)到兩組特征圖的信息,從而提升模型的特征提取能力。

1.3 基于SMU激活函數(shù)的CS-Ghost瓶頸層

ReLU激活函數(shù)具有快速的收斂能力。ReLU函數(shù)對(duì)負(fù)的特征值直接歸零,特征值在原點(diǎn)不可微的特性使得下一層出現(xiàn)更多的負(fù)值特征,最終超過(guò)50%的神經(jīng)元在模型訓(xùn)練期間死亡。相比ReLU函數(shù),SMU函數(shù)在原點(diǎn)處可微,在模型訓(xùn)練時(shí)能夠更加平滑地傳遞特征到下一層,有效避免ReLU函數(shù)導(dǎo)致的神經(jīng)元死亡問(wèn)題。應(yīng)用SMU函數(shù)的模型可以在訓(xùn)練過(guò)程中更好地從手勢(shì)圖像中學(xué)到手勢(shì)特征。因此,為了提升模型在訓(xùn)練時(shí)的穩(wěn)定性,本文選用SMU激活函數(shù)[18]代替ReLU函數(shù),該函數(shù)的公式可用式(1)表示:

其中:a是一個(gè)超參數(shù),默認(rèn)值設(shè)為0.25;u是一個(gè)可訓(xùn)練參數(shù),初始化值為1000000;erf()是高斯誤差函數(shù),定義為:

本文參照ResNet中的殘差結(jié)構(gòu)[19],通過(guò)CS-Ghost模塊和SMU激活函數(shù)構(gòu)建CS-Ghost瓶頸層,如圖3所示。CS-Ghost瓶頸層分為步長(zhǎng)為1和步長(zhǎng)為2兩種結(jié)構(gòu),每種結(jié)構(gòu)主要由兩個(gè)CS-Ghost模塊組成。對(duì)于步長(zhǎng)為1的CS-Ghost瓶頸層,在第一個(gè)CS-Ghost模塊后添加一個(gè)批量歸一化層(BN)和一個(gè)SMU激活函數(shù);同時(shí)根據(jù)MobileNetV2[20]的建議,在第二個(gè)CS-Ghost模塊后使用一個(gè)批量歸一化層而不使用激活函數(shù),以避免信息損失;最后使用Add操作將輸入特征與經(jīng)過(guò)兩個(gè)CS-Ghost模塊后的特征進(jìn)行相加,得到輸出特征。對(duì)于卷積步長(zhǎng)為2的CS-Ghost瓶頸層,需要使用步長(zhǎng)為2的深度可分離卷積(Depthwise separable convolutions, DWConv)對(duì)特征進(jìn)行空間下采樣,其他結(jié)構(gòu)與步長(zhǎng)為1的CS-Ghost瓶頸層相同。使用SMU激活函數(shù)代替ReLU函數(shù),CS-Ghost瓶頸層在模型訓(xùn)練時(shí)可以接收到更多的有效特征。

1.4 ECA模塊

在復(fù)雜背景下,手勢(shì)圖像中一些環(huán)境干擾因素,例如光照以及背景中不同的物品等,在訓(xùn)練過(guò)程中這些因素會(huì)產(chǎn)生影響模型準(zhǔn)確率的不利特征,并且在訓(xùn)練過(guò)程中被傳播放大,可視為噪聲。通道注意機(jī)制削弱了這些背景特征的通道,降低了它們的權(quán)重[21],從而減少干擾因素對(duì)模型的負(fù)面影響。大多數(shù)注意力機(jī)制模塊無(wú)法兼顧計(jì)算成本和識(shí)別性能[22],例如SE模塊[23]在通道之間交換信息并進(jìn)行特征降維,這個(gè)操作會(huì)增大模型的計(jì)算成本,且對(duì)通道注意力的預(yù)測(cè)產(chǎn)生負(fù)面影響[24]。

ECA(Efficient channel attention)模塊是一種輕量的通道注意力模塊,使用一維卷積組合相鄰?fù)ǖ郎系奶卣鬟M(jìn)行特征加權(quán),以補(bǔ)償特征維數(shù)減少所造成的缺陷,避免了特征降維操作的負(fù)面影響。此外,ECA模塊采用了跨通道交互,在保持性能的同時(shí)不會(huì)過(guò)多增加模型的計(jì)算開銷。因此,輕量級(jí)模型適合引入ECA模塊,在提高模型特征提取能力的同時(shí)保持模型的輕量級(jí)特性。本文在CS-Ghost瓶頸層的Add操作之前嵌入ECA模塊,對(duì)殘差模塊生成的特征進(jìn)行校準(zhǔn),加強(qiáng)模型的識(shí)別能力。ECA模塊的具體結(jié)構(gòu)如圖4所示,其中:W是特征圖的寬度,H是特征圖的高度,C是通道的數(shù)量,GAP(Global average pooling)表示全局平均池化層。ECA模塊能夠根據(jù)通道數(shù)自適應(yīng)地確定卷積核大小K,從而節(jié)省計(jì)算資源。K的計(jì)算公式如式(3)所示:

其中:b和γ是固定數(shù)值的系數(shù),其值分別為1和2;||odd代表取最接近其值的奇數(shù)。

2 結(jié)果與討論

2.1 實(shí)驗(yàn)數(shù)據(jù)集

本文使用NUS-Ⅱ和ASL手勢(shì)圖像數(shù)據(jù)集進(jìn)行實(shí)驗(yàn),圖5(a)和圖5(b)分別為NUS-Ⅱ和ASL手勢(shì)數(shù)據(jù)集的示例圖像。NUS-Ⅱ數(shù)據(jù)集由50名受試者在不同背景下采集制作,包含10種不同的手勢(shì),共有2000幅圖像,ASL數(shù)據(jù)集提供了一套手勢(shì)代替從“A”到“Z”的26個(gè)字母以及“Delete”“Space”和“Nothing”字符,共29個(gè)手勢(shì)類別,包含80000幅圖像。

為了驗(yàn)證本文方法的有效性,本文將復(fù)雜程度更高的OUHANDS手勢(shì)圖像數(shù)據(jù)集作為主要數(shù)據(jù)集。OUHANDS數(shù)據(jù)集由深度傳感攝像頭拍攝捕捉,23名受試者,包含從“A”到“K”(不包含“G”)10種不同的手語(yǔ)動(dòng)作。該數(shù)據(jù)集中圖像背景較為復(fù)雜,共包含28種不同的背景。圖5(c)中展示了“F”“I”和“J”3種手語(yǔ)動(dòng)作,每種手語(yǔ)動(dòng)作選取3幅圖像放在同一列中,每列的前兩幅圖像處于同一背景下,第三幅圖像和前兩幅圖像的背景不同。手勢(shì)“F”中兩種背景圖像分別處于暗光和正常光環(huán)境下,其中正常光環(huán)境中的手勢(shì)放在人像前面,存在膚色干擾因素。對(duì)于手勢(shì)“J”,相同背景的兩幅圖像中手勢(shì)的位置和角度不同,不同背景的圖像之間光源位置不同。OUHANDS中擁有3000幅RGB圖像,每幅圖像數(shù)據(jù)的分辨率為640×480,本文將其中的80%劃分為訓(xùn)練集,20%劃分為測(cè)試集。

2.2 實(shí)驗(yàn)準(zhǔn)備

實(shí)驗(yàn)環(huán)境如下:服務(wù)器操作系統(tǒng)為Ubuntu16.04,Python版本3.7.2,使用的深度學(xué)習(xí)框架為TensorFlow2.3,顯卡為Nvidia GeForce GTX 2070Ti,實(shí)驗(yàn)選用Adam算法作為模型參數(shù)優(yōu)化器,BatchSize的大小設(shè)置為16,訓(xùn)練周期為100次。在訓(xùn)練之前對(duì)圖像進(jìn)行預(yù)處理,先對(duì)讀入的原始手勢(shì)圖像進(jìn)行尺寸歸一化,變成224×224×3的三通道RGB圖像,再對(duì)三通道RGB圖像進(jìn)行標(biāo)準(zhǔn)化,將三通道RGB圖像的像素從0~255的整數(shù)映射為0~1的浮點(diǎn)數(shù),最后輸入模型進(jìn)行訓(xùn)練和測(cè)試。

2.3 激活函數(shù)對(duì)比實(shí)驗(yàn)

為了驗(yàn)證SMU激活函數(shù)的有效性,本文在CS-GhostNet模型中使用5種激活函數(shù)在OUHANDS數(shù)據(jù)集上進(jìn)行對(duì)比實(shí)驗(yàn),對(duì)于每種激活函數(shù),本文進(jìn)行了20次測(cè)試,最終求出每種激活函數(shù)對(duì)應(yīng)的平均準(zhǔn)確率及方差。采用不同激活函數(shù)的模型平均準(zhǔn)確率如表1所示,使用SMU激活函數(shù)的模型平均準(zhǔn)確率為97.98%,相比Sigmoid函數(shù)和Tanh函數(shù)分別提高了0.42%和0.76%。在反向傳播的過(guò)程中,Sigmoid函數(shù)和Tanh函數(shù)飽和區(qū)域接近于0且非常平緩,容易出現(xiàn)梯度消失的問(wèn)題,導(dǎo)致網(wǎng)絡(luò)中神經(jīng)元的權(quán)重?zé)o法即時(shí)更新。SMU函數(shù)在超參數(shù)確定的情況下,正輸入時(shí)得到的結(jié)果是線性的,能夠完整傳遞梯度,可以避免梯度消失問(wèn)題。同時(shí),SMU函數(shù)的平均準(zhǔn)確率相比ReLU函數(shù)和Leaky ReLu函數(shù)分別提高了0.06%和0.12%。由于ReLU函數(shù)解決了梯度消失問(wèn)題,所以其平均準(zhǔn)確率相對(duì)Sigmoid函數(shù)和Tanh函數(shù)有所提升,但ReLU函數(shù)在輸入負(fù)值的情況下存在神經(jīng)元壞死的問(wèn)題,Leaky ReLU函數(shù)在負(fù)半軸添加了一個(gè)小的正斜率,確保神經(jīng)元的權(quán)重在負(fù)值輸入的情況下仍然可以更新。但Leaky ReLU函數(shù)中使用的斜率很小,影響權(quán)重更新的速度,最終會(huì)影響模型的平均準(zhǔn)確率。SMU函數(shù)通過(guò)平滑逼近的方式更新權(quán)重,在避免神經(jīng)元壞死問(wèn)題的同時(shí)加快模型的收斂速度,在模型訓(xùn)練過(guò)程中能夠傳遞更多的有效參數(shù),得到的特征更加契合手勢(shì)圖像,最終提高了模型的平均準(zhǔn)確率。

為了驗(yàn)證激活函數(shù)對(duì)模型穩(wěn)定性的影響,本文計(jì)算了5種激活函數(shù)的準(zhǔn)確率方差。從表1中可以看出,Tanh函數(shù)的方差最大,達(dá)到了0.32%,當(dāng)輸入較大或較小時(shí),Tanh函數(shù)的輸出較為單一,不利于權(quán)重更新,最終影響了模型的收斂速度使得平均準(zhǔn)確率不夠穩(wěn)定。Sigmoid函數(shù)和Leaky ReLU函數(shù)的方差較為接近,分別為0.23%和0.24%,Sigmoid函數(shù)中的梯度消失問(wèn)題影響了模型收斂速度,Leaky ReLU函數(shù)在負(fù)值輸入下使用小斜率不利于權(quán)重更新。ReLU函數(shù)的方差為0.19%,其在正輸入時(shí)輸出是線性的,負(fù)輸入時(shí)輸出直接為0,計(jì)算速度快且不存在梯度消失的問(wèn)題。SMU函數(shù)的方差最小,只有0.16%,SMU函數(shù)能夠平滑地傳遞特征到下一層,權(quán)重更新快,模型收斂速度加快,使得平均準(zhǔn)確率波動(dòng)幅度小,從而增強(qiáng)模型的穩(wěn)定性。

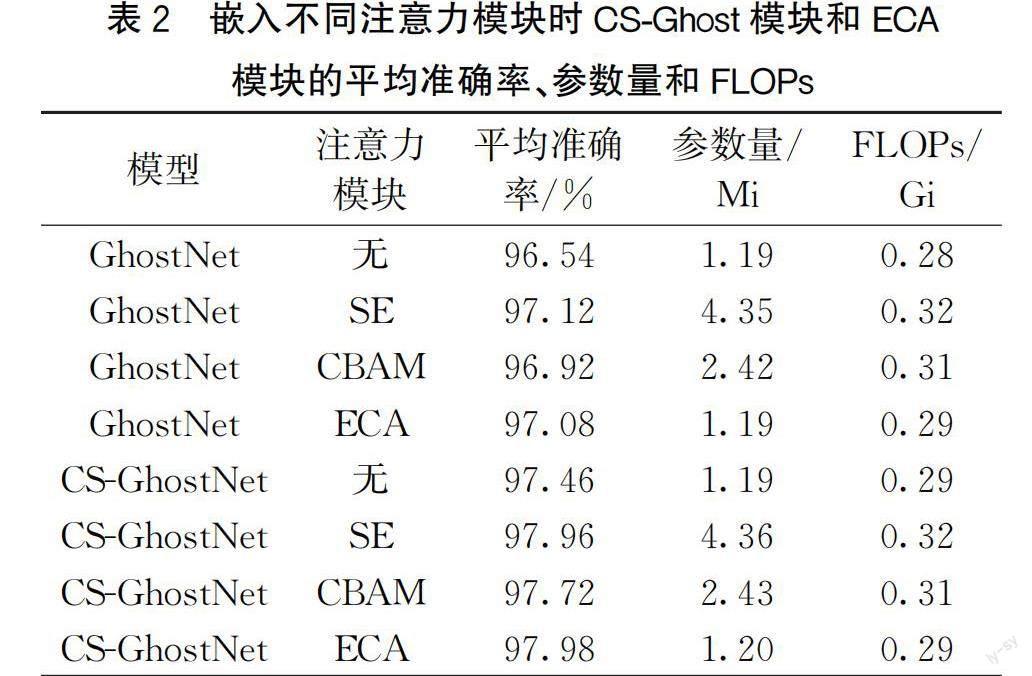

2.4 通道混洗機(jī)制和ECA模塊的性能驗(yàn)證實(shí)驗(yàn)

為了探索通道混洗機(jī)制和ECA模塊對(duì)模型產(chǎn)生的影響,本文將對(duì)GhostNet和CS-GhostNet嵌入不同注意力模塊進(jìn)行對(duì)比實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果如表2所示。從表2中可以看出,CS-GhostNet相對(duì)GhostNet平均準(zhǔn)確率有顯著提升,在不加注意力模塊的情況下,CS-GhostNet相對(duì)GhostNet提高0.92%的平均準(zhǔn)確率,參數(shù)量沒有變化,F(xiàn)LOPs增加了0.01 Gi。將SE模塊、CBAM模塊和ECA模塊分別加入模型后,CS-GhostNet相對(duì)GHostNet平均準(zhǔn)確率分別提高了0.84%、0.80%和0.90%,參數(shù)量和FLOPs沒有顯著變化,這是因?yàn)橥ǖ阑煜礄C(jī)制用于增強(qiáng)模型的特征提取能力且花費(fèi)的計(jì)算成本較低,能夠進(jìn)一步提升模型的性能。加入SE模塊與CBAM模塊的CS-GhostNet平均準(zhǔn)確率分別提升了0.50%和0.26%,但SE模塊將模型的參數(shù)量從1.19 Mi增加到4.36 Mi,F(xiàn)LOPs從0.29 Gi增加到0.32 Gi,CBAM模塊增加了1.34 Mi的參數(shù)量和0.02 Gi的FLOPs。SE模塊和CBAM模塊雖然提升了模型的平均準(zhǔn)確率,但增大了模型的計(jì)算成本。加入ECA模塊的CS-GhostNet在平均準(zhǔn)確率提升了0.52%的同時(shí)參數(shù)量只增加了0.01 Mi,且FLOPs沒有增加。與實(shí)驗(yàn)中的其他注意力模塊對(duì)比,ECA模塊在提升平均準(zhǔn)確率的同時(shí)不會(huì)顯著影響模型的參數(shù)量和計(jì)算成本,有效提升模型的性能。

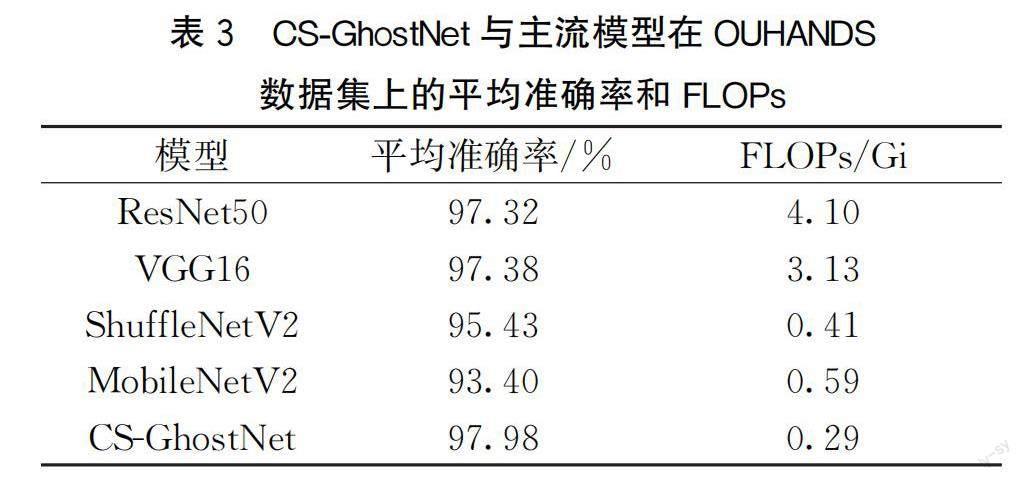

2.5 CS-GhostNet的性能驗(yàn)證實(shí)驗(yàn)

為了驗(yàn)證提出的CS-GhostNet模型的有效性,將此模型與主流的分類模型ResNet50、VGG16、ShuffleNetV2以及MobileNetV2在OUHANDS數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),在平均準(zhǔn)確率和FLOPs兩個(gè)方面作對(duì)比分析,實(shí)驗(yàn)結(jié)果如表3所示。

由表3可見,本文提出的CS-GhostNet模型在平均準(zhǔn)確率上比ResNet50高0.66%,比VGG16高0.60%,且FLOPs為0.29 Gi,遠(yuǎn)低于ResNet50的4.1 Gi和VGG16的3.13 Gi,CS-GhostNet在保持模型輕量特性的同時(shí)平均準(zhǔn)確率能夠高于VGG16和ResNet50這些計(jì)算成本較高的模型。與ShuffleNetV2和MobileNetV2相比,CS-GhostNet不僅平均準(zhǔn)確率分別提升了2.55%和4.58%,F(xiàn)LOPs也分別降低了0.12 Gi和0.30 Gi,CS-GhostNet的平均準(zhǔn)確率提升幅度較大且計(jì)算成本也低于兩個(gè)輕量級(jí)模型實(shí)驗(yàn)結(jié)果表明,CS-GhostNet在保持模型低計(jì)算成本的同時(shí)實(shí)現(xiàn)了較高的平均準(zhǔn)確率,是一種性能優(yōu)良的網(wǎng)絡(luò)模型。

2.6 訓(xùn)練性能對(duì)比實(shí)驗(yàn)

為了測(cè)試本文提出的CS-GhostNet模型在訓(xùn)練時(shí)的性能,將該模型與VGG16、ResNet50、MobileNetV2、ShuffleNetV2和GhostNet模型在訓(xùn)練時(shí)的準(zhǔn)確率變化情況進(jìn)行對(duì)比分析,這6種模型在OUHANDS數(shù)據(jù)集上的準(zhǔn)確率變化曲線如圖6所示。由圖6可知,CS-GhostNet在60次迭代后基本收斂,VGG16和ResNet50在70次迭代后收斂,GhostNet、MobileNetV2和ShuffleNetV2都在80次迭代后才開始收斂,且在80到100次迭代中準(zhǔn)確率曲線仍然存在一定程度的波動(dòng)。輕量級(jí)模型GhostNet、MobileNetV2和ShuffleNetV2的收斂速度較慢且穩(wěn)定性較差。ResNet50和VGG16的穩(wěn)定性較好,但收斂速度一般。CS-GhostNet的收斂速度最快且穩(wěn)定性好,這是因?yàn)橥ǖ阑煜床僮骱虴CA模塊能夠讓模型在訓(xùn)練前期提取到更多的有效特征,加快了模型的收斂速度;SMU函數(shù)增強(qiáng)了模型在反向傳播中的學(xué)習(xí)能力,提高了模型的穩(wěn)定性。觀察圖6中模型的準(zhǔn)確率變化曲線,可以發(fā)現(xiàn)CS-GhostNet的準(zhǔn)確率最高,VGG16和ResNet50準(zhǔn)確率略低,GhostNet、ShuffleNetV2和MobileNetV2的準(zhǔn)確率較低。實(shí)驗(yàn)結(jié)果表明,在模型訓(xùn)練的過(guò)程中,CS-GhostNet在收斂速度和穩(wěn)定性方面表現(xiàn)較好,識(shí)別準(zhǔn)確率達(dá)到最高,模型整體性能優(yōu)秀。

2.7 時(shí)間性能驗(yàn)證實(shí)驗(yàn)

為了測(cè)試提出方法的時(shí)間性能,本文將不同方法的訓(xùn)練時(shí)間和預(yù)測(cè)時(shí)間進(jìn)行對(duì)比,實(shí)驗(yàn)結(jié)果如表4所示,其中訓(xùn)練時(shí)間是指模型從開始訓(xùn)練到100個(gè)周期訓(xùn)練完成所花費(fèi)的時(shí)間,預(yù)測(cè)時(shí)間是指已經(jīng)訓(xùn)練完成的模型對(duì)于預(yù)測(cè)一幅分辨率為640×480的手勢(shì)圖像花費(fèi)的時(shí)間。從表4中可以看出,CS-GhostNet的訓(xùn)練時(shí)間為0.72 h,相對(duì)MobileNetV2和ShuffleNetV2分別減少了0.05 h和0.08 h,比訓(xùn)練時(shí)間最長(zhǎng)的Xception減少了0.62 h。CS-GhostNet對(duì)于單幅圖像的預(yù)測(cè)時(shí)間只需要232 ms,比輕量級(jí)模型MobileNetV2和ShuffleNetV2分別減少6 ms和11 ms,比ResNet50和Xception分別減少了30 ms和81 ms。CS-GhostNet的訓(xùn)練時(shí)間較短,表明了模型具有較低計(jì)算成本。相比其他模型,CS-GhostNet對(duì)單幅圖像預(yù)測(cè)的時(shí)間成本較低,在時(shí)間性能方面有一定的優(yōu)越性。

2.8 不同數(shù)據(jù)集上的對(duì)比實(shí)驗(yàn)

為了測(cè)試提出模型的泛化性能,在OUHANDS數(shù)據(jù)集、ASL數(shù)據(jù)集以及NUS-Ⅱ數(shù)據(jù)集上進(jìn)行CS-GhostNet和其他模型的對(duì)比實(shí)驗(yàn)。由表5可見,在OUHANDS數(shù)據(jù)集的實(shí)驗(yàn)結(jié)果中,CS-GhostNet的平均準(zhǔn)確率為97.98%,在所比較的方法中平均準(zhǔn)確率最高。ASL數(shù)據(jù)集圖像背景較為簡(jiǎn)單,VGG16在該數(shù)據(jù)集上存在過(guò)擬合現(xiàn)象,平均準(zhǔn)確率為98.46%,ResNet50在一定程度上解決了過(guò)擬合問(wèn)題,得到了99.2%的平均準(zhǔn)確率,CS-GhostNet作為參數(shù)量較少的輕量級(jí)模型,過(guò)擬合風(fēng)險(xiǎn)較低,平均準(zhǔn)確率為98.82%,略低于ResNet50,但高于其他模型。在NUS-Ⅱ數(shù)據(jù)集上,CS-GhostNet達(dá)到了98.36%的平均準(zhǔn)確率,高于其他模型。通過(guò)分析可知,本文提出的CS-GhostNet能夠在3個(gè)數(shù)據(jù)集上獲得較高的平均準(zhǔn)確率,泛化性能良好。

3 結(jié) 論

本文提出一種基于改進(jìn)GhostNet的輕量級(jí)手勢(shì)圖像識(shí)別方法,通過(guò)通道混洗操作改進(jìn)Ghost模塊,增強(qiáng)特征通道之間的信息交流;使用SMU激活函數(shù)加強(qiáng)模型的特征學(xué)習(xí)能力和訓(xùn)練時(shí)的穩(wěn)定性;加入ECA模塊減少特征中的噪聲信息。實(shí)驗(yàn)結(jié)果表明,采用CS-Ghost模塊、SMU函數(shù)和ECA模塊可以保證模型在輕量的特性下提高手勢(shì)圖像的識(shí)別準(zhǔn)確率。本文提出方法在ASL和NUS-Ⅱ數(shù)據(jù)集上分別得到了98.82%和98.36%的平均準(zhǔn)確率,在OUHANDS數(shù)據(jù)集上平均準(zhǔn)確率達(dá)到了97.98%,參數(shù)量為1.20 Mi,F(xiàn)LOPs為0.29 Gi,在準(zhǔn)確率和計(jì)算成本方面與現(xiàn)有手勢(shì)圖像識(shí)別方法相比有明顯優(yōu)越性。

參考文獻(xiàn):

[1]Jiang D, Zheng Z J, Li G F, et al. Gesture recognition based on binocular vision[J]. Cluster Computing, 2019, 22(6): 13261-13271.

[2]王銀, 陳云龍, 孫前來(lái). 復(fù)雜背景下的手勢(shì)識(shí)別[J]. 中國(guó)圖象圖形學(xué)報(bào), 2021, 26(4):815-827.

[3]陳影柔, 田秋紅, 楊慧敏, 等. 基于多特征加權(quán)融合的靜態(tài)手勢(shì)識(shí)別[J]. 計(jì)算機(jī)系統(tǒng)應(yīng)用, 2021, 30(2):20-27.

[4]Tian Q H, Bao J X, Yang H M, et al. Improving arm segmentation in sign language recognition systems using image processing[J]. Technology and Health Care: Official Journal of the European Society for Engineering and Medicine, 2021, 29(3): 527-540.

[5]Sadeddine K, Chelali F Z, Djeradi R, et al. Recognition of user-dependent and independent static hand gestures: Application to sign language[J]. Journal of Visual Communication and Image Representation, 2021, 79: 103193.

[6]楊述斌, 潘偉, 蔣宗霖. 基于HOG特征與手部多特征信息融合的靜態(tài)手勢(shì)識(shí)別[J]. 自動(dòng)化與儀表, 2020, 35(8):47-51.

[7]Pardasani A, Sharma A K, Banerjee S, et al. Enhancing the ability to communicate by synthesizing american sign language using image recognition in a chatbot for differently abled[C]∥2018 7th International Conference on Reliability, Infocom Technologies and Optimization(Trends and Future Directions). Noida, India: IEEE, 2018: 529-532.

[8]Khotimah W N, Suciati N, Benedict I. Indonesian sign language recognition by using the static and dynamic features[C]∥2018 International Seminar on Intelligent Technology and Its Applications (ISITIA). Bali, Indonesia: IEEE, 2018: 293-298.

[9]Kwolek B, Baczynski W, Sako S. Recognition of JSL fingerspelling using deep convolutional neural networks[J]. Neurocomputing, 2021, 456: 586-598.

[10]Xie B, He X Y, Li Y. RGB-D static gesture recognition based on convolutional neural network[J]. The Journal of Engineering, 2018, 2018(16): 1515-1520.

[11]Tao W J, Leu M C, Yin Z Z. American Sign Language alphabet recognition using Convolutional Neural Networks with multiview augmentation and inference fusion[J]. Engineering Applications of Artificial Intelligence, 2018, 76: 202-213.

[12]Singh D K, Kumar A, Ansari M A. Robust modelling of static hand gestures using deep convolutional network for sign language translation[C]∥2021 International Conference on Computing, Communication, and Intelligent Systems (ICCCIS). Greater Noida, India: IEEE, 2021: 487-492.

[13]辛文斌, 郝惠敏, 卜明龍, 等. 基于ShuffleNetv2-YOLOv3模型的靜態(tài)手勢(shì)實(shí)時(shí)識(shí)別方法[J]. 浙江大學(xué)學(xué)報(bào)(工學(xué)版), 2021, 55(10):1815-1824.

[14]Wang W J, He M L, Wang X H, et al. Medical gesture recognition method based on improved lightweight network[J]. Applied Sciences, 2022, 12(13): 6414.

[15]Ansari Z A, Harit G. Nearest neighbour classification of Indian sign language gestures using kinect camera[J]. Sadhana, 2016, 41(2):161-182.

[16]Han K, Wang Y H, Tian Q, et al. GhostNet: More features from cheap operations[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, USA: IEEE, 2020: 1577-1586.

[17]Ma N N, Zhang X Y, Zheng H T, et al. ShuffleNet V2: Practical guidelines for efficient CNN architecture design[C]∥Ferrari, V, Hebert M, Sminchisescu C, Weiss Y. Lecture Notes in Computer Science: European Conference on Computer Vision . Springer, Cham, 2018, 11218: 116-131.

[18]Biswas K, Kumar S, Banerjee S, et al. SMU: Smooth activation function for deep networks using smoothing maximum technique[EB/OL]. (2022-10-31)[2021-11-08]. https:∥arxiv.org/abs/2111.04682.

[19]He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 770-778.

[20]Sandler M, Howard A, Zhu M L, et al. MobileNetV2: Inverted residuals and linear bottlenecks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 4510-4520.

[21]He L J, Gong X L, Zhang S, et al. Efficient attention based deep fusion CNN for smoke detection in fog environment[J]. Neurocomputing, 2021, 434: 224-238.

[22]Gao R H, Wang R, Feng L, et al. Dual-branch, efficient, channel attention-based crop disease identification[J]. Computers and Electronics in Agriculture, 2021, 190: 106410.

[23]Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]∥2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 7132-7141.

[24]Wang Q L, Wu B G, Zhu P F, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks[C]∥Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA: IEEE, 2020: 11531-11539.

[25]Chollet F. Xception: Deep learning with depthwise separable convolutions[C]∥2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017: 1800-1807.

[26]Tan M X, Le Q V. EfficientNet: Rethinking model scaling for convolutional neural networks[C]∥International Conference on Machine Learning. Long Beach, CA, USA: PMLR, 2019: 6105-6114.

[27]Adithya V, Rajesh R. A deep convolutional neural network approach for static hand gesture recognition[J]. Procedia Computer Science, 2020, 171: 2353-2361.

[28]Yadav K S, Kirupakaran A M, Laskar R H, et al. Design and development of a vision-based system for detection, tracking and recognition of isolated dynamic bare hand gesticulated characters[J]. Expert Systems, 2022: e12970.

[29]Bhaumik G, Verma M, Govil M C, et al. HyFiNet: Hybrid feature attention network for hand gesture recognition[J]. Multimedia Tools and Applications, 2022: 1-20.

[30]Wang S, Zhang S H, Zhang X W, et al. A two-branch hand gesture recognition approach combining atrous convolution and attention mechanism[J]. The Visual Computer, 2022: 1-14.

(責(zé)任編輯:康 鋒)