一種面向企業廣域網的新型算力連接和路由技術試點方案

慶祖良,史庭祥,徐法祿,張 健,徐 方

(1.中國移動通信集團江蘇有限公司,江蘇 南京 210012;2.移動網絡和移動多媒體技術國家重點實驗室,廣東 深圳 518055;3.中興通訊股份有限公司,江蘇 南京 210012)

0 引言

伴隨千行百業的應用上云和5G網絡大規模建設接近尾聲,流量“增量不增收”已使運營商依賴的流量經營模式難以支撐收入持續、大幅增長。近些年發展起來的運營商云業務,即依托數據中心(DC)的服務器和云資源租賃業務,成為運營商收入第二曲線的切入點。誠然,圍繞應用建設的算力基礎設施和網絡基礎設施,其控制權原由互聯網云商和運營商各自擁有,對外體現為“應用算力”和“網絡運力”[1-2],但是圍繞算力業務構建新型網絡毫無爭議地成為運營商實現算力時代下基礎通信網絡升級的差異化戰略的絕佳抓手。

投射到企業網絡上,在企業應用普遍上云的背景下,企業網絡不得不面對既要在應用的客戶端和服務端之間搭建低成本連接通道,又要盡可能保障用戶體驗、達成服務端算力有效利用的兩難境地。換言之,隨著用戶在跨地、多園區和居家辦公等接入泛在化,及算力和各種內部應用分布在多地DC的算力泛在化,企業亟待解決分布于多地園區通過專線互聯組成的規模廣域網(Wide Area Network,WAN)如何保障算力部分有效連接的難題。

具體而言,面臨兩方面的挑戰:

① 從宏觀政策和產業現狀趨勢角度,分布在多地的DC等算力基礎設施建設已成為國家政策和產業層面的雙重熱點,既追求資源的規模化,又體現資源在多地分布的均衡性。

國家政策層面:2021年3月,《國家“十四五”規劃和2035年遠景目標綱要》提出“數據中心和智能計算中心”建設納入新型信息基礎設施的范圍。同年5月,發改委、工信部和能源局聯合發布《全國一體化大數據中心協同創新體系算力樞紐實施方案》,啟用建設東西部4+4國家算力樞紐節點,“東數西算”工程正式全面啟動[3-4]。

產業層面和市場情況:OTT云商已布局DC外遷,騰訊、京東參與成渝節點申報,華為在甘肅、重慶多地申報DC建設。同時,算力基礎設施投入巨大,阿里云在2020年宣布未來三年投入2 000億元建設DC,騰訊未來五年投入5 000億,滿足千行百業的算力需求。

運營商方面:不僅加大資源投入,如三大運營商著力建設分布于多地的云DC,而且2021年下半年,中國移動集團將“算力網絡”提升到戰略目標的高度,在構建的“連接+算力+能力”的新型網絡中算力承擔著“資源中臺”的承上啟下的中樞角色,同時圍繞算力建設網絡,算力的網絡化和網絡的算力化相得益彰,為通信網絡和云計算的網絡轉型和經營轉型指明方向,昭示著算力供給的大變革已到來[5-7]。

② 從多業務質量(QoS)保障的應用場景出發,基于不同業務的不同質量需求的傳統QoS保障方案,面臨多地接入、多個用戶、多種業務的流量調度和管理的復雜場景的挑戰。

具體而言,以園區的辦公、研發和生產場景為例,除基本的網頁瀏覽、工作郵件等辦公需求外,在主要的工作時間段內還需要提供芯片仿真、軟件測試、多地接入的音視頻會議、實時語音通話、文件實時上傳和下載等業務。特別是隨著應用引入分布式云原生[8]、容器技術和大規模云資源池,網絡面可見的業務數量大幅增加,相應需要提供不同的網絡質量,以保證差異化的業務質量[9-11]。

1 傳統QoS技術

IP網絡的業務一般分為實時業務和非實時業務。實時業務往往希望占據固定帶寬,對網絡質量變化感知明顯,對網絡質量的穩定性要求高,例如語音業務。非實時業務所占帶寬難以預測,經常會出現突發流量。突發流量會導致網絡質量下降、引起網絡擁塞、增加轉發時延,嚴重時還會產生丟包,導致業務質量下降甚至不可用。

解決網絡擁塞最好的辦法是增加網絡帶寬,但從運營、維護的成本考慮,這是不現實的,尤其對企業WAN而言受到昂貴的運營商OTN專線租賃費用的嚴格約束,因此,最有效的解決方案是應用一個“有保證”的策略對網絡流量進行管理,即將QoS技術應用于針對網絡有突發流量時需要保障重要業務質量的場景。

在網絡中部署QoS技術來保證帶寬、時延和抖動等IP度量指標在一定的合理范圍內,從而提高網絡的服務質量,這涉及到QoS模型。一般而言,除Best-Effort服務模型和IntServ服務模型外,當前主流的是DiffServ服務模型。

DiffServ模型的基本原理是將網絡中的流量分成多個類,每個類享受不同的處理,尤其是網絡出現擁塞時不同的類會享受不同級別的處理,從而得到不同的丟包率、時延以及抖動。同一類的業務在網絡中會被聚合起來統一發送,保證相同的時延、抖動和丟包率等QoS指標。

該模型是帶內模式,即不需要信令。應用程序發出報文前,不需要預先向網絡提出資源申請,而通過設置報文的QoS參數信息,傳遞給網絡節點其QoS需求。網絡根據每個報文流指定的QoS參數信息來提供差分服務,即對報文劃分QoS,差異化地進行流量控制和轉發。DiffServ模型的優點是將復雜的服務質量保證通過報文自身攜帶的信息轉換為單跳行為,從而大大減少了信令的工作。

上述傳統QoS技術,針對不同的業務提供不同的服務,可以滿足語音、視頻以及數據等業務的不同服務需求。但是隨著企業跨地域發展,各種接入方式和應用彼此交錯,帶來WAN設備的高速發展,接入用戶數和每個用戶的業務量也隨之顯著提升,傳統QoS技術遭遇挑戰,局限性在企業WAN和復雜的企業應用中表現為:

① 傳統QoS基于端口帶寬調度,流量管理基于服務等級進行業務區分,但很難具備基于用戶和應用進行區分業務質量的能力,因此比較適合部署在網絡核心側,但不適合部署在業務接入側。

② 傳統QoS無法做到同時對多個用戶的多個業務進行流量管理和調度。

③ 針對跨地域的企業WAN場景,涵蓋上行和下行流量的從接入端到服務端的端到端QoS需求迫在眉睫。

為應對這些挑戰,需要一種既能區分業務應用又能根據用戶業務的優先級進行調度的技術。需要基于多級隊列的多級調度,細化區分業務流量,對多用戶、多種業務等傳輸需求進行統一管理和分層調度,并提供統一控制策略,在網絡建設成本的約束下,為實時類應用和高等級用戶提供差異化傳輸質量保證。

同時,遠期的基于算力標識的算力路由技術處于研究階段,尚不足以支撐企業WAN的商用需求,且對網絡協議和終端有更新需求[12-13]。而服務跨地域的用戶和算力的WAN,要求對不同用戶的不同業務提供差異化和端到端質量保障,以便實現對算力能力部分的有效連接和差異化服務供給。

綜上所述,在滿足用戶體驗的情況下,面向不同應用如何提升企業網絡基礎設施的資源效率和運營效率、達成高效算力服務,既有理論價值也有實踐意義,將有助于打造一張面向多業務、多地域和多接入的成本領先、質量可承諾的企業WAN。

2 新型算力連接和路由技術方案

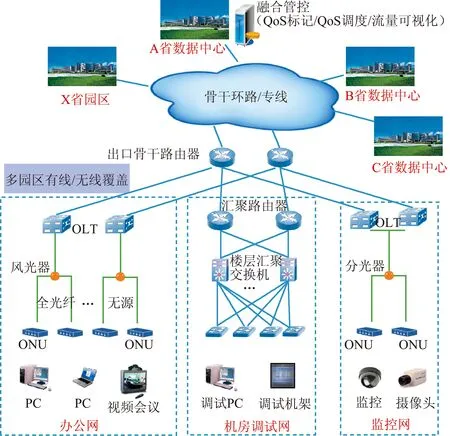

基于分布在多地的企業園區通過專線接入彼此互聯的WAN,及分屬于辦公網、調試網和監控網的不同業務客戶端構成的多業務混合場景,如圖1所示,各種應用所需的算力連接服務質量不盡相同。一方面,專線帶寬長期處于高負荷狀態;另一方面QoS要求高的實時類業務需要端到端質量保障,而傳統保障型網絡方案無法滿足要求。

圖1 多地域、多業務和多接入的企業園區分布Fig.1 Distribution of enterprise campuses with multiple regions, services, and accesses

為此,立足多園區和多業務場景,本文提出基于業務優先級調度的企業園區算力連接創新方案,即一種新型算力連接和路由技術方案。該方案通過控制與轉發部分的創新,探索算力連接的服務化和差異化,技術賦能算力服務整體。從多業務融合的接入和承載網出發,圍繞SRv6、QoS標記和管理、QoS調度、QoS策略的集中管控和自動化執行、業務和流量可視化運維等關鍵技術進行攻關,探索模塊化、標準化、可復制的園區運力網絡技術方案和服務新模式。

2.1 總體設計

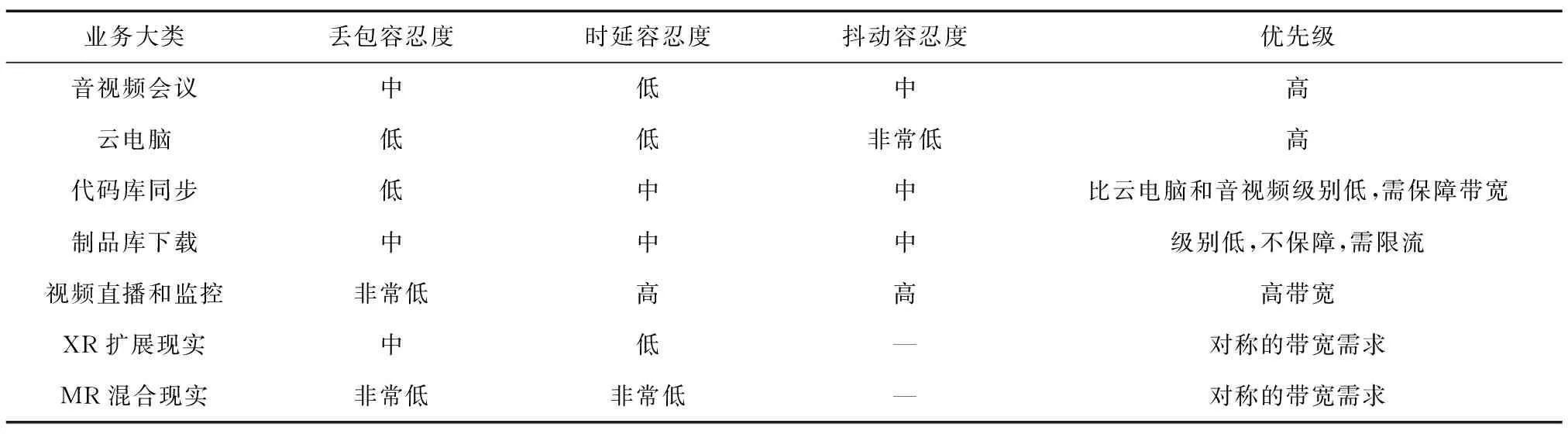

企業園區的業務種類繁多,對QoS需求各有不同。比如音視頻會議的視頻部分要求高帶寬和低時延,需要QoS流量監控功能為視頻報文提供高帶寬,又需要QoS優先級功能為視頻報文和語音報文設置優先級。實時語音部分要求低丟包和低時延,通過QoS優先級功能調整語音報文的優先級高于視頻報文,并通過流量監管功能提供最大帶寬,保證語音報文在帶寬有限的情況下優先通過。園區典型業務的QoS和優先級分析如表1所示。

表1 園區典型業務的QoS和優先級分析Tab.1 QoS and priority analysis of typical services in the campus

為此,本文的QoS優先級調度和流量管控功能設計包括如下子功能:

① QoS標記:在網絡邊緣由接入節點完成業務流的分類和匯聚。接入節點根據多種條件,如報文的IP地址段、業務TCP/UDP端口號、協議類型等,對報文進行分類和設置不同的QoS標記字段。

② QoS調度:其他節點只要識別報文中的這些標記分配資源和流量管理。根據每個報文流指定的QoS標記信息來提供差異化質量服務,即為不同業務流的報文分配服務等級,差異化地進行流控和轉發,進而實現提供端到端的業務質量管控。通過報文自身攜帶的信息完成差異化的QoS管控,從而大量降低信令面的負荷。

③ QoS策略的集中管控、自動化執行和流量可視化運維:為減少人工運維配置的工作量,網絡控制器采用接入網和傳輸網融合的管控系統,以便建立QoS策略的集中管控系統,通過自動化執行,實現全鏈路QoS能力的自動化。與Netflow和報表工具的配合使用,實現流量可視化運維。此外,QoS集中管控功能和業務控制器和運營系統協同,探索運力運營的服務化和應用場景化增值。

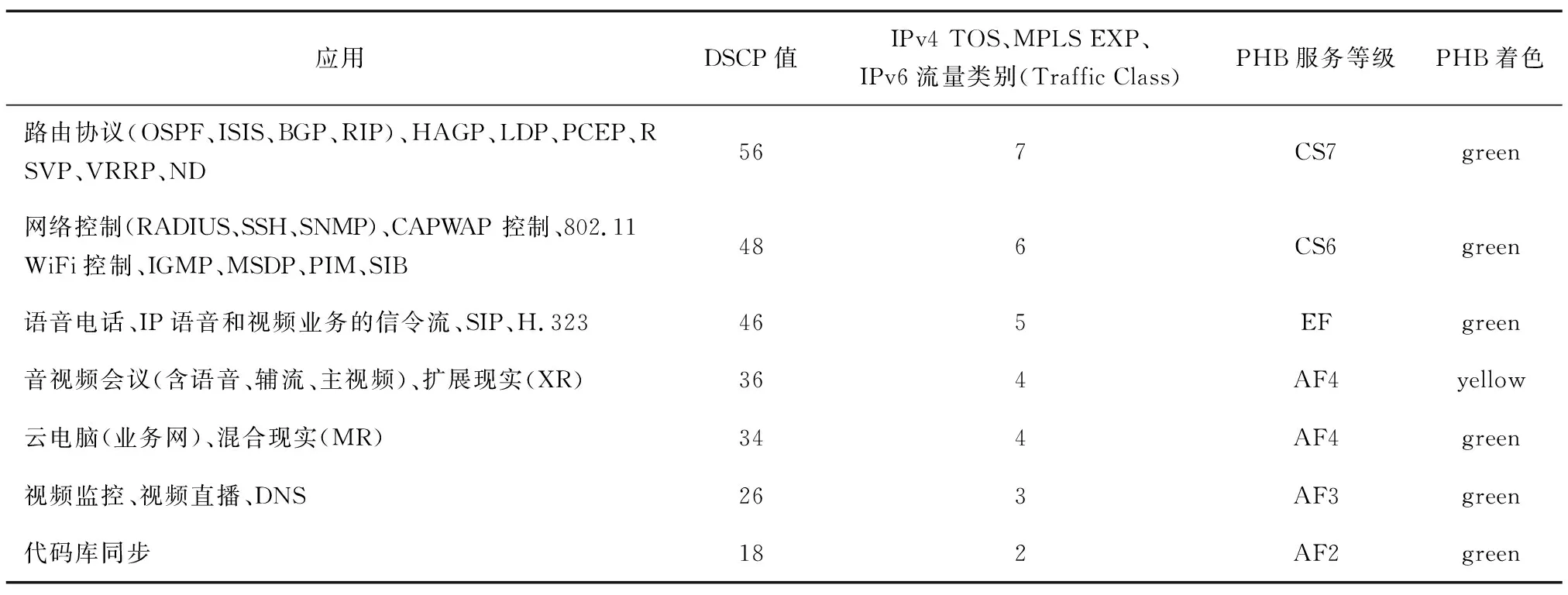

2.2 QoS標記和管理

報文的分類和標記工作,即設置業務報文的不同類別或優先級。通過QoS配置中的流分類實現報文的不同分類或優先級,標記在網絡設備中傳遞通過優先級映射實現。不同的報文使用不同類型的QoS優先級表征,如IP報文使用DSCP,MPLS報文使用EXP。業務報文QoS標記的映射關系設置參考如表2所示。

表2 業務QoS標記的映射關系設置參考Tab.2 Reference for mapping relationship settings of service QoS markers

應用的客戶端和服務端無須發送帶QoS標記的IP報文,一般在用戶側的接入交換機和匯聚交換機,及應用所在DC的入云側云PE上,根據5元組或DPI自動識別業務,按預定規則標記報文的DSCP值。PE設備提供IP DSCP和MPLS EXP的相互映射和繼承能力。全鏈路設備,如邊緣控制器/SRv6頭節點、園區核心路由器和骨干路由器等具備根據DSCP值、MPLS EXP進行QoS保障和調度的能力。

2.3 QoS調度和多優先級技術

根據企業WAN的多用戶、多種業務等傳輸對象的特點,本方案提供統一管理和分層調度功能。除支持設備層QoS調度功能外,還支持全鏈路QoS調度功能。

① 設備層QoS調度:為不同協議的控制報文配置DSCP和優先級一般高于業務報文;業務報文的調度功能支持多種PHB和著色配置,支持QoS多隊列調度算法和基于流量的帶寬控制,以便音視頻會議和云電腦等實時類業務獲得高比例帶寬保障。

② 全鏈路QoS調度:根據融合管控系統提供多維度選路計算、路徑編排功能,通過SRv6 Policy動態下發的控制指令,全鏈路設備在廣域層面實施流量在多條鏈路上調度,實現流量的負載均衡。管控系統通過QoS多優先級設置,為音視頻和云電腦等實時類業務動態計算最佳路徑,滿足低時延、低丟包和低抖動,對其他低優先級業務提供盡力而為的業務,即不保障時延和抖動。

傳統QoS方案一般基于端口帶寬調度,缺乏基于用戶區分業務質量的能力,即保證某類業務占用固定的傳輸帶寬,但往往造成更嚴重的網絡擁塞。該方式不適合園區出口帶寬受限情況下業務高峰時段的業務QoS管控需求,為此,本文所述的QoS調度方案通過設置優先級的應用服務端或客戶端的流量,以“優先”方式占用帶寬。

優先級函數PR的定義見式(1),應用可以由服務端IP地址,也可由客戶端的IP五元組、端口等信息確定。PR在網絡傳輸過程會映射成DSCP、EXP等不同協議值。

PR=Fun{丟包容忍度、時延容忍度、抖動容忍度}per 應用。

(1)

假設“優先級配置”定義了N個PR優先級,即PR1、PR2、…、PRn,并為每個PR設置帶寬百分比BW1、BW2、…、BWn。不在“優先級配置”的應用,采用盡力而為的傳輸帶寬控制方式,稱為BE隊列,而定義PR的應用采用“一定比例”的優先傳輸,即PR隊列。式(2)~式(4)分別定義PR隊列的帶寬百分比、每個優先級應用的帶寬百分比和BE隊列的帶寬百分比:

為避免BE隊列零帶寬的完全被搶占的局面,設置10%的保護帶寬,即BWbe最小值是10%,BWpr最大值是90%。

同時執行該配置的多優先級調度策略后,調度系統先后進入2個過程:

過程一:PR隊列的每個優先級應用的丟包率降到零。通過逐步提升BWpr梯度逐步逼近零丟包率,如設置2%上升梯度。

過程二:總丟包率不高于多優先級調度策略實施前。

① 設BE隊列的丟包率為LPbe,PR隊列的丟包率為LPpr,實時計算全部流量的總丟包率,并在一段時間內得到穩定平均值,有如下表達式:

LPgr=LPpr+LPbe。

(5)

② 若總丟包率高于前值,則判定優先級應用占用過多帶寬,嚴重擠占普通應用的傳輸帶寬,造成總體業務質量變差,因此,BWpr下降一個梯度,如2%,再執行更新的調度策略,直到總丟包率不高于多優先級調度策略實施前。

2.4 QoS策略的集中管控和自動化執行

滿足設備層QoS調度和全鏈路調度需求,網絡控制器作為端到端的集中管控設備,面向運維人員提供簡便易懂的策略信息設定和存儲等功能,具體如下:

① QoS和鏈路調度策略的集中存儲平臺,存儲包括預定義的各類業務對應的分類依據(比如五元組、識別規則)、鏈路需求(延時、抖動、丟包率等)、QoS標記值、PHB(或轉發動作)、限速策略、QoS調度策略、算路策略和路徑調度策略等信息。

② 提供業務基礎信息的錄入界面或API,以增加、修改、刪除業務信息。

③ 根據運維人員錄入的業務信息,自動實現端到端的QoS策略下發、更新或撤銷。

④ 運維自動化:面向運維人員的界面應盡量簡化、易于使用,使運維人員溝通簡單地勾選即可完成策略信息的設定。

此外,還將規劃異常流量處理機制,如通過API接口可與第三方安全系統對接,實現對網絡中的異常流量(比如攻擊流量)自動實施預定義的異常流量QoS策略,并通過郵件、短信等方式通知運維人員或異常流量源的資產責任人。

2.5 業務和流量可視化

(1)流量采集和可視化

為減少采集點,在WAN路由器如園區核心或出口路由器上采集設備特定接口上各種QoS標記的業務流量數據,以減少信令面負荷。

根據采集的流量數據,輸出實時和準實時的業務占比圖,包括各類流量的帶寬絕對值和占有比例、給定時間段(如5、10、30 min、2 h等)的流量動態變化趨勢曲線。

(2)全網流量拓撲和AI趨勢預測

在網絡設備性能允許的情況下,可支持采集全鏈路網絡設備的各種QoS標記的業務流量數據,并據此自動生成的流量拓撲,動態呈現全網各類流量的實時、準實時數據流圖。基于AI/大數據預測未來流量的演變趨勢,為網絡規劃、優化和擴容提供可靠依據。

3 方案試點和成效驗證

基于國內企業某園區的辦公和研發需求,員工使用客戶端通過運營商專線接入業務服務端所在異地城市DC核心節點。鑒于企業內網環境中,業務客戶端和服務端分屬不同城市的園區和DC,園區和DC通過運營商專線互聯,多用戶、多種業務融合度高,采用融合業務承載方案,同一種業務在多VPN網絡間穿梭,網絡控制器集中提供跨地域的業務端到端的QoS調度和流量管控能力,實現專線內QoS調度和跨專線的SRv6調度。試點網絡應用環境及拓撲示意如圖2所示。

圖2 試點網絡應用環境及拓撲示意Fig.2 Pilot network application environment and topology diagram

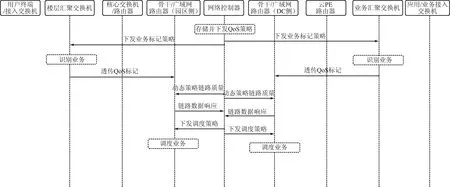

(1)QoS調度和流量管控的試點流程

為減少全鏈路設備的流量數據采集負荷,只在2處收集流量數據:上行在園區側出口路由器,下行在業務側骨干路由器。多業務QoS優先級和流量管控流程如圖3所示。

圖3 國內某園區接入異地DC的應用場景下QoS調度和流量管控流程Fig.3 QoS scheduling and flow control process in the application scenario of a domestic campus accessing a remote DC

① 網絡控制器配置、存儲并下發QoS調度和流量管控等策略,管控該園區上行流量并收集園區出口路由器的業務流量信息及業務側DC的下行流量并收集骨干路由器的業務流量信息;

② 分發業務標記策略到信任邊界的接入側和業務側的匯聚交換機設備,含業務側的服務源IP地址和接入側的源IP地址和端口信息;

③ 接入側匯聚交換機和業務側匯聚交換機根據IP地址和業務TCP/UDP端口號識別業務,進行QoS標記;

④ 匯聚交換機傳遞QoS標記到園區出口路由器和業務側網絡的骨干路由器;

⑤ 網絡控制器下發動態測量鏈路質量的指令,收集園區出口或骨干路由器的各種QoS標記的業務流量數據;

⑥ 網絡控制器向園區出口路由器和業務側骨干路由器下發QoS調度和流量管控策略;

⑦ 園區出口路由器和業務側骨干路由器向網絡控制器反饋業務流量數據,并根據下發的調度和管控策略完成業務調度和流量控制;

⑧ 網絡控制器輸出實時業務和非實時業務的流量可視化報告,運維人員可根據報告適時調整QoS調度和管控策略,更新網絡控制器的數據配置。

(2)設備簡介

① 樓層匯聚交換機:ZXR10 8902E交換機;

② 樓棟核心交換機:ZXR10 C69E-15交換機;

③ 園區核心路由器、骨干路由器、云PE路由器:ZXR10 M6000-3S PLUS;

④ 業務匯聚交換機:ZXR10 5960M-4M-HI交換機;

⑤ 網絡控制器:ZTE ZENIC ONE。

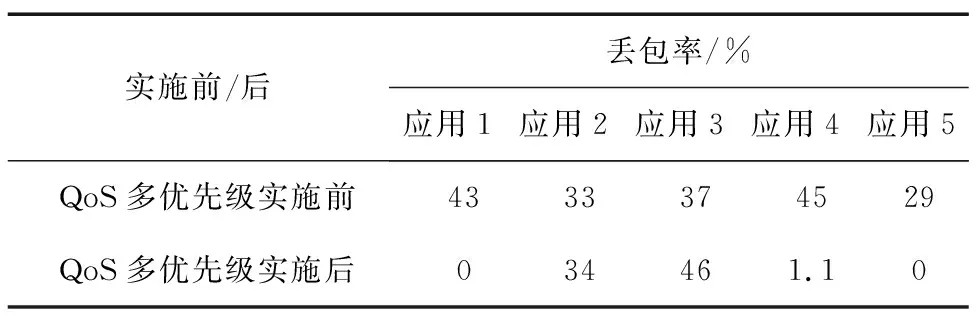

(3)成效驗證

從企業應用的實際出發,丟包率是核心性能指標,因此對本次試點方案的成效驗證,重點考察試點前后該項指標的優化情況。業務場景方面,選擇辦公場景下的音視頻會議、云電腦,研發調試場景下的研發測試和業務調試,以及園區監控場景下的監控和攝像頭業務。具體試點時,為辦公場景的音視頻會議和云電腦設置QoS多優先級管控策略,包括上行和下行的流量收集,QoS調度和流量管控。如表3所示,QoS多優先級實施前后,在總丟包率未升高的情況下,配置優先級的應用1、4、5的丟包率降或逼近到零,顯著改善時延敏感型業務在業務忙時的使用體驗。

表3 QoS多優先級方案實施前后的效果對比Tab.3 Comparison of effects before and after implementation of QoS multi-priority solution

4 結束語

企業IPWAN在IDC建設模式之下被劃分為DC內網絡和DC間網絡,然而作為企業各種應用的通信基礎設施,其實質是提供應用的客戶端和服務端之間信息傳輸功能。隨著企業應用上云比例快速提升,應用的服務端,即算力資源的主要消費方,使得IPWAN提供的信息傳輸功能可稱為“算力連接”——連接應用的服務端的算力。鑒于園區間專線帶寬價格昂貴,使得DC間的出口帶寬受限、網絡擁塞帶來時延敏感型業務體驗顯著下降,成為在業務高峰或忙時的常態。因此,提出一種面向企業WAN的算力連接和路由技術顯得必要。

一般而言,大中型企業的內網環境復雜,應用的客戶端和服務端分屬不同城市的園區和DC,園區和DC通過運營商專線互聯,多用戶、多種業務融合度高,往往采用融合多業務的統一承載方案,同一種業務在多VPN網絡間穿梭。

針對該場景,研究在園區出口帶寬受限條件下,對時延敏感型業務(音視頻會議、云電腦等)配置高優先級的QoS多優先級技術并進行可行性驗證和評估。區別于傳統設備層QoS調度技術受限于單點設備的不足,該創新技術結合網絡控制器的跨域融合和QoS管控增強、IP網絡流量和質量可視化等功能,實現園區內全網絡設備的QoS標識配置,接入節點業務流聚類,出口節點統一管控。還支持圖形化界面和批量化方式配置,實現園區接入的不同業務在跨園區范圍內的QoS優先級保障。

未來將參考算力連接的“有效性”、出口帶寬的“動態路由和多路由負載均衡”“彈性帶寬控制機制”等相關研究[14-16],基于網絡大數據建立流量預測模型,從而構建兼具網絡資源配置的敏捷性、資源縮擴容的自動預測和開通能力的下一代自智IP網絡[17-18],成為自動降本提效的自主進化企業網的新型底層基礎設施。