基于LL-GG-LG Net 的CT 和PET 醫學圖像融合

周 濤, 張祥祥*, 陸惠玲, 李 琦, 程倩茹

(1. 北方民族大學 計算機科學與工程學院, 寧夏 銀川 750021;2. 北方民族大學圖像圖形智能處理國家民委重點實驗室, 寧夏 銀川 750021;3. 寧夏醫科大學 醫學信息工程學院, 寧夏 銀川 750004)

1 引言

醫學圖像融合是指將來自不同技術的圖像融合成一幅融合圖像,從而最大限度地利用有用信息,減少冗余,與單一模態的醫學圖像相比,融合圖像所包含的紋理結構信息更加豐富,病灶更加明顯,減少圖像的不確定性和冗余信息,提高臨床適用性[1],從而能夠幫助醫生在許多臨床應用中進行綜合診斷、術前規劃、術中指導和介入治療[2]。由于成像方式不同,不同模態醫學圖像反應的器官結構信息也不同,如CT 成像利用X射線檢測骨骼和致密結構的信息,對骨骼的顯示很清晰[3],對病變的定位良好,但對病變本身的顯示相對較差,軟組織對比度有限。PET 圖像對軟組織、器官、血管等顯示清晰,有利于確定病灶范圍,但空間分辨率不如CT,對剛性的骨組織顯示差,并有一定的幾何失真[4]。多模態醫學圖像融合技術通過綜合不同模態醫學圖像之間的互補與冗余信息,為臨床疾病診斷與科學研究提供豐富的信息,可以有效輔助醫生對病灶進行診斷。

現有的圖像融合方法可分為傳統的融合方法和基于深度學習的融合方法,其中傳統融合方法大致可以分為:基于多尺度變換的方法[5]、基于稀疏表示(Sparse Representation,SR)的方法[6]、混合方法[7]和其他方法[8],這些方法通常需要手動設計特征提取機制和融合策略,如Li 等人[9]提出潛在低秩表示(Latent Low-Rank Representation,LatLRR)圖像融合方法,將源圖像分為低秩部分和顯著部分,有效保留邊緣輪廓信息。Li 等人[10]提出拉普拉斯再分解(Laplacian Redecomposition,LRD)醫學圖像融合方法,有效解決顏色失真、模糊和噪聲問題。這些方法仍然存在魯棒性不足、泛化能力弱、優化困難、需要更多計算資源和細節丟失等缺點。

基于深度學習的融合方法可進一步劃分為卷積神經網絡、編解碼網絡和生成對抗網絡的圖像融合方法:基于卷積神經網絡的圖像融合方法通過利用卷積運算強大的特征提取和重建能力來獲得更好的融合性能。Liu 等人[11]提出了一種用于醫學圖像融合的深度卷積神經網絡(Convolutional Neural Networks,CNN),使用連體卷積網絡生成權重圖,對源圖像的像素活動信息進行整合,并通過圖像金字塔以多尺度方式進行融合。Tang 等人[12]提出基于殘差編解碼細節保留交叉網絡(Detail Preserving Cross Network,DPCN),該網絡采用結構引導的功能特征提取分支、功能引導的結構特征提取分支,雙分支提取架構提取源圖像的功能信息和結構信息。但由于只有最后一層的結果被用作圖像特征,因此容易丟失中間層信息。基于編解碼網絡的圖像融合方法通過設計和訓練由卷積神經網絡構成的編碼器和解碼器得到融合圖像,有效地避免神經網絡深度對性能的影響,如DenseFuse[13],在編碼器中引入密集連接機制有效解決中間層信息丟失問題,Res2Net[14]將Resnet 模塊用于編碼器中,提高網絡的多尺度特征提取能力。DIFNet(Deep Image Fusion Net)[15]采用雙編碼器生成與高維輸入圖像具有相同對比度的輸出圖像。

EMFusion(Enhanced Medical Image Fusion Network)[16]通過表層和深層約束以增強信息保存,其中表層水平約束基于顯著性和豐富測量,深層約束是通過訓練編碼器定義的,有效解決了信息失真的問題。這些方法有效解決中間層信息丟失問題,但訓練過程中專注于圖像重建任務,無法正確的提取出融合所需要的顯著特征,忽略全局特征的提取。基于生成對抗網絡的圖像融合方法在生成器和鑒別器之間建立對抗博弈,可以無監督地估計目標的概率分布,從而以隱式方式實現特征提取、特征融合和圖像重建[17]。Ma 等人將GAN(Generative Adversarial Network)[18]引入圖像融合領域,提出一種名為FusionGAN 的融合方法。DDcGAN(Dual-Discriminator Conditional Generative Adversarial Network)[19]包含兩個鑒別器來驅動生成器融合源圖像特征信息,以保持與兩個輸入圖像之間的最大相似性。Zhang等人[20]提出了一種具有全尺度跳躍連接和雙馬爾可夫鑒別器(GAN with Full-scale skip connection and dual Markovian discriminators, GANFM)的生成對抗融合網絡,以充分保留源圖像中的有效信息,保留顯著對比度和豐富紋理。然而這些方法模型復雜,使得訓練過程不穩定,生成器和鑒別器之間的對抗不充分導致融合圖像失真。

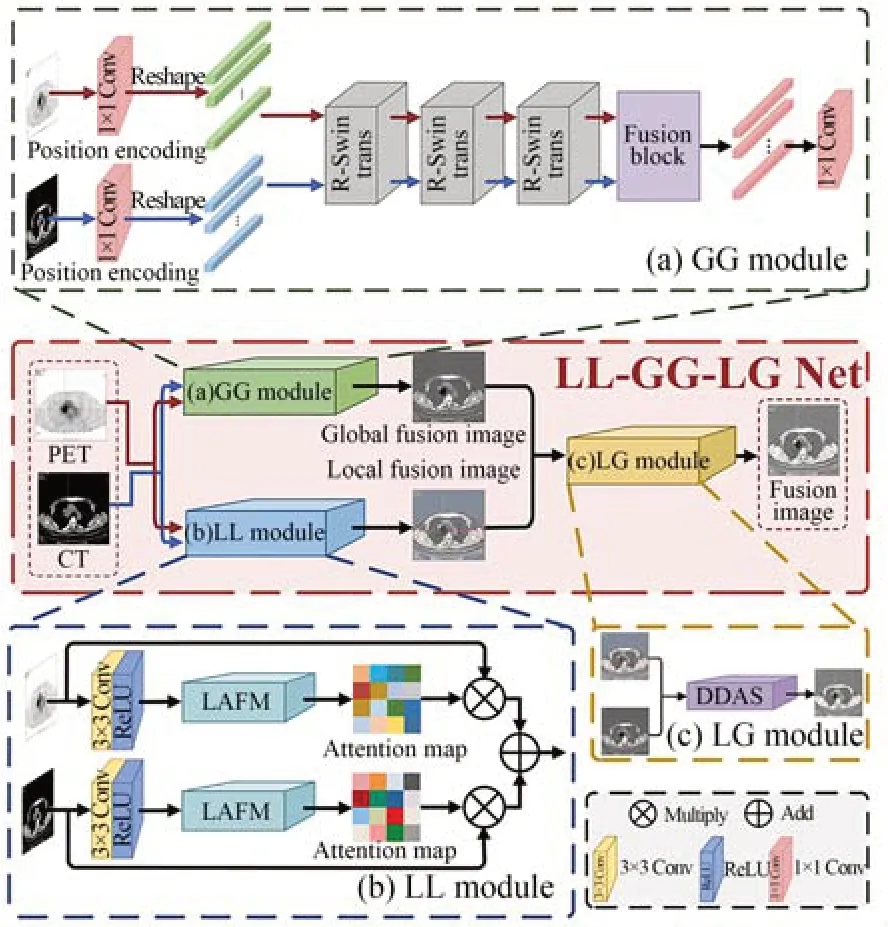

基于深度學習網絡的醫學圖像融合是近幾年的研究熱點。但是根據上述文獻報道以及醫學圖像的特點,現有融合模型還存在一些不足,從問題的角度來看,由于成像機制的不同,不同模態的醫學圖像側重于不同類別的器官或組織信息,存在周圍組織與病灶區域之間的模式復雜性和強度相似性問題;從方法的角度來看,由于卷積神經網絡有限的感受野,特征提取過程中主要關注圖像的局部信息,難以捕獲全局上下文語義信息,忽略全局特征與局部特征的交互。為此本文從問題角度出發,充分考慮CNN 網絡的特點,加強全局特征與局部特征的交互,提出一種用于PET 和CT 圖像的醫學圖像融合方法LLGG-LG Net,其主要貢獻是:(1)構造了用于提取局部-全局信息的三分支融合網絡,有效提取源圖像的局部信息和全局信息,增強局部-全局的信息交互能力;(2)設計了局部-局部融合模塊(Local-Local Fusion Module,LL Module),通過兩次空間注意力獲取PET/CT 的局部融合信息,生成局部融合圖像;(3)提出了全局-全局融合模塊(Global-Global Fusion Module,GG Module),通過在Swin Transformer 中添加殘差連接機制以提高全局信息的融合性能,生成全局融合圖像;(4)為了提高局部-全局信息的交互能力,進一步增強融合圖像質量,提出局部-全局融合模塊(Local-Global Fusion Module,LG Module),聚合局部融合圖像特征和全局融合圖像特征,使融合圖像病變區域顯著、細節豐富且魯棒性高。

2 LL-GG-LG Net 模型

本文提出用于PET 和CT 醫學圖像融合的LL-GG-LG Net 融合方法,該方法框架由局部-局部融合模塊(Local-Local Fusion Module,LL Module)、全局-全局融合模塊(Global-Global Fusion Module,GG Module)和局部-全局融合模塊(Local-Global Fusion Module,LG Module)三部分組成,首先將配準好的醫學圖像IPET,ICT分別經過LL Module 和GG Module,得到局部融合圖像FL和全局融合圖像FG,然后將FL和FG輸入到LG Module 中重建得到最終融合圖像FM。該方法有效解決背景和病灶區域相似度高,提取全局信息特征能力有限,局部-全局信息交互能力弱,難以有效保留病變區域復雜信息的問題。

2.1 LL-GG-LG Net 網絡結構

LL-GG-LG Net 網絡結構如圖1 所示,首先將源圖像轉換為卷積層的特征表示,并輸入LLGG-LG Net 網絡的局部-局部融合模塊分支中,通過空間注意力機制提取源圖像邊緣紋理信息,生成注意力圖,并將源圖像和生成的權重圖進行相乘操作,最后進行累加生成局部融合圖像;然后通過1×1 卷積將源圖像進行位置編碼,生成序列向量,并將其輸入到全局-全局融合模塊中,提取全局特征,采用L1-norm 融合規則生成全局融合圖像;最后,將雙分支融合網絡所生成的局部融合圖像和全局融合圖像采用局部-全局融合模塊進行圖像重構,提高局部-全局信息的交互,增強融合圖像質量。

圖1 LL-GG-LG Net 醫學圖像融合網絡Fig.1 LL-GG-LG Net Medical Image Fusion Network

2.2 局部-局部融合模塊(LL Module)

注意力機制通常根據源有特征圖設計一個權重分布,通過其權重分布區分每個區域的重要性,再將該權重分布施加到源特征圖上,抑制背景中的不同干擾,使得不同特征擁有不同權值,其中權值大的特征更加容易被注意到,因此在計算機視覺領域得到廣泛應用[21]。空間注意力機制[22]通過平均池化和最大池化獲得全局信息,但由于不同的信息表征,層次化特征的注意焦點有很大的不同,因此為了有效提取源圖像局部特征,本文設計了雙層注意力模塊提取局部細節信息,該模塊通過兩次平均池化和最大池化提取源圖像的邊緣和背景信息,用來凸顯像素層次上的重要空間位置特征,使得病變區域和骨骼紋理的邊界特征明顯。

雙層注意力模塊結構如圖2 所示。首先將源圖像轉換為卷積層的特征表示,并輸入空間注意力模塊中,空間注意力模塊首先通過平均池化層和最大池化層分別對輸入特征通道域上進行池化操作后再拼接在一起,得到2 倍通道特征圖,接著通過1×1 卷積將其壓縮為原通道,并再次通過平均池化層和最大池化層分別對輸入特征通道域上進行池化操作后再拼接在一起,得到深層特征圖,并通過3×3 卷積壓縮其通道,此外,為了補償在最后卷積層中的上采樣操作期間丟失的特征,本文使用卷積層的一個跳躍連接,在下/上采樣操作后,局部-局部融合模塊可以完全包含源圖像局部特征信息,最后通過sigmoid 激活函數歸一化空間權重信息,得到空間注意力權重圖M2i,最后將輸入特征圖Ii和權重圖M2i對應元素相乘,得到最終的局部融合圖像;局部-局部融合模塊公式如式(1)所示:

圖2 雙層注意力模塊Fig.2 Two-layer attention module

第一層局部特征信息表示:

其中:M1i表示第一層局部特征信息,Ii表示源圖像,i∈1,2,源圖像PET 圖像記為I1,源圖像CT記為I2,C1×1表示1×1 大小卷積核的卷積層。

最終權重圖表示公式如下:

其中:δ(·)表示Sigmoid 激活函數,C3×3表示3×3 大小卷積核的卷積層,生成最終的局部融合圖,公式表達為:

其中:IA表示最終生成的局部融合圖像,⊙表示點乘操作。

2.3 全局-全局融合模塊(GG Module)

CNN 通過利用卷積運算強大的特征提取和重建能力來獲取圖像特征并重建融合圖像,然而根據局部處理的原理,CNN 對遠程依賴建模的能力有限。Transformer[23]模型通過自注意力機制來捕獲上下文之間的全局交互信息,突出病變組織結構特征,但忽略了局部相關性對于病灶特征融合的重要性。因此,為了有效提高網絡全局感知能力,保留病變區域的有效特征,本文使用全局-全局融合模塊,該模塊在Swin Transformer中添加殘差連接機制(Residual-Swin Transformer Module,RSTM)有效聚合不同層次的特征,彌補了Transformer 對病變區域特征提取弱的問題,提高Transformer 在全局特征提取過程中關注病變局部特征的相關性,并采用L1-norm融合規則生成全局融合圖像。

全局-全局融合模塊內部結構如圖1(a)所示,本文首先將輸入圖像Ii∈RH×W×3(其中H、W和3 分別表示其高度、寬度和通道大小,i=1 表示源圖像PET 圖像,i=2 表示源圖像CT 圖像),首先采用1×1 卷積操作對源圖像進行位置編碼,并將特征維度映射到維度C,C設置成96,生成序列向量=1 表示源圖像PET圖像,i=2 表示源圖像CT 圖像),然后應用三個R-Swin Transformer 塊提取全局特征,其表達公式如下:

其中:RSTBm表示第m個R-Swin Transformer塊,通過以上操作,提取PET 和CT 圖像的全局特征,然后,采用基于行向量維數和列向量維數的L1-norm 融合規則進行特征融合,得到融合的全局特征FG,其公式表示為:

其中:HNorm表示L1-norm 融合操作,最后使用卷積層重構融合圖像IF,其公式為:

其中:HConv表示特征重構卷積操作,該卷積為1×1 卷積,padding 設置為0。

2.3.1 R-Swin Transformer 模塊

圖3(a)展示了R-Swin Transformer 模塊(Residual-Swin Transformer Module,RSTM)的體系結構,它包括一系列STL 以及殘差連接,給定輸入序列向量,本文應用n個STL 來提取中間全局特征(i=1 表示源圖像PET 圖像,i=2 表示源圖像CT 圖像),RSTM 的最終輸出由式(7)計算:

圖3 R-Swin Transformer 模塊結構Fig.3 R-Swin Transformer module structure

其中:HRSTBn表示第n個STL。類似于CNN 的架構,多層Swin Transformer 可以有效地對全局特征進行建模,殘差連接可以對不同層次的特征進行聚合。

如圖3(b)所示,STL 由多頭自注意(Multiheaded Self-attention,MSA)和多層感知器(Multiple perceptron,MLP)組成。此外在每個MSA 模塊和每個MLP 之前都會應用LN(LayerNorm)層,并且在每個模塊之后采用殘差連接,因此可以將Swin Transformer 中的第l層的輸出表示為:

由于W-MSA 的窗口之間相互作用較弱,為了在不增加計算量的情況下引入跨窗口交互,Swin Transformer 則在W-MSA 結構之后添加了SW-MSA 模塊,該模塊的窗口配置與W-MSA 不同,其通過向左上方向循環移動來開發高效的批處理方法,在此移動之后,批處理窗口可以由特征圖中的多個不相鄰窗口組成,同時在W-MAS中保持相同數量的批處理窗口作為規則劃分。W-MSA 和SW-MAS 中保持相同數量的批處理窗口作為規則劃分。W-MSA 和SW-MSA 在局部窗口內進行自注意計算時,在計算相似度時都考慮了相對位置偏差。

利用這種移位窗口劃分機制,SW-MSA 和MLP 模塊的輸出可以寫為:

其中:WQ,WK和WV∈RD×d是跨不同窗口共享的三個線性投影層的可學習參數,Q,K.V∈RL×d為查詢矩陣、鍵矩陣、值矩陣,d表示查詢或的維度,B∈RL×L表示相對位置偏差。

2.3.2L1-norm 融合規則

基于L1-norm 的PET 和CT 圖像序列矩陣的融合策略,并測量了它們的行和列向量維的活躍度。本文將PET 和CT 的全局特征分別定義為(i,j)和(i,j),首先使用L1-norm 計算它們的行向量權重,通過Softmax 函數獲得它們的活躍度,即HPETr(i)和HCTr(i),它們由以下方程表示:

同理,從列向量維測量其活躍度,并將PET和CT 圖像的列向量活躍度分別記為HPETl(j)和,它們由以下公式表示:

然后,得到列向量維的融合全局特征,并將其稱為Fcol(i,j),它由以下方程表示:

對融合后的全局特征在行向量維和列向量維度上進行逐元加法運算,得到最終的融合全局特征,其計算公式如下:

最后利用融合后的全局特征通過卷積層重建全局融合圖像。

2.4 局部-全局融合模塊(LG Module)

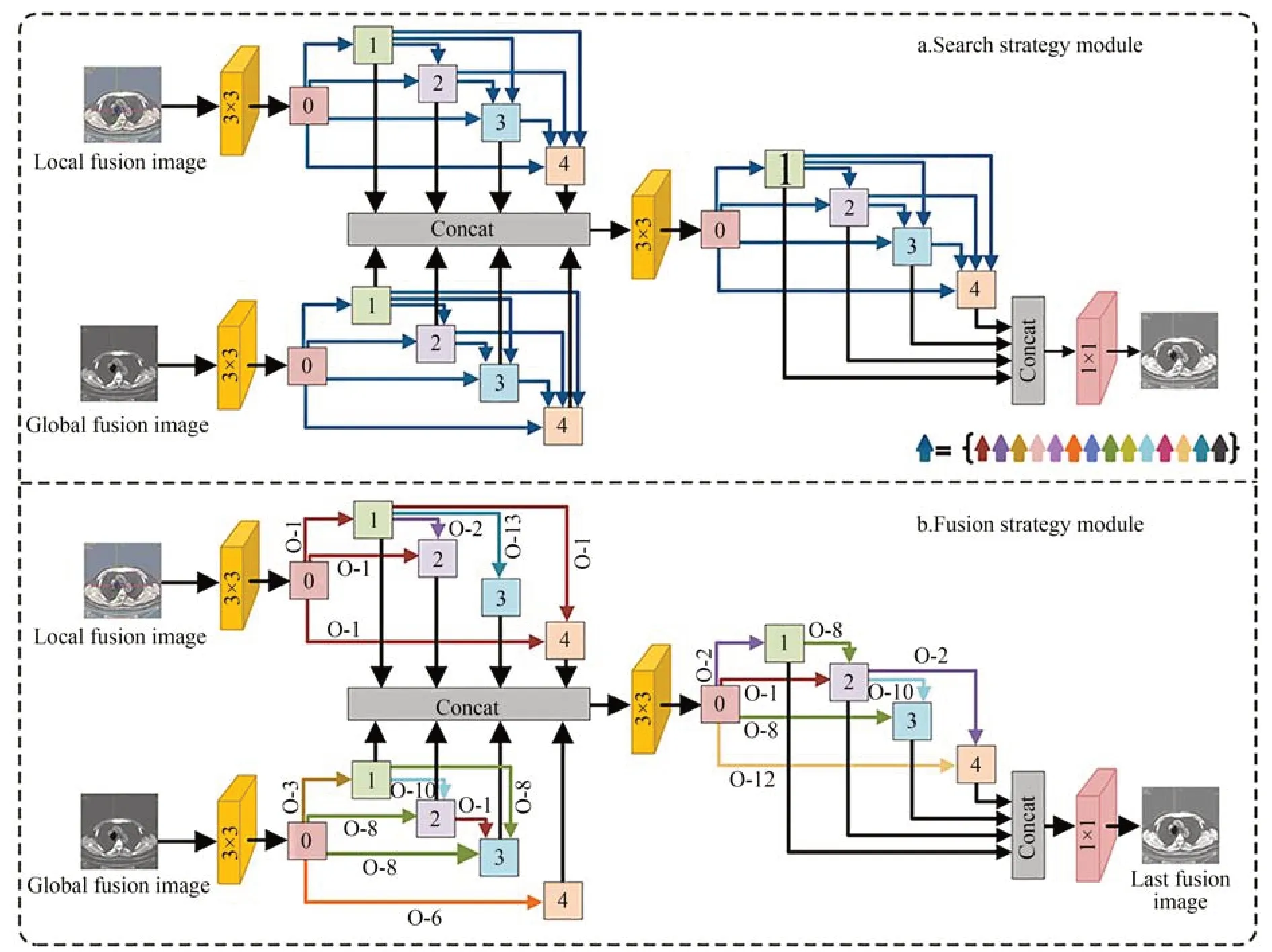

由于不同病變區域的形狀和大小均不同,導致網絡在提取邊緣和紋理信息的同時,難以保留病變特征,使得模型在關注局部病變特征的同時難以進行病灶空間定位,因此本文通過添加局部-全局融合模塊進行全局信息和局部信息的交互融合。根據密集網[24]的特性,即每一層的輸出將級聯到下一個輸入,使得網絡能夠更好地保留每一層提取的特征,增強了特征提取能力,有效保留局部信息特征和全局信息,本文引入密集網絡進行最后一步融合。此外受神經網絡架構[25]的啟發,考慮到輸入圖像特征不同,所需提取的信息也有所差異,相同的特征提取操作,難以兼顧不同源圖像的特征,因此本文設計基于神經網絡架構搜索策略訓練的密集網進行局部-全局信息融合,為了降低計算成本,提高網絡的性能和效率,本文采用可微分神經網絡架構[26]自適應的構建和搜索以學習最佳密集網絡架構(Darts:Differentiable Architecture Search,DDAS),保留局部融合圖像和全局融合圖像的差異信息,解決融合圖像噪聲和背景與病灶區域相似度高問題。

DDAS 模塊結構如圖4 所示。首先,采用搜索策略模塊訓練密集網絡,預定義了三個相同的密集連接網絡,每個網絡都包含五個節點的非循環圖,即0,1,2,3,4,其中每個節點表示一組特征圖,第一個節點由先前3×3 卷積操作得到的特征圖作為輸入節點,每個節點的輸出都級聯到后續所有節點的輸入,本文將局部融合圖像和全局融合圖像分別輸入到密集網中,根據融合策略自適應的訓練網絡,經過訓練選出最終的融合網絡架構,如圖4 所示,將局部融合圖像和全局融合圖像分別輸入到已經訓練好的密集網中,進行特征提取和重構操作,生成最終的融合圖像,實驗表明該方法有效解決噪聲問題以及背景和病灶區域相似度高問題。

圖4 DDAS 模塊結構Fig.4 DDAS module structure

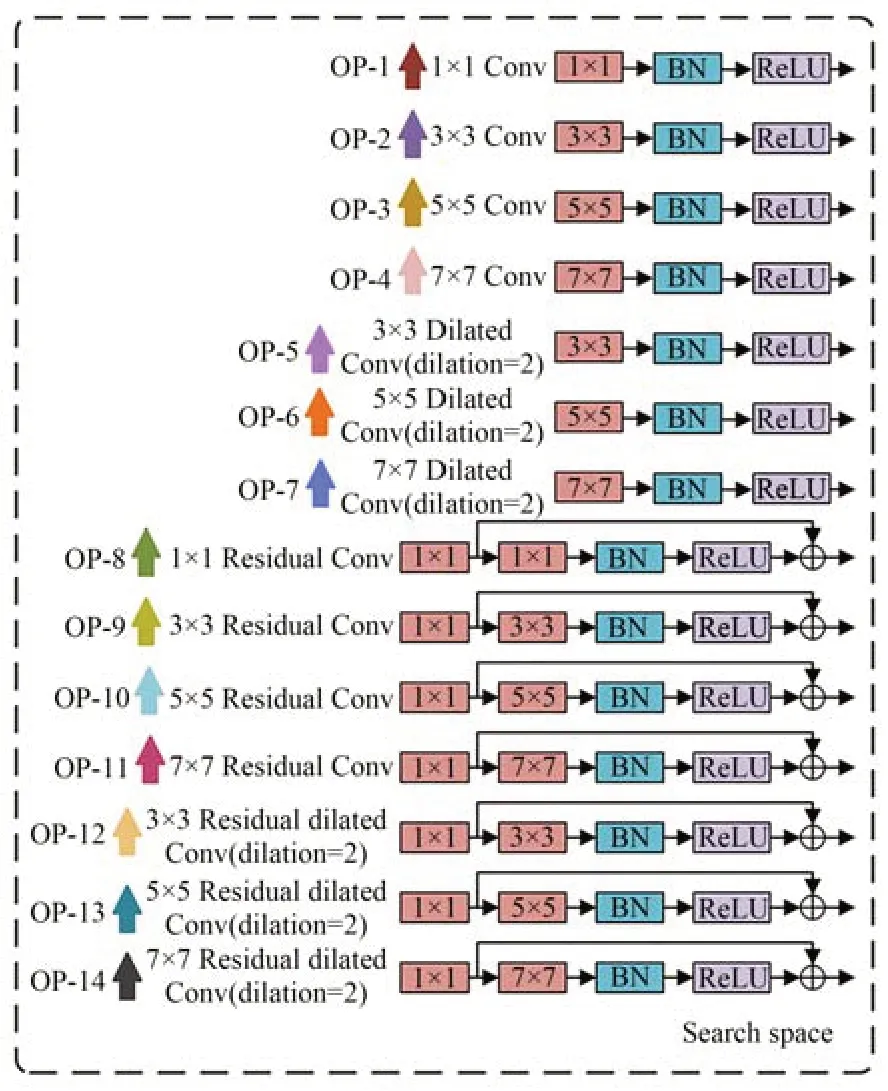

2.4.1 搜索空間

本文搜索空間0 選擇如圖5 所示(彩圖見期刊電子版),其中運算集合0(·)主要包括1×1 卷積、3×3 卷積、5×5 卷積、7×7 卷積、3×3 擴張卷積、5×5 卷積、7×7 擴張卷積、1×1 殘差卷積、3×3 殘差卷積、5×5 殘差卷積、7×7 殘差卷積、3×3 擴張卷積、5×5 殘差擴張卷積、7×7 殘差擴張卷積等14 種操作,并以不同顏色箭頭進行標注。

圖5 搜索空間模塊結構Fig.5 Search space module structure

2.4.2 搜索策略

本文采用的可微搜索策略,具體結構如圖4所示,首先預定義了三個相同的單元組成網絡,每個單元包含五個節點的非循環圖,即0,1,2,3,4,其中每個節點表示一組特征圖,第一個節點由先前3×3 卷積操作得到的特征圖作為輸入節點,中間節點j與前身節點i之間的信息流由邊E(i,j)連接,中間節點是其先前邊的輸出總和,其表示為Nj,公式表達如下:

中間節點是其先前邊輸出的總和,而輸出節點則是通道維度中所有節點的串聯,其表示為:

其中:搜索空間0 表示候選運算O(·)集合,表示歸一化結構參數,Xi表示第i個節點,體系結構搜索的任務歸結為學習變量,在搜索結束時,可以通過用最有可能的操作替換每個混合操作,進而獲得離散結構,即(在集合0 中選取一個子操作使得最大)。

在搜索階段,本文需要解決一個雙層優化問題,本文使用LTrain和LVal分別表示訓練和驗證損失,這兩個損失由α和w確定(α表示三個單元的體系結構,w表示網絡的權重,*表示最優權重),其中體系結構的目標是找到α*,使得LVal(w,α*)損失最小化;找出w*使得LTrain訓練的損失最小,即w*=argminw LTrain(w,w*)。

為了簡化訓練搜索任務,添加了特殊的空操作,及兩個節點之間缺少連接;經訓練選出一組最合適的融合架構,具體結構如圖5 所示,其中0,1,2,3,4 五個節點之間的操作均采用不同顏色,其顏色與搜索空間顏色相對應,并對應其具體操作。

3 實驗結果與分析

3.1 實驗設置

數據集選用2018年1 月至2020年6 月在寧夏某三甲醫院核醫學進行PET/CT 全身檢查的肺部腫瘤臨床患者,以圖像質量符合分析要求(圖像質量清晰、無偽影、病灶可見),患者未接收射頻消融,肺切除治療,且病理報告完整詳細為實驗納入標準,有95 名符合實驗入選條件的患者納入實驗,身高不限,其中包括女性46 例(占48%),年齡30~80 歲,平均年齡(54.32±4.21)歲。男性49 例(占52%),年齡27~74 歲,平均年齡(50±5.11)歲。患者禁食6 h,控制血糖10 以下,顯像前排尿,去除金屬飾物。靜脈注射氟[18F]脫氧葡萄糖注射液(18F-FDG)3.7 mbq/kg,注射完顯像劑一小時后在安靜、避光的房間平臥45~60 min 進行肺部及軀干部PET-CT 圖像采集,掃描完成取橫斷面、矢狀面與冠狀面圖像。數據集圖像標準化攝取值≥2.5 為陽性,采用GE公司Discovery MI 型PET/CT 機進行掃描檢查。所有CT 掃描均固定電壓在120 kV、電流在90~200 mA 進行曝光,Thick 為3.75 mm,Iterval 為3 270,SFOV 為Large,DFOV 為50 cm,Recon-Type 為std,操作者均為多年從事CT 及核醫學工作的資深技術人員,為確保對病變進行正確標注,為確保數據準確性,本次數據由三位專家醫生結合臨床綜合診斷,進行評估,結果以多數人意見為準,三位專家醫生包括一位具有8年臨床經驗的胸外科醫生,一位具有5年臨床經驗的呼吸內科醫生,一位影像科專業醫生。數據集經旋轉、鏡像的數據增強與數據增廣處理,三種模態圖像數據集的最終樣本數分別為2 430 張,其中選取1 000 張CT 與PET 圖像作為訓練集,200 張作為驗證集,200 張作為測試集,圖像標簽由兩位臨床醫師手動繪制。原始圖像格式為DICOM 格式,掃描層厚為7 mm,由于融合結果的效果還受到灰度不均勻性、偽影等因素的影響,且原圖像直接輸入網絡會造成訓練困難,因此有必要對圖像進行預處理使網絡實現更好的融合效果。本文用算法將數據讀取之后轉換為JPG 格式,并進行Resize 操作,將其變為356 pixel×356 pixel。

實驗室硬件環境服務器Intel(R) Xeon(R)Gold6154 CPU,內存256 GB,顯卡NVIDIA TITANV, 實驗環境框架采用pytorch,python 版本為3.7.0,CUDA 版本為11.1.106。 訓練時Batchsize 被設置為4,訓練150 個epoch,選擇學習速率為1e-4 的Amda 優化器。

3.2 對比實驗

為了驗證LL-GG-LG Net 的有效性,選取兩種基于分解變換的融合方法,五種基于深度學習的圖像融合網絡,對CT 圖像和PET 圖像的融合結果進行比較。方法一:LATLRR 變換[9]。方法二:LRD[10]。 方法三:DPCN[12]。 方法四:Res2Net[14]。方法五:DIFNet[15]。方法六:EMFusion[16]。方法七:DDcGAN[19]。以上五種基于深度學習的圖像融合網絡的參數值設置為其作者指定的默認值。本文從定性與定量兩個方面評價本文方法的有效性。

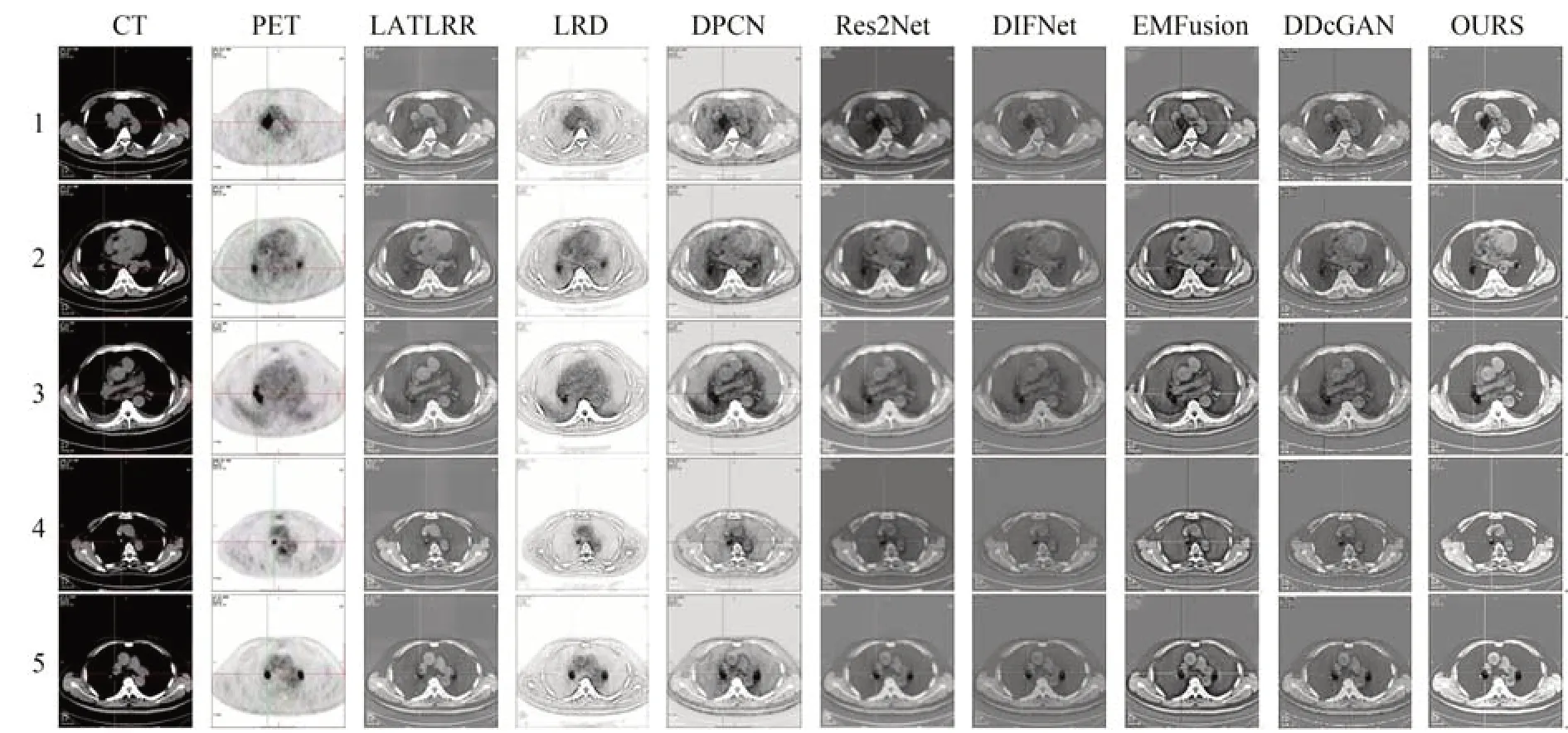

3.2.1 定性比較

圖6 展示了本文提出的方法與上述七種比較方法的融合結果圖,針對CT 縱膈窗和PET 圖像融合進行了主觀對比實驗,可以看出LATLRR結果展示圖中融合結果比較模糊,病灶部位輪廓顯示不清;LRD 方法融合的圖像中細節丟失嚴重,影響醫生對疾病信息的識別;Res2Net 增強了邊緣信息,但融合圖像未能保持適當的亮度,病灶骨骼信息模糊;DIFNet 融合方法雖然增強了對比度,但圖像亮度過高影響視覺效果,且具有一定的噪聲;DPCN,DDcGAN 和EMFusion 方法可以突出病變區域信息,但融合后的圖像對比度較低,邊緣信息模糊。相比之下,本文方法能夠有效保留源圖像的邊緣細節及輪廓特征,病變區域的信息也更加豐富完整,有效解決背景與病灶區域之間的模式復雜性和強度相似性問題,方便醫生的觀察。

圖6 不同方法主觀對比融合圖像Fig.6 Subjective comparison of fused images by different methods

3.2.2 定量比較

為了客觀且全面的評價模型的融合性能,同時便于與其他算法進行比較,本文從融合圖像細節信息豐富度,清晰度、邊緣保留程度、邊緣信息量、紋理信息多個角度評估融合性能,選取以下六種常見評價指標進行比較:平均梯度AG、邊緣強度EI、邊緣信息傳遞因子QAB/F、空間頻率SF、標準差SD、信息熵IE。以上指標值越大,性能越好。

(1)平均梯度。

平均梯度(Average Gradient, AG)反映了融合圖像的細節和紋理信息。該數值越大,融合圖像信息越豐富,融合性能越好。公式如下:

其中:M和N分別代表融合圖像的高度和寬度,F(i,j)表示圖像的第i行第j列像素值。

(2)邊緣強度。

邊緣強度(Edge Intensity,EI),邊緣強度越大,融合圖像質量越高。公式如下:

其中:M,N為圖像的寬高;hx,hy為x和y方向的Sobel 算子;Sx和Sy為Sobel 算子卷積后的結果。

(3)基于邊緣的相似性度量QAB/F。

QAB/F衡量融合圖像保留源圖像的邊緣信息數量,計算得到的QAB/F的取值范圍為[0,1],其值越接近0,表示損失的邊緣信息越多;該值越大,表示融合性能越好。設圖像A,B,大小為n×m,融合圖像為F,邊緣信息保持度QAF(i,j)和QBF(i,j),分別用WA(i,j)和WB(i,j)進行加權,得到融合圖像F相對于圖像A 和圖像B 的邊緣保持度。公式如下:

其中:W是固定大小的滑動窗口,0 ≤QAB/F(i,j)≤1。QAB/F的值越高,融合圖像保留源圖像的邊緣信息越豐富。

(4)空間頻率。

空間頻率(Spatial Frequency, SF)反映圖像的整體清晰度,空間頻率越大,融合圖像包含的邊緣和紋理信息越豐富,融合性能也就越好。公式如下:

其中:RF,CF分別表示空間行頻率和空間列頻率,M和N分別表示融合圖像的高度和寬度,I(i,j)表示圖像的第i行第j列像素值。

(5)標準差。

標準差(Standard Deviation, SD)衡量信息的豐富程度,標準差越大,圖像的灰度級分布越分散,圖像的信息量越多。公式如下:

其中,μ表示均值,反映亮度信息。

(6)信息熵。

信息熵(Information Entropy, IE)衡量圖像中所包含的信息數量。公式如下:

其中:l表示圖像的灰度等級,Pl表示融合圖像中相應灰度級的歸一化直方圖。

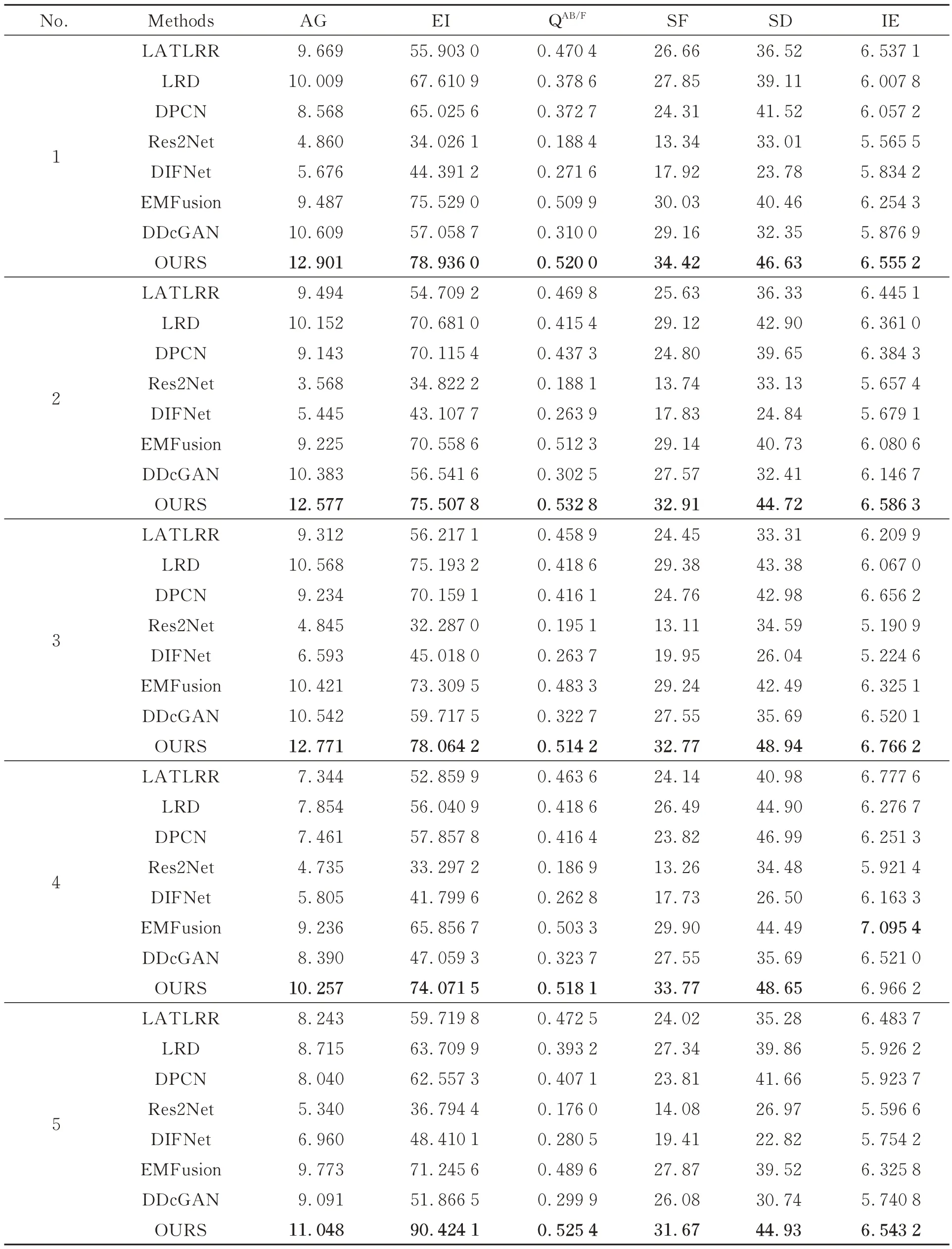

本實驗采用測試數據集的200 對CT 和PET圖像分五組,根據對比的七種融合方法以及本文方法生成融合圖像,表1 展示了在不同指標上每組圖像不同融合方法融合結果的平均值。

表1 客觀評價指標均值Tab.1 Mean value of objective evaluation metrics.

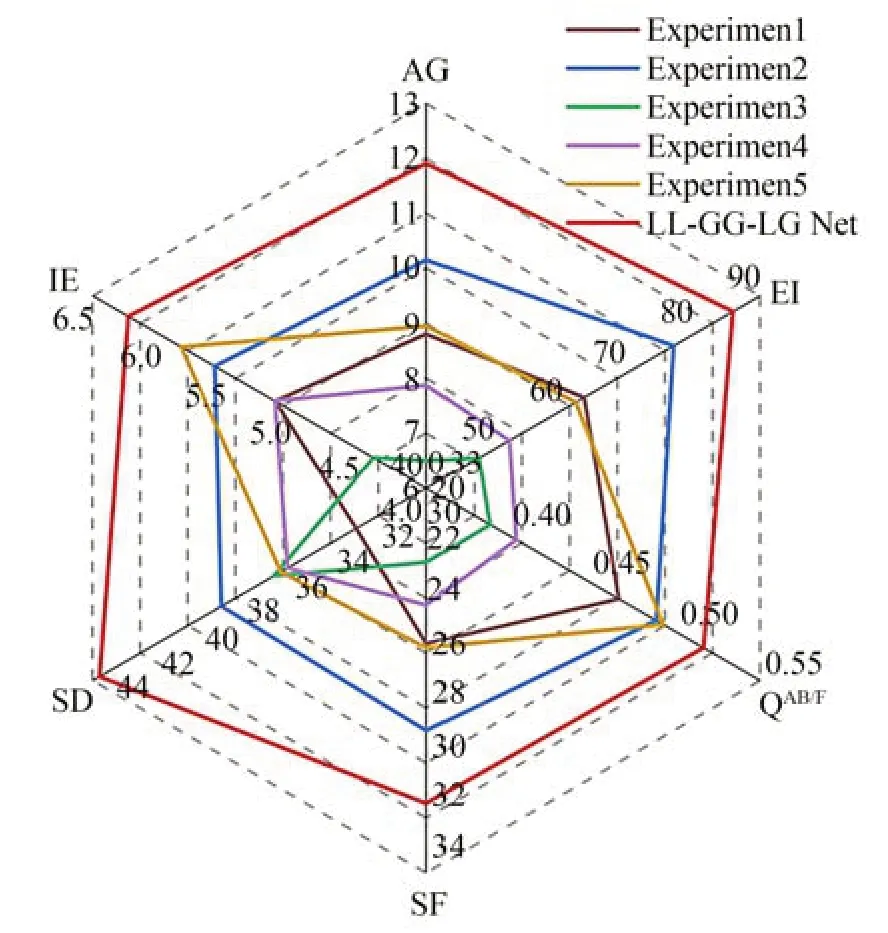

在表1 和圖7 中可以看出,本文方法的空間頻率(SF)和標準差(SD)明顯高于其他七種方法,說明本文方法融合清晰度高,凸顯了PET 圖像的病灶區域特征,AG,EI,QAB/F、IE 評價指標上,本文方法與其他七種方法相比有很大提升,說明本文方法保留邊緣細節信息能力較好,融合圖像病變區域信息豐富。

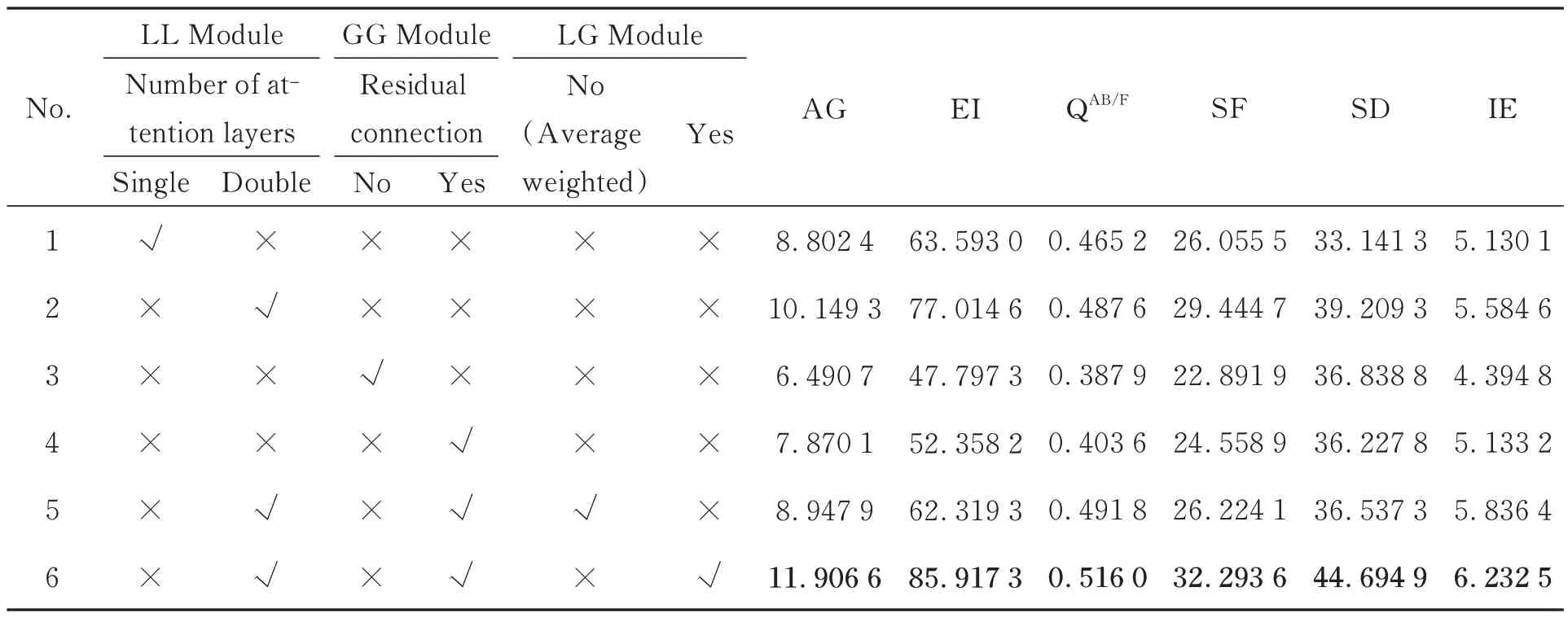

3.3 消融實驗

為了驗證LL-GG-LG Net 模型中局部-局部融合模塊(LL Module)、LL Module 中兩層空間注意力模塊、全局-全局融合模塊(GG Module)、GG Module 中Swin Transformer 添加的殘差連接和局部-全局融合模塊(LG Module)的有效性,本文設計了六組消融實驗來進行對比,實驗1 是僅保留一層注意力機制的LL Module,用來驗證雙層注意力機制對局部特征提取能力的影響。實驗2 在整體網絡中去除GG Module 和LG Module,僅采用LL Module,用來驗證LL Module 對圖像融合中的影響。實驗3 是僅保留Swin Transformer 中去除殘差連接機制的LL Module,用來驗證殘差連接機制對病變區域特征提取的影響。實驗4 在整體網絡中去除LL Module 和LG Module,僅使用GG Module,用來驗證其對融合圖像全局特征保留的影響。實驗5 在整體網絡中去除LG Mode,將LL Module 生成的局部融合圖像和GG Module 生成的全局融合圖像采用像素加權平均的方法進行融合,用來驗證LG Mode 對圖像融合中細節保留以及對比度的影響。實驗6 是本文融合方法。具體如表2 所示。表中√表示實驗中添加此創新模塊,×表示沒有添加此創新模塊。

表2 消融實驗客觀評價指標均值Tab.2 Mean value of objective evaluation metrics for ablation experiments

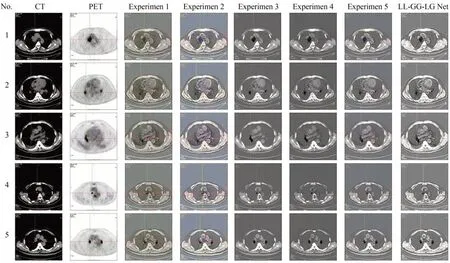

圖8 展示了消融實驗與本文方法在五組PET 和CT 醫學圖像融合后的定性對比效果,表2 為六組圖像在不同客觀評價指標上的平均值,實驗1 的融合效果病灶明顯且對比度高,但整體對比度較差,輪廓信息不明顯,丟失了一定的邊緣信息。實驗2 相比實驗1,AG 增加了15%,SF提升了13%,融合得到的圖像整體對比度較好,證明兩層注意力網絡能夠有效保留細節信息和邊緣信息。實驗3 的融合圖像相比較實驗2,病灶信息更加清晰,但是忽略了邊緣輪廓信息。評價指標SD 增加了10%,整體對比度明顯提高,但從AG,EI,SF 和SD 指標值來看,實驗4 與實驗3相比,評價指標AG 提高了21%,IE 提高了16%,說明R-Swin Transformer 有效保留了源圖像細節內容。實驗5 在視覺上突出了病灶區域信息,且邊緣信息豐富,但在評價指標上略低。本文方法相比實驗2 在評價指標AG 上增加了17%、EI提上了11%、IE 提升了10%、SD 增加了14%、相比實驗5 在QAB/F提升了4%,說明LG Module 能夠充分保留圖像的邊緣和紋理信息,保留豐富細節信息,并對圖像的降噪以及區分背景和病灶區域相似度發揮了良好的作用。

圖8 消融實驗定性比較Fig.8 Qualitative comparison of ablation experiments

表2、圖8 和圖9,更能堅信本文所提出的局部-局部融合模塊(LL Module),全局-全局融合模塊(GG Module)和局部-全局融合模塊(LG Module)相結合方法有效的結合了全局特征和局部特征,從各項數據的結果中更加體現了對源圖像分別提取局部特征和全局特征并進行局部-全局信息交互融合的方法在多模態醫學圖像融合的優勢。

圖9 消融實驗雷達圖Fig.9 Radar map of ablation experiments

4 結 論

針對多模態醫學圖像融合捕獲全局特征能力有限,忽略了全局和局部特征關聯性,周圍組織與病變區域之間的模式復雜性和強度相似性的問題,本文提出面向PET 和CT 醫學圖像融合的LL-GG-LG Net 模型。首先為了有效保留邊緣和紋理等特征,局部-局部融合模塊進行局部特征的提取融合。此外,設計了R-Swin Transformer 模塊保留病灶部位復雜信息。最后,采用局部-全局融合模塊聚合全局特征和局部特征,有效保留紋理邊緣等全局信息與局部病變區域。使用臨床數據集對本文提出的方法進行驗證,實驗結果表明LL-GG-LG Net 在AG,EI,QAB/F,SF,SD,IE 6 種評價指標上分別平均提高了21.5%,11%,4%,13%,9%,3%。7 組對比實驗表明本文所提出的模型能夠計算圖像全局關系的同時關注病變區域局部特征,二者互為補充相互融合,使得融合圖像能夠突出病變區域信息,結構清晰且紋理細節豐富,為醫生的輔助診斷,提高術前準備工作效率提供了有效幫助。