基于ClothResNet模型的人體衣物顏色識別

黃玥玥, 陳 曉, 王海燕, 姚海洋

(陜西科技大學(xué) 電子信息與人工智能學(xué)院, 陜西 西安 710016)

人體衣物外觀對個體具有強烈的表征意義,其對社會生活多個方面有著廣泛且深刻的影響。在時尚領(lǐng)域,顏色作為服裝感知的最主要特征,可鮮明地表現(xiàn)人類情感,塑造迥然不同的形象[1];在電商領(lǐng)域,顏色搭配對服裝的銷售具有重要影響[2-4];在安全領(lǐng)域,利用大量交叉監(jiān)控視頻搜索人物時,外部衣物屬性作為重要的識別特征,可聯(lián)合實現(xiàn)更準(zhǔn)確地實時人物捕捉與分析[5-7],因此,如何高效、準(zhǔn)確地識別人體衣物屬性受到多個領(lǐng)域的廣泛關(guān)注。

傳統(tǒng)人體衣物顏色識別方法基于手工特征結(jié)合分類器,手工設(shè)計衣物各種特征并從背景中分離出來,然后利用機器學(xué)習(xí)方法K-means[8]、Mean shift[9]等作為離散數(shù)據(jù)的聚類算法,通過重建衣物的顏色空間數(shù)據(jù)提高對衣物顏色的識別。這些方法通常用手工判定邊界方式,會消耗大量的人工成本,且當(dāng)圖像背景顏色與服裝顏色相似時,識別算法會將其顏色聚為一類,導(dǎo)致對衣物顏色識別精確率過低。基于深度學(xué)習(xí)的衣物顏色識別,采用端到端的深度神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),通過聯(lián)合優(yōu)化將特征提取和分類器合并成統(tǒng)一的框架,使得識別模型更能表征數(shù)據(jù)特點。如Ivanov等[10]設(shè)計了以LeNet為基本網(wǎng)絡(luò)結(jié)構(gòu)的模型,可自動提取圖像中人體衣物特征,但該方法識別精確率僅達(dá)到78%。Roy[11]利用YOLOv3和殘差網(wǎng)絡(luò),有效提取了圖像中衣物的位置信息,利用DeepFashion[12]數(shù)據(jù)集進(jìn)行訓(xùn)練,實現(xiàn)了服裝的邊框回歸檢測;通過在測試數(shù)據(jù)集中進(jìn)行衣物顏色的識別驗證,準(zhǔn)確度達(dá)89%。Chen等[13]提出一種改進(jìn)卷積神經(jīng)網(wǎng)絡(luò)(CNN)用于對紅、綠、藍(lán)及黑色4種衣物顏色識別,獲得了92.52%的平均精確率。由以上總結(jié)可知,已有方法僅對少數(shù)衣物顏色可實現(xiàn)較準(zhǔn)確的識別,無法適用于真實情況特別是顏色受到嚴(yán)重扭曲的狀況,且多數(shù)方法均只針對單一場景,無法適應(yīng)復(fù)雜變化的環(huán)境。

針對以上問題,本文提出基于ClothResNet模型的人體衣物顏色識別方法,采用端對端的技術(shù)實現(xiàn)對衣物輪廓的自動提取,最終實現(xiàn)人體衣物顏色的識別,克服了手動分離衣物的繁瑣性,有效提高了衣物顏色識別的準(zhǔn)確率,實現(xiàn)了對多種人體衣物顏色高效、準(zhǔn)確識別的目的。

1 實驗部分

1.1 人體衣物標(biāo)注數(shù)據(jù)集的構(gòu)建

為訓(xùn)練針對人體衣物顏色識別的ClothResNet網(wǎng)絡(luò)模型,需要構(gòu)建一個大規(guī)模的人體衣物顏色標(biāo)注數(shù)據(jù)集。本文選擇活動模板回歸(active template regression,ATR)[14]數(shù)據(jù)集中的部分圖像進(jìn)行衣物分割、標(biāo)注、擴(kuò)充,構(gòu)建了專門用于人體衣物顏色識別的數(shù)據(jù)集,命名為pcaparsing(people clothes attribute parsing)。該數(shù)據(jù)集包含紅、橙、黃、綠、青、藍(lán)、紫、白、黑、棕、粉和灰12種顏色的衣物,每個樣本包括原始彩色圖像和對應(yīng)的掩碼圖。掩碼圖是通過在原始彩色圖像上分割提取衣物輪廓,并在對應(yīng)位置標(biāo)注其所屬顏色獲得的。圖1示出pcaparsing中示例圖片。

圖1 樣本集示例圖片F(xiàn)ig.1 Sample image of dataset.(a) Sample 1;(b)Sample 2;(c) Sample 3;(d) Sample 4

由于ATR數(shù)據(jù)集中可用于網(wǎng)絡(luò)訓(xùn)練的圖像數(shù)據(jù)僅有5 639張,且顏色分布不均勻,導(dǎo)致模型難以學(xué)習(xí)到少量屬性的全部特征,增大了模型訓(xùn)練的難度;因此,本文對原始數(shù)據(jù)進(jìn)行了擴(kuò)充,以防止神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)到不相干的模式,從根本上提升了網(wǎng)絡(luò)的泛化性能和對衣物屬性的識別性能。本次數(shù)據(jù)擴(kuò)充主要針對顏色數(shù)量較少的數(shù)據(jù)進(jìn)行處理,采用的數(shù)據(jù)增強方式包括裁剪、上下移動、水平翻轉(zhuǎn)和垂直翻轉(zhuǎn)等。通過數(shù)據(jù)擴(kuò)充,每種顏色的圖像數(shù)量均達(dá)到了 1 000 張左右,從而在數(shù)據(jù)集中保持了每種類別的圖像數(shù)量呈現(xiàn)均勻分布。圖2示出數(shù)據(jù)擴(kuò)充后的輸入數(shù)據(jù)和對應(yīng)的標(biāo)注圖示例。

圖2 數(shù)據(jù)擴(kuò)充示例Fig.2 Data expansion example

1.2 ClothResNet網(wǎng)絡(luò)的構(gòu)建

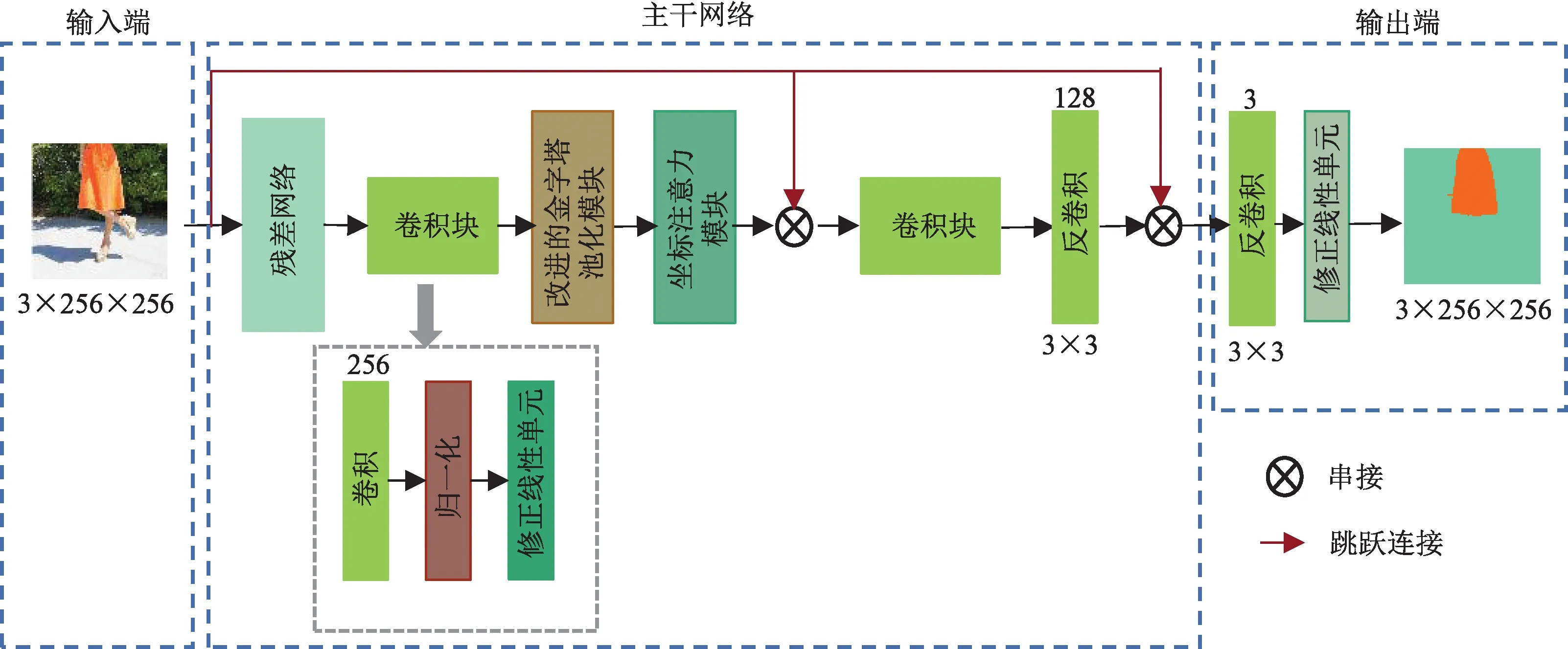

ClothResNet人體衣物顏色識別網(wǎng)絡(luò)主要包含輸入端、主干網(wǎng)絡(luò)以及輸出端3個部分,網(wǎng)絡(luò)結(jié)構(gòu)如圖3所示。

圖3 ClothResNet 網(wǎng)絡(luò)結(jié)構(gòu)Fig.3 ClothResNet network structure

1.2.1 輸入端

在訓(xùn)練過程中,每次輸入16張含有人體衣物的彩色圖像,大小設(shè)置為3×256像素×256像素。

1.2.2 主干網(wǎng)絡(luò)

主干網(wǎng)絡(luò)由3個模塊組成,分別是殘差網(wǎng)絡(luò)、改進(jìn)的金字塔池化模塊和坐標(biāo)注意力模塊。

模塊1:殘差網(wǎng)絡(luò)采用ResNet18作為基礎(chǔ)網(wǎng)絡(luò),并將ResNet18前2個殘差塊卷積核輸出通道設(shè)置為64,卷積核大小設(shè)置為3×3×1,并舍棄后面的池化和全連接層。此模塊通過高低級特征的融合,能夠減少特征信息的丟失,高效地提取圖像全局特征,并使網(wǎng)絡(luò)較快地達(dá)到收斂狀態(tài)。

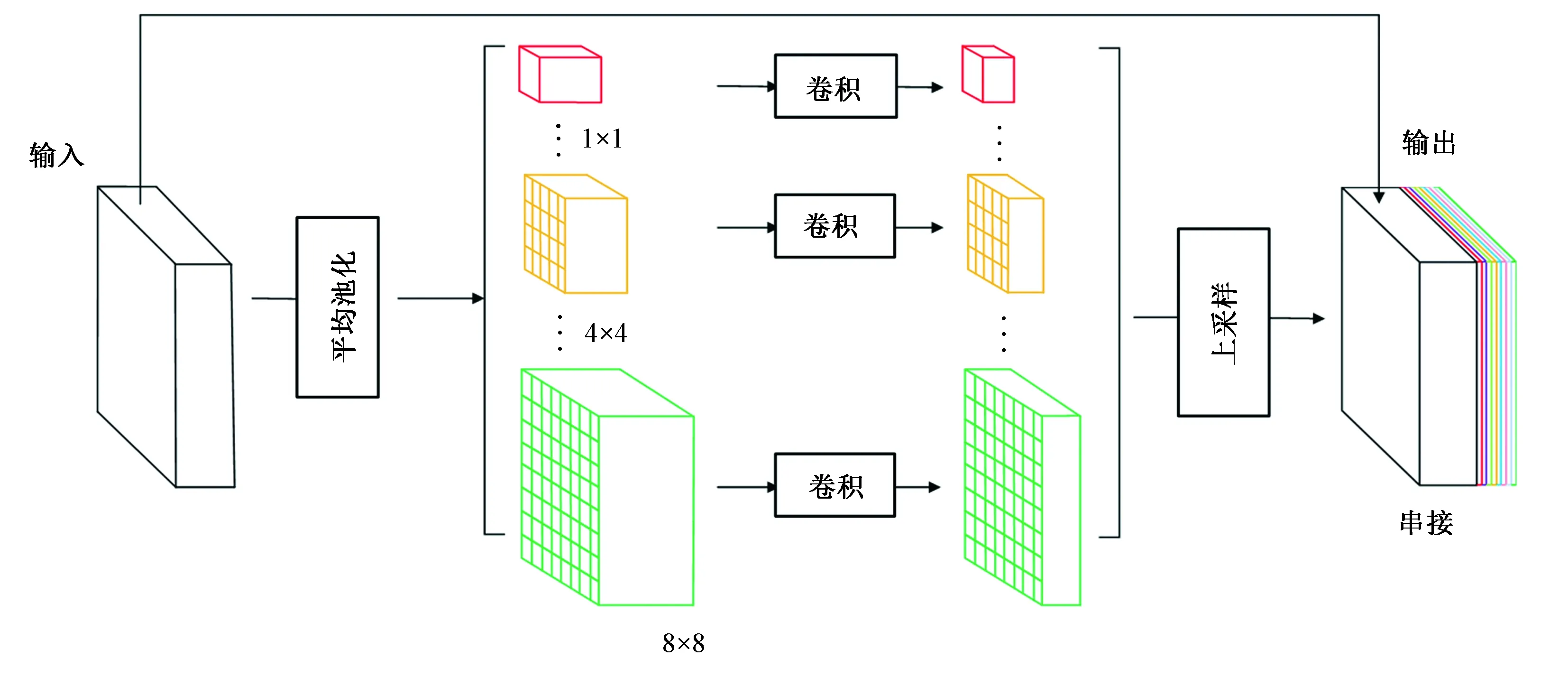

模塊2:改進(jìn)的金字塔池化模塊將殘差網(wǎng)絡(luò)提取到的特征進(jìn)行多尺度變換,以便進(jìn)行串接。傳統(tǒng)的金字塔池化結(jié)構(gòu)未能對衣物輪廓信息進(jìn)行更好的提取,因此,本文在傳統(tǒng)的金字塔池化結(jié)構(gòu)基礎(chǔ)上增加了4個特征塊,分別設(shè)計為4×4、5×5、7×7和 8×8, 這樣可減少不同區(qū)域之間的上下文信息丟失,從而增強對圖像中不同特征的提取。該模塊的結(jié)構(gòu)如圖4所示。

圖4 改進(jìn)的金字塔池化網(wǎng)絡(luò)結(jié)構(gòu)Fig.4 Optimized pyramid pooled network structure

模塊3:坐標(biāo)注意力模塊,其網(wǎng)絡(luò)結(jié)構(gòu)如圖5所示。該模塊的輸入特征圖大小為1 024×32像素×32像素,通過2個卷積核大小分別為(32,1)和(1,32)的卷積層對輸入特征圖在水平和垂直方向上進(jìn)行編碼,以捕捉一個衣物圖像中空間方向上的長期依賴關(guān)系,并在另一個空間方向上保持準(zhǔn)確的位置信息,這有助于網(wǎng)絡(luò)更準(zhǔn)確地定位感興趣的對象。接下來,將編碼后的特征圖連接起來并送入一個1×1的共享卷積層進(jìn)行轉(zhuǎn)換,得到32×1像素×64像素大小的特征圖。然后對該特征圖進(jìn)行歸一化和激活函數(shù)處理。此外,利用2個1×1卷積層分別將編碼后的2個特征圖轉(zhuǎn)換為與輸入具有相同通道數(shù)的向量,并經(jīng)過Sigmoid激活函數(shù)處理。最后,將2個特征圖相乘得到注意塊的輸出,其大小為1 024×32像素×32像素。這樣設(shè)計的坐標(biāo)注意力模塊可更好地捕捉衣物輪廓信息,并提高感興趣區(qū)域的準(zhǔn)確性。

1.2.3 輸出端

輸入端為3×256像素×256像素的彩色圖像,經(jīng)主干網(wǎng)絡(luò)輸出的圖像大小為128像素×128像素,在輸出端通過反卷積層和線性修正單元得到與輸入圖像等大的特征圖。

1.3 評價指標(biāo)

本文用2種評價指標(biāo)衡量提出模型的有效性,分別為平均交并比、精確率。平均交并比M反映真實圖像與預(yù)測圖像的重合度,從而衡量衣物分割準(zhǔn)確率,其公式如下:

式中:n為總體分類數(shù),在本文中n為12;x為實際類別樣本和預(yù)測類別樣本的交集和并集之比,其定義如下:

式中:NTP為被模型分類正確的正類樣本數(shù)量;NFN為被模型分類錯誤的正樣本數(shù)量;NFP為被模型分類錯誤的負(fù)類樣本數(shù)量。

在得到預(yù)測圖像后,統(tǒng)計其中分割出的衣物顏色分類是否正確。針對最終衣物顏色識別結(jié)果,另需使用精確率來評價最終分類結(jié)果的準(zhǔn)確度,計算公式如下:

1.4 實驗參數(shù)設(shè)置及模型訓(xùn)練

在模型設(shè)計中,通常會將數(shù)據(jù)集劃分為訓(xùn)練集和測試集,其中訓(xùn)練集用于訓(xùn)練模型參數(shù),而測試集則用于評估最終訓(xùn)練好的模型的性能。本文中,數(shù)據(jù)集的劃分比例為8∶2,即訓(xùn)練集占80%,測試集占20%。在訓(xùn)練過程中,將訓(xùn)練數(shù)據(jù)集輸入ClothResNet網(wǎng)絡(luò)進(jìn)行訓(xùn)練,通過反向傳播調(diào)整網(wǎng)絡(luò)參數(shù)。

本文所有實驗均在Tesla V100環(huán)境下使用Paddle工具箱運行進(jìn)行訓(xùn)練,訓(xùn)練過程中,訓(xùn)練和測試圖像的尺寸為3×256像素×256像素,使用LeakyReLU(斜率為0.2)和Adagrad算法進(jìn)行訓(xùn)練,損失函數(shù)為交叉熵?fù)p失,初始學(xué)習(xí)率為0.000 2,批處理大小設(shè)置為16,訓(xùn)練120輪。

1.5 模型對比分析

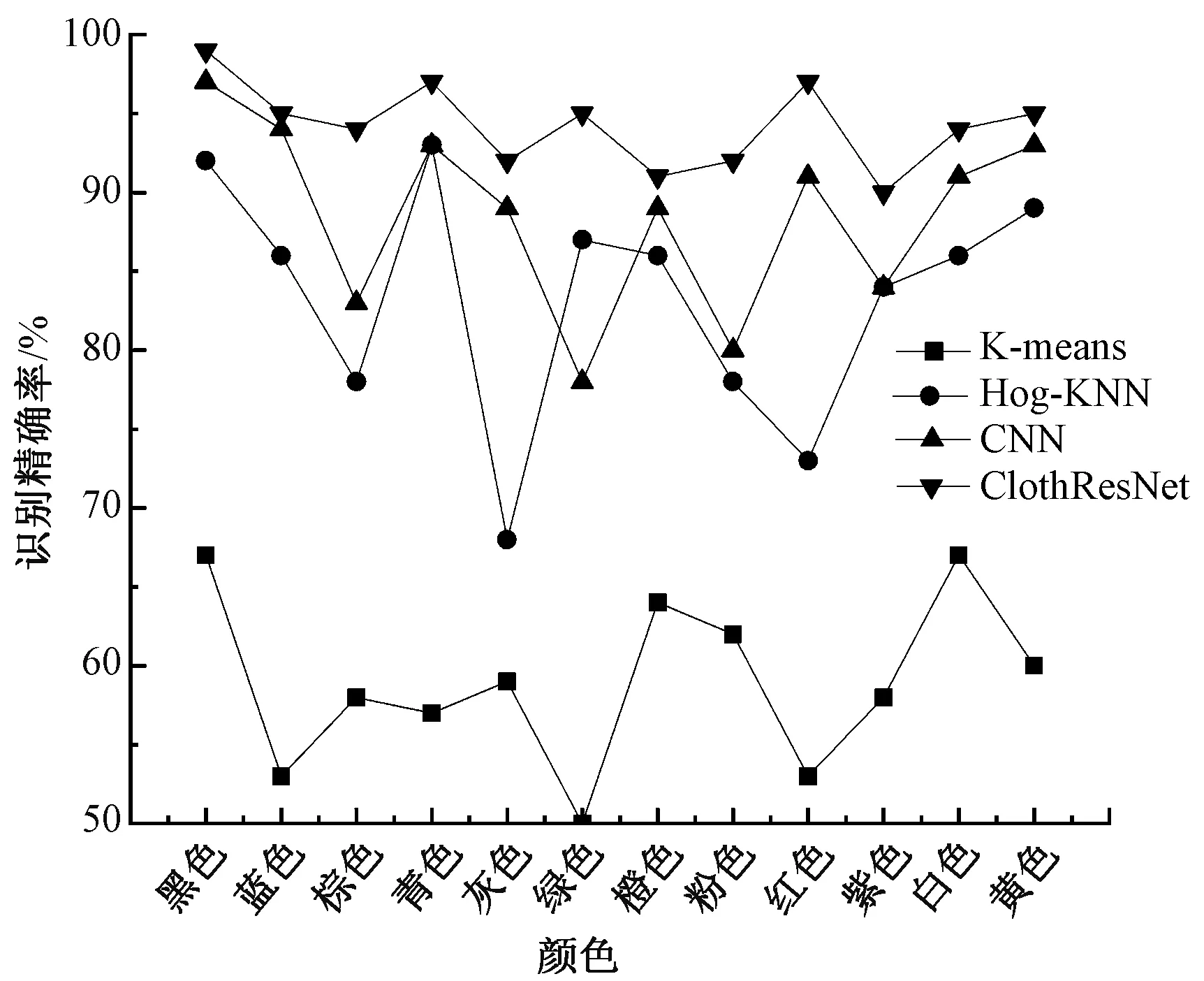

圖6為用K-means、Hog-KNN、卷積神經(jīng)網(wǎng)絡(luò)(CNN)以及本文方法ClothResNet對12種人體衣物顏色的識別精確率對比圖。

圖6 K-means、Hog-KNN、CNN、ClothResNet識別顏色精確率的對比圖Fig.6 Comparison diagram of color recognition accuracy of K-means,Hog-KNN, CNN and ClothResNet

從圖6可看出,在本文構(gòu)建的數(shù)據(jù)集上,ClothResNet模型對衣物顏色識別精確率均優(yōu)于同類方法。由于K-means方法是將圖像中的所有像素聚集在一起,而不是衣物,因此對衣物顏色的預(yù)測不準(zhǔn)確;Hog-KNN用Hog方法提取特征后再進(jìn)行聚類信息提取,從而得到了相對較好的結(jié)果,但其對某些顏色的提取能力較差,如在對灰色衣物進(jìn)行識別時精確率僅有65%左右;利用深度學(xué)習(xí)方法則能夠均勻地捕獲衣物屬性信息,CNN方法相較于傳統(tǒng)方法也具有較高的識別精確率,但其網(wǎng)絡(luò)結(jié)構(gòu)簡單,不能提取圖像中的深層語義信息,從而造成識別率不高;ClothResNet模型對每種顏色的識別都取得了較高的識別精確率,從而驗證了本文模型的有效性。相比其他網(wǎng)絡(luò),本文提出的方案能夠有針對性地解決對人體衣物顏色識別率不高的問題。對金字塔池化模塊進(jìn)行改進(jìn)并融入坐標(biāo)注意力機制提升了網(wǎng)絡(luò)的局部特征提取能力,降低了識別錯誤率。

2 消融實驗

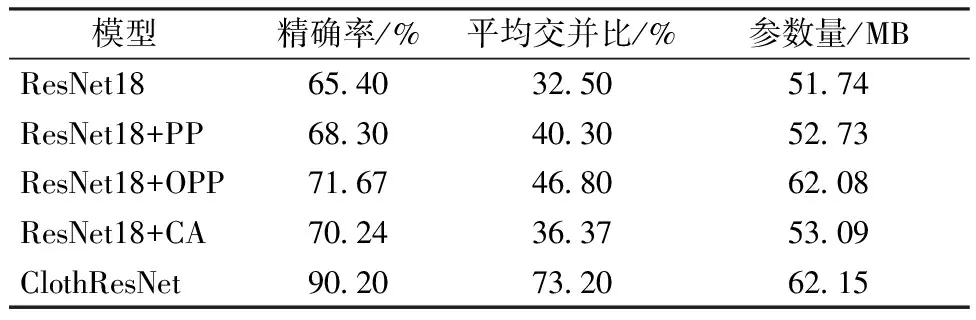

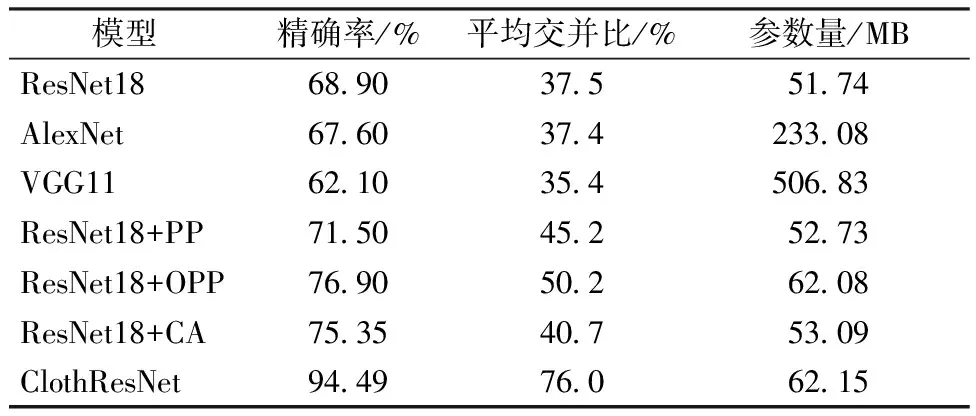

為驗證本文構(gòu)建的人體衣物顏色識別模型ClothResNet加入各個模塊的有效性、ResNet18作為骨干網(wǎng)絡(luò)的優(yōu)勢以及擴(kuò)充樣本對算法的影響,選取深度學(xué)習(xí)中典型的骨干網(wǎng)絡(luò)AlexNet和VGG11作為ResNet18對比網(wǎng)絡(luò),對基于ResNet18網(wǎng)絡(luò)僅加入金字塔池化的模型(ResNet18+PP)、ResNet18加入改進(jìn)的金字塔池化模型(ResNet18+OPP)和基于ResNet18網(wǎng)絡(luò)僅使用坐標(biāo)注意力機制的模型(ResNet18+CA) 各自分別在原始數(shù)據(jù)集與樣本擴(kuò)充后的數(shù)據(jù)集進(jìn)行實驗,結(jié)果如表1、2所示。

表1 原始數(shù)據(jù)集消融實驗對比Tab.1 Comparison of ablation experiments with original dataset

從表1、2可看出,相比在原始數(shù)據(jù)集擴(kuò)充樣本后各個網(wǎng)絡(luò)模塊對人體衣物的顏色識別結(jié)果得到了提升,從而證明對樣本進(jìn)行的多種變換提高了網(wǎng)絡(luò)的泛化性能。從表2可看出,使用骨干網(wǎng)絡(luò)ResNet18與AlexNet、VGG11相比,能夠在參數(shù)量遠(yuǎn)小于其它二者的情況下,達(dá)到相對較好的分割和識別效果。對于原始數(shù)據(jù)集,在加入優(yōu)化的金字塔池化模塊和坐標(biāo)注意力機制后對于衣物的分割和顏色的識別都得到了提升。從表2中比較ResNet18+PP與ResNet18+OPP可知,原始金字塔池化模塊對衣物的分割交并比為45.2%,而改進(jìn)的金字塔模塊提升了5%;ResNet18+PP對衣物顏色識別精確率為71.50%,而ResNet18+OPP在此基礎(chǔ)上提升5.4%。在骨干網(wǎng)絡(luò)中加入坐標(biāo)注意力后分割交并比提升了3.2%,也有效提升了網(wǎng)絡(luò)的識別性能,識別精確率相比ResNet18提升6.45%。本文的ClothResNet模型融合改進(jìn)的金字塔池化模塊和坐標(biāo)注意力模塊,在ResNet18的基礎(chǔ)上只增加了10.41 MB的參數(shù)量,而對衣物顏色識別精確率達(dá)到了94.49%。

表2 擴(kuò)充數(shù)據(jù)集消融實驗對比Tab.2 Comparison of ablation experiments with extended dataset

3 結(jié)束語

本文提出了人體衣物顏色識別模型ClothResNet,模型以ResNet18為基礎(chǔ)網(wǎng)絡(luò),融入了改進(jìn)的金字塔模塊、坐標(biāo)注意力機制,最終實現(xiàn)了對12種人體衣物顏色的高效識別。該方法克服了傳統(tǒng)人體衣物顏色識別方法繁雜的衣物分割步驟,以及簡單卷積神經(jīng)網(wǎng)絡(luò)(CNN)模型識別效率低的缺點。從實驗結(jié)果來看,提出的ClothResNet模型較傳統(tǒng)方法和簡單的CNN模型有更好的衣物顏色識別效果,達(dá)到了94.49%的平均識別精確率。

本模型只針對12種人體衣物顏色進(jìn)行識別,研究仍存在不足,現(xiàn)實中的人體衣物顏色種類遠(yuǎn)超于 12種。 在后續(xù)的工作中,將擴(kuò)大人體衣物顏色樣本圖像庫,通過研究神經(jīng)網(wǎng)絡(luò)的各層結(jié)構(gòu),構(gòu)建出能識別更多種類人體衣物顏色的網(wǎng)絡(luò)模型。