NHNet——新型層次化遙感圖像語義分割網(wǎng)絡(luò)

摘要:

深度學(xué)習(xí)分割方法是遙感圖像分割領(lǐng)域的熱點(diǎn)之一,主流的深度學(xué)習(xí)方法有卷積神經(jīng)網(wǎng)絡(luò)、transformer神經(jīng)網(wǎng)絡(luò)及兩者的結(jié)合。特征提取是圖像分割的重要環(huán)節(jié),除了用卷積等方式提取特征,最近的研究聚焦于一些新的特征提取范式,如圖卷積、小波變換等。本文利用聚類算法的區(qū)域構(gòu)建屬性,將改進(jìn)的聚類算法用于骨干特征提取模塊,同時(shí)使用卷積和視覺transformer作為輔助模塊,以獲取更豐富的特征表述;在模塊基礎(chǔ)上,提出了一種新型層次化遙感圖像語義分割網(wǎng)絡(luò)(NHNet);評估了NHNet語義分割的性能,并在LoveDA遙感數(shù)據(jù)集上與其他方法進(jìn)行比較。結(jié)果表明,基于多特征提取的NHNet獲得了競爭性的性能表現(xiàn),平均交并比為49.64%,F(xiàn)1分?jǐn)?shù)為65.7%。同時(shí),消融實(shí)驗(yàn)證明輔助模塊提高了聚類算法分割的精確性,給NHNet分別提升了1.03%和2.41%的平均交并比。

關(guān)鍵詞:

遙感圖像;語義分割;聚類算法;卷積神經(jīng)網(wǎng)絡(luò);自注意力

doi:10.13278/j.cnki.jjuese.20230155

中圖分類號:TP751.1

文獻(xiàn)標(biāo)志碼:A

王威,熊藝舟,王新. NHNet:新型層次化遙感圖像語義分割網(wǎng)絡(luò). 吉林大學(xué)學(xué)報(bào)(地球科學(xué)版),2024,54(5):17641772. doi:10.13278/j.cnki.jjuese.20230155.

Wang Wei, Xiong Yizhou, Wang Xin. NHNet: A Novel Hierarchical Semantic Segmentation Network for Remote Sensing Images. Journal of Jilin University (Earth Science Edition), 2024, 54 (5): 17641772. doi:10.13278/j.cnki.jjuese.20230155.

收稿日期:20230626

作者簡介:王威(1974-),男,教授,博士生導(dǎo)師,CCF會員,主要從事計(jì)算機(jī)視覺、模式識別方面的研究,E-mail: wangwei@csust.edu.cn

通信作者:王新(1976-),女,講師,主要從事計(jì)算機(jī)視覺、模式識別方面的研究,E-mail: wangxin@csust.edu.cn

基金項(xiàng)目:湖南省重點(diǎn)研究開發(fā)項(xiàng)目(2020SK2134);湖南省自然科學(xué)基金項(xiàng)目(2022JJ30625)

Supported by the Key Research and Development Project of" Hunan Province (2020SK2134) and the Project of" Natural Science Foundation of Hunan Province" (2022JJ30625)

NHNet: A Novel Hierarchical Semantic Segmentation Network for Remote Sensing Images

Wang Wei, Xiong Yizhou, Wang Xin

School of Computer and Communication Engineering, Changsha University of Science and Technology, Changsha 410000, China

Abstract:

Deep learning segmentation method is one of the hot topics in the field of remote sensing image segmentation. The mainstream deep learning methods include convolutional neural networks, transformer neural networks, and a combination of the two. Feature extraction is an important part of image segmentation. In addition to using convolution and other methods to extract features, recent research has focused on some new feature extraction paradigms, such as graph convolution and wavelet transform. In this article, the region construction attribute of clustering algorithms is utilized, and the improved clustering algorithm is used as the backbone feature extraction module while the convolution and visual transformer are used as auxiliary modules to obtain richer feature representations. On the basis of the module, a new hierarchical remote sensing image semantic segmentation network (NHNet) is proposed. The performance of NHNet semantic segmentation is evaluated and compared with other methods on the LoveDA remote sensing dataset. The results show that NHNet based on multi-feature extraction achieved competitive performance, with an average intersection-to-union ratio of 49.64% and a score of 65.7%. At the same time, ablation experiments show that the auxiliary module improves the accuracy of clustering algorithm segmentation, increasing the average intersection-to-union ratio of NHNet by 1.03% and 2.41%, respectively.

Key words:

remote sensing images; semantic segmentation; clustering algorithm; convolutional neural network; self attention

0" 引言

遙感技術(shù)已經(jīng)廣泛應(yīng)用于農(nóng)業(yè)、林業(yè)、水資源管理、城市規(guī)劃、環(huán)境保護(hù)、天氣預(yù)報(bào)、國土資源調(diào)查等領(lǐng)域。如何利用日益豐富且完善的遙感數(shù)據(jù)集對地球進(jìn)行智能觀測,是遙感領(lǐng)域的巨大機(jī)會和挑戰(zhàn),如利用衛(wèi)星數(shù)據(jù)反演海底地形[1]和進(jìn)行變化檢測[2]等。其中遙感語義分割[35]利用遙感技術(shù)獲取的圖像,通過計(jì)算機(jī)視覺技術(shù)和深度學(xué)習(xí)等算法對圖像中的目標(biāo)進(jìn)行分類,將圖像中的每個(gè)像素點(diǎn)標(biāo)記為相應(yīng)的類別,實(shí)現(xiàn)對圖像的語義理解和識別。這要求網(wǎng)絡(luò)必須能夠捕獲遙感場景的整體視圖,同時(shí)保留細(xì)節(jié)和語義信息。語義分割技術(shù)可以快速準(zhǔn)確地提取出圖像中的各種地物信息,如建筑、道路、河流、森林等,從而對地表特征進(jìn)行精細(xì)化分析和研究,也可以輔助農(nóng)業(yè)、林業(yè)、水資源管理等領(lǐng)域做出決策,對于遙感數(shù)據(jù)集的利用有重大意義。

傳統(tǒng)的語義分割方法通常采用基于區(qū)域[6]的方法,例如使用區(qū)域生長算法或聚類算法將像素分成不同的區(qū)域。這些方法在一定程度上可以實(shí)現(xiàn)圖像中物體的分割,但是很難準(zhǔn)確地標(biāo)記物體邊界,對復(fù)雜場景的處理效果并不理想。近年來,深度學(xué)習(xí)方法已經(jīng)成為語義分割領(lǐng)域中的主流方法。通過使用卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network, CNN)等深度學(xué)習(xí)模型,可以有效提取圖像特征,并進(jìn)行精確的像素級別分割。其中,全卷積網(wǎng)絡(luò)[7](fully convolutional networks, FCN)、編碼器解碼器網(wǎng)絡(luò)(encoder-decoder)[810]、空洞卷積網(wǎng)絡(luò)[11](dilated convNet)和分割網(wǎng)絡(luò)[12](segmentation network, SegNet)等模型被廣泛應(yīng)用于語義分割任務(wù)中。

最近,ViT(vision transformers)[13]將基于純自注意力的transformer引入了視覺領(lǐng)域,并在各種視覺任務(wù)上取得了優(yōu)異的性能,比如SegFormer[14]。同時(shí),為了使ViT更加適用于密集視覺任務(wù),SwinT(Swin transformer)[15]采用了類似于卷積的滑動窗口注意力,并且在網(wǎng)絡(luò)中加入了層次結(jié)構(gòu)。NAT(neighborhood attention transformer)[16]重新討論了滑動窗口注意力,提出了鄰域注意力,將像素的自注意力定位到不固定的最近鄰,具有平移等方差的額外優(yōu)勢。DiNAT(dilated neighborhood attention transformer)[17]在鄰域注意力的基礎(chǔ)上加入了膨脹鄰域注意力,擴(kuò)大了NAT的感受野。但是,ViT需要強(qiáng)大的計(jì)算資源,對移動設(shè)備不友好,這引發(fā)了輕量級語義分割網(wǎng)絡(luò)的研究。研究通過一系列的參數(shù)壓縮、技術(shù)優(yōu)化實(shí)現(xiàn)了輕量化和高效率的特點(diǎn)[1823],如TopFormer[24]、SeaFormer[25]采用卷積神經(jīng)網(wǎng)絡(luò)和ViT結(jié)合的方式發(fā)揮他們各自的優(yōu)勢,在計(jì)算成本和性能表現(xiàn)之間獲得平衡。

為了避免增量改進(jìn)陷阱,一些研究將目光聚焦于新的特征提取范式,如ViG(vision graph neural network)[26]。ViG為了捕捉不規(guī)則和復(fù)雜的物體,將圖像劃分為一些像素塊并視為圖節(jié)點(diǎn),利用圖卷積和FFN(feed-forward network)模塊提取圖形特征,首次將圖神經(jīng)網(wǎng)絡(luò)用于大規(guī)模的視覺任務(wù)。上下文聚類網(wǎng)絡(luò)[27](context clusters,CoCs)將圖像視為一組無組織的點(diǎn),通過聚類算法提取特征,盡管沒有使用任何卷積和注意力,也在基準(zhǔn)測試上取得不弱于基于卷積和注意力算法的性能。

上述研究表明,隨著更多的特征提取方式被引入到視覺領(lǐng)域,傳統(tǒng)的卷積網(wǎng)絡(luò)和自注意力網(wǎng)絡(luò)不再是構(gòu)建神經(jīng)網(wǎng)絡(luò)的唯一選擇。本文利用聚類算法強(qiáng)大的區(qū)域構(gòu)建能力,借鑒上述研究中卷積和自注意力的有效結(jié)合方式,提出一種新型層次化遙感圖像語義分割模型(NHNet)。首先利用聚類算法的區(qū)域構(gòu)建屬性,將改進(jìn)聚類塊作為網(wǎng)絡(luò)的基本特征提取模塊,搭建由聚類塊組成的骨干網(wǎng)絡(luò),使神經(jīng)網(wǎng)絡(luò)的感受野能夠靈活變動,適應(yīng)遙感圖像固有的對象物體不規(guī)則的特點(diǎn);然后提出層次化遙感圖像分割架構(gòu)(NHNet),在淺層使用基于卷積的C模塊(C block, CB)增強(qiáng)其空間細(xì)節(jié)特征,在深層使用基于多頭注意力的T模塊(T block, TB)提取全局語義信息;最后設(shè)計(jì)特征注入模塊(feature injection module, FIM),以消除三種特征提取方法的語義差距,實(shí)現(xiàn)更加平滑的特征融合。并且在LoveDA[28]數(shù)據(jù)集上與其他方法進(jìn)行比較,以期為遙感圖像語義分割提供解決分割問題的新視角。

1" 網(wǎng)絡(luò)結(jié)構(gòu)

1.1" 總體架構(gòu)

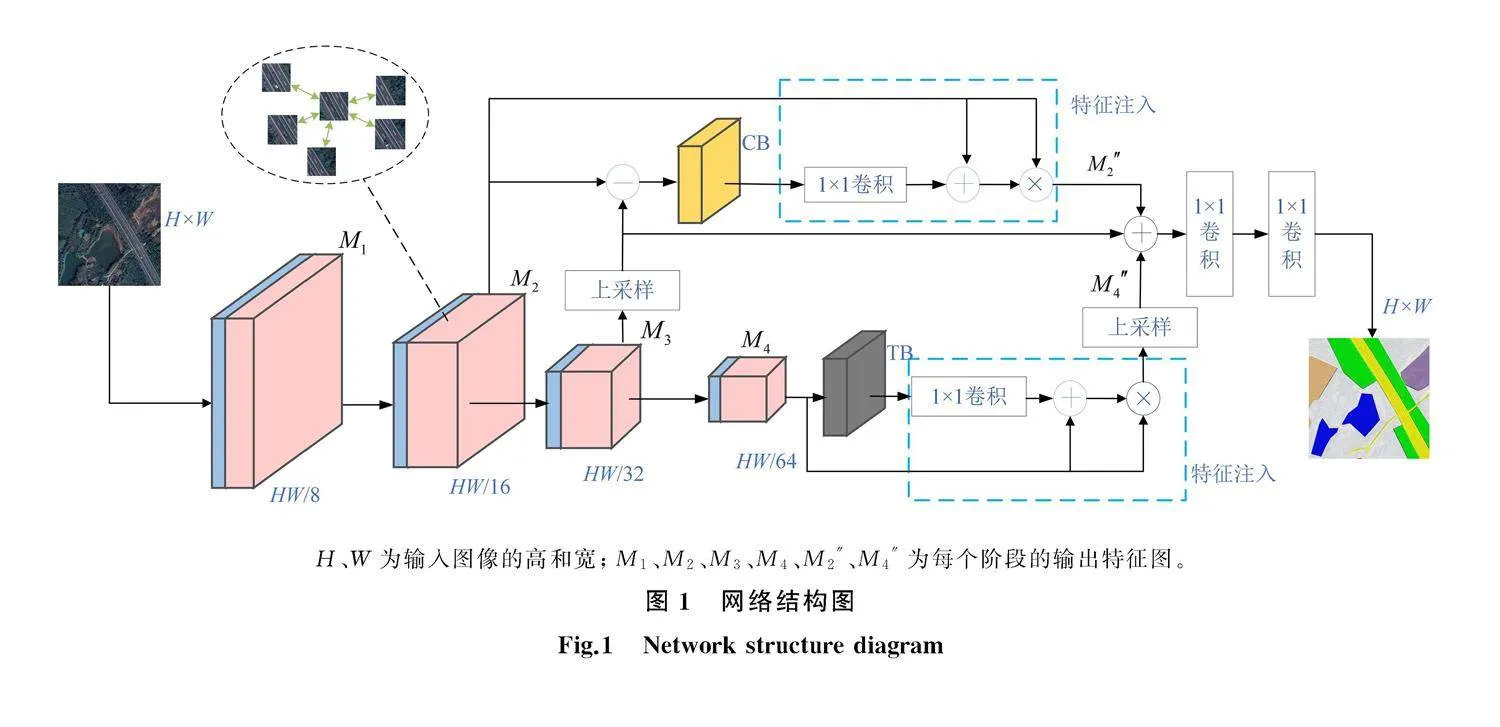

模型的總體架構(gòu)如圖1所示。為了獲得區(qū)域構(gòu)建能力,基于區(qū)域?qū)D像進(jìn)行分割,本文將聚類塊作為基本的特征提取模塊。圖像經(jīng)過4個(gè)聚類塊處理之后,為了獲得空間細(xì)節(jié)信息和全局語義信息,分別使用基于卷積和ViT的特征提取模塊對原特征進(jìn)行特征提取,并將提取的特征通過特征注入模塊進(jìn)行融合注入。由于不同層次之間的特征存在差異,所以對淺層和深層特征采用不同的處理方法。淺層網(wǎng)絡(luò)輸出的特征含有豐富的空間細(xì)節(jié)和紋理信息,使用基于卷積的3個(gè)倒置瓶頸模塊組成C模塊捕獲更精確的分割細(xì)節(jié);深層網(wǎng)絡(luò)輸出的特征含有豐富的全局語義信息,使用基于transformer的3個(gè)ViT模塊組成T模塊捕獲語義特征信息。為了使特征更加平滑地融合,使用特征注入模塊,將特征提取模塊中的細(xì)節(jié)和全局特征與相對應(yīng)的原尺度特征進(jìn)行融合,以增強(qiáng)表示。

1.2" 基本特征提取模塊

為了使網(wǎng)絡(luò)具有基于區(qū)域進(jìn)行分割的能力,網(wǎng)絡(luò)的基本特征提取模塊為聚類塊。一個(gè)聚類塊包含兩個(gè)子模塊,其中:第一個(gè)子模塊為區(qū)域劃分模塊,利用特征相似矩陣實(shí)現(xiàn)特征圖的區(qū)域劃分;第二個(gè)子模塊為特征聚合與更新模塊,在劃分好的區(qū)域內(nèi)進(jìn)行像素點(diǎn)特征的更新計(jì)算。整個(gè)網(wǎng)絡(luò)共分為四個(gè)階段,每個(gè)階段都包含一個(gè)下采樣和N個(gè)聚類塊,下采樣模塊用來降低特征圖的分辨率,增加特征圖的維度。如圖1所示,四個(gè)階段的通道維度為32,64,196,320,輸出特征圖定義為{M1,M2,M3,M4}。

1)區(qū)域劃分。給定一組像素點(diǎn)P∈Rn×d,其中,n為像素總數(shù),d為像素的特征維度。首先進(jìn)行相似性運(yùn)算,在空間均勻地提出c個(gè)中心點(diǎn),通過平均其周圍k個(gè)相鄰點(diǎn)計(jì)算中心特征;然后計(jì)算像素點(diǎn)和中心點(diǎn)集的像素值,得到余弦相似度s∈Rc×n,將每個(gè)像素點(diǎn)分配到最相似的中心,得到c個(gè)不重疊區(qū)域。

2)特征聚合與更新。劃分區(qū)域之后,為了進(jìn)一步計(jì)算區(qū)域中每個(gè)像素點(diǎn)的特征值,需要在每個(gè)區(qū)域中進(jìn)行特征聚合。假定一個(gè)區(qū)域中有m個(gè)像素點(diǎn),與中心點(diǎn)的相似度為s∈Rm,本文將這些像素

H、W為輸入圖像的高和寬;M1、M2、M3、M4、M2″、M4″為每個(gè)階段的輸出特征圖。

點(diǎn)映射到一個(gè)值空間PV∈Rm×w,其中w是維度數(shù)。聚合特征g的公式表達(dá)如下:

g=VcC+1C∑mi=0sig(αsi+β)Vi; (1)

C=1+∑mi=0sig(αsi+β)。(2)

式中:Vc為值空間的中心點(diǎn);Vi為值空間PV中的第i個(gè)點(diǎn);sig(·)表示激活函數(shù)sigmoid;α和β為可學(xué)習(xí)的因子;si為相似度矩陣中的第i個(gè)元素;為了控制大小,聚合特征歸一化為C。

之后根據(jù)像素點(diǎn)與中心點(diǎn)的相似性,自適應(yīng)地將g分配到區(qū)域中的每個(gè)像素點(diǎn)。如此,這些點(diǎn)可以相互通信,并共享來自區(qū)域中所有點(diǎn)的特征。利用g對區(qū)域內(nèi)每個(gè)點(diǎn)Pi的更新方式表示為

Pi′=Pi+FC(sig(αsi+β))g 。(3)

式中:Pi′為進(jìn)行特征更新之后的第i個(gè)像素點(diǎn);FC(·)為全連接層。

3)根據(jù)式(3)計(jì)算圖像的所有像素點(diǎn),得到聚類塊的計(jì)算方式。在網(wǎng)絡(luò)結(jié)構(gòu)(圖1)中,將一個(gè)下采樣和重復(fù)多次的聚類塊作為一個(gè)階段,不同階段的聚類塊重復(fù)次數(shù)決定了網(wǎng)絡(luò)的學(xué)習(xí)能力和規(guī)模,將每個(gè)階段的聚類塊數(shù)量設(shè)置為{2,2,6,2}。

聚類塊將圖像視為一系列無序的點(diǎn),每個(gè)點(diǎn)都包括原始特征和位置信息,通過聚類算法對深度特征進(jìn)行分層分組和特征提取。這種方式為圖像和視覺表示提供了一個(gè)新的視角,聚類算法通過特征相似性將所有像素點(diǎn)歸納為幾個(gè)簇,在簇內(nèi)進(jìn)行特征聚合和特征更新。由于一個(gè)簇中像素點(diǎn)的數(shù)量是不固定的,有可能一個(gè)簇中的像素點(diǎn)總數(shù)為零,所以一個(gè)像素點(diǎn)會在一個(gè)不規(guī)則不固定的感受野中與其他像素點(diǎn)產(chǎn)生交互,這種特性更契合圖像分割中的感受野要求。

1.3" 特征增強(qiáng)模塊

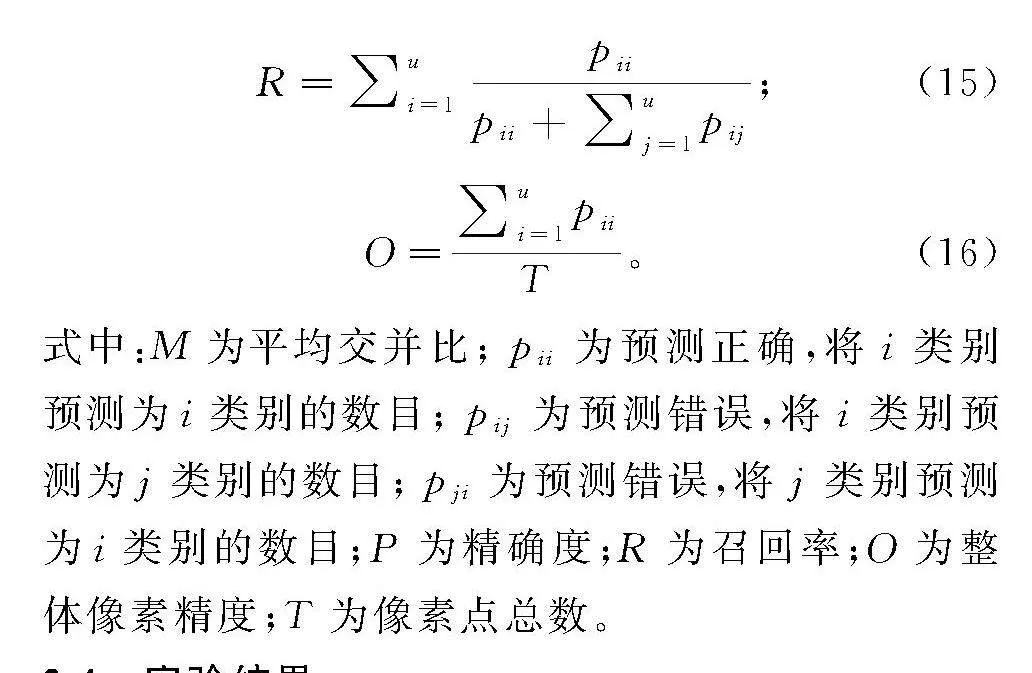

特征增強(qiáng)模塊如圖2所示。

1)T模塊。在骨干網(wǎng)絡(luò)生成的特征圖中,第4階段生成的特征圖M4具有較大的感受野,含有豐富的語義特征,因此本文使用3個(gè)T模塊對關(guān)鍵語義信息進(jìn)行過濾提取。T模塊由兩個(gè)殘差層組成,分別為多頭自注意力層和線性化層,其表達(dá)如下:

M4=M4+MulAtt(Norm(M4));(4)

M4′=M4+Mlp(Norm(M4))。(5)

式中:Norm(·)表示歸一化層;MulAtt(·)表示多頭注意力層;Mlp(·)表示線性化層,由一個(gè)深度可分離的3×3卷積和兩個(gè)1×1卷積組成,進(jìn)行通道間的信息交流;M4′為最終的輸出。

BN. batch normalization;ReLU. rectified linear unit;LN. layer normalization;MLP. multilayer perceptron。

2)C模塊。M2具有高分辨率特征,沒有M3、M4經(jīng)過下采樣而導(dǎo)致的空間細(xì)節(jié)信息損失,對得到更精確的分割結(jié)果而言至關(guān)重要,比如更精確的房屋邊緣信息、更連續(xù)的長距離河流分割信息;但是對高分辨率特征的過度學(xué)習(xí)會導(dǎo)致計(jì)算成本的上升。因此,本文采用3個(gè)基于深度可分離卷積的C模塊完成高分辨率特征的提取。淺層特征圖會包含一些噪音和冗余信息,所以使用CR(·)模塊對M2進(jìn)行預(yù)處理,加強(qiáng)特征多樣性,使C模塊學(xué)習(xí)與M3、M4互補(bǔ)的空間細(xì)節(jié)信息。整個(gè)過程表達(dá)如下:

CR(M2)=Conv1×1(M2)-UP(Conv1×1(M3));(6)

M2′=Conv1×1(DW3×3(Conv1×1(CR(M2)))。 (7)

式中:Conv1×1(·)為卷積核為1的普通卷積;UP(·)為雙線性插值上采樣;DW3×3(·)為卷積核為3的深度可分離卷積;M2′為最終的輸出。每個(gè)卷積都固定一個(gè)BN層和ReLU激活層,沒有在公式中寫出。M2首先進(jìn)入預(yù)處理模塊CR(·),減去M3上采樣之后的特征圖,得到骨干網(wǎng)深層損失的特征信息;然后用1×1普通卷積對其進(jìn)行升維,用深度可分離的3×3卷積進(jìn)行特征運(yùn)算,用1×1卷積降低維度。升維幅度設(shè)置為6,C模塊的重復(fù)次數(shù)設(shè)置為3。

1.4" 特征注入模塊

由于特征提取方式不同,本文設(shè)計(jì)了特征注入模塊來融合這些特征。M4首先經(jīng)過T模塊得到全局語義信息特征;然后分別經(jīng)過一個(gè)1×1卷積層、歸一化層和激活層,得到消除差異的特征信息M4′;之后將這些特征信息的分辨率和通道數(shù)與M4統(tǒng)一,通過一個(gè)矩陣加法和矩陣乘法把這些特征信息注入到M4,最終得到了獲得語義增強(qiáng)的特征圖M4″。M2的注入方式與M4基本一致,不同點(diǎn)在于,因?yàn)镃模塊中利用了M3,通道數(shù)被上升到了M3的大小,所以M2的通道數(shù)首先也要被上升到M3的大小,然后進(jìn)行特征注入。方法的公式表達(dá)如下:

M2′=Conv1×1(CB(M2));(8)

M2″=M2′·UP(M2)+UP(M2); (9)

M4′=Conv1×1(TB(M4));(10)

M4″=M4′·M4+M4。 (11)

式中:CB(·)為C模塊;TB(·)為T模塊。

融合的特征具有豐富的空間細(xì)節(jié)信息和全局語義信息,這是遙感圖像分割的性能基礎(chǔ),在此基礎(chǔ)上添加分割頭。分割頭由兩個(gè)1×1卷積層組成,每個(gè)卷積層后固定一個(gè)BN層和ReLU激活層,通過平滑的通道維度下降輸出結(jié)果。

2" 實(shí)驗(yàn)結(jié)果與分析

在本節(jié)中,首先在LoveDA公共數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),并將結(jié)果與其他方法進(jìn)行比較。然后進(jìn)行消融研究,以分析特征增強(qiáng)模塊和特征注入模塊的有效性。

2.1" 數(shù)據(jù)集

為了驗(yàn)證NHNet的可行性,本文在數(shù)據(jù)集LoveDA上進(jìn)行了實(shí)驗(yàn)。LoveDA數(shù)據(jù)集包含來自三個(gè)不同城市的5 987張0.3 m高分辨率影像和166 768個(gè)標(biāo)注語義對象[20]。與現(xiàn)有的其他遙感數(shù)據(jù)集相比,LoveDA同時(shí)包含了城市和農(nóng)村地區(qū)的不同影像,這增加了數(shù)據(jù)集的復(fù)雜性和處理的困難程度。城鄉(xiāng)景觀有不同的分布:人口密度高的城市景觀中包含了大量的人工物體,如建筑和道路;相比之下,鄉(xiāng)村景觀包含了更多的自然元素,如林地和水。這種類間不一致的分布造成了一定問題。LoveDA數(shù)據(jù)集中主要標(biāo)注了7個(gè)類別:背景、建筑、道路、水域、荒地、林地和耕地,每個(gè)圖像經(jīng)過幾何配準(zhǔn)和圖像預(yù)處理,變成1 024×1 024分辨率的影像,總圖像數(shù)量為5 987張,劃分為訓(xùn)練集2 522張、驗(yàn)證集1 669張、測試集1 796張。

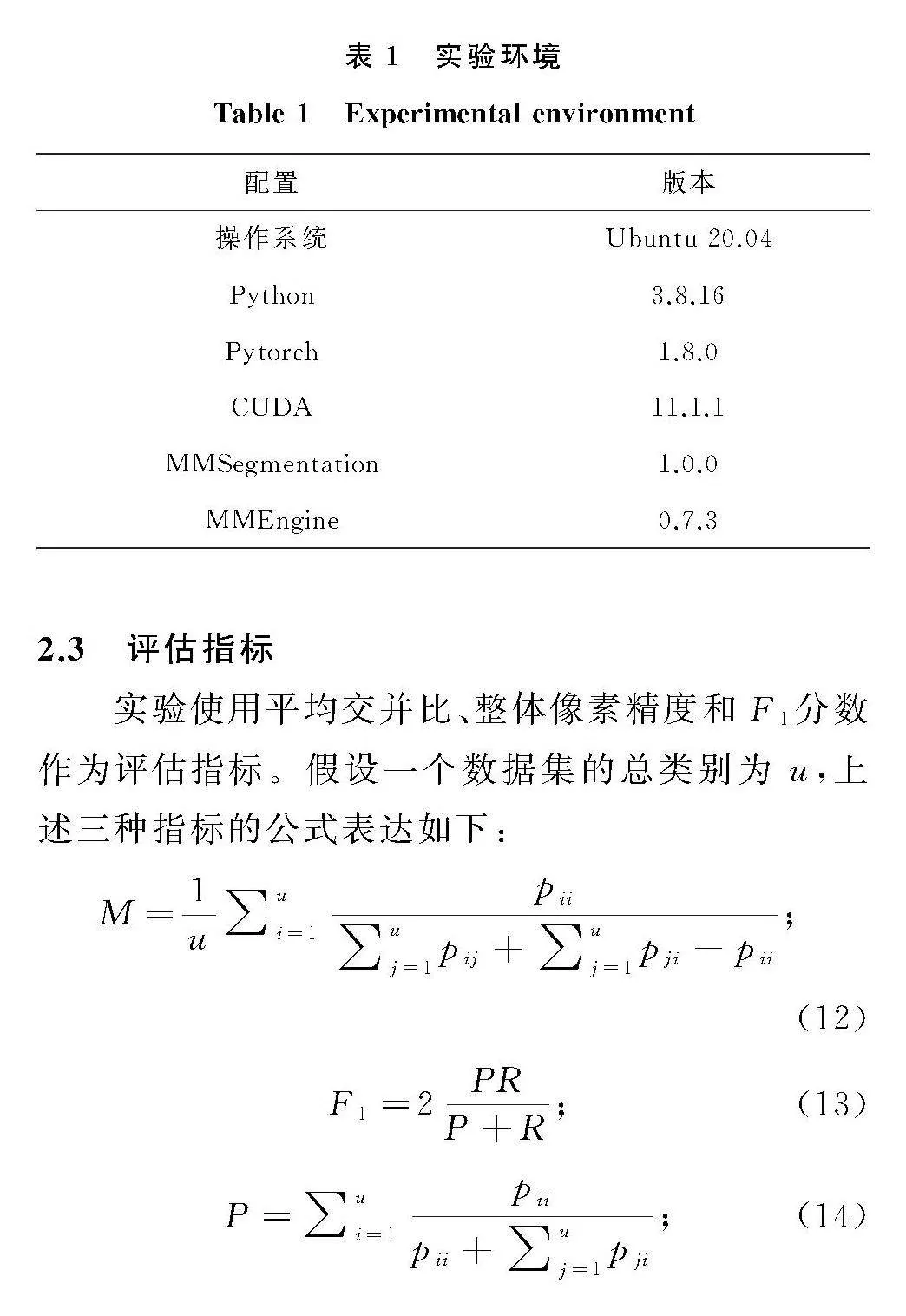

2.2" 參數(shù)設(shè)置

實(shí)驗(yàn)框架為MMSegmentation和Pytorch。具體實(shí)驗(yàn)時(shí),為了保持一致性,所有的實(shí)驗(yàn)設(shè)置都是統(tǒng)一的:使用AdamW優(yōu)化器訓(xùn)練4萬次迭代,批量大小為5,初始學(xué)習(xí)率為0.000 1,權(quán)重衰減為0.001,poly學(xué)習(xí)策略因子為0.9。數(shù)據(jù)集上,采用相同的圖像增強(qiáng)策略進(jìn)行公平比較:將訓(xùn)練圖像分辨率調(diào)整為1 024×1 024,然后進(jìn)行50%概率的隨機(jī)翻轉(zhuǎn)和隨機(jī)裁剪;將測試圖像分辨率調(diào)整為1 024×1 024,然后進(jìn)行概率為50%隨機(jī)翻轉(zhuǎn)。在實(shí)驗(yàn)進(jìn)行時(shí),每4 000次迭代評估一次網(wǎng)絡(luò)的平均交并比和最高精度,到第4萬次迭代時(shí)有十次評估,取最大值。所有實(shí)驗(yàn)配備一張內(nèi)存為20 GB的NVDIA A10顯卡,軟件設(shè)備如表1所示。

2.3" 評估指標(biāo)

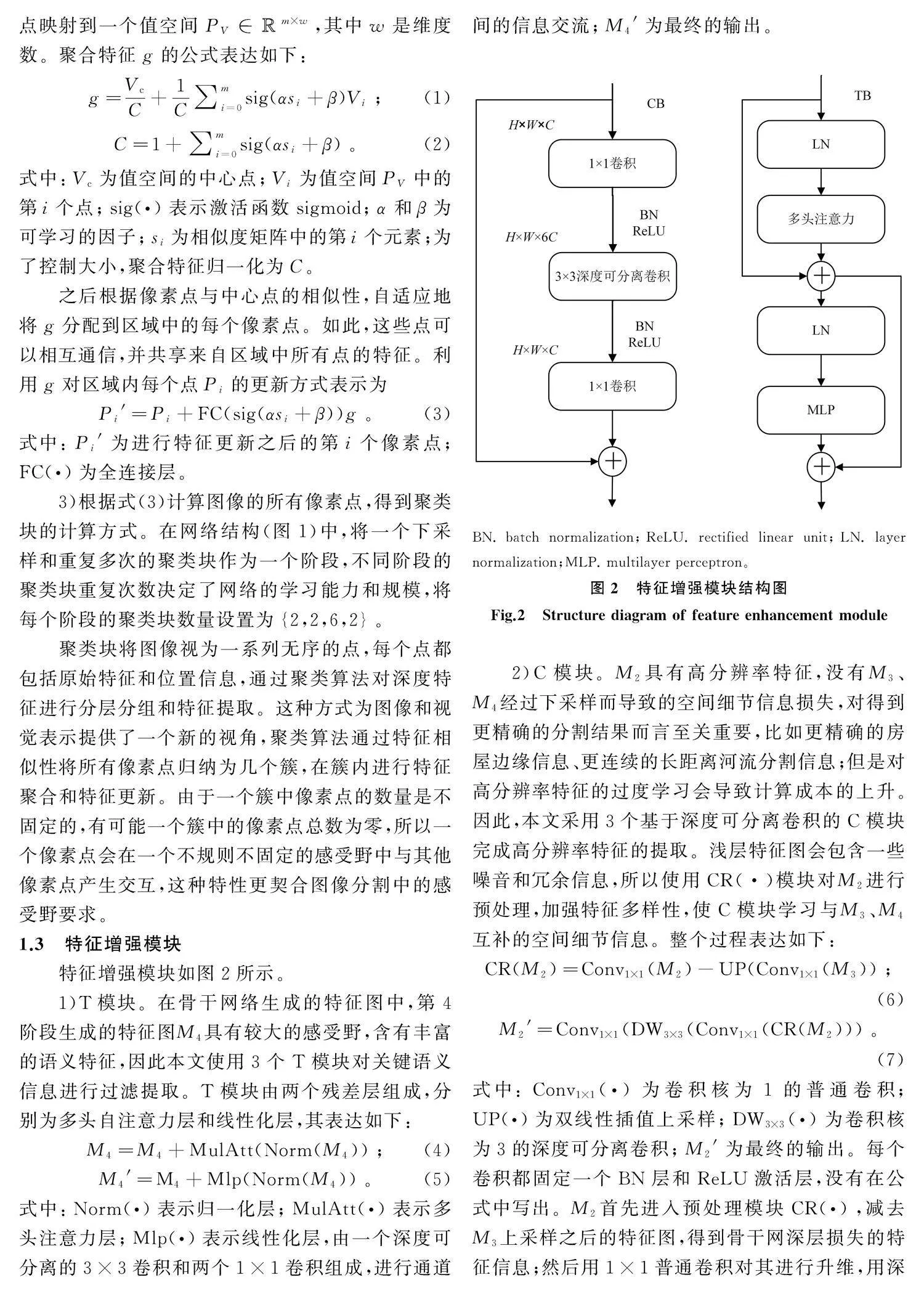

實(shí)驗(yàn)使用平均交并比、整體像素精度和F1分?jǐn)?shù)作為評估指標(biāo)。假設(shè)一個(gè)數(shù)據(jù)集的總類別為 u,上述三種指標(biāo)的公式表達(dá)如下:

M=1u∑ui=1pii∑uj=1pij+∑uj=1pji-pii;(12)

F1=2PRP+R;(13)

P=∑ui=1piipii+∑uj=1pji;(14)

R=∑ui=1piipii+∑uj=1pij;(15)

O=∑ui=1piiT。(16)

式中:M為平均交并比;pii為預(yù)測正確,將i類別預(yù)測為i類別的數(shù)目;pij為預(yù)測錯(cuò)誤,將i類別預(yù)測為j類別的數(shù)目;pji為預(yù)測錯(cuò)誤,將j類別預(yù)測為i類別的數(shù)目;P為精確度;R為召回率;O為整體像素精度;T為像素點(diǎn)總數(shù)。

2.4" 實(shí)驗(yàn)結(jié)果

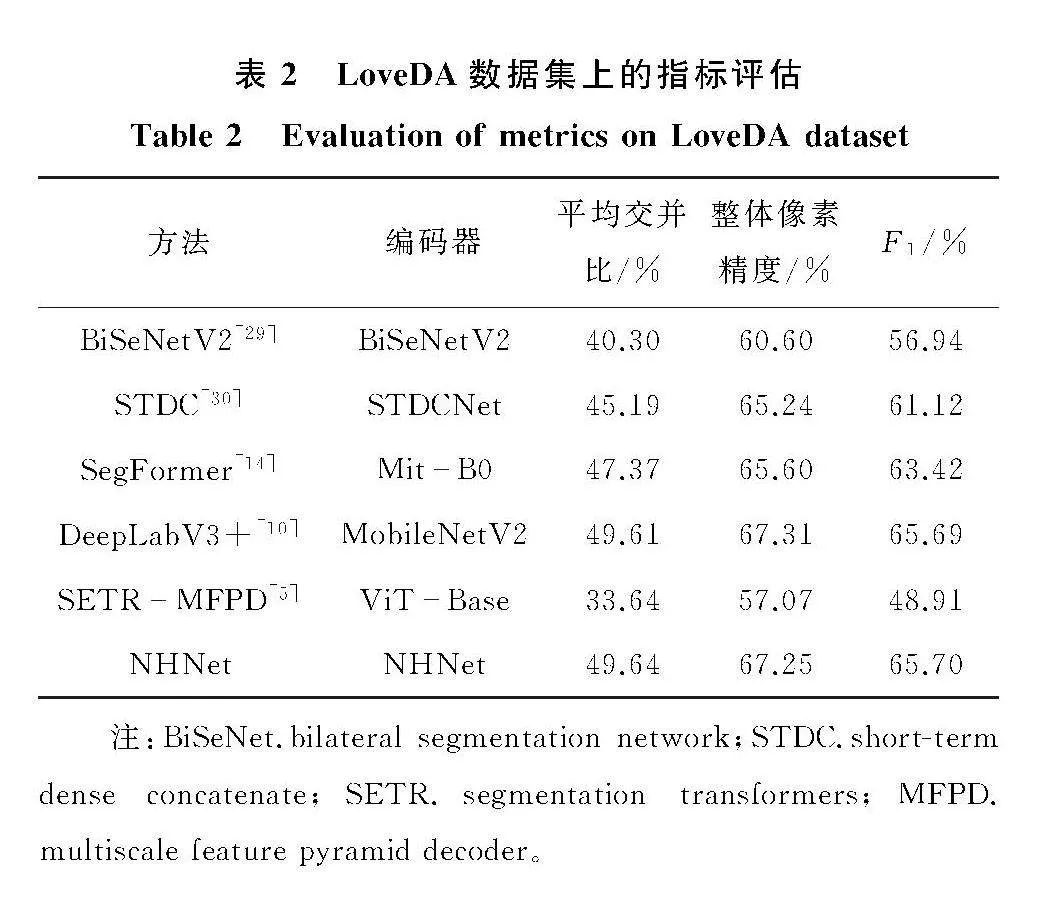

將NHNet在LoveDA數(shù)據(jù)集上與現(xiàn)有的高性能語義分割方法進(jìn)行了對比實(shí)驗(yàn),結(jié)果如表2所示。NHNet在平均交并比和F1分?jǐn)?shù)兩個(gè)指標(biāo)上獲得了最優(yōu)(平均交并比達(dá)49.64%,F(xiàn)1分?jǐn)?shù)達(dá)65.70%),基于輕量級神經(jīng)網(wǎng)絡(luò)MobileNetV2的DeepLabV3+在指標(biāo)整體像素精度上獲得了最優(yōu)(達(dá)67.31%)。表3詳細(xì)記錄了每個(gè)類別的交并比,與其他分割方法相比,NHNet對背景、建筑、水域、荒地這四個(gè)類別上的識別度最高,但對耕地的識別程度不高(比DeepLabV3+低5.44%)。

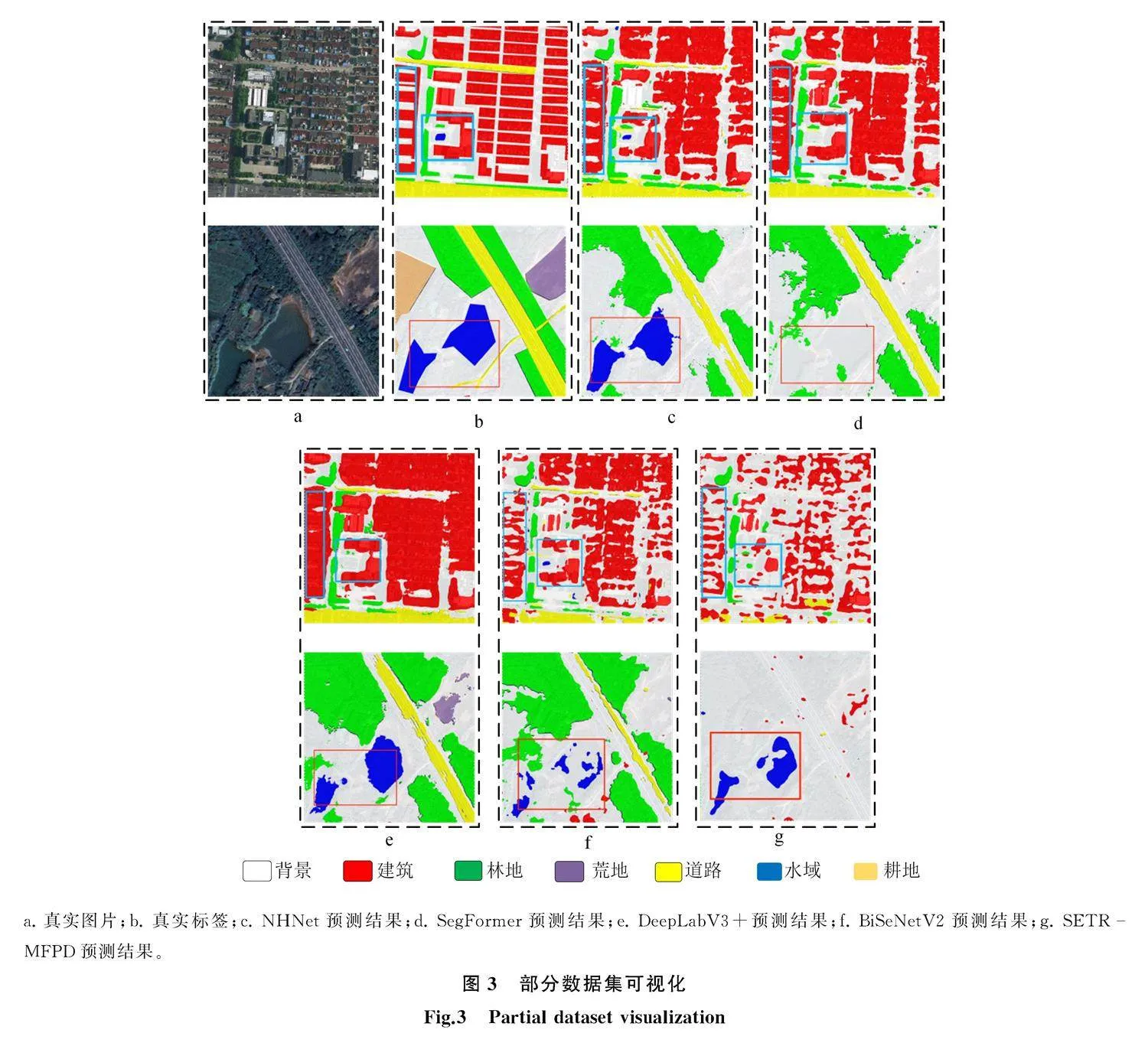

為了更直觀地展示實(shí)驗(yàn)結(jié)果,本文將部分?jǐn)?shù)據(jù)集進(jìn)行了可視化,結(jié)果如圖3所示。從圖3中可以看出,真實(shí)標(biāo)簽中建筑物間的空地較大,NHNet盡可能地識別出了這些在建筑物中的空地,基于transformer的SegFormer也有這種識別能力,但是基于卷積的DeepLabV3+識別的建筑物基本上是連續(xù)的狀態(tài);同時(shí)發(fā)現(xiàn)NHNet對荒地的識別程度不高,從而導(dǎo)致了整體識別度的變低。

2.5" 消融研究

本文通過消融實(shí)驗(yàn)進(jìn)一步驗(yàn)證NHNet中T模塊、C模塊和特征注入模塊的影響。所有的結(jié)果都在LoveDA測試集上進(jìn)行驗(yàn)證和評估,如表4所示。從表4中可以看出,基線的平均交并比為46.20%;當(dāng)加上注重于淺層空間特征的C模塊時(shí),平均交并比達(dá)到了47.23%,相比于基線提升了1.03%;之后在網(wǎng)絡(luò)中加上注重于高層語義信息的T模塊,平均交并比達(dá)到了49.64%,相比于C模塊提升了2.41%。這證明C模塊、T模塊對聚類算法具有很好的輔助提升作用。但是這兩個(gè)模塊對于整個(gè)網(wǎng)絡(luò)架構(gòu)的影響不同,從表4中可以看出,T模塊對于網(wǎng)絡(luò)效果

的提升作用比C模塊高1.38%。本文認(rèn)為造成這種現(xiàn)象的原因是基于相似度的聚類算法缺乏對語義信息的有效提取,而基于多頭自注意力的T模塊強(qiáng)化了高層特征圖的全局語義信息,加強(qiáng)了網(wǎng)絡(luò)對相似類別和困難類別的辨別能力。另一方面,聚類算法具有較強(qiáng)的空間細(xì)節(jié)信息捕捉能力,所以注重于空間信息特征的C模塊對其的強(qiáng)化弱于T模塊。

表5給出了特征注入模塊的消融實(shí)驗(yàn)結(jié)果,表中CFIM代表使用了特征注入,但是注入方式與FIM不同,CFIM也放棄了原有的特征,但是將處理之后的特征注入到了M3中,然后進(jìn)入分割頭。從表5中可以看出,無注入時(shí)平均交并比比使用特征注入模塊時(shí)低1.64%,說明特征增強(qiáng)只具有輔助作用,不能完全代替原本骨干網(wǎng)絡(luò)學(xué)習(xí)到的特征信息,需要特征注入模塊來緩解不同特征提取方法間的差異。使用CFIM的情況比使用FIM的平均交并比低1.90%,這與直觀上的理解一致,注入不同尺度的特征,盡管通過上采樣達(dá)到了相同的分辨率,仍不能彌補(bǔ)它們之間存在的差異,所以這也是三個(gè)對比實(shí)驗(yàn)中效果最不好的。

3" 結(jié)語

本文提出了一種結(jié)合多種特征提取方式的新型遙感圖像分割網(wǎng)絡(luò),將聚類算法、卷積算法和多頭自注意力算法這三個(gè)特征提取方式結(jié)合使用,利用聚類算法的區(qū)域構(gòu)建屬性實(shí)現(xiàn)感受野的合理劃分,搭建了由聚類塊組成的基本特征提取模塊;基于層次化的遙感圖像分割架構(gòu),使用基于卷積的C模塊促進(jìn)淺層空間細(xì)節(jié)信息的精確分割,使用基于自注意力的T模塊加強(qiáng)網(wǎng)絡(luò)的語義特征提取能力,利用特征注入模塊平衡不同特征間的差異,實(shí)現(xiàn)了更加平滑的特征融合。本文在實(shí)驗(yàn)部分證明了這種方法的有效性,并且在公開數(shù)據(jù)集上取得了良好的效果。

但是NHNet多種特征提取方式的結(jié)合體現(xiàn)在整體網(wǎng)絡(luò)架構(gòu)上,還沒有更深層次的融合促進(jìn)。因此未來的研究方向會集中于更深層次的融合促進(jìn),比如將特征增強(qiáng)模塊加入骨干網(wǎng)絡(luò)中,在網(wǎng)絡(luò)運(yùn)行的每一個(gè)階段進(jìn)行實(shí)時(shí)的雙向融合,或者在特征增強(qiáng)模塊之后設(shè)計(jì)一個(gè)更加徹底的特征混洗,設(shè)計(jì)關(guān)系感知融合模塊。

參考文獻(xiàn)(References):

[1]" 蔣濤,姜笑,郭金運(yùn),等.利用衛(wèi)星測高數(shù)據(jù)反演全球海底地形研究進(jìn)展[J].吉林大學(xué)學(xué)報(bào)(地球科學(xué)版),2023,53(6):20292044.

Jiang Tao, Jiang Xiao, Guo Jinyun, et al. Review on Research Progress of Recovering Bathymetry from Satellite Altimetry-Derived Data[J]. Journal of Jilin University (Earth Science Edition), 2023, 53(6): 20292044.

[2]" 李美霖,芮杰,金飛,等. 基于改進(jìn)YOLOX的遙感影像目標(biāo)檢測算法[J]. 吉林大學(xué)學(xué)報(bào)(地球科學(xué)版),2023,53(4):13131322.

Li Meilin, Rui Jie, Jin Fei, et al.Remote Sensing Image Target Detection Algorithm Based on Improved YOLOX[J]. Journal of Jilin University (Earth Science Edition), 2023, 53 (4): 13131322.

[3]" Guo S, Liu L, Gan Z, et al. Isdnet: Integrating Shallow and Deep Networks for Efficient Ultra-High Resolution Segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: Computer Vision Foundation, 2022: 43614370.

[4]" Ji D, Zhao F, Lu H, et al.Ultra-High Resolution Segmentation with Ultra-Rich Context: A Novel Benchmark[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver:Computer Vision Foundation,2023: 2362123630.

[5]" Wang W, Tang C, Wang X, et al.A ViT-Based Multiscale Feature Fusion Approach for Remote Sensing Image Segmentation[J]. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 15.

[6]" Adams R, Bischof L. Seeded Region Growing[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1994, 16(6): 641647.

[7]" Long J, Shelhamer E, Darrell T. Fully Convolutional Networks for Semantic Segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston:Computer Vision Foundation,2015: 34313440.

[8]" Ronneberger O, Fischer P, Brox T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]//Medical Image Computing and Computer-Assisted Intervention: MICCAI 2015: 18th International Conference. Munich: Springer International Publishing, 2015: 234241.

[9]" Zhao H, Shi J, Qi X, et al. Pyramid Scene Parsing Network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu:Computer Vision Foundation,2017: 28812890.

[10]" Chen L C, Zhu Y, Papandreou G, et al. Encoder-Decoder with Atrous Separable Convolution for Semantic Image Segmentation[EB/OL].[20230321]. https://doi.org/10.48550/ arXiv.1802.02611.

[11]" Yu F, Koltun V.Multi-Scale Context Aggregation by Dilated Convolutions[EB/OL]. [20240417]. https://arxiv.org/pdf/ 1511.07122.pdf.

[12]" Badrinarayanan V, Kendall A, Cipolla R. Segnet: A Deep Convolutional Encoder-Decoder Architecture for Image Aegmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(12): 24812495.

[13]" Dosovitskiy A, Beyer L, Kolesnikov A, et al.An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale[EB/OL]. [20240417]. https://arxiv.org/pdf/2010. 11929.pdf.

[14]" Xie E, Wang W, Yu Z, et al. SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers[J]. Advances in Neural Information Processing Systems, 2021, 34: 1207712090.

[15]" Liu Z, Lin Y, Cao Y, et al. Swin Transformer: Hierarchical Vision Transformer Using Shifted Windows[EB/OL]. [20230315]. https://doi.org/10.48550/arXiv.2103.14030.

[16]" Hassani A, Walton S, Li J, et al. Neighborhood Attention Transformer[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver:Computer Vision Foundation,2023: 61856194.

[17]" Hassani A, Shi H. Dilated Neighborhood Attention Transformer[EB/OL]. [20240417]. https://arxiv.org/pdf/ 2209.15001.pdf.

[18]" Mehta S, Rastegari M. Mobilevit: Light-Weight, General-Purpose, and Mobile-Friendly Vision Transformer[EB/OL]. [20240417]. https//arxiv.org/pdf/2110.02178.pdf.

[19]" Yang C, Wang Y, Zhang J, et al.Lite Vision Transformer with Enhanced Self-Attention[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans:Computer Vision Foundation,2022: 1199812008.

[20]" Chen Y, Dai X, Chen D, et al.Mobile-Former: Bridging Mobilenet and Transformer[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition." New Orleans:Computer Vision Foundation,2022: 52705279.

[21]" Mehta S, Rastegari M. Separable Self-Attention for Mobile Vision Transformers[EB/OL]. [20240417]. https://arxiv.org/pdf/2206.02680.pdf.

[22]" Wadekar S N, Chaurasia A. Mobilevitv3: Mobile-Friendly Vision Transformer with Simple and Effective Fusion of Local, Global and Input Features[EB/OL]. [20240417]. https://arxiv.org/pdf/2209.15159.pdf.

[23]" Li Y, Yuan G, Wen Y, et al. Efficient Former: Vision Transformers at MobileNet Speed[J]. Advances in Neural Information Processing Systems, 2022, 35: 1293412949.

[24]" Zhang W, Huang Z, Luo G, et al.TopFormer: Token Pyramid Transformer for Mobile Semantic Segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition." New Orleans:Computer Vision Foundation,2022: 1208312093.

[25]" Wan Q, Huang Z, Lu J, et al.SeaFormer: Squeeze-Enhanced Axial Transformer for Mobile Semantic Segmentation[EB/OL]. [20240417]. https://arxiv.org/pdf/2301.13156. pdf.

[26]" Han K, Wang Y, Guo J, et al.Vision GNN: An Image Is Worth Graph of Nodes[EB/OL]. [20240417]. https://arxiv.org/ pdf/2206.00272.pdf.

[27]" Ma X, Zhou Y, Wang H, et al.Image as Set of Points[EB/OL]. [20240417]. https://arxiv.org/pdf/2303.01494. pdf.

[28]" Wang J, Zheng Z, Ma A, et al. LoveDA: A Remote Sensing Land-Cover Dataset for Domain Adaptive Semantic Segmentation[EB/OL]. [20240417]. https://arxiv.org/pdf/2110. 08733.pdf.

[29]" Yu C, Gao C, Wang J, et al. BiSeNet v2: Bilateral Network with Guided Aggregation for Real-time Semantic Segmentation[J]. International Journal of Computer Vision, 2021, 129: 30513068.

[30]" Fan M, Lai S, Huang J, et al. Rethinking BiSeNet for Real-Time Semantic Segmentation[EB/OL]. [20230406]. https://doi. org/10.48550/arXiv.2104.13188.