一種基于深度強化學習的頻率捷變雷達智能頻點決策方法

張嘉翔 張凱翔 梁振楠* 陳新亮③ 劉泉華②④

①(北京理工大學信息與電子學院雷達技術研究所 北京 100081)

②(北京理工大學重慶創新中心 重慶 401120)

③(北京理工大學長三角研究院(嘉興) 嘉興 314000)

④(衛星導航電子信息技術教育部重點實驗室(北京理工大學) 北京 100081)

1 引言

在現代戰爭中,敵方為了獲取電磁頻譜優勢與戰場主動權,通常會發射各種有源干擾破壞雷達作戰性能,從而掩護目標完成預定的作戰任務[1]。雷達為了應對各種干擾,相應的抗干擾技術在對抗中不斷升級[2]。一般來說,抗干擾技術按照雷達處理階段的不同可以分為主動抗干擾和被動抗干擾[3]。在雷達發射信號階段,主動抗干擾技術可以通過雷達波形設計降低敵方干擾機對雷達信號的截獲概率或識別概率,從而降低干擾機的干擾效能[4-6]。如果雷達已經接收到了干擾信號,被動抗干擾技術可以通過空、時、頻等多個處理域完成目標與干擾的分離,達到對干擾抑制的目的[7-9]。

隨著雷達抗干擾研究的不斷深入,被動抗干擾手段日益豐富。然而,掛載在掩護目標上的自衛式干擾機通過發射大功率瞄準干擾,使干擾與目標回波在多處理域重疊,難以分離。頻率捷變雷達通過使用自主調節發射信號載頻的主動抗干擾手段,使得干擾機難以截獲和干擾,為對抗自衛式壓制干擾提供了可能[10]。其抗干擾性能主要取決于跳頻策略,傳統隨機跳頻策略已經被證明不是最佳選擇[11]。如何精準預測干擾機下一時刻將要發射的干擾頻點,從而指導雷達信號的頻點選擇,是頻率捷變雷達在與干擾機博弈中取勝的主要難點。

相比針對靜態優化問題設計的啟發式搜索算法,強化學習可以讓智能體與環境不斷交互,獲得反饋,從而指導智能體在動態環境下進行決策[12]。基于深度學習模型強大的數據表征能力而衍生出的深度強化學習,能夠處理高維數據并完成非線性映射,彌補了傳統強化學習算法的不足[13],在認知電子戰方面已經得到了一定的研究。如果將干擾信息看作環境狀態,抗干擾措施看作雷達動作,抗干擾效能看作即時回報,那么認知抗干擾決策問題可以通過強化學習技術解決。文獻[14]針對干擾類型和參數固定的復合干擾場景,分別使用Q學習和SARSA (State-Action-Reward-State-Action)探索了抗干擾措施組合選取問題。文獻[15]使用改進的DDPG (Deep Deterministic Policy Gradient)算法對12種抗干擾措施進行選擇,以實施抗干擾措施前后干擾威脅度變化作為反饋。文獻[16]使用DDPGMADDPG (Deep Deterministic Policy Gradient and the Multi-Agent Deep Deterministic Policy Gradient)對包含復合干擾在內的12種干擾類型,以抗干擾改善因子作為反饋,進行多處理域抗干擾措施自適應選取。

在頻點決策方面,強化學習主要圍繞瞄頻或掃頻干擾的頻率捷變波形設計展開研究[17]。文獻[18]首次對雷達脈沖級跳頻策略展開研究,分別對比了隨機頻點選擇、Q學習、深度Q網絡(Deep Q-Network,DQN)等3種策略,證明了DQN在決策方面具備更好的性能。并在文獻[19]中繼續深化研究內容,將檢測概率作為獎勵值,而不是之前論文中的信干噪比,同時優化了DQN模型。文獻[20]在文獻[18]和文獻[19]工作的基礎上,考慮了一種具備偵收功能的干擾機,以及子脈沖頻率捷變雷達,并基于近端策略優化(Proximal Policy Optimization,PPO)算法完成智能決策。文獻[21]考慮了網絡化無人機雷達工作系統,使用雷達信息表示理論作為獎勵函數,基于雙貪婪的改進Q學習算法優化系統抗干擾性能。文獻[22]假定干擾機也具備馬爾科夫性質,在預測得到干擾策略的基礎上選擇雷達頻點與之對抗。文獻[23]考慮了跳頻速率會影響相干積分性能和多普勒分辨率,使用Q學習自適應調整雷達發射波形的脈寬和頻點以對抗掃頻干擾。

總體來說,上述研究均基于雷達不同的性能指標設計獎勵函數,以此優化頻點等雷達參數。雖然在對抗成功率方面超過隨機頻點決策方法,然而缺少對抗干擾策略收斂速度的討論。應當指出,在現代電子戰中,干擾機可能具備多種策略,并根據某種規則在不同策略間切換。因此雷達在進行抗干擾策略學習時,應當盡快收斂到最優策略,從而保持對抗先機。如果雷達還未收斂到最優策略時,干擾機改變策略,那么雷達將陷入被動地位。因此,網絡收斂時間或是所需樣本量是評價一個智能化算法能夠應用于實際作戰場景的重要衡量指標。

受上述研究啟發,考慮到現代干擾機具備偵收-瞄準-干擾的基本策略,本文針對頻率捷變雷達,設計了一種基于強化學習的雷達子脈沖跳頻抗干擾策略。將當前時刻感知到的干擾頻點以及上一時刻的雷達頻點作為狀態,將當前時刻的雷達頻點選擇策略作為動作,以目標檢測結果和信干噪比作為即時獎勵函數設計強化學習關鍵要素,基于DQN完成子脈沖頻點選取策略的學習。仿真針對兩種不同偵收策略的干擾機,證明了所提方法的有效性以及較高的收斂效率。

與文獻[20]不同的是,本文的主要貢獻在于如何通過對強化學習關鍵要素的設計,從而達到快速收斂到最優解的目的,而不是在于網絡設計與修改。具體包括4點:(1)雖然干擾機具備偵干周期,但是我們通過狀態空間的合理設計,僅使用單個時間步即可學習到干擾周期性策略,同時不需要使用長短期記憶網絡(Long Short-Term Memory,LSTM)等時間記憶網絡即可完成最優策略學習,顯著降低了收斂時間。(2)在動作設計方面,我們設計了一種子脈沖頻點可重復選取的特殊波形,增大了動作空間選取范圍。(3)在動作選取方面,我們通過ε-貪婪原則,實現了搜索和利用的有效平衡。在訓練初期,以隨機搜索為主,減小了收斂到局部最優解的概率。隨著訓練過程的進行,隨機搜索概率逐漸降低,選擇網絡輸出動作的概率逐漸增加,便于收斂。(4)在獎勵設計方面,圍繞目標檢測性能,在單次目標檢測結果的基礎上,引入了更具差異性的信干噪比指標,緩解了因為采樣不充分可能收斂到局部最優解的情況。

2 背景

2.1 子脈沖頻率捷變波形設計

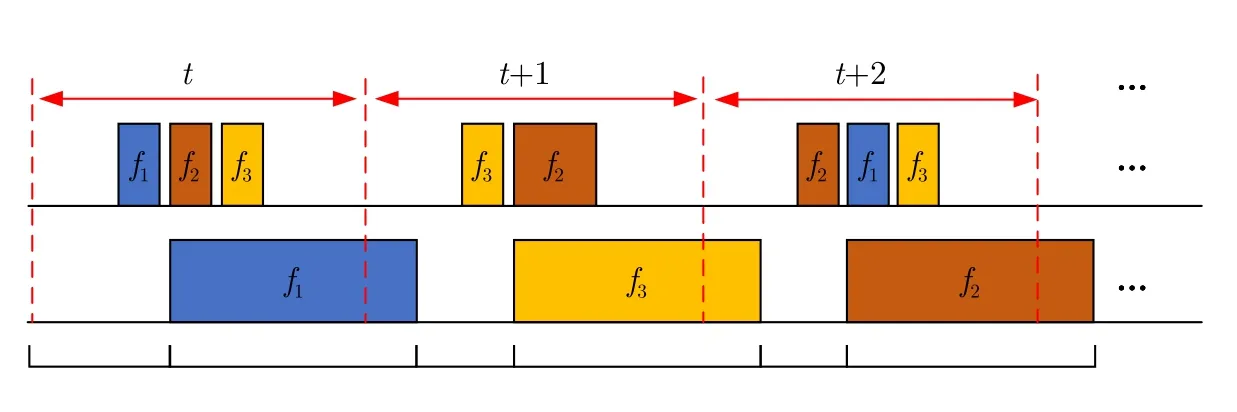

由于現代干擾機可以對接收到的雷達信號進行快速測頻與頻率引導,對傳統雷達具備較大威脅。而頻率捷變雷達可以實現子脈沖級的頻率調制,為與其對抗提供了可能。作為常用的雷達傳輸信號波形,基于線性調頻(Linear Frequency Modulation,LFM)信號的子脈沖頻率捷變波形如圖1(a)所示,其時域表達式如下:

圖1 頻率捷變波形示意圖Fig.1 Schematic diagram of the frequency agility waveform

其中,rect(·)表示矩形窗函數,N表示子脈沖個數,Tsub表示子脈沖脈寬;τn表示第n個子脈沖的延時,fn表示子脈沖頻點,Kn表示第n個子脈沖的調頻斜率。頻率捷變雷達各可選頻點應當去相關從而達到頻率抗干擾的目的,即保證si(ω)sj(ω)=0,其中,s i(ω)表 示子脈沖i的頻譜,sj(ω)表示子脈沖j的頻譜。

式(1)所定義的傳統頻率捷變雷達在進行子脈沖頻點選取時,通常會選擇不同的雷達頻點。為擴充頻點選取自由度,增大波形復雜度,本文設計了一種子脈沖頻點可重復選取的雷達發射波形,如圖1(b)所示。當相鄰子脈沖選取重復頻點時,則將其合成一個寬脈沖,其脈寬為Tcom=NrepTsub,其中Nrep表示選取相同頻點的相鄰子脈沖數量。同時保證合成后的寬脈沖帶寬不變,即Bcom=Bsub。合成后的脈沖數用Ncom表示。

2.2 強化學習與Q學習算法原理

強化學習可以由馬爾科夫決策過程(Markov Decision Process,MDP)描述,滿足馬爾科夫性質。強化學習的優化目標為最大化累計回報,定義為

其中,rt表示智能體在狀態st下執行動作at并轉移到st+1后得到的回報;γ為折扣因子,是st+1及其之后的獎勵權重,取值范圍為0~1,表示對未來獎勵的重視程度。

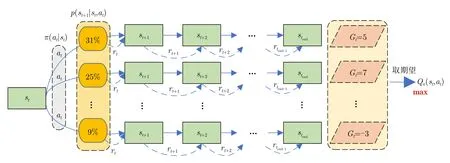

由于MDP是一種隨機過程,其隨機獨立性導致累計回報Gt是一個隨機變量,無法定量描述,如圖2所示。因此可對累計回報取期望,獲得狀態值函數Vπ(s) 和動作狀態值函數Qπ(s,a),將優化問題變成找到一種最優策略π,使任意一個狀態的Vπ(s)或Qπ(s,a)為最大。而Q學習的優化目標是針對Qπ(s,a),其貝爾曼方程及最優動作狀態值函數Q*(s,a)定義如下:

圖2 MDP的隨機獨立性與強化學習的優化目標Fig.2 The random independence of MDP and the optimization objectives of reinforcement learning

由于在實際場景中,我們可能不知道環境先驗信息p(s′|s,a),因此無法獲得值函數的解析表示。而Q學習可以通過多次取平均的方式,近似估計得到Q。具體來說,從任意狀態開始與環境1個時間步長,利用t時刻的即時回報rt和下一時刻最大的狀態動作值函數對當前時刻動作狀態值函數Q(st,at)進行估計,最后重復上述動作多次取平均。值函數的更新公式為

其中,α為學習率,表示更新的步長。

Q學習通過不斷與環境進行交互來獲取并更新Q值,并將Q值存入到由狀態和動作組成的Q表中。待智能體學習完成后,根據當前狀態的Q值來選取能夠獲取最大收益的動作。

3 基于深度Q網絡的自適應頻點決策

3.1 基于深度Q網絡的子脈沖頻點決策模型

雷達子脈沖級頻點決策往往對應于指數級增長的動作空間,而傳統Q學習基于Q表存儲和查找Q值,維護難度巨大。而DQN利用神經網絡擬合值函數,替換了傳統Q表的存儲方式,有效解決了高維狀態和動作空間的尋優問題。

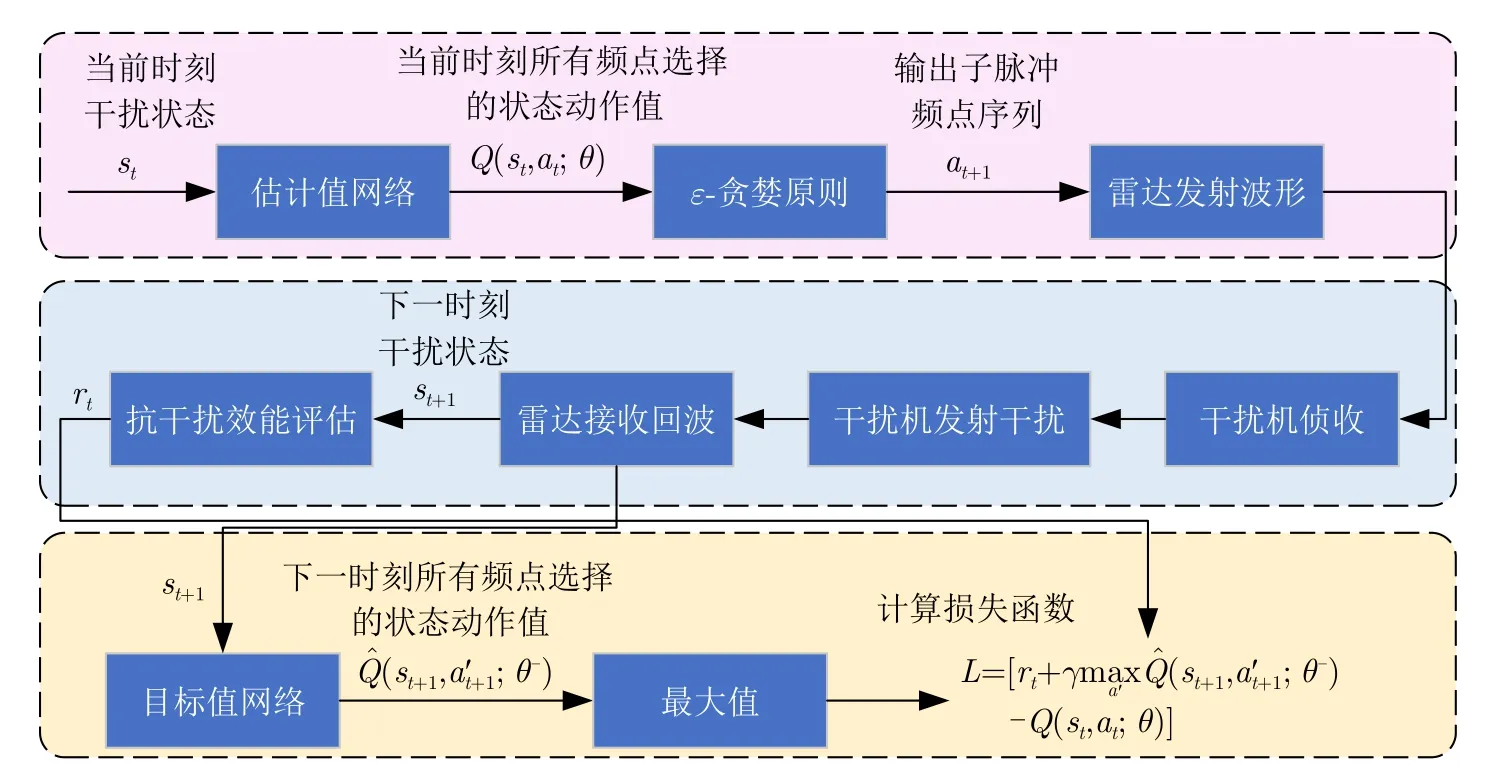

圖3 DQN網絡參數的更新過程Fig.3 The network parameter update process of DQN

輸入當前狀態st,通過估計值網絡預測得到當前狀態st對應的不同動作at的Q值,然后通過ε-貪婪原則選擇at并轉至下一狀態st+1,同時獲得rt。通過目標值網絡計算下一狀態st+1的最大值,將其與估計值作差更新估計值網絡參數θ,表示為

其中,ε-貪婪原則以概率 1-ε選擇估計值網絡輸出的具有最大Q值的頻點,以概率ε隨機選擇頻點,并隨著訓練步數的增加減小ε,從而達到搜索和利用的充分結合。

上述流程經過一定次數后,基于軟更新來更新目標值網絡參數θ-:

其中,0<τ ?1表示軟間隔更新系數。由于在一段時間內目標值具有一定穩定性,這能在一定程度上降低估計值 Q網絡和目標值網絡之間的耦合性,提升了網絡的收斂性和穩定性。

訓練完成后,測試時直接輸入當前時刻狀態至訓練好的模型中,即可獲取最優動作。

3.2 強化學習關鍵要素設計

上述提及的狀態、動作和獎勵是強化學習的關鍵要素,其中狀態和獎勵是算法的輸入,動作是算法的輸出。設置如下:

(1) 狀態空間:假設雷達能夠通過干擾感知等手段獲取干擾頻點信息,則狀態空間由雷達子脈沖頻點和干擾頻點組成。

其中,fR,t-1=[fsub1,t-1,fsub2,t-1,...,fsubN,t-1] 和fJ,t分別表示t-1時刻雷達N個子脈沖的頻點選擇以及t時刻干擾瞄準頻點。fJ,t取值范圍為 1~(N+1),1~N表示干擾機發射窄帶瞄頻干擾的瞄準頻點,(N+1)表示干擾機發射寬帶阻塞干擾。fsubn,t(1≤n≤N) 的取值范圍為 1~N,表示第n個子脈沖的頻點。

(2) 動作空間:t時刻雷達N個子脈沖頻點選擇:

(3) 獎勵函數:獎勵函數應當圍繞雷達作戰任務設置,本文以預警雷達為例,采用目標檢測結果Fd和信干噪比(Signal-to-Jamming-plus-Noise Ratio,SJNR)作為評價指標。前者直接反映了目標檢測能力,而后者的存在加快了最優解的收斂速度,降低收斂到局部最優解的可能,從而最大化目標檢測性能。定義如下:

其中,對于目標檢測結果Fd,我們可以根據提前獲取的戰場態勢信息預估目標距離波門,在子脈沖脈壓后基于單元平均恒虛警率(Cell Average-Constant False Alarm Rate,CA-CFAR)檢測判斷目標能否被檢測到[24]。如果第n個子脈沖檢測到目標則Fd,n=1,反之則Fd,n=-1。同時可以獲取目標平均功率PT,n和干擾噪聲平均功率η為歸一化系數,用來將信干噪比限制在0~1之間,從而提高訓練穩定性。

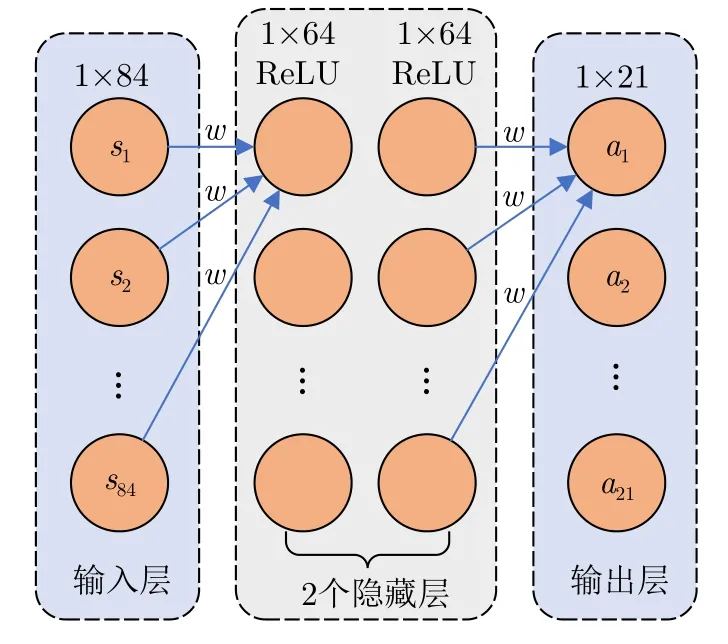

結合狀態、動作和獎勵的定義,基于深度Q網絡的雷達子脈沖頻點決策流程如算法1所示。

4 仿真與分析

4.1 場景設置

4.1.1 仿真參數設置

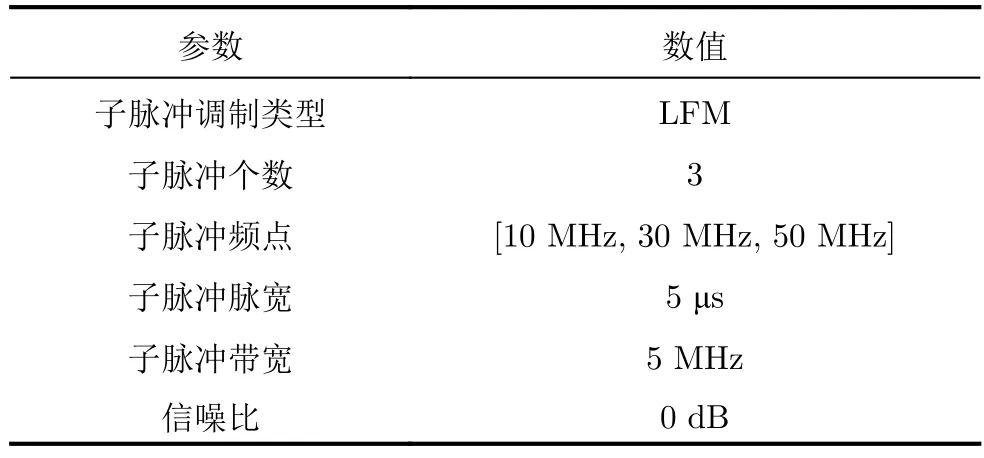

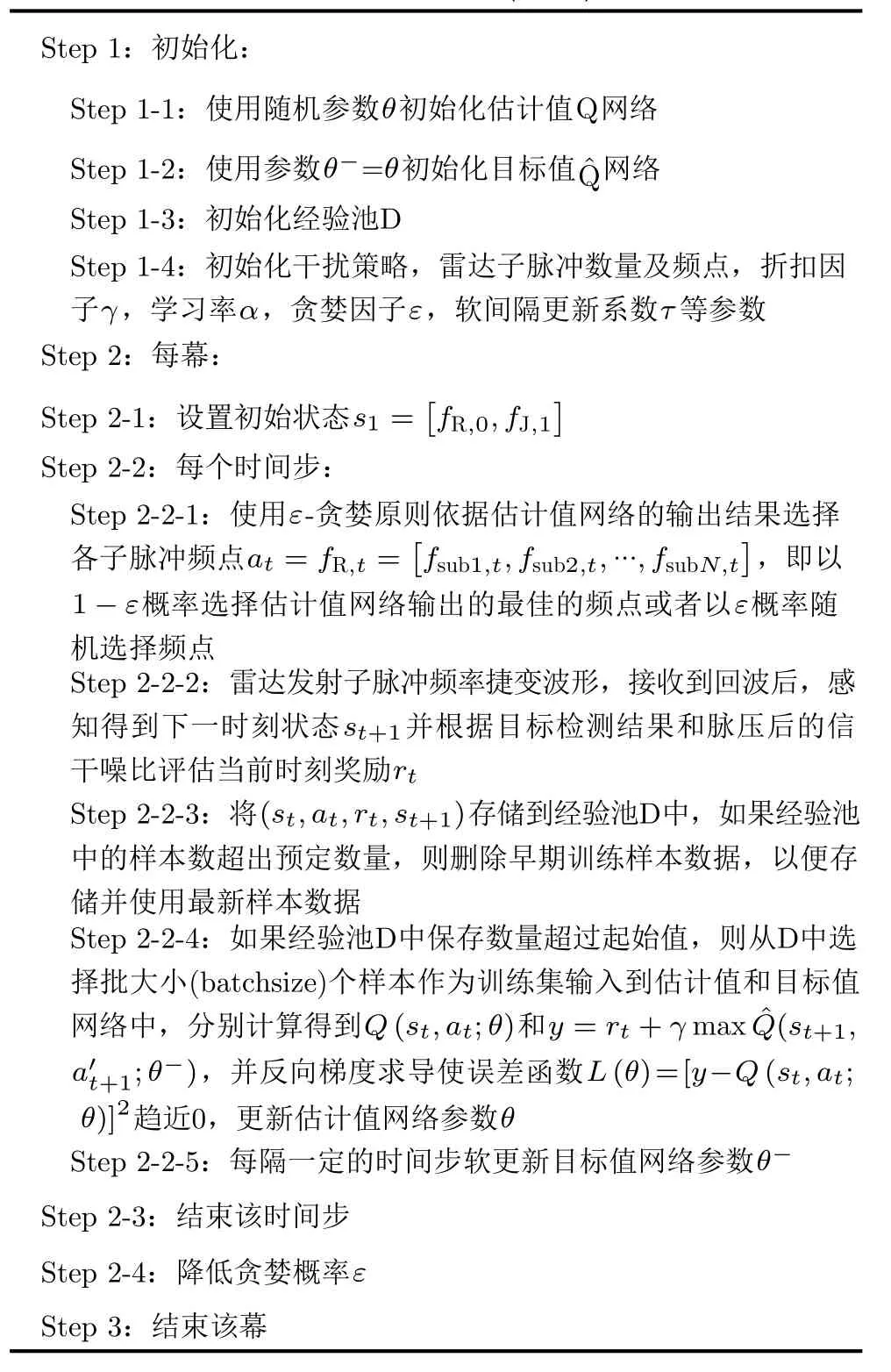

本文以3個子脈沖和3個可選頻點為例,討論DQN應用于子脈沖頻點自適應選取的可行性。為避免子脈沖脈壓后出現虛假目標,非相鄰子脈沖不能選取重復頻點,因此動作總數為 33-6=21。頻率捷變信號、干擾、DQN的仿真參數分別如表1-表3所示。其中,每幕表示1個相參處理間隔(Coherent Processing Interval,CPI),時間步t表示某個CPI中的第t個脈沖重復周期。

表1 頻率捷變信號參數設置Tab.1 The parameter settings of frequency agile signal

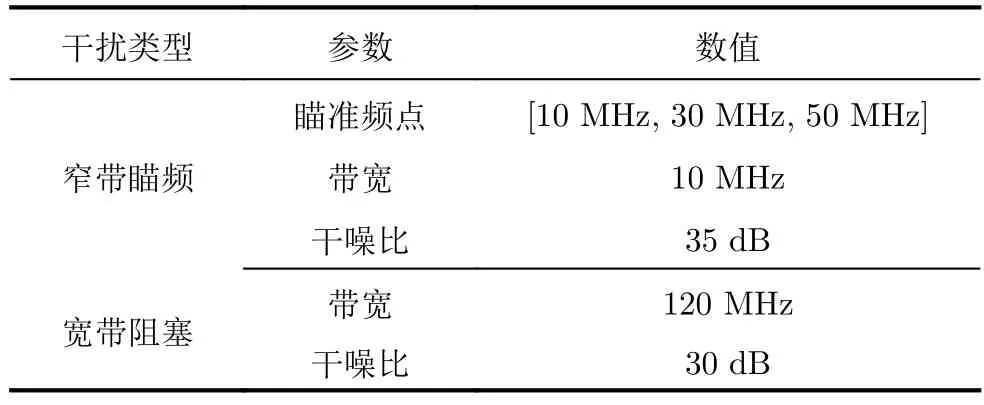

表2 干擾參數設置Tab.2 The parameter settings of jamming

表3 DQN參數設置Tab.3 The parameter settings of DQN

很重要的一個技巧是,本文在基于貪婪原則隨機選取動作時,只考慮所有子脈沖選擇相同頻點的情況,即脈內不跳頻。該處理旨在盡可能提高相參處理增益以及使干擾機偵收到單頻信號并誘導其發射窄帶瞄頻干擾,從而加快最優策略學習。同樣出于加速收斂的目的,輸入到神經網絡的獎勵按照子脈沖個數進行了歸一化。

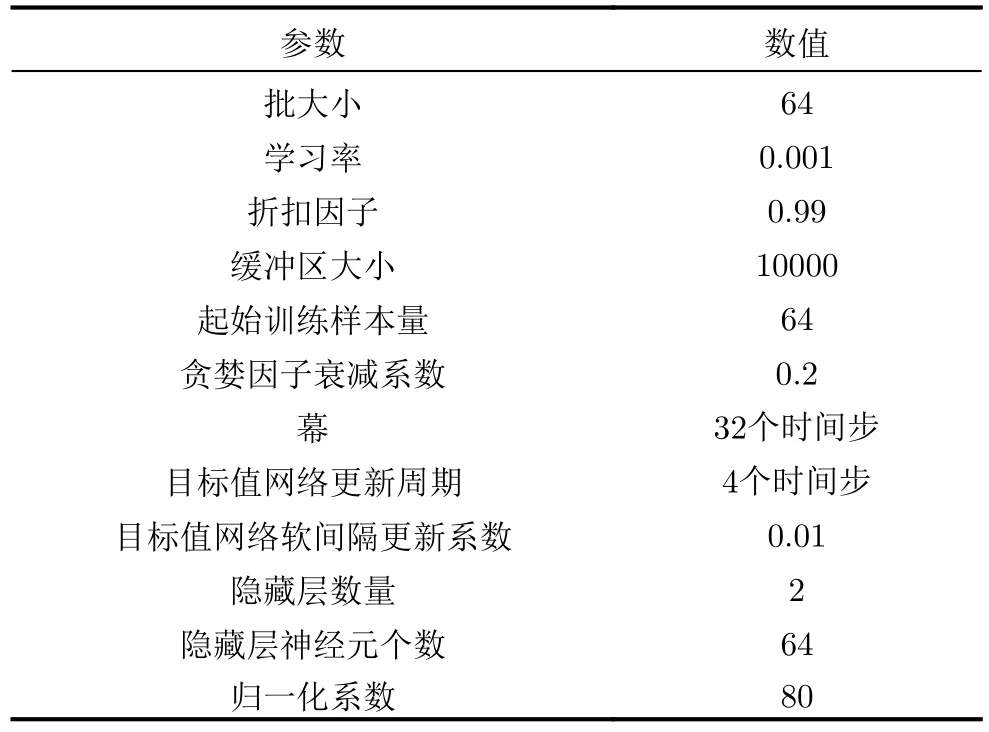

估計值網絡和目標值網絡的結構相同,均使用4層全連接神經網絡,分別為輸入層、2個隱藏層和輸出層。其中,隱藏層的神經元個數均為64,并使用ReLU作為激活函數,如圖4所示。

圖4 全連接神經網絡結構示意圖Fig.4 The schematic diagram of fully connected neural network structure

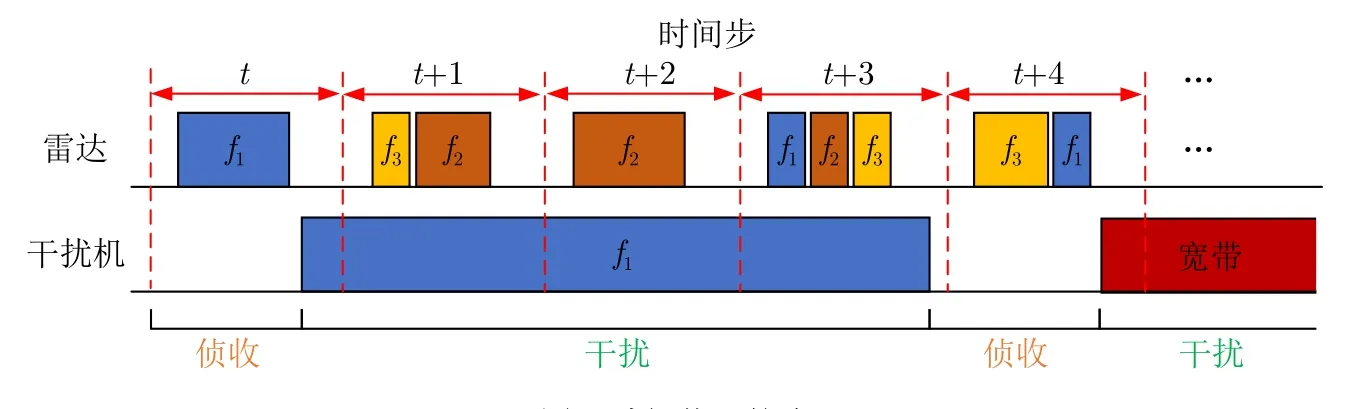

4.1.2 干擾策略設置

考慮一個具備偵收功能的干擾機,并根據偵-干時間長短分別設置了脈內偵干和脈間偵干等兩種固定干擾策略,分別如圖5、圖6所示。由于切片轉發干擾的對抗效果受限于切片寬度、轉發次數等參數,靈活的參數變化可能會導致對抗失效,因此本文考慮的干擾類型為壓制干擾,包括窄帶瞄頻和寬帶阻塞。其中,窄帶瞄頻干擾的帶寬為雷達子脈沖帶寬的2倍,更寬的帶寬會使得全部狀態的獎勵值發生整體偏移,但在歸一化后會消除該影響。

算法 1 基于深度Q網絡的雷達子脈沖頻點決策Alg.1 Radar sub-pulse frequency decision based on Deep Q-Network (DQN)

圖5 脈內偵干策略Fig.5 The intra-pulse interception-jamming strategy

圖6 脈間偵干策略Fig.6 The pulse-to-pulse interception-jamming strategy

對于脈內偵干策略,假設干擾機偵收到雷達脈沖上升沿及下降沿,立即對其測頻,轉發對應頻點的窄帶瞄頻干擾。值得注意的是,干擾時長設置略小于1個脈沖重復周期(Pulse Repetition Time,PRT),從而使得在當前PRT會同時受到上一時刻以及當前時刻的干擾。因此,雷達在該干擾策略下的一種較為合適的選擇為后續子脈沖發射不同于子脈沖1的雷達頻點,并且每個PRT均保持相同的發射策略。由于干擾所在頻點在濾波后可能會在鄰近頻點上存在干擾功率殘留,因此最優策略為雷達后續子脈沖跳頻到距離子脈沖1所選頻點的最遠頻點上。即雷達最優頻點選擇為 [1,N,N] 或 [N,1,1]。

對于脈間偵干策略,假設干擾機從偵收到第1個子脈沖開始持續偵收一段時間,直至沒有檢測到子脈沖時偵收結束。根據偵收結果發射一段時間長度的干擾,干擾時長在3~4個PRT之間。相比脈內偵干策略,后者不會在某個PRT同時受到兩部分干擾。在偵收階段若只偵收到1個頻點,則發射對應頻點的窄帶瞄頻干擾,反之則發射寬帶阻塞干擾。雷達需要盡量避免干擾機發射寬帶阻塞干擾,為此雷達需要在干擾機偵收階段時只發射單頻信號,而在干擾階段時選擇其余頻點。類似地,考慮到濾波引起的干擾功率殘留,在干擾機偵收時雷達最優策略為 [1,1,1] 或 [N,N,N],對應的干擾時雷達最優策略為 [N,N,N] 或 [1,1,1]。

值得注意的是,脈間偵干策略雖然具備周期性,但當前時刻的干擾動作不完全取決于上一時刻的狀態,而是按照固定的時序執行偵收和干擾,因此不具備馬爾科夫性。脈間偵干策略尋求的是由4個PRT組成的偵干周期的最大獎勵,滿足式(5)所示的貝爾曼最優方程的價值迭代原理,因此可以使用強化學習解決。

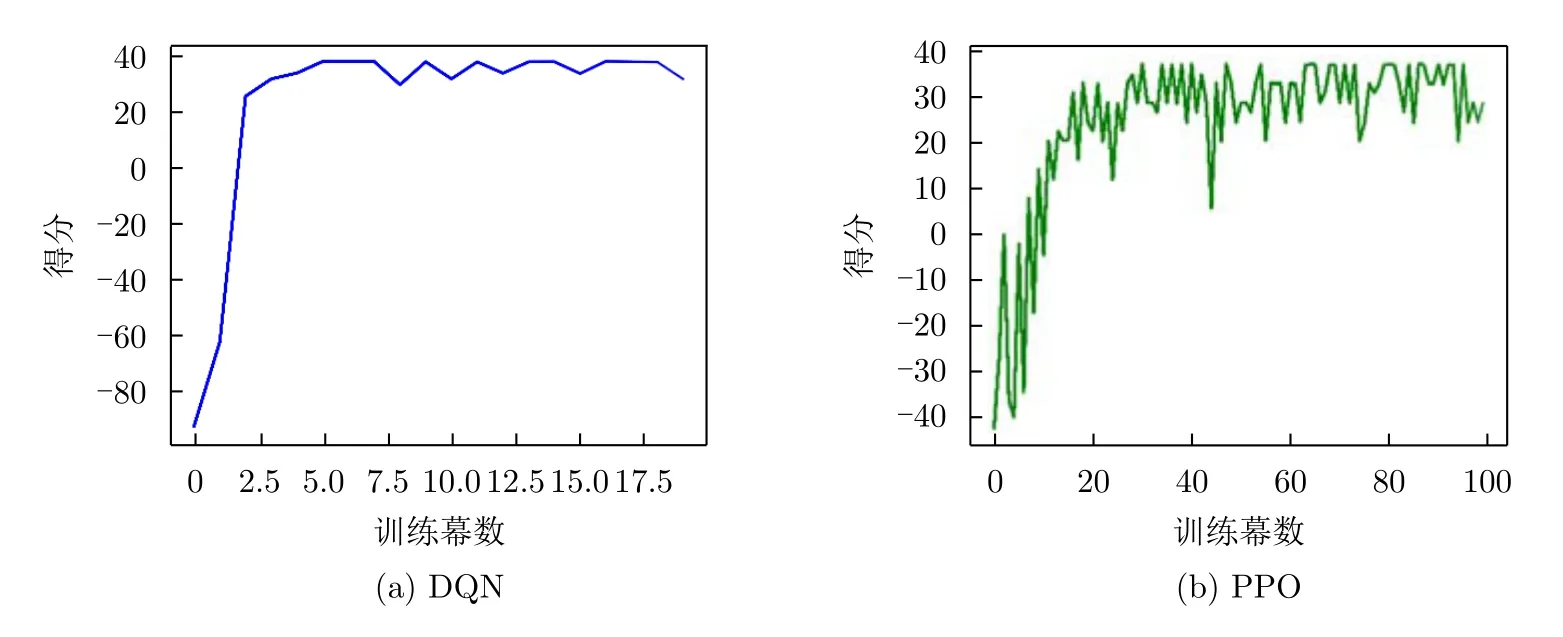

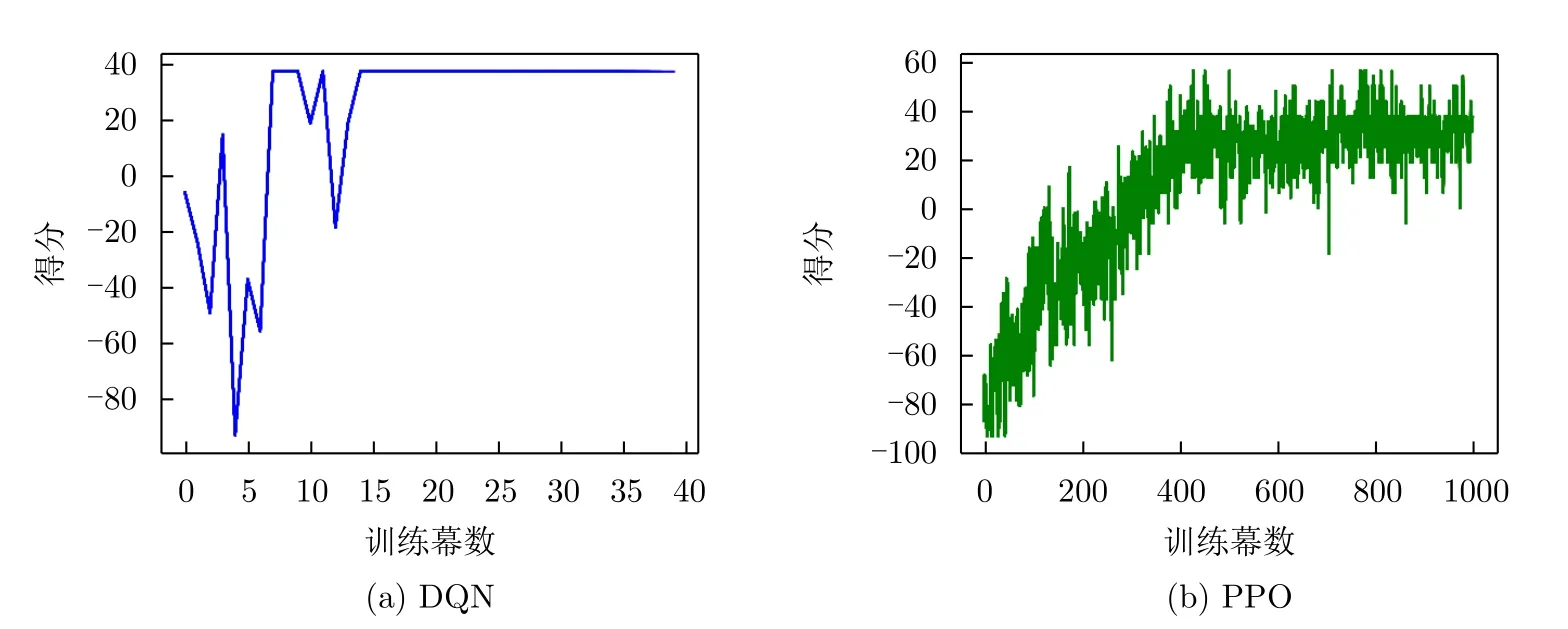

4.2 脈內偵干策略

此時干擾機偵收到1個子脈沖的上升沿與下降沿后,完成測頻并立刻發射干擾,雷達頻點對抗的訓練結果如圖7所示。得分曲線在第4個CPI左右即可收斂,在36分附近波動,如圖7(a)所示。圖7(b)展示了文獻[20]提出的基于PPO與LSTM相結合的頻點決策算法,其至少需要30幕的時間才能提升到32分附近震蕩,因此策略學習耗時且魯棒性較差。其本質原因在于PPO為on-policy算法,只能利用神經網絡進行動作搜索,導致探索性不足,所以存在收斂速度慢、可能會收斂到局部最優解、得分無法保持等諸多問題。

圖7 脈內偵干策略的子脈沖頻點決策訓練結果Fig.7 The training results of sub-pulse frequency decision for the intra-pulse interception-jamming strategy

根據圖7(a)的收斂情況,保存前10個CPI的訓練模型,每個模型對抗100幕,對抗成功率如圖8所示。根據4.1.2節對脈內偵干策略的分析,雷達應將未被偵收到的子脈沖頻點設置為距離偵收頻點的最遠頻點。因此,PRT對抗成功定義為{fR=[1,3,3]&fJ=1} 或{fR=[3,1,1]&fJ=3},即21個動作中只有2個動作為最優,占比9.5%。CPI對抗成功的判決依據是當前CPI內所有PRT均對抗成功。

圖8 訓練用CPI數量對脈內偵干策略下對抗成功率的影響Fig.8 The impact of the number of CPI used for training on the success rate of confrontation for the intra-pulse interception-jamming strategy

發現訓練所用CPI數量對對抗成功率的影響與收斂情況基本對應,從第3個CPI開始,對抗成功率即可達到100%。

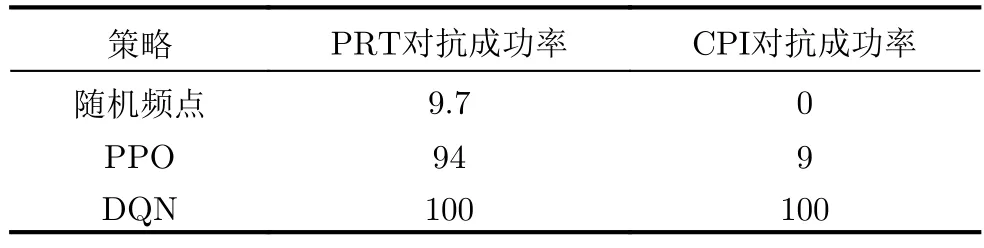

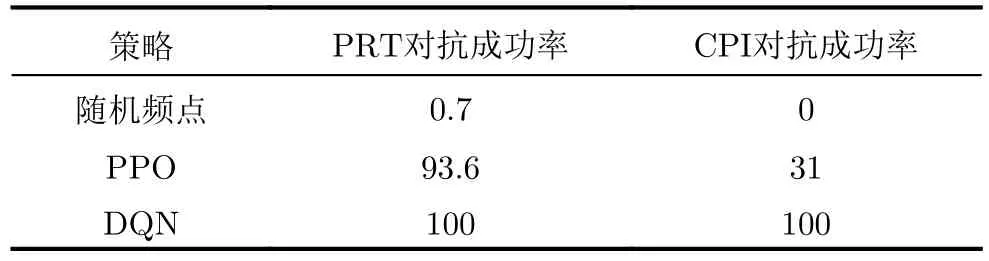

表4展示了隨機頻點、PPO-LSTM和DQN的單次對抗(PRT)成功率,單幕(CPI)對抗成功率。隨機頻點決策的成功率與最優動作占比,即理論值大致相同。基于PPO的頻點決策雖然在第2個和第3個子脈沖避開了干擾頻點,但是由于其搜索力度不夠,有一定概率選取到次優策略。而基于DQN的頻點決策算法由于使用了ε-貪婪算法,大大擴展了動作搜索空間,更容易收斂到最優策略。

表4 脈內偵干策略的對抗成功率(%)Tab.4 The success rate of confrontation for the intra-pulse interception-jamming strategy (%)

PPO算法由于可以處理連續動作空間問題,并且可以學習到隨機策略,因此是強化學習中受眾面最廣的基線方法。然而在本文研究的頻點決策場景中,不涉及連續動作空間,最優策略也可以由隨機策略退化到確定性策略,因此PPO算法優勢沒有得到充分利用。更為重要的是,由于每幕對抗中次優策略不低于最優策略得分的10%,大大提高了僅依靠神經網絡參數進行動作搜索的最優策略收斂難度。

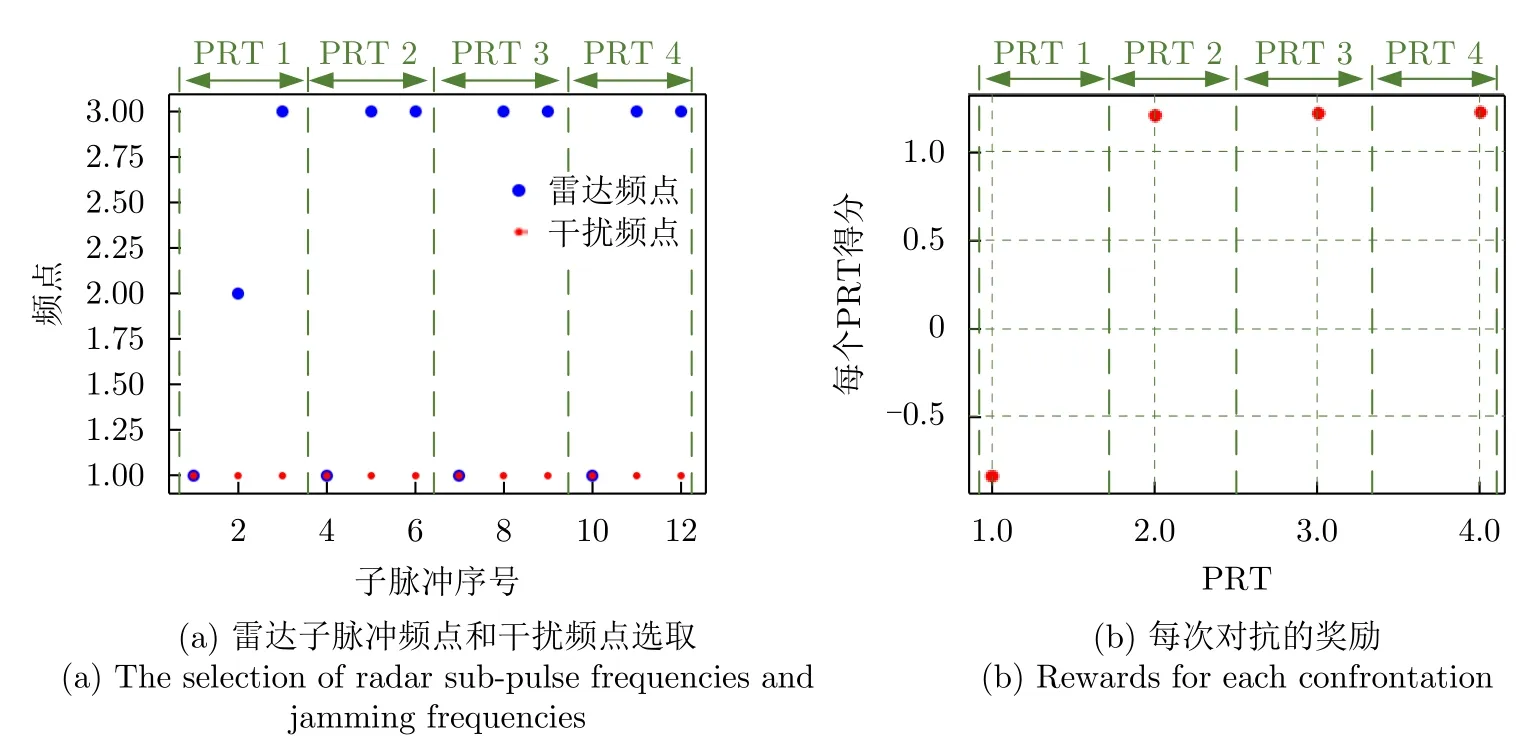

圖9(a)展示了雷達和干擾在4個PRT下的頻點選取情況。對于第1個PRT,由于初始狀態的隨機性,雷達選取頻點[1,2,3],干擾瞄準頻點1。由于單個子脈沖的信噪比增益有限,因此除被干擾的子脈沖外,另有1個子脈沖未能檢測到目標,獎勵為負值,如圖9(b)所示。在第2,3,4個PRT,基于訓練好的模型,雷達的第2個和第3個子脈沖均選擇離干擾頻點1最遠的頻點3,降低了干擾剩余能量的同時,合成了寬脈沖,提高了信噪比增益。

圖9 雷達與干擾對抗4個PRT的策略及對抗獎勵Fig.9 The strategies and rewards for radar anti-jamming during four PRT periods

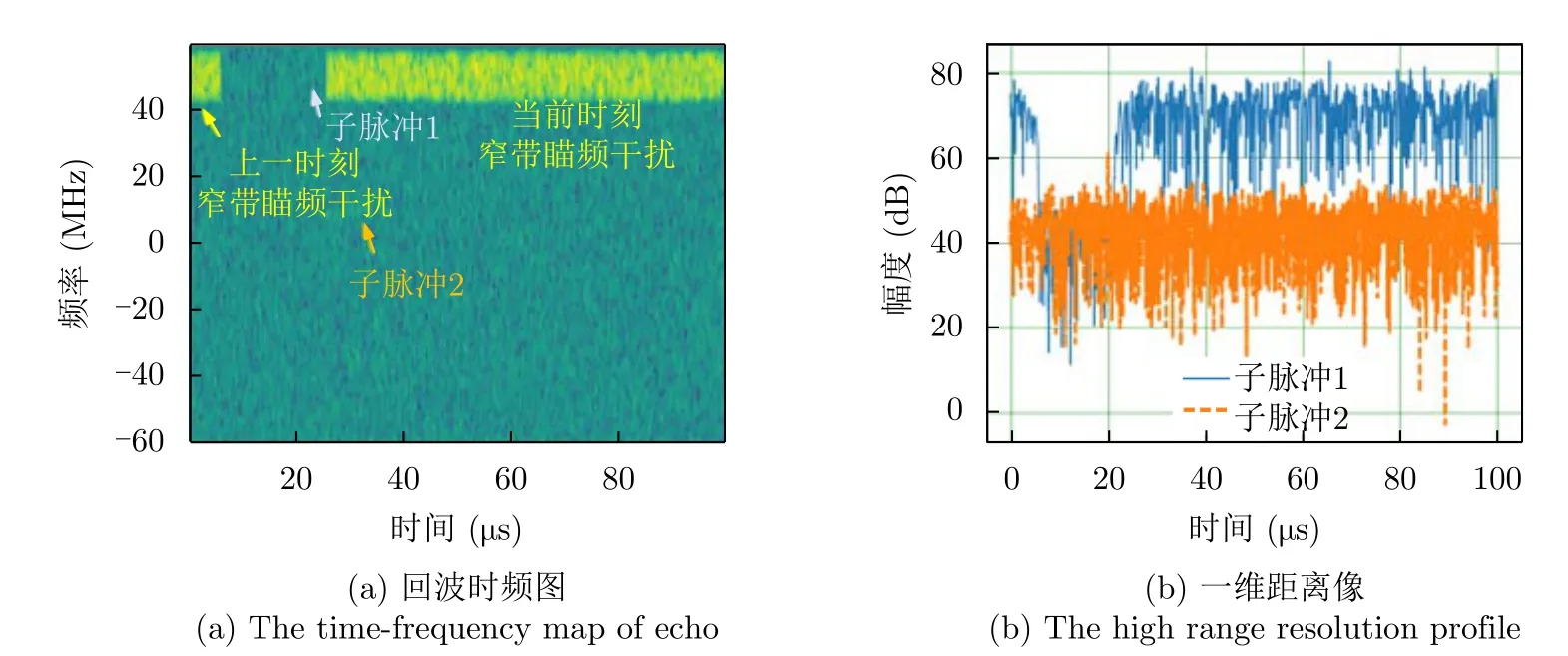

最優動作的時頻圖及一維距離像如圖10所示。當前PRT會同時收到瞄準上一時刻第1個子脈沖以及瞄準當前時刻第1個子脈沖的窄帶瞄頻干擾,后者會在瞄準后立即發射。因此,第1個子脈沖脈壓后,目標尖峰出現在當前時刻產生的大功率噪聲干擾邊緣,導致漏檢。第2個子脈沖由于跳頻策略與干擾頻域正交,因此脈壓后能夠檢測到目標尖峰,具有較高的信干噪比。

圖10 雷達執行最優策略的時頻圖及一維距離像Fig.10 The time-frequency map and the one-dimensional High-Resolution Range Profile (HRRP) for radar executing optimal strategy

本文圍繞目標檢測性能,基于單個PRT能否檢測到目標以及脈壓后的信干噪比兩方面評價跳頻抗干擾效能。表5展示了蒙特卡洛1000次下,雷達的幾個典型頻點選取策略的目標檢測率、脈壓后的信干噪比以及平均得分。為便于分析,假設當前時刻和上一時刻均干擾相同的頻點,頻點[3,1,1]和[1,3,3]為本文所提模型的策略。可以看出:

表5 脈內偵干策略下各種雷達策略對抗1000次結果(fJ=fsub1)Tab.5 The results of 1000 confrontations with various radar strategies for the intra-pulse interception-jamming strategy (fJ=fsub1)

(1) 由于在當前PRT能同時受到上一時刻和當前時刻的干擾,因此至少有一個雷達頻點會被干擾到。根據式(10)所示的獎勵函數計算方式,最大得分始終小于2;

(2) 當子脈沖2和子脈沖3跳頻成功時,兩個子脈沖均選擇離干擾頻點的最遠頻點時,平均得分最高,為最優策略,即[1,3,3]和[3,1,1];

(3) 諸如[1,2,3]和[2,1,3]等傳統頻點選取策略,由于脈壓增益有限,導致目標檢測率較低;而[1,2,2]和[2,1,1]等選擇了干擾頻點相鄰頻點的動作,由于濾波后的干擾能量殘余,從而降低了信干噪比,非最優策略;

(4) 次優策略和最優策略的單次對抗得分僅差0.06,網絡能夠捕獲到細微差異,收斂到最優解。

4.3 脈間偵干策略

針對脈間偵干策略,DQN和PPO的訓練曲線如圖11所示。DQN在第15幕(CPI)左右即可收斂,得分在37分附近。而PPO的訓練過程雖然整體呈現上升-平穩,但是其波動始終較為劇烈,且至少需要400幕左右才能趨于平穩。

圖11 脈間偵干策略的子脈沖頻點決策訓練結果Fig.11 The training results of sub-pulse frequency decision for the pulse-to-pulse interception-jamming strategy

圖12展示了訓練所用CPI數量對對抗成功率的影響,蒙特卡洛次數為100幕。由于雷達初始頻點隨機選取,不參與決策,因此去除包含初始狀態在內的第1個干擾偵干周期。從第2個周期開始統計,即每幕(CPI)對抗28次。根據4.1.2節對脈間偵干策略的分析,雷達應始終發射單頻信號,并在干擾機對當前脈沖偵收干擾后的下個脈沖跳到另一頻點,從而誘導干擾機在后續干擾周期內發射窄帶瞄頻干擾,避免發射寬帶阻塞干擾導致跳頻手段失效。由于干擾機可以在偵收后立即發射對應頻點的干擾,所以每個偵干周期內,無論采取何種手段,至少會存在1個PRT抗干擾失敗。因此可以僅針對剩余PRT計算抗干擾成功率,將PRT對抗成功定義為干擾機處于發射干擾階段時雷達選取到最優策略,即{fJ=3&fR=[1,1,1]}或{fJ=1&fR=[3,3,3]};CPI對抗成功的判決依據是當前CPI內所有PRT均對抗成功。

可以發現,在前20個CPI的訓練過程中模型學習到的策略不是一直向好,而是波動變化。在第13個PRT策略出現了明顯惡化,這與圖11(a)的訓練結果相一致。此時模型尚未穩定學習到干擾機的偵干策略,因此仍主要處于試錯探索階段。從第15~20個CPI,模型探索到干擾機策略,并學習到有效對抗策略,保持穩定。

100次蒙特卡洛仿真下的隨機頻點、PPO和DQN決策的單次對抗(PRT)成功率,單幕(CPI)對抗成功率如表6所示。由于對抗成功率隱含雷達在干擾機偵-干PRT和干擾PRT均發射不同的單頻信號,因此隨機頻點選擇的成功概率極低,僅有0.7%。相比PPO,DQN動作搜索更加充分,使對抗成功率得到有效提高,達到100%。

表6 脈間偵干策略的對抗成功率(%)Tab.6 The success rate of confrontation for the pulse-to-pulse interception-jamming strategy (%)

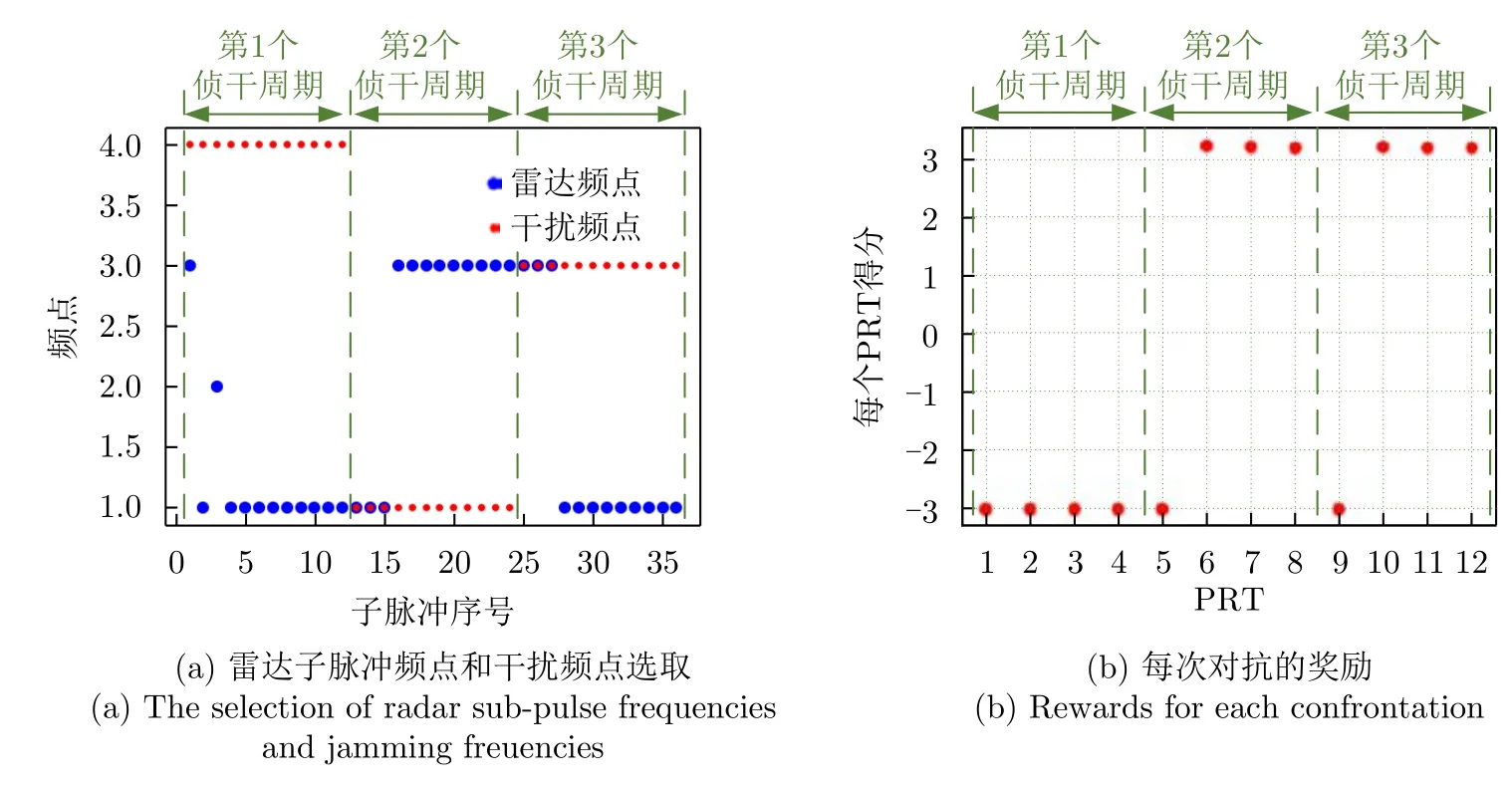

圖13(a)展示了干擾機的3個偵干周期下的雷達子脈沖頻點選取和干擾瞄準頻點。在第1個偵干周期中,由于雷達初始狀態的隨機性,3個子脈沖分別選取不同頻點,導致干擾機在接下來的3個PRT中發射寬帶阻塞干擾,此時無論雷達如何跳頻,目標均未被檢測到,獎勵為負值,如圖13(b)所示。在第2個偵干周期的第1次對抗中,雷達3個子脈沖均選擇頻點1,干擾機偵收到并立刻發射對應頻點的干擾,因此第1個PRT的獎勵為負值。接下來的3個PRT,干擾機繼續發射頻點1,而雷達選擇離頻點1最遠的頻點3。至此第2個偵干周期結束,雷達頻點選取成功。在第3個偵干周期中,雷達和干擾的頻點選取對調,雷達仍然能夠通過頻點決策選擇受到干擾最小的頻點。

圖13 對抗3個偵干周期的雷達策略及對抗獎勵Fig.13 The strategies and rewards for radar anti-jamming during three interception-jamming periods

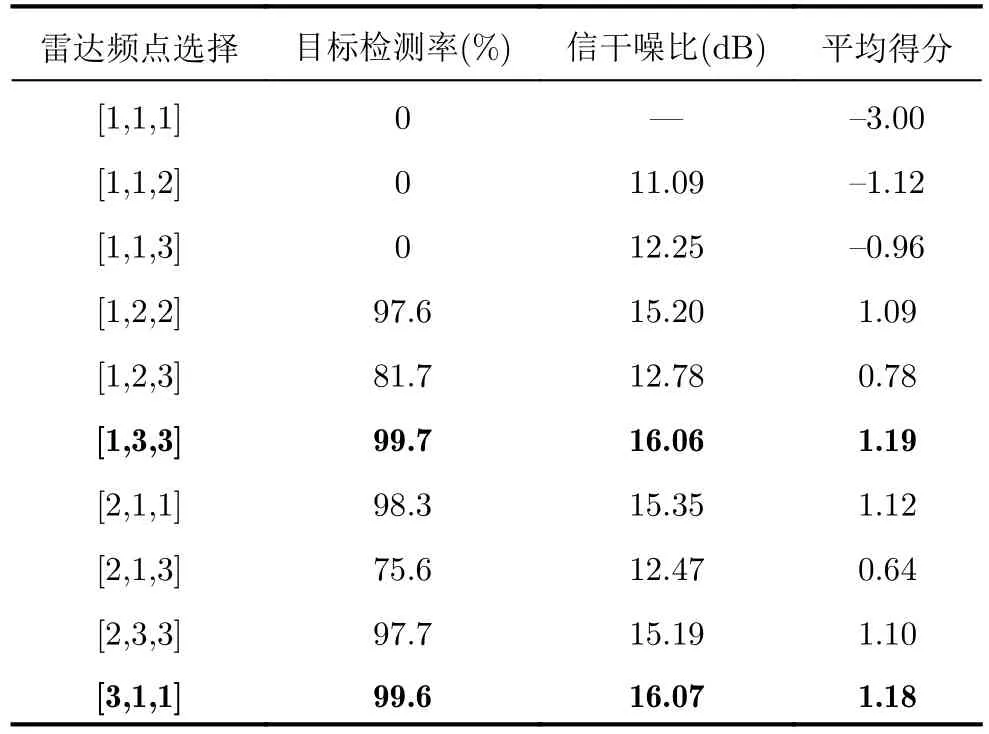

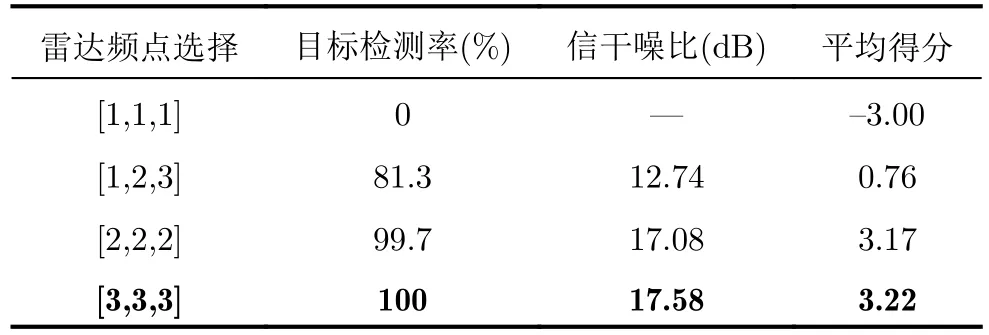

以干擾瞄準頻點1為例,蒙特卡洛1000次,統計各種策略對抗的目標檢測率、脈壓后的信干噪比以及平均得分,如表7所示,其中頻點[3,3,3]為本文所提模型的策略。可以看出:

表7 脈間偵干策略下各種雷達策略對抗1000次的結果(fJ=1)Tab.7 The results of 1000 confrontations with various radar strategies for the pulse-to-pulse interception-jamming strategy (fJ=1)

(1) 對于傳統雷達跳頻策略[1,2,3],有1個子脈沖會被干擾到,此時獎勵雖然為正值,但是較低;

(2) 對于[2,2,2],雖然從頻點數值上看確實跳頻成功,但此時瞄準頻點1的干擾功率可能未被全部濾掉,有很少一部分的功率會溢出到頻點2,使得其信干噪比略低于頻點3;

(3) 當雷達所有子脈沖均選擇頻點3時,接收到的干擾平均功率達到最小值,平均得分最高,為最優策略。

5 結語

針對瞄準式壓制干擾,本文面向頻率捷變雷達,提出了一種基于深度強化學習的頻點自適應快速選取方法。根據當前時刻干擾狀態,以及上一時刻雷達動作,依靠神經網絡自適應選取當前時刻最優雷達頻點,并基于目標檢測結果以及脈壓后的信干噪比作為獎勵反饋,迭代改進策略。仿真部分考慮了具備偵收-瞄準-干擾功能的干擾機,證明了通過關鍵要素設計可以以單個時間步長作為輸入學習到干擾策略的時序性。同時,所用DQN算法配合貪婪準則實現了搜索-利用的平衡,配合信干噪比的反饋加速最優抗干擾策略收斂,相比PPO算法收斂速度提升至少10倍。考慮到實際場景中,干擾頻點在濾波后可能在鄰近頻點存在能量殘余的情況,所提頻率捷變波形設計方法允許子脈沖多次重復選取距離干擾頻點最遠的雷達頻點,有效降低了回波中的干擾剩余能量,提高了信干噪比。同時擴展了動作空間,提供了最優動作選取的基礎。

通過本文研究發現,當子脈沖數或脈沖數較多時,增大了網絡的搜索和決策空間,使得收斂時間進一步增加,并且提高了最優策略的收斂難度。但這不會影響強化學習的關鍵要素設計,因此所提方法仍能根據交互數據的反饋結果進行策略優化。另外,考慮到子脈沖間、脈沖間的相位不一致,在積累時會帶來一定程度上的增益損失。因此在未來的研究中,考慮將子脈沖以及脈沖間的積累情況納入到獎勵函數中,從而指導策略選取。

利益沖突所有作者均聲明不存在利益沖突

Conflict of InterestsThe authors declare that there is no conflict of interests