基于區間分塊Q學習的智能車輛安全舒適剎車算法

余欣磊 周賢文 張依戀 顧偉

摘 要:針對當前智能汽車剎車場景下的安全與舒適性問題,提出一種基于區間分塊的Q學習算法。首先在Q表中將前車加速度以一定間隔劃分入等長區間,用區間中值做間隔來劃分后車加速度。其次通過在安全條件下與加速度呈負相關的獎勵設置,使智能體在保證安全的前提下盡量降低剎車加速度。最后在智能體訓練的過程中遵循ε-貪心策略以減少隨機性,在訓練完畢后遵循貪心策略以最大程度利用智能體。將提出的算法與傳統Q學習算法在三種常見道路場景上進行仿真測試。實驗結果顯示使用提出算法的智能車輛在剎車場景中安全率100%、平均剎車加速度小于2 m/s2且能處理連續剎車加速度,表明提出的算法能夠在確保智能汽車安全剎車的同時實現較低的剎車加速度。同時在連續剎車加速度與離線環境等復雜情況下,算法均能正常使用。

關鍵詞:智能汽車;智能剎車;Q學習;區間分塊

中圖分類號:TP391?? 文獻標志碼:A?? 文章編號:1001-3695(2024)01-027-0183-05

doi:10.19734/j.issn.1001-3695.2023.05.0220

Interval-block-based Q-learning algorithm for safe and comfortable braking of intelligent vehicles

Abstract: To address the safety and comfort issues in intelligent vehicle braking scenarios,this paper proposed a Q-learning algorithm based on interval partitioning.Firstly,the algorithm divided the acceleration of the preceding vehicle into equal-length intervals with a certain interval in the Q-table,and used the interval median to partition the acceleration of the following vehicle.Secondly,the algorithm used a reward function that was negatively correlated with acceleration under safe conditions to encourage the agent to minimize braking acceleration while ensuring safety.Finally,the algorithm followed the ε-greedy strategy during the training of the agent to reduce randomness,and followed the greedy strategy after training to maximize the utilization of the agent.This paper simulated the proposed algorithm and the traditional Q-learning algorithm on three common road scenarios.The experimental results show that the intelligent vehicle used the proposed algorithm has a 100% safety rate in braking scenarios,with an average braking acceleration of less than 2 m/s2,and can handle continuous braking acceleration,which indicates that the proposed algorithm can achieve lower braking deceleration to improve passengers comfort while ensuring safe braking of the intelligent vehicles.In addition,the algorithm is effective in complex scenarios including continuous braking deceleration and offline environments.

Key words:intelligent vehicle;intelligent braking;Q-learning;interval block

0 引言

目前智能網聯技術快速發展,各類互聯網行業巨頭紛紛涌入,智能汽車領域正成為新一輪科技革命和產業革命的戰略高地。隨著智能汽車數量的不斷增加,我國智能汽車行業也將迎來發展的黃金期[1]。在發展過程中,智能汽車暴露出一些問題,如因使用互聯網而帶來的網絡安全問題[2]、因緊急剎車導致的汽車追尾等安全問題[3]。據統計,我國因公路事故傷亡的死亡率高達30%(發達國家僅3%~4%)[4],而在汽車道路交通事故中,追尾問題占70%以上。其中,緊急剎車是導致追尾問題的一個重要誘因,因此,做好緊急剎車的有效應對,對于規避因汽車追尾產生的交通事故至關重要。

針對緊急情況下如何安全剎車這一問題,近年來已有許多專家學者進行了研究,2009年,Mamat等人[5]通過一個模糊邏輯控制器(fuzzy logic controller,FLC)將駕駛員的常見行為量化為一系列的規則并對其進行設計,從而對智能汽車的剎車進行自動控制。文獻[6]提出自動緊急剎車系統(automated emergency braking system,AEBS),主要依靠新興的傳感器技術,通過車載傳感器獲取前后車距離,進行機器條件判斷,最終決定是否剎車以及剎車力度調節。文獻[7]利用一個集成芯片對智能汽車剎車進行控制。文獻[8]采用深度強化學習的方法進行智能決策。隨著深度學習(deep learning,DL)的發展,尤其是深度強化學習在圍棋和其他電腦游戲下的展示,強化學習(reinforcement learning,RL)吸引了越來越多專家學者們的關注[9]。強化學習又稱為增強學習[10],是機器學習下的一個分支,區別于監督學習與無監督學習,強化學習不存在人為指導和方法,完全由機器對策略集進行學習。可以理解為強化學習智能體在與環境進行交互的過程中,通過不斷地嘗試,從錯誤中學習經驗,并根據經驗調整其策略,來最大化最終所有獎勵的累積值[11]。這使得強化學習具有很強的環境適應力,訓練完成后的智能體可以獨立工作,無須外界幫助。汽車剎車場景兼具時間短、網絡不穩定、場景復雜等特性,因此剎車控制器必須高效穩定且能應對復雜場景。而強化學習相較傳統的控制器設計算法效率更高,訓練完成后的智能體可不依賴網絡獨立工作,且對非線性問題處理非常有效。因此,強化學習十分切合汽車緊急剎車場景。

目前已有較多關于Q學習的研究,文獻[12]通過雙層深度Q神經網絡(double deep Q network,DDQN)研究飛機姿態控制,文獻[13]提出一種基于等效因子的汽車能量控制策略,文獻[14]提出一種基于雙Q表與啟發式因素的Q學習并將其應用于無人機空戰,但這些Q學習很少與汽車剎車問題聯系在一起,且幾乎沒有考慮乘客舒適度問題。然而,隨著人們對乘車舒適性需求的不斷提高,如何在保證安全的基礎上提升乘客乘車舒適度成了緊急剎車問題的一個研究重點。

本文采用強化學習中的Q學習實現智能車輛的安全舒適剎車,并在此基礎上,通過區間分塊方法改進Q學習,改進后的Q學習可以處理連續狀態空間問題。本文所做的工作主要有:a)結合實際駕駛場景,將汽車剎車問題轉換為強化學習問題,并考慮乘客舒適度,在安全剎車的前提下改善乘客體驗。b)提出區間分塊方法,對傳統Q學習算法改進,改進后的算法能夠有效處理連續狀態空間問題,切合實際汽車剎車場景。

1 模型與算法

1.1 汽車跟馳模型

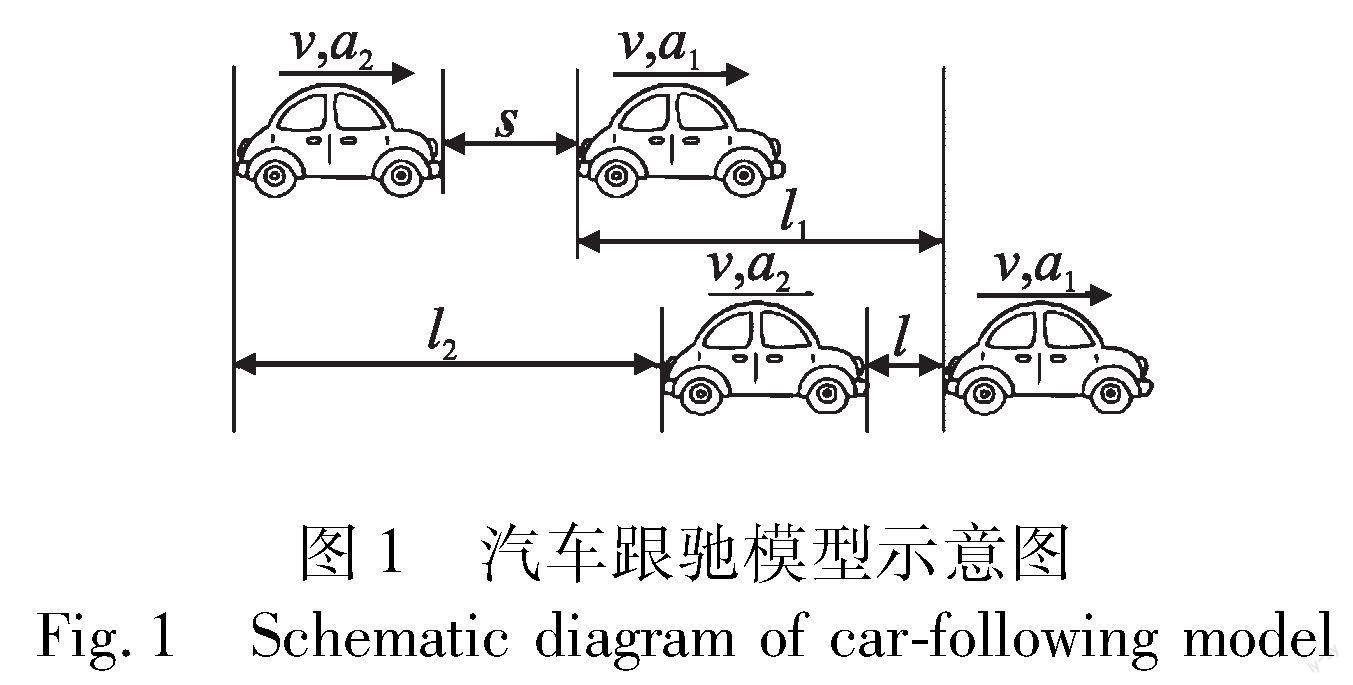

本文考慮文獻[15]中的汽車跟馳模型,該模型包含前后兩輛汽車,其中s代表兩車初始相隔距離,v代表兩車速度,a1代表前車剎車加速度,a2代表后車剎車加速度,l1代表前車剎車距離,l2代表后車剎車距離,l代表兩車最終相隔距離,具體如圖1所示。

考慮如圖1所示模型,兩車以相同的速度行駛,在某一時刻因突發情況,前車以一定的加速度開始剎車,后車隨即以一定的加速度跟隨前車開始剎車。本文假設前后兩車的初始相隔距離滿足《中華人民共和國道路交通安全法實施條例》中的安全距離,即兩車距離(m)在數值上等于兩車速度(km/h)。

根據模型可以得出,前車剎車距離為

后車剎車距離為

兩車最終相隔距離為

要保證安全剎車,后車的最小加速度為

假設舒適加速度為ac,則可得到表1關系。

1.2 Q學習算法

強化學習由智能體和環境兩部分組成,智能體是訓練的對象,除智能體外均屬于環境。在學習過程中,智能體從環境中獲取狀態信息,根據策略給出相應的動作,環境接收智能體動作后再傳遞回新的狀態信息與獎勵。在與環境的不斷交互中,通過值函數來評價智能體的好壞[16]。

Q學習是最有效的強化學習獨立模型算法之一[17]。Q學習的核心在于創建一個Q表,將狀態(state)與動作(action)定義為行與列,某一行對應某一種狀態,某一列對應某一種動作,對應行列里的值Q(state,action),一般簡寫為Q(S,A),即對應狀態下采取對應動作的動作值函數。動作值函數反映的是智能體在某一狀態下采取某一動作的價值,動作值函數越大說明在對應狀態下采取對應動作的價值越大,智能體一般就越傾向于選取該動作。通過不斷訓練,最終得到一個Q表。通過讀取Q表,即可根據對應狀態采取對應動作。智能體是訓練的目標,本質是Q表,在汽車跟馳模型中代表的是根據前車加速度a1選擇后車加速度a2的策略集。狀態S是前車加速度a1,狀態空間是所有前車加速度a1構成的集合;動作A是后車加速度a2,動作空間是所有后車加速度a2構成的集合,Q(S,A)是某一確定前車加速度a1下采取某一確定后車加速度a2的價值。獎勵是關于最終相隔距離l和后車加速度a2的一個函數,在訓練智能體時遵循的是ε-貪心策略,訓練完成后,智能體遵循的是貪心策略。智能體訓練示意圖如圖2所示。

貪心策略就是在任意狀態下智能體只選擇該狀態下Q(S,A)最大的動作,數學表達為

π(a|s)=arg maxQ(s,a)(5)

Π是智能體的策略集,Π(A|S)就是指在狀態S時智能體選擇動作A的策略。ε-貪心策略則是在任意狀態下以ε的概率隨機選擇該狀態下的動作,以1-ε的概率選擇該狀態下Q(S,A)最大的動作,數學表達為

之所以在訓練和使用智能體時使用兩種不同的策略,是為了處理智能體的探索-利用困境。如果智能體一味地利用先前的經驗,很容易因為前期的隨機性,導致最終陷入局部最優。如果智能體一味地探索,在有限狀態空間下會花費大量時間,在無限狀態空間下會陷入死循環。所以在訓練時遵循ε-貪心策略,既保證對經驗的利用,又保留了一定的探索,減少智能體陷入局部最優的概率。在最終訓練完成后則遵循貪心策略,最大程度利用智能體的經驗以獲取最大收益。

1.3 區間分塊Q學習算法

傳統Q學習算法適用于離散狀態空間問題,無法處理現實情況下的連續狀態空間問題。因為傳統Q學習中的Q表是一個固定大小的有限表格,這就要求傳統Q學習必須知道所有狀態信息與動作,才能將其一一填入Q表,進而加以訓練。Q學習本質是對Q表進行搜索迭代優化,Q表搜索維度越小,Q學習收斂速度越快。傳統Q學習搜索維度數學表達為

d=m×n(7)

其中:d是Q學習的搜索維度;m是狀態空間下狀態的數量;n是動作空間下動作的數量。在連續狀態空間下,狀態的數量是無限的,即m趨于無窮大,所以d趨于無窮大,Q學習就無法收斂,問題無法解決。

本文提出一種區間分塊方法,以區間的形式表示狀態空間,將狀態空間內連續的狀態按照一定的間隔劃入等長的離散區間塊中,以離散的區間塊代表這個區間內所有連續的狀態,則問題的搜索維度d*就簡化為

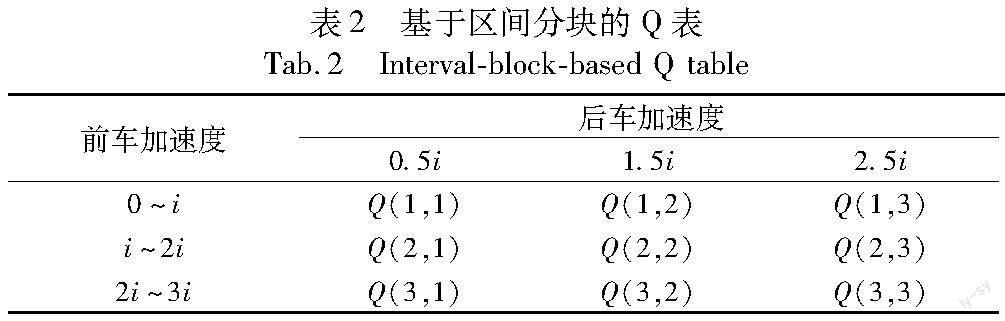

其中:m*是將狀態空間以區間形式表示的長度,i是區間劃分的間隔。不論狀態空間內包含多少種狀態,以區間形式劃分都可以將其變成離散的區間塊,問題的搜索維度就大大下降了。結合汽車剎車場景,后車只要保持與前車一致的剎車加速度即可保證安全剎車,所以當前車加速度以區間形式劃分后,以區間的中值來劃分后車加速度,很符合安全剎車的先驗知識。具體Q表如表2所示。

表格中Q(1,1)代表第一種狀態(前車加速度處于0~i m/s2)下選取第一種動作(后車加速度變為0.5i m/s2)的價值。Q(1,1)越大,代表該狀態下選取該動作的價值越大,智能體就越傾向于在該狀態(前車加速度處于0~i m/s2)下選取該動作(后車加速度變為0.5i m/s2)。

Q(S,A)的大小由獎勵函數累加確定:

Q(s,a)=Q(s,a)+reward(a2)(9)

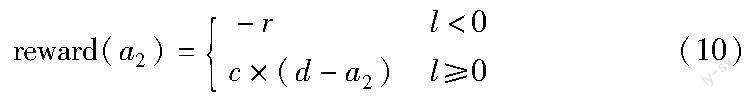

其中:reward(a2)是獎勵函數,數學表達為

其中:l為兩車最終相隔距離(l<0代表兩車相撞,因此獎勵為負,l>0時通過d-a2使后車加速度盡量減少);c是權重系數,減小前期因隨機性探索產生的優勢,使智能體盡可能多地探索,減少智能體陷入局部最優的概率。區間分塊方法通過對前車加速度的區間劃分解決了連續狀態空間下搜索維度無限的問題,結合實際場景中汽車安全剎車的先驗知識,對后車加速度按前車加速度區間中值劃分,算法的整體流程如下所示。

輸入:兩車初始相隔距離s、兩車速度v、前車加速度a1。

輸出:后車加速度a2。

while 1 do

初始化Q表,stop=0

for i=0,episode do

初始化前車加速度

區間分塊前車加速度

純隨機探索

探索與利用

確定獎勵

end for

for i=1,number do

if 訓練達標

stop+=1

end if

end for

if stop==number

end if

end while

2 實驗與分析

2.1 實驗環境與總仿真

本文使用 PyCharm建立仿真系統,全程在無網絡狀態下進行,驗證改進Q學習算法剎車的安全性、舒適性與連續性。將本文的改進Q學習算法與傳統Q學習算法在城市道路、城市快速路、高速公路三種情況下進行對比,特別指出,此處的傳統Q學習算法采用了與本文改進Q學習算法一致的獎勵設置,但是沒有使用區間分塊,目的是證明區間分塊方法對連續狀態空間問題的處理能力。

根據文獻[18]對人體震動和乘坐舒適性的大量評估研究,本文設定舒適加速度ac為2 m/s2,路面可提供的最大加速度為amax為5 m/s2。在0~5 m/s2的加速度區間內,i取1 m/s2則智能體不夠精確,i取0.01 m/s2則訓練效率偏低,因此綜合智能體準確性與訓練效率,選取i為0.1m/s2。

本文對三種路面情況在各進行100萬次仿真測試,因為0~1 m/s2前車加速度過小,導致最終相隔距離遠超其余區間,所以將前車加速度在1~5 m/s2隨機產生。最終相隔距離大于0視為安全剎車,將數據整理如表3所示。

2.2 城市道路仿真

城市道路限速為60 km/h,對應的安全跟車距離為60 m,因為城市事故多發生于超速時,所以本文使用s=72 m,v=20 m/s,即72 km/h兩車速度與72 m兩車初始相隔距離模擬城市道路緊急剎車情況。

圖3(a)是后車加速度折線圖,將前車加速度以0.1 m/s2為間隔從0~5 m/s2進行劃分,圓形點代表傳統Q學習曲線,五角星點代表改進Q學習曲線。由圖可知,改進Q學習與傳統Q學習均能控制加速度在舒適加速度內,證明改進Q學習算法剎車的舒適性。圖3(b)是改進Q學習下最終相隔距離圖,由圖可知,改進Q學習下最終相隔距離始終大于0,即汽車始終安全剎車。特別指出由于在0~1 m/s2區間前車加速度過小,導致最終距離遠超其余區間,所以將1~5 m/s2區間放大顯示,由放大圖可清晰看出,即使前車加速度取5 m/s2,也有100 m以上的最終相隔距離,證明改進Q學習算法剎車的安全性。圖3(c)是后車加速度散點圖,當在0~5 m/s2按0.1 m/s2間隔均勻產生50個前車加速度時,因為設置在傳統Q學習離散點上,所以傳統Q學習與改進Q學習均能給出相應后車加速度。當在0~5 m/s2內隨機產生50個前車加速度時,因為幾乎不可能在傳統Q學習離散點上,所以傳統Q學習無法處理,只能給出0 m/s2的后車加速度,而改進Q學習依然能給出相應的后車加速度。所以由圖可知,通過區間分塊方法改進的Q學習可以有效處理連續前車加速度問題,而傳統Q學習則無法解決,證明了改進Q學習算法剎車的連續性。

2.3 城市快速路仿真

城市快速路限速在60~100 km/h,具體由路況決定,對應的安全跟車距離為60~100 m,因為城市快速路超速較少,但高速行駛時事故發生的概率較高,所以本文使用s=90 m,v=25 m/s,即90 km/h兩車速度與90 m兩車初始相隔距離模擬城市快速路緊急剎車情況。圖4(a)是后車加速度折線圖,由圖可知,改進Q學習與傳統Q學習均能控制加速度在舒適加速度內,證明改進Q學習算法剎車的舒適性;圖4(b)是改進Q學習下最終相隔距離,由圖可知,改進Q學習下最終相隔距離始終大于0,即汽車始終安全剎車;圖4(c)是后車加速度散點圖,結論與上文類似。

2.4 高速公路仿真

高速公路限速在100~120 km/h,具體由車道決定,對應的安全跟車距離為100~120 m,因為高速公路超速較少,且車輛大多低速行駛,所以本文使用s=108 m,v=30 m/s,即108 km/h兩車速度與108 m兩車初始相隔距離模擬高速公路緊急剎車情況。

圖5(a)是后車加速度折線圖,由圖9可知,改進Q學習與傳統Q學習均能控制加速度在舒適加速度內,證明改進Q學習算法剎車的舒適性;由圖5(b)可知,改進Q學習下最終相隔距離始終大于0,即汽車始終安全剎車;圖5(c)是后車加速度散點圖,結論與上文類似。

2.5 算法總結

總仿真實驗中使用改進Q學習算法對三種路面情況各進行了100萬次測試,安全率均為100%,體現了算法的安全性與穩定性;平均相隔距離城市道路為303 m,城市快速路為421 m,高速公路為562 m,因為在高速情況下,即使微小的擾動也會產生巨大的影響,所以智能體提前預留更遠的平均相隔距離以應對實際情況。平均剎車加速度城市道路為1.48 m/s2,城市快速路為1.65 m/s2,高速公路為1.80 m/s2,因為高速情況下過低的加速度無法保證安全剎車,智能體必須優先確保安全性,再考慮舒適性。最終三種路面情況的平均剎車加速度仍符合舒適剎車加速度,體現了算法的安全性與舒適性。

三種道路仿真實驗中,結合圖3(a)、圖4(a)、圖5(a)可以看出:城市道路上,智能體始終將加速度控制在2 m/s2以下;城市快速路上當前車剎車加速度大于4.5 m/s2時,智能體將加速度超出2 m/s2;高速公路上當前車加速度大于3.5 m/s2時,智能體已將加速度超出2 m/s2。因為在城市道路的低速情況下,智能體始終可以保證安全剎車,隨著速度的增高,在城市快速路上,智能體會采取更高的剎車加速度以優先確保安全性,在高速公路上更是如此。所以圖3(b)、圖4(b)、圖5(b)中智能體始終保持了安全的最終相隔距離:城市道路上均大于100 m;城市快速路上均大于150 m;高速公路上均大于200 m。其體現了該算法在優先確保安全性的前提下盡可能地實現了舒適性。結合圖3(c)、圖4(c)、圖5(c)可以看出,傳統Q學習在面對連續前車加速度時無法處理,只能在離散前車加速度時處理,而改進Q學習均能處理,其體現了算法的連續性。

3 結束語

針對智能車輛安全舒適剎車問題,本文提出了一種基于區間分塊的Q學習算法,使用速度與兩車初始相隔距離對三種常見路面進行仿真,并與傳統Q學習算法進行了對比。仿真結果表明,提出的算法能夠在確保智能汽車安全剎車的同時實現較低的剎車加速度,能夠處理連續前車剎車加速度問題且無須網絡幫助。區間分塊能實現的前提是前車加速度這一狀態雖然無限,但是在狀態空間中均勻分布,所以離散的區間塊代表了一定大小的無限,如果狀態空間中的狀態并不均勻分布,就無法使用區間分塊方法。但在汽車剎車問題上,區間分塊方法仍具有泛用性。受限于實際情況,算法未能在真實車輛中進行測試,未來計劃進一步實際研究。

參考文獻:

[1]桂晶晶,吳芯洋,曾月,等.我國智能汽車發展現狀及前景[J].中國高新科技,2022(4):60-61.(Gui Jingjing,Wu Xinyang,Zeng Yue,et al.Status and prospect of the development of smart cars in China[J].China High and New Technology,2022(4):60-61.)

[2]趙子駿,段希冉.智能汽車安全風險分析與應對路徑[J].中國電子科學研究院學報,2022,17(8):822-827.(Zhao Zijun,Duan Xiran.Analysis of intelligent vehicle safety risks and their countermea-sures[J].Journal of China Academy of Electronics and Information Technology,2022,17(8):822-827.)

[3]肖凌云,胡文浩.智能汽車事故分析與安全應對策略研究[J].人工智能,2022(4):88-96.(Xiao Lingyun,Hu Wenhao.Research on intelligent vehicle accident analysis and safety response strategies[J].AI-View,2022(4):88-96.)

[4]李百明.汽車追尾預警系統設計[J].機電技術,2015(6):126-127,137.(Li Baiming.Design of automobile rear end warning system[J].Mechanical & Electrical Technology,2015(6):126-127,137.)

[5]Mamat M ,Ghani M N.Fuzzy logic controller on automated car braking system[C]//Proc of IEEE International Conference on Control and Automation.Piscataway,NJ:IEEE Press,2009:2371-2375.

[6]Ariyanto M,Haryadi D G,Munadi M,et al.Development of low-cost autonomous emergency braking system for an electric car[C]//Proc of the 5th International Conference on Electric Vehicular Technology.Piscataway,NJ:IEEE Press,2018:167-171.

[7]黃志芳,宋世杰,陳澤銳,等.汽車智能防撞系統[J].物聯網技術,2020,10(5):67-69.(Huang Zhifang,Song Shijie,Chen Zerui,et al.Intelligent collision prevention system for automobiles[J].Internet of Things Technologies,2020,10(5):67-69.)

[8]黃志清,曲志偉,張吉,等.基于深度強化學習的端到端無人駕駛決策[J].電子學報,2020,48(9):1711-1719.(Huang Zhiqing,Qu Zhiwei,Zhang Ji,et al.End-to-end autonomous driving decision based on deep reinforcement learning[J].Acta Electronica Sinica,2020,48(9):1711-1719.)

[9]Silver D,Huang A,Maddison C J,et al.Mastering the game of go with deep neural networks and tree search[J].Nature,2016,529(7587):484.

[10]Sutton R S,Barto A G.Reinforcement learning:an introduction[M].2nd ed.Cambridge,CA:MIT Press,2018.

[11]王揚,陳智斌,吳兆蕊,等.強化學習求解組合最優化問題的研究綜述[J].計算機科學與探索,2022,16(2):261-279.(Wang Yang,Chen Zhibin,Wu Zhaorui,et al.Review of reinforcement lear-ning for combinatorial optimization problem[J].Journal of Frontiers of Computer Science and Technology,2022,16(2):261-279.)

[12]Richter J D,Calix A R.Using double deep Q-learning to learn attitude control of fixed-wing aircraft[C]//Proc of the 16th International Conference on Signal-Image Technology & Internet-Based Systems.Pisca-taway,NJ:IEEE Press,2022:646-651.

[13]尹燕莉,張鑫新,潘小亮,等.基于等效因子的Q學習燃料電池汽車能量管理策略[J].汽車安全與節能學報,2022,13(4):785-795.(Yin Yanli,Zhang Xinxin,Pan Xiaoliang,et al.Equivalent factor of energy management strategy for fuel cell hybrid electric vehicles based on Q-learning[J].Journal of Automotive Safety and Energy,2022,13(4):785-795.)

[14]Qu Hong,Wei Xiaolong,Sun Chuhan,et al.Research on UAV air combat maneuver decision-making based on improved Q-learning algorithm[C]// Proc of the 5th IEEE International Conference on Information Systems and Computer Aided Education.Piscataway,NJ:IEEE Press,2022:55-58.

[15]Wu Zhaohui,Liu Yanfei,Pan Gang.A smart car control model for brake comfort based on car following[C]//Proc of IEEE Conference on Intelligent Transportation Systems.Piscataway,NJ:IEEE Press,2009:42-46.

[16]杜康豪,宋睿卓,魏慶來.強化學習在機器博弈上的應用綜述[J].控制工程,2021,28(10):1998-2004.(Du Kanghao,Song Ruizhuo,Wei Qinglai.Review of reinforcement learning applications in machine games[J].Control Engineering of China,2021,28(10):1998-2004.)

[17]Lyu Le,Shen Yang,Zhang Sicheng.The advance of reinforcement learning and deep reinforcement learning[C]//Proc of IEEE International Conference on Electrical Engineering,Big Data and Algorithms.Piscataway,NJ:IEEE Press,2022:644-648.

[18]Janeway N R.Vehicle vibration limits to fit the passenger[J].SAE J,1948,56(8):48-49.

(上接第182頁)

[12]Diehl P U,Pedroni B U,Cassidy A,et al.TrueHappiness:neuromorphic emotion recognition on TrueNorth[C]//Proc of International Joint Conference on Neural Networks.Piscataway,NJ:IEEE Press,2016:4278-4285.

[13]Han Bing,Srinivasan G,Roy K.RMP-SNN:residual membrane potential neuron for enabling deeper high-accuracy and low-latency spiking neural network[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2020:13558-13567.

[14]Sengupta A,Ye Yuting,Wang R, et al.Going deeper in spiking neural networks:VGG and residual architectures[J].Frontiers in Neuroscience,2019,13.https://doi.org/10.3389/fnins.2019.00095.

[15]Kim S,Park S,Na B,et al.Spiking-YOLO:spiking neural network for energy-efficient object detection[C]//Proc of the 34th AAAI Confe-rence on Artificial Intelligence.Palo Alto,CA:AAAI Press,2020:11270-11277.

[16]Ding Jianhao,Yu Zhaofei,Tian Yonghong,et al.Optimal ANN-SNN conversion for fast and accurate inference in deep spiking neural networks[C]//Proc of the 30th International Joint Conference on Artificial Intelligence.Palo Alto,CA:AAAI Press,2021:2328-2336.

[17]Li Yuhang,Deng Shikuang,Dong Xin,et al.A free lunch from ANN:towards efficient,accurate spiking neural networks calibration[C]//Proc of the 38th International Conference on Machine Learning.2021:6316-6325.

[18]Bu Tong,Fang Wei,Ding Jianhao,et al.Optimal ANN-SNN conversion for high-accuracy and ultra-low-latency spiking neural networks[C]//Proc of International Conference on Learning Representations.2022:1-19.

[19]Cubuk E D,Zoph B,Mane D,et al.AutoAugment:learning augmentation strategies from data[C]//Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition.Piscataway,NJ:IEEE Press,2019:113-123.

[20]George M,Roger M.MIT-BIH arrhythmia database[DB/OL].(2005-02-24)[2023-07-15].https://www.physionet.org/content/mitdb/1.0.0/-31.

[21]張馳,唐鳳珍.基于自適應編碼的脈沖神經網絡[J].計算機應用研究,2022,39(2):593-597.(Zhang Chi,Tang Fengzhen.Self-adaptive coding for spiking neural network[J].Application Research of Computers,2022,39(2):593-597.)

[22]Rathi N,Roy K.DIET-SNN:a low-latency spiking neural network with direct input encoding and leakage and threshold optimization[J].IEEE Trans on Neural Networks and Learning Systems,2023,34(6):3174- 3182.

[23]Horowitz M.1.1 computings energy problem(and what we can do about it)[C]// Proc of IEEE International Solid-State Circuits Conference Digest of Technical Papers.Piscataway,NJ:IEEE Press,2014:10-14.

[24]Deng Shikuang,Gu Shi.Optimal conversion of conventional artificial neural networks to spiking neural networks[C]//Proc of International Conference on Learning Representations.2021:1-14.

[25]Yan Zhanglu,Zhou Jun,Wong W F.Near lossless transfer learning for spiking neural networks[C]//Proc of the 35th AAAI Conference on Artificial Intelligence.Palo Alto,CA:AAAI Press,2021:10577-10584.