基于遙感智能解譯技術的圍堰潰決洪水淹沒分析

周翔 羅爽 王成

摘要:水電站圍堰潰決洪水突發性強且非常規,應急調查時效性要求高。為分析水電站圍堰潰決洪水風險,以旭龍水電站為例,提出了一套基于遙感智能解譯技術的潰堰洪水淹沒分析方法用于實物指標應急調查,并選取與居民財產安全密切相關的建筑物為典型對象,通過構建U-Net卷積神經網絡模型,對旭龍水電站下游區域進行建筑物提取。結果表明:該方法可有效識別出建筑物分布情況,F-score指標精度在93%以上,在算法效率上也明顯優于人工解譯。

關鍵詞:圍堰潰決洪水; 淹沒分析; 遙感智能解譯; 卷積神經網絡; 旭龍水電站

中圖法分類號:P237;TV122+.4

文獻標志碼:A

DOI:10.15974/j.cnki.slsdkb.2024.05.020

文章編號:1006-0081(2024)05-0111-06

0 引言

水電站上、下游圍堰設計采用的洪水標準通常較高,發生潰決風險的概率較低。但是,如果遭遇地震破壞,超過設計標準的暴雨洪水,滲流變形破壞、坍塌、滑坡事故以及施工質量差等因素,可能導致潰堰風險。一旦發生潰決事故,會對壩區及下游造成重大的影響,因此有必要開展潰堰洪水風險分析。近年來,通過遙感監測手段實現洪水風險區實物指標的高效、高精度信息提取,可科學評估潰堰洪水對壩區和下游人民生命和財產安全的影響,為制定水電站防洪減災預案提供依據[1]。

傳統的遙感實物指標調查主要采用人工解譯的方式,需要耗費大量的人力成本和時間成本,難以快速高效地實現大范圍遙感解譯[2- 3]。近年來,隨著人工智能技術的飛速發展,采用機器學習方法實現高分辨率遙感影像自動、快速、精確解譯已經成為主流的研究方向。其中,以深度學習為代表的人工智能方法憑借其強大的特征學習和多層次表達能力,在遙感影像智能解譯領域已得到廣泛關注,并取得了成果[4-6]。例如,陳嘉浩等[7]發展了一種融合級聯CRFs和U-Net深度學習模型,在廣東省佛山市的Worldview衛星影像數據上實現了建筑物的自動提取,F-score精度達到了91.4%。Ji等[8]構建了一套開放的多源遙感影像建筑物數據集,并提出了一種連體U-Net網絡模型用于建筑物提取,在航空影像數據集上的識別準確率達到93.8%。林娜等[9]提出了一種基于空洞卷積U-Net的遙感影像道路提取算法,在Massachusetts roads數據集上F-score精度達到了84.5%。以上遙感影像智能解譯方法主要針對城市地區的實物指標開展算法研究,然而由于水電站潰堰洪水突發性強且非常規,目前將遙感智能解譯技術應用于水電站潰堰洪水分析的研究成果仍較少。

因此,本文以旭龍水電站為研究對象,將遙感智能解譯技術應用于旭龍水電站圍堰潰決洪水的淹沒分析中,選取潰堰影響分析中實物指標應急調查進行研究。

1 工程概況

旭龍水電站位于云南省德欽縣與四川省得榮縣交界的金沙江干流上游河段,開發任務以發電為主,是金沙江上游河段“一庫十三級”梯級開發方案中的第12級,是“西電東送”骨干電源點之一。壩址控制流域面積18.95萬km2,采用混凝土雙曲拱壩,壩高213 m,總庫容8.47億m3,為日調節水電站。工程為Ⅰ等大(1)型工程,混凝土壩及相應泄洪建筑物按1 000 a一遇洪水設計,5 000 a一遇洪水校核。工程采用一次性攔斷河床、全年圍堰擋水、導流隧洞泄流的導流方式。

旭龍水電站下游有已建成的梨園水電站,屬Ⅰ等大(1)型工程,總庫容8.05億m3。旭龍水電站圍堰潰決后會對壩區和下游造成影響,但不會影響梨園水電站的運行。旭龍水電站壩址至梨園水電站壩址區間自上而下有四川省甘孜藏族自治州得榮縣、云南省迪慶藏族自治州德欽縣、維西傈僳族自治縣、香格里拉市和云南省麗江市玉龍納西族自治縣5個市縣。

周翔 等基于遙感智能解譯技術的圍堰潰決洪水淹沒分析——以旭龍水電站為例

2 研究方法

2.1 技術路線

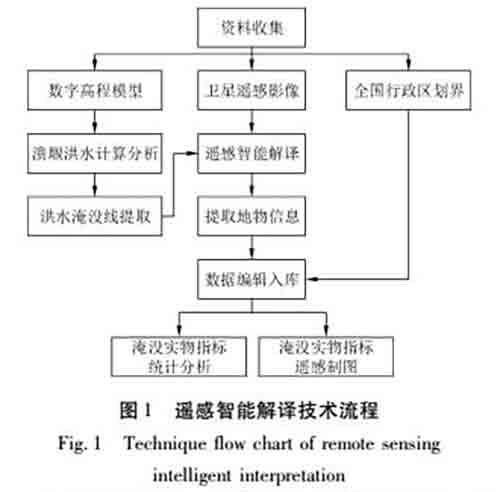

針對旭龍水電站潰堰洪水影響分析中實物指標應急調查需求,本文構建了一套潰堰洪水影響分析遙感智能解譯技術體系,具體包括:資料收集、洪水淹沒線提取、遙感智能解譯、數據編輯入庫、淹沒實物指標統計分析與制圖5個部分,技術路線如圖1所示。

(1) 資料收集。充分收集項目前期資料,了解掌握研究區域特點,做好解譯準備工作。結合該研究區域具體情況和工作需求,收集得到旭龍水電站所在周邊區域的數字高程模型、衛星遙感影像、全國行政區劃界等,為研究的開展奠定了堅實的基礎。

(2) 洪水淹沒線提取。通過構建旭龍水電站潰堰洪水數學模型,計算得出下游沿程最高水位,結合收集得到的數字高程模型進行插值加密處理獲取等值線,根據等值線按照各斷面的最高洪水位分段描繪洪水淹沒線,為遙感智能解譯提供了遙感影像解譯范圍。

(3) 遙感智能解譯。根據旭龍水電站潰堰洪水影響分析需要,結合淹沒實物指標主要解譯內容,利用已構建的遙感智能解譯模型對收集到的衛星遙感影像進行自動化解譯,提取對應的地物信息,并通過專業解譯人員對智能解譯成果進行檢查和修飾,完成遙感解譯工作。本文采用U-Net卷積神經網絡模型[10]作為遙感智能解譯模型。

(4) 數據編輯入庫。按照系統數據庫相關要求,應用GIS軟件對受淹沒影響的實物指標遙感解譯數據進行建庫編輯處理,結合收集到的全國行政區劃界等資料,構建拓撲關系,標注地物類屬性,開展圖幅之間圖形、屬性接邊等,完成數據入庫工作。

(5) 淹沒實物指標統計分析與制圖。潰堰影響分析計算所用解譯成果是基于遙感智能解譯成果,通過提取淹沒區域內耕地、園地、村莊范圍及工礦用地等要素圖斑,根據2023年影像更新處理,將各地類圖斑空間分布成果、行政區界以及不同潰堰洪水成果相疊加統計得出,并按照要求進行淹沒實物指標統計與分析,制作淹沒實物指標解譯成果專題圖。

2.2 遙感智能解譯

遙感影像智能解譯技術通過引入計算機視覺領域的智能模型,對遙感影像進行分類、識別、提取等,從而實現對遙感影像的自動化解譯。地理空間科學與深度學習相融合的GeoAI新技術不斷涌現,推動了遙感影像解譯技術由人工目視解譯和半自動解譯向智能化、自動化方向飛速發展[11- 12]。本文結合水電站潰堰洪水分析的實際需求和遙感智能解譯技術發展情況,采用U-Net卷積神經網絡模型作為本研究的智能模型。

2.2.1 U-Net卷積神經網絡模型

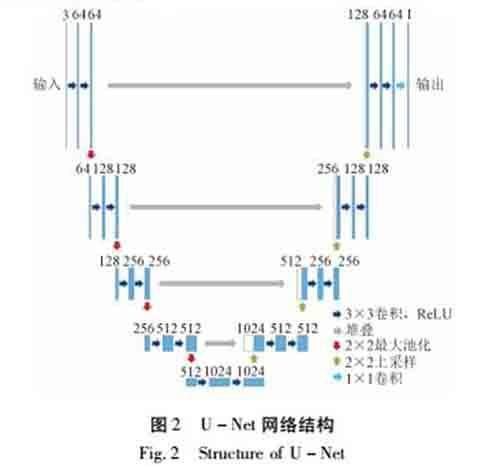

U-Net卷積神經網絡模型于2015年由Ronneberger等[10]提出,由于其網絡結構呈“U”型而得名,最初用于醫學影像分割,后來逐步發展為深度學習的基準網絡模型之一,并在諸多領域得到廣泛應用,如云檢測[13]、建筑物檢測[8]、語義分割[14]等。本研究同樣屬于目標識別問題,故而將U-Net網絡作為研究方法。

U-Net是由卷積、下采樣、上采樣和堆疊操作組成的編碼器-解碼器對稱網絡。其中編碼是一個下采樣過程,提取高維抽象特征,而解碼則是上采樣過程,恢復影像原始尺寸,并不斷融入下采樣的最終或中間的特征圖,實現淺層細節特征與深層抽象特征的信息融合,得到最終解譯結果。U-Net網絡結構如圖2所示。

2.2.2 后處理優化

通過U-Net模型的處理后可以得到初步的遙感解譯結果,但往往會存在小碎塊區域和空洞區域。因此,為了提升解譯結果的精度,本文采用了小碎塊剔除和空洞填充的形態學后處理方式加以優化。

另外,為了滿足數據庫建設和專題信息制圖等方面的應用需要,本文進一步將以上解譯結果進行地理坐標信息添加和柵格-矢量轉換,從而得到最終解譯結果。

3 結果分析

旭龍水電站潰堰洪水影響分析中涉及的實物調查指標包括淹沒耕地、園地、村莊及工礦用地、道路、橋梁、電力、通訊及附屬設施等多種要素,本文選取與居民財產安全密切相關的建筑物為典型對象進行分析。

3.1 遙感智能解譯效果

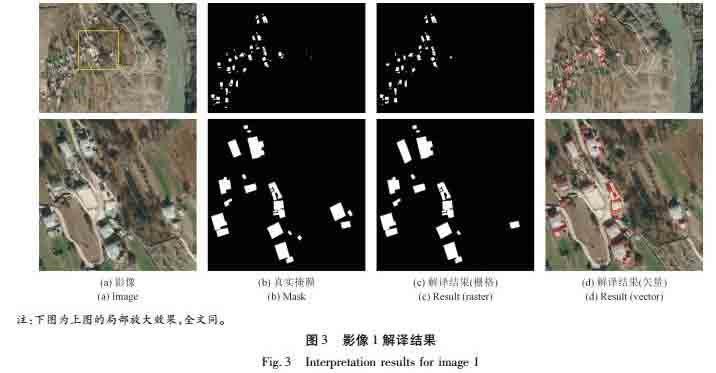

本文選取旭龍水電站下游至梨園水電站之間建筑物較為密集的2個區域作為試驗對象,分析潰堰對下游的防洪影響,采用分辨率0.3 m的谷歌影像進行建筑物智能解譯試驗,分別從定性和定量兩方面進行分析。

3.1.1 定性分析

圖3和圖4分別展示了兩幅建筑物密集區域的智能解譯結果和局部放大圖。總體來看,建筑物區域均實現了較好的提取效果,可以較為有效識別出建筑物分布情況。圖3中建筑物分布較為零散,部分建筑物色彩與其他地物較為相似,總體上實現了較好的提取效果。圖4中建筑物沿金沙江縱向分布,并存在與建筑物色彩較為相近的水泥地面,解譯結果表明建筑物得到有效提取。從定性分析來看,本文中的遙感智能解譯方法可以滿足建筑物的提取需求。

3.1.2 定量分析

為使結果更加可靠,本文采用準確率P、召回率R和F-score 3種精度評價指標進行了定量分析,取值范圍為0~1[15- 16],這3個指標值越高表示解譯性能越好。具體計算公式如下:

式中:TP為正確識別的像素數量,FN為將該對象錯誤識別為非對象的像素數量,FP為將非對象錯誤識別為該對象的像素數量。

兩組數據建筑物提取精度及效率評價如表1所示。從建筑物提取精度來看,影像1和影像2準確率均為98%左右,召回率在90%左右,F-score精度在93%以上,驗證了該智能解譯方法的有效性。從建筑物提取效率來看,影像1和影像2的覆蓋面積分別為0.58 km2和0.19 km2,測試時間分別為5 s和2 s,而人工解譯時間分別約為30,20 min,智能解譯算法運行效率更高。

旭龍水電站若發生潰堰洪水,經估算下游淹沒總面積約為106 km2,建筑物遙感智能解譯的時間為15 min左右,人工解譯需要約20人天。相比人工解譯,智能解譯方法可有效提升解譯效率。

3.2 淹沒實物指標遙感制圖

基于數字高程模型提取洪水淹沒線并結合遙感智能解譯建筑物矢量結果,可運用空間疊加分析統計淹沒實物指標。本次采用的衛星遙感智能解譯方法可實現快速統計淹沒范圍面積、淹沒居民地面積等實物指標,可為潰堰洪水淹沒方案制定快速提供決策分析依據。同時,利用收集的公開全國行政區劃、道路等基礎空間信息數據,洪水淹沒線、衛星影像、遙感智能解譯結果等制作淹沒實物指標遙感專題圖(圖5),可直觀展示潰堰洪水淹沒影響的空間分布情況。

此處選取香格里拉市金江鎮附近情況進行說明,金江鎮居民地高程1 804~1 902 m,當潰堰后最高洪水位為1 866 m時,淹沒總面積約為17.41 km2,淹沒居民地面積約為0.85 km2。

4 結語

本文提出了一套潰堰洪水影響分析遙感智能解譯技術體系,通過構建U-Net卷積神經網絡模型,對旭龍水電站下游區域進行建筑物提取。選取了兩個旭龍水電站下游建筑物較為密集的區域開展試驗,定性分析發現采用的遙感智能解譯方法可以有效識別出建筑物分布情況,定量分析發現F-score定量評價指標精度在93%以上,在算法效率上也明顯優于人工解譯。該方法可有效提升生產作業效率,為水利工程項目的開展提供重要參考依據。

參考文獻:

[1]黃筱,張林杰,馮剛,等.無人機遙感在黑龍江特大洪水應急監測中的應用[J].水利水電快報,2023,44(3):34-38.

[2]張繼賢,顧海燕,楊懿,等.自然資源要素智能解譯研究進展與方向[J].測繪學報,2022,51(7):1606-1617.

[3]彭道松,聶小飛,莫明浩,等.基于深度學習的水土保持措施遙感解譯信息提取研究[J].中國水土保持,2023(4):45-49.

[4]陶超,陰紫薇,朱慶,等.遙感影像智能解譯:從監督學習到自監督學習[J].測繪學報,2021,50(8):1122-1134.

[5]宋文龍,呂娟,劉昌軍,等.遙感技術在數字孿生流域建設中的應用[J].中國防汛抗旱,2022,32(6):15-20.

[6]隆星宇,李輝,白雪山,等.基于深度學習的人工滑坡隱患自動識別新方法[J].人民長江,2023,54(7):113-120.

[7]陳嘉浩,邢漢發,陳相龍.融合級聯CRFs和U-Net深度學習模型的遙感影像建筑物自動提取[J].華南師范大學學報(自然科學版),2022,54(1):70-78.

[8]JI S,WEI S,LU M.Fully Convolutional networks for multisource building extraction from an open aerial and satellite imagery data set[J].IEEE Transactions on Geoscience and Remote Sensing,2019,57(1):574-586.

[9]林娜,張小青,王嵐,等.空洞卷積U-Net的遙感影像道路提取方法[J].測繪科學,2021,46(9):109-114.

[10]RONNEBERGER O,FISCHER P,BROX T.U-Net:Convolutional Networks for Biomedical Image Segmentation[C]∥MICCAI Society.MICCAI 2015.Cham:Springer International Publishing,2015.

[11]尹磊,楊凌云,張磊,等.深度學習在遙感影像智能解譯中的應用現狀簡述[J].華北自然資源,2023(1):93-97.

[12]孫濤,王雷,付文博,等.深度學習在水利行業上的應用綜述[J].中國農村水利水電,2018(12):90-93,100.

[13]WIELAND M,LI Y,MARTINIS S.Multi-sensor cloud and cloud shadow segmentation with a convolutional neural network[J].Remote Sensing of Environment,2019,230:111203.

[14]DIAKOGIANNIS F I,WALDNER F,CACCETTA P,et al.ResUNet-a:A deep learning framework for semantic segmentation of remotely sensed data[J].ISPRS Journal of Photogrammetry and Remote Sensing,2020,162:94-114.

[15]ADELINE K R M,CHEN M,BRIOTTET X,et al.Shadow detection in very high spatial resolution aerial images:A comparative study[J].ISPRS Journal of Photogrammetry and Remote Sensing,2013,80:21-38.

[16]LUO S,LI H,SHEN H.Deeply supervised convolutional neural network for shadow detection based on a novel aerial shadow imagery dataset[J].ISPRS Journal of Photogrammetry and Remote Sensing,2020,167:443-457.

編輯:江文

Inundation analysis of cofferdam break flood based on remote sensing intelligent interpretation technolog:a case of Xulong Hydropower Station

ZHOU Xiang1,2,3,LUO Shuang1,2,3,4,WANG Cheng1,2,3

(1.Changjiang Spatial Information Technology Engineering Co.,Ltd.(Wuhan),Wuhan 430010,China;2.Changjiang Survey,Planning,Design and Research Co.,Ltd.,Wuhan 430010,China;3.Changjiang Satellite Remote Sensing Application Research Center,Wuhan 430010,China;4.Hubei Key Laboratory of Basin Water Security,Wuhan 430010,China)

Abstract:

Cofferdam break flood of hydropower station is sudden and unconventional,which requires high efficiency of emergency investigation.A remote sensing intelligent interpretation framework analysis of cofferdam break flood was proposed for emergency investigation of physical indicators,and buildings closely related to residential property safety were selected as typical objects for analysis.The U-Net convolutional neural network model was constructed to extract the building in the lower reaches of Xulong Hydropower Station.The results demonstrated that the proposed method could effectively identify the distribution of buildings.The accuracy of F-score quantitative evaluation index was above 93%,and the algorithm efficiency was also significantly better than manual interpretation.

Key words:

cofferdam break flood; inundation analysis; remote sensing intelligent interpretation; convolutional neural network; Xulong Hydropower Station

收稿日期:2023-10-30

基金項目:流域水安全保障湖北省重點實驗室開放研究基金項目資助(CX2023K16);長江勘測規劃設計研究有限責任公司自主創新項目(CX2022Z31)

作者簡介:周翔,男,高級工程師,主要從事水利工程測量方面的工作。E-mail:zhouxiang@cjwsjy.com.cn

通信作者:羅爽,男,工程師,博士,主要從事遙感影像智能處理與人工智能算法研究工作。E-mail:luoshuang_cjwsjy@163.com