基于WLS濾波優化的雙目視覺深度圖重建

周思琦 管志光 殷珊珊 郭子屹 林明星

摘要:為解決雙目視覺三維重建深度圖邊緣不連續的問題,提出基于加權最小二乘(weighted least squares,WLS)濾波的深度圖優化,經雙目標定、畸變矯正、立體校正、立體匹配建立三維深度圖,加入WLS濾波,通過調整正則項更改約束條件,對梯度較大的區域減少約束,保留圖像邊緣,對梯度較小的區域平滑處理,去除噪聲,采用峰值信噪比、結構相似性指數、平均絕對誤差3個參數評價圖像質量。評價結果表明:與半全局匹配算法相比,此算法的峰值信噪比增大1.849 dB,圖像失真更少,質量更高;結構相似性指數增大0.415 1,與原圖結構相似性更強;平均絕對誤差減小21.542 2,還原度更高。重建的深度圖視覺效果更好,改善立體匹配不連續的問題,減小匹配誤差,使視差圖質量更高。

關鍵詞:WLS濾波;雙目視覺;三維重建;深度圖;立體匹配

中圖分類號:U463.6;TP391.41文獻標志碼:A文章編號:1672-0032(2024)02-0139-07

引用格式:周思琦,管志光,殷珊珊,等.基于WLS濾波優化的雙目視覺深度圖重建[J].山東交通學院學報,2024,32(2):139-145.

ZHOU Siqi, GUAN Zhiguang, YIN Shanshan, et al. Depth map reconstruction of binocular vision optimized by WLS filtering[J].Journal of Shandong Jiaotong University,2024,32(2):139-145.

0?引言

雙目視覺的深度圖是在相機拍攝后,根據相機的位置和內部參數(圖像原點坐標、圖像坐標系像素寬度、焦距、像素點尺寸偏差等),通過程序處理建立1個新的三維圖像[1-2],在水下研究、生物探索、機械制造等領域應用廣泛[3-5],例如機械臂手臂抓取目標、跟蹤研究海洋生物等[6],在智能領域應用更廣。深度圖的重建過程受結構光、內部參數及飛行時間的影響[7],深度圖成像不清晰,獲取高精度、高分辨率深度圖較困難[8]。

深度圖所需視差通常由局部濾波器內核基于高分辨率紅綠藍(red green blue,RGB)顏色空間圖像的電導率信息采樣得到[9-11]。優化深度圖時,采用神經網絡進行立體匹配算法逐漸增多,其中粗精結合二次匹配算法[12]和加入多尺度損失函數保留圖像邊緣算法[13]可提高圖像質量,但計算量過大,過程繁瑣。改進后的AD算法和Census匹配算法計算量小[14],結合深度學習、彩色編碼細化重建結果[15],對圖像邊緣處理效果不佳。基于濾波的算法中,同態濾波算法可提高圖像亮度和對比度[16],但六角椎體模型(hue saturation value,HSV)和RGB空間轉換不適用于深度圖。分割圖像前景和背景,用濾波估計透射率,達到細化圖像的效果[17];對暈輪效應進行高斯濾波處理,得到細節完善的森林圖像[18]。濾波的優化效率比神經網絡高,濾波優化方法中全局優化比局部優化準確,重建的三維深度圖精確度更好,選取合適的濾波就能獲取針對性的、理想的處理圖像。

本文提出基于加權最小二乘(weighted least squares,WLS)濾波優化深度圖的重建算法,采用基于雙邊濾波的WLS保邊濾波器,對深度圖噪聲明顯的區域平滑去噪,同時保留深度圖中的物體邊緣,以期通過調整正則項(懲罰項)更改約束條件,平衡邊緣和平滑區的占比,對不同環境下的深度圖都有良好的適應能力。

1?坐標轉換

三維重建的具體步驟可分為:標定得到相機的內部參數、旋轉參數、平移參數、畸變參數→根據畸變參數矯正相機畸變→按照旋轉和平移參數調整左右相機圖像,使圖像共面→在左右圖像中移動像素塊,使特征點匹配→三維重建。通過張氏標定法[19]獲取內、外部參數,攝像機標定是獲取攝像機內外參數的過程,目的是建立從客觀世界坐標系到圖像平面坐標系間的對應過程。楊健[20]、權穩穩[21]采用張氏標定法研究雙目定位,雙目定位是基于傳統標定法和自標定法間的優化方法。

三維重建的坐標轉換是以相機坐標為媒介,將二維圖像坐標轉換為世界坐標。

構建相機坐標和世界坐標的轉換關系[19]為:

xCyCzC=r11r12r13r21r22r23r31r32r33xWyWzW+TxTyTz,(1)

式中:xC、yC、zC為相機坐標系坐標,r11~r33為旋轉坐標系元素,xW、yW、zW為世界坐標系坐標,Tx、Ty、Tz為平移參數。

相機坐標系是二維平面坐標系,在圖像三維空間進行平移、旋轉、縮放和透視投影需矩陣和向量相乘,因此加入齊次坐標擴展坐標系,齊次坐標系是指采用N+1維坐標表示N維坐標,有利于后期進行仿射變化。根據所得圖像,構建圖像坐標系和相機坐標系關系為:

zCuv1=f0000f000010xCyCzC1 ,(2)

式中:(u,v)為目標點像素坐標,f為相機焦距。

圖像坐標系分為物理坐標系和像素坐標系,從圖像直接獲得的是目標點的物理坐標,還需計算圖像像素坐標

uv1=1dxγu001dyv0001xy1,(3)

式中: (u0,v0)為光學中心像素坐標,(x,y)為目標點物理坐標,dx為x軸方向1個像素寬度,dy為y軸方向1個像素寬度,γ為像素點尺寸偏差。

2?三維重建

2.1?畸變矯正

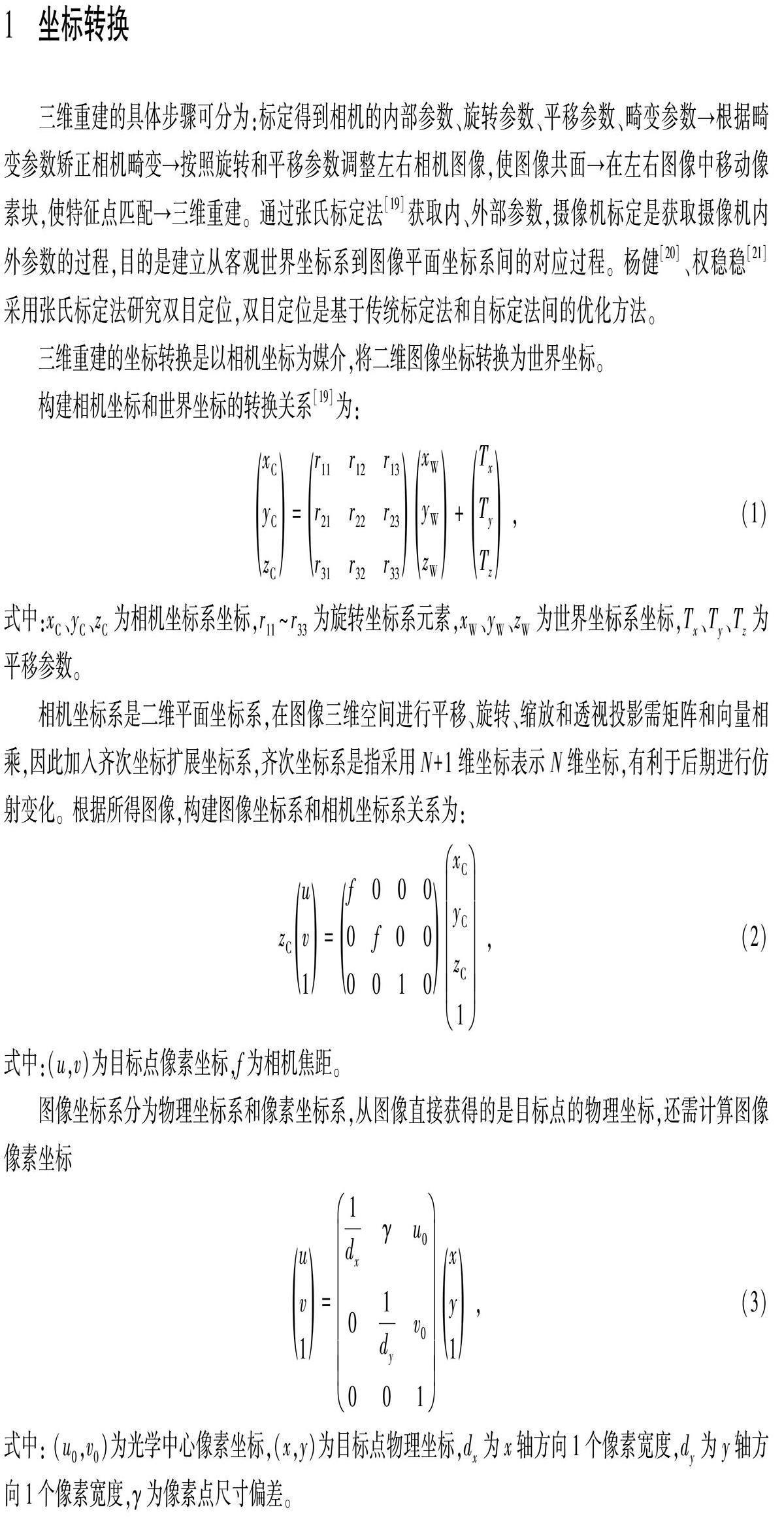

受相機制造工藝限制,所得圖像不能完全按理想公式計算,若不考慮畸變,可能導致三維重建失敗或存在較大誤差,因此,需通過計算矯正畸變。圖像畸變分為桶形畸變和枕形畸變,如圖1所示。由鏡頭形狀造成的缺陷,用徑向畸變和切向畸變聯合表示,試驗所用相機畸變小于0.3%,徑向畸變和切向畸變同時存在,畸變系數是相機的內部參數,由標定結果可得畸變系數。

矯正畸變原理[21]表示為:

x′y′=1+k1r2+k2r4+k3r6xy+2p1xy+p2r2+2x22p2xy+p1r2+2y2,

式中:(x′, y′)為矯正畸變后目標點的圖像物理坐標,k1、k2、k3為相機的徑向畸變系數,r為徑向距離,p1、p2為相機的切向畸變系數。

2.2?立體校正

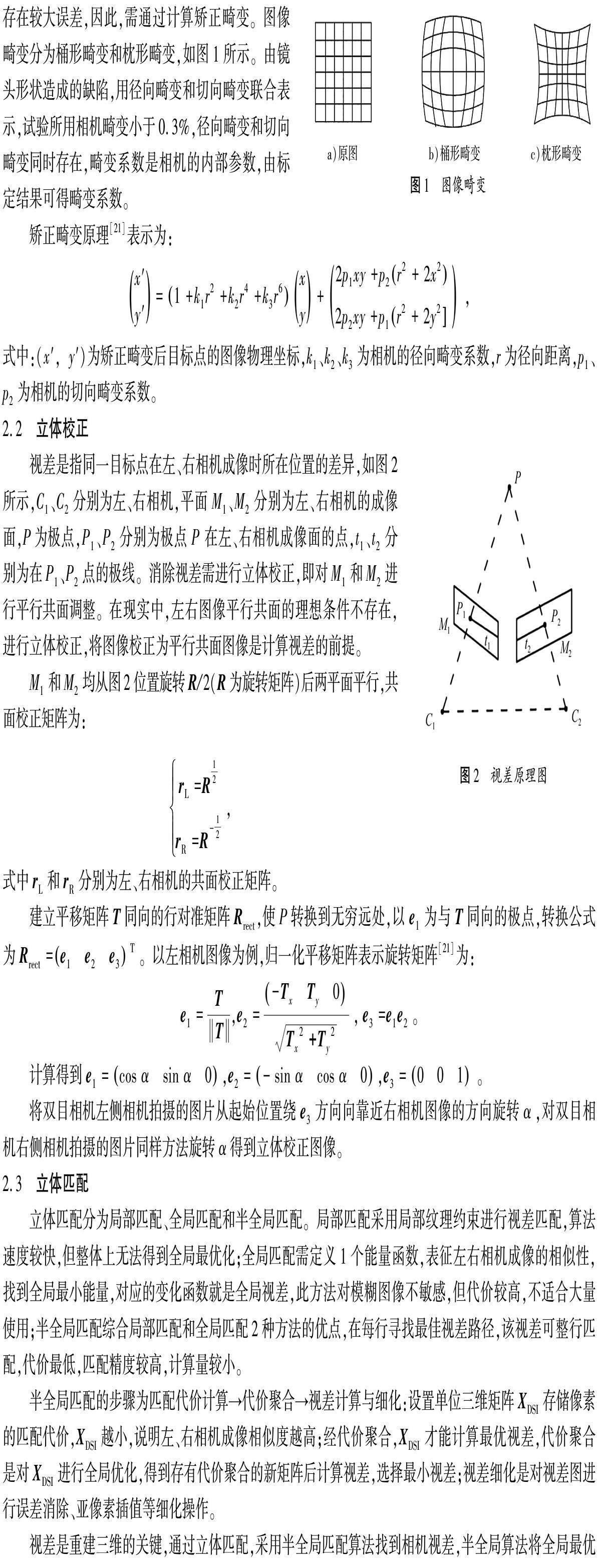

視差是指同一目標點在左、右相機成像時所在位置的差異,如圖2所示,C1、C2分別為左、右相機,平面M1、M2分別為左、右相機的成像面,P為極點,P1、P2分別為極點P 在左、右相機成像面的點,t1、t2分別為在P1、P2點的極線。消除視差需進行立體校正,即對M1和M2進行平行共面調整。在現實中,左右圖像平行共面的理想條件不存在,進行立體校正,將圖像校正為平行共面圖像是計算視差的前提。

M1和M2均從圖2位置旋轉R/2(R為旋轉矩陣)后兩平面平行,共面校正矩陣為:

rL=R12rR=R-12 ,

式中rL和rR分別為左、右相機的共面校正矩陣。

建立平移矩陣T同向的行對準矩陣Rrect,使P轉換到無窮遠處,以e1為與T同向的極點,轉換公式為Rrect=e1?e2?e3T。以左相機圖像為例,歸一化平移矩陣表示旋轉矩陣[21]為:

e1=TT,e2=-TxTy0?Tx2+Ty2,e3=e1e2。

計算得到e1=cos αsin α0,e2=-sin αcos α0,e3=001。

將雙目相機左側相機拍攝的圖片從起始位置繞e3方向向靠近右相機圖像的方向旋轉α,對雙目相機右側相機拍攝的圖片同樣方法旋轉α得到立體校正圖像。

2.3?立體匹配

立體匹配分為局部匹配、全局匹配和半全局匹配。局部匹配采用局部紋理約束進行視差匹配,算法速度較快,但整體上無法得到全局最優化;全局匹配需定義1個能量函數,表征左右相機成像的相似性,找到全局最小能量,對應的變化函數就是全局視差,此方法對模糊圖像不敏感,但代價較高,不適合大量使用;半全局匹配綜合局部匹配和全局匹配2種方法的優點,在每行尋找最佳視差路徑,該視差可整行匹配,代價最低,匹配精度較高,計算量較小。

半全局匹配的步驟為匹配代價計算→代價聚合→視差計算與細化:設置單位三維矩陣XDSI存儲像素的匹配代價,XDSI越小,說明左、右相機成像相似度越高;經代價聚合,XDSI才能計算最優視差,代價聚合是對XDSI進行全局優化,得到存有代價聚合的新矩陣后計算視差,選擇最小視差;視差細化是對視差圖進行誤差消除、亞像素插值等細化操作。

視差是重建三維的關鍵,通過立體匹配,采用半全局匹配算法找到相機視差,半全局算法將全局最優化問題簡化為多方向代價問題,用一維多個代價聚合的方式實現二維路徑最優化,尋找每個像素的最優視差,生成深度圖,求得目標點坐標為:

z=Qx fQx-u0-uR-uL-u0s=Qx fQx-dx=Qx fQx-duR-u0s=QxQx-dx-xcy=Qx fQx-dvR-v0s=QxQx-dy-yc,(5)

式中:Qx為左、右相機基線;(uL,vL)、(uR,vR)分別為左目、右目的目標點像素坐標;d為視差,d=uL-uR。

由式(5)可得目標點的世界坐標,建立相機三維深度圖。

3?WLS濾波深度圖優化

圖像優化通常是指對圖像采取多尺度分層處理,將圖像分為平滑基礎層、大尺度亮度變化層和小尺度細節殘差層,分層處理后再合并為優化圖像,易產生視覺偽影,把不存在的影像呈現在圖像上,需避免產生視覺偽影,保留圖像細節。

線性濾波的優化使圖像邊緣不清晰,輸出圖像易出現光暈,不適合多尺度圖像處理。WLS濾波是基于雙邊濾波的加權最小二乘保邊濾波,能通過調整正則項(懲罰項)更改約束條件平衡邊緣和平滑區,對深度圖噪聲明顯的區域平滑去噪,同時保留深度圖中物體邊緣。

設原圖為G,WLS濾波輸出圖為W,為使W盡可能接近G,WLS濾波損失函數應取最小值,損失函數

fW=∑pWp-Gp2+δaxpG-W-x2p+aypG-W-y2p ,

式中:axp、ayp分別為圖像坐標系x、y方向的梯度加權矩陣,控制不同方向的平滑程度;p為像素點坐標;Wp為WLS濾波輸出圖中p點的像素;Gp為原圖中p點的像素;δ為正則項參數。

Wp-Gp2可確保輸入圖像和輸出圖像的相似度更高,將G和W的距離最小化,保留圖像邊緣;δaxpG-W-x2p+aypG-W-y2p為正則項,作用為構造輔助函數,把約束優化問題轉化為無約束問題,將原圖的偏導最小化,實現小梯度區域的平滑。當圖像的邊緣梯度較大時,約束變小,保留邊緣特征;當圖像的邊緣梯度較小時,認為不是重要細節信息,約束變大,減少邊緣特征。δ越大,輸出圖像越平滑,損失函數的二次型矩陣形式為:

fW=a-bTa-b+δaTDTxAxDxa+aTDTyAyDya ,

式中:a、b為圖像的向量表示,Ax、Ay為圖像對角矩陣,Dx、Dy為前向離散差分算子,DTx、DTy為后向離散差分算子。

為求得損失函數的最小值,令損失函數導數為0,求目標解:

(I+δL )-1a=b ,

L=DTxAxDx+DTyAyDy ,

式中:I為單位矩陣;L為五點空間異構Laplacian矩陣,隨空間位置而改變。

平滑權重函數為:

axpG=-l-xpμ+ε-1aypG=-l-ypμ+ε-1 ,

式中:l為原圖像對數亮度通道;axpG和aypG決定W圖像梯度的靈敏度;ε為常數,為防止分母為0,ε=0.000 1。

WLS濾波器的濾波函數可表示為:

Fδ=I+δLG-1 。

式中LG為圖像G的五點空間異構矩陣。

經計算和試驗,優化后的WLS濾波器參數為:正則化系數為4 000,邊緣敏感度為0.125,視差差異閾值為110,深度不連續半徑為3像素。

4?深度圖結果分析

采用雙目相機像元PXYZ-H65-606,分辨率為1280像素×720像素。拍攝標定的數據集為80組圖像,標定板為30 mm棋盤格,圖案陣列為12格×9格。試驗系統為Windows 10專業版,英特爾Core i7-7700 2.80GHz四核處理器,顯卡為NVIDIA GeForce GTX 1050,試驗環境為PyCharm Community Edition 2022.3.3、OpenCV4.7.0.72。

經標定和計算,左相機內部參數為905.300 4?0.960 2647.966 7?0?904.967 6308.883 6?0?0?1?,畸變系數為(0.027 5?-0.088 6?0.001 9?0.000 6?0.149 2)。

右相機內部參數為906.348 2?0.762 3640.843 6?0?905.881 1321.577 1?0?0?0?,畸變系數為(0.025 7-0.050 7?0.001 3?0.001 1?0.008 4),旋轉矩陣為0.999 9-0.001 00.014 00.001 0?1?-0.001 4-0.014 00.001 40.999 9,平移矩陣為(-59.530 4?-0.070 2?-0.014 8)。

雙目相機原圖如圖3所示,半全局匹配算法深度圖如圖4所示。采用半全局匹配在整幅圖中整體尋找最優視差,對遮擋和弱紋理區域較敏感,深度圖在弱紋理區域的噪聲更強,還原度更差,易造成錯誤匹配。深度圖經WLS濾波優化后如圖5所示,對背景的單一弱紋理有較好的還原度,保留圖像的邊緣特征,去除半全局匹配深度圖的噪聲,可優化圖像細節。

通過圖像中最大像素和均方誤差確定峰值信噪比,峰值信噪比越大,表示輸入圖像的相似度越高。結構相似性指數分別從圖像亮度、對比度、結構3個方向評價圖像質量,可衡量圖像的失真程度或相似程度,結構相似性指數取值范圍為[-1,1],結構相似性指數越大,相似度越高。平均絕對誤差為輸入圖像、輸出圖像像素灰度差的絕對值除以圖像像素,平均絕對誤差越小,左右相機成像偏差越小。指定圖像尚未有較成熟的評價體系,此處采用的3種圖像質量評價參數只作參考,仍需結合人眼視覺感知綜合判斷圖像質量。

算法峰值信噪比/dB結構相似性指數平均絕對誤差

半全局匹配?9.768 00.430 543.606 0

WLS濾波優化11.617 00.845 622.063 8

為適應圖像質量評價算法,對半全局匹配的深度圖進行灰度反轉,在3種圖像質量評價算法中,以原圖為參考,評價半全局匹配和WLS濾波優化2種方法生成深度圖的質量,結果如表1所示。

由表1可知:與采用半全局匹配算法相比,經WLS濾波后的深度圖峰值信噪比較高,圖像失真較少,質量較高;結構相似性指數較大,與原圖結構相似性更大,深度圖呈現效果較好;平均絕對誤差更小,還原度更高。在試驗環境中,低紋理區域有更好的視覺效果,對海參邊緣等細節還原度較高,視覺匹配的準確度較高。經WLS濾波器處理的深度圖質量更好,連續性更好。

5?結論

針對雙目視覺三維重建深度圖邊緣不連續的問題,提出基于WLS濾波的深度圖優化。獲取雙目相機內外部參數后,對相機圖像畸變、歪斜等現象進行校正,在半全局匹配算法后加入WLS濾波優化深度圖,對梯度較大的區域減少約束、保留細節,對梯度較小的區域平滑處理、去除噪聲,重建的深度圖視覺效果更好,可改善半全局區域匹配不連續的問題,減小匹配誤差,使視差圖質量更高。采用3種圖像質量評價指標對半全局匹配算法深度圖和WLS濾波優化算法深度圖進行質量評價,結合視覺感知說明WLS濾波器優化后的深度圖效果更好。

參考文獻:

[1]?李煊,張銘鈞. 水下雙目視覺系統中的目標分割和目標定位[J].華中科技大學學報(自然科學版),2017,45(12):53-59.

[2]?李光樂,謝小鵬. 水下移動雙目視覺高精度定位方法[J].中國測試,2015,41(增刊1):37-39.

[3]?ZHOU J C,SUN J M,ZHANG W S,et al. Multi-view underwater image enhancement method via embedded fusion mechanism[J].Engineering Applications of Artificial Intelligence: the International Journal of Intelligent Real-Time Automation,2023,121:105946.

[4]?楊皓天,萬騰. 葡萄采摘機械臂的雙目定位與抓取精度研究[J].農機化研究,2022,44(12):49-54.

[5]?秦朗朗,潘豐. 基于雙目定位的離合器下料系統設計[J].傳感器與微系統,2017,36(10):80-84.

[6]?ZHOU J C,ZHANG D H,ZHANG W S. Cross-view enhancement network for underwater images[J].Engineering Applications of Artificial Intelligence: the International Journal of Intelligent Real-Time Automation,2023,121:105952.

[7]?楊敬鈺,謝天昊,岳煥景. 基于多層級跨模態特征融合的深度圖重建算法[J].華中科技大學學報(自然科學版),2023,51(3):52-59.

[8]?徐碩,姜言清,李曄,等. 智能水下機器人自主回收的雙目視覺定位[J].哈爾濱工程大學學報,2022,43(8):1084-1090.

[9]?SENUSHKIN D,ROMANOV M,BELIKOV I,et al.Decoder modulation for indoor depth completion[C]// Proceedings of the IEEE International Conference on Intelligent Robots and Systems.Piscataway, New Jersey, United States:IEEE,2021:1697-1704.

[10]?IMRAN S,LONGY F,LIU X,et al.Depth coefficients for depth completion[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Piscataway,New Jersey, United States:IEEE,2019:12438-12447.

[11]?LONG Y Q,YU H M,LIU B.Depth completion towards different sensor configurations via relative depth map estimation and scale recovery[J].Journal of Visual Communication and Image Representation,2021,32(4):25-36.

[12]?馬偉蘋,李文新,孫晉川,等. 基于粗-精立體匹配的雙目視覺目標定位方法[J].計算機應用,2020,40(1):227-232.

[13]?孔慧芳,房亮. 基于多尺度特征融合的快速單目圖像深度估計[J].合肥工業大學學報(自然科學版),2022,45(3):332-335.

[14]?符強,孔健明,紀元法,等. 基于雙目視覺的無人機實時測距算法[J].電光與控制,2023,30(4):94-99.

[15]?岳煥景,廖磊,楊敬鈺. 基于雙重自注意力機制的人臉圖像修復[J].湖南大學學報(自然科學版),2023,50(8):32-41.

[16]?邵小強,楊濤,衛晉陽,等. 改進同態濾波的礦井監控視頻圖像增強算法[J].西安科技大學學報,2022,42(6):1205-1213.

[17]?劉長明,曹紅燕,范焱,等. 結合OSTU閾值法的自適應DCP圖像優化算法[J].火力與指揮控制,2022,47(6):162-170.

[18]?孟宇彤,趙康軍,趙偉. 針對森林背景的去霧圖像優化[J].森林工程,2022,38(4):106-112.

[19]?ZHANG Z Y. A flexible new technique for camera calibration[J].IEEE Transactions on Patern Analysis and Machine Intelligence, 2000,22(11):1330-1334.

[20]?楊健.基于視覺的水下目標識別與定位技術研究[D].桂林:桂林電子科技大學,2022.

[21]?權穩穩.基于視覺的水下目標識別與定位技術研究[D].濟南:山東大學,2018.

Depth map reconstruction of binocular vision optimized by

WLS filtering

ZHOU Siqi1, GUAN Zhiguang1*, YIN Shanshan1, GUO Ziyi1, LIN Mingxing2

1. School of Construction Machinery,Shandong Jiaotong University,Jinan 250357,China;

2. School of Mechanical Engineering,Shandong University,Jinan 250061,China

Abstract:To address the issue of discontinuities in the depth map of binocular vision three-dimensional reconstruction, a depth map optimization based on weighted least squares (WLS) filtering is proposed. A 3D depth map is established through binocular calibration, distortion correction, stereo rectification, and stereo matching. WLS filtering is applied. By adjusting the regularization term to modify the constraint conditions, constraints are reduced in regions with large gradients to preserve image edges, while smoothing is applied to regions with small gradients to remove noise. The image quality is evaluated using three parameters: peak signal-to-noise ratio (PSNR), structural similarity index (SSI), and mean absolute error (MAE). The evaluation results show that compared to the semi-global matching algorithm, this algorithm increases the PSNR by 1.849 dB, resulting in lower image distortion and higher quality. The SSI increases by 0.415 1, indicating stronger similarity to the original image structure. The MAE decreases by 21.542 2, leading to higher fidelity. The reconstructed depth map shows better visual effects, which improves the issue of discontinuities in stereo matching, reduces matching errors, and enhances the quality of the parallax map.

Keywords:WLS filtering;binocular vision;3D reconstruction;depth map; stereo matching

(責任編輯:王惠)

收稿日期:2023-01-09

基金項目:山東省自然科學基金項目(ZR2020ME267);山東省重點研發計劃(重大科技創新工程)項目(2019JZZY020703)

第一作者簡介:周思琦(1999—),女,黑龍江嫩江人,碩士研究生,主要研究方向為水下雙目定位,E-mail:1797079352@qq.com。

*通信作者簡介:管志光(1980—),男,山東單縣人,教授,工學博士,主要研究方向為機器視覺和水下雙目視覺等,E-mail:guanzhiguang@sdjtu.edu.cn。

DOI:10.3969/j.issn.1672-0032.2024.02.019