基于改進Swin Transformer 的花色布匹瑕疵檢測算法

邱健數 項朝輝 錢月鐘

摘要:在進行布匹瑕疵檢測時,復雜的花色紋理對瑕疵的檢測帶來一定的困難。針對該問題,文中提出了基于改進SwinTransformer的花色布匹瑕疵檢測算法。首先,利用雙路Swin Transformer注意力骨干網絡提取缺陷圖與模板圖中的特征信息。然后,采用改進的特征金字塔網絡對四個層次的特征進行融合。最后,根據融合后的特征完成了瑕疵的定位與分類。在布匹生成工廠采集的數據集上進行模型訓練與測試,結果表明,文中所提算法的準確率和平均精確率均優于所比較的算法。

關鍵詞:布匹瑕疵檢測;注意力網絡;特征金字塔網絡;瑕疵分類;計算機視覺

中圖分類號:TP391 文獻標識碼:A

文章編號:1009-3044(2024)13-0009-05 開放科學(資源服務)標識碼(OSID) :

0 引言

紡織布匹具有多變、復雜的紋理圖案,被廣泛應用于服裝、鞋類等產品的生產中。由于紡織機械故障、紗線原料問題,在紡織布匹制造過程中會出現種類多樣的瑕疵。目前,紡織行業定義的織物瑕疵達到70多種[1]。傳統紡織工廠仍主要采用人工檢測,該方法依賴于檢測人員的經驗,且隨著作業時間延長,易產生疲勞,造成漏檢和誤檢。因此,紡織布匹自動檢測對提升產品質量、降低經濟損失具有較大意義。

傳統的布匹瑕疵自動化檢測方法包括:統計學方法[2]、光譜分析法[3]和模型法[4]。近年來,人工智能技術迅速發展,大量研究人員開始使用人工智能算法解決布匹瑕疵檢測問題。其中,卷積神經網絡相關的算法最為突出。Jing等[5]提出了一種非常高效的卷積神經網絡Mobile-Unet來實現端到端的缺陷分割。Jun等[6]采用兩階段的卷積神經網絡對局部缺陷和全局缺陷分別進行識別。Jing等[7]在YOLOv3模型的基礎上結合織物缺陷尺寸和k-means算法對目標幀進行維度聚類,有效降低了織物疵點的檢測錯誤率。Xie等[8]基于全卷積通道注意塊和自底向上路徑增強傳遞連接塊設計了改進的RefineDet網絡,提高了缺陷定位精度。Song等[9]采用了EfficientDet-D0作為檢測算法,綜合了輕量級和可擴展性的優點,適應資源受限的邊緣設備。楊毅等[10]在MobileNetv2的逆殘差結構中加入CoordAttention注意力模塊,將空間精確位置信息嵌入到通道注意力中,增強網絡聚焦小目標特征的能力。龍玥等[11]將RepVGG網絡融合SE模塊,提出SERepVGG網絡作為SSD的主干網絡在增強網絡特征提取能力的同時,減少網絡的參數量和計算量。張銀等[12]針對織物圖像尺寸大、局部瑕疵數量少、圖像背景復雜等問題,設計了一種基于Cascade R-CNN融合尺度不變特征的織物瑕疵檢測方法。曲皓等[13]提出一種雙端輸入型網絡架構Wnet,在卷積深層網絡中補充全局信息但對細小的織物瑕疵,檢測效果依舊不夠理想。

盡管利用卷積神經網絡進行織物瑕疵檢測具有良好的局部特征提取能力,但缺少全局建模能力,導致特征中缺乏全局信息,無法達到預期的檢測效果。Transformer具有完備的全局建模能力,最初被廣泛應用于自然語言處理領域,后被引入計算機視覺領域。Dosovitskiy等[14]提出的Vision Transformer將圖片切分為圖片塊作為Transformer的輸入,在圖片分類任務上表現很好。Transformer的核心算法是自注意力機制,該機制彌補了卷積神經網絡在全局建模上的短板。李輝等[15]提出了融合形變卷積和自注意力的素色布匹檢測方法,有效提升了布匹瑕疵檢測的準確率和效率。時造雄等[16]在改進的YOLOv5模型頸部中引入注意力機制,能同時關注空間和通道信息,提高花色布匹表面瑕疵檢測的準確率。Transformer的自注意力機制從語言應用到視覺應用的挑戰源自于兩個領域的差異。例如,視覺實體在尺度上存在巨大差異。Liu等[17]提出了移動窗口計算的Swin Transformer,提升了在各種尺度上建模的靈活性,在許多通用檢測數據集上取得了領先的檢測效果。然而,紡織布匹瑕疵具有背景復雜、小目標為主和目標長寬比極端等難點存在,直接使用Swin Transformer 難以得到理想的效果。

因此,本文提出了一種改進的Swin Transformer布匹瑕疵檢測網絡Double-Swin。該網絡設計了雙路注意力通道的骨干網絡,同時在檢測圖和模板圖上進行注意力計算,且分階段融合注意力信息,有助于網絡關注到瑕疵與背景之間的聯系。同時,采用改進的BiFPN頸部網絡,對不同階段的特征按照自適應權重進行融合,有助于目標的發現。在相同的復雜花色布匹數據集上進行的大量實驗表明,Double-Swin的表現超過現有的主流目標檢測模型。

1 Double-Swin 模型

1.1 Double-Swin 骨干網絡

本文設計的Double-Swin骨干網絡主要分為兩部分:1) 設計了雙路注意力通道,同時輸入檢測圖和對應的模板圖,經過注意力計算后,將上路注意力特征與下路注意力特征融合,進入下一階段注意力計算。2) Swim Transformer模塊,該模塊在雙路通道上共享相同的權重,在上路中主要計算檢測圖中的缺陷注意力,在下路中主要計算模板圖中的背景注意力。具體結構如圖1所示。

受人工檢測過程啟發,檢測人員會對比檢測布匹和模板布匹來發現瑕疵。因此,本文設計了雙路注意力通道結構。雙路注意力通道的主要作用包括:1) 計算檢測圖上的注意力,得到與布匹瑕疵相關的全局信息;2) 計算模板圖上的注意力,得到與布匹背景相關的全局信息;3) 融合上下路注意力,使得網絡能夠關注到瑕疵與背景之間的聯系。結合Swim Trans?former,該部分計算過程如下:

1.2 改進的特征金字塔網絡

通常,在深度骨干網絡提取特征的過程中,網絡的深層包含較多的全局信息,而淺層包含更多的局部信息。將深層和淺層的多尺度特征進行融合,可以有效提升目標檢測的效果[18-19]。特征金字塔網絡(FPN) [20]提出了自上而下將深層特征和淺層特征進行融合的方法,從而提升小目標檢測能力。受到NAS-FPN[21]和BiFPN[22]的啟發,本文設計了改進的雙向特征金字塔(DTSkip-BiFPN) 。該結構避免了NAS-FPN所需的極大搜索算力,同時與BiFPN相比,引入了自下而上的間隔跳躍連接,能夠將深層的特征信息跨尺度融合到淺層特征中。具體結構如圖2(d) 所示。

在進行特征融合時,對于每一個融合節點的輸入特征賦予可學習的權重wi,且wi ≥ 0,以DTSkip-BiFPN 的第4層為例,融合過程如下所示:

式中,Ptd4 為自頂向下路徑融合第4層的中間特征,Conv() 為卷積計算,Resize() 為重塑尺寸計算,ε=0.000 1起到避免數值不穩定的作用。

1.3 Double-swin 模型完整結構

Double-swin的完整網絡結構如圖3所示,首先將寬度均為W、高度為H 的檢測圖像和對應的模板圖輸入網絡中,經過Patch Partition模塊等分為16個區域,雙路數據尺寸均從(W,H,3) 被轉換為( W/4, H/4,48)。隨后,在Double-ST Block1中,雙路數據首先經過一個相同的Linear Emberdding層被分別投影至維度C,接著雙路數據進入兩個連續的Swim Transformer進行注意力計算,前一個Swim Transformer使用W-MSA進行多頭自注意力計算,后一個Swim Transformer使用SW-MSA進行滑動窗口多頭注意力計算,實現了信息的跨窗口通信,計算過程中,數據尺寸會維持在( W/4, H/4),Double-ST Block1 最終輸出的雙路數據尺寸均為( W/4, H/4,C )。雙路的輸出特征將進行一次融合,使得網絡關注到瑕疵與背景之間的聯系。融合后的特征和模板路的特征將再次以雙路的形式進入Double-ST Block2中。在Double-ST Block2階段,雙路輸入先經過一個共同的Patch Mergeing層,對數據完成一次下采樣,雙路數據尺寸均變換到( W/8, H/8,2C ),之后的注意力計算與Double-ST Block1 相同。Double-STBlock2 最終輸出的雙路數據尺寸均為( W/8, H/8,2C )。Double-ST Block3 和Double-ST Block4經過類似的計算,分別輸出的數據特征尺寸為(W/16 , H/16 ,4C )和( W/32 , H/32 ,8C )。至此,骨干網絡已完成注意力特征提取。4個階段的特征信息再經過3層DTSkip-BiFPN的多尺度特征融合,最后經過預測層,實現最終的布匹瑕疵檢測。

2 實驗及結果分析

2.1 實驗數據集說明

本文實驗所使用的數據采集自佛山南海紡織車間[23]。訓練集由3 933 幅缺陷圖及對應的模板圖構成,總計15 600個瑕疵標簽。測試集包含438幅缺陷圖,1 651個瑕疵標簽。瑕疵缺陷涵蓋了紡織業中常見的15類瑕疵,例如玷污、錯花等,每幅待檢測的缺陷圖含有一種或多種瑕疵。圖像的原尺寸為4 096×1696,在實驗時進行了裁剪并縮放為512×256。在訓練過程中,采取了隨機翻轉、對稱變化等數據增強方式對訓練集進行數據擴充,布匹瑕疵樣本如圖4所示。實驗所使用的計算設備的CPU型號為Intel Core i7,GPU型號為NVIDIA RTX-3080,內存為64G,使用Py?Torch進行網絡模型搭建。

2.2 實驗評價指標

為了對本文方法的性能進行評估,從準確度(Ac?curacy,Acc) 和平均精準度(Average Precision,AP) 來分析性能,其中準確度:

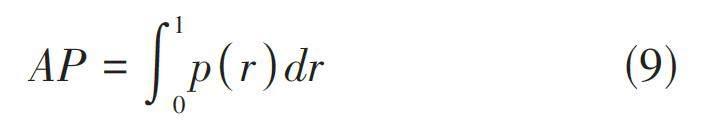

式中,TP為判斷正確的正例個數,FP為判斷錯誤的正例個數,TN為判斷正確的負例個數,FN為判斷錯誤的負例個數。平均精確度:

式中,p = TP/TP + FP 表示精確率,r = TP/TP + FN 表示召回率,那么AP就可以模型在不同召回率下的平均精確度,即為PR曲線下的面積。

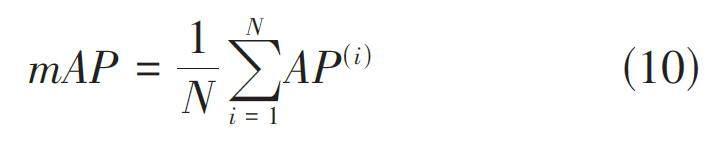

若AP(i)表示第i類瑕疵平均精確度,則類別平均精準度:

2.3 實驗設計與結果分析

為驗證本文模型的有效性,對比了本文模型與Faster R-CNN、Cascade R-CNN和DETR在2.1提到的布匹數據集上的性能。四組實驗的Batch size均設置為8,并采用等間隔調整策略對學習率進行調整。根據表1,可見Double-swin和DETR在準確率和各項平均精確度上均優于卷積類的網絡。這主要得益于trans?former類骨干網絡相比卷積類骨干網絡具有更好的全局信息提取能力,有利于瑕疵的檢測。具體來說,AP50表示在IOU閾值為0.5時的平均精確率,AP75表示在IOU 閾值為0.75 時的平均精確率。本文提出的Double-swin,在AP50上分別比Faster R-CNN、CascadeR-CNN和DETR提升了11.8%、6% 和2.7%,在AP75上分別提升了13.5%、7.4%和2.9%。APs表示IOU閾值在[0.5, 0.95]區間上對尺寸小于32×32的瑕疵的平均精確率,APm表示IOU閾值在[0.5, 0.95]區間上對尺寸介于32×32 和96×96 之間的瑕疵的平均精確率,APl 表示IOU閾值在[0.5, 0.95]區間上對尺寸大于96×96的瑕疵的平均精確率。Double-swin在各個尺寸的瑕疵檢測能力都優于其他模型,在小瑕疵和大瑕疵的檢測效果提升明顯,可推斷Double-swin的雙路注意力結構和改進的特征金字塔為布匹瑕疵檢測提供了更多有效的信息。在關鍵評估指標mAP上,Double-swin相較其他模型分別提升了10.5%、4.4%和1.8%。

為了更直觀地比較模型在復雜背景下的瑕疵檢測性能,筆者對上述模型在布匹背景復雜情況下的實際檢測效果進行了對比,結果如圖5所示。圖中紅色框表示瑕疵的真實位置,綠色框表示模型的預測位置。從對比結果可以看出,本文提出的Double-swin 能夠更完整、更精確地定位出瑕疵。

為進一步分析Double-swin中雙路注意力結構和DTSkip-BiFPN的有效性,筆者設計了4組消融實驗。從表2可以看出,與直接使用Swin Transformer作為骨干網絡、BiFPN作為特征融合結構相比,使用Doubleswin的雙路注意力骨干網絡在關鍵評價指標mAP上提升了1.1%,使用DTSkip-BiFPN 在mAP 上提升了0.3%。由此可知,雙路注意力結構和DTSkip-BiFPN 在提升模型性能上均是有效的,其中雙路注意力結構的提升效果更為顯著。

3 結束語

本文設計了Double-swin布匹瑕疵檢測算法,能夠有效地對花色布匹上的各類瑕疵進行定位與分類。首先,利用雙路Swin Transformer骨干網絡同時提取檢測圖和模板圖上的注意力特征,然后使用改進的特征金字塔DTSkip-BiFPN對各階段的特征進行融合,最后根據融合后的特征進行瑕疵檢測。經實驗分析發現,本文提出的檢測算法效果優于Faster R-CNN、Cas?cade R-CNN和DETR等模型。

參考文獻:

[1] HANBAY K,TALU M F,?ZG?VEN ? F. Fabric defect detec?tion systems and methods—a systematic literature review[J].Optik,2016,127(24):11960-11973.

[2] ZHANG K B,YAN Y D,LI P F,et al. Fabric defect detection us?ing salience metric for color dissimilarity and positional aggre?gation[J]. IEEE Access,2018,6:49170-49181.

[3] TONG L,WONG W K,KWONG C K. Fabric defect detection forapparel industry:a nonlocal sparse representation approach[J].IEEE Access,2017:1.

[4] YAN H,PAYNABAR K,SHI J J. Anomaly detection in imageswith smooth background via smooth-sparse decomposition[J].Technometrics,2017,59(1):102-114.

[5] JING J F,WANG Z,R?TSCH M,et al. Mobile-Unet:an efficientconvolutional neural network for fabric defect detection[J]. Tex?tile Research Journal,2022,92(1/2):30-42.

[6] JUN X,WANG J G,ZHOU J,et al. Fabric defect detection basedon a deep convolutional neural network using a two-stage strat?egy[J]. Textile Research Journal,2021,91(1/2):130-142.

[7] JING J F,ZHUO D,ZHANG H H,et al. Fabric defect detectionusing the improved YOLOv3 model[J]. Journal of EngineeredFibers and Fabrics,2020,15:155892502090826.

[8] XIE H S, WU Z S. A robust fabric defect detection methodbased on improved RefineDet[J]. Sensors,2020,20(15):4260.

[9] SONG S J,JING J F,HUANG Y Q,et al. EfficientDet for fabricdefect detection based on edge computing[J]. Journal of Engi?neered Fibers and Fabrics,2021,16:155892502110083.

[10] 楊毅,桑慶兵.多尺度特征自適應融合的輕量化織物瑕疵檢測[J].計算機工程,2022,48(12):288-295.

[11] 龍玥,韓軍,孫園,等.改進型SSD網絡的織物瑕疵檢測算法[J].廈門理工學院學報,2022,30(5):64-73.

[12] 張銀,佟樂.基于改進CascadeR-CNN的織物瑕疵檢測方法[J].上海師范大學學報(自然科學版),2023,52(2):231-237.

[13] 曲皓,狄嵐,梁久禎,等.雙端輸入型嵌套融合多尺度信息的織物瑕疵檢測[J]. 南京大學學報(自然科學),2023,59(3):398-412.

[14] DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An imageis worth 16x16 words: transformers for image recognition atscale[EB/OL]. International Conference on Machine Learning.PMLR, 2020.

[15] 李輝,呂祥聰,徐凌偉,等.融合形變卷積和自注意力的素色布匹瑕疵檢測[J].聊城大學學報(自然科學版),2022,35(6):1-10.

[16] 時造雄,茅正沖.基于改進Yolov5的花色布匹瑕疵檢測方法[J].計算機測量與控制,2023,31(4):56-62.

[17] LIU Z,LIN Y T,CAO Y,et al.Swin Transformer:hierarchical Vi?sion Transformer using Shifted Windows[C]//2021 IEEE/CVFInternational Conference on Computer Vision (ICCV).October10-17,2021.Montreal,QC,Canada.IEEE,2021.

[18] ZHANG F,LIN S L,XIAO X Y,et al.Global attention networkwith multiscale feature fusion for infrared small target detec?tion[J].Optics & Laser Technology,2024,168:110012.

[19] XU H,ZHONG S,ZHANG T X,et al.Multiscale multilevel re?sidual feature fusion for real-time infrared small target detec?tion[J].IEEE Transactions on Geoscience and Remote Sensing,2023,61:1-16.

[20] LIN T Y,DOLLAR P,GIRSHICK R,et al.Feature pyramid net?works for object detection[C]//2017 IEEE Conference on Com?puter Vision and Pattern Recognition (CVPR). July 21-26,2017.Honolulu,HI.IEEE,2017.

[21] GHIASI G,LIN T Y,LE Q V.NAS-FPN:learning scalable fea?ture pyramid architecture for object detection[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).June 15-20,2019.Long Beach,CA,USA.IEEE,2019.

[22] TAN M X,PANG R M,LE Q V.EfficientDet:scalable and effi?cient object detection[C]//2020 IEEE/CVF Conference onComputer Vision and Pattern Recognition (CVPR).June 13-19,2020.Seattle,WA,USA.IEEE,2020.

[23] 孟志青,邱健數.基于級聯卷積神經網絡的復雜花色布匹瑕疵檢測算法[J].模式識別與人工智能,2020,33(12):1135-1144.

【通聯編輯:唐一東】

基金項目:2023 年溫州市基礎科研項目:基于深度學習技術的復雜花色布匹瑕疵檢測及預警系統構建(G2023091) ;浙江工貿職業技術學院教師科技創新項目:復雜圖案布匹缺陷檢測及預警技術研究(縱20220005) ;溫州市重大科技項目:基于機器視覺的微型電子元器件在線檢測技術研究及裝備研制(ZG2023022) 資助