基于ResNet和UNet的胃癌病理圖像診斷系統

DOI:10.3969/j.issn.10001565.2024.04.012

摘要:考慮到人工對胃癌病理圖像的判別和診斷可能存在漏檢的問題,為使診斷更加準確,提出一種基于ResNet和UNet的病理圖像診斷系統,旨在實現對病理圖像的分類、分割以及輸出診斷結果.采用ResNet模型對胃癌病理圖像進行有癌和無癌的分類.對UNet模型進行改進,改進后的模型在每個下采樣和上采樣之前加入卷積注意力模塊,以增強模型對癌變區域的關注.使用殘差模塊替代編碼部分的2次卷積,來提高特征的利用率;利用Inception模塊來替代解碼部分上采樣中的2個卷積,從而擴充其寬度并獲取不同尺度的特征.將分類與分割結果綜合考慮,獲取最終的胃癌病理圖像的診斷結果.實驗結果表明,該系統可以有效地診斷胃癌病理圖像中是否存在癌變.

關鍵詞:病理圖像;圖像分類;UNet;圖像分割;胃癌診斷

中圖分類號:TP391.4文獻標志碼:A文章編號:10001565(2024)04043308

Gastric cancer pathological image diagnosis

system based on ResNet and UNet

ZHANG Wenyue1, JIA Ziyan1, LI Qing2, ZHANG Dachuan2, PAN Lingjiao1, SHEN Dawei1

(1. School of Electrical and Information Engineering, Jiangsu University of Technology,

Changzhou 213001, China; 2. Department of Pathology, Changzhou First

Peoples Hospital, Changzhou 213004, China)

Abstract: Considering that manual identification and diagnosis of gastric cancer pathological images may cause missed detection and in order to make diagnosis more accurate, a pathological image diagnosis system based on ResNet and UNet is proposed, aiming to classify, segment and output the diagnosis results of pathological images. The ResNet model is used to classify gastric cancer pathological images with and without cancer. The UNet model is improved, and the improved model adds a convolutional block attention module before each down-sampling and up-sampling to enhance the models attention to cancerous areas. The residual module is used to replace the two convolutions in the encoding part to improve feature utilization; and the Inception module is used to replace the two convolutions in the up-sampling

收稿日期:20231027;修回日期:20240425

基金項目:國家自然科學基金資助項目(62001196); 江蘇省“333高層次人才培養工程”項目(2022-3-4-107); 常州市科技計劃項目(CM20223015); 常州應用基礎研究項目(CJ20220064;CJ20220059)

第一作者:張文悅(1997—),女,江蘇理工學院在讀碩士研究生,主要從事計算機醫學圖像處理方向研究.

E-mail:zhangwenyue97wren@163.com

通信作者:賈子彥(1981—),男,江蘇理工學院副教授,主要從事可見光通信、機器視覺、5G方向研究.

E-mail:jiaziyan@jsut.edu.cn

of the decoding part, thereby expanding its width to obtain features of different scales. The classification and segmentation results are comprehensively considered to obtain the final diagnostic results of gastric cancer pathological images. Experimental results show that this system can effectively diagnose the presence of cancer in gastric cancer pathological images.

Key words:pathological images; image classification; UNet; image segmentation; diagnosis of gastric cancer

中國癌癥發病率不斷增加,而胃癌致死率在所有癌癥類型中位于前3位[1-2].傳統的胃癌篩查主要是利用內窺鏡或影像檢查等方式對異常部位的組織取樣并制成病理切片,通過專業病理醫生對病理圖像進行閱片和診斷[3-4].目前,病理醫生主要集中在三甲醫院,導致基層醫院的診斷需求難以得到滿足[5].在胃癌診斷和治療中,人工智能技術起到了重要作用.胃癌病理圖像復雜多變,分割過程存在許多困難和挑戰,如圖像質量、噪聲、光照和形態等因素.隨著計算機硬件和深度學習技術的不斷發展,深度學習在數字病理圖像中的應用優勢也愈加顯著[6].

近年來,深度學習作為人工智能的子領域,在病理圖像的分類與分割研究中有著廣泛的應用.喻殿智等[7]在對乳腺癌病理圖像的研究中利用協調注意力機制與DenseNet基礎分類模型進行融合,在BreakHis數據集中驗證的分類準確率為90.23%,從而證明該模型可以有效提升網絡特征提取能力.楊昆等[8]對ResNet50和VGG16等分類方法在腎透明細胞癌病理圖像分類中的效果進行對比,并提出以ResNet50為基礎融合通道注意力模塊sECANet,在腎透明細胞癌的分級任務中表現優于基礎模型,為改善腎癌治療和預后提供了有價值的參考.Li等[9]提出一種雙路UNet網絡結構,每一支路分別對核的區域和核的邊界進行識別,對重疊細胞核具有一定的分割能力,但是實驗過程中也存在著過度分割的問題.Baykal等[10]結合基于深度學習的FCN、SegNet以及UNet 3種網絡模型,該網絡使用微調網絡的特征來提高分割效率,獲得了相比于多數投票算法具有更加準確的分割結果.鄧健志等[11]以UNet為基礎模型設計了深度殘差幻影模塊,并引入了空洞拆分注意力模塊來獲取更多的特征信息,從而提高病理圖像的分割精度.Zhang等[12]提出將改進的ASPP模塊與UNet模型進行融合,以改善UNet在多次上采樣和下采樣操作中導致的邊緣信息丟失情況,并使用深度可分離卷積來代替原有的卷積結構,從而降低模型的復雜度.

現有研究主要集中在提高圖像分類或分割準確性上,未考慮將分類和分割后的結果圖進行拼接,以及將拼接后的結果圖與處理前的整張病理圖像作對比,并將對比結果用于輔助病理醫生的診斷工作.因此,本研究提出了一個基于深度學習的胃癌病理圖像診斷系統.該系統不僅能確保分割的準確性,而且能有效地輔助醫生進行診斷,采用卷積神經網絡中的ResNet模型對病理圖像進行有癌和無癌的分類,應用全卷積神經網絡中的UNet模型對分類后的圖像進行有癌區域的圖像分割.將分類和分割處理后的圖像結果綜合考慮,并將其拼接成帶有癌變區域標注的完整病理圖像.

1系統和模塊介紹

基于深度學習的胃癌病理圖像診斷系統的研究目的是對整張數字病理圖像進行診斷并判別是否存在癌變區域.該診斷通過胃癌病理圖像分類模塊和分割模塊實現,并對胃癌病理圖像分割算法進行改進,以達到更高的分割準確性.

1.1胃癌病理圖像診斷判別系統

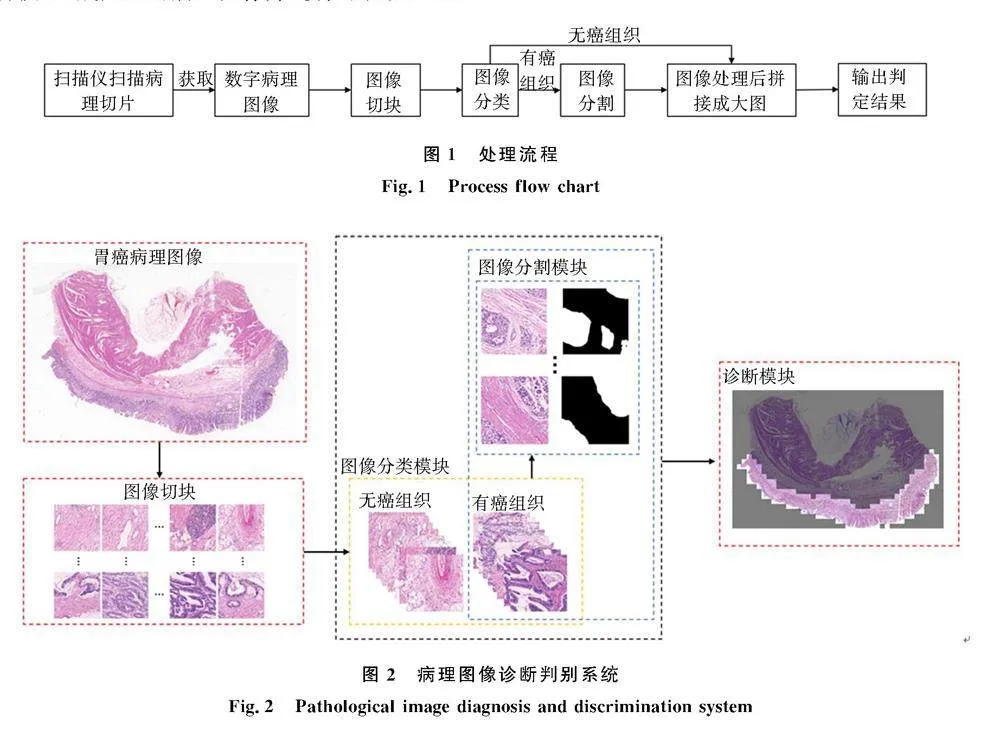

數字病理圖像是由數字掃描儀對病理組織切片掃描獲取,對其后續的處理流程如圖1所示.胃癌病理圖像診斷判別系統如圖2所示,由于獲取的整張數字病理圖像具有約10萬像素的高分辨率,因此無法直接進行分類和分割.采用OpenSlide方法對讀取到的數字病理圖像進行圖像切塊處理.使用ResNet模型搭建圖像分類模塊對處理后的圖像進行有癌和無癌的分類,若分類結果均為無癌,則輸出該切片無癌的判定結果.對UNet基礎模型進行改進,實現對分類為有癌的圖像進行癌變區域的準確分割.將獲得的分類和分割結果進行拼接,生成完整的病理圖像并進行可視化顯示.

1.2胃癌病理圖像分類模塊

Warin等[13]在卷積神經網絡的基礎上融合了DenseNet模型和ResNet模型,將該融合模型用于檢測口腔病理圖像的分類情況,并將結果和與醫生的診斷結果進行對比,最后獲得了較高的分類效率.Azour等[14]將預訓練模型EfficientNet與CNN預訓練模型集成后對乳腺癌病理圖像進行診斷,并通過實驗證明VGG19、ResNet系列、EfficientNet系列和DensNet-201等較小的模型更適用于小規模的數據集分類任務.由上述研究可以看出,ResNet模型在病理圖像的分類方面表現更加優異,所以本實驗選用ResNet模型進行圖像分類訓練.

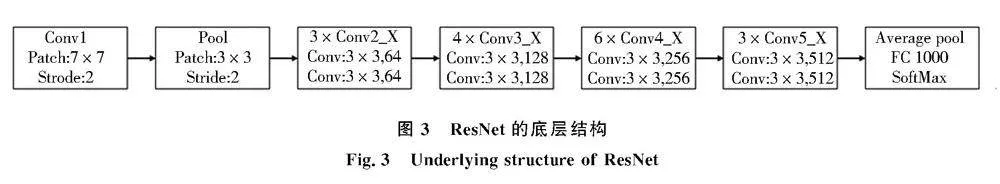

何愷明等[15]在2015年提出了ResNet系列網絡,該網絡采用了數據預處理方法,并在網絡結構中使用Batch Normalization替代Dropout,以加速訓練并解決梯度消失和梯度爆炸的問題.此外,還引入了殘差(Residual)模塊結構來緩解網絡退化問題,有效解決了深層網絡中的退化問題.殘差結構的原理就是在增加網絡層數的同時使非線性疊加層f(x)來更好地逼近目標函數H(x),通過快捷連接使F(x)+x逼近H(x).在深層網絡中加入恒等映射能夠使淺層特征直接傳遞至深層,有助于避免反向傳播過程中的梯度消失問題.這一策略不僅防止了網絡性能的下降,而且提升了深層網絡的整體性能表現.本實驗是對中等規模的胃癌病理圖像數據集進行分類實驗,該數據集中只需要進行有癌組織和無癌組織2個類別的區分,ResNet的底層結構如圖3所示.圖3ResNet的底層結構

Fig.3Underlying structure of ResNet1.3胃癌病理圖像分割模塊

UNet模型[16]在醫學圖像分割任務中取得了較好的分割性能.該模型能夠有效地獲取淺層和深層的圖像特征信息,有助于減少語義間隙問題.由于UNet模型在醫學圖像分割領域中的突出表現,本實驗基于UNet模型進行了改進.

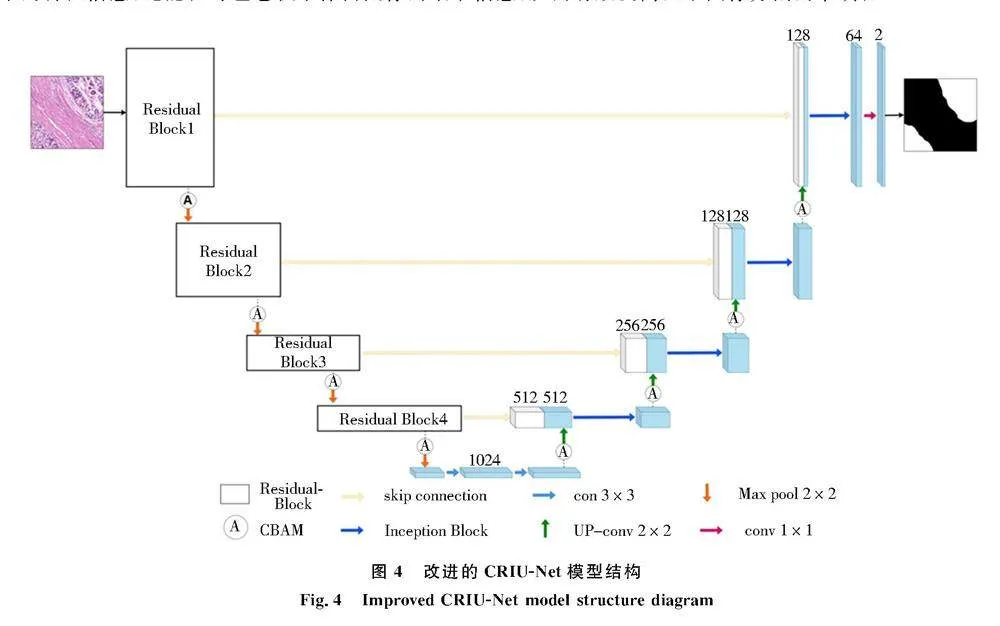

1.3.1CRIU-Net模型

為了提高UNet模型在醫學圖像中的分割準確性,提出一種結合卷積注意力模塊、殘差結構和Inception結構的病理圖像分割模型,簡稱為CRIU-Net模型,其總體框架如圖4所示.首先,在每個下采樣和上采樣之前都添加了卷積注意力模塊.其次,在編碼部分采用殘差模塊替換雙卷積.最后,在解碼部分使用Inception模塊替換雙卷積,在保持網絡深度的同時增強網絡的寬度和信息獲取能力.不僅有助于網絡更好地捕捉圖像中的特征信息,還能在每組卷積中保留圖像的細節信息,從而有效提高醫學圖像分割的準確性.

1.3.2卷積注意力模塊

采用的卷積注意力模塊[17](convolutional block attention module, CBAM)是由通道注意力機制模塊和空間注意力機制模塊組成.將2個模塊串聯在一起,使得卷積注意力模塊能夠同時學習通道和空間的注意力權重.這有助于卷積神經網絡更有效地捕捉輸入特征中的關鍵通道和關鍵空間位置,從而提升網絡的表達能力和泛化能力.

1)通道注意力機制模塊

首先輸入特征圖F,其大小為H×W×C,同時將特征圖進行平均池化操作和最大池化操作,從而獲得2個大小為1×1×C的特征通道.其次分別經過參數共享多感知器處理得到2個特征,并將2個特征進行相加.然后使用Sigmoid激活函數對向量進行歸一化使其范圍在[0,1]之間,從而獲得每個通道的注意力權重.最后將獲得的注意力權重乘以輸入特征圖的每個通道,實現增強重要通道的響應,抑制不重要通道的響應,其中Mc的計算公式如式(1)所示.Mc(F)=Sigmoid(MLP(AvgPool(F))+MLP(MaxPool(F))).(1)2)空間注意力機制模塊

首先輸入特征圖F′,其大小為H×W×C,同時將特征圖進行平均池化操作和最大池化操作,從而獲得2個大小為H×W×1的特征通道.然后將2個特征通道進行拼接.最后使用Sigmoid激活函數得到相應的權重系數,其中Ms的計算公式如式(2)所示.Ms(F′)=Sigmoid(conv7×7([AvgPool(F′);MaxPool(F′)])).(2)1.3.3殘差模塊

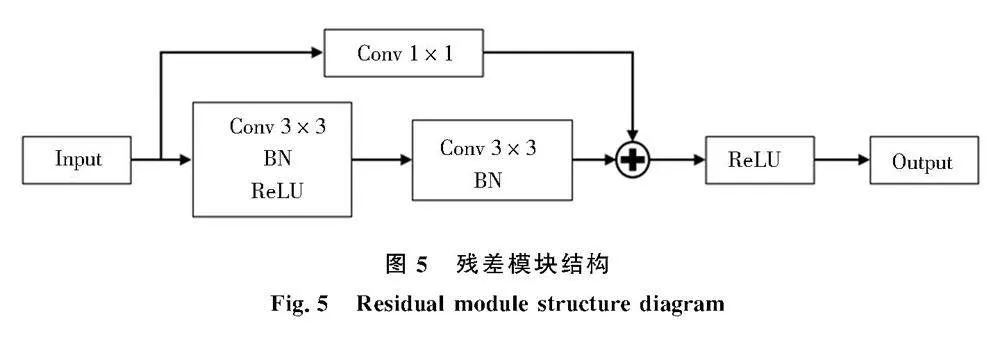

殘差模塊是ResNet模型中的基本構建單元,旨在解決深度神經網絡中的梯度消失和表達能力受限的問題.在傳統的卷積神經網絡中,隨著網絡層數的增加,梯度信號會逐漸變弱,導致網絡難以訓練.該模塊通過引入跳躍連接方法來解決上述問題.

殘差模塊結構如圖5所示,其基本結構是將輸入特征與輸出特征相加來構建,而非僅僅通過卷積操作將輸入特征轉換為輸出特征.跳躍連接允許網絡直接學習殘差,即輸入特征與期望的輸出特征之間的差異.這種設計有助于網絡更容易地學習恒等映射或近似恒等映射,并且能夠更高效地傳播梯度信號.由于跳躍連接的引入,網絡可以從淺層開始進行優化,而不需要一開始就進行端到端的訓練全程訓練.這種特性使得網絡更易于訓練,同時也有助于加速整個訓練過程.

1.3.4Inception模塊

傳統的卷積神經網絡中,通常使用固定大小的卷積核進行特征提取.為了提高網絡的性能,一般采用不斷加深網絡深度的方式.隨著網絡深度的增加,網絡訓練時的參數也越來越多,從而導致網絡過擬合.在2014年Google公司研究團隊提出GoogleLeNet卷積神經網絡.該網絡中Inception模塊通過增加模型寬度的方法使網絡性能再次提升,有效解決增加網絡深度帶來的過擬合問題.

Inception模塊主要由4個1×1卷積核、1個3×3卷積核、1個最大池化層和1個5×5卷積核組成.它并行地使用了不同尺度的卷積核來獲取多種感受野并進行特征提取.隨后,將得到的特征圖在通道維度上進行拼接,并使用1×1的卷積核進行降維,從而減少參數量.

2實驗與結果分析

2.1數據集

實驗中的胃癌數字病理圖像數據集來源于常州市第一人民醫院病理科.這些數字病理圖像是由數字掃描儀掃描病理組織切片生成的,格式為KFB.每張圖像的分辨率大約在50 000×50 000像素.由于完整的數字病理圖像無法直接應用與深度學習,因此將其轉換為TIF格式以便進行標注和訓練.利用python中OpenSlide庫的接口對圖像進行切塊,每個patch圖的大小為2 048×2 048像素,并對這些patch圖進行像素級別的手工標注.本分類數據集中共包含1 922張用于訓練、測試和驗證的胃癌病理圖像,按照8∶1∶1比例分為訓練集、測試集和驗證集;本分割數據集使用分類數據集中的961張有癌圖像用于訓練、測試和驗證,同時按照8∶1∶1比例分為訓練集、測試集和驗證集.

相比于自然圖像,病理圖像的獲得更加困難,通常需要進行復雜的采集和處理.此外,病理圖像數據集的樣本量往往有限,這可能導致訓練神經網絡時出現過擬合問題,即網絡在訓練數據上表現良好但在新數據上的泛化能力較差.而數據增強技術可以有效增加數據集的大小,從而更好地減少網絡出現過擬合問題.在不降低數據集質量的前提下對數據集中的數據進行水平翻轉和垂直翻轉來在線擴充數據集.

2.2實驗設置

該模型是使用Python 3.8和Pytorch實現的.模型的訓練和測試是在一臺服務器上進行的.分類模型和分割模型使用Tesla T4顯卡.使用的優化器是RMSprop,學習速度為0.00 001,用于訓練的批量大小為4.

2.3評價指標

對醫學圖像進行二分類的圖像分割,常采用的評價指標是交并比(Intersection over Union, IoU)、準確率(Accuracy)和Dice系數.為明確下述評價指標的計算公式的介紹,故先說明公式中所涉及的參數含義,TP(True Positive):真正例數,模型預測為正例,實際是正例,又可以用Pii表示;FP(False Positive):假正例數,模型預測為正例,實際是反例,又可以用Pij表示;FN(False Negative):假反例數,模型預測為反例,實際是正例,又可以用Pji表示;TN(True Negative):真反例數,模型預測為反例,實際是反例,又可以用Pjj表示.

交并比(IoU)是指用于比較預測結果與實際標簽之間的重疊區域,即將預測結果和實際標簽的交集大小除以它們的并集大小,如式(3)所示.IoU=TPTP+FP+FN ,(3)準確率(Accuracy)是指預測分割結果中正確分類的像素數占總像素數的比例,如式(4)所示.Accuracy=TP+TNTP+FP+TN+FN .(4)Dice系數是指用于衡量2個集合相似度的指標,如式(5)所示.Dice=2TP2TP+FP+FN .(5)2.4分類模型結果對比

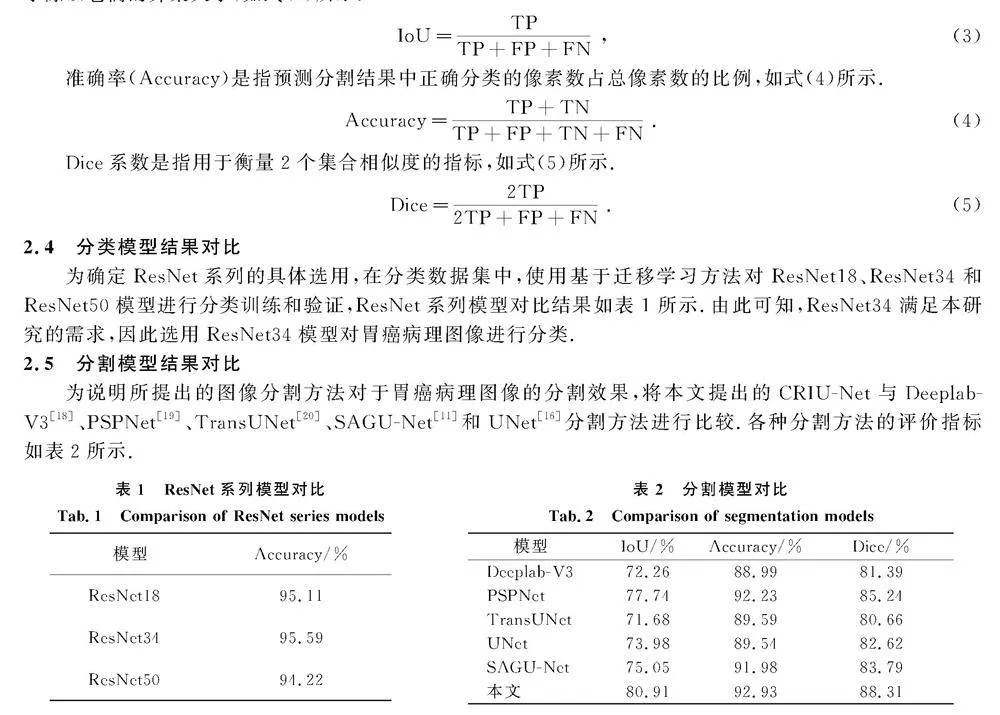

為確定ResNet系列的具體選用,在分類數據集中,使用基于遷移學習方法對ResNet18、ResNet34和ResNet50模型進行分類訓練和驗證,ResNet系列模型對比結果如表1所示.由此可知,ResNet34滿足本研究的需求,因此選用ResNet34模型對胃癌病理圖像進行分類.

2.5分割模型結果對比

為說明所提出的圖像分割方法對于胃癌病理圖像的分割效果,將本文提出的CRIU-Net與Deeplab-V3[18]、PSPNet[19]、TransUNet[20]、SAGU-Net[11]和UNet[16]分割方法進行比較.各種分割方法的評價指標如表2所示.表1ResNet系列模型對比

Tab.1Comparison of ResNet series models模型Accuracy/%ResNet1895.11ResNet3495.59ResNet5094.22表2分割模型對比

Tab.2Comparison of segmentation models模型IoU/%Accuracy/%Dice/%Deeplab-V372.2688.9981.39PSPNet77.7492.2385.24TransUNet71.6889.5980.66UNet73.9889.5482.62SAGU-Net75.0591.9883.79本文80.9192.9388.31

從表2中可知,CRIU-Net在圖像分割任務上的表現明顯優于現有的分割方法.這主要是由于在模型中引入了卷積注意力模塊、殘差模塊以及Inception模塊.這些模塊不僅有效地增加了網絡的寬度,還成功地保留了上一層的特征信息并增強了對有用特征的關注.這使得模型能夠獲得更豐富的特征信息并用于下一層的計算,從而取得了優秀的性能指標,充分展示了本文提出的CRIU-Net模型的優勢.圖6展示了各分割方法在相同病理圖像數據集上的分割結果.

2.6消融實驗

通過消融實驗驗證CRIU-Net模型中采用的Inception、CBAM和Residual模塊的合理性和有效性.共分為8組實驗:第1組為UNet基礎模型;第2組為Inception與UNet結合的組合;第3組為CBAM與UNet的組合;第4組為Residual與UNet的組合;第5組為Residual、Inception與UNet的組合;第6組為Residual、CBAM與UNet的組合;第7組為Inception、CBAM與UNet的組合;第8組為本文提出的CRIU-Net方法.其消融實驗結果如表3所示.

由表3可以看出,在UNet基礎模型中分別加入Inception、CBAM和Residual中的其中1種或2種模塊后,與基礎模型相比,其交并比與準確率有所提升.這表明通過增加模型的網絡寬度、加強對特征信息的注意力以及保留初始特征信息都能有效地改善模型的性能.當3種模塊共同組成的模型與UNet基礎模型相比時,即CRIU-Net模型,其在交并比和準確率上分別提升了6.93%和3.39%.在綜合分類與分割結果后,可將其拼接成完整的胃癌病理圖像,其中包括癌變位置和分割區域,具體如圖7所示.

3結論

針對胃癌病理圖像的診斷,提出了基于ResNet模型的胃癌圖像分類以及基于UNet模型的改進胃癌圖像分割方法.在圖像分割任務中,提出了CRIU-Net模型,該模型引入Inception模塊并加入了CBAM和Residual模塊.經過消融實驗及與其他分割模型的對比實驗,該模型在病理圖像分割中,其IoU和Accuracy分別為80.91%和92.93%.實驗結果表明,CRIU-Net模型在訓練過程中表現出較好的穩定性和魯棒性.與基礎的UNet模型相比,CRIU-Net模型在IoU和準確率上分別提高了6.93%和3.39%.隨著未來胃癌病理圖像數據集的不斷增加和HE染色步驟的標準化,胃癌病理圖像的數字診斷也會為病理醫生提供更加精準的參考.

參考文獻:

[1]BRAY F, LAVERSANNE M, WEIDERPASS E, et al.The ever-increasing importance of cancer as a leading cause of premature death worldwide[J].Cancer, 2021, 127(16):3029-3030.DOI.org/10.1002/cncr.33587.

[2]鄭榮壽,張思維,孫可欣,等.2016年中國惡性腫瘤流行情況分析[J].中華腫瘤雜志 , 2023, 45(3):212-220.DOI:10.3760/cma.j.cn112152-20220922-00647.

[3]石田蕾,張家意,鮑泳揚,等.基于深度學習的黑色素細胞病變全流程智能化精準診斷[J].生物醫學工程學雜志, 2022,39(05):919-927.DOI:10.7507/1001-5515.202203080.

[4]陳潁鍶,李晗,周雪婷,等.融合空洞卷積與注意力的胃癌組織切片分割[J].中國圖象圖形學報, 2021,26(09):2281-2292.DOI:10.11834/jig.200765.

[5]王繼偉,樊偉,陳崗,等.基于深度卷積神經網絡的數字病理輔助診斷系統設計[J].中國數字醫學, 2020,15(12)48-52.DOI:10.3969/j.issn.1673-7571.2020.12.014.

[6]ZHAO Y, ZHANG J, HU D, et al.Application of deep learning in histopathology images of breast cancer: a review[J]. Micromachines, 2022,13(12):2197. DOI: 10.3390/mi13122197.

[7]喻殿智,張欣,遲杏.基于CA-DenseNet的乳腺癌病理圖像識別[J].國外電子測量技術,2022,41(05):137-143. DOI:10.19652/j.cnki.femt.2103531.

[8]楊昆,常世龍,王尉丞,等.基于sECANet通道注意力機制的腎透明細胞癌病理圖像ISUP分級預測[J].電子與信息學報,2022,44(01):138-148. DOI: 10.11999/JEIT210900.

[9]LI X, WANG Y, TANG Q, et al. Dual U-Net for the segmentation of overlapping glioma nuclei[J]. IEEE Access, Vol84040-84052,2019. DOI: 10.1109/ACCESS.2019.2924744.

[10]BAYKAL E, DOAN H, EKINCI M, et al. An ensemble of fine-tuned fully convolutional neural networks for pleural effusion cell nuclei segmentation[J]. Computers and Electrical Engineering, 2019: 81. DOI: 10.1016/j.compeleceng.2019.106533.

[11]鄧健志,支佩佩,張峰銘,等.結合拆分注意力特征融合的病理圖像分割網絡[J].科學技術與工程,2023,23(7):2922-2931. DOI: 10.3969/j. issn.1671-1815.2023.07.030.

[12]ZHANG Y Y, LI Y Q, HE D Z. U-shaped network with multi-scale feature extraction for lesion region segmentation in gastric cancer images[C]//2023 IEEE 3rd International Conference on Information Technology, Big Data and Artificial Intelligence (ICIBA), Chongqing, China, 2023:234-238. DOI: 10.1109/ICIBA56860.2023.10165314.

[13]WARIN K, LIMPRASERT W, SUEBNUKARN S, et al. Performance of deep convolutional neural network for classification and detection of oral potentially malignant disorders in photographic images[J]. International journal of oral and maxillofacial surgery, 2022, 51(5):699-704. DOI:10.1016/j.ijom.2021.09.001.

[14]AZOUR F, BOUKERCHE A. An efficient transfer and ensemble learning based computer aided breast abnormality diagnosis system[J]. IEEE Access, vol. 11, 2023: 21199-21209. DOI: 10.1109/ACCESS.2022.3192857.

[15]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [J]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas, NV, USA, IEEE, 2016, 770-778. DOI:10.1109/CVPR.2016.90.

[16]RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[J]. arXiv preprint arXiv:1505.04597,2015. DOI.org/10.48550/arXiv.1505.04597.

[17]WOO S, PARK J, LEE J Y, et al. CBAM: convolutional block attention module [C]// Proceedings of the European conference on computer vision (ECCV). 2018: 3-19. DOI: 10.1007/978-3-030-01234-2_1.

[18]CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv preprint arXiv:1706.05587, 2017. DOI: 10.48550/ arXiv:1706.05587.

[19]ZHAO H, SHI J, QI X, et al. Pyramid scene parsing network [C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 2881-2890. DOI: 10.1109/CVPR.2017.660.

[20]CHEN J, LU Y, YU Q, et al. TransUNet: transformers make strong encoders for medical image segmentation[J]. arXiv preprint arXiv:2102.04306, 2021. DOI: 10.48550/arXiv.2102.04306.

(責任編輯:孟素蘭)