基于GA-TD3算法的交叉路口決策模型

摘 要:為了解決交叉路口場景下無人駕駛決策模型成功率低、模型不穩定、車輛通行效率低的問題,從兩個方面對TD3算法作出改進,提出了基于GA-TD3算法的交叉路口決策模型。首先引入記憶模塊,使用GRU神經網絡來提升決策模型的成功率;其次在狀態空間引入社會注意力機制,更加關注與社會車輛的交互行為,保證模型穩定性的同時提升車輛的通行效率。采用CARLA仿真器進行20 000回合的模型訓練后,TD3算法通過路口的成功率為92.4%,GA-TD3算法的成功率為97.6%,且車輛的通行時間縮短了3.36 s。GA-TD3算法模型在學習效率和通行效率上均有所提升,可用于緩解城市中的交通壓力,提高駕駛效率。

關鍵詞:深度強化學習; 無人駕駛決策; 交叉路口; 循環神經網絡; 注意力機制

中圖分類號:TP399 文獻標志碼:A 文章編號:1001-3695(2024)07-006-1965-06

doi:10.19734/j.issn.1001-3695.2023.10.0570

Intersection decision model based on GA-TD3 algorithm

Abstract:Addressing problems such as low success rates, instability, and inefficient traffic flow in autonomous decision-making models at intersections, this paper proposed an intersection decision model based on the GA-TD3(GRU attention twin delayed deep deterministic policy gradient)algorithm by improving TD3 algorithm from two aspects. Firstly,it introduced a memory module which using GRU neural network to improve the success rate of the decision model. Secondly, it introduced a social attention mechanism in the state space to focus on interactions with social vehicles,which ensured the stability of the model while improving the traffic efficiency of vehicles. After 20 000 rounds of training in the CARLA simulator, the TD3 algorithm achieves a success rate of 92.4%, while the success rate of the GA-TD3 algorithm is 97.6%. Additionally, the vehicle’s travel time is shortened by 3.36 s. GA-TD3 algorithm improves both learning efficiency and traffic efficiency, which can alleviate traffic pressure in urban scenes and improve driving efficiency.

Key words:deep reinforcement learning; autonomous driving decision; intersection scenario; recurrent neural network; attention mechanism

0 引言

在城市道路場景中,交叉路口場景的隨機性較高,復雜度高于其他道路場景,因此交叉路口的事故發生率遠高于其他場景,從而引發交通擁堵,路口通行效率也受到了極大的影響。無人駕駛技術的引入在一定程度上可以緩解交通擁堵,但想要實現高級別的無人駕駛,對交叉路口等復雜場景的研究是十分重要的。

無人駕駛傳統決策模型大致分為基于規則的決策模型[1~3]、基于博弈論的決策模型[4]、基于啟發式探索的決策模型[5]以及基于協同合作的方法[6,7]。傳統的無人駕駛決策方法更多應用在簡單場景中,無法與環境進行實時交互,在隨機性強的場景中處理能力較差。

強化學習算法則彌補了缺陷,可以根據環境的反饋來學習并調整相應的決策策略,具有較強的自適應能力,例如Q-learning[8]、sarsa[9]。傳統強化學習決策模型只能解決少量離散的動作值,因此得到的決策模型根據簡單的狀態空間給出的決策動作較為粗糙。

深度學習在處理大批量的數據方面具有較高的準確性,因此與強化學習結合得到的深度強化學習算法在處理連續高維的環境狀態空間具有較好的表現能力,在連續控制任務[10]、棋盤游戲[11]以及實施策略游戲[12]上達到了超人級別的性能。此外無人駕駛領域也有著較為不錯的成果[13~15],深度強化學習模型在匝道匯入[16]換道場景[17]都有著一定的研究,采用深度強化學習的方法解決交叉路口問題也是現階段研究的熱點之一[18~20]。文獻[21]采用一種基于DDPG(deep deterministic policy gradien)算法的匝道匯入車流決策模型,將匯入車流問題轉換為序列決策問題的方式進行求解。針對文獻[21]實驗模型不具備記憶功能的問題,吳思凡等人[22]提出基于LSTM-A3C(long short-term memory-asynchronous advantage actor-critic)算法的智能車匯入模型。實驗結果表明結合長短期記憶神經網絡可有效地解決模型訓練時間長和模型收斂慢的問題,但DDPG算法本身存在局部最優、Q估計錯誤等問題,導致模型成功率低。雙延遲深度確定性策略梯度(twin delayed deep deterministic policy gradient,TD3)算法改善了DDPG的問題[23]。文獻[24]對TD3算法中的actor網絡進行改進,為目標動作添加OU(Ornstein-Uhlenbeck) 噪聲,對改進后的TD3算法進行無人駕駛車輛在無信號交叉口下的右轉駕駛決策研究,發現其不僅能夠探索更多可能,而且通行決策表現更加突出。由于駕駛環境的不確定性,導致大多數基于規則的模型決策精度差,文獻[25]改進了TD3算法的結構,使用長短期記憶(LSTM)來選擇基于時間信息的動作,該算法在SUMO仿真模擬器進行驗證,在不確定交通場景下具有較好的泛化效果。

由于十字交叉路口場景的動態性和未知性較大,導致決策模型收斂速度慢、成功率低、訓練過程模型波動較大以及交通效率低等問題,提出基于GA-TD3(GRU attention-twin delayed deep deterministic policy gradient)無人駕駛決策模型。該模型是在TD3算法的基礎上,加入GRU(gate recurrent unit)神經網絡,通過優化網絡結構來提升決策模型的成功率;引入社會注意力機制,更加關注與社會車輛的交互行為來提升無人駕駛車輛通行效率。基于CARLA仿真平臺,本文算法分別與主流的深度強化學習算法TD3、SAC(soft actor critic)算法進行實驗對比,實驗結果表明改進后的模型達到了預期效果。

1 基于GA-TD3算法的決策模型

本文提出的交叉路口決策模型采用TD3算法模型作為基準進行改進。TD3是由DDPG算法改進而來,引入雙層critic網絡解決DPPG算法Q值高估的問題,actor網絡延遲更新,以及增加動作噪聲提升算法的性能。此外,DDPG和TD3主要用于處理連續的狀態空間和動作空間,在無人駕駛決策領域有著不錯的表現。

由于無人駕駛車輛的動作是連續的,為了保證動作的連貫性,在動作探索的過程中采用OU噪聲取代了高斯噪聲,以此提高模型的準確率[24]。此外還有學者通過修改經驗回放池,對過往經驗進行合理采樣,以提升模型的成功概率。但針對動態變化的場景,以上改進依舊存在學習效率低、模型不穩定的問題。

面對交叉路口場景,agent車輛在訓練過程中普遍存在對前后狀態信息關聯性較少的問題,同樣TD3模型也會因場景中的車輛布局動態變化導致模型的成功率降低,車輛通行路口的效率也隨之降低。無人駕駛場景的狀態空間和動作空間以連續數據為主,在處理大量具有序列特征的數據,RNN(recurrent neural network)神經網絡能夠很好地挖掘到數據中的時態及語義,在無人駕駛場景中可以較好地處理狀態空間中的有序數據并獲取有意義的狀態關系[26]。但RNN不具備長期記憶信息能力,在模型訓練過程中容易產生梯度消失的問題。LSTM具有長期記憶的功能,可以有效解決RNN面臨的梯度問題,該神經網絡在記憶有意義信息的同時也會忘記無意義的信息。文獻[25]同樣采用LSTM與TD3算法進行結合,使用長短期記憶來選擇基于時間信息的動作,使agent車輛的動作更可靠,從而提升模型的成功率。將LSTM與TD3模型結合在一定程度上增加了模型的維度,在處理前期較為簡單的場景會增加動作選擇的范圍,導致模型的在前期訓練出現不穩定、收斂慢的問題。

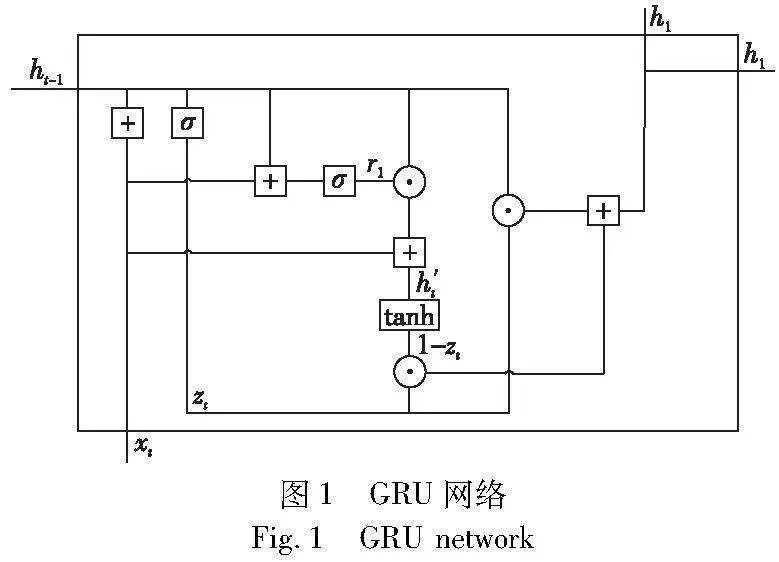

GRU是LSTM的變體,如圖1所示,其框架結構更加簡潔,僅由兩個門構成(update門和reset門),因此可以直接將隱藏狀態傳遞給下一個單元,參數也相對更少,面對一般規模的數據集,GRU比LSTM更容易訓練,模型的收斂速度更快,卻具有相近的性能[27]。

GRU有update門和reset門兩個重要的門,分別如式(1)(2)所示。

zt=σ(Wz·[ht-1,xt])(1)

rt=σ(Wr·[ht-1,xt])(2)

其中:xt為第t個時步的輸入向量;經過線性變換后,ht-1表示上一時步的信息并再次進行線性變換。

reset門與update門同理,新的記憶信息將通過reset門存儲的過去信息進行計算,公式為

h′t=tanh(W·[rtht-1,xt])(3)

update門用來決定當前記憶內容h′t與ht-1中需要存儲哪些信息,ht用來存儲當前單元的信息并傳遞到下一個單元中。具體公式為

ht=(1-zt)*h(t-1)+zt*h′t(4)

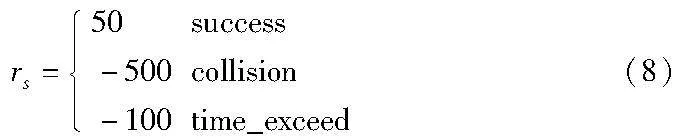

門控循環單元會記憶每一個循環過程中有用的信息并傳遞到下一個循環單元,保留有意義的歷史信息,將GRU神經網絡與TD3的actor-critic網絡相結合,為TD3算法模型提供記憶功能詳細結構,如圖2所示。actor-critic網絡均采用全連接網絡結構,狀態數據處理過程融入GRU網絡,通過GRU網絡保留上一時刻有意義的歷史狀態信息與當前輸入的狀態進行計算,保留有需要記憶的狀態ht傳遞給actor-critic網絡最后一層進行處理,actor-critic網絡中對狀態數據處理建立連接,以此改善了深度強化學習模型在面對復雜場景收斂速度慢、成功率低的問題。

深度強化學習算法的網絡結構是由各個全連接層組合而成,獲取到的狀態信息輸入模型中,并依次輸入到各全連接層進行處理,全連接層將處理后的結果輸入到下一層,最終得到相關的策略。這些策略在訓練過程中較容易得到,但難以給出做出當前動作的理由。如何讓決策變得更加合理成為了學術界的一大難題。對于無人駕駛決策動作而言,agent車輛能夠集中關注到交匯過程中有價值的信息是十分重要的[28,29]。

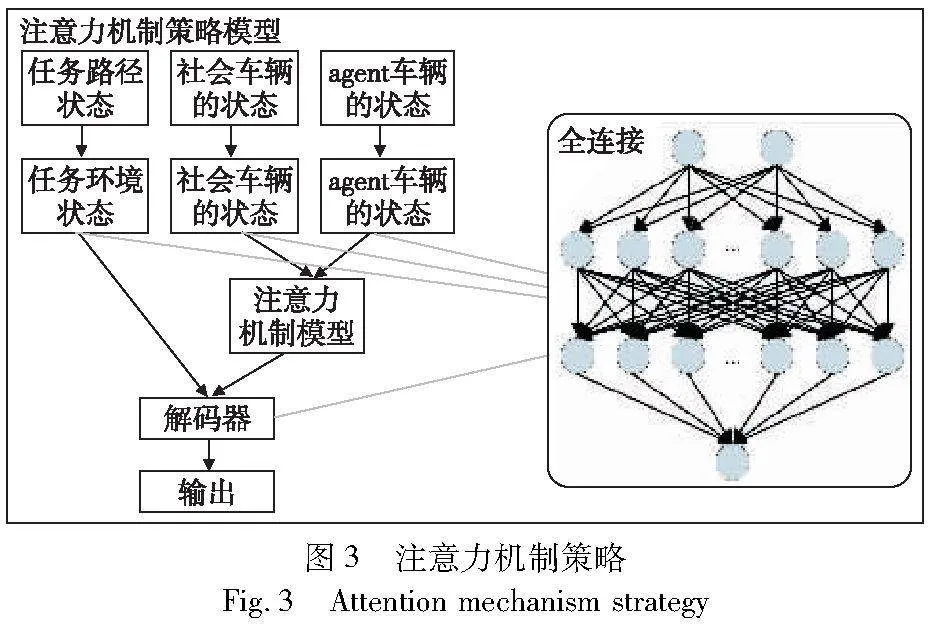

注意力機制被廣泛運用于深度學習模型的多個領域,比如圖像檢測、語音識別、以及自然語言處理等。近年來,注意力機制開始與深度強化學習相結合,主要應用于深度強化學習決策序列等方向,無人駕駛車輛可以根據輸入的狀態序列找到需要關注且有價值的狀態。

采用這種技術的主要目的是使深度強化學習模型自動捕獲自我車輛和社會車輛之間的依賴關系,以獲取更好的性能并具備較好的可解釋性。如圖3所示,將注意力機制應用于actor網絡,模型中的編碼器和解碼器由全連接層組成,由此構成注意力機制策略結構。產生注意力張量的過程可以描述如下:首先,需要將所有車輛的狀態表示分解為自我車輛狀態和社會車輛狀態兩個部分,分別對它們各自的狀態進行編碼,給出所有車的嵌入結果,然后將嵌入結果傳遞給深度強化學習網絡進行學習。注意力機制聚焦狀態信息之間的依賴關系,使自我車輛在動作選擇上也更加準確,保證模型的穩定性。

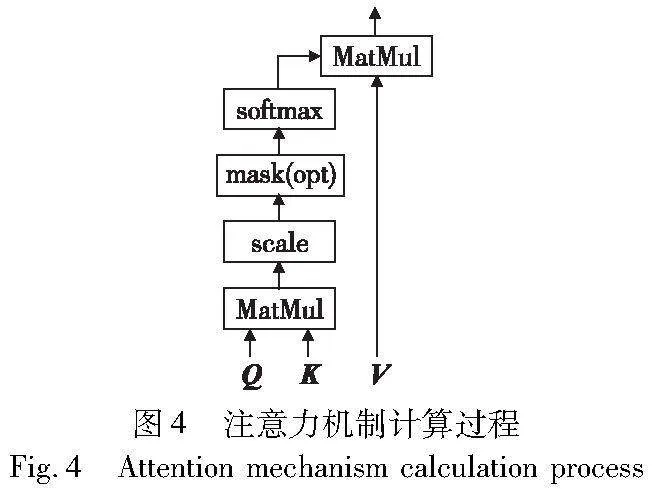

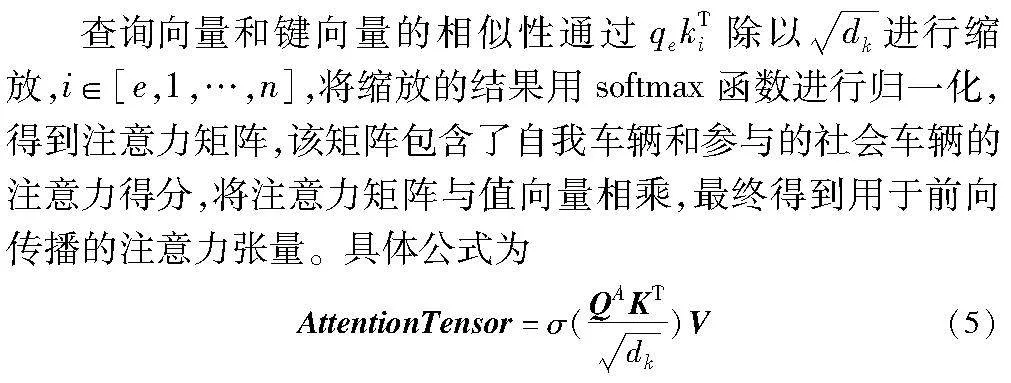

GA-TD3模型中的注意力機制的查詢向量定義為QA=[qe],代表計算當前agent車輛與其他需要集中關注的社會車輛狀態的關系度和關聯性。鍵向量定義為K=[ke,k1,…,kn],主要與查詢向量搭配使用,代表社會車輛和agent車輛之間產生交互的狀態關鍵信息。值向量定義為V=[ve,v1,…,vn],代表當前狀態空間對agent車輛交互過程中動作選擇的重要狀態信息,也代表著狀態空間需要集中關注的重要信息。深度強化學習模型根據獲取到的注意力信息進行策略選擇,增加了策略選擇的可解釋性。計算過程如圖4所示。

1.1 狀態空間

狀態空間是無人駕駛車輛從環境中獲取的所有車輛的狀態數據,這些數據反映了當前環境下車輛作出決策后所發生的一些情況。在復雜場景下無人駕駛車輛的狀態空間主要包括自我車輛的速度ve、位置pe,以及自我車輛與交互的社會車輛的相對速度vrel,相對位置prel和相對航向角rrel。因此,狀態空間定義為

st=(ve,pe,vrel,prel,rrel)(6)

1.2 動作空間

在深度強化學習決策模型中,無人駕駛車輛的動作空間包含自我車輛要執行的動作指令。在實驗環境中自我車輛在通過十字路口時的動作分為加速動作和減速動作,因此動作空間離散為加速Aup、減速Adown兩個向量,表示為

A={Aup,Adown}(7)

1.3 獎勵函數

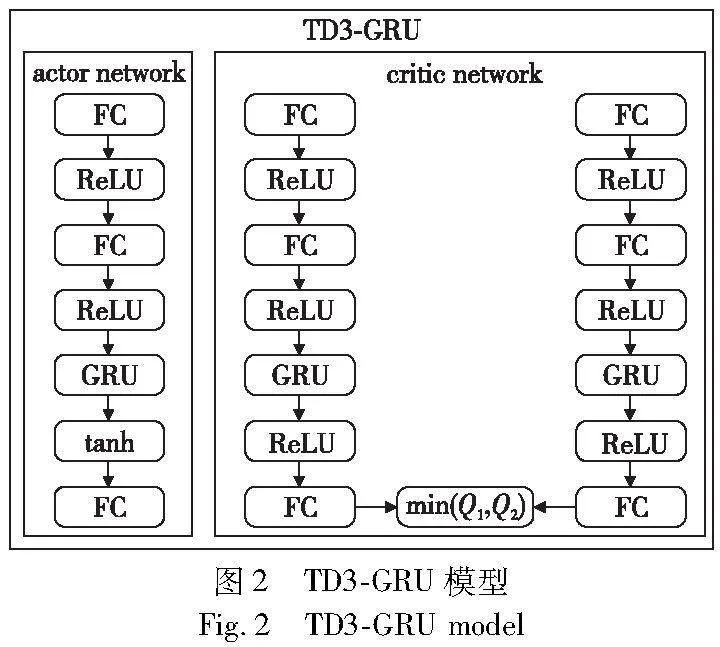

在深度強化學習模型中,獎勵函數主要體現在自我車輛和社會車輛交互過程中,自我車輛可以獲得最大期望的決策,獎勵函數的設定對于無人駕駛作出的期望決策動作至關重要。因此,決策模型算法的函數設定選擇圍繞車輛是否能成功通過十字路口來進行設計,在通過路口的過程中,自我車輛與社會車輛不發生碰撞并且通過的時間不能過長。根據以上條件,獎勵函數可以分為兩個部分組成,即r=rt+rs。

rs代表自我車輛根據當前狀態設定獎勵函數,為了保證能夠獲得較大的成功率,當車輛發生碰撞時深度強化學習模型將給出最大懲罰。同時,為了避免自我車輛通過十字路口等待最佳的通行間隙,導致車輛進入盲目等待狀態,將對等待超過30 s的車輛給予超時懲罰。edbf83cc4248e99b276b3e0c4b5eed94fcf25fa4722714f7e9ba68aa2472c03e在每個回合中,車輛到達設定的終點再給予獎勵。

以上是當前回合結束后對車輛當前狀態設定獎勵函數,這樣車輛獲得的獎勵實時性較低。為了能夠獲得實時獎勵,在自我車輛行駛過程中每走一步都給予及時獎勵rt=rt+rstep,其中rstep=-0.2為每個時間步長設定的小懲罰,以此來提高車輛的通行時間。

1.4 交叉路口決策模型

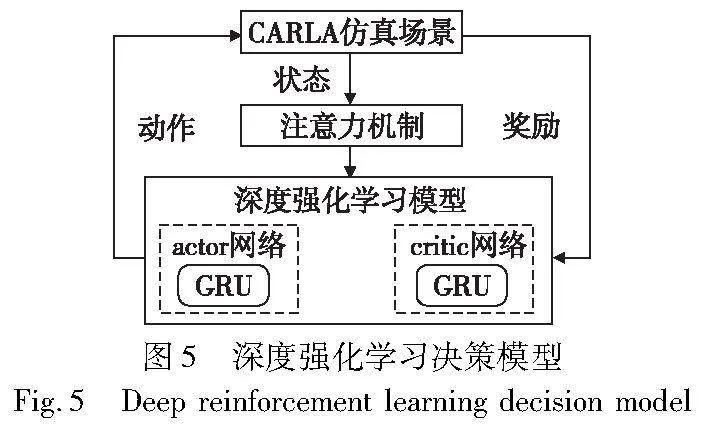

基于GA-TD3算法的完整決策模型如圖5所示。CARLA仿真場景提供當前時刻環境狀態st,首先使用注意力機制模型處理狀態信息,輸出的注意力張量AttentionTensor輸入到actor網絡。在actor-critic網絡中,GRU處理得到的ht傳遞給網絡的最后一層全連接層,最終actor網絡輸出相應的動作。自我車輛則根據模型的動作輸出結果,在仿真場景中不斷地探索,與社會車輛進行交互,在環境交互的過程中,模型車輛自我回報獎勵,critic網絡根據得到的動作獎勵對動作進行評估得到Qmin(s,a)。模型采用延遲更新策略,對網絡參數進行更新,以此探索得到最優的交叉路口決策模型。

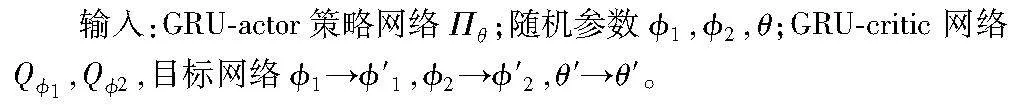

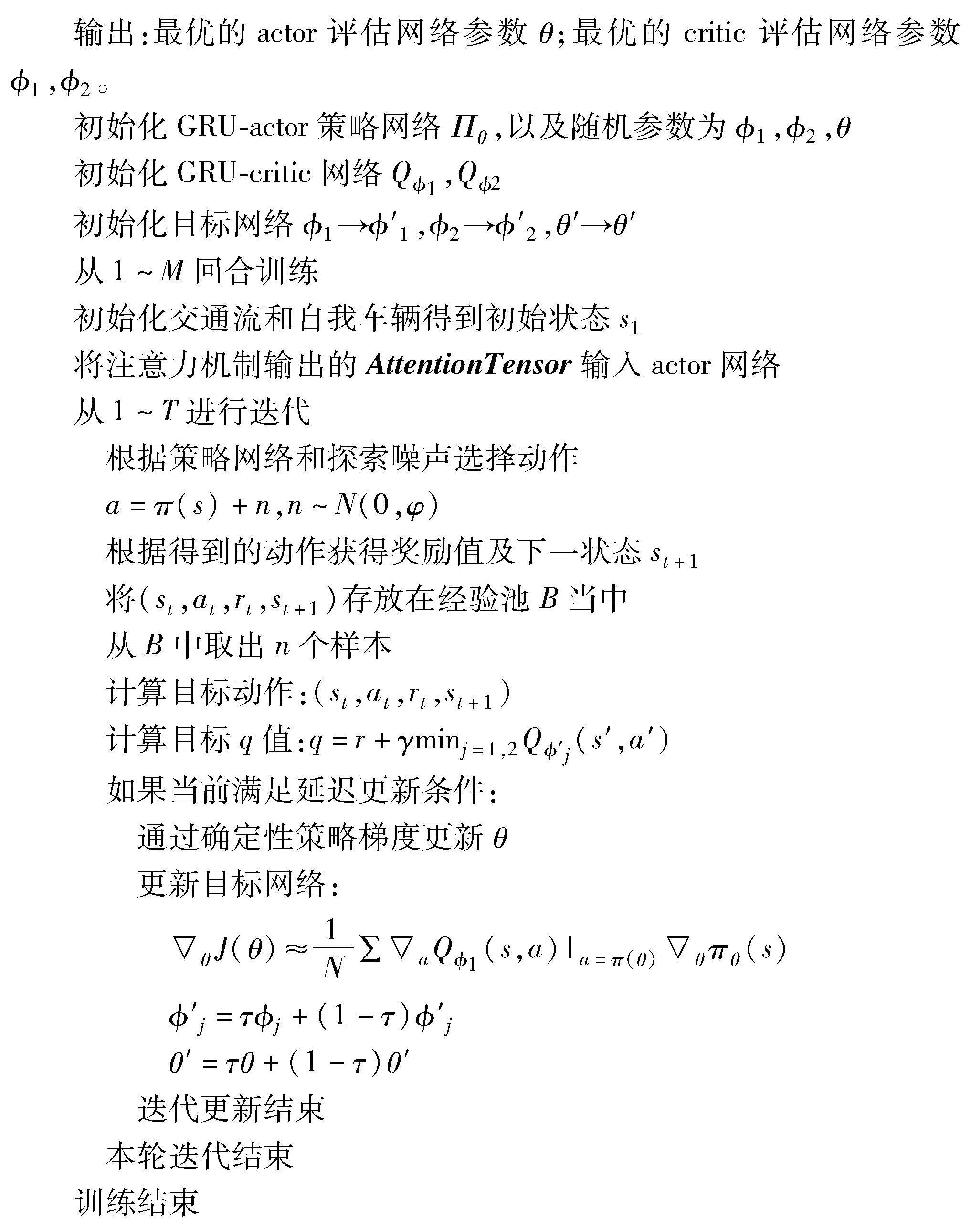

詳細的算法流程如算法1所示,首先初始化GRU-actor和GRU-critic網絡參數,并初始化相關的目標網絡參數。從CARLA仿真模擬器獲取的狀態空間進行解析,將狀態空間輸入到注意力機制模型中,注意力機制實時關注agent車輛與社會車輛交互的重要信息,將得到的注意力張量輸入到模型中進行訓練,模型根據獲取到的狀態信息進行動作選擇,從而得到合理的策略。actor和critic網絡根據延遲更新的頻率依次更新,并更新相關的目標網絡。深度強化學習不斷地迭代循環直至訓練結束,從而獲取到模型的最優策略。

算法1 GRU-Attention-TD3

2 仿真實驗

2.1 仿真環境

實驗設備配置為:Ubuntu 20.04系統,Intel Xeon Gold 6326 CPU @ 2.90 GHz,128 GB運行內存,顯卡Tesla V100-PCIE-32 GB。 實驗開發語言以Python語言為主,神經網絡框架選擇TensorFlow框架,采用CARLA仿真模擬器,選擇了Town03地圖搭建仿真場景。實驗場景搭建參考文獻[24]。根據實驗需求重新設定實驗場景數據。

自我車輛及社會車輛的路線,仿真場景如圖6(a)所示。交通流中社會車輛分直行通過十字路口和右轉同自我車輛共同匯入目的道路兩種路徑,如圖6(b)所示。右轉和直行的社會車輛隨機生成,社會車輛的跟車距離保持在5 m,在7~12 s隨機時間里生成社會車輛。當右轉車輛和直行車輛數量達到6輛以上開始生成自我車輛,進行訓練。為了加快訓練的時間,實驗場景關閉了紅綠燈的輪轉時間,始終保持自我車輛在結束新一輪訓練后能夠立刻生成。

實驗中的自我車輛根據設定的路線完成左轉行駛任務。場景以帶有交通信號燈的十字路口、交通流以垂直方向直行與左轉車輛同時存在的情景為主,當社會車輛數量達到5輛時,交通流初始化完畢,開始生成自我車輛。生成自我車輛有兩個限定條件,分別是交通流初始完畢和當前通行方向交通信號燈為綠燈。同時滿足這兩個條件,CARLA場景開始新的回合生成自我車輛,左轉通過當前路口。自我車輛的縱向控制由算法輸出的目標速度決定,限定了車輛的目標速度為50 km/h。社會車輛的初始速度為10 km/h,最終的目標速度為50 km/h。

2.2 深度強化學習參數設定

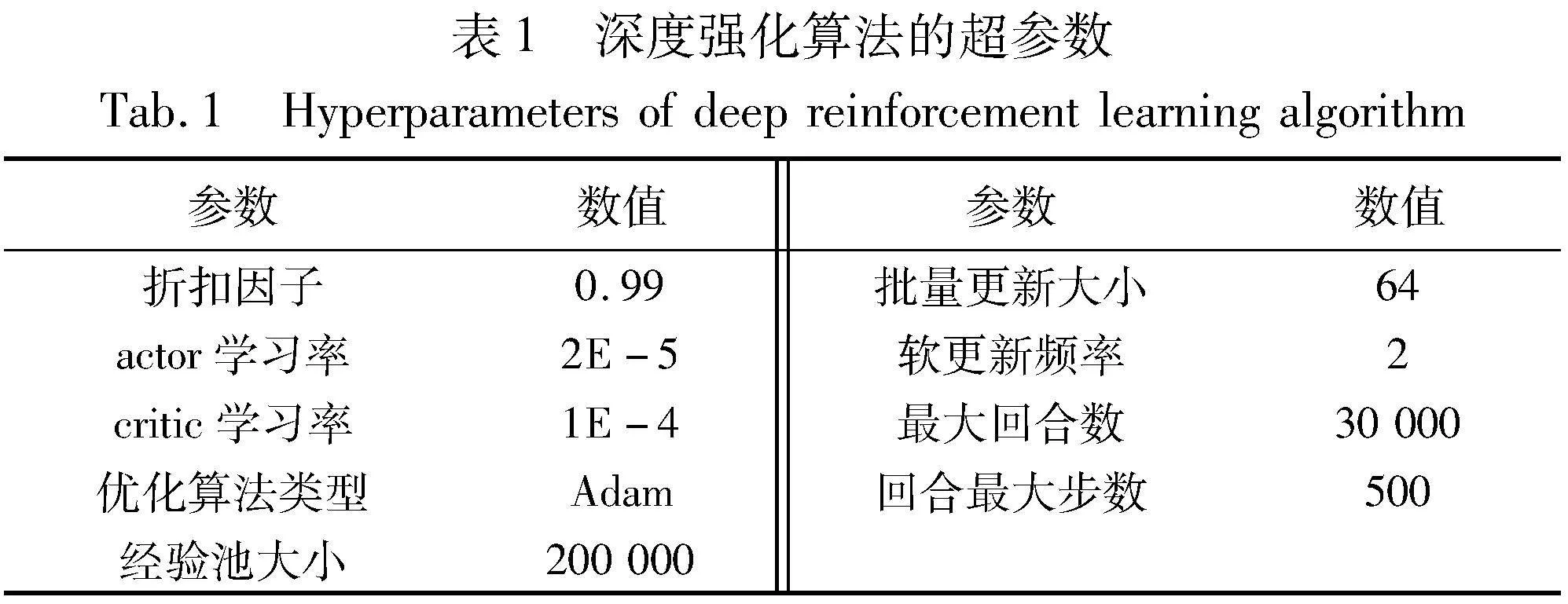

本文實驗訓練回合為20 000輪,帶有噪聲的回合數為1 000輪,模型訓練的詳細超參數如表1所示。

3 實驗結果分析

實驗采用不同的決策算法輸出的動作結果控制自我車輛根據周圍車流環境的變化順利左轉通過十字路口駛入主路,通過對比不同模型的成功率、超時率、獎勵值,以及車輛通過路口的時間來衡量深度強化學習模型的好壞。

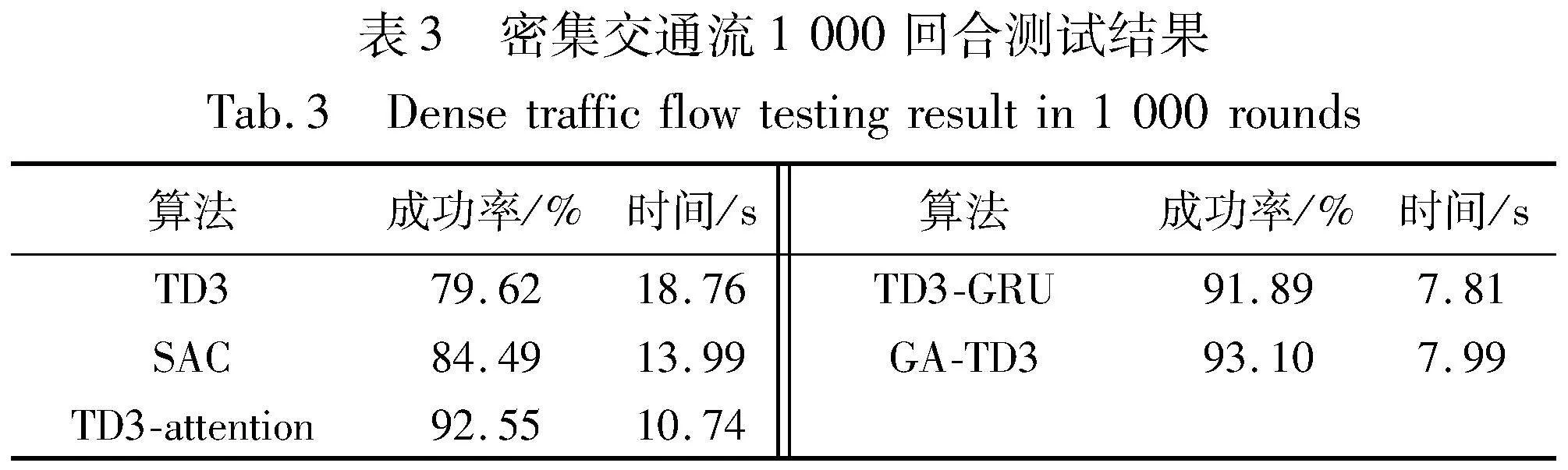

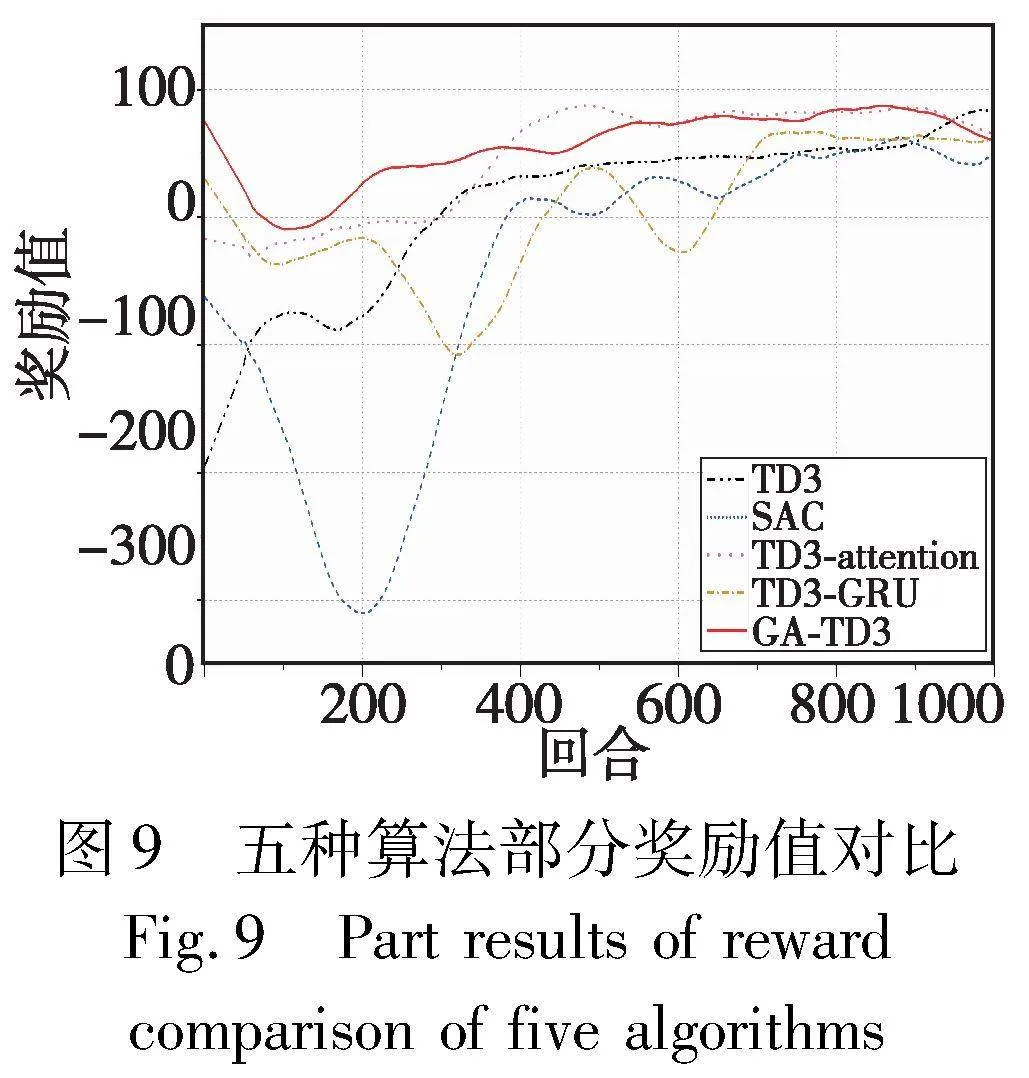

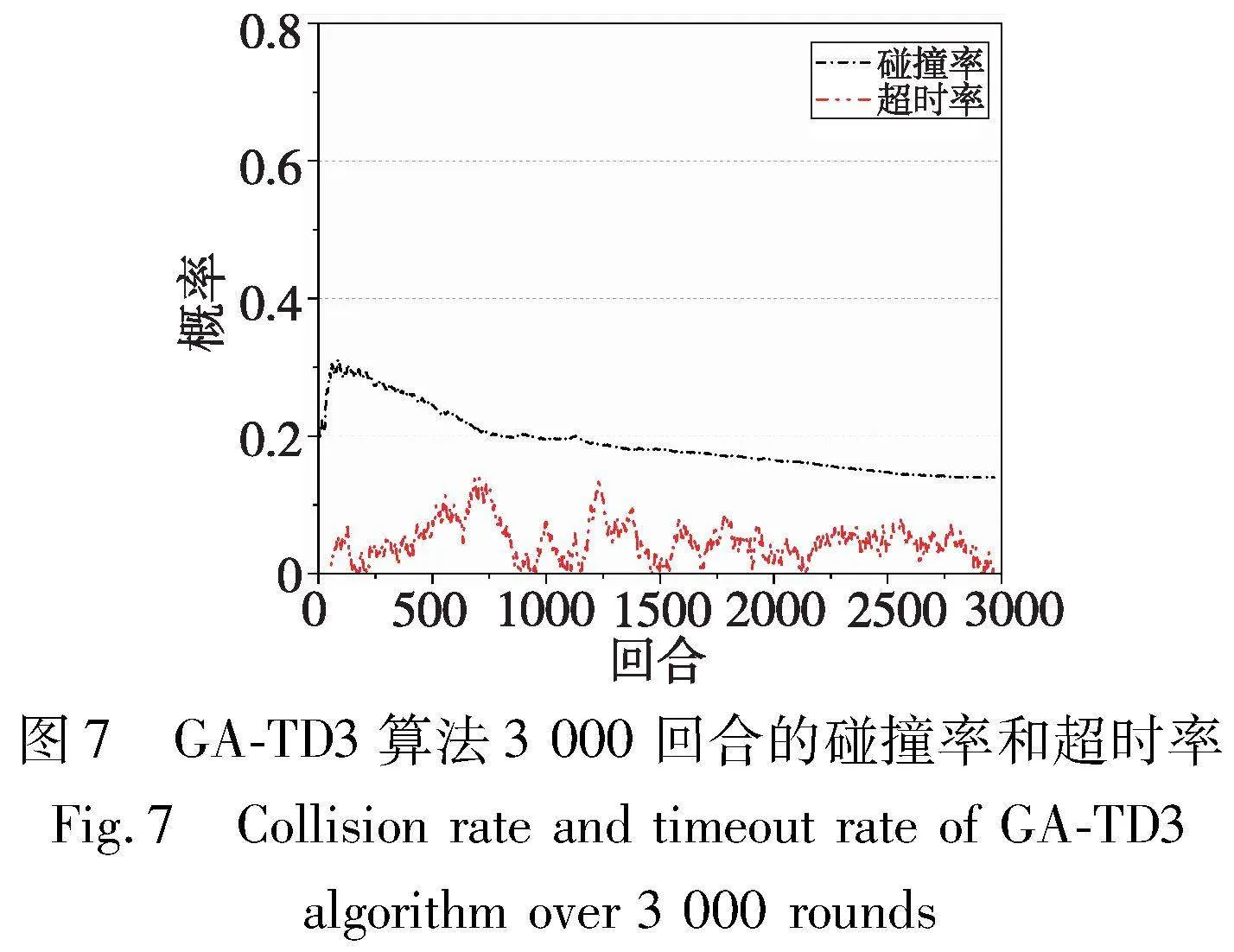

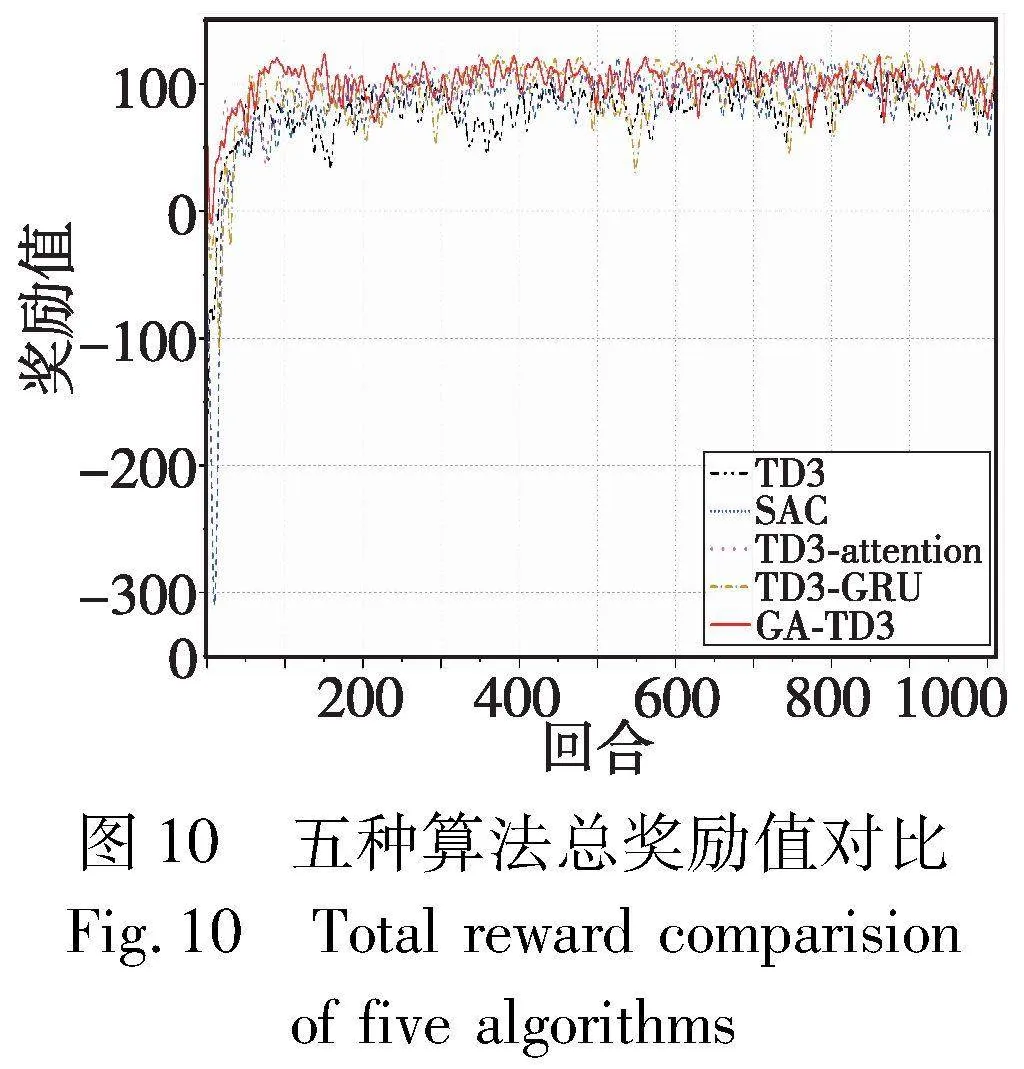

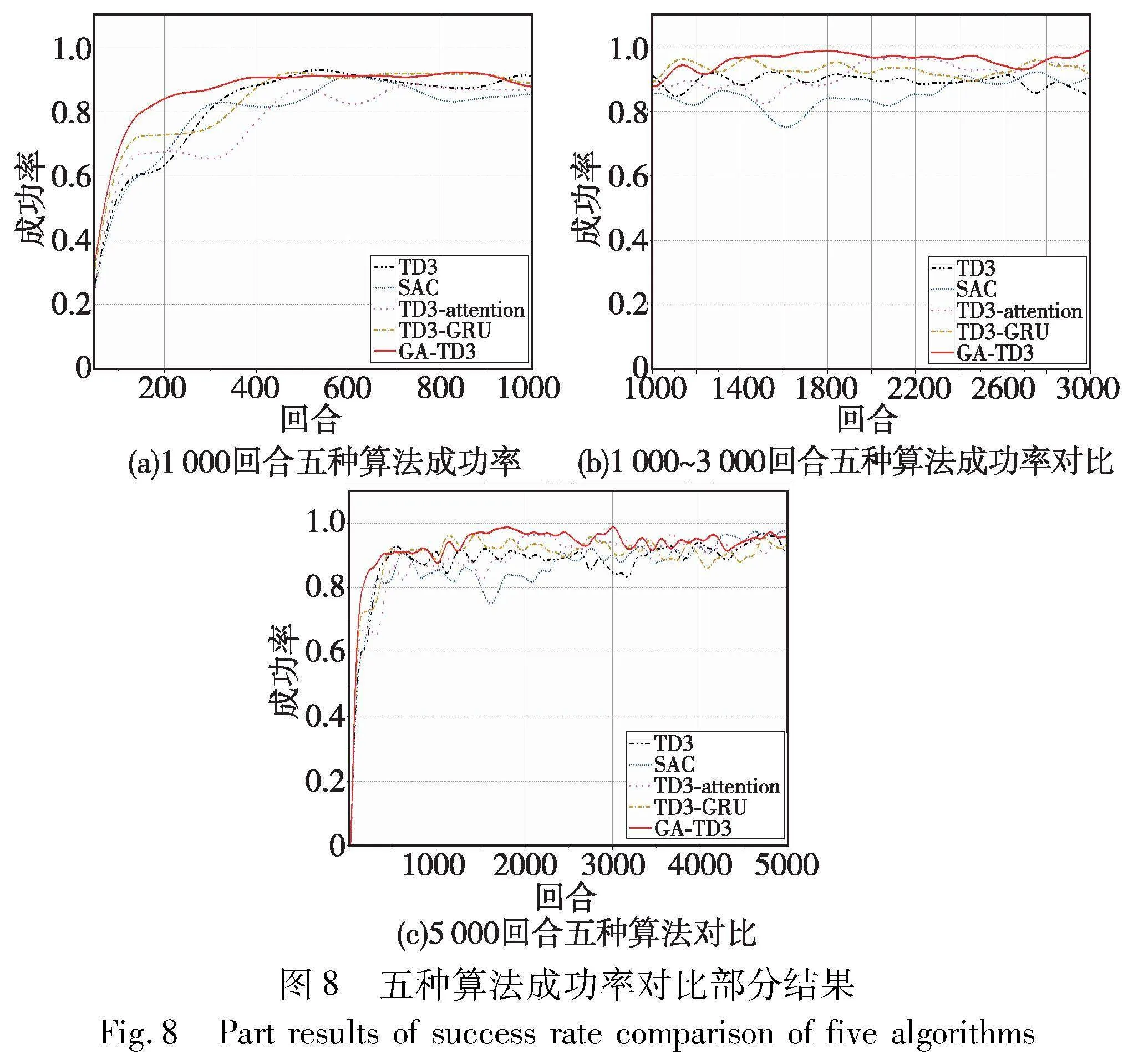

將本文改進后的算法與TD3[24]、SAC[30]、TD3-GRU[31]、TD3-Attention[15]進行實驗對比,詳細結果如圖7~10所示。如圖7所示,GA-TD3模型在訓練初期,自我車輛為了通過路口不停在探索動作,因此決策模型的碰撞率較高,在150回合左右達到峰值后模型學習到了一部分經驗樣本,探索動作相對保守,碰撞率開始下降。由于剛開始訓練的模型處于不停探索的狀態,所以剛開始超時率為0。在訓練了一段時間后,為了保證安全通行,自主車輛等待通行的最佳間隙,在此過程中車輛容易出現等待超時的現象。模型學習到車輛出現盲等狀態,為了增加通行效率,模型增加動作探索。在后續的訓練過程中,模型通過來回的探索等待以此尋找最佳動作,在2 000回合后模型的超時率在一定區間內穩定波動,且模型的碰撞率持續下降,由此可見模型在2 000回合后趨于收斂。

圖8為GA-TD3算法與其他算法的對比局部圖。從圖中可以看出,GRU網絡的記憶功能對模型uNmUZMh3Od9SQl7eaRAOJA==的訓練速度上有一定提升。TD3-GRU與GA-TD3模型訓練前期,相較于TD3模型,引入GRU的模型收斂速度較快,200回合模型已經具有收斂趨勢。GA-TD3在300回合已經處于一個較為平穩的狀態,在訓練了1 000回合后,成功率基本保持在0.92以上,當模型訓練至5 000回合,模型的成功率已經可以達到0.95。TD3-GRU模型的收斂效果與GA-TD3模型較為接近,當模型訓練至2 000回合,模型的成功率在0.9~0.95。TD3-attention模型收斂速度相對于TD3-GRU較慢,在2 000回合后模型的成功率維持在0.9左右。TD3模型的收斂速度與SAC較為接近,相較于引入GRU的TD3模型收斂速度較慢,且成功率相對較低,前5 000回合成功率基本維持在0.9以下。與TD3同一時間段提出的SAC算法相比,SAC在前期的訓練結果最低,由于SAC是隨機探索的策略,前期訓練當作探索的不確定性較大,導致模型收斂相對較慢。綜上,提出模型在收斂速度上優于TD3與SAC兩個模型。

由于GRU網絡與TD3網絡結合得到的TD3-GRU模型結構相較于TD3模型更為復雜,模型在訓練過程中,環境的隨機性會導致模型在訓練期間出現波動。基于注意力機制的深度強化學習決策模型,能夠幫助agent車輛在與社會車輛交互的過程中,查詢篩選出有效的狀態數據,減少了模型對無效動作的探索,提升模型的學習效率和穩定性。獎勵函數設定每次發生碰撞賦予-500的回報,在前期探索過程中,可以看出引入注意力機制的模型獎勵回報平均總值維持在0以上。TD3為確定性策略,在動作探索過程中,對于環境的變換適應性較差,導致獎勵值較長時間處于負值狀態。SAC為隨機探索策略,在探索過程中相較于TD3模型更能適應變換的場景。

如圖10所示,TD3和TD3-GRU模型在模型的穩定性上較差,這是因為環境中的社會車輛始終都是隨機生成的,在模型訓練后期容易出現成功率下降的情況。因此隨機場景中,傳統深度強化學習算法想要在長期訓練過程中維持一個相對穩定的成功率,具有一定的難度。提出基于attention模型的深度強化學習算法會更加關注狀態空間中agent車輛與社會車輛的交互行為,使其關注到更有價值的狀態信息。從獎勵值結果圖中也可以看出,TD3-attention模型和GA-TD3模型在隨機場景下模型的穩定性較優。獎勵值維持在正值,證明agent車輛出現碰撞的概率較低。

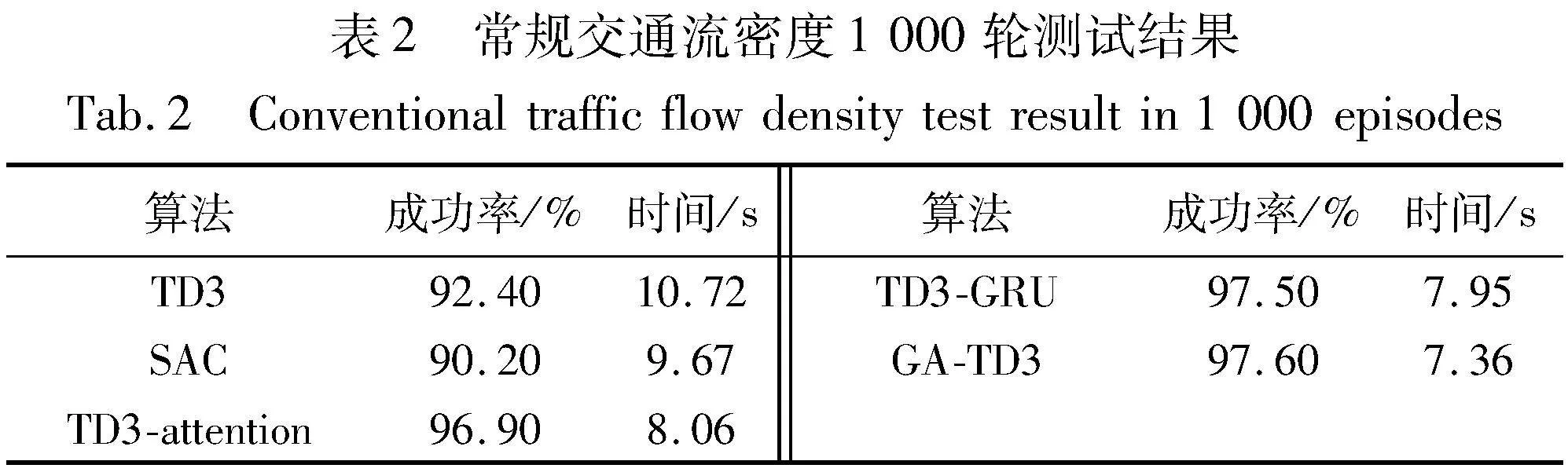

對五組算法模型進行確定性驗證實驗,結果如表2所示。在保證五組模型的社會車輛生成概率和紅綠燈場景保持一致的情況下,對TD3、SAC、TD3-attention、TD3-GRU、以及GA-TD3模型行分別進行1 000回合的驗證性實驗。實驗結果表明GA-TD3無人駕駛決策模型的成功率達到了97.6%,TD3模型的成功率為92.4%,成功率提升了5.2%,車輛通過十字路口的時間縮短了3.36 s;與SAC模型相比,成功率提升了7.4%,通行時間縮短了2.31 s。整體模型的成功率和車輛的通行效率均有提升。

此外,對五組算法還進行了密集交通流的測試。重新設定測試場景,修改社會車輛的生成時間間隔在4~8 s,社會車輛的跟車距離最小保持在3 m。當社會車輛的數量達到8輛的時候,開始生成自我車輛進行驗證測試,五組算法依次進行1 000輪驗證測試,驗證結果如表3所示。從表中可以看出,改進后的模型較為穩定,成功率保持在90%以上,TD3和SAC模型的成功率都有所降低,且同行時間更長,在測試過程中出現了自我車輛等待超時的現象,導致模型的成功率有所降低。注意力機制的模型在密集交通流的場景更加關注社會車輛與自我車輛之間的交互,等待選擇最佳通行間隙,因此通行時間相對于表2的交通流場景等待時間較長。引入GRU的模型由于車流密度的增加,場景的動態性增加,模型更加關注的是車輛到達終點的結果,所以在測試過程前期碰撞率有所增加,導致模型在測試過程中適應性相對不足,成功率有小幅降低,但在通行時間上沒有太大的變化。從整體上看,提出的GA-TD3模型在成功率遠高于TD3模型,通行時間上相對于表2的交通流場景增加了0.63 s,和密集交通流下的TD3-GRU模型的通行時間相對接近,且成功率優于TD3-GRU的模型。

從實驗整體上對比可以看出,提出模型在穩定性和成功率均有所提升。針對交叉路口而言,本文模型下的agent車輛通過交叉路口過程中產生碰撞概率以及agent車輛在路口不通行進入長期等待的概率都會大幅降低,從而提高了車輛通過交叉路口的效率。該方法在城市交叉場景中可以極大提高車輛的通行效率、緩解交通壓力,并增加車輛的安全率,減少交通事故的發生。

4 結束語

本文圍繞復雜場景下的深度強化學習決策模型進行研究,主要針對十字路口無人駕駛車輛左轉匯入目的車道的場景,提出了基于TD3的改進算法GA-TD3。左轉車輛需要與不同路徑的社會車輛在交匯點進行交互,無人駕駛車輛如何在交互過程中作出合理安全的決策行為十分重要。本文算法引入注意力機制使自我車輛和社會車輛進行交互,查詢最有價值的交互車輛,提升模型的成功率以及模型的穩定性。其次將GRU神經網絡融入到TD3的網絡結構中,使模型具備記憶功能,更好地處理有序的數據,加快了模型的收斂速度,增加了模型的成功率。實驗采用CARLA仿真模擬器進行模擬實驗。通過實驗驗證,基于GA-TD3無人駕駛決策模型在訓練至500回合后開始收斂,驗證集的成功率達到了97.6%,相較于TD3算法成功率提升了5.2%,減少了agent車輛與社會車輛碰撞,提升了無人駕駛的安全性能。此外,車輛的通行時間也縮短了3.36 s,大大增加了路口車輛的通行效率,緩解了城市復雜場景下交通壓力。GA-TD3無人駕駛決策模型在成功率和通行效率上都得到了驗證。但該模型在面對車流量更密集的場景還有待改進,下一步將對此問題提出進一步研究。

參考文獻:

[1]Bai Zhengwei, Hao Peng, Shangguan Wei, et al. Hybrid reinforcement learning-basN7eBPA15xr9ZiVgiEYSpxQ==ed ECO-driving strategy for connected and automated vehicles at signalized intersections[J]. IEEE Trans on Intelligent Transportation Systems, 2022, 23(9): 15850-15863.

[2]Schmidt G K, Posch B. A two-layer control scheme for merging of automated vehicles[C]//Proc of the 22nd IEEE Conference on Decision and Control. Piscataway, NJ: IEEE Press, 1983: 495-500.

[3]Rios-Torres J, Malikopoulos A A. Automated and cooperative vehicle merging at highway on-ramps[J]. IEEE Trans on Intelligent Transportation Systems, 2016,18(4): 780-789.

[4]Qu Dayi, Zhang Kekun, Song Hui, et al. Analysis and modeling of lane-changing game strategy for autonomous driving vehicles[J]. IEEE Access, 2022, 10: 69531-69542.

[5]Cheng Wei, Fei Hui, Yang Zijiang, et al. Fine-grained highway autono-mous vehicle lane-changing trajectory prediction based on a heuristic attention-aided encoder-decoder model[J]. Transportation Research Part C: Emerging Technologies, 2022, 140: 103706.

[6]Pei Huaxin, Zhang Jiawei, Zhang Yi, et al. Fault-tolerant cooperative driving at signal-free intersections[J]. IEEE Trans on Intelligent Vehicles, 2022, 8(1): 121-134.

[7]Pei Huaxin, Zhang Jiawei, Zhang Yi, et al. Optimal cooperative dri-ving at signal-free intersections with polynomial-time complexity[J]. IEEE Trans on Intelligent Transportation Systems, 2021, 23(8): 12908-12920.

[8]Yan Qi,Wang Hongfeng. Double-layer Q-learning-based joint decision-making of dual resource-constrained aircraft assembly scheduling and flexible preventive maintenance[J]. IEEE Trans on Aerospace and Electronic Systems, 2022, 58(6): 4938-4952.

[9]Rais M S, Boudour R, Zouaidia K, et al. Decision making for auto-nomous vehicles in highway scenarios using Harmonic SK deep SARSA[J]. Applied Intelligence, 2023, 53(3): 2488-2505.

[10]Lillicrap T P, Hunt J J, Pritzel A, et al. Continuous control with deep reinforcement learning [EB/OL]. (2019-07-05). https://arxiv.org/abs/1509.02971.

[11]Silver D, Huang A, Maddison C J, et al. Mastering the game of Go with deep neural networks and tree search[J]. Nature, 2016, 529(7587): 484-489.

[12]Vinyals O, Babuschkin I, Czarnecki W M, et al. Grandmaster level in StarCraft Ⅱ using multi-agent reinforcement learning[J]. Nature, 2019, 575(7782): 350-354.

[13]Kiran B R, Sobh I, Talpaert V, et al. Deep reinforcement learning for autonomous driving: a survey[J]. IEEE Trans on Intelligent Transportation Systems, 2021,23(6): 4909-4926.

[14]Wu Jingda, Huang Zhiyu, Lyu Chen. Uncertainty-aware model-based reinforcement learning: methodology and application in autonomous driving[J]. IEEE Trans on Intelligent Vehicles, 2022, 8(1): 194-203.

[15]Chen Jianyu, Li S E, Tomizuka M. Interpretable end-to-end urban autonomous driving with latent deep reinforcement learning[J]. IEEE Trans on Intelligent Transportation Systems, 2021,23(6): 5068-5078.

[16]Wang Huanjie,Gao Hongbo,Yuan Shihua,et al. Interpretable decision-making for autonomous vehicles at highway on-ramps with latent space reinforcement learning[J]. IEEE Trans on Vehicular Technology, 2021, 70(9): 8707-8719.

[17]Li Guofa, Yang Yifan, Li Shen, et al. Decision making of autonomous vehicles in lane change scenarios: deep reinforcement learning approaches with risk awareness[J]. Transportation Research Part C: Emerging Technologies, 2022, 134: 103452.

[18]Zhou Mofan, Yu Yang, Qu Xiaobo. Development of an efficient dri-ving strategy for connected and automated vehicles at signalized intersections: a reinforcement learning approach[J]. IEEE Trans on Intelligent Transportation Systems, 2019, 21(1): 433-443.

[19]Wei Lianzhen, Li Zirui, Gong Jianwei, et al. Autonomous driving strategies at intersections: scenarios, state-of-the-art, and future outlooks[C]//Proc of IEEE International Intelligent Transportation Systems Conference. Piscataway, NJ: IEEE Press, 2021: 44-51.

[20]Shu Hong, Liu Teng, Mu Xingyu, et al. Driving tasks transfer using deep reinforcement learning for decision-making of autonomous vehicles in unsignalized intersection[J]. IEEE Trans on Vehicular Technology, 2021, 71(1): 41-52.

[21]吳思凡, 杜煜, 徐世杰, 等. 基于深度確定性策略梯度的智能車匯流模型[J]. 計算機工程, 2020, 46(1): 87-92. (Wu Sifan, Du Yu, Xu Shijie, et al. Traffic merging model for intelligent vehicle based on deep deterministic policy gradient[J]. Computer Engineering, 2020, 46(1): 87-92.)

[22]吳思凡, 杜煜, 徐世杰, 等. 基于長短期記憶-異步優勢動作評判的智能車匯入模型[J]. 汽車技術, 2019, 529(10): 42-47. (Wu Sifan, Du Yu, Xu Shijie, et al. Intelligent vehicle merging model based on long short-term memory and asynchronous advantage actor critic algorithm[J]. Automobile Technology, 2019, 529(10): 42-47.)

[23]Liu Yuqi, Zhang Qichao, Zhao Dongbin. A reinforcement learning benchmark for autonomous driving in intersection scenarios[C]//Proc of IEEE Symposium Series on Computational Intelligence. Pisca-taway, NJ: IEEE Press, 2021: 1-8.

[24]王曙燕, 萬頃田. 自動駕駛車輛在無信號交叉口右轉駕駛決策技術研究[J]. 計算機應用研究, 2023,40(5): 1468-1472. (Wang Shuyan, Wan Qintian. Right-turn driving decisions of autonomous vehicles at signal-free intersections[J]. Application Research of Computers, 2023,40(5): 1468-1472.)

[25]Wu Sifan, Tian Daxin, Zhou Jianshan, et al. Autonomous on-ramp merge strategy using deep reinforcement learning in uncertain highway environment[C]//Proc of IEEE International Conference on Unmanned Systems. Piscataway, NJ: IEEE Press, 2022: 658-663.

[26]Liu Shuijing, Chang Peixin, Liang Weihang, et al. Decentralized structural-RNN for robot crowd navigation with deep reinforcement learning[C]//Proc of IEEE International Conference on Robotics and Automation. Piscataway, NJ: IEEE Press, 2021: 3517-3524.

[27]Ni Tianwei, Eysenbach B, Salakhutdinov R. Recurrent model-free RL can be a strong baseline for many POMDPs[EB/OL]. (2022-06-05). https://arxiv.org/abs/2110.05038.

[28]Mott A, Zoran D, Chrzanowski M, et al. Towards interpretable reinforcement learning using attention augmented agents[EB/OL]. (2019-06-06). https://arxiv.org/abs/1906.02500.

[29]Iqbal S, Sha Fei. Actor-attention-critic for multi-agent reinforcement learning[C]//Proc of International Conference on Machine Learning. [S.l.]: PMLR, 2019: 2961-2970.

[30]Tang Xiaoling, Huang Bing, Liu Teng, et al. Highway decision-making and motion planning for autonomous driving via soft actor-critic[J]. IEEE Trans on Vehicular Technology, 2022, 71(5): 4706-4717.

[31]Ye Junliang, Gharavi H. Deep reinforcement learning assisted beam tracking and data transmission for 5G V2X networks[J]. IEEE Trans on Intelligent Transportation Systems, 2023, 24(9): 9613-9626.