基于多智能體深度強化學習的車聯網可信任務卸載策略

摘 要:針對車聯網中邊緣節點的可信性無法保證的問題,提出了一種基于聲譽的車聯網可信任務卸載模型,用記錄在區塊鏈上的邊緣節點聲譽來評估其可信度,從而幫助終端設備選取可靠的邊緣節點進行任務卸載。同時,將卸載策略建模為聲譽約束下的時延和能耗最小化問題,采用多智能體深度確定性策略梯度算法來求解該NP-hard問題的近似最優解,邊緣服務器依據任務卸載的完成情況獲得獎勵,然后據此更新記錄在區塊鏈上的聲譽。仿真實驗表明,與基準測試方案相比,該算法在時延和能耗方面降低了25.58%~27.44%。

關鍵詞:車聯網; 邊緣計算; 區塊鏈; 深度強化學習; 任務卸載

中圖分類號:TP181 文獻標志碼:A 文章編號:1001-3695(2024)07-007-1971-06

doi:10.19734/j.issn.1001-3695.2023.11.0546

Strategy on trusted task offloading for Internet of Vehicles based onmulti-agent deep reinforcement learning

Abstract:Aiming at the problem that the credibility of edge nodes in the Internet of Vehicles could not be guaranteed, this paper proposed a reputation-based task offloading and resource allocation model for the Internet of Vehicles, and used the reputation of edge nodes recorded on the blockchain to evaluate its credibility, so as to help the terminal devices select reliable edge nodes for task offloading. At the same time, this paper modeled the offloading strategy as the time delay and energy consumption minimization problem under the reputation constraint, and used the multi-agent deep deterministic policy gradient algorithm to solve the approximate optimal solution of the NP-hard problem. The edge server received rewards based on the completion of task offloading, and then updated the reputation recorded on the blockchain. Simulation experiments show that the proposed algorithm reduces in terms of time delay and energy consumption by 25.58% to 27.44% compared with the benchmark testing schemes.

Key words:Internet of Vehicles; edge computing; blockchain; deep reinforcement learning; task offloading

隨著車聯網的快速發展,計算密集型和時延敏感型的服務和應用[1,2]不斷增加,資源受限的終端設備[3]無法滿足用戶日益增長的服務需求[4]。邊緣計算[5]的計算和存儲能力[6]為解決上述問題提供了很好的方向,車輛通過將任務卸載至鄰近的邊緣服務器,完成自身不能實現的任務,同時可以更快地獲得服務響應[7]。與云計算[8]相比,邊緣計算將服務匯聚到核心網絡的邊緣,降低了回程負荷和傳輸鏈路的距離,從而為用戶提供高帶寬、低延遲的網絡服務。

隨著人工智能的發展,研究人員開始嘗試通過機器學習[9]來解決任務卸載問題。對于邊緣計算環境中的任務卸載問題,已有研究[10~14]致力于找到在時延和能耗約束下的最優卸載策略,然而這些研究忽略了邊緣服務器一般在不受信任的環境中運行[15]。終端設備更希望將任務卸載到可靠的邊緣服務器,雖然文獻[16~19]考慮了邊緣服務器的可信性,但是忽略了邊緣服務器進行任務卸載而出現的時延和能耗問題。

本文考慮邊緣服務器的可信問題,提出了一個可信的邊緣計算卸載模型,激勵邊緣服務器參與任務卸載來獲取聲譽,用記錄在區塊鏈上的聲譽評估邊緣服務器的可信度,依據實用拜占庭容錯機制選擇一個邊緣服務器作為服務中心來決策邊緣服務器的卸載行為;將邊緣計算任務卸載問題建模為計算、緩存和通信資源約束下的時延和能耗最小化問題,采用多智能體深度確定性策略梯度(multi-agent deep deterministic policy gradient,MADDPG)算法求解該問題,以達到快速獲得卸載決策的目的。主要貢獻如下:a)采用聲譽機制來激勵邊緣服務器參與任務競爭,提高邊緣服務器的收益,幫助用戶選取可靠的邊緣服務器進行任務卸載;b)綜合考慮時延和能耗,將任務卸載問題轉換為求解目標函數問題,并通過改進的MADDPG算法求解;c)通過仿真實驗驗證了所提出算法的可行性和有效性。

1 相關工作

本文相關工作分為兩個方面:邊緣服務器對用戶的可信性問題以及任務卸載產生的時延和能耗問題。可信度旨在幫助用戶選取可靠的邊緣服務器進行任務卸載。Kong等人[16]提出了一種基于多反饋信任機制的任務卸載策略,以提供可信的運行環境和可靠的服務。Zheng等人[17]提出了一種基于信任度的自適應訪問控制方案,以提供在邊緣計算環境中的自適應和細粒度的屬性訪問控制。為提高服務遷移場景中邊緣節點的可靠性,El Ioini等人[18]研究了一種信任機制,邊緣節點可以基于信任分數來決定將其服務和用戶信息遷移到哪個節點。Zeng等人[19]提出了一種基于信任的多智能體模仿學習方案來改善智能城市邊緣計算的任務卸載,使邊緣服務器能夠高效、準確地獲取設備信任。上述研究雖然考慮了邊緣服務器對用戶的可信性,但是忽略了邊緣服務器在卸載時的時延和能耗問題。

已有學者對邊緣計算環境下的任務卸載問題進行了一些研究。然而,傳統的任務卸載方法如遞歸和動態規劃[20]在滿足終端設備日益提高的服務質量需求方面面臨著巨大的挑戰[21]。因此,Zhao等人[10]開發了一種雙延遲深度確定性策略梯度算法,通過無人機的軌跡、計算任務分配和通信資源管理來解決任務卸載問題,以最小化執行延遲和能量消耗的總和。Kong等人[11]為解決能源成本問題,結合深度確定性策略梯度算法,設計了一種聯合計算和緩存框架。Liu等人[12]提出了一種深度Q網絡和深度確定性策略梯度算法來解決海上無人機群在邊緣計算網絡中的通信和計算的延遲最小化問題。Zhang等人[13]提出了一種基于深度強化學習的動態任務卸載方案,確保多個邊緣服務器能以較低的任務延遲和能耗完成任務卸載和計算。為了減少計算卸載在時變信道條件下的計算復雜性,Chen等人[14]提出了一種基于深度強化學習的博弈學習算法,來提高處理和預測的能力以及時間序列中的延遲。對于邊緣計算環境中的任務卸載問題,上述研究均致力于找到在時延和能耗約束下的最優卸載策略,然而這些研究忽略了邊緣服務器的可信度。針對上述算法的局限性,本文綜合考慮在邊緣服務器可信性、時延和能耗的約束下的任務卸載問題,采用聲譽機制和MADDPG算法來作出卸載決策。

2 系統模型及問題描述

2.1 系統模型

模型主要由云、邊緣服務器和用戶設備組成。邊緣計算層部署了m個邊緣服務器,邊緣服務器相互協作為用戶設備(user devices,U={U1,U2,…,Ui,…,UN})提供服務。設備通過回程鏈路鏈接到邊緣服務器,邊緣服務器則通過高速鏈路訪問云。圖1為模型的分層架構和主要工作流程。

a)用戶和設備層:單個用戶管理多個終端設備,一個終端設備通常負責一項或多項特定的數據收集,然后將收集到的數據移交給位于邊緣計算層的邊緣服務器進行處理。

b)邊緣計算層:依據實用拜占庭容錯機制[22]選出一個邊緣服務器作為服務中心(edge server service center,ESSC),其余邊緣服務器(edge server,ES={ES1,ES2,…,ESm,…,ESM})查看自身空閑的計算和存儲能力來決定是否參與任務競爭。

c)區塊鏈層:依據智能合約[23]來確保ES之間相互信任,存儲用戶、設備、ES以及任務的相關信息,以確保區塊上的信息不可竄改。

d)云層:云服務器負責分析區塊鏈中的信息,判斷ES是否遵循智能合約,遵循智能合約的ES可以查看區塊鏈中的信息。ESSC以分布式方式分配計算、緩存和通信資源,通過MADDPG算法作出卸載決策,從而實現終端設備-邊緣-云之間的資源合作。層與層之間通過數據信息傳輸進行相互協作,以實現模型功能。

2.1.1 聲譽模型

ESSC通過身份驗證機制[23]來驗證用戶身份和用戶車輛信息。ES通過任務卸載獲得收益,采用激勵機制使其收益最大化,并將其收益轉換為聲譽來選取可靠的ES。

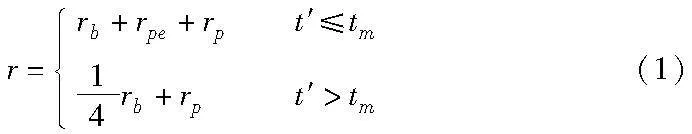

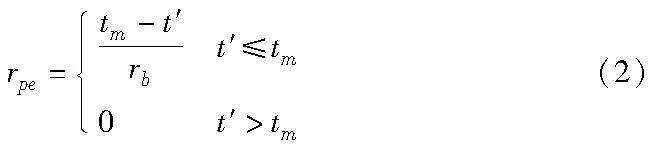

ES通過以下方式獲得獎勵:a)基礎獎勵rb:U支付獎勵使ES完成任務,其值不得超過U本身所擁有的,ES按時完成任務后,將獲得rb;b) 績效獎勵rpe:當任務執行者ETe提前完成任務卸載時,ESSC根據完成時間所給予的獎勵;c)參與者獎勵rp:為鼓勵ES積極參與任務競爭,只要ES成為任務候選者ETc就給予一定的獎勵,該值是固定的,由ESSC獎勵。通過驗證的U發送任務請求和rb,ESSC廣播任務T的信息和rb,rb越高,則ETc就越多。競爭成功的ETc作為ETe獲得的總獎勵為

其中:tm是U允許ETe完成T的最大執行時間,t′是ETe完成T所用的實際時間。依據t′計算rpe:

ETe的表現被記錄在區塊鏈中,以方便進行長期的聲譽評估。ES的基礎聲譽為

rpes=r(3)

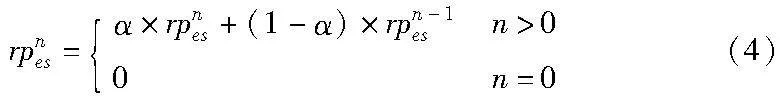

ES只有保持高性能才能獲得高聲譽,其聲譽應根據一段時間內完成多個T的性能來評估,以防止其通過少量T掩蓋過去糟糕的表現。同時,ES不能以不穩定的性能進行任務卸載,以防止其在大量任務中隱藏不當行為。ESSC首先確定用來評估聲譽的任務數量n,如U密度較高的區域,ES需執行更多的任務,即ESSC使用較大的n來防止惡意邊緣服務器快速建立聲譽。由于rpes不依賴ES的評級,所以惡意邊緣服務器無法通過給予高評價來提高聲譽。ES的當前聲譽根據任務卸載的歷史表現評估:

其中:rpnes是ES完成第n個T的聲譽,α∈[0,1]。

如前所述,ES會因性能不穩定而受到懲罰。nes表示ES在n個T中成功完成卸載的任務數量,則ES的最終聲譽為

通過這種方式,低rpes但具有高性能的ES仍可以參與任務競爭。ETe會在完成任務后打包上傳給ESSC,用于聲譽評估和獎勵發放。

2.1.2 時延模型

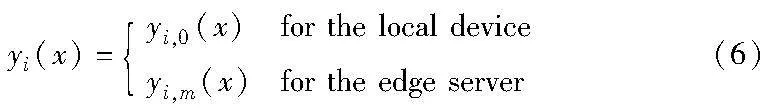

如前所述,ETc的聲譽表明其有能力在tm內完成T。由于一些ETc可能更接近U,可以較低的時延與其通信,所以選擇ETe時還應考慮時延問題。在模型中,每個任務不能再進一步被劃分。Ti既可以在Ui執行,也可以卸載到ES。首先,用yi(x)表示U是否將任務卸載到ES,即

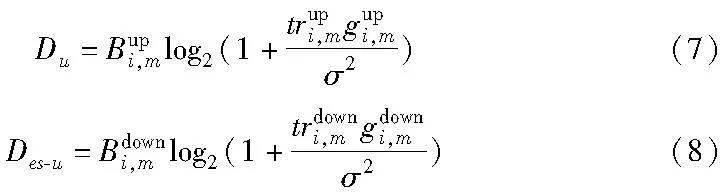

U通過正交頻分多址上傳數據。總可用的頻譜資源Cmsp由ESSC給出,信道數用chm表示,Bm=Cmsp/chm表示每個子信道的帶寬。U在每個時間槽決定是否將Ti卸載給ES。當Ui選擇將Ti卸載到第m個ES(ESm)時,上行和下行數據傳輸速率為

其中:trupi,m和trdowni,m分別表示為Ui和ESm之間的上行和下行傳輸功率,gupi,m和gdowni,m分別表示ESm和Ui之間的上行和下行信道增益,服從均值為0、單位方差為σ2的高斯分布,即為系統噪聲功率;Bupi,m和Bdowni,m分別表示分配給第m個鏈路的上行和下行信道帶寬。每個信道都有兩種狀態,可以表示為fbm(x)∈{0,1},即為{空閑,繁忙}。當信道正在傳輸任務時,該信道將被占用,則狀態由空閑轉變為繁忙。由于鏈路建立時間相對較短,所以這里只考慮數據傳輸時間。

a)本地計算模型。如果Ui根據當前策略yi,0(x)選擇在時隙t局部計算Ti,則Ui的局部計算延遲只與執行Ti所需的計算能力CPiu和周期Ciucpu有關,即

b)任務卸載模型。如果Ui根據當前策略yi,m(x)將Ti卸載到ES,則Ui需要將Ti傳輸給ETe。然后,ETe需要對Ti進行卸載。最后,ETe將結果返回給Ui。

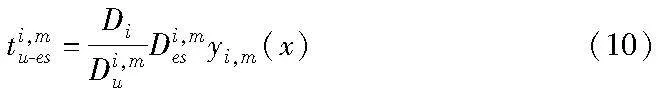

根據以上描述,Ui上傳Ti到ESm所需時間為

其中:Di表示Ti的數據大小,Di,mu表示Ui到ESm的上行數據傳輸速率,Di,mes表示Ui和ESm之間的距離。在此期間,信道處于繁忙狀態,不能被用于傳輸另一個任務。

ESm完成任務卸載的時間為

其中:Cmcpu和CPi,mes分別表示ESm的CPU周期和計算能力。同時,ESm傳輸數據給Ui的時間為

其中:DRi表示ESm完成任務卸載后的數據大小,Di,mes-u表示ESm到Ui的下行數據傳輸速率。

因此,ESm進行任務卸載的時延表示為

模型的總時延為ηi=max{tiu,βi}(14)

2.1.3 能耗模型

選擇ETe關鍵標準還需考慮能耗問題。Ti在Ui執行和任務卸載到ES的能耗分別如下。

a)本地計算模型。每個計算周期的能耗[24]:

b)任務卸載模型。當Ui選擇將任務卸載到ES,能耗產生主要在傳輸階段和執行階段。這里不考慮ES執行任務所造成的能耗。用Pi,mu-es表示ESm和Ui之間的傳輸功率,則ES卸載任務的能耗為

模型的總能耗為

2.2 問題描述

最小化總時延和能耗是一個多目標優化問題,然而在實踐中實現是非常復雜的。為簡化問題,便于理論分析,考慮了一個線性加權目標函數。

其中:δ∈[0,1]表示在時延和能耗方面的權重。

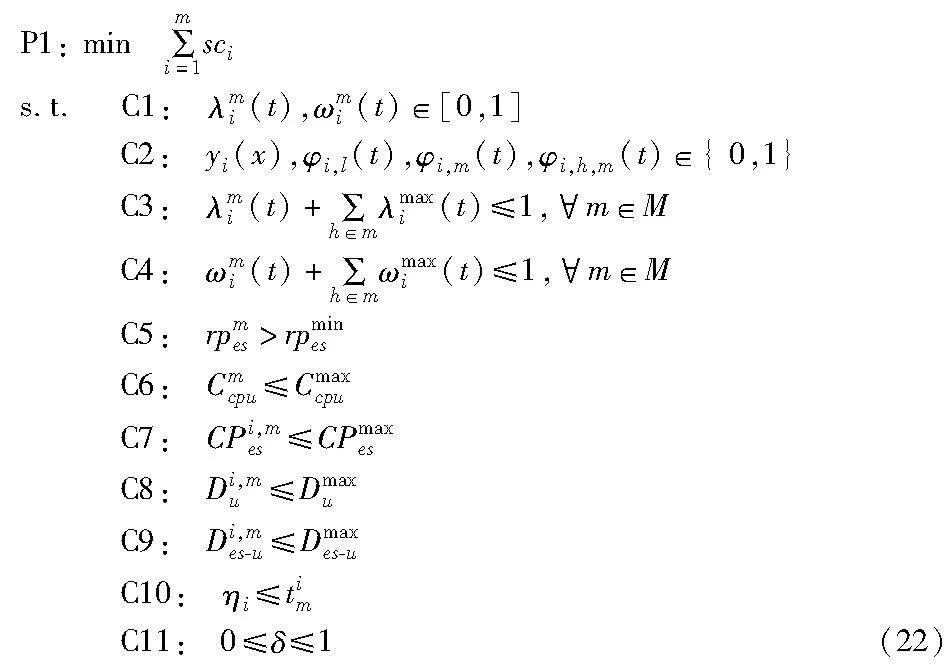

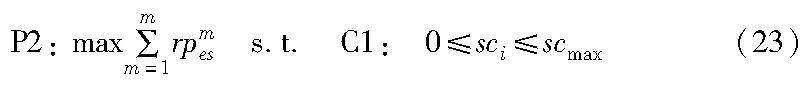

ESSC選擇聲譽最高的ETc成為ETe。若所有ETmc沒有執行過任務,則成本最低的ETmc執行Ti。因此,將目標函數解耦為兩個子問題。第一個優化問題為

其中:約束條件C1表示ES的計算和存儲資源的分配變量。C2表示卸載決策模式。C3和C4表示ES的計算和存儲資源的分配不能超過總資源量。C5表示邊緣服務器參與任務競爭的聲譽要求。C6和C7分別表示CPU周期和ES計算能力不能超過最大值。C8和C9分別表示上行和下行鏈路容量的最大值。C10表示任務卸載時延需要滿足U的時延要求。C11表示時延和能耗的權重約束。第二個優化問題為

其中:C1表示ETe的成本限制,即在滿足[0,scmax]約束條件下,具有聲譽最大值的ETc作為ETe。

3 算法設計

優化問題P1是一個多邊緣服務器合作和競爭問題,其目的是找到成本最優值,從而得到目標聲譽rpmes和目標邊緣服務器ETmc(優化問題P2)。由于上述優化問題是NP-hard問題,傳統的優化方法很難快速解決,所以提出了一種基于多智能體深度強化學習的任務卸載的優化算法。

深度強化學習[25]利用深度神經網絡訓練模型,加快學習速度以實現更好的性能。深度Q網絡(deep Q-network,DQN)算法的建模是基于馬爾可夫決策過程進行的,包括代理即ES、環境、狀態、行動和獎勵元素。具體來說,代理在時隙t處觀察環境以獲得當前狀態,根據當前狀態執行動作,從環境中獲得獎勵,當前狀態轉移為下一個狀態,代理依據新的環境狀態執行動作并獲得獎勵,此循環一直運行到環境的最終狀態。

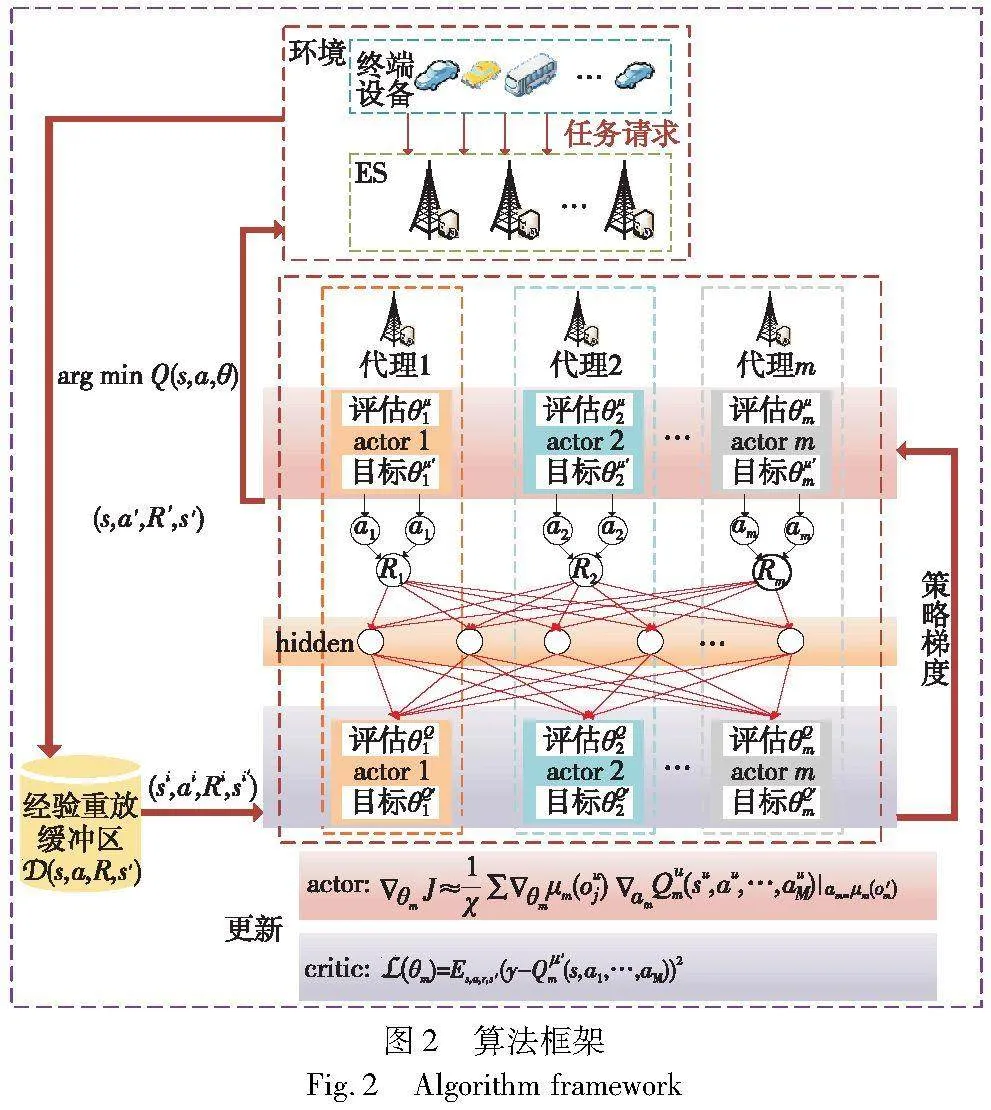

隨著智能體數量的增加,行動者和評論家(actor-critic)算法會出現方差變大的問題。從ES的角度來看,其他ES的策略會迅速升級并保持未知的狀態,使得環境處于非平穩狀態。MADDPG算法在actor-critic算法和深度確定性策略梯度算法的基礎上進行了改進,允許多智能體即ES參與任務競爭,同時每個ES擁有目標網絡和評估網絡,以便通過深度確定性策略梯度獲得卸載策略。actor根據ES的狀態決定動作,critic評估actor的行為,即輸出Q值。目標和評估網絡參數更新記為θμes和θQes,經驗回放緩沖區Euclid Math OneDAp的存在降低了過擬合問題和樣本相關性,更新參數時,評估網絡從Euclid Math OneDAp中隨機獲取樣本。基于MADDPG的主要思想,將P1轉換為馬爾可夫決策來表示任務卸載決策過程。

a)觀察狀態。在每個時間段,ESSC在其覆蓋范圍和當前可用資源下從U收集任務請求,并建立虛擬任務隊列。οtaskt(t)=(T1,m(t),T2,m(t),…,TN,m(t))表示未處理任務的狀態。在時隙t,如果Ui遠離ES的覆蓋范圍,則定義為Ti,m(t)=0。同時,可用頻譜資源表示為ospm(t)=Cm,essp(t),可用計算資源表示為ocom(t)=CPi,mes(t) ,上行和下行的數據傳輸速率為oupm(t)=Di,mu(t)和odownm(t)=Di,mes-u(t),ES上的觀測狀態為οt(t)=(otaskt(t),ospm(t),ocom(t),oupm(t),odownm(t))。由于環境完全是觀測到的,所以觀察結果等價于環境狀態,則一組系統觀測定義為

ο(t)=(o1(t),…,oM(t))(24)

b)動作空間。在時隙t,動作a(t)包含ESSC為Ui選擇的卸載策略。卸載決策變量為φi,l(t),φi,m(t),φi,h,m(t)∈{0,1},其中,φi,l(t)表示Ti(t)在Ui處理,在ES卸載則為φi,m(t),φi,h,m(t)表示ES將Ti(t)移交給另一個ES卸載。λi,m(t)和ωi,m(t)表示為Ti(t)分配的計算和緩存資源,則ES的動作am(t)=(φi,l(t),φi,m(t),φi,h,m(t),λi,m(t),ωi,m(t))為

a(t)=(a1(t),…,aM(t))(25)

c)獎勵函數。為提高ES的處理效率,ESSC將處理效率作為系統獎勵,記為ξm(t)。ζm(t)表示ES未完成卸載的懲罰,則獎勵函數為

Rm(t)=ξm(t)-1/ζm(t)(26)

d)ε-貪婪。在學習階段,從動作空間中隨機選擇一個動作。在訓練階段,從Euclid Math OneDAp選擇值最高的動作。

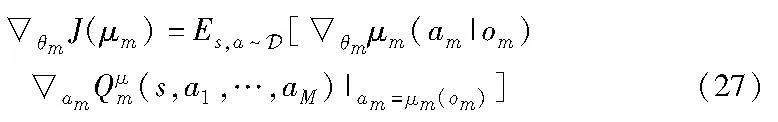

MADDPG算法架構如圖2所示。在訓練狀態下,θ={θ1,…,θm}是m個ES的策略參數集,相應的確定性策略集為μ={μθ1,…,μθm}。每個ES的評估網絡不僅知道其自身代理的變化,還知道其他ES的行動策略。因此,ES的確定性策略梯度可以表示為

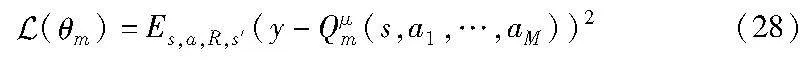

其中:Qμm(s,a1,…,aM)為Q函數,s(t)=ο(t)。此外,critic對目標Q函數的損失函數進行更新:

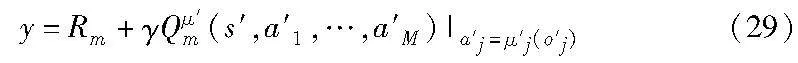

其中:

其中:γ為折扣因子,a′j=μ′j(o′j)表示目標網絡的預測動作。

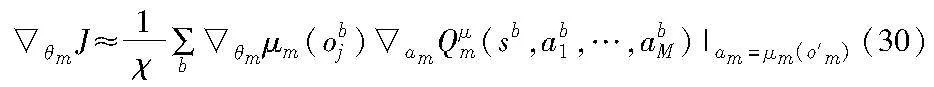

通過ES的最小化策略梯度來更新actor網絡:

其中:b為樣本索引;χ表示小批量樣本。

最后,目標網絡參數更新:

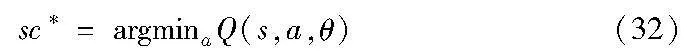

其中:0<τ<1。MADDPG算法的偽代碼如算法1所示。基于上述定義,根據時延和能耗選出成本最低的ES,即

算法1 MADDPG算法

4 仿真與評估

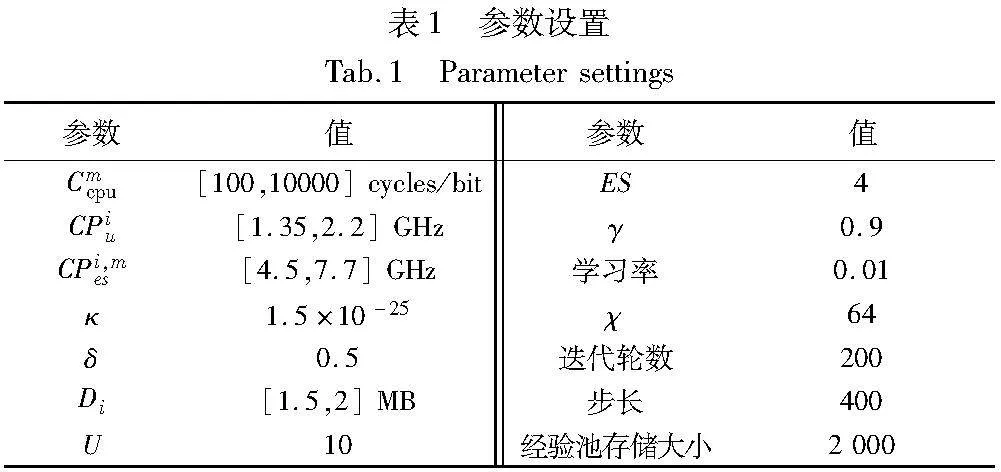

本模型基于Python 3.7實現,實驗中使用的數據集為EUA[26]。該數據集包含了澳大利亞墨爾本中央商務區的基站和終端設備數據,澳大利亞所有的蜂窩基站的地理位置作為邊緣服務器的位置。實驗參數設置如表1所示。在實驗中,將本文模型與以下三種方案比較:

a)local:U執行任務,不傳輸數據到ES進行任務卸載。

b)DDQN算法[27]:主要針對DQN算法[25]的Q值過估計問題,改變目標值的計算方法。

c)D3QN算法[28]:該算法改動了DQN算法的神經網絡的最后一層,并通過狀態值與動作值的和來表示Q值。

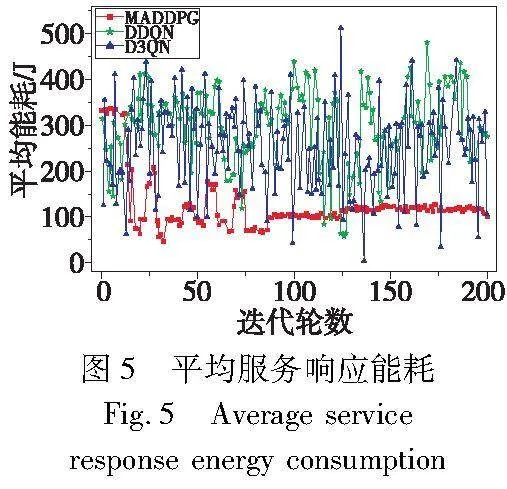

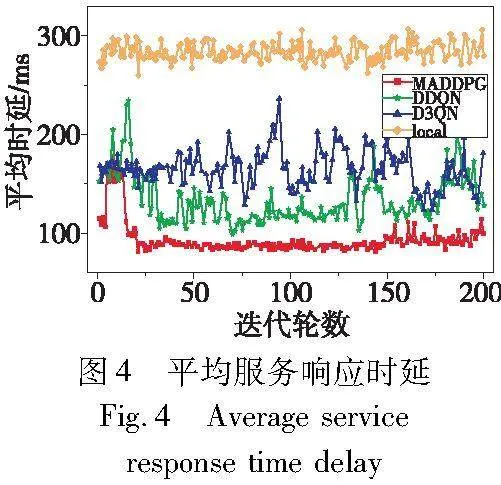

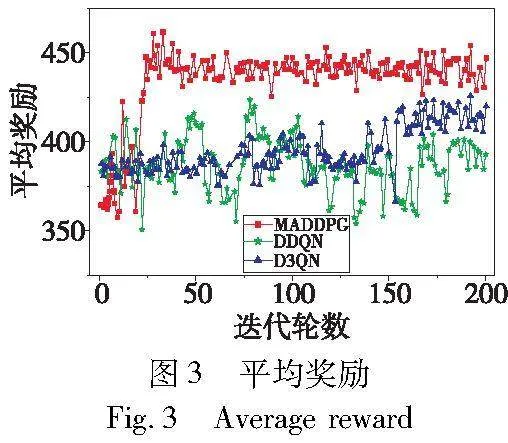

圖3顯示了各算法在平均獎勵(即聲譽)的收斂性能。可以明顯看出,MADDPG算法在前25輪劇烈波動,隨著訓練次數的增加,調整評估和目標網絡參數,逐漸得到近似最優策略和最優策略對應的狀態-動作函數。因此,從25輪開始,就可以獲得相對較高和穩定的獎勵。同時,MADDPG算法的平均獎勵優于DDQN和D3QN算法13.8%~16.1%。圖4和5比較了各算法的平均服務響應時延和能耗,MADDPG算法分別高于其他算法23.77%~62.59%和68.37%~72.98%。原因是該算法中的ES擁有不同的目標和評估網絡,利用ES的特點以實現更好的卸載策略,這驗證了所提出算法的有效性。

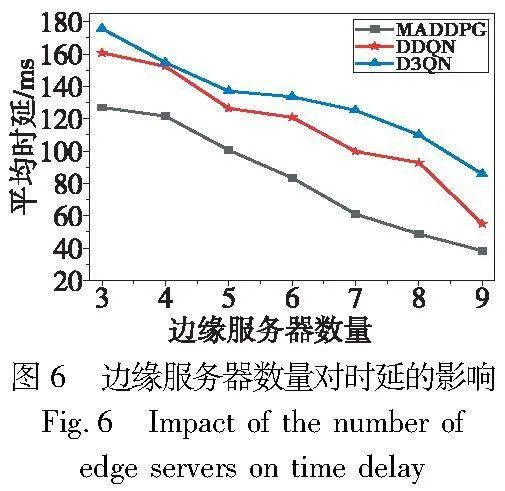

圖6顯示隨著邊緣服務器數量的增加,各算法的服務響應時延逐漸降低。這是因為ES卸載任務的計算和存儲資源增大,使得路由循環和網絡暢通。與其他算法相比,當ES從3增加到9時,MADDPG算法的服務響應時延減少30.31%~55.24%。

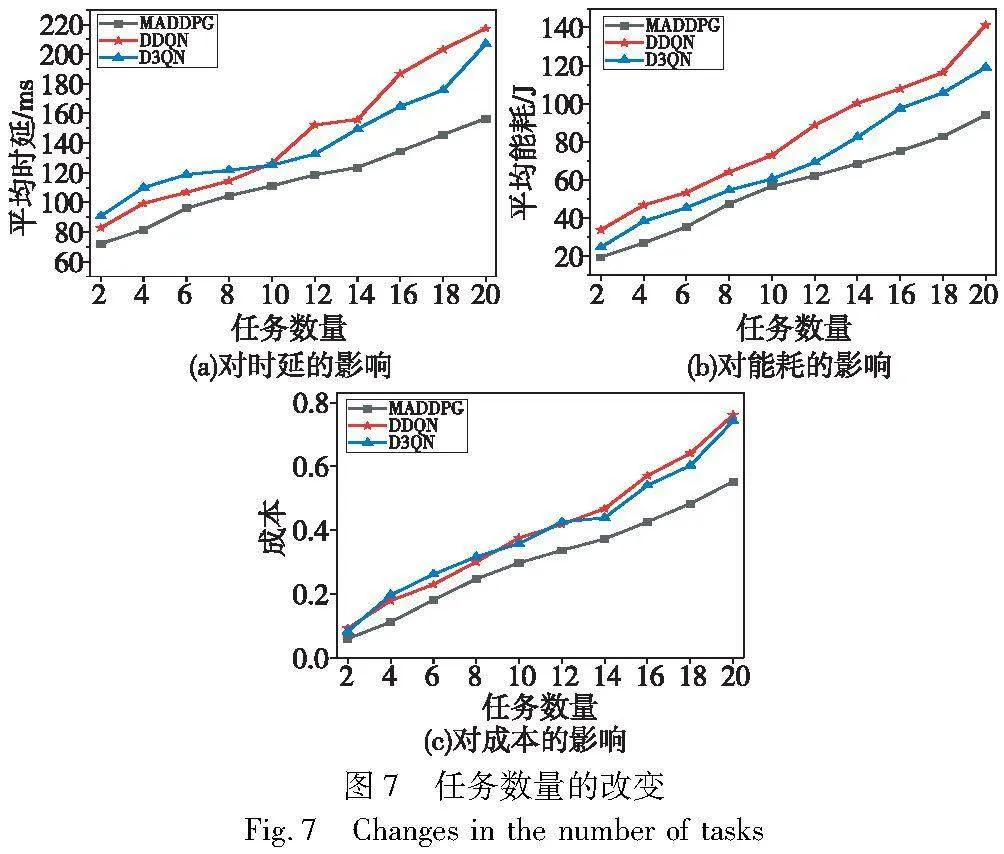

圖7(a)顯示隨著任務請求數量的增加,各算法的平均服務響應時延也在增加。受ES的計算和存儲能力的限制,更多的服務請求意味著ES的工作負載更大,從而造成更大的延遲。該圖表明當請求數量從2增加到20時,MADDPG算法的時延增加了53.96%,而其他算法至少增加了61.85%和56.16%,同時,MADDPG算法的時延增長少于其他算法24.31%~27.93%。圖7(b)表明各算法的平均服務響應能耗隨著請求數量的增加而增大,這是因為模型能耗會隨著卸載負荷的增加而增加。該圖還表明MADDPG算法的能耗優于其他算法33.47%和21.07%。當負載水平增加和網絡變得擁擠時,這種性能的差異會變得顯著。圖7(c)顯示了任務數量對成本的影響。任務請求數量的增加,使得所有策略的處理效率降低。這是因為請求增加會產生更多具有不同需求的任務,以競爭ES有限的計算和存儲資源,導致部分任務無法被處理。由于ES的數量固定,對于延遲更敏感的任務將在本地執行,所以模型處理效率降低,而成本逐漸增加。相比較而言,MADDPG算法性能最好,優于對比算法27.44%和25.58%。

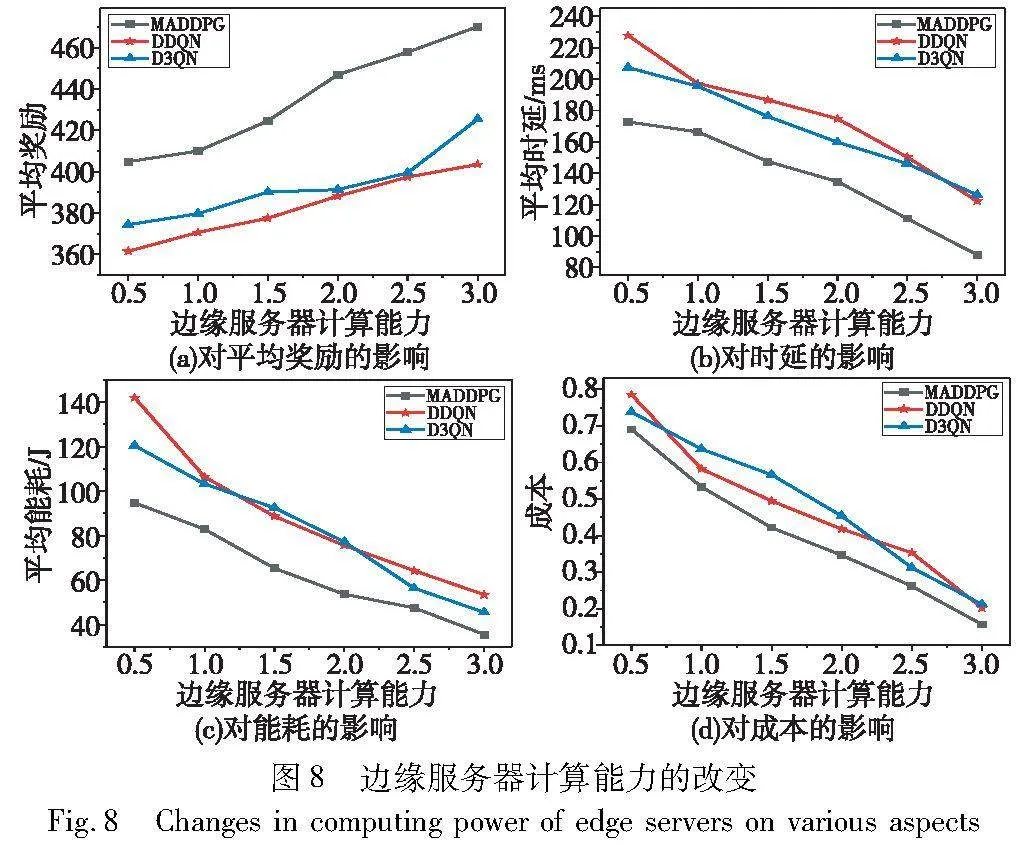

圖8顯示了ES計算能力的影響。如圖8(a)所示,ES計算能力的增加,使得其可執行的任務數量增加,從而得到的平均獎勵增加。當ES的計算能力從0.5增加到3時,MADDPG算法的平均獎勵增加了13.89%,高于其他算法27.79%~55.48%。從圖8(b)可以看出,ES計算能力的增加使得更多的任務被卸載到ES,從而各算法的平均服務響應時延降低。與其他算法相比,MADDPG算法的時延較低,特別是在ES的能力較弱的情況下,其處理時延整體降低了49.04%,少于其他算法5.9%~25.36%。圖8(c)顯示了ES的計算能力對能耗的影響,隨著其計算能力的增加,模型能耗降低,原因如前所述。同時,MADDPG算法的能耗始終低于其他算法21.98%~33.52%。結果表明,該算法可以更快地將任務卸載到ES,從而降低了成本,如圖8(d)所示。

5 結束語

本文研究了在聲譽、時延和能耗的約束下,車聯網環境中的任務卸載問題。為求解優化問題,提出了一種多智能體深度強化學習算法來決策任務卸載方案,幫助終端設備選取可靠的邊緣服務器來卸載任務,同時獎勵完成任務卸載的邊緣服務器。實驗表明,本文算法比其他算法具有更好的性能。

下一步研究是結合聲譽機制來優化本文所使用的共識機制。同時,嘗試本研究是否能在其他場景中使用,如視頻分流。

參考文獻:

[1]Wang Xiaojie, Zhu Hailin, Ning Zhaolong, et al. Blockchain intelligence for Internet of Vehicles: challenges and solutions[J]. IEEE Communications Surveys & Tutorials, 2023,25(4): 2325-2355.

[2]Hossain M S, Kumar L, El Haj Assad M, et al. Advancements and future prospects of electric vehicle technologies: a comprehensive review[J]. Complexity, 2022, 2022: 1-21.

[3]Gismalla M S M, Azmi A I, Salim M R B, et al. Survey on device to device (D2D) communicIi9sNrn0XXbJrV2rhErIpFT18J7yT0CFeQmA8HhVc18=ation for 5GB/6G networks: concept, applications, challenges, and future directions[J]. IEEE Access, 2022, 10: 30792-30821.

[4]Shafiq M, Tian Z, Bashir A K, et al. CorrAUC: a malicious bot-IoT traffic detection method in IoT network using machine-learning techniques[J]. IEEE Internet of Things Journal, 2020, 8(5): 3242-3254.

[5]韋睿, 祝長鴻, 王怡, 等. 基于軟件定義網絡和移動邊緣計算的車聯網高效任務卸載方案[J]. 計算機應用研究, 2023,40(6): 1817-1824. (Wei Rui, Zhu Changhong, Wang Yi, et al. Efficient task offloading scheme of Internet of Vehicles based on software defined network and mobile edge computing[J]. Application Research of Computers, 2023,40(6): 1817-1824.)

[6]Haibeh L A, Yagoub M C E, Jarray A. A survey on mobile edge computing infrastructure: design, resource management, and optimization approaches[J]. IEEE Access, 2022,10: 27591-27610.

[7]Song Shinan, Fang Zhiyi, Jiang Jingyan. Fast-DRD: fast decentra-lized reinforcement distillation for deadline-aware edge computing[J]. Information Processing & Management, 2022,59(2): 102850.

[8]呂書玉, 馬中, 戴新發, 等. 云控制系統研究現狀綜述[J]. 計算機應用研究, 2021, 38(5): 1287-1293. (Lyu Shuyu, Ma Zhong, Dai Xinfa, et al. Survey on cloud control systems[J]. Application Research of Computers, 2021,38(5): 1287-1293.)

[9]Hua Haochen, Li Yutong, Wang Tonghe, et al. Edge computing with artificial intelligence: a machine learning perspective[J]. ACM Computing Surveys, 2023,55(9): 1-35.

[10]Zhao Nan, Ye Zhiyang, Pei Yiyang, et al. Multi-agent deep reinforcement learning for task offloading in UAV-assisted mobile edge computing[J]. IEEE Trans on Wireless Communications, 2022,21(9): 6949-6960.

[11]Kong Xiangjie, Duan Gaohui, Hou Mingliang, et al. Deep reinforcement learning-based energy-efficient edge computing for Internet of Vehicles[J]. IEEE Trans on Industrial Informatics, 2022,18(9): 6308-6316.

[12]Liu Ying,Yan Junjie,Zhao Xiaohui. Deep reinforcement learning based latency minimization for mobile edge computing with virtualization in maritime UAV communication network[J]. IEEE Trans on Vehicular Technology, 2022,71(4): 4225-4236.

[13]Zhang Degan, Cao Lixiang, Zhu Haoli, et al. Task offloading method of edge computing in Internet of Vehicles based on deep reinforcement learning[J]. Cluster Computing, 2022,25(2): 1175-1187.

[14]Chen Miaojiang, Liu Wei, Wang Tian, et al. A game-based deep reinforcement learning approach for energy-efficient computation in MEC systems[J]. Knowledge-Based Systems, 2022, 235: 107660.

[15]Alsenani Y, Alnori A. Trust-aware scheduling for edge computing with task dependencies and unreliable servers[J]. IEEE Access, 2023, 11: 113514-113525.

[16]Kong Wenping, Li Xiaoyong, Hou Liyang, et al. A reliable and efficient task offloading strategy based on multifeedback trust mechanism for IoT edge computing[J]. IEEE Internet of Things Journal, 2022, 9(15): 13927-13941.

[17]Zheng Wenying, Chen Bing, He Debiao. An adaptive access control scheme based on trust degrees for edge computing[J]. Computer Standards & Interfaces, 2022, 82: 103640.

[18]El Ioini N, Barzegar H R, Pahl C. Trust management for service migration in multi-access edge computing environments[J]. Computer Communications, 2022, 194: 167-179.

[19]Zeng Pengjie, Liu Anfeng, Zhu Chunsheng, et al. Trust-based multi-agent imitation learning for green edge computing in smart cities[J]. IEEE Trans on Green Communications and Networking, 2022,6(3): 1635-1648.

[20]Pelle I, Szalay M, Czentye J, et al. Cost and latency optimized edge computing platform[J]. Electronics, 2022, 11(4): 561.

[21]Maray M, Shuja J. Computation offloading in mobile cloud computing and mobile edge computing: survey, taxonomy, and open issues[J]. Mobile Information Systems, 2022, 2022: article ID 1121822.

[22]Yang Jian, Jia Zhenhong, Su Ruiguo, et al. Improved fault-tolerant consensus based on the PBFT algorithm[J]. IEEE Access, 2022,10: 30274-30283.

[23]Zukarnain Z A, Muneer A, Ab Aziz M K. Authentication securing methods for mobile identity: issues, solutions and challenges[J]. Symmetry, 2022,14(4): 821.

[24]Zhu Anqing, Wen Youyun. Computing offloading strategy using improved genetic algorithm in mobile edge computing system[J]. Journal of Grid Computing, 2021,19(3): 38.

[25]Ladosz P, Weng L, Kim M, et al. Exploration in deep reinforcement learning: a survey[J]. Information Fusion, 2022, 85: 1-22.

[26]Lai P, He Qiang, Abdelrazek M, et al. Optimal edge user allocation in edge computing with variable sized vector bin packing[C]//Proc of the 16th International Conference on Service-Oriented Computing. Berlin: Springer, 2018: 230-245.

[27]Chraibi A, Ben A S, Touhafi A, et al. A novel dynamic multi-objective task scheduling optimization based on dueling DQN and PER[J]. The Journal of Supercomputing, 2023, 79: 21368-21423.

[28]Kwantwi T, Sun G, Kuadey N A E, et al. Blockchain-based computing resource trading in autonomous multi-access edge network slicing: a dueling double deep Q-learning approach[J]. IEEE Trans on Network and Service Management, 2023,20(3): 2912-2928.