MSs-MEC中基于DRL的服務(wù)緩存和任務(wù)遷移聯(lián)合優(yōu)化算法

摘 要:多服務(wù)移動邊緣計算(multiple-services mobile edge computing,MSs-MEC)能根據(jù)需求自適應(yīng)調(diào)整服務(wù)緩存決策,使得部署在用戶側(cè)的邊緣服務(wù)器能夠靈活處理不同服務(wù)類型的任務(wù)。但在實際應(yīng)用中,特定類型任務(wù)的成功遷移依賴于服務(wù)環(huán)境的提前安裝。此外,同時進行任務(wù)遷移和服務(wù)緩存可能會因時間沖突而導(dǎo)致計算延時。因此,針對上述相關(guān)問題,首先將任務(wù)遷移和服務(wù)緩存決策進行解耦,針對深度強化學(xué)習(xí)(deep reinforcement learning,DRL)在具有高維的混合決策空間的性能提升不明顯的缺點(例如資源分配時利用率不高),將DRL與Transformer結(jié)合,通過在歷史數(shù)據(jù)中學(xué)習(xí),輸出當(dāng)前時隙的任務(wù)遷移決策和下一時隙的任務(wù)決策,保證任務(wù)到達邊緣服務(wù)器時能立即執(zhí)行。其次,為了提高資源分配問題中的資源利用率,將問題分解為連續(xù)資源分配問題和離散的任務(wù)遷移與服務(wù)緩存問題,利用凸優(yōu)化技術(shù)求解資源分配最優(yōu)決策。廣泛的數(shù)值結(jié)果表明,與其他基線算法相比,提出的算法能有效地減少任務(wù)的平均完成時延,同時在資源利用率和穩(wěn)定性方面也有優(yōu)異的表現(xiàn)。

關(guān)鍵詞:多服務(wù)移動邊緣計算;凸優(yōu)化;服務(wù)緩存;任務(wù)遷移;資源分配算法

中圖分類號:TP393 文獻標志碼:A 文章編號:1001-3695(2024)07-034-2165-08

doi: 10.19734/j.issn.1001-3695.2023.10.0538

DRL-based joint optimization algorithm for service caching and task migration in multi-services mobile edge computing

Abstract: MSs-MEC can adaptively adjust service cache decisions according to needs, so that edge servers deploys on the user side can flexibly handle tasks of different service types. However, in practical applications, the successful migration of specific types of tasks depends on the early installation of the service environment. In addition, simultaneous task migration and service caching may result in time conflicts and computation delays. Therefore, in response to the above issues, this paper firstly decoupled task migration and service caching decisions. To address the shortcomings of DRL in high-dimensional mixed decision spaces, where performance improvement was not significant(such as low utilization rate during resource allocation), it combined DRL with Transformer to learn from historical data and output task migration decisions for the current time slot and the next time slot, ensuring that tasks could be executed immediately when they reached the edge server. Secondly, in order to improve resource utilization in resource allocation problems, it decomposed the problem into continuous resource allocation problems and discreted task migration and service caching problems, and used convex optimization technique to solve the optimal decision for resource allocation. Extensive numerical results indicate that the proposed algorithm can effectively reduce the average completion delay of tasks compared to other baseline algorithms, at the same time, it also has excellent performance in resource utilization and stability.

Key words:MSs-MEC; convex optimization; service cache; task migration; resource allocation algorithm

0 引言

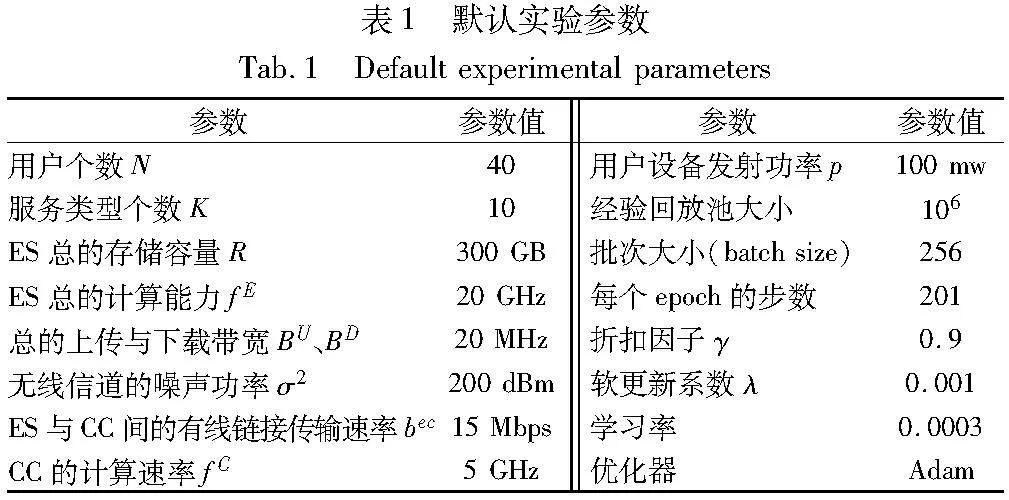

當(dāng)前,任務(wù)遷移和資源分配是MEC的主要研究熱點。一方面,任務(wù)遷移能夠解決算力不足的問題;另一方面,任務(wù)遷移過程產(chǎn)生的時延和能耗以及資源分配方案等對系統(tǒng)性能有重要影響。更進一步,隨著5G技術(shù)在各種應(yīng)用場景中的深入發(fā)展,持續(xù)增加的大量不同服務(wù)類型的任務(wù)處理需求給邊緣網(wǎng)絡(luò)帶來了巨大的壓力[1]。為了充分利用邊緣服務(wù)器(edge ser-ver,ES)的可用資源,提高系統(tǒng)性能,業(yè)界提出了服務(wù)緩存機制,即在ES中預(yù)先緩存與任務(wù)相關(guān)的代碼或服務(wù),使ES能夠處理對應(yīng)類型的任務(wù)。但是,MEC中的服務(wù)需求和受歡迎程度是隨時間變化的,一個確定的服務(wù)緩存決策方案并不總能改善和提高系統(tǒng)性能。同時,任務(wù)遷移和服務(wù)緩存的決定是必須相互耦合的。例如,一個對象檢測應(yīng)用程序需要在處理檢測任務(wù)之前在ES中安裝相關(guān)的模型。只有通過緩存常用的服務(wù)并遷移與這些服務(wù)相關(guān)的任務(wù),才能提高系統(tǒng)性能。因此,如何在資源有限的ES中選擇所有服務(wù)類型的最佳子集進行緩存,并確定具有相同服務(wù)類型的任務(wù)是在ES還是在云中心(cloud center,CC)上執(zhí)行,以最大限度地提高整個系統(tǒng)的性能,是一個具有重要研究意義的問題。

多服務(wù)移動邊緣計算(multiple-services mobile edge computing,MSs-MEC)是一種新型的MEC網(wǎng)絡(luò)環(huán)境,它將MEC和服務(wù)緩存相結(jié)合,能自適應(yīng)地調(diào)整每個時隙的服務(wù)緩存決策,使得部署在用戶側(cè)的ES能夠靈活處理屬于不同服務(wù)類型的任務(wù),從而為用戶提供更好的服務(wù)質(zhì)量。MSs-MEC已被廣泛應(yīng)用于多種場景,如虛擬現(xiàn)實、模式識別和車聯(lián)網(wǎng)等[2]。

在實際應(yīng)用中,特定類型任務(wù)的成功遷移依賴于服務(wù)環(huán)境的提前安裝。此外,同時進行任務(wù)遷移和服務(wù)緩存可能會因時間沖突而導(dǎo)致計算延時。因此,針對上述問題,本文考慮一個支持MSs-MEC的云邊協(xié)同系統(tǒng),用戶根據(jù)自己的偏好動態(tài)地生成屬于不同類型服務(wù)的獨立任務(wù),ES必須緩存對應(yīng)類型的服務(wù)才能執(zhí)行此類型任務(wù),否則ES會將該類型任務(wù)路由到遠程CC執(zhí)行。本文主要通過對帶寬資源、計算資源分配以及任務(wù)遷移和緩存決策的聯(lián)合優(yōu)化來最小化任務(wù)平均完成時延,最大化支持多服務(wù)移動邊緣計算系統(tǒng)的資源利用率,從而優(yōu)化MEC系統(tǒng)性能。

1 相關(guān)研究工作

MEC的主要目標是通過將所需資源放置在網(wǎng)絡(luò)邊緣,從而緩解云計算存在的高時延、低性能缺陷。近年來,國內(nèi)外學(xué)者針對該領(lǐng)域相關(guān)課題,如計算遷移、服務(wù)緩存以及基于深度強化學(xué)習(xí)在該領(lǐng)域的運用等方面進行了大量的研究工作。

作為MEC領(lǐng)域最重要的部分,計算遷移使得任務(wù)能夠被遷移到ES上執(zhí)行,從而優(yōu)化性能。例如,文獻[3]研究了云邊協(xié)作車輛網(wǎng)絡(luò)中計算遷移和資源分配的聯(lián)合優(yōu)化。文獻[4]提出一個能量收集時間、本地計算頻率、遷移時間和功率聯(lián)合優(yōu)化模型,以最大限度地提高無線供電的MEC網(wǎng)絡(luò)的計算效率。考慮到車載MEC的動態(tài)網(wǎng)絡(luò)環(huán)境,文獻[5]提出一個多用戶非合作博弈的計算遷移模型,通過調(diào)整網(wǎng)絡(luò)中每輛車的遷移概率,構(gòu)建分布式最佳響應(yīng)算法來最大化每輛車的效用。與全部任務(wù)遷移模式相比,部分計算遷移也是處理計算密集型或時延敏感型應(yīng)用的一種有前景策略。例如,文獻[6]在支持MEC的物聯(lián)網(wǎng)中提出一個合作性的部分計算遷移方案,其中將云遷移作為備選方案。此外,文獻[7]為MEC中的多用戶開發(fā)了一種基于博弈論的部分計算遷移策略以減少計算開銷。文獻[8]在資源受限的移動邊緣計算模型中考慮資源分配和計費問題,并使用一種基于拍賣的分配機制來獲取最優(yōu)解。文獻[9]在多MEC服務(wù)器的物聯(lián)網(wǎng)環(huán)境中,考慮物聯(lián)網(wǎng)系統(tǒng)的能源效率和服務(wù)時延之間的權(quán)衡,提出了一種基于李雅普諾夫優(yōu)化的在線卸載和資源分配算法,用于生成任務(wù)卸載方案。文獻[10]研究以認知無人機作為中繼節(jié)點的MEC模型,通過聯(lián)合優(yōu)化用戶的傳輸功率,制定了以最小化用戶處理時延為目標的優(yōu)化問題。為了提高基于區(qū)塊鏈的移動邊緣計算系統(tǒng)中的任務(wù)處理速度和交易吞吐量,F(xiàn)eng等人[11]設(shè)計一個基于深度強化學(xué)習(xí)的協(xié)同計算遷移和資源分配框架,聯(lián)合優(yōu)化遷移決策、功率分配、塊大小和塊間隔。總的來說,多數(shù)研究都默認ES能處理所有類型任務(wù),但實際中不同用戶生成的任務(wù)類型可能不同,而ES的存儲空間有限,并不能將所有的類型服務(wù)緩存。因此,在ES資源受限的情況下,如何高效地遷移任務(wù)、優(yōu)化MEC系統(tǒng)性能仍然值得進一步研究。

作為MEC的另一個優(yōu)化主題,服務(wù)緩存是指將所需的應(yīng)用服務(wù)提前存儲在邊緣服務(wù)器中,從而在任務(wù)遷移過程中為用戶提供更好的服務(wù)體驗。例如,文獻[12]提出一種在線算法,其目標是確定最佳的服務(wù)緩存集和任務(wù)遷移目的地,以最大限度地提高邊緣計算性能。為了縮短用戶請求的響應(yīng)時間,文獻[13]提出一種針對在線請求服務(wù)場景的分布式云邊緣協(xié)作緩存機制。文獻[14]為可分割的任務(wù)設(shè)計智能的聯(lián)合緩存和遷移策略。為了在具有異構(gòu)任務(wù)請求、應(yīng)用數(shù)據(jù)預(yù)存儲和基站協(xié)調(diào)的MEC系統(tǒng)中共同優(yōu)化計算遷移、服務(wù)緩存和資源分配,文獻[15]提出一種服務(wù)緩存和計算遷移協(xié)同算法,以最小化平均任務(wù)執(zhí)行時間。類似地,文獻[16]提出一種基于半有限松弛方法和交替優(yōu)化的近似算法,以最小化所有用戶的整體計算和時延成本。然而,上述方法很少研究服務(wù)緩存和計算遷移決策之間的時間關(guān)系,由于緩存決策是遷移的前提條件,如何協(xié)調(diào)計算兩個時隙之間的緩存和遷移決策是一個困難且關(guān)鍵的問題。

另外,在機器學(xué)習(xí)發(fā)展的推動下,DRL已被廣泛地應(yīng)用于各種領(lǐng)域。因此,采用DRL來解決MEC中的優(yōu)化問題也是很有前景的。例如,文獻[17]提出基于分布式DRL的算法,在不斷變化的多無人駕駛飛行器MEC環(huán)境中有效地調(diào)整計算遷移策略。文獻[18]提出基于DRL的在線遷移框架,以優(yōu)化適應(yīng)無線供電MEC網(wǎng)絡(luò)中的任務(wù)遷移決策和無線資源分配。文獻[19]提出一種在高動態(tài)的車輛環(huán)境中聯(lián)合確定車輛間部分計算遷移目的地和計算資源分配方案。為了給車輛提供高質(zhì)量、低時延、低比特率差異的直播服務(wù),文獻[20]利用軟演員批判DRL算法進行車輛調(diào)度、比特率選擇、計算和頻譜資源分配的聯(lián)合優(yōu)化。此外,文獻[21]提出一種基于DRL、Transformer和模型的優(yōu)化整合方案,以解決端到端傳輸問題,并聯(lián)合進行連續(xù)功率分配和離散比特率適應(yīng)。文獻[22]對比了傳統(tǒng)的Q學(xué)習(xí)和深度Q網(wǎng)絡(luò)(deep Q network,DQN)算法在求解任務(wù)卸載調(diào)度問題上的性能差異。然而此類方案沒有考慮分布式架構(gòu),降低了魯棒性的同時增大了訓(xùn)練難度。盡管上述工作表明,DRL算法是處理MEC中動態(tài)決策問題的有效方法,但在提高資源利用率方面卻略顯不足。

總的來說,具有服務(wù)緩存的任務(wù)遷移問題在相關(guān)文獻中得到了廣泛的研究,但是大多是基于傳統(tǒng)優(yōu)化方法來提出解決方案,沒有考慮到遷移任務(wù)生成的動態(tài)性,也不能從系統(tǒng)角度對MEC進行優(yōu)化。文獻[23]提出一種基于軟演員-評論家(soft actor-critic,SAC)的深度強化學(xué)習(xí)算法來同時確定服務(wù)緩存和任務(wù)卸載的離散決策以及上下帶寬和計算資源的連續(xù)分配決策。在此基礎(chǔ)上,本文將任務(wù)遷移和服務(wù)緩存決策進行解耦,針對DRL在具有高維的混合決策空間的資源分配時利用率不高的缺點,將DRL與Transformer結(jié)合,通過在歷史數(shù)據(jù)中學(xué)習(xí),輸出當(dāng)前時隙的任務(wù)遷移決策和下一時隙的任務(wù)決策,保證任務(wù)到達邊緣服務(wù)器時能立即執(zhí)行。其次,為了提高資源分配問題中的資源利用率,將問題分解為連續(xù)資源分配問題和離散的任務(wù)遷移與服務(wù)緩存問題,利用凸優(yōu)化技術(shù)求解資源分配最優(yōu)決策。因此,本文通過對帶寬資源、計算資源分配以及任務(wù)遷移和緩存決策進行聯(lián)合優(yōu)化來最小化任務(wù)平均完成時延,最大化支持多服務(wù)移動邊緣計算系統(tǒng)的資源利用率,從而優(yōu)化MEC系統(tǒng)性能。

2 系統(tǒng)模型及問題定義

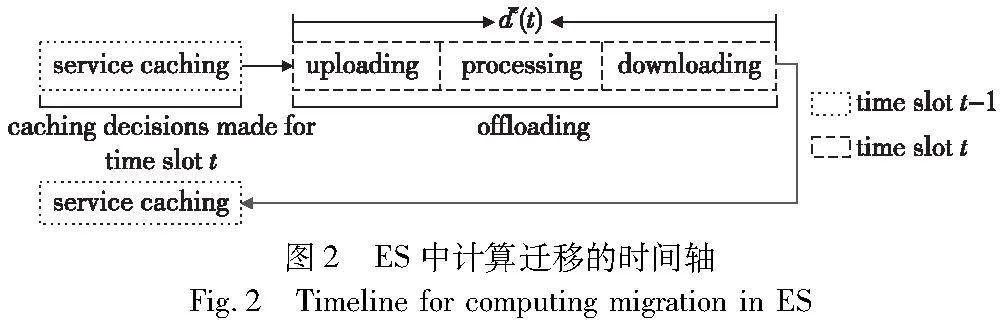

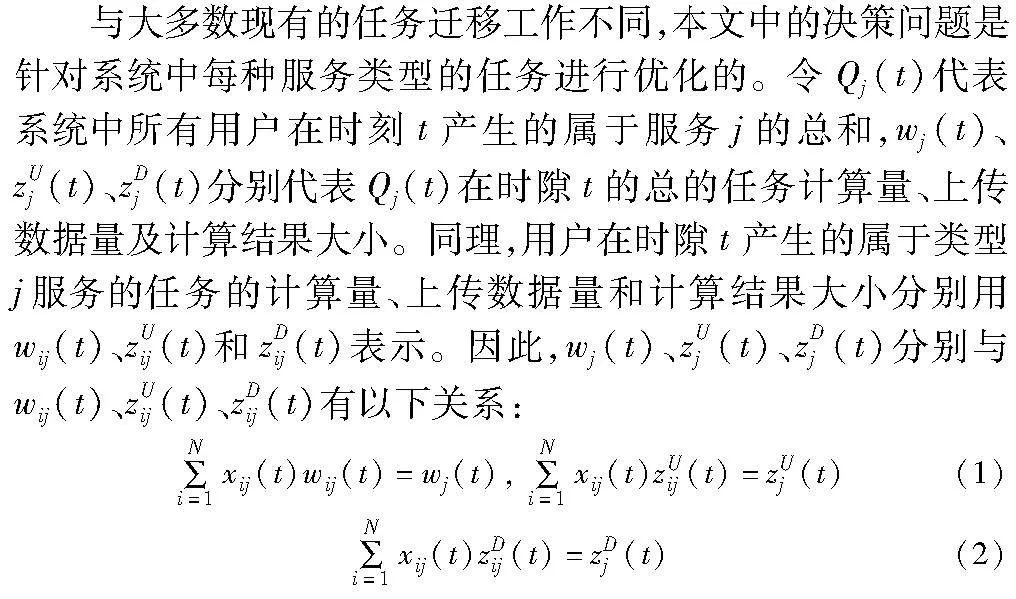

ES中計算遷移的時間軸如圖2所示。由于ES的存儲和計算能力有限,CC被視為協(xié)作遷移目的地,從而確保成功執(zhí)行任務(wù)。

由于ES的存儲和計算能力不足,只能在ES上緩存服務(wù)的某個子集,所以必須根據(jù)不斷變化的環(huán)境決定服務(wù)緩存決策。令二進制決策aj(t)∈{0,1}表示服務(wù)j的緩存決定,aj(t)=1表示緩存服務(wù)j到ES中,否則aj(t)=0。在時隙t中,假設(shè)ES的總緩存空間為R,安裝服務(wù)j所占用的空間是rj,則存儲容量需要滿足約束:

2.1 傳輸模型

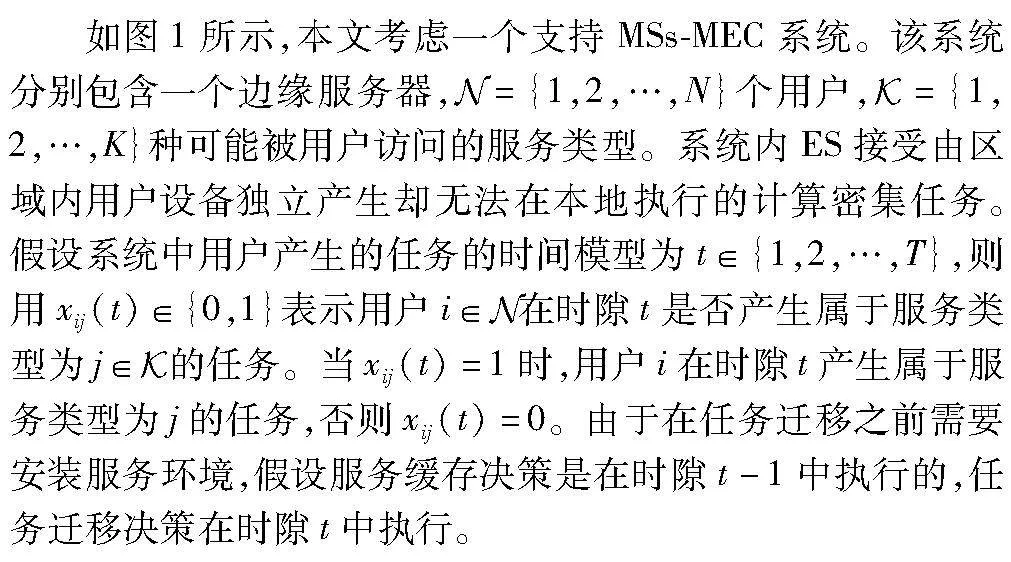

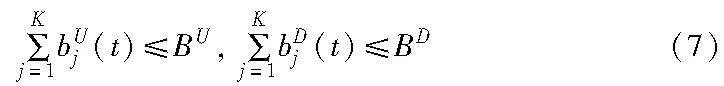

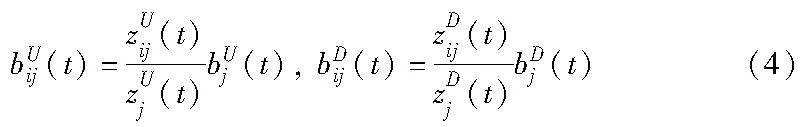

由于用戶設(shè)備計算存儲能力欠缺,任務(wù)必須先被傳輸?shù)紼S或CC才能被執(zhí)行。所以,任務(wù)Qj(t)在每個時隙獲得的帶寬大小對其傳輸時延有重要影響。用bUij(t)、bDij(t)分別表示當(dāng)xij(t)=1時用戶被分配到的用于上傳數(shù)據(jù)與下載結(jié)果的帶寬大小。同理,bUj(t)、bDj(t)分別表示分配給任務(wù)Qj(t)的上傳數(shù)據(jù)與下載結(jié)果的帶寬大小。則bUij(t)、bDij(t)與bUj(t)、bDj(t)的關(guān)系可分別表示為

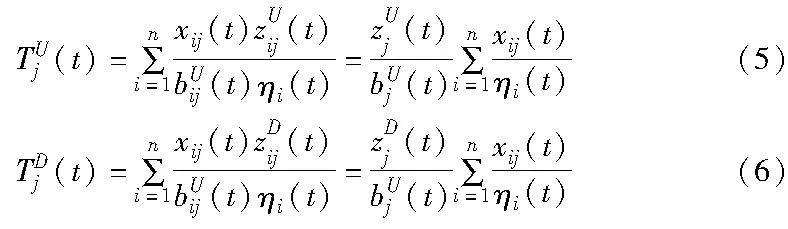

令TUj(t)和TDj(t)分別表示任務(wù)Qj(t)在無線信道上傳輸入數(shù)據(jù)和下載處理結(jié)果的時間成本。為了簡單起見,忽略任務(wù)到達的排隊時延,并假設(shè)每個用戶設(shè)備根據(jù)自己的信道條件向ES傳輸任務(wù),所以,任務(wù)上傳和結(jié)果下載的時延分別表示為

其中:ηi(t)是用戶i的無線頻譜效率,用log2(1+phi(t)/σ2)表示,p是用戶設(shè)備的發(fā)射功率,hi(t)是用戶i在時隙t的無線通道增益,可近似為128.1+37.6lg d,而σ2是無線信道的噪聲功率。令BU和BD分別表示系統(tǒng)中總上傳和下載的帶寬容量,因此,帶寬分配需滿足以下約束條件:

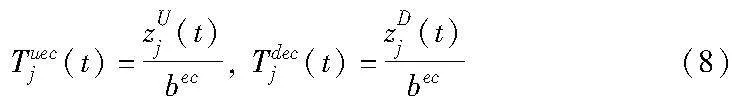

為了確保用戶任務(wù)成功執(zhí)行,將CC作為遷移協(xié)助目的地。當(dāng)CC被選為遷移目的地時,任務(wù)首先通過無線通道傳輸?shù)紼S,然后通過大容量的有線連接轉(zhuǎn)發(fā)到CC。因此,從ES到CC的傳輸速度可被認為是一個恒定值。假設(shè)ES和CC之間的上行傳輸速率等于ES和CC之間的下行傳輸速率,兩者都用bec表示。任務(wù)Qj(t)從ES到CC的上傳和下載時間可表示為Tuecj(t)和Tdecj(t),則分別描述為

令oj(t)∈{0,1}代表二元遷移決策,表示任務(wù)Qj(t)在ES(oj(t)=1)或CC(oj(t)=0)中執(zhí)行。由于服務(wù)緩存是ES中任務(wù)執(zhí)行的先決條件,服務(wù)緩存決策需要在遷移決策執(zhí)行之前決定,所以系統(tǒng)需要滿足約束條件:

oj(t)≤aj(t-1)(9)

2.2 計算模型

當(dāng)任務(wù)被遷移到ES執(zhí)行時,用fej(t)表示分配給任務(wù)Qj(t)的計算資源,因此,Qj(t)的處理時間可寫成Tej(t):

由于ES的計算資源有限,在時隙t中分配給任務(wù)的計算資源之和不能超過ES的總計算能力。令fE代表ES的總計算能力,則分配給任務(wù)Qj(t)的計算資源遵循以下約束條件:

當(dāng)CC被選為遷移目的地時,CC的計算能力足夠并假定其計算速率為一常數(shù)值,用fc表示。假設(shè)CC有能力處理所有服務(wù)類型的任務(wù),因此由CC執(zhí)行的任務(wù)Qj(t)的時間消耗可用Tcj(t)表示,并通過式(12)計算。

2.3 問題定義

本文的優(yōu)化目標是在一段時間內(nèi)最小化任務(wù)平均完成時延,同時最大化支持多服務(wù)移動邊緣計算系統(tǒng)的資源利用率。當(dāng)服務(wù)j的任務(wù)由ES處理時,其處理時延dej(t)表示為

dej(t)=TUj(t)+TDj(t)+Tej(t)(13)

另一方面,當(dāng)服務(wù)j的任務(wù)被遷移到CC執(zhí)行時,其處理時延用dcj(t)表示,并描述為

dcj(t)=TUj(t)+TDj(t)+Tcj(t)+Tuecj(t)+Tdecj(t)(14)

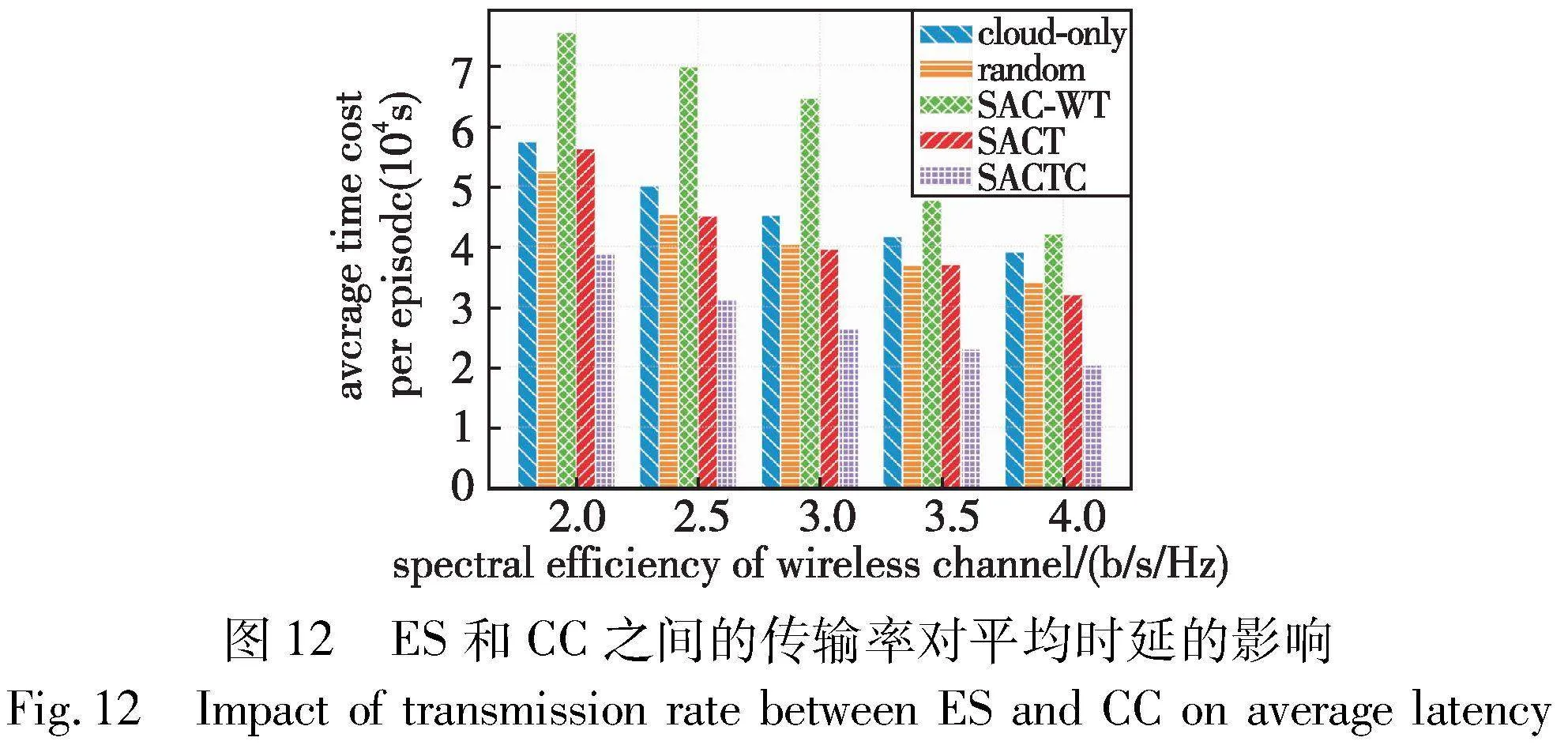

在每個時隙,代理需要確定屬于不同服務(wù)類型任務(wù)的bUj(t)、bDj(t)、aj(t)、oj(t)和fej(t),從而獲得最小平均時延。對于時隙t,系統(tǒng)任務(wù)的完成時延用d(t)表示,并定義為

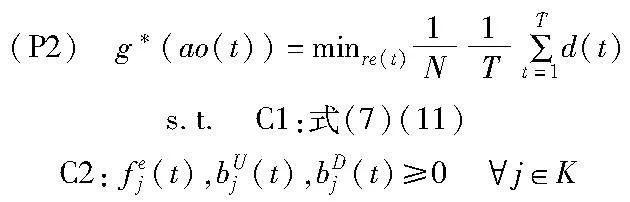

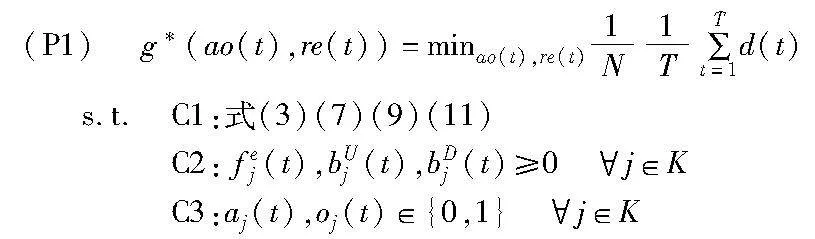

因此,將系統(tǒng)中要優(yōu)化的目標轉(zhuǎn)換為T個時隙范圍內(nèi)的優(yōu)化問題。為了便于表示,服務(wù)緩存和計算遷移決策以及t時隙的資源分配決策定義為ao(t)={a(t+1),o(t)}和re(t)={bU(t),bD(t),fe(t)},則上述優(yōu)化問題表示為

其中:bU(t)=[bU1(t),…,bUK(t)],bD(t)=[bD1(t),…,bDK(t)],a(t)=[a1(t),…,aK(t)],o(t)=[o1(t),…,oK(t)],fe(t)=[fe1(t),…,fek(t)]。C1約束中的式(3)表示緩存服務(wù)所占用的總存儲空間不能超過ES的最大緩存容量;式(7)表示在每個時隙分配給每個服務(wù)的上行和下行帶寬不能超過系統(tǒng)的總可用帶寬;式(9)表示,當(dāng)相應(yīng)的服務(wù)沒有在ES中緩存時,任務(wù)不能被遷移到ES;式(11)表示分配的計算速率之和不能超過ES擁有的可分配計算資源。C2表示系統(tǒng)應(yīng)該為每個任務(wù)分配所需的資源進行傳輸和執(zhí)行。C3表示服務(wù)緩存和計算遷移決策是二元決策。由于問題P1是一個在有限時隙T下具有大規(guī)模狀態(tài)和行動空間的動態(tài)編程問題,所以本文在下列的求解過程中,首先將其轉(zhuǎn)換為馬爾可夫決策過程(Markov decision process,MDP),隨后再將MDP問題分解為兩個階段的子問題,最后提出一種結(jié)合DRL、Transformer和凸優(yōu)化的智能算法來分別求解上述問題。

3 問題求解

3.1 馬爾可夫決策過程

從上述討論看出,包含離散的0-1決策變量的優(yōu)化問題P1是一個非凸問題,因此傳統(tǒng)的凸優(yōu)化解決方法不適合該問題。為了實現(xiàn)本文的目標,將優(yōu)化問題P1建模為MDP五元組{S,A,R,P,γ}。具體來說,所考慮的MDP描述如下:在時隙t的開始,系統(tǒng)根據(jù)過去和現(xiàn)在的狀態(tài)(例如,任務(wù)的輸入或輸出大小,服務(wù)的計算要求和以前的服務(wù)緩存決策)收集相關(guān)參數(shù),形成st∈S,然后根據(jù)st從動作集A中選擇一個可用的動作at執(zhí)行,系統(tǒng)狀態(tài)根據(jù)給定的狀態(tài)轉(zhuǎn)換概率P更新為st+1并獲得獎勵rt∈R。在下文中將詳細介紹MDP的要素。

a)狀態(tài)空間:系統(tǒng)在時隙t的狀態(tài)表示為st=[w(t),zU(t),zD(t),n(t),a(t-1)],其中w(t)=[w1(t),…,wK(t)],zU(t)=[zU1(t),…,zUK(t)],zD(t)=[zD1(t),…,zDK(t)]分別為每種服務(wù)類型的任務(wù)的計算需求、輸入數(shù)據(jù)大小以及處理結(jié)果,而n(t)=[n1(t),…,nK(t)],其中nj(t)=|i|xij(t)=1,i∈N|是對服務(wù)j的訪問數(shù),a(t-1)=[a1(t-1),…,aK(t-1)]表示每個服務(wù)在t-1的時隙中的緩存決定。

b)動作空間:根據(jù)狀態(tài)st,系統(tǒng)不僅需要決定服務(wù)緩存和計算遷移決策,還需要決定資源分配決策,包括帶寬和CPU頻率。因此,t時隙中的動作描述為at=[a(t),o(t),bU(t),bD(t),fe(t)]。其中,a(t)=[a1(t),…,aj(t),…,aK(t)]是預(yù)測時隙t+1的服務(wù)緩存決策,而o(t)、bU(t)、bD(t)、fe(t)分別是時隙t中各服務(wù)的遷移決策、上行帶寬分配、下行帶寬分配和CPU頻率分配的決策。

c)狀態(tài)轉(zhuǎn)移概率:對st的敏銳觀察說明,服務(wù)緩存決策a(t)直接由行動at-1給出,而狀態(tài)st+1與st獨立。因此,狀態(tài)轉(zhuǎn)換概率表示為

P(st+1|st,at)=P(w(t+1),zU(t+1),zD(t+1),nj(t+1),

a(t+1)|at)=P(w(t+1),zU(t+1),zD(t+1),nj(t+1))(16)

其中:w(t+1)、zU(t+1)、zD(t+1)和nj(t+1)是與遷移和緩存決策獨立的隨機過程。

d)獎勵函數(shù):獎勵是代理在遇到st執(zhí)行at后環(huán)境反饋給代理的一個即時標量信號,它幫助代理改進其策略。為了最小化任務(wù)完成時延同時最大化有限時隙內(nèi)的資源利用率,將獎勵函數(shù)與優(yōu)化目標相結(jié)合,并將其表述為任務(wù)時延的負值與時隙t的資源利用率之差,即

rt=-d(t)+ω[eupt+edownt+ecput](17)

其中:eupt、edownt和ecput是時隙t中上行帶寬、下行帶寬和CPU頻率的利用率,ω表示資源利用率重要性的權(quán)重系數(shù)。

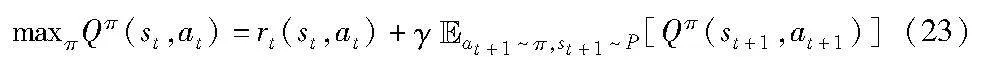

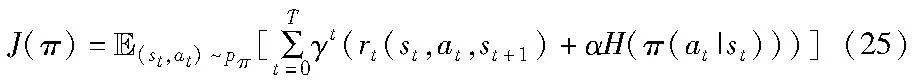

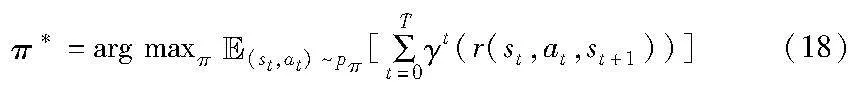

e)折扣因子γ:DRL算法通過政策評估和政策迭代來學(xué)習(xí)一個最優(yōu)策略。根據(jù)貝爾曼最優(yōu)方程,最優(yōu)策略可描述為

其中:γ∈(0,1)是折扣因子,表示即時回報和未來回報之間的相對重要性。

3.2 問題分解

從以上定義可知原始優(yōu)化問題P1因其約束條件包含整數(shù)離散變量是一個非凸問題。此外,P1中的緩存和遷移決策是時間上的耦合,這使得傳統(tǒng)的啟發(fā)式方法(如凸放松)不適用。以神經(jīng)網(wǎng)絡(luò)為函數(shù)近似器的深度強化學(xué)習(xí)的出現(xiàn),為處理非凸優(yōu)化問題提供了新的解決方案。然而,對P1應(yīng)用傳統(tǒng)的DRL算法可能會受到維度詛咒的影響,并且由于高維行動空間而導(dǎo)致收斂速度緩慢。為了解決上述問題,將P1分解為兩個階段的子問題(例如DRL子問題和凸優(yōu)化子問題)。DRL子問題旨在學(xué)習(xí)最優(yōu)策略,以確定服務(wù)緩存和計算遷移決策,而凸優(yōu)化子問題則通過凸優(yōu)化器(如內(nèi)點優(yōu)化器)解決資源分配問題。

3.2.1 凸優(yōu)化子問題

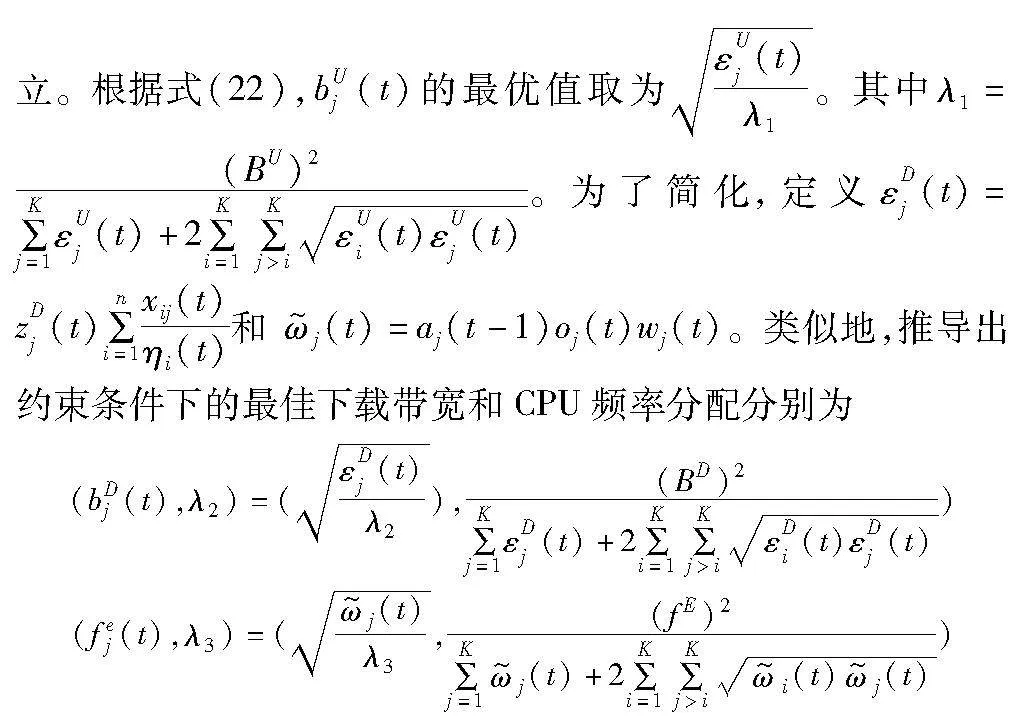

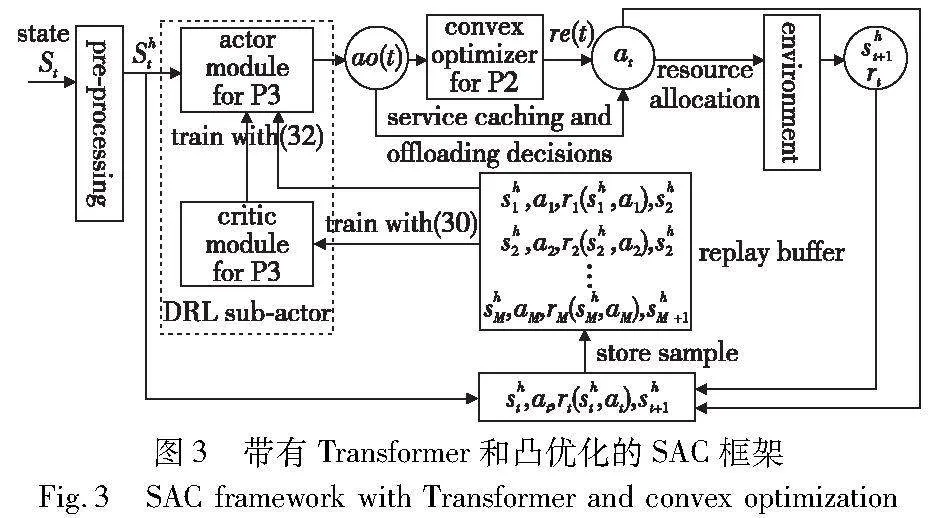

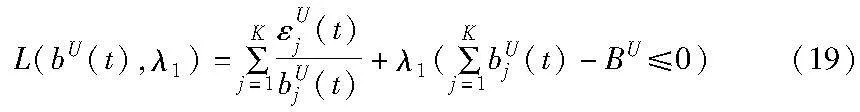

首先,在確定了緩存和遷移決策的前提條件下,將資源分配問題從P1分解出來。特別是,給定離散決策ao(t),在每個時隙t的非凸問題P1可重寫為

由于帶寬和頻率分配是相互獨立的,將上傳帶寬分配問題從P2中分離出來,并將其表述為

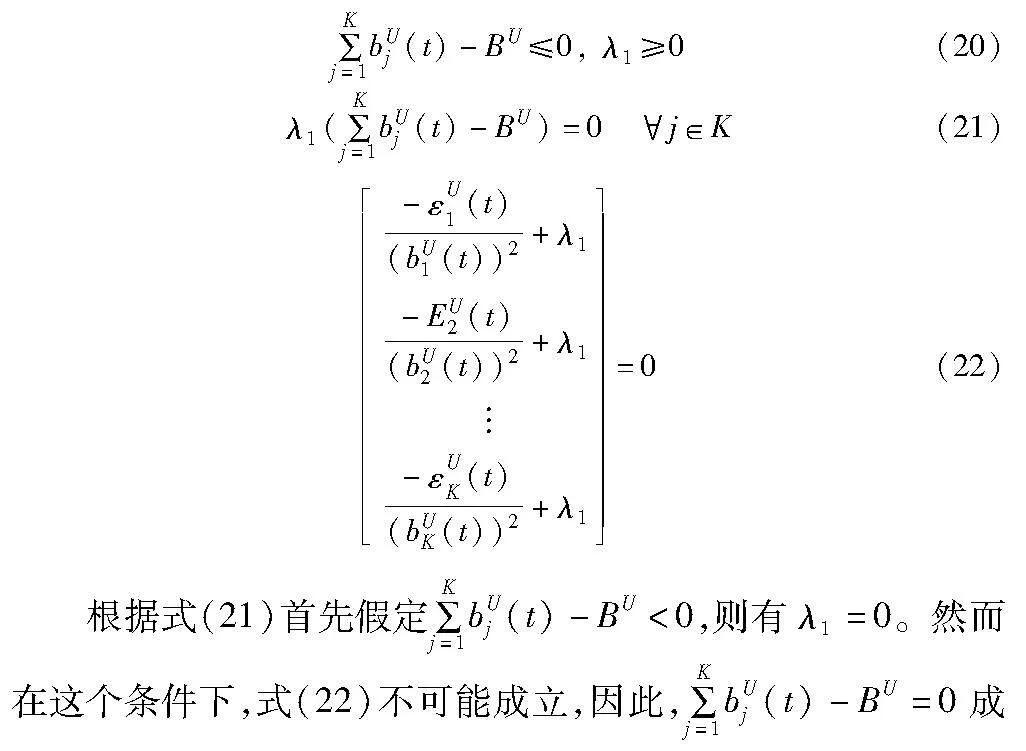

引入拉格朗日乘子λ1來獲得P4的拉格朗日函數(shù):

隨后得到了P4的KKT條件:

3.2.2 強化學(xué)習(xí)子問題

每個時隙的服務(wù)緩存和遷移決策決定了任務(wù)將被送到哪里執(zhí)行,這對長期的任務(wù)完成時延有很大影響。為此,本文引用了基于DRL的方法來尋找最佳遷移策略。根據(jù)貝爾曼方程,P1在時隙t的狀態(tài)值函數(shù)Qπ寫成:

此外,從上面的討論中得出在st采取at行動時,在時間段t的即時獎勵為

rt(st,ao(t)|re*(t))=-d(t)+ω[eupt+edownt+ecput](24)

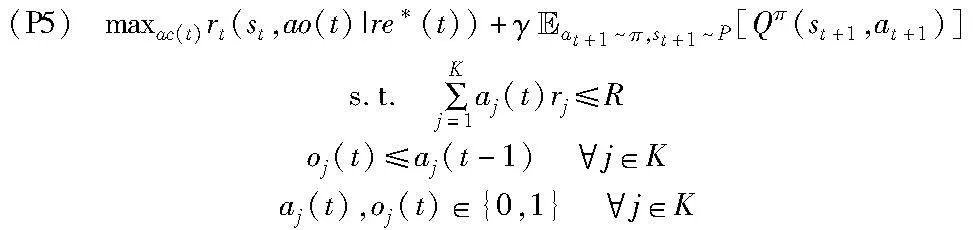

其中:re*(t)=[bU(t),bD(t),fe(t)]是問題P2的最優(yōu)解。因此,解決DRL子問題等同于計算最佳離散的服務(wù)緩存和遷移決策,即P5。

基于DRL的巨大進步,本文提出了一種基于DRL的算法,結(jié)合Transformer在處理時間序列數(shù)據(jù)方面的優(yōu)勢,學(xué)習(xí)一種策略,決定在P5中最佳的服務(wù)緩存和遷移決策ao(t)。

4 SACTC算法設(shè)計

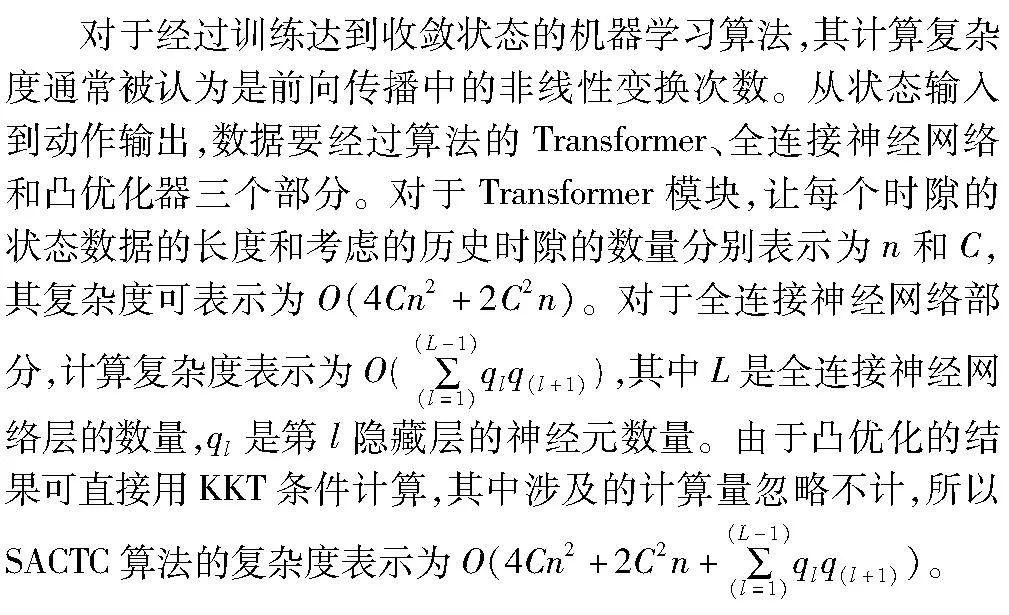

本章提出了一種基于DRL的算法來解決上述問題,該算法從歷史經(jīng)驗中學(xué)習(xí),并在不知道未來信息的情況下作出決策。算法是基于筆者在文獻[24]提出的SAC的DRL算法,其目的是使熵最大化以確保穩(wěn)定性和探索性。此外,為了對時間序列數(shù)據(jù)的關(guān)系進行建模,并對未來的行動進行準確的預(yù)測,該算法嵌入了Transformer這一創(chuàng)新技術(shù)。基于SAC、Transformer以及凸優(yōu)化的服務(wù)緩存、遷移以及資源分配的算法(SACTC)的框架如圖3所示。

4.1 基于最大化熵強化學(xué)習(xí)

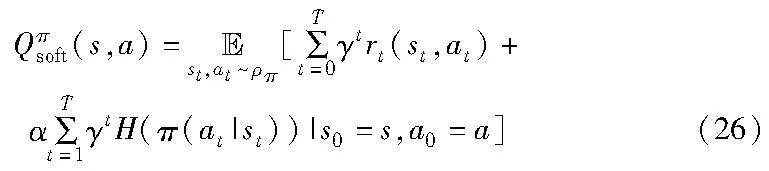

強化學(xué)習(xí)代理的主要目標是學(xué)習(xí)一個策略π,使得累積預(yù)期獎勵最大化。然而,與大多數(shù)現(xiàn)有的強化學(xué)習(xí)算法不同的是,本文在SAC算法的目標中多加入了一個熵項H(π(a|s))=-log(π(a|s)),表示策略π的隨機性,這使代理能夠獲得更好的探索和更強的魯棒性。因此,在SAC中,具有預(yù)期熵的軟目標被寫成:

其中:γ∈(0,1)是折扣因子,表示未來獎勵的重要性;α∈(0,1)是溫度系數(shù),表示熵和獎勵在目標中的相對重要性。鑒于初始狀態(tài)s0和行動a0,軟Q函數(shù)可表示為

與其他基于Actor-Critic的算法類似,SAC算法通過在策略評估(計算當(dāng)前政策的價值)和策略改進之間交替進行,選擇在熵目標最大化的方向上使Q值最大化的最佳策略。

4.2 狀態(tài)預(yù)處理

與以往在服務(wù)緩存領(lǐng)域的研究不同,本文構(gòu)建一個更實用的模型,即服務(wù)緩存決策在時隙t-1結(jié)束時進行,這使得時隙t的計算遷移決策能夠立即執(zhí)行,而無須等待。為此,將過去C時間段的狀態(tài)結(jié)合起來,以獲得系統(tǒng)狀態(tài)動量,這使得DRL代理能夠?qū)Ψ?wù)緩存決策進行準確預(yù)測。因此,輸入神經(jīng)網(wǎng)絡(luò)的狀態(tài)描述為

sh=(st,…,s(t-C+1))(27)

如果狀態(tài)歷史長度C較長,代理人可作出更好的決定。另一方面,較大的C會產(chǎn)生一個大的狀態(tài)空間,減緩算法的學(xué)習(xí)速度。為了在性能和簡單性之間平衡,本文設(shè)定C=3。

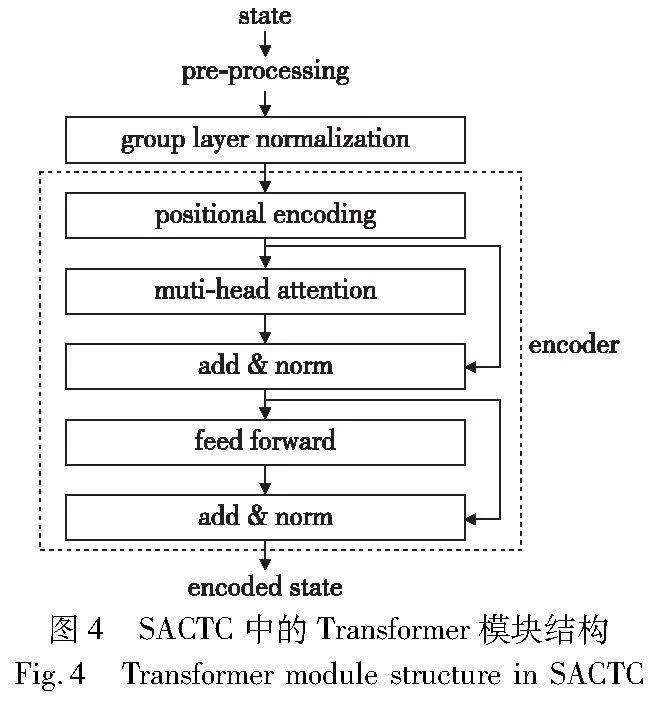

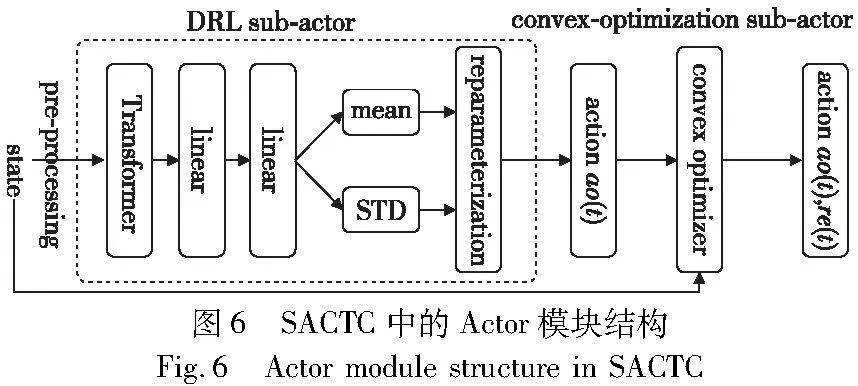

4.3 Transformer模塊

本文沒有使用傳統(tǒng)的或循環(huán)的神經(jīng)網(wǎng)絡(luò),而是利用Transformer的優(yōu)勢來計算不同時間段的依賴關(guān)系。Transformer包括編碼器和解碼器。編碼器由兩個子層組成,包括一個多頭自注意機制和一個基于位置全連接的前饋網(wǎng)絡(luò),用于對輸入狀態(tài)進行編碼,給它們分配代表應(yīng)該注意的程度的權(quán)重,而解碼器通常用于生成預(yù)測結(jié)果。如圖4所示,本文的目標是利用Transformer的編碼器模塊來解決以下兩個挑戰(zhàn)。一方面,系統(tǒng)中每種類型的服務(wù)被訪問的概率不一樣,這里的目標是將當(dāng)前時隙附近的狀態(tài)的時間數(shù)據(jù)進行組合,然后將它們輸入到Transformer中,對系統(tǒng)狀態(tài)的趨勢進行描述,從而對下一個時隙的服務(wù)緩存決策進行預(yù)測;另一方面,狀態(tài)內(nèi)的特征由不同類型的數(shù)據(jù)組成(如離散特征nj(t)和連續(xù)特征w(t)),Transformer的編碼器用來構(gòu)建狀態(tài)內(nèi)特征之間的多重依賴關(guān)系。具體來說,如圖4所示,包含歷史信息的狀態(tài)首先被送入歸一化模塊,將每個特征轉(zhuǎn)換為無量綱的純值,然后歸一化的輸出將被傳遞給編碼器,最后通過多頭自我關(guān)注機制計算輸入序列的權(quán)重。

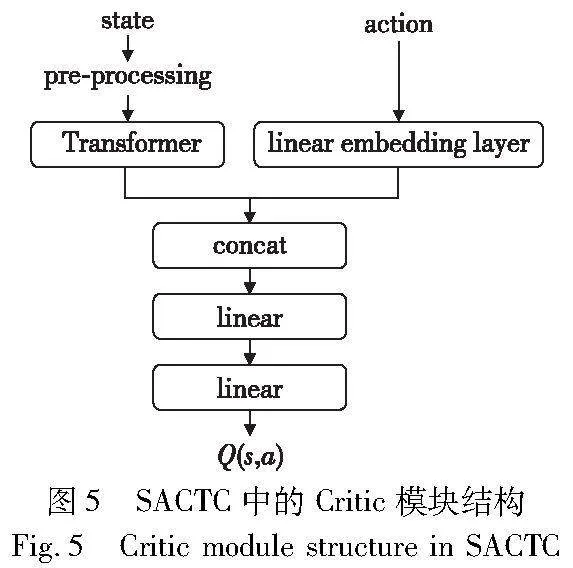

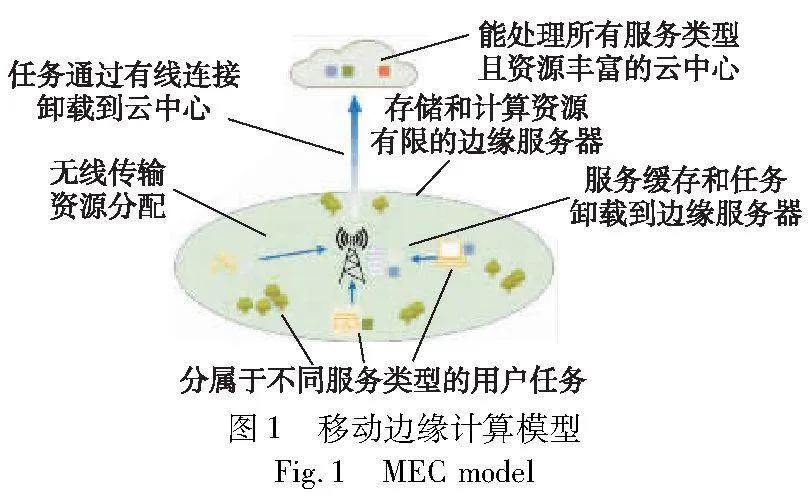

4.4 Critic模塊

如圖5所示,Critic模塊將Transformer模塊的狀態(tài)輸出和線性層的動作輸出作為輸入,并估計狀態(tài)-動作對的Q(s,a)值。為了能夠在連續(xù)和高維的動作空間中估計狀態(tài)-動作值,具體來說,SAC通過使用參數(shù)為w的神經(jīng)網(wǎng)絡(luò)來近似Q(s,a),即Q(s,a)≈Qw(s,a)。與大多數(shù)基于數(shù)值的DRL算法類似,Qw(s,a)的參數(shù)w通過最小化均方誤差損失函數(shù)進行更新。

4.5 Actor模塊

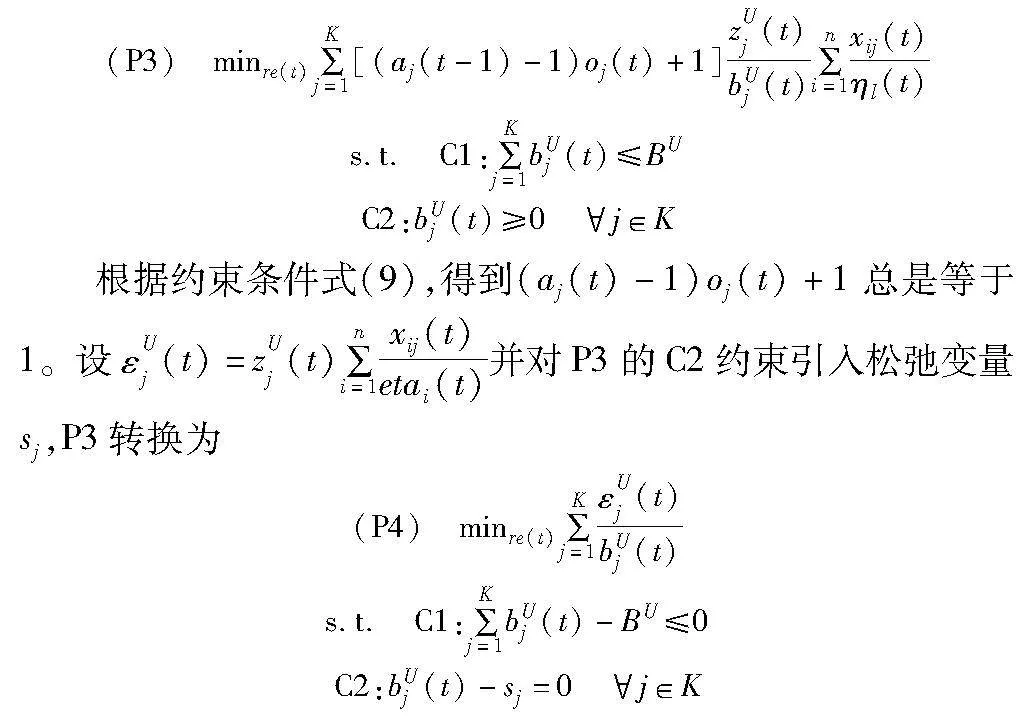

Actor模塊負責(zé)將一個狀態(tài)映射到一個最佳決策。由于SACTC算法的輸出決策不僅包括離散的服務(wù)緩存和遷移決策,還包括連續(xù)的資源分配決策,所以SACTC算法的Actor模塊由DRL sub-actor和凸優(yōu)化sub-actor兩個子Actor組成。

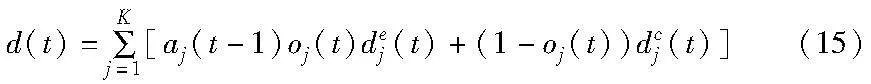

如圖6所示,DRL sub-actor首先將包含過去和當(dāng)前信息的原始狀態(tài)傳遞給狀態(tài)預(yù)處理和Transformer模塊,以對歷史信息進行編碼。隨后再將扁平化的狀態(tài)輸入兩層全連接網(wǎng)絡(luò)后,輸出服務(wù)緩存和計算遷移決策。策略網(wǎng)絡(luò)π的參數(shù)用θ表示,并通過最小化Kullback-Leibler散度來找到一個滿足Qπnew(st,at)≥Qπold(st,at)的新策略。因此,策略π的損失函數(shù)定義為

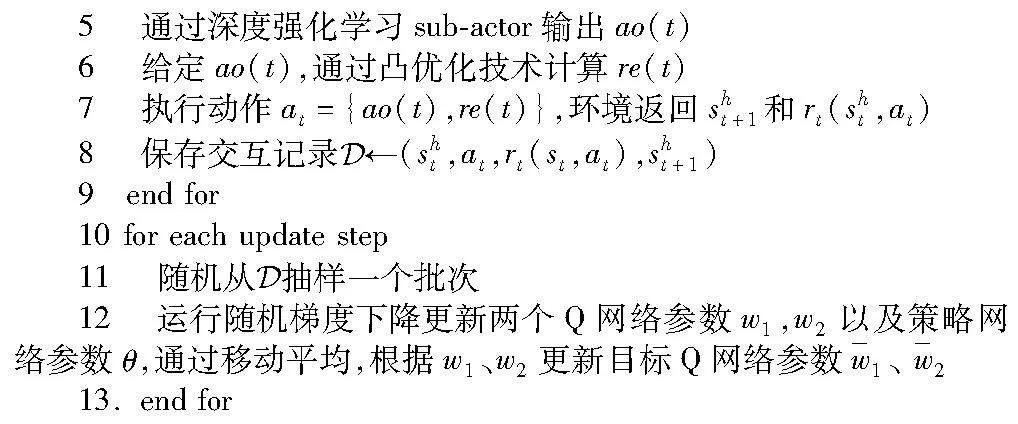

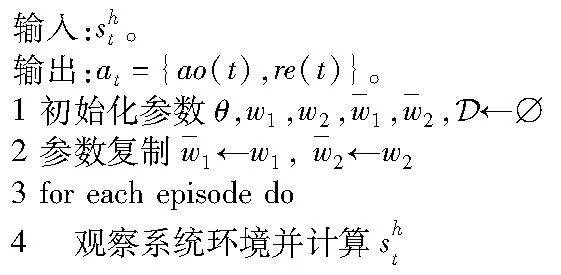

類似地,凸優(yōu)化子行為以當(dāng)前狀態(tài)和遷移決策為輸入,通過采用凸優(yōu)化器解決(P3),返回最優(yōu)資源分配決策,如上行、下行帶寬和CPU頻率分配決策。算法的細節(jié)顯示在算法1中。

算法1 SACTC算法

4.6 算法復(fù)雜度分析

5 仿真實驗及分析

本章通過設(shè)置仿真參數(shù),在不同的環(huán)境下將本文算法與基線算法進行比較,以驗證SACTC算法的收斂性能和有效性。實驗環(huán)境是在Intel酷睿i7處理器、NVIDIA GeForce RTX3060筆記本GPU和16 GB內(nèi)存電腦上實現(xiàn)的。

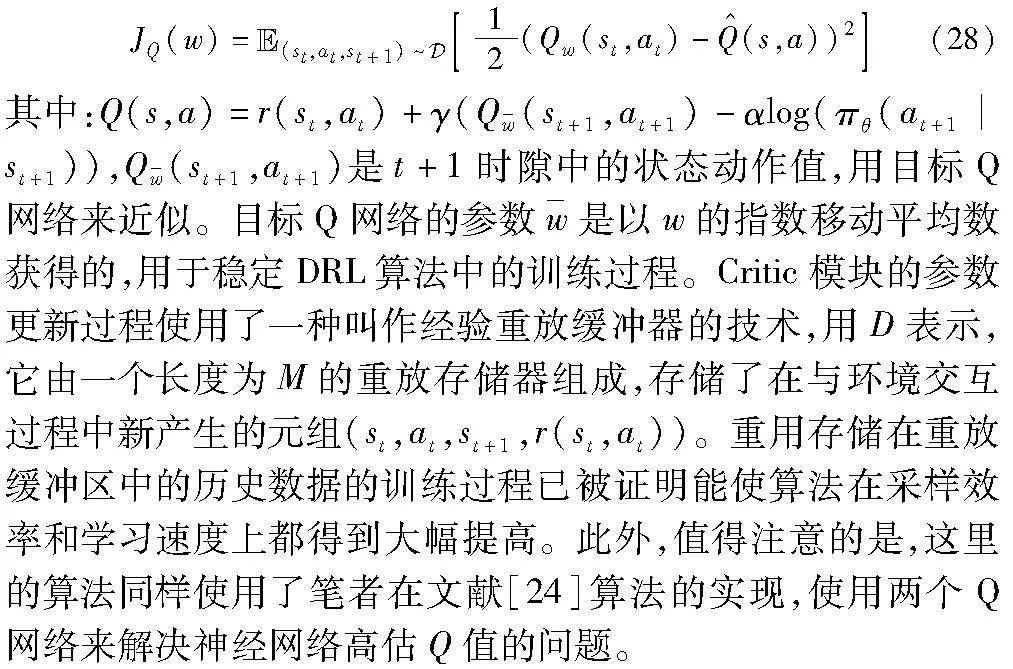

5.1 實驗參數(shù)設(shè)置

為了模擬真實環(huán)境,假設(shè)在一個支持MSs-MEC的系統(tǒng)中有N=40個用戶、一個ES和一個CC。特別地,CC作為ES的輔助,當(dāng)任務(wù)的服務(wù)沒有緩存在ES中時,它確保任務(wù)成功執(zhí)行。ES的存儲容量為R=300 GB,計算能力為31 GHz。假設(shè)系統(tǒng)中用戶的服務(wù)類型需求共有K=10種,安裝服務(wù)的空間需求遵循U[40,80]G的均勻分布,不同服務(wù)在每個時隙的訪問概率服從Zipf法則。每個用戶任務(wù)到達服從泊松分布,到達率為λ∈[8,12,18,24] Mb。為簡單起見,假設(shè)每個任務(wù)的計算需求是任務(wù)輸入數(shù)據(jù)大小的比率,即330 cyles/Byte。此外,移動設(shè)備到ES的距離服從U[80,300]m的均勻分布,系統(tǒng)中的總上傳帶寬和下載帶寬為BU=BD=20 MHz。無線網(wǎng)絡(luò)的上行和下行頻譜效率為ηui=ηdi=3 bit/s/Hz。對于SACTC算法,它共包含5個網(wǎng)絡(luò)(1個Actor網(wǎng)絡(luò)和4個Crtic網(wǎng)絡(luò)),其中兩個網(wǎng)絡(luò)用于計算Q值,目的是減少動作值的過度估計,而其他網(wǎng)絡(luò)則負責(zé)計算目標Q值。每個神經(jīng)網(wǎng)絡(luò)包含4層(輸入層、輸出層和2個隱藏層),隱藏層的神經(jīng)元數(shù)量為512。詳細參數(shù)如表1所示。

將本文SACTC算法與以下四種基線算法進行比較,以評估其在不同角度的性能。

a)cloud-only方案。系統(tǒng)中用戶產(chǎn)生的任務(wù)全部轉(zhuǎn)發(fā)給CC執(zhí)行。在這個方案中,上行鏈路和下行鏈路的資源由一個凸優(yōu)化器來分配。

b)隨機方案。在這個方案中,服務(wù)緩存和任務(wù)遷移決定是隨機決定的,而上行鏈路、下行鏈路和CPU頻率資源是由凸優(yōu)化器進行分配。

c)帶整合SAC與Transformer的方案(SACT)。在這個方案中,不僅離散的服務(wù)緩存和任務(wù)遷移決策,而且連續(xù)的資源分配決策也是由SAC算法與Transformer模塊結(jié)合決定。

d)SAC方案(SAC-WT)。在這個方案中,所有的決策都只由SAC深度強化學(xué)習(xí)算法決定,其中Actor和Crtic模塊都是由全連接網(wǎng)絡(luò)組成。

5.2 收斂性分析

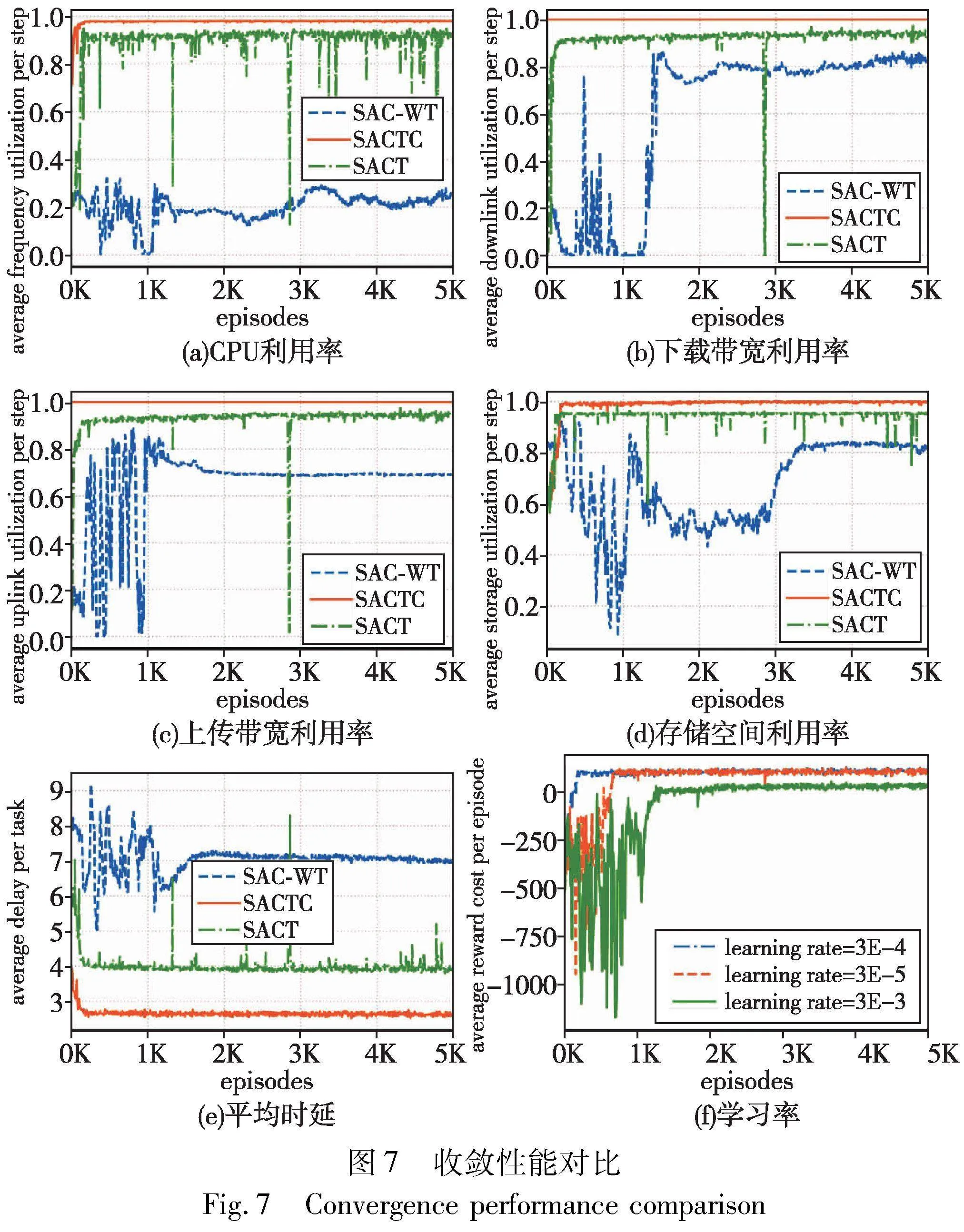

如圖7所示,與其他基于DRL的算法相比,SACTC實現(xiàn)了最高的資源利用率、最低的任務(wù)時延和最穩(wěn)定的訓(xùn)練過程。其原因如下:首先,通過將原優(yōu)化問題分解為強化學(xué)習(xí)子問題和凸優(yōu)化子問題,既降低了問題的復(fù)雜性,又減少了DRL策略在高維動作空間和多重約束帶來的不穩(wěn)定和難以收斂的負面影響;同時在凸優(yōu)化技術(shù)的幫助下大大提高了系統(tǒng)資源的利用率;其次,使用Transformer來學(xué)習(xí)不同時隙的緩存和遷移決策之間的關(guān)聯(lián)性,提高了算法的魯棒性,加速了算法的收斂速度。

具體來說,從圖7(a)~(e)可以看出,基于全連接神經(jīng)網(wǎng)絡(luò)的SAC-WT算法很難找到改善系統(tǒng)性能的任務(wù)遷移、服務(wù)緩存和資源分配決策,而基于Transformer的SACT算法顯示出明顯的性能改善,然而,過多的動作空間使得算法訓(xùn)練過程不穩(wěn)定。此外,圖7(f)還給出了Adam優(yōu)化器的不同學(xué)習(xí)率對SACTC算法收斂和穩(wěn)定性的影響。可觀察到,當(dāng)學(xué)習(xí)率設(shè)置為3×10-4時,SACTC算法需要大約500次能達到收斂狀態(tài),而當(dāng)學(xué)習(xí)率設(shè)置為其他值時,算法的訓(xùn)練過程變得不穩(wěn)定或者無法收斂到最優(yōu)狀態(tài)。這是因為學(xué)習(xí)率是神經(jīng)網(wǎng)絡(luò)權(quán)重在梯度降低方向上的更新步驟的大小,過大或過小的學(xué)習(xí)率都可能導(dǎo)致算法的訓(xùn)練變得不穩(wěn)定或錯過最佳收斂值。

5.3 對比實驗

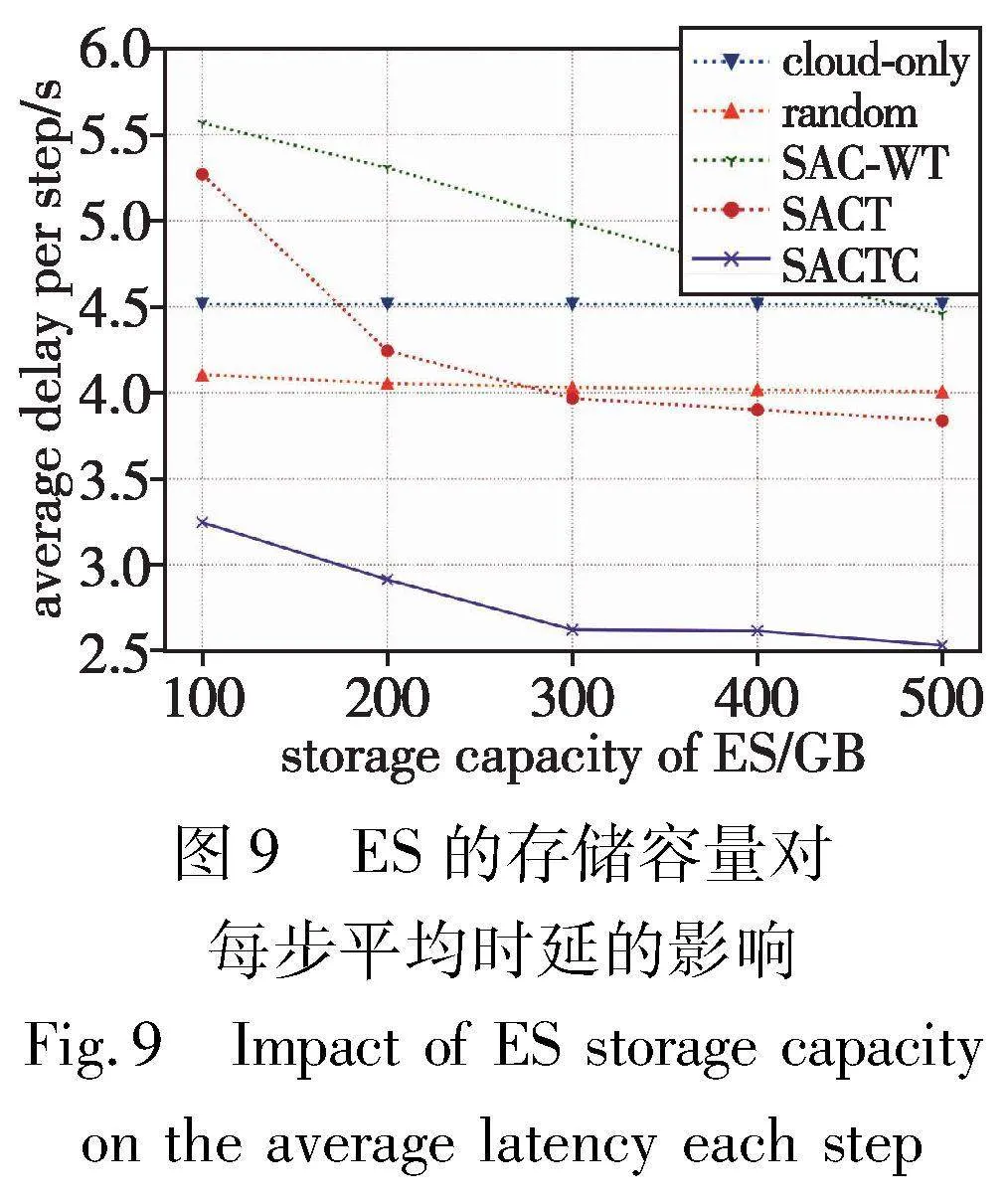

為了驗證本文算法的有效性和優(yōu)越性,本節(jié)分別驗證SACTC在用戶數(shù)量、存儲容量、ES的計算能力、無線信道的總帶寬、ES和CC之間的傳輸速率對每步平均任務(wù)時延的影響。

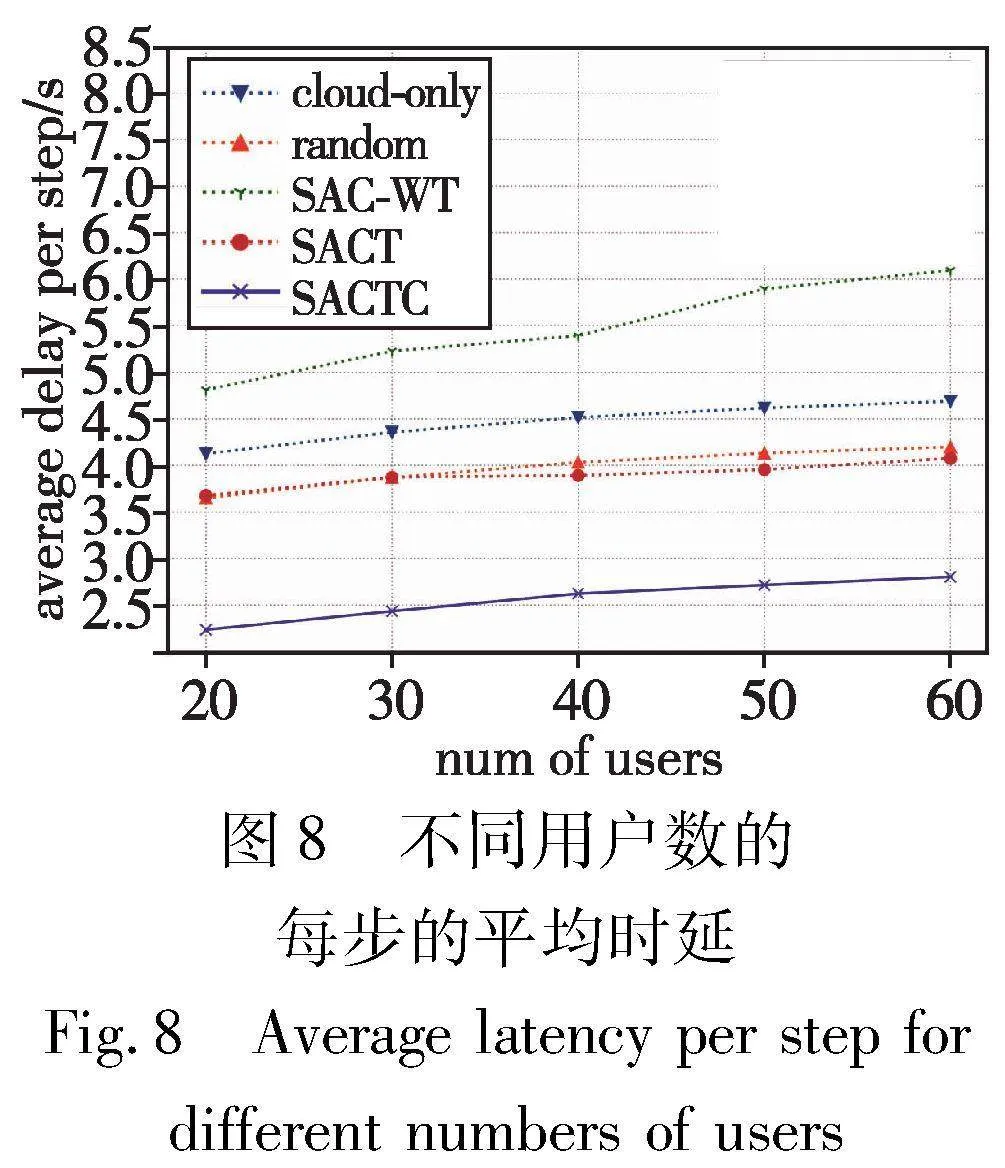

a)為了驗證不同的用戶數(shù)對SACTC和基線方案的平均時延的影響,設(shè)置用戶數(shù)從20~60,增量為10的實驗。如圖8所示,隨著用戶數(shù)量的增加,所有算法的平均時延都會增加。這是因為任務(wù)的處理需要系統(tǒng)中的各種資源,隨著用戶的增加,用戶之間對資源的競爭會加劇,在這種情況下,分配給用戶的資源會減少,從而增加任務(wù)的傳輸和處理時延。具體來說,SACTC在不同數(shù)量的用戶中實現(xiàn)了最小的平均任務(wù)時延。與SAC-WT和SACT方案相比,SACTC算法的平均時延平均降低了53%和34%,其原因是該方案通過凸優(yōu)化充分利用系統(tǒng)中的有限資源,并通過結(jié)合Transformer模塊有效確定能使時延最小化的耦合的服務(wù)緩存和任務(wù)遷移的決定。

b)為了評估ES的存儲容量對任務(wù)平均時延的影響,設(shè)置實驗使ES的存儲容量從100 GB增長到500 GB不等,增量為100 GB。圖9表明提出的方案與這些基線方案相比具有更少的平均時延,這是因為它具有更低維強化學(xué)習(xí)行動空間和更充分的資源利用率的優(yōu)勢。對于使用凸優(yōu)化進行資源分配的隨機算法和云計算算法,ES存儲容量的增加并沒有改變系統(tǒng)中可分配的資源總量,所以這兩種算法的平均任務(wù)時延幾乎沒有變化。然而,對于基于DRL的方法,隨著ES存儲容量的增加,更多的服務(wù)被緩存在ES中,因此更多的任務(wù)被遷移到ES中執(zhí)行,使其平均時延降低。

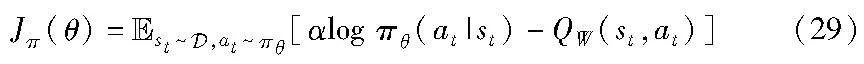

c)為了測試ES的計算能力對任務(wù)平均時延的影響,設(shè)置ES的計算能力從8 MHz增加到32 MHz,每次增量為6 MHz的實驗。圖10顯示,ES的計算能力越大,平均任務(wù)時延越低。這是因為較大的計算能力意味著有更多的計算資源被任務(wù)獲得,從而降低任務(wù)處理時延。與其他基線算法相比,本文SACTC算法在不同的ES計算能力下能夠?qū)崿F(xiàn)最低的任務(wù)平均時延。因為SACTC通過Transformer模塊可以更好地協(xié)調(diào)前一時隙和當(dāng)前時隙的遷移和緩存決策,輸出最關(guān)鍵的決策。然而,SAC-WT很難輸出適當(dāng)?shù)姆?wù)緩存和任務(wù)遷移決策,以及足夠的資源分配決策來減少任務(wù)時延,而且SACT算法的資源利用率比SACTC要差。

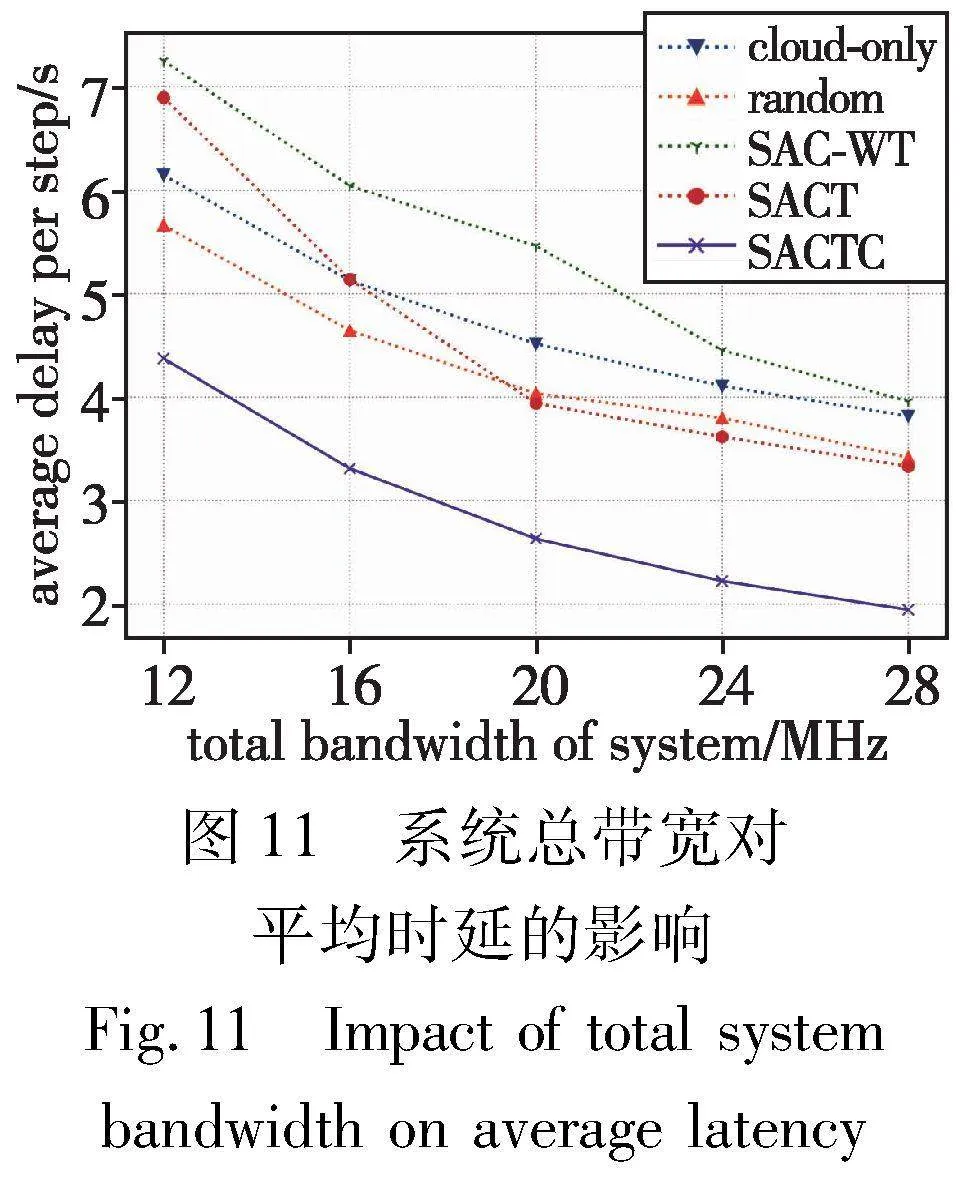

d)為了驗證系統(tǒng)帶寬對平均任務(wù)時延的影響,設(shè)置系統(tǒng)帶寬從12 MHz到28 MHz,增量為6 MHz的實驗。圖11說明了隨著帶寬的增加,所有算法任務(wù)的時延都有明顯的減少。這是因為帶寬是影響任務(wù)時延的關(guān)鍵因素,隨著分配更多的帶寬,無線網(wǎng)絡(luò)的傳輸速率將更快,同樣大小的數(shù)據(jù)傳輸?shù)紼S的時間將更短。通過問題分解技術(shù),與SAC-WT和SACT算法相比,SACTC算法分別獲得47.5%和37%的延時減少。

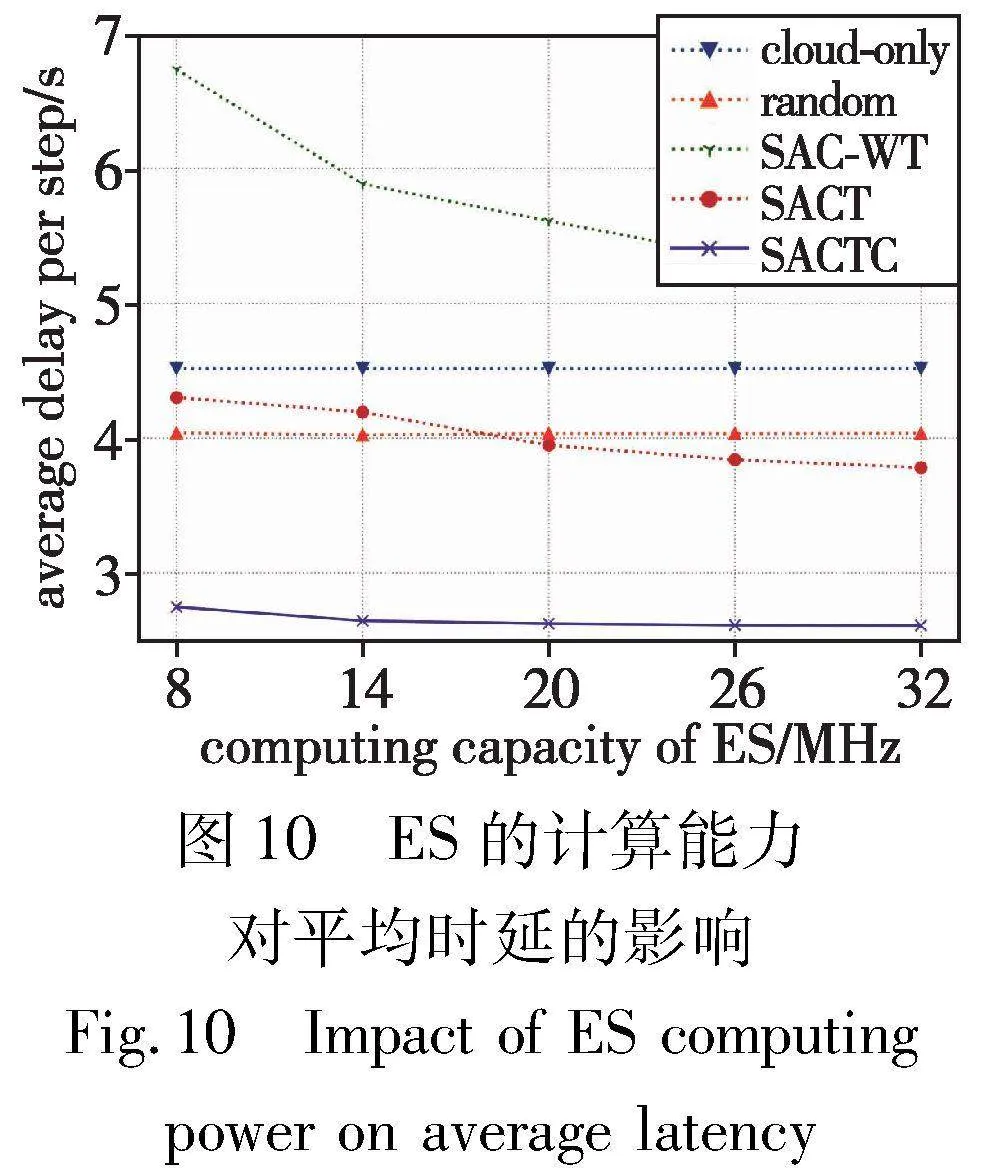

e)為了評估ES和CC之間的傳輸速率對平均任務(wù)時延的影響,實驗中設(shè)置ES和CC之間的傳輸速率從5~25 M/s遞增,增量為5 M/s。從圖12中看出,隨著ES和CC之間傳輸速率的增加,所有算法的任務(wù)平均時延都逐漸減少。對于SAC-WT算法,平均任務(wù)時延受到bec的強烈影響,而對于與Transformer集成的SACT算法,因其輸出關(guān)鍵的服務(wù)緩存和任務(wù)遷移決策從而實現(xiàn)更低的任務(wù)時延。仔細觀察圖12,SACTC在不同的bec值下實現(xiàn)了最小的任務(wù)平均延時,而且它們之間的差異不大,這是因為將Transformer集成到SACTC的Actor模塊中,并使用凸優(yōu)化進行資源分配,使得SACTC能夠充分利用ES中的可用資源,從而輸出更有效的決策,并具有更大的魯棒性。

6 結(jié)束語

本文研究了MSs-MEC系統(tǒng)中的服務(wù)緩存和計算遷移的聯(lián)合優(yōu)化問題。為了使系統(tǒng)的長期任務(wù)時延和資源利用率最小化,提出一種基于深度強化學(xué)習(xí)的混合算法SACTC,將原始問題分解為DRL子問題和凸優(yōu)化子問題,以降低原始優(yōu)化問題的復(fù)雜性。具體地,本文將Transformer集成到SAC算法中,以確定離散的服務(wù)緩存和任務(wù)遷移決策,以準確學(xué)習(xí)時間段之間的依賴關(guān)系,并利用凸優(yōu)化明智地計算連續(xù)資源分配。大量的仿真實驗證明,本文算法在不同的角度都能獲得最低的任務(wù)平均時延和最高的資源利用率,并且具有很強的魯棒性和穩(wěn)定性。進一步研究工作包括更為真實的仿真環(huán)境或是在真實網(wǎng)絡(luò)環(huán)境中實驗,可將優(yōu)化問題擴展到邊緣節(jié)點協(xié)作方面來減少任務(wù)卸載的延遲或其他費用。

參考文獻:

[1]Wang Jiadai,Zhao Lei,Liu Jiajia,et al. Smart resource allocation for mobile edge computing: a deep reinforcement learning approach[J]. IEEE Trans on Emerging Topics in Computing,2021,9(3): 1529-1541.

[2]Zhang Fangzhou. MEC-based latency aware optical character recognition and real-time English translation for smart cities[J]. Internet Technology Letters,2020,4:168.

[3]Zhao Junhui,Li Qiuping,Gong Yi,et al. Computation offloading and resource allocation for cloud assisted mobile edge computing in vehicular networks[J]. IEEE Trans on Vehicular Technology,2019,68(8): 7944-7956.

[4]Zhou Fuhui,Hu R Q. Computation efficiency maximization in wireless-powered mobile edge computing networks[J]. IEEE Trans on Wireless Communications,2020,19(5): 3170-3184.

[5]Wang Yunpeng,Lang Ping,Tian Daxin,et al. A game-based computation offloading method in vehicular multiaccess edge computing networks[J]. IEEE Internet of Things Journal,2020,7(6): 4987-4996.

[6]Ning Zhaolong,Dong Peiran,Kong Xiangjie,et al. A cooperative partial computation offloading scheme for mobile edge computing enabled Internet of Things[J]. IEEE Internet of Things Journal,2019,6(3): 4804-4814.

[7]Zhou Shuchen,Jadoon W. The partial computation offloading strategy based on game theory for multi-user in mobile edge computing environment[J]. Computer Networks,2020,178: 107334.

[8]Bahreini T,Badri H,Grosu D. Mechanisms for resource allocation and pricing in mobile edge computing systems[J]. IEEE Trans on Pa-rallel and Distributed Systems,2022,33(3): 667-682.

[9]Hu Han,Song Weiwei,Wang Qun,et al. Energy efficiency and delay tradeoff in an MEC-enabled mobile IoT network[J]. IEEE Internet of Things Journal,2022,9(17): 15942-15956.

[10]Sabuj S R,Asiedu D K P,Lee K J,et al. Delay optimization in mobile edge computing: cognitive UAV-assisted eMBB and mMTC services[J]. IEEE Trans on Cognitive Communications and Networking,2022,8(2): 1019-1033.

[11]Feng Jie,Yu F R,Pei Qingqi,et al. Cooperative computation off-loading and resource allocation for blockchain-enabled mobile-edge computing: a deep reinforcement learning approach[J]. IEEE Internet of Things Journal,2020,7(7): 6214-6228.

[12]Fan Qingyan,Lin Junyu,F(xiàn)eng Guangsheng,et al. Joint service caching and computation offloading to maximize system profits in mobile edge-cloud computing[C]//Proc of 16th International Conference on Mobility,Sensing and Networking. Piscataway,NJ:IEEE Press,2020: 244-251.

[13]Liu Fang,Zhang Zhenyuan,Wang Zunfu,et al. ECC: edge collaborative caching strategy for differentiated services load-balancing[J]. Computers,Materials and Continua,2021,69(2): 2045-2060.

[14]Peng Kai,Nie Jiangtian,Kumar N,et al. Joint optimization of service chain caching and task offloading in mobile edge computing[J]. Applied Soft Computing,2021,103: 107142.

[15]Zhong Shijie,Guo Songtao,Yu Hongyan,et al. Cooperative service caching and computation offloading in multi-access edge computing[J]. Computer Networks,2021,189: 107916.

[16]Zhang Guanglin,Zhang Shun,Zhang Wenqian,et al. Joint service caching,computation offloading and resource allocation in mobile edge computing systems[J]. IEEE Trans on Wireless Communications,2021,20(8): 5288-5300.

[17]Wang Zhongyu,Lyu Tiejun,Chang Zheng. Computation offloading and resource allocation based on distributed deep learning and software defined mobile edge computing[J]. Computer Networks,2022,205: 108732.

[18]Huang Liang,Bi Suzhi,Zhang Y A.Deep reinforcement learning for online computation offloading in wireless powered mobile-edge computing networks[J].IEEE Trans on Mobile Computing,2020,19(11):2581-2593.

[19]Shi Jinming,Du Jun,Wang Jian,et al. Deep reinforcement learning-based V2V partial computation offloading in vehicular fog computing[C]//Proc of IEEE Wireless Communications and Networking Conference. Piscataway,NJ:IEEE Press,2021: 1-6.

[20]Fu Fang,Kang Yunpeng,Zhang Zhicai,et al. Soft actor-critic DRL for live transcoding and streaming in vehicular fog-computing-enabled IoV[J]. IEEE Internet of Things Journal,2021,8(3): 1308-1321.

[21]Wang Shuoyao,Bi Suzhi,Zhang Y A. Deep reinforcement learning with communication transformer for adaptive live streaming in wireless edge networks[J]. IEEE Journal on Selected Areas in Communications,2022,40(1): 308-322.

[22]鄺祝芳,陳清林,李林峰,等. 基于深度強化學(xué)習(xí)的多用戶邊緣計算任務(wù)卸載調(diào)度與資源分配算法[J]. 計算機學(xué)報,2022,45(4): 812-824.(Kuang Zhufang,Chen Qinglin,Li Linfeng,et al. Multi-user edge computing task offloading scheduling and resource allocation based on deep reinforcement learning[J]. Chinese Journal of Computers,2022,45(4): 812-824.)

[23]彭姿馀,王高才,農(nóng)望.基于SAC的多服務(wù)移動邊緣計算中任務(wù)卸載和資源配置算法[J].計算機應(yīng)用研究,2023,40(5):1497-1503.(Peng Ziyu,Wang Gaocai,Nong Wang. SAC based algorithm for task offloading and resource provisioning in multiple-services mobile edge computing[J]. Application Research of Computers,2023,40(5):1497-1503.)

[24]Peng Ziyu,Wang Gaocai,Nong Wang,et al.Task offloading in multiple-services mobile edge computing: a deep reinforcement learning al-gorithm[J]. Computer Communications,2023,202:1-15.