基于聯(lián)盟鏈的邊緣緩存系統(tǒng)中最佳緩存策略設計

摘 要:針對不同運營商各自部署邊緣設備,投入巨大且緩存內容相互隔離,無法共享的問題,改進了一種基于聯(lián)盟鏈的邊緣緩存系統(tǒng)架構,使運營商部署的邊緣設備間能夠打破內容隔離,實現(xiàn)更大范圍的共享。為了提高運營商緩存收益,同時保證用戶傳輸質量,降低用戶傳輸時延,首先針對緩存內容流行度、內容大小以及邊緣設備的協(xié)作能力,分析不同內容交付方式對于用戶傳輸時延和運營商緩存收益的影響;然后,以最大化緩存收益和最小化傳輸時延為目標建立優(yōu)化問題;最后,為解決構建的高維度大規(guī)模的緩存決策問題,采用基于異步優(yōu)勢動作評價的內容緩存算法確定內容的最佳放置位置。仿真結果表明,所提緩存策略能夠有效地提高邊緣緩存收益,降低內容傳輸時延,提升用戶體驗。

關鍵詞:邊緣緩存; 區(qū)塊鏈; 智能合約; 協(xié)作緩存; 深度強化學習

中圖分類號:TP929 文獻標志碼:A 文章編號:1001-3695(2024)07-035-2173-06

doi:10.19734/j.issn.1001-3695.2023.12.0593

Design of optimal caching strategy in edge caching system

based on consortium chain

Abstract:To solve the problem that the edge devices deployed by different operators have huge investment and the cached contents are isolated and have difficulty in sharing information, this paper improved the architecture of an edge cache system based on consortium chain, so that the edge devices deployed by different operators could break the content isolation and achieve a wider range of content sharing. In order to improve the operator cache revenue while ensuring the user transmission quality and reducing the user transmission delay, this paper firstly analyzed the impact of different content delivery methods on user transmission delay and operator caching benefits in terms of cache popularity, content size, and edge device collaboration capabilities. Then,it established an optimization problem with the goal of maximizing the cache benefit and minimizing the transmission delay. Finally, to solve the proposed high-dimensional large-scale caching decision problem,it used asynchronous advantage actor-critic(A3C) based content caching algorithm to determine optimal placement of content. Simulation results show that the proposed cache strategy can effectively enhance the revenue of edge caching, reduce the delay of content delivery and improve the user experience.

Key words:edge cache; block chain; smart contract; cooperative caching; deep reinforcement learning

0 引言

隨著萬物互聯(lián)的移動互聯(lián)網業(yè)務發(fā)展,全球移動流量將呈指數(shù)級增長,2020年移動數(shù)據(jù)量為每月約62 EB,而在2023年達到每月約5 016 EB[1]。移動邊緣計算將存儲資源部署在微基站(small-cell base station,SBS)、宏基站(macro base station,MBS)等網絡邊緣節(jié)點,用戶可以從邊緣節(jié)點直接獲取數(shù)據(jù),而無須經過云計算中心傳輸,極大降低了子數(shù)據(jù)傳輸延遲,有效減輕了網絡的流量負載[2]。然而面對數(shù)量巨大且請求頻率高的熱點內容,SBS的存儲容量十分受限,并且不同的運營商緩存內容相互隔離,互不共享,導致熱點內容在不同運營商的SBS上重復緩存,緩存空間利用率不高,網絡建設運營成本居高不下[3]。為解決上述問題,基于區(qū)塊鏈的邊緣緩存技術得到了廣泛的關注與研究[4]。區(qū)塊鏈技術是一種高級的數(shù)據(jù)庫機制,存儲的數(shù)據(jù)或信息具有不可偽造、公開透明、集體維護等特點。基于區(qū)塊鏈的邊緣緩存技術將邊緣緩存技術與區(qū)塊鏈技術相結合,使熱點內容分布式地存儲在距離用戶較近的SBS上,利用區(qū)塊鏈去中心化、防竄改、公開透明等特點保證數(shù)據(jù)傳輸和訪問安全,能夠實現(xiàn)更大范圍的內容共享,提高了SBS的緩存利用率,成為6G邊緣緩存工作的新范式[5]。

由于公有鏈的運行機制會導致區(qū)塊鏈賬本難以長期維護,而且任意節(jié)點均可接入系統(tǒng)導致惡意攻擊的概率增加[6];而私有鏈僅供單個組織或機構使用,無法完全去中心化且不適用于SBS數(shù)量巨大的邊緣緩存系統(tǒng)[7]。聯(lián)盟鏈作為公有鏈和私有鏈的折中方案,只針對某個特定組織或群體,由若干成員共同參與管理,已成為區(qū)塊鏈技術發(fā)展的主要方向之一[8]。因此,本文將研究基于聯(lián)盟鏈的邊緣緩存策略來鼓勵運營商之間進行數(shù)據(jù)安全共享傳輸。

在基于區(qū)塊鏈和邊緣緩存的研究中,文獻[9]考慮不同物聯(lián)網系統(tǒng)的異構性以及集中化數(shù)據(jù)處理平臺單點故障等問題,提出一種基于區(qū)塊鏈技術的去中心化物聯(lián)網數(shù)據(jù)共享和存儲方案。針對基于區(qū)塊鏈的邊緣緩存資源分配問題,文獻[10]提出邊緣緩存節(jié)點內容選擇算法,將馬爾可夫鏈融合至緩存替換策略中,減少了帶寬資源浪費,提高了緩存命中率和空間利用率。針對區(qū)塊鏈的緩存資源交易機制問題,文獻[11]設計了一種基于內容提供商和邊緣節(jié)點之間的緩存資源交易機制,在訂單匹配過程中分解緩存資源請求,提高了邊緣緩存資源的使用效率。以上研究主要針對于求解運營商單個性能需求的最佳緩存位置。在實際的通信網絡中,往往不僅要考慮運營商性能需求,還需要考慮對用戶服務質量的影響。兩者差異化需求常常會帶來不同的系統(tǒng)設計側重,因此往往需要綜合考慮這些性能指標。

深度強化學習(deep reinforcement learning,DRL)算法因為能夠應對時變環(huán)境,產生最優(yōu)策略來最大化長期獎勵,為內容緩存優(yōu)化提供了新的解決方案。文獻[12]采用雙深度Q網絡(deep Q network,DQN)框架用于協(xié)作緩存和請求路由,最大限度減少用戶長期獲取內容的平均延遲。文獻[13]研究了區(qū)塊鏈網絡中的內容緩存問題,采用分布式近端策略優(yōu)化方案解決了最優(yōu)的緩存部署策略。文獻[14]針對區(qū)塊鏈系統(tǒng)中礦工平均效用最大化問題,采用異步優(yōu)勢動作評價(asynchronous advantage actor-critic,A3C)算法解決了聯(lián)合資源定價和分配問題。面對高維度大規(guī)模緩存決策問題的動態(tài)特性,A3C算法能夠優(yōu)化深度神經網絡采用異步梯度下降以獲得最優(yōu)策略,被證明在動態(tài)環(huán)境中具有更快的收斂性能[15]。

文獻[16]提出了一種基于聯(lián)盟鏈的邊緣緩存系統(tǒng)架構,通過考慮邊緣節(jié)點的開銷,設計了一種基于內容緩存的部分實用拜占庭容錯(partial practical Byzantine fault tolerance,pPBFT)共識機制來研究運營商緩存收益;文獻[17]利用貪婪算法僅針對靜態(tài)內容流行度求解出運營商緩存收益最大值。兩者均沒有考慮到內容的時變性給運營商和用戶帶來的影響。針對上述問題,本文對文獻[16]的網絡架構進行改進,并針對基于聯(lián)盟鏈的邊緣緩存系統(tǒng)的運營商緩存收益和用戶傳輸時延進行優(yōu)化,利用隨機參數(shù)的Zipf分布來模擬動態(tài)內容流行度分布,提出一種基于A3C的內容緩存算法對最大化運營商緩存收益和最小化用戶傳輸時延等緩存策略進行求解,以滿足實際通信網絡中的差異化需求。本文主要貢獻如下:

a)改進了基于聯(lián)盟鏈的內容共享交易流程,并結合動態(tài)內容流行度、內容大小以及SBS的協(xié)作能力,分析不同內容交付方式對于用戶傳輸時延和運營商緩存收益的影響。

b)以最大化運營商緩存收益和最小化用戶傳輸時延為優(yōu)化目標,為解決所構建的高維度大規(guī)模的緩存決策問題,將SBS的緩存決策過程建模為馬爾可夫決策過程(Markov decision processes,MDP),并利用A3C算法學習流行度時變的最優(yōu)緩存策略,通過在多個環(huán)境上異步并行執(zhí)行多個線程來確定內容放置位置。通過仿真評估本文算法與現(xiàn)有緩存策略的性能,驗證了所提緩存策略的有效性。

1 系統(tǒng)模型

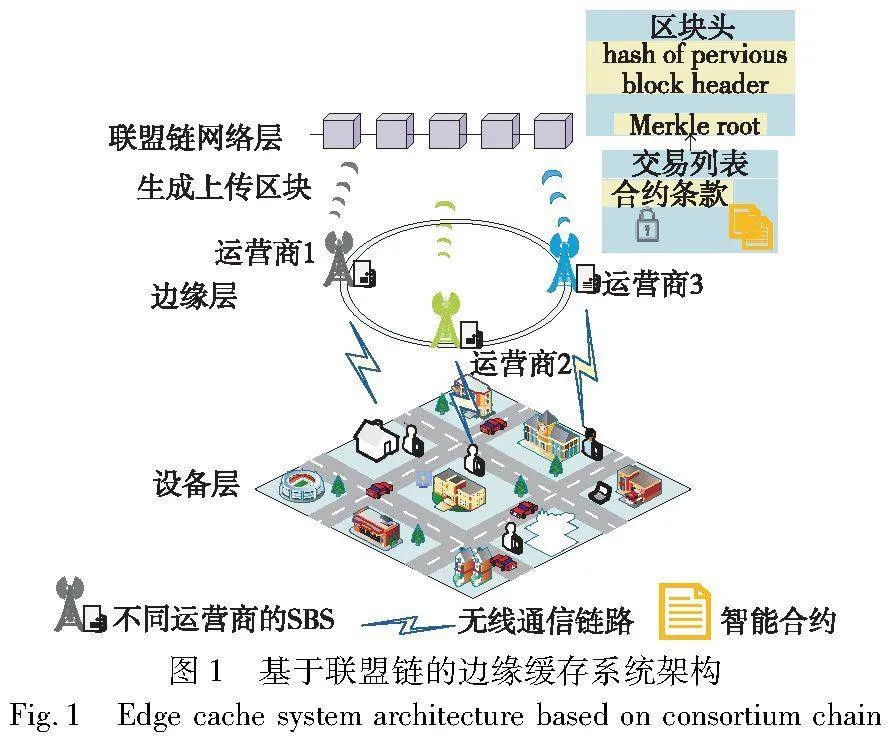

本章介紹基于聯(lián)盟鏈的邊緣緩存系統(tǒng)架構,對基于智能合約的內容共享協(xié)作交易流程進行設計以及對動態(tài)內容流行度進行建模。

1.1 網絡架構

本文建立了聯(lián)盟鏈和邊緣緩存的三層架構來實現(xiàn)內容傳輸共享。如圖1所示,它由設備層、邊緣層和聯(lián)盟鏈網絡層組成。各層功能描述如下:

a)設備層。用戶的智能設備通過無線通信鏈路連接到附近的SBS,并向邊緣層發(fā)送或接收數(shù)據(jù)。

b)邊緣層。邊緣層由不同運營商管理的SBS組成,其主要包含緩存節(jié)點和智能合約節(jié)點。緩存節(jié)點負責SBS信息的注冊與認證、查找內容以及不同運營商之間的內容轉發(fā);智能合約節(jié)點負責驗證交易、上傳區(qū)塊以及通過數(shù)字合同的形式保證參與交易各方按照智能合約自動執(zhí)行內容的交付。

c)聯(lián)盟鏈網絡層。聯(lián)盟鏈網絡提供記錄SBS請求信息和創(chuàng)建智能合約的去中心化服務,可以有序地存儲交易記錄。區(qū)塊中的交易列表記錄了有關內容共享交易的詳細信息,并生成Merkle root哈希記錄在區(qū)塊頭中,加密的合約條款記錄了內容單價,以預定義的方式執(zhí)行可靠的交易。

1.2 基于聯(lián)盟鏈的內容共享交易流程

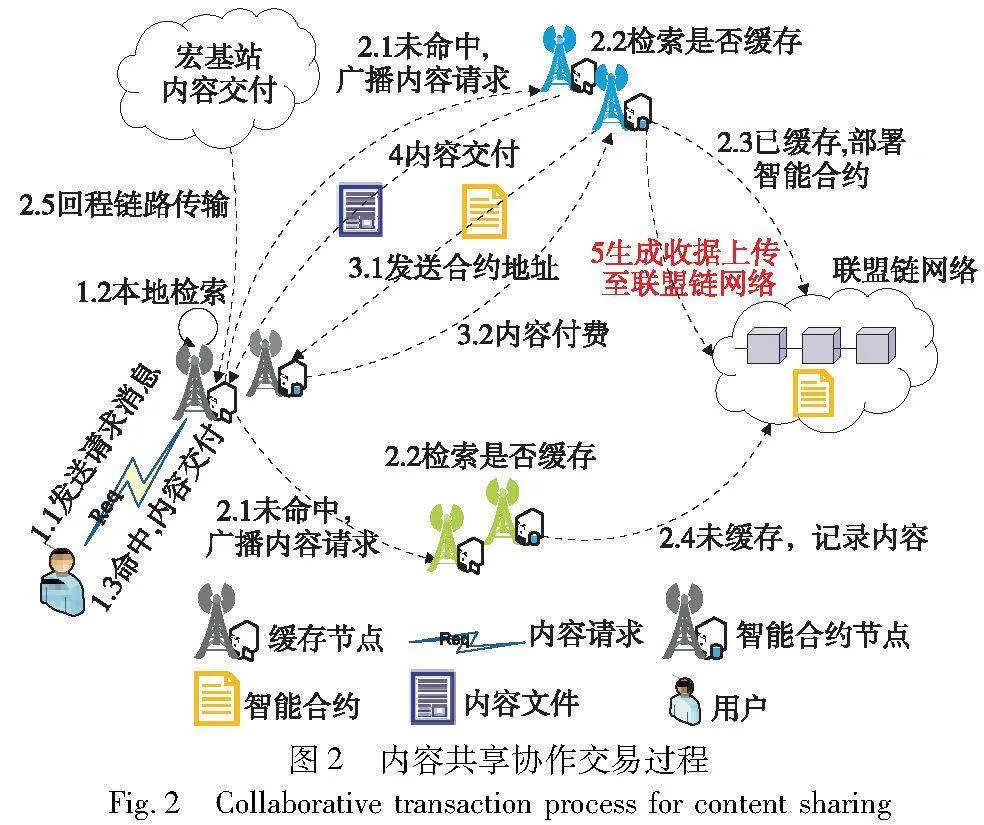

為保證不同運營商SBS之間的內容共享交易的安全性,本文對基于智能合約的內容共享協(xié)作交易流程進行設計,主要通過以下幾個階段實現(xiàn)[18]:

a)身份建立和初始化。要實現(xiàn)不同運營商之間的內容協(xié)作共享,邊緣節(jié)點首先通過聯(lián)盟鏈網絡認證后,注冊合法身份。假設SBS和內容庫分別表示為Euclid Math OneBAp={b1,b2,…,bI}和Euclid Math OneFAp={f1,f2,…,fJ},則SBS bi的身份信息可描述為

IDi:={idnp,kpubi,kprii,Ci,wi}(1)

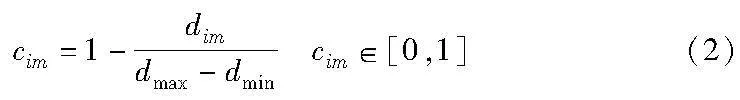

其中:每個字段分別為SBS連接的網絡運營商的身份號idnp,bi的公鑰kpubi和私鑰kprii,bi的協(xié)作域向量Ci以及錢包地址wi,錢包地址由其唯一的公鑰kpubi根據(jù)哈希創(chuàng)建[19]。由于地理位置等影響,并非系統(tǒng)中任意兩個SBS都適合進行內容共享,所以定義bi的協(xié)作域矩陣Ci,矩陣中每一項表示bi和其他SBS之間的協(xié)作優(yōu)先度,表示為

其中:dim表示bi和bm之間的距離;dmax表示協(xié)作域中最遠的兩個SBS的距離,距離越大說明其協(xié)作能力越低,不適合進行內容傳輸共享。

b)合約創(chuàng)建。邊緣節(jié)點就合約達成一致后,就可在聯(lián)盟鏈上部署智能合約。合約地址對所有邊緣節(jié)點公開,以便每個節(jié)點可以選擇與合約進行交互,SBS可以通過聯(lián)盟鏈發(fā)起內容共享請求。具體內容共享交易過程如圖2所示。

(a)用戶發(fā)起內容請求,本地SBS的緩存節(jié)點為用戶提供內容服務。如果內容在本地緩存命中,則直接進行內容傳輸;若未命中,則通過聯(lián)盟鏈向協(xié)作域內其他SBS的緩存節(jié)點廣播內容請求。

(b)其他SBS的緩存節(jié)點收到內容請求后,先檢查有無緩存。若已緩存,則協(xié)作域內的SBS反饋合作意向,待雙方協(xié)作意向達成后,發(fā)送內容的SBS的智能合約節(jié)點部署智能合約,對此次內容交易進行處理;若未緩存,則記錄內容的同時更新區(qū)塊,請求內容的SBS采取回程鏈路傳輸方式獲取內容。

(c)發(fā)送內容的SBS將合約地址傳送給請求內容的SBS,智能合約中記錄了發(fā)送內容的SBS的錢包地址以及費用;請求內容的SBS審核合約內容無誤后,向其支付所需費用。

(d)發(fā)送內容的SBS收到內容費用后進行內容傳輸。

(e)內容傳輸完成后,發(fā)送內容的SBS會生成交易收據(jù),之后使用哈希算法生成此次交易對應哈希值并上傳至區(qū)塊體中的交易列表中。內容共享交易過程執(zhí)行完畢。

c)交易記錄。在內容交易完成后,請求內容的SBS bi將生成的交易記錄發(fā)送到聯(lián)盟鏈網絡進行驗證,驗證成功后廣播到所有聯(lián)盟鏈節(jié)點。該交易記錄包括內容fj的數(shù)據(jù)量Qj,請求內容費用cost,提供內容的SBS bm的錢包地址wm和數(shù)字簽名Sigm以及當前消息的時間戳ts。交易記錄描述如下:

Transi=Epubi(Qj,cost,wm,Sigm,ts)(3)

其中:Epubi表示bi的公鑰kpubi對交易Transi進行加密;Sigm=Signprim(Qj,cost)表示bm的私鑰kprim對內容數(shù)據(jù)量Qj和費用cost簽署的數(shù)字簽名。

d)區(qū)塊創(chuàng)建。每個區(qū)塊由聯(lián)盟鏈節(jié)點協(xié)商創(chuàng)建,新區(qū)塊創(chuàng)建后,智能合約節(jié)點廣播帶有時間戳的區(qū)塊,其他節(jié)點驗證新區(qū)塊中交易記錄的正確性,通過實用拜占庭容錯共識機制[20]使系統(tǒng)達成共識。

1.3 內容流行度模型

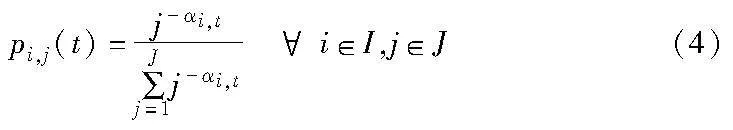

內容流行度通常情況下建模為齊夫(Zipf)分布,表示用戶對內容的請求概率[21]。考慮到實際中不同時隙的用戶對內容的偏好可能不同,所以每個SBS在不同時隙具有不同的內容流行度分布。定義在時隙t內容流行度表示為pi,j(t),可以用Zipf分布近似描述,即

其中:αi,t是反映在時隙t內SBS bi內容請求概率偏斜參數(shù)。由于內容請求的可變性,每個SBS的Zipf參數(shù)在每個時隙內可能不同,所以動態(tài)內容流行度分布集合表示為p(t)={pi,j(t),i∈I,j∈J}。

2 系統(tǒng)性能分析

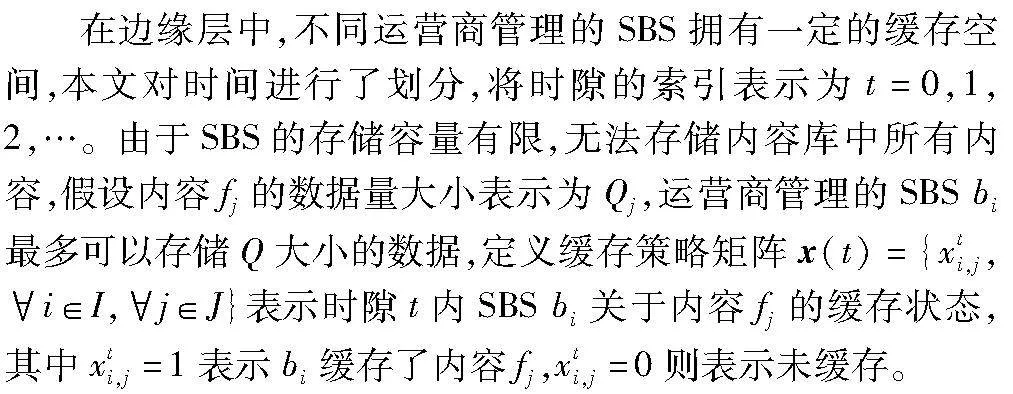

2.1 傳輸時延分析

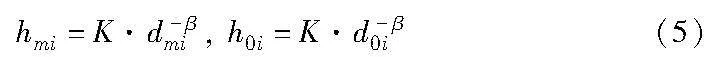

假設SBS和MBS的信道帶寬分別為w和w0,發(fā)射功率分別為q和q0,MBS到bi的距離為d0i。則bm到bi的信道增益和MBS到bi的信道增益分別為

其中:常數(shù)K為固定傳輸損耗;β為路徑損耗因子。由香農公式可得bm到bi的傳輸速率以及MBS到bi的傳輸速率,分別為

因此,bm向bi傳輸內容fj與MBS向bi傳輸內容fj所產生的傳輸時延分別為

a)當用戶向bi請求內容fj時,bi會先在本地進行查找,若本地緩存命中,則直接進行內容交付。由于本地基站到用戶的傳輸時延總是存在且很小,記傳輸時延Dloc(t)=0。

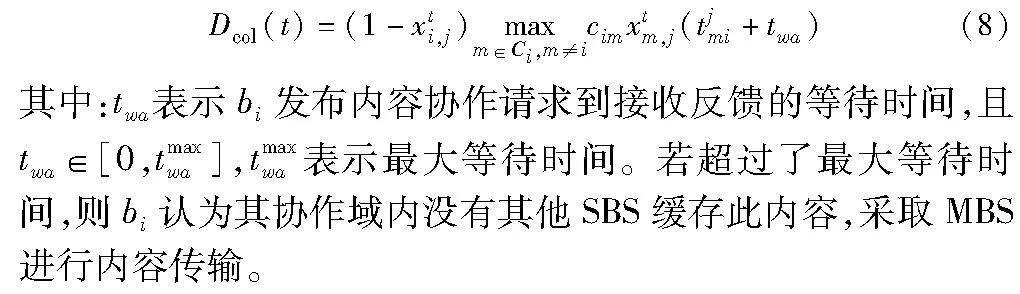

b)當bi沒有緩存內容fj,但是其協(xié)作域Ci內有SBS bm緩存了該內容,此時采取協(xié)作內容交付。由于協(xié)作的SBS相較于MBS在地理位置上離用戶更近,能夠有效降低傳輸時延,所以將SBS bm緩存內容fj對bi的傳輸時延表示為

c)如果本地及協(xié)作域內均沒有SBS緩存內容fj時,此時采取MBS進行內容交付,此時傳輸時延表示為

綜上所述,考慮到不同運營商管理的SBS以及不同內容大小,用戶平均傳輸時延的表達式為

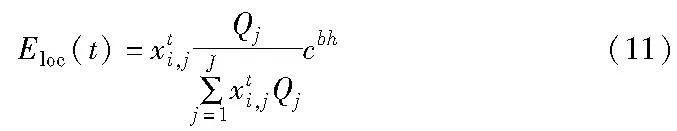

2.2 緩存收益分析

a)當SBS bi收到本地用戶對內容fj的請求,如果本地緩存命中,將直接通過無線鏈路為用戶提供服務;否則,bi需要從MBS處通過回程鏈路獲取內容。本文將本地緩存所節(jié)省的回程傳輸成本作為本地緩存收益,表示為

其中:cbh表示從MBS處獲取內容所產生的回程鏈路成本。

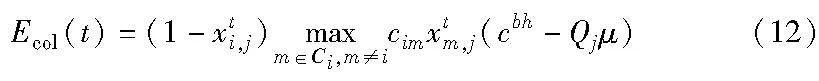

b)當SBS bi沒有緩存內容fj,但其協(xié)作域Ci內有SBS bm緩存了該內容,此時采用協(xié)作內容交付。盡管必須承擔內容費用,但合作的SBS相較于MBS在地理位置上距離用戶更近,也能有效降低從回程資源有限的MBS中獲取內容所帶來的開銷,故采取協(xié)作內容傳輸?shù)氖找姹硎緸?/p>

其中:μ為單位內容請求所需支付的費用。

c)當bi及其協(xié)作域中均沒有SBS緩存內容fj,采用MBS進行內容傳輸,會消耗額外的回程開銷,此時收益Enc(t)=0。

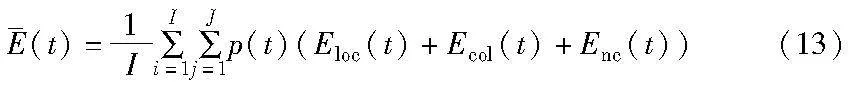

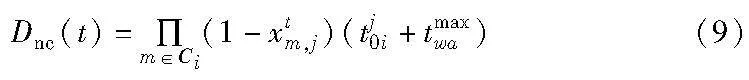

因此,運營商平均緩存收益的表達式為

3 基于A3C的內容緩存算法

3.1 優(yōu)化問題建模

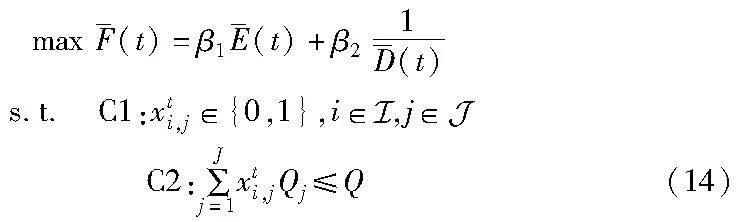

由于差異化的需求常常導致不同的性能指標,如運營商緩存收益最大化、用戶傳輸時延最小化等。這些性能指標相互沖突,一個指標的提升往往會導致另一個指標性能的下降。為了滿足實際通信場景中差異化的通信需求,需要綜合考慮這些性能指標。因此,在滿足不同內容大小、SBS的容量限制的條件下,基于第2章的分析,本文提出了緩存收益最大化與傳輸時延最小化的優(yōu)化問題,并通過線性加權法進行整合,表示為

其中:β1和β2分別為目標函數(shù)的加權系數(shù),且β1+β2=1;約束條件C1表明緩存決策變量是具有離散特性的0-1變量;約束條件C2確保SBS緩存內容大小不超過容量限制。由于式(14)優(yōu)化問題屬于NP-hard[22],利用傳統(tǒng)算法可能很難解決問題。為解決高維度大規(guī)模動作空間中的MDP問題,本文利用基于A3C的內容緩存算法來獲得收益最大且時延最小的最優(yōu)緩存策略。

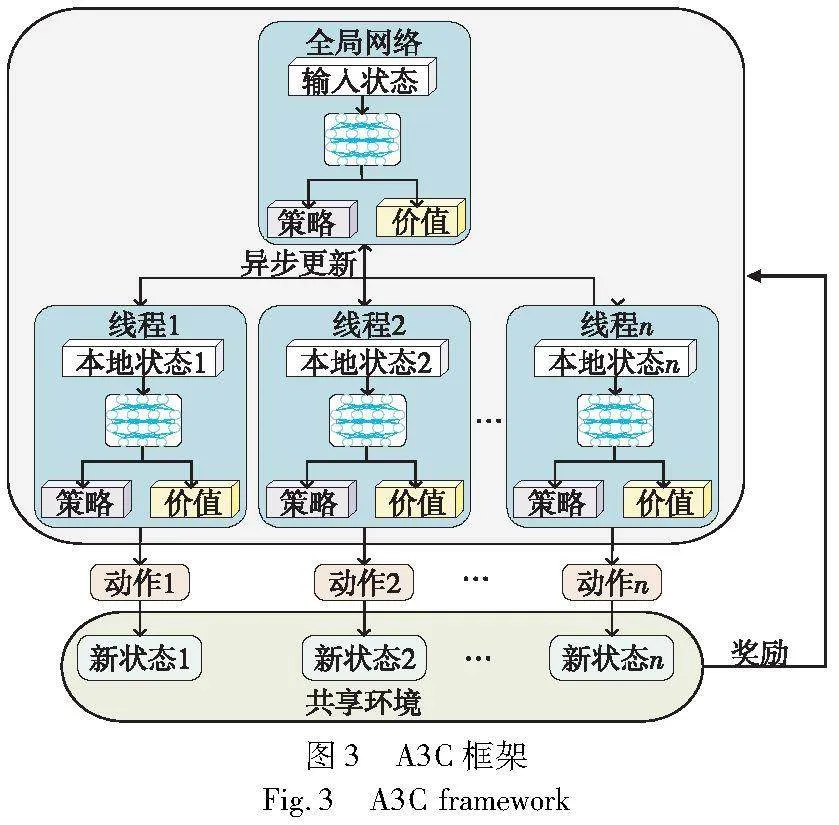

3.2 A3C算法概述

在actor-critic(AC)框架中,智能體由單個actor-critic組成,代理通過狀態(tài)、動作與環(huán)境進行交互,以最大化折扣獎勵。在每一時隙中,actor網絡使用當前策略在當前狀態(tài)下執(zhí)行動作,并將獎勵返回給critic網絡。

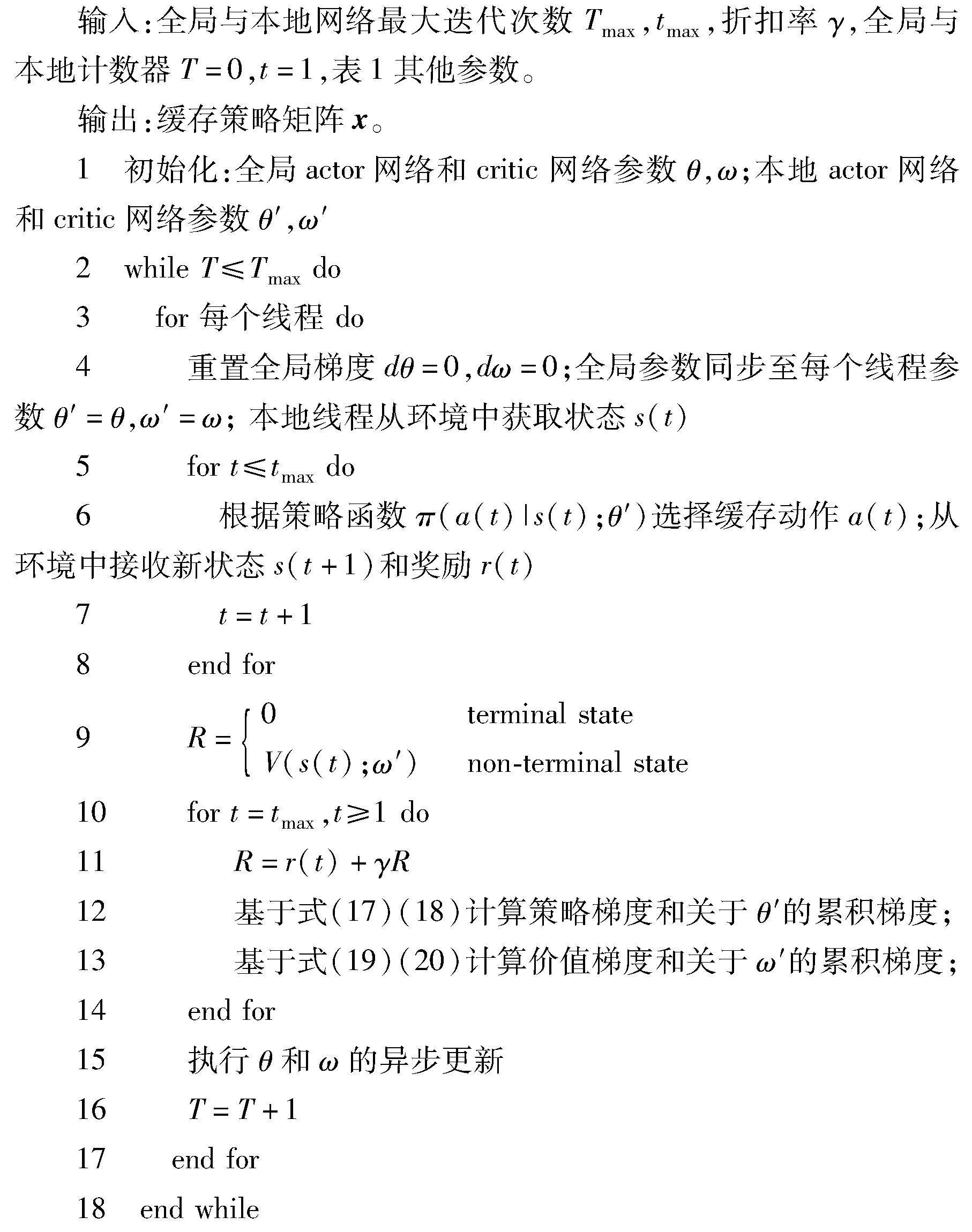

A3C算法是在AC算法的基礎上提出的,采用了異步訓練的思想[23],通過將actor-critic放在多線程中進行同步訓練,能夠顯著提高訓練效率和收斂速度。如圖3所示,具體地,A3C算法通過一個全局網絡創(chuàng)建多個線程和環(huán)境,每個線程充當隨機探索的代理。全局網絡和線程網絡具有相同的結構,都是actor-critic網絡。actor-critic網絡使用兩個深度神經網絡,分別用于改進策略函數(shù)和估計價值函數(shù)。全局網絡無須訓練,僅用于存儲參數(shù),多個代理與其環(huán)境交互以并行學習和計算策略梯度。然后,每個線程將運行結果反饋給全局網絡,并從全局網絡獲取最新的參數(shù)更新,以指導自己與系統(tǒng)環(huán)境之間的下一次學習交互。通過在多個環(huán)境中并行運算多個線程,其生成的數(shù)據(jù)具有多樣性,打破了數(shù)據(jù)之間的相關性,提升了網絡在訓練過程中的穩(wěn)定性。由于多個線程的工作原理相同,所以以一個線程內的網絡訓練過程為例來說明所提出的緩存策略。

3.3 使用A3C算法求解緩存策略

本文將每個線程的狀態(tài)空間、動作空間和獎勵函數(shù)定義如下:

a)狀態(tài)空間。狀態(tài)空間定義為集合s(t)={x(t),p(t)},其中:x(t)表示在時隙t內不同運營商的SBS對不同內容的緩存狀態(tài),p(t)表示時隙t內容流行度分布。

b)動作空間。動作空間定義為集合a(t)={ai,j(t),i∈I,j∈J},其中a(t)是時隙t處的二進制緩存動作向量,即表示時隙t處緩存刷新階段執(zhí)行的動作,ai,j(t)=1表示在時隙t+1處內容fj應存儲在bi上。

c)獎勵函數(shù)。因為目標是通過為流行內容選擇最佳緩存位置來最大化緩存收益,同時最小化傳輸時延,所以即時獎勵函數(shù)定義為組合后的單目標優(yōu)化函數(shù),表示為r(t)=(t)。

基于A3C的聯(lián)盟鏈邊緣緩存的訓練過程描述如下:

a)actor進程:actor網絡的任務是引導SBS選擇并執(zhí)行相應的緩存動作。在每個時隙t,通過輸入當前狀態(tài)s(t),在不超過SBS容量限制的情況下輸出當前策略函數(shù)π(a(t)|s(t);θ′),并根據(jù)該函數(shù)選擇合適的緩存內容的位置。在SBS執(zhí)行當前動作a(t)后,狀態(tài)將從s(t)轉移到s(t+1),SBS獲得即時獎勵r(t)。最后,SBS將(s(t),a(t),r(t),s(t+1))存入緩沖區(qū),重復執(zhí)行上述過程,直到動作執(zhí)行完tmax步。

b)critic進程:critic網絡的任務是提供更準確的價值函數(shù)估計。通過輸入當前狀態(tài)s(t),輸出當前價值函數(shù)V(s(t);ω′),并評估從actor網絡中獲得的策略,以便SBS學習到最優(yōu)的緩存策略。

在actor-critic網絡的每個線程執(zhí)行完所有步驟后,開始使用梯度算法計算網絡參數(shù),并將其梯度信息發(fā)送到全局網絡。在所有異步線程完成后,全局網絡根據(jù)累積的梯度信息更新網絡參數(shù)。此外,更新的參數(shù)將被發(fā)送到每個SBS以加速學習進度。該過程以迭代方式重復,在全局網絡執(zhí)行Tmax后結束。最后,全局網絡將選擇長期獎勵最大的緩存方案。

c)梯度更新:A3C算法使用tmax步獎勵來同時更新策略和價值網絡,使函數(shù)變化更快,加快學習速度。定義優(yōu)勢函數(shù)At以減少估計的方差,作為所選行動的評價標準。通過式(15)計算。

A(s(t),a(t))=Q(s(t),a(t))-V(s(t))(15)

其中:V(s(t))是從critic網絡的輸出中獲得的價值函數(shù);Q(s(t),a(t))表示在時隙t內采取行動的長期折扣累積獎勵,可以計算為

其中:n是tmax的上界,在采取tmax動作之后或達到最終狀態(tài)時更新策略和價值函數(shù);γ是提供當前獎勵和未來獎勵之間權衡的折扣率。

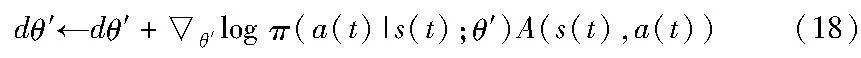

actor網絡定義了帶參數(shù)θ′的策略函數(shù)π(a(t)|s(t);θ′),損失函數(shù)定義為

LA=log π(a(t)|s(t);θ′)A(s(t),a(t))(17)

采用梯度上升算法更新actor網絡的參數(shù),表示為

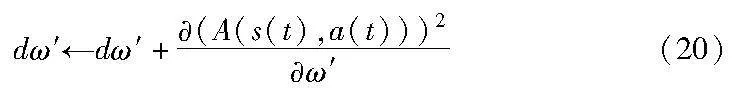

同理,critic網絡定義了帶參數(shù)ω′的價值函數(shù)V(s(t);ω′),其損失函數(shù)為

LC=(A(s(t),a(t)))2(19)

利用梯度下降算法更新critic網絡的參數(shù),表示為

最后,算法1總結了所提基于A3C的內容緩存算法的詳細過程,將算法1得到的最終緩存方案與式(10)(13)結合可得平均緩存收益和平均傳輸時延。

算法1 基于A3C的內容緩存算法

4 仿真分析

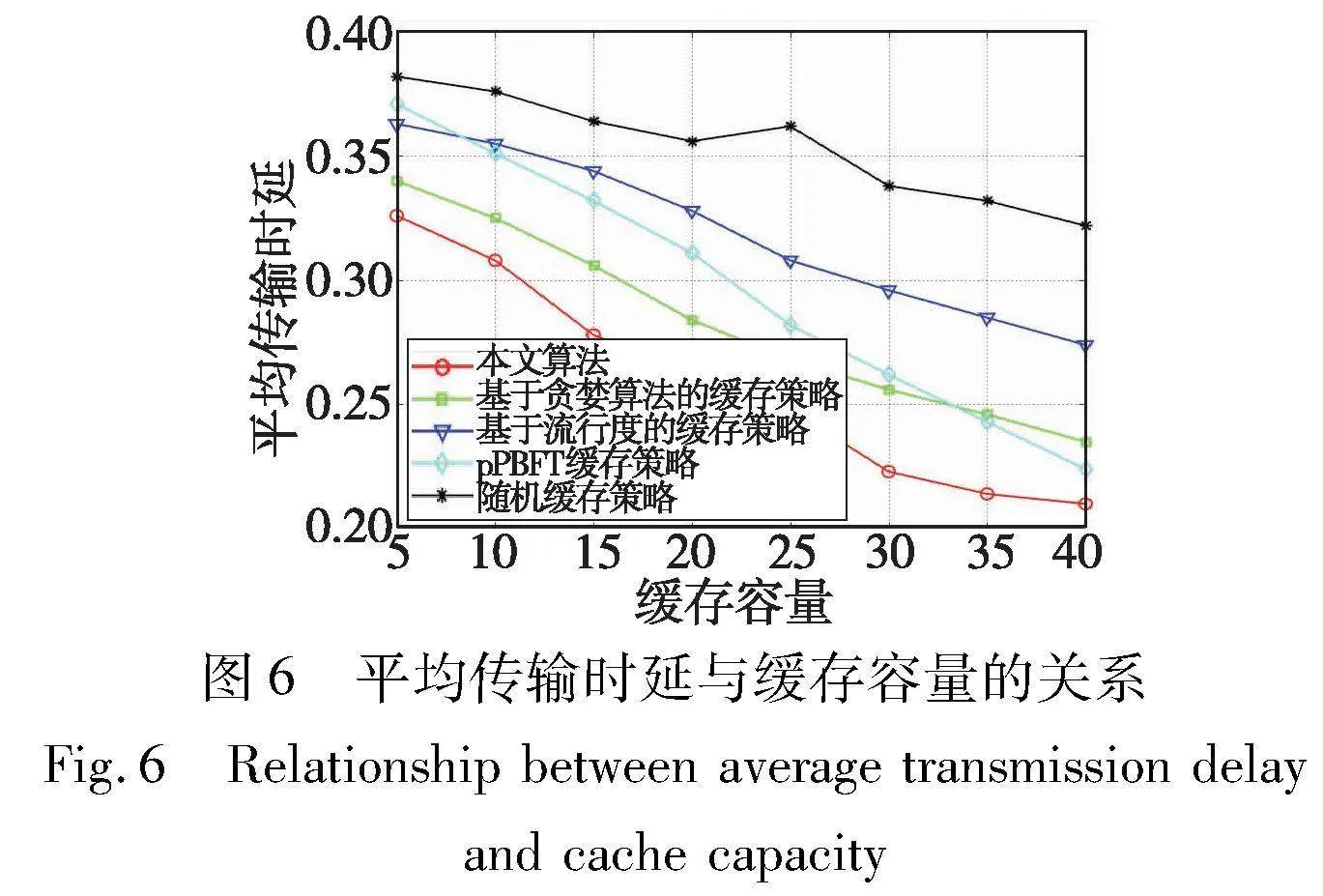

為了驗證所提策略的性能,與現(xiàn)有的緩存策略進行分析對比[24],其中包括基于貪婪算法的緩存策略[25]、基于流行度的緩存策略和隨機緩存策略。其中,文獻[25]提出的基于貪婪算法的緩存策略在SBS的有限緩存空間下根據(jù)目標函數(shù)盡可能多地緩存流行內容;基于流行度的緩存策略中,SBS根據(jù)內容流行度的排序依次緩存,最終用盡緩存空間;在隨機緩存策略中,SBS在緩存空間的約束下隨機緩存內容。

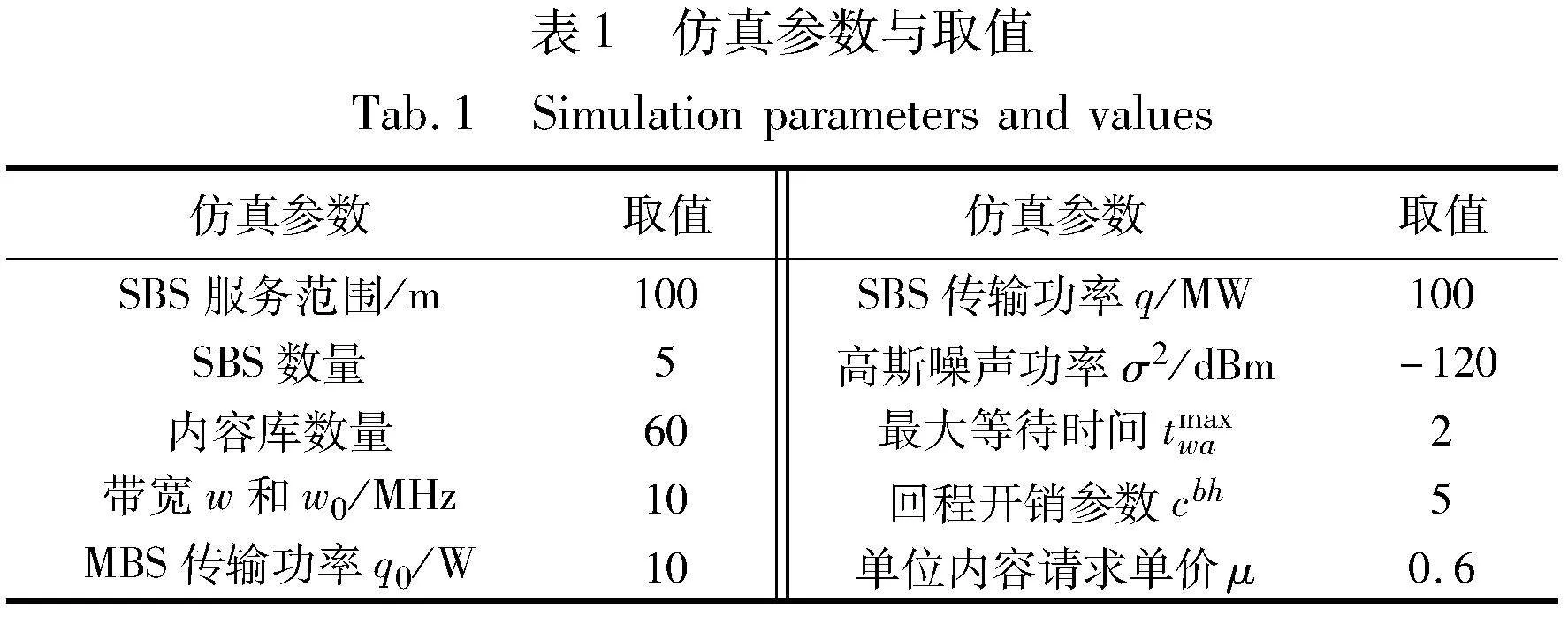

為簡化計算量,將內容數(shù)據(jù)量進行歸一化處理,從{1Q0,2Q0,3Q0,4Q0,5Q0}中隨機選擇,Zipf分布指數(shù)αi,t在每個時隙[0.6,1.2]隨機變化。將actor和critic網絡的學習率分別設置為0.000 1和0.01[26],為了協(xié)調運營商收益和用戶傳輸時延的重要程度,利用熵權法按指標提供信息量大小設置即時獎勵權重β1=0.7和β2=0.3,其余仿真參數(shù)如表1所示[17,27~29]。

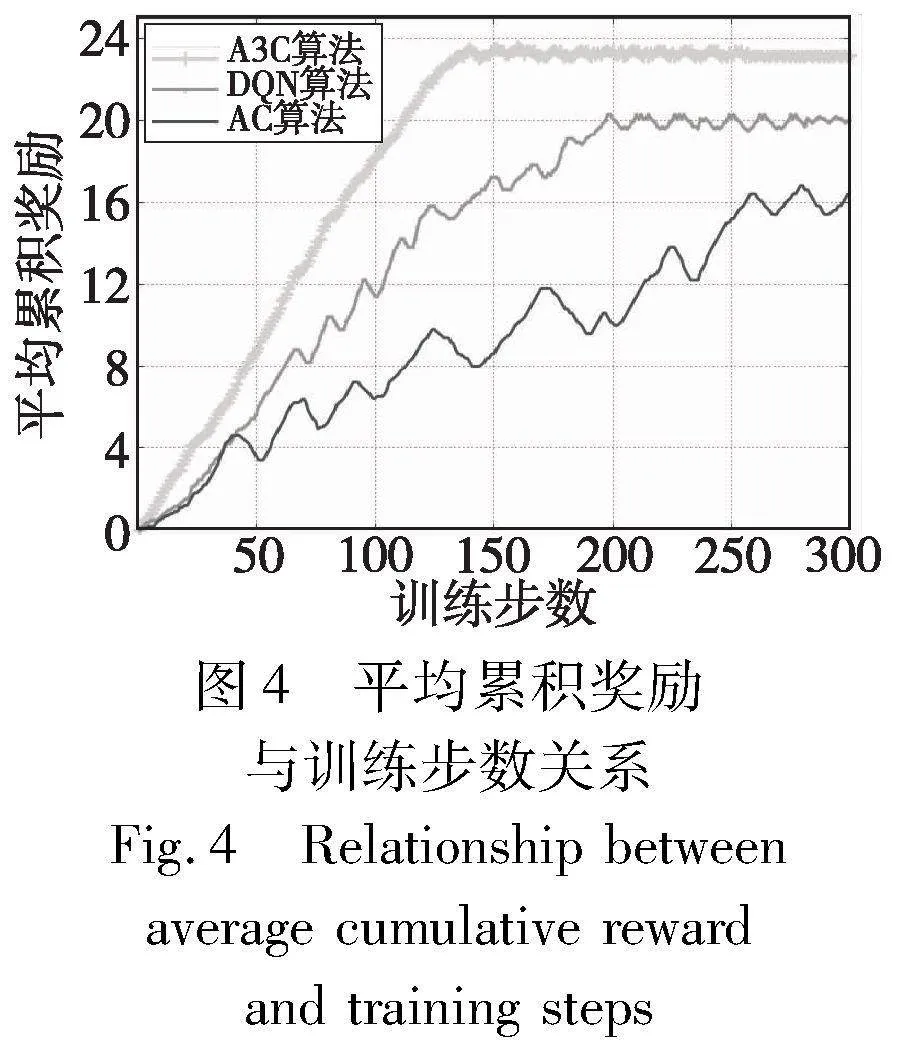

圖4表示本文算法和其他兩種基準算法之間平均累計獎勵的性能比較。可以看出,DQN和AC的累計獎勵均低于A3C,并且A3C的性能更穩(wěn)定,收斂速度更快。這是因為A3C采用異步機制,即采用多線程并行探索,有助于快速發(fā)現(xiàn)未知的動作和狀態(tài),從而極大提高了學習效率。

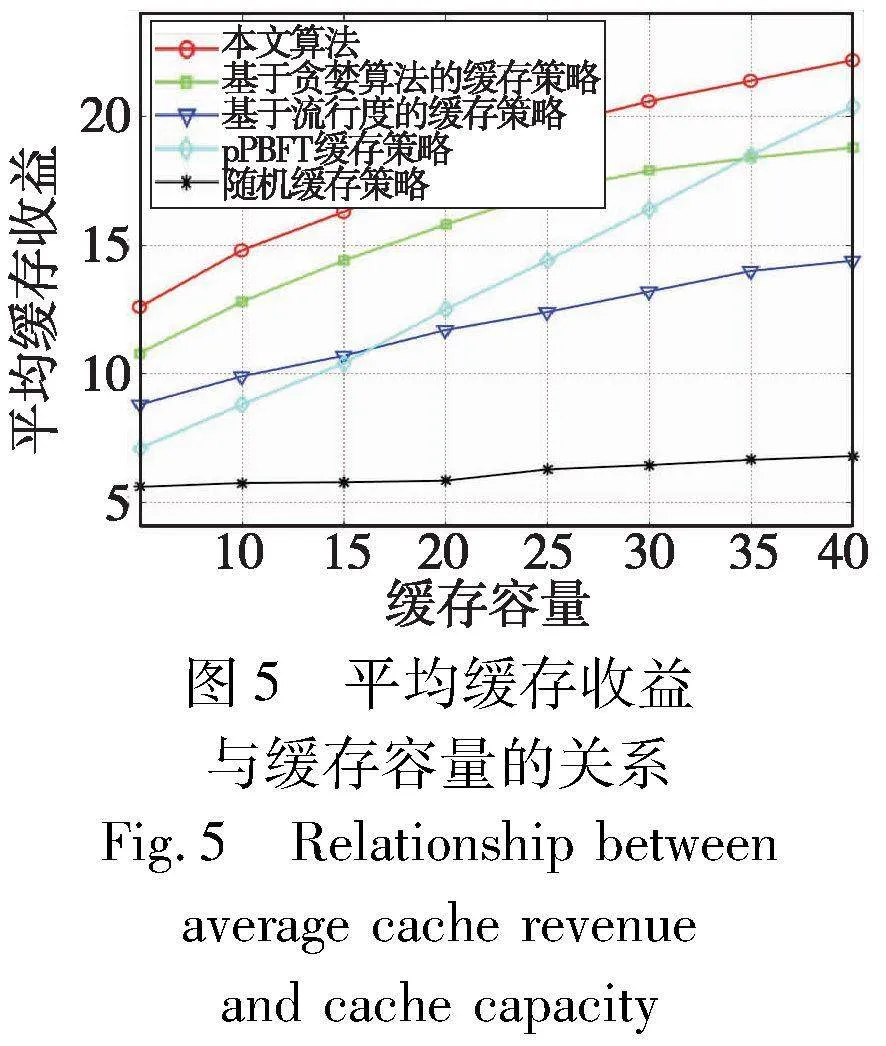

圖5描述了不同容量下SBS平均緩存收益比較,從圖上可以看出,隨著緩存容量的增加,緩存收益呈現(xiàn)增長的趨勢,但增長的速度會逐漸下降。這是因為隨著SBS緩存容量的增加,更多的內容能夠緩存在SBS上,使得收益增加,隨著本地緩存的內容越來越多,其需要通過聯(lián)盟鏈進行內容共享的概率也會隨之降低,進而緩存收益中通過內容共享獲取到的收益會減少,導致收益增長的速度會逐漸下降。對比文獻[16]提出的pPBFT算法,隨著系統(tǒng)容量的增加,pPBFT緩存策略的收益逐漸升高,這是因為pPBFT會重復緩存某些內容,而本文緩存策略考慮內容的時變性不會對內容進行重復緩存,避免了節(jié)點間的惡意競爭。因此,本文基于聯(lián)盟鏈的A3C算法緩存策略帶來的收益明顯優(yōu)于其他四種方案,能夠顯著提高運營商邊緣緩存系統(tǒng)帶來的收益。

圖6描述了SBS不同緩存容量下的用戶平均傳輸時延的比較。由于隨機緩存策略的性能不穩(wěn)定,所以與SBS緩存容量大小不成正比。其中,不同緩存策略的用戶平均傳輸時延均呈下降趨勢,這是因為隨著緩存容量的增加,SBS可以緩存更多的內容,用戶請求的更多內容可以緩存在本地SBS或協(xié)作域SBS中,并且從SBS處獲取內容的延遲比從MBS獲取內容的延遲要小得多,通過MBS傳輸?shù)母怕蕰p少,所以縮短了用戶從MBS處獲取內容的傳輸時延。其次,由于本文算法考慮了SBS之間的協(xié)作,所以基于聯(lián)盟鏈的A3C算法緩存策略的用戶平均時延低于其他四種緩存方案,證明了聯(lián)盟鏈和協(xié)作緩存對于用戶傳輸時延的重要性。可以看出在SBS容量大小受到限制的情況下,本文緩存方案優(yōu)于其他緩存方案,可以降低用戶平均傳輸時延。

5 結束語

本文在基于聯(lián)盟鏈的邊緣緩存系統(tǒng)的緩存策略優(yōu)化方案中同時考慮運營商緩存收益和用戶傳輸時延的影響,改進了基于聯(lián)盟鏈的內容共享交易流程,并綜合考慮動態(tài)內容流行度以及SBS的協(xié)作程度,以最大化運營商緩存收益和最小化用戶傳輸時延為目標建立優(yōu)化問題。考慮到優(yōu)化問題是NP-hard,提出基于A3C求解出最優(yōu)內容緩存策略。仿真結果表明,與其他緩存策略相比,該策略可以提高運營商緩存內容的收益,同時降低用戶傳輸時延。在未來研究中,本文將對聯(lián)盟鏈真實場景進行測試,改進現(xiàn)存的共識算法從而降低系統(tǒng)共識開銷。

參考文獻:

[1]Jiang Wei, Han Bin, Habibi M A, et al. The road towards 6G: a comprehensive survey[J]. IEEE Open Journal of the Communications Society, 2021,2: 334-366.

[2]Sheraz M, Ahmed M, Hou X, et al. Artificial intelligence for wireless caching: schemes, performance, and challenges[J]. IEEE Communications Surveys & Tutorials, 2020, 23(1): 631-661.

[3]Guo Shaoyong, Hu Xing, Guo Song, et al. Blockchain meets edge computing: a distributed and trusted authentication system[J]. IEEE Trans on Industrial Informatics, 2020,16(3): 1972-1983.

[4]You Xiaohu, Wang Chengxiang, Huang Jie, et al. Towards 6G wireless communication networks: vision, enabling technologies, and new paradigm shifts[J]. Science China: Information Sciences, 2021, 64(1): 5-78.

[5]Sun Wen, Li Sheng, Zhang Yan. Edge caching in blockchain empo-wered 6G[J]. China Communications, 2021, 18(1): 1-17.

[6]牛淑芬, 楊平平, 謝亞亞, 等. 區(qū)塊鏈上基于云輔助的密文策略屬性基數(shù)據(jù)共享加密方案[J]. 電子與信息學報, 2021, 43(7): 1864-1871. (Niu Shufen, Yang Pingping, Xie Yaya, et al. Cloud-assisted ciphertext policy attribute base data sharing encryption scheme on blockchain[J]. Journal of Electronics & Information Technology, 2021, 43(7): 1864-1871.)

[7]Davenport A, Shetty S. Air gapped wallet schemes and private key leakage in permissioned blockchain platforms[C]//Proc of IEEE International Conference on Blockchain. Piscataway, NJ: IEEE Press, 2019: 541-545.

[8]Zheng Peilin, Xu Quanqing, Zheng Zibin, et al. Meepo: sharded consortium blockchain[C]//Proc of the 37th International Conference on Data Engineering. Piscataway, NJ: IEEE Press, 2021: 1847-1852.

[9]蔣宇娜, 葛曉虎, 楊旸, 等. 面向 6G 的區(qū)塊鏈物聯(lián)網數(shù)據(jù)共享和存儲機制[J]. 通信學報, 2020,41(10): 48-58. (Jiang Yu’na, Ge Xiaohu, Yang Yang, et al. 6G oriented blockchain based Internet of Things data sharing and storage mechanism[J]. Journal on Communications, 2020, 41(10): 48-58.)

[10]Wang Hongman, Li Yingxue, Zhao Xiaoqi, et al. An algorithm based on Markov chain to improve edge cache hit ratio for blockchain-enabled IoT[J]. China Communications, 2020, 17(9): 66-76.

[11]Liu Jiadi, Guo Songtao, Shi Yawei, et al. Decentralized caching framework toward edge network based on blockchain[J]. IEEE Internet of Things Journal, 2020, 7(9): 9158-9174.

[12]Li Ding, Han Yiwen, Wang Chenyang, et al. Deep reinforcement learning for cooperative edge caching in future mobile networks[C]//Proc of IEEE Wireless Communications and Networking Conference. Piscataway, NJ: IEEE Press, 2019: 1-6.

[13]Chen Mengqi, Wu Guangming, Zhang Yuhuang, et al. Distributed deep reinforcement learning-based content caching in edge computing-enabled blockchain networks[C]//Proc of the 13th International Conference on Wireless Communications and Signal Processing. Pisca-taway, NJ: IEEE Press, 2021: 1-5.

[14]Du Jiangbo, Cheng Wenjie, Lu Guangyue, et al. Resource pricing and allocation in MEC enabled blockchain systems: an A3C deep reinforcement learning approach[J]. IEEE Trans on Network Science and Engineering, 2021, 9(1): 33-44.

[15]Ye Xinyu, Li Meng, Yu F R, et al. MEC and blockchain-enabled energy-efficient Internet of Vehicles based on A3C approach[C]//Proc of IEEE Global Communications Conference. Piscataway, NJ: IEEE Press, 2021: 1-6.

[16]姜靜, 王凱, 許曰強, 等. 基于聯(lián)盟鏈的運營商最佳緩存策略[J]. 電子與信息學報, 2022, 44(9): 3043-3050. (Jiang Jing, Wang Kai, Xu Yueqiang, et al. Optimal caching strategy of operators based on consortium blockchain[J]. Journal of Electronics & Information Technology, 2022, 44(9): 3043-3050.)

[17]楊帆, 姜靜, 杜劍波, 等. 基于聯(lián)盟鏈的邊緣緩存系統(tǒng)收益最大化的緩存策略[J]. 計算機應用研究, 2023, 40(8): 2447-2451,2466. (Yang Fan, Jiang Jing, Du Jianbo, et al. Benefit maximization caching strategy in edge cache system based on consortium blockchain[J]. Application Research of Computers, 2023, 40(8): 2447-2451,2466.)

[18]Xu Qichao, Su Zhou, Yang Qing. Blockchain-based trustworthy edge caching scheme for mobile cyber-physical system[J]. IEEE Internet of Things Journal, 2019, 7(2): 1098-1110.

[19]Preneel B. Cryptographic hash functions[J]. European Trans on Telecommunications, 1994, 5(4): 431-448.

[20]Zhang Ran, Yu F R, Liu Jiang, et al. Deep reinforcement learning(DRL)-based device-to-device(D2D) caching with blockchain and mobile edge computing[J]. IEEE Trans on Wireless Communications, 2020, 19(10): 6469-6485.

[21]Li Qiang, Shi Wennian, Xiao Yong, et al. Content size-aware edge caching: a size-weighted popularity-based approach[C]//Proc of IEEE Global Communications Conference. Piscataway, NJ: IEEE Press, 2018: 206-212.

[22]王蕊, 申敏, 何云, 等. Cell-Free大規(guī)模 MIMO系統(tǒng)中基于傳輸時延的緩存策略研究[J]. 通信學報, 2021, 42(12): 134-143. (Wang Rui, Shen Min, He Yun, et al. Research on caching strategy based on transmission delay in Cell-Free massive MIMO systems[J]. Journal on Communication, 2021, 42(12): 134-143.)

[23]Mnih V, Badia A P, Mirza M, et al. Asynchronous methods for deep reinforcement learning[C]//Proc of the 33rd International Conference on Machine Learning. [S.l.]: PMLR, 2016: 1928-1937.

[24]蔡艷, 吳凡, 朱洪波. D2D 協(xié)作邊緣緩存系統(tǒng)中基于傳輸時延的緩存策略[J]. 通信學報, 2021, 42(3): 183-189. (Cai Yan, Wu Fan, Zhu Hongbo. Caching strategy based on transmission delay for D2D cooperative edge caching system[J]. Journal on Communication, 2021, 42(3): 183-189.)

[25]Banerjee B, Seetharam A, Tellambura C. Greedy caching: a latency-aware caching strategy for information-centric networks[C]//Proc of IFIP Networking Conference and Workshops. Piscataway, NJ: IEEE Press, 2017: 1-9.

[26]Feng Jie, Yu F R, Pei Qingqi, et al. Cooperative computation offloading and resource allocation for blockchain-enabled mobile-edge computing: a deep reinforcement learning approach[J]. IEEE Internet of Things Journal, 2019, 7(7): 6214-6228.

[27]王亞麗, 陳家超, 張俊娜. 移動邊緣計算中收益最大化的緩存協(xié)作策略[J]. 計算機應用, 2022, 42(11): 3479-3485. (Wang Yali, Chen Jiachao, Zhang Junna. Cache cooperation strategy for maximizing revenue in mobile edge computing[J]. Journal of Computer Applications, 2022, 42(11): 3479-3485.)

[28]黃永明, 鄭沖, 張征明, 等. 大規(guī)模無線通信網絡移動邊緣計算和緩存研究[J]. 通信學報, 2021, 42(4): 44-61. (Huang Yongming, Zheng Chong, Zhang Zhengming, et al. Research on mobile edge computing and caching in massive wireless communication network[J]. Journal on Communications, 2021, 42(4): 44-61.)

[29]左亞兵, 王凱, 楊帆, 等. 基于用戶偏好的協(xié)作內容緩存策略[J]. 計算機應用研究, 2022, 39(1): 123-127. (Zuo Yabing, Wang Kai, Yang Fan, et al. Collaborative content caching strategy based on user preferences[J]. Application Research of Compu-ters, 2022, 39(1): 123-127.)