面向神經(jīng)輻射場(chǎng)的水印算法

摘 要:針對(duì)隱式表示的3D模型的版權(quán)保護(hù)問(wèn)題,提出了一種面向神經(jīng)輻射場(chǎng)(NeRF)的水印算法。該算法通過(guò)嵌入網(wǎng)絡(luò)對(duì)訓(xùn)練集中的圖像嵌入水印,再利用NeRF模型進(jìn)行3D模型建模。版權(quán)驗(yàn)證方通過(guò)給定一個(gè)秘密視角作為神經(jīng)輻射場(chǎng)的輸入,生成新視角下的圖像作為后門(mén)圖像,接著利用神經(jīng)網(wǎng)絡(luò)的過(guò)參數(shù)化方法設(shè)計(jì)一個(gè)水印提取器,獲取該視角下嵌入的水印圖像。在黑盒場(chǎng)景下,一旦懷疑3D模型被未經(jīng)授權(quán)地使用,驗(yàn)證方則可以通過(guò)秘密視角提取水印以驗(yàn)證網(wǎng)絡(luò)版權(quán)。實(shí)驗(yàn)結(jié)果表明,所提算法提取水印不僅具有良好的視覺(jué)效果,而且對(duì)不同類(lèi)型的噪聲攻擊具有較好的抵抗能力。

關(guān)鍵詞:神經(jīng)輻射場(chǎng);3D水印;魯棒性;黑盒水印

中圖分類(lèi)號(hào):TP309.2 文獻(xiàn)標(biāo)志碼:A 文章編號(hào):1001-3695(2024)07-037-2184-05

doi: 10.19734/j.issn.1001-3695.2023.11.0571

Watermarking for neural radiance field

Abstract:This paper proposed a watermarking algorithm for neural radiance fields(NeRF) to address the copyright protection issue of implicit 3D models. The algorithm embedded watermarks into the images in the training set through an embedding network, and then utilized the NeRF model for 3D model modeling. It generated a backdoor image by the copyright verifier from a new perspective by providing a secret perspective as input to the neural radiation field. Subsequently, it designed a watermark extractor using the hyperparameterization method of the neural network to obtain the embedded watermark image from that perspective. In a black box scenario, once there was suspicion of unauthorized use of the 3D model, the verifier could extract watermarks from a secret perspective to verify network copyright. The experimental results demonstrate that the proposed algorithm not only yields good visual effects when extracting watermarks, but also exhibits robust resistance to different types of noise attacks.

Key words:neural radiation field; 3D watermark; robustness; black box watermark

0 引言

隱式神經(jīng)表示是一種對(duì)圖像、聲音、文字等信號(hào)進(jìn)行參數(shù)化的方法[1]。在真實(shí)世界中,模擬信號(hào)本可以用一個(gè)連續(xù)的函數(shù)來(lái)表示,但由于無(wú)法得知這個(gè)連續(xù)函數(shù)準(zhǔn)確的表達(dá)形式,所以可考慮用神經(jīng)網(wǎng)絡(luò)來(lái)逼近這個(gè)連續(xù)函數(shù)以表示信號(hào)本身。2020年,Mildenhall等人[2]首次提出了神經(jīng)輻射場(chǎng)(NeRF)的概念,采用多層感知機(jī)(MLP)對(duì)3D場(chǎng)景進(jìn)行隱式表示,通過(guò)對(duì)3D模型進(jìn)行渲染生成2D圖像,實(shí)現(xiàn)了新視角的合成。基于隱式表示的3D渲染技術(shù)目前已經(jīng)成為計(jì)算機(jī)視覺(jué)研究最熱門(mén)的領(lǐng)域之一。可以預(yù)測(cè),在不遠(yuǎn)的將來(lái),人們像分享2D圖像和視頻一樣,在網(wǎng)上分享3D內(nèi)容,保護(hù)隱式表示的3D數(shù)據(jù)必將成為未來(lái)的一個(gè)重要課題。

現(xiàn)有3D模型的版權(quán)保護(hù)方法通常分為通過(guò)函數(shù)變換的方法對(duì)3D網(wǎng)格模型嵌入水印[3~7]、修改3D模型參數(shù)嵌入水印[8]和運(yùn)用深度學(xué)習(xí)技術(shù)嵌入水印[9~11]三類(lèi)。但與傳統(tǒng)的3D模型不同,神經(jīng)輻射場(chǎng)是表示三維場(chǎng)景中每個(gè)點(diǎn)的顏色和密度的函數(shù),沒(méi)有具體可見(jiàn)的3D模型和3D模型參數(shù)等數(shù)據(jù),因此無(wú)法對(duì)3D形狀進(jìn)行平移、旋轉(zhuǎn)或在3D模型參數(shù)中嵌入水印,且神經(jīng)輻射場(chǎng)通過(guò)MLP網(wǎng)絡(luò)結(jié)構(gòu)訓(xùn)練得到,調(diào)整網(wǎng)絡(luò)結(jié)構(gòu)嵌入水印會(huì)影響3D渲染的效果。

NeRF表示的3D模型以神經(jīng)網(wǎng)絡(luò)的形式呈現(xiàn)。一些研究人員已經(jīng)開(kāi)展了針對(duì)神經(jīng)網(wǎng)絡(luò)形式數(shù)據(jù)的版權(quán)保護(hù)研究,即神經(jīng)網(wǎng)絡(luò)水印[12~23]。但以上神經(jīng)網(wǎng)絡(luò)水印通常將神經(jīng)網(wǎng)絡(luò)看作是一種數(shù)據(jù)處理工具,它保護(hù)的是工具本身,而在隱式表示的場(chǎng)景下,神經(jīng)網(wǎng)絡(luò)其實(shí)就是數(shù)據(jù)本身,保護(hù)神經(jīng)網(wǎng)絡(luò)就是保護(hù)數(shù)據(jù)。2022年,Li等人[24]首次建立了信息隱藏與NeRF之間的聯(lián)系,提出了StegaNeRF方案用于信息隱藏。該方案首先訓(xùn)練一個(gè)標(biāo)準(zhǔn)的NeRF模型,然后將該NeRF模型看作是一個(gè)新視角生成器,訓(xùn)練消息提取網(wǎng)絡(luò)的同時(shí)對(duì)NeRF網(wǎng)絡(luò)進(jìn)行二次訓(xùn)練,以保證從新的StegaNeRF網(wǎng)絡(luò)中渲染的2D圖像能夠準(zhǔn)確提取消息,但該方案需要對(duì)模型進(jìn)行二次訓(xùn)練,訓(xùn)練時(shí)間較長(zhǎng),且未充分考慮噪聲攻擊的問(wèn)題,不具有魯棒性。2023年,Luo等人[25]提出了CopyRNeRF方案,用水印的顏色表示代替NeRF中原有的顏色表示來(lái)保護(hù)NeRF模型的版權(quán)。該方法可以直接保護(hù)NeRF模型的版權(quán),同時(shí)保持較高的渲染質(zhì)量和比特精度,但此方案仍需要二次訓(xùn)練NeRF模型,且提取水印質(zhì)量不高。

為解決訓(xùn)練速度慢、提取水印圖像質(zhì)量不高的問(wèn)題,本文提出了一種新的面向NeRF的水印方案。該方案首先通過(guò)嵌入網(wǎng)絡(luò)對(duì)訓(xùn)練集中的圖像嵌入水印;接著,利用NeRF模型進(jìn)行3D模型建模;版權(quán)驗(yàn)證方通過(guò)給定一個(gè)秘密視角作為神經(jīng)輻射場(chǎng)的輸入,生成視角下的圖像作為后門(mén)圖像;接著利用神經(jīng)網(wǎng)絡(luò)的過(guò)參數(shù)化方法來(lái)設(shè)計(jì)一個(gè)水印提取器,以獲得該視角下嵌入的水印。在黑盒場(chǎng)景下,一旦懷疑3D模型的版權(quán)受到侵犯,版權(quán)驗(yàn)證方則可以通過(guò)秘密視角提取水印信息以驗(yàn)證模型的版權(quán)。與StegaNeRF相比,本文方法無(wú)須對(duì)NeRF進(jìn)行二次訓(xùn)練,保證了3D模型渲染圖像的質(zhì)量。

1 本文方法

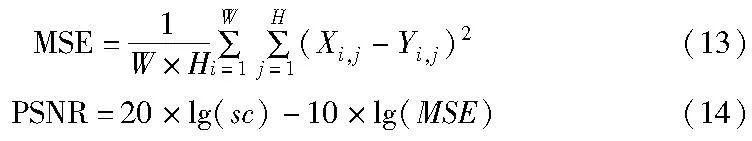

1.1 應(yīng)用場(chǎng)景

面向神經(jīng)輻射場(chǎng)水印的典型使用場(chǎng)景如下:

a)Alice獲取了一些3D場(chǎng)景的圖像;

b)Alice在圖像中嵌入水印并生成NeRF模型N;

c)Alice在網(wǎng)上分享模型N供他人欣賞自己的3D場(chǎng)景;

d)Bob獲取了模型N,且未經(jīng)過(guò)Alice允許以自己的名義發(fā)布到網(wǎng)絡(luò);

e)Alice看到了Bob發(fā)布的模型N,通過(guò)密鑰m提取水印,驗(yàn)證Alice是模型N的主人,而不是Bob;

f)Bob侵犯版權(quán),需要撤回發(fā)布。

應(yīng)用場(chǎng)景的具體流程如圖1所示。

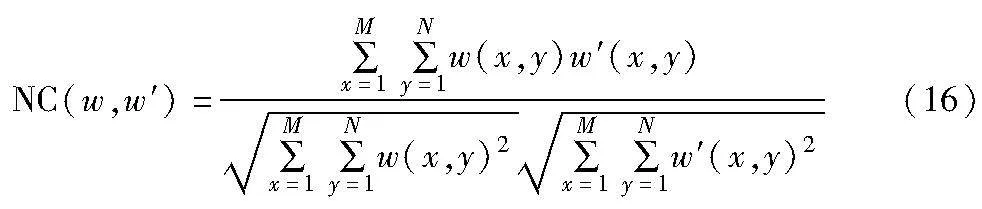

1.2 算法總體框架

本文提出了一種面向神經(jīng)輻射場(chǎng)的水印算法,算法的總體框架如圖2所示。主要有嵌入網(wǎng)絡(luò)E、噪聲層P、神經(jīng)輻射場(chǎng)N和提取網(wǎng)絡(luò)D四部分組成。嵌入網(wǎng)絡(luò)E接受水印圖像w和NeRF訓(xùn)練數(shù)據(jù)集中的一張圖像k作為輸入,輸出嵌入水印信息的圖像k′,再將k′和lego數(shù)據(jù)集中圖像1到i經(jīng)過(guò)噪聲層處理與對(duì)應(yīng)視角信息一起輸入到MLP網(wǎng)絡(luò)M中訓(xùn)練得到神經(jīng)輻射場(chǎng)N,再給N一個(gè)秘密視角m生成新視角圖像s,最后用過(guò)參數(shù)化的方法訓(xùn)練一個(gè)提取網(wǎng)絡(luò)D,以圖像s作為輸入,輸出水印圖像w′。在版權(quán)驗(yàn)證時(shí),若使用的視角為訓(xùn)練時(shí)使用的秘密視角m,則可以提取到清晰的水印圖像w′;否則無(wú)法提取到水印圖像,以此證明神經(jīng)輻射場(chǎng)數(shù)據(jù)的所有權(quán)。

1.3 神經(jīng)輻射場(chǎng)

神經(jīng)輻射場(chǎng)是一種用于生成3D場(chǎng)景的技術(shù),通過(guò)神經(jīng)網(wǎng)絡(luò)模型,構(gòu)建像素空間到場(chǎng)景空間的映射來(lái)預(yù)測(cè)場(chǎng)景的輻射傳輸。NeRF中輸入空間點(diǎn)的3D坐標(biāo)位置x=(x,y,z)和方向d=(θ,φ),輸出空間點(diǎn)的顏色c=(r,g,b)和對(duì)應(yīng)位置(體素)的密度σ。在具體的實(shí)現(xiàn)中,先對(duì)x和d進(jìn)行位置信息編碼,再將x輸入到MLP網(wǎng)絡(luò)中,并輸出σ和一個(gè)256維的中間特征,中間特征和d再一起輸入到全連接層中預(yù)測(cè)顏色,最后通過(guò)體渲染生成2D圖像。

體渲染實(shí)質(zhì)上是一個(gè)三維到二維的建模過(guò)程,利用三維重建得到的3D點(diǎn)的像素值c和體密度σ,沿著觀測(cè)方向上的一條射線進(jìn)行像素點(diǎn)采樣加權(quán)疊加,得到最終的2D圖像像素值,如式(1)所示。

1.4 密鑰

本文采用后門(mén)水印[26]的思想,使用相機(jī)參數(shù)m作為密鑰,輸入到生成的NeRF中來(lái)獲取新視角圖像s。由于可選的視角有無(wú)窮多個(gè),密鑰空間為無(wú)窮大,保證了本文算法的安全性。

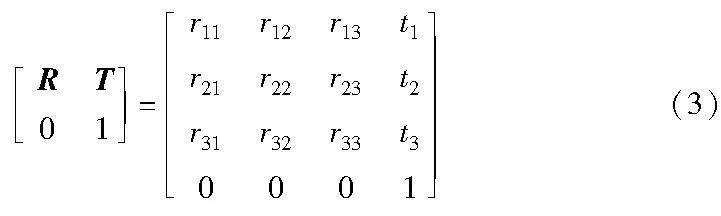

相機(jī)參數(shù)分為內(nèi)參和外參,相機(jī)外參決定相機(jī)的位置和朝向,作用是把相機(jī)坐標(biāo)系下的點(diǎn)變換到世界坐標(biāo)系下。相機(jī)內(nèi)參決定投影屬性,作用是將相機(jī)坐標(biāo)系下的3D坐標(biāo)映射到2D的圖像平面。外參矩陣是一個(gè)4×4的矩陣,左上角3×3大小的向量是旋轉(zhuǎn)矩陣R,右上角的3×1大小的向量是平移向量T,矩陣如式(3)所示。

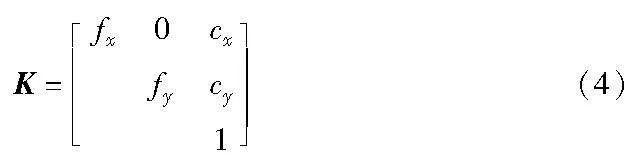

內(nèi)參矩陣是一個(gè)3×3的矩陣,以針孔相機(jī)為例,相機(jī)的內(nèi)參矩陣K如式(4)所示。

內(nèi)參矩陣K中,fx和fy是相機(jī)的水平和垂直焦距,cx和cy是圖像原點(diǎn)相對(duì)于相機(jī)光心的水平和垂直偏移量。內(nèi)參和外參矩陣的唯一性確保了生成新視角圖像的唯一,且密鑰信息較小,便于版權(quán)保護(hù)方的使用和管理。

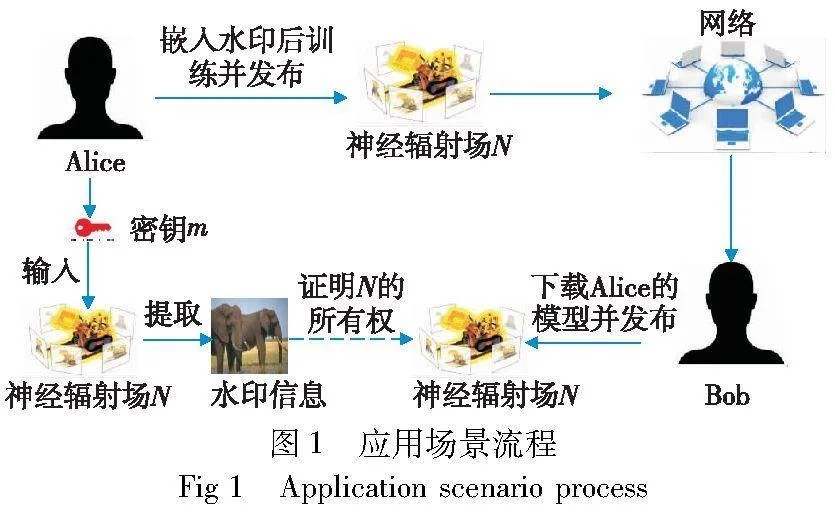

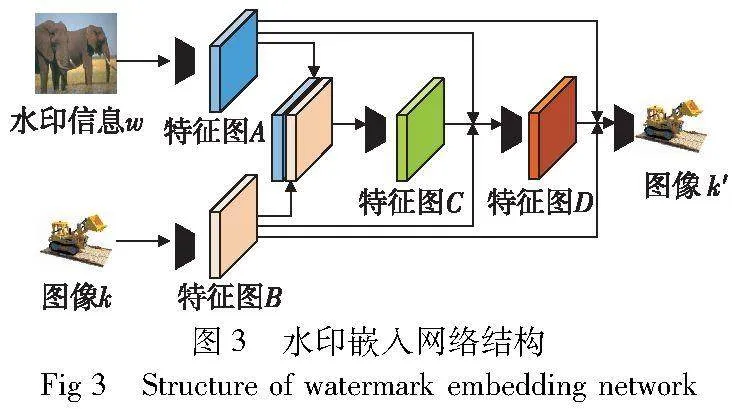

1.5 嵌入網(wǎng)絡(luò)

嵌入網(wǎng)絡(luò)E輸入尺寸大小為3×W×H的水印圖像w和lego數(shù)據(jù)集中的圖像k,將水印圖像w經(jīng)過(guò)一個(gè)輸出通道為32的卷積層conv,得到尺寸大小為32×W×H的特征圖A,將圖像k經(jīng)過(guò)一個(gè)輸出通道為32的卷積層conv,得到尺寸大小為32×W×H的特征圖B,再將特征圖A和B進(jìn)行拼接后經(jīng)過(guò)輸出通道數(shù)為32的卷積層,得到特征圖C。

為充分提取圖像特征,在提取網(wǎng)絡(luò)中采用了密集連接技術(shù),通過(guò)密集連接加強(qiáng)特征的傳遞,增強(qiáng)嵌入網(wǎng)絡(luò)對(duì)圖像深層次特征的提取能力,依次將A、B和C進(jìn)行拼接,經(jīng)過(guò)卷積層得到特征圖D。

D=conv32+32+32→32(cat(A,B,C))(6)

最后將A、B、C和D拼接經(jīng)過(guò)輸出通道為3的卷積層,輸出與圖像k一樣大小的圖像k′。

k′=conv32+32+32+32→3(cat(A,B,C,D))(7)

嵌入網(wǎng)絡(luò)中,卷積核大小為3×3,步長(zhǎng)為1,填充為1,使用ReLU作為激活函數(shù)再使用BN(batch normalization)層對(duì)數(shù)據(jù)進(jìn)行歸一化處理。嵌入網(wǎng)絡(luò)結(jié)構(gòu)如圖3所示。

1.6 噪聲層

神經(jīng)輻射場(chǎng)在遭受噪聲攻擊后,會(huì)使秘密視角下生成的圖像失真,為使本文方法具有魯棒性,引入了噪聲層對(duì)模型進(jìn)行處理。與直接對(duì)模型數(shù)據(jù)添加噪聲的方式不同,本文采用對(duì)模型的輸入添加噪聲來(lái)模擬NeRF受到噪聲攻擊的過(guò)程。本文設(shè)置了高斯噪聲、椒鹽噪聲、speckle噪聲、泊松噪聲以模擬不同類(lèi)型的失真。

1.7 提取網(wǎng)絡(luò)

提取網(wǎng)絡(luò)采用過(guò)參數(shù)化的方法來(lái)提取水印信息,與嵌入網(wǎng)絡(luò)類(lèi)似,提取網(wǎng)絡(luò)采用密集連接的思想加強(qiáng)特征的傳遞。

1.7.1 過(guò)參數(shù)化

神經(jīng)網(wǎng)絡(luò)經(jīng)常由于參數(shù)量大而出現(xiàn)過(guò)擬合,文獻(xiàn)[26]利用神經(jīng)網(wǎng)絡(luò)容易過(guò)參數(shù)化的特性設(shè)計(jì)了后門(mén)水印,本文采用這一方法,用大參數(shù)量的網(wǎng)絡(luò)作為提取網(wǎng)絡(luò),輸入秘密視角圖像和原水印圖像,輸出水印圖像,通過(guò)增加迭代次數(shù),讓網(wǎng)絡(luò)出現(xiàn)過(guò)擬合。當(dāng)輸入秘密視角圖像時(shí),可獲取清晰水印圖像,而輸入其他視角圖像時(shí),無(wú)法獲取水印圖像,從而保證了本文算法的安全性。

1.7.2 提取網(wǎng)絡(luò)結(jié)構(gòu)

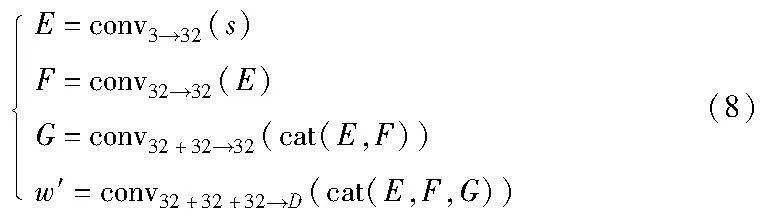

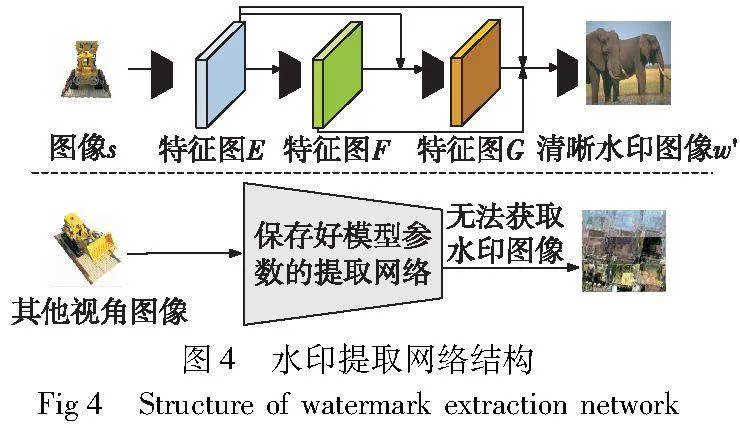

提取網(wǎng)絡(luò)輸入尺寸為3×W×H的圖像s,經(jīng)過(guò)一個(gè)輸出通道為32的卷積層得到特征圖E,E經(jīng)過(guò)一次卷積得到特征圖F,將E和F拼接得到特征圖G,再將E、F、G拼接并進(jìn)行一次卷積后得到清晰水印圖像w′。基本流程如式(8)所示。

提取網(wǎng)絡(luò)卷積核設(shè)置與嵌入網(wǎng)絡(luò)相同,最后一層卷積后輸出3×W×H的水印圖像。訓(xùn)練好提取網(wǎng)絡(luò)后,保存模型參數(shù),輸入經(jīng)過(guò)NeRF其他視角生成的圖像則無(wú)法提取水印圖像。提取網(wǎng)絡(luò)詳細(xì)結(jié)構(gòu)如圖4所示。

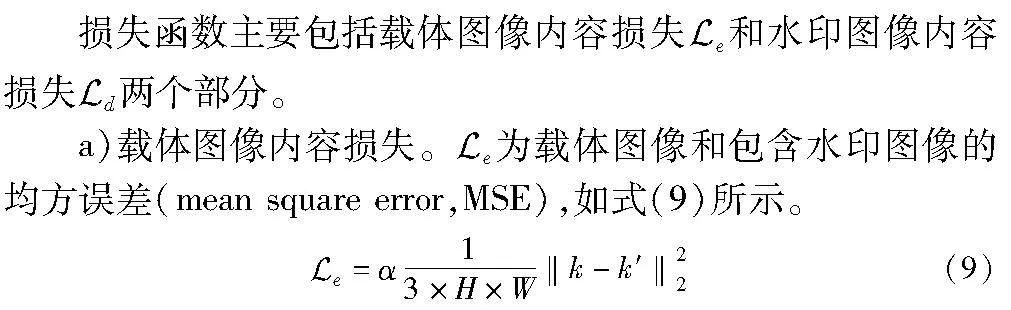

2 損失函數(shù)

其中:α為權(quán)重參數(shù);k為載體圖像;k′為包含水印圖像。

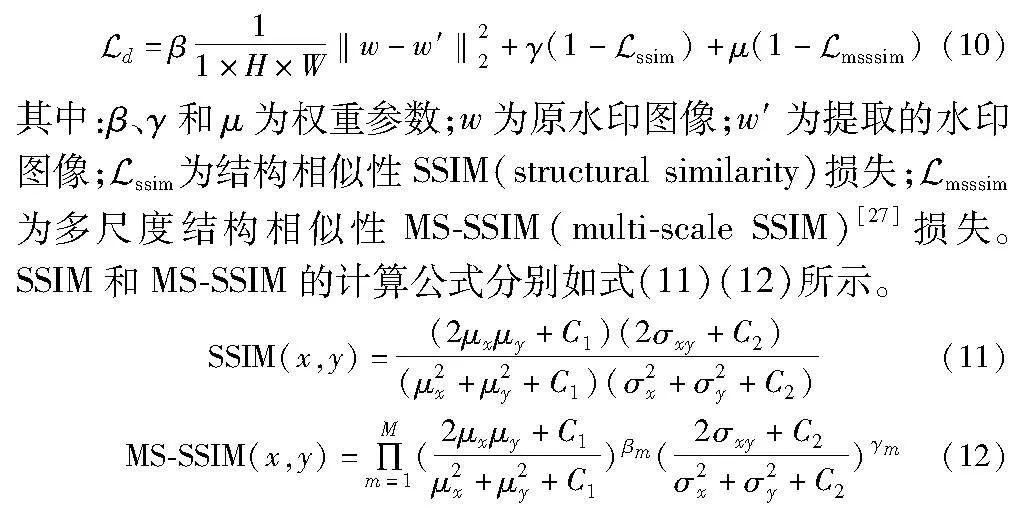

b)水印圖像內(nèi)容損失。Euclid Math OneLApd為水印圖像內(nèi)容損失:

其中:μx、σx分別為圖像X的均值和方差;μy、σy分別為圖像Y的均值和方差;σxy為X和Y的協(xié)方差;M表示不同尺度;βm和γm表示圖像之間的相對(duì)重要性,βm=γm=1;C1、C2為常數(shù);k1默認(rèn)取值0.01,k2取值0.03;L為像素值的動(dòng)態(tài)范圍,取值為255。

3 實(shí)驗(yàn)結(jié)果與分析

3.1 實(shí)驗(yàn)設(shè)置

本實(shí)驗(yàn)使用NeRFSynthetic的lego、chair、ship等數(shù)據(jù)集訓(xùn)練NeRF模型,隨機(jī)選取ImageNet數(shù)據(jù)集中的圖像作為水印圖像進(jìn)行了測(cè)試。NeRFSynthetic數(shù)據(jù)集中包含模型不同角度的圖像和對(duì)應(yīng)的相機(jī)參數(shù)。ImageNet數(shù)據(jù)集較大,包含14 197 122張圖像,本文選取了其中100張圖像作為水印圖像進(jìn)行實(shí)驗(yàn)。運(yùn)行實(shí)驗(yàn)的設(shè)備為64 GB內(nèi)存的電腦,NVIDIA GeForce RTX 2070顯卡。嵌入網(wǎng)絡(luò)和提取網(wǎng)絡(luò)采用Adam優(yōu)化器,輸入圖像大小統(tǒng)一調(diào)整為256×256,learning rate為0.000 1,epochs為50 000,損失函數(shù)參數(shù)設(shè)置為α=0.3,β=0.3,γ=0.5,μ=0.5。

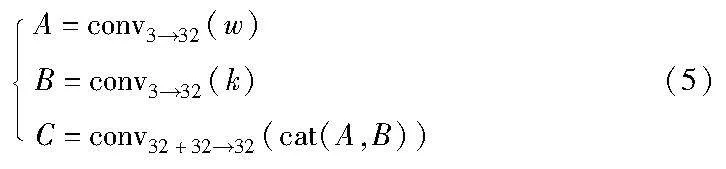

3.2 不可覺(jué)察性

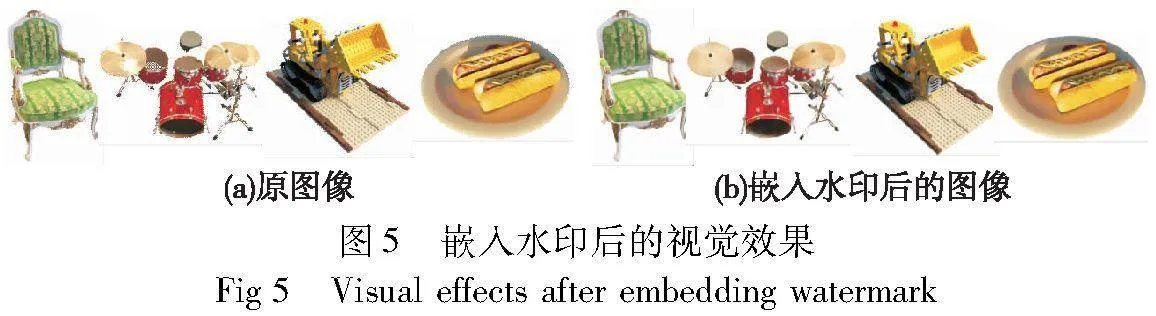

不可感知性又稱(chēng)之為感知透明性,指嵌入水印圖像和原圖像在感知上不存在差異,通常采用MSE反映圖像變化的質(zhì)量,峰值性噪比PSNR(peak signal to noise ratio)比較圖像的壓縮質(zhì)量,SSIM顯示嵌入水印圖像和原圖像的相似性。為評(píng)價(jià)感知損失,本文還用LPIPS[28]對(duì)圖像質(zhì)量進(jìn)行了評(píng)估。在評(píng)估過(guò)程中,PSNR由MES計(jì)算得出,PSNR與SSIM越高越好,LPIPS越低越好,其中MSE與PSNR的計(jì)算方法分別如式(13)(14)所示。

其中:X和Y分別是兩個(gè)大小為W×H的圖像;sc代表縮放因子,通常取值為2。

3.2.1 圖像質(zhì)量

實(shí)驗(yàn)過(guò)程中分別計(jì)算原圖像k和嵌入水印后的圖像k′(嵌入網(wǎng)絡(luò)),水印圖像w和提取水印圖像w′(提取網(wǎng)絡(luò))之間的PSNR、SSIM和LPIPS的值作為實(shí)驗(yàn)結(jié)果,如表1所示。從表1中可以看出,嵌入網(wǎng)絡(luò)和提取網(wǎng)絡(luò)的PSNR、SSIM值較高,LPIPS值較低,表明本文算法生成的嵌入水印圖像和提取水印圖像的不可感知性較高。

3.2.2 圖像效果

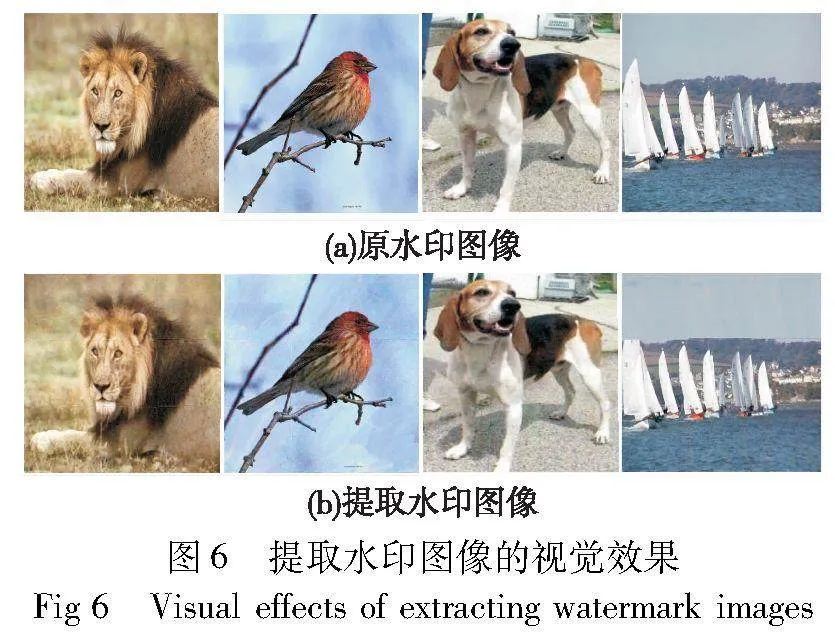

實(shí)驗(yàn)在lego、chair、ship、drums、hotdog和materials數(shù)據(jù)集中各取一張圖像嵌入水印信息,然后將這張圖像和其他圖像用NeRF的算法對(duì)其進(jìn)行訓(xùn)練,再?gòu)匿秩竞笮乱曈X(jué)圖像中提取水印信息,嵌入水印后的圖像和提取水印圖像的視覺(jué)效果如圖5、6所示。

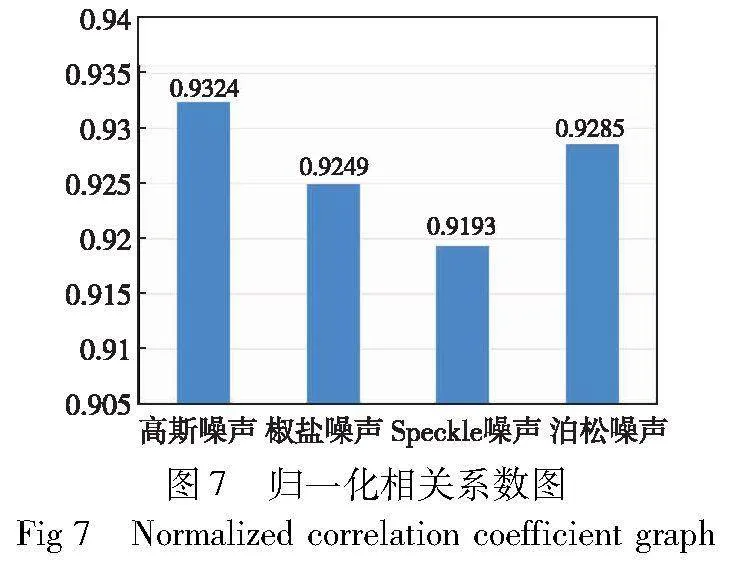

3.3 魯棒性

魯棒性是水印在攻擊中生存的能力,本文通過(guò)對(duì)訓(xùn)練集中的圖像添加噪聲來(lái)模擬神經(jīng)輻射場(chǎng)受到攻擊的過(guò)程。魯棒性通常用誤碼率(bit error rate,BER)和歸一化相關(guān)系數(shù)(norma-lized correlation,NC)來(lái)衡量。

3.3.1 誤碼率

誤碼率(BER)定義為PSNR的倒數(shù),其公式如式(15)所示。

BER決定原圖像在水印過(guò)程中的更改。本實(shí)驗(yàn)在lego數(shù)據(jù)集的圖像中加入噪聲,使用ImageNet數(shù)據(jù)集中獅子圖像作為水印圖像得出實(shí)驗(yàn)結(jié)果。表2給出了在不同噪聲攻擊下提取到水印的BER值。

3.3.2 歸一化相關(guān)系數(shù)

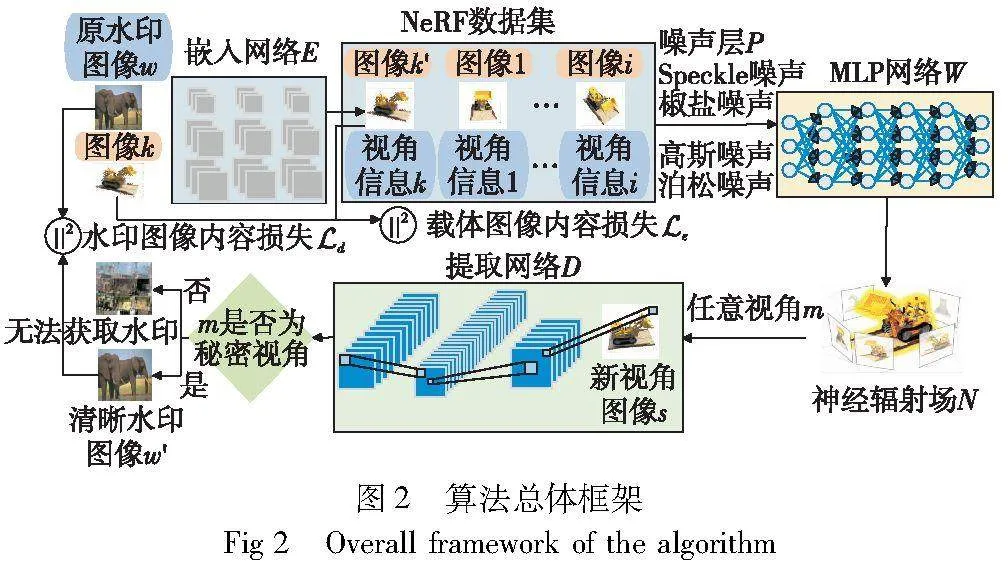

為定量評(píng)估提取水印圖像和原水印圖像的相似性,本文采用歸一化系數(shù)作為評(píng)價(jià)標(biāo)準(zhǔn)。其定義如式(16)所示。

其中:w(x,y)為原水印圖像;w′(x,y)為提取的水印圖像;M、N為圖像分辨率,歸一化相關(guān)系數(shù)表示原圖像和提取水印圖像之間的相似度,取值在0~1,越接近1表示魯棒性越好。

實(shí)驗(yàn)中用不同噪聲對(duì)嵌入水印后的圖像進(jìn)行攻擊,最后提取水印圖像并計(jì)算對(duì)應(yīng)的NC,攻擊后提取水印圖像的歸一化相關(guān)系數(shù)如圖7所示。分析圖7給出的結(jié)果可以看出,本文水印方案有良好的抗干擾能力。

3.4 秘密視角的有效性

為測(cè)試秘密視角的有效性,本文在不同視覺(jué)下生成圖像對(duì)提取水印效果的影響,實(shí)驗(yàn)選取lego數(shù)據(jù)集中一張圖像嵌入水印,選取ImageNet數(shù)據(jù)集中的大象圖像作為水印圖像,通過(guò)NeRF渲染出不同視角下的圖像,放入提取器中進(jìn)行測(cè)試,實(shí)驗(yàn)結(jié)果如圖8所示。

由實(shí)驗(yàn)結(jié)果可以看出,隨著旋轉(zhuǎn)角度的增大,提取的水印圖像越來(lái)越模糊,直到無(wú)法提取出水印圖像。為定量分析角度對(duì)提取水印效果的影響,本文還給出了提取網(wǎng)絡(luò)在不同視覺(jué)圖像輸入時(shí),提取水印與原圖像之間的PSNR、SSIM和LPIPS的值,實(shí)驗(yàn)結(jié)果如表3所示。表3中角度變化是繞中心軸z軸旋轉(zhuǎn)的角度。

由實(shí)驗(yàn)數(shù)據(jù)可知,旋轉(zhuǎn)角度越小,提取水印和原水印的PSNR和SSIM值越高,LPIPS值越低,表明本文方案具有良好的保護(hù)模型版權(quán)的能力。

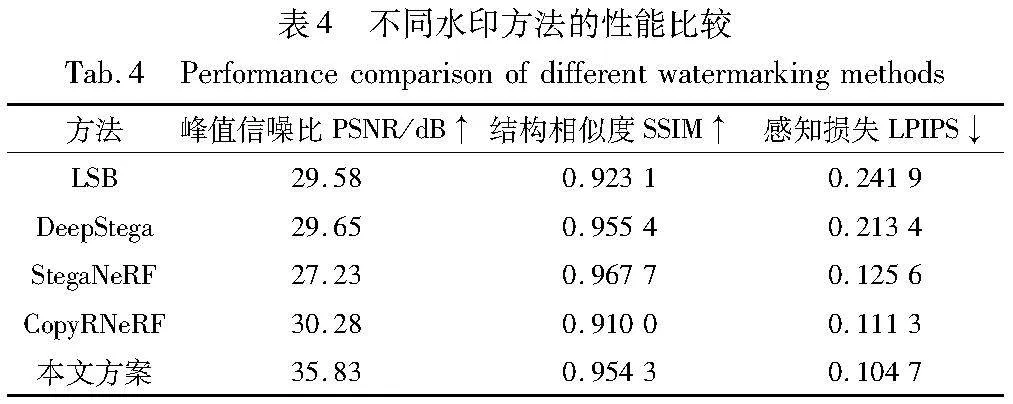

3.5 水印方案對(duì)比

本文方案采用神經(jīng)網(wǎng)絡(luò)水印中黑盒水印的方法來(lái)保護(hù)NeRF,相比于StegaNeRF對(duì)模型進(jìn)行二次訓(xùn)練,本文通過(guò)一種間接的方法來(lái)保護(hù)NeRF模型版權(quán),因此不會(huì)影響NeRF模型本身的性能,且本文訓(xùn)練的提取器有較高的水印提取質(zhì)量。為公平比較不同類(lèi)型的水印方案,將本文方案分別與傳統(tǒng)的水印方案(LSB、DeepStega)和面向神經(jīng)輻射場(chǎng)的水印方案在峰值信噪比(PSNR)、結(jié)構(gòu)相似性(SSIM)和感知損失(LPIPS)三個(gè)方面進(jìn)行對(duì)比,水印方案都以水印圖像w和lego數(shù)據(jù)集中的圖像k作為輸入,通過(guò)比較原水印圖像與提取水印圖像之間的PSNR、SSIM和LPIPS的值來(lái)對(duì)方案進(jìn)行分析,如表4所示。與傳統(tǒng)的水印方案相比,本文方案具有較高的不可察覺(jué)性。與StegaNeRF和CopyRNeRF方案相比,本文方案具有更小的感知損失。

4 結(jié)束語(yǔ)

本文首次提出了神經(jīng)隱式表示水印的概念,利用神經(jīng)網(wǎng)絡(luò)水印技術(shù)保護(hù)數(shù)據(jù)隱式表達(dá)的神經(jīng)網(wǎng)絡(luò),并設(shè)計(jì)了一種面向神經(jīng)輻射場(chǎng)的水印算法,先用嵌入網(wǎng)絡(luò)對(duì)訓(xùn)練集中圖像嵌入水印,再利用NeRF生成3D模型并渲染出新視角圖像,最后用新視角圖像作為密鑰,實(shí)現(xiàn)水印提取過(guò)程。實(shí)驗(yàn)結(jié)果表明,本文取無(wú)窮大視角空間中任意視角作為密鑰,保證了算法的安全性,提取水印不僅有良好的視覺(jué)效果,還具有較好的魯棒性。未來(lái)工作中可改進(jìn)提取網(wǎng)絡(luò)結(jié)構(gòu),減小相鄰視角圖像提取水印信息的可能性,進(jìn)一步提高算法的安全性。

參考文獻(xiàn):

[1]Sitzmann V,Martel J N P,Bergman A W,et al. Implicit neural representations with periodic activation functions[EB/OL].(2020-06-17). https://arxiv.org/abs/2006.09661.

[2]Mildenhall B,Srinivasan P P,Tancik M,et al. NeRF: representing scenes as neural radiance fields for view synthesis[J]. Communications of the ACM,2022,65(1): 99-106.

[3]張國(guó)有,崔健. 基于頂點(diǎn)范數(shù)三維網(wǎng)格模型抗簡(jiǎn)化盲水印算法[J]. 計(jì)算機(jī)工程與設(shè)計(jì),2023,44(3): 692-698.(Zhang Guoyou,Cui Jian. Anti-simplified blind watermarking algorithm for three-dimensional mesh model based on vertex norm[J]. Computer Engineering and Design,2023,44(3): 692-698.)

[4]張國(guó)有,劉佳華,米佳. 針對(duì)三維彩色點(diǎn)云模型水印算法的研究[J]. 計(jì)算機(jī)技術(shù)與發(fā)展,2023,33(5): 62-68,95.(Zhang Guo-you,Liu Jiahua,Mi Jia. Research on watermarking algorithm for 3D color point cloud model[J]. Computer Technology and Development,2023,33(5): 62-68,95.)

[5]李播陽(yáng),張頻,吳江. 改進(jìn)零視差像素點(diǎn)重組的圖像數(shù)字水印算法[J]. 計(jì)算機(jī)仿真,2023,40(2): 244-248.(Li Boyang,Zhang Pin,Wu Jiang. Image digital watermarking algorithm based on improved zero disparity pixel reconstruction[J]. Computer Simulation,2023,40(2): 244-248.)

[6]熊祥光,韋立,謝剛. 基于3D-DCT和SVD的魯棒彩色圖像水印算法[J]. 計(jì)算機(jī)工程與科學(xué),2015,37(6): 1093-1100.(Xiong Xiangguang,Wei Li,Xie Gang. A robust color image watermarking algorithm based on 3D-DCT and SVD[J]. Computer Engineering & Science,2015,37(6): 1093-1100.)

[7]Zhang Xialin,Shen Zaiquan. Copyright protection method for 3D model of geological body based on digital watermarking technology[J]. Journal of Visual Communication and Image Representation,2019,59: 334-346.

[8]Pham G N,Lee S H,Kwon O H,et al. A 3D printing model watermarking algorithm based on 3D slicing and feature points[J]. Electronics,2018,7(2): 23.

[9]Rezaei M,Rezaeian M,Derhami V,et al. Deep learning-based 3D local feature descriptor from Mercator projections[J]. Computer Aided Geometric Design,2019,74: 101771.

[10]Wang Feng,Zhou Hang,F(xiàn)ang Han,et al. Deep 3D mesh watermar-king with self-adaptive robustness[J]. Cybersecurity,2022,5(1): article No.24.

[11]Azhari F,Sennersten C,Milford M,et al. PointCrack3D: crack detection in unstructured environments using a 3D-point-cloud-based deep neural network[EB/OL].(2021-11-23). https://arxiv.org/abs/2111.11615.

[12]Park J,Kim J,Seo J,et al. Illegal 3D content distribution tracking system based on DNN forensic watermarking[C]// Proc of International Conference on Artificial Intelligence in Information and Com-munication. Piscataway,NJ: IEEE Press,2023: 777-781.

[13]Cao Xiaoyu,Jia Jinyuan,Gong N Z. IPGuard: protecting intellectual property of deep neural networks via fingerprinting the classification boundary[C]// Proc of ACM Asia Conference on Computer and Communications Security. New York: ACM Press,2021: 14-25.

[14]Feng Le,Zhang Xinpeng. Watermarking neural network with compensation mechanism[C]// Proc of the 13th International Conference on Knowledge Science,Engineering and Management. Berlin: Springer-Verlag,2020: 363-375.

[15]Lukas N,Zhang Yuxuan,Kerschbaum F. Deep neural network fingerprinting by conferrable adversarial examples[EB/OL].(2021-01-20). https://arxiv.org/abs/1912.00888.

[16]Lyu Peizhuo,Li Pan,Zhang Shengzhi,et al. HufuNet: embedding the left piece as watermark and keeping the right piece for ownership verification in deep neural networks[EB/OL].(2021-03-25). https://arxiv.org/abs/2103.13628.

[17]Merrer E L,Pérez P,Trédan G. Adversarial frontier stitching for remote neural network watermarking[J]. Neural Computing and Applications,2020,32: 9233-9244.

[18]Guo J,Potkonjak M. Watermarking deep neural networks for embedded systems[C]// Proc of IEEE/ACM International Conference on Computer-Aided Design. Piscataway,NJ: IEEE Press,2018: 1-8.

[19]Xue Mingfu,Wu Zhiyu,He Can,et al. Active DNN IP protection: a novel user fingerprint management and DNN authorization control technique[C]// Proc of the 19th International Conference on Trust,Security and Privacy in Computing and Communications. Piscataway,NJ: IEEE Press,2020: 975-982.

[20]Zhu Renjie,Zhang Xinpeng,Shi Mengte,et al. Secure neural network watermarking protocol against forging attack[J/OL]. Journal on Image and Video Processing,2020,2020(1).(2020-09-04). https://doi.org/10.1186/s13640-020-00527-1.

[21]Wu Hanzhou,Liu Gen,Yao Yuwei,et al. Watermarking neural networks with watermarked images[J]. IEEE Trans on Circuits and Systems for Video Technology,2021,31(7): 2591-2601.

[22]Zhang Jie,Chen Dongdong,Liao Jing,et al. Model watermarking for image processing networks[C]// Proc of AAAI Conference on Artificial Intelligence. Palo Alto,CA: AAAI Press,2020: 12805-12812.

[23]Zhang Jie,Chen Dongdong,Liao Jing,et al. Deep model intellectual property protection via deep watermarking[J]. IEEE Trans on Pattern Analysis and Machine Intelligence,2022,44(8): 4005-4020.

[24]Li Chenxin,F(xiàn)eng B Y,F(xiàn)an Zhiwen,et al. StegaNeRF: embedding invisible information within neural radiance fields[C]// Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2023: 441-453.

[25]Luo Ziyuan,Guo Qing,Cheung K C,et al. CopyrNeRF: protecting the copyright of neural radiance fields[C]// Proc of IEEE/CVF International Conference on Computer Vision. Piscataway,NJ: IEEE Press,2023: 22344-22354.

[26]Adi Y,Baum C,Cisse M,et al. Turning your weakness into a strength: watermarking deep neural networks by backdooring[C]// Proc of the 27th USENIX Security Symposium. Berkeley,CA: USENIX Association,2018: 1615-1631.

[27]Wang Z,Simoncelli E P,Bovik A C. Multiscale structural similarity for image quality assessment[C]// Proc of the 37th Asilomar Confe-rence on Signals,Systems & Computers. Piscataway,NJ: IEEE Press,2003: 1398-1402.

[28]Zhang R,Isola P,Efros A A,et al. The unreasonable effectiveness of deep features as a perceptual metric[C]// Proc of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway,NJ: IEEE Press,2018: 586-595.