結合圖神經網絡的小樣本圖像分類方法

摘 要:針對目前在小樣本圖像分類任務上,現有模型存在特征提取不足、提取的特征信息單一等問題,提出一種結合圖神經網絡的雙特征提取的原型網絡(Graph-Based Dual-Encoding Prototype Network,GB-ProtoNet)。GB-ProtoNet 采用了雙特征提取器結構,通過整合2 種不同的神經網絡,有效地捕獲并融合了樣本的全局特征信息和局部特征信息。具體而言,該模型結合了殘差網絡(Residual Network,ResNet) 和基于圖譜卷積網絡(Graph SAmple and aggreGatE,GraphSAGE) 的圖神經網絡。ResNet 能夠在多層網絡結構中有效地傳遞和保留信息,從而提取樣本的全局特征信息。GraphSAGE 擅長處理圖結構數據,通過采樣和聚合鄰居節點的信息,提取出樣本的局部特征信息。GB-ProtoNet 在訓練階段使用標簽平滑交叉熵損失函數計算損失并更新模型參數。該模型在miniImageNet 和CUB-2002-2011 數據集上進行對比實驗,與其他經典模型相比,GB-ProtoNet 在5-Way 1-Shot 和5-Way 5-Shot 兩種設置上均取得最佳分類精度。

關鍵詞:小樣本學習;圖像分類;圖譜卷積網絡

中圖分類號:TP391. 41 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)07-1668-08

0 引言

大數據時代下,隨著數據獲取和存儲技術的飛速發展,數據量呈現爆炸式增長。然而,在一些實際應用場景中,由于數據獲取成本高、標注難度大和數據分布不均勻等因素,往往難以獲得大量標注的樣本數據。因此,越來越多的任務面臨著樣本數據不足的問題。由此引發了研究人員對小樣本學習的探索。近年來,研究人員提出了多種小樣本圖像分類方法,主要包括基于數據增強、基于遷移學習、基于元學習和基于度量學習的方法。

數據增強方法可以為機器學習模型生成數據,減少對訓練數據的依賴性,從而提高機器學習模型的性能[1]。其中,有監督的數據增強方法有幾何變換和像素級操作,可增加數據量[2]。無監督的數據增強方法主要通過模型,尋找合適的增強方法,如GAN[3]、MFC-GAN[4]、IDA-GAN[5]等方法。遷移學習的方法利用先驗知識,通過相似類別的樣本來提高模型的性能[6]。根據數據和任務的相似程度來看,遷移學習可分為歸納式遷移學習、轉導式遷移學習和無監督式遷移學習[7]。元學習也稱學會學習,旨在學習如何快速準確地將模型適應新任務[8],主要分為黑箱元學習、層次元學習和貝葉斯元學習[9]。

度量學習的核心思想是學習一個距離度量,使得同一類別的樣本之間的距離盡可能小,不同類別的樣本之間的距離盡可能大[10]。度量學習通常使用深度神經網絡提取樣本特征,隨后學習一個距離度量,在新的度量空間中完成相似度比較。例如,關系網絡[11]將每個樣本與每個類別原型進行對比,學習一個關系函數來表示每個樣本與每個類別原型之間的相似性。然后,將關系函數的輸出進行分類,得到該樣本的預測類別。原型網絡[12]首先為每個類別學習一個原型,然后將待分類樣本與每個原型的距離進行比較,將距離最小的類別作為該樣本的預測類別。匹配網絡[13]的核心思想是使用余弦相似度度量樣本之間的距離,并使用支持集(SupportSet)和查詢集(Query Set)進行訓練。MAML[14]的核心思想是學習一個初始模型,該模型能夠快速適應新任務。Zhang 等[15]基于圖像區域之間最優匹配的角度,提出了一種基于度量的小樣本學習方法———Deep Earth Mover-s Distance(deepEMD)。該方法使用推土機距離(Earth Mover-s Distance,EMD)作為度量來計算密集圖像表示之間的結構距離,以確定圖像相關性。任維鑫等[16]使用孿生網絡作為框架,通過自監督的對比學習和基于構造監督標簽與二值交叉熵的距離損失來優化模型的性能。Yu等[17]通過改進原型網絡中的度量學習方法,將核心度量函數改為曼哈頓距離并優化卷積神經網絡結構,減少噪聲的影響且更易于模型優化。陸妍等[18]針對小樣本細粒度分類中相似性度量單一的問題,提出一種基于Transformer 的小樣本細粒度圖像分類模型,設計了具有Transformer 架構的多軸注意力模塊,能夠更好挖掘圖像特征。許華杰等[19]提出了一種基于特征圖增強原型和查詢特征聚合的小樣本圖像分類方法,有效緩解了類原型代表性不足和類內差異較大問題。

圖神經網絡(Graph Neural Network,GNN)[20]是一種用于處理圖結構數據的神經網絡。圖結構數據是現實世界中廣泛存在的一種數據形式。近年來,有許多研究者將GNN 與小樣本學習相結合,以充分利用圖結構對節點和邊的數據的提取,提高模型在小樣本上的性能[21]。Zhong 等[22]提出了一個用于小樣本圖像分類的圖補充潛在表示網絡(GraphComplemented Latent Representation,GCLR ),引入GNN 充分利用每個類別內樣本之間的關系,提高關聯挖掘能力。Xiong 等[23]提出了一種利用多維邊緣特征的圖神經網絡(Graph Neural Network ExploitingMulti-Dimensional Edge Features,MDE-GNN)。MDE-GNN 引入多維邊緣特征信息構建圖中的邊矩陣,使得模型能夠更好地捕捉圖像之間的復雜關系。Tong 等[24]提出了一種用于高光譜圖像(HyperspectralImage,HSI)小樣本分類的注意力加權圖卷積網絡(Attention-weighted Graph Convolutional Network,AwGCN)模型,通過構建注意力加權圖和利用圖卷積網絡傳播標簽,解決HSI 少樣本分類所面臨的巨大標記數據需求問題。Chen 等[25]提出了分層圖神經網絡(Hierarchical Graph Neural Network,HGNN),著眼于挖掘類別內部和類別之間的區分特征,從而更好地進行小樣本分類。李凡等[26]將ResNet 與GNN 相結合,設計了殘差圖卷積網絡,增強網絡穩定性,并結合注意力機制提高信息傳遞效率。

本文提出了一種基于GNN 的雙特征提取原型網絡(Graph-Based Dual-Encoding Prototype Network,GB-ProtoNet),并對其在小樣本圖像分類任務中的表現進行了研究。GB-ProtoNet 在原型網絡的基礎上進行了改進,主要貢獻如下:① 雙編碼特征提取模塊。該模塊融合了ResNet 和基于圖譜卷積網絡(Graph SAmple and aggreGatE,Graph-SAGE)的GNN分別提取樣本的全局信息和局部信息,提取更全面、更魯棒的圖像特征。② GraphSAGE GNN。采用Graph-SAGE 構建GNN,捕捉圖像中的局部依賴關系,增強模型對圖像細節的表達能力。③ 標簽平滑交叉熵損失函數。通過加入一個平滑項,可以減小梯度的大小,有效緩解模型過擬合問題,提升模型的泛化能力。

實驗表明,GB-ProtoNet 在miniImageNet 和CUB-2002-2011 數據集上取得了優異的性能,在5-Way 1-Shot 和5-Way 5-Shot 設置下分別取得了87. 05% 、76. 22% 和96. 76% 、88. 70% 的精度。

1 本文方法

1. 1 小樣本問題定義

在小樣本學習中,對于給定任務,其包含3 個數據集為訓練集、驗證集和測試集,這3 個數據集類別兩兩正交。為了方便對比不同方法,通常在N-WayK-Shot 任務上進行測試,認為如果一個方法可在N-Way K-Shot 任務上取得較好結果,則該方法具備小樣本學習能力。N-Way K-Shot 任務也稱為N-WayK-Shot Q-query 任務,一般來說,小樣本學習的訓練集中包含了很多類別,每個類別有多個樣本。在訓練階段,從訓練集中隨機選取N 個類別,每個類別抽取K 個樣本作為Support Set,Support Set 包括N×K 個樣本,K 通常設為1 或5;每個類再抽取Q 個樣本作為Query Set,Query Set 可以為1 個樣本也可以為多個樣本,根據其標注的類別,計算分類損失用于模型學習。模型在訓練過程中定期在驗證集上進行評估,驗證集同樣被劃分為Support Set 和QuerySet,并根據驗證集上計算的損失調整模型參數,以防止模型過擬合訓練集。在測試階段,測試集被分為Support Set 和Query Set,此時僅計算模型的分類精度,用于評估模型在未知數據上的泛化能力。

1. 2 模型總體架構

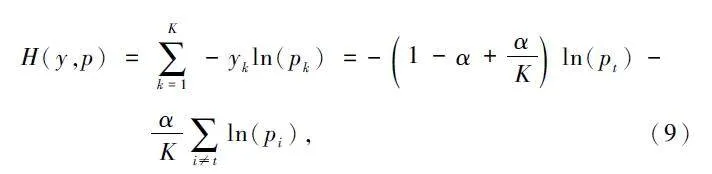

小樣本圖像分類任務通常由特征提取模塊和特征比較模塊構成。本文提出了GB-ProtoNet,在原型網絡的基礎上,使用雙特征提取模塊,引入殘差特征提取模塊和GNN 特征提取模塊分別進行特征提取。ResNet 是一種經典的深度卷積網絡,擅長提取圖像的全局特征;GNN 特征提取模塊中的GraphSAGE,擅長提取圖像的局部特征。雙特征提取模塊可以充分利用圖像的空間結構信息和局部特征信息,從而提高模型的泛化能力。

在特征提取階段,殘差特征提取模塊將圖像轉換為全局特征向量,GNN 特征提取模塊則將圖像序列化為圖,并使用GNN 進行圖像節點特征的聚合,得到每個圖像的局部特征向量。隨后,將全局特征向量和局部特征向量進行融合,獲得具有更全面圖像信息的特征向量。在分類階段,使用標簽平滑交叉熵損失函數計算損失,用歐氏距離度量樣本與各個類原型間的距離進行分類。基于GNN 的小樣本圖像分類模型如圖1 所示。

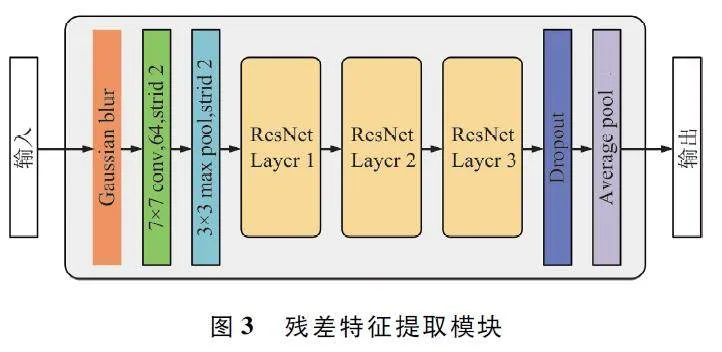

1. 3 殘差特征提取模塊

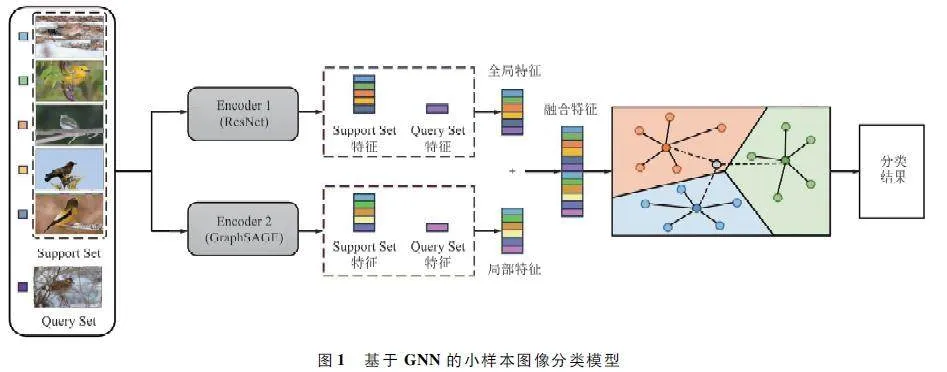

ResNet 由多個殘差模塊組成,在防止梯度消失和加強特征提取能力方面效果良好。ResNet 的核心是殘差結構。殘差結構[27]的思想是:將原本要學習的函數H(x)改為學習F(x)= H(x)-x,其中x 是輸入。如H(x)的梯度較小或消失,則F(x)的梯度仍有可能較大,從而避免梯度消失問題。ResNet 的計算如下:

y = H(x) = F(x)+ x, (1)

式中:y 為輸出,F(x)為殘差函數,x 為輸入。

本文提出的殘差特征提取模塊中包含4 個ResNetlayer,每個ResNet layer 由多個ResNet Block 組成。ResNet Block 結構如圖2 所示,其計算如下:

y = F(x) = F(x;W)。(2)

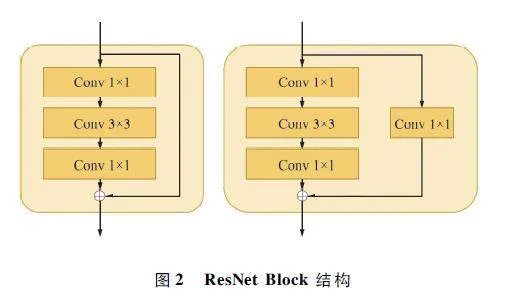

為了避免殘差特征提取模塊學習到過多圖片噪聲,在其輸入端添加了高斯濾波器。高斯濾波器能夠有效消除圖片噪聲,其輸出在局部區域是平滑的,并且具有平滑的邊緣,能夠保持圖片的整體結構。高斯濾波器是一種線性濾波器,其輸出如下:

式中:y 為高斯濾波器的輸出,wi 為濾波器的權重,bi 為濾波器的偏置,x 為輸入,σ 為濾波器的標準差。

在小樣本學習中,由于訓練數據量有限,模型容易過擬合。為了防止過擬合,在ResNet layer 后添加了Dropout 模塊,對特征進行稀疏化。Dropout 操作會隨機丟棄一部分特征,從而增加模型的隨機性和魯棒性,提高模型的泛化能力。Dropout 操作的輸出如式下:

y = x⊙d, (4)

式中:x 為輸入特征矩陣,d 為Dropout 矩陣,⊙為按元素相乘運算。

Dropout 矩陣的生成方法如下:

d = Bernoulli(p), (5)

式中:Bernoulli(p)表示伯努利分布,p 表示Dropout率,即在訓練過程中丟棄特征的概率。在訓練過程中,生成Dropout 矩陣d。將輸入特征矩陣x 與Dropout 矩陣d 按元素相乘,得到Dropout 操作的輸出y。模型使用輸出y 進行訓練。

在殘差特征提取模塊中,首先使用高斯濾波器對圖像進行處理,以去除圖像中的噪聲并提高圖像的整體質量。然后通過1 ×1 的卷積和最大池化操作,有效地提取輸入圖像中的特征,并降低特征圖的維度。接著通過4 個ResNet layer,每個ResNet layer由多個ResNet Block 組成,其中ResNet Block 由2 個卷積層和一個殘差連接構成。殘差連接可以有效地防止梯度消失,提高模型的深度可訓練性。然后通過Dropout 層,在訓練過程中隨機丟棄一部分特征,從而增加模型的隨機性和魯棒性,提高模型的泛化能力,避免過擬合情況。最后通過平均池化層,在降低模型的計算量的同時保留特征圖中的均值信息,提高模型的魯棒性。殘差特征提取模塊如圖3 所示。

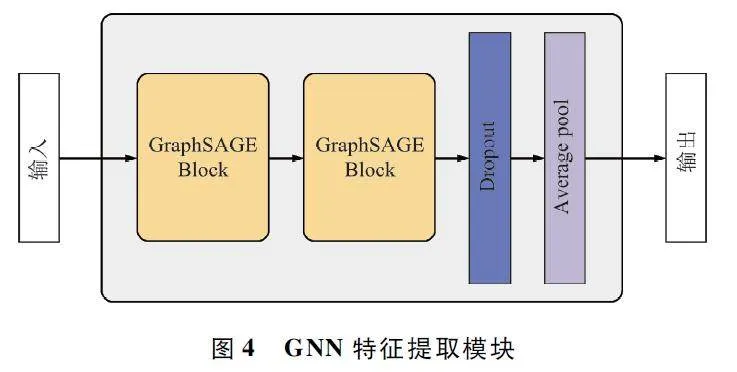

1. 4 GNN 特征提取模塊

為了提取樣本圖像的局部特征,在殘差特征提取模塊的基礎上引入一個GNN 模塊組合成雙提特征提取器。GNN 可以通過學習圖中的節點和邊的關系,從而提取圖中的信息。本文使用GraphSAGE[28]構建GNN 特征提取模塊,它基于鄰居聚合(Neighborhood Aggregation),將每個節點的特征聚合為一個新的特征,該特征包含了該節點和其鄰居的相關信息。一個GraphSAGE 模塊的運行流程可以分為2 個步驟:① 鄰居采樣;② 聚合。

在鄰居采樣階段,為了降低計算復雜度,對每個頂點采樣a 個鄰居頂點作為待聚合信息的頂點。如果頂點的鄰居數少于a,則采用有放回抽樣,直到采樣出a 個頂點;如果頂點的鄰居數多于a,則采用無放回抽樣。由于本文中的輸入為圖像,因此構建的鄰接矩陣將圖像像素視為圖的節點,并在相鄰像素之間建立邊連接。以此用于鄰居采樣。

在聚合階段,采用mean 聚合函數聚合鄰居頂點蘊含的信息,其運算如下所示。

hkv← σ(W·MEAN({hk -1v }∪ {hk -1u ,?u ∈ N(v)})),(6)

式中:hv 為節點v 的特征向量,hu 為節點u 的特征向量,σ 為非線性激活函數,W 為鄰接矩陣,N(v)為節點v 的鄰居節點集合,k 為聚合深度。

本文提出的GraphSAGE 構建的GNN 特征提取模塊如圖4 所示。該模塊首先將輸入圖片的每個像素視為圖的節點,并構建鄰接矩陣。鄰接矩陣表示了圖中節點之間的連接關系。然后,該模塊通過2 個GraphSAGE 模塊提取圖像的局部特征。GraphSAGE模塊是一種基于鄰居聚合的GNN,通過聚合每個節點的鄰居信息,來更新節點的特征。最后,該模塊通過Flatten 和自適應平均池化調整輸出特征的形狀。Flatten 操作將多維張量展平為一維張量。自適應平均池化操作根據輸入張量的大小,選擇合適的池化窗口大小。

1. 5 雙特征提取結構

如圖4 所示,本文所提出的GBProtoNet 設計了2 個網絡,分別提取圖片的全局特征和局部特征。圖3 所示的殘差特征提取模塊為Encoder 1,表示為f1(x),x 為輸入的圖片,用于提取圖片全局特征。圖4 所示的GNN 特征提取模塊為Encoder 2,表示為f2(x),用于提取圖片局部特征。2 個特征提取模塊輸出的特征向量尺寸均為1×2 048。

分別提取全局特征和局部特征后,使用下式對2 個特征進行合并,生成圖片的融合特征。

f(x) = Cat(f1(x),f2(x)), (7)

式中:Cat()操作在最后一個維度對特征向量進行拼接,融合特征f(x)的特征向量尺寸為1×4 096。

1. 6 損失函數

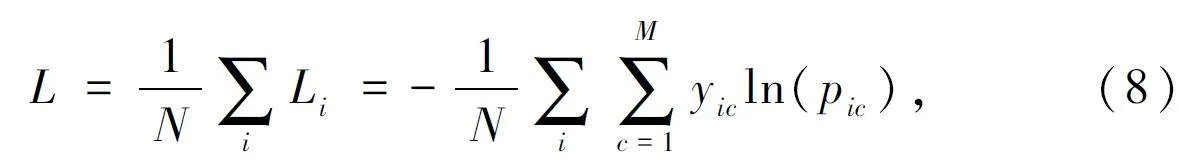

交叉熵損失(Cross Entropy Loss)函數是一種常用的損失函數,多用于分類任務。其計算如下:

式中:M 表示類別數量,yic 表示符號函數,pic 表示觀測樣本i 屬于類別c 的預測概率。

交叉熵損失函數衡量了2 個概率分布之間的差異。在分類任務中,真實標簽表示樣本的真實類別,預測概率表示模型對樣本的預測類別。它的值越小,表示模型對樣本的預測類別與真實類別越接近,也就是說模型的預測結果越準確。

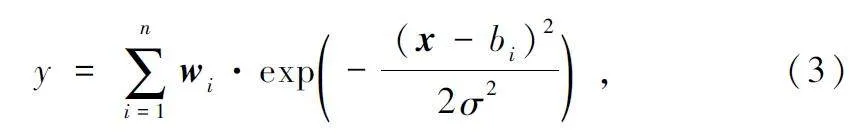

但交叉熵損失函數在訓練過程中可能會出現震蕩,并對噪聲敏感,會影響模型的收斂速度和對噪聲的魯棒性。因此本文使用標簽平滑交叉熵損失函數(Smooth Cross Entropy),通過加入一個平滑項,可以減小梯度的大小,從而提高模型的穩定性,計算如下:

式中:K 為類別數量,yk 為觀測樣本的類別,pk 為樣本屬于類別k 的預測概率,α 為平滑參數。

2 實驗

2. 1 數據集

本文在miniImageNet[13]和CUB-2002-2011[29]數據集上進行了實驗。miniImageNet 數據集是ImageNet 數據集的一個子集,共有100 個類別,每個類別包含600 張彩色圖片,共60 000 張。CUB-2002-2011 數據集是一個鳥類數據集,共有200 個類別,共11 788 張圖片,該數據集由加州理工學院于2010 年提出。由于2 個數據集的圖片尺寸大小不一,為方便進行訓練,在預處理階段,將所有圖片的大小設置為3×128 pixel×128 pixel。

訓練集、驗證集和測試集在數據集中的占比分別為64% 、16% 、20% 。在miniImageNet 數據集上,訓練集包含38 400 張圖片,共64 個類別;驗證集包含9 600 張圖片,共16 個類別;測試集包含12 000 張圖片,共20 個類別。在CUB-2002-2011 數據集上,訓練集包含7 545 張圖片,共128 個類別;驗證集包含1 886 張圖片,共32 個類別;測試集包含2 357 張圖片,共40 個類別。值得注意的是,CUB-2002-2011數據集并非全是彩色圖片,因此本文在預處理階段將一維圖像擴充為三維圖像。數據集的示例如圖5所示。

2. 2 實驗設置

本文的所有實驗均在Ubuntu 20. 04 系統上,NVIDIA RTX A5000 (24 GB),在PyTorch 1. 11. 0、Python 3. 8 和CUDA 11. 3 環境下進行。實驗中使用AdamW 優化器進行訓練,學習率初始值為0. 000 1,衰減系數為0. 5,每10 個epoch 衰減一次。訓練采用余弦退火學習率調整策略,訓練輪數為200。本實驗使用5-Way 1-Shot 和5-Way 5-Shot 實驗策略進行訓練。

2. 3 評價指標

為了評估本文提出的方法在小樣本分類任務上的有效性,使用分類準確率作為主要性能指標。在miniImageNet 和CUB-2002-2011 數據集上,本文的GB-ProtoNet 和其他對比實驗的精度,均使用1 000 個epoch 的測試結果計算平均準確率,并計算了每個模型分類準確率的95% 置信區間。準確率計算如下:

ACC = TP + TN/TP + FN + FP + TN, (10)

式中:真陽性(TP)表示正確分類為正類的正樣本,假陰性(FN)表示被誤分類為負類的正樣本,假陽性(FP)表示被誤分類為正類的負樣本,真陰性(TN)表示正確分類為負類的負樣本。

2. 4 對比實驗結果

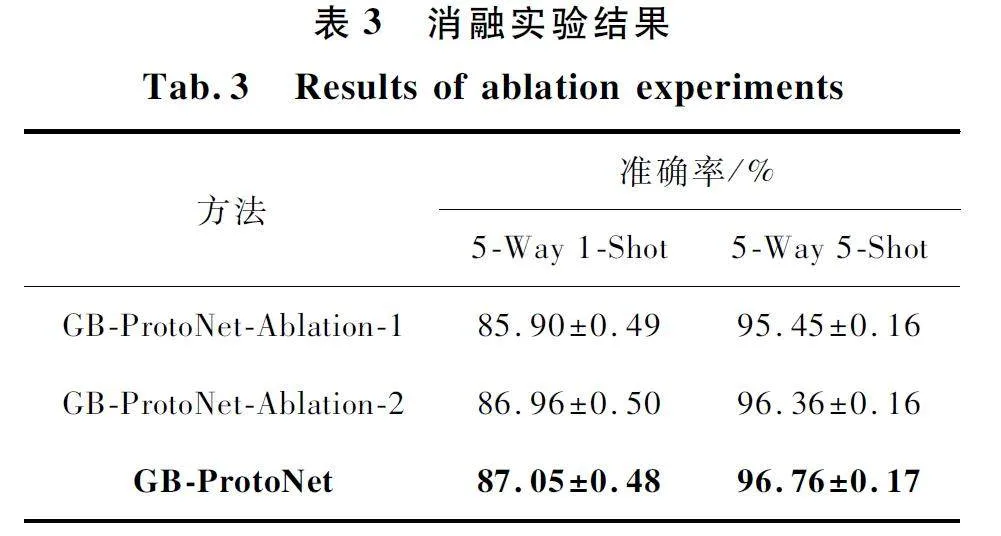

為了驗證本文所提GB-ProtoNet 模型的有效性,分別與多種小樣本學習方法進行對比實驗,如Pro-toNet、RelationNet、MAML、DeepEMD 等模型,并在miniImageNet 和CUB-2002-2011 數據集上進行對比實驗,結果如表1 和表2 所示。

從表1 和表2 可以看出,GB-ProtoNet 在2 個數據集上都取得了最優的性能。在miniImageNet 數據集上,1-Shot 設置的準確率為86. 96% ,5-Shot 設置的準確率為96. 76% 。在CUB-2002-2011 數據集上,1-Shot 設置的準確率為76. 13% ,5-Shot 設置的準確率為88. 70% 。與其他方法相比,GB-ProtoNet的優勢主要體現在以下方面。

利用GNN 捕捉圖像的局部特征。GNN 能夠有效地學習圖像中的節點信息,這對于小樣本圖像分類任務非常重要。GB-ProtoNet 使用GraphSAGE 來生成圖像特征,通過鄰接聚合學習圖的節點特征,從而能夠更好地捕捉圖像的局部信息。

使用雙特征提取模塊進行分類。雙特征提取模塊能夠從全局和局部兩方面來學習特征,可以提高分類性能。GB-ProtoNet 使用2 個特征提取模塊,其中殘差特征提取模塊用于生成圖像全局特征,GNN特征提取模塊用于生成局部特征。

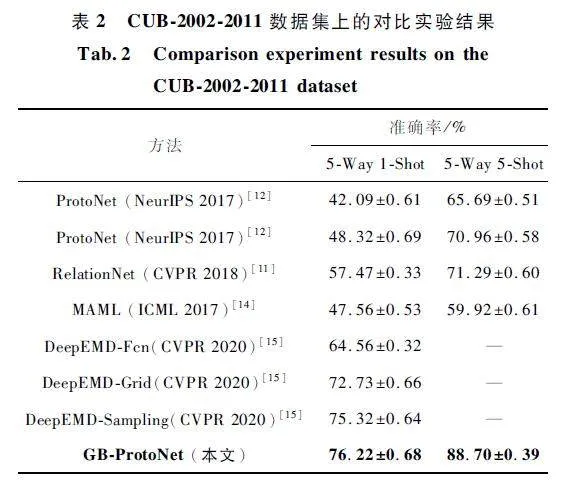

2. 5 消融實驗

消融實驗是評估模型性能的重要手段之一。通過消融實驗,可以分析模型的不同組成部分對性能的影響,從而更好地理解模型的工作機制。在數據集miniImageNet 上對GB-ProtoNet 進行消融實驗,以分析GNN 特征提取模塊和標簽平滑的交叉熵損失函數對模型性能的影響。實驗結果如表3 所示。

在消融實驗中,GB-ProtoNet-Ablation-1 為保留殘差特征提取模塊、使用交叉熵損失函數的模型,GB-ProtoNet-Ablation-2 為保留雙特征提取模塊、使用交叉熵損失函數的模型,GB-ProtoNet 為使用雙特征提取模塊、使用標簽平滑交叉熵損失函數的模型。實驗結果表明,當添加GNN 特征提取模塊時,分類效果有所提升,說明GNN 能有效提取模型的局部信息,增強模型的特征提取能力。模型GB-ProtoNet 在miniImageNet 數據集上的5-Way 1-Shot 和5-Way 5-Shot 兩種設置的分類性能最佳,準確率分別達到87. 05% 和96. 76% 。

3 結束語。

現有的小樣本圖像分類模型存在特征提取不足、信息單一等問題。針對這些問題,提出了一種結合GNN 的雙特征提取的原型網絡———GB-ProtoNet。GB-ProtoNet 采用雙特征提取器,分別使用ResNet和基于GraphSAGE 的GNN 提取樣本的全局特征和局部特征。全局特征反映了樣本的整體信息,而局部特征反映了樣本的局部細節。在訓練階段,GB-ProtoNet 使用標簽平滑交叉熵損失函數,該損失函數可以有效緩解模型在訓練過程中的極端值問題,提高模型的穩定性。通過對比實驗,本文提出的GB-rotoNet 模型在miniImageNet 數據集上,1-Shot設置下的準確率為86. 96% ,5-Shot 設置下的準確率為96. 76% ;在CUB-2002-2011 數據集上,1-Shot 設置下的準確率為76. 13% ,5-Shot 設置下的準確率為88. 70% 。相較于ProtoNet、RelationNet、MAML、DeepEMD 等同類模型,GB-ProtoNet 在2 個數據集上均取得了最優性能,充分驗證了其先進性和有效性。

參考文獻

[1] XU M L,YOON S,FUENTES A,et al. A ComprehensiveSurvey of Image Augmentation Techniques for DeepLearning[J]. Pattern Recognition,2022,137:109347.

[2] KHALIFA N E,LOEY M,MIRJALILI S. A ComprehensiveSurvey of Recent Trends in Deep Learning for Digital Images Augmentation [J ]. Artificial Intelligence Review,2021,55(3):2351-2377.

[3] GOODFELLOW I,POUGETABADIE J,MIRZA M,et al.Generative Adversarial Networks[J]. Communications ofthe ACM,2020,63(11):139-144.

[4] ALIGOMBE A,ELYAN E. MFCGAN:ClassimbalancedDataset Classification Using Multiple Fake Class GenerativeAdversarial Network [J ]. Neurocomputing,2019,361:212-221.

[5] YANG H,ZHOU Y. IDAGAN:A Novel Imbalanced CataAugmentation GAN[C]∥2020 25th International Conference on Pattern Recognition (ICPR). Milan:IEEE,2021:8299-8305.

[6] ZHUANG F Z,QI Z Y,DUAN K Y,et al. A ComprehensiveSurvey on Transfer Learning [J ]. Proceedings of theIEEE,2020,109(1):43-76.

[7] AGARWAL N,SONDHI A,CHOPRA K,et al. TransferLearning:Survey and Classification[J]. Smart Innovationsin Communication and Computational Sciences,2021,1168:145-155.

[8] LI X X,SUN Z,XUE J H,et al. A Concise Review of Recent Fewshot MetaLearning Methods[J]. Neurocomputing,2021,456:463-468.

[9] PENG H. A Comprehensive Overview and Survey of RecentAdvances in Metalearning [EB / OL]. (2020 - 04 - 17 )[2024-02-01]. https:∥arxiv. org / abs/ 2004. 11149.

[10] LI X X,YANG X C,MA Z Y,et al. Deep Metric Learningfor Fewshot Image Classification:A Review of Recent Developments[J]. Pattern Recognition,2023,138:109381.

[11] SUNG F,YANG Y X,ZHANG L,et al. Learning to Compare:Relation Network for Fewshot Learning[C]∥2018IEEE / CVF Conference on Computer Vision and PatternRecognition (CVPR). Salt Lake City:IEEE Computer Society,2018:1199-1208.

[12] SNELL J,SWERSKY K,ZEMEL R. Prototypical Networksfor Fewshot Learning[C]∥Proceedings of the 31st International Conference on Neural Information Processing Systems. New York:ACM,2017:4080-4090.

[13] VINYALS O,BLUNDELL C,LILLICRAP T,et al. MatchingNetworks for One Shot Learning [C]∥ Proceedings of the30th International Conference on Neural Information Processing Systems. [S. l. ]:ACM,2016:3637-3645.

[14] FINN C,ABBEEL P,LEVINE S. Modelagnostic Metalearning for Fast Adaptation of Deep Networks[C]∥ International Conference on Machine Learning. Sydney:ACM,2017:1126-1135.

[15] ZHANG C,CAI Y J,LIN G S,et al. DeepEMD:Differentiable Earth Movers Distance for Fewshot Learning [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2022,45(5):5632-5648.

[16] 任維鑫,曹新亮,白宗文. 一種單樣本農作物病害識別方法[J]. 無線電工程,2023,53(2):484-489.

[17] YU Z C,WANG K,XIE S X,et al. Prototypical NetworkBased on Manhattan Distance[J]. Computer Modeling inEngineering & Sciences,2022,131(2):655-675.

[18] 陸妍,王陽萍,王文潤. 基于Transformer 的小樣本細粒度圖像分類方法[J]. 計算機工程與應用,2023,59(23):219-227.

[19] 許華杰,梁書偉. 采用特征圖增強原型的小樣本圖像分類方法[J]. 計算機科學與探索,2024,18 (4 ):990-1000.

[20] ZHOU J,CUI G Q,HU S D,et al. Graph Neural Networks:A Review of Methods and Applications [J]. AI Open,2020,1:57-81.

[21] 楊潔,董一鴻,錢江波. 基于圖神經網絡的小樣本學習方法研究進展[J]. 計算機研究與發展,2024,61(4):856-876.

[22] ZHONG X,GU C,YE M,et al. Graph ComplementedLatent Representation for Fewshot Image Classification[J ]. IEEE Transactions on Multimedia,2023,25:1979-1990.

[23] XIONG C,LI W,LIU Y,et al. Multidimensional EdgeFeatures Graph Neural Network on Fewshot Image Classification[J]. IEEE Signal Processing Letters,2021,28:573-577.

[24] TONG X Y,YIN J H,HAN B N,et al. Fewshot Learningwith Attentionweighted Graph Convolutional Networks forHyperspectral Image Classification[C]∥IEEE InternationalConference on Image Processing (ICIP ). Abu Dhabi:IEEE,2020:1686-1690.

[25] CHEN C,LI K L,WEI W,et al. Hierarchical GraphNeural Networks for Fewshot Learning[J]. IEEE Transactions on Circuits and Systems for Video Technology,2022,32(1):240-252.

[26] 李凡,賈東立,姚昱,等. 結合殘差與自注意力機制的圖卷積小樣本圖像分類網絡[J]. 計算機科學,2023,50(增刊1):376-380.

[27] HE K M,ZHANG X Y,REN S Q,et al. Deep ResidualLearning for Image Recognition[C]∥Proceedings of theIEEE Conference on Computer Vision and Pattern Recognition. Las Vegas:IEEE,2016:770-778.

[28] HAMILTON W L,YING Z,LESKOVEC J. Inductive Representation Learning on Large Graphs[C]∥ Proceedingsof the 31st International Conference on Neural InformationProcessing Systems. New York:ACM,2017:1025-1035.

[29] WAH C,BRANSON S,WELINDER P,et al. The CaltechUCSD Birds2002011 Dataset[DB]. [2024-01-10]. http:∥www. vision. caltech. edu / datasets / cub_200_2011 / .

作者簡介

齊露露 女,(1998—),碩士研究生。主要研究方向:小樣本圖像分類。

(*通信作者)俞衛琴 女,(1982—),博士,副教授,碩士生導師。主要研究方向:非線性動力學理論與應用。