基于YOLO的低成本且輕量化的秧苗計數研究

摘 "要: 農業生產中需要對秧苗進行計數以獲取種子質量和種植密度等評估信息,而小規模批量育種環境下存在人工依賴程度高、軟硬件設備差的情況。針對此問題,文中以唇形科植物為例,提出了一種低成本、輕量化的秧苗計數方法。首先提出數據集的快速構建方法,以降低數據集成本;然后通過改進YOLO模型頸部特征融合部分和精簡頭部來保證模型輕量高效,并添加改進的通道注意力方法以改善圖像低分辨率造成的漏檢率過高問題,構建了秧苗計數模型Seedet。實驗結果表明,與YOLOv5s模型相比,Seedet的模型參數與計算量分別降低了73.45%和47.59%,檢測精確率和速度分別提高了3.987%和70.09%。文中提出的計數方法更適合于低成本場景下的秧苗計數,促進了農業生產中深度學習的落地應用。

關鍵詞: 秧苗計數; YOLO; 深度學習; 輕量化; 通道注意力; 低成本

中圖分類號: TN919?34; TP391 " " " " " " " " "文獻標識碼: A " " " " " " " " " " " 文章編號: 1004?373X(2024)15?0122?05

Research on low?cost and lightweight seedling counting method based on YOLO

SU Yousheng1, CHEN Jiqing1, 2, HAO Kewei1, SHE Kairong1, HUANG Yang1

(1. School of Mechanical Engineering, Guangxi University, Nanning 530007, China;

2. Key Laboratory of Guangxi Manufacturing System and Advanced Manufacturing Technology, Nanning 530007, China)

Abstract: It is required to count the seedling in agricultural production to obtain assessment information such as seed quality and planting density. However, there is a high degree of manual dependence and poor hardware and software equipment in small?scale batch breeding environments. In view of the above, a low?cost and lightweight seedling counting method is proposed by taking Labiatae as an example. A fast construction method for the dataset is proposed to reduce the cost of the dataset. By improving the feature fusion part of the neck and streamlining the head of the YOLO model, the lightweight and efficiency of the model is ensured. In addition, an improved channel attention method is added to eliminate the excessive missed detection rate caused by the low resolution of the image. So far, the seedling counting model Seedet is constructed. The experimental results show that the Seedet′s parameters and computational burden are reduced by 73.45% and 47.59%, respectively, and its detection accuracy and detection speed are improved by 3.987% and 70.09%, respectively, in comparison with those of the YOLOv5s. The proposed counting method is more suitable for seedling counting in low?cost scenarios and can promote the application of deep learning in agricultural production.

Keywords: seedling counting; YOLO; deep learning; lightweight; channel attention; low cost

0 "引 "言

唇形科含有豐富的藥用植物資源,是重要的藥用類群[1],羅勒和薄荷是其典型代表。羅勒因為豐富的歷史背景和藥食兩用特性而具有較高的經濟價值。在羅勒選育和批量生產中,需要對秧苗進行計數以獲得更準確的信息。目前,這項工作主要依賴人工完成,存在著時效性差、人工成本高、精度波動大等問題[2]。準確而快速地進行秧苗計數可以實現農業資源的合理配置與詳細檢測,在科研育種和智慧農業方面起著關鍵作用。

近年來,計算機視覺技術的發展與應用促進了農業的信息化與自動化[3]。為了實時監測溫室蟲情和精準防控蟲害,文獻[4]設計了一種基于誘蟲板圖像背景均勻化的自適應分割方法,該方法使用顏色模型圖像分割方法和隨機森林算法實現害蟲的識別與計數;文獻[5]進行了穴盤苗發芽率在線視覺檢測研究,采用梯度直方圖提取特征和支持向量機算法分類后進行定位;文獻[6]通過局部最大值濾波算法實現了無人機圖像與激光雷達在玉米植株自動計數方面的對比;文獻[7]同樣通過無人機圖像使用圖像分割與擬合算法實現了大面積棉田出苗信息的提取。上述研究依賴人工設計的特征提取器,具有良好的可解釋性和程序設計簡單等優勢。然而,這些傳統視覺算法通常缺乏泛化性和魯棒性,對光照以及紋理特征要求嚴格,無法應對復雜任務和大規模數據。深度學習算法因精度高,對成像條件要求低而逐漸成為當前研究的主流。文獻[8]使用卷積神經網絡實現了馬鈴薯葉片病害識別與病斑檢測;文獻[9]改進了YOLOv4的錨框與損失函數以提高林業害蟲檢測的準確性;在農業計數方面,文獻[10]改進了YOLOv5的網絡結構與先驗框,并添加注意力機制提升了蝴蝶蘭花朵計數的精確率,然而該模型存在參數量較大、運算速度低的問題;文獻[11]基于VGG?16模型借助無人機圖像實現了實際農田環境的棉苗計數,但該模型存在低分辨率下漏檢率較高的問題。

綜上,目前的秧苗計數研究集中于大面積的開放環境,對于小規模溫室育種環境研究較少。此外,小規模農業生產環境下還存在著人工依賴程度高、軟硬件環境差的問題。因此,本文通過傳統視覺算法和YOLO算法[12]相結合實現數據集快速構建,并通過改進YOLO模型保證秧苗計數模型Seedet的高效運行。實驗結果證明,改進的通道注意力(Improved Channel Attention, ICA)方法可有效降低漏檢率,提出的計數方法適用于低成本場景下的秧苗計數,為農業中深度學習的實際應用提供了參考。

1 "理論基礎

1.1 "圖像預處理

傳統視覺算法中的圖像預處理技術對圖像進行幾何變換和顏色空間變換。幾何變換主要包括平移、旋轉、縮放、翻轉等,在進行幾何變換時需對圖像的標簽數據進行對應的操作,以減少標注工作量;顏色空間變換又被稱為色彩變換,通常是通過調整圖像的亮度、對比度、飽和度和色調等使圖像展現出不同的色彩信息。

通過圖像預處理技術可以快速進行圖像數據擴增,有效增加數據集的信息數據豐富度,進而提高深度學習模型的學習和泛化能力。在進行圖像幾何和色彩變換時應合理選擇變換方式與程度,避免原始數據失真。

1.2 "YOLO算法

YOLO是目標檢測任務中使用頻率最高的框架,其核心思想是將整張圖作為網絡的輸入,在輸出層直接回歸目標的位置坐標和類別,相比于二階段的RCNN系列,YOLO系列有著明顯的速度和參數優勢[13]。YOLO系列在迭代過程中不斷實現性能改進和功能完善,比較有代表性的是開放源代碼且仍在更新的YOLOv5和YOLOv8。

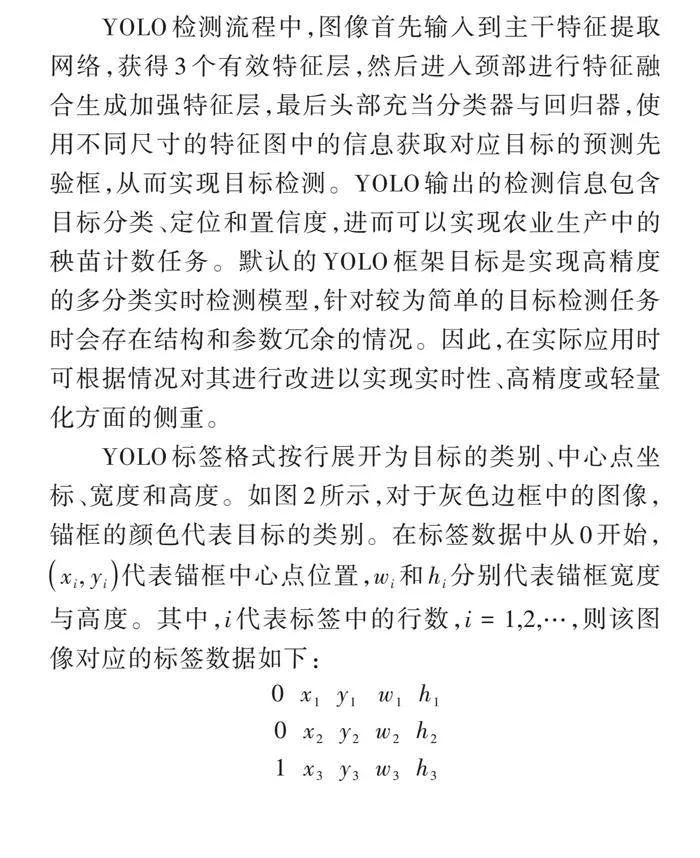

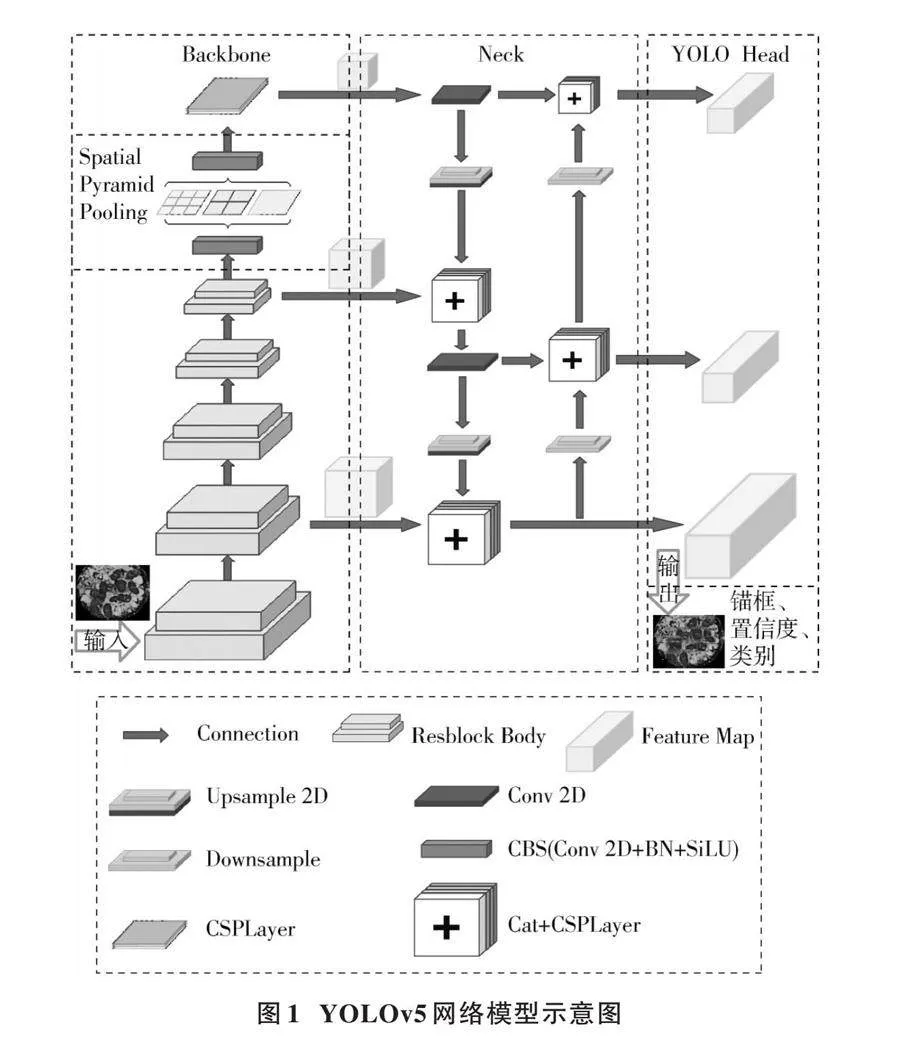

YOLO框架雖然在不斷改進,但其網絡結構變化較小,主要分為主干(Backbone)、頸部(Neck)和頭部(YOLO Head)三部分。圖1所示的YOLOv5網絡模型即為典型的YOLO模型架構。

YOLO檢測流程中,圖像首先輸入到主干特征提取網絡,獲得3個有效特征層,然后進入頸部進行特征融合生成加強特征層,最后頭部充當分類器與回歸器,使用不同尺寸的特征圖中的信息獲取對應目標的預測先驗框,從而實現目標檢測。YOLO輸出的檢測信息包含目標分類、定位和置信度,進而可以實現農業生產中的秧苗計數任務。默認的YOLO框架目標是實現高精度的多分類實時檢測模型,針對較為簡單的目標檢測任務時會存在結構和參數冗余的情況。因此,在實際應用時可根據情況對其進行改進以實現實時性、高精度或輕量化方面的側重。

YOLO標簽格式按行展開為目標的類別、中心點坐標、寬度和高度。如圖2所示,對于灰色邊框中的圖像,錨框的顏色代表目標的類別。在標簽數據中從0開始,[xi, yi]代表錨框中心點位置,[wi]和[hi]分別代表錨框寬度與高度。其中,[i]代表標簽中的行數,[i=1,2,…],則該圖像對應的標簽數據如下:

[0 " x1 " y1 " "w1 " h10 " x2 " y2 " w2 " h21 " x3 " y3 " w3 " h3]

此時0代表人的類別,1代表狗的類別。除類別外,其余指標都需進行歸一化處理以便計算。

2 "基于YOLO的秧苗計數研究

2.1 "數據集快速構建方法

相較于傳統視覺算法,基于深度學習的算法因其復雜的結構和龐大的參數量,展現出了卓越的數據擬合能力,能夠精準地映射高度復雜的非線性關系。因此,深度學習模型的數據需求造成了成本增加和計算資源的占用。

由幾何變換原理和YOLO數據集標簽的格式可知,在對圖像進行幾何變換時標簽數據只需簡單調整即可保證正確的映射。對于目標檢測任務來說,標簽數據在幾何變換時一般不改變類別,在色彩變換時無變化。以圖2為例,在對圖像進行水平翻轉、上下翻轉、逆時針旋轉、順時針旋轉時,分別有:

[xi'=1-xi, yi'=yi, wi'=wi, hi'=hixi'=xi, yi'=1-yi, wi'=wi, hi'=hixi'=yi, yi'=1-xi, wi'=hi, hi'=wixi'=1-yi, yi'=xi, wi'=wi, hi'=hi] (1)

式中,[xi']代表幾何變換之后的[xi],其余字母含義與此類似,每一行都代表著一種映射。

數據集快速構建流程圖如圖3所示,本文通過將傳統視覺算法和YOLO算法結合,實現數據集的高質量擴充與構建。

2.2 "改進的通道注意力機制

注意力機制能夠幫助模型更好地理解數據重要信息,提高模型性能,但同時會增加模型的復雜性[14]。為了保證模型輕量,本文著重于通道注意力方面的改進。SE[15]和ECA[16]是典型的輕量級通道注意力機制,SE重點在于獲取輸入特征層各通道的權重,ECA在SE的基礎上研究用一維卷積替換全連接層。SE模塊可以對輸入特征層每個通道分配權重,提高模型對特征層信息的抽取。如圖4所示,ICA模塊增加了全局最大池化來保留更多信道信息,并通過共享的一維卷積層進行交互,卷積核大小為[kc]。

由ECA可知,通道數[C]與一維卷積核尺寸[k]有式(2)所示的非線性映射關系,這確保了通道信息交互程度在最佳范圍內。

[C=?(k)=2γ*k-b] (2)

[k=ψ(C)=log2Cγ+bγodd ] (3)

式中:[C]是通道數;[k]是卷積核大小;[γ]是非線性系數;[b]是偏置值;[ψ]代表映射函數。

在[C]確定后,將系數設為2,偏置值[b=1],由式(3)推導出[k]。[C]越大,通道信息交互作用就越強。ICA是在SE和ECA的基礎上改進而來的,ECA的相關研究同樣適用,因此可得[kc=k]。

2.3 "改進后的YOLO模型

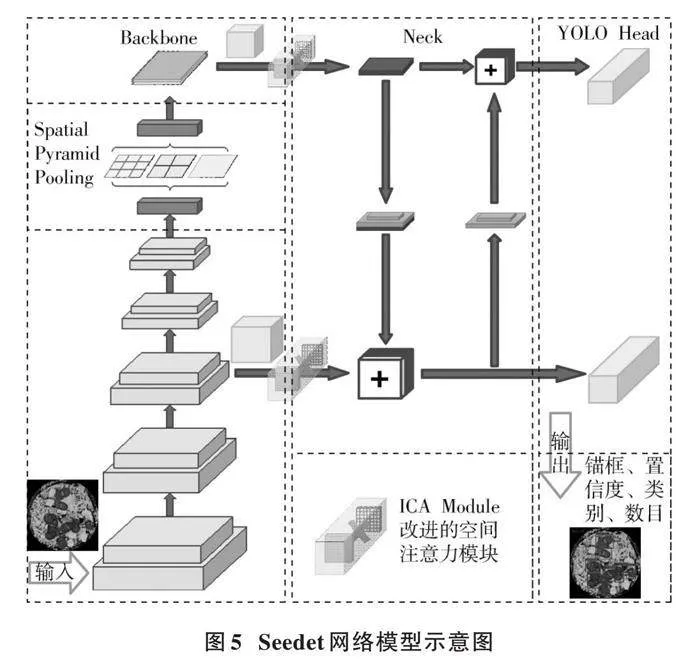

因為本文研究目標是低成本場景下秧苗計數方法,軟硬件條件差,模型需要輕量化。由于秧苗尺寸和規格差異較小,因此選擇精簡YOLO模型的頸部與頭部來實現輕量化,并通過添加ICA模塊保證檢測的準確性,最終構建了秧苗檢測模型Seedet,如圖5所示。與YOLOv5s相比,Seedet的參數量和計算量大幅下降,具體會在下一節進行描述。

3 "實驗結果與分析

3.1 "數據集

本文訓練數據取自廣西南寧市花卉公園育苗中心,初始數據為羅勒育苗穴盤,通過定位裁剪后獲得分辨率為256×256的初始圖像450張,通過提出的數據集快速構建方法最終獲得7 200張圖像和對應標簽數據。數據集按照(訓練集+驗證集)∶測試集= 9∶1,訓練集∶驗證集=9∶1的比例劃分。

3.2 "實驗環境及參數設置

實驗主要的軟硬件環境為:NVIDIA 2060 12 GB GPU,CUDA 11.8,PyTorch 1.11。模型訓練時采用實現簡單、收斂速度快的SGD優化器[17],其初始學習率設為0.01,動量參數設為0.937,權值衰減設為0.000 5。經測試后選擇合適的迭代次數為300。

3.3 "評估標準

評估模型的推理速度和資源消耗使用FPS、參數量和計算量三個指標。模型的檢測性能評估指標采用精準率[P]、召回率[R]、平均精度均值[mAP](選用[mAP]@0.5標準)和精確率[F1],其中[F1]權衡[P]與[R]以防止評估失衡,計算公式為:

[F1=2PR(P+R)] (4)

3.4 "消融實驗

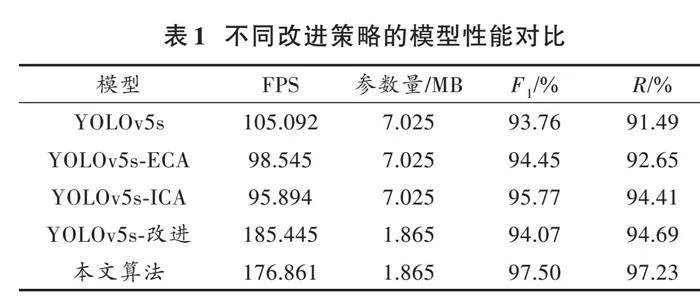

通過消融實驗驗證ICA模塊與模型改進的有效性,結果如表1所示。

由不同改進策略的模型性能對比數據可知,注意力機制模塊的添加對模型的參數量沒有明顯的影響,但造成了推理速度不到10%的下降。值得注意的是,通道注意力機制對召回率的提升效果很明顯,這意味著漏檢率的下降。在YOLOv5s模型上的實驗表明,本文提出的ICA模塊在召回率上相較于經典的ECA注意力模塊提升了1.76%,相較于無注意力機制提升了2.92%。與ECA模塊相比,ICA模塊使用全局最大池化來額外增加一條權重通道,增強了信息交互能力,提升了通道信息提取能力,只增加了2%左右的時間開銷。

3.5 "不同網絡模型對比

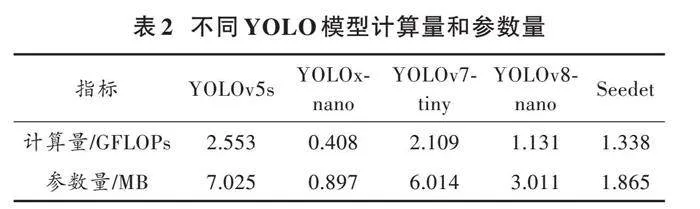

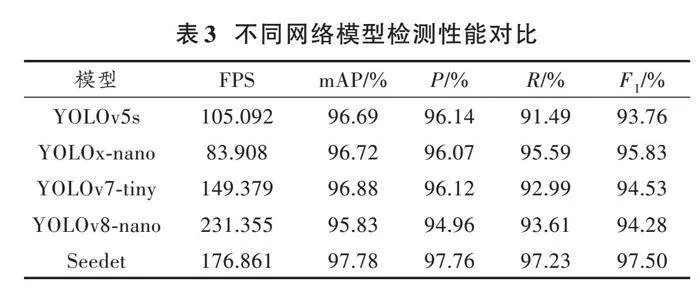

選取現有YOLO模型的輕量級分支與Seedet進行資源消耗指標的對比,數據如表2所示。

由表2數據可知,在模型的輕量化方面,由于Seedet優化了YOLOv5s的頸部與頭部結構,精簡分支的同時調整了通道的配比,側重處理中等規格的有效特征層。改進的模型降低了模型的參數量,計算量只有1.338 GFLOPs,顯著提高了推理速度。與YOLOv5s相比,Seedet的參數量與計算量降分別降低了73.45%和47.59%,檢測精確率和速度分別提高了3.987%和70.09%。

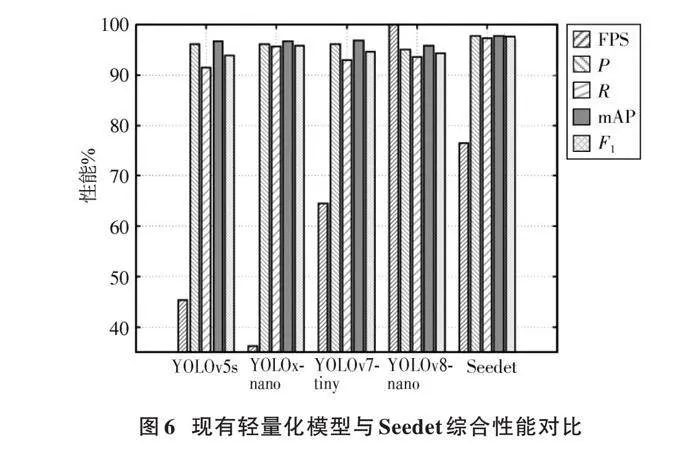

圖6直觀地展現了現有的輕量化模型與Seedet進行綜合性能的比較,其中FPS做了歸一化展示,具體數據見表3。綜合分析可知,Seedet能夠均衡資源消耗與檢測性能,在秧苗檢測方面具有優越性。

3.6 "檢測結果分析

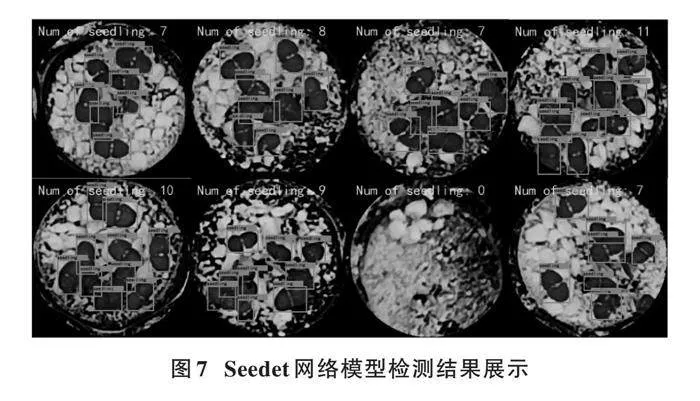

對測試集進行計數效果檢驗,部分結果如圖7所示。現存在問題是缺乏對圖片邊緣不完整秧苗的有效識別,如圖7右下角所示。這是除了目標分辨率過低外造成多個模型召回率偏低的重要原因。從整體效果來看,Seedet能解決葉片遮擋問題與低分辨率漏檢問題,完成羅勒秧苗計數任務。

4 "結 "論

針對小規模育種環境下人工依賴程度高、軟硬件條件差的問題,本文提出基于YOLO模型的數據集快速構建方法以降低成本,并通過添加通道注意力機制和改進YOLO結構保證秧苗檢測模型的輕量高效。經對比實驗驗證,可得到如下結論:

1) 提出的通道注意力機制對召回率的提升效果明顯,大大降低了低分辨率目標的漏檢。

2) 在輕量化模型對比實驗中,本文提出的Seedet綜合性能表現優異,能勝任唇形科植物秧苗計數任務。

3) 傳統視覺算法與YOLO結合的數據集快速構建方法和Seedet模型搭配能有效降低小規模育種環境下秧苗計數的成本,為農業發展做出貢獻。

注:本文通訊作者為陳繼清。

參考文獻

[1] 邱曉萍,張懿,陳煜林,等.中國唇形科藥用植物資源及利用現狀和開發潛力[J].應用與環境生物學報,2023,29(2):346?356.

[2] 彭強,涂賽飛,趙中雨,等.基于機器視覺的木薯疾病監測系統[J].武漢理工大學學報,2022,44(9):95?100.

[3] 秦昌友,楊艷山,顧峰瑋,等.現代農業領域中計算機視覺技術的運用與發展[J].中國農機化學報,2023,44(12):119?128.

[4] 卜俊怡,孫國祥,王迎旭,等.基于誘蟲板圖像的溫室番茄作物害蟲識別與監測方法[J].南京農業大學學報,2021,44(2):373?383.

[5] 張帆,楊勇,駱少明,等.穴盤苗發芽率在線視覺檢測研究[J].西南大學學報(自然科學版),2021,43(10):84?91.

[6] 姜友誼,張成健,韓少宇,等.基于無人機三維點云的玉米植株自動計數研究[J].浙江農業學報,2022,34(9):2032?2042.

[7] 朱松松,陳至坤,張怡.基于無人機數字圖像的棉花出苗信息提取[J].現代電子技術,2022,45(1):61?64.

[8] 王林柏,張博,姚竟發,等.基于卷積神經網絡馬鈴薯葉片病害識別和病斑檢測[J].中國農機化學報,2021,42(11):122?129.

[9] 陳道懷,汪杭軍.基于改進YOLOv4的林業害蟲檢測[J].浙江農業學報,2022,34(6):1306?1315.

[10] 肖克輝,楊宏,蘇章順,等.基于改進YOLOv5的蝴蝶蘭花朵識別與計數[J].中國農機化學報,2023,44(11):155?161.

[11] 祁洋,李亞楠,孫明,等.基于特征融合的棉花幼苗計數算法[J].農業工程學報,2022,38(9):180?186.

[12] REDMON J, DIVVALA S K, GIRSHICK R B, et al. You only look once: Unified, real?time object detection [EB/OL]. [2018?08?13]. http://arxiv.org/abs/1506.02640.

[13] 張三林,張立萍,鄭威強,等.基于YOLOv5的核桃品種識別與定位[J].中國農機化學報,2022,43(7):167?172.

[14] 徐宏偉,李然,張家旭.基于改進YOLOv7的湖面漂浮物目標檢測算法[J].現代電子技術,2024,47(1):105?110.

[15] HU J, SHEN L, ALBANIE S, et al. Squeeze?and?excitation networks [J]. IEEE transactions on pattern analysis and machine intelligence, 2020, 42(8): 2011?2023.

[16] WANG Q L, WU B G, ZHU P F, et al. ECA?Net: Efficient channel attention for deep convolutional neural networks [EB/OL]. [2023?12?04]. http://arxiv.org/abs/1910.03151.

[17] KESKAR N S, SOCHER R. Improving generalization performance by switching from adam to SGD [EB/OL]. [2018?08?13]. http://arxiv.org/abs/1712.07628.

作者簡介:蘇優生(1996—),男,碩士研究生,研究方向為計算機視覺。

陳繼清(1984—),男,博士,副教授,研究方向為機器人運動控制、機器視覺、特種機器人系統。

郝科崴(1998—),男,碩士研究生,研究方向為目標跟蹤。

佘鍇蓉(1998—),女,碩士研究生,研究方向為計算機視覺。

黃 "樣(1997—),男,碩士研究生,研究方向為機器人感知系統。