基于改進U-Net的視網膜血管分割算法

文章編號:1005-5630(2024)05-0009-08 DOI:10.3969/j.issn.1005-5630.202308280111

摘要:在面對視網膜圖像中細小血管時,現有算法存在分割精度低的問題。通過在U-Net中引入殘差模塊與細節增強注意力機制模塊,提出了一種改進的U-Net分割算法。在編解碼階段,用殘差模塊取代傳統的卷積模塊,解決了網絡隨深度增加而退化的問題;同時在編碼器和解碼器間增加細節增強注意力機制,減少編碼器輸出中的無用信息,從而提高網絡抓取有效特征信息的敏感度。此外,基于標準圖像集DRIVE的實驗結果表明,所提算法的分割準確率、靈敏度與F1值較U-Net算法分別提高了0.46%,2.14%,1.56%,優于傳統分割算法。

關鍵詞:圖像分割;視網膜血管;細節增強;殘差模塊

中圖分類號:TP 391文獻標志碼:A

Retinal blood vessel segmentation algorithm based on improved U-Net

LIU Yuan,LI Baicheng,WU Chunbo

(School of Optical-Electrical and Computer Engineering,University of Shanghai for Science andTechnology,Shanghai 200093,China)

Abstract:The existing algorithms have the problem of low segmentation accuracy when facing small vessels in retinal images.In this paper,an improved U-Net segmentation algorithm is proposed by introducing residual module and detail enhancement attention mechanism module into U-Net network.In the coding and decoding stages,the residual module is used to replace the traditional convolutional module,which solves the problem of network degradation with increasing depth.Meanwhile,a detail enhancement attention mechanism is added between the encoder and the decoder to reduce the useless information in the output of the encoder,so that the sensitivity of the network to capture valid feature information is improved.In addition,the experimental results based on the standard image set DRIVE reveal that the segmentation accuracy,sensitivity and F1 score of the proposed algorithm are improved by 0.46%,2.14%and 1.56%,respectively compared to the U-Net,which is superior to the traditional segmentation algorithms.

Keywords:image segmentation;retinal vessels;detail enhancement;residual module

引言

視網膜血管是人體微循環的重要組成部分,其血管直徑、迂曲度和分支模式等形態學變化特征與青光眼、糖尿病、高血壓等疾病的嚴重程度密切相關。例如,原發性高血壓會導致視網膜血管的痙攣和狹窄,血管壁增厚,嚴重者會導致滲出、出血和棉絮斑。醫生利用儀器觀察和分析視網膜的血管形狀、粗細以及有無增生,可以對眼底疾病進行有效篩查和診斷。由于視網膜血管的厚度變化大、眼科疾病的體征以及光照不平衡等問題,視網膜血管分割具有挑戰性。目前臨床上需要經驗豐富的專家手動分割視網膜區域。這種人工操作方法不僅耗時耗力,分割結果也不理想[1–4]。因此,找到一種高效的自動視網膜血管分割方法輔助醫生進行檢查和診斷是一項非常重要且有意義的工作。

一般來說,基于機器學習的視網膜血管分割算法可以大致分為兩類:無監督方法和有監督方法,兩者的區別在于輸入數據是否有人工分割的標簽。有監督學習需要海量的數據標簽,訓練周期較長,但具有良好的泛化效果[5]。無監督方法,如匹配濾波[6]、形態學[7]、血管跟蹤方法[8]等,可以自動根據現有數據學習和尋找目標的特征信息,找到類似血管的模式或簇。但是當分割圖像存在過多的干擾信息時,無監督提取血管分割算法的分割效果欠佳,性能還有待進一步提高。

隨著計算機視覺領域的快速發展,深度學習技術在圖像處理方向發揮了重要作用。深度學習是仿造神經元的結構去模擬人類思考的思維模式,可以快速處理原始數據以提取有效特征和自動學習特征分類。深度學習打破了傳統特征選擇方法的設計復雜性和局限性,避免了人工選擇特征的誤差,網絡模型可以從海量的數據庫中學習最深層的特征。由于深度卷積神經網絡(DCNN)的成功,許多分割網絡被提出并應用于醫學圖像領域,如全卷積神經網絡(FCN)[9]、Deep Lab[10]、SegNet[11]、U-Net[12]等。通過引入跳躍連接,U-Net能夠有效融合圖像低層和高層特征,減少語義鴻溝問題,在醫學圖像上表現出了良好的檢測能力。Wang等[13]提出雙編碼U-Net(DEUNet),顯著增強了網絡以端到端和像素到像素的方式分割視網膜血管的能力。Yoo等[14]引入注意力機制,增加有用特征信息的權重,減少冗余信息的干擾,進一步提高網絡的表達能力。Cherukuri等[15]使用多尺度表示濾波器來處理血管厚度多樣性。此外,Yan等[16]提出了一種新的片段級損失,改善了薄血管的分割結果。上述網絡模型在視網膜血管分割的研究任務中都可以獲取精確的血管輪廓和細節信息,但依然存在以下問題:一方面,在許多邊緣區域,低對比度使微小血管與背景難以區分;另一方面,用于模型的樣本較少,容易出現過擬合問題。

因此,本文提出一種改進的U-Net視網膜血管分割算法。首先對數據進行通道提取,選取對比度較高的通道作為輸入并進行歸一化、均衡化等預處理操作;然后用殘差模塊替代傳統卷積,不僅解決了梯度消失和梯度爆炸的問題,還能提高網絡的性能;最后在編解碼間采用細節增強注意力機制進行跳躍連接,提高網絡對微小的血管特征抓取的能力。將殘差模塊和注意力機制模塊與U-Net相結合,能夠有效提高模型對血管輪廓分割的準確性以及細節特征識別能力。

1算法原理

1.1改進的U-Net

受到ResNet和傳統遞歸網絡的啟發,并參考了當前基于CNN的U-Net的一些想法,本文對U-Net進行了改進。首先將U-Net編碼器和解碼器的傳統卷積Conv+ReLU結構改為殘差模塊。由于網絡深度的增加,使用殘差結構可以避免網絡深度增加導致的梯度消失問題。另外在跳躍連接處引入細節增強注意力機制(DEA),可以支持通道之間的復雜相關性,并減少網絡深度增加導致的參數數量和計算負擔。

圖1為本文改進的U-Net框架,由編碼器、解碼器、帶有細節增強注意力機制的跳躍連接三部分組成。編碼器包含4組下采樣層和殘差卷積模塊,解碼器由4組上采樣和殘差卷積模塊以及最高層1×1的卷積層組成,用來恢復特征大小,將通道數降為一維并通過Sigmoid激活函數輸出分割結果。編解碼器之間由帶有注意力機制的跳躍層連接,用以在提高網絡分割精度的同時捕獲到視網膜血管的更多細節特征。

1.2殘差模塊

在深度學習的模型搭建過程中,網絡層次的不斷加深會導致梯度消失和梯度爆炸。雖然使用數據的初始化和正則化可以有效解決梯度問題,但是模型的性能也會受到影響。因為網絡模型的不斷加深,模型訓練難度越來越大,訓練的錯誤會先減少后增多,模型的性能會明顯下降。He等[17]提出殘差ResNet模塊可以有效解決梯度消失和梯度爆炸問題,通過shortcut操作將輸入恒等映射到輸出,保證信息傳遞的完整性,使深層網絡更易訓練。即使網絡模型層次再深,訓練結果也可以表現優越。

在原始的U-Net網絡模型中,傳統的卷積層由兩個Conv-BN-ReLU組成。頻繁的卷積和冷卻操作會產生大量的噪聲信息。批量歸一化(BN)方法可以規范隱藏層神經的激活值,防止出現基本信息,并提高模型的表達能力。ReLU可以降低模型的復雜性,加快收斂速度。

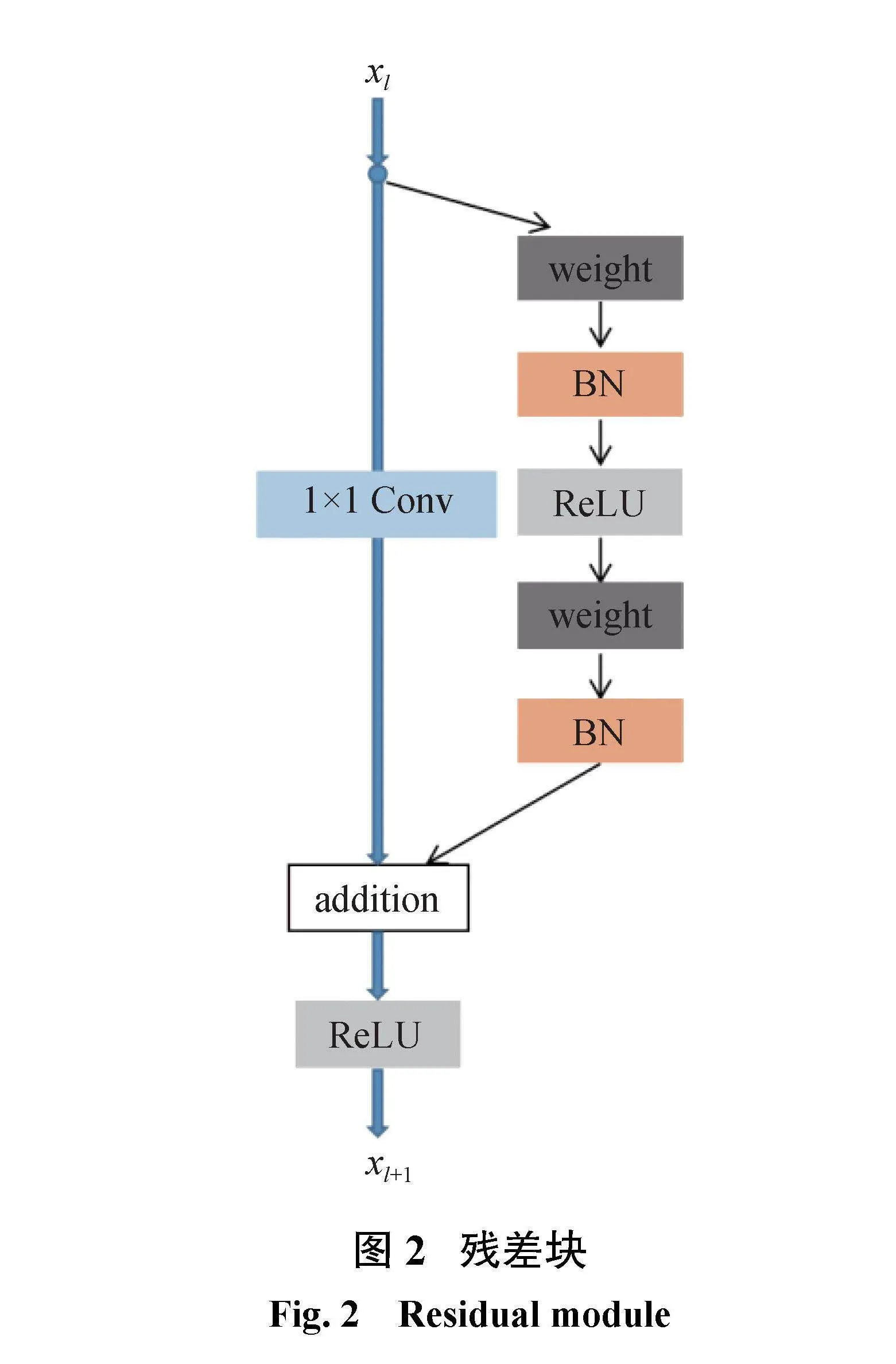

ResNet網絡由一系列的殘差模塊構成。如圖2所示,一個殘差塊可以表示為

xl+1=xl+F(xl;Wl)(1)

殘差塊由直接映射和殘差結構兩個環節構成。其中h(xl)是直接映射,F(xl;Wl)是殘差部分,可由2個或者3個卷積層組成。圖2左邊部分代表直接映射,圖2中右側包含卷積的部分代表殘差結構,weight在網絡中是指卷積操作,addition是指單位加操作。

在卷積網絡中,xl可能和xl+1的Feature Map的數量不一致,因此需要使用1×1卷積減少或者擴增參數達到統一。此時,殘差塊表示為

xl+1=h(xl)+F(xl;Wl)

其中h(xl)=Wl、x,Wl、是1×1卷積操作。

1.3注意力機制

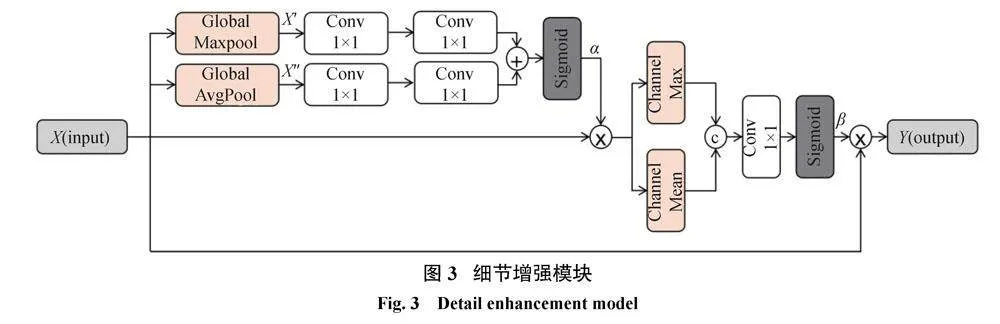

雖然在特征提取部分引入了殘差模塊,可以提取豐富的上下文特征,但在連續的下采樣操作中,會丟失大量微小對象的特征。對于U-Net體系結構,簡單的跳躍連接只能在一定程度上減輕池化層導致的信息丟失問題對整體分割精度的影響。為了使分割網絡獲取視網膜血管的更多細節,提出一種細節增強注意力(detail enhancement attention,DEA)機制來代替簡單的跳躍連接。DEA是一個進行圖像恢復編碼端到解碼端的模型,當編碼端以不同尺寸的卷積核提取到不同深度的信息時,通過注意力機制增強感興趣的區域,再對增強的信息進行融合,得到增強后的結果。

視網膜血管具有不同的厚度結構,與眼底圖像中的其他結構相比,這些結構通常相對較小,尤其是薄的視網膜血管。對于U-Net,來自編碼器單元的特征映射包含豐富而重要的空間細節信息,但也包含一些圖像噪聲。本文提出DEA模塊的目的是捕獲視網膜血管的空間信息并減小圖像噪聲的影響,模型提取的有效特征可以與編碼器特征充分融合,從而避免上采樣過程中一些微小血管與邊緣信息丟失的情況。對編碼層輸出執行全局池化操作,并計算注意力向量來校準特征信息的權重,從而提高網絡對血管特征的敏感性。詳細的細節增強注意力機制的原理如圖3所示。

首先對特征圖X分別進行全局最大池化和平均池化得到輸出X、和X、、;其次將X、和X、、分別進行兩次1×1卷積操作后融合,再經過Sigmoid激活函數得到權重系數α;然后用權重系數α校準特征圖得到輸出α×X,再將特征圖α×X分別進行通道最大和平均操作后融合;經過1×1卷積、Sigmoid函數得到通道系數β;最后將特征圖X用通道系數β校準得到最終輸出特征圖Y。

2實驗結果與分析

2.1數據集與預處理

為了全面評估和測試提出的改進U-Net的分割性能,本文在DRIVE公共數據集上進行實驗。DRIVE數據集作為視網膜血管分割常用的公共數據集,包含40幅三通道彩色圖像,每幅圖像的圖像大小為584 pixel×565 pixel。由于DRIVE數據集數據量很小,為了避免模型在訓練過程中產生過擬合現象,需要對DRIVE數據集進行數據增強。首先將預處理后的圖像進行?90°到90°隨機旋轉;然后將圖片隨機進行水平或垂直翻轉,概率各為50%;最后采用滑窗方式對圖像進行隨機切片。模型訓練和測試分為兩部分,比例為1∶1。20幅圖像用于訓練,其余部分用于模型測試。

眼底圖像通常包含噪聲和不均勻光照,需要在訓練前進行圖像預處理操作。通過實驗發現,RGB三通道的綠色通道的血管與背景的對比度高,圖片可以表現更細節的血管特征。因此,在預處理操作中首先提取綠色通道視網膜圖片作為輸入;然后對圖片進行歸一化處理和CLAHE算法(對比度受限自適應直方圖均衡化)進一步提高視網膜血管特征與背景的對比度;最后在不影響亮度較強部分的圖像質量的情況下,用伽馬變換算法增強眼底視網膜圖像中亮度較暗的血管部分。由于數據集數量不足容易引發過擬合問題,本文采用圖像隨機翻轉、旋轉、剪裁的數據增強技術應用于眼底圖像,以構建更多的訓練數據。

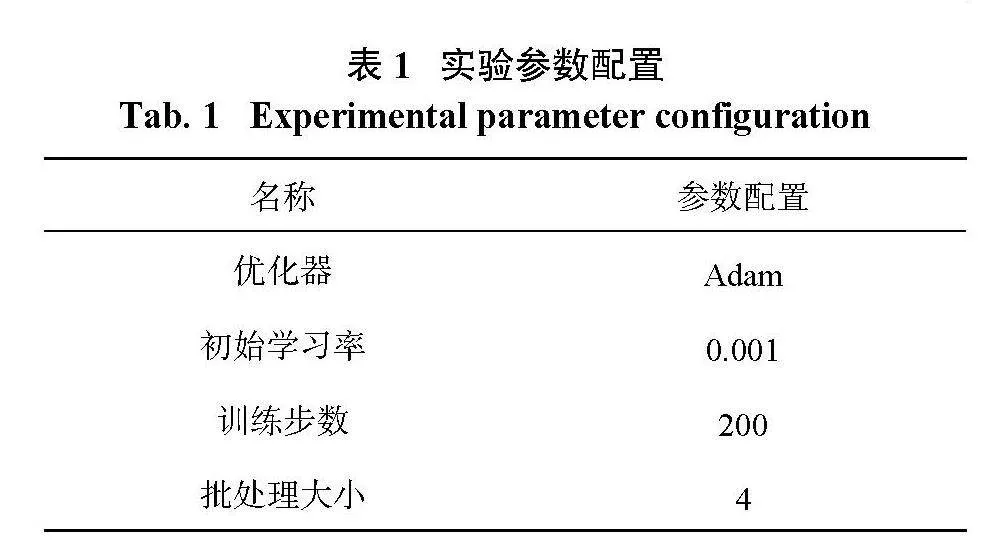

在個人計算機MAC13.1操作系統、8 GB內存、PyTorch1.13上搭建實驗平臺,實驗操作參數如表1所示。

2.2評價指標

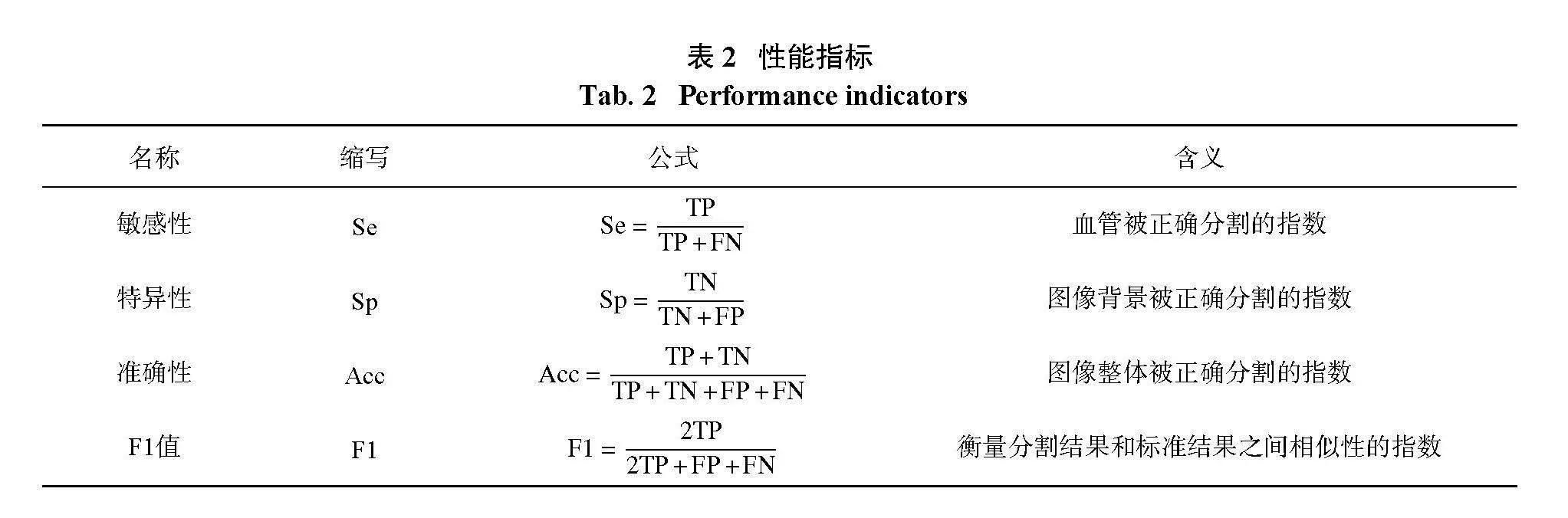

本文使用目前分割算法中常見的性能指標,敏感性(Sensitivity)、特異性(Specificity)、準確性(Accuracy)、F1值(F1-score)來評估算法的性能,各項指標的具體定義如表2所示。TP:被正確分割的血管像素數量;FP:錯誤分割的血管像素數量;TN:正確分割的背景像素數量;FN:錯誤分割的背景像素數量。

2.3實驗結果與分析

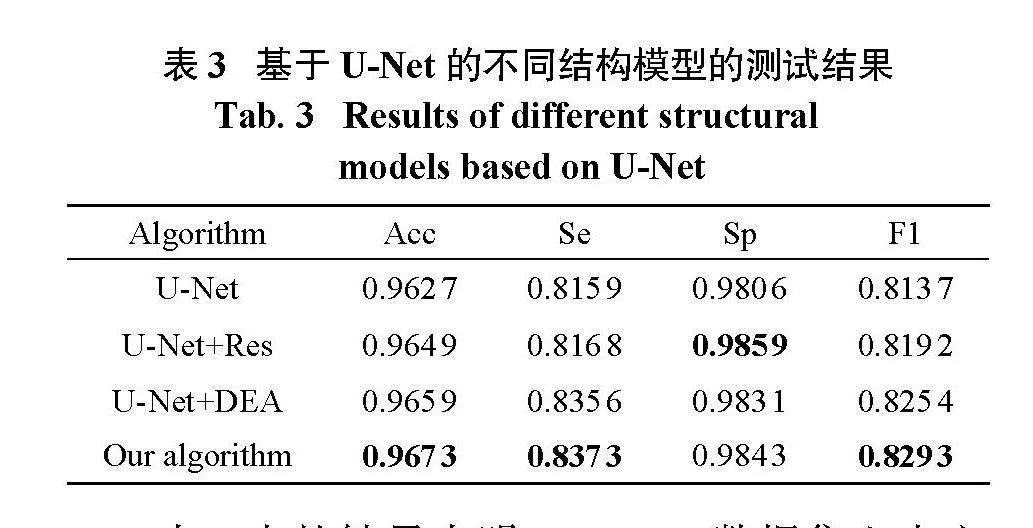

為了驗證本文所提網絡框架的性能,分析了不同模型的分割結果。在實驗中,不同的模型訓練使用相同的實驗配置、參數和訓練集的數量。在DRIVE數據集上進行了U-Net、U-Net+Res、U-Net+DEA以及本文算法的實驗。比較了實驗結果,如表3所示。

表3中的結果表明,DRIVE數據集上本文所提算法的Acc、Se和F1值高于U-Net、U-Net+Res和U-Net+DEA模型,分別為0.967 3、0.837 3和0.829 3。Sp值0.984 3高于U-Net和U-Net+DEA模型,但略低于U-Net+Res模型。整體來看,本文算法在分割結果方面優于其他3個模型。實驗證明,在跳躍連接中添加細節增強模塊以及在編解碼路徑中添加殘差模塊可以更好地提取視網膜血管的文本特征。

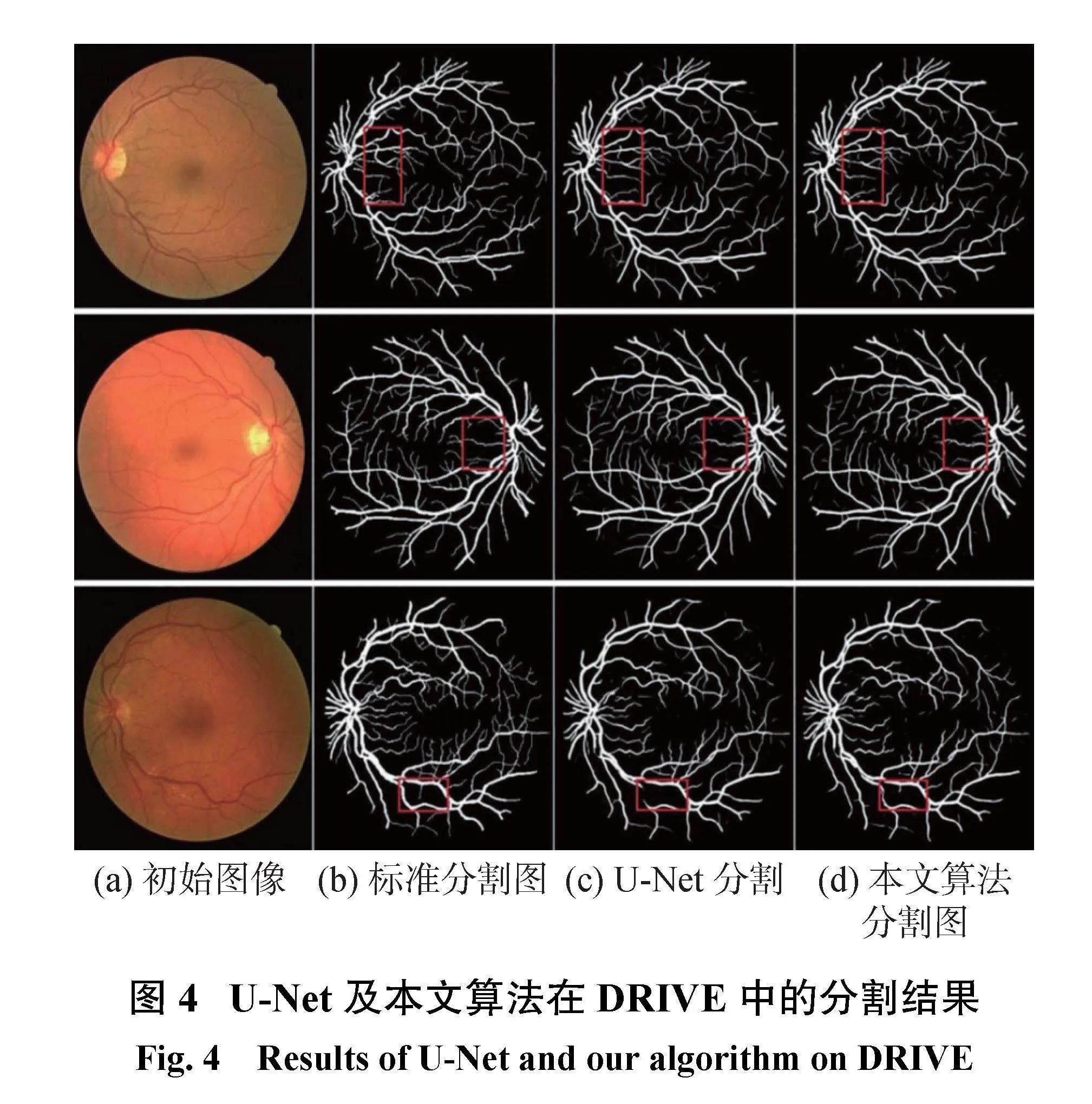

根據視網膜血管圖像分割可視化圖的分析結果,圖4顯示了U-Net和本文算法在DRIVE測試數據集上的血管分割結果。其中,圖4(a)列為視網膜初始圖像,圖4(b)為專家標準分割圖,圖4(c)為U-Net模型分割結果圖,圖4(d)為本文算法分割結果圖。實驗結果驗證了本文所提算法的可行性,分割結果優于U-Net模型。

圖5是視網膜血管局部分割對比圖,每一行包括原始圖像、標準圖像、U-Net分割圖像和本文算法分割結果圖像,并且相同局部區域的圖像被放大。通過實驗對比可以發現U-Net模型雖然可以檢測大部分視網膜血管,但血管連接部分的檢測效果較差。如分割圖的第1行所示,上側兩個大血管分叉的連接處斷開,并且U-Net分割結果的中間部分直接忽略了模糊小血管的分割。這表明本文提出的算法模型比U-Net模型具有更強的特征提取能力,并且可以正確地分割血管像素。

2.4不同算法指標對比

2.3節已證明本文算法模型在視網膜血管分割中比U-Net模型具有更好的性能。為了進一步證明本文算法在視網膜血管分割中的性能,在DRIVE數據集上將本文算法與現有醫學圖像分割領域的先進方法進行了定量對比,如表4所示。在DRIVE數據集中,所提出的算法比其他算法取得了更好的結果。與其他算法相比,本文算法Se和F1值明顯優于其他方法。圖6為不同算法指標對比的折線圖,從圖6可以明顯看到,本文算法的4個性能指標明顯高于大多數方法。其他算法由于未對毛細血管處進行細節增強處理,對末端細小血管的特征提取并不到位,會出現不同程度的欠分割和不連續的情況。因此,本文算法能夠準確分割視網膜血管,捕獲到視網膜血管的更多細節,具有良好的性能。

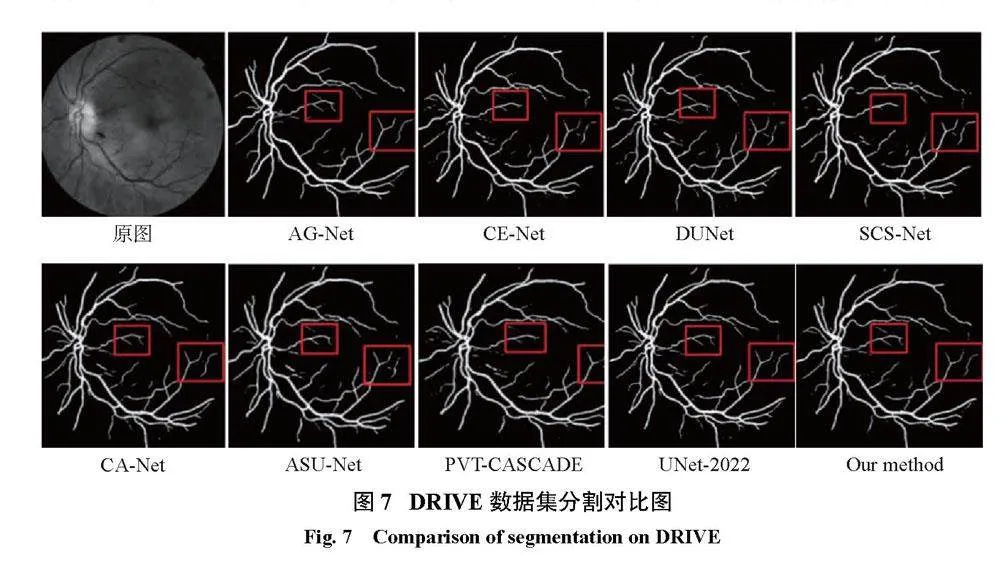

為了能更加直觀地對比本文算法與其他網絡的結果,現將分割圖進行對比,如圖7所示。從圖7可以看到,在紅框部分其他網絡在分割血管末端時出現了不同程度的斷裂和噪點,而改進的U-Net不僅完整地分割到了末端血管且未出現噪點,分割結果干凈完整。這再次說明本文算法的分割結果是優于其他8個網絡的。但本文算1b17b1444f295f535994dd1ba13343695240e377d9a92d54b2541948edbd9168法框架相比其他方法更為復雜,仍需致力于保持高網絡分割精度的同時降低算法復雜度。

3結論

本文算法結合了ResNet和注意力機制,提出一種改進的U-Net分割模型。以U-Net為基礎,先將原始的傳統卷積替換為殘差卷積,又引入了細節增強模塊(DEA),降低下采樣所導致的細小血管信息丟失的可能性。在DRIVE數據集上進行測試,得到的準確性、敏感性、特異性和F1值分別為96.73%、83.73%、98.43%和82.93%。相比傳統算法,本文算法分割結果可觀,整體性能較優。

參考文獻:

[1]GUO Q,DUFFY S P,MATTHEWS K,et al.Microfluidic analysis of red blood cell deformability[J].Journal of Biomechanics,2014,47(8):1767–1776.

[2]CHEUNG C Y L,IKRAM M K,CHEN C,et al.Imaging retina to study dementia and stroke[J].Progress in Retinal and Eye Research,2017,57:89–107.

[3]YU L F,QIN Z,ZHUANG T M,et al.A framework for hierarchical division of retinal vascular networks[J].Neurocomputing,2020,392:221–232.

[4]FRAZ M M,WELIKALA R A,RUDNICKA A R,et al.QUARTZ:quantitative analysis of retinal vessel topology and size–an automated system for quantification of retinal vessels morphology[J].Expert Systems with Applications,2015,42(20):7221–7234.

[5]LI J,ZHANG T,ZHAO Y,et al.MC-UNet:multimodule concatenation based on U-shape network for retinal bloodvessels segmentation[J].ComputationalIntelligence and Neuroscience,2022,2022:9917691.

[6]CHAUDHURI S,CHATTERJEE S,KATZ N,et al.Detection of bloodvessels in retinal images using two-dimensional matched filters[J].IEEE Transactions on Medical Imaging,1989,8(3):263–269.

[7]ZANA F,KLEIN J C.Segmentation of vessel-like patterns using mathematical morphology and curvature evaluation[J].IEEE Transactions on Image Processing,2001,10(7):1010–1019.

[8]CHUTATAPE O,ZHENG L,KRISHNAN S M.Retinal bloodvessel detection and tracking by matched Gaussian and Kalman filters[C]//Proceedings of the 20th Annual International Conference of the IEEE Engineering in Medicine and Biology Society.Hong Kong,China:IEEE,1998:3144?3149.

[9]JI J,LU X C,LUO M,et al.Parallel fully convolutional network for semantic segmentation[J].IEEE Access,2021,9:673–682.

[10]YUAN H B,ZHU J J,WANG Q F,et al.An improved DeepLab v3+741d5aac680d80411c9d70d13af1883e7ac2591ee3cb1f43ffdce9449a694e8edeep learning network applied to the segmentation of grape leaf black rot spots[J].Frontiersin Plant Science,2022,13:795410.

[11]BADRINARAYANAN V,KENDALL A,CIPOLLA R.SegNet:a deep convolutional encoder-decoder architecture for image segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(12):2481–2495.

[12]RONNEBERGER O,FISCHER P,BROX T.U-Net:convolutional networks for biomedical image segmentation[C]//18th International Conference on Medical Image Computing and Computer-Assisted Intervention.Munich,Germany:Springer,2015:234?241.

[13]WANG B,QIU S,HE H G.Dual encoding U-Net for retinal vessel segmentation[C]//22nd International Conference on Medical Image Computing and Computer Assisted Intervention.Shenzhen,China:Springer,2019:84?92.

[14]YOO D,PARK S,LEE J Y,et al.AttentionNet:aggregating weak directions for accurate object detection[C]//2015 IEEE International Conference on Computer Vision(ICCV).Santiago,Chile:IEEE,2015:2659?2667.

[15]CHERUKURI V,KUMAR B G V,BALA R,et al.Deep retinal image segmentation with regularization under geometric priors[J].IEEE Transactions on Image Processing,2020,29:2552–2567.

[16]YAN Z Q,YANG X,CHENG K T.Joint segment-level and pixel-wise losses for deep learning based retinal vessel segmentation[J].IEEE Transactions on Biomedical Engineering,2018,65(9):1912–1923.

[17]HE K M,ZHANG X Y,REN S Q,et al.Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas,NV,USA:IEEE,2016:770?778.

[18]ZHANG S H,FU H Z,YAN Y G,et al.Attentionguided network for retinal image segmentation[C]//22nd International Conference on Medical Image Computing and Computer Assisted Intervention.Shenzhen,China:Springer,2019:797?805.

[19]GU Z W,CHENG J,FU H Z,et al.CE-Net:context encoder network for 2D medical image segmentation[J].IEEE Transactions on Medical Imaging,2019,38(10):2281–2292.

[20]JIN Q G,MENG Z P,PHAM T D,et al.DUNet:a deformable network for retinal vessel segmentation[J].Knowledge-Based Systems,2019,178:149–162.

[21]WU H S,WANG W,ZHONG J F,et al.SCS-Net:a scale and context sensitive network for retinal vessel segmentation[J].Medical Image Analysis,2021,70:102025.

[22]GU R,WANG G T,SONG T,et al.CA-Net:comprehensive attention convolutional neural networks for explainable medical image segmentation[J].IEEE Transactions on Medical Imaging,2021,40(2):699–711.

[23]SUN K X,XIN Y L,MA Y D,et al.ASU-Net:U-shape adaptive scale network for mass segmentation in mammograms[J].Journal of Intelligent&Fuzzy Systems:Applications in Engineering and Technology,2022,42(4):4205–4220.

[24]RAHMAN M M,MARCULESCU R.Medical image segmentation via cascaded attention decoding[C]//2023 IEEE/CVF Winter Conference on Applications of Computer Vision(WACV).Waikoloa,HI,USA:IEEE,2023:6211?6220.

[25]GUO J S,ZHOU H Y,WANG L S,et al.UNet-2022:exploring dynamics in non-isomorphic architecture[EB/OL].[2022-10-27].https://doi.org/10.48550/arXiv.2210.15566.

(編輯:張磊)